Los portales de datos abiertos son una fuente invaluable de información pública. Sin embargo, extraer insights significativos de estos datos puede resultar desafiante para usuarios sin conocimientos técnicos avanzados.

En este ejercicio práctico, exploraremos el desarrollo de una aplicación web que democratiza el acceso a estos datos mediante el uso de inteligencia artificial, permitiendo realizar consultas en lenguaje natural.

La aplicación, desarrollada utilizando el portal datos.gob.es como fuente de datos, integra tecnologías modernas como Streamlit para la interfaz de usuario y el modelo de lenguaje Gemini de Google para el procesamiento de lenguaje natural. La naturaleza modular permite que se pueda utilizar cualquier modelo de Inteligencia Artificial con mínimos cambios. El proyecto completo está disponible en el repositorio de Github.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

En este vídeo, el autor te explica que vas a encontrar tanto en el Github como en Google Colab.

Arquitectura de la aplicación

El núcleo de la aplicación se basa en cuatro apartados principales e interconectados que trabajan para procesar las consultas de la persona usuaria:

- Generación del Contexto

- Analiza las características del dataset elegido.

- Genera una descripción detallada incluyendo dimensiones, tipos de datos y estadísticas.

- Crea una plantilla estructurada con guías específicas para la generación de código.

- Combinación de Contexto y Consulta

- Une el contexto generado con la pregunta de la persona usuaria creando el prompt que recibirá el modelo de inteligencia artificial.

- Generación de Respuesta

- Envía el prompt al modelo y obtiene el código Python que permite resolver la cuestión generada.

- Ejecución del Código

- Ejecuta de manera segura el código generado con un sistema de reintentos y correcciones automáticas.

- Captura y expone los resultados en el frontal de la aplicación.

Figura 1. Flujo de procesamiento de solicitudes

Proceso de desarrollo

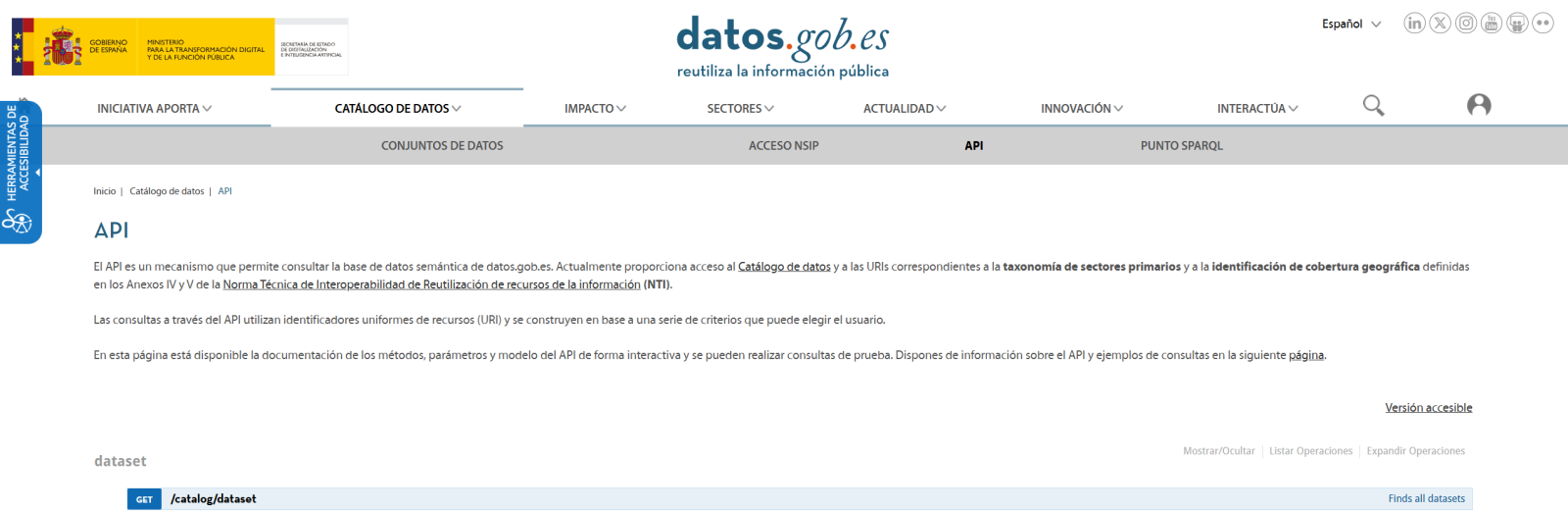

El primer paso es establecer una forma de acceder a los datos públicos. El portal datos.gob.es ofrece vía API los datasets. Se han desarrollado funciones para navegar por el catálogo y descargar estos archivos de forma eficiente.

Figura 2. API de datos.gob

El segundo paso aborda la cuestión: ¿cómo convertir preguntas en lenguaje natural en análisis de datos útiles? Aquí es donde entra Gemini, el modelo de lenguaje de Google. Sin embargo, no basta con simplemente conectar el modelo; es necesario enseñarle a entender el contexto específico de cada dataset.

Se ha desarrollado un sistema en tres capas:

- Una función que analiza el dataset y genera una "ficha técnica" detallada.

- Otra que combina esta ficha con la pregunta del usuario.

- Y una tercera que traduce todo esto en código Python ejecutable.

Se puede ver en la imagen inferior como se desarrolla este proceso y, posteriormente, se muestran los resultados del código generado ya ejecutado.

Figura 3. Visualización del procesamiento de respuesta de la aplicación

Por último, con Streamlit, se ha construido una interfaz web que muestra el proceso y sus resultados al usuario. La interfaz es tan simple como elegir un dataset y hacer una pregunta, pero también lo suficientemente potente como para mostrar visualizaciones complejas y permitir la exploración de datos.

El resultado final es una aplicación que permite a cualquier persona, independientemente de sus conocimientos técnicos, realizar análisis de datos y aprender sobre el código ejecutado por el modelo. Por ejemplo, un funcionario municipal puede preguntar "¿Cuál es la edad media de la flota de vehículos?" y obtener una visualización clara de la distribución de edades.

Figura 4. Caso de uso completo. Visualizar la distribución de los años de matriculación de la flota automovilística del ayuntamiento de Almendralejo en 2018

¿Qué puedes aprender?

Este ejercicio práctico te permite aprender:

- Integración de IA en Aplicaciones Web:

- Cómo comunicarse efectivamente con modelos de lenguaje como Gemini.

- Técnicas para estructurar prompts que generen código preciso.

- Estrategias para manejar y ejecutar código generado por IA de forma segura.

- Desarrollo Web con Streamlit:

- Creación de interfaces interactivas en Python.

- Manejo de estado y sesiones en aplicaciones web.

- Implementación de componentes visuales para datos.

- Trabajo con Datos Abiertos:

- Conexión y consumo de APIs de datos públicos.

- Procesamiento de archivos Excel y DataFrames.

- Técnicas de visualización de datos.

- Buenas Prácticas de Desarrollo:

- Estructuración modular de código Python.

- Manejo de errores y reintentos.

- Implementación de sistemas de feedback visual.

- Despliegue de aplicaciones web usando ngrok.

Conclusiones y futuro

Este ejercicio demuestra el extraordinario potencial de la inteligencia artificial como puente entre los datos públicos y los usuarios finales. A través del caso práctico desarrollado, hemos podido observar cómo la combinación de modelos de lenguaje avanzados con interfaces intuitivas permite democratizar el acceso al análisis de datos, transformando consultas en lenguaje natural en análisis significativos y visualizaciones informativas.

Para aquellas personas interesadas en expandir las capacidades del sistema, existen múltiples direcciones prometedoras para su evolución:

- Incorporación de modelos de lenguaje más avanzados que permitan análisis más sofisticados.

- Implementación de sistemas de aprendizaje que mejoren las respuestas basándose en el feedback del usuario.

- Integración con más fuentes de datos abiertos y formatos diversos.

- Desarrollo de capacidades de análisis predictivo y prescriptivo.

En resumen, este ejercicio no solo demuestra la viabilidad de democratizar el análisis de datos mediante la inteligencia artificial, sino que también señala un camino prometedor hacia un futuro donde el acceso y análisis de datos públicos sea verdaderamente universal. La combinación de tecnologías modernas como Streamlit, modelos de lenguaje y técnicas de visualización abre un abanico de posibilidades para que organizaciones y ciudadanos aprovechen al máximo el valor de los datos abiertos.

Hola. Felicitaciones por la aplicación. Entiendo que dado que son datos abiertos, no tienen ningún tipo de riesgo con la normativa RGPD y por tanto el objetivo principal de facilitar el acceso libre a la información, lo cumple de manera eficiente.

Buenos días,

Muchas gracias, efectivamente y como comenta, se contempla al estar trabajando con datos del catálogo.

Un saludo.