En el ámbito de los datos geoespaciales, la codificación y estandarización juegan un papel fundamental para garantizar la interoperabilidad entre sistemas y mejorar la accesibilidad a la información.

La Directiva INSPIRE (Infrastructure for Spatial Information in Europe) determina las reglas generales para el establecimiento de una Infraestructura de Información espacial en la Comunidad Europea basada en las Infraestructuras de los Estados miembros. Aprobada por el Parlamento Europeo y el Consejo el 14 de marzo de 2007 (Directiva 2007/2/CE), está diseñada para lograr estos objetivos, asegurando que la información espacial sea coherente y accesible a lo largo de los países miembros de la UE.

Entre las diversas codificaciones disponibles para los conjuntos de datos INSPIRE, el estándar GeoPackage emerge como una alternativa flexible y eficiente frente a formatos tradicionales como GML o GeoJSON. Este artículo explorará cómo el GeoPackage puede mejorar la gestión de datos INSPIRE y cómo puede implementarse utilizando herramientas como hale studio, una plataforma visual que facilita la transformación de datos conforme a especificaciones INSPIRE.

¿Qué es GeoPackage?

GeoPackage es un estándar desarrollado por el Open Geospatial Consortium (OGC) que utiliza SQLite como base para almacenar información geoespacial de manera compacta y accesible. A diferencia de otros formatos que requieren procesos de transformación intermedios, los datos en un fichero GeoPackage pueden ser leídos y actualizados directamente en su formato nativo. Esto permite una mayor eficiencia en las operaciones de lectura y escritura, especialmente en aplicaciones GIS.

Principales características de GeoPackage

-

Formato abierto y estándar: al ser un estándar abierto, GeoPackage es adecuado para la publicación de datos espaciales abiertos, facilitando el acceso a datos geoespaciales en formatos que los usuarios pueden manejar sin licencias costosas o restricciones de uso.

-

Contenedor único: un archivo GeoPackage puede almacenar datos vectoriales, mosaicos de imágenes y datos no espaciales.

-

Compatibilidad: es soportado por diversas plataformas GIS, incluyendo QGIS y ArcGIS, así como por herramientas ETL como FME.

- Indexación espacial: el formato incluye índices espaciales (RTree) que permiten una búsqueda y manipulación de datos más rápida.

Para obtener más detalles técnicos, puedes consultar el estándar GeoPackage en la web de OGC.

¿Por qué utilizar GeoPackage en INSPIRE?

INSPIRE requiere que los datos espaciales sean interoperables a nivel europeo, y su estándar de codificación por defecto es GML. No obstante, GeoPackage se ofrece como una alternativa que puede reducir la complejidad en ciertos casos de uso, especialmente en aquellos donde el rendimiento y la usabilidad son cruciales.

El uso de GeoPackage dentro de INSPIRE está respaldado por las buenas prácticas desarrolladas para crear modelos lógicos optimizados que faciliten el uso en entornos GIS. Estas prácticas permiten crear esquemas específicos según el caso de uso y ofrecen una flexibilidad que otros formatos no proporcionan. Además, GeoPackage es especialmente útil en escenarios donde se manejan conjuntos de datos de tamaño medio a grande, ya que su formato compacto reduce el tamaño del archivo y, por lo tanto, facilita el intercambio de datos.

Implementación de GeoPackage en INSPIRE usando Hale Studio

Una de las herramientas recomendadas para implementar GeoPackage en INSPIRE es el software open-source hale studio. Este software de transformación de datos permite mapear y transformar modelos de datos de forma visual y sin necesidad de programar.

A continuación, se describen los pasos básicos para transformar un conjunto de datos conforme a INSPIRE usando hale studio:

- Cargar el modelo fuente: importar el conjunto de datos en su formato original, como GML.

- Definir el modelo de destino (GeoPackage): cargar un archivo GeoPackage en blanco que actúe como modelo de destino para almacenar los datos transformados.

- Configurar el mapeo de datos: a través de la interfaz visual de hale, mapear los atributos y aplicar reglas de transformación para asegurar la conformidad con el modelo GeoPackage de INSPIRE.

- Exportar el conjunto de datos: una vez validada la transformación, exportar el archivo en formato GeoPackage.

Hale studio facilita esta transformación y permite optimizar los modelos de datos para un rendimiento mejorado en entornos GIS. Más información sobre hale studio y sus capacidades de transformación está disponible en su página oficial.

Ejemplos de implementación

La aplicación del estándar GeoPackage en INSPIRE ya ha sido probada en varios casos de uso, proporcionando un marco sólido para futuras implementaciones.

- Directiva de Ruido Ambiental (END): en este contexto, el GeoPackage se ha utilizado para almacenar y gestionar datos relacionados con el ruido, alineando los modelos con las especificaciones de INSPIRE. La Agencia Europea de Medio Ambiente (EEA) proporciona plantillas y guías para facilitar esta implementación, disponibles en su repositorio.

- Proyecto GO-PEG: este proyecto utiliza el GeoPackage para desarrollar modelos 3D en geología, permitiendo la representación detallada de zonas geológicas, como la cuenca del Po en Italia. Las directrices y ejemplos de implementación del GO-PEG están disponibles aquí.

Estos ejemplos ilustran cómo el GeoPackage permite mejorar la eficiencia y usabilidad de los datos INSPIRE en aplicaciones prácticas, especialmente en entornos GIS que requieren la manipulación rápida y directa de datos espaciales.

La implementación de GeoPackage en el marco de INSPIRE demuestra su aplicabilidad en datos abiertos a nivel europeo. Iniciativas como la Directiva de Ruido Ambiental (END) y el Proyecto GO-PEG han mostrado cómo los datos abiertos en GeoPackage pueden servir a múltiples sectores, desde la gestión ambiental hasta estudios geológicos.

Beneficios del GeoPackage para los proveedores y usuarios de datos

La adopción del GeoPackage en INSPIRE ofrece beneficios tanto para quienes generan como para quienes consumen los datos:

-

Para proveedores: el modelo simplificado de GeoPackage permite reducir los errores de codificación y mejora la armonización de datos, lo que facilita su distribución en formatos compactos.

- Para usuarios: la compatibilidad con herramientas GIS permite acceder a los datos sin necesidad de transformaciones adicionales, mejorando la experiencia de consumo y reduciendo los tiempos de carga y consulta.

Limitaciones y retos

Si bien el GeoPackage es una alternativa robusta, existen ciertos desafíos a considerar:

- Limitaciones en la interoperabilidad: a diferencia de GML, GeoPackage no es compatible con todos los servicios de publicación de datos en red, aunque algunos avances en protocolos como STAC están mejorando estas limitaciones.

- Optimización para conjuntos de datos grandes: aunque GeoPackage es óptimo para conjuntos de datos medianos a grandes, el tamaño del archivo puede ser un obstáculo en datos extremadamente grandes o en redes de bajo ancho de banda.

Conclusión

La incorporación del estándar GeoPackage en INSPIRE representa un avance significativo para la gestión y distribución de datos espaciales en Europa, promoviendo una infraestructura de datos espaciales más eficiente y accesible. Este enfoque contribuye a la interoperabilidad de datos y facilita su uso en diversos sistemas GIS, mejorando tanto la experiencia de los proveedores como de los usuarios.

Para quienes deseen implementar este formato, herramientas como hale studio ofrecen soluciones prácticas y accesibles que simplifican el proceso de transformación de datos INSPIRE. Con la adopción de buenas prácticas y el uso de modelos de datos optimizados, el GeoPackage puede desempeñar un papel crucial en el futuro de la infraestructura de datos espaciales en Europa. A lo que se suma que este enfoque alineado con los principios de transparencia y reutilización de datos permite que las administraciones y organizaciones aprovechen los datos abiertos para apoyar la toma de decisiones informadas y el desarrollo de aplicaciones innovadoras en diversas áreas.

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los datos abiertos tienen un rol relevante en el desarrollo tecnológico por muchos motivos. A modo de ejemplo, son un componente fundamental en la toma de decisiones informadas, en la evaluación de procesos o incluso en el impulso de la innovación tecnológica. Siempre y cuando, cuenten con la calidad óptima, estén actualizados y respeten los aspectos éticos, los datos pueden ser el ingrediente clave para el alcanzar el éxito de un proyecto.

A fin de aprovechar plenamente las ventajas de los datos abiertos en la sociedad, la Unión Europea cuenta con diversas iniciativas para impulsar la economía del dato, un modelo digital único que fomenta el intercambio de datos, destacando la soberanía y el gobierno de los mismos, el marco ideal y necesario para los datos abiertos.

En la economía del dato, tal y como recoge la regulación vigente, se garantiza la privacidad de las personas y la interoperabilidad de los datos. El marco regulatorio se encarga de velar por el cumplimiento de esta premisa. Ejemplo de ello puede ser la modificación de la Ley 37/2007 para la reutilización de información del sector público en cumplimiento de la Directiva Europea 2019/1024. Esta regulación se alinea con la Estrategia de datos de la Unión Europea que define un horizonte con un mercado único de datos en el que se facilite un intercambio mutuo, libre y seguro entre el sector público y el privado.

Para lograr este objetivo, se deben abordar cuestiones clave, como preservar ciertas garantías jurídicas o acordar unas características comunes de descripción de metadatos que deben cumplir los dataset para facilitar el acceso y uso de los datos entre sectores, es decir, utilizar un lenguaje común que permita la interoperabilidad entre catálogos de conjuntos de datos.

¿Qué son los estándares de metadatos?

Un primer paso hacia la interoperabilidad y reutilización de los datos es desarrollar mecanismos que habiliten una descripción homogénea de los mismos y que, además, dicha descripción sea fácilmente interpretable y procesable tanto por humanos como por máquinas. En este sentido, se han ido creando diferentes vocabularios que, con el tiempo, se han ido consensuando hasta convertirse en estándares.

Los vocabularios estandarizados ofrecen una semántica que sirve como base para la publicación de conjuntos de datos que actúa como "leyenda" para facilitar la comprensión del contenido de los datos. Al fin y al cabo, se puede decir que estos vocabularios proporcionan una colección de metadatos para describir los datos que se publican; y como todos los usuarios de esos datos tienen acceso a los metadatos y entienden su significado, es más fácil interoperar y reutilizar los datos.

W3C: Estándares DCAT y DCAT-AP

A nivel internacional, se pueden destacar varias organizaciones que crean y mantienen estándares:

-

World Wide Web Consortium (W3C): desarrolla el Vocabulario de Catálogos de Datos (DCAT): un estándar de descripción diseñado con el objetivo de facilitar la interoperabilidad entre catálogos de conjuntos de datos publicados en la web.

-

Posteriormente, tomando como base DCAT, se desarrolló DCAT-AP, una especificación para el intercambio de descripciones de datos publicados en los portales de datos en Europa que cuenta con extensiones de DCAT-AP más específicas como:

- GeoDCAT-AP que extiende DCAT-AP para la publicación de datos espaciales.

- StatDCAT-AP que igualmente, extiende DCAT-AP para describir datasets de contenidos estadísticos.

-

ISO: Organización de Estandarización Internacional

Además de World Wide Web Consortium, existen otras organizaciones que se dedican a la estandarización, por ejemplo, la Organización de Estandarización Internacional (ISO, por sus siglas en inglés Internacional Standarization Organisation).

- Entre otros muchos tipos de estándares, ISO también ha definido normas de estandarización de metadatos de catálogos de datos:

- ISO 19115 para describir información geográfica. Como ocurre en DCAT, también se han desarrollado extensiones y especificaciones técnicas a partir de ISO 19115, por ejemplo:

- ISO 19115-2 para datos ráster e imágenes.

- ISO 19139 proporciona una implementación en XML del vocabulario.

- ISO 19115 para describir información geográfica. Como ocurre en DCAT, también se han desarrollado extensiones y especificaciones técnicas a partir de ISO 19115, por ejemplo:

El horizonte en los estándares de metadatos: retos y oportunidades

Tanto W3C como ISO trabajan en el desarrollo y mantenimiento de vocabularios estandarizados y adaptados a las necesidades de los usuarios. Su trabajo contribuye a lograr un ecosistema de datos abiertos interoperables que facilite la reutilización. Sin embargo, la interoperabilidad a menudo se encuentra con obstáculos derivados de debilidades de calidad, como pueden ser datos obsoletos, dificultades para acceder e interoperar con ellos o metadatos incompletos.

A pesar de ello, como se ha demostrado, la compartición de datos es un mecanismo fundamental en la economía del dato. Así que garantizar la interoperabilidad y reutilización de estos es una acción clave para abordar el desarrollo de la economía de los datos en línea con las expectativas de las organizaciones en lo que se refiere a innovación.

Entre las múltiples ventajas que ofrece la reutilización de conjuntos de datos y su interoperabilidad se puede destacar la creación de aplicaciones y servicios que aportan un valor a la sociedad o ayudan en la evaluación de políticas, por ejemplo.

Además, la reutilización e interoperabilidad de los conjuntos de datos favorece el desarrollo económico en general, y la economía del dato, en particular. Se estima que esta industria alcanzará un valor de 829.000 millones de euros en 2025, según previsiones de la Unión Europea. Para poder aprovechar los beneficios que ofrece compartir datos, primero, se deben acordar y respetar unas normas de descripción comunes: los estándares para describir metadatos de catálogos de conjuntos de datos.

Ya ha pasado mucho tiempo desde la primera vez que oímos hablar del ecosistema Apache Hadoop para procesamiento de datos distribuidos. Las cosas han cambiado mucho desde entonces, y ahora usamos herramientas de más alto nivel para construir soluciones basadas en grandes cargas de datos. Sin embargo, es importante destacar algunas buenas prácticas relacionadas con los formatos de nuestros datos si queremos diseñar soluciones big data verdaderamente eficientes y escalables.

Introducción

Los que trabajamos en el sector de los datos sabemos de la importancia de la eficiencia en múltiples aspectos de las soluciones y arquitecturas de datos. Hablamos de eficiencia en tiempos de procesamiento, pero también, en términos de espacio ocupado y como no, de costes de almacenamiento. Una buena decisión en cuanto a tipos de formatos de datos puede ser vital con respecto a la escalabilidad futura de una solución basada en datos.

Para hablar de este tema, en este post os traemos una reflexión acerca del formato de datos Apache Parquet o simplemente Parquet. Las primeras versiones de Apache Parquet se lanzaron en el año 2013. Desde 2015, Apache Parquet es uno de los proyectos de cabecera patrocinados y mantenidos por Apache Software Foundation (ASF). ¡Arrancamos!

¿Qué es Apache Parquet?

Sabemos que es posible que nunca hayas oído hablar del formato de archivo Apache Parquet con anterioridad. El formato Parquet, es un tipo de fichero que contiene datos (de tipo tabla) en su interior, de forma similar a cuando hablamos del fichero tipo CSV. Aunque parezca obvio, los ficheros parquet tienen extensión .parquet y a diferencia de un CSV, no es un fichero en texto plano (se representa de forma binaria), lo que significa que no lo podemos abrir y examinar con un simple editor de texto. El formato parquet es un tipo de formato de los que clasificamos en orientados-a-columnas (column-oriented file format). Como habrás adivinado, existen otros formatos orientados-a-filas o row-oriented. Tal es el caso de los formatos tipo CSV, TSV o AVRO.

Pero, ¿qué significa que un formato de datos sea o esté orientado a filas o a columnas? En un fichero CSV (recordamos, orientado a filas) cada registro es una fila. En Parquet, sin embargo, es cada columna la que se almacena de forma independiente. La diferencia más extrema la notamos cuándo, en un fichero de tipo CSV, queremos leer solamente una columna. A pesar de que solo queremos acceder a la información de una columna, por el tipo de formato, tenemos irremediablemente que leer todas las filas de la tabla. Cuando usamos formato Parquet, cada columna es accesible de forma independiente al resto. Como los datos en cada columna se espera que sean homogéneos (del mismo tipo), el formato parquet abre un sin fin de posibilidades a la hora de codificar, comprimir y optimizar el almacenamiento de los datos. De lo contrario, si lo que queremos es almacenar datos con el objetivo de leer muchas filas completas muy a menudo, el formato parquet nos penalizará en esas lecturas y no seremos eficientes ya que estamos utilizando orientación a columnas para leer filas.

Otra característica de Parquet es que es un formato de datos autodescriptivo que integra el esquema o la estructura dentro de los datos en sí. Es decir, propiedades (o metadatos) de los datos como el tipo (si es un número entero, un real o una cadena de texto), el número de valores, el tipo de compresión (los datos se pueden comprimir para ahorrar espacio), etc. están incluidas en el propio fichero junto con los datos como tal. De esta forma, cualquier programa que se utilice para leer los datos, puede acceder a estos metadatos, para por ejemplo, determinar sin ambigüedades, qué tipo de datos se espera leer en una columna determinada. A quien no le ha pasado de importar un CSV en un programa y encontrarse con que los datos están mal interpretados (números como textos, fechas como números, etc.)

Como hemos comentado, una de las contrapartidas de parquet frente a CSV es que no lo podemos abrir con tan solo usar un editor de texto. No obstante, existen múltiples herramientas para manejar ficheros parquet. Para ilustrar un ejemplo sencillo podemos utilizar parquet-tools en Python. En este ejemplo se puede ver el mismo conjunto de datos representado en formato parquet y csv.

Anteriormente mencionamos que otra de las características diferenciadoras de parquet frente a CSV es que el primero incluye el esquema de los datos en su interior. Para demostrarlo vamos a ejecutar el comando parquet-tools inspect test1.parquet.

A continuación vemos como la herramienta nos muestra el esquema de los datos que contiene el fichero organizado por columnas. Vemos, primeramente, un resumen del número de columnas, filas y versión del formato y el tamaño en bytes. Seguidamente, vemos el nombre de las columnas y a continuación, para cada columna, los datos más importantes, entre los que destacan el tipo de dato. Vemos cómo en la columna “one” se almacenan datos de tipo DOUBLE (apropiado para números reales), mientras que en la columna “two” los datos son de tipo BYTE_ARRAY que sirven para almacenar cadenas de textos.

############ file meta data ############

created_by: parquet-cpp version 1.5.1-SNAPSHOT

num_columns: 3

num_rows: 3

num_row_groups: 1

format_version: 1.0

serialized_size: 2226

############ Columns ############

one

two

three

############ Column(one) ############

name: one

path: one

max_definition_level: 1

max_repetition_level: 0

physical_type: DOUBLE

logical_type: None

converted_type (legacy): NONE

############ Column(two) ############

name: two

path: two

max_definition_level: 1

max_repetition_level: 0

physical_type: BYTE_ARRAY

logical_type: String

converted_type (legacy): UTF8

############ Column(three) ############

name: three

path: three

max_definition_level: 1

max_repetition_level: 0

physical_type: BOOLEAN

logical_type: None

converted_type (legacy): NONE

Resumen de las características técnicas de los ficheros parquet

- Apache Parquet está orientado a columnas y diseñado para brindar un almacenamiento en columnas eficiente en comparación con los tipos de ficheros basados en filas, como CSV.

- Los archivos Parquet se diseñaron teniendo en cuenta estructuras de datos anidadas complejas.

- Apache Parquet está diseñado para admitir esquemas de compresión y codificación muy eficientes.

- Apache Parquet genera menores costes de almacenamiento para archivos de datos y maximiza la efectividad de las consultas de datos con tecnologías cloud actuales como Amazon Athena, Redshift Spectrum, BigQuery y Azure Data Lakes.

- Licenciado bajo la licencia Apache y disponible para cualquier proyecto.

¿Para qué se usa Parquet?

Ahora que ya conocemos un poco más este formato de datos, veamos en qué ocasiones está más recomendado su uso. Sin lugar a dudas el reino de los parquets son los Data Lakes. Los Data Lakes son espacios de almacenamiento de ficheros distribuidos muy usados hoy en día para crear grandes repositorios de datos corporativos heterogéneos en la nube. A diferencia de un Data Warehouse, un Data Lake no tiene un motor de base de datos subyacente ni existe un modelo relacional de los datos. Pero veamos un ejemplo práctico de las ventajas de usar Parquet frente a CSV en este tipo de almacenamiento.

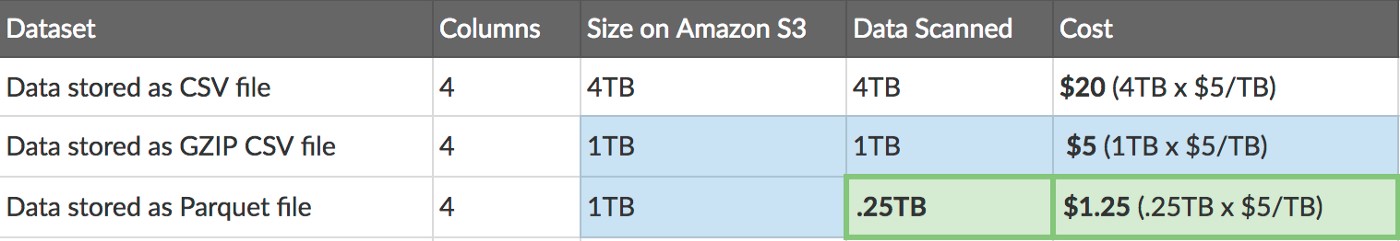

Supongamos que tenemos un conjunto de datos en formato de tabla (4 columnas) que representa las ventas históricas de una empresa durante los últimos 10 años. Si almacenamos esta tabla en formato CSV en Amazon Web Services S3 veremos que el tamaño que ocupa son 4TB. Si comprimimos este fichero con GZIP veremos que su tamaño se reduce a la cuarta parte (1TB). Cuando esa misma tabla la almacenamos en el mismo servicio (S3) en formato Parquet, vemos que ocupa lo mismo que el CSV comprimido. Pero además, cuándo queramos acceder a una parte de los datos - pongamos 1 sola columna - en el caso del fichero CSV (como hemos comentado anteriormente) tenemos que leer toda la tabla, puesto que es un almacenamiento por filas. Sin embargo, como el formato Parquet es un almacenamiento orientado a columnas, podemos leer una sola columna de forma independiente, accediendo solo a un cuarto de la información de la tabla, con el ahorro en tiempo y en coste que esto supone.

Post original de Thomas Spicer en Medium.com

Una vez que hemos entendido la eficiencia de la lectura de datos usando Parquet debido al acceso columnar de los mismos, podemos entender ahora por qué la mayoría de los servicios de almacenamiento y procesamiento de datos actuales son favorables a Parquet frente a CSV. Estos servicios en nube para procesamiento de datos son altamente populares entre los profesionales de datos puesto que el analista o científico de datos tan solo se tiene que preocupar del análisis. Son los servicios los que garantizan la accesibilidad y la eficiencia en la lectura.

Podría parecer que solo los casos de uso más sofisticados y analíticos usan Parquet como formato de referencia, pero son ya muchos equipos en las compañías, que empiezan a usar Parquet desde el origen para sus aplicaciones de Inteligencia de Negocio o Business Intelligence con herramientas para usuarios de negocio (no técnicos) como Power BI o Tableau.

Como conclusión, en este post hemos resaltado las características positivas del formato de datos parquet para el almacenamiento y procesado de datos cuando se trata de casos de uso analíticos (machine learning, inteligencia artificial) o con una marcada orientación a columnas (como por ejemplo series temporales). Como todo en la vida, no hay una solución perfecta para todas las situaciones. Existen y seguirán existiendo casos de uso orientados a filas así como existen formatos específicos para almacenar imágenes o mapas. En cualquier caso, no hay duda de que si tu aplicación encaja con las características de parquet, experimentarás mejoras importantes de eficiencia si optas por este formato frente a otros más convencionales como CSV. ¡Nos vemos en el próximo post!

Contenido elaborado por Alejandro Alija,experto en Transformación Digital e Innovación.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

En el mundo digital, los datos se convierten en un activo fundamental para las empresas. Gracias a ellos, pueden conocer mejor su entorno, negocio y competencia, y tomar decisiones oportunas en el momento adecuado.

En este contexto, no es de extrañar que cada vez más compañías busquen perfiles profesionales con capacidades digitales avanzadas. Trabajadores que sean capaces de buscar, encontrar, procesar y comunicar historias apasionantes sustentadas en los datos.

El informe "Cómo generar valor a partir de los datos: formatos, técnicas y herramientas para analizar datos abiertos" tiene como objetivo orientar a aquellos profesionales que deseen mejorar las competencias digitales destacadas anteriormente. En él se exploran diferentes técnicas para la extracción y el análisis descriptivo de los datos contenidos en los repositorios de datos abiertos.

El documento se estructura de la siguiente manera:

-

Formatos de datos. Explicación sobre los formatos de datos más habituales que se pueden encontrar en un repositorio de datos abiertos, prestando especial atención al csv y json.

-

Mecanismos de intercambio de datos a través de La Web. Recopilación de ejemplos prácticos que ilustran cómo extraer datos de interés de algunos de los repositorios con más populares de Internet.

-

Principales licencias. Se explican los factores que hay que tener en cuenta al trabajar con distintos tipos de licencias, orientando al lector hacia su identificación y reconocimiento.

-

Herramientas y tecnologías para el análisis de datos. Esta sección se vuelve ligeramente más técnica. En ella, se muestran diferentes ejemplos de extracción de información útil de los repositorios de datos abiertos, haciendo uso de algunos fragmentos cortos de código en diferentes lenguajes de programación.

-

Conclusiones. Se ofrece una visión tecnológica de futuro, con la mirada puesta en los más jóvenes, quienes constituirán la fuerza de trabajo del futuro.

El informe está orientado hacia un público general no especialista, aunque aquellos lectores familiarizados con el tratamiento e intercambio de datos en el mundo web se encontrarán con una lectura familiar y reconocible.

A continuación puedes descargar el texto completo, así como el resumen ejecutivo y una presentación resumen.

Nota: El código publicado pretende ser una guía para el lector, pero puede requerir de dependencias externas o configuraciones específicas para cada usuario que desee ejecutarlo.

Desde que se traspuso la Directiva 2003/98/CE del Parlamento Europeo y del Consejo, de 17 de noviembre de 2003, relativa a la reutilización de la información del sector público en la Ley 37/2007, de 16 de noviembre, sobre reutilización de la información del sector público, han sido numerosos los pasos dados para avanzar en la reutilización de información del sector público (RISP). Entre estos pasos, la publicación de reglamentación, guías, documentos explicativos y acciones de difusión y apoyo en materia RISP ha sido una constante.

Con el Real Decreto 1495/2011, de 24 de octubre, por el que se desarrolla la Ley 37/2007, de 16 de noviembre, sobre reutilización de la información del sector público, para el ámbito del sector público estatal, se realiza el desarrollo reglamentario de la Ley 37/2007 anteriormente citada. En este Real Decreto se establecen las obligaciones del sector público estatal, las modalidades de reutilización de los documentos reutilizables y el régimen aplicable a documentos reutilizables sujetos a derechos de propiedad intelectual o con datos personales. La evaluación de las actividades en materia de reutilización de la información pública se fija también en el Real Decreto, fijándose para ello indicadores.

Para ayudar a los órganos del sector público estatal en el cumplimiento del Real Decreto 1495/2011, varias han sido las labores llevadas a cabo desde su publicación. Algunas de ellas son las siguientes:

-

La publicación de la Guía de aplicación del Real Decreto 1495/2011, donde se describen las adaptaciones y tareas de mantenimiento necesarias en sus sistemas de información, los modelos o herramientas a emplear, así como una propuesta de esquema organizativo que apoye y dé soporte a la publicación y puesta a disposición de la información reutilizable.

-

La aprobación de la Norma Técnica de Interoperabilidad sobre reutilización de recursos de información, NTI RISP, donde se establecen normas comunes sobre la localización, descripción e identificación de los recursos de información para la reutilización, y la publicación de la Guía de aplicación de la Norma Técnica de Interoperabilidad de Reutilización de Recursos de Información, para ayudar la implementación de la NTI RISP.

-

Las jornadas para la formación y explicación de fundamentos RISP a órganos de las Administraciones

-

Apoyo a órganos del sector público estatal en la elaboración de sus planes RISP, en base a una metodología propuesta y afín a ello.

-

La publicación de los documentos: Funcionamiento del Catálogo de datos y Guía para la catalogación de conjuntos de datos para instruir sobre la publicación de conjuntos de datos en el Catálogo de datos.

-

Desarrollo de Herramientas para la construcción del espacio RISP, donde se explica los mecanismos para la federación de catálogos y la visualización de conjuntos de datos en un espacio web propio.

-

La recolección y publicación de las Consultas RISP al servicio de soporte a organismos.

-

Recolección de buenas prácticas en formatos para la publicación de información reutilizable en función del tipo.

En la actualidad, desde la iniciativa Aporta se continúa ofreciendo el servicio de Soporte a organismos.