Los datos poseen una naturaleza fluida y compleja: cambian, crecen y evolucionan constantemente, mostrando una volatilidad que los diferencia profundamente del código fuente. Para responder al desafío de gestionar esta evolución de manera fiable, hemos elaborado la nueva "Guía técnica: Control de versiones de datos".

Esta guía aborda una disciplina emergente que adapta los principios de la ingeniería de software al ecosistema de datos: el Control de Versiones de Datos (CVD). El documento no solo explora los fundamentos teóricos, sino que ofrece un enfoque práctico para resolver problemas críticos en la gestión de datos, como la reproducibilidad de modelos de Machine Learning, la trazabilidad en auditorías regulatorias y la colaboración eficiente en equipos distribuidos.

¿Por qué es necesaria una guía sobre versionado de datos?

Históricamente, la gestión de versiones de datos se ha realizado de forma manual (archivos con sufijos "_final_v2.csv"), un enfoque propenso a errores e insostenible en entornos profesionales. Aunque herramientas como Git han revolucionado el desarrollo de software, no están diseñadas para manejar eficientemente archivos de gran volumen o binarios, características intrínsecas de los conjuntos de datos.

Esta guía nace para cubrir esa brecha tecnológica y metodológica, explicando las diferencias fundamentales entre versionar código y versionar datos. El documento detalla cómo herramientas especializadas como DVC (Data Version Control) permiten gestionar el ciclo de vida de los datos con la misma rigurosidad que el código, garantizando que siempre se pueda responder a la pregunta: "¿Qué datos exactos se usaron para obtener este resultado?".

Estructura y contenidos

El documento sigue un enfoque progresivo, partiendo de los conceptos básicos hasta llegar a la implementación técnica, estructurándose en los siguientes bloques clave:

- Fundamentos del versionado: análisis de la problemática actual (el "modelo fantasma", auditorías imposibles) y definición de conceptos clave como snapshots, linaje de datos y checksums.

- Estrategias y metodologías: adaptación del versionado semántico (SemVer) a los conjuntos de datos, estrategias de almacenamiento (incremental vs. completo) y gestión de metadatos para garantizar la trazabilidad.

- Herramientas en la práctica: un análisis detallado de herramientas como DVC, Git LFS y soluciones nativas en la nube (AWS, Google Cloud, Azure), incluyendo una comparativa para elegir la más adecuada según el tamaño del equipo y los datos.

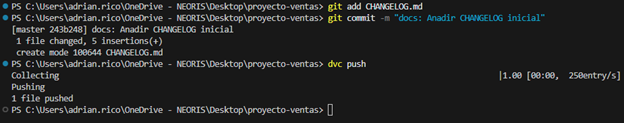

- Caso de estudio práctico: un tutorial paso a paso sobre cómo configurar un entorno local con DVC y Git, simulando un ciclo de vida real de datos: desde la generación y primer versionado, hasta la actualización, sincronización remota y recuperación de versiones anteriores (rollback).

- Gobernanza y mejores prácticas: recomendaciones sobre roles, políticas de retención y compliance para asegurar una implementación exitosa en la organización.

Figura 1: Ejemplo práctico de uso de commandos GIT y DVC incluido en la guía.

¿A quién va dirigida?

Esta guía está diseñada para un perfil técnico amplio dentro del sector público y privado: científicos de datos, ingenieros de datos, analistas y responsables de catálogos de datos.

Es especialmente útil para aquellos profesionales que buscan profesionalizar sus flujos de trabajo, garantizar la reproducibilidad científica de sus investigaciones o asegurar el cumplimiento normativo en sectores regulados. Aunque se recomienda tener conocimientos básicos de Git y línea de comandos, la guía incluye ejemplos prácticos y explicaciones detalladas que facilitan el aprendizaje.