Edalitics es un servicio de analítica en la nube que permite conectar datos, modelarlos, crear informes y cuadros de mando sin desplegar infraestructura propia y sin conocimientos técnicos. Está basado en EDA (Enterprise Data Analytics), la plataforma open source de la empresa Jortilles y se ofrece como Saas (Software as a Service), lo que reduce la complejidad técnica: el usuario accede a través de un navegador, selecciona sus fuentes y construye visualizaciones simplemente arrastrando y soltando, o bien mediante SQL.

Edalitics funciona como una plataforma de datos corporativos y públicos: puede conectarse a bases de datos y servicios web, y también admite ficheros CSV que el usuario sube para enriquecer su modelo. A partir de ahí, se crean dashboards, KPIs y alertas por correo, y se publican informes privados o públicos para distintos perfiles de decisión, con control de acceso y trazabilidad. Permite tener usuarios ilimitados, lo que la hace interesante para grandes organizaciones con muchos usuarios.

Es importante aclarar que Edalitics no incorpora datasets por defecto, sino que se integra con APIs o portales abiertos. Organismos como el Consell Comarcal del Baix Empordà han utilizado Edalitics para desplegar sus catálogos de datos abiertos.

Edalitics ofrece dos modalidades de uso:

- Versión en la nube (Cloud). La plataforma puede utilizarse directamente en la nube, con un modelo de tarifas escalonado. Esta versión es gratuita para organizaciones con un uso limitado. Las organizaciones con mayores exigencias de uso o volumen de datos pueden acceder a una versión de pago mediante una cuota mensual.

- Instalación en servidores propios (On-Premise). Para aquellas organizaciones que prefieran alojar Edalitics en su propia infraestructura, Jortilles ofrece:

- Asistencia en la instalación y configuración, adaptándose al entorno del cliente.

- Posibilidad de contratar un mantenimiento anual que incluye: soporte técnico directo del equipo desarrollador y acceso a actualizaciones y mejoras de forma proactiva, asegurando el buen funcionamiento y evolución de la plataforma.

Hace dos décadas no existían, pero en los últimos años, las redes sociales han adquirido una gran importancia en nuestras vidas. 29 millones de españoles usan de forma activa estos servicios, según los datos recopilados por EPData. De media, los usuarios pasan casi 2 horas al día conectados a ellas.

Estos datos convierten las redes sociales en una fuente de información fundamental para conocer nuestro entorno. Pero esta información no suele estar estructurada, sino que es necesario recurrir a herramientas de análisis de redes para poder analizar los datos y extraer conclusiones.

¿Qué es el análisis de redes?

El análisis de redes es el proceso de representar, analizar y extraer patrones con significado a partir de datos de medios sociales. Se trata de una aproximación metodológica y teórica para observar relaciones entre personas, países u organizaciones, de tal forma que se puedan describir comportamientos, estructuras o mecanismos de influencia.

La aplicación del análisis de redes ha aumentado en los últimos años debido a la proliferación de contextos relacionados y su utilización en múltiples disciplinas, como las matemáticas, la antropología, la salud, la sociología o el marketing, entre otras.

Las herramientas de análisis de redes permiten estudiar las características intrínsecas de las redes sociales como el grado de centralidad, la densidad, la intermediación o la cercanía entre miembros de una red. En este artículo vamos a recoger información sobre dos herramientas útiles para abordar esta tarea.

Dos ejemplos de herramientas de análisis de redes

Gephi:

Funcionalidad:

Gephi es un software de exploración y visualización interactiva para todo tipo de redes y gráficos complejos, dinámicos y jerárquicos, con una arquitectura modular.

Principales ventajas:

Para trabajar con Gephi no es necesario tener nociones de programación. Permite manejar redes de gran tamaño (hasta 50.000 nodos y un millón de aristas), mediante acciones de particionado y ordenación de los grafos. Además admite múltiples formatos de entrada, comunes en el análisis de redes, como GDF (GUESS), GML, Pajek NET, GEXF o GraphML, entre otros.

Otra de sus ventajas es que ofrece un conjunto de estadísticas asociadas al análisis de redes y permite la exportación de los informes y gráficos generados.

¿Quieres saber más?

- Materiales de ayuda: En la página de Gephi podemos encontrar tutoriales oficiales y documentos elaborados por la comunidad de usuarios, en formato texto o vídeo. Hay documentos en varios los idiomas, incluyendo este en español, que muestra un ejemplo práctico para que los usuarios lo recreen.

- Repositorio: En GitHub existen varios repositorios con recursos y herramientas para Gephi.

- Comunidad de usuarios: Podemos encontrar grupos de discusión sobre Gephi en Stackoverflow.

- Redes sociales: La cuenta de Twitter @Gephi comparte novedades y tendencias de una forma cercana. Gephi también dispone de perfil de compañía en LinkedIn.

NodeXL:

Funcionalidad:

NodeXL es una extensión de Microsoft Excel para el análisis y representación de grafos. Trabaja mostrando gráficos a partir de una lista dada de conexiones, aportando capacidades de análisis y descubrimiento de patrones y relación entre los datos.

Principales ventajas:

Esta herramienta presenta conexiones directas para analizar medios sociales en línea, e incluye conexiones para hacer consultas a las APIs de Twitter, Flickr y Youtube. Además, permite la automatización de las tareas.

¿Quieres saber más?

- Materiales de ayuda: En la web oficial de Social Media Research Foundation, la sede de NodeXL, hay un espacio para tutoriales en formato texto y video. Entre otras cuestiones, encontramos información sobre cómo trabajar con listas de usuarios de Twitter, crear una red semántica utilizando la función de análisis de texto o establecer redes de recomendación de vídeos en YouTube. En Slideshare también encontramos tutoriales como este de introducción. NodeXL también cuenta con un canal de Youtube y un blog con ejemplos de uso.

- Comunidad de usuarios: En la página web oficial existen foros donde los usuarios pueden consultar cualquier duda.

- Redes sociales: La cuenta de Twitter @smr_foundation informa sobre eventos, webinars y novedades de la herramienta. También puedes seguir al director de Social Media Research Foundation en LinkedIn, quien comparte contenidos de ayuda y casos de uso, entre otras cosas.

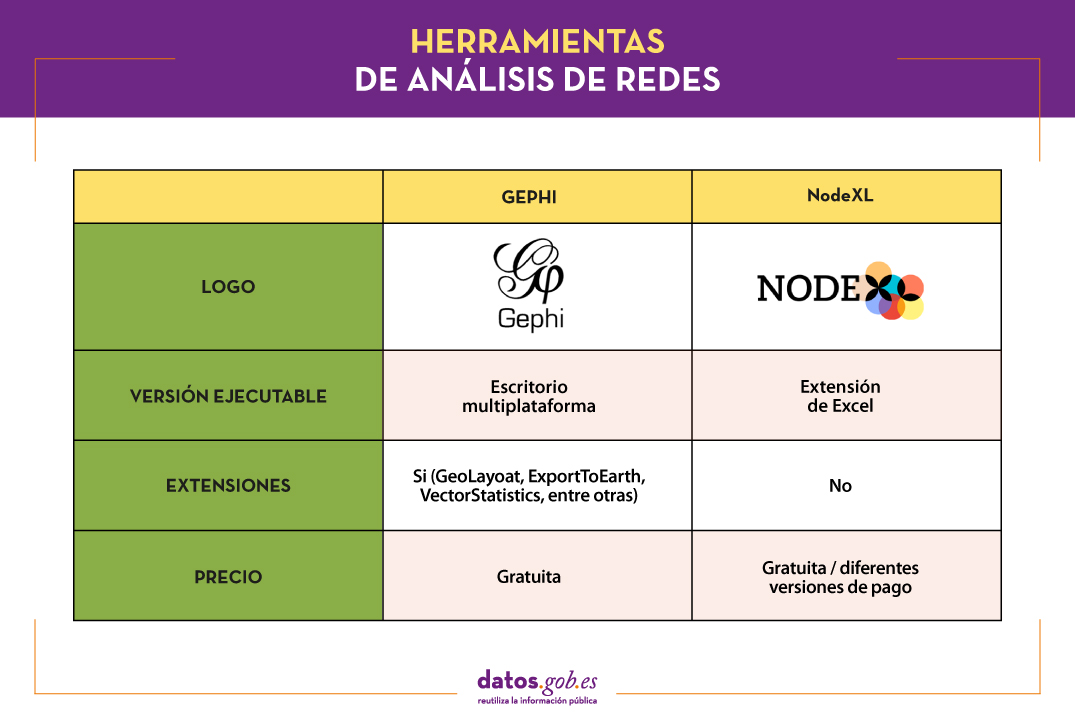

La siguiente tabla muestra un resumen de las herramientas mencionadas anteriormente:

Si quieres compartir tu experiencia con estas u otras herramientas, cuéntanoslo en la sección de comentarios.

Este artículo es el último de una serie donde se recogen distintas herramientas para el procesamiento, análisis y visualización de datos. Otros números de la serie son:

- Las herramientas de análisis de datos más populares

- Las herramientas de depuración y conversión de datos más populares

- Las herramientas de visualización de datos más populares

- Las librerías y APIs de visualización de datos más populares

- Las herramientas de visualización geoespacial más populares

Puedes encontrar información sobre todas ellas en el informe “Herramientas de procesado y visualización de datos”, recientemente actualizado.

Contenido elaborado por el equipo de datos.gob.es.

Los datos son un pilar fundamental en la toma de decisiones empresariales. Antes de tomar cualquier decisión, es necesario analizar la situación para comprender el contexto y vislumbrar las posibles alternativas. Y para ello es necesario presentar los datos de una manera clara y comprensible.

El análisis de datos no sirve de nada si no conseguimos que el resultado se entienda. Y la mejor manera de entender los datos es visualizarlos.

¿Qué es la visualización de datos?

La visualización de datos es una tarea vinculada al análisis de datos cuyo objetivo es la representación gráfica de la información subyacente de los datos. Para ello se utilizan desde elementos gráficos básicos, como gráficos de líneas, de dispersión o mapas de calor, hasta visualizaciones complejas configuradas sobre un dashboard o cuadro de mando. La visualización de datos permite detectar patrones, tendencias o datos anómalos, proyectar predicciones o comunicar inferencias derivada del análisis de datos, entre otras cuestiones.

Gracias a estas representaciones, personas sin conocimientos avanzados de analítica pueden interpretar y comprender los datos de una manera más sencilla y tomar decisiones en base a ellos en ámbitos tan dispares como el marketing, la salud, la ciencia, la economía, el periodismo o incluso el arte.

Podemos dividir las herramientas de visualización de datos, en dos categorías. Por un lado, las herramientas de visualización genéricas y por otro, las librerías y APIs de visualización, más versátiles, pero que necesitan el manejo de lenguajes de programación. En este artículo nos vamos a centrar en las primeras.

Principales ejemplos de herramientas de visualización de datos genéricas

Kibana

Funcionalidad:

Kibana es un software de código abierto que forma parte del paquete de productos Elastic Stack. Proporciona capacidades de visualización y exploración de datos indexados sobre el motor de analítica Elasticsearch.

Principales ventajas:

Su principal ventaja es que presenta la información de manera visual a través de dashboards personalizables, mediante la integración de filtros facetados por rangos, categorías de información, cobertura geoespacial o intervalos temporales, entre otros. Además, dispone de un catálogo de herramientas de desarrollo (Dev Tools) para interactuar con los datos almacenados en Elasticsearch.

¿Quieres saber más?

- Materiales de ayuda: En la propia web de Elastic encontramos este manual de usuario que incluye conceptos básicos para configurar Kibana, cómo crear y personalizar los dashboards o cómo interactuar con las API de Kibana, entre otros. Elastic también ofrece vídeos cortos en su canal de Youtube y organiza, de manera periódica, webinars donde se explican diversos aspectos y casos de uso en Kibana.

- Repositorio: En este Github tienes distintos recursos para su configuración, incluyendo pluggins, tests y ejemplos.

- Comunidad de usuarios: Existe una comunidad de usuarios oficial en su página web, aunque también puedes encontrar grupos de discusión en Stackoverflow.

- Redes sociales: Puedes seguir la cuenta de Twitter @elastic para estar al día de las novedades de Kibana y descubrir experiencias de uso, o unirte a su grupo de LinkedIn.

Tableau Public

Funcionalidad:

Tableau Public es una herramienta diseñada para la realización de visualizaciones combinando una interfaz gráfica con elementos habituales de las herramientas de Bussiness Integillence, como el modelo de organización variable mediante el uso de dimensiones y la conexión con bases de datos o datasets.

Principales ventajas:

Destaca por su interfaz gráfica, eficiente y rápida, y por su integración sencilla de bases de datos u hojas de cálculo de cualquier tamaño. Además, permite la combinación de diversas fuentes de datos en una sola vista.

Como punto negativo, para poder usar la versión gratuita, tanto los datos como las visualizaciones deben ser publicados en su web de manera pública, eliminando la confidencialidad de la información.

¿Quieres saber más?

- Materiales de ayuda: Tableau ofrece un manual con 8 pasos para empezar a usar Tableau Desktop, que se incluye desde cómo conectarse a los datos hasta cómo compartir los hallazgos. En la web de Tableau también puedes encontrar tutoriales, una galería de visualizaciones, recursos para usuarios (como podcast o concursos) y un blog con artículos relacionados.

- Comunidad de usuarios: En el foro oficial de Tableau puedes encontrar más de 450 grupos de usuarios y respuestas a más de 195.000 cuestiones.

- Redes sociales: En la cuenta de Twitter @tableaupublic se incluyen ejemplos de visualizaciones, experiencias e información sobre novedades. También hay disponible un grupo de LinkedIn.

SpagoBI (Knowage)

Funcionalidad:

SpagoBI (actualmente llamada Knowage) es una plataforma de código abierto diseñada principalmente para aplicaciones de Inteligencia de negocios. Ofrece soluciones para la presentación de informes, análisis multidimensional, minería de datos, dashboards y consultas ad-hoc.

Principales ventajas:

SpagoBI permite crear informes personalizables y exportable en diferentes formatos (HTML, PDF, XLS, XML, TXT, CSV y RTF) que pueden contener tablas, tablas cruzadas, gráficos interactivos y texto.

¿Quieres saber más?

- Materiales de ayuda: En este documento puedes encontrar un manual de instalación, un manual de administración, una guía de usuario e información sobre las distintas funcionalidades. En su canal de youtube puedes encontrar distintas listas de reproducción con historias de éxito, ejemplos de visualizaciones, tutoriales sobre distintas funcionalidades o webinars, entre otros. En el caso de los webinars, también puedes acceder a ellos desde su página web, donde se incluye la agenda con las próximas citas.

- Repositorio: En Github hay distintos repositorios con material de interés para los usuarios de SpagoBI.

- Comunidad de usuarios: Puedes encontrar distintas preguntas planteadas por los usuarios -y sus respuestas- en Stackoverflow.

- Redes sociales: La comunidad de usuarios también tiene a su disposición un grupo de LinkedIn. En Twitter, conviven los canales @SpagoBI y @knowage_suite, que informan de las novedades y muestran ejemplos de trabajos realizado con esta herramienta.

Grafana

Funcionalidad:

Grafana permite crear visualizaciones interactivas y dinámicas. Originalmente empezó siendo un componente de Kibana, pero en la actualidad son herramientas completamente independientes.

Principales ventajas:

Esta herramienta permite a los usuarios interactuar, intercambiando datos o dashboards. Además, integra diferentes bases de datos como: PostgreSQL, MySQL y Elasticsearch, de las que se puede obtener métricas, filtrar datos o realizar anotaciones en tiempo real.

¿Quieres saber más?

- Materiales de ayuda: En la web de Grafana hay múltiple información sobre cómo instalar esta herramienta, crear un dashboard o gestionar alertas. Además cuentan con un blog, así como con webinars y videos, también disponible en su canal de Youtube.

- Repositorio: Desde este GitHub puedes descargar paquetes y recursos, como plugins.

- Comunidad de usuarios: Al igual que en algunos de los casos anteriores, encontramos una comunidad oficial en la propia web de Grafana, y comunidades informales en Gitter y Stackoverflow.

- Redes sociales: La cuenta de Twitter @grafana muestra ejemplos de uso y ayuda a difundir las novedades resaltadas en el blog. Los usuarios también se pueden unir a su grupo de LinkedIn.

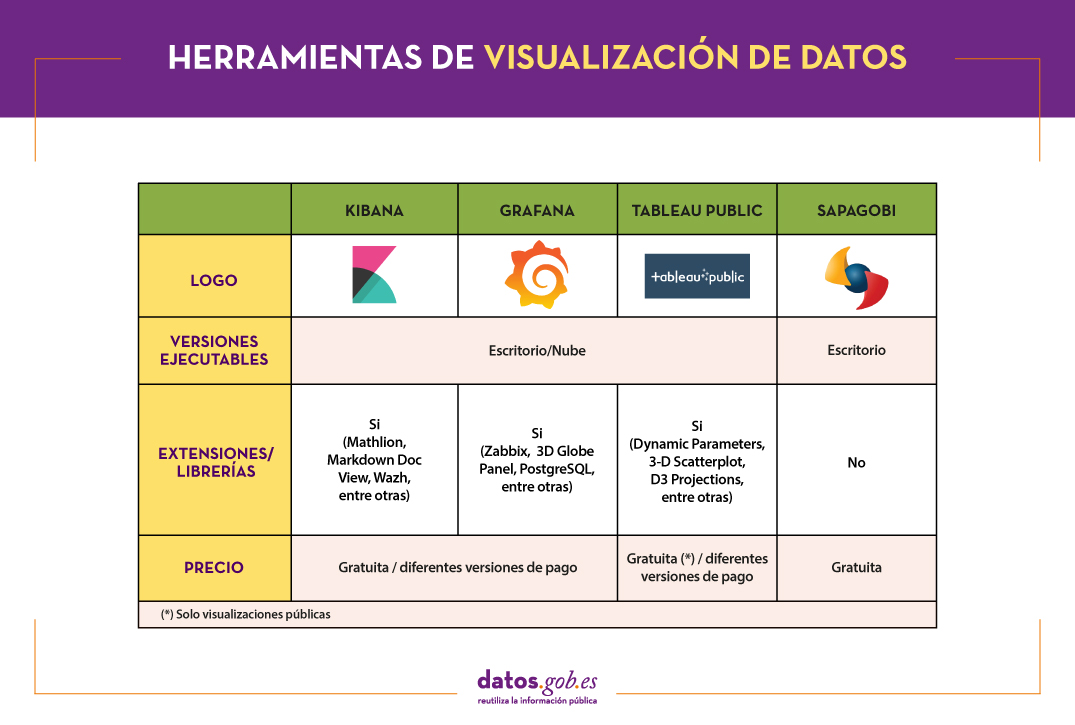

La siguiente tabla muestra un resumen de las herramientas mencionadas anteriormente:

Estos son solo 4 ejemplos de herramientas populares de visualización de datos. Próximamente pondremos a tu disposición un artículo con ejemplos de librerías y APIs de visualización. Te invitamos a compartir tu experiencia con estas u otras herramientas en los comentarios.

Si quieres saber más sobre las distintas fases del procesamiento de los datos, puedes ver el informe completo “Herramientas de procesado y visualización de datos”, recientemente actualizado. Además, tienes a tu disposición los siguientes artículos monográficos:

- Las herramientas de análisis de datos más populares

- Las herramientas de depuración y conversión de datos más populares

- Las librerías y APIs de visualización de datos más populares

- Las herramientas de visualización geoespacial más populares

- Las herramientas de análisis de redes más populares

Contenido elaborado por el equipo de datos.gob.es.

El análisis de datos es un proceso que nos permite obtener conocimiento de la información subyacente de los datos con el propósito de extraer conclusiones que permitan tomar decisiones informadas. Sin la analítica de datos, empresas y organizaciones se encuentran limitadas a la hora de examinar sus resultados y determinar la dirección a seguir para tener mayores probabilidades de éxito.

Tipos de analítica

Dentro del campo de la analítica encontramos distintos procesos que tratan de dar respuesta al pasado, presente y futuro de nuestras actividades:

- Análisis exploratorio, que somete a los datos a un tratamiento estadístico, para determinar por qué ha ocurrido un determinado evento.

- Análisis descriptivo, que explora los datos desde diferentes perspectivas para saber qué sucedió.

- Análisis predictivo, que permite predecir valores futuros de las variables de interés para conocer qué sucederá.

- Análisis prescriptivo, que ofrece recomendaciones al testear las variables del entorno y sugerir aquellas con mayor probabilidad de generar un resultado positivo.

En este artículo se recoge una selección de herramientas más populares de análisis de datos que te permitirán realizar estas tareas, divididas en base a dos públicos objetivos:

- Herramientas que no implican realizar tareas de programación, dirigidas a usuarios sin conocimientos técnicos avanzados.

- Herramientas que presentan una mayor versatilidad, pero necesitan el manejo de lenguajes de programación, por lo que están dirigidas a usuarios con estos conocimientos.

Es conveniente recordar que antes de realizar cualquier análisis de este tipo es necesario transformar los datos que utilicemos para que tengan la misma estructura y formato, libres de errores, algo que ya vimos en el artículo Herramientas de depuración y conversión de datos.

Herramientas de análisis de datos para no programadores

WEKA

Funcionalidad:

WEKA es un software multiplataforma de aprendizaje automático y minería de datos. Se puede acceder a sus funcionalidades a través de una interfaz gráfica, una línea de comandos o una API de Java.

Principales ventajas:

Una de sus principales ventajas es que contiene una gran cantidad de herramientas integradas para tareas estándar de aprendizaje automático y que permite el acceso a otras herramientas como son scikit-learn, R y Deeplearning.

¿Quieres saber más?

- Materiales de ayuda: Como apéndice al libro Data Mining: Practical Machine Learning: tools and techniques, encontramos este manual de WEKA que nos acerca a sus paneles y funcionalidades. Incluye métodos para los principales problemas de minería de datos: regresión, clasificación, clustering, reglas de asociación y selección de atributos. También tenemos a nuestra disposición en la red este manual y estos tutoriales elaborado por la Universidad de Waikato, entidad desarrolladora de la herramienta, que también ha puesto en marcha un blog sobre la materia.

- Repositorio: El código fuente oficial de WEKA está disponible en esta URL. También puedes acceder a ella desde este repositorio Github, así como a distintos paquetes o herramientas.

- Comunidad de usuarios: Puedes encontrar grupos de usuarios en Stackoverflow.

KNIME

Funcionalidad:

KNIME es un software de minería de datos, que permite el análisis de datos y la realización de visualizaciones a través de una interfaz gráfica.

Principales ventajas:

La interfaz gráfica sobre las que se modelan los flujos de análisis de datos utiliza nodos, que representan los diferentes algoritmos y flechas que muestran el flujo de los datos en el pipeline de procesamiento. Además, permite incorporar código desarrollado en R y Python, así como la interacción con WEKA.

¿Quieres saber más?

- Materiales de ayuda: En la propia web de KNIME puedes encontrar distintos documentos de ayuda, que te guían en su instalación, la creación de flujos de trabajo o el uso de nodos. Además, en su canal de Youtube puedes encontrar múltiples vídeos, incluyendo listas de reproducción con aspectos básicos para usuarios que se enfrentan a esta herramienta por primera vez.

- Repositorio: En GitHub se proporcionan herramientas para configurar el SDK (Kit de desarrollo de software, en sus siglas en inglés) de KNIME, para que puedas trabajar con el código fuente de las extensiones o desarrollar propias.

- Comunidad de usuarios: Los usuarios de KNIME tienen a su disposición grupos para resolver dudas en Gitter y Stackoverflow, así como un foro de discusión en la propia web de Knime.

- Redes sociales: Puedes seguir la cuenta de Twitter @knime y su perfil de LinkedIn para estar al día de las novedades de KNIME y de los eventos o charlas relacionados.

ORANGE

Funcionalidad:

Orange es un software abierto de aprendizaje automático y minería de datos, similar a Knime.

Principales ventajas:

Orange crea los análisis y visualizaciones de datos utilizando el paradigma drag and drop (arrastrar y soltar) a partir de un catálogo de widgets que representan diferentes tareas. Además, puede ser instalado como una librería de Python.

¿Quieres saber más?

- Materiales de ayuda: En este caso destacamos dos libros. En primer lugar, Introducción a la minería de datos con Orange, que recoge los flujos de trabajo y visualizaciones del curso on Introduction to Data Mining del propio Orange. En segundo, Orange Data Mining LibraryDocumentation, una ligera introducción al scripting en Orange. También puedes encontrar video tutoriales, en el canal de Youtube Orange Data Mining.

- Repositorio: Desde este GitHub puedes descargar los recursos necesarios para su instalación.

- Comunidad de usuarios: En Gitter, StackExchange y Stackoverflow los usuarios han creado espacios donde plantear dudas y contar experiencias.

- Redes sociales: En el perfil de twitter @OrangeDataMiner y su cuenta de LinkedIn se recogen informes, eventos, casos de uso y noticias relacionadas con esta herramienta.

Herramientas de análisis de datos para programadores

R (The R Project for statistical computing)

Funcionalidad:

R es un lenguaje de programación orientado a objetos e interpretado, creado inicialmente para computación estadística y creación de representaciones gráficas.

Principales ventajas:

R es uno de los lenguajes más usados en investigación científica y eso se debe a sus múltiples ventajas:

- Dispone de un entorno de programación, R-Studio.

- Está formado por un conjunto de funciones que pueden ampliarse fácilmente, mediante la instalación de librerías o la definición de funciones personalizadas.

- Está permanentemente actualizado debido a su extensa comunidad de usuarios y programadores, que desde sus inicios contribuyen al desarrollo de nuevas funciones, librerías y actualizaciones disponibles para todos los usuarios de forma libre y gratuita.

¿Quieres saber más?

- Materiales de ayuda: Debido a su popular, existen una gran cantidad de materiales de ayuda. Como ejemplo destacamos los libros R for Data Science y Manual de R. También puedes encontrar guías en el espacio web The R Manuals y los webinars que desde el propio R Studio organizan.

- Comunidad de usuarios: Existe un espacio de discusión en Stackoverflow. Además, a nivel España, encontramos dos grupos que realizan distintas actividades (hackathons, jornadas, cursos…) para promover el uso de R: la comunidad R-Hispano y R-Ladies. Puedes saber más sobre ellos en este artículo.

- Redes sociales: R cuenta con un grupo en LinkedIn con casi 150.000 miembros.

Python

Funcionalidad:

Python es un lenguaje de programación interpretado, dinámico, multiplataforma y multiparadigma, que soporta parcialmente programación orientada a objetos, programación estructurada, programación imperativa y programación funcional.

Principales ventajas:

Se trata de un lenguaje de programación cuya filosofía hace hincapié en ofrecer una sintaxis de código legible, fácil de usar y fácil de aprender. Además, permite la integración de librerías como Matplotlib, Bokeh, Numpy, Pandas o spaCy, para implementar funciones que posibilitan la realización de análisis estadísticos y gráficos interactivos complejos.

¿Quieres saber más?

- Materiales de ayuda: Al igual que ocurría con R, al ser u lenguaje muy popular encontramos gran cantidad de materiales y ayuda en la red como, los tutoriales The Python Tutorial y LearnPython.org, o el portal con videos Pyvideo, donde podrás encontrar diversos webinars.

- Repositorio: En Github puedes encontrar distintos repositorios relacionados con el lenguaje de programación Python.

- Comunidad de usuarios: Aquellos usuarios con preguntas pueden buscar la ayuda de personas en su misma situación en Stackoverflow o Gitter. En la propia web de Python también puedes encontrar un gran número de comunidades a nivel mundial.

- Redes sociales: El perfil oficial de twitter de la Python Software Foundation es @ThePSF. También hay grupo en Linkedin.

GNU Octave

Funcionalidad:

GNU Octave es un lenguaje de programación diseñado principalmente para resolver tareas de algebra computacional. Es la alternativa más conocida a la solución comercial MATLAB, pero de carácter libre y gratuito. Además, no dispone de una interfaz gráfica.

Principales ventajas:

GNU Octave dispone de potentes funciones matemáticas integradas (ecuaciones diferenciales, algebra lineal, cálculo con matrices) y pueden ampliarse con la incorporación de librerías, como Scientific Library, Dionysus o Bc. También dispone de un paquete index con numerosas extensiones que enriquecen la funcionalidad de la herramienta.

¿Quieres saber más?

- Materiales de ayuda: En este enlace tienes los apuntes del curso de GNU Octave de la Universidad Complutense de Madrid. En la propia web de GNU Octave también puedes encontrar manuales y en su perfil de youtube, video tutoriales.

- Repositorio: La comunidad de desarrolladores de GNU Octave tiene a su alcance distintos repositorios en Github con materiales de interés.

- Comunidad de usuarios: En Stackoverflow y en la web de GNU Octave hay un espacio para que los usuarios compartan opiniones y experiencia.

- Redes sociales: Puedes seguir las novedades ligadas a esta herramienta en la cuenta de Twitter @GnuOctave y este grupo de LinkedIn.

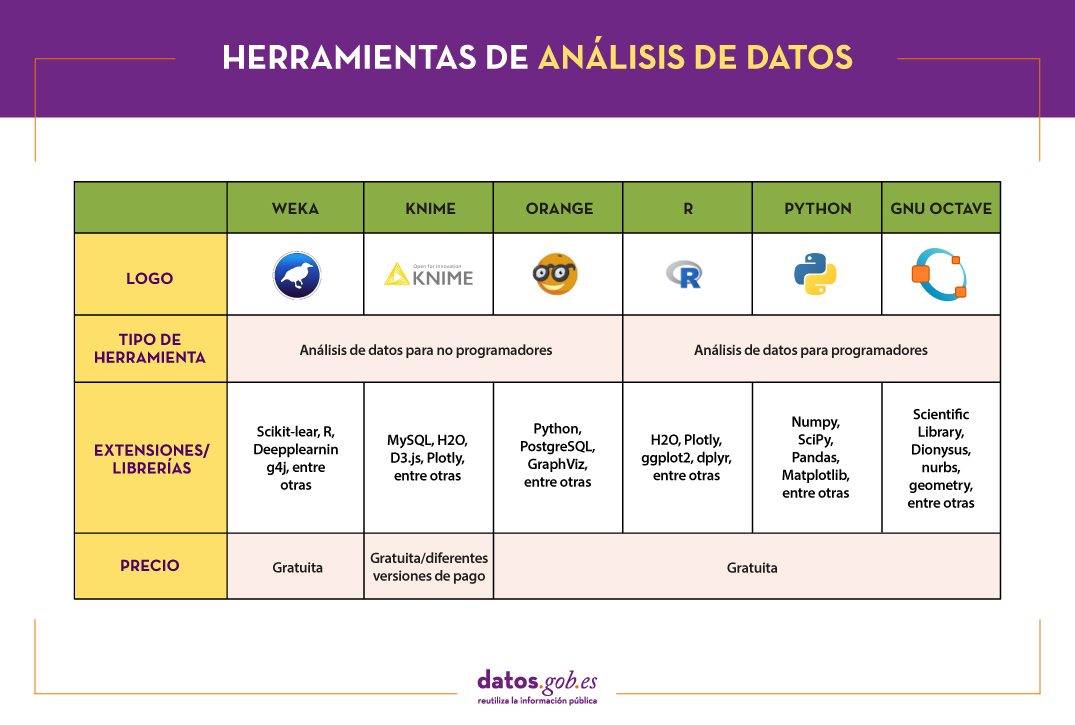

La siguiente tabla muestra un resumen de las herramientas mencionadas anteriormente:

Esta es solo una selección de herramientas de análisis de datos, pero hay muchas más. Te invitamos a compartir en los comentarios tu experiencia con estas u otras soluciones.

Para aquellos que quieran saber más sobre estas herramientas y otras que nos pueden ayudar durante las distintas fases del procesamiento de los datos, desde datos.gob.es ponemos a vuestra disposición el informe “Herramientas de procesado y visualización de datos “recientemente actualizado. Puedes ver el informe completo aquí. Puedes ver más herramientas relacionadas con este campo en los siguientes monográficos:

- Las herramientas de depuración y conversión de datos más populares

- Las herramientas de visualización de datos más populares

- Las librerías y APIs de visualización de datos más populares

- Las herramientas de visualización geoespacial más populares

- Las herramientas de análisis de redes más populares

Contenido elaborado por el equipo de datos.gob.es.

A la hora de realizar un proyecto de análisis de datos, lo habitual es trabajar con distintas fuentes, que en muchas ocasiones incluyen datasets con formatos y estructuras heterogéneas que no siempre comparten la misma calidad. Por ello, una de las primeras fases en cualquier proceso de análisis de datos es la conocida como depuración de datos o data cleaning.

¿Qué es la depuración de datos?

Cuando hablamos de depuración de datos nos referimos al conjunto de procesos necesarios para la preparación y transformación de datos procedentes de distintas fuentes para su análisis. Fruto de estos procesos se genera una estructura homogénea, libre de errores y en el formato adecuado, que será procesable en las posteriores etapas de análisis. A este conjunto de datos resultante se le conoce como vista minable de datos.

La depuración es esencial en el procesado de los datos, ya que los estandariza y los formatea antes de introducirlos en el sistema de destino, de tal forma que podamos trabajar con ellos de manera apropiada.

Dentro de los distintos procesos que conforman la fase de depuración de datos se incluye la conversión de los mismos, que supone la transformación de los datos a un formato concreto. De esta forma pueden ser utilizados por herramientas que solo aceptan determinados formatos.

En el mercado encontramos muchas herramientas de depuración de datos que también realizan su conversión a otros formatos, aunque igualmente existen herramientas que realizan cada una de estas tareas de manera exclusiva. A continuación, se recogen algunos ejemplos seleccionados en fase a su popularidad, aunque te invitamos a dejar en comentarios cualquier mención a otras herramientas que sean de tu interés.

Principales ejemplos de herramientas de depuración de datos

Dos de las herramientas más utilizadas en el campo de la depuración de datos son Open Refine y Talend Open Studio.

OpenRefine

Funcionalidad:

OpenRefine es una herramienta gratuita, que busca mejorar la calidad y estructura de los datos corrigiendo errores comunes como duplicidades de los datos, datos incompletos o inconsistencias. Gracias a ella los usuarios pueden organizar, limpiar, aplicar transformaciones, convertir en diferentes formatos y enriquecer los datos mediante el uso de servicios web y otras fuentes externas de datos.

Principales ventajas:

Una de sus principales ventajas es que utiliza el lenguaje GREL (Google Refine Expression Languaje), que permite realizar tareas de depuración avanzadas aplicando un importante número de funciones utilizando expresiones regulares. Además, permite incorporar extensiones adicionales mediante el acceso a funciones para georreferenciar información, vincular datos de la DBpedia u otras fuentes, generando datos enlazados en RDF.

¿Quieres saber más?

- Materiales de ayuda: En este manual de usuario se recorren todos los aspectos de la configuración y el uso de Open Refine 3.4.1, incluidas todas las funciones y características de la interfaz y esta cuenta de Youtube distintos video-tutoriales.

- Repositorio: En este GitHub se encuentran los recursos necesarios para que puedas operar OpenRefine desde Mac OS, Linux y Windows.

- Comunidad de usuarios: Los usuarios de OpenRefine pueden encontrar grupos de discusión en Google, Gitter y Stackoverflow.

- Redes sociales: En la cuenta de Twitter de @OpenRefine puedes encontrar vídeos, guías, información sobre las últimas novedades o próximos eventos relacionados con OpenRefine.

Talend Open Studio

Funcionalidad:

Talend Open Studio es una solución de código abierto que integra un conjunto de herramientas ETL (Extraer, Transformar y Cargar) diseñadas para extraer, depurar y transformar conjuntos de datos para su posterior análisis. Como resultado genera código estandarizado en Perl y Java que puede ser reutilizado en diferentes proyectos.

Principales ventajas:

Esta herramienta destaca por su interfaz intuitiva basada en la programación por componentes, una técnica que consiste en concatenar procesos con diversas funcionalidades mediante flujos de entrada y salida.

¿Quieres saber más?

- Materiales de ayuda: En la propia web de Talend puedes encontrar distintos manuales de usuario y tutoriales para descubrir Talend Studio y su interfaz, y crear un proyecto, junto con sencillos trabajos de ejemplo.

- Repositorio: Este GitHub contiene los archivos fuente de Talend Open Studio, los cuales archivos deben utilizarse junto con el código común contenido en tcommon-studio-se.

- Comunidad de usuarios: En Stackoverflow existen canales donde usuarios cuentas su experiencia y plantean distintas dudas.

- Redes sociales: Talend Open Studio cuenta con una página de LinkedIn y el perfil @Talend en Twitter, donde comparten novedades, experiencias y casos de uso, entre otros.

Principales ejemplos de Herramientas de conversión de datos

En el caso de la conversión de datos, destacan por su popularidad Mr Data Converter, Beautify Converters y Tabula.

Mr Data Converter

Funcionalidad:

Mr Data Converter es una aplicación web que permite convertir datos que se encuentran en formato CSV o Excel a otros formatos como CSV, JSON, HTML y XML de manera sencilla.

Principales ventajas:

Uno de sus puntos fuertes es que los datos se incorporan copiando y pegando sobre la interfaz de la aplicación, sin necesidad de subir ningún archivo. Lo mismo sucede a la hora de exportar, donde basta con copiar y pegar el código generado. En el lado negativo de la balanza, encontramos una limitación en el tamaño máximo de los datos, que no deben superar los 300 MB.

¿Quieres saber más?

- Repositorio: Puedes encontrar información sobre la licencia y distintos materiales en este GitHub.

Beautify Converters

Funcionalidad:

Beautify Converters es una aplicación web, que permite convertir datos a formatos JSON, SQL, CSV o Excel, entre otros. Pertenece a la colección de herramientas online gratuitas de Beautify Tools.

Principales ventajas:

Al igual que sucedía con Mr Data Converter, el usuario puede incorporar los datos copiando y pegando sobre la interfaz de la aplicación. También se puede realizar esta acción subiendo el archivo desde un equipo local. A diferencia de la herramienta anterior, admite un número significativamente mayor de formatos, SQL, YAML o RSS.

¿Quieres saber más?

- Repositorio: En este repositorio GitHub tienes información sobre la licencia y el resto de herramientas de la colección Beautify Tools.

Tabula

Funcionalidad:

Tabula permite extraer tablas de informes PDF -excepto en aquellos que son solo imagen-, en formatos reutilizables por herramientas de análisis y visualización de datos.

Principales ventajas:

Su principal ventaja es una interfaz muy sencilla. Únicamente será necesario subir el PDF, seleccionar las tablas que queramos extraer y finalmente seleccionar el formato deseado, Excel, CSV o JSON.

¿Quieres saber más?

- Materiales de ayuda: La Junta de Andalucía ha desarrollado este tutorial donde cuenta cómo subir un archivo PDF a Tabula y extraer los datos tabulares en formato CSV, listos para su uso en hojas de cálculo. El proceso lo ejemplifican con el conjunto de datos Calidad sanitaria de las aguas de baño.

- Repositorio: Puedes descargar los materiales desde este enlace o GitHub.

- Redes sociales: La cuenta @TabulaPDF, aunque no está muy actualizada, ofrece, entre otros, información sobre corrección de errores y mantenimiento, guías y comentarios de usuarios que utilizan esta herramienta.

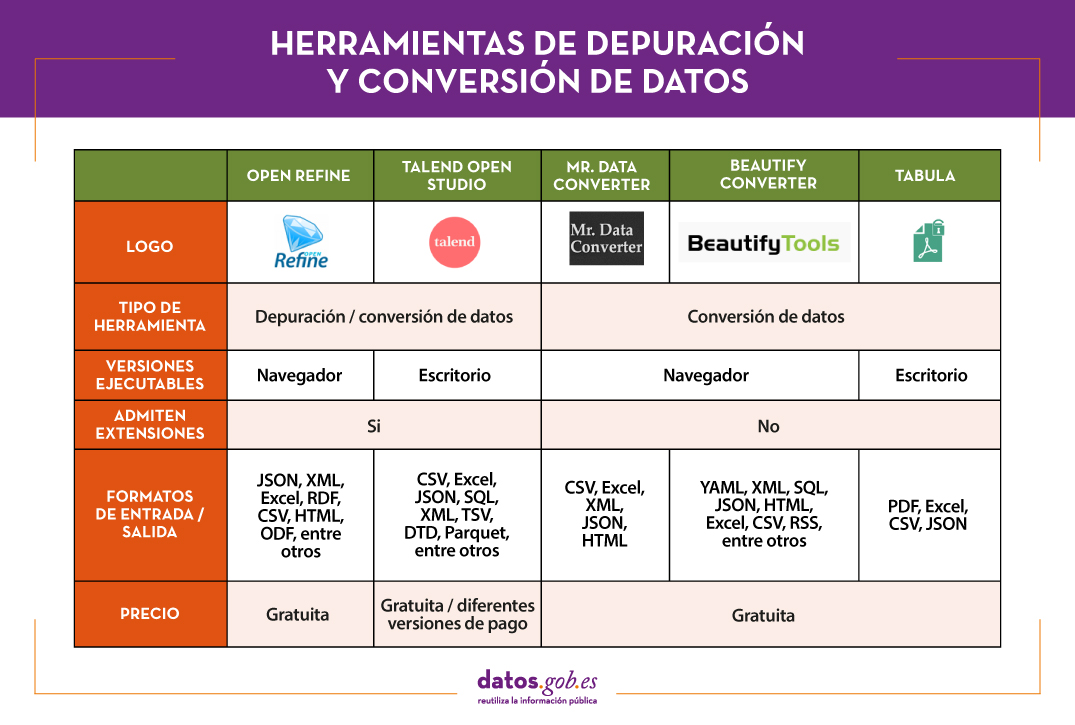

La siguiente tabla muestra un resumen de las herramientas mencionadas anteriormente:

La adecuación y conversión de los datos puede consumir una gran cantidad de recursos, económicos y temporales, de cualquier proyecto. Este tipo de herramientas ayudan a realizar estas actividades con agilidad y eficiencia, liberando a los científicos de datos para poder centrarse en otras actividades.

Para aquellos que quieran saber más sobre estas herramientas y otras que nos pueden ayudar durante las distintas fases del procesamiento de los datos, desde datos.gob.es ponemos a vuestra disposición el informe “Herramientas de procesado y visualización de datos “recientemente actualizado. Puedes ver el informe completo aquí. Puedes ver más herramientas relacionadas con este campo en los siguientes monográficos:

- Las herramientas de análisis de datos más populares

- Las herramientas de visualización de datos más populares

- Las librerías y APIs de visualización de datos más populares

- Las herramientas de visualización geoespacial más populares

- Las herramientas de análisis de redes más populares

Contenido elaborado por el equipo de datos.gob.es.

La ciencia de datos está llegando a todos los sectores, desde la agricultura a la sanidad, pasando por el turismo o el transporte. Y también a la cultura, como nos demuestra el DataLab de la Fundación Juan March, un laboratorio de conocimiento que no solo busca cuidar y difundir los contenidos de la Biblioteca, sino también extraer información de valor que pueda ser utilizada para optimizar procesos, tomar mejores decisiones o incluso crear nuevos servicios.

El DataLab de la Biblioteca de la Fundación Juan March nació en 2013, recogiendo las experiencias aprendidas en la Biblioteca de Datos del antiguo Centro de Estudios Avanzados en Ciencias Sociales (CEACS) del Instituto Juan March. DataLab nació en la Biblioteca de la Fundación Juan March para liderar la organización del conocimiento digital producido tanto por la propia Biblioteca como por el resto de las áreas de la Fundación, ocupándose de la estructura, la curación y la analítica de los datos digitales.

El reto era grande. La Fundación se había creado en 1955, y desde entonces había ido acumulando una valiosa colección integrada por contenidos de diversos formatos: vídeos, imágenes, audios, textos… A ello había que sumar la gran cantidad de conocimiento organizado y conservado para fines internos en los departamentos de la Fundación.

Para hacer frente a este reto, se apostó por un equipo multidisciplinar, que integrase a bibliotecarios, tecnólogos y matemáticos. Utilizando tecnologías y metodologías propias de la ciencia de datos, pudieron explorar formas nuevas de analizar y visualizar la información.

En concreto, el DataLab cuenta con 4 áreas de actuación:

- Curación de datos: Una de las principales tareas del DataLab es la gestión y el mantenimiento continúo de los repositorios digitales de la organización. Sus responsabilidades abarcan la clasificación, documentación, almacenamiento, integración y preservación digital de los datos. Actualmente dichos datos se difunden a través de portales temáticos de conocimiento (por ejemplo, centrados en la música española contemporánea o el teatro musical español) que atraen una media de 10.000 usuarios al mes, entre ellos investigadores y especialistas en ciencias sociales y en humanidades que buscan una fuente de inspiración para nuevos proyectos.

- Analítica: Una de novedades del DataLab es su apuesta por el uso de analíticas aplicadas a los datos culturales. Por un lado, emplean tecnologías de análisis en la curación de los datos, lo que da como resultado procesos automatizados que facilitan la clasificación de la información. Por otro, también explotan los datos analíticamente. Es decir, el DataLab funciona como un servicio transversal que proporciona inteligencia de negocio al resto de áreas de la Fundación, a través de la elaboración de cuadros de mando y la resolución de peticiones concretas de información y análisis.

- Infraestructura: Para poner en marcha un proyecto de esta envergadura, era necesario crear toda una infraestructura tecnológica que permitiera capturar datos de distintas fuentes, organizarlos y estructurarlos para después poder explotarlos en distintas herramientas y procesos. Por ello se encuentran en un proceso de desarrollo continuo en el que van afinando la captura, normalización, análisis y enriquecimiento de los datos. Todo ello se lleva a cabo en entornos especializados de Big Data en la nube.

- Innovación. Uno de los pilares fundamentales del DataLab es la experimentación con nuevas tecnologías que puedan aportar una capa de valor adicional a los datos. Por ejemplo, los procesos de captura de datos se enriquecen gracias a herramientas de Inteligencia Artificial, que realizan desde análisis de sentimiento de los comentarios vertidos en redes sociales hasta transcripciones de contenidos que se clasifican de manera automática.

Todo este trabajo ha dado como resultado un proyecto en continua evolución y crecimiento, que pone a disposición de los usuarios información de gran valor, demostrando el potencial de la ciencia de datos aplicado a la cultura.

Sociedad dedicada a la información comercial y tecnológica para empresas. Su principal misión es ayudar a empresas de todo el mundo, con soluciones de analítica avanzada y herramientas de integración de datos, a identificar oportunidades de negocio y posibles riesgos de impago a través de información empresarial, modelos predictivos y de propensión de compra; para que las áreas de finanzas, riesgos, marketing, ventas, compras y logística puedan:

- Encontrar nuevos y buenos clientes.

- Analizar la salud financiera de empresas y autónomos.

- Minimizar el riesgo de impago de operaciones comerciales.

Iberinform es filial de Crédito y Caución, operador global de seguro de crédito con presencia en más de 50 países.

Axesor es una empresa de servicios especialista en sistemas de gestión del riesgo de crédito, de conocimiento empresarial, financiero y de marketing.

- Una compañía del grupo Experian, empresa internacional de servicios de información global, con 17.800 personas que operan en 45 países

- Axesor cuenta con una oferta adaptada a toda clase de clientes, con una importante penetración en multinacionales.

Entre sus principales objetivos destacan:

- Maximizar el ahorro de empresas al reducir sus impagados y los periodos medios de cobro, optimizando sus recursos y tiempos de gestión, gracias a una gestión avanzada del riesgo de crédito comercial.

- Mejorar los Planes de Marketing y Expansión de empresas, a través de un exhaustivo análisis de su entorno y competencia, así como un mayor conocimiento de clientes.

- Optimizar los recursos de empresas, asumiendo sus trámites con las Administraciones Públicas.

Betterplace es una empresa tecnológica especializada en Location Intelligence cuya tecnología extrae y analiza información empresarial que, cruzada con datos públicos y privados, ayuda a los usuarios a optimizar tiempo y recursos en el día a día de su negocio. En sus propias palabras: "traducimos tablas a mapas para así guiar la toma de decisiones".

Clikalia es una proptech española que nació con el objetivo de convertir los procesos complejos y lentos de compra y venta de inmuebles, en procesos simples y rápidos aportando una liquidez inmediata a los vendedores comprando su casa en tan solo siete días. La clave de su éxito está en su fuerte apuesta por la tecnología y la digitalización de todos sus procesos.