¿Sabías que España creó en 2023 la primera agencia estatal dedicada específicamente a la supervisión de la inteligencia artificial (IA)? Anticipándose incluso al Reglamento Europeo en esta materia, la Agencia Española de Supervisión de Inteligencia Artificial (AESIA) nació con el objetivo de garantizar el uso ético y seguro de la IA, fomentando un desarrollo tecnológico responsable.

Entre sus principales funciones está asegurar que tanto entidades públicas como privadas cumplan con la normativa vigente. Para ello promueve buenas prácticas y asesora sobre el cumplimiento del marco regulatorio europeo, motivo por el cual recientemente ha publicado una serie de guías para asegurar la aplicación consistente de la regulación europea de IA.

En este post profundizaremos en qué es la AESIA y conoceremos detalles relevantes del contenido de las guías.

¿Qué es la AESIA y por qué es clave para el ecosistema de datos?

La AESIA nace en el marco del Eje 3 de la Estrategia Española de IA. Su creación responde a la necesidad de contar con una autoridad independiente que no solo supervise, sino que oriente el despliegue de sistemas algorítmicos en nuestra sociedad.

A diferencia de otros organismos puramente sancionadores, la AESIA está diseñada como un Think & Do Tank de inteligencia, es decir, una organización que investiga y propone soluciones. Su utilidad práctica se divide en tres vertientes:

- Seguridad jurídica: proporciona marcos claros para que las empresas, especialmente las pymes, sepan a qué atenerse al innovar.

- Referente internacional: actúa como el interlocutor español ante la Comisión Europea, asegurando que la voz de nuestro ecosistema tecnológico sea escuchada en la elaboración de estándares europeos.

- Confianza ciudadana: garantiza que los sistemas de IA utilizados en servicios públicos o áreas críticas respeten los derechos fundamentales, evitando sesgos y promoviendo la transparencia.

Desde datos.gob.es, siempre hemos defendido que el valor de los datos reside en su calidad y accesibilidad. La AESIA complementa esta visión asegurando que, una vez que los datos se transforman en modelos de IA, su uso sea responsable. Por ello, estas guías son una extensión natural de los recursos que publicamos habitualmente sobre gobernanza y apertura de datos.

Recursos para el uso de la IA: guías y checklist

La AESIA ha publicado recientemente unos materiales de apoyo a la implementación y el cumplimiento de la normativa europea de Inteligencia Artificial y sus obligaciones aplicables. Aunque no tienen carácter vinculante ni sustituyen ni desarrollan la normativa vigente, proporcionan recomendaciones prácticas alineadas con los requisitos regulatorios a la espera de que se aprueben las normas armonizadas de aplicación para todos los Estados miembros.

Son el resultado directo del piloto español de Sandbox Regulatorio de IA. Este entorno de pruebas permitió a desarrolladores y autoridades colaborar en un espacio controlado para entender cómo aplicar la normativa europea en casos de uso reales.

Es fundamental destacar que estos documentos se publican sin perjuicio de las guías técnicas que la Comisión Europea está elaborando. De hecho, España está sirviendo de "laboratorio" para Europa: las lecciones aprendidas aquí proporcionarán una base sólida al grupo de trabajo de la Comisión, asegurando una aplicación consistente de la regulación en todos los Estados miembros.

Las guías están diseñadas para ser una hoja de ruta completa, desde la concepción del sistema hasta su vigilancia una vez está en el mercado.

Figura 1. Guías de AESIA para cumplir con la regulación. Fuente: Agencia Española de la Supervisión de la IA

- 01. Introductoria al Reglamento de IA: ofrece una visión general sobre las obligaciones, los plazos de aplicación y los roles (proveedores, desplegadores, etc.). Es el punto de partida esencial para cualquier organización que desarrolle o despliegue sistemas de IA.

- 02. Práctica y ejemplos: aterriza los conceptos jurídicos en casos de uso cotidianos (por ejemplo, ¿es mi sistema de selección de personal una IA de alto riesgo?). Incluye árboles de decisión y un glosario de términos clave del artículo 3 del Reglamento, ayudando a determinar si un sistema específico está regulado, qué nivel de riesgo tiene y qué obligaciones son aplicables.

- 03. Evaluación de conformidad: explica los pasos técnicos necesarios para obtener el "sello" que permite comercializar un sistema de IA de alto riesgo, detallando los dos procedimientos posibles según los Anexos VI y VII del Reglamento como valuación basada en control interno o evaluación con intervención de organismo notificado.

- 04. Sistema de gestión de la calidad: define cómo las organizaciones deben estructurar sus procesos internos para mantener estándares constantes. Abarca la estrategia de cumplimiento regulatorio, técnicas y procedimientos de diseño, sistemas de examen y validación, entre otros.

- 05. Gestión de riesgos: es un manual sobre cómo identificar, evaluar y mitigar posibles impactos negativos del sistema durante todo su ciclo de vida.

- 06. Vigilancia humana: detalla los mecanismos para que las decisiones de la IA sean siempre supervisables por personas, evitando la "caja negra" tecnológica. Establece principios como comprensión de capacidades y limitaciones, interpretación de resultados, autoridad para no usar el sistema o anular decisiones.

- 07. Datos y gobernanza de datos: aborda las prácticas necesarias para entrenar, validar y testear modelos de IA asegurando que los conjuntos de datos sean relevantes, representativos, exactos y completos. Cubre procesos de gestión de datos (diseño, recogida, análisis, etiquetado, almacenamiento, etc.), detección y mitigación de sesgos, cumplimiento del Reglamento General de Protección de Datos, linaje de datos y documentación de hipótesis de diseño, siendo de especial interés para la comunidad de datos abiertos y científicos de datos.

- 08. Transparencia: establece cómo informar al usuario de que está interactuando con una IA y cómo explicar el razonamiento detrás de un resultado algorítmico.

- 09. Precisión: define métricas apropiadas según el tipo de sistema para garantizar que el modelo de IA cumple su objetivo.

- 10. Solidez: proporciona orientación técnica sobre cómo garantizar que los sistemas de IA funcionan de manera fiable y consistente en condiciones variables.

- 11. Ciberseguridad: instruye sobre protección contra amenazas específicas del ámbito de IA.

- 12. Registros: define las medidas para cumplir con las obligaciones de registro automático de eventos.

- 13. Vigilancia poscomercialización: documenta los procesos para ejecutar el plan de vigilancia, documentación y análisis de datos sobre el rendimiento del sistema durante toda su vida útil.

- 14. Gestión de incidentes: describe el procedimiento para notificar incidentes graves a las autoridades competentes.

- 15. Documentación técnica: establece la estructura completa que debe incluir la documentación técnica (proceso de desarrollo, datos de entrenamiento/validación/prueba, gestión de riesgos aplicada, rendimiento y métricas, supervisión humana, etc.).

- 16. Manual de checklist de Guías de requisitos: explica cómo utilizar las 13 checklists de autodiagnóstico que permiten realizar evaluación del cumplimiento, identificar brechas, diseñar planes de adaptación y priorizar acciones de mejora.

Todas las guías están disponibles aquí y tienen una estructura modular que se adapta a diferentes niveles de conocimiento y necesidades empresariales.

La herramienta de autodiagnóstico y sus ventajas

En paralelo, la AESIA publica un material que facilita la traducción de requisitos abstractos en preguntas concretas y verificables, proporcionando una herramienta práctica para la evaluación continua del grado de cumplimiento.

Se trata de listas de verificación que permiten a una entidad evaluar su nivel de cumplimiento de forma autónoma.

La utilización de estas checklists proporciona múltiples beneficios a las organizaciones. En primer lugar, facilitan la identificación temprana de brechas de cumplimiento, permitiendo a las organizaciones tomar medidas correctivas antes de la comercialización o puesta en servicio del sistema. También promueven un enfoque sistemático y estructurado del cumplimiento normativo. Al seguir la estructura de los artículos del Reglamento, garantizan que ningún requisito esencial quede sin evaluar.

Por otro lado, facilitan la comunicación entre equipos técnicos, jurídicos y de gestión, proporcionando un lenguaje común y una referencia compartida para discutir el cumplimiento normativo. Y, por último, las checklists sirven como base documental para demostrar la debida diligencia ante las autoridades supervisoras.

Debemos entender que estos documentos no son estáticos. Están sujetos a un proceso permanente de evaluación y revisión. En este sentido, la AESIA continúa desarrollando su capacidad operativa y ampliando sus herramientas de apoyo al cumplimiento.

Desde la plataforma de datos abiertos del Gobierno de España, te invitamos a explorar estos recursos. El desarrollo de la IA debe ir de la mano con datos bien gobernados y supervisión ética.

Los datos poseen una naturaleza fluida y compleja: cambian, crecen y evolucionan constantemente, mostrando una volatilidad que los diferencia profundamente del código fuente. Para responder al desafío de gestionar esta evolución de manera fiable, hemos elaborado la nueva "Guía técnica: Control de versiones de datos".

Esta guía aborda una disciplina emergente que adapta los principios de la ingeniería de software al ecosistema de datos: el Control de Versiones de Datos (CVD). El documento no solo explora los fundamentos teóricos, sino que ofrece un enfoque práctico para resolver problemas críticos en la gestión de datos, como la reproducibilidad de modelos de Machine Learning, la trazabilidad en auditorías regulatorias y la colaboración eficiente en equipos distribuidos.

¿Por qué es necesaria una guía sobre versionado de datos?

Históricamente, la gestión de versiones de datos se ha realizado de forma manual (archivos con sufijos "_final_v2.csv"), un enfoque propenso a errores e insostenible en entornos profesionales. Aunque herramientas como Git han revolucionado el desarrollo de software, no están diseñadas para manejar eficientemente archivos de gran volumen o binarios, características intrínsecas de los conjuntos de datos.

Esta guía nace para cubrir esa brecha tecnológica y metodológica, explicando las diferencias fundamentales entre versionar código y versionar datos. El documento detalla cómo herramientas especializadas como DVC (Data Version Control) permiten gestionar el ciclo de vida de los datos con la misma rigurosidad que el código, garantizando que siempre se pueda responder a la pregunta: "¿Qué datos exactos se usaron para obtener este resultado?".

Estructura y contenidos

El documento sigue un enfoque progresivo, partiendo de los conceptos básicos hasta llegar a la implementación técnica, estructurándose en los siguientes bloques clave:

- Fundamentos del versionado: análisis de la problemática actual (el "modelo fantasma", auditorías imposibles) y definición de conceptos clave como snapshots, linaje de datos y checksums.

- Estrategias y metodologías: adaptación del versionado semántico (SemVer) a los conjuntos de datos, estrategias de almacenamiento (incremental vs. completo) y gestión de metadatos para garantizar la trazabilidad.

- Herramientas en la práctica: un análisis detallado de herramientas como DVC, Git LFS y soluciones nativas en la nube (AWS, Google Cloud, Azure), incluyendo una comparativa para elegir la más adecuada según el tamaño del equipo y los datos.

- Caso de estudio práctico: un tutorial paso a paso sobre cómo configurar un entorno local con DVC y Git, simulando un ciclo de vida real de datos: desde la generación y primer versionado, hasta la actualización, sincronización remota y recuperación de versiones anteriores (rollback).

- Gobernanza y mejores prácticas: recomendaciones sobre roles, políticas de retención y compliance para asegurar una implementación exitosa en la organización.

Figura 1: Ejemplo práctico de uso de commandos GIT y DVC incluido en la guía.

¿A quién va dirigida?

Esta guía está diseñada para un perfil técnico amplio dentro del sector público y privado: científicos de datos, ingenieros de datos, analistas y responsables de catálogos de datos.

Es especialmente útil para aquellos profesionales que buscan profesionalizar sus flujos de trabajo, garantizar la reproducibilidad científica de sus investigaciones o asegurar el cumplimiento normativo en sectores regulados. Aunque se recomienda tener conocimientos básicos de Git y línea de comandos, la guía incluye ejemplos prácticos y explicaciones detalladas que facilitan el aprendizaje.

La futura nueva versión de la Norma Técnica de Interoperabilidad de Recursos de Información del Sector Público (NTI-RISP) incorpora DCAT-AP-ES como modelo de referencia para la descripción de conjuntos y servicios de datos. Esto supone un paso clave hacia una mayor interoperabilidad, calidad y alineación con los estándares europeos de datos.

Esta guía tiene como objetivo ayudar en su migración hacia este nuevo modelo. Está dirigida a responsables técnicos y gestores de catálogos de datos públicos que, sin disponer de experiencia avanzada en semántica o modelos de metadatos, necesitan actualizar su catálogo RDF para garantizar su conformidad con DCAT-AP-ES. Además, las pautas del documento también son aplicables para la migración desde otros modelos de metadatos basados en RDF, como perfiles locales, DCAT, DCAT-AP o adaptaciones sectoriales, ya que los principios y verificaciones fundamentales son comunes.

¿Por qué migrar a DCAT-AP-ES?

La Norma Técnica de Interoperabilidad de Recursos de Información del Sector Público constituye, desde 2013, el marco regulador en España para la gestión y apertura de los datos públicos. Alineada con el objetivo europeo y español de impulsar la economía del dato, la norma se ha actualizado con el fin de favorecer el intercambio de información a gran escala en entornos distribuidos y federados.

Esta actualización, que en el momento de publicación de la guía está en proceso de tramitación administrativa, incorpora un nuevo modelo de metadatos alineado con los estándares europeos más recientes: DCAT-AP-ES. Estos estándares facilitan la descripción homogénea de los conjuntos de datos y recursos de información reutilizables puestos a disposición pública. DCAT-AP-ES adopta las directrices del esquema europeo de intercambio de metadatos DCAT-AP (Data Catalog Vocabulary – Aplication Profile), promoviendo así la interoperabilidad entre catálogos nacionales y europeos.

Las ventajas de adoptar DCAT-AP-ES se resumen en:

- Interoperabilidad semántica y técnica: asegura que distintos catálogos puedan entenderse entre sí de forma automática.

- Alineación normativa: responde a los nuevos requisitos previstos en la NTI-RISP y alinea el catálogo con la Directiva (UE) 2019/1024 relativa a los datos abiertos y la reutilización de la información del sector público y el Reglamento de Ejecución (UE) 2023/138 por el que se establecen una lista de conjuntos de datos específicos de alto valor (High Value Dataset o HVD), facilitando la publicación de HVD y servicios de datos asociados.

- Mejora de la capacidad de encontrar los recursos: facilita la búsqueda, localización y reutilización de los conjuntos de datos mediante metadatos estandarizados y completos.

- Reducción de incidencias en la federación: minimiza errores y conflictos al integrar catálogos de distintas administraciones, garantizando la consistencia y la calidad en los procesos de interoperabilidad.

¿Qué ha cambiado en DCAT-AP-ES?

DCAT-AP-ES amplía y ordena el modelo anterior para hacerlo más interoperable, más preciso desde el punto de vista legal y más útil para el mantenimiento y la reutilización técnica de los catálogos de datos.

Los principales cambios son:

- En el catálogo: ahora es posible enlazar catálogos entre sí, registrar quién los creó, añadir una declaración de derechos complementaria a la licencia o describir cada entrada mediante registros.

- En los conjuntos de datos: se incorporan nuevas propiedades para cumplir la normativa sobre conjuntos de alto valor, dar soporte a la comunicación, documentar la procedencia y las relaciones entre recursos, gestionar versiones y describir la resolución espacial/temporal o el sitio web. Asimismo, se redefine la responsabilidad de la licencia, desplazando su declaración al nivel más adecuado.

- En las distribuciones: se amplían las opciones para indicar la disponibilidad planificada, la legislación, política de uso, la integridad, los formatos empaquetados, la URL directa de descarga, la licencia propia y el estado del ciclo de vida.

Un enfoque práctico y gradual

Muchos catálogos ya cumplen los requisitos establecidos en la versión de NTI-RISP de 2013. En estos casos, la migración a DCAT-AP-ES requiere un ajuste reducido, aunque la guía contempla también escenarios más complejos, siguiendo un enfoque progresivo y adaptable.

El documento distingue entre el cumplimiento mínimo indispensable y algunas ampliaciones que mejoran la calidad e interoperabilidad.

Se recomienda seguir una estrategia iterativa: partir del núcleo mínimo para asegurar continuidad operativa y, posteriormente, planificar la incorporación escalonada de elementos adicionales, como servicios de datos, contacto, legislación aplicable, categorización de HVD y metadatos contextuales. Este enfoque reduce riesgos, distribuye el esfuerzo de adaptación y favorece una transición ordenada.

Una vez realizados los primeros ajustes, el catálogo puede federarse tanto con el Catálogo Nacional, albergado en datos.gob.es, como con el Catálogo oficial de datos europeos, incrementado progresivamente la calidad y la interoperabilidad de los metadatos.

La guía constituye un material de apoyo técnico que facilita una transición básica, conforme a los requisitos mínimos de interoperabilidad. Además, complementa otros recursos de referencia, como la Guía técnica de implementación y modelo del perfil de aplicación DCAT-AP-ES, los ejemplos de implementación (Migración desde NIT-RISP a DCAT-AP-ES y Migración desde NTI-RISP a DCAT-AP-ES HVD) y las convenciones complementarias al modelo DCAT-AP-ES que definen reglas adicionales para abordar necesidades prácticas.

La ciencia de datos se ha consolidado como un pilar de la toma de decisiones basada en evidencias en sectores públicos y privados. En este contexto, surge la necesidad de una guía práctica y universal que trascienda modas tecnológicas y proporcione principios sólidos y aplicables. La presente guía ofrece un decálogo de buenas prácticas que acompaña al científico de datos a lo largo de todo el ciclo de vida de un proyecto, desde la conceptualización del problema hasta la evaluación ética del impacto.

- Comprender el problema antes de mirar los datos. La clave inicial es definir claramente el contexto, objetivos, restricciones e indicadores de éxito. Un framing sólido evita errores posteriores.

- Conocer los datos en profundidad. Más allá de las variables, implica analizar su origen, trazabilidad y posibles sesgos. La auditoría de datos es esencial para garantizar representatividad y fiabilidad.

- Cuidar la calidad. Sin datos limpios no hay ciencia. Técnicas de EDA, imputación, normalización y control de métricas de calidad permiten construir bases sólidas y reproducibles.

- Documentar y versionar. La reproducibilidad es condición científica. Notebooks, pipelines, control de versiones y prácticas de MLOps aseguran trazabilidad y replicabilidad de procesos y modelos.

- Elegir el modelo adecuado. No siempre gana la sofisticación: la decisión debe equilibrar rendimiento, interpretabilidad, costes y restricciones operativas.

- Medir con sentido. Las métricas deben alinearse con los objetivos. Validación cruzada, control del data drift y separación rigurosa de datos de entrenamiento, validación y test son imprescindibles para garantizar generalización.

- Visualizar para comunicar. La visualización no es un adorno, sino un lenguaje para comprender y persuadir. Storytelling con datos y diseño claro son herramientas críticas para conectar con audiencias diversas.

- Jugar en equipo. La ciencia de datos es colaborativa: requiere ingenieros de datos, expertos de dominio y responsables de negocio. El científico de datos debe actuar como facilitador y traductor entre lo técnico y lo estratégico.

- Mantenerse actualizado (y crítico). El ecosistema evoluciona constantemente. Es necesario combinar aprendizaje continuo con criterio selectivo, priorizando fundamentos sólidos frente a modas pasajeras.

- Ser ético. Los modelos tienen impacto real. Es imprescindible evaluar sesgos, proteger la privacidad, garantizar la explicabilidad y anticipar usos indebidos. La ética es brújula y condición de legitimidad.

Finalmente, el informe incluye un bonus-track sobre Python y R, destacando que ambos lenguajes son aliados complementarios: Python domina en producción y despliegue, mientras que R ofrece rigor estadístico y visualización avanzada. Conocer ambos multiplica la versatilidad del científico de datos.

El Decálogo del científico de datos constituye una guía práctica, atemporal y de aplicación transversal que ayuda a profesionales y organizaciones a convertir los datos en decisiones informadas, confiables y responsables. Su objetivo es reforzar la calidad técnica, la colaboración y la ética en una disciplina en plena expansión y con gran impacto social.

Contenido elaborado por Alejandro Alija, experto en Transformación Digital e Innovación. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su auto

Los datos abiertos son un combustible fundamental en la innovación digital contemporánea, creando ecosistemas de información que democratizan el acceso al conocimiento y potencian el desarrollo de soluciones tecnológicas avanzadas.

Sin embargo, la mera disponibilidad de datos no es suficiente. La construcción de ecosistemas robustos y sostenibles requiere marcos normativos claros, principios éticos sólidos y metodologías de gestión que garanticen tanto la innovación como la protección de derechos fundamentales. Por ello, la documentación especializada que orienta estos procesos se convierte en un recurso estratégico para gobiernos, organizaciones y empresas que buscan participar responsablemente en la economía digital.

En este post, recopilamos informes recientes, elaborados por organizaciones de referencia tanto del ámbito público como privado, que ofrecen estas orientaciones clave. Estos documentos no solo analizan los desafíos actuales de los ecosistemas de datos abiertos, sino que proporcionan herramientas prácticas y marcos de trabajo concretos para su implementación efectiva.

Estado y evolución del mercado del open data

Conocer cómo es y qué cambios ha habido en el ecosistema de los datos abiertos a nivel europeo y nacional es importante para tomar decisiones informadas y adaptarse a las necesidades de la industria. En este sentido, la Comisión Europea publica, periódicamente, un informe sobre los mercados de datos, que se actualiza regularmente. La última versión es de diciembre de 2024, aunque periódicamente se van publicando casos de uso que ejemplifican el potencial de los datos en Europa (el último de febrero de 2025).

Por otro lado, desde una perspectiva regulatoria europea, el último informe anual sobre la implementación de la Ley de Mercados Digitales (DMA) aborda una visión integral de las medidas adoptadas para garantizar la equidad y competitividad en el sector digital. Este documento es interesante para comprender cómo se está configurando el marco normativo que afecta directamente a los ecosistemas de datos abiertos.

A nivel nacional, el informe sectorial de ASEDIE sobre la "Economía del Dato en su ámbito infomediario" 2025 proporciona evidencia cuantitativa del valor económico generado por los ecosistemas de datos abiertos en España.

La importancia de los datos abiertos en la IA

Está claro que la intersección entre datos abiertos e inteligencia artificial es una realidad que plantea desafíos éticos y normativos complejos que requieren respuestas colaborativas y multisectoriales. En este contexto, el desarrollo de marcos que guíen el uso responsable de la IA se convierte en una prioridad estratégica, especialmente cuando estas tecnologías se nutren de ecosistemas de datos públicos y privados para generar valor social y económico. Estos son algunos informes que abordan este objetivo:

- IA generativa y datos abiertos: directrices y buenas prácticas: el Departamento de Comercio de EE. UU. ha publicado una guía con principios y buenas prácticas sobre cómo aplicar inteligencia artificial generativa de forma ética y efectiva en el contexto de los datos abiertos. El documento ofrece pautas para optimizar la calidad y la estructura de los datos abiertos con el fin de hacerlos útiles para estos sistemas, incluyendo la transparencia y gobernanza.

- Guía de buenas prácticas para el uso de la inteligencia artificial ética: esta guía muestra un enfoque integral que combina principios éticos sólidos con preceptos normativos claros y aplicables. Además del marco teórico, la guía sirve de herramienta práctica para implementar sistemas de IA de manera responsable, considerando tanto los beneficios potenciales como los riesgos asociados. La colaboración entre actores públicos y privados garantiza que las recomendaciones sean tanto técnicamente viables como socialmente responsables.

- Enhancing Access to and Sharing of Data in the Age of AI: este análisis de la Organización para la Cooperación y el Desarrollo Económicos (OCDE) aborda uno de los principales obstáculos para el desarrollo de la inteligencia artificial: el acceso limitado a datos de calidad y modelos efectivos. A través de ejemplos, se identifican estrategias específicas que los gobiernos pueden implementar para mejorar significativamente el acceso y la compartición de datos y ciertos modelos de IA.

- A Blueprint to Unlock New Data Commons for AI: Open Data Policy Lab ha elaborado una guía práctica que se centra en la creación y gestión de bienes comunes de dato (data commons) específicamente diseñados para habilitar casos de uso de inteligencia artificial de interés público. La guía ofrece metodologías concretas sobre cómo gestionar datos de manera que se facilite la creación de estos bienes comunes de dato, incluyendo aspectos de gobernanza, sostenibilidad técnica y alineación con objetivos de interés público.

- Guía práctica sobre colaboraciones basadas en datos: la iniciativa Data for Children Collaborative ha publicado una guía paso a paso para desarrollar colaboraciones de datos efectivas, con un enfoque en impacto social. Incluye ejemplos reales, modelos de gobernanza y herramientas prácticas para impulsar alianzas sostenibles.

En resumen, estos informes definen el camino hacia ecosistemas de datos más maduros, éticos y colaborativos. Desde las cifras de crecimiento del sector infomediario español hasta los marcos regulatorios europeos, pasando por las guías prácticas para la implementación de IA responsable, todos estos documentos comparten una visión común: el futuro de los datos abiertos depende de nuestra capacidad para construir puentes entre el sector público y privado, entre la innovación tecnológica y la responsabilidad social.

La Agencia Española de Protección de Datos ha publicado recientemente la traducción al español de la Guía sobre generación de datos sintéticos, elaborada originalmente por la Autoridad de Protección de Datos de Singapur. Este documento ofrece orientación técnica y práctica para personas responsables, encargadas y delegadas de protección de datos sobre cómo implementar esta tecnología que permite simular datos reales manteniendo sus características estadísticas sin comprometer información personal.

La guía destaca cómo los datos sintéticos pueden impulsar la economía del dato, acelerar la innovación y mitigar riesgos en brechas de seguridad. Para ello, presenta casos prácticos, recomendaciones y buenas prácticas orientadas a reducir los riesgos de reidentificación. En este post, analizamos los aspectos clave de la Guía destacando casos de uso principales y ejemplos de aplicación práctica.

¿Qué son los datos sintéticos? Concepto y beneficios

Los datos sintéticos son datos artificiales generados mediante modelos matemáticos específicamente diseñados para sistemas de inteligencia artificial (IA) o aprendizaje automático (ML). Estos datos se crean entrenando un modelo con un conjunto de datos de origen para imitar sus características y estructura, pero sin replicar exactamente los registros originales.

Los datos sintéticos de alta calidad conservan las propiedades estadísticas y los patrones de los datos originales. Por lo tanto, permiten realizar análisis que produzcan resultados similares a los que se obtendrían con los datos reales. Sin embargo, al ser artificiales, reducen significativamente los riesgos asociados con la exposición de información sensible o personal.

Para profundizar en este tema, tienes disponible este Informe monográfico sobre datos sintéticos: ¿Qué son y para qué se usan? con información detallada sobre los fundamentos teóricos, metodologías y aplicaciones prácticas de esta tecnología.

La implementación de datos sintéticos ofrece múltiples ventajas para las organizaciones, por ejemplo:

- Protección de la privacidad: permiten realizar análisis de datos manteniendo la confidencialidad de la información personal o comercialmente sensible.

- Cumplimiento normativo: facilitan el seguimiento de regulaciones de protección de datos mientras se maximiza el valor de los activos de información.

- Reducción de riesgos: minimizan las posibilidades de brechas de datos y sus consecuencias.

- Impulso a la innovación: aceleran el desarrollo de soluciones basadas en datos sin comprometer la privacidad.

- Mejora en la colaboración: posibilitan compartir información valiosa entre organizaciones y departamentos de forma segura.

Pasos para generar datos sintéticos

Para implementar correctamente esta tecnología, la Guía sobre generación de datos sintéticos recomienda seguir un enfoque estructurado en cinco pasos:

- Conocer los datos: comprender claramente el propósito de los datos sintéticos y las características de los datos de origen que deben preservarse, estableciendo objetivos precisos respecto al umbral de riesgo aceptable y la utilidad esperada.

- Preparar los datos: identificar las ideas clave que deben conservarse, seleccionar los atributos relevantes, eliminar o seudonimizar identificadores directos, y estandarizar los formatos y estructuras en un diccionario de datos bien documentado.

- Generar datos sintéticos: seleccionar los métodos más adecuados según el caso de uso, evaluar la calidad mediante comprobaciones de integridad, fidelidad y utilidad, y ajustar iterativamente el proceso para lograr el equilibrio deseado.

- Evaluar riesgos de reidentificación: aplicar técnicas basadas en ataques para determinar la posibilidad de inferir información sobre individuos o su pertenencia al conjunto original, asegurando que los niveles de riesgo sean aceptables.

- Gestionar riesgos residuales: implementar controles técnicos, de gobernanza y contractuales para mitigar los riesgos identificados, documentando adecuadamente todo el proceso.

Aplicaciones prácticas y casos de éxito

Para obtener todas estas ventajas, los datos sintéticos pueden aplicarse en diversos escenarios que responden a necesidades específicas de las organizaciones. La Guía menciona, por ejemplo:

1. Generación de conjuntos de datos para entrenar modelos de IA/ML: los datos sintéticos resuelven el problema de la escasez de datos etiquetados (es decir, que se pueden utilizar) para entrenar modelos de IA. Cuando los datos reales son limitados, los datos sintéticos pueden ser una alternativa rentable. Además, permiten simular eventos extraordinarios o incrementar la representación de grupos minoritarios en los conjuntos de entrenamiento. Una aplicación interesante para mejorar el rendimiento y la representatividad de todos los grupos sociales en los modelos de IA.

2. Análisis de datos y colaboración: este tipo de datos facilitan el intercambio de información para análisis, especialmente en sectores como la salud, donde los datos originales son particularmente sensibles. Tanto en este sector como en otros, proporcionan a las partes interesadas una muestra representativa de los datos reales sin exponer información confidencial, permitiendo evaluar la calidad y potencial de los datos antes de establecer acuerdos formales.

3. Pruebas de software: son muy útiles para el desarrollo de sistemas y la realización de pruebas de software porque permiten utilizar datos realistas, pero no reales en entornos de desarrollo, evitando así posibles brechas de datos personales en caso de comprometerse el entorno de desarrollo.

La aplicación práctica de datos sintéticos ya está demostrando resultados positivos en diversos sectores:

I. Sector financiero: detección de fraudes. J.P. Morgan ha utilizado con éxito datos sintéticos para entrenar modelos de detección de fraude, creando conjuntos de datos con un mayor porcentaje de casos fraudulentos que permitieron mejorar significativamente la capacidad de los modelos para identificar comportamientos anómalos.

II. Sector tecnológico: investigación sobre sesgos en IA. Mastercard colaboró con investigadores para desarrollar métodos de prueba de sesgos en IA mediante datos sintéticos que mantenían las relaciones reales de los datos originales, pero eran lo suficientemente privados como para compartirse con investigadores externos, permitiendo avances que no habrían sido posibles sin esta tecnología.

III. Sector salud: salvaguarda de datos de pacientes. Johnson & Johnson implementó datos sintéticos generados por IA como alternativa a las técnicas tradicionales de anonimización para procesar datos sanitarios, logrando una mejora significativa en la calidad del análisis al representar eficazmente a la población objetivo mientras se protegía la privacidad de los pacientes.

El equilibrio entre utilidad y protección

Es importante destacar que los datos sintéticos no están inherentemente libres de riesgos. La semejanza con los datos originales podría, en determinadas circunstancias, permitir la filtración de información sobre individuos o datos confidenciales. Por ello, resulta crucial encontrar un equilibrio entre la utilidad de los datos y su protección.

Este equilibrio puede lograrse mediante la implementación de buenas prácticas durante el proceso de generación de datos sintéticos, incorporando medidas de protección como:

- Preparación adecuada de los datos: eliminación de valores atípicos, seudonimización de identificadores directos y generalización de datos granulares.

- Evaluación de riesgos de reidentificación: análisis de la posibilidad de que se puedan vincular los datos sintéticos con individuos reales.

- Implementación de controles técnicos: añadir ruido a los datos, reducir la granularidad o aplicar técnicas de privacidad diferencial.

Los datos sintéticos representan una oportunidad excepcional para impulsar la innovación basada en datos mientras se respeta la privacidad y se cumple con las normativas de protección de datos. Su capacidad para generar información estadísticamente representativa pero artificial los convierte en una herramienta versátil para múltiples aplicaciones, desde el entrenamiento de modelos de IA hasta la colaboración entre organizaciones y el desarrollo de software.

Al implementar adecuadamente las buenas prácticas y controles descritos en Guía sobre generación de datos sintéticos que ha traducido la AEPD, las organizaciones pueden aprovechar los beneficios de los datos sintéticos minimizando los riesgos asociados, posicionándose a la vanguardia de la transformación digital responsable. La adopción de tecnologías de mejora de la privacidad como los datos sintéticos no solo representa una medida defensiva, sino un paso proactivo hacia una cultura organizacional que valora tanto la innovación como la protección de datos, aspectos fundamentales para el éxito en la economía digital del futuro.

¿Cómo pueden las administraciones públicas aprovechar el valor de los datos? Esta pregunta no es sencilla de abordar, su respuesta viene condicionada por varios factores que tienen que ver con el contexto de cada administración, los datos con los que cuente y los objetivos específicos que se planteen.

No obstante, existen guías de referencia que pueden ayudar a definir un camino hacia la acción. Una de ellas es la que publica la Comisión Europea a través de la Oficina de Publicaciones de la UE, Data Innovation Toolkit, que surge como una brújula estratégica para navegar este complejo ecosistema de innovación de datos.

Esta herramienta no es un simple manual ya que incluye plantillas para que la implementación del proceso sea más sencilla. Orientada a perfiles diversos como pueden ser analistas noveles o experimentados responsables políticos e innovadores tecnológicos, Data Innovation Toolkit es un recurso útil que acompaña en el proceso, paso a paso.

Su objetivo es democratizar la innovación basada en datos proporcionando un marco estructurado que trasciende la mera recopilación de información. En este post, analizaremos los contenidos de la guía europea, así como las referencias que proporciona para plantear un buen uso innovador de los datos.

Estructura que abarca el ciclo de vida de los datos

La guía está organizada en cuatro pasos principales, que abordan todo el ciclo de vida de los datos.

-

Planificación

La primera parte de la guía se centra en establecer unos cimientos sólidos para cualquier proyecto de innovación con datos. Antes de abordar cualquier proceso, es importante definir objetivos. Para ello, el Data Innovation Toolkit sugiere realizar una reflexión profunda que requiere alinear las necesidades específicas del proyecto con los objetivos estratégicos de la organización. En este paso, también es clave el mapeo de stakeholders o identificación de actores. Esto implica comprender en profundidad los intereses, expectativas y posibles contribuciones de cada actor involucrado. Esta comprensión permite diseñar estrategias de engagement que maximicen la colaboración y minimicen los potenciales conflictos.

Para crear un equipo adecuado de innovación en datos, podemos utilizar la matriz RACI (Responsible, Accountable, Consulted, Informed, por sus siglas en inglés), y así definir con precisión los roles y responsabilidades. No se trata solo de reunir profesionales, sino de construir equipos multidisciplinares donde cada miembro comprenda exactamente su función y contribución al proyecto. Para ayudar en esta tarea la guía facilita:

- Herramienta de definición de retos: para identificar y articular las cuestiones clave que pretenden resolver, resumiéndolas en una única declaración.

- Herramienta de mapeo de stakeholders: para visualizar la red de individuos y organizaciones implicadas, evaluando su influencia e intereses.

- Herramienta de definición de equipos: para facilitar la identificación de personas de su organización que puedan ayudarle.

- Herramienta para definir roles: para, una vez definidos los perfiles necesarios, determinar sus responsabilidades y su papel en el proyecto de datos de forma más detallada, utilizando una matriz RACI.

- Herramienta para definir Personas: las Personas son un concepto que se usa para definir tipos específicos de usuarios, denominados arquetipos de comportamiento. Esta guía ayuda a crear estos perfiles detallados, que representan a los usuarios o clientes que estarán involucrados en el proyecto.

- Herramienta para el mapeo de Data Journey: para realizar una representación sintética que describa paso a paso cómo puede interactuar un usuario con sus datos. El proceso se representa desde la perspectiva del usuario, describiendo lo que ocurre en cada fase de la interacción y los puntos de contacto.

-

Recopilación y procesamiento

Una vez constituido el equipo e identificados los objetivos, se realiza una clasificación de los datos que va más allá de la tradicional división entre cuantitativos y cualitativos.

Ámbito cuantitativo:

-

Los datos discretos, como el número de quejas en un servicio público, no solo representan una cifra, sino una oportunidad para identificar sistemáticamente áreas de mejora. Permiten a las administraciones mapear problemas recurrentes y diseñar intervenciones específicas. Los datos continuos, como los tiempos de respuesta en trámites administrativos, ofrecen una radiografía de la eficiencia operativa. No se trata solo de medir, sino de comprender los factores que influyen en la variabilidad de estos tiempos y diseñar procesos más ágiles y eficientes.

Ámbito cualitativo:

-

Los datos nominales (de nombres) posibilitan la categorización de servicios públicos, permitiendo una comprensión más estructurada de la diversidad de intervenciones administrativas.

-

Los datos ordinales (de números), como las valoraciones de satisfacción, se convierten en una herramienta de priorización para la mejora continua.

En el documento están disponibles una serie de checklist para revisar este aspecto:

-

Checklist de data gaps: para identificar si existe algún vacío en los datos que vamos a utilizar y, si es así, cómo solventarlo.

-

Plantilla de data collection: para alinear el conjunto de datos al objetivo del análisis innovador.

-

Checklist de data collection: para asegurar el acceso a las fuentes de datos necesarias para ejecutar el proyecto.

-

Checklist de calidad de los datos: para repasar el nivel de calidad del conjunto de datos.

-

Cartas de procesamiento de datos: para revisar que los datos se están procesando de manera segura, eficiente y cumpliendo con las regulaciones.

-

Compartir y analizar

En este punto, el Data Innovation Toolkit propone cuatro estrategias de análisis que transforman los datos en conocimiento accionable.

-

El análisis descriptivo: va más allá de la simple visualización de datos históricos, permitiendo construir narrativas que expliquen la evolución de los fenómenos estudiados.

-

El análisis diagnóstico: profundiza en la investigación de causas, desentrañando los patrones ocultos que explican los comportamientos observados.

-

El análisis predictivo: se convierte en una herramienta de planificación estratégica, permitiendo a las administraciones prepararse para escenarios futuros.

- El análisis prescriptivo: da un paso más, no solo proyectando tendencias, sino recomendando acciones concretas basadas en el modelado de datos.

Además del análisis, la dimensión ética es fundamental. Por ello, la guía establece protocolos estrictos para garantizar transferencias de datos seguras, cumplimiento normativo, transparencia y consentimiento informado. En este apartado, se ofrecen las siguientes checklist:

- Plantilla de compartición de datos: para asegurar que se comparte de manera segura, legal y transparente.

- Checklist de compartición de datos: para realizar todos los pasos necesarios para compartir los datos de manera segura, ética y alcanzando todos los objetivos definidos.

- Plantilla de análisis de datos: para dirigir un análisis adecuado que permita obtener insights útiles y significativos para el proyecto.

-

Uso y evaluación

La última etapa se centra en convertir los insights en acciones reales. La comunicación de resultados, la definición de indicadores clave (KPI), la medición de impacto y las estrategias de escalabilidad se convierten en herramientas para la mejora continua.

Un recurso colaborativo en continua mejora

En resumen, el toolkit ofrece una transformación integral: desde la toma de decisiones basada en evidencia hasta la personalización de servicios públicos, pasando por el aumento de la transparencia y la optimización de recursos. También puedes revisar las checklist disponibles en este apartado que son:

- Checklist de uso de datos: para revisar que los datos y las conclusiones obtenidas se utilizan de manera eficaz, responsable y orientado a los objetivos óptimos.

- Innovación de datos mediante herramienta de KPI: para definir los KPI que medirán el éxito del proceso.

- Herramientas de medición de impacto y evaluación del éxito: para valorar el éxito y el impacto de la innovación en el proyecto de datos.

- Plan de escalabilidad de la innovación en datos: para identificar estrategias para escalar el proyecto de manera eficaz.

Además, este repositorio de recursos de innovación y datos es un catálogo dinámico de conocimiento que incluye artículos especializados, guías de implementación, casos de estudio y materiales de aprendizaje.

Puedes acceder aquí a la lista de materiales que proporciona el Data Innovation Toolkit

E incluso ponerte en contacto con el equipo de desarrollo por si tienes alguna duda o quieres contribuir al repositorio:

Parar concluir, llegar a aprovechar el valor de los datos con una perspectiva innovadora no es un salto mágico, sino un proceso gradual y complejo. En este camino, el Data Innovation Toolkit puede ser de utilidad ya que ofrece un marco estructurado. La implementación efectiva requerirá inversión en capacitación, adaptación cultural y compromiso a largo plazo.

Vivimos un momento histórico en el que los datos son un activo clave, del que dependen cada día multitud de pequeñas y grandes decisiones de empresas, organismos públicos, entidades sociales y ciudadanos. Por ello, es importante conocer de donde proviene cada dato, para garantizar que las cuestiones que afectan a nuestra vida están basadas en información veraz.

¿Qué es la citación de datos?

Cuando hablamos de “citar” nos referimos al proceso de indicar qué fuentes externas se han utilizado para crear contenidos. Una cuestión ampliamente recomendable que afecta a todos los datos, incluidos los datos públicos como está recogido en nuestro ordenamiento jurídico. En el caso de los datos ofrecidos por las adminstraciones, el Real Decreto 1495/2011 incluye la necesidad del reutilizador de citar la fuente de origen de la información.

Para ayudar a los usuarios en esta tarea, la Oficina de Publicaciones de la Unión Europea editó Data Citation: A guide to best practice, donde se habla de la importancia de la citación de datos y se recogen recomendaciones de buenas prácticas, así como los retos a superar para citar conjuntos de datos de manera correcta.

¿Por qué es importante la citación de datos?

La guía menciona las razones más relevantes por las que es recomendable llevar a cabo esta práctica:

- El crédito. Crear conjuntos de datos conlleva trabajo. Citar al autor o autores les permite recibir feedback y saber que su trabajo es útil, lo que les anima a seguir trabajando en nuevos conjuntos de datos.

- La transparencia. Cuando los datos se citan, el lector puede acudir a ellos para revisarlos, comprender mejor su alcance y evaluar su idoneidad.

- La integridad. Los usuarios no deben de caer en el plagio. No deben atribuirse el mérito de la creación de conjuntos de datos que no son suyos..

- La reproducibilidad. La citación de los datos permite que una tercera persona pueda intentar reproducir los mismos resultados, utilizando la misma información.

- La reutilización. La citación de datos facilita que cada vez más conjuntos de datos se den a conocer y, por tanto, aumente su uso.

- Minería de textos. Los datos no solo son consumidos por humanos, también pueden serlo por máquinas. Una correcta citación ayudará a las máquinas a comprender mejor el contexto de los conjuntos de datos, amplificando los beneficios de su reutilización.

Buenas prácticas generales

De entre todas las buenas prácticas generales incluidas en la guía, a continuación destacamos algunas de las más relevantes:

- Sé preciso. Es necesario que los datos citados estén definidos con exactitud. La citación de datos debe indicar qué datos concretos se han utilizado de cada conjunto de datos. También es importante señalar si han sido procesados y si provienen directamente del creador o de algún agregador (como un observatorio que ha tomado datos de diversas fuentes).

- Utiliza "identificadores persistentes" (persistent identifiers o PID). Al igual que cada libro que encontramos en una biblioteca tiene su identificador, los conjuntos de datos también pueden (y deben) tenerlo. Los identificadores persistentes son esquemas formales que proporcionan una nomenclatura común, que identifican de manera única los conjuntos de datos, evitando ambigüedades. A la hora de citar conjuntos de datos, es necesario localizarlos y escribirlos como un hipervínculo accionable, sobre el que se puede hacer clic para acceder al conjunto de datos citado y a sus metadatos. Existen diferentes familias de PID, pero la guía destaca dos de las más comunes: el sistema Handle y el identificador de objeto digital (DOI).

- Indica el momento en el que se ha accedido a los datos. Esta cuestión es de gran importancia cuando trabajamos con datos dinámicos (que se actualizan y cambian periódicamente) o continuos (sobre los que se añaden datos adicionales sin modificar los antiguos). En estos casos, es importante citar la fecha de acceso. Además, si es necesario, el usuario puede añadir “snapshots” o instantáneas del conjunto de datos, es decir, copias tomadas en momentos concretos.

- Consulta los metadatos del conjunto de datos utilizado y las funcionalidades del portal en que se ubica. En los metadatos se encuentra gran cantidad de la información necesaria para la cita.

Además, los portales de datos pueden incluir herramientas que ayuden a la citación. Es el caso del Portal de datos abiertos de la Unión Europea en cuyo menú superior se puede encontrar el botón de citación.

- Apóyate en herramientas de software. La mayoría de los programas informáticos utilizados para crear documentos permiten crear y formatear citas automáticamente, asegurando su formato. Además, existen herramientas específicas de gestión de citas como BibTeX o Mendeley, que permiten crear bases de datos de citas teniendo en cuenta sus peculiaridades, una función de gran utilidad cuando es necesario citar numerosos conjuntos de datos en múltiples documentos.

Cómo citar correctamente

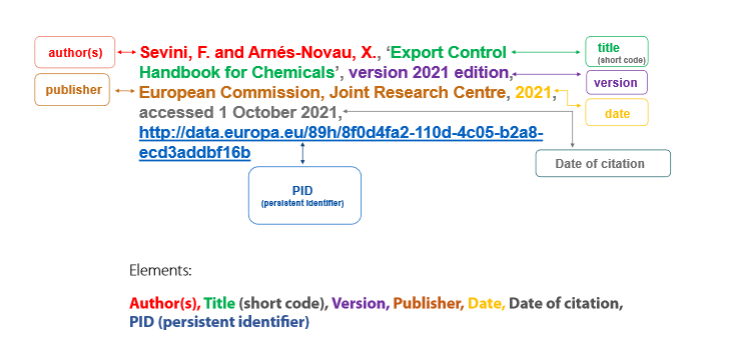

La segunda parte del informe contiene el material técnico de referencia para crear citas que cumplan las recomendaciones indicadas. Abarca los elementos que debe incluir una cita y cómo ordenarlos para distintos fines.

Entre los elementos que debe incluir una cita se encuentran:

- Autor, puede referir tanto al individuo que ha creado el conjunto de datos (autor personal) como a la organización responsable (autor corporativo).

- Título del dataset.

- Versión/edición.

- Publicador, que es la entidad que hace disponible el conjunto de datos y puede coincidir o no con el autor (en caso de que coincidan no es necesario repetirlo).

- Fecha de publicación, donde se indica el año en que se creó. Es importante incluir entre paréntesis el momento de la última actualización.

- Fecha de citación, que expresa la fecha en la que el creador de la cita accedió a los datos, incluyendo la hora si es necesario. Para los formatos de fechas y horas, la guía recomienda acudir a la especificación DCAT, ya que ofrece una precisión mayor en términos de interoperabilidad.

- Identificador persistente.

Respeto al orden de toda esa información, existen diferentes directrices en relación con la estructura general de las citas. La guía muestra las diferentes formas más adecuadas de citar según el tipo de documento en el que aparece la cita (documentos periodísticos, online, etc.), incluyendo ejemplos y recomendación. Entre otros, destaca el ejemplo del Libro de estilo interinstitucional (ISG), que edita la Oficina de Publicaciones de la UE. Este libro de estilo no contiene orientaciones específicas sobre cómo citar datos, pero sí una estructura general para citas que puede aplicarse a los conjuntos de datos, recogida en la siguiente imagen.

La guía finaliza con una serie de anexos con listas de control, diagramas y ejemplos.

Si quieres saber más sobre este documento, te recomendamos ver este seminario online donde se resumen los puntos más importantes.

En definitiva, citar correctamente los conjuntos de datos mejora la calidad y la transparencia del proceso de reutilización de los datos, estimulándolo al mismo tiempo. Por tanto, fomentar la citación correcta de los datos es una práctica no solo recomendable, sino cada vez más necesaria.

La Guía de Gobierno Abierto para Empleadas y Empleados Públicos es un manual para orientar al personal de las administraciones públicas de todos los niveles (local, regional y estatal) sobre el concepto y las condiciones necesarias para lograr un “gobierno abierto inclusivo en un entorno digital”. Concretamente, el documento busca que la administración asuma el gobierno abierto como un elemento transversal de la sociedad, fomentando su conexión con los Objetivos de Desarrollo Sostenible.

Se trata de una guía exhaustiva, práctica y bien estructurada, que facilita la comprensión y la implementación de los principios del gobierno abierto, dando a conocer ejemplos y buenas prácticas que impulsen el desarrollo de las competencias necesarias para facilitar la sostenibilidad del gobierno abierto a largo plazo.

¿Qué es el gobierno abierto?

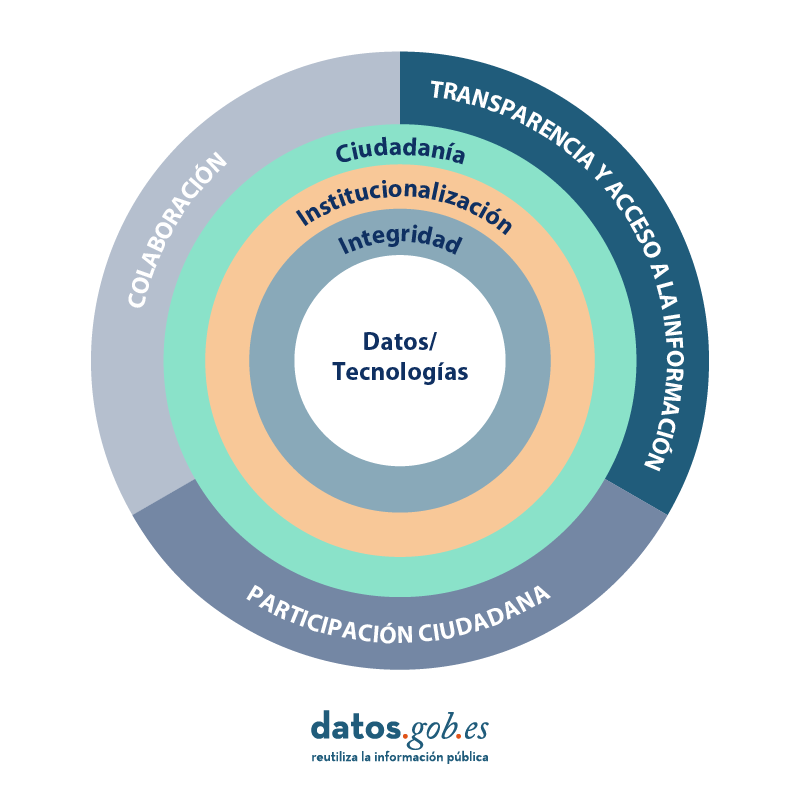

La guía adopta la definición más aceptada de gobierno abierto, basada en tres ejes:

- Transparencia y acceso a la información (eje visión): Hace referencia al acceso abierto a la información pública para facilitar una mayor rendición de cuentas.

- Participación ciudadana (eje voz): Ofrece la posibilidad de que la ciudadanía sea escuchada e intervenga para mejorar los procesos de decisión y cocreación en las políticas públicas.

- Colaboración (eje valor): Se centra en la cooperación dentro de la administración o de manera externa, con la ciudadanía u organizaciones de la sociedad civil, a través de la innovación para generar una mayor coproducción en el diseño y puesta en marcha de los servicios públicos.

Este manual define dichos ejes y los descompone en sus elementos más relevantes para su mejor comprensión y aplicación. Según la guía, los elementos básicos de la administración abierta son:

- Una integridad transversal a toda acción pública.

- Los datos son “la materia prima de gobiernos y administraciones públicas” y, por ese motivo, deben ponerse a disposición de “cualquier actor”, respetando los límites que establece la ley. El uso de tecnologías de la información y comunicación (digitales) se concibe como un “espacio de expansión de la acción pública”, sin desatender las brechas digitales.

- La ciudadanía se sitúa en el centro de la administración abierta, porque no es solo objeto de la acción pública, sino que también “debe gozar de un papel protagonista en todas las dinámicas de transparencia, participación y colaboración”.

- La sostenibilidad de las iniciativas de la administración.

Adaptación de un visual de la Guía de Gobierno Abierto para Empleadas y Empleados Públicos. Fuente: https://funcionpublica.hacienda.gob.es/Secretaria-de-Estado-de-Funcion-Publica/Actualidad/ultimas-noticias/Noticias/2023/04/2023_04_11.html

Beneficios del Gobierno abierto

Con todo ello, se consiguen una serie de beneficios:

- Más calidad institucional y más legitimidad

- Aumento de la confianza en las instituciones

- Políticas más específicas para atender a la ciudadanía

- Más equidad de acceso a la formulación de políticas

- Más innovación en las actuaciones públicas

¿Cómo puedo utilizar la guía?

La guía es muy útil, ya que, para explicar algunos conceptos, plantea retos para que las propias personas funcionarias puedan reflexionar sobre ellos e incluso ponerlos en marcha. Asimismo, los autores proponen casos que van ofreciendo un panorama del gobierno abierto en el mundo y su evolución, tanto de los conceptos relacionados con éste como de las leyes, normativas, planes relevantes y ámbitos de aplicación (incluidos la Ley 19/2023 de transparencia, la agenda España Digital 2025, Carta Derechos Digitales y el Reglamento General de Protección de Datos, conocido como RGPD). Como ejemplo, entre los casos que menciona, se incluyen el Plan de Inclusión Social Elkar-EKIN de la de Diputación Foral de Gipuzkoa y Frena La Curva, una iniciativa puesta en marcha por miembros de la Dirección General de Participación Ciudadana y el LAAAB del Gobierno de Aragón durante el COVID-19.

La guía también incluye un test de autodiagnóstico en rendición de cuentas, fomento de la colaboración, referencias bibliográficas y propuestas de mejora.

Además, ofrece diagramas y resúmenes para explicar y esquematizar cada concepto, así como pautas específicas para ponerlos en práctica. Por ejemplo, se incluye la pregunta ¿dónde están los límites en el acceso a la información pública? Para responderla, la guía cita en qué casos se puede dar acceso a información que haga referencia a la ideología, creencias, afiliación religiosa o sindical de una persona (pág. 26). Con una adaptación a contextos concretos, el manual muy bien podría servir de base para organizar talleres de formación para personas funcionarias por la cantidad de asuntos relevantes que aborda y su organización.

Los autores hacen bien en incluir también advertencias y críticas constructivas a la situación del gobierno abierto en las instituciones. Aunque no hacen señalamientos directos, hablan de:

- Cajas negras: Se critican por ser sistemas cerrados. Se afirma que las cajas negras se deben abrir y transparentar y se debe “incrementar la representación de sectores tradicionalmente excluidos de las decisiones públicas”.

- Lenguaje administrativo: Es un reto para una real transparencia, ya que, según un estudio que menciona la guía, de 760 textos oficiales, un 78% de ellos no eran claros. Entre lo más difícil de entender se encuentran las solicitudes de becas, ayudas y subvenciones, y los trámites vinculados con el empleo.

- La existencia de una falta de transparencia en algunos municipios, según apunta otro estudio mencionado en la guía. El índice de gobierno abierto global, elaborado por World Justice Project, coloca España en el puesto 24, por detrás de países como Estonia (14), Chile (18), Costa Rica (19) o Uruguay (21) y por delante de Italia (28), Grecia (36) o Rumanía (51), entre 102 países. Open Knowledge Foundation ha dejado de actualizar su Global Open Data Index, específicamente sobre datos abiertos.

En resumen, la administración pública se concibe como un paso hacia un Estado abierto, con la incorporación de los valores de lo abierto a todos los poderes del Estado, incluidos los poderes legislativo y judicial, además del gubernamental.

Otras cuestiones adicionales que se podrían tener en cuenta

Para aquellos que quieran seguir el camino hacia un gobierno abierto, existen una serie de cuestiones a tener en cuenta:

- La guía se puede adaptar a diferentes ámbitos y escalas de lo público. Pero la administración pública no es homogénea ni las personas que la componen tienen las mismas responsabilidades, motivaciones, conocimientos o posturas ante el gobierno abierto. En un examen sobre el uso por parte de la ciudadanía de datos abiertos de la administración vasca, se concluía que un obstáculo para la transparencia es la falta de aceptación o colaboración en algunos sectores de la propia administración. Un paso hacia adelante, por tanto, podría ser hacer campañas internas para la difusión de las ventajas para la administración de integrar perspectivas ciudadanas y generar esos espacios para integrar sus aportaciones.

- Aunque el modelo de caja negra está desapareciendo de la administración pública, que está sometida a gran escrutinio, este ha vuelto de la mano de sistemas algorítmicos cerrados y opacos aplicados a la administración de lo público. Hay muchos estudios en la literatura científica –por ejemplo, este— que alertan de que sistemas de caja opaca erróneos pueden estar funcionando en la administración pública sin que nadie se dé cuenta hasta que se generan resultados dañinos. Este es un asunto que necesita revisión.

- Para su adaptación a contextos concretos, habría que poder definir más concretamente qué es la participación, colaboración y cocreación. Como indica la guía, no solo implican la transparencia, sino poner en práctica iniciativas de colaboración o de innovación. Pero además es necesario hacerse una serie de preguntas adicionales ¿qué es una iniciativa de colaboración o innovación?, ¿qué metodologías existen?, ¿cómo se organiza y mide su éxito?

- La guía resalta la necesidad de incluir a la ciudadanía en el gobierno abierto. Cuando se habla de la inclusión y participación, sobre todo se menciona a la sociedad civil organizada y la academia, por ejemplo, en el Foro de Gobierno Abierto. Pero existen posibilidades de mejora para impulsar una participación y colaboración de las personas a título individual, sobre todo, si se trata de personas con poco acceso a la tecnología. La guía menciona brechas digitales de género, territoriales, por razón de edad o discapacidad, pero no las explora. Sin embargo, cuando se ha plataformizado el acceso a muchos servicios, ayudas y asistencia públicas (sobre todo después de la pandemia de COVID-19), dichas brechas digitales afectan a muchas personas, especialmente personas ancianas, de bajos recursos y a mujeres. Dado que una guía generalista no puede abordar todos los asuntos relevantes en detalle, este merecería una guía aparte.

Cada vez más las instituciones públicas acuden a la decisión algorítmica para una toma de decisiones eficaz, rápida e inclusiva. Por ello, resulta también cada vez más relevante la formación de la propia administración en materia de gobierno abierto en un entorno digitalizado, datificado y plataformizado. Esta guía es un gran primer paso para aquellos que quieren aproximarse a la materia.

Contenido elaborado por Miren Gutiérrez, Doctora e investigadora en la Universidad de Deusto, experta en activismo de datos, justicia de datos, alfabetización de datos y desinformación de género. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor

A la hora de poner en marcha una iniciativa de datos abiertos, es necesario que todas las personas implicadas en su desarrollo sean conscientes de los beneficios de la apertura de datos, y que tengan claros los procesos y flujos de trabajo necesarios para alcanzar las metas marcadas. Solo así se podrá conseguir una iniciativa con datos actualizados y que cumplan los parámetros de calidad necesarios.

Esa idea la tenían clara en la Iniciativa Alba Smart, y por ello han creado diversos materiales que no solo sirven para dotar de conocimiento a todos los implicados, sino también para motivar y concienciar a jefes de servicio y concejales sobre la necesidad (y obligatoriedad) de publicar cuanta información sea posible para uso de la ciudadanía.

¿Qué es Alba Smart?

El proyecto Alba Smart está desarrollado, de manera conjunta, por los ayuntamientos de Almendralejo y Badajoz con el objetivo de avanzar en su desarrollo como ciudades inteligentes. Entre las áreas que abarca se encuentra el control de flujos de movilidad turística, la creación de un hub de innovación, la instalación de puntos de acceso wifi en edificios públicos, la puesta en marcha de un wifi social o la gestión de aparcamientos y flotas.

En el marco de este proyecto se ha desarrollado una plataforma para unificar la información de dispositivos y sistemas, facilitando así la gestión de los servicios públicos de una manera más eficiente. Alba Smart también incorpora un cuadro de mando integral, así como un portal de datos abiertos para cada ayuntamiento (aquí tienes disponible el de Almendralejo y el de Badajoz).

La iniciativa Alba Smart cuenta con la colaboración de Red.es a través del Plan Nacional de Ciudades Inteligentes.

Actividades para impulsar los datos abiertos

Dentro del contexto de Alba Smart, encontramos un grupo de trabajo de Datos Abiertos del ayuntamiento de Badajoz, que ha puesto en marcha diversas actividades enfocadas a la divulgación del open data en el marco de una entidad local.

Una de las primeras acciones que han llevado a cabo es la elaboración de una WIKI interna en la que han ido documentando todos los materiales que les han sido de utilidad. Esta WIKI facilita la compartición de contenido interno, de tal forma que todos los usuarios tienen a su disposición materiales de interés para dar respuesta a preguntas como: qué es el open data, qué roles, tareas y procesos implica, por qué es necesario adoptar este tipo de políticas, etc.

Además, en la parte pública de la web de Badajoz, tanto de Transparencia como de Datos Abiertos, han compartido una serie de documentos incluidos en esta WIKI que también pueden ser del interés de otras iniciativas locales:

Contenidos relacionados con la Transparencia

En la web se incluye un apartado-resumen con contenidos sobre TRANSPARENCIA. Entre otras cuestiones, incluye un listado de indicadores ITA2017 y su asignación a cada Servicio del Ayuntamiento.

En este apartado también se recoge el marco normativo que aplica al territorio, así como referencias externas.

Contenidos relacionados con los datos abiertos

También incluye un apartado-resumen sobre DATOS ABIERTOS , donde se recoge la normativa a aplicar y enlaces de interés, además de:

- El listado de 40 conjuntos de datos recomendados por la FEMP en 2019. Este documento recoge una serie de dataset que deberían publicar todas las entidades locales de España con el fin de homogeneizar la publicación de datos abiertos y facilitar su gestión. El listado generado por Alba Smart incluye información sobre el servicio del ayuntamiento responsable de la apertura de cada conjunto de datos.

- Un resumen del plan de implantación seguido por el ayuntamiento, donde se incluye el flujo de trabajo a seguir, haciendo hincapié en la necesidad de que se ejecute de manera continuada: identificando nuevas fuentes de información, revisando procesos internos, etc.

- Una serie de vídeos formativos, de elaboración propia, para ayudar a los compañeros en la preparación y publicación de datos. Incluyen tutoriales sobre cómo organizar los datos, su catalogación o el proceso de revisión y aprobación, entre otros.

- Un manual (de ejemplo) sobre cómo subir un fichero a su plataforma de datos abiertos, la cual está desarrollada con CKAN. Se trata de un documento práctico, con capturas de pantalla, que muestran paso a paso todo el proceso.

- El listado de vocabularios que utilizan como referencia, los cuales permiten organizar, categorizar y etiquetar sistemáticamente la información.

Entre sus próximos pasos se encuentra la presentación de los conjuntos de datos en el visualizador de mapas del ayuntamiento. Los datos del portal ya se vuelcan en el GIS corporativo para facilitar esta función en el futuro.

Con todas estas acciones se pretende garantizar la sostenibilidad del portal, facilitando su actualización continua por parte de un equipo de trabajo que tienen bien claro los procedimientos de trabajo.