La Unión Europea tiene como objetivo potenciar la Economía del Dato, impulsando el flujo libre de datos entre los estados miembros y entre sectores estratégicos, en beneficio de empresas, investigadores, administraciones públicas y ciudadanos. Sin duda, los datos son un factor crítico en la revolución industrial y tecnológica que estamos viviendo, y por ello una de las prioridades digitales de la UE pasa por capitalizar su valor latente, apoyándose para ello en un mercado único donde estos puedan compartirse bajo condiciones de seguridad, y sobre todo de soberanía, pues sólo así se garantizarán los indiscutibles valores y derechos europeos.

Así, la Estrategia Europea de Datos busca potenciar su intercambio a gran escala, bajo entornos distribuidos y federados, pero que sin embargo garanticen la ciberseguridad y la transparencia. Para lograr escala, y liberar todo el potencial de los datos en la economía digital, un elemento fundamental es la generación de confianza. Esta, como elemento basal que condiciona la liquidez del ecosistema, debe desarrollarse coherentemente a lo largo de diferentes ámbitos y entre diferentes actores (proveedores de datos, usuarios, intermediarios, plataformas de servicios, desarrolladores, …). Por ende, su articulación afecta a diferentes perspectivas, incluida la de negocio y funcional, la legal y regulatoria, la operacional, e incluso la tecnológica. Por tanto, el éxito en estos proyectos de alta complejidad pasa por desarrollar estrategias que busquen minimizar las barreras de entrada a los participantes, y maximizar la eficacia y sostenibilidad de los servicios ofrecidos. Esto a su vez se traduce en el desarrollo de infraestructuras y modelos de gobernanza para los datos que sean fácilmente escalables, y que sirvan de base para un intercambio efectivo de datos con que generar valor para todos sus participantes.

Una metodología para impulsar los espacios de datos

España ha hecho suyo el cometido de llevar a la práctica esa estrategia europea, y desde hace años se trabaja en crear el entorno propicio para facilitar el despliegue y asentamiento de una Economía del Dato Soberana, apoyándose, entre otros instrumentos, en el Plan de Recuperación, Transformación y Resiliencia. En este sentido, y desde su papel coordinador y posibilista, la Oficina del Dato ha desplegado esfuerzos en el diseño de una metodología conceptual general, agnóstica a un sector concreto. Esta configura la creación de ecosistemas de datos alrededor de proyectos prácticos que aporten valor a los miembros de dicho ecosistema.

Por ello, la metodología consta de varios elementos, siendo la experimentación uno de ellos. Esto es así debido a que, por su naturaleza flexible, los datos pueden ser tratados, modelizados, y por ende interpretados, desde distintas perspectivas. Por este motivo, la experimentación resulta clave para calibrar adecuadamente aquellos procesos y tratamientos necesarios para llegar al mercado con pilotos o casos de negocio ya cercanos a las industrias, de modo que estén más cerca a generar un impacto positivo. En este sentido, se hace necesario demostrar el valor tangible y apuntalar su sostenibilidad, lo que implica contar, como mínimo, con:

- Marcos de referencia para una gobernanza efectiva de datos

- Actuaciones para mejorar la disponibilidad y la calidad de los datos, buscando también incrementar su interoperabilidad por diseño

- Herramientas y plataformas de intercambio y explotación de datos.

Así mismo, y dado que cada sector tiene su propia especificidad en lo que respecta a tipos y semánticas de datos, modelos de negocio, y necesidades de los participantes, la creación de comunidades de expertos, representando la voz del mercado, es otro elemento fundamental de cara a generar proyectos de utilidad. En base a esta escucha activa, que conduzca a la compresión de las dinámicas del dato en cada sector, se logra caracterizar las condiciones de mercado y de gobernanza necesarias para el despliegue de los espacios de datos en sectores estratégicos como el turismo, la movilidad, agroalimentación, comercio, salud o la industria.

En este proceso de generación de comunidad, las cooperativas de datos juegan un papel fundamental, así como la figura más general del intermediario de datos, que sirve para sensibilizar sobre la oportunidad existente y favorecer la creación y consolidación efectiva de estos nuevos modelos de negocio.

Todos estos elementos son distintas piezas de un puzle con que explorar nuevas oportunidades de desarrollo de negocio, así como para el diseño de proyectos tangibles con que demostrar el valor diferencial que la compartición de datos aportará a la realidad de las industrias. Así, y desde la perspectiva operativa, el último elemento de la metodología es el desarrollo de casos de uso concretos. Estos también permitirán desplegar iterativamente un catálogo de experiencias y recursos de datos reutilizables en cada sector, con que facilitar la construcción de nuevos proyectos. Este catálogo se convierte así en la pieza central de una plataforma común sectorial y federada, y cuya arquitectura distribuida facilita también la interconexión intersectorial.

Sobre hombros de gigantes

Hay que destacar que España no parte de cero, pues cuenta ya con un potente ecosistema de innovación y experimentación en datos, que ofrece servicios avanzados. Creemos por tanto interesante progresar en la armonización o complementariedad de sus objetivos, así como en la difusión de sus capacidades para ganar capilaridad. Además, la metodología planteada refuerza el alineamiento con los proyectos europeos del mismo ámbito, lo que servirá para conectar los aprendizajes y avances desde la escala nacional a los realizados a nivel UE, así como para poner en práctica las tareas de diseño de los "cianotipos" promulgados por la Comisión Europea a través del Data Spaces Support Centre.

Por último, el impulso de proyectos experimentales o piloto permite también el desarrollo de estándares para tecnologías innovadoras de datos, guardando una estrecha relación con el proyecto Gaia-X. Así, el Hub Gaia-X España cuenta con un nodo de interoperabilidad, que sirve para certificar el cumplimiento de las reglas prescritas por cada sector, y por ende para generar la citada confianza digital en base a sus necesidades específicas.

Desde la Oficina del Dato, creemos que la interconexión y la escalabilidad a futuro de los proyectos de datos se encuentran en el centro del esfuerzo de implementación de la Estrategia Europea de Datos, y resultan cruciales para alcanzar una Economía del Dato dinámica y rica, pero a su vez garante de los valores europeos y donde la trazabilidad y la transparencia ayuden a colectivizar el valor del dato, catalizando una economía más fuerte y cohesionadora.

Bajo la Presidencia española del Consejo de la Unión Europea, el Gobierno de España ha liderado la cumbre Gaia-X Summit 2023 que se ha celebrado en Alicante durante los días 9 y 10 de noviembre. El evento tenía como objetivo repasar los últimos avances de Gaia-X en la promoción de la soberanía de datos en Europa. Tal y como presentamos en datos.gob.es, Gaia-X es una iniciativa europea del sector privado para la creación de una infraestructura de datos que sea federada, abierta, interoperable y reversible, y que sirve por tanto fomenta la soberanía digital y la disponibilidad de los datos.

La cumbre ha servido también ha servido como espacio para el intercambio de ideas entre las voces líderes de la comunidad europea de espacios de datos, y ha culminado con la presentación de un comunicado para impulsar la autonomía estratégica en la nube, los datos y la inteligencia artificial, elemento considerado crítico para la competitividad de la UE. El documento, fomentado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, constituye un llamamiento conjunto para una respuesta “más coherente y coordinada” en el desarrollo de programas y proyectos, tanto europeos como a nivel de estados miembro, relacionados con los datos y las tecnologías del sector.

Para ello, el comunicado aboga por la interoperabilidad respaldada por una infraestructura sólida de servicios en la nube y por el desarrollo de una inteligencia artificial basada en datos de alta calidad, con una gobernanza sólida que cumpla con los marcos normativos europeos. En concreto, se resaltan las posibilidades que ofrecen las redes neuronales profundas (Deep Neural Networks), cuyo éxito recae en tres factores principales: algoritmos, capacidad de cálculo y acceso a grandes cantidades de datos. En este sentido, el documento resalta la necesidad de apostar por este último factor, impulsando un paradigma de red neuronal basado en datos de alta calidad, bien parametrizados y en infraestructuras compartidas, que no sólo ahorren un tiempo valioso a los investigadores, sino que también eviten la degradación medioambiental, dado que limita las necesidades de cómputo de estos sistemas al trabajar más allá del paradigma de fuerza bruta.

Por este motivo, otro de los aspectos abordados por el documento es la dinamización del acceso a fuentes de datos de diferentes dominios complementarios. Eso permitiría una economía de datos “flexible, dinámica y altamente escalable” que sirva para optimizar procesos, innovar y/o crear nuevos modelos de negocio.

El llamamiento se muestra optimista con la iniciativas y programas europeos existentes, empezando por el propio proyecto de Gaia-X. También se resaltan otros proyectos como son el IPCEI-CIS o proyecto Simpl europeo. Asimismo, subraya la necesidad de “una coordinación más amplia y efectiva para impulsar proyectos industriales, avanzar en la estandarización de etiquetas de nube y datos confiables, lo que sirve para garantizar unos niveles altos de ciberseguridad, protección de datos, transparencia algorítmica y portabilidad”.

El comunicado destaca la importancia de lograr un mercado único de datos que incluya procesos de intercambios de datos bajo un marco común de gobernanza. Así, valora el novedoso conjunto de legislación digital y de datos, como la ley de datos (Data Act), entre cuyos objetivos se encuentra el impulso de la disponibilidad de datos en el conjunto de la Unión. El comunicado está abierto a la adhesión de nuevos miembros que busquen avanzar en el fomento de una economía del dato flexible, dinámica y altamente escalable.

Alicante acogerá los próximos días 9 y 10 de noviembre el Summit 2023 de Gaia-X, en el que se llevará a cabo un repaso sobre los últimos progresos realizados por esta iniciativa en la promoción de la soberanía de datos en Europa. La interoperabilidad, transparencia y el cumplimiento normativo adquieren una dimensión práctica a través del intercambio y explotación de datos articulados bajo un entorno de nube confiable.

También se abordarán las relaciones establecidas con líderes del sector, expertos, empresas, gobiernos, instituciones académicas y organizaciones varias, facilitando el intercambio de ideas y experiencias entre los diversos grupos de interés involucrados en la transformación digital europea. El evento contará con conferencias magistrales, talleres interactivos y mesas redondas, en las que se explorarán las posibilidades ilimitadas de los ecosistemas digitales cooperativos, y de un futuro próximo en el que los datos se hayan convertido en un activo de alto valor añadido.

Este evento está organizado por la asociación europea Gaia-X, en colaboración con el Hub español de Gaia-X. Cuenta también con la participación de la Oficina del Dato, dependiente de la Secretaría de Estado de Digitalización e Inteligencia Artificial, y se desarrolla bajo los auspicios de la presidencia española del Consejo de la Unión Europea.

La iniciativa Gaia-X busca garantizar que los datos sean almacenados y procesados de manera segura y soberana, respetando las regulaciones europeas, además de fomentar la colaboración entre diferentes y heterogéneos actores, como empresas, gobiernos y organizaciones. Así, Gaia-X promueve la innovación y el desarrollo económico basado en datos en Europa. Por tanto, la relación abierta en colaboración con la Unión Europea resulta fundamental para la consecución de sus objetivos.

La soberanía digital: una Europa adaptada a la era de los datos

Como para Gaia-X, uno de los grandes objetivos de la Unión Europea es el de fomentar la soberanía digital a lo largo de todo su territorio. Para ello, promueve el desarrollo de industrias y tecnologías clave para su competitividad y seguridad, fortalece sus relaciones comerciales y cadenas de suministro, y mitiga dependencias externas, concentrándose en la reindustrialización de su territorio y en asegurar su autonomía digital estratégica.

El concepto de soberanía digital abarca distintas dimensiones: tecnológica, regulatoria y socioeconómica. La dimensión tecnológica se refiere al hardware, software, nube e infraestructura de redes utilizados para acceder, procesar y almacenar datos. Mientras, la dimensión regulatoria se refiere a las normas que proporcionan seguridad jurídica a los ciudadanos, empresas e instituciones que operan en un ámbito digital. Finalmente, la dimensión socioeconómica se enfoca en las iniciativas empresariales y los derechos individuales en el nuevo entorno digital global. Para avanzar en todas estas dimensiones, la UE se apoya en proyectos como Gaia-X.

La iniciativa busca crear ecosistemas federados, abiertos, seguros y transparentes, donde los conjuntos y servicios de datos cumplen una serie mínima de reglas comunes que les permiten así ser reutilizables bajo entornos de confianza y transparencia. A su vez, esto habilita la creación de ecosistemas de datos confiables de alta calidad, con que las organizaciones europeas podrán impulsar su proceso de digitalización, mejorando las cadenas de valor a lo largo de diferentes sectores industriales. Estas cadenas de valor, desplegadas digitalmente sobre entornos de nube federada y confiable (“Trusted Cloud”), gozan de trazabilidad y transparencia, y sirven por tanto para impulsar los esfuerzos de cumplimiento normativo y soberanía digital.

En resumen, este enfoque se basa en aprovechar y reforzar unos valores reflejados en un marco regulatorio en desarrollo que busca incorporar conceptos como la confianza y la gobernanza en los entornos de datos. Esto busca convertir la UE en líder de una sociedad y economía donde la digitalización sea vector para reindustrializarnos y prosperar, pero siempre bajo el marco de unos valores que nos definen.

Se puede acceder al programa completo de este Summit desde la página oficial de la asociación europea: https://gaia-x.eu/summit-2023/agenda/.

En la era de los datos, nos enfrentamos al desafío de la escasez de datos de valor para la construcción de nuevos productos y servicios digitales. Aunque vivimos en una época en la que los datos están por todas partes, a menudo nos encontramos con dificultades para acceder a datos de calidad que nos permitan comprender procesos o sistemas desde una perspectiva basada en datos. La falta de disponibilidad, la fragmentación, la seguridad y la privacidad son solo algunas de las razones que dificultan el acceso a datos reales.

Sin embargo, los datos sintéticos han surgido como una solución prometedora a este problema. Los datos sintéticos son información fabricada artificialmente que imita las características y distribuciones de los datos reales, sin contener información personal o sensible. Estos datos se generan mediante algoritmos y técnicas que preservan la estructura y las propiedades estadísticas de los datos originales.

Los datos sintéticos son útiles en diversas situaciones donde la disponibilidad de datos reales es limitada o se requiere proteger la privacidad de las personas involucradas. Tienen aplicaciones en la investigación científica, pruebas de software y sistemas, y entrenamiento de modelos de inteligencia artificial. Permiten a los investigadores explorar nuevos enfoques sin acceder a datos sensibles, a los desarrolladores probar aplicaciones sin exponer datos reales y a los expertos en IA entrenar modelos sin la necesidad de recopilar todos los datos del mundo real que en ocasiones son, simplemente, imposibles de capturar en tiempos y costes asumibles.

Existen diferentes métodos para generar datos sintéticos, como el remuestreo, el modelado probabilístico y generativo, y los métodos de perturbación y enmascaramiento. Cada método tiene sus ventajas y desafíos, pero en general, los datos sintéticos ofrecen una alternativa segura y confiable para el análisis, la experimentación y el entrenamiento de modelos de inteligencia artificial.

Es importante destacar que el uso de datos sintéticos ofrece una solución viable para superar las limitaciones de acceso a datos reales y abordar preocupaciones de privacidad y seguridad. Los datos sintéticos permiten realizar pruebas, entrenar algoritmos y desarrollar aplicaciones sin exponer información confidencial. Sin embargo, es fundamental garantizar la calidad y la fidelidad de los datos sintéticos mediante evaluaciones rigurosas y comparaciones con los datos reales.

En este informe, abordamos de forma introductoria la disciplina de los datos sintéticos, ilustrando algunos casos de uso de valor para los diferentes tipos de datos sintéticos que se pueden generar. Los vehículos autónomos, la secuenciación de ADN o los controles de calidad en las cadenas de producción son solo algunos de los casos que detallamos en este informe. Además, hemos destacado el uso del software open-source SDV (Synthetic Data Vault), desarrollado en el entorno académico del MIT, que utiliza algoritmos de aprendizaje automático para crear datos sintéticos tabulares que imitan las propiedades y distribuciones de los datos reales. Desarrollamos un ejemplo práctico, en un entorno de Google Colab para generar datos sintéticos sobre clientes ficticios alojados en un hotel ficticio. Hemos seguido un flujo de trabajo que involucra la preparación de datos reales y metadatos, el entrenamiento del sintetizador y la generación de datos sintéticos basados en los patrones aprendidos. Además, hemos aplicado técnicas de anonimización para proteger los datos sensibles y hemos evaluado la calidad de los datos sintéticos generados.

En resumen, los datos sintéticos son una herramienta poderosa en la era de los datos, ya que nos permiten superar la escasez y la falta de disponibilidad de datos de valor. Con su capacidad para imitar los datos reales sin comprometer la privacidad, los datos sintéticos tienen el potencial de transformar la forma en que desarrollamos proyectos de inteligencia artificial y análisis. A medida que avanzamos en esta nueva era, es probable que los datos sintéticos desempeñen un papel cada vez más importante en la generación de nuevos productos y servicios digitales.

Si quieres saber más sobre el contenido de este informe, puedes ver la entrevista a su autor.

En esta infografía se resume el concepto y sus principales aplicaciones:

Puedes descargarla en PDF aquí

A continuación, puedes descargar el informe completo, el resumen ejecutivo y una presentación-resumen.

Vivimos en un entorno en constante evolución en el que los datos crecen de manera exponencial y son, además, un componente fundamental de la economía digital. En este contexto, es necesario desbloquear su potencial para maximizar su valor mediante la creación de oportunidades para su reutilización. Sin embargo, es importante tener en cuenta que ese incremento en velocidad, escala y variedad de los datos supone que asegurar su calidad sea más complicado.

En este escenario surge la necesidad de establecer procesos comunes aplicables a los activos de datos de toda organización a lo largo de su ciclo de vida. Todo tipo de instituciones deben disponer de datos bien gobernados, gestionados y con niveles adecuados de calidad, siendo necesaria una metodología de evaluación común que pueda ayudar a una mejora continua de dichos procesos y permita evaluar la madurez de una organización de forma estandarizada.

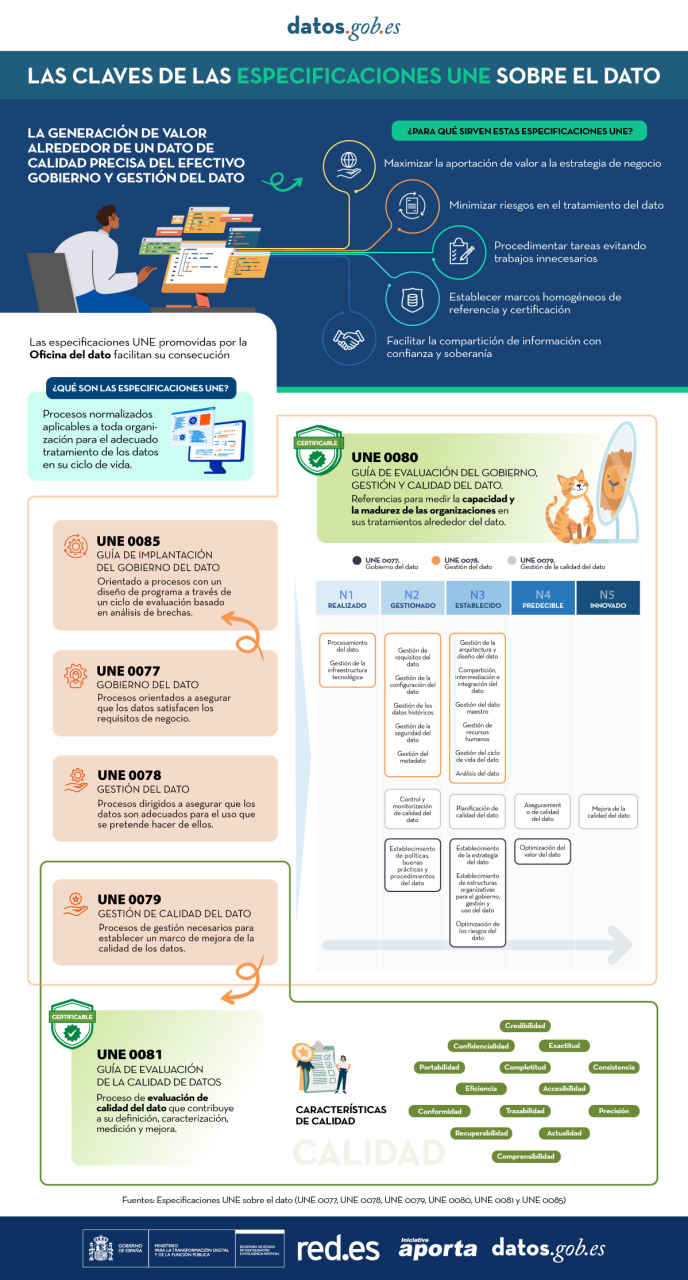

La Oficina del Dato ha patrocinado, promovido y participado en la generación de las especificaciones UNE, unos recursos normativos que permiten implantar procesos comunes en la gestión del dato y que además proporcionan un marco de referencia para establecer una cultura de datos organizacional.

Por una parte, encontramos las especificaciones UNE 0077:2023 Gobierno del dato, UNE 0078:2023 Gestión del dato y UNE 0079:2023 Gestión de la calidad del dato, que están concebidas para ser aplicadas de forma conjunta, habilitando un marco de referencia sólido que fomente la adopción de prácticas sostenibles y efectivas alrededor del dato.

Además, es necesaria una metodología de evaluación común que permita una mejora continua de los procesos de gobierno, gestión y gestión de la calidad del dato, así como la medición de la madurez de las organizaciones de forma estandarizada. Para el desarrollo de un marco homogéneo de evaluación del tratamiento que una organización hace de los datos se ha desarrollado la especificación UNE 0080.

Con el objetivo de ofrecer un proceso basado en estándares internacionales que ayude a las organizaciones a utilizar un modelo de calidad y a definir características y métricas de calidad adecuadas, se ha generado la especificación UNE 0081 Evaluación de la calidad del dato que complementa la UNE 0079 Gestión de la calidad del dato.

La siguiente infografía resumen cuáles son las claves de las Especificaciones UNE sobre el dato y las principales ventajas de su aplicación (haz clic en la imagen para acceder a la infografía).

También está disponible un vídeo explicativo sobre las Especificaciones UNE sobre datos

Hoy en día, la calidad de los datos desempeña un papel fundamental en el mundo actual, donde la información es un activo valioso. Asegurar que los datos sean precisos, completos y confiables se ha vuelto esencial para el éxito de las organizaciones y garantiza el éxito de la toma de decisiones informadas.

La calidad de los datos tiene un impacto directo no solo en el intercambio y uso a nivel interno de cada organización, sino también en la compartición de datos entre diferentes entidades, siendo una variable clave en el éxito del nuevo paradigma de los espacios de datos. Cuando los datos son de alta calidad, se crea un entorno propicio para el intercambio de información precisa y consistente, lo cual permite a las organizaciones colaborar de manera más efectiva, fomentando la innovación y el desarrollo conjunto de soluciones.

Una buena calidad de datos facilita la reutilización de la información en diferentes contextos, generando valor más allá del sistema que los crea. Los datos de alta calidad son más fiables y accesibles, y pueden ser utilizados por múltiples sistemas y aplicaciones, lo que aumenta su valor y utilidad. Al reducir considerablemente la necesidad de realizar correcciones y ajustes constantes, se ahorra tiempo y recursos, permitiendo una mayor eficiencia en la implementación de proyectos y la creación de nuevos productos y servicios.

La calidad de los datos también juega un papel fundamental en el avance de la inteligencia artificial y el aprendizaje automático. Los modelos de IA se basan en grandes volúmenes de datos para obtener resultados precisos y confiables. Si los datos utilizados están contaminados o son de baja calidad, los resultados de los algoritmos de IA serán poco confiables o incluso erróneos. Por lo tanto, garantizar la calidad de los datos es esencial para lograr el máximo rendimiento de las aplicaciones de IA, reducir o eliminar sesgos y aprovechar su potencial al máximo.

Con el objetivo de ofrecer un proceso basado en estándares internacionales que pueda ayudar a las organizaciones a utilizar un modelo de calidad y a definir características y métricas de calidad adecuadas, la Oficina del Dato ha patrocinado, promovido y participado en la generación de la especificación UNE 0081 Evaluación de la calidad del dato que complementa la especificación ya existente UNE 0079 Gestión de la calidad del dato, centrada más en la definición de procesos de gestión de la calidad del dato que en la calidad del dato como tal.

Especificación UNE – Guía de Evaluación de la calidad del dato

La especificación UNE 0081, familia de estándares internacionales ISO/IEC 25000, permite conocer y evaluar la calidad de los datos de toda organización, permitiendo establecer un plan futuro para su mejora, y pudiéndose incluso llegar a certificar su calidad formalmente. Los destinatarios de está especificación, aplicable a cualquier tipo de organización independientemente de su tamaño o dedicación, serán los responsables de calidad de datos, así como los consultores y auditores que necesiten llevar a cabo una evaluación de los conjuntos de datos dentro de sus funciones.

La especificación primero expone el modelo de calidad del dato, en dónde se detallan las características de calidad que pueden tener los datos, así como algunas métricas aplicables, para una vez definido este marco de trabajo, pasar a definir el proceso que se debe seguir para evaluar la calidad de un conjunto de datos. Finalmente, la especificación acaba detallando como interpretar los resultados obtenidos de la evaluación mostrando algún ejemplo concreto de aplicación.

Modelo de calidad del dato

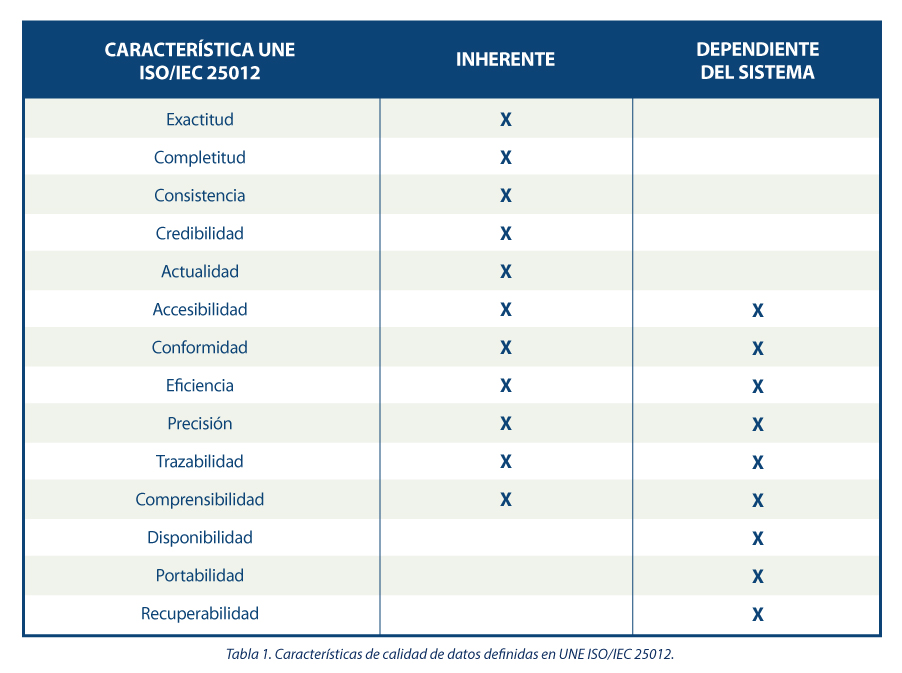

La guía propone una serie de características de calidad siguiendo las presentes en la norma ISO/IEC 25012, clasificándolas entre aquellas inherentes al dato, dependientes del sistema donde se aloja el dato o dependientes de ambas circunstancias. Se justifica la elección de estas características dado que abarcan las presentes en otros marcos de referencia tales como DAMA, FAIR, EHDS, IA Act y RGPD.

En base a las características definidas, la guía se apoya en la norma ISO/IEC 25024 para proponer un conjunto de métricas que sirvan para medir las propiedades de las características, entendiendo estas propiedades como “subcaracteristicas” de las características.

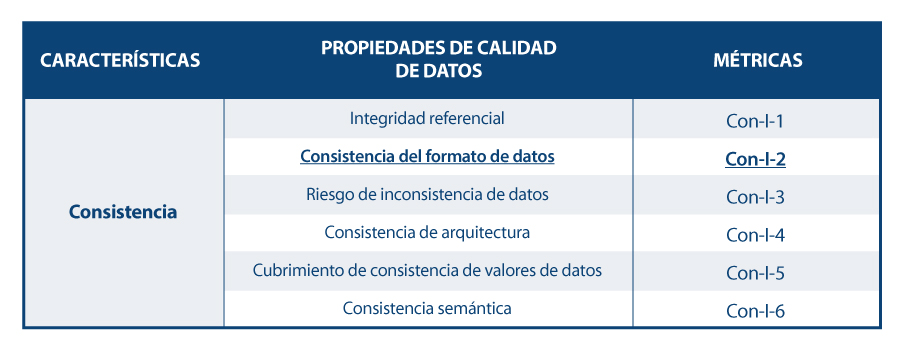

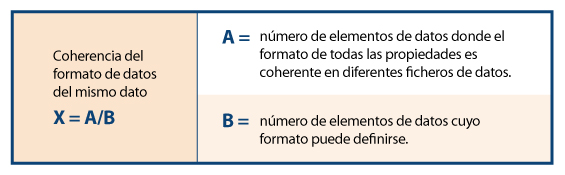

Así, a modo de ejemplo, siguiendo el esquema de dependencias, para la característica concreta de “consistencia del formato de datos” se muestran sus propiedades y métricas, detallándose una de ellas.

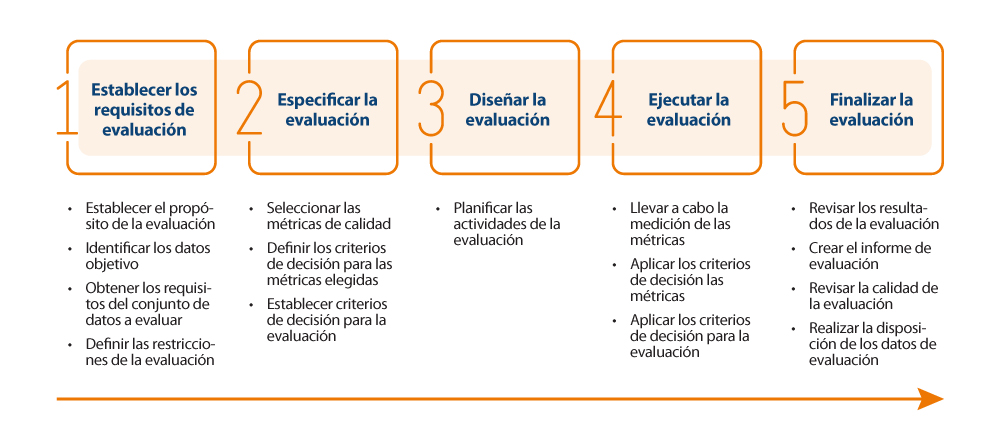

Proceso para evaluar la calidad de un conjunto de datos

Para realizar la evaluación en sí de la calidad de los datos, la guía propone seguir la norma ISO/IEC 25040, que establece un modelo de evaluación que tiene en cuenta tanto los requisitos y restricciones definidas por la organización, como los recursos necesarios tanto materiales como personales. Con estos requisititos, se establece un plan de evaluación a través de unas métricas y criterios de decisión concretos en función de los requisitos de negocio, que permita realizar la correcta medición de las propiedades y características e interpretar sus resultados.

A continuación, se muestra un esquema con los pasos a realizar en el proceso, así como sus principales actividades:

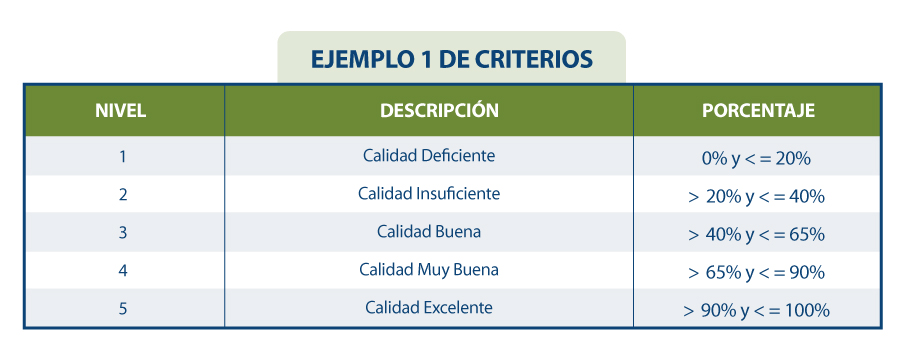

Resultados de la evaluación de calidad

El resultado de la evaluación dependerá directamente de los requisitos marcados por la organización y los criterios de cumplimiento. Las propiedades de las características suelen evaluarse de 0 a 100 a partir de los valores obtenidos en las métricas definidas para cada uno de ellos, y las características a su vez se evalúan por agregación de las anteriores también de 0 a 100 o mediante la conversión a un valor discreto de 1 a 5 (1 calidad deficiente, 5 calidad excelente) en función de las reglas de cálculo y ponderación que se hayan establecido. Al igual que de la medición de las propiedades se obtiene la de sus características, lo mismo pasa con estas características, que mediante su suma ponderada en base a las reglas que se hayan definido (pudiendo establecer más peso a unas características que a otras), se pueda obtener un resultado final de la calidad de los datos. Por ejemplo, si queremos calcular la calidad de los datos en base a una suma ponderada de sus características intrínsecas, en donde por el tipo de negocio, interese darle mayor peso a la exactitud, entonces se podría definir una fórmula como la siguiente:

Calidad de datos = 0.4*Exactitud + 0.15*Completitud + 0.15*Consistencia + 0.15*Credibilidad + 0.15*Actualidad

Supongamos que de forma similar se han calculado cada una de las características de la calidad en base la suma ponderada de sus propiedades, resultando los siguientes valores: Exactitud=50%, Completitud=45%, Consistencia=35%, Credibilidad=100% y Actualidad=50%. De esta forma la calidad de datos resultaría:

Calidad de datos = 0.4*50% + 0.15*45% + 0.15*35% + 0.15*100% + 0.15*50% = 54.5%

Si suponemos que se han establecido en la organización unos requisitos como los que se muestran en la siguiente tabla:

Se podría concluir que la organización en general cuenta con una calificación del dato de “3= Calidad Buena”.

En resumen, la evaluación y mejora de la calidad del conjunto de datos podrá ser todo lo exhaustiva y rigurosa que sea necesaria, y se debe llevar a cabo de manera iterativa y constante de forma que los datos vayan incrementando su calidad de forma continua, de forma que se asegure una calidad del dato mínima o incluso se pueda certificar. Esta calidad mínima del dato puede referirse a mejorar los conjuntos de datos internos a una organización, es decir, los que la organización gestiona y explota para el funcionamiento de sus procesos de negocio; o bien puede utilizarse para favorecer la compartición de conjuntos de datos mediante el nuevo paradigma de los espacios de datos generando nuevas oportunidades de mercado. En este último caso, cuando una organización quiera integrar sus datos en un espacio de datos para su futura intermediación, es conveniente realizar una evaluación de calidad, etiquetando el conjunto de datos adecuadamente en referencia a su calidad (quizás mediante su metadatado). Un dato de calidad contrastada tiene una utilidad y un valor distinto de aquel que carece de ella, posicionando al primero en un lugar preferencial dentro del mercado competitivo.

El contenido de esta guía, así como del resto de especificaciones UNE mencionadas, puede visualizarse de forma libre y gratuita desde el portal de AENOR a través del enlace que figura a continuación accediendo al apartado de compra y marcando “lectura” en el desplegable en el que aparece preseleccionado “pdf”. El acceso a esta familia de especificaciones UNE del dato está patrocinado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, Dirección General del Dato. Aunque la visualización requiere registro previo, se aplica un descuento del 100% sobre el total del precio que se aplica en el momento de finalizar la compra. Tras finalizar la compra se podrá acceder a la norma o normas seleccionadas desde el área de cliente en el apartado mis productos.

ESPECIFICACION UNE 0081:2023 | Normas AENOR

https://tienda.aenor.com/norma-une-especificacion-une-0080-2023-n0071383

https://tienda.aenor.com/norma-une-especificacion-une-0079-2023-n0071118

https://tienda.aenor.com/norma-une-especificacion-une-0078-2023-n0071117

https://tienda.aenor.com/norma-une-especificacion-une-0077-2023-n0071116

El pasado 11 de septiembre se celebró un webinar en el que se llevó a cabo un repaso sobre Gaia-X, desde sus fundamentos, encarnados por su arquitectura y modelo de confianza denominado Trust Framework, pasando por los Servicios de Federación con los que se trata de facilitar y agilizar el acceso a la infraestructura, hasta el catálogo de servicios que unos usuarios (proveedores) podrán poner a disposición de otros (consumidores).

El webinar dirigido por la gerente del Hub español de Gaia-X, estuvo protagonizado por dos de los expertos de la Oficina del Dato, que a través de sus ponencias guiaron a la audiencia hacia un mayor conocimiento de los que es la iniciativa Gaia-X. Al final de la sesión. se contó con una dinámica de preguntas y respuestas en la que se pudo profundizar en detalle. Se puede acceder a la grabación de este seminario desde la página oficial del Hub: [Forjando el Futuro de los Espacios de Datos Federados en Europa | Gaia-X (gaiax.es)

Gaia-X como pieza clave para forjar los Espacios de Datos europeos

Gaia-X surge como un innovador paradigma con el que facilitar la integración de los recursos informáticos. En base a modelos tecnológicos de la Web 3.0, se habilita la identificación y trazabilidad de diferentes recursos de datos, desde conjuntos de datos, algoritmos, diferentes modelos semánticos o de otra índole conceptual, a incluso infraestructura tecnológica subyacente (recursos de nube). Esto sirve para visibilizar el origen y el funcionamiento de estas entidades, lo que permite facilitar la transparencia y el cumplimiento de normativas y los valores europeos.

Más concretamente, Gaia-X proporciona diferentes servicios encargados de verificar automáticamente el cumplimiento de unas reglas mínimas de interoperabilidad, lo que permite después definir reglas más abstractas con un foco de negocio, o incluso como base para definir e instanciar la Nube Confiable y los espacios soberanos de datos. Estos servicios se operacionalizarán mediante diferentes nodos de interoperabilidad de Gaia-X, o Gaia-X Digital Clearing Houses.

Con Gaia-X como herramienta podremos publicar, encontrar y explotar un catálogo de servicios que cubrirá diferentes servicios según los requerimientos del usuario. Por ejemplo, para infraestructura cloud estos pueden ser características como la residencia en territorio europeo o el cumplimiento de normativas UE (como el eIDAS o el RGPD, o las normas de intermediación de datos presentes en el Reglamento de Gobernanza de Datos), y también crear servicios combinables, agregando piezas de diferentes proveedores (algo complejo en estos momentos). También se encontrarán conjuntos de datos específicos con los que entrenar modelos de Inteligencia Artificial, y sobre los cuales su propietario tendrá control gracias a la trazabilidad habilitada, hasta la ejecución de algoritmos y apps sobre datos propios del consumidor, de forma que se preserve en todo momento la privacidad de los mismos.

Como vemos, esta novedosa capacidad de trazabilidad, basada en tecnologías punteras, sirve como acicate del Compliance, y por ello es una pieza fundamental en el despliegue de los espacios de datos interoperables a nivel europeo y el mercado único digital.

Motivación

Hoy en día, en un entorno en constante cambio y en el que la generación de datos está creciendo de forma exponencial, es necesario establecer procesos comunes a lo largo del ciclo de vida de los activos de datos de toda organización. Disponer de datos bien gobernados, gestionados y con niveles adecuados de calidad se convierte en una necesidad para todo tipo de instituciones, siendo necesaria una metodología de evaluación común que pueda ayudar a una mejora continua de dichos procesos y permita evaluar la madurez de una organización de forma estandarizada.

El desarrollo de un marco homogéneo de evaluación de la madurez para una organización, con relación al tratamiento que hace de los datos, brinda la oportunidad de analizar detalladamente los procedimientos internos que realiza, identificando debilidades asociadas a esos procedimientos y permitiendo establecer planes de acción para su optimización y mejora. Al fortalecer estos procesos internos se garantiza una mayor confiabilidad y calidad de los datos, lo que también redunda en una mayor y más fácil participación en los nuevos mercados de datos, habilitando estos la comercialización y compartición de datos con soberanía, confianza y seguridad. Este innovador paradigma favorece la colaboración entre organizaciones, aprovechando sus sinergias, y generando además un desarrollo de entornos empresariales más eficientes y de mayor innovación.

El mencionado proceso de evaluación se podrá llevar a cabo de forma estandarizada gracias al desarrollo y publicación de la nueva especificación UNE 0080, y debe considerarse como un proceso de mejora continua. A lo largo de ese camino, entidades reconocidas e independientes podrán emitir certificaciones que validen que una organización cumple con ciertos estándares y requisitos establecidos, de tal forma que una organización pueda demostrar su compromiso y excelencia con los estándares, lo cual servirá para lograr un buen posicionamiento en el competitivo mercado de la economía del dato.

Especificaciones UNE – Guía de Evaluación del Gobierno, Gestión y Gestión de la Calidad del Dato

La Oficina del Dato ha patrocinado, promovido y participado en la generación de la especificación nacional UNE 0080:2023, con la que dar respuesta a la necesidad de contar con una guía de evaluación de procesos basada en estándares internacionales, con la que organizaciones tanto públicas como privadas, puedan evaluar de forma sistemática el estado actual o grado de consecución de sus procesos de trabajo en materia de gobierno, gestión y gestión de calidad del dato en base a la definición dada para esos procesos en las especificaciones UNE de Gobierno del dato UNE 0077:2023, Gestión del dato UNE 0078:2023, y Gestión de la calidad del dato UNE 0079:2023. Esta nueva especificación se encuentra dirigida a los responsables de implantar y supervisar los procesos de gobierno, gestión y calidad del dato en sus respectivas organizaciones, de tal forma que aseguren su buen funcionamiento o, en caso de que sea necesario, sean capaz de mejorarlos, así como a los consultores y auditores que necesiten llevar a cabo una evaluación de dichos procesos.

El modelo de evaluación de los procesos desarrollado en la guía está basado en la familia de normas internacionales ISO/IEC 33000, mientras que el modelo de madurez de la organización asociado a esa evaluación de los procesos está basado en el Modelo Alarcos de Madurez de Datos (MAMD) según las normas ISO 8000.

En la siguiente figura se pueden ver los 22 procesos definidos en las especificaciones UNE (0077, 0078 y 0079) distribuidos por los diferentes niveles de madurez organizacional con los que están relacionados. Es importante matizar que en esta figura no se muestran los niveles de capacidad de cada proceso, los cuales se desarrollan a continuación.

Modelo de Evaluación de procesos

El modelo de evaluación de procesos establece que cada uno de los 22 procesos definidos en las diferentes especificaciones (5 de Gobierno, 13 de gestión y 4 de gestión de la calidad) tienen distintos niveles de capacidad o grados de mejora, siendo el nivel 0 el más básico (no implementado) y el nivel 5 el más avanzado (innovado).

Cada nivel de capacidad de un proceso lleva asociados unos atributos de proceso (o requisitos) que es necesario cumplir para alcanzar dicho nivel de capacidad, siendo necesario no sólo cumplir los atributos de proceso del nivel a alcanzar, sino también los relativos a niveles inferiores. Los atributos de proceso por nivel de capacidad son los siguientes:

En la guía de evaluación se detallan exactamente qué requisitos son necesarios satisfacer para dar por cumplido cada atributo de proceso, así como sus métricas de evaluación para concluir si un atributo de proceso está No implementado (N), Parcialmente implementado (P), Ampliamente implementado (A) o Totalmente implementado (T). Por tanto, si por ejemplo queremos afirmar que un determinado proceso de nuestra organización está a un nivel de capacidad “Nivel 2 - Proceso Gestionado”, los atributos del proceso relativos al nivel 1 deben de estar Totalmente implementados (T) y los relativos al nivel 2 al menos Ampliamente implementados (A) o Totalmente implementados (T).

Modelo de Evaluación de madurez de la organización

La guía propone que para determinar el nivel de madurez de la organización en conjunto, será necesario no sólo que ésta realice los procesos propios de cada nivel, tal y como se muestra en la figura anterior, sino que estos también alcancen el nivel de capacidad acorde al nivel de madurez contra el que se evalúa.

Pongamos un ejemplo: si una organización quiere evaluar y acreditar que cumple con el nivel 2 de madurez organizacional “Gestionado”, necesita realizar al menos todos los procesos relativos al nivel de madurez 1 (2 procesos) y al nivel 2 (7 procesos), y que estos además estén desarrollados a un nivel de capacidad mínimo de grado 2 (proceso gestionado) mediante la certificación de sus respectivos atributos de proceso (‘totalmente implementado’ los atributos de procesos del nivel de capacidad 1 y ‘ampliamente implementados’ o ‘totalmente implementados’ los atributos de procesos relativos al nivel 2). Así, tal y como se muestra en la Figura 4 resumen de la evaluación de madurez organizacional, puede observarse como todos los procesos relativos al nivel gestionado han sido evaluados en cuanto a su capacidad como implementados al menos ampliamente.

En resumen, gracias al desarrollo de esta especificación o guía, las organizaciones van a disponer de una herramienta estandarizada para ser capaces de autoevaluar sus procesos en torno al gobierno del dato, gestión del dato, y gestión de la calidad del dato. Además, resulta también posible que puedan ser evaluadas por entidades externas certificadoras en última instancia, que acrediten no sólo la madurez organizacional, sino también una calidad del dato mínima, para escenarios en que éste vaya a ser compartido con otros participantes del ecosistema.

El contenido de esta guía, así como del resto de especificaciones UNE mencionadas, puede visualizarse de forma libre y gratuita desde el portal de AENOR a través del enlace que figura a continuación accediendo al apartado de compra y marcando “lectura” en el desplegable en el que aparece preseleccionado “pdf”. El acceso a esta familia de especificaciones UNE del dato está patrocinado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, Dirección General del Dato. Aunque la visualización requiere registro previo, se aplica un descuento del 100% sobre el total del precio que se aplica en el momento de finalizar la compra. Tras finalizar la compra se podrá acceder a la norma o normas seleccionadas desde el área de cliente en el apartado mis productos.

- ESPECIFICACION UNE 0077:2023

- ESPECIFICACION UNE 0078:2023

- ESPECIFICACION UNE 0079:2023

- ESPECIFICACION UNE 0080:2023

En el siguiente vídeo se presenta un resumen de las mencionadas guías.

La Oficina del Dato elabora dos guías de ayuda para la concepción eficaz de espacios de datos

El concepto de espacio de datos, entendido como un ecosistema de compartición voluntaria de datos en un entorno de confianza, seguridad y soberanía, se va a desplegar con todo su potencial a lo largo de los próximos años, como apuesta clave de la Unión Europea para impulsar la economía del dato y preservar su soberanía digital. Dichos espacios se construyen alrededor de casos de uso concretos de compartición y explotación de datos donde satisfacer necesidades de negocio concretas, un proceso para el que no resulta sencillo descubrir dichas necesidades, ni su óptimo diseño, al estar presentes diversas consideraciones y áreas de conocimiento.

Para rebajar las barreras de entrada ligadas a su concepción, la Oficina del Dato, dependiente de la Secretaría de Estado de Digitalización e Inteligencia Artificial, ejerciendo su función de dinamizar el gobierno, gestión, compartición y el uso de datos, ha publicado sendas guías que facilitarán la puesta en marcha de casos de uso de compartición de datos: la Guía de evaluación de viabilidad de casos de uso y la Guía de diseño de casos de uso.

Ambos documentos tienen como objetivo ayudar a los potenciales creadores de espacios de datos a superar los desafíos propios de la puesta en marcha de un caso de uso de compartición de datos. En este sentido, las guías orientan paso a paso y en las sucesivas etapas del proceso, proporcionando plantillas con preguntas concretas a las diferentes situaciones que se irán presentando en su diseño. El uso de estas guías debe entenderse de forma iterativa, permitiendo un proceso de refinamiento; así, una vez establecida la viabilidad de un determinado escenario, se abordará su diseño detallado, en un proceso en el que la propia dinámica puede llevar a provocar un replanteamiento de la etapa original de viabilidad. De igual forma, las preguntas presentes en cada paso pueden provocar matizaciones en los pasos anteriores, permitiendo en todo momento una progresiva mejora.

Las guías tienen como origen el contenido de los trabajos realizados desde la iniciativa Data Sharing Coalition. Trabajos en los que, compartiendo experiencia y conocimiento, las organizaciones abordaron el desafío que supuso iniciar el camino de crear en la práctica casos de uso de compartición y explotación de datos. Tomando como base esta referencia, las guías que aquí presentamos han ido evolucionando y han sido particularizadas para el contexto español, siendo enriquecidas igualmente con las aportaciones de los participantes a los eventos de dinamización de espacios de datos organizados por la Oficina del Dato.

Guía de evaluación de viabilidad de casos de uso

La Guía de evaluación de viabilidad de casos de uso permite generar, describir y evaluar ideas de casos de uso escalables de compartición de datos. Con el objetivo final de tomar una decisión acerca de la viabilidad del escenario propuesto, la guía plantea una metodología estructurada a lo largo de cinco pasos: generación del caso de uso, definición de su alcance, evaluación del potencial, estudio de la complejidad de la interacción y toma de decisión final de viabilidad.

Guía de diseño de casos de uso

Una vez abordada la viabilidad del escenario planteado, y si ésta se estimase afirmativa, la Guía de diseño de casos de uso ofrece el soporte necesario para su puesta en marcha. En este punto, se incide tanto en su escalabilidad como en la reutilización de los datos más allá del ámbito inicial. A la hora de diseñar de forma óptima un caso de uso de intercambio y explotación de datos, creemos que las cuestiones de implementación técnica representan tan sólo uno de los factores a tomar en cuenta, resaltando también la criticidad de consideraciones tales como su gobernanza, el modelo de negocio, la experiencia de usuario y los diversos aspectos regulatorios sobre los que se articula y opera.

La Guía, a lo largo de diferentes etapas, aborda la definición detallada del caso de uso, fijando el objetivo y alcance, identificando las funcionalidades que permiten habilitar la compartición de datos, y detallando qué habilitadores permiten el desarrollo de dichas funcionalidades. Gracias al enfoque práctico de la guía, en ella se incluyen útiles plantillas de preguntas-clave que permiten descubrir fácilmente los diversos aspectos a considerar, abordando temas como los principios rectores del caso de uso, el modelo de iteración, los componentes funcionales, las reglas y regulaciones, los contratos, la privacidad, la gestión de la información y los riesgos, las herramientas de apoyo, o incluso los acuerdos de nivel de servicio o la planificación del proyecto.

Los documentos base de ambas guías, las plantillas de preguntas en formato de hoja de cálculo para facilitar su cumplimentación, así como un ejemplo relativo a la viabilidad del proyecto “Caminos de pasión” facilitado por la Fundación Santa María la Real, se encuentran disponibles a través de los siguientes enlaces.

Un espacio de datos es un marco de desarrollo que permite la creación de un ecosistema completo proporcionando una estructura organizativa, normativa, técnica y de gobernanza con el objetivo de facilitar el intercambio confiable y seguro de distintos activos de datos para el beneficio común de todos los actores implicados y asegurando que se cumpla con toda la normativa y leyes aplicables. Los espacios de datos son, además, un elemento clave de la nueva estrategia de datos de la Unión Europea y una pieza imprescindible a la hora de materializar el objetivo del mercado único de datos europeo.

Como parte de esta estrategia, la Unión Europea está actualmente explorando la creación de varios pilotos de espacios de datos en algunos sectores y dominios estratégicos: sanidad, industria, agricultura, finanzas, movilidad, Pacto Verde, energía, Administración pública y competencias. Estos espacios de datos ofrecen un gran potencial a la hora de ayudar a las organizaciones a mejorar en la toma de decisiones, aumentar la innovación, desarrollar nuevos productos, servicios y modelos de negocio, reducir costes y evitar duplicar esfuerzos. Sin embargo, la creación de un espacio de datos exitoso no es una actividad trivial y requiere analizar cuidadosamente los casos de uso primero y enfrentarse después a grandes desafíos en los ámbitos de negocio, legal, operativo, funcional, tecnológico y de gobernanza.

Es por ello que, como medida de apoyo, se ha creado también el Centro de Soporte para los Espacios de Datos (Data Spaces Support Centre o DSSC), un órgano que se encarga de proporcionar orientación, herramientas y recursos a todas aquellas organizaciones interesadas en crear nuevos espacios de datos o participar en ellos. Uno de los primeros recursos elaborados por el DSSC ha sido precisamente el kit de iniciación a los espacios de datos, cuya versión final se ha publicado recientemente y que proporciona una guía inicial básica para entender cuáles son los elementos básicos de un espacio de datos y cómo afrontar los diferentes desafíos que se plantean a la hora de construirlos. Repasamos a continuación algunas de las principales pautas y recomendaciones que nos ofrece este kit de iniciación.

El valor de los espacios de datos y sus modelos de negocio

Los espacios de datos pueden resultar una alternativa real a las plataformas unidireccionales actuales, generando modelos de negocio basados en los efectos de red que dan respuesta tanto a la oferta como a la demanda de datos. Entre los distintos patrones de modelo de negocio existentes en los espacios de datos podemos encontrar:

- Reparto de costes: todos los participantes ahorran tiempo y dinero al compartir los datos con un objetivo común, como por ejemplo la red inteligente de proveedores conectados SCSN.

- Innovación conjunta: la innovación sólo es posible si se comparten los datos al no disponer ninguno de los participantes de los datos completos de forma individual, como por ejemplo en la plataforma Eona-X de movilidad, transporte y turismo.

- Fuerzas combinadas: distintos actores se unen para evitar que un único agente pueda dominar un determinado espacio, como en la red de datos de fabricación EuPro Gigant.

- Mercado compartido: actores que tienen intereses comunes comparten datos entre sí para poder beneficiarse mutuamente, como por ejemplo la red de automoción Catena-X.

- Mayor bien común: cuando los sectores público y privado comparten datos con una finalidad social, como por ejemplo en el espacio de datos de movilidad que en España se desarrolla a través del Grupo de Trabajo de Movilidad del Hub Gaia-X.

Los aspectos legales

La parte legal de los espacios de datos puede constituir un gran desafío al moverse estos necesariamente entre múltiples marcos legales y regulaciones, tanto nacionales como europeos. Para afrontar este reto, el Data Spaces Support Centre propone la elaboración de un marco de referencia compuesto de tres instrumentos principales:

- Los marcos jurídicos transversales que serán de aplicación a todos los espacios de datos, como la ley contractual, la protección de datos, la propiedad intelectual, las leyes de competencia o las de ciberseguridad.

- Los aspectos organizativos a considerar a la hora de establecer modelos y mecanismos para la gobernanza de los datos en cada caso específico.

- La dimensión contractual a tener en cuenta a la hora de intercambiar datos y los acuerdos y términos de uso que se deben establecer para que eso sea posible.

Las actividades operativas

El diseño de las actividades operativas deberá abordar los acuerdos que posibiliten el funcionamiento organizativo del espacio de datos, como por ejemplo pautas para la incorporación de nuevos participantes, sobre la toma de decisiones y para la resolución de conflictos.

Además, se deberán también tener en cuenta las operaciones de carácter empresarial, como la racionalización y automatización de procesos, las tareas de marketing y las actividades de sensibilización, que son también componentes importantes de las actividades operativas.

Funcionalidad de los espacios de datos

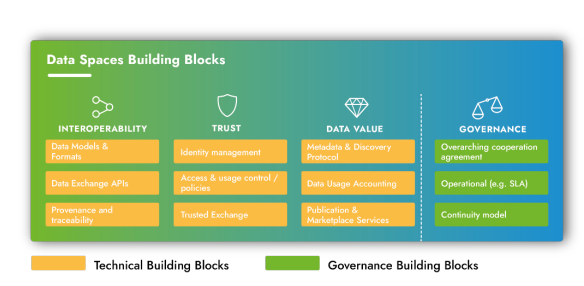

Los espacios de datos compartirán una serie de componentes básicos (o building blocks) que serán los que ofrezcan la funcionalidad mínima esperada de los mismos, incluyendo al menos los siguientes elementos:

- Interoperabilidad: modelos de datos y formatos, interfaces de intercambio de datos y origen y trazabilidad.

- Confianza: gestión de la identidad, control de acceso y uso e intercambios de datos seguros.

- Valor del dato: metadatos y protocolos de localización, contabilidad del uso de los datos y servicios de publicación y comerciales.

- Gobernanza: acuerdos de cooperación y de nivel de servicio y modelos de continuidad.

Si bien cabe esperar que estos componentes sean comunes a todos los espacios de datos y ofrezcan una funcionalidad similar, cada espacio de datos en particular podrá tomar las decisiones de diseño que estime más oportunas a la hora de implementarlos y llevarlos a cabo.

Aspectos tecnológicos

Los espacios de datos están diseñados de manera que sean agnósticos en cuanto a la tecnología, es decir, que se definen únicamente en términos de funcionalidad y con libertad en cuanto a la elección de las tecnologías específicas para su implementación. En este escenario será importante establecer referencias claras en cuanto a:

- Una base formal de estándares de facto que se deberán seguir.

- Especificaciones que sirvan como referencia para las distintas implementaciones.

- Implementaciones de código abierto de los componentes básicos llevadas a cabo por otros agentes.

Gobernanza de los espacios de datos

Para diseñar, poner en marcha y mantener un espacio de datos es necesario que múltiples organizaciones colaboren de forma conjunta y en diferentes funciones. Esto requiere que estas entidades construyan una visión común de los aspectos clave de dicha colaboración a través de un marco de gobernanza.

Para ello, se deberá llevar a cabo un ejercicio de diseño conjunto a través del cual los actores interesados lleguen a la formalización de una serie de acuerdos que definan los aspectos estratégicos y operativos clave, como las cuestiones legales, la descripción de la red de participantes, el código de conducta, los términos y condiciones de uso, los acuerdos de constitución y adhesión al espacio de datos o el modelo de gobierno.

En un futuro próximo el centro de soporte DSSC identificará los componentes básicos de cada una de las dimensiones descritas anteriormente y proporcionará orientación adicional para cada uno de ellos a través de la elaboración de un plan común (o blueprint) para los espacios de datos. Así pues, si os estáis planteando participar en alguna de las iniciativas de espacios de datos que se están poniendo en marcha, pero no tenéis muy claro por dónde empezar, entonces este kit básico de iniciación os resultará sin duda un recurso valioso a la hora de comprender los conceptos básicos – junto con el glosario que explica toda la terminología relacionada. Tampoco olvidéis subscribiros al boletín de noticias del centro de soporte para estar al tanto de todas las novedades, documentación y los servicios de apoyo que ofrece.

Contenido elaborado por Carlos Iglesias, Open data Researcher y consultor, World Wide Web Foundation. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.