Durante los últimos años hemos visto avances espectaculares en el uso de la inteligencia artificial (IA) y, detrás de todos estos logros, siempre encontraremos un mismo ingrediente común: los datos. Un ejemplo ilustrativo y conocido por todo el mundo es el de los modelos de lenguaje utilizados por OpenAI para su famoso ChatGPT, como por ejemplo GPT-3, uno de sus primeros modelos que fue entrenado con más de 45 terabytes de datos, convenientemente organizados y estructurados para que resultaran de utilidad.

Sin suficiente disponibilidad de datos de calidad y convenientemente preparados, incluso los algoritmos más avanzados no servirán de mucho, ni a nivel social ni económico. De hecho, Gartner estima que más del 40% de los proyectos emergentes de agentes de IA en la actualidad terminarán siendo abandonados a medio plazo debido a la falta de datos adecuados y otros problemas de calidad. Por tanto, el esfuerzo invertido en estandarizar, limpiar y documentar los datos puede marcar la diferencia entre una iniciativa de IA exitosa y un experimento fallido. En resumen, el clásico principio de “basura entra, basura sale” en la ingeniería informática aplicado esta vez a la inteligencia artificial: si alimentamos una IA con datos de baja calidad, sus resultados serán igualmente pobres y poco fiables.

Tomando consciencia de este problema surge el concepto de AI Data Readiness o preparación de los datos para ser usados por la inteligencia artificial. En este artículo exploraremos qué significa que los datos estén "listos para la IA", por qué es importante y qué necesitaremos para que los algoritmos de IA puedan aprovechar nuestros datos de forma eficaz. Esto revierta en un mayor valor social, favoreciendo la eliminación de sesgos y el impulso de la equidad.

¿Qué implica que los datos estén "listos para la IA"?

Tener datos listos para la IA (AI-ready) significa que estos datos cumplen una serie de requisitos técnicos, estructurales y de calidad que optimizan su aprovechamiento por parte de los algoritmos de inteligencia artificial. Esto incluye múltiples aspectos como la completitud de los datos, la ausencia de errores e inconsistencias, el uso de formatos adecuados, metadatos y estructuras homogéneas, así como proporcionar el contexto necesario para poder verificar que estén alineados con el uso que la IA les dará.

Preparar datos para la IA suele requerir de un proceso en varias etapas. Por ejemplo, de nuevo la consultora Gartner recomienda seguir los siguientes pasos:

- Evaluar las necesidades de datos según el caso de uso: identificar qué datos son relevantes para el problema que queremos resolver con la IA (el tipo de datos, volumen necesario, nivel de detalle, etc.), entendiendo que esta evaluación puede ser un proceso iterativo que se refine a medida que el proyecto de IA avanza.

- Alinear las áreas de negocio y conseguir el apoyo directivo: presentar los requisitos de datos a los responsables según las necesidades detectadas y lograr su respaldo, asegurando así los recursos requeridos para preparar los datos adecuadamente.

- Desarrollar buenas prácticas de gobernanza de los datos: implementar políticas y herramientas de gestión de datos adecuadas (calidad, catálogos, linaje de datos, seguridad, etc.) y asegurarnos de que incorporen también las necesidades de los proyectos de IA.

- Ampliar el ecosistema de datos: integrar nuevas fuentes de datos, romper potenciales barreras y silos que estén trabajando de forma aislada dentro de la organización y adaptar la infraestructura para poder manejar los grandes volúmenes y variedad de datos necesarios para el correcto funcionamiento de la IA.

- Garantizar la escalabilidad y cumplimiento normativo: asegurar que la gestión de datos pueda escalar a medida que crecen los proyectos de IA, manteniendo al mismo tiempo un marco de gobernanza sólido y acorde con los protocolos éticos necesarios y el cumplimiento de la normativa existente.

Si seguimos una estrategia similar a esta estaremos consiguiendo integrar los nuevos requisitos y necesidades de la IA en nuestras prácticas habituales de gobernanza del dato. En esencia, se trata simplemente de conseguir que nuestros datos estén preparados para alimentar modelos de IA con las mínimas fricciones posibles, evitando posibles contratiempos a posteriori durante el desarrollo de los proyectos.

Datos abiertos “preparados para IA”

En el ámbito de la ciencia abierta y los datos abiertos se han promovido desde hace años los principios FAIR. Estas siglas en inglés establecen que los datos deben localizables, accesibles, interoperables y reutilizables. Los principios FAIR han servido para guiar la gestión de datos científicos y datos abiertos para hacerlos más útiles y mejorar su uso por parte de la comunidad científica y la sociedad en general. Sin embargo, dichos principios no fueron diseñados para abordan las nuevas necesidades particulares asociadas al auge de la IA.

Se plantea por tanto en la actualidad la propuesta de extender los principios originales añadiendo un quinto principio de preparación (readiness) para la IA, pasando así del FAIR inicial a FAIR-R o FAIR². El objetivo sería precisamente el de hacer explícitos aquellos atributos adicionales que hacen que los datos estén listos para acelerar su uso responsable y transparente como herramienta necesaria para las aplicaciones de la IA de alto interés público.

¿Qué añadiría exactamente esta nueva R a los principios FAIR? En esencia, enfatiza algunos aspectos como:

- Etiquetado, anotado y enriquecimiento adecuado de los datos.

- Transparencia sobre el origen, linaje y tratamiento de los datos.

- Estándares, metadatos, esquemas y formatos óptimos para su uso por parte de la IA.

- Cobertura y calidad suficientes para evitar sesgos o falta de representatividad.

En el contexto de los datos abiertos, esta discusión es especialmente relevante dentro del discurso de la "cuarta ola" del movimiento de apertura de datos, a través del cual se argumenta que si los gobiernos, universidades y otras instituciones liberan sus datos, pero estos no se encuentran en las condiciones óptimas para poder alimentar a los algoritmos, se estaría perdiendo una oportunidad única para todo un nuevo universo de innovación e impacto social: mejoras en los diagnósticos médicos, detección de brotes epidemiológicos, optimización del tráfico urbano y de las rutas de transporte, maximización del rendimiento de las cosechas o prevención de la deforestación son sólo algunos ejemplos de las posibles oportunidades perdidas.

Además, de no ser así, podríamos entrar también en un largo “invierno de los datos”, en el que las aplicaciones positivas de la IA se vean limitadas por conjuntos de datos de mala calidad, inaccesibles o llenos de sesgos. En ese escenario, la promesa de una IA por el bien común se quedaría congelada, incapaz de evolucionar por falta de materia prima adecuada, mientras que las aplicaciones de la IA lideradas por iniciativas con intereses privados continuarían avanzando y aumentando el acceso desigual al beneficio proporcionado por las tecnologías.

Conclusión: el camino hacia IA de calidad, inclusiva y con verdadero valor social

En la era de la inteligencia artificial, los datos son tan importantes como los algoritmos. Tener datos bien preparados y compartidos de forma abierta para que todos puedan utilizarlos, puede marcar la diferencia entre una IA que aporta valor social y una que tan sólo es capaz de producir resultados sesgados.

Nunca podemos dar por sentada la calidad ni la idoneidad de los datos para las nuevas aplicaciones de la IA: hay que seguir evaluándolos, trabajándolos y llevando a cabo una gobernanza de estos de forma rigurosa y efectiva del mismo modo que se venía recomendado para otras aplicaciones. Lograr que nuestros datos estén listos para la IA no es por tanto una tarea trivial, pero los beneficios a largo plazo son claros: algoritmos más precisos, reducir sesgos indeseados, aumentar la transparencia de la IA y extender sus beneficios a más ámbitos de forma equitativa.

Por el contrario, ignorar la preparación de los datos conlleva un alto riesgo de proyectos de IA fallidos, conclusiones erróneas o exclusión de quienes no tienen acceso a datos de calidad. Abordar las asignaturas pendientes sobre cómo preparar y compartir datos de forma responsable es esencial para desbloquear todo el potencial de la innovación impulsada por IA en favor del bien común. Si los datos de calidad son la base para la promesa de una IA más humana y equitativa, asegurémonos de construir una base suficientemente sólida para poder alcanzar nuestro objetivo.

En este camino hacia una inteligencia artificial más inclusiva, alimentada por datos de calidad y con verdadero valor social, la Unión Europea también está avanzando con pasos firmes. A través de iniciativas como su estrategia de la Data Union, la creación de espacios comunes de datos en sectores clave como salud, movilidad o agricultura, y el impulso del llamado AI Continent y las AI factories, Europa busca construir una infraestructura digital donde los datos estén gobernados de forma responsable, sean interoperables y estén preparados para ser utilizados por sistemas de IA en beneficio del bien común. Esta visión no solo promueve una mayor soberanía digital, sino que refuerza el principio de que los datos públicos deben servir para desarrollar tecnologías al servicio de las personas y no al revés.

Content prepared by Carlos Iglesias, Open data Researcher and consultant, World Wide Web Foundation. The contents and views reflected in this publication are the sole responsibility of the author.

Como dicta la tradición, el fin de año es un buen momento para reflexionar sobre nuestras metas y objetivos de cara a la nueva etapa que comienza tras las campanadas. En materia de datos, el inicio de un nuevo año también brinda oportunidades para trazar un futuro interoperable y digital que habilite el desarrollo de una economía del dato robusta, un escenario que beneficie tanto a investigadores como administraciones públicas o empresas privadas, así como que repercuta positivamente en el ciudadano como cliente final de muchas operaciones realizadas con datos, optimizando y reduciendo los tiempos de tramitación. Para lograr este fin, existe la Estrategia europea de datos que persigue desbloquear el potencial de los datos a través de, entre otras, la Ley de Datos (Data Act, en inglés) que recoge un conjunto de medidas relacionadas con el acceso y uso equitativo de los datos asegurando así mismo que el dato manejado sea de calidad, esté debidamente securizado, etc.

Como solución a esta necesidad, este último año se han publicado las especificaciones UNE de datos que son recursos normativos e informativos para implantar procesos comunes de gobierno, gestión y calidad del dato. Estas especificaciones, respaldadas por la Oficina del Dato, establecen estándares para disponer de datos bien gobernados (UNE 0077), gestionados (UNE 0078) y con niveles adecuados de calidad (UNE0079), permitiendo así mismo un crecimiento sostenible en la organización durante la implantación de los distintos procesos. Además de estas tres especificaciones, la especificación UNE 0080 define una guía y proceso de evaluación de madurez para medir el grado de implantación de los procesos de gobierno, gestión, y calidad del dato. Por su parte, la UNE 0081 también establece un proceso de evaluación del activo de datos en sí, es decir, de los conjuntos de datos, independientemente de su naturaleza o tipología; en resumen, su contenido está estrechamente relacionado con la UNE 0079 porque recoge unas características de calidad de los datos. La adopción de todas ellas puede proporcionar múltiples beneficios. En este post, analizamos cuáles son y cómo sería el proceso para cada especificación.

Así, con la mirada puesta en el futuro, planteamos un propósito de año nuevo: la aplicación de las especificaciones UNE del dato a una organización.

¿Qué ventajas tiene su aplicación y cómo puedo acceder a ellas?

En la era actual, donde el gobierno y la gestión eficiente de los datos se han convertido en un pilar fundamental para el éxito organizacional, la implementación de las especificaciones UNE sobre datos emerge como un faro guía hacia la excelencia marcando el camino a seguir. Estas especificaciones describen rigurosos procesos estandarizados que ofrecen a las organizaciones la posibilidad de construir una estructura robusta y confiable para el manejo de sus datos e información a lo largo de todo su ciclo de vida.

Al adoptar las especificaciones UNE, no solo se garantiza la calidad y seguridad de los datos, sino que también se constituye una base sólida y adecuada para la toma de decisiones informadas enriqueciendo los procesos organizacionales con buenas prácticas de datos. Por lo tanto, toda organización que decida abrazar estas normativas de cara al nuevo año estará acercándose a la innovación, la eficiencia y la confianza en el gobierno y la gestión de datos; así como preparándose para afrontar los desafíos y oportunidades que depara el futuro digital. La aplicación de especificaciones UNE no solo es un compromiso con la calidad, sino una inversión estratégica que pavimenta el camino hacia el éxito sostenible en un entorno empresarial cada vez más competitivo y dinámico porque:

- Maximiza la aportación de valor a la estrategia de negocio

- Minimiza riesgos en el tratamiento del dato

- Optimiza las tareas evitando trabajos innecesarios

- Establece marcos homogéneos de referencia y certificación

- Facilita la compartición de información con confianza y soberanía

El contenido de las guías puede visualizarse de forma libre y gratuita desde el portal de AENOR a través del enlace que figura a continuación accediendo al apartado de compra y marcando “lectura” en el desplegable en el que aparece preseleccionado “pdf”. El acceso a esta familia de especificaciones UNE del dato está patrocinado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, Dirección General del Dato. Aunque la visualización requiere registro previo, se aplica un descuento del 100% sobre el total del precio que se aplica en el momento de finalizar la compra. Tras finalizar la compra se podrá acceder a la norma o normas seleccionadas desde el área de cliente en el apartado mis productos.

- ESPECIFICACION UNE 0077:2023

- ESPECIFICACION UNE 0078:2023

- ESPECIFICACION UNE 0079:2023

- ESPECIFICACIÓN UNE 0080:2023

- ESPECIFICACIÓN UNE 0081:2023

Desde datos.gob.es nos hemos hecho eco del contenido de las mismas y hemos preparado diferentes recursos didácticos como esta infografía o este vídeo explicativo.

¿Cómo se aplican a una organización?

Una vez tomada la decisión de abordar la implantación de estas especificaciones, surge un interrogante crucial: ¿Cuál es la manera más efectiva de hacerlo? La respuesta a esta cuestión dependerá de la situación inicial (marcada por una evaluación inicial de madurez), el tipo de organización y los recursos disponibles en el momento de establecer el plan director o plan de implantación. No obstante, en datos.gob.es, hemos publicado una serie de contenidos elaborados por expertos en tecnologías ligadas a la economía del dato datos.gob.es, hemos publicado una serie de contenidos elaborados por expertos en tecnologías ligadas a la economía del dato que te acompañarán en el proceso.

Antes de empezar, es importante conocer los diferentes procesos que constituyen cada una de las especificaciones UNE sobre datos. En esta imagen se exponen cuáles son.

Una vez entendido lo básico, la serie de contenidos ‘Aplicación de las especificaciones UNE sobre datos’ abordan un ejercicio práctico, desglosado en tres posts, sobre un caso de uso especifico: la aplicación de estas especificaciones a los datos abiertos. Como ejemplo, se define una necesidad que tiene el Ayuntamiento ficticio de Vistabella: avanzar en la publicación en abierto de información de transporte público y eventos culturales.

- En el primer post de la serie, se destaca la importancia de utilizar la especificación UNE 0077 de gobierno del dato para establecer mecanismos aprobados que respalden la apertura y publicación de los datos abiertos. A través de este primer contenido, se realiza un repaso de los procesos necesarios para alinear la estrategia organizacional de tal manera que se logre conseguir la máxima transparencia y calidad de los servicios públicos mediante la reutilización de información.

- El segundo artículo de la serie se sumerge en la norma UNE 0079 de gestión de calidad de los datos y su aplicación en el contexto de los datos abiertos. Este contenido subraya que la calidad de los datos abiertos va más allá de los principios FAIR y destaca la importancia de evaluar la calidad mediante criterios objetivos. A través del ejercicio práctico, se explora cómo el Ayuntamiento de Vistabella aborda los procesos de la UNE para mejorar la calidad de los datos abiertos como parte de su estrategia para potenciar la publicación de datos sobre transporte público y eventos culturales.

- Por último, la norma UNE 0078 sobre gestión de datos se explica en un tercer artículo en el que se presenta el proceso de Compartición, Intermediación e Integración de Datos (CIIDat) para la publicación de datos abiertos, combinado con plantillas específicas.

En conjunto, estos tres artículos ofrecen una guía para que cualquier organización avance con éxito hacia la publicación en abierto de información clave, asegurando la coherencia y calidad de los datos. Al seguir estos pasos, las organizaciones estarán preparadas para cumplir con los estándares normativos con todas las ventajas que supone.

Para finalizar, abrazar el propósito de año nuevo de aplicar las especificaciones UNE sobre datos representa un compromiso estratégico y visionario para cualquier organización que, además, estará alineado con la Estrategia europea de datos y la hoja de ruta europea que persigue configurar un futuro digital líder a nivel mundial.

La nueva especificación UNE 0081 Evaluación de Calidad de Datos, centrada en los datos como producto (conjuntos de datos o bases de datos), complementa la especificación UNE 0079 Gestión de la calidad del dato, que analizamos en este artículo, se focaliza en los procesos de gestión de la calidad del dato. Ambas normas, la 0079 y la 0081 se complementan y abordan de forma holística la calidad de los datos:

- La norma UNE 0079 refiere los procesos, las actividades que deber realizar la organización para garantizar los niveles adecuados de calidad de sus datos para satisfacer la estrategia que la organización se han marcado.

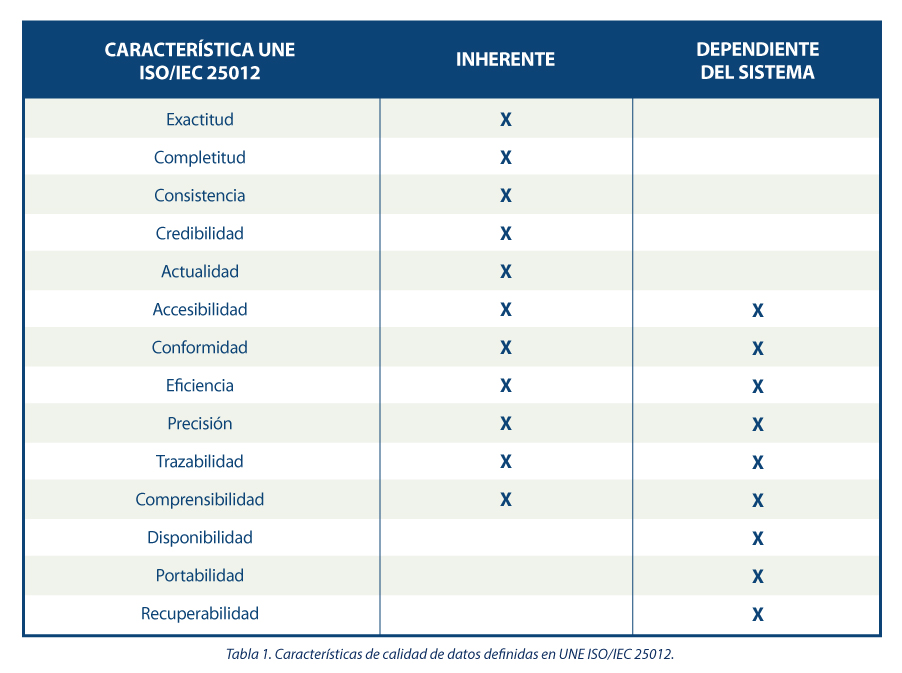

- Por otra parte, la UNE 0081 define un modelo de calidad del dato, basado en las normas ISO/IEC 25012 e ISO/IEC 25024, en el que se detallan las características de calidad que pueden tener los datos, así como algunas métricas aplicables. También define el proceso que se debe seguir para evaluar la calidad de un conjunto de datos concreto, tomando como base la norma ISO/IEC 25040. Finalmente, la especificación acaba detallando cómo interpretar los resultados obtenidos de la evaluación, mostrando ejemplos concretos de aplicación.

¿Cómo puede una organización hacer uso de esta especificación para evaluar el nivel de calidad de sus datos?

Para dar respuesta a esta pregunta, vamos a contar el ejemplo del Ayuntamiento de Vistabella, previamente utilizado en artículos anteriores. El ayuntamiento tiene una serie de conjuntos de datos, cuya calidad quiere evaluar, para poder mejorarlos y dar un mejor servicio a la ciudadanía. La institución es consciente de que trabaja con muchos tipos de datos (transaccionales, maestros, de referencia, etc.), por lo tanto, lo primero que realiza es una primera identificación de los conjuntos de datos que aportan valor y para los cuales, no disponer de niveles adecuados de calidad, puede repercutir en el día a día. Algunos criterios a la seguir a la hora de seleccionar estos conjuntos pueden ser: datos que aportan un valor al ciudadano, datos resultantes de un proceso de integración o visión maestra del dato, datos críticos por ser utilizados en varios procesos/procedimientos, etc.

El siguiente paso será determinar en qué punto(s) del ciclo de vida de los procesos operativos del ayuntamiento se realizarán estos controles de calidad del dato.

Es en este punto donde la especificación UNE 0081 entra en juego. La evaluación se hace en función de las "reglas de negocio" que definen los requerimientos, requisitos de datos o validaciones que deben cumplir los datos para que aporten valor a la organización. A continuación, se muestran algunos ejemplos:

- Los DNI de los ciudadanos tendrán que cumplir con la sintaxis específica para ello (8 números y una letra).

- Toda fecha existente en el sistema tendrá que seguir la notación DD-MM-AAAA.

- No se admitirán registros de documentación con fecha posterior a la actual.

- Se deberá tener traza de quién y cuándo ha realizado un cambio en un conjunto de datos.

Para poder identificar de forma sistemática y exhaustiva las reglas de negocio que tengan que cumplir los datos en cada etapa de su ciclo de vida, el ayuntamiento hace uso de una metodología basada en BR4DQ.

A continuación, desde el ayuntamiento, se revisan todas las características de calidad de datos incluidas dentro de la especificación, se priorizan, y se determina un primer conjunto de ellas que se querrán tener en cuenta para la evaluación. Para ello, y en esta primera etapa, el ayuntamiento decide quedarse exclusivamente con las 5 características inherentes de ISO 25012 definidas dentro de la especificación. Estas son: exactitud, completitud, consistencia, credibilidad y actualidad.

Del mismo modo, para cada una de estas primeras características que se ha acordado abordar, se identifican posibles propiedades. Para ello, finalmente, desde el ayuntamiento se decide trabajar con el siguiente modelo de calidad que incluye las siguientes características y propiedades:

Hasta este punto, el ayuntamiento tiene identificado el conjunto de datos a evaluar, así como las reglas de negocio que le aplican, y en qué aspectos de la calidad se va a centrar (modelo de calidad de datos). A continuación, es necesario llevar a cabo la medición de calidad de datos a través de la validación de las reglas de negocio. Para ello se obtienen valores para las distintas métricas, los cuales se computan siguiendo una aproximación de abajo hacia arriba hasta determinar el nivel de calidad de datos del repositorio

Definición del proceso de evaluación

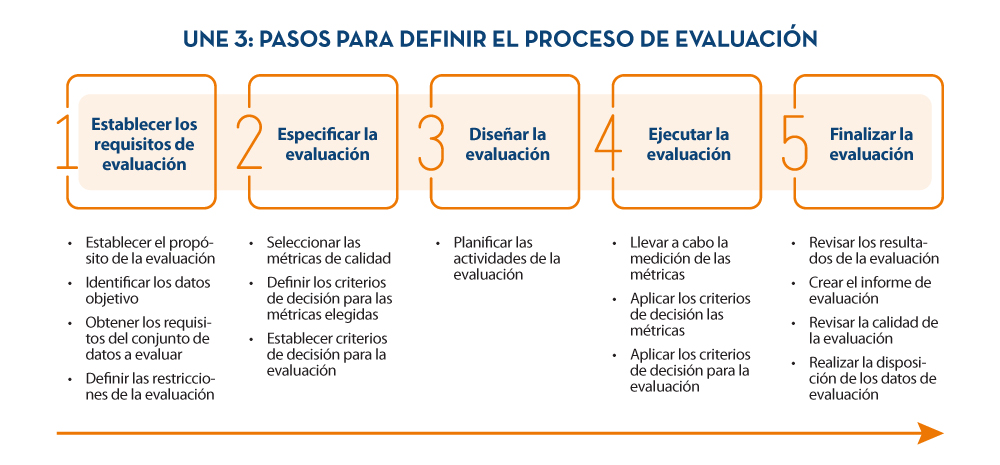

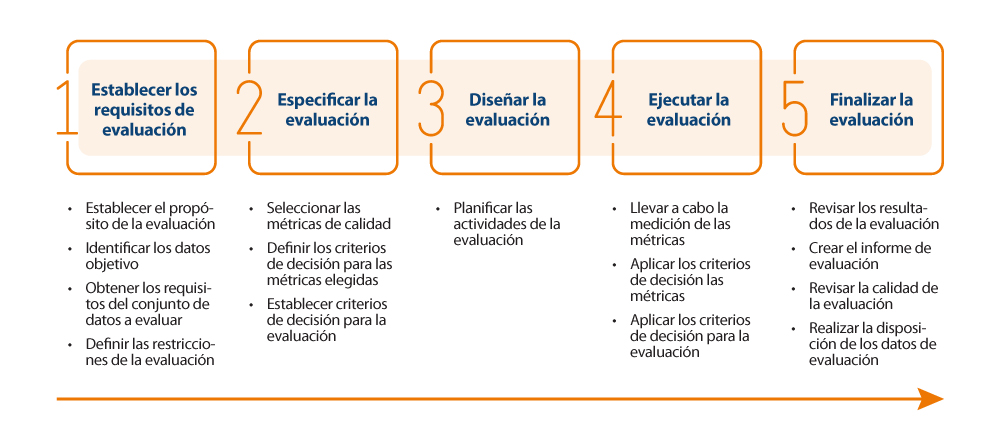

Para realizar la evaluación de una forma adecuada, se decide hacer uso del proceso de evaluación de calidad basado en ISO 25024, indicado dentro de la especificación UNE 0081 (véase a continuación).

Aplicación del proceso de evaluación

A continuación, se resumen los aspectos más destacables llevados a cabo por el Ayuntamiento durante la etapa 4 del proceso de evaluación:

- Validación del grado de cumplimiento de cada regla de negocio por propiedad: Disponiendo de todas las reglas de negocio clasificadas por propiedad, se valida el grado de cumplimiento de cada una de ellas, obteniendo así una serie de valores para cada una de las métricas. Esto se ejecuta sobre cada uno de los conjuntos de datos a evaluar.

A modo de ejemplo, para la propiedad de exactitud sintáctica se obtienen dos métricas:

- Número de registros que cumplen las reglas de negocio de exactitud sintáctica: 826.254

- Número de registros que deben cumplir las reglas de negocio de exactitud sintáctica: 850.639

- Cuantificación del valor de la propiedad: A partir de estas métricas, se cuantifica y determina el valor de la propiedad haciendo uso de la función de medición especificada en la especificación UNE 0081. Para el caso concreto de la exactitud sintáctica se determina que una densidad de registros del 97,1% cumplen todas las reglas de exactitud sintáctica.

- Cálculo del valor de la característica: Para ello, se hace uso de los resultados de cada una de las métricas de calidad de datos asociadas a una propiedad. Para calcularlo, y tal como se especifica en la especificación UNE 0081, se decide seguir una suma ponderada en la que cada propiedad tiene el mismo peso. Para el caso de la Exactitud, se dispone de los valores de Exactitud sintáctica: 97,1, Exactitud semántica: 95, y Rango de exactitud: 92,9. Computando estas 3 puntuaciones, se obtuvo un valor de 95 sobre 100 para esta característica.

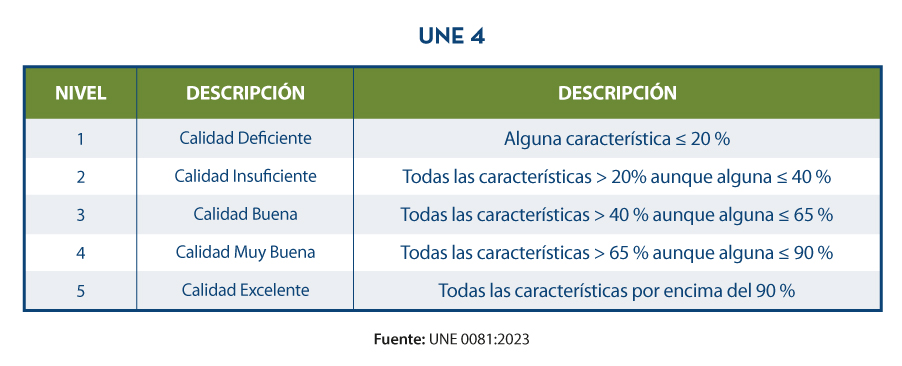

- Paso del valor cuantitativo al cualitativo: Para finalizar y poder proporcionar un resultado final de calidad, se decide hacer uso de otra suma ponderada; en este caso, todas las dimensiones tienen el mismo peso. Partiendo de los resultados agregados anteriormente de las características mencionadas: Exactitud: 95, Completitud: 87, Consistencia: 90, Credibilidad: 88, Actualidad: 93, se determina un nivel de calidad de 90 sobre 100 para el repositorio. Por último, es necesario pasar de este valor cuantitativo de 0 a 100 a un valor cualitativo. En este ejemplo concreto, haciendo, uso de la función de niveles de calidad basada en porcentajes, se concluye que el nivel de calidad del repositorio, para la propiedad analizada, es 4, o “Muy Buena”.

Visualización de resultados

Por último, y una vez realizada la evaluación de todas las características, desde el ayuntamiento se construyen una serie de cuadros de mandos de control de calidad de datos con distinto nivel de agregación (característica, propiedad, conjunto de datos y tabla/vista) partiendo de los resultados de la evaluación, de manera que rápidamente se puede consultar el nivel de calidad. Para ello, a modo de ejemplo se muestran los resultados con distinto nivel de agregación.

Como se puede ver a lo largo de todo el ejemplo de aplicación, existe una relación directa entre la aplicación de esta especificación UNE 0081, con determinadas partes de la especificación 0078, concretamente con el proceso de gestión de requisitos de datos, y con la especificación UNE 0079, al menos con los procesos de planificación y control de calidad de datos. Fruto de la evaluación se establecerán recomendaciones de mejora de calidad (acciones correctivas), que incidirán directamente en los procesos del dato establecidos, todo ello de acuerdo con el circulo de mejora continua PDCA de Deming.

Una vez finalizado el ejemplo, y como valor añadido, hay que destacar que es posible certificar el nivel de calidad de datos de los repositorios organizacionales. Para ello, será necesario contar con una entidad de certificación que provea este servicio de calidad de datos, así como con un laboratorio acreditado según la norma ISO 17025 con potestad para la emisión de informes de evaluación de calidad de datos.

El contenido de esta guía puede descargarse de forma libre y gratuita desde el portal de AENOR a través del enlace que figura a continuación accediendo al apartado de compra. El acceso a esta familia de especificaciones UNE del dato está patrocinado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, Dirección General del Dato. Aunque la descarga requiere registro previo, se aplica un descuento del 100% sobre el total del precio que se aplica en el momento de finalizar la compra. Tras finalizar la compra se podrá acceder a la norma o normas seleccionadas desde el área de cliente en el apartado mis productos.

Contenido elaborado por Dr. Fernando Gualo, Profesor en UCLM y Consultor de Gobierno y Calidad de datos. El contenido y el punto de vista reflejado en esta publicación es responsabilidad exclusiva de su autor.

Hoy en día, la calidad de los datos desempeña un papel fundamental en el mundo actual, donde la información es un activo valioso. Asegurar que los datos sean precisos, completos y confiables se ha vuelto esencial para el éxito de las organizaciones y garantiza el éxito de la toma de decisiones informadas.

La calidad de los datos tiene un impacto directo no solo en el intercambio y uso a nivel interno de cada organización, sino también en la compartición de datos entre diferentes entidades, siendo una variable clave en el éxito del nuevo paradigma de los espacios de datos. Cuando los datos son de alta calidad, se crea un entorno propicio para el intercambio de información precisa y consistente, lo cual permite a las organizaciones colaborar de manera más efectiva, fomentando la innovación y el desarrollo conjunto de soluciones.

Una buena calidad de datos facilita la reutilización de la información en diferentes contextos, generando valor más allá del sistema que los crea. Los datos de alta calidad son más fiables y accesibles, y pueden ser utilizados por múltiples sistemas y aplicaciones, lo que aumenta su valor y utilidad. Al reducir considerablemente la necesidad de realizar correcciones y ajustes constantes, se ahorra tiempo y recursos, permitiendo una mayor eficiencia en la implementación de proyectos y la creación de nuevos productos y servicios.

La calidad de los datos también juega un papel fundamental en el avance de la inteligencia artificial y el aprendizaje automático. Los modelos de IA se basan en grandes volúmenes de datos para obtener resultados precisos y confiables. Si los datos utilizados están contaminados o son de baja calidad, los resultados de los algoritmos de IA serán poco confiables o incluso erróneos. Por lo tanto, garantizar la calidad de los datos es esencial para lograr el máximo rendimiento de las aplicaciones de IA, reducir o eliminar sesgos y aprovechar su potencial al máximo.

Con el objetivo de ofrecer un proceso basado en estándares internacionales que pueda ayudar a las organizaciones a utilizar un modelo de calidad y a definir características y métricas de calidad adecuadas, la Oficina del Dato ha patrocinado, promovido y participado en la generación de la especificación UNE 0081 Evaluación de la calidad del dato que complementa la especificación ya existente UNE 0079 Gestión de la calidad del dato, centrada más en la definición de procesos de gestión de la calidad del dato que en la calidad del dato como tal.

Especificación UNE – Guía de Evaluación de la calidad del dato

La especificación UNE 0081, familia de estándares internacionales ISO/IEC 25000, permite conocer y evaluar la calidad de los datos de toda organización, permitiendo establecer un plan futuro para su mejora, y pudiéndose incluso llegar a certificar su calidad formalmente. Los destinatarios de está especificación, aplicable a cualquier tipo de organización independientemente de su tamaño o dedicación, serán los responsables de calidad de datos, así como los consultores y auditores que necesiten llevar a cabo una evaluación de los conjuntos de datos dentro de sus funciones.

La especificación primero expone el modelo de calidad del dato, en dónde se detallan las características de calidad que pueden tener los datos, así como algunas métricas aplicables, para una vez definido este marco de trabajo, pasar a definir el proceso que se debe seguir para evaluar la calidad de un conjunto de datos. Finalmente, la especificación acaba detallando como interpretar los resultados obtenidos de la evaluación mostrando algún ejemplo concreto de aplicación.

Modelo de calidad del dato

La guía propone una serie de características de calidad siguiendo las presentes en la norma ISO/IEC 25012, clasificándolas entre aquellas inherentes al dato, dependientes del sistema donde se aloja el dato o dependientes de ambas circunstancias. Se justifica la elección de estas características dado que abarcan las presentes en otros marcos de referencia tales como DAMA, FAIR, EHDS, IA Act y RGPD.

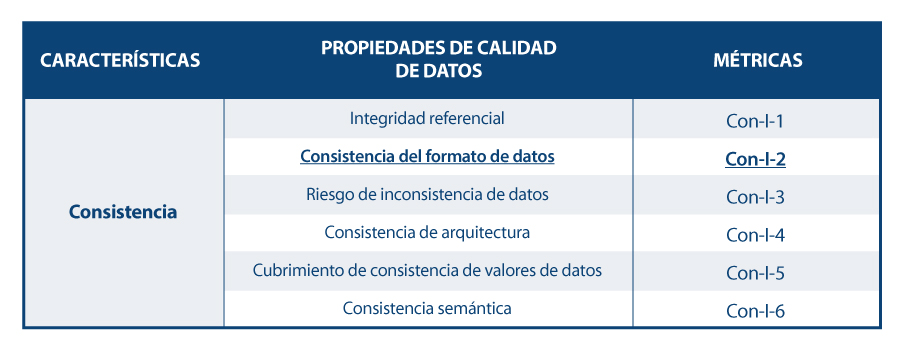

En base a las características definidas, la guía se apoya en la norma ISO/IEC 25024 para proponer un conjunto de métricas que sirvan para medir las propiedades de las características, entendiendo estas propiedades como “subcaracteristicas” de las características.

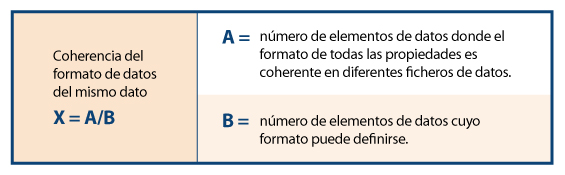

Así, a modo de ejemplo, siguiendo el esquema de dependencias, para la característica concreta de “consistencia del formato de datos” se muestran sus propiedades y métricas, detallándose una de ellas.

Proceso para evaluar la calidad de un conjunto de datos

Para realizar la evaluación en sí de la calidad de los datos, la guía propone seguir la norma ISO/IEC 25040, que establece un modelo de evaluación que tiene en cuenta tanto los requisitos y restricciones definidas por la organización, como los recursos necesarios tanto materiales como personales. Con estos requisititos, se establece un plan de evaluación a través de unas métricas y criterios de decisión concretos en función de los requisitos de negocio, que permita realizar la correcta medición de las propiedades y características e interpretar sus resultados.

A continuación, se muestra un esquema con los pasos a realizar en el proceso, así como sus principales actividades:

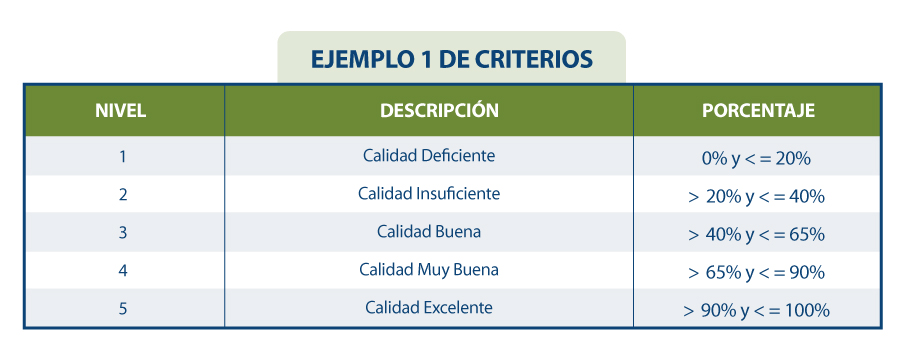

Resultados de la evaluación de calidad

El resultado de la evaluación dependerá directamente de los requisitos marcados por la organización y los criterios de cumplimiento. Las propiedades de las características suelen evaluarse de 0 a 100 a partir de los valores obtenidos en las métricas definidas para cada uno de ellos, y las características a su vez se evalúan por agregación de las anteriores también de 0 a 100 o mediante la conversión a un valor discreto de 1 a 5 (1 calidad deficiente, 5 calidad excelente) en función de las reglas de cálculo y ponderación que se hayan establecido. Al igual que de la medición de las propiedades se obtiene la de sus características, lo mismo pasa con estas características, que mediante su suma ponderada en base a las reglas que se hayan definido (pudiendo establecer más peso a unas características que a otras), se pueda obtener un resultado final de la calidad de los datos. Por ejemplo, si queremos calcular la calidad de los datos en base a una suma ponderada de sus características intrínsecas, en donde por el tipo de negocio, interese darle mayor peso a la exactitud, entonces se podría definir una fórmula como la siguiente:

Calidad de datos = 0.4*Exactitud + 0.15*Completitud + 0.15*Consistencia + 0.15*Credibilidad + 0.15*Actualidad

Supongamos que de forma similar se han calculado cada una de las características de la calidad en base la suma ponderada de sus propiedades, resultando los siguientes valores: Exactitud=50%, Completitud=45%, Consistencia=35%, Credibilidad=100% y Actualidad=50%. De esta forma la calidad de datos resultaría:

Calidad de datos = 0.4*50% + 0.15*45% + 0.15*35% + 0.15*100% + 0.15*50% = 54.5%

Si suponemos que se han establecido en la organización unos requisitos como los que se muestran en la siguiente tabla:

Se podría concluir que la organización en general cuenta con una calificación del dato de “3= Calidad Buena”.

En resumen, la evaluación y mejora de la calidad del conjunto de datos podrá ser todo lo exhaustiva y rigurosa que sea necesaria, y se debe llevar a cabo de manera iterativa y constante de forma que los datos vayan incrementando su calidad de forma continua, de forma que se asegure una calidad del dato mínima o incluso se pueda certificar. Esta calidad mínima del dato puede referirse a mejorar los conjuntos de datos internos a una organización, es decir, los que la organización gestiona y explota para el funcionamiento de sus procesos de negocio; o bien puede utilizarse para favorecer la compartición de conjuntos de datos mediante el nuevo paradigma de los espacios de datos generando nuevas oportunidades de mercado. En este último caso, cuando una organización quiera integrar sus datos en un espacio de datos para su futura intermediación, es conveniente realizar una evaluación de calidad, etiquetando el conjunto de datos adecuadamente en referencia a su calidad (quizás mediante su metadatado). Un dato de calidad contrastada tiene una utilidad y un valor distinto de aquel que carece de ella, posicionando al primero en un lugar preferencial dentro del mercado competitivo.

El contenido de esta guía, así como del resto de especificaciones UNE mencionadas, puede visualizarse de forma libre y gratuita desde el portal de AENOR a través del enlace que figura a continuación accediendo al apartado de compra y marcando “lectura” en el desplegable en el que aparece preseleccionado “pdf”. El acceso a esta familia de especificaciones UNE del dato está patrocinado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, Dirección General del Dato. Aunque la visualización requiere registro previo, se aplica un descuento del 100% sobre el total del precio que se aplica en el momento de finalizar la compra. Tras finalizar la compra se podrá acceder a la norma o normas seleccionadas desde el área de cliente en el apartado mis productos.

ESPECIFICACION UNE 0081:2023 | Normas AENOR

https://tienda.aenor.com/norma-une-especificacion-une-0080-2023-n0071383

https://tienda.aenor.com/norma-une-especificacion-une-0079-2023-n0071118

https://tienda.aenor.com/norma-une-especificacion-une-0078-2023-n0071117

https://tienda.aenor.com/norma-une-especificacion-une-0077-2023-n0071116

Los libros son una fuente inagotable de conocimientos y de experiencias vividas por otros antes que nosotros, que podemos reutilizar para avanzar en nuestras vidas. Las bibliotecas, por tanto, son lugares donde los lectores que buscan libros, los toman prestados y una vez usados y extraído de ellos lo que necesitan, los devuelven. Resulta curioso imaginar las razones por las que un lector necesita encontrar un libro concreto que trate de un determinado tema.

En caso de que haya varios libros que cumplan con las características requeridas, cuáles pueden ser los criterios que pesen más para elegir el libro que el lector considera que mejor contribuye a su tarea. Y una vez finalizado el periodo de préstamo del libro, la labor de los bibliotecarios para hacer que todo vuelva a un estado inicial resulta casi mágica. El proceso de dejar los libros de vuelta en las estanterías se puede repetir indefinidamente.

Tanto en esas estanterías inmensas que están a disposición pública de todos los lectores en las salas, como esas otras más pequeñas, fuera de la vista de todos, donde descansan bajo custodia los libros que, debido a alguna razón no pueden estar públicamente disponibles. Este proceso lleva pasando siglos desde que el hombre empezó a escribir y a compartir su conocimiento entre coetáneos y entre generaciones.

En cierto sentido, los datos son como los libros. Y los repositorios de datos son como las bibliotecas: en nuestro día a día, tanto a nivel profesional como a nivel personal, necesitamos datos que están en las “estanterías” de numerosas “bibliotecas”. Algunos, que están abiertos, muy pocos aún, se pueden usar; otros están restringidos, y necesitamos permisos para usarlos.

En cualquier caso, contribuyen a desarrollar proyectos personales y profesionales; y por eso, estamos entendiendo que los datos son el pilar de la nueva economía del dato, lo mismo que los libros llevan siendo el pilar del conocimiento desde hace miles de años.

Los cuatro principios FAIR

Tal como ocurre con las bibliotecas, para poder elegir y usar los datos más adecuados para nuestras tareas, necesitamos que “los bibliotecarios de los datos hagan su magia” para ordenarlo todo de tal manera que sea fácil encontrar, acceder, interoperar y reutilizar los datos. Ese es el secreto de los “magos de los datos”: algo que ellos, recelosamente, llaman principios FAIR para que el resto de los humanos no podamos descubrirlos. No obstante, siempre es posible dar algunas pistas, para que podamos sacar mejor partido de su magia:

- Tiene que poder ser fácil encontrar los datos. De aquí viene la “F” de los principios FAIR, de “findable” (localizable, en español). Para ello, es importante que los datos estén suficientemente descritos mediante una colección adecuada de metadatos, de tal manera que se puedan realizar búsquedas de manera sencilla. Del mismo modo que en las bibliotecas se establece un tejuelo para etiquetar los libros, los datos necesitan su propia etiqueta. Los “magos de los datos” tienen que encontrar, por un lado, formas de escribir las etiquetas para que sea fácil localizar los libros, y por otro proporcionar herramientas (como buscadores) para que los usuarios puedan hacer búsquedas. Los usuarios, por nuestra parte, tenemos que conocer y saber interpretar lo que significan las distintas etiquetas de los libros, y saber cómo funcionan las herramientas de búsqueda (imposible no acordarse aquí de los protagonistas de “Ángeles y demonios” de Dan Brown buscando en la Biblioteca del Vaticano).

- Una vez localizados los datos que se pretenden utilizar, tiene que ser fácil poder acceder a ellos para utilizarlos. Esta es la A de “accessible” de FAIR. Lo mismo que para tomar prestado un libro de una biblioteca hay que hacerse socio y te dan un carné, con los datos pasa lo mismo: hay que conseguir una licencia para acceder a los datos. En este sentido, sería ideal poder acceder a cualquier libro sin tener ningún tipo de traba previa como ocurre con los datos abiertos licenciados por CC BY 4.0 o equivalente. Pero el hecho de ser socio de la “biblioteca de datos”, no tiene por qué conferirte acceso a toda la biblioteca. Quizás para ciertos datos que descansan en esas estanterías custodiadas fuera del alcance de todas las miradas, necesites ciertos permisos (imposible no acodarse aquí de “El nombre de la rosa” de Umberto Eco).

- No es suficiente con poder acceder a los datos, tiene que ser fácil poder interoperar con ellos, entendiendo su significado y sus descripciones. Este principio se representa con la “I” de “interoperable” en FAIR. Así, los “magos de los datos” tienen que conseguir, mediante las correspondientes técnicas, que los datos estén descritos y puedan ser entendidos para poder ser usados en el contexto de uso de los usuarios; aunque en, no pocas ocasiones, serán los usuarios los que tengan que adaptarse para poder operar con los datos (imposible no acordarse de las runas élficas de “El Señor de los Anillos” de J.R.R. Tolkien).

- Finalmente, los datos, al igual que los libros, tienen que poder ser reutilizados para ayudar una y otra vez a que otros puedan cubrir sus propias necesidades. De aquí la “R” de “reusable” en FAIR. Para ello, los “magos de los datos” tiene que establecer los mecanismos para asegurar que, tras su uso, todo puede volver a ese estado inicial, que será el punto de partida desde el que otros empezarán sus propios caminos.

A medida que nuestra sociedad va avanzando en esto de la economía digital, nuestras necesidades de datos van cambiando. Y no es que necesitemos más datos, sino que necesitamos disponer de forma distinta de los datos que se tienen, de los que se producen y de los que se ponen a disposición de los usuarios. Además, necesitamos ser más respetuosos con los datos que se generan, y con cómo usamos esos datos para no violar los derechos ni las libertades de los ciudadanos. Así que puede decirse, que nos enfrentamos a nuevos retos, lo que requiere nuevas soluciones. Esto obliga a nuestros “magos de datos” a perfeccionar sus trucos, pero siempre manteniendo la esencia de su magia, esto es, de los principios FAIR.

Hace poco, al final de febrero de 2023, tuvo lugar una Asamblea de estos magos de datos. Y estuvieron discutiendo sobre cómo revisar los principios FAIR para perfeccionar estos trucos de magia para escenarios tan relevantes como los espacios europeos de datos, los datos geoespaciales, o incluso cómo medir lo bien que se aplican los principios FAIR para estos nuevos retos. Si quieres ver de lo que hablaron, puedes ver los videos y el material en el siguiente enlace: https://www.go-peg.eu/2023/03/07/go-peg-final-workshop-28-february-20203-1030-1300-cet/

Contenido elaborado por Dr. Ismael Caballero, Profesor titular en UCLM

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Garantizar la calidad de los datos es una tarea primordial para cualquier iniciativa open data. Antes de su publicación, es necesario validar los conjuntos de datos para comprobar que no contienen errores, duplicidades, etc. De esta manera, su potencial de reutilización crecerá.

La calidad de los datos está condicionada por muchos aspectos. En ese sentido, en el marco de de la Iniciativa Aporta se ha elaborado la “Guía práctica para la mejora de la calidad de datos abiertos”, que proporciona un compendio de directrices para actuar sobre las distintas características que definen la calidad e impulsar su mejora.

La guía incluye un listado con algunas herramientas gratuitas dirigidas a aplicar medidas correctoras sobre los datos en origen. En este artículo te mostramos algunos ejemplos. Se trata de herramientas útiles para trabajar aspectos concretos relacionados con la calidad, por lo que su mayor o menor utilidad dependerá de los datos con los que estés trabajando y sus características.

Se trata de una colección de herramientas online para realizar tareas de conversión de formatos y codificación de caracteres. Puedes seleccionar entre distintos conversores, pero destacamos las herramientas para trabajar con la codificación UTF8. Esta colección compila un amplio catálogo de herramientas de programación, que ofrecen funcionalidades de conversión, encriptación, generación de contraseñas, edición y gestión de textos e imágenes, conversión de fechas y horas, realización de operaciones matemáticas, etc.

Todas las herramientas son gratuitas, sin anuncios intrusivos, y fáciles de usar gracias a una interfaz de usuario sencilla. Además, cada una de ellas incluye ejemplos de uso.

Gestionada por el Open Data Institute, esta herramienta online permite comprobar si un archivo CSV es legible por máquinas y verificar que incluye las columnas y los tipos de valores que debería. También permite añadir esquemas a los archivos de datos. Tras el análisis, genera un informe con los resultados y una marca que puede ser embebida en el portal de datos desde el que se sirve el dataset evaluado.

Aunque es muy sencilla de utilizar (solo hay que cargar el archivo que se quiere verificar y hacer clic en el botón de validar), la web incluye un apartado de ayuda. Trabaja bien con archivos de hasta 100 Mb de tamaño. También ofrece un sencillo manual con directrices sobre cómo crear un archivo en formato CSV correctamente y evitar los errores más comunes.

DenCode ofrece herramientas de codificación y descodificación online. Entre las funcionalidades que ofrece destaca esta herramienta que ayuda a los publicadores en la conversión de datos tipo fecha al formato ISO 8601, que es el estándar internacional que facilita la homogenización de este tipo de datos y su interoperabilidad.

La herramienta es muy intuitiva, ya que solo es necesario escribir, en el apartado habilitado para ello, la fecha y hora a convertir.

XML Escape / Unescape es una herramienta online de código abierto, utilizada para el “escapado” o enmascaramiento de caracteres especiales en XML y la realización del proceso inverso. La herramienta se encarga de eliminar los rastros de aquellos caracteres que podrían ser interpretados erróneamente.

Al igual que en el caso anterior, la herramienta es muy intuitiva. Solo es necesario copiar y pegar el fragmento a tratar en el editor.

JSONLint es un validador y reformulador para JSON, que permite chequear si el código es válido de acuerdo a dicha especificación. Cuenta con un editor donde escribir o copiar y pegar el código, aunque también se puede introducir directamente una url para su validación. JSONLint analizará dicho código para encontrar y sugerir la corrección de los errores explicando, además, los multiples motivos por los que se pueden producir. La herramienta también puede ser utilizada como compresor, reduciendo de esta forma el tamaño de los archivos.

En su web incluye información sobre buenas prácticas a la hora de trabajar con el formato JSON, así como información sobre errores comunes.

Open Refine es una herramienta pensada para el tratamiento y enriquecimiento de datos: permite limpiarlos, transformar su formato y ampliarlos con servicios web y datos externos. Una de sus principales características es que utiliza un lenguaje propio, GREL (Google Refine Expression Languaje), que permite realizar tareas de depuración avanzadas. Está disponible en más de 15 idiomas.

En su página web ofrece varios vídeos que explican su funcionamiento. También cuenta con una sección de documentación con cursos online, guías y preguntas frecuentes. Además, los usuarios pueden recurrir a su amplia comunidad y a los grupos de discusión en Google, Gitter y Stackoverflow, para solucionar dudas y compartir experiencias.

OpenRefine permite añadir diferentes extensiones. Una de ellas es la que permite transformar datos tabulares a un esquema RDF a través de un punto SPARQL. Los formatos concretos con los que permite trabajar son: TSV, CSV, SV, XLS, XLSX, JSON, XML, RDF como XML y Google sheet. La interfaz visual guía en la elección de los predicados, la definición de los mapeos de tipos de datos a RDF y la implementación de transformaciones complejas utilizando el lenguaje GREL.

En su web incluye información sobre cómo utilizar la herramienta, así como casos de uso.

Esta herramienta permite generar y validar JSON schemas a partir de archivos JSON. Estos esquemas permiten describir formatos de datos existentes, proporcionando una documentación clara y legible tanto para las personas como para las máquinas.

En la web de JSON Schema tienes distintos materiales formativos a tu disposición, incluyendo ejemplos, e información sobre distintas implementaciones. También puedes aprender más sobre JSON schema en su perfil de Github.

Se trata de una herramienta online de validación para la especificación SHACL, estándar del W3C para validar grafos RDF contra un conjunto de condiciones expresadas en SHACL. Al igual que en las herramientas anteriores, solo es necesario cortar y pegar el código para que se proceda a su validación.

La herramienta ofrece algunos ejemplos de uso. Además, todo el código está disponibles en Github.

Swagger es una herramienta para la edición y validación de especificaciones que siguen el estándar OpenAPI. Aunque cuenta con una versión de pago con más funcionalidades, los usuarios pueden crear una cuenta gratuita que les permitirá diseñar la documentación de APIS de forma rápida y estandarizada. Dicha versión gratuita cuenta con funcionalidades de detección inteligente de errores y autocompletado de sintaxis.

Sphinx es un software de código abierto para generar cualquier tipo de documentación sobre los datos. Permite crear estructuras jerárquicas de contenidos e índices automáticos, así como ampliar las referencias cruzadas a través del marcado semántico y los enlaces automáticos para funciones, clases, citas, términos de glosario y piezas de información similares. Utiliza el lenguaje de marcado reStructuredText por defecto, y puede leer MyST markdown a través de extensiones de terceros.

A través de su web puedes acceder a una gran cantidad de tutoriales y guías. Además, cuenta con una importante comunidad de usuarios.

Se trata de un software de código abierto para alojar y documentar la semántica de los datos, similar al anterior. Su objetivo es simplificar la generación de documentación del software al automatizar la creación, el control de versiones y el alojamiento de documentaciones.

Cuenta con un extenso tutorial donde indica los pasos a seguir para crear un proyecto de documentación.

Esta herramienta permite convertir las palabras que integran un texto en mayúsculas y/o minúsculas. El usuario solo tiene que introducir un texto y la herramienta lo convierte a distintos formatos: todo mayúsculas, todo minúsculas, Title Case (donde todas las palabras importantes comienzan con mayúsculas, mientras que los términos menores, como artículos o preposiciones, van en minúsculas) o AP-Style Title Case (donde todos los términos comienzan con mayúsculas).

Esto es solo un ejemplo de algunas herramientas online que pueden ayudar a trabajar sobres aspectos relacionados con la calidad de los datos. Si quieres recomendar alguna otra herramienta, puedes dejarnos un comentario o escribir a dinamizacion@datos.gob.es.

Contenido elaborado por el equipo de datos.gob.es.

Transformar los datos en conocimiento se ha convertido en uno de los objetivos principales a los que se enfrentan tanto las organizaciones públicas como privadas en la actualidad. Pero, para poder lograrlo, es necesario partir de la premisa de que los datos tratados están gobernados y son de calidad.

En este sentido, la Asociación Española de Normalización (UNE) ha publicado recientemente un artículo e informe donde se recogen distintas normas técnicas que buscan garantizar que la correcta gestión y gobernanza de los datos de una organización. En este post se recogen ambos materiales, incluyendo una infografía-resumen de las normas destacadas.

En los artículos de referencia señalados se mencionan norman técnicas relativas a gobernanza, gestión, calidad, seguridad y privacidad de datos. En esta ocasión queremos hacer un zoom sobre aquellas centradas en la calidad de los datos.

Estándares de referencia de gestión de la calidad

Tal y como dijo Lord Kelvin, físico y matemático británico del siglo XIX, “lo que no se mide, no se puede mejorar y lo que no se mejora, se degrada siempre”. Pero para medir la calidad del dato y poder mejorarla se necesitan estándares que nos ayuden a homogeneizar primero dicha calidad*. A ello nos pueden ayudar las normas técnicas detalladas a continuación:

Norma ISO 8000

La normativa ISO (International Organization for Standardization), dispone de la norma ISO 8000 como el estándar internacional para la calidad de los datos de transacción, los datos de producto y los datos maestros empresariales. Esta norma se estructura en 4 partes: conceptos generales de la calidad de los datos (ISO 8000-1, ISO 8000-2 e ISO 8000-8), procesos de gestión de la calidad de los datos (ISO 8000-6x), aspectos relacionados con el intercambio de datos maestros entre organizaciones (partes 100 a 150) y aplicación de la calidad de los datos de producto (ISO 8000-311).

Dentro de la familia de las ISO 8000-6X, centrada en los procesos de gestión de la calidad de los datos para crear, almacenar y transferir los datos que dan soporte a los procesos de negocio de manera oportuna y rentable, encontramos:

- La ISO 8000-60 proporciona una visión general de los procesos de gestión de calidad de los datos sometidos a un ciclo de mejora continua.

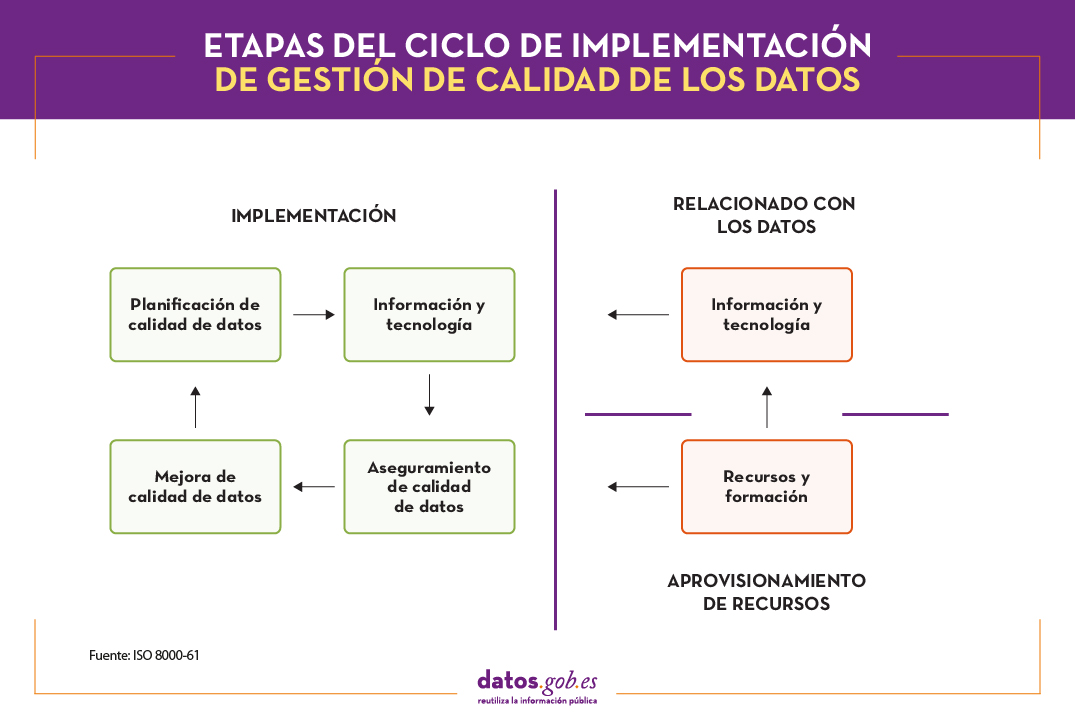

- La ISO 8000-61 establece un modelo de referencia de procesos de gestión de calidad de los datos. La principal característica es que, para alcanzar la mejora continua, el proceso de implementación debe ser ejecutado continuamente siguiendo el ciclo Plan-Do-Check-Act. Además, se incluyen procesos de implementación relacionados con el aprovisionamiento de los recursos y el procesamiento de datos. Tal y como se muestra en la siguiente imagen, las cuatro etapas del ciclo de implementación deben disponer de datos de entrada, información de control y soporte para una mejora continua, así como contar con los recursos necesarios para el desempeño de las actividades.

- Por su parte, la ISO 8000-62, la última de la familia de las ISO 8000-6X, se enfoca en la evaluación de madurez de procesos organizacionales. En ella se especifica un marco de trabajo para evaluar la madurez de la gestión de la calidad de datos de la organización, basado en su capacidad de ejecutar las actividades relacionadas con los procesos de gestión de la calidad de datos identificados en la ISO 8000-61. En función de la capacidad del proceso evaluado, se asigna uno de los niveles definidos.

Norma ISO 25012

Otra de las normas ISO que trata sobre la calidad de los datos es la familia de las ISO 25000, que tiene por objetivo la creación de un marco de trabajo común para evaluar la cvalidad del producto de software. En concreto, la norma ISO 25012 define un un modelo general de calidad de datos aplicable a datos almacenados de forma estructurada en un sistema de información.

Además, en el contexto de datos abiertos se considera una referencia de acuerdo al conjunto de buenas prácticas para la evaluación de la calidad de los datos abiertos desarrollado por la red paneuropea Share-PSI, concebida para servir de orientación a todas las organizaciones públicas a la hora de compartir información.

En este caso, la calidad del producto de datos se entiende como el grado en que estos satisfacen los requisitos definidos previamente en el modelo de calidad de datos mediante las siguientes 15 características.

Estas características o dimensiones de calidad, se clasifican principalmente en dos categorías.

La calidad de datos inherente se relaciona con el potencial intrínseco de los datos de satisfacer las necesidades definidas cuando se utilizan en condiciones concretas. Se trata de:

- Exactitud: grado en el que los datos representan el verdadero valor del atributo deseado en un contexto específico, como pueda ser la cercanía de los datos a un conjunto de valores definidos en un determinado dominio.

- Completitud: grado en el que los datos asociados tienen valor para todos los atributos definidos.

- Consistencia: grado de coherencia con otros datos existentes, eliminando contradicciones.

- Credibilidad: grado en que los datos tienen atributos que se consideran ciertos y creíbles en su contexto, incluyendo la veracidad de los orígenes de datos.

- Actualidad: grado de vigencia de los datos para su contexto de uso.

Por otro lado, la calidad de datos dependiente del sistema se relaciona con el grado alcanzado a través de un sistema informático bajo condiciones concretas. Se trata de:

- Disponibilidad: grado en que los datos tienen atributos que permiten ser obtenidos por usuarios autorizados.

- Portabilidad: capacidad de los datos de ser instalados, reemplazados o eliminados de un sistema a otro, preservando el nivel de calidad.

- Recuperabilidad: grado en que los datos tienen atributos que permiten mantener y preservar la calidad incluso en caso de fallos.

Adicionalmente, hay características o dimensiones que pueden englobarse tanto dentro de calidad de datos inherente como dependiente del sistema. Estas son:

- Accesibilidad: posibilidad de acceso a los datos en un contexto concreto por unos roles determinados.

- Conformidad: grado en que los datos contienen atributos en base a estándares, normativas o referencias establecidas.

- Confidencialidad: mide el grado de aseguramiento de los datos en base a su naturaleza para poder acceder a ellos solo por los roles configurados.

- Eficiencia: posibilidades que ofrecen los datos para ser procesados con niveles de rendimiento esperados en situaciones concretas.

- Precisión: exactitud de los datos en base a un contexto de uso específico.

- Trazabilidad: capacidad de auditar el ciclo de vida completo del dato.

- Comprensibilidad: capacidad de los datos de ser interpretados por cualquier usuario, incluyendo la utilización de símbolos y lenguajes determinados para un contexto específico.

Además de las normas ISO, existen otros marcos de referencia que establecen pautas comunes para la medición de la calidad. DAMA Internacional, por ejemplo, tras analizar las similitudes de todos los modelos, establece 8 dimensiones de calidad básicas comunes a cualquier estándar: exactitud, completitud, consistencia, integridad, razonabilidad, oportunidad, unicidad, validez.

La necesidad de mejora continua

La homogeneización de la calidad de los datos de acuerdo a estándares de referencia como los descritos, permiten asentar las bases para una mejora continua de la información. A partir de la aplicación de estas normas, y teniendo en cuenta las dimensiones detalladas, es posible definir indicadores de calidad. Una vez se implementen y ejecuten, arrojarán unos resultados que tendrán que ser revisados por los diferentes propietarios de los datos, estableciendo umbrales de tolerancia e identificando así incidencias de calidad en todos aquellos indicadores que no superen el umbral definido.

Para ello, se tendrán en cuenta diferentes parámetros como la naturaleza del dato o su impacto en el negocio, ya que no se puede tratar de igual forma un campo descriptivo que una clave primaria, por ejemplo.

A partir de ahí, es frecuente poner en marcha un circuito de resolución de incidencias capaz de detectar la causa raíz que genera una deficiencia de calidad en un dato para extraerla y garantizar la mejora continua.

Gracias a ello, se obtienen innumerables beneficios, como minimizar riesgos, ahorro de tiempo y recursos, toma ágil de decisiones, adaptación a nuevos requerimientos o mejora reputacional.

Cabe destacar que las normas técnicas abordadas en este post permiten homogeneizar la calidad. Para tareas de medición de la calidad de los datos per se, deberíamos acudir a otras normas como la ISO 25024:2015.

Contenido elaborado por Juan Mañes, experto en Data Governance.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.