El Ayuntamiento de Madrid ha lanzado una iniciativa para demostrar el potencial de los datos abiertos: la I edición de los Premios a la Reutilización de Datos Abiertos 2025. Con un presupuesto total de 15.000 euros, esta competición busca fomentar la reutilización de los datos compartidos por el consistorio en su portal open data, demostrando que pueden ser motor de innovación social y participación ciudadana.

El reto está claro: convertir los datos en ideas útiles, originales e impactantes. Si crees que puedes hacerlo, a continuación, te resumimos la información que debes tener en cuenta para concursar.

¿Quién puede participar?

La competición está abierta a prácticamente todo el mundo: desde personas a título individual, hasta empresas o colectivos de cualquier tipo. La única condición es presentar un proyecto que haya sido realizado entre el 10 de septiembre de 2022 y el 9 de septiembre de 2025 y que utilice como base al menos un conjunto de datos del portal de datos abiertos del Ayuntamiento de Madrid. Se pueden usar también datos provenientes de otras fuentes públicas y privadas, siempre y cuando los datasets del Ayuntamiento de Madrid sean una pieza clave del proyecto.

Eso sí, no se aceptan proyectos que ya hayan sido premiados, contratados o financiados por el propio Ayuntamiento, ni trabajos presentados fuera de plazo o sin la documentación requerida.

¿Qué proyectos se pueden presentar?

Hay cuatro grandes áreas en las que se puede participar:

- Servicios web y aplicaciones: hace referencia a proyectos que proporcionen servicios, estudios, aplicaciones web o apps móviles.

- Estudios, investigaciones e ideas: se refiere a proyectos de exploración, análisis o descripción de ideas dirigidas a la creación de servicios, estudios, visualizaciones, aplicaciones web o apps móviles. También pueden participar en esta categoría trabajos universitarios de fin de grado y máster.

- Propuestas de mejora de la calidad del portal de datos abiertos: incluye proyectos, servicios, aplicaciones o iniciativas que contribuyan a impulsar la calidad de los conjuntos de datos publicados en el portal de datos abiertos del Ayuntamiento de Madrid.

- Visualizaciones de datos: se puede participar en esta categoría con diversos contenidos, como mapas, gráficos, tablas, modelos 3D, arte digital, aplicaciones web y animaciones. Las representaciones pueden ser estáticas, como infografías, carteles o figuras en publicaciones, o dinámicas, incluyendo vídeos, cuadros de mando interactivos e historias.

¿Cuáles son los premios?

Para cada categoría se otorgan dos premios de diversa dotación económica:

|

Categoría |

Primer premio |

Segundo premio |

|

Servicios web y aplicaciones |

3.000 € | 1.500 € |

| Propuestas de mejora de la calidad del Portal de Datos Abiertos | 3.000 € | 1.500 € |

| Estudios, investigaciones e ideas | 2.000 € | 1.000 € |

| Visualizaciones de datos | 2.000 € | 1.000 € |

Figura 1. Dotación económica de la I edición de los Premios a la Reutilización de Datos Abiertos 2025. Fuente: Ayuntamiento de Madrid.

Más allá del premio económico, esta convocatoria es una gran oportunidad para darle visibilidad a ideas que aprovechan la transparencia y el potencial de los datos abiertos. Además, si la propuesta mejora servicios públicos, resuelve un problema real o ayuda a comprender mejor la ciudad, tendrá un gran valor que va mucho más allá del reconocimiento.

¿Cómo se valoran los proyectos?

Un jurado valorará cada proyecto asignando una puntuación máxima de 50 puntos, que tendrá en cuenta aspectos como la originalidad, el beneficio social, la calidad técnica, la accesibilidad, la facilidad de uso, o incluso el diseño, en el caso de las visualizaciones. Si se considera necesario, el jurado podrá solicitar la ampliación de la información presentada a los participantes.

Ganarán los dos proyectos con máxima puntuación, aunque para ser consideradas, las propuestas deben alcanzar al menos 25 puntos de los 50 posibles. Si ninguna cumple este requisito, la categoría se declarará desierta.

El jurado estará compuesto por representantes de diferentes áreas del Ayuntamiento, con experiencia en innovación, transparencia, tecnología y datos. También participará un representante de ASEDIE (Asociación Multisectorial de la Información), la asociación que promueve la reutilización y distribución de la información en España.

¿Cómo se participa?

La fecha límite para inscribirse es el 9 de septiembre de 2025 a las 23:59 h. En el caso de las personas físicas, la solicitud se puede presentar:

- De forma online a través de la Sede Electrónica del Ayuntamiento. Este procedimiento requiere de identificación y firma electrónica.

- De forma presencial en oficinas de atención municipal.

En el caso de las personas jurídicas, solo podrán presentar su candidatura de forma telemática.

En cualquier caso, hay que completar el formulario oficial y acompañarlo de una memoria donde se explique bien el proyecto, su funcionamiento, sus beneficios, el uso de los datos, y si es posible, se incluyan capturas, enlaces o prototipos.

Puedes ver las bases completas aquí.

Más de 90.000 personas de todo el mundo participaron en la última edición del Space App Challenge. Este evento anual de dos días, que organiza la agencia espacial estadounidense, la NASA, es una oportunidad para innovar y aprender sobre las ventajas que pueden ofrecer los datos abiertos espaciales.

Este año la competición se celebrará durante el 4 y 5 de octubre. A través de un hackathon, los participantes se involucrarán de primera mano con las misiones e investigaciones más relevantes de la NASA. Es una oportunidad para aprender a lanzar y liderar proyectos mediante el uso práctico de los datos de la NASA en el mundo real. Además, se trata de una actividad gratuita abierta a cualquier persona (los menores de 18 años deberán estar acompañados por un tutor legal).

En este post, te contamos algunas de las claves que necesitas saber sobre este evento de referencia global.

¿Dónde se celebra?

Bajo el sello del Space Apps Challenge tienen lugar eventos virtuales y presenciales por todo el mundo. En concreto, en España se celebran encuentros en varias ciudades:

- Barcelona

- Dónde: presencial, en 42 Barcelona (Carrer D’Albert Einstein 11).

- Madrid

- Dónde: presencial, en la Escuela de Competencias Digitales – San Blas Digital (Calle Amposta, 34).

- Murcia

- Dónde: presencial en UCAM HITECH (Av. Andrés Hernandez Ros, 1, Guadalupe).

- Málaga

- Dónde: presencial, en una ubicación por determinar (puedes ponerte en contacto con la organizadora del evento a través del enlace).

- Pamplona

- Dónde: presencial y virtual, en una ubicación por determinar (puedes ponerte en contacto con la organización del evento a través del enlace)

- San Vicente del Raspeig (Alicante)

- Dónde: presencial, en el Parque Científico de Alicante (Universidad de Alicante, San Vicente del Raspeig).

- Sevilla

- Dónde: presencial, en una ubicación todavía por determinar (puedes ponerte en contacto con la organizadora del evento a través del enlace).

- Valencia

- Dónde: presencial, en la Casa del Alumno UPV, Universidad Politécnica de Valencia (Camino de Vera, s/n Edificio 4K).

- Zaragoza

- Dónde: presencial, en el Edificio Betancourt, Campus Río Ebro (EINA) Calle María de Luna, 1.

Todos ellos contarán con una ceremonia de bienvenida el viernes 3 de octubre a las 17.30 en la que se presentarán los detalles de la competición, se organizarán los equipos y las temáticas de cada reto.

Para participar en cualquiera de los eventos, puedes registrarte individualmente y la organización te ayudará a encontrar equipo. También puedes inscribir directamente a tu equipo (de un máximo de 6 personas).

Si no encuentras ningún evento presencial cerca de ti, puedes inscribirte al evento universal que será online.

¿Hay premios?

¡Sí! Cada evento entregará sus propios premios. Y, además, la NASA reconoce, cada año, diez premios globales divididos en diferentes categorías:

- Premio mejor uso de la ciencia: reconoce al proyecto que realiza el uso más válido y destacado de la ciencia y/o del método científico.

- Premio mejor uso de los datos: se otorga al proyecto que hace más accesibles los datos espaciales o los utiliza de manera única.

- Premio mejor uso de la tecnología: distingue al proyecto que representa el uso más innovador de la tecnología.

- Premio impacto galáctico: se concede al proyecto con mayor potencial para mejorar la vida en la Tierra o en el universo.

- Premio mejor concepto de misión: reconoce al proyecto con el concepto y diseño más plausibles.

- Premio más inspirador: se entrega al proyecto que logra conmover e inspirar al público.

- Premio mejor narrativa: destaca al proyecto que comunica de forma más creativa el potencial de los datos abiertos a través del arte de contar historias.

- Premio conexión global: se otorga al proyecto que mejor conecta a personas de todo el mundo mediante la tecnología.

- Premio arte y tecnología: reconoce al proyecto que combina de manera más efectiva las habilidades técnicas y creativas.

- Premio impacto local: se concede al proyecto que demuestra el mayor potencial para generar un impacto a nivel local.

Figura 1. Premios del Space App Challenge. Fuente: https://www.spaceappschallenge.org/brand/

De Gijón al mundo: el proyecto español premiado en 2024

En la edición del año pasado, un proyecto español, en concreto de Gijón, ganó el premio global a mejor concepto de misión con su propuesta de aplicación Landsat Connect. El equipo AsturExplorer desarrolló una aplicación web diseñada para proporcionar una forma rápida, sencilla e intuitiva de seguir la trayectoria de los satélites Landsat y acceder a los datos de reflectancia superficial. Su proyecto fomentaba las capacidades de aprendizaje interdisciplinar y científico, y capacitaba a la ciudadanía.

El programa Landsat consiste en una serie de misiones satelitales de observación de la Tierra, gestionadas conjuntamente por la NASA y el Servicio Geológico de Estados Unidos (USGS), que proporcionan imágenes y datos sobre nuestro planeta desde 1972.

Los usuarios finales de la app desarrollada por AsturExplorer pueden establecer una ubicación de destino y recibir notificaciones con antelación para conocer cuándo pasará el satélite Landsat sobre cada zona. Esto permite a los usuarios preparar y tomar sus propias mediciones en el terreno y obtener datos de píxeles sin necesidad de controlar constantemente los horarios de los satélites.

El equipo AsturExplorer utilizó datos abiertos Landsat de la NASA y de Earth Explorer. También hicieron uso de la inteligencia artificial para entender el problema técnico y comparar múltiples alternativas. Puedes leer más sobre este caso de uso aquí.

¿Cómo me registro?

La web de Space App Challenge ofrece un apartado de preguntas frecuentes y un vídeo tutorial para facilitar el registro. El proceso es sencillo:

- Crea una cuenta

- Regístrate en el Hackathon

- Elige un evento local

- Únete a un equipo y forma el tuyo propio

- Entrega un proyecto (antes de las 11.59h del 5 de octubre)

- Completa la encuesta de participación

Te animamos a formar parte de este evento de referencia global en el que reutilizarás conjuntos de datos abiertos. ¡Una gran oportunidad!

Entre helados y días más largos, el verano ya está aquí. En esta época del año, la información en abierto se puede convertir en nuestra mejor aliada para planificar escapadas, conocer horarios de las zonas de baño de nuestra comunidad o incluso saber el estado del tráfico en carreteras que nos lleven a nuestro próximo destino.

Tanto si te mueves como si permaneces en casa descansando, en el portal datos.gob.es puedes encontrar una amplia variedad de datasets y aplicaciones que pueden transformar la forma de vivir y disfrutar el verano. Además, si lo que te apetece es aprovechar la época estival para formarte, también tenemos recursos para ti.

Formaciones, descanso o aventura, en este post, te ofrecemos algunos de los recursos que te pueden ser útiles este verano.

Una oportunidad para aprender: cursos y aplicaciones culturales

¿Estás pensando en dar un giro en tu carrera profesional? ¿O te gustaría mejorar en alguna disciplina? La ciencia de datos es una de las competencias más demandadas por las empresas y la inteligencia artificial cada día ofrece nuevas oportunidades para aplicarla en nuestro día a día.

Para entender bien ambas disciplinas y estar a la última en lo que respecta a su desarrollo, puedes aprovechar el verano para formarte en programación, visualización de datos o incluso IA generativa. En este post, que publicamos a principio de verano, tienes una lista de propuestas, ¡todavía estás a tiempo de apuntarte a algunas!

Si ya cuentas con algo de conocimiento, te aconsejamos revisar nuestros ejercicios paso a paso. En cada uno de ellos encontrarás el código reproducible y completamente documentado, para que puedas replicarlo a tu ritmo. En esta infografía te mostramos varios ejemplos, divididos por temáticas y nivel de dificultad. Una manera práctica de poner a prueba tus habilidades técnicas y conocer herramientas y tecnologías innovadoras.

Si en lugar de ciencia de datos, quieres aprovechar para adquirir más conocimientos culturales, también tenemos opciones para ti. En primer lugar, te recomendamos este conjunto de datos sobre la agenda cultura de eventos del País Vasco para descubrir festivales, conciertos y otras actividades culturales. Otro dataset interesante es el de oficinas de información turística en Tenerife donde te pondrán informar cómo planificar itinerarios culturales. Y esta aplicación te acompañará a recorrer Castilla y León a través de un mapa gamificado para identificar lugares turísticos de interés.

Planifica tu escapada perfecta: datasets para el turismo y las vacaciones

Algunos de los conjuntos de datos abiertos que puedes encontrar en datos.gob.es son la base para crear aplicaciones que pueden ser de gran utilidad para viajar. Hablamos, por ejemplo, del dataset de campings en Navarra que proporciona datos actualizados sobre campamentos de turismo en activo, incluyendo información sobre servicios, ubicación y capacidad. En esta misma comunidad autónoma, este dataset sobre restaurantes y cafeterías te puede ser de utilidad.

Por otro lado, este conjunto de datos sobre la oferta de alojamientos turísticos de Aragón presenta un catálogo completo de hoteles, paradores y hospederías clasificados por categoría, permitiendo a los viajeros tomar decisiones informadas según su presupuesto y preferencias.

Otro recurso interesante es el este dataset que publica Instituto Nacional de Estadística que puedes encontrar también federado en datos.gob.es sobre viajes, pernoctación duración media y gasto por viaje. Gracias a este conjunto de datos te puedes hacer una idea de cómo viaja la gente y tomarlo de referencia para planificar tu viaje.

Disfruta del agua: conjuntos de datos abiertos para actividades acuáticas

El acceso a información sobre playas y zonas de baño es fundamental para un verano seguro y placentero. El dataset de playas de Bizkaia ofrece información detallada sobre las características de cada playa, incluyendo servicios disponibles, accesibilidad y condiciones del agua. De manera similar, este dataset de las zonas de baño en la Comunidad de Madrid proporciona datos sobre espacios acuáticos seguros y controlados en la región.

Si lo que quieres es una visión más general, esta aplicación que ha desarrollado el Ministerio para la Transición Ecológica y Reto Demográfico (MITECO) con datos abiertos ofrece una visualización nacional de las playas a nivel nacional. Más recientemente, el equipo de datos de RTVE ha desarrollado este Gran Mapa de las playas de España que recoge más de 3.500 destinos con información específica.

Para los amantes de los deportes acuáticos y la navegación, los datasets de predicción de mareas tanto de Galicia como del País Vasco, ofrecen información crucial para planificar actividades en el mar. Estos datos permiten a navegantes, surfistas y pescadores optimizar sus actividades según las condiciones oceánicas.

Movilidad inteligente: datasets para viajar sin complicaciones

No es novedad que la movilidad durante estos meses es aún mayor que en el resto del año. Los datasets sobre estado del tráfico en Barcelona y el de las carreteras de Navarra proporcionan información en tiempo real que ayuda a los viajeros a evitar congestiones y planificar rutas eficientes. Esta información es especialmente valiosa durante los períodos de mayor movilidad estival, cuando las carreteras experimentan un aumento significativo del tráfico.

Las aplicaciones que informan sobre el precio de los carburantes en las distintas gasolineras españolas son de las más consultadas de nuestro portal durante todo el año, pero en verano su popularidad se dispara aún más. Son interesantes porque permiten localizar las estaciones de servicio con precios más competitivos, optimizando el presupuesto de viaje. Esta información también la puedes encontrar en datasets actualizada regularmente y es especialmente útil para viajes largos y planificación de rutas.

El futuro de los datos abiertos en turismo

La convergencia de datos abiertos, tecnología móvil e inteligencia artificial está creando nuevas oportunidades para personalizar y mejorar la experiencia turística. Los datasets y recursos disponibles en datos.gob.es no solo proporcionan información actual, sino que también sirven como base para el desarrollo de soluciones innovadoras que pueden anticipar necesidades, optimizar recursos y crear experiencias más satisfactorias para los viajeros.

Desde la planificación de rutas hasta la selección de alojamientos o la búsqueda de actividades culturales, estos datasets y aplicaciones empoderan a la ciudadanía y son un recurso útil para maximizar el disfrute de esta época del año. Este verano, antes de hacer las maletas, vale la pena explorar las posibilidades que ofrecen los datos abiertos.

España da un paso clave hacia la economía del dato con el lanzamiento del Kit Espacios de Datos, un programa de ayudas que subvencionará la integración de entidades públicas y privadas en espacios de datos sectoriales.

Los espacios de datos son ecosistemas seguros en los que organizaciones, tanto públicas como privadas, comparten información de forma interoperable, bajo reglas comunes y con garantías de privacidad. Éstos permiten desarrollar nuevos productos, mejorar la toma de decisiones y aumentar la eficiencia operativa, en sectores como la salud, la movilidad o la agroalimentación, entre otros.

Hoy, el Ministerio para la Transformación Digital y de la Función Pública, a través de la Secretaría de Estado de Digitalización e Inteligencia Artificial ha publicado en el BOE las bases que regulan la concesión de ayudas a entidades interesadas en incorporarse de forma efectiva a un espacio de datos.

Este programa, que recibe el nombre de “Kit Espacios de Datos”, estará gestionado por Red.es y subvencionará los costes en los que hayan incurrido las entidades beneficiarias para conseguir su incorporación a un espacio de datos elegible, es decir, que cumpla los requisitos fijados en las bases, a contar desde el día de la publicación de estas.

Destinatarios y financiación

Este plan de ayudas está dirigido a entidades tanto públicas como privadas, así como Administraciones Públicas. Dentro de los beneficiarios de estas ayudas se encuentran los participantes, que son aquellas entidades que buscan integrase en estos ecosistemas para compartir y aprovechar datos y servicios.

Para la ejecución de este plan, el Gobierno ha lanzado una ayuda de hasta 60 millones de euros que se repartirán, según el tipo de entidad o el nivel de integración de la siguiente manera:

- Entidades privadas y públicas con actividad económica tendrán una ayuda de hasta 15.000€ en régimen de incorporación efectiva o de hasta 30.000€ si se incorpora como proveedor.

- Por otro lado, las Administraciones Públicas tendrán financiación de hasta 25.000€ si se incorporan de manera efectiva, o de hasta 50.000€ si lo hacen como proveedor.

La incorporación de empresas de diferentes sectores en los espacios de datos generará beneficios tanto a nivel empresarial como para la economía nacional como el aumento de la capacidad de innovación de las empresas beneficiarias, la creación de nuevos productos y servicios basados en el análisis de los datos y la mejora de la eficiencia operativa y toma de decisiones.

Se prevé que la convocatoria se publique durante el cuarto trimestre de 2025. Las subvenciones se solicitarán en régimen de concurrencia no competitiva, por orden de llegada y hasta agotar los fondos disponibles.

Con la publicación en el BOE de estas bases reguladoras se pretende dinamizar el ecosistema de datos en España, fortalecer la competitividad de la economía en el ámbito global y consolidar la sostenibilidad financiera de modelos de negocio innovadores.

Más información:

Bases reguladoras en el BOE.

Página de LinkedIn del Centro de Referencia de Espacios de Datos.

Imagina una máquina que pueda saber si estás feliz, preocupado o a punto de tomar una decisión, incluso antes de que tú lo sepas con claridad. Aunque suena a ciencia ficción, ese futuro ya está empezando a tomar forma. Gracias a los avances en neurociencia y tecnología, hoy podemos registrar, analizar e incluso predecir ciertos patrones de actividad cerebral. A los datos que se generan a partir de estos registros se les conoce como neurodatos.

En este artículo vamos a explicar este concepto, así como potenciales casos de uso, tomando como base el informe “TechDispatch sobre Neurodatos”, de la Agencia Española de Protección de Datos (AEPD).

¿Qué son los neurodatos y cómo se recolectan?

El término neurodatos se refiere a los datos que se recopilan directamente del cerebro y el sistema nervioso, mediante tecnologías como la electroencefalografía (EEG), la resonancia magnética funcional (fMRI), los implantes neuronales o incluso interfaces cerebro-computadora. En este sentido, su captación se ve impulsada por las neurotecnologías.

De acuerdo con la OCDE, las neurotecnologías se identifican con “dispositivos y procedimientos que se utilizan para acceder, investigar, evaluar, manipular y emular la estructura y función de los sistemas neuronales”. Las neurotecnologías pueden ser invasivas (si requieren interfaces cerebro-ordenador que se implanten quirúrgicamente en el cerebro) o no invasivas, con interfaces que se colocan fuera del cuerpo (como gafas o diademas).

Asimismo, existen dos formas habituales de recopilar los datos:

- Recolección pasiva, donde los datos se captan de manera habitual sin que el sujeto tenga que realizar ninguna actividad específica.

- Recolección activa, donde se recogen datos mientras los usuarios realizan una actividad concreta. Por ejemplo, pensar explícitamente en algo, responder preguntas, realizar tareas físicas o recibir determinados estímulos.

Posibles casos de uso

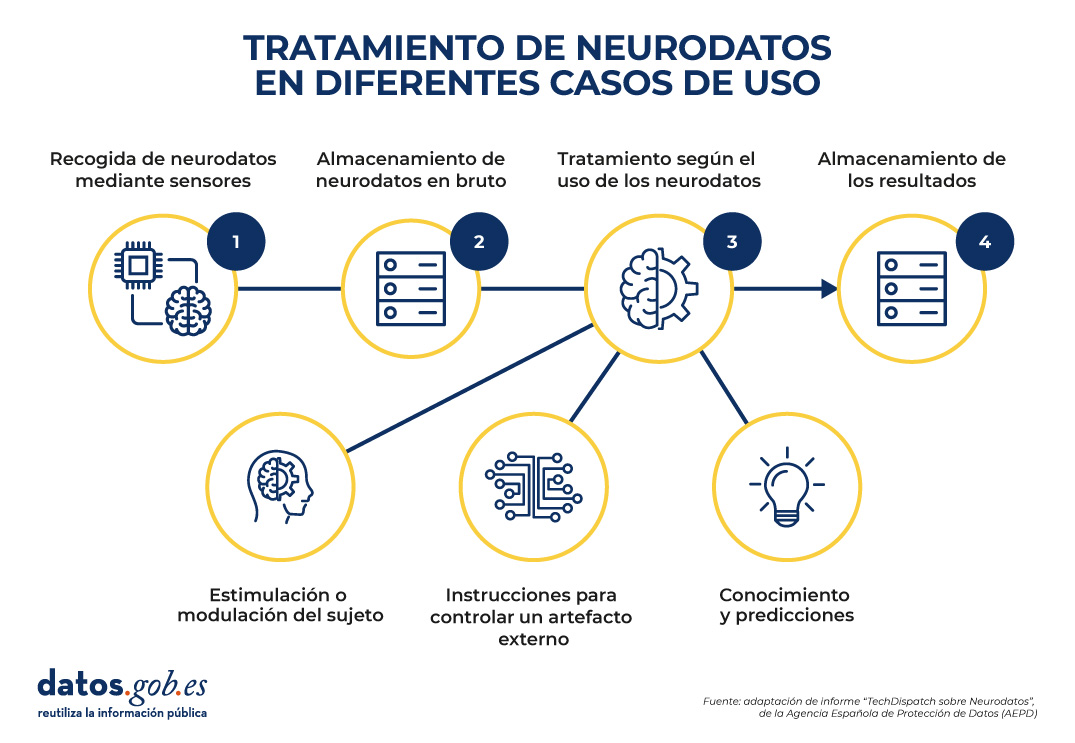

Una vez se han recolectado los datos en bruto, se procede a su almacenamiento y tratamiento. El tratamiento variará según la finalidad y el uso que se quiera dar a los neurodatos.

Figura 1. Estructura común para entender el tratamiento de neurodatos en diferentes casos de uso. Fuente: Informe “TechDispatch sobre Neurodatos”, de la Agencia Española de Protección de Datos (AEPD).

Como se puede ver en la imagen anterior, la Agencia Española de Protección de datos ha identificado 3 posibles finalidades:

-

Tratamiento de neurodatos para adquirir conocimiento directo y/o realizar predicciones.

Los neurodatos permiten descubrir patrones que decodifican la actividad cerebral en diversos sectores, como, por ejemplo:

- Salud: los neurodatos facilitan la investigación sobre el funcionamiento del cerebro y el sistema nervioso, lo que permite detectar signos de enfermedades neurológicas o mentales, realizar diagnósticos tempranos y predecir su comportamiento. Esto facilita el tratamiento personalizado desde etapas muy tempranas. Su impacto puede ser notable, por ejemplo, en la lucha contra el Alzheimer, la epilepsia o la depresión.

- Educación: a través de los estímulos cerebrales se puede analizar el rendimiento y los resultados del aprendizaje de los estudiantes. Por ejemplo, se puede medir la atención o el esfuerzo cognitivo del alumnado. Al cruzar estos datos con otros aspectos internos (como las preferencias del alumno) y externos (como las condiciones del aula o la metodología de enseñanza), se pueden tomar decisiones dirigidas a adaptar el ritmo de enseñanza.

- Marketing, economía y ocio: se puede analizar la respuesta cerebral ante ciertos estímulos para mejorar productos de ocio o campañas publicitarias. El objetivo es conocer las motivaciones y preferencias que impactan en la toma de decisiones. También se pueden utilizar en el ámbito laboral, para realizar un seguimiento de los empleados, conocer sus habilidades o determinar cómo funcionan ante la presión.

- Seguridad y vigilancia: los neurodatos se pueden usar para monitorizar factores que afectan a conductores o pilotos, como la somnolencia o la falta de atención, y así prevenir accidentes.

-

Tratamiento de neurodatos para controlar aplicaciones o dispositivos.

Al igual que en el estadio anterior, supone la recolección y análisis de información para la toma de decisiones, pero conlleva además una operación adicional: la generación de acciones a través de los impulsos mentales. Veamos varios ejemplos:

-

Ayudas ortopédicas o protésicas, implantes médicos o vida asistida por el entorno: gracias a tecnologías como las interfaces cerebro-computadora, es posible diseñar prótesis que respondan a la intención del usuario mediante la actividad cerebral. Además, los neurodatos pueden integrarse con sistemas inteligentes del hogar para anticipar necesidades, ajustar el entorno a los estados emocionales o cognitivos del usuario, e incluso emitir alertas ante signos tempranos de deterioro neurológico. Esto puede suponer una mejora de la autonomía de los pacientes y de su calidad de vida.

-

Robótica: se pueden interpretar las señales neuronales del usuario para controlar maquinaria, dispositivos de precisión o aplicaciones sin necesidad de utilizar las manos. Esto permite, por ejemplo, que una persona pueda manejar un brazo robótico o una herramienta quirúrgica simplemente con su pensamiento, lo cual es especialmente valioso en entornos donde se requiere precisión extrema o cuando el operador tiene movilidad reducida.

-

Videojuegos, realidad virtual y metaverso: dado que los neurodatos permiten controlar dispositivos de software, se pueden desarrollar interfaces cerebro-computadora que hagan posible manejar personajes o realizar acciones dentro de un juego, únicamente con la mente, sin necesidad de mandos físicos. Esto no solo incrementa la inmersión del jugador, sino que abre la puerta a experiencias más inclusivas y personalizadas.

- Defensa: los soldados pueden operar sistemas de armas, vehículos no tripulados, drones o robots de desactivación de explosivos en remoto, aumentando la seguridad personal y la eficiencia operativa en situaciones críticas.

-

Tratamiento de neurodatos para la estimulación o modulación del sujeto, logrando un neurofeedback.

En este caso, las señales del cerebro (salidas) se utilizan para generar nuevas señales que retroalimentan al cerebro (como entradas), lo que supone el control de las ondas cerebrales. Es el campo más complejo desde el punto de vista ético, ya que podrían generarse acciones de las que no es consciente el usuario. Algunos ejemplos son:

-

Psicología: los neurodatos tienen potencial para cambiar la forma en que el cerebro responde a ciertos estímulos. Se pueden utilizar, por tanto, como método de terapia para tratar el TDAH (Trastorno por Déficit de Atención e Hiperactividad), la ansiedad, la depresión, la epilepsia, el trastorno del espectro autista, el insomnio o la drogadicción, entre otros.

- Neuromejora: también se pueden utilizar para mejorar las capacidades cognitivas y afectivas en personas sanas. A través del análisis y estimulación personalizada de la actividad cerebral, es posible optimizar funciones como la memoria, la concentración, la toma de decisiones o la gestión emocional.

Retos éticos del uso de los neurodatos

Como hemos visto, aunque el potencial de los neurodatos es enorme, también plantea grandes retos éticos y legales. A diferencia de otros tipos de datos, los neurodatos pueden revelar aspectos profundamente íntimos de una persona, como sus deseos, emociones, miedos o intenciones. Esto abre la puerta a posibles usos indebidos, como la manipulación, la vigilancia encubierta o la discriminación basada en características neuronales. Además, se pueden recopilar en remoto y actuar sobre ellos sin que el sujeto sea consciente de la manipulación.

Esto ha generado un debate sobre la necesidad de nuevos derechos, como los neuroderechos, que buscan proteger la privacidad mental, la identidad personal y la libertad cognitiva. Desde diversas organizaciones internacionales, incluida la Unión Europea, se están tomando medidas para enfrentar estos desafíos y avanzar en la creación de marcos regulatorios y éticos que protejan los derechos fundamentales en el uso de tecnologías neurotecnológicas. Próximamente publicaremos un artículo que profundizará en estos aspectos.

En conclusión, los neurodatos suponen un avance muy prometedor, pero no exento de desafíos. Su capacidad para transformar sectores como la salud, la educación o la robótica es innegable, pero también lo son los desafíos éticos y legales que plantea su uso. A medida que avanzamos hacia un futuro donde mente y máquina están cada vez más conectadas, resulta crucial establecer marcos de regulación que garanticen la protección de los derechos humanos, en especial la privacidad mental y la autonomía individual. De esta forma podremos aprovechar todo el potencial de los neurodatos de manera justa, segura y responsable, en beneficio de toda la sociedad.

La compartición de datos o data sharing se ha convertido en un pilar imprescindible para el avance de la analítica y el intercambio de conocimiento, tanto en el ámbito privado como en el público. Las organizaciones de cualquier tamaño y sector –empresas, administraciones públicas, instituciones de investigación, comunidades de desarrolladores o individuos– encuentran un fuerte valor en la capacidad de compartir información de forma segura, fiable y eficiente. Este intercambio no se limita a datos en crudo o datasets estructurados; también se extiende a productos de datos más avanzados, tales como modelos de machine learning entrenados, dashboards analíticos, resultados de experimentos científicos y otros artefactos complejos que generan un gran impacto a través de su reutilización.

En este contexto, la importancia de la gobernanza de estos recursos cobra un papel crítico. No es suficiente con disponer de un método para mover ficheros de un sitio a otro; es necesario garantizar aspectos clave como el control de acceso (quién puede leer o modificar cierto recurso), la trazabilidad y la auditoría (saber quién ha accedido, cuándo y con qué finalidad) o el cumplimiento de regulaciones o estándares, especialmente en entornos empresariales y gubernamentales.

Con el fin de unificar estos requisitos, Unity Catalog surge como un almacén de metadatos (metastore) de próxima generación, pensado para centralizar y simplificar la gobernanza de datos y recursos de datos. Originalmente, Unity Catalog formaba parte de los servicios ofrecidos por la plataforma Databricks, pero el proyecto ha dado un salto a la comunidad de código abierto para convertirse en un estándar de referencia. Esto implica que ahora es posible utilizarlo, modificarlo y, en definitiva, contribuir a su evolución desde un entorno libre y colaborativo. Con ello, se espera que más organizaciones adopten sus modelos de catálogo y compartición, impulsando la reutilización de datos y la creación de flujos analíticos e innovaciones tecnológicas.

Fuente: https://docs.unitycatalog.io/

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

Objetivos

En este ejercicio, aprenderemos a configurar Unity Catalog, una herramienta que nos ayuda a organizar y compartir datos en la nube de manera segura. Aunque utilizaremos algo de código, explicaremos cada paso para que incluso personas con poca experiencia en programación puedan seguirlo a través de un laboratorio práctico.

Trabajaremos con un escenario realista donde gestionaremos datos sobre transporte público en diferentes ciudades. Crearemos catálogos de datos, configuraremos una base de datos y aprenderemos a interactuar con la información usando herramientas como Docker, Apache Spark y MLflow.

Nivel de dificultad: Intermedio.

Figura 1. Esquema Unity Catalog

Recursos Necesarios

En esta sección explicaremos los requisitos previos y recursos necesarios para poder desarrollar este laboratorio. El laboratorio está pensado para desarrollarse en un ordenador personal estándar (Windows, MacOS, Linux).

Adicionalmente utilizaremos las siguientes herramientas y entornos de trabajo:

- Docker Desktop: Docker es una herramienta que nos permite ejecutar aplicaciones en un entorno aislado llamado contenedor. Un contenedor es como una "caja" que contiene todo lo necesario para que una aplicación funcione correctamente, sin importar el sistema operativo que estés usando.

- Visual Studio Code: Nuestro entorno de trabajo será un Notebook Python que ejecutaremos y manipularemos a través del editor de código ampliamente utilizado Visual Studio Code (VS Code).

- Unity Catalog: Es una herramienta de gobernanza de datos que permite organizar y controlar el acceso a recursos como tablas, volúmenes de datos, funciones o modelos de machine learning. A lo largo del laboratorio, utilizaremos su versión open source, que puede desplegarse localmente, para aprender a gestionar catálogos de datos con control de permisos, trazabilidad y estructura jerárquica. Unity Catalog actúa como un metastore centralizado, facilitando la colaboración y la reutilización de datos de forma segura.

- Amazon Web Services: AWS será el proveedor cloud que utilizaremos para alojar ciertos datos del laboratorio, en concreto los datos en crudo (como archivos JSON) que gestionaremos mediante volúmenes de datos. Aprovecharemos su servicio Amazon S3 para almacenar estos archivos y configuraremos las credenciales y permisos necesarios para que Unity Catalog pueda interactuar con ellos de forma controlada.

Desarrollo del ejercicio

A lo largo del ejercicio, los participantes desplegarán la aplicación, comprenderán su arquitectura e irán construyendo un catálogo de datos paso a paso, aplicando buenas prácticas de organización, control de acceso y trazabilidad.

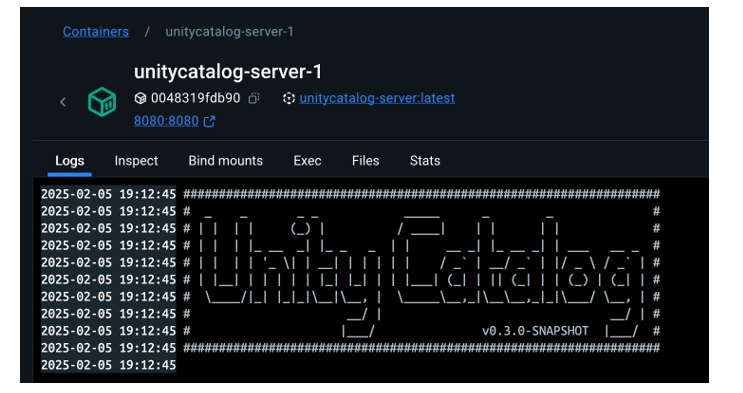

Despliegue y primeros pasos

- Clonamos el repositorio de Unity Catalog y lo levantamos con Docker.

- Exploramos su arquitectura: un backend accesible por API y CLI, y una interfaz gráfica intuitiva.

- Navegamos por los recursos que gestiona Unity Catalog: catálogos, esquemas, tablas, volúmenes, funciones y modelos.

Figura 2. Captura de pantalla

¿Qué aprenderemos aquí?

Cómo levantar la aplicación, sus componentes principales, y cómo empezar a interactuar con ella desde distintos puntos: web, API y CLI.

Organización de recursos

- Configuramos una base de datos MySQL externa como repositorio de metadatos.

- Creamos catálogos para representar distintas ciudades y esquemas para distintos servicios públicos.

Figura 3. Captura de pantalla

¿Qué aprenderemos aquí?

Cómo estructurar el gobierno de datos a distintos niveles (ciudad, servicio, dataset) y cómo gestionar los metadatos de forma centralizada y persistente.

Construcción de datos y uso real

- Creamos tablas estructuradas para representar rutas, autobuses o paradas.

- Cargamos datos reales en estas tablas usando PySpark.Habilitamos un bucket en AWS S3 como almacenamiento de datos en crudo (volúmenes).

- Subimos ficheros JSON con eventos de telemetría y los gobernamos desde Unity Catalog.

Figura 4. Esquema

¿Qué aprenderemos aquí?

Cómo convivir con distintos tipos de datos (estructurados y no estructurados), y cómo integrarlos con fuentes externas (como AWS S3).

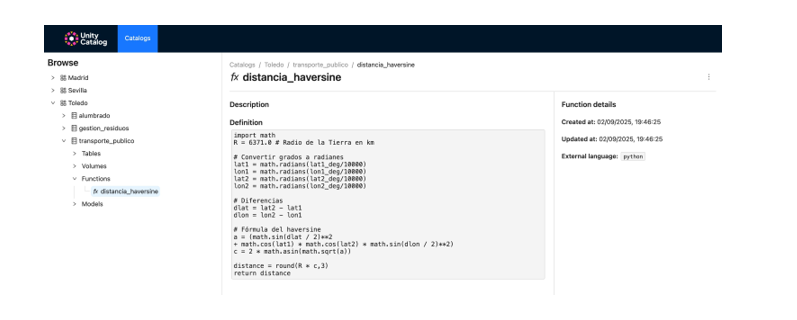

Funciones reutilizables y modelos de IA

- Registramos funciones personalizadas (como el cálculo de distancias) reutilizables desde el catálogo.

- Creamos y registramos modelos de machine learning con MLflow.

- Ejecutamos predicciones desde Unity Catalog como si fueran cualquier otro recurso del ecosistema.

Figura 5. Captura de pantalla

¿Qué aprenderemos aquí?

Cómo ampliar el gobierno de datos a funciones y modelos, y cómo facilitar su reutilización y trazabilidad en entornos colaborativos.

Resultados y conclusiones

Como resultado de este laboratorio práctico, vamos a poner conocer la herramienta Unity Catalog como plataforma abierta para la gobernanza de datos y recursos de datos como modelos de machine learning. Exploraremos, además, el contexto de un caso de uso concreto y con un ecosistema de herramientas similar al que podemos encontrar en una organización real, sus capacidades, su modo de despliegue y su uso.

Mediante este ejercicio configuraremos y utilizaremos Unity Catalog para organizar datos de transporte público. En concreto, podrás:

- Aprender a instalar herramientas como Docker o Spark.

- Crear catálogos, esquemas y tablas en Unity Catalog.

- Cargar datos y almacenarlos en un bucket de Amazon S3.

- Implementar un modelo de machine learning con MLflow.

Veremos, en los próximos años, si este tipo de herramientas alcanzan el nivel de estandarización necesario para transformar la forma en que se administran y comparten los recursos de datos en múltiples sectores.

¡Te animamos a realizar más ejercicios de ciencia de datos! Accede al repositorio aquí

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Las ciudades concentran más de dos tercios de la población europea y consumen alrededor del 80 % de la energía. En este contexto, el cambio climático está teniendo un impacto particularmente severo en los entornos urbanos, no solo por su densidad, sino por sus características constructivas, su metabolismo energético y la escasez de vegetación en muchas zonas consolidadas. Uno de los efectos más visibles y preocupantes es el fenómeno conocido como isla de calor urbana (UHI, por sus siglas en inglés).

Las islas de calor se producen cuando la temperatura en las zonas urbanas es significativamente más alta que en las zonas rurales o periurbanas cercanas, especialmente durante la noche. Este diferencial térmico puede superar fácilmente los cinco grados centígrados en determinadas condiciones. Las consecuencias de este fenómeno van más allá del malestar térmico: afecta directamente a la salud, la calidad del aire, el consumo energético, la biodiversidad urbana y la equidad social.

En los últimos años, la disponibilidad de datos abiertos —especialmente datos geoespaciales— ha permitido caracterizar, mapear y analizar las islas de calor urbanas con una precisión sin precedentes. Este artículo explora cómo estos datos pueden ser utilizados para diseñar soluciones urbanas adaptadas al cambio climático, tomando como eje la mitigación de las islas de calor.

Qué son las islas de calor urbanas y por qué se producen

Una isla de calor urbana es un fenómeno térmico que se genera cuando la infraestructura urbana absorbe y retiene más calor que las zonas no urbanizadas. Esta acumulación de calor se debe a varios factores que actúan de forma sinérgica:

- La presencia de materiales como asfalto, hormigón o ladrillo, que tienen una alta capacidad de absorción térmica.

- La escasez de vegetación, que limita el enfriamiento natural por evapotranspiración.

- La morfología urbana (altura y disposición de los edificios), que puede obstaculizar la ventilación natural.

- Las emisiones de calor derivadas de la actividad humana (vehículos, climatización o procesos industriales).

- La impermeabilización del suelo, que impide la infiltración de agua y reduce el efecto termorregulador del subsuelo húmedo.

El resultado es que muchas ciudades, especialmente en latitudes mediterráneas, se convierten en auténticos sumideros de calor durante los meses cálidos. Este fenómeno no afecta por igual a todos los barrios: los más vulnerables son, con frecuencia, los más densamente construidos, con menos arbolado y con una mayor proporción de población en situación de pobreza energética.

Figura 1. Elemento ilustrativo sobre las islas de calor.

El papel clave de los datos para entender y combatir las islas de calor

Para intervenir eficazmente en las islas de calor es necesario saber dónde, cuándo y cómo se producen. A diferencia de otros riesgos naturales, el efecto isla de calor no es visible a simple vista, y su intensidad varía según la hora del día, la época del año y las condiciones meteorológicas concretas. Por tanto, requiere una base de conocimiento sólida y dinámica, que solo se puede construir mediante la integración de datos diversos, actualizados y territorializados.

En este punto, los datos geoespaciales abiertos son una herramienta fundamental. A través de imágenes satelitales, mapas urbanos, datos meteorológicos, cartografía catastral y otros conjuntos accesibles al público, es posible construir modelos térmicos urbanos, identificar zonas críticas, estimar exposiciones diferenciales y evaluar el impacto de las medidas adoptadas.

A continuación, se detallan las principales categorías de datos que permiten abordar el fenómeno de las islas de calor desde una perspectiva territorial e interdisciplinar.

Tipologías de datos geoespaciales aplicables al estudio del fenómeno

1. Datos satelitales de observación de la Tierra

Los sensores térmicos embarcados en satélites como Landsat 8/9 (NASA/USGS) o Sentinel-3 (Copernicus) permiten generar mapas de temperatura superficial urbana con resoluciones que oscilan entre los 30 y los 1.000 metros. Aunque estas imágenes tienen limitaciones espaciales y temporales, son suficientes para detectar patrones y tendencias, sobre todo si se combinan con series temporales.

Estos datos, accesibles a través de plataformas como el Copernicus Open Access Hub o el USGS EarthExplorer, son fundamentales para realizar estudios comparativos entre ciudades o para observar la evolución temporal de una misma zona.

2. Datos meteorológicos urbanos

La red de estaciones de AEMET, junto con otras estaciones automáticas gestionadas por comunidades autónomas o ayuntamientos, permite analizar la evolución de las temperaturas del aire en diferentes puntos urbanos. En algunos casos, también se dispone de sensores ciudadanos o redes de sensores distribuidos en el espacio urbano que permiten generar mapas de calor en tiempo real con alta resolución.

3. Cartografía urbana y modelos digitales del terreno

Los modelos digitales de superficie (DSM), modelos digitales del terreno (DTM) y cartografías derivadas del LIDAR permiten estudiar la morfología urbana, la densidad edificatoria, la orientación de las calles, la pendiente del terreno y otros factores que afectan a la ventilación natural y la acumulación de calor. En España, estos datos son accesibles a través del Centro Nacional de Información Geográfica (CNIG).

4. Bases de datos de cobertura y uso de suelo

Las bases de datos como Corine Land Cover del Programa Copernicus, o los mapas de ocupación del suelo a nivel autonómico permiten distinguir entre zonas urbanizadas, zonas verdes, superficies impermeables y cuerpos de agua. Esta información es clave para calcular el grado de artificialización de una zona y su relación con el balance térmico.

5. Inventarios de arbolado y espacios verdes

Algunos ayuntamientos publican en sus portales de datos abiertos el inventario detallado del arbolado urbano, parques y jardines. Estos datos, georreferenciados, permiten analizar el efecto de la vegetación sobre el confort térmico, así como planificar nuevas plantaciones o corredores verdes.

6. Datos socioeconómicos y de vulnerabilidad

Los datos del Instituto Nacional de Estadística (INE), junto con los sistemas de información social de comunidades autónomas y ayuntamientos, permiten identificar los barrios más vulnerables desde el punto de vista social y económico. Su cruce con los datos térmicos permite incorporar una dimensión de justicia climática en la toma de decisiones.

Aplicaciones prácticas: cómo se utilizan los datos abiertos para actuar

Una vez reunidos e integrados los datos relevantes, se pueden aplicar múltiples estrategias de análisis que permiten fundamentar políticas públicas y proyectos urbanos con criterios de sostenibilidad y equidad. A continuación, se describen algunas de las principales aplicaciones.

- Cartografía de zonas de calor y mapas de vulnerabilidad: el uso conjunto de imágenes térmicas, datos meteorológicos y capas urbanas permite generar mapas de intensidad de isla de calor a nivel de barrio o manzana. Si estos mapas se combinan con indicadores sociales, demográficos y de salud pública, es posible construir mapas de vulnerabilidad térmica, que prioricen la intervención en zonas donde se cruzan altas temperaturas y altos niveles de riesgo social. Estos mapas permiten, por ejemplo:

- Identificar barrios prioritarios para reverdecimiento urbano.

- Planificar rutas de evacuación o zonas de sombra durante olas de calor.

- Determinar la localización óptima de refugios climáticos.

- Evaluación del impacto de soluciones basadas en la naturaleza: los datos abiertos también permiten monitorizar los efectos de determinadas actuaciones urbanas. Por ejemplo, mediante series temporales de imágenes satelitales o sensores de temperatura, se puede evaluar cómo la creación de un parque o la plantación de arbolado en una calle ha modificado la temperatura superficial. Este enfoque de evaluación ex post permite justificar inversiones públicas, ajustar diseños y escalar soluciones eficaces a otras zonas con condiciones similares.

- Modelización urbana y simulaciones climáticas: los modelos urbanos tridimensionales, construidos a partir de datos abiertos LIDAR o cartografía catastral, permiten simular el comportamiento térmico de un barrio o una ciudad bajo diferentes escenarios climáticos y urbanísticos. Estas simulaciones, combinadas con herramientas como ENVI-met o Urban Weather Generator, son fundamentales para apoyar la toma de decisiones en planeamiento urbano.

Estudios y análisis existentes sobre islas de calor urbanas: qué se ha hecho y qué podemos aprender

Durante la última década se han realizado múltiples estudios en España y Europa que muestran cómo los datos abiertos, especialmente los de carácter geoespacial, permiten caracterizar y analizar el fenómeno de las islas de calor urbanas. Estos trabajos son fundamentales no solo por sus resultados específicos, sino porque ilustran metodologías replicables y escalables. Seguidamente, se describen algunos de los más relevantes.

Estudio de la Universidad Politécnica de Madrid sobre temperatura superficial en Madrid

Un equipo del Departamento de Ingeniería Topográfica y Cartografía de la UPM analizó la evolución de la temperatura superficial en el municipio de Madrid utilizando imágenes térmicas del satélite Landsat 8 en el periodo estival. El estudio se centró en detectar los cambios espaciales de las zonas más cálidas y relacionarlos con el uso del suelo, la vegetación urbana y la densidad edificatoria.

Figura 2. Imagen ilustrativa. Fuente: generada con IA

Metodología:

Se aplicaron técnicas de teledetección para extraer la temperatura superficial a partir del canal térmico TIRS del Landsat. Posteriormente, se realizó un análisis estadístico de correlación entre los valores térmicos y variables como el NDVI (índice de vegetación), el tipo de cobertura del suelo (datos CORINE) y la morfología urbana.

Resultados principales:

Las zonas con mayor densidad edificatoria, como los barrios del centro y del sur, mostraban temperaturas superficiales más altas. Por su parte, la presencia de parques urbanos reducía entre 3 y 5 °C la temperatura de su entorno inmediato. Se confirmó que el efecto isla de calor se intensifica en horarios nocturnos, especialmente durante olas de calor persistentes.

Este tipo de análisis es especialmente útil para diseñar estrategias de reverdecimiento urbano y para justificar intervenciones en barrios vulnerables.

Atlas de vulnerabilidad climática de Barcelona

El Ayuntamiento de Barcelona, en colaboración con expertos en salud pública y geografía urbana, desarrolló un Atlas de vulnerabilidad climática que incluye mapas detallados de exposición al calor, sensibilidad poblacional y capacidad adaptativa. El objetivo era orientar políticas municipales frente al cambio climático, especialmente en el ámbito de salud y servicios sociales.

Figura 3. Imagen que contiene cerca, exterior, edificios y pasto. Fuente: generada con IA

Metodología:

El atlas se elaboró combinando datos abiertos y administrativos a nivel de sección censal. Se analizaron tres dimensiones: exposición (datos de temperatura del aire y superficie), sensibilidad (edad avanzada, densidad, morbilidad) y capacidad adaptativa (acceso a zonas verdes, calidad de la vivienda, equipamientos). Los indicadores se normalizaron y combinaron mediante análisis espacial multicriterio para generar un índice de vulnerabilidad climática. El resultado permitió localizar los barrios con mayor riesgo frente al calor extremo y orientar medidas municipales.

Resultados principales:

A partir del atlas, se diseñó la red de “refugios climáticos”, que incluye bibliotecas, centros cívicos, escuelas y parques acondicionados, activados durante los episodios de calor extremo. La selección de estos espacios se basó directamente en los datos del atlas.

Análisis multitemporal del efecto isla de calor en Sevilla

Investigadores de la Universidad de Sevilla utilizaron datos satelitales de Sentinel-3 y Landsat 8 para estudiar la evolución del fenómeno de isla de calor en la ciudad entre 2015 y 2022. El objetivo fue evaluar la eficacia de ciertas actuaciones urbanas —como el plan “Reverdece tu barrio”— y anticipar los efectos del cambio climático en la ciudad.

Metodología:

Se emplearon imágenes térmicas y datos NDVI para calcular diferencias de temperatura entre áreas urbanas y zonas rurales circundantes. También se aplicaron técnicas de clasificación supervisada para identificar usos del suelo y su evolución. Se utilizaron datos abiertos de inventarios de arbolado y mapas de sombra urbana para interpretar los resultados.

Resultados principales:

Las actuaciones puntuales de renaturalización tienen un impacto local muy positivo, pero su efecto sobre el conjunto de la ciudad es limitado si no se integran en una estrategia de escala metropolitana. El estudio concluyó que una red continua de vegetación y cuerpos de agua es más eficaz que actuaciones aisladas.

Comparativa europea del proyecto Urban Heat Island Atlas (Copernicus)

Aunque no es un estudio español, el visor desarrollado por Copernicus para el programa europeo Urban Atlas ofrece un análisis comparativo entre ciudades europeas.

Metodología:

El visor integra imágenes térmicas de Sentinel-3, datos de ocupación del suelo y cartografía urbana para evaluar la severidad del efecto isla de calor.

Figura 4. Imagen ilustrativa

Ilustración: Infografía que muestra los principales factores que provocan el efecto isla de calor urbano (UHI). Las zonas urbanas retienen el calor debido a los edificios altos, las superficies impermeables y los materiales que retienen el calor, mientras que las zonas verdes son más frescas Fuente: Urban heat islands.

Resultados principales:

Este tipo de herramientas permite a ciudades de menor tamaño disponer de una primera aproximación del fenómeno sin necesidad de desarrollar modelos propios. Al estar basado en datos abiertos y gratuitos, el visor permite consultas directas por parte de técnicos y ciudadanía.

Limitaciones y desafíos actuales

A pesar del avance en la apertura de datos, todavía existen importantes retos:

- Desigualdad territorial: no todas las ciudades disponen de la misma calidad y cantidad de datos.

- Actualización irregular: algunos conjuntos se publican de forma puntual y no se actualizan regularmente.

- Escasa granularidad: los datos a menudo están agregados por distritos o secciones censales, lo que dificulta intervenciones a escala de calle.

- Falta de capacidades técnicas: muchas administraciones locales no cuentan con personal especializado en análisis geoespacial.

- Poca conexión con la ciudadanía: el conocimiento generado a partir de los datos no siempre se traduce en acciones visibles o comprensibles para la población.

Conclusión: construir resiliencia climática desde el dato geoespacial

Las islas de calor urbanas no son un fenómeno nuevo, pero en el contexto del cambio climático adquieren una dimensión crítica. Las ciudades que no planifiquen con base en datos se verán cada vez más expuestas a episodios de calor extremo, con impactos desiguales entre su población.

Los datos abiertos —y en particular los datos geoespaciales— ofrecen una oportunidad estratégica para transformar esta amenaza en una palanca de cambio. Con ellos podemos identificar, anticipar, intervenir y evaluar. Pero para que esto suceda, es imprescindible:

- Consolidar infraestructuras de datos accesibles, actualizadas y de calidad.

- Fomentar la colaboración entre niveles de gobierno, centros de investigación y ciudadanía.

- Capacitar a los técnicos municipales en el uso de herramientas geoespaciales.

- Promover una cultura de la toma de decisiones basada en evidencia y sensibilidad climática.

El dato no sustituye a la política, pero permite fundamentarla, mejorarla y hacerla más equitativa. En un escenario de calentamiento global, contar con datos geoespaciales abiertos es una herramienta clave para hacer que nuestras ciudades sean más habitables y mejor preparadas para el futuro.

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El deporte siempre se ha caracterizado por generar muchos datos, estadísticas, gráficos… Pero acumular cifras no es suficiente. Es necesario analizar los datos, sacar conclusiones y tomar decisiones en base a ellos. Las ventajas de compartir datos en este sector van más allá de lo meramente deportivo, teniendo un impacto positivo en la salud y en el ámbito económico. van más allá de lo meramente deportivo, teniendo un impacto positivo en la salud y en el ámbito económico.

La inteligencia artificial (IA) ha llegado también al sector del deporte profesional y su capacidad para procesar enormes cantidades de datos ha abierto la puerta a aprovechar al máximo el potencial de toda esa información. El Manchester City, uno de los clubes de fútbol más conocidos de la Premier League británica, fue uno de los pioneros en utilizar la inteligencia artificial para mejorar su desempeño deportivo: utiliza algoritmos de IA para la selección de nuevos talentos y ha colaborado en el desarrollo de WaitTime, una plataforma de inteligencia artificial que gestiona la asistencia de multitudes en grandes recintos deportivos y de ocio. En España, el Real Madrid, por ejemplo, incorporó el uso de la inteligencia artificial hace unos años e impulsa foros sobre el impacto de la IA en el deporte.

Los sistemas de inteligencia artificial analizan volúmenes extensos de datos recopilados durante entrenamientos y competiciones, y son capaces de proporcionar evaluaciones detalladas sobre la efectividad de las estrategias y oportunidades de optimización. Además, es posible desarrollar alertas sobre riesgos de lesiones, permitiendo establecer medidas de prevención, o crear planes de entrenamiento personalizados que se adaptan automáticamente a cada deportista en función de sus necesidades individuales. Estas herramientas han modificado por completo la preparación deportiva contemporánea de alto nivel. Es este post vamos a repasar algunos de estos casos de uso.

De la simple observación a una gestión completa del dato para optimizar resultados

Los métodos tradicionales de evaluación deportiva han evolucionado hacia sistemas tecnológicos altamente especializados. Las herramientas de inteligencia artificial y aprendizaje automático procesan volúmenes masivos de información durante entrenamientos y competiciones, convirtiendo estadísticas, datos biométricos y contenido audiovisual en insights estratégicos para la gestión de la preparación y la salud de deportistas.

Los sistemas de análisis de rendimiento en tiempo real constituyen una de las implementaciones más consolidadas en el sector deportivo. Para recopilar estos datos, es habitual ver a los deportistas entrenar con bandas o chalecos que monitorizan en tiempo real diferentes parámetros. Tanto estos como otros dispositivos y sensores, registran movimientos, velocidades y datos biométricos. La frecuencia cardiaca, la velocidad o la aceleración son algunos de los datos más habituales. Los algoritmos de IA procesan esta información, generando resultados inmediatos que ayudan a optimizar programas de entrenamiento personalizados para cada deportista y adaptaciones tácticas, identificando patrones para localizar áreas de mejora.

En este sentido, las plataformas de inteligencia artificial deportiva evalúan tanto el desempeño individual como la dinámica colectiva en el caso de los deportes de equipos. Para evaluar el área táctica se analizan distintos tipos de datos según la modalidad deportiva. En disciplinas de resistencia se examina la velocidad, la distancia, el ritmo o la potencia, mientras que en los deportes de equipo cobran especial relevancia datos sobre la posición de los jugadores o la precisión en los pases o tiros.

Otro avance son las cámaras con IA, que permiten seguir la trayectoria de los jugadores en el campo y los movimientos de los distintos elementos, como el balón en los deportes de pelota. Estos sistemas generan multitud de datos sobre posiciones, desplazamientos y patrones de juego. El análisis de estos conjuntos de datos históricos permite identificar fortalezas y vulnerabilidades estratégicas tanto propias como de los oponentes. Esto ayuda a generar diferentes opciones tácticas y mejorar la toma de decisiones antes de una competición.

Salud y bienestar de las personas deportistas

Los sistemas de prevención de lesiones deportivas analizan datos históricos y métricas en tiempo real. Sus algoritmos identifican patrones de riesgo de lesiones, lo que permite tomar medidas preventivas personalizadas para cada atleta. En el caso del fútbol, equipos como el Manchester United, Liverpool, Valencia CF y Getafe CF implementan estas tecnologías desde hace varios años.

Además de los datos que hemos visto anteriormente, las plataformas de monitorización deportiva también registran variables fisiológicas de forma continua: frecuencia cardíaca, patrones de sueño, fatiga muscular y biomecánica del movimiento. Los dispositivos wearables con capacidades de inteligencia artificial detectan indicadores de fatiga, desequilibrios o estrés físico que preceden a lesiones. Con estos datos, los algoritmos predicen patrones que detectan riesgos y facilitan actuar de manera preventiva, ajustando entrenamientos o desarrollando programas específicos de recuperación antes de que se produzca una lesión. De esta forma se pueden calibrar cargas de entrenamiento, volumen de repeticiones, intensidad y períodos de recuperación según perfiles individuales. Este mantenimiento predictivo para deportistas es especialmente relevante para equipos y clubes en los que los atletas constituyen no solo activos deportivos, sino también económicos. Además, estos sistemas también optimizan procesos de rehabilitación deportiva, permitiendo reducir los tiempos de recuperación en lesiones musculares hasta un 30% y proporciona predicciones sobre riesgo de reincidencia.

Si bien no son infalibles, los datos indican que estas plataformas predicen aproximadamente 50% de lesiones durante temporadas deportivas, aunque no pueden pronosticar cuándo se van a producir. La aplicación de la IA al cuidado de la salud en el deporte contribuye así a la extensión de las carreras deportivas profesionales, facilitando un rendimiento óptimo y el bienestar atlético del deportista a largo plazo.

Mejora de la experiencia del público

La inteligencia artificial también está revolucionando la forma en que los aficionados disfrutan del deporte, tanto en estadios como desde casa. Gracias a sistemas de procesamiento de lenguaje natural (NLP), los espectadores pueden seguir comentarios y subtítulos en tiempo real, facilitando el acceso a personas con discapacidad auditiva o hablantes de otras lenguas. El Manchester City ha incorporado recientemente esta tecnología para la generación de subtítulos en tiempo real en las pantallas de su estadio. Estas aplicaciones han llegado también a otras disciplinas deportivas: IBM Watson ha desarrollado una funcionalidad que permite a los aficionados de Wimbledon ver los vídeos con comentarios destacados y subtítulos generados por IA.

Además, la IA optimiza la gestión de grandes aforos mediante sensores y algoritmos predictivos, agilizando el acceso, mejorando la seguridad y personalizando servicios como la ubicación de asientos. Incluso en las retransmisiones, herramientas impulsadas por IA ofrecen estadísticas instantáneas, highlights automatizados y cámaras inteligentes que siguen la acción sin intervención humana, haciendo la experiencia más inmersiva y dinámica. La NBA utiliza Second Spectrum, un sistema que combina cámaras con IA para analizar movimientos de jugadores y crear visualizaciones, como rutas de pases o probabilidades de tiro. Otros deportes, como el golf o la Fórmula 1, también utilizan herramientas similares que mejoran la experiencia de los aficionados.

La privacidad de los datos y otros desafíos

La aplicación de la IA en el deporte plantea también importantes desafíos éticos. La recopilación y análisis de información biométrica genera dudas sobre la seguridad y protección de datos personales de los deportistas, por lo que es necesario establecer protocolos que garanticen la gestión del consentimiento, así como la propiedad de dichos datos.

La equidad representa otra preocupación, ya que la aplicación de la inteligencia artificial otorga ventajas competitivas a los equipos y organizaciones con mayores recursos económicos, lo que puede contribuir a perpetuar desigualdades.

A pesar de estos desafíos, la inteligencia artificial ha transformado radicalmente el panorama deportivo profesional. El futuro del deporte parece estar unido a la evolución de esta tecnología. Su aplicación promete seguir elevando el rendimiento de los atletas y la experiencia del público, aunque es necesario superar algunos desafíos.

Imagina que quieres saber cuántas terrazas hay en tu barrio, cómo evolucionan los niveles de polen del aire que respiras cada día o si el reciclaje en tu ciudad está funcionando bien. Toda esa información existe en las bases de datos de tu ayuntamiento, pero se encuentra entre hojas de cálculo y documentos técnicos que solo los expertos sabían interpretar.

Aquí es donde entran en juego las iniciativas de visualización de datos abiertos: transforman esos números aparentemente fríos en historias que cualquier persona puede entender de un vistazo. Un gráfico colorido que muestra la evolución del tráfico en tu calle, un mapa interactivo con las zonas verdes de tu ciudad, o una infografía que explica en qué se gasta el presupuesto municipal. Estas herramientas convierten la información pública en algo cercano, útil y, además, comprensible para toda la ciudadanía.

Además, las ventajas de este tipo de soluciones no son solo para la ciudadanía, sino que también benefician a la Administración que realiza el ejercicio, porque permite:

- Detectar y corregir errores en los datos.

- Incorporar nuevos conjuntos al portal.

- Disminuir el número de preguntas del ciudadano.

- Generar más confianza por parte de la sociedad.

Por tanto, visualizar datos abiertos permite acercar la Administración a la ciudadanía, facilita la toma de decisiones informadas, ayuda a las Administraciones Públicas a mejorar su oferta de datos abiertos y permite crear una sociedad más participativa donde todos podemos entender mejor cómo funciona el sector público. En este post, te presentamos algunos ejemplos de iniciativas de visualización de open data en portales de datos abiertos autonómicos y municipales.

Visualiza Madrid: acercando los datos a la ciudadanía

El portal de datos abiertos del Ayuntamiento de Madrid ha desarrollado la iniciativa "Visualiza Madrid", un proyecto que nace con el objetivo específico de hacer que los datos abiertos y su potencial lleguen a la ciudadanía en general, trascendiendo los perfiles técnicos especializados. Tal y como explicó Ascensión Hidalgo Bellota, Subdirectora general de Transparencia del Ayuntamiento de Madrid, durante el IV Encuentro Nacional de Datos Abiertos, “esta iniciativa responde a la necesidad de democratizar el acceso a la información pública”.

Actualmente, Visualiza Madrid cuenta con 29 visualizaciones que abarcan diferentes temáticas de interés ciudadano, desde información sobre terrazas de hostelería hasta gestión de residuos y análisis del tráfico urbano. Esta diversidad temática demuestra la versatilidad de las visualizaciones como herramienta para comunicar información de sectores muy diversos de la administración pública.

Además, la iniciativa ha recibido este año un reconocimiento externo a través de los premios Audaz 2025, una iniciativa del capítulo español de la Red Académica de Gobierno Abierto (RAGA España).

Castilla y León: análisis integral de datos regionales

La Junta de Castilla y León también ha desarrollado un portal especializado en análisis y visualizaciones que destaca por su enfoque integral hacia la presentación de datos autonómicos. Su plataforma de visualizaciones ofrece una aproximación sistemática al análisis de información regional, permitiendo a los usuarios explorar diferentes dimensiones de la realidad de Castilla y León a través de herramientas interactivas y dinámicas.

Esta iniciativa permite presentar información compleja de manera estructurada y comprensible, facilitando tanto el análisis académico como el uso ciudadano de los datos. La plataforma integra diferentes fuentes de información autonómica, creando un ecosistema coherente de visualizaciones que permite obtener una visión panorámica de diversos aspectos de la gestión regional. Entre las temáticas que ofrece podemos mencionar datos de turismo, del mercado laboral o de la ejecución de los presupuestos. Todas las visualizaciones están realizadas con conjuntos de datos abiertos del portal autonómico de Castilla y León.

El enfoque de Castilla y León demuestra cómo las visualizaciones pueden servir como herramienta de análisis territorial, proporcionando insights valiosos sobre dinámicas económicas, sociales y demográficas que resultan fundamentales para la planificación y evaluación de políticas públicas regionales.

Canarias: integración tecnológica con widgets interactivos

Por otro lado, el Gobierno de Canarias ha apostado por una estrategia innovadora mediante la implementación de widgets que permiten la integración de visualizaciones de datos abiertos del Instituto Canario de Estadística (ISTAC) en diferentes plataformas y contextos. Esta aproximación tecnológica representa un salto cualitativo en la distribución y reutilización de visualizaciones de datos públicos.

Los widgets desarrollados por Canarias facilitan que terceros puedan incorporar visualizaciones oficiales en sus propias aplicaciones, sitios web o análisis, ampliando exponencialmente el alcance y la utilidad de los datos abiertos canarios. Esta estrategia no solo multiplica los puntos de acceso a la información pública, sino que también fomenta la creación de un ecosistema colaborativo donde diferentes actores pueden beneficiarse y contribuir al valor de los datos abiertos.

La iniciativa canaria ilustra cómo la tecnología puede ser utilizada para crear soluciones escalables y flexibles que maximicen el impacto de las inversiones en visualización de datos abiertos, estableciendo un modelo replicable para otras administraciones que busquen amplificar el alcance de sus iniciativas de transparencia.

Lecciones aprendidas y mejores prácticas

A modo de ejemplo, los casos analizados revelan patrones comunes que pueden servir como guía para futuras iniciativas. La orientación hacia la ciudadanía general, más allá de usuarios técnicos especializados, emerge como un factor de oportunidad para el éxito de estas plataformas. Para mantener el interés y la relevancia de las visualizaciones es importante ofrecer diversidad temática y actualizar los datos regularmente.

La integración tecnológica y la interoperabilidad, como demuestra el caso de Canarias, abren nuevas posibilidades para maximizar el impacto de las inversiones públicas en visualización de datos. Asimismo, el reconocimiento externo y la participación en redes profesionales, como evidencia el caso de Madrid, contribuyen a la mejora continua y al intercambio de mejores prácticas entre administraciones.

En términos generales, las iniciativas de visualización de datos abiertos representan una oportunidad muy valiosa en la estrategia de transparencia y gobierno abierto de las administraciones públicas españolas. Los casos de Madrid, Castilla y León, así como de Canarias, son ejemplo de que existe un potencial enorme para transformar datos públicos en herramientas de empoderamiento ciudadano y mejora de la gestión pública.

El éxito de estas iniciativas radica en su capacidad para conectar la información gubernamental con las necesidades reales de la ciudadanía, creando puentes de comprensión que fortalecen la relación entre administración y sociedad. A medida que estas experiencias maduren y se consoliden, será fundamental mantener el foco en la usabilidad, la accesibilidad y la relevancia de las visualizaciones, asegurando que los datos abiertos cumplan verdaderamente su promesa de contribuir a una sociedad más informada, participativa y democrática.

La visualización de datos abiertos no es solo una cuestión técnica, sino una oportunidad estratégica para redefinir la comunicación pública y fortalecer los cimientos de una Administración verdaderamente abierta y transparente.

En un mundo cada vez más interconectado y complejo, la inteligencia geoespacial (GEOINT) se ha convertido en una herramienta esencial para la toma de decisiones en el ámbito de la defensa y la seguridad. La capacidad de recopilar, analizar e interpretar datos geoespaciales permite a las Fuerzas Armadas y a las agencias de seguridad comprender mejor el entorno operativo, anticipar amenazas y planificar operaciones con mayor eficacia.

En este contexto, los datos satelitales, clasificados pero también los abiertos, han adquirido una relevancia significativa. Programas como Copernicus de la Unión Europea proporcionan acceso gratuito y abierto a una amplia gama de datos de observación de la Tierra, lo que democratiza el acceso a información crítica y fomenta la colaboración entre diferentes actores.

Este artículo explora el papel de los datos en la inteligencia geoespacial aplicada a la defensa, destacando su importancia, aplicaciones y el liderazgo de España en este ámbito.

¿Qué es la Inteligencia Geoespacial?

La inteligencia geoespacial (GEOINT) es una disciplina que combina la recopilación, análisis e interpretación de datos geoespaciales para apoyar la toma de decisiones en diversas áreas, incluyendo la defensa, la seguridad y la gestión de emergencias. Estos datos pueden incluir imágenes satelitales, información de sensores remotos, datos de sistemas de información geográfica (SIG) y otras fuentes que proporcionan información sobre la ubicación y las características del terreno.

En el ámbito de la defensa, la GEOINT permite a los analistas y planificadores militares obtener una comprensión detallada del entorno operativo, identificar amenazas potenciales y planificar operaciones con mayor precisión. Además, facilita la coordinación entre diferentes unidades y agencias, mejorando la eficacia de las operaciones conjuntas.

Aplicaciones en el ámbito de la defensa

La integración de datos satelitales abiertos en la inteligencia geoespacial ha ampliado significativamente las capacidades de defensa. A continuación, se presentan algunas de las aplicaciones más relevantes:

Figura 1. Aplicaciones GEOINT en defensa. Fuente: elaboración propia

La inteligencia geoespacial no solo apoya a las Fuerzas Armadas en la toma de decisiones tácticas, sino que también transforma la forma en que se planifican y ejecutan operaciones militares, de vigilancia y de respuesta a emergencias. Aquí presentamos casos de uso concretos donde la GEOINT, apoyado en datos satelitales abiertos, ha tenido un impacto decisivo.

Monitoreo de movimientos militares en conflictos

Caso: Guerra de Ucrania (2022–2024)

Organizaciones como el Centro de Satélites de la UE (SatCen) y ONGs como Conflict Intelligence Team han usado imágenes Sentinel-1 y Sentinel-2 (Copernicus) para:

- Detectar concentraciones de tropas y material militar ruso.

- Analizar cambios en aeródromos, bases o rutas logísticas.

- Apoyar la verificación independiente de eventos sobre el terreno.

Esto ha sido clave para la toma de decisiones de la UE y la OTAN, sin necesidad de recurrir a datos clasificados.

Vigilancia marítima y control de fronteras

Caso: Operaciones de FRONTEX en el Mediterráneo

GEOINT alimentado por Sentinel-1 (radar) y Sentinel-3 (óptico + altímetro) permite:

- Identificar embarcaciones no autorizadas, incluso bajo nubes o de noche.

- Integrar alertas con AIS (sistema de identificación automática de buques).

- Coordinar rescates y operaciones de intercepción.

Ventaja: el radar de apertura sintética (SAR) de Sentinel-1 puede ver a través de las nubes, lo que lo hace ideal para vigilancia continua.

Apoyo a misiones de paz y ayuda humanitaria

Caso: Terremoto en Siria/Turquía (2023)

Datos abiertos (Sentinel-2, Landsat-8, PlanetScope gratuito tras catástrofe) se emplearon para:

- Detectar zonas colapsadas y evaluar daños.

- Planificar rutas de acceso seguras.

Coordinar campamentos y recursos con el apoyo de militares.

El papel de España

España ha demostrado un compromiso significativo con el desarrollo y la aplicación de la inteligencia geoespacial en defensa.

|

Centro de Satélites de la Unión Europea (SatCen) |

Proyecto Zeus del Ejército Español |

Participación en Programas Europeos | Desarrollo de capacidades nacionales |

|

Ubicado en Torrejón de Ardoz, el SatCen es una agencia de la Unión Europea que proporciona productos y servicios de inteligencia geoespacial para apoyar la toma de decisiones en materia de seguridad y defensa. España, como país anfitrión, desempeña un papel central en las operaciones del SatCen. |

El Ejército de Tierra español ha lanzado el proyecto Zeus, una iniciativa tecnológica que integra inteligencia artificial, redes 5G y datos satelitales para mejorar las capacidades operativas. Este proyecto busca crear una nube táctica de combate que permita una mayor interoperabilidad y eficacia en las operaciones militares. |

España participa activamente en programas europeos relacionados con la observación de la Tierra y la inteligencia geoespacial, como Copernicus y MUSIS. Además, colabora en iniciativas bilaterales y multilaterales para el desarrollo de capacidades satelitales y la compartición de datos. |

A nivel nacional, España ha invertido en el desarrollo de capacidades propias en inteligencia geoespacial, incluyendo la formación de personal especializado y la adquisición de tecnologías avanzadas. Estas inversiones refuerzan la autonomía estratégica del país y su capacidad para contribuir a operaciones internacionales. |

Figura 2. Tabla comparativa de la participación de España en distintos proyectos satelitales. Fuente: elaboración propia

Desafíos y oportunidades

Aunque los datos satelitales abiertos ofrecen numerosas ventajas, también presentan ciertos desafíos que deben abordarse para maximizar su utilidad en el ámbito de la defensa.

-

Calidad y resolución de los datos: si bien los datos abiertos son valiosos, a menudo tienen limitaciones en términos de resolución espacial y temporal en comparación con datos comerciales o clasificados. Esto puede afectar su aplicabilidad en ciertas operaciones que requieren información de alta precisión.

-

Integración de datos: la integración de datos de múltiples fuentes, incluyendo datos abiertos, comerciales y clasificados, requiere sistemas y procesos que garanticen la interoperabilidad y la coherencia de la información. Esto implica desafíos técnicos y organizativos que deben ser superados.

-

Seguridad y confidencialidad: el uso de datos abiertos en contextos de defensa plantea cuestiones sobre la seguridad y la confidencialidad de la información. Es esencial establecer protocolos y medidas de seguridad que protejan la información sensible y eviten su uso indebido.