Los datos son un recurso fundamental para mejorar nuestra calidad de vida porque permiten mejorar los procesos de toma de decisiones para crear productos y servicios personalizados, tanto en el sector público como en el privado. En contextos como la salud, la movilidad, la energía o la educación, el uso de datos facilita soluciones más eficientes y adaptadas a las necesidades reales de las personas. No obstante, en el trabajo con datos, la privacidad juega un papel clave. En este post, analizaremos cómo los espacios de datos, el paradigma de computación federada y el aprendizaje federado, una de sus aplicaciones más potentes, plantean una solución equilibrada para aprovechar el potencial de los datos sin poner en riesgo la privacidad. Además, resaltaremos cómo el aprendizaje federado también puede usarse con datos abiertos para mejorar su reutilización de forma colaborativa, incremental y eficiente.

La privacidad, clave en la gestión de datos

Como se ha mencionado anteriormente, el uso intensivo de datos exige una creciente atención a la privacidad. Por ejemplo, en salud digital, un mal uso secundario de datos de historias clínicas electrónicas podría vulnerar derechos fundamentales de pacientes. Una forma eficaz de preservar la privacidad es mediante ecosistemas de datos que prioricen la soberanía de los datos, como es el caso de los espacios de datos. Un espacio de datos es un sistema de gestión federada de datos que permite su intercambio de manera confiable entre proveedores y consumidores. Además, el espacio de datos garantiza la interoperabilidad de los datos para crear productos y servicios que generen valor. En un espacio de datos, cada proveedor mantiene sus propias normas de gobernanza, conservando el control sobre sus datos (es decir, la soberanía sobre sus datos), a la vez que se posibilita su reutilización por consumidores. Esto implica que cada proveedor debe poder decidir qué datos comparte, con quién y bajo qué condiciones, garantizando el cumplimiento de sus intereses y obligaciones legales.

Computación federada y espacios de datos

Los espacios de datos representan una evolución en la gestión de datos, relacionada con un paradigma denominado computación federada (federated computing), donde los datos se reutilizan sin necesidad de que haya un trasiego de datos desde los proveedores de datos hacia los consumidores. En la computación federada, los proveedores transforman sus datos en resultados intermedios que preservan la privacidad con el fin de poder ser enviados a los consumidores de datos. Además, esto posibilita que puedan aplicarse otras técnicas de mejora de la privacidad de datos (Privacy-Enhancing Technologies). La computación federada se alinea perfectamente con arquitecturas de referencia como Gaia-X y su Trust Framework, que establece los principios y requisitos para garantizar un intercambio de datos seguro, transparente y conforme a reglas comunes entre proveedores y consumidores de datos.

Aprendizaje federado

Una de las aplicaciones más potentes de la computación federada es el aprendizaje automático federado (federated learning), una técnica de inteligencia artificial que permite entrenar modelos sin necesidad de centralizar los datos. Es decir, en lugar de enviar los datos a un servidor central para procesarlos, lo que se envía son los modelos entrenados localmente por cada participante.

Estos modelos se combinan posteriormente de manera centralizada para crear un modelo global. A modo de ejemplo, imaginemos un consorcio de hospitales que quiere desarrollar un modelo predictivo para detectar una enfermedad rara. Cada hospital posee datos sensibles de sus pacientes, y compartirlos abiertamente no es viable por cuestiones de privacidad (incluso otras cuestiones legales o éticas). Con el aprendizaje federado, cada hospital entrena localmente el modelo con sus propios datos, y solo comparte los parámetros del modelo (resultados del entrenamiento) de manera centralizada. Así, el modelo final aprovecha la diversidad de datos de todos los hospitales sin comprometer la privacidad individual y las reglas de gobernanza de datos de cada hospital.

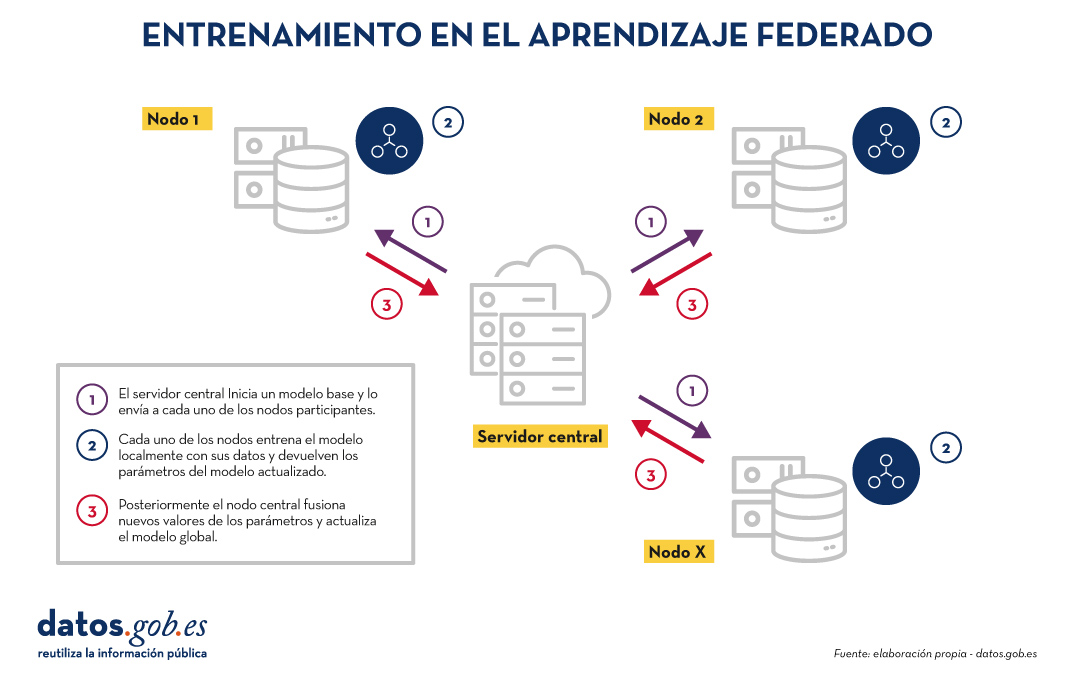

El entrenamiento en el aprendizaje federado suele seguir un ciclo iterativo:

- Un servidor central inicia un modelo base y lo envía a cada uno de los nodos distribuidos participantes.

- Cada nodo entrena el modelo localmente con sus datos.

- Los nodos devuelven solo los parámetros del modelo actualizado, no los datos (es decir, se evita el trasiego de datos).

- El servidor central agrega las actualizaciones en los parámetros, resultados del entrenamiento en cada nodo y actualiza el modelo global.

- El ciclo se repite hasta alcanzar un modelo suficientemente preciso.

Figura 1. Visual que representa el proceso de entrenamiento del aprendizaje federados. Elaboración propia

Este enfoque es compatible con diversos algoritmos de aprendizaje automático, incluyendo redes neuronales profundas, modelos de regresión, clasificadores, etc.

Beneficios y desafíos del aprendizaje federado

El aprendizaje federado ofrece múltiples beneficios al evitar el trasiego de datos. Destacamos los siguientes:

- Privacidad y cumplimiento normativo: al permanecer en su origen, se reducen significativamente los riesgos de exposición de los datos y se facilita el cumplimiento de regulaciones como el Reglamento General de Protección de Datos (RGPD).

- Soberanía de los datos: cada entidad mantiene el control total sobre sus datos, lo que evita conflictos de competitividad.

- Eficiencia: evita los costes y la complejidad de intercambiar grandes volúmenes de datos, lo que acelera los tiempos de procesamiento y desarrollo.

- Confianza: facilita la colaboración entre organizaciones sin fricciones.

Existen diversos casos de uso en los cuales el aprendizaje federado es necesario, por ejemplo:

- Salud: hospitales y centros de investigación pueden colaborar en modelos predictivos sin compartir datos de pacientes.

- Finanzas: bancos y aseguradoras pueden construir modelos de detección de fraude o análisis de riesgo compartido, respetando la confidencialidad de sus clientes.

- Turismo inteligente: los destinos turísticos pueden analizar flujos de visitantes o patrones de consumo sin necesidad de unificar las bases de datos de sus actores (tanto públicos como privados).

- Industria: empresas del mismo sector pueden entrenar modelos para mantenimiento predictivo o eficiencia operativa sin revelar datos competitivos.

Aunque sus beneficios son claros en diversidad de casos de uso, el aprendizaje federado también presenta retos técnicos y organizativos:

- Heterogeneidad de datos: los datos locales pueden tener diferentes formatos o estructuras, lo que dificulta el entrenamiento. Además, el esquema de estos datos puede cambiar con el tiempo, lo que representa una dificultad añadida.

- Datos desbalanceados: algunos nodos pueden tener más datos o de mayor calidad que otros, lo que puede sesgar el modelo global.

- Costes computacionales locales: cada nodo necesita recursos suficientes para entrenar el modelo localmente.

- Sincronización: el ciclo de entrenamiento requiere buena coordinación entre nodos para evitar latencias o errores.

Más allá del aprendizaje federado

Aunque la aplicación más destacada de la computación federada es el aprendizaje federado, están surgiendo muchas otras aplicaciones adicionales en la gestión de datos como, por ejemplo, el análisis de datos federado (federated analytics). El análisis de datos federado permite realizar análisis estadísticos y descriptivos sobre datos distribuidos sin necesidad de moverlos a los consumidores, sino que cada proveedor realiza localmente los cálculos estadísticos requeridos y solo comparte con el consumidor los resultados agregados según sus requisitos y permisos. En la siguiente tabla se muestran las diferencias entre aprendizaje federado y análisis de datos federado.

|

Criterio |

Aprendizaje federado |

Análisis de datos federado |

|

Objetivo |

Predicción y entrenamiento de modelos de aprendizaje automático. | Análisis descriptivo y cálculo de estadísticas. |

| Tipo de tarea | Tareas predictivas (por ejemplo, clasificación o regresión). | Tareas descriptivas (por ejemplo, medias o correlaciones). |

| Ejemplo | Entrenar modelos de diagnóstico de enfermedades a través de imágenes médicas procedentes de diversos hospitales. | Cálculo de indicadores sanitarios de un área de salud sin mover los datos entre hospitales. |

| Salida esperada | Modelo global entrenado. | Resultados estadísticos agregados. |

| Naturaleza | Iterativa. | Directa. |

| Complejidad computacional | Alta. | Media. |

| Algoritmos | Aprendizaje automático. | Algoritmos estadísticos. |

Figura 1. Tabla comparativa. Fuente: elaboración propia

Aprendizaje federado y datos abiertos: una simbiosis por explorar

En principio, los datos abiertos resuelven los problemas de privacidad antes de su publicación, por lo que se podría pensar que no es preciso hacer uso de técnicas de aprendizaje federado. Nada más lejos de la realidad. El uso de técnicas de aprendizaje federado puede aportar ventajas significativas en la gestión y explotación de los datos abiertos. De hecho, el primer aspecto a resaltar es que los portales de datos abiertos como datos.gob.es o data.europa.eu son entornos federados. Por ello, en estos portales, la aplicación de aprendizaje federado sobre conjuntos de datos de gran tamaño permitiría entrenar modelos directamente en origen, evitando costes de transferencia y procesamiento. Por otro lado, el aprendizaje federado facilitaría la combinación de datos abiertos con otros datos sensibles sin comprometer la privacidad de estos últimos. Finalmente, la naturaleza de una gran variedad de tipos de datos abiertos es muy dinámica (como los datos de tráfico), por lo que el aprendizaje federado habilitaría un entrenamiento incremental, considerando automáticamente nuevas actualizaciones de conjuntos de datos abiertos a medida que se publican, sin necesidad de reiniciar costosos procesos de entrenamiento.

Aprendizaje federado, base para una IA respetuosa con la privacidad

El aprendizaje automático federado representa una evolución necesaria en la forma en que desarrollamos servicios de inteligencia artificial, especialmente en contextos donde los datos son sensibles o están distribuidos entre varios proveedores. Su alineación natural con el concepto de espacio de datos lo convierte en una tecnología clave para impulsar la innovación basada en la compartición de datos, teniendo en cuenta la privacidad y manteniendo la soberanía de los datos.

A medida que la regulación (como el Reglamento relativo al Espacio Europeo de Datos de Salud) y las infraestructuras de espacios de datos evolucionen, el aprendizaje federado, y otros tipos de computación federada, jugarán un papel cada vez más importante en la compartición de datos, maximizando el valor de los datos, pero sin comprometer la privacidad. Finalmente, cabe destacar que, lejos de ser innecesario, el aprendizaje federado puede convertirse en un aliado estratégico para mejorar la eficiencia, gobernanza e impacto de los ecosistemas de datos abiertos.

Jose Norberto Mazón, Catedrático de Lenguajes y Sistemas Informáticos de la Universidad de Alicante. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

En el panorama actual del análisis de datos y la inteligencia artificial, la generación automática de informes completos y coherentes representa un desafío significativo. Mientras que las herramientas tradicionales permiten visualizar datos o generar estadísticas aisladas, existe la necesidad de sistemas que puedan investigar un tema a fondo, recopilar información de diversas fuentes, y sintetizar hallazgos en un informe estructurado y coherente.

En este ejercicio práctico, exploraremos el desarrollo de un agente de generación de reportes basado en LangGraph e inteligencia artificial. A diferencia de los enfoques tradicionales basados en plantillas o análisis estadísticos predefinidos, nuestra solución aprovecha los últimos avances en modelos de lenguaje para:

- Crear equipos virtuales de analistas especializados en diferentes aspectos de un tema.

- Realizar entrevistas simuladas para recopilar información detallada.

- Sintetizar los hallazgos en un informe coherente y bien estructurado.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

Como se muestra en la Figura 1, el flujo completo del agente sigue una secuencia lógica que va desde la generación inicial de preguntas hasta la redacción final del informe.

Figura 1. Diagrama de flujo del agente.

Arquitectura de la aplicación

El núcleo de la aplicación se basa en un diseño modular implementado como un grafo de estados interconectados, donde cada módulo representa una funcionalidad específica en el proceso de generación de reportes. Esta estructura permite un flujo de trabajo flexible, recursivo cuando es necesario, y con capacidad de intervención humana en puntos estratégicos.

Componentes principales

El sistema se compone de tres módulos fundamentales que trabajan en conjunto:

1. Generador de Analistas Virtuales

Este componente crea un equipo diverso de analistas virtuales especializados en diferentes aspectos del tema a investigar. El flujo incluye:

- Creación inicial de perfiles basados en el tema de investigación.

- Punto de retroalimentación humana que permite revisar y refinar los perfiles generados.

- Regeneración opcional de analistas incorporando sugerencias.

Este enfoque garantiza que el informe final incluya perspectivas diversas y complementarias, enriqueciendo el análisis.

2. Sistema de Entrevistas

Una vez generados los analistas, cada uno participa en un proceso de entrevista simulada que incluye:

- Generación de preguntas relevantes basadas en el perfil del analista.

- Búsqueda de información en fuentes vía Tavily Search y Wikipedia.

- Generación de respuestas informativas combinando la información obtenida.

- Decisión automática sobre continuar o finalizar la entrevista en función de la información recopilada.

- Almacenamiento de la transcripción para su procesamiento posterior.

El sistema de entrevistas representa el corazón del agente, donde se obtiene la información que nutrirá el informe final. Tal y como se muestra en la Figura 2, este proceso puede monitorizarse en tiempo real mediante LangSmith, una herramienta abierta de observabilidad que permite seguir cada paso del flujo.

Figura 2. Monitorización del sistema vía LangGraph. Ejemplo concreto de una interacción analista-entrevistador.

3. Generador de Informes

Finalmente, el sistema procesa las entrevistas para crear un informe coherente mediante:

- Redacción de secciones individuales basadas en cada entrevista.

- Creación de una introducción que presente el tema y la estructura del informe.

- Organización del contenido principal que integra todas las secciones.

- Generación de una conclusión que sintetiza los hallazgos principales.

- Consolidación de todas las fuentes utilizadas.

La Figura 3 muestra un ejemplo del informe resultante del proceso completo, demostrando la calidad y estructura del documento final generado automáticamente.

Figura 3. Vista del informe resultante del proceso de generación automática al prompt de “Datos abiertos en España”.

¿Qué puedes aprender?

Este ejercicio práctico te permite aprender:

Integración de IA avanzada en sistemas de procesamiento de información:

- Cómo comunicarse efectivamente con modelos de lenguaje.

- Técnicas para estructurar prompts que generen respuestas coherentes y útiles.

- Estrategias para simular equipos virtuales de expertos.

Desarrollo con LangGraph:

- Creación de grafos de estados para modelar flujos complejos.

- Implementación de puntos de decisión condicionales.

- Diseño de sistemas con intervención humana en puntos estratégicos.

Procesamiento paralelo con LLMs:

- Técnicas de paralelización de tareas con modelos de lenguaje.

- Coordinación de múltiples subprocesos independientes.

- Métodos de consolidación de información dispersa.

Buenas prácticas de diseño:

- Estructuración modular de sistemas complejos.

- Manejo de errores y reintentos.

- Seguimiento y depuración de flujos de trabajo mediante LangSmith.

Conclusiones y futuro

Este ejercicio demuestra el extraordinario potencial de la inteligencia artificial como puente entre los datos y los usuarios finales. A través del caso práctico desarrollado, podemos observar cómo la combinación de modelos de lenguaje avanzados con arquitecturas flexibles basadas en grafos abre nuevas posibilidades para la generación automática de informes.

La capacidad de simular equipos de expertos virtuales, realizar investigaciones paralelas y sintetizar hallazgos en documentos coherentes, representa un paso significativo hacia la democratización del análisis de información compleja.

Para aquellas personas interesadas en expandir las capacidades del sistema, existen múltiples direcciones prometedoras para su evolución:

- Incorporación de mecanismos de verificación automática de datos para garantizar la precisión.

- Implementación de capacidades multimodales que permitan incorporar imágenes y visualizaciones.

- Integración con más fuentes de información y bases de conocimiento.

- Desarrollo de interfaces de usuario más intuitivas para la intervención humana.

- Expansión a dominios especializados como medicina, derecho o ciencias.

En resumen, este ejercicio no solo demuestra la viabilidad de automatizar la generación de informes complejos mediante inteligencia artificial, sino que también señala un camino prometedor hacia un futuro donde el análisis profundo de cualquier tema esté al alcance de todos, independientemente de su nivel de experiencia técnica. La combinación de modelos de lenguaje avanzados, arquitecturas de grafos y técnicas de paralelización abre un abanico de posibilidades para transformar la forma en que generamos y consumimos información.

La evolución de la IA generativa está siendo vertiginosa: desde los primeros grandes modelos del lenguaje que nos impresionaron con su capacidad para reproducir la lecto-escritura de los humanos, pasando por las avanzadas técnicas de RAG (Retrieval-Augmented Generation) que mejoraron cuantitativamente la calidad de las respuestas proporcionadas y la aparición de agentes inteligentes, hasta llegar a una innovación que redefine nuestra relación con la tecnología: Computer use.

A finales del mes de abril del año 2020, tan solo un mes después de que comenzara un periodo inédito de confinamiento domiciliario de alcance mundial debido a la pandemia mundial del SAR-Covid19, difundíamos desde datos.gob.es los grandes modelos del lenguaje GPT-2 y GPT-3. OpenAI, fundada en 2015, había presentado prácticamente un año antes (febrero del 2019) un nuevo modelo del lenguaje que era capaz de generar texto escrito prácticamente indistinguible del creado por un humano. GPT-2 se había entrenado con un corpus (conjunto de textos preparados para entrenar modelos del lenguaje) de unos 40 GB (Gigabytes) de tamaño (unos 8 millones de páginas web), mientras que la última familia de modelos basados en GPT-4 se estima que han sido entrenados con corpus del tamaño de TB (Terabytes); mil veces más.

En este contexto, es importante hablar de dos conceptos:

- LLM (Large Language Models): son modelos de lenguaje de gran escala, entrenados con vastas cantidades de datos y capaces de realizar una amplia gama de tareas lingüísticas. Hoy, disponemos de incontables herramientas basadas en estos LLM que, por campos de especialidad, son capaces de generar código de programación, imágenes y videos ultra-realistas y resolver problemas matemáticos complejos. Todas las grandes empresas y organizaciones del sector tecnológico-digital se han lanzado a integrar estas herramientas en sus diferentes productos de software y hardware, desarrollando casos de uso que resuelven u optimizan tareas y actividades concretas que previamente tenían alta intervención humana.

- Agentes: la experiencia de uso con los modelos de inteligencia artificial cada vez es más completa, de forma que le podemos pedir a nuestra interfaz no sólo respuestas a nuestras preguntas, sino también que realice tareas complejas que requieren integración con otras herramientas informáticas. Por ejemplo, no solo le preguntamos a un chatbot información sobre los mejores restaurantes de la zona, sino que le pedimos que busque disponibilidad de mesa para unas fechas concretas y realice una reserva por nosotros. Esta experiencia de uso extendida es lo que nos proporcionan los agentes de inteligencia artificial. Basados en los grandes modelos del lenguaje, estos agentes son capaces de interaccionar con el mundo exterior (al modelo) y “hablar” con otros servicios mediante API e interfaces de programación preparadas para tal fin.

Computer use

Sin embargo, la capacidad de los agentes para realizar acciones de forma autónoma depende de dos elementos clave: por un lado, su programación concreta -la funcionalidad que se les haya programado o configurado-; por otro lado, la necesidad de que el resto de programas estén preparados para “hablar” con estos agentes. Es decir, sus interfaces de programación han de estar listas para recibir instrucciones de estos agentes. Por ejemplo, la aplicación de reservas del restaurante ha de estar preparada, no solo para recepcionar formularios rellenados por un humano, sino también, peticiones realizadas por un agente que previamente ha sido invocado por un humano mediante lenguaje natural. Este hecho impone una limitación sobre el conjunto de actividades y/o tareas que podemos automatizar desde un interfaz conversacional. Es decir, el interfaz conversacional puede proporcionarnos respuestas casi infinitas a las cuestiones que le planteemos, pero encuentra grandes limitaciones para interactuar con el mundo exterior debido a la falta de preparación del resto de aplicaciones informáticas.

Aquí es donde entra Computer use. Con la llegada del modelo Claude 3.5 Sonnet, la empresa Anthropic ha introducido Computer use, una capacidad en fase beta que permite a la IA interactuar directamente con interfaces gráficas de usuario.

¿Cómo funciona Computer use?

Claude puede mover el cursor de tu ordenador como si fueras tú, hacer clic en botones y escribir texto, emulando la forma en que los humanos operamos con un ordenador. La mejor forma de entender cómo funciona Computer use en la práctica es viéndolo en acción. Aquí os dejamos un link directo al canal de YouTube de la sección específica de Computer use.

Figura 1. Captura del canal de YouTube de Anthropic, sección específica de Computer use.

¿Te animas a probarlo?

Si has llegado hasta aquí, no te puedes quedar sin probarlo con tus propias manos.

A continuación, te proponemos una sencilla guía para poder probar Computer use en un entorno aislado. Es importante tener en cuenta las recomendaciones de seguridad que Antrophic propone en sus guías de Computer use. Esta característica del modelo Claude Sonet puede realizar acciones sobre un ordenador y esto puede ser potencialmente peligroso, por lo que se recomienda revisar cuidadosamente la advertencia de seguridad de Computer use.

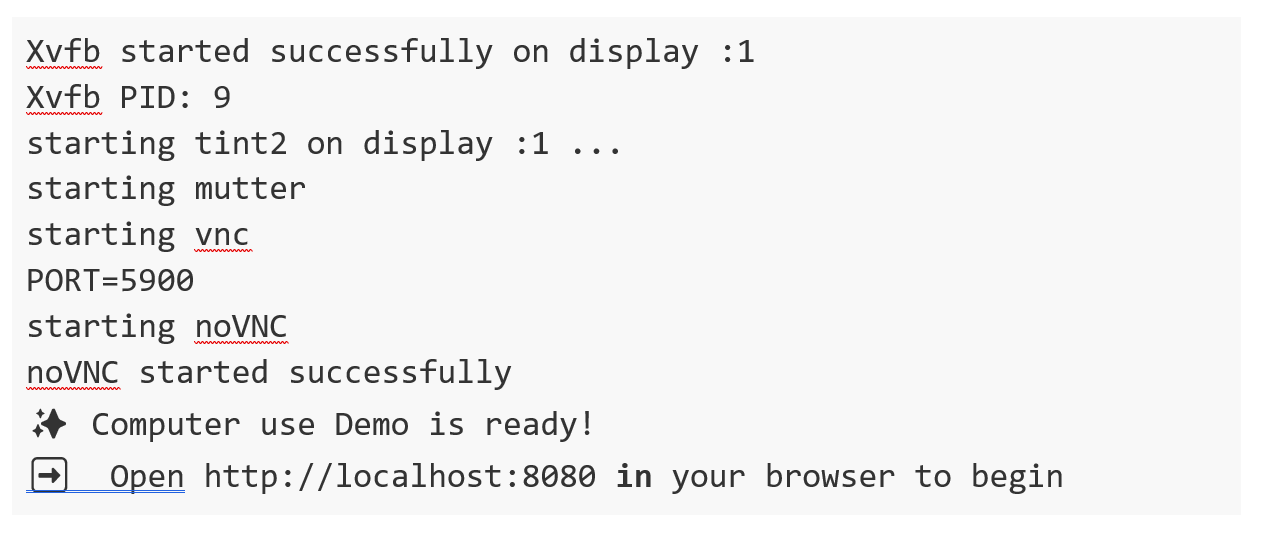

Toda la documentación oficial para desarrolladores se encuentra en el repositorio oficial de Github de Antrophic. En este post, nosotros hemos optado por ejecutar Computer use en un entorno de un contenedor de Docker. Es la forma más sencilla y segura de probarlo. Si no lo tienes ya, puedes seguir las sencillas guías oficiales para pre-instalarlo en tu sistema.

Para reproducir esta prueba os proponemos seguir este guion paso a paso:

- Antropic API Key. Para interactuar con Claude Sonet necesitas una cuenta de Antropic que puedes crear gratuitamente aquí. Una vez dentro, puedes ir a la sección de API Keys y crear una nueva para tu prueba

- Una vez tengas tu API Key, deberás de ejecutar este comando en tu terminal, sustituyendo tu clave donde indica “%your_api_key%”:

3. Si todo ha ido bien, verás estos mensajes en tu terminal y ya solo te queda abrir tu navegador y escribir esta url en la barra de navegación: http://localhost:8080/

Verás que se abre tu interfaz:

Figura 2. Interfaz de Computer use.

Ya puedes emplazar a explorar cómo funciona Computer use. Te sugerimos el siguiente prompt para empezar:

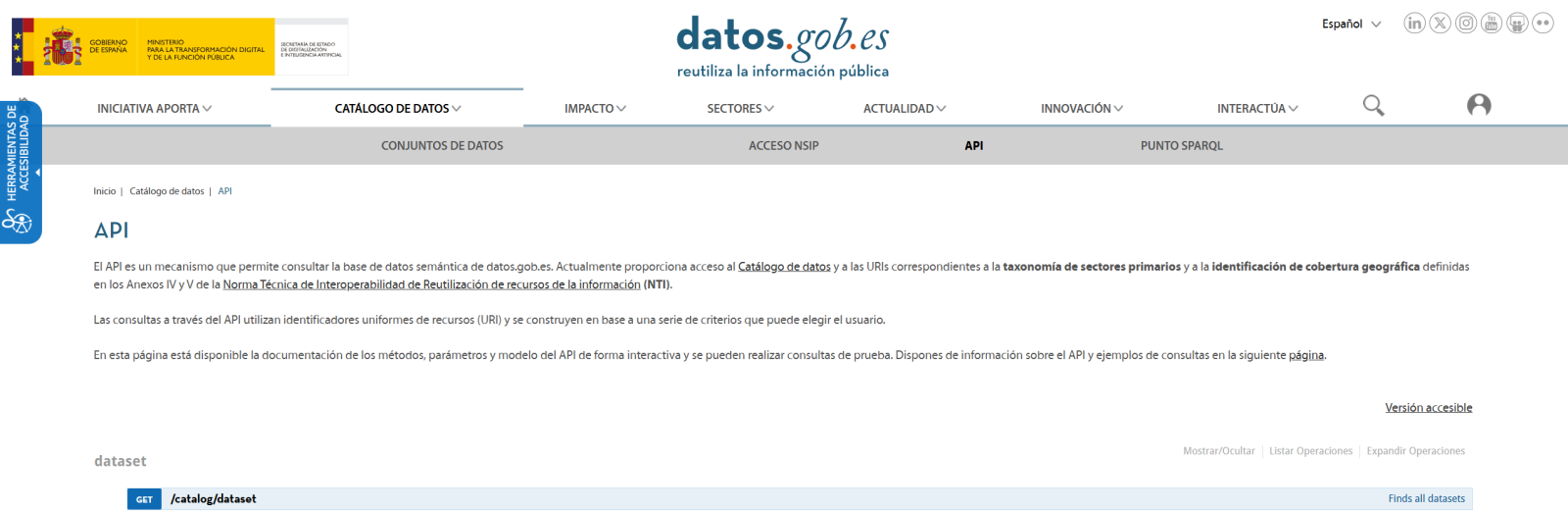

Te proponemos que empieces poco a poco. Por ejemplo, pídele que abra un navegador y busque algo. También puedes pedirle que te de información sobre tu ordenador o sistema operativo. Poco a poco, puedes ir pidiendo tareas más complejas. Nosotros hemos probado este prompt y tras varias pruebas hemos conseguido que Computer use realice la tarea completa.

Abre un navegador, navega hasta el catálogo de datos.gob.es, usa el buscador para localizar un conjunto de datos sobre: Seguridad ciudadana. Siniestralidad Tráfico. 2014; Localiza el fichero en formato csv; descárgalo y ábrelo con libre Office.

Potenciales usos en plataformas de datos como datos.gob.es

A la vista de esta primera versión experimental de Computer use parece que el potencial de la herramienta es muy alto. Podemos imaginar cuantas más cosas podemos hacer gracias a esta herramienta. Aquí os dejamos algunas ideas:

- Podríamos pedirle al sistema que realice una búsqueda completa de datasets relacionados con una temática concreta y que hiciera un resumen en un documento de los principales resultados. De esta manera, si por ejemplo escribimos un artículo sobre datos del tráfico en España, podríamos obtener de forma desatendida un listado con los principales datasets abiertos de datos de tráfico en España en el catálogo de datos.gob.es.

- De la misma forma, podríamos solicitar un resumen igual, pero en este caso, no de dataset, sino de artículos de la plataforma.

- Un ejemplo un poco más sofisticado sería pedirle a Claude, mediante el interfaz conversacional de Computer use que nos haga una serie de llamadas a la API de datos.gob.es para obtener información de ciertos datasets de forma programática. Para ello, abrimos un navegador y nos logueamos en una aplicación como Postman (recordemos en este punto que Computer use está en modo experimental y no nos permite introducir datos sensibles como credenciales de usuario en páginas web). A continuación le podemos pedimos que busque información sobre la API de datos.gob.es y ejecute una llamada http aprovechando que dicha API no requiere autenticación.

A través de estos sencillos ejemplos, esperamos haberte presentado una nueva aplicación de la IA generativa y que hayas entendido el cambio de paradigma que supone esta nueva capacidad. Si la máquina es capaz de emular el uso de un ordenador como lo hacemos los humanos, se abren nuevas oportunidades inimaginables para los próximos meses.

Contenido elaborado por Alejandro Alija, experto en Transformación Digital e Innovación. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su auto

La enorme aceleración de la innovación en torno a la inteligencia artificial (IA) en estos últimos años gira, en gran medida, en torno al desarrollo de los llamados “modelos fundacionales”. También conocidos como modelos grandes (Large [X] Models o LxM), Los modelos fundacionales, según la definición del Center for Research on Foundation Models (CRFM) del Institute for Human-Centered Artificial Intelligence's (HAI) de la Universidad de Stanford son modelos que han sido entrenados con conjuntos de datos de gran tamaño y gran diversidad y que pueden adaptarse a realizar una amplia gama de tareas mediante técnicas como el ajuste fino (fine-tuning).

Precisamente es esta versatilidad y capacidad de adaptación lo que ha convertido a los modelos fundacionales en la piedra angular de las numerosas aplicaciones de la inteligencia artificial que están desarrollándose, ya que una única arquitectura base puede utilizarse en multitud de casos de uso con un esfuerzo adicional limitado.

Tipos de modelos fundacionales

La "X" en LxM puede sustituirse por varias opciones según el tipo de datos o tareas para las que el modelo está especializado. Los más conocidos por el público son los LLM (Large Language Models), que están en la base de aplicaciones como ChatGPT o Gemini, y que se centran en la comprensión y generación de lenguaje natural. Por su parte, los LVM (Large Vision Models), como DINOv2 o CLIP, están diseñados para interpretar imágenes y vídeos, reconocer objetos o generar descripciones visuales. También existen modelos como como Operator o Rabbit R1 que se encuentran en la categoría de LAM (Large Action Models) y que están orientados a ejecutar acciones a partir de instrucciones complejas.

A medida que han ido surgiendo regulaciones en distintas partes del mundo, también han aparecido otras definiciones que buscan establecer criterios y responsabilidades sobre estos modelos para fomentar la confianza y la seguridad. La definición más relevante para nuestro contexto es la establecida en el Reglamento de IA de la Unión Europea (AI Act), el cual los denomina “modelos de IA de uso general” y los distingue por su “capacidad de realizar de manera competente una amplia variedad de tareas diferenciadas” y porque “suelen entrenarse usando grandes volúmenes de datos y a través de diversos métodos, como el aprendizaje autosupervisado, no supervisado o por refuerzo”.

Modelos fundacionales en español y otras lenguas cooficiales

Históricamente, el inglés ha sido el idioma dominante en el desarrollo de los grandes modelos de IA, hasta el punto de que en torno al 90% de los tokens de entrenamiento de los grandes modelos actuales se han extraído de textos en inglés. Por ello resulta lógico que los modelos más conocidos, por ejemplo la familia GPT de OpenAI, Gemini de Google o Llama de Meta, sean más competentes respondiendo en inglés y presenten menor desempeño al usarlos en otros idiomas como el español.

Por tanto, la creación de modelos fundacionales en español, como ALIA, no es un simple ejercicio técnico o de investigación, sino que se trata de un movimiento estratégico para garantizar que la inteligencia artificial no haga aún más profundas las asimetrías lingüísticas y culturales que ya existen en las tecnologías digitales en general. El desarrollo de ALIA, impulsado por la Estrategia de Inteligencia Artificial 2024 de España, “partiendo del amplio alcance de nuestras lenguas, habladas por 600 millones de personas, tiene como objetivo facilitar el desarrollo de servicios y productos avanzados en tecnologías del lenguaje, ofreciendo una infraestructura marcada por la máxima transparencia y apertura”.

Este tipo de iniciativas no son exclusivas de España. Otros proyectos similares incluyen BLOOM, un modelo multilingüe de 176 mil millones de parámetros desarrollado por más de 1.000 investigadores de todo el mundo y que soporta 46 lenguas naturales y 13 lenguajes de programación. En China, Baidu ha desarrollado ERNIE, un modelo con fuerte capacidad en mandarín, mientras que en Francia el modelo PAGNOL se ha centrado en mejorar las capacidades en francés. Estos esfuerzos paralelos muestran una tendencia global hacia la "democratización lingüística" de la IA.

Desde principios de 2025, están disponibles los primeros modelos de lenguaje en las cuatro lenguas cooficiales, dentro del proyecto ALIA. En la familia de modelos ALIA destaca ALIA-40B, un modelo con 40.000 millones de parámetros, que es por el momento el modelo fundacional multilingüe público más avanzado de Europa y que fue entrenado durante más de 8 meses en el supercomputador MareNostrum 5, procesando 6,9 billones de tokens que equivaldrían a unos 33 terabytes de texto (¡unos 17 millones de libros!). Aquí se incluyen todo tipo de documentos oficiales y repositorios científicos en español, desde los diarios de sesiones del Congreso hasta repositorios científicos o boletines oficiales para asegurar la riqueza y calidad de su conocimiento.

Aunque se trata de un modelo multilingüe, el español y lenguas cooficiales tienen un peso muy superior al habitual en estos modelos, en torno al 20%, ya que el entrenamiento del modelo se diseñó específicamente para estas lenguas, reduciendo la relevancia del inglés y adaptando los tokens a las necesidades del español, catalán, euskera y gallego. Gracias a ello, ALIA “entiende” mejor nuestras expresiones locales y matices culturales que un modelo genérico entrenado mayoritariamente en inglés.

Aplicaciones de los modelos fundacionales en español y lenguas cooficiales

Aún es muy pronto para juzgar el impacto en sectores y aplicaciones concretas que puedan tener ALIA y otros modelos que puedan desarrollarse a partir de esta experiencia. Sin embargo, se espera que sirvan de base para mejorar multitud de aplicaciones y soluciones de Inteligencia Artificial:

- Administración pública y gobierno: ALIA podría dar vida a asistentes virtuales que atiendan a la ciudadanía las 24 horas en trámites como pagar impuestos, renovar el DNI, solicitar becas, etc. ya que está entrenado específicamente con la normativa española. De hecho, ya se anunció un piloto para la Agencia Tributaria usando ALIA, que tendría como objetivo agilizar gestiones internas.

- Educación: un modelo como ALIA podría ser también la base de tutores virtuales personalizados que orienten a estudiantes en español y lenguas cooficiales. Por ejemplo, asistentes que expliquen conceptos de matemáticas o historia en lenguaje sencillo y respondan preguntas del alumnado, adaptándose a su nivel ya que, al conocer bien nuestra lengua, serían capaces de aportar matices importantes en las respuestas y entender las dudas típicas de hablantes nativos en estos idiomas. También podrían ayudar a profesores, generando ejercicios o resúmenes de lecturas o asistiéndoles en la corrección de los trabajos de los alumnos.

- Salud: ALIA podría servir para analizar textos médicos y ayudar a profesionales de la salud con informes clínicos, historiales, folletos informativos, etc. Por ejemplo, podría revisar expedientes de pacientes para extraer elementos clave, o asistir a los profesionales en el proceso de diagnóstico. De hecho, el Ministerio de Sanidad planea una aplicación piloto con ALIA para mejorar la detección temprana de insuficiencias cardíacas en atención primaria.

- Justicia: en el ámbito jurídico, ALIA entendería términos técnicos y contextos del derecho español mucho mejor que un modelo no especializado ya que ha sido entrenada con vocabulario legal de documentos oficiales. Un asistente legal virtual basado en ALIA podría ser capaz de contestar consultas básicas del ciudadano como, por ejemplo, cómo iniciar un determinado trámite legal, citando la normativa aplicable. La administración de justicia podría beneficiarse también con unas traducciones automáticas de documentos judiciales entre lenguas cooficiales mucho más precisas.

Líneas futuras

El desarrollo de modelos fundaciones en español, al igual que en otros idiomas, comienza a considerarse fuera de Estados Unidos como una cuestión estratégica que contribuye a garantizar la soberanía tecnológica de los países. Por supuesto, será necesario seguir entrenando versiones más avanzadas (se apunta a modelos de hasta 175 mil millones de parámetros, que serían equiparables a los más potentes del mundo), incorporando nuevos datos abiertos, y afinando las aplicaciones. Desde la Dirección del Dato y la SEDIA se pretende continuar apoyando el crecimiento de esta familia de modelos, para mantenerla en vanguardia y asegurar su adopción.

Por otra parte, estos primeros modelos fundacionales en español y lenguas cooficiales se han centrado inicialmente en el lenguaje escrito, así que la siguiente frontera natural podría estar en la multimodalidad. Integrar la capacidad de gestionar imágenes, audio o vídeo en español junto con el texto multiplicaría sus aplicaciones prácticas ya que en la interpretación de imágenes en español es uno de los ámbitos donde se detectan mayores deficiencias en los grandes modelos genéricos.

También habrá que vigilar los aspectos éticos para asegurarse que estos modelos no perpetúen sesgos y sean útiles para todos los colectivos, incluyendo aquellos que hablan en distintas lenguas o que tienen diferentes niveles educativos. En este aspecto la Inteligencia Artificial Explicable (XAI) no es algo opcional, sino un requisito fundamental para garantizar su adopción responsable. La Agencia Nacional de Supervisión de la IA, la comunidad investigadora y la propia sociedad civil tendrán aquí un rol importante.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La Dirección General de Tráfico (DGT) es el organismo responsable de garantizar la seguridad y fluidez en las vías de circulación de España. Entre otras actividades, se encarga de la expedición de permisos, el control del tráfico y la gestión de infracciones.

Fruto de su actividad, se genera una gran cantidad de datos, muchos de los cuales se ponen a disposición de la ciudadanía como datos abiertos. Estos datasets no solo promueven la transparencia, sino que también son una herramienta para fomentar la innovación y mejorar la seguridad vial a través de su reutilización por parte de investigadores, empresas, administraciones públicas y ciudadanos interesados.

En este artículo vamos a repasar algunos de estos conjuntos de datos, incluyendo ejemplos de aplicación.

Cómo acceder a los datasets de la DGT

Los conjuntos de datos de la DGT ofrecen información detallada y estructurada sobre diversos aspectos de la seguridad vial y la movilidad en España, incluyendo desde estadísticas de accidentes hasta información sobre vehículos y conductores. La continuidad temporal de estos conjuntos de datos, disponibles desde principios de siglo hasta la actualidad, posibilita análisis longitudinales que reflejan la evolución de los patrones de movilidad y seguridad vial en España.

Los usuarios pueden acceder a los conjuntos de datos en diferentes espacios:

- DGT en cifras. Es una sección de la Dirección General de Tráfico que ofrece un acceso centralizado a estadísticas y datos clave relacionados con la seguridad vial, los vehículos y los conductores en España. Este portal incluye información detallada sobre siniestralidad, denuncias, parque vehicular y características técnicas de los vehículos, entre otros temas. Además, proporciona análisis históricos y comparativos que permiten evaluar tendencias y diseñar estrategias para mejorar la seguridad en las carreteras.

- Punto de Acceso Nacional de Tráfico y Movilidad (National Access Point o NAP). Gestionado por la DGT, es una plataforma diseñada para centralizar y facilitar el acceso a datos viarios y de tráfico, incluidas sus actualizaciones. Este portal ha sido creado bajo el marco de la Directiva Europea 2010/40/UE y reúne información proporcionada por diversas entidades de gestión del tráfico, autoridades viarias y operadores de infraestructuras. Entre los datos disponibles se incluyen incidencias de tráfico, puntos de recarga para vehículos eléctricos, zonas de bajas emisiones y ocupación de parkings, entre otros. Su objetivo es promover la interoperabilidad y el desarrollo de soluciones inteligentes que mejoren la seguridad vial y la eficiencia en el transporte.

Mientras el NAP está enfocado en datos en tiempo real y soluciones tecnológicas, DGT en cifras se centra en proporcionar estadísticas e información histórica para análisis y toma de decisiones. Además, el NAP reúne datos no solo de la DGT, sino también de otros organismos y empresas privadas.

La mayoría de estos datos están disponibles a través de datos.gob.es.

Ejemplos de conjuntos de datos de la DGT

Algunos ejemplos de dataset que se pueden encontrar en datos.gob.es son:

- Accidentes con víctimas: incluye información detallada sobre víctimas mortales, heridos hospitalizados y leves, así como las circunstancias por tipo de vía. Estos datos ayudan a entender por qué ocurren los accidentes y quiénes están involucrados, permiten identificar situaciones de riesgo y detectar comportamientos peligrosos en la carretera. Es útil para crear mejores campañas de prevención, detectar puntos negros en las carreteras y ayudar a las autoridades a tomar decisiones más informadas. También resultan de interés para profesionales de salud pública, urbanistas y compañías de seguros que trabajan para reducir los accidentes y sus consecuencias.

- Censo de conductores: ofrece una radiografía completa de quiénes tienen permiso para conducir en España. La información resulta especialmente útil para entender la evolución del parque de conductores, identificar tendencias demográficas y analizar la penetración de los diferentes tipos de permisos por territorio y género.

- Matriculaciones de turismos por marca y cilindrada: muestra qué coches nuevos compraron los españoles, organizados por marca y potencia del motor. La información permite identificar tendencias de consumo. Estos datos son valiosos para fabricantes, concesionarios y analistas del sector automovilístico, que pueden estudiar el comportamiento del mercado en un año concreto. También resultan útiles para investigadores en movilidad, medio ambiente y economía, permitiendo analizar la evolución del parque móvil español y su impacto en términos de emisiones, consumo energético y tendencias de mercado.

Casos de uso de los datasets de la DGT

La publicación de estos datos en formato abierto permite potenciar la innovación en áreas como la prevención de accidentes, el desarrollo de infraestructuras viales más seguras, la elaboración de políticas públicas basadas en evidencia, y la creación de aplicaciones tecnológicas relacionadas con la movilidad. A continuación, se recogen algunos ejemplos:

Uso de datos por la propia DGT

La propia DGT reutiliza sus datos para crear herramientas que faciliten la visualización de la información y la acerquen de forma sencilla a la ciudadanía. Es el caso del Mapa de estado del tráfico e incidencias, que se actualiza de forma constante y automática con la información introducida 24 horas al día por la Agrupación de Tráfico de la Guardia Civil y los responsables de los Centros de Gestión de Tráfico de la DGT, la Generalitat de Catalunya y el Gobierno Vasco. Incluye información sobre las carreteras afectadas por fenómenos meteorológicos (como hielo, inundaciones, etc.) y la previsión de evolución.

Además, la DGT también aprovecha sus datos para realizar estudios que proporcionen información sobre determinados aspectos relacionados con la movilidad y la seguridad vial, de gran utilidad para la toma de decisiones y elaboración de políticas. Un ejemplo, es este estudio que analizar el comportamiento y la actividad de determinados colectivos en accidentes de tráfico para plantear medidas de manera proactiva. Otro ejemplo: este proyecto para implementar un sistema informático que identifique, mediante geolocalización, los puntos críticos de mayor siniestralidad en carreteras para su tratamiento y traslado de conclusiones.

Uso de los datos por parte de terceros

Los conjuntos de datos ofrecidos por la DGT también son reutilizados por otras administraciones públicas, investigadores, emprendedores y empresas privadas, fomentando la innovación en este campo. Gracias a ellos, encontramos apps que permiten a los usuarios acceder a información detallada sobre vehículos en España (como características técnicas e historial de inspecciones) o que informan sobre los lugares más peligrosos para los ciclistas.

Además, su combinación con tecnologías avanzadas como la inteligencia artificial permite extraer aún más valor de los datos, facilitando la identificación de patrones y ayudando a ciudadanos y autoridades a tomar medidas preventivas. Un ejemplo es la aplicación Waze, que ha implementado una funcionalidad basada en inteligencia artificial para identificar y alertar a los conductores sobre tramos de alta siniestralidad en las carreteras, es decir, los conocidos como "puntos negros". Este sistema combina datos históricos de accidentes con análisis de características de las vías, como desniveles, densidad de tráfico e intersecciones, para ofrecer alertas precisas y de alta utilidad. La aplicación notifica a los usuarios con antelación cuando se aproximan a estas zonas peligrosas, con el objetivo de reducir riesgos y mejorar la seguridad vial. Esta innovación complementa los datos proporcionados por la Dirección General de Tráfico ayudando a salvar vidas al fomentar una conducción más precavida.

Para aquellos que quieran animarse y practicar con los datos de la DGT, desde datos.gob.es tenemos a disposición de los usuarios un ejercicio paso a paso de ciencia de datos. Los usuarios podrán analizar estos conjuntos de datos y utilizar modelos predictivos que permiten realizar estimaciones respecto a la evolución del vehículo eléctrico en España. Para ello se utilizan desarrollos de código documentados y herramientas de uso gratuito. Todo el material generado está disponible para su reutilización en el repositorio de GitHub de datos.gob.es.

En resumen, los conjuntos de datos que la DGT ofrecen grandes oportunidades de reutilización, más aún si se combinan con tecnologías disruptivas. Gracias a ello se impulsa la innovación, la sostenibilidad y un transporte más seguro y conectado, que está ayudando a transformar la movilidad urbana y rural.

Un año más, la Comisión Europea organizó los EU Open Data Days, uno de los eventos de referencia sobre datos abiertos e innovación a nivel mundial. Los pasados días 19 y 20 de marzo, el Centro Europeo de Convenciones de Luxemburgo reunió a expertos, funcionarios públicos y representantes del ámbito académico para compartir conocimientos, experiencias y avances en materia de datos abiertos en Europa.

Durante estas dos intensas jornadas, que también pudieron seguirse online, se exploraron temas cruciales como la gobernanza, la calidad, la interoperabilidad y el impacto de la inteligencia artificial (IA) en los datos abiertos. Este evento se ha convertido en un foro esencial para impulsar el desarrollo de políticas y prácticas que fomenten la transparencia y la innovación basada en datos en toda la Unión Europea. En este post, repasamos cada una de las ponencias del evento.

Apertura e historia de los datos

Para empezar, la Directora General de la Oficina de Publicaciones de la Unión Europea, Hilde Hardeman, inauguró el evento dando la bienvenida a los asistentes y estableciendo el tono para las discusiones que seguirían. A continuación, Helena Korjonen y Emma Schymanski, dos expertas de la Universidad de Luxemburgo, presentaron una retrospectiva titulada "Un viaje de datos: de la oscuridad a la iluminación", donde exploraron la evolución del almacenamiento y compartición de datos a lo largo de 18.000 años. Desde las pinturas rupestres hasta los servidores modernos, este recorrido histórico destacó cómo muchos de los desafíos actuales en materia de datos abiertos, como la propiedad, la preservación y la accesibilidad, tienen raíces profundas en la historia de la humanidad.

A continuación, Slava Jankin, profesor del Centro de IA en Gobierno de la Universidad de Birmingham, presentó una ponencia sobre gemelos digitales impulsados por IA y datos abiertos para crear simulaciones dinámicas de sistemas de gobernanza, que permiten a los responsables políticos probar reformas y predecir resultados antes de implementarlos.

Casos de uso entre los datos abiertos y la IA

Por otro lado, también se presentaron varios casos de uso, como la experiencia práctica de Lituania en la catalogación exhaustiva de datos públicos. Milda Aksamitauskas de la Universidad de Wisconsin, abordó los desafíos de gobernanza y las estrategias de comunicación empleadas en el proyecto y presentó lecciones sobre cómo otros países podrían adaptar métodos similares para mejorar la transparencia y la toma de decisiones basadas en datos.

En relación, el coordinador científico Bastiaan van Loenen presentó las conclusiones del proyecto en el que trabaja, ODECO de Horizon 2020, centrado en la creación de ecosistemas sostenibles de datos abiertos. Tal y como explicó van Loenen, la investigación, que ha sido desarrollada durante cuatro años por 15 investigadores, ha explorado las necesidades de los usuarios y las estructuras de gobernanza para siete grupos distintos, destacando cómo los enfoques circulares, inclusivos y basados en habilidades pueden proporcionar valor económico y social a los ecosistemas de datos abiertos.

Además, la inteligencia artificial fue protagonista durante todo el evento. La profesora asistente Anastasija Nikiforova de la Universidad de Tartu ofreció una visión reveladora sobre cómo la inteligencia artificial puede transformar los ecosistemas de datos abiertos gubernamentales. En su presentación, "Datos para IA o IA para datos" exploró ocho roles distintos que la IA puede desempeñar. Por ejemplo, la IA puede servir de ‘limpiador’ de un portal de open data e incluso recuperar datos del ecosistema, proporcionando valiosas perspectivas para los responsables políticos y los investigadores sobre cómo aprovechar eficazmente la IA en las iniciativas de datos abiertos.

También utilizando herramientas impulsadas por IA, encontramos el EU Open Research Repository lanzado por Zenodo en 2024, una iniciativa de ciencia abierta que proporciona un repositorio de investigación adaptado para los beneficiarios de financiación de investigación de la UE. La presentación de Lars Holm Nielsen destacó cómo las herramientas impulsadas por IA y los conjuntos de datos abiertos de alta calidad reducen el coste y el esfuerzo de limpieza de datos, al tiempo que garantizan la adherencia a los principios FAIR.

La jornada continuó con la intervención de Maroš Šefčovič, Comisario Europeo de Comercio y Seguridad Económica, Relaciones Interinstitucionales y Transparencia, quien subrayó el compromiso de la Comisión Europea con los datos abiertos como pilar fundamental para la transparencia y la innovación en la Unión Europea.

Interoperabilidad y calidad de datos

Después de una pausa, Georges Lobo y Pavlina Fragkou coordinador de programa y de proyecto del SEMIC, respectivamente, explicaron cómo el Centro de Interoperabilidad Semántica de Europa (SEMIC) mejora el intercambio interoperable de datos en Europa a través del perfil de aplicación del vocabulario de catálogo de datos (DCAT-AP) y las secuencias de eventos de datos vinculados (LDES). Su presentación destacó cómo estos estándares facilitan la publicación y el consumo eficientes de datos, con casos prácticos como el Rijksmuseum y la Agencia Ferroviaria de la Unión Europea, demostrando su valor para fomentar ecosistemas de datos interoperables y sostenibles.

A continuación, Barbara Šlibar, de la Universidad de Zagreb, ofreció un análisis detallado de la calidad de los metadatos en los conjuntos de datos abiertos europeos, revelando disparidades significativas en cinco dimensiones clave. Su estudio, basado en muestras aleatorias de data.europa.eu, subrayó la importancia de mejorar las prácticas de metadatos y aumentar la concienciación entre las partes interesadas para mejorar la usabilidad y el valor de los datos abiertos en Europa.

Después, Bianca Sammer, de Bavarian Agency for Digital Affairs compartió su experiencia creando el portal de datos abiertos de Alemania en solo un año. Su presentación "Desbloqueando el potencial" destacó soluciones innovadoras para superar los desafíos en la gestión de datos abiertos. Por ejemplo, consiguieron una mejora automatizada de la calidad de los metadatos, una infraestructura de código abierto reutilizable y estrategias de participación para administraciones públicas y usuarios.

Actualidad y horizonte respecto a los datos abiertos

El segundo día comenzó con las intervenciones de Rafał Rosiński, Subsecretario de Estado del Ministerio de Asuntos Digitales de Polonia, quien presentó la perspectiva de la Presidencia polaca sobre datos abiertos y transformación digital, y Roberto Viola, Director General de la Dirección General de Redes de Comunicación, Contenido y Tecnología de la Comisión Europea, que habló sobre el camino europeo hacia la innovación digital.

Después de la presentación de la jornada, empezaron las ponencias sobre casos de uso y propuestas innovadoras en open data. En primer lugar, Stefaan Verhulst, cofundador del laboratorio de gobernanza neoyorquino GovLab, bautizó al momento histórico que estamos viviendo como la "cuarta ola de datos abiertos" caracterizada por la integración de la inteligencia artificial generativa con datos abiertos para abordar desafíos sociales. Su presentación planteó preguntas cruciales sobre cómo las interfaces conversacionales basadas en IA pueden mejorar la accesibilidad, qué significa que los datos abiertos estén "preparados para la IA" y cómo construir soluciones basadas en datos sostenibles que equilibren la apertura y la confianza.

A continuación, Christos Ellinides, Director General de Traducción de la Comisión Europea, destacó la importancia de los datos lingüísticos para la IA en el continente. Con 25 años de datos que abarcan múltiples idiomas y la experiencia para desarrollar servicios multilingües basados en inteligencia artificial, la Comisión está a la vanguardia en el ámbito de los espacios de datos lingüísticos y en el uso de infraestructuras europeas de computación de alto rendimiento para explotar datos e IA.

Casos de uso de reutilización de datos abiertos

La reutilización aporta múltiples beneficios. Kjersti Steien, de la agencia de digitalización noruega, presentó el portal nacional de datos de Noruega, data.norge.no, que emplea un motor de búsqueda impulsado por IA para mejorar la capacidad de descubrimiento de datos. Utilizando Google Vertex, el motor permite a los usuarios encontrar conjuntos de datos relevantes sin necesidad de conocer los términos exactos utilizados por los proveedores de datos, demostrando cómo la IA puede mejorar la reutilización de datos y adaptarse a los modelos de lenguaje emergentes.

Más allá de Noruega, también se pusieron en la mesa casos de uso de otras ciudades y países. Sam Hawkins, Director del programa de datos de Ember en el Reino Unido, subrayó la importancia de los datos energéticos abiertos para avanzar en la transición hacia energías limpias y garantizar la flexibilidad del sistema.

Otro caso fue el que presentó Marika Eik de la Universidad de Estonia, que aprovecha datos urbanos y la colaboración intersectorial para mejorar la sostenibilidad y el impacto comunitario. Su sesión examinó un enfoque a nivel de ciudad para las métricas de sostenibilidad y los cálculos de huella de CO2, basándose en datos de municipios, operadores inmobiliarios, instituciones de investigación y análisis de movilidad para ofrecer modelos replicables que mejoren la responsabilidad ambiental.

Por otro lado, Raphaël Kergueno, de Transparency International EU, explicó cómo Integrity Watch EU aprovecha los datos abiertos para mejorar la transparencia y la rendición de cuentas en la Unión. Esta iniciativa reutiliza conjuntos de datos como el Registro de Transparencia de la UE y los registros de reuniones de la Comisión Europea para aumentar la conciencia pública sobre las actividades de lobby y mejorar la supervisión legislativa, demostrando el potencial de los datos abiertos para fortalecer la gobernanza democrática.

También, Kate Larkin del Observatorio Marino Europeo, presentó la Red Europea de Observación y Datos Marinos, destacando cómo los servicios paneuropeos de datos marinos, que se adhieren a los principios FAIR contribuyen a iniciativas como el Pacto Verde Europeo, la planificación espacial marítima y la economía azul. Su presentación mostró casos de uso prácticos que demuestran la integración de datos marinos en ecosistemas de datos más amplios como el European Digital Twin Ocean.

Visualización y comunicación de datos

Además de casos de uso, los EU Open Data Days 2025 pusieron en valor la visualización de datos como mecanismo para acercar el open data a la gente. En este sentido, Antonio Moneo, CEO de Tangible Data, exploró cómo transformar conjuntos de datos complejos en esculturas físicas fomenta la alfabetización de datos y la participación comunitaria.

Por otro lado, Jan Willem Tulp, fundador de TULP interactive, examinó cómo el diseño visual influye en la percepción de los datos. Su sesión exploró cómo elementos de diseño como el color, la escala y el enfoque pueden dar forma a narrativas e introducir potencialmente sesgos, destacando las responsabilidades de los visualizadores de datos para mantener la transparencia mientras elaboran narrativas visuales convincentes.

Educación y alfabetización en datos

Davide Taibi, investigador del Consejo Nacional de Investigación de Italia, compartió experiencias sobre la integración de la alfabetización en datos e IA en los itinerarios educativos, basadas en proyectos financiados por la UE como DATALIT, DEDALUS y SMERALD. Estas iniciativas pilotaron módulos de aprendizaje digitalmente mejorados en educación superior, escuelas secundarias y formación profesional en varios Estados miembros de la UE, centrándose en enfoques orientados a competencias y sistemas de aprendizaje basados en TI.

Nadieh Bremer, fundadora de Visual Cinnamon, exploró cómo los enfoques creativos para la visualización de datos pueden revelar los intrincados vínculos entre personas, culturas y conceptos. Los ejemplos incluyeron un árbol genealógico de 3.000 personas de la realeza europea, las relaciones en el Patrimonio Cultural Inmaterial de la UNESCO y constelaciones interculturales en el cielo nocturno, demostrando cómo los procesos de diseño iterativo pueden descubrir patrones ocultos en redes complejas.

El artista digital Andreas Refsgaard cerró las presentaciones con una reflexión sobre la intersección de la IA generativa, el arte y la ciencia de datos. A través de ejemplos artísticos y atractivos, invitó a la audiencia a reflexionar sobre el vasto potencial y los dilemas éticos que surgen de la creciente influencia de las tecnologías digitales en nuestra vida cotidiana.

En resumen, los EU Open Data Days 2025 han demostrado, una vez más, la importancia de estos encuentros para impulsar la evolución del ecosistema de datos abiertos en Europa. Los debates, presentaciones y casos prácticos compartidos durante estas dos jornadas no solo han puesto de manifiesto los avances logrados, sino también los desafíos pendientes y las oportunidades emergentes. En un contexto donde la inteligencia artificial, la sostenibilidad y la participación ciudadana están transformando la manera en que utilizamos y valoramos los datos, eventos como este resultan fundamentales para fomentar la colaboración, compartir conocimientos y desarrollar estrategias que maximicen el valor social y económico de los datos abiertos. El compromiso continuo de las instituciones europeas, los gobiernos nacionales, la academia y la sociedad civil será esencial para construir un ecosistema de datos abiertos más robusto, accesible e impactante que responda a los desafíos del siglo XXI y contribuya al bienestar de todos los ciudadanos europeos.

Puedes volver las grabaciones de cada ponencia aquí.

Los datos geoespaciales han impulsado mejoras en diversos sectores y la energía no es la excepción. Estos datos nos permiten conocer mejor nuestro entorno para promover la sostenibilidad, la innovación y la toma de decisiones informadas.

Uno de los principales proveedores de datos abiertos geoespaciales es Copernicus, el programa de observación de la Tierra de la Unión Europea. A través de una red de satélites llamados Sentinel y datos de fuentes terrestres, marítimas y aéreas, Copernicus proporciona información geoespacial accesible de manera gratuita a través de diversas plataformas.

Aunque los datos de Copernicus son de gran utilidad en múltiples áreas, como la lucha contra el cambio climático, la planificación urbana o la agricultura, en este artículo nos vamos a centrar en su rol para impulsar la sostenibilidad y eficiencia energética. La disponibilidad de datos abiertos de alta calidad fomenta la innovación en este sector promoviendo el desarrollo de nuevas herramientas y aplicaciones que mejoran la gestión y el uso de la energía. A continuación mostramos algunos ejemplos.

Predicción climática para mejorar la producción

Los datos geoespaciales proporcionan información detallada sobre las condiciones meteorológicas, la calidad del aire y otros factores, fundamentales para comprender y predecir fenómenos ambientales, como tormentas o sequías, que afectan a la producción y distribución de energía.

Un ejemplo es este proyecto que ofrece previsiones de viento de alta resolución para dar respuesta a los sectores del petróleo y el gas, la aviación, el transporte marítimo y la defensa. Utiliza datos procedentes de observaciones por satélite como de modelos numéricos, incluyendo información sobre las corrientes oceánicas, las olas y la temperatura superficial del mar procedentes del “Servicio Marino de Copernicus”. Gracias a su granularidad puede ofrecer un sistema de previsión meteorológica preciso a una escala muy local, lo que permite conocer el comportamiento de fenómenos meteorológicos y climáticos extremos con un mayor nivel de exactitud.

Optimización de recursos

Los datos proporcionados por Copernicus también permiten identificar las mejores ubicaciones para la instalación de centros de generación energética, como parques solares y eólicos, al facilitar el análisis de factores como la radiación solar y la velocidad del viento. Además, ayudan a monitorear la eficiencia de estas instalaciones, asegurando que estén operando al máximo de su capacidad.

En este sentido,se ha desarrollado un proyecto para encontrar el mejor emplazamiento para un sistema flotante combinado de energía eólica y undimotriz (es decir, basada en el movimiento de las olas). Al obtener ambas energías con una sola plataforma, esta solución permite ahorrar espacio y reducir el impacto en el terreno, a la vez que supone una mejora de la eficiencia. El viento y las olas llegan en momentos diferentes a la plataforma, por lo que capturar ambos elementos ayuda a reducir la variabilidad y suaviza la producción total de electricidad. Gracias a los datos de Copernicus (obtenidos del servicio Atlántico -Vizcaya Ibérica Irlanda- Reanálisis de olas oceánicas), la empresa proveedora de esta situación pudo obtener componentes separados de olas de viento y oleaje, lo que permitió una comprensión más completa de la direccionalidad de ambos elementos. Este trabajo condujo a la selección de la Plataforma de Energía Marina de Vizcaya (BiMEP) para el despliegue del dispositivo.

Otro ejemplo es Mon Toit Solaire, un sistema integrado de ayuda a la decisión basado en Internet para el desarrollo de la generación de energía fotovoltaica en tejados. Esta herramienta simula y calcula el potencial energético de un proyecto fotovoltaico y proporciona a los usuarios información técnica y financiera fiable. Utiliza datos de radiación solar producidos por el “Servicio de vigilancia de la atmósfera de Copernicus”, junto con datos topográficos urbanos tridimensionales y simulaciones de incentivos fiscales, costes y precios de la energía, lo que permite calcular el rendimiento de la inversión.

Monitorización Ambiental y evaluación de impacto

La información geoespacial permite mejorar el monitoreo ambiental y realizar evaluaciones de impacto precisas en el sector energético. Estos datos permiten a las empresas energéticas identificar riesgos ambientales asociados a sus operaciones, diseñar estrategias para mitigar su impacto y optimizar sus procesos hacia una mayor sostenibilidad. Además, apoyan el cumplimiento de normativas ambientales al facilitar reportes basados en datos objetivos, fomentando un desarrollo energético más responsable y respetuoso con el medio ambiente.

Entre los retos que plantea la conservación de la biodiversidad de los océanos, el ruido submarino de origen humano se reconoce como una grave amenaza y está regulado a nivel europeo. Con el fin de evaluar el impacto en la vida marina de los parques eólicos a lo largo de la costa sur de Francia, este proyecto utiliza mapas de sonido estadísticos de alta resolución, que proporcionan una visión detallada de los procesos costeros, con una frecuencia temporal horaria y una alta resolución espacial de hasta 1,8 km. En concreto, utilizan información procedente de los servicios de “análisis y previsión de la física del mar Mediterráneo” y “Viento y tensión en la superficie del mar por hora en el océano mundial”.

Gestión de emergencias y desastres medioambientales

En situaciones de desastre o eventos climáticos extremos, los datos geoespaciales pueden ayudar a evaluar rápidamente los daños y coordinar las respuestas de emergencia de manera más eficiente.

También pueden prevenir cómo se van a comportar los vertidos. Esta es el objetivo del Instituto de Investigación Marina de la Universidad de Klaipeda, que ha desarrollado un sistema de vigilancia y previsión de episodios de contaminación química y microbiológica mediante un modelo hidrodinámico operativo 3D de alta resolución. Para ellos utilizan el “Análisis y previsiones físicas del Mar Báltico” de Copernicus. El modelo ofrece previsiones en tiempo real y a cinco días vista de las corrientes de agua, abordando los retos que plantean las aguas poco profundas y las zonas portuarias. Su objetivo es ayudar a gestionar incidentes de contaminación, sobre todo en regiones propensas a ella, como puertos y terminales petrolíferas.

Estos ejemplos ponen de manifiesto la utilidad de los datos geoespaciales, especialmente aquellos proporcionados por programas como Copernicus. El hecho de que empresas e instituciones puedan acceder libremente a estos datos está revolucionando el sector energético, contribuyendo a un sistema más eficiente, sostenible y resiliente.

La vivienda es una de las principales preocupaciones de los ciudadanos españoles, de acuerdo con el barómetro de enero de 2025 del Centro de Investigaciones Sociológicas (CIS). Para conocer la situación real del acceso a la vivienda, es necesario disponer de datos públicos, actualizados y de calidad, que permitan a todos los actores de este ecosistema realizar análisis y tomar decisiones informadas.

En este artículo vamos a repasar algunos ejemplos de datos abiertos disponibles, así como herramientas y soluciones que se han creado en base a ellos para acercar esta información a la ciudadanía.

Los datos abiertos pueden tener varios usos en este sector:

- Permitir a los organismos públicos conocer las necesidades de la ciudadanía y elaborar políticas acordes.

- Ayudar a particulares a encontrar viviendas para alquilar o comprar.

- Facilitar información a constructores y empresas para que desarrollen viviendas que den respuesta a esas necesidades.

Por ello, en este campo, los datos más utilizados incluyen aquellos que hacen referencia a las viviendas, pero también a aspectos demográficos y sociales, muchas veces con un alto componente geoespacial. Algunos de los datasets más populares en este sentido son el Índices de precios de consumo y vivienda del Instituto Nacional de Estadística (INE) o los datos del Catastro.

Diferentes organismos públicos han puesto a disposición de la ciudadanía espacios donde reúnen diversos datos relacionados con la vivienda. Es el caso del Ayuntamiento de Barcelona y su portal “Vivienda en datos”, un entorno que centraliza el acceso a información y datos de diversas fuentes, incluyendo datasets de su portal de datos abiertos.

Otro ejemplo es el portal de visualización de datos del Ayuntamiento de Madrid, donde se incluyen cuadros de mando con información sobre el número de inmuebles residenciales por distrito o barrio, así como su valor catastral, con acceso directo a la descarga de los datos utilizados.

Más ejemplos de organismos que también posibilitan el acceso a este tipo de información son la Junta de Castilla y León, el Gobierno Vasco o la Comunidad Valenciana. Además, aquellas personas que lo deseen pueden encontrar multitud de datos relacionados con la vivienda en el Catálogo Nacional de Datos Abiertos, albergado aquí, en datos.gob.es.

También cabe señalar que no solo los organismos públicos abren datos relacionados con esta materia. Hace unos meses, el portal inmobiliario idealista hizo público un conjunto de datos con información detallada de miles de viviendas en Madrid, Barcelona y Valencia. Está disponible como un paquete en R a través de Github.

Herramientas y soluciones para acercar esos datos a los ciudadanos

Datos como los anteriormente mencionados pueden ser reutilizados con múltiples fines, como mostramos en artículos anteriores y como podemos ver en esta nueva aproximación a los diversos casos de uso:

Periodismo de datos

Los medios de comunicación utilizan los datos abiertos sobre vivienda para ofrecer una visión más precisa de la situación del mercado inmobiliario, ayudando a los ciudadanos a comprender las dinámicas que afectan a los precios, la oferta y la demanda. Al acceder a datos sobre la evolución de los precios, la disponibilidad de viviendas o las políticas públicas relacionadas, los medios pueden generar reportajes e infografías que explican de manera accesible la situación y cómo estos factores impactan en la vida cotidiana de las personas. Estos artículos proporcionan información relevante a los ciudadanos, de forma sencilla, para tomar decisiones sobre su situación habitacional.

Un ejemplo es este artículo que permite visualizar, barrio a barrio, el precio del alquiler y el acceso a la vivienda según ingresos, para el cual se utilizaron datos abiertos del Ministerio de Vivienda y Agenda Urbana, el Catastro o el INE, entre otros. En la misma línea se mueve este artículo sobre el porcentaje de ingresos que se destina al alquiler.

Elaboración de informes y políticas

Los datos abiertos sobre vivienda son utilizados por organismos públicos como el Ministerio de Vivienda y Agenda Urbana en su Observatorio de Vivienda y Suelo, donde se generan boletines estadísticos electrónicos que integran datos disponibles en las principales fuentes estadísticas oficiales. El fin es realizar un seguimiento del sector desde diversas perspectivas y a lo largo de las distintas fases del proceso (mercado del suelo, productos edificados, accesibilidad y financiación, etc.). El Ministerio de Vivienda y Agenda Urbana también utiliza datos de diversas fuentes, como la Agencia Tributaria, el Catastro o el INE, para su Sistema Estatal de Referencia de Precios de Alquiler de Vivienda, que define rangos de valores de precios de alquiler de viviendas en zonas declaradas como tensionadas.

Oferta de servicios inmobiliarios

Los datos abiertos pueden ser valiosos para el sector de la construcción: la información abierta sobre el uso del suelo y los permisos se consultan antes de emprender trabajos de excavación y empezar a construir obras nuevas.

Además, algunas de las empresas que utilizan datos abiertos son sitios web inmobiliarios. Estos portales reutilizan conjuntos de datos abiertos para proporcionar a los usuarios precios comparables de las propiedades, estadísticas de delincuencia en los barrios o proximidad a instalaciones públicas educativas, sanitarias y recreativas. A ello ayudan, por ejemplo, herramientas como Location intelligence, que permite acceder a datos del padrón, precios de alquiler, características de la vivienda o planeamiento urbano. Los organismos públicos también pueden ayudar a este campo con sus propias soluciones, como Donde Vivo, del Gobierno de Aragón,que permite obtener un mapa interactivo y la información relacionada de los puntos de interés, centros educativos y sanitarios más cercanos así como información geoestadística del lugar donde vive.

También existen herramientas que ayudan a prever gastos futuros como, Urban3r, donde los usuarios pueden visualizar diferentes indicadores que les ayudan a conocer los datos de demanda energética de los edificios residenciales en su estado actual y tras someterlos a una rehabilitación energética, así como los costes estimados de estas intervenciones.Este es un campo donde las tecnologías disruptivas basadas en datos, como la inteligencia artificial, tendrán cada vez más protagonismo, al optimizar procesos y facilitar la toma de decisiones tanto para los compradores como para los proveedores de viviendas. A través del análisis de grandes volúmenes de datos, la IA puede predecir tendencias del mercado, identificar zonas con mayor demanda o proporcionar recomendaciones personalizadas según las necesidades de cada usuario. Algunas empresas ya han puesto en marcha chatbots, que responden a las preguntas de los usuarios, pero la IA puede ayudar incluso a crear proyectos para el desarrollo de viviendas económicas y sostenibles.

En resumen, nos encontramos en un campo donde las nuevas tecnologías van a hacer cada vez más fácil que los ciudadanos podamos conocer la oferta de viviendas, pero esta oferta debe estar alineada con las necesidades de los usuarios. Por ello es necesario continuar impulsando la apertura de datos de calidad, que ayuden a conocer la situación e impulsar políticas públicas y soluciones que facilitan el acceso a la vivienda.

El concepto de data commons o bienes comunes de datos surge como un enfoque transformador para la gestión y el intercambio de datos que sirvan a fines colectivos y como alternativa al creciente número de macrosilos de datos de uso privado. Al tratar los datos como un recurso compartido, los data commons facilitan la colaboración, la innovación y el acceso equitativo a los mismos, enfatizando el valor comunal de los datos por encima de cualquier otra consideración. A medida que navegamos por las complejidades de la era digital —marcada en la actualidad por los rápidos avances en inteligencia artificial (IA) y el continuo debate sobre los retos en la gobernanza de datos— el papel que pueden jugar los data commons es ahora probablemente más importante que nunca.

¿Qué son los data commons?

Los data commons se refieren a un marco cooperativo donde los datos son recopilados, gobernados y compartidos entre todos los participantes de la comunidad mediante protocolos que promueven la apertura, la equidad, el uso ético y la sostenibilidad. Los data commons se diferencian de los modelos tradicionales de intercambio de datos, principalmente, por la prioridad que se da a la colaboración y la inclusión sobre el control unitario.

Otro objetivo común de los data commons es la creación de conocimiento colectivo que pueda ser utilizado por cualquiera para el bien de la sociedad. Esto los hace particularmente útiles a la hora de afrontar los grandes desafíos actuales, como los retos del medio ambiente, la interacción multilingüe, la movilidad, las catástrofes humanitarias, la preservación del conocimiento o los nuevos desafíos de la salud y la sanidad.

Además, también es cada vez más frecuente que estas iniciativas para compartir datos incorporen todo tipo de herramientas que faciliten su análisis e interpretación consiguiendo así democratizar no sólo la propiedad y el acceso a los datos, sino también su uso.

Por todo lo anterior, los data commons podrían considerarse hoy en día como una infraestructura digital pública crítica a la hora de aprovechar los datos y promover el bienestar social.

Principios de los data commons

Los data commons se construyen sobre una serie de principios simples que serán clave para su correcta gobernanza:

- Apertura y accesibilidad: los datos deben ser accesibles para todos los autorizados.

- Gobernanza ética: equilibrio entre la inclusión y la privacidad.

- Sostenibilidad: establecer mecanismos de financiación y recursos para mantener los datos como bienes comunes a lo largo del tiempo.

- Colaboración: fomentar que los participantes contribuyan con nuevos datos e ideas que habiliten su uso para el beneficio mutuo.

- Confianza: relaciones basadas en la transparencia y la credibilidad entre partícipes.

Además, si queremos asegurarnos también de que los data commons cumplan su papel como infraestructura digital de dominio público, deberemos garantizar otros requisitos mínimos adicionales como: existencia de identificadores únicos permanentes, metadatos documentados, acceso fácil a través de interfaces de programación de aplicaciones (API), portabilidad de los datos, acuerdos de intercambio de datos entre pares y capacidad de realizar operaciones sobre los mismos.

El importante papel de los data commons en la era de la Inteligencia Artificial

La innovación impulsada por la IA ha incrementado exponencialmente la demanda de conjuntos de datos diversos y de alta calidad, un bien relativamente escaso a gran escala que puede dar lugar a cuellos de botella en el desarrollo futuro de la tecnología y que, al mismo tiempo, hace de los data commons un facilitador muy relevante a la hora de conseguir una IA más equitativa. Al proporcionar conjuntos de datos compartidos gobernados por principios éticos, los data commons contribuyen a mitigar riesgos frecuentes como los sesgos, los monopolios de datos y el acceso desigual a los beneficios de la IA.

Además, la actual concentración de los desarrollos en el ámbito de la IA representa también un desafío para el interés público. En este contexto, los data commons cuentan con la llave necesaria para habilitar un conjunto de sistemas y aplicaciones de IA alternativos, públicos y orientados al interés general, que puedan contribuir a rebalancear esta concentración de poder actual. El objetivo de estos modelos sería demostrar cómo se pueden diseñar sistemas más democráticos, orientados al interés público y con propósitos bien definidos, basados en los principios y modelos de gobernanza de la IA pública.

Sin embargo, la era de la IA generativa también presenta nuevos desafíos para los data commons como, por ejemplo y quizás el más destacado, el riesgo potencial de una explotación descontrolada de los conjuntos de datos compartidos que podría dar lugar a nuevos desafíos éticos por el uso indebido de los datos y la vulneración de la privacidad.