embalses.info es una plataforma web que proporciona información actualizada sobre el estado de los embalses y pantanos de España. La aplicación ofrece datos hidrológicos en tiempo real con actualizaciones semanales, permitiendo a ciudadanos, investigadores y gestores públicos consultar niveles de agua, capacidades y evoluciones históricas de más de 400 embalses organizados en 16 cuencas hidrográficas.

La aplicación cuenta con un dashboard interactivo que muestra el estado general de los embalses españoles, un mapa interactivo (próximamente) de cuencas con niveles de llenado, y páginas detalladas para cada embalse con gráficos de evolución semanal, comparativas con años anteriores, e históricos desde los años 80. Incluye un potente buscador, análisis de datos con gráficos interactivos, y un formulario de contacto para sugerencias.

Desde el punto de vista técnico, la plataforma utiliza Next.js 14+ con TypeScript en el frontend, Prisma ORM para acceso a datos, y PostgreSQL/SQL Server como base de datos. Está optimizada para SEO con sitemap XML dinámico, meta tags optimizados, datos estructurados y URLs amigables. El sitio es completamente responsive, accesible y cuenta con tema claro/oscuro automático.

El valor público de la aplicación radica en proporcionar transparencia e información accesible sobre los recursos hídricos españoles, permitiendo a agricultores, administraciones, investigadores y medios de comunicación tomar decisiones informadas basadas en datos confiables y actualizados.

En todo entorno de gestión de datos (empresas, Administración pública, consorcios, proyectos de investigación), disponer de datos no basta: si no sabes qué datos tienes, dónde están, qué significan, quién los mantiene, con qué calidad, cuándo cambiaron o cómo se relacionan con otros datos, entonces el valor es muy limitado. Los metadatos —datos sobre los datos— son esenciales para:

-

Visibilidad y acceso: permitir que usuarios encuentren qué datos existen y puedan acceder.

-

Contextualización: saber qué significan los datos (definiciones, unidades, semántica).

-

Trazabilidad / linaje: entender de dónde vienen los datos y cómo han sido transformados.

-

Gobierno y control: conocer quién es responsable, qué políticas aplican, permisos, versiones, obsolescencia.

-

Calidad, integridad y consistencia: asegurar la fiabilidad de los datos mediante reglas, métricas y monitoreo.

-

Interoperabilidad: garantizar que diferentes sistemas o dominios puedan compartir datos, utilizando un vocabulario común, definiciones compartidas y relaciones explícitas.

En resumen, los metadatos son la palanca que convierte los datos “aislados” en un ecosistema de información gobernada. A medida que los datos crecen en volumen, diversidad y velocidad, su función va más allá de la simple descripción: los metadatos añaden contexto, permiten interpretar los datos y facilitan que puedan ser encontrados, accesibles, interoperables y reutilizables (FAIR).

En el nuevo contexto impulsado por la inteligencia artificial, esta capa de metadatos adquiere una relevancia aún mayor, ya que proporciona la información de procedencia (provenance) necesaria para garantizar la trazabilidad, la fiabilidad y la reproducibilidad de los resultados. Por ello, algunos marcos recientes amplían estos principios hacia FAIR-R, donde la “R” adicional resalta la importancia de que los datos estén listos para la IA (AI-ready), es decir, que cumplen una serie de requisitos técnicos, estructurales y de calidad que optimizan su aprovechamiento por parte de los algoritmos de inteligencia artificial.

Así, hablamos de metadatos enriquecidos, capaces de conectar información técnica, semántica y contextual para potenciar el aprendizaje automático, la interoperabilidad entre dominios y la generación de conocimiento verificable.

De los metadatos tradicionales a los “metadatos enriquecidos”

Metadatos tradicionales

En el contexto de este artículo, cuando hablamos de metadatos con un uso tradicional, pensamos en catálogos, diccionarios, glosarios, modelos de datos de base de datos, y estructuras rígidas (tablas y columnas). Los tipos de metadatos más comunes son:

-

Metadatos técnicos: tipo de columna, longitud, formato, claves foráneas, índices, ubicaciones físicas.

-

Metadatos de negocio / semánticos: nombre de campo, descripción, dominio de valores, reglas de negocio, términos del glosario empresarial.

-

Metadatos operativos / de ejecución: frecuencia de actualización, última carga, tiempos de procesamiento, estadísticas de uso.

-

Metadatos de calidad: porcentaje de valores nulos, duplicados, validaciones.

-

Metadatos de seguridad / acceso: políticas de acceso, permisos, clasificación de sensibilidad.

-

Metadatos de linaje: rastreo de transformación en los pipelines de datos.

Estos metadatos se almacenan usualmente en repositorios o herramientas de catalogación, muchas veces con estructuras tabulares o en bases relacionales, con vínculos predefinidos.

¿Por qué metadatos enriquecidos?

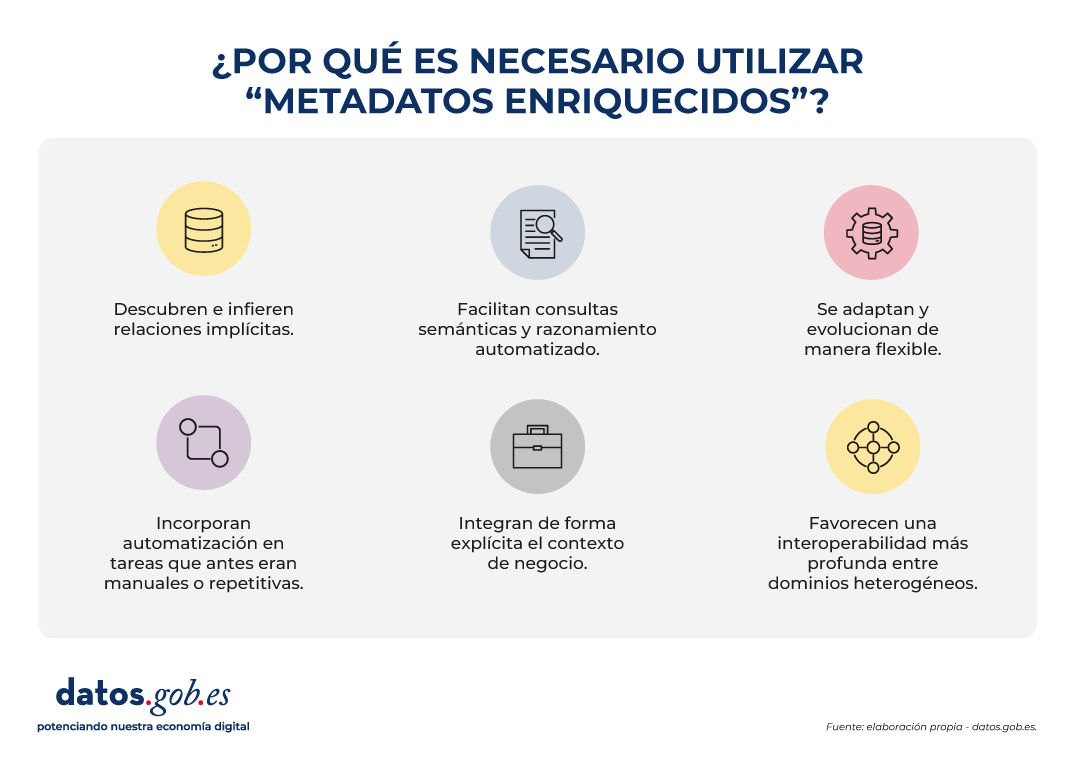

Los metadatos enriquecidos son aquella capa que no solo describe atributos, sino que:

- Descubren e infieren relaciones implícitas, identificando vínculos que no están expresamente definidos en los esquemas de datos. Esto permite, por ejemplo, reconocer que dos variables con nombres diferentes en sistemas distintos representan en realidad el mismo concepto (“altitud” y “elevación”), o que ciertos atributos mantienen una relación jerárquica (“municipio” pertenece a “provincia”).

- Facilitan consultas semánticas y razonamiento automatizado, permitiendo que los usuarios y las máquinas exploren relaciones y patrones que no están explícitamente definidos en las bases de datos. En lugar de limitarse a buscar coincidencias exactas de nombres o estructuras, los metadatos enriquecidos permiten formular preguntas basadas en significado y contexto. Por ejemplo, identificar automáticamente todos los conjuntos de datos relacionados con “ciudades costeras” aunque el término no aparezca literalmente en los metadatos.

- Se adaptan y evolucionan de manera flexible, ya que pueden ampliarse con nuevos tipos de entidades, relaciones o dominios sin necesidad de rediseñar toda la estructura del catálogo. Esto permite incorporar fácilmente nuevas fuentes de datos, modelos o estándares, garantizando la sostenibilidad del sistema a largo plazo.

- Incorporan automatización en tareas que antes eran manuales o repetitivas, como la detección de duplicidades, el emparejamiento automático de conceptos equivalentes o el enriquecimiento semántico mediante aprendizaje automático. También pueden identificar incoherencias o anomalías, mejorando la calidad y la coherencia de los metadatos.

- Integran de forma explícita el contexto de negocio, enlazando cada activo de datos con su significado operativo y su rol dentro de los procesos organizativos. Para ello utilizan vocabularios controlados, ontologías o taxonomías que facilitan un entendimiento común entre equipos técnicos, analistas y responsables de negocio.

- Favorecen una interoperabilidad más profunda entre dominios heterogéneos, que va más allá del intercambio sintáctico facilitado por los metadatos tradicionales. Los metadatos enriquecidos añaden una capa semántica que permite comprender y relacionar los datos en función de su significado, no solo de su formato. Así, datos procedentes de diferentes fuentes o sectores —por ejemplo, Sistemas de información Geográfica (GIS en inglés), Building Information Modeling (BIM) o Internet de las Cosas (IoT)— pueden vincularse de manera coherente dentro de un marco conceptual compartido. Esta interoperabilidad semántica es la que posibilita integrar conocimiento y reutilizar información entre contextos técnicos y organizativos diversos.

Esto convierte los metadatos en un activo vivo, enriquecido y conectado con el conocimiento del dominio, no solo un “registro” pasivo.

La evolución de los metadatos: ontologías y grafos de conocimiento

La incorporación de ontologías y grafos de conocimiento representa una evolución conceptual en la manera de describir, relacionar y aprovechar los metadatos, de ahí que hablemos de metadatos enriquecidos. Estas herramientas no solo documentan los datos, sino que los conectan dentro de una red de significado, permitiendo que las relaciones entre entidades, conceptos y contextos sean explícitas y computables.

En el contexto actual, marcado por el auge de la inteligencia artificial, esta estructura semántica adquiere un papel fundamental: proporciona a los algoritmos el conocimiento contextual necesario para interpretar, aprender y razonar sobre los datos de forma más precisa y transparente. Ontologías y grafos permiten que los sistemas de IA no solo procesen información, sino que entiendan las relaciones entre los elementos y puedan generar inferencias fundamentadas, abriendo el camino hacia modelos más explicativos y confiables.

Este cambio de paradigma transforma los metadatos en una estructura dinámica, capaz de reflejar la complejidad del conocimiento y de facilitar la interoperabilidad semántica entre distintos dominios y fuentes de información. Para comprender esta evolución conviene definir y relacionar algunos conceptos:

Ontologías

En el mundo de los datos, una ontología es un mapa conceptual muy organizado que define claramente:

- Qué entidades existen (ej. ciudad, río, carretera).

- Qué propiedades tienen (ej. una ciudad tiene nombre, población, código postal).

- Cómo se relacionan entre sí (ej. un río atraviesa una ciudad, una carretera conecta dos municipios).

El objetivo es que personas y máquinas compartan un mismo vocabulario y entiendan los datos de la misma manera. Las ontologías permiten:

- Definir conceptos y relaciones: por ejemplo, “una parcela pertenece a un municipio”, “un edificio tiene coordenadas geográficas”.

- Poner reglas y restricciones: como “cada edificio debe estar exactamente en una parcela catastral”.

- Unificar vocabularios: si en un sistema se dice “parcela” y en otro “unidad catastral”, la ontología ayuda a reconocer que son análogos.

- Hacer inferencias: a partir de datos simples, descubrir nuevo conocimiento (si un edificio está en una parcela y la parcela en Sevilla, se puede inferir que el edificio está en Sevilla).

- Establecer un lenguaje común: funcionan como un diccionario compartido entre distintos sistemas o dominios (GIS, BIM, IoT, catastro, urbanismo).

En resumen: una ontología es el diccionario y las reglas del juego que permiten que diferentes sistemas geoespaciales (mapas, catastro, sensores, BIM, etc.) se entiendan entre sí y puedan trabajar de manera integrada.

Grafos de conocimiento (Knowledge Graphs)

Un grafo de conocimiento es una forma de organizar información como si fuera una red de conceptos conectados entre sí.

-

Los nodos representan cosas o entidades, como una ciudad, un río o un edificio.

-

Las aristas (líneas) muestran las relaciones entre ellas, por ejemplo: “está en”, “atraviesa” o “pertenece a”.

-

A diferencia de un simple dibujo de conexiones, un grafo de conocimiento también explica el significado de esas relaciones: añade semántica.

Un grafo de conocimiento combina tres elementos principales:

-

Datos: los casos concretos o instancias, como “Sevilla”, “Río Guadalquivir” o “Edificio Ayuntamiento de Sevilla”.

-

Semántica (u ontología): las reglas y vocabularios que definen qué tipos de cosas existen (ciudades, ríos, edificios) y cómo pueden relacionarse entre sí.

-

Razonamiento: la capacidad de descubrir nuevas conexiones a partir de las existentes (por ejemplo, si un río atraviesa una ciudad y esa ciudad está en España, el sistema puede deducir que el río está en España).

Además, los grafos de conocimiento permiten conectar información de distintos ámbitos (por ejemplo, datos sobre personas, lugares y empresas) bajo un mismo lenguaje común, facilitando el análisis y la interoperabilidad entre disciplinas.

En otras palabras, un knowledge graph es el resultado de aplicar una ontología (el modelo de datos) a varios conjuntos de datos individuales (elementos espaciales, otros datos del territorio, registros de pacientes o productos de catálogo, etc.). Los grafos de conocimiento son ideales para integrar datos heterogéneos, porque no requieren un esquema rígido previamente completo: se pueden ir creciendo de forma flexible. Además, permiten consultas semánticas y navegación con relaciones complejas. A continuación, se pone un ejemplo para datos espaciales con los que entender las diferencias:

|

Ontología de datos espaciales (modelo conceptual) |

Grafo de conocimiento (ejemplos concretos con instancias) |

|---|---|

|

|

|

|

Casos de uso

Para entender mejor el valor de los metadatos inteligentes y los catálogos semánticos, nada mejor que mirar ejemplos donde ya se están aplicando. Estos casos muestran cómo la combinación de ontologías y grafos de conocimiento permite conectar información dispersa, mejorar la interoperabilidad y generar conocimiento accionable en distintos contextos.

Desde la gestión de emergencias hasta la planificación urbana o la protección del medio ambiente, diferentes proyectos internacionales han demostrado que la semántica no es solo teoría, sino una herramienta práctica que transforma datos en decisiones.

Algunos ejemplos relevantes incluyen:

- LinkedGeoData que convirtió datos de OpenStreetMap en Linked Data, enlazándolos con otras fuentes abiertas.

- Virtual Singapore un gemelo digital 3D que integra datos geoespaciales, urbanos y en tiempo real para simulación y planificación.

- JedAI-spatial una herramienta para interconectar datos espaciales en 3D mediante relaciones semánticas.

- SOSA Ontology, estándar ampliamente usado en proyectos de sensores e IoT para observaciones ambientales con componente geoespacial.

- Proyectos europeos de permisos digitales de construcción (ej. ACCORD), que combinan catálogos semánticos, modelos BIM y datos GIS para validar automáticamente normativas de construcción.

Conclusiones

La evolución hacia metadatos enriquecidos, apoyados en ontologías, grafos de conocimiento y principios FAIR-R, representa un cambio sustancial en la manera de gestionar, conectar y comprender los datos. Este nuevo enfoque convierte los metadatos en un componente activo de la infraestructura digital, capaz de aportar contexto, trazabilidad y significado, y no solo de describir información.

Los metadatos enriquecidos permiten aprender de los datos, mejorar la interoperabilidad semántica entre dominios y facilitar consultas más expresivas, donde las relaciones y dependencias pueden descubrirse de forma automatizada. De este modo, favorecen la integración de información dispersa y apoyan tanto la toma de decisiones informadas como el desarrollo de modelos de inteligencia artificial más explicativos y confiables.

En el ámbito de los datos abiertos, estos avances impulsan la transición desde repositorios descriptivos hacia ecosistemas de conocimiento interconectado, donde los datos pueden combinarse y reutilizarse de manera flexible y verificable. La incorporación de contexto semántico y procedencia (provenance) refuerza la transparencia, la calidad y la reutilización responsable.

Esta transformación requiere, sin embargo, un enfoque progresivo y bien gobernado: es fundamental planificar la migración de sistemas, garantizar la calidad semántica, y promover la participación de comunidades multidisciplinares.

En definitiva, los metadatos enriquecidos son la base para pasar de datos aislados a conocimiento conectado y trazable, elemento clave para la interoperabilidad, la sostenibilidad y la confianza en la economía de los datos.

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autora

Los datos abiertos tienen un gran potencial para transformar la forma en que interactuamos con nuestras ciudades. Al estar disponibles para toda la ciudadanía, permiten desarrollar aplicaciones y herramientas que dan respuesta a retos urbanos como la accesibilidad, la seguridad vial o la participación ciudadana. Facilitar el acceso a esta información no solo impulsa la innovación, sino que también contribuye a mejorar la calidad de vida en los entornos urbanos.

Este potencial cobra aún más relevancia si consideramos el contexto actual. El crecimiento urbano acelerado ha traído consigo nuevos desafíos, especialmente en materia de salud pública. Según datos de las Naciones Unidas, se estima que para 2050 más del 68% de la población mundial vivirá en ciudades. Por lo tanto, el diseño de entornos urbanos saludables es una prioridad en la que los datos abiertos se consolidan como una herramienta clave: permiten planificar ciudades más resilientes, inclusivas y sostenibles, poniendo el bienestar de las personas en el centro de las decisiones. En este post, te contamos qué son los entornos urbanos saludables y cómo pueden los datos abiertos ayudar a construirlos y mantenerlos.

¿Qué son los Entornos urbanos saludables? Usos y ejemplos

Los entornos urbanos saludables van más allá de la simple ausencia de contaminación o ruido. Según la Organización Mundial de la Salud (OMS), estos espacios deben promover activamente estilos de vida saludables, facilitar la actividad física, fomentar la interacción social y garantizar el acceso equitativo a servicios básicos. Como establece la "Guía para planificar ciudades saludables" del Ministerio de Sanidad, estos entornos se caracterizan por tres elementos clave:

-

Ciudades pensadas para caminar: deben ser espacios que prioricen la movilidad peatonal y ciclista, con calles seguras, accesibles y confortables que inviten al desplazamiento activo.

-

Incorporación de la naturaleza: integran zonas verdes, infraestructura azul y elementos naturales que mejoran la calidad del aire, regulan la temperatura urbana y ofrecen espacios de recreo y descanso.

-

Espacios de encuentro y convivencia: cuentan con áreas que facilitan la interacción social, reducen el aislamiento y fortalecen el tejido comunitario.

El papel de los datos abiertos en entornos urbanos saludables

En este escenario, los datos abiertos actúan como el sistema nervioso de las ciudades inteligentes, proporcionando información valiosa sobre patrones de uso, necesidades ciudadanas y efectividad de las políticas públicas. En concreto, en el ámbito de los espacios urbanos saludables son especialmente útiles los datos de:

-

Análisis de patrones de actividad física: los datos de movilidad, uso de instalaciones deportivas y frecuentación de espacios verdes revelan dónde y cuándo los ciudadanos son más activos, identificando oportunidades para optimizar la infraestructura existente.

-

Monitorización de la calidad ambiental: los sensores urbanos que miden la calidad del aire, los niveles de ruido y la temperatura proporcionan información en tiempo real sobre las condiciones de salubridad de diferentes áreas urbanas.

-

Evaluación de accesibilidad: el transporte público, la infraestructura peatonal y la distribución de servicios permiten identificar barreras al acceso y diseñar soluciones más inclusivas.

-

Participación ciudadana informada: las plataformas de datos abiertos facilitan procesos participativos donde los ciudadanos pueden contribuir con información local y colaborar en la toma de decisiones.

El ecosistema español de datos abiertos cuenta con sólidas plataformas que alimentan proyectos de espacios urbanos saludables. Por ejemplo, el Portal de Datos Abiertos del Ayuntamiento de Madrid ofrece información en tiempo real sobre la calidad del aire así como un inventario completo de zonas verdes. También Barcelona publica datos sobre calidad del aire, incluyendo las ubicaciones y características de las estaciones de medida.

Estos portales no solo almacenan información, sino que la estructuran de manera que desarrolladores, investigadores y ciudadanos puedan crear aplicaciones y servicios innovadores.

Casos de uso: aplicaciones que reutilizan datos abiertos

Varios proyectos demuestran cómo los datos abiertos se traducen en mejoras tangibles para la salud urbana. Por un lado, podemos destacar algunas aplicaciones o herramientas digitales como:

-

AQI Air Quality Index: utiliza datos gubernamentales para ofrecer información en tiempo real sobre la calidad del aire en diferentes ciudades españolas.

-

GV Aire: procesa datos oficiales de calidad atmosférica para generar alertas y recomendaciones ciudadanas.

-

Índice de Calidad del Aire Nacional: centraliza información de estaciones de medición de todo el país.

-

Valencia Verde: utiliza datos municipales para mostrar ubicación y características de parques y jardines de Valencia.

Por otro lado, existen iniciativas que combinan datos abiertos multisectoriales para ofrecer soluciones que mejoran la interacción entre urbe y ciudadanía. Por ejemplo:

-

Programa Supermanzanas: utiliza mapas que muestran los niveles de contaminación de calidad del aire y datos de tráfico disponibles en formatos abiertos como CSV y GeoPackage de Barcelona Open Data y el Ajuntament de Barcelona para identificar calles donde la reducción del tráfico rodado puede maximizar los beneficios para la salud, creando espacios seguros para peatones y ciclistas.

-

La plataforma DataActive: busca establecer una infraestructura internacional en la que participen investigadores, entidades deportivas públicas y privadas. Las temáticas que aborda incluyen la gestión del territorio, el urbanismo, la sostenibilidad, la movilidad, la calidad del aire y la justicia ambiental. Su objetivo es promover entornos urbanos más activos, saludables y accesibles mediante la implementación de estrategias basadas en el open data y la investigación.

La disponibilidad de datos se complementa con herramientas avanzadas de visualización. La Infraestructura de Datos Espaciales de Madrid (IDEM) ofrece visores geográficos especializados en calidad del aire y el Instituto Geográfico Nacional (IGN) ofrece el callejero nacional CartoCiudad con información de todas las ciudades de España.

Gobernanza efectiva y ecosistema de innovación

No obstante, la efectividad de estas iniciativas depende de nuevos modelos de gobernanza que integren múltiples actores. Para lograr una correcta coordinación entre administraciones públicas de diferentes niveles, empresas privadas, organizaciones del tercer sector y ciudadanía es esencial contar con datos abiertos de calidad.

Los datos abiertos no solo alimentan aplicaciones específicas, sino que crean un ecosistema completo de innovación. Desarrolladores independientes, startups, centros de investigación y organizaciones ciudadanas utilizan estos datos para:

-

Desarrollar estudios de impacto en salud urbana.

-

Crear herramientas de planificación participativa.

-

Generar alertas tempranas sobre riesgos ambientales.

-

Evaluar la efectividad de políticas públicas.

-

Diseñar servicios personalizados según las necesidades de diferentes grupos poblacionales.

Los proyectos de espacios urbanos saludables basados en datos abiertos generan múltiples beneficios tangibles:

-

Eficiencia en la gestión pública: los datos permiten optimizar la asignación de recursos, priorizar intervenciones y evaluar su impacto real sobre la salud ciudadana.

-

Innovación y desarrollo económico: el ecosistema de datos abiertos estimula la creación de startups y servicios innovadores que mejoran la calidad de vida urbana, como demuestran las múltiples aplicaciones disponibles en datos.gob.es.

-

Transparencia y participación: la disponibilidad de datos facilita el control ciudadano y fortalece los procesos democráticos de toma de decisiones.

-

Evidencia científica: los datos sobre salud urbana contribuyen al desarrollo de políticas públicas basadas en evidencia y al avance del conocimiento científico.

-

Replicabilidad: las soluciones exitosas pueden adaptarse y replicarse en otras ciudades, acelerando la transformación hacia entornos urbanos más saludables.

En definitiva, el futuro de nuestras ciudades depende de nuestra capacidad para integrar tecnología, participación ciudadana y políticas públicas innovadoras. Los ejemplos analizados demuestran que los datos abiertos no son solo información; son la base para construir entornos urbanos que promuevan activamente la salud, la equidad y la sostenibilidad.

Los datos abiertos de fuentes públicas han evolucionado a lo largo de estos años, pasando de ser simples repositorios de información a constituir ecosistemas dinámicos que pueden transformar la gobernanza pública. En este contexto, la inteligencia artificial (IA) emerge como una tecnología catalizadora que se beneficia del valor de los datos abiertos y potencia exponencialmente su utilidad. En este post veremos cómo es la relación simbiótica de mutuo beneficio entre la IA y los datos abiertos.

Tradicionalmente, el debate sobre datos abiertos se ha centrado en los portales: las plataformas en las que gobiernos publican información para que la ciudadanía, las empresas y las organizaciones puedan acceder a ella. Pero la llamada “Tercera Ola de Datos Abiertos”, término acuñado por el GovLab de la Universidad de Nueva York, enfatiza que ya no basta con publicar datasets a demanda o por defecto. Lo importante es pensar en el ecosistema completo: el ciclo de vida de los datos, su explotación, mantenimiento y, sobre todo, el valor que generan en la sociedad.

¿Qué función pueden tener los datos abiertos aplicados a la IA?

En este contexto, la IA aparece como un catalizador capaz de automatizar tareas, enriquecer los datos abiertos gubernamentales (OGD), facilitar su comprensión y estimular la colaboración entre actores.

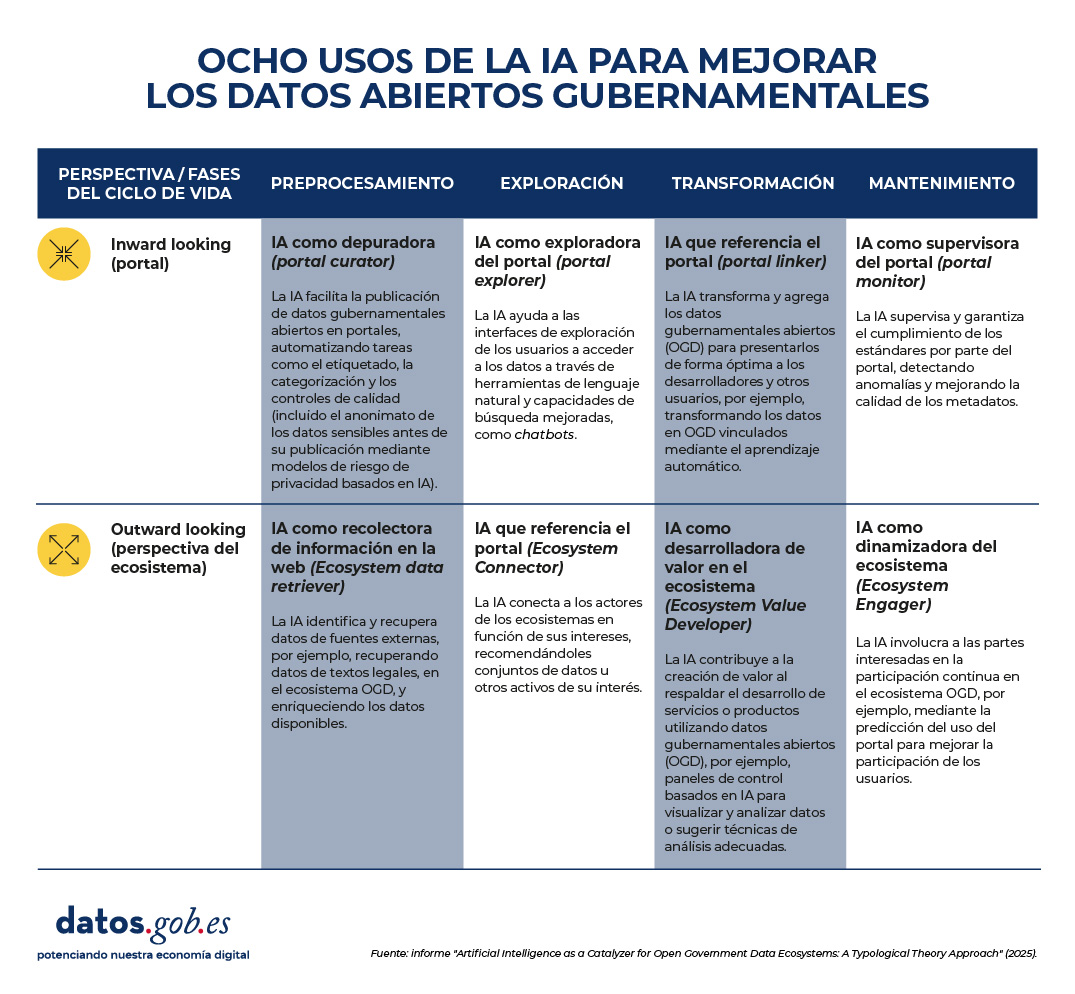

Una investigación reciente, desarrollada por universidades europeas, mapea cómo está sucediendo esta revolución silenciosa. El estudio propone una clasificación de los usos según en dos dimensiones:

- Perspectiva, que a su vez se divide en dos posibles vías:

- Inward-looking (portal): el foco está en las funciones internas de los portales de datos.

- Outward-looking (ecosistema): el foco se amplía a las interacciones con actores externos (ciudadanos, empresas, organizaciones).

- Fases del ciclo de vida del dato, las cuales podemos dividir en pre-procesamiento, exploración, transformación y mantenimiento.

En resumen, el informe identifica estos ocho tipos de uso de la IA en los datos abiertos gubernamentales, que se producen al cruzar las perspectivas y las fases en el ciclo de vida del dato.

Figura 1. Ocho uso de la IA para mejorar los datos abiertos gubernamentales. Fuente: presentación "Data for AI or AI for data: artificial intelligence as a catalyser for open government ecosystems", basada en el informe del mismo nombre, de los EU Open Data Days 2025.

A continuación, se detalla cada uno de estos usos:

1. IA como depuradora (portal curator)

Esta aplicación se centra en el pre-procesamiento de datos dentro del portal. La IA ayuda a organizar, limpiar, anonimizar y etiquetar datasets antes de su publicación. Algunos ejemplos de tareas son:

- Automatización y mejora de las tareas de publicación de datos.

- Realización de funciones de etiquetado automático y categorización.

- Anonimización de datos para proteger la privacidad.

- Limpieza y filtrado automático de conjuntos de datos.

- Extracción de características y manejo de datos faltantes.

2. IA como recolectora de datos del ecosistema (ecosystem data retriever)

También en la fase de pre-procesamiento, pero con un enfoque externo, la IA amplía la cobertura de los portales al identificar y recopilar información de fuentes diversas. Algunas tareas son:

- Recuperar datos estructurados desde textos legales o normativos.

- Minería de noticias para enriquecer datasets con información contextual.

- Integración de datos urbanos procedentes de sensores o registros digitales.

- Descubrimiento y enlace de fuentes heterogéneas.

- Conversión de documentos complejos en información estructurada.

3. IA como exploradora del portal (portal explorer)

En la fase de exploración, los sistemas de IA también pueden facilitar la búsqueda e interacción con los datos publicados, con un enfoque más interno. Algunos casos de uso:

- Desarrollar buscadores semánticos para localizar conjuntos de datos.

- Implementar chatbots que guíen a los usuarios en la exploración de datos.

- Proporcionar interfaces de lenguaje natural para consultas directas.

- Optimizar los motores de búsqueda internos del portal.

- Utilizar modelos de lenguaje para mejorar la recuperación de información.

4. IA como recolectora de información en la web (ecosystem connector)

Operando también en la fase de exploración, la IA actúa como un puente entre actores y recursos del ecosistema. Algunos ejemplos son:

- Recomendar datasets relevantes a investigadores o empresas.

- Identificar socios potenciales a partir de intereses comunes.

- Extraer temas emergentes para apoyar la formulación de políticas.

- Visualizar datos de múltiples fuentes en paneles interactivos.

- Personalizar sugerencias de datos basadas en actividades en redes sociales.

5. IA que referencia el portal (portal linker)

Esta funcionalidad se enfoca en la transformación de datos dentro del portal. Su función es facilitar la combinación y presentación de información para distintos públicos. Algunas tareas son:

- Convertir datos en grafos de conocimiento (estructuras que conectan información relacionada, conocidas como Linked Open Data).

- Resumir y simplificar datos con técnicas de PLN (Procesamiento del Lenguaje Natural).

- Aplicar razonamiento automático para generar información derivada.

- Potenciar la visualización multivariante de datasets complejos.

- Integrar datos diversos en productos de información accesibles.

6. IA como desarrolladora de valor en el ecosistema (ecosystem value developer)

En la fase de transformación y con mirada externa, la IA genera productos y servicios basados en datos abiertos que aportan valor añadido. Algunas tareas son:

- Sugerir técnicas analíticas adecuadas según el tipo de conjunto de datos.

- Asistir en la codificación y procesamiento de información.

- Crear paneles de control basados en análisis predictivo.

- Garantizar la corrección y coherencia de los datos transformados.

- Apoyar el desarrollo de servicios digitales innovadores.

7. IA como supervisora del portal (portal monitor)

Se centra en el mantenimiento del portal, con un enfoque interno. Su papel es garantizar la calidad, consistencia y cumplimiento de estándares. Algunas tareas son:

- Detectar anomalías y valores atípicos en conjuntos de datos publicados.

- Evaluar la consistencia de metadatos y esquemas.

- Automatizar procesos de actualización y depuración de datos.

- Identificar incidencias en tiempo real para su corrección.

- Reducir costes de mantenimiento mediante monitorización inteligente.

8. IA como dinamizadora del ecosistema (ecosystem engager)

Y, por último, esta función opera en la fase de mantenimiento, pero hacia afuera. Busca promover la participación ciudadana y la interacción continua. Algunas tareas son:

- Predecir patrones de uso y anticipar necesidades de los usuarios.

- Proporcionar retroalimentación personalizada sobre datasets.

- Facilitar la auditoría ciudadana de la calidad de los datos.

- Incentivar la participación en comunidades de datos abiertos.

- Identificar perfiles de usuarios para diseñar experiencias más inclusivas.

¿Qué nos dice la evidencia?

El estudio se basa en una revisión de más de 70 artículos académicos que examinan la intersección entre IA y los datos abiertos gubernamentales (open government data u OGD). A partir de estos casos, los autores observan que:

- Algunos de los perfiles definidos, como portal curator, portal explorer y portal monitor, están relativamente maduros y cuentan con múltiples ejemplos en la literatura.

- Otros, como ecosystem value developer y ecosystem engager, están menos explorados, aunque son los que más potencial tienen para generar impacto social y económico.

- La mayoría de las aplicaciones actuales se centran en automatizar tareas concretas, pero hay un gran margen para diseñar arquitecturas más integrales, que combinen varios tipos de IA en un mismo portal o en todo el ciclo de vida del dato.

Desde un punto de vista académico, esta tipología aporta un lenguaje común y una estructura conceptual para estudiar la relación entre IA y datos abiertos. Permite identificar vacíos en la investigación y orientar futuros trabajos hacia un enfoque más sistémico.

En la práctica, el marco es útil para:

- Gestores de portales de datos: les ayuda a identificar qué tipos de IA pueden implementar según sus necesidades, desde mejorar la calidad de los datasets hasta facilitar la interacción con los usuarios.

- Responsables políticos: les orienta sobre cómo diseñar estrategias de adopción de IA en iniciativas de datos abiertos, equilibrando eficiencia, transparencia y participación.

- Investigadores y desarrolladores: les ofrece un mapa de oportunidades para crear herramientas innovadoras que atiendan necesidades específicas del ecosistema.

Limitaciones y próximos pasos de la sinergia entre IA y open data

Además de las ventajas, el estudio reconoce algunas asignaturas pendientes que, en cierta manera, sirven como hoja de ruta para el futuro. Para empezar, varias de las aplicaciones que se han identificado están todavía en fases tempranas o son conceptuales. Y, quizá lo más relevante, aún no se ha abordado en profundidad el debate sobre los riesgos y dilemas éticos del uso de IA en datos abiertos: sesgos, privacidad, sostenibilidad tecnológica.

En definitiva, la combinación de IA y datos abiertos es todavía un terreno en construcción, pero con un enorme potencial. La clave estará en pasar de experimentos aislados a estrategias integrales, capaces de generar valor social, económico y democrático. La IA, en este sentido, no funciona de manera independiente a los datos abiertos: los multiplica y los hace más relevantes para gobiernos, ciudadanía y sociedad en general.

En un mundo donde la inmediatez cobra cada vez más importancia, el comercio predictivo se ha convertido en una herramienta clave para anticipar comportamientos de consumo, optimizar decisiones y ofrecer experiencias personalizadas. Ya no se trata solo de reaccionar ante las necesidades del cliente, sino de predecir lo que quiere incluso antes de que lo sepa.

En este artículo vamos a explicar qué es el comercio predictivo y la importancia de los datos abiertos en ello, incluyendo ejemplos reales.

¿Qué es el comercio predictivo?

El comercio predictivo es una estrategia basada en el análisis de datos para anticipar las decisiones de compra de los consumidores. Utiliza algoritmos de inteligencia artificial y modelos estadísticos para identificar patrones de comportamiento, preferencias y momentos clave en el ciclo de consumo. Gracias a ello, las empresas pueden conocer información relevante sobre qué productos serán más demandados, cuándo y dónde se realizará una compra o qué clientes tienen mayor probabilidad de adquirir una determinada marca.

Esto es de gran importancia en un mercado como el actual, donde existe una saturación de productos y competencia. El comercio predictivo permite a las empresas ajustar inventarios, precios, campañas de marketing o la logística en tiempo real, convirtiéndose en una gran ventaja competitiva.

El papel de los datos abiertos en el comercio predictivo

Estos modelos se alimentan de grandes volúmenes de datos: históricos de compra, navegación web, ubicación o comentarios en redes sociales, entre otros. Pero cuanto más precisos y diversos sean los datos, más afinadas serán las predicciones. Aquí es donde los datos abiertos juegan un papel fundamental, ya que permiten añadir nuevas variables a tener en cuenta a la hora de definir el comportamiento del consumidor. Entre otras cuestiones, los datos abiertos pueden ayudarnos a:

- Enriquecer modelos de predicción con información externa como datos demográficos, movilidad urbana o indicadores económicos.

- Detectar patrones regionales que influyen en el consumo, como, por ejemplo, el impacto del clima en la venta de ciertos productos estacionales.

- Diseñar estrategias más inclusivas al incorporar datos públicos sobre hábitos y necesidades de distintos grupos sociales.

La siguiente tabla muestra ejemplos de conjuntos de datos disponibles en datos.gob.es que pueden servir para estas tareas, a nivel nacional, aunque muchas comunidades autónomas y ayuntamientos también publican este tipo de datos junto a otros también de interés.

| Conjunto de datos | Ejemplo | Posible uso |

|---|---|---|

| Padrón municipal por edad y sexo | Instituto Nacional de Estadística (INE) | Segmenta poblaciones por territorio, edad y género. Es útil para personalizar campañas en base a la población mayoritaria de cada municipio o prever la demanda por perfil demográfico. |

| Encuesta de presupuestos familiares | Instituto Nacional de Estadística (INE) | Ofrece información sobre el gasto medio por hogar en diferentes categorías. Puede ayudar a anticipar patrones de consumo por nivel socioeconómico. |

| Índice de precio de consumo (IPC) | Instituto Nacional de Estadística (INE) | Desagrega el IPC por territorio, midiendo cómo varían los precios de bienes y servicios en cada provincia española. Tiene utilidad para ajustar precios y estrategias de penetración de mercado. |

| Avisos meteorológicos en tiempo real | Ministerio para la Transición Ecológica y Reto Demográfico | Alerta de fenómenos meteorológicos adversos. Permite correlacionar clima con ventas de productos (ropa, bebidas, calefacción, etc.). |

| Estadísticas de educación y alfabetización digital | Instituto Nacional de Estadística (INE) | Ofrece información sobre el uso de Internet en los últimos 3 meses. Permite identificar brechas digitales y adaptar las estrategias de comunicación o formación. |

| Datos sobre estancias turísticas | Instituto Nacional de Estadística (INE) | Informa sobre la estancia media de turistas por comunidades autónomas. Ayuda a anticipar demanda en zonas con alta afluencia estacional, como productos locales o servicios turísticos. |

| Número de recetas y gasto farmacéutico | Mutualidad General de Funcionarios Civiles del Estado (MUFACE) | Ofrece información del consumo de medicamentos por provincia y subgrupos de edad. Facilita la estimación de ventas de otros productos sanitarios y de parafarmacia relacionados al estimar cuántos usuarios irán a la farmacia. |

Figura 1. Tabla comparativa. Fuente: elaboración propia -datos.gob.es.

Casos de uso reales

Desde hace años, ya encontramos empresas que están utilizando este tipo de datos para optimizar sus estrategias comerciales. Veamos algunos ejemplos:

- Uso de datos meteorológicos para optimizar el stock en grandes supermercados

Los grandes almacenes Walmart utilizan algoritmos de IA que incorporan datos meteorológicos (como olas de calor, tormentas o cambios de temperatura) junto a datos históricos de ventas, eventos y tendencias digitales, para prever la demanda a nivel granular y optimizar inventarios. Esto permite ajustar automáticamente el reabastecimiento de productos críticos según patrones climáticos anticipados. Además, Walmart menciona que su sistema considera “datos futuros” como patrones climáticos macro (“macroweather”), tendencias económicas y demografía local para anticipar la demanda y posibles interrupciones en la cadena de suministro.

La firma Tesco también utiliza datos meteorológicos públicos en sus modelos predictivos. Esto le permite anticipar patrones de compra, como que por cada aumento de 10°C en la temperatura, las ventas de barbacoa se incrementan hasta en un 300%. Además, Tesco recibe pronósticos meteorológicos locales hasta tres veces al día, conectándolos con datos sobre 18 millones de productos y el tipo de clientes de cada tienda. Esta información se comparte con sus proveedores para ajustar los envíos y mejorar la eficiencia logística.

- Uso de datos demográficos para decidir la ubicación de locales

Desde hace años Starbucks ha recurrido a la analítica predictiva para planificar su expansión. La compañía utiliza plataformas de inteligencia geoespacial, desarrolladas con tecnología GIS, para combinar múltiples fuentes de información —entre ellas datos abiertos demográficos y socioeconómicos como la densidad de población, el nivel de ingresos, los patrones de movilidad, el transporte público o la tipología de negocios cercanos— junto con históricos de ventas propias. Gracias a esta integración, puede predecir qué ubicaciones tienen mayor potencial de éxito, evitando la competencia entre locales y asegurando que cada nueva tienda se sitúe en el entorno más adecuado.

Domino's Pizza también utilizó modelos similares para analizar si la apertura de un nuevo local en un barrio de Londres tendría éxito y cómo afectaría a otras ubicaciones cercanas, considerando patrones de compra y características demográficas locales.

Este enfoque permite predecir flujos de clientes y maximizar la rentabilidad mediante decisiones de localización más informadas.

- Datos socioeconómicos para fijar precios en base a la demografía

Un ejemplo interesante lo encontramos en SDG Group, consultora internacional especializada en analítica avanzada para retail. La compañía ha desarrollado soluciones que permiten ajustar precios y promociones teniendo en cuenta las características demográficas y socioeconómicas de cada zona -como la base de consumidores, la ubicación o el tamaño del punto de venta-. Gracias a estos modelos es posible estimar la elasticidad de la demanda y diseñar estrategias de precios dinámicos adaptados al contexto real de cada área, optimizando tanto la rentabilidad como la experiencia de compra.

El futuro del comercio predictivo

El auge del comercio predictivo se ha visto impulsado por el avance de la inteligencia artificial y la disponibilidad de datos, tanto abiertos como privados. Desde la elección del lugar ideal para abrir una tienda hasta la gestión eficiente de inventarios, los datos públicos combinados con analítica avanzada permiten anticipar comportamientos y necesidades de los consumidores con una precisión cada vez mayor.

No obstante, aún quedan retos importantes por afrontar: la heterogeneidad de las fuentes de datos, que en muchos casos carecen de estándares comunes; la necesidad de contar con tecnologías e infraestructuras sólidas que permitan integrar la información abierta con los sistemas internos de las empresas; y, por último, el desafío de garantizar un uso ético y transparente, que respete la privacidad de las personas y evite la generación de sesgos en los modelos.

Superar estos retos será clave para que el comercio predictivo despliegue todo su potencial y se convierta en una herramienta estratégica para empresas de todos los tamaños. En este camino, los datos abiertos jugarán un papel fundamental como motor de innovación, transparencia y competitividad en el comercio del futuro.

Los asistentes de inteligencia artificial (IA) ya forman parte de nuestro día a día: les preguntamos la hora, cómo llegar a un determinado lugar o les pedimos que reproduzcan nuestra canción favorita. Y aunque la IA, en el futuro, pueda llegar a ofrecernos infinitas funcionalidades, no hay que olvidar que la diversidad lingüística es aún una asignatura pendiente.

En España, donde conviven el castellano junto con lenguas cooficiales como el euskera, catalán, valenciano y gallego, esta cuestión cobra especial relevancia. La supervivencia y vitalidad de estas lenguas en la era digital depende, en gran medida, de su capacidad para adaptarse y estar presentes en las tecnologías emergentes. Actualmente, la mayoría de asistentes virtuales, traductores automáticos o sistemas de reconocimiento de voz no entienden todos los idiomas cooficiales. Sin embargo, ¿sabías que existen proyectos colaborativos para garantizar la diversidad lingüística?

En este post te contamos el planteamiento y los mayores avances de algunas iniciativas que están construyendo los cimientos digitales necesarios para que las lenguas cooficiales en España también prosperen en la era de la inteligencia artificial.

ILENIA, el paraguas coordinador de iniciativas de recursos multilingües en España

Los modelos que vamos a ver en este post comparten enfoque porque forman parte de ILENIA, coordinador a nivel estatal que conecta los esfuerzos individuales de las comunidades autónomas. Esta iniciativa agrupa los proyectos BSC-CNS (AINA), CENID (VIVES), HiTZ (NEL-GAITU) y la Universidad de Santiago de Compostela (NÓS), con el objetivo de generar recursos digitales que permitan desarrollar aplicaciones multilingües en las diferentes lenguas de España.

El éxito de estas iniciativas depende fundamentalmente de la participación ciudadana. A través de plataformas como Common Voice de Mozilla, cualquier hablante puede contribuir a la construcción de estos recursos lingüísticos mediante diferentes modalidades de colaboración:

- Habla leída: recopilar diferentes maneras de hablar a través de las donaciones de voz de un texto específico.

- Habla espontánea: crea datasets reales y orgánicos fruto de conversaciones con los prompts.

- Texto en idioma: colaborar en la transcripción de audios o en la aportación de contenido textual, sugiriendo nuevas frases o preguntas para enriquecer los corpus.

Todos los recursos se publican bajo licencias libres como CC0, permitiendo su uso gratuito por parte de investigadores, desarrolladores y empresas.

El reto de la diversidad lingüística en la era digital

Los sistemas de inteligencia artificial aprenden de los datos que reciben durante su entrenamiento. Para desarrollar tecnologías que funcionen correctamente en una lengua específica, es imprescindible contar con grandes volúmenes de datos: grabaciones de audio, corpus de texto y ejemplos de uso real del idioma.

En otras publicaciones de datos.gob.es hemos abordado el funcionamiento de los modelos fundacionales y las iniciativas en castellano como ALIA, entrenadas con grandes corpus de texto como los de la Real Academia Española.

En ambos posts se explica por qué la recopilación de datos lingüísticos no es una tarea barata ni sencilla. Las empresas tecnológicas han invertido masivamente en recopilar estos recursos para lenguas con gran número de hablantes, pero las lenguas cooficiales españolas se enfrentan a una desventaja estructural. Esto ha llevado a que muchos modelos no funcionen correctamente o no estén disponibles en valenciano, catalán, euskera o gallego.

No obstante, existen iniciativas colaborativas y de datos abiertos que permiten crear recursos lingüísticos de calidad. Se trata de los proyectos que varias comunidades autónomas han puesto en marcha marcando el camino hacia un futuro digital multilingüe.

Por un lado, el Proyecto Nós en Galicia crea recursos orales y conversacionales en gallego con todos los acentos y variantes dialectales para facilitar la integración a través de herramientas como GPS, asistentes de voz o ChatGPT. Un propósito similar el de Aina en Catalunya que además ofrece una plataforma académica y un laboratorio para desarrolladores o Vives en la Comunidad Valenciana. En el País Vasco también existe el proyecto Euskorpus que tiene como objetivo la constitución de un corpus de texto de calidad en euskera. Veamos cada uno de ellos.

Proyecto Nós, un enfoque colaborativo para el gallego digital

El proyecto ha desarrollado ya tres herramientas operativas: un traductor neuronal multilingüe, un sistema de reconocimiento de voz que convierte habla en texto, y una aplicación de síntesis de voz. Estos recursos se publican bajo licencias abiertas, garantizando su acceso libre y gratuito para investigadores, desarrolladores y empresas. Estas son sus características principales:

- Impulsado por: la Xunta de Galicia y la Universidad de Santiago de Compostela.

- Objetivo principal: crear recursos orales y conversacionales en gallego que capturen la diversidad dialectal y de acentos de la lengua.

- Cómo participar: el proyecto acepta contribuciones voluntarias tanto leyendo textos como respondiendo a preguntas espontáneas.

- Dona tu voz en gallego: https://doagalego.nos.gal

Aina, hacia una IA que entienda y hable catalán

Con un planteamiento similar al proyecto Nós, Aina busca facilitar la integración del catalán en los modelos de lenguaje de inteligencia artificial.

Se estructura en dos vertientes complementarias que maximizan su impacto:

- Aina Tech se centra en facilitar la transferencia tecnológica al sector empresarial, proporcionando las herramientas necesarias para traducir automáticamente al catalán webs, servicios y negocios en línea.

- Aina Lab impulsa la creación de una comunidad de desarrolladores a través de iniciativas como Aina Challenge, fomentando la innovación colaborativa en tecnologías del lenguaje en catalán. A través de esta convocatoria se han premiado 22 propuestas ya seleccionadas con un importe total de 1 millón para que ejecuten sus proyectos.

Las características del proyecto son:

- Impulsado por: la Generalitat de Catalunya en colaboración con el Barcelona Supercomputing Center (BSC-CNS)

- Objetivo principal: va más allá de la creación de herramientas, busca construir una infraestructura de IA abierta, transparente y responsable con el catalán.

- Cómo participar: puedes añadir comentarios, mejoras y sugerencias a través del buzón de contacto: https://form.typeform.com/to/KcjhThot?typeform-source=langtech-bsc.gitbook.io.

Vives, el proyecto colaborativo para IA en valenciano

Por otro lado, Vives recopila voces hablando en valenciano para que sirvan de entrenamiento a los modelos de IA.

- Impulsado por: el Centro de Inteligencia Digital de Alicante (CENID).

- Objetivo: busca crear corpus masivos de texto y voz, fomentar la participación ciudadana en la recolección de datos, y desarrollar modelos lingüísticos especializados en sectores como el turismo y el audiovisual, garantizando la privacidad de los datos.

- Cómo participar: puedes donar tu voz a través de este enlace: https://vives.gplsi.es/instruccions/.

Gaitu: inversión estratégica en la digitalización del euskera

En Euskera, podemos destacar Gaitu que busca recopilar voces hablando en euskera para poder entrenar los modelos de IA. Sus características son:

- Impulsado por: HiTZ, el centro vasco de tecnología de la lengua.

- Objetivo: desarrollar un corpus en euskera para entrenar modelos de IA.

- Cómo participar: puedes donar tu voz en euskera aquí https://commonvoice.mozilla.org/eu/speak.

Ventajas de construir y preservar modelos de lenguaje multilingües

Los proyectos de digitalización de las lenguas cooficiales trascienden el ámbito puramente tecnológico para convertirse en herramientas de equidad digital y preservación cultural. Su impacto se manifiesta en múltiples dimensiones:

- Para la ciudadanía: estos recursos garantizan que hablantes de todas las edades y niveles de competencia digital puedan interactuar con la tecnología en su lengua materna, eliminando barreras que podrían excluir a determinados colectivos del ecosistema digital.

- Para el sector empresarial: la disponibilidad de recursos lingüísticos abiertos facilita que empresas y desarrolladores puedan crear productos y servicios en estas lenguas sin asumir los altos costes tradicionalmente asociados al desarrollo de tecnologías lingüísticas.

- Para el tejido investigador, estos corpus constituyen una base fundamental para el avance de la investigación en procesamiento de lenguaje natural y tecnologías del habla, especialmente relevante para lenguas con menor presencia en recursos digitales internacionales.

El éxito de estas iniciativas demuestra que es posible construir un futuro digital donde la diversidad lingüística no sea un obstáculo sino una fortaleza, y donde la innovación tecnológica se ponga al servicio de la preservación y promoción del patrimonio cultural lingüístico.

En el campo de la ciencia de datos, la capacidad de construir modelos predictivos robustos es fundamental. Sin embargo, un modelo no es solo un conjunto de algoritmos, es una herramienta que debe ser comprendida, validada y, en última instancia, útil para la toma de decisiones.

Gracias a la transparencia y accesibilidad de los datos abiertos, tenemos la oportunidad única de trabajar en este ejercicio con información real, actualizada y de calidad institucional que refleja problemáticas ambientales. Esta democratización del acceso permite no solo desarrollar análisis rigurosos con datos oficiales, sino también contribuir al debate público informado sobre políticas ambientales, creando un puente directo entre la investigación científica y las necesidades sociales.

En este ejercicio práctico, nos sumergiremos en el ciclo de vida completo de un proyecto de modelado, utilizando un caso de estudio real: el análisis de la calidad del aire en Castilla y León. A diferencia de los enfoques que se centran únicamente en la implementación de algoritmos, nuestra metodología se enfoca en:

- Carga y exploración inicial de los datos: identificar patrones, anomalías y relaciones subyacentes que guiarán nuestro modelado.

- Análisis exploratorio orientado al modelado: construir visualizaciones y realizar ingeniería de características para optimizar el modelado.

- Desarrollo y evaluación de modelos de regresión: construir y comparar múltiples modelos iterativos para entender cómo la complejidad afecta el rendimiento.

- Aplicación del modelo y conclusiones: utilizar el modelo final para simular escenarios y cuantificar el impacto de posibles políticas ambientales.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

Arquitectura del Análisis

El núcleo de este ejercicio sigue un flujo estructurado en cuatro fases clave, como se ilustra en la Figura 1. Cada fase se construye sobre la anterior, desde la exploración inicial de los datos hasta la aplicación final del modelo.

Figura 1. Fases del proyecto de modelado predictivo.

Proceso de Desarrollo

1. Carga y exploración inicial de los datos

El primer paso es entender la materia prima de nuestro análisis: los datos. Utilizando un conjunto de datos de calidad del aire de Castilla y León, que abarca 24 años de mediciones, nos enfrentamos a desafíos comunes en el mundo real:

- Valores Faltantes: variables como el CO y el PM2.5 tienen una cobertura de datos limitada.

- Datos Anómalos: se detectan valores negativos y extremos, probablemente debidos a errores de los sensores.

A través de un proceso de limpieza y transformación, convertimos los datos brutos en un conjunto de datos limpio y estructurado, listo para el modelado.

2. Análisis exploratorio orientado al modelado

Una vez limpios los datos, buscamos patrones. El análisis visual revela una fuerte estacionalidad en los niveles de NO₂, con picos en invierno y valles en verano. Esta observación es crucial y nos lleva a la creación de nuevas variables (ingeniería de características), como componentes cíclicos para los meses, que permiten al modelo "entender" la naturaleza circular de las estaciones.

Figura 2. Variación estacional de los niveles de NO₂ en Castilla y León.

3. Desarrollo y evaluación de modelos de regresión

Con un conocimiento sólido de los datos, procedemos a construir tres modelos de regresión lineal de complejidad creciente:

- Modelo Base: utiliza solo los contaminantes como predictores.

- Modelo Estacional: añade las variables de tiempo.

- Modelo Completo: incluye interacciones y efectos geográficos.

La comparación de estos modelos nos permite cuantificar la mejora en la capacidad predictiva. El Modelo Estacional emerge como la opción óptima, explicando casi el 63% de la variabilidad del NO₂, un resultado notable para datos ambientales.

4. Aplicación del modelo y conclusiones

Finalmente, sometemos el modelo a un riguroso diagnóstico y lo utilizamos para simular el impacto de políticas ambientales. Por ejemplo, nuestro análisis estima que una reducción del 20% en las emisiones de NO podría traducirse en una disminución del 4.8% en los niveles de NO₂.

Figura 3. Rendimiento del modelo estacional. Los valores predichos se alinean bien con los valores reales.

¿Qué puedes aprender?

Este ejercicio práctico te permite aprender:

- Ciclo de vida de un proyecto de datos: desde la limpieza hasta la aplicación.

- Técnicas de regresión lineal: construcción, interpretación y diagnóstico.

- Manejo de datos temporales: captura de estacionalidad y tendencias.

- Validación de modelos: técnicas como la validación cruzada y temporal.

- Comunicación de resultados: cómo traducir hallazgos en insights accionables.

Conclusiones y Futuro

Este ejercicio demuestra el poder de un enfoque estructurado y riguroso en la ciencia de datos. Hemos transformado un conjunto de datos complejo en un modelo predictivo que no solo es preciso, sino también interpretable y útil.

Para aquellos interesados en llevar este análisis al siguiente nivel, las posibilidades son numerosas:

- Incorporación de datos meteorológicos: variables como la temperatura y el viento podrían mejorar significativamente la precisión.

- Modelos más avanzados: explorar técnicas como los Modelos Aditivos Generalizados (GAM) u otros algoritmos de machine learning.

- Análisis espacial: investigar cómo varían los patrones de contaminación entre diferentes ubicaciones.

En resumen, este ejercicio no solo ilustra la aplicación de técnicas de regresión, sino que también subraya la importancia de un enfoque integral que combine el rigor estadístico con la relevancia práctica.

¿Cuántas veces has tenido entre tus manos un conjunto de datos que necesitabas analizar, pero te has encontrado con errores, inconsistencias o problemas de formato que te han hecho perder horas de trabajo? La realidad es que, aunque cada día tenemos más datos disponibles, no siempre contamos con las herramientas o conocimientos necesarios para trabajar con ellos de manera eficiente.

Para abordar este proceso existen varias opciones. Una de ellas es Open Data Editor, una herramienta gratuita y de código abierto que Open Knowledge Foundation (OKFN) ha diseñado pensando en democratizar el acceso y la explotación de los datos.

Características principales y funcionalidades

Tal y como indican desde OKFN, esta aplicación está diseñada para personas que trabajan con datos tabulares (Excel, Google Sheets, CSV) y que no saben programar o no tienen acceso a herramientas técnicas especializadas. Su enfoque sin código la convierte en una alternativa accesible que se centra específicamente en la limpieza y validación de datos tabulares.

La herramienta implementa un proceso conocido como "validación de datos", que consiste en encontrar errores en conjuntos de datos y corregirlos de manera eficiente. Además, verifica que las hojas de cálculo o conjuntos de datos contengan toda la información necesaria para que otras personas puedan utilizarlos. Por lo tanto, también tiene en cuenta la interoperabilidad, un valor muy relevante en lo que respecta a la reutilización de datasets.

Más allá de garantizar la reutilización, Open Data Editor también vela por la privacidad y seguridad gracias a su arquitectura local, es decir, los datos permanecen en el dispositivo del usuario.

Proyectos piloto: impacto global y resultados tangibles

A pesar de que se trata de una herramienta muy intuitiva, la organización pone a disposición del usuario un curso online y gratuito para aprender a sacarle el máximo partido. Actualmente el curso está en inglés, pero la traducción al español estará disponible próximamente.

Además del curso principal, la Open Knowledge Foundation ha implementado un programa de “formación de formadores” que capacita a personas para que puedan impartir el curso localmente en diferentes regiones del mundo. En el marco de este programa de formación se están ejecutando proyectos piloto aplicados a diferentes sectores y comunidades. Estos proyectos piloto se han enfocado especialmente en incentivar el acceso a formación básica en herramientas de análisis de datos de calidad, algo que, OKFN considera que no debe estar limitado por barreras económicas o tecnológicas.

Los casos de uso documentados muestran aplicaciones diversas que van desde organizaciones de derechos humanos hasta instituciones gubernamentales locales, todas aprovechando las capacidades de validación y limpieza de datos que ofrece la herramienta. El enfoque educativo de Open Data Editor va más allá del simple uso de la herramienta: se trata de formar en open data y promover el conocimiento abierto y accesible.

Próximos pasos: integración de inteligencia artificial

Los resultados de esta primera fase han sido tan prometedores que la Open Knowledge Foundation ha decidido avanzar hacia una segunda etapa, esta vez incorporando tecnologías de inteligencia artificial para ampliar aún más las capacidades de la herramienta. La nueva versión, que ofrece asistencia de IA enfocada en validación y características que generen confianza, acaba de ser anunciada y lanzada.

La filosofía detrás de esta integración de IA es mantener el carácter educativo de la herramienta. En lugar de crear una "caja negra" que simplemente proporcione resultados, la nueva funcionalidad explicará cada paso que realiza la inteligencia artificial, permitiendo que los usuarios comprendan no solo qué se está haciendo con sus datos, sino también por qué se están tomando ciertas decisiones.

Esta aproximación transparente a la IA es especialmente importante en el contexto de datos abiertos y gubernamentales, tal y como explicamos en este episodio del pódcast de datos.gob.es. Los usuarios de Open Data Editor podrán ver cómo la IA identifica problemas potenciales, sugiere correcciones y valida la calidad de los datos, convirtiéndose en una herramienta de aprendizaje además de una utilidad práctica.

Impacto en el ecosistema open data

Esta nueva funcionalidad se sumará al propósito por ofrecer una herramienta sostenible y abierta. Es precisamente este compromiso con el código abierto lo que hace que Open Data Editor pueda ser adaptada y mejorada por la comunidad global de desarrolladores. Para ello, utilizan como base tecnológica el Framework Frictionless, que asegura que los estándares utilizados sean abiertos y ampliamente adoptados en el ecosistema de datos abiertos.

No hay duda de que la herramienta está especialmente alineada con los principios de datos abiertos gubernamentales, proporcionando a las Administraciones públicas una manera de mejorar la calidad de sus publicaciones de datos sin requerir inversiones significativas en infraestructura técnica o capacitación especializada. Para periodistas de datos y organizaciones de la sociedad civil, Open Data Editor ofrece la capacidad de trabajar con conjuntos de datos complejos de manera más eficiente, permitiendo que se concentren en el análisis y la interpretación en lugar de en la limpieza técnica de los datos.

En definitiva, más que una herramienta técnica, Open Data Editor simboliza un cambio paradigmático hacia la democratización del análisis de datos. Porque su impacto se extiende más allá de sus funcionalidades inmediatas, contribuyendo a un ecosistema más amplio de datos abiertos y accesibles.

En un mundo cada vez más complejo, las decisiones públicas necesitan más que intuición: requieren evidencia científica. Aquí es donde entran en juego las iniciativas de I+P (Innovación + Política Pública): una intersección entre creatividad, conocimiento basado en datos y acción política.

En este artículo vamos a explicar este concepto, incluyendo ejemplos e información sobre programas de financiación.

¿Qué es I+P?

I+P no es una fórmula matemática, sino una práctica estratégica que combina el conocimiento científico, la investigación y la participación ciudadana para mejorar la formulación, implementación y evaluación de políticas públicas. No se trata únicamente de aplicar tecnología a lo público, sino de repensar cómo se toman las decisiones, cómo se formulan soluciones y cómo se involucra a la sociedad en estos procesos a través de la aplicación de metodologías científicas.

Esta idea nace del concepto “ciencia para las políticas públicas”, también conocida como “ciencia para la política” o “Science for Policy” (S4P) e implica la colaboración activa entre las administraciones públicas y la comunidad científica.

Las iniciativas de I+P promueven la evidencia empírica y la experimentación. Para ello, impulsan el uso de datos, tecnologías emergentes, pruebas piloto, metodologías ágiles y ciclos de retroalimentación que ayudan a diseñar políticas más eficientes y eficaces, centradas en las necesidades reales de la ciudadanía. Gracias a ello se facilita la toma de decisiones en tiempo real y la posibilidad de realizar ajustes ágiles ante situaciones que requieren respuestas rápidas. En definitiva, se trata de dar respuestas más creativas y acertadas a los retos de hoy en día, como pueden ser el cambio climático o la desigualdad digital, áreas donde las políticas tradicionales se pueden quedar cortas.

El siguiente visual resume estos y otros beneficios.

Fuente: Convocatoria de innovación pública de FECYT- adaptado por datos.gob.es.

Ejemplos de iniciativas de I+P

El uso de datos para la toma de decisiones políticas quedó patente durante la pandemia de COVID-19, donde los responsables políticos iban adaptando las medidas a tomar en base a los reportes de instituciones como la Organización Mundial de la Salud (OMS). Pero más allá de este tipo de acontecimientos extraordinarios, hoy en día encontramos iniciativas consolidadas que buscan cada vez más promover la innovación y la toma de decisiones fundamentada en datos científicos en el ámbito público de forma continua. Veamos dos ejemplos.

-

Informes periódicos de instituciones científicas para acercar el conocimiento científico a la toma de decisiones públicas

Los informes científicos sobre temas como el cambio climático, la resistencia bacteriana o la producción alimentaria son ejemplos de cómo la ciencia puede orientar decisiones políticas informadas.

La iniciativa Science4Policy del Consejo Superior de Investigaciones Científicas (CSIC) es un ejemplo de ello. Se trata de una colección de informes temáticos que presentan evidencias sólidas, generadas en sus centros de investigación, sobre problemas sociales relevantes. Cada informe incluye:

- Una introducción al problema y su impacto social.

- Información sobre la investigación desarrollada por el CSIC sobre el tema.

- Conclusiones y recomendaciones para políticas públicas.

Su objetivo principal es transformar el conocimiento científico en aportaciones accesibles para públicos no especializados, facilitando así decisiones informadas por parte de los poderes públicos.

-

Los laboratorios de innovación pública, un espacio para la creatividad basada en la ciencia

Los laboratorios de innovación pública o GovLabs son espacios experimentales que permiten a empleados públicos, científicos, expertos en diversas materias y ciudadanos co-crear políticas, prototipar soluciones y aprender de forma iterativa.

Un ejemplo es el Laboratorio de Innovación Pública (LIP) impulsado por el Instituto Nacional de Administración Pública (INAP), donde se han realizado pilotos sobre el uso de tecnologías para impulsar el puesto de trabajo de nueva generación, la colaboración intermunicipal para compartir talento o la descentralización de pruebas selectivas. Además, cuentan con un Catálogo de Recursos de Innovación donde se recopilan herramientas con licencias abiertas puestas en marcha por diversos organismos y que pueden servir de apoyo a los emprendedores públicos.

También cabe la pena destacar a la Red Española de Innovación Pública y Transferencia Científica, impulsada por la Fundación NovaGob. Es un espacio colaborativo que reúne a profesionales, administraciones públicas, universidades y organizaciones del tercer sector con el objetivo de transformar la gestión pública en España. A través de grupos de trabajo y repositorios de buenas prácticas, impulsa el uso de la inteligencia artificial, la simplificación administrativa y la mejora de la atención ciudadana.

También encontramos laboratorios de innovación pública a nivel regional, como, por ejemplo Govtechlab Madrid, un proyecto liderado por la Fundación para el Conocimiento madri+d que conecta startups y pymes digitales con instituciones públicas para resolver retos reales. Durante el curso 2023/2024, lanzaron 9 pilotos, por ejemplo, para recopilar y analizar la opinión de la ciudadanía para tomar mejores decisiones en el Ayuntamiento de Alcobendas, unificar la toma y gestión de datos en las inscripciones de las actividades del Área de Juventud del Ayuntamiento de Boadilla del Monte o proporcionar información veraz y actualizada de manera digital sobre el tejido comercial mostoleño.

El papel de los gobiernos e instituciones públicas

La innovación en política pública puede estar impulsada por una diversidad de actores: administraciones públicas abiertas al cambio, universidades y centros de investigación, startups cívicas y empresas tecnológicas, organizaciones de la sociedad civil o ciudadanos comprometidos.

La Comisión Europea, por ejemplo, desempeña un papel clave en el fortalecimiento del ecosistema de ciencia para la política en Europa, promoviendo el uso efectivo del conocimiento científico en la toma de decisiones a todos los niveles: europeo, nacional, regional y local. A través de programas como Horizonte Europa y la Agenda de Política del Espacio Europeo de Investigación 2025-2027, se impulsan acciones para desarrollar capacidades, compartir buenas prácticas y alinear la investigación con las necesidades sociales.

En España también encontramos acciones como la reciente convocatoria de financiación de la Fundación Española para la Ciencia y la Tecnología (FECYT), el Ministerio de Ciencia, Innovación y Universidades, y la Oficina Nacional de Asesoramiento Científico, cuyo objetivo es impulsar:

- Proyectos de investigación que generen nuevas evidencias científicas aplicables al diseño de políticas públicas (Categoría A).

- Actividades de asesoramiento científico y transferencia de conocimiento entre investigadores y responsables públicos (Categoría B).

Los proyectos pueden recibir hasta 100.000 euros (Categoría A) o 25.000 euros (Categoría B), cubriendo hasta el 90% del coste total. Pueden participar organismos de investigación, universidades, entidades sanitarias, centros tecnológicos, centros de I+D y otros actores que promuevan la transferencia de la I+D. El plazo para solicitar la ayuda finaliza el próximo 17 de septiembre de 2025. Para más información, se deben visitar las bases de la convocatoria o asistir a algunas sesiones formativas que se están realizando.

Conclusión

En un mundo donde los desafíos sociales, económicos y medioambientales son cada vez más complejos, necesitamos nuevas formas de pensar y actuar desde las instituciones públicas. Por ello, I+P no es una moda, es una necesidad que nos permite pasar del “creemos que funciona” al “sabemos que funciona”, fomentando una política más adaptativa, ágil y eficaz.

Un año más, la Junta de Castilla y León ha lanzado su concurso de datos abiertos para premiar el uso innovador de la reutilización de la información pública.

En este post, te resumimos los detalles para participar en la IX edición de este evento, que es una oportunidad tanto para profesionales como para estudiantes, personas creativas o equipos multidisciplinares que deseen dar visibilidad a su talento a través de la reutilización de datos públicos.

¿En qué consiste la competición?

El objetivo del concurso es reconocer proyectos que utilicen conjuntos de datos abiertos de la Junta de Castilla y León. Estos datasets pueden combinarse, si así lo desean los participantes, con otras fuentes públicas o privadas, de cualquier nivel de la administración.

Los proyectos pueden presentarse en cuatro categorías:

- Categoría Ideas: orientada a personas o equipos que quieran presentar una propuesta para crear un servicio, estudio, aplicación, sitio web o cualquier otro tipo de desarrollo. No es necesario que el proyecto esté finalizado; lo importante es que la idea sea original, viable y tenga un impacto potencial positivo.

- Categoría Productos y Servicios: pensada para proyectos ya desarrollados y accesibles para la ciudadanía, como servicios online, aplicaciones móviles o sitios web. Todos los desarrollos deben estar disponibles a través de una URL pública. Esta categoría incluye un premio específico para estudiantes matriculados en enseñanzas oficiales durante los cursos lectivos 2024/2025 o 2025/2026.

- Categoría Recurso Didáctico: se dirige a proyectos educativos que utilicen datos abiertos como herramienta de apoyo en el aula. El objetivo es fomentar la enseñanza innovadora mediante recursos con licencia Creative Commons, que puedan ser compartidos y reutilizados por docentes y alumnado.

- Categoría Periodismo de Datos: premiará trabajos periodísticos publicados o actualizados de forma relevante, en formato escrito o audiovisual, que hagan uso de los datos abiertos para informar, contextualizar o analizar temas de interés para la ciudadanía. Las piezas periodísticas deberán haber sido publicadas en un medio de comunicación impreso o digital desde el día 24 de septiembre de 2024, día siguiente a la fecha de finalización del plazo de presentación de candidaturas de la convocatoria de premios inmediatamente anterior.

En todas las categorías, es imprescindible que se utilice al menos un conjunto de datos del portal de datos abiertos de la Junta de Castilla y León. Esta plataforma cuenta con centenares de datasets sobre diferentes sectores como medio ambiente, economía, sociedad, administración pública, cultura, educación, etc. que pueden aprovecharse como base para desarrollar ideas útiles, informativas y transformadoras.

¿Quién puede participar?

El concurso está abierto a cualquier persona física o jurídica, que se puede presentar de manera individual como en grupo. Además, puedes presentar más de una candidatura incluso para distintas categorías. Aunque un mismo proyecto no podrá recibir más de un premio, esta flexibilidad permite que una misma idea se explore desde diferentes enfoques: educativo, periodístico, técnico o conceptual.

¿Qué premios se otorgan?

La edición de 2025 del concurso contempla premios con dotación económica, diploma acreditativo y difusión institucional a través del portal de datos abiertos y otros canales de comunicación de la Junta.

El reparto y la cuantía de los premios por categoría es:

- Categoría Ideas

- Primer premio: 1.500 €

- Segundo premio: 500 €

- Categoría Productos y Servicios

- Primer premio: 2.500 €

- Segundo premio: 1.500 €

- Tercer premio: 500 €

- Premio especial estudiantes: 1.500 €

- Categoría Recurso Didáctico

- Primer premio: 1.500 €

- Categoría Periodismo de Datos

- Primer premio: 1.500 €

- Segundo premio: 1.000 €

¿Bajo qué criterios se otorgan los premios? El jurado valorará las candidaturas teniendo en cuenta diferentes criterios de valoración, conforme recogen las bases y la orden de convocatoria, entre los que se encuentran su originalidad, utilidad social, calidad técnica, viabilidad, impacto, valor económico y grado de innovación.

¿Cómo participar?

Como ya pasaba en otras ediciones, las candidaturas podrán presentarse de dos maneras:

- Presencial, en el Registro General de la Consejería de la Presidencia, en las oficinas de asistencia en materia de registros de la Junta de Castilla y León o en los lugares establecidos en el artículo 16.4 de la Ley 39/2015.

- Electrónica, a través de la sede electrónica de la Junta de Castilla y León

Cada solicitud debe incluir:

- Datos identificativos del autor o autores.

- Título del proyecto.

- Categoría o categorías a las que se presenta.

- Una memoria explicativa del proyecto, con una extensión máxima de 1.000 palabras, aportando toda aquella información que pueda ser valorada por el jurado conforme al baremo establecido.

- En el caso de presentar candidatura a la categoría Productos y Servicios, se especificará la URL de acceso al proyecto

La fecha límite para enviar propuestas es el 22 de septiembre de 2025

Con este certamen, la Junta de Castilla y León reafirma su compromiso con la política de datos abiertos y la cultura de la reutilización. El concurso no solo reconoce la creatividad, la innovación y la utilidad de los proyectos presentados, sino que también contribuye a divulgar el potencial transformador de los datos abiertos en áreas como la educación, el periodismo, la tecnología o el emprendimiento social.

En ediciones anteriores, se han premiado soluciones para mejorar la movilidad, mapas interactivos sobre incendios forestales, herramientas para el análisis del gasto público o recursos educativos sobre el medio rural, entre muchos otros ejemplos. Puedes leer más sobre las propuestas ganadoras del año pasado y otras, en nuestro portal. Además, todos estos proyectos pueden consultarse en el histórico de ganadores disponible en el portal open data de la comunidad.

¡Te animamos a participar en el concurso y sacar el máximo provecho a los datos abiertos de Castilla y León!