Casi la mitad de los adultos europeos carecen de competencias digitales básicas. De acuerdo con el último informe sobre el estado de la Década Digital, en 2023, solo el 55,6% de los ciudadanos declararon tener este tipo de capacidades. Este porcentaje crece al 66,2% en el caso de España, situado por delante de la media europea.

Tener capacidades digitales básicas es esencial en la sociedad actual, porque permite acceder a una mayor cantidad de información y servicios, así como comunicarse de manera efectiva en entornos online, facilitando una mayor participación en actividades cívicas y sociales. Y también supone una gran ventaja competitiva en el mundo laboral.

En Europa, más del 90% de las funciones profesionales requieren un nivel básico de conocimientos digitales. Hace mucho tiempo que el conocimiento tecnológico dejó de ser únicamente necesario para profesiones técnicas, sino que se está extendiendo a todos los sectores, desde las empresas hasta el transporte e incluso la agricultura. En este sentido, más del 70% de las empresas han afirmado que la falta de personal con las competencias digitales adecuadas es un obstáculo para la inversión.

Por ello, un objetivo clave de la Década Digital es garantizar que al menos el 80% de las personas de entre 16 y 74 años posean al menos competencias digitales básicas de aquí a 2030

Capacidades tecnológicas básicas que todos deberíamos tener

Cuando hablamos de capacidades tecnológicas básicas nos referimos, de acuerdo con el framework DigComp, a diversas áreas, entre las que se encuentran:

- Alfabetización informacional y de datos: incluye localizar, recuperar, gestionar y organizar datos, juzgando la pertinencia de la fuente y su contenido.

- Comunicación y colaboración: supone interactuar, comunicarse y colaborar a través de las tecnologías digitales teniendo en cuenta la diversidad cultural y generacional. También incluye la gestión de la propia presencia, identidad y reputación digitales.

- Creación de contenidos digitales: se definiría como la mejora e integración de información y contenidos para generar nuevos mensajes, respetando los derechos de autor y las licencias. También implica saber dar instrucciones comprensibles para un sistema informático.

- Seguridad: se circunscribe a la protección de dispositivos, contenidos, datos personales y la intimidad en los entornos digitales, para proteger la salud física y mental.

- Resolución de problemas: permite identificar y resolver necesidades y problemas en entornos digitales. También se enfoca en el uso de herramientas digitales para innovar procesos y productos, manteniéndose al día de la evolución digital.

¿Qué puestos de trabajo relacionados con datos son los más demandados?

Una vez que tenemos claro cuáles son las competencias básicas, cabe destacar que en un mundo donde cada vez cobra más importancia la digitalización no es de extrañar que también crezca la demanda de conocimientos tecnológicos avanzados y relacionados con los datos.

De acuerdo con los datos de la plataforma de empleo LinkedIn, entre las 25 profesiones que más crecen en España en 2024 encontramos analistas de seguridad (puesto 1), analistas de desarrollo de software (2), ingenieros de datos (11) e ingenieros de inteligencia artificial (25). Datos similares ofrece el Mapa del Empleo de Fundación Telefónica, que además destaca cuatro de los perfiles más demandados relacionados con los datos:

- Analista de datos: encargados de la gestión y aprovechamiento de la información, se dedican a la recopilación, análisis y explotación de los datos, para lo cual suelen recurrir a la creación de cuadros de mando e informes.

- Diseñador/a o administrador/a de bases de datos: enfocados en diseñar, implementar y gestionar bases de datos. Así como mantener su seguridad, ejecutando procedimientos de respaldo y recuperación de datos en caso de fallos.

- Ingeniero/a de datos: responsables del diseño e implementación de arquitecturas de datos e infraestructuras para captar, almacenar, procesar y acceder a los datos, optimizando su rendimiento y garantizando su seguridad.

- Científico/a de datos: centrado en el análisis de datos y modelado predictivo, la optimización de algoritmos y la comunicación de resultados.

Todos ellos son puestos con buenos salarios y expectativas de futuro, en los que sin embargo sigue existiendo una gran brecha entre hombres y mujeres. De acuerdo con datos europeos, sólo 1 de cada 6 especialistas en TIC y 1 de cada 3 licenciados en ciencias, tecnología, ingeniería y matemáticas (STEM) son mujeres.

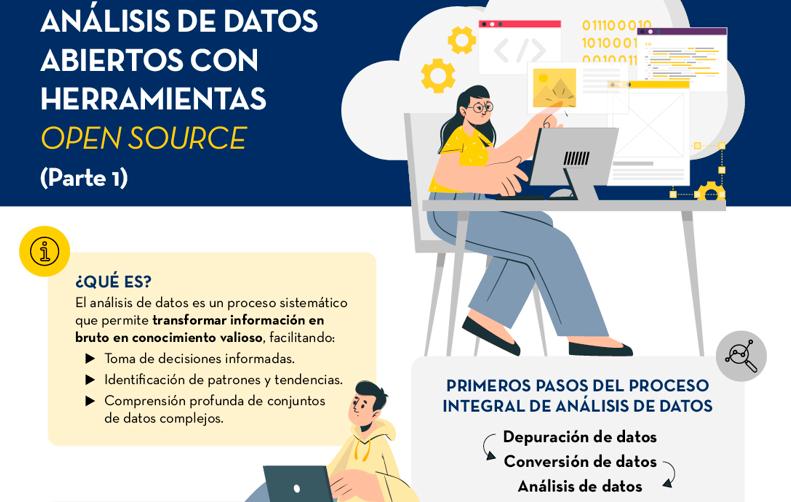

Para desarrollar profesiones relacionadas con los datos, se necesitan, entre otros, conocimientos de lenguajes de programación populares como Python, R o SQL, y múltiples herramientas de procesado y visualización de datos, como las detalladas en estos artículos:

- Herramientas de depuración y conversión de datos

- Herramientas de análisis de datos

- Herramientas de visualización de datos

- Librerías y APIs de visualización de datos

- Herramientas de visualización geoespacial

- Herramientas de análisis de redes

Actualmente la oferta de formaciones sobre todas estas capacidades no deja de crecer.

Perspectivas de futuro

Casi una cuarta parte de todos los puestos de trabajo (23%) cambiarán en los próximos cinco años, de acuerdo con el Informe sobre el Futuro del Empleo 2023 del Foro Económico Mundial. Los avances tecnológicos crearán nuevos empleos, transformarán los existentes y destruirán aquellos que se queden anticuados. Los conocimientos técnicos, relacionados con áreas como la inteligencia artificial o el Big Data, y el desarrollo de habilidades cognitivas, como el pensamiento analítico, supondrán grandes ventajas competitivas en el mercado laboral del futuro. En este contexto, las iniciativas políticas para impulsar la recapacitación de la sociedad, como el Plan europeo de Acción de Educación Digital (2021-2027), ayudaran a generar marcos y certificados comunes en un mundo en constante evolución.

La revolución tecnológica ha venido para quedarse y continuará cambiando nuestro mundo. Por ello, quienes antes empiecen a adquirir nuevas capacidades, tendrán una posición más ventajosa en el panorama laboral futuro.

La ciencia ciudadana se está consolidando como una de las fuentes de referencia más relevantes en la investigación contemporánea. Así lo reconoce el Centro Superior de Investigaciones Científicas (CSIC) que define la ciencia ciudadana como una metodología y un medio para el fomento de la cultura científica en la que confluyen estrategias propias de la ciencia y de la participación ciudadana.

Ya hablamos hace un tiempo de la importancia que la ciencia ciudadana tenía en la sociedad. Hoy en día, los proyectos de ciencia ciudadana no solo han aumentado en número, diversidad y complejidad, sino que también han impulsado un significativo proceso de reflexión sobre cómo la ciudadanía puede contribuir activamente a la generación de datos y conocimiento.

Para llegar a este punto, programas como Horizonte 2020, que reconocía explícitamente la participación ciudadana en ciencia, han jugado un papel fundamental. Más en concreto, el capítulo "Ciencia con y para la sociedad” dio un importante empuje a este tipo de iniciativas en Europa y también en España. De hecho, a raíz de la participación española en dicho programa, así como en iniciativas paralelas, los proyectos españoles han ido aumentando su envergadura y las conexiones con iniciativas internacionales.

Este creciente interés por la ciencia ciudadana también se traduce en políticas concretas. Ejemplo de ello es la actual Estrategia Española de Ciencia, Tecnología e Innovación (EECTI), para el periodo 2021-2027 que incluye “la responsabilidad social y económica de la I+D+I a través de la incorporación de la ciencia ciudadana”.

En definitiva, comentamos hace un tiempo, las iniciativas de ciencia ciudadana buscan incentivar una ciencia más democrática, que responda a los intereses de toda la ciudadanía y que genere información que se pueda reutilizar en pro de la sociedad. A continuación, mostramos algunos ejemplos de proyectos de ciencia ciudadana que ayudan a recolectar datos cuya reutilización puede tener un impacto positivo en la sociedad:

Proyecto AtmOOs Academic: Educación y ciencia ciudadana sobre contaminación atmosférica y movilidad.

En este programa, Thigis desarrolló una prueba piloto de ciencia ciudadana sobre movilidad y medio ambiente con los alumnos de un colegio del distrito del Eixample de Barcelona. Este proyecto, que ya es replicable en otros centros educativos, consiste en recoger datos de patrones de movilidad del alumnado para analizar cuestiones relacionadas con la sostenibilidad.

En la web de AtmOOs Academic se pueden visualizar los resultados de todas las ediciones que llevan realizándose anualmente desde el curso 2017-2018 y muestran información sobre los vehículos que emplean los alumnos para ir a clase o las emisiones generadas según etapa escolar.

WildINTEL: Proyecto de investigación sobre el monitoreo de vida en Huelva

La Universidad de Huelva y la Agencia Estatal de Investigaciones Científicas (CSIC) colaboran para construir un sistema de monitoreo de vida silvestre para obtener las variables esenciales de biodiversidad. Para llevarlo a cabo, se utilizan cámaras de fototrampeo de captura remota de datos e inteligencia artificial.

El proyecto WildINTEL se centra en el desarrollo de un sistema de monitoreo que sea escalable y reproducible, facilitando así la recolección y gestión eficiente de datos sobre biodiversidad. Este sistema incorporará tecnologías innovadoras para proporcionar estimaciones demográficas precisas y objetivas de las poblaciones y comunidades.

A través de este proyecto, que empezó en diciembre de 2023 y seguirá ejecutándose hasta diciembre de 2026, se espera conseguir herramientas y productos para mejorar la gestión de la biodiversidad no solo en la provincia de Huelva sino en toda Europa.

IncluScience-Me: Ciencia ciudadana en el aula para impulsar la cultura científica y la conservación de la biodiversidad.

Este proyecto de ciencia ciudadana que combina educación y biodiversidad surge de la necesidad de abordar la investigación científica en las escuelas. Para ello, el alumnado toma el rol de persona investigadora para abordar un reto real: rastrear e identificar los mamíferos que habitan en sus entornos cercanos para ayudar a la actualización de un mapa de distribución y, por ende, a su conservación.

IncluScience-Me nace en la Universidad de Córdoba y, en concreto, en el Grupo de Investigación en Educación y Gestión de la Biodiversidad (Gesbio), y ha sido posible gracias a la participación de la Universidad de Castilla-La Mancha y el Instituto de Investigación en Recursos Cinegéticos de Ciudad Real (IREC), con la colaboración de la Fundación Española para la Ciencia y la Tecnología - Ministerio de Ciencia, Innovación y Universidades.

La Memoria del Rebaño: Corpus documental de la vida pastoril.

Este proyecto de ciencia ciudadana que lleva activo desde julio de 2023 tiene como objetivo recabar conocimientos y experiencias de pastores y pastoras, en activo y jubilados, sobre el manejo de rebaños y la actividad ganadera.

La entidad responsable del programa es el Institut Català de Paleoecología Humana i Evolució Social aunque también colaboran el Museu Etnogràfic de Ripoll, Institució Milà i Fontanals-CSIC, Universidad Autònoma de Barcelona y Universidad Rovira i Virgili.

A través del programa, se ayuda a interpretar el registro arqueológico y contribuye a conservar los conocimientos de la práctica pastoril. Además, pone en valor la experiencia y los conocimientos de las personas mayores, un trabajo que contribuye a acabar con la connotación negativa de la “vejez” en una sociedad que prima la “juventud”, es decir, que pasen de ser considerados sujetos pasivos a ser considerados sujetos sociales activos.

Plastic Pirates España: Estudio de la contaminación por plástico en ríos europeos.

Es un proyecto de ciencia ciudadana que se ha llevado a cabo durante el último año con jóvenes de entre 12 y 18 años de las comunidades de Castilla y León y Cataluña pretende contribuir a generar evidencias científicas y concienciación ambiental sobre los residuos plásticos en los ríos.

Para ello, grupos de jóvenes de diferentes centros educativos, asociaciones y agrupaciones juveniles, han participado en campañas de muestreo donde se recogen datos de la presencia de residuos y basuras, principalmente plásticos y microplásticos en las riberas y agua de los ríos.

En España este proyecto lo ha coordinado el Centro Tecnológico BETA de la Universidad de Vic - Universidad Central de Cataluña junto a la Universidad de Burgos y la Fundación Oxígeno. Puedes acceder a más información en su página web.

Estos son algunos ejemplos de proyectos de ciencia ciudadana. Puedes consultar más en el Observatorio de Ciencia Ciudadana en España, una iniciativa que recoge múltiples recursos didácticos, informes y más información de interés sobre la ciencia ciudadana y su impacto en España. ¿Conoces algún otro proyecto? Mándanoslo a dinamizacion@datos.gob.es y podemos darlo a conocer a través de nuestros canales de difusión.

En la era digital actual, la compartición de datos y los datos abiertos (open data) han emergido como pilares fundamentales para la innovación, la transparencia y el desarrollo económico. Diversas compañías y organizaciones alrededor del mundo están adoptando estos enfoques para fomentar el acceso abierto a la información y potenciar la toma de decisiones basada en datos. A continuación, exploramos algunos ejemplos internacionales y nacionales de cómo estas prácticas están siendo implementadas.

Casos de éxito globales

Uno de los referentes globales en la compartición de datos es LinkedIn con su programa Data for Impact. Este programa facilita a gobiernos y organizaciones el acceso a datos económicos agregados y anonimizados, basados en el Economic Graph de LinkedIn, el cual representa la actividad profesional global. Es importante aclarar que los datos solo pueden utilizarse con fines de investigación y desarrollo. El acceso debe solicitarse vía email, adjuntando una propuesta para su evaluación, y se priorizan propuestas de gobiernos y organizaciones multilaterales. Estos datos han sido utilizados por entidades como el Banco Mundial y el Banco Central Europeo para informar de políticas y decisiones económicas clave. El enfoque de LinkedIn en la privacidad y la calidad de los datos asegura que estas colaboraciones beneficien tanto a las organizaciones como a los ciudadanos, promoviendo un crecimiento económico inclusivo, verde y alineado con las tecnologías digitales.

Por otro lado, el Registry of Open Data on AWS (RODA) es un repositorio gestionado Amazon Web Services (AWS) que alberga conjuntos de datos públicos. Los datasets no son proporcionados directamente por AWS, sino que son mantenidos por organizaciones gubernamentales, investigadores, empresas y particulares. Podemos encontrar, en el momento de escribir este post, más de 550 conjuntos de datos publicados por diferentes organizaciones, incluyendo algunas como el Allen Institute for Artificial Intelligence (AI2) o la propia NASA. Esta plataforma facilita que los usuarios aprovechen los servicios de computación en la nube de AWS para su análisis.

En el ámbito del periodismo de datos, FiveThirtyEight, propiedad de ABC News, ha adoptado un enfoque de transparencia radical al compartir públicamente los datos y códigos detrás de sus artículos y visualizaciones. Estos se encuentran accesibles a través de GitHub en formatos fácilmente reutilizables como CSV. Esta práctica no solo permite la verificación independiente de su trabajo, sino que también impulsa la creación de nuevas historias y análisis por parte de otros investigadores y periodistas. FiveThirtyEight se ha convertido en un modelo a seguir en lo relativo a cómo los datos abiertos pueden mejorar la calidad y la credibilidad del periodismo.

Casos de éxito en España

España no se queda atrás en cuanto a iniciativas de compartición de datos y open data por parte de compañías privadas. Varias empresas españolas están liderando iniciativas que promueven la accesibilidad y transparencia de los datos en diferentes sectores. Veamos algunos ejemplos.

Idealista, uno de los portales inmobiliarios más importantes del país, ha publicado un conjunto de datos abiertos que incluye información detallada sobre más de 180,000 viviendas en Madrid, Barcelona y Valencia. Este conjunto de datos proporciona las coordenadas geográficas y los precios de venta de cada propiedad, junto con sus características internas y la información oficial del catastro español. Este conjunto de datos está disponible para su acceso a través de GitHub como un paquete en R y se ha convertido en una gran herramienta para el análisis del mercado inmobiliario, permitiendo a investigadores y profesionales del sector desarrollar modelos de valoración automática y realizar estudios detallados sobre la segmentación del mercado. Cabe destacar que Idealista también reutiliza datos públicos de organismos como el catastro o el INE para ofrecer servicios de datos que dan soporte a las decisiones en el mercado inmobiliario, como contratación de hipotecas, estudios de mercado, valoración de carteras, etc.Por su parte BBVA, a través de su Fundación, ofrece acceso a un extenso fondo estadístico con bases de datos que incluyen cuadros, tablas y gráficos dinámicos. Estas bases de datos, de descarga libre, cubren temas como la productividad, la competitividad, el capital humano o la desigualdad en España, entre otros. Además, proporcionan series históricas sobre la economía española, inversiones, actividades culturales y gasto público. Estas herramientas están diseñadas para complementar publicaciones impresas y ofrecer una visión profunda sobre la evolución económica y social del país.

Además, Esri España habilita su Portal de Datos Abiertos, que pone a disposición de los usuarios una amplia variedad de contenidos que pueden ser consultados, analizados y descargados. Este portal incluye datos gestionados por Esri España, junto con una recopilación de otros portales de datos abiertos desarrollados con tecnología Esri. Esto amplía significativamente las posibilidades para investigadores, desarrolladores y profesionales que buscan aprovechar los datos geoespaciales en sus proyectos. Podemos encontrar conjuntos de datos en las categorías de salud, ciencia y tecnología o economía, entre otros.

En el ámbito de las empresas públicas, España también cuenta con ejemplos destacados de compromiso con los datos abiertos. Renfe, la principal operadora ferroviaria, y Red Eléctrica Española (REE), la entidad responsable de la operación del sistema eléctrico, han desarrollado programas de open data que facilitan el acceso a información relevante para la ciudadanía y para el desarrollo de aplicaciones y servicios que mejoren la eficiencia y la sostenibilidad. Destaca, en el caso de REE, la posibilidad de consumo de los datos disponibles a través de APIs REST, que facilitan la integración de aplicaciones sobre conjuntos de datos que reciben continuas actualizaciones sobre el estado de los mercados eléctricos.

Conclusión

La compartición de datos y el open data representan una evolución crucial en la forma en que las organizaciones gestionan y aprovechan la información. Desde gigantes tecnológicos internacionales como LinkedIn y AWS hasta innovadores nacionales como Idealista y BBVA, están proporcionando acceso abierto a los datos con el fin de impulsar un cambio significativo en cómo se toman decisiones, el desarrollo de políticas y la creación de nuevas oportunidades económicas. En España, tanto las empresas privadas como las públicas están mostrando un fuerte compromiso con estas prácticas, posicionando al país como un líder en la adopción de modelos de datos abiertos y de compartición de datos que beneficien a toda la sociedad.

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La inteligencia artificial (IA) está revolucionando la manera en que creamos y consumimos contenido. Desde la automatización de tareas repetitivas hasta la personalización de experiencias, la IA ofrece herramientas que están cambiando el panorama del marketing, la comunicación y la creatividad.

Estas inteligencias artificiales necesitan ser entrenadas con datos acordes a los objetivos, sobre los que no discurran derechos de autor. Por ello, los datos abiertos se alzan como una herramienta de gran utilidad de cara al futuro de la IA.

Para profundizar sobre esta temática, The Govlab ha publicado el informe “A Fourth Wave of Open Data? Exploring the Spectrum of Scenarios for Open Data and Generative AI” (¿Una cuarta ola de datos abiertos? Explorando el espectro de escenarios para los datos abiertos y la IA generativa). En él se analiza la relación emergente entre los datos abiertos y la IA generativa, presentado diversos escenarios y recomendaciones. A continuación, se recogen sus claves.

El papel de los datos en la IA generativa

Los datos son la base fundamental de los modelos generativos de inteligencia artificial. Construir y entrenar dichos modelos requiere un gran volumen de datos, cuya escala y variedad está condicionada por los objetivos y los casos de uso del modelo.

El siguiente gráfico explica cómo los datos funcionan como una pieza clave tanto de entrada de un sistema de IA generativa, como de salida. Los datos se recopilan de diversas fuentes, incluyendo portales de datos abiertos, con el fin de entrenar un modelo de IA de propósito general. Este modelo, posteriormente, será adaptado para realizar funciones específicas y diferentes tipos de análisis, que generan, a su vez, nuevos datos, que pueden utilizarse para seguir entrenando modelos.

Figura 1. El Rol de los datos abiertos en la IA generativa, adaptado del informe “A Fourth Wave of Open Data? Exploring the Spectrum of Scenarios for Open Data and Generative AI”, de The Govlab, 2024.

5 escenarios donde convergen los datos abiertos y la Inteligencia artificial

Con el fin de ayudar a los proveedores de datos abiertos a “preparar” dichos datos para la IA generativa, The Govlab ha definido cinco escenarios que resumen cinco formas distintas en las que los datos abiertos y la IA generativa pueden cruzarse. Estos escenarios pretenden ser un punto de partida, que se irá ampliando en el futuro, en base a los casos de uso disponibles.

| Escenario | Función | Requisitos de calidad | Necesidades de metadatos | Ejemplo |

|---|---|---|---|---|

| Preentrenamiento (Pretraining) | Entrenamiento de las capas fundacionales de un modelo de IA generativa con grandes cantidades de datos abiertos. | Alto volumen de datos, diversos y representativos del dominio de aplicación y uso no estructurado. | Información clara sobre la fuente de los datos. | Los datos del proyecto Harmonized Landsat Sentinel-2 (HLS) de la NASA se utilizaron para entrenar el modelo fundacional geoespacial watsonx.ai. |

| Adaptación (Adaptation) | Perfeccionamiento de un modelo preentrenado con datos abiertos específicos para tareas concretas, utilizando técnicas de fine-tuning or RAG. | Datos tabulares y/o no estructurados de alta precisión y relevancia para la tarea objetivo, con una distribución equilibrada. | Metadatado centrado en la anotación y procedencia de los datos para aportar enriquecimiento contextual. | Partiendo del modelo LLaMA 70B, el Gobierno de Francia creó LLaMandement, un modelo de lenguaje grande perfeccionado para el análisis y la redacción de resúmenes de proyectos jurídicos. Para ello usaron datos de SIGNALE, la plataforma legislativa del Gobierno francés. |

| Inferencia y generación de hechos relevantes (Inference and Insight Generation) | Extracción de información y patrones a partir de datos abiertos mediante un modelo entrenado de IA generativa. | Datos tabulares de alta calidad, completos y coherentes. | Metadatado descriptivo de los métodos de recogida de datos, información de origen y control de versiones. | Wobby es una interfaz generativa que acepta consultas en lenguaje natural y produce respuestas en forma de resúmenes y visualizaciones, utilizando conjuntos de datos de distintas oficinas como Eurostat o el Banco Mundial. |

| Incremento de datos (Data Augmentation) | Aprovechamiento de los datos abiertos para generar datos sintéticos o proporcionar ontologías para extender la cantidad de datos de entrenamiento. | Datos tabulares y/o no estructurados que sean una representación cercana a la realidad, asegurando el cumplimiento de consideraciones éticas. | Transparencia sobre el proceso de generación y posibles sesgos. | Un equipo de investigadores adaptó el modelo Synthea de EE.UU. para incluir datos demográficos y hospitalarios de Australia. Utilizando este modelo, el equipo pudo generar aproximadamente 117.000 historiales médicos sintéticos específicos, aplicados a su región. |

| Exploración abierta (Open-Ended Exploration) | Exploración y descubrimiento de nuevos conocimientos y patrones en datos abiertos mediante modelos generativos. | Datos tabulares y/o no estructurados, diversos y completos. | Información clara sobre fuentes y derechos de autor, comprensión de posibles sesgos y limitaciones, identificación de entidades. | NEPAccess es un piloto para desbloquear el acceso datos relacionados con la Ley Nacional de Política Medioambiental (NEPA) de EE.UU. mediante un modelo generativo de IA. Incluirá funciones para redactar evaluaciones de impacto ambiental, análisis de datos, etc. |

Figura 2. Cinco escenarios donde convergen los datos abiertos y la Inteligencia artificial, adaptado del informe “A Fourth Wave of Open Data? Exploring the Spectrum of Scenarios for Open Data and Generative AI”, de The Govlab, 2024.

Puedes leer el detalle de estos escenarios en el informe, donde se explican más ejemplos. Además, The Govlab también ha puesto en marcha un observatorio donde recopila ejemplos de intersecciones entre datos abiertos e inteligencia artificial generativa (los incluidos en el informe junto con otros adicionales). Cualquier usuario puede proponer nuevos casos a través de este formulario. Dichos ejemplos se utilizarán para continuar estudiando este campo y mejorar los escenarios actualmente definidos.

Entre los casos que se pueden ver en la web, encontramos una empresa española: Tendios. Se trata de una compañía de software como servicio que ha desarrollado un chatbot para ayudar en el análisis de licitaciones y concursos públicos con el fin de facilitar la concurrencia. Esta herramienta está entrenada con documentos públicos de licitaciones gubernamentales.

Recomendaciones para publicadores de datos

Para extraer el máximo potencial de IA generativa, mejorando su eficiencia y eficacia, el informe destaca que los proveedores de datos abiertos deben hacer frente a algunos retos, como la mejora de la gobernanza y la gestión de los datos. En este sentido, recogen cinco recomendaciones:

- Mejorar la transparencia y la documentación. A través del uso de estándares, diccionarios de datos, vocabularios, plantillas de metadatos, etc. se ayudará a aplicar prácticas de documentación sobre el linaje, la calidad, las consideraciones éticas y el impacto de los resultados.

- Mantener la calidad y la integridad. Se necesita formación y procesos rutinarios que aseguren la calidad, incluida la validación automatizada o manual, así como herramientas para actualizar los conjuntos de datos rápidamente cuando sea necesario. Además, son necesarios mecanismos para informar y abordar problemas que puedan surgir relacionados con los datos, a fin de impulsar la transparencia y facilitar la creación de una comunidad en torno a los conjuntos de datos abiertos.

- Fomentar la interoperabilidad y los estándares. Implica adoptar y promover normas internacionales de datos, con especial foco en los datos sintéticos y los contenidos generados por IA.

- Mejorar la accesibilidad y la facilidad de uso. Supone la mejora de los portales de datos abiertos mediante algoritmos de búsqueda inteligentes y herramientas interactivas. También es imprescindible establecer un espacio compartido donde los publicadores de los datos y los usuarios puedan intercambiar opiniones y manifestar necesidades, con el fin de hacer coincidir oferta y demanda.

- Abordar las consideraciones éticas. Proteger a los titulares de los datos es de máxima prioridad al hablar de datos abiertos e IA generativa. Se necesitan comités éticos y directrices éticas exhaustivas en torno a la recopilación, el intercambio y el uso de datos abiertos, así como tecnologías avanzadas de preservación de la intimidad.

Estamos ante un campo en continua evolución que necesita de actualización constante por parte de los publicadores de datos. Estos deben proporcionar conjuntos de datos adecuados tanto técnica como éticamente, para que los sistemas de IA generativa puedan alcanzar todo su potencial.

Antes de realizar un análisis de datos, con fines estadístico o predictivos por ejemplo a través de técnicas de machine learning, es necesario comprender la materia prima con la que vamos a trabajar. Hay que entender y evaluar la calidad de los datos para así, entre otros aspectos, detectar y tratar los datos atípicos o incorrectos, evitando posibles errores que pudieran repercutir en los resultados del análisis.

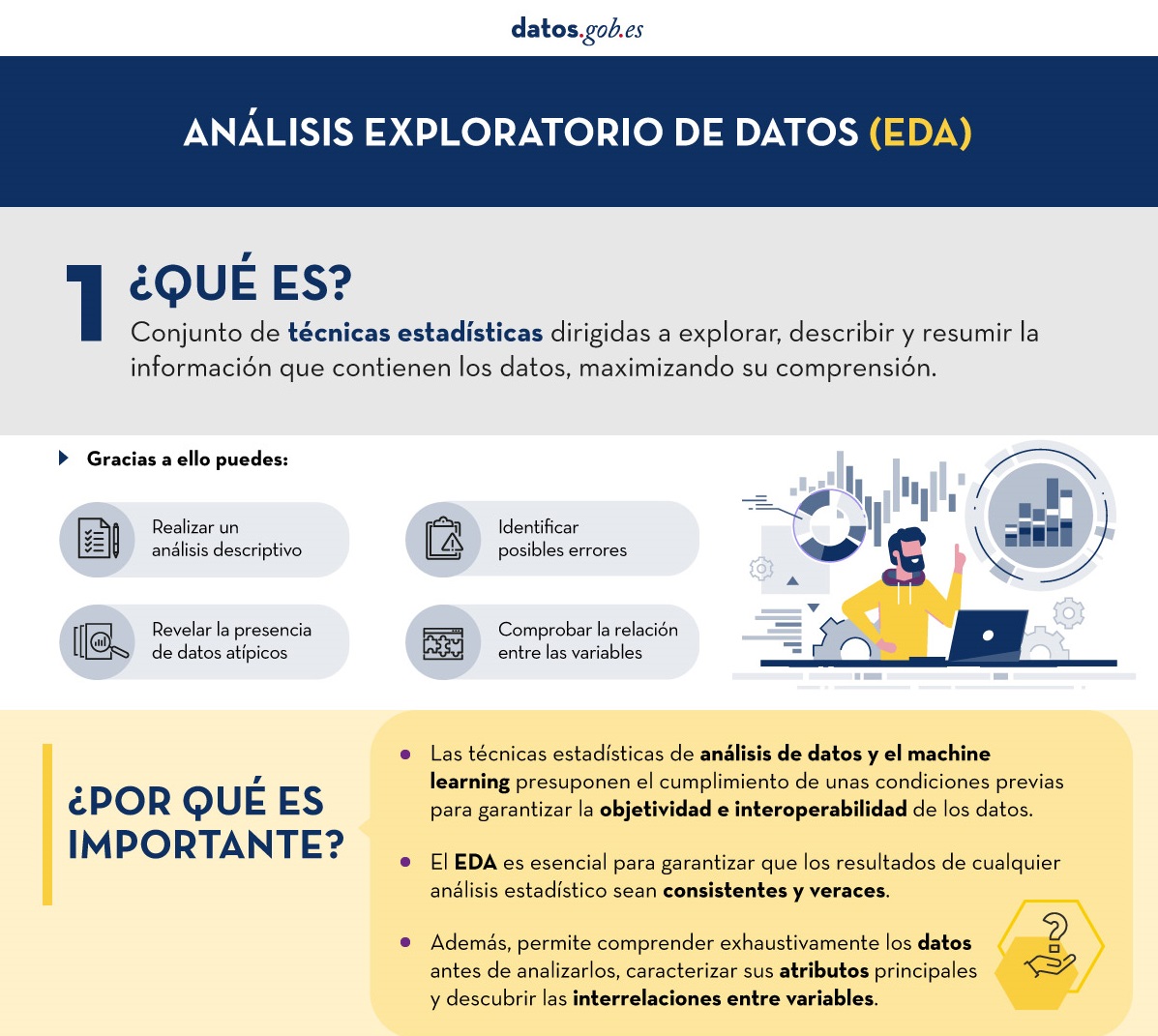

Una forma de llevar a cabo este pre-procesamiento es mediante un análisis exploratorio de datos (AED) o exploratory data analysis (EDA).

¿Qué es el análisis exploratorio de los datos?

El AED consiste en aplicar un conjunto de técnicas estadísticas dirigidas a explorar, describir y resumir la naturaleza de los datos, de tal forma que podamos garantizar su objetividad e interoperabilidad.

Gracias a ello se pueden identificar posibles errores, revelar la presencia de valores atípicos, comprobar la relación entre variables (correlaciones) y su posible redundancia, así como realizar un análisis descriptivo de los datos mediante representaciones gráficas y resúmenes de los aspectos más significativos.

En muchas ocasiones, esta exploración de los datos se descuida y no se lleva a cabo de manera correcta. Por este motivo, desde datos.gob.es hemos elaborado una guía introductoria que recoge una serie de tareas mínimas para realizar un correcto análisis exploratorios de datos, paso previo y necesario antes de llevar a cabo cualquier tipo de análisis estadístico o predictivo ligado a las técnicas de machine learning.

¿Qué incluye la guía?

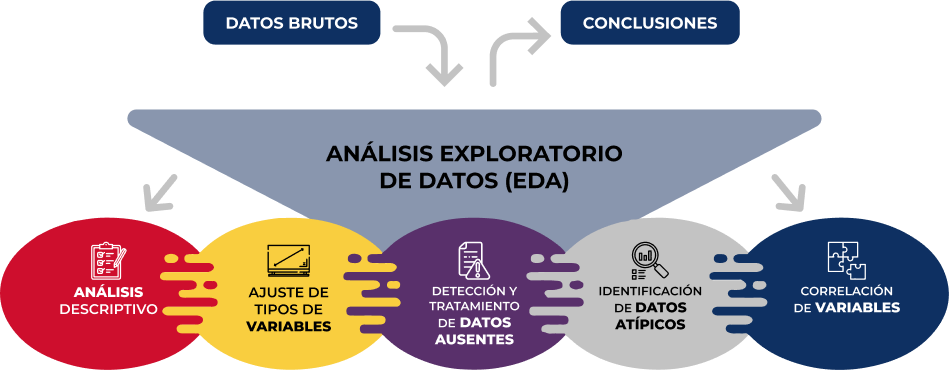

La guía explica de forma sencilla cuáles son los pasos a seguir para garantizar unos datos consistentes y veraces. Para su elaboración se ha tomado como referencia el análisis exploratorio de datos descrito en el libro R for Data Science de Wickman y Grolemund (2017) disponible de forma gratuita. Estos pasos son:

Figura 1. Fases del análisis exploratorio de datos. Fuente: elaboración propia.

En la guía se explica cada uno de estos pasos y por qué son necesarios. Asimismo, se ilustran de manera práctica a través de un ejemplo. Para dicho caso práctico, se ha utilizado el dataset relativo al registro de la calidad del aire en la Comunidad Autónoma de Castilla y León incluido en nuestro catálogo de datos abiertos. El tratamiento se ha llevado a cabo con herramientas tecnológicas open source y gratuitas. En la guía se recoge el código para que los usuarios pueden replicarlo de forma autodidacta siguiendo los pasos indicados.

La guía finaliza con un apartado de recursos adicionales para aquellos que quieran seguir profundizando en la materia.

¿A quién va dirigida?

El público objetivo de la guía es el usuario reutilizador de datos abiertos. Es decir, desarrolladores, emprendedores o incluso periodistas de datos que quieran extraer todo el valor posible de la información con la que trabajan para obtener unos resultados fiables.

Es aconsejable que el usuario tenga nociones básicas del lenguaje de programación R, elegido para ilustrar los ejemplos. No obstante, en el apartado de bibliografía se incluyen recursos para adquirir mayores habilidades en este campo.

A continuación, en el apartado documentación, puedes descargarte la guía, así como una infografía-resumen que ilustra los principales pasos del análisis exploratorios de datos. También tienes disponible el código fuente del ejemplo práctico en nuestro Github.

Haz click para ver la infografía completa, en versión accesible

Figura 2. Captura de la infografía. Fuente: elaboración propia.

Infografía - Análisis de datos abiertos con herramientas open source PARTE I

Infografía - Visualización de datos abiertos con herramientas open source PARTE II

Ver infografía completa

1. Introducción

Las visualizaciones son representaciones gráficas de datos que permiten comunicar, de manera sencilla y efectiva, la información ligada a los mismos. Las posibilidades de visualización son muy amplias, desde representaciones básicas como los gráficos de líneas, de barras o métricas relevantes, hasta visualizaciones configuradas sobre cuadros de mando interactivos.

En esta sección de “Visualizaciones paso a paso” estamos presentando periódicamente ejercicios prácticos haciendo uso de datos abiertos disponibles en datos.gob.es u otros catálogos similares. En ellos, se abordan y describen de manera sencilla las etapas necesarias para obtener los datos, realizar las transformaciones y los análisis pertinentes para, finalmente obtener unas conclusiones a modo de resumen de dicha información.

En cada ejercicio práctico se utilizan desarrollos de código documentados y herramientas de uso gratuito. Todo el material generado está disponible para su reutilización en el repositorio de GitHub de datos.gob.es.

En este ejercicio concreto, exploraremos los flujos de turistas a nivel nacional, creando visualizaciones de los turistas que se mueven entre las comunidades autónomas (CCAA) y provincias.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

En este vídeo, el autor te explica que vas a encontrar tanto en el Github como en Google Colab.

2. Contexto

Analizar los flujos de turistas nacionales nos permite observar ciertos movimientos ya muy conocidos, como, por ejemplo, que la provincia de Alicante es un destino muy popular del turismo veraniego. Además, este análisis es interesante para observar tendencias en el impacto económico que el turismo pueda tener, año tras año, en ciertas CCAA o provincias. El artículo sobre experiencias para la gestión de los flujos de visitantes en destinos turísticos ilustra el impacto de los datos en el sector.

3. Objetivo

El objetivo principal del ejercicio es crear visualizaciones interactivas en Python que permitan visualizar información compleja de manera comprensible y atractiva. Se cumplirá este objetivo usando un conjunto de datos abiertos que contiene información sobre flujos de turistas nacionales, planteando varias preguntas sobre los datos y contestándolas gráficamente. Podremos responder a preguntas como las que se plantean a continuación:

- ¿En qué CCAA hay más turismo procedente de la misma CA?

- ¿Cuál es la CA que más sale de su propia CA?

- ¿Qué diferencias hay entre los flujos de turistas a lo largo del año?

- ¿Cuál es la provincia valenciana que más turistas recibe?

La comprensión de las herramientas propuestas aportará al lector la capacidad para poder modificar el código contenido en el notebook que acompaña a este ejercicio para seguir explorando los datos por su cuenta y detectar más comportamientos interesantes a partir del conjunto de datos utilizado.

Para poder crear visualizaciones interactivas y contestar a las preguntas sobre los flujos de turistas, será necesario un proceso de limpieza y reformateado de datos que está descrito en el notebook que acompaña este ejercicio.

4. Recursos

Conjunto de datos

El conjunto de datos abiertos utilizado contiene información sobre los flujos de turistas en España a nivel de CCAA y provincias, indicando también los valores totales a nivel nacional. El conjunto de datos ha sido publicado por el Instituto Nacional de Estadística, a través de varios tipos de ficheros. Para el presente ejercicio utilizamos únicamente el fichero .csv separado por “;”. Los datos datan de julio de 2019 a marzo de 2024 (a la hora de redactar este ejercicio) y se actualizan mensualmente.

Número de turistas por CCAA y provincia de destino desagregados por PROVINCIA de origen

El conjunto de datos también se encuentra disponible para su descarga en este repositorio de Github.

Herramientas analíticas

Para la limpieza de los datos y la creación de las visualizaciones se ha utilizado el lenguaje de programación Python. El código creado para este ejercicio se pone a disposición del lector a través de un notebook de Google Colab.

Las librerías de Python que utilizaremos para llevar a cabo el ejercicio son:

- pandas: es una librería que se utiliza para el análisis y manipulación de datos.

- holoviews: es una librería que permite crear visualizaciones interactivas, combinando las funcionalidades de otras librerías como Bokeh y Matplotlib.

5. Desarrollo del ejercicio

Para visualizar los datos sobre flujos de turistas interactivamente crearemos dos tipos de diagramas, los diagramas de cuerdas y los diagramas de Sankey.

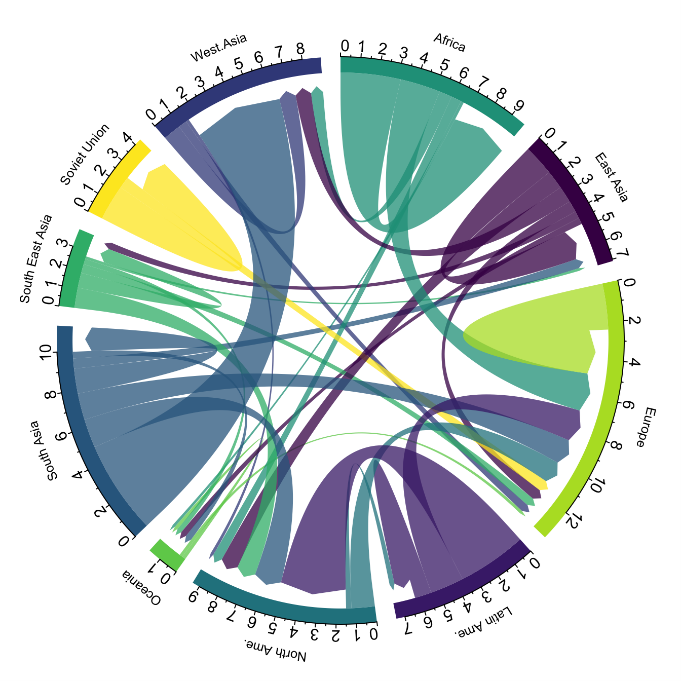

Los diagramas de cuerdas son un tipo de diagrama que está compuesto por nodos y aristas, véase la figura 1. Los nodos se sitúan en un círculo y las aristas simbolizan las relaciones entre los nodos del círculo. Estos diagramas suelen utilizarse para mostrar tipos de flujos, por ejemplo, flujos migratorios o monetarios. El volumen diferente de las aristas se visualiza de manera comprensible y refleja la importancia de un flujo o de un nodo. Por su forma de círculo, el diagrama de cuerdas es una buena opción para visualizar las relaciones entre todos los nodos de nuestro análisis (relación del tipo “varios a varios”).

Figura 1. Diagrama de cuerdas (Migración global). Fuente.

Los diagramas de Sankey, igual que los diagramas de cuerdas, son un tipo de diagrama que está compuesto por nodos y aristas, véase la figura 2. Los nodos se representan en los márgenes de la visualización, estando las aristas entre los márgenes. Por esta agrupación lineal de los nodos, los diagramas de Sankey son mejores que los diagramas de cuerdas para análisis en los cuales queramos visualizar la relación entre:

- varios nodos y otros nodos (tipo varios a varios, o varios a pocos, o viceversa)

- varios nodos y un solo nodo (varios a uno, o viceversa)

Figura 2. Diagrama de Sankey (Migración interna Reino Unido). Fuente.

El ejercicio está dividido en 5 partes, siendo la parte 0 (“configuración inicial”) solo de montar el entorno de programación. A continuación, describimos las cinco partes y los pasos que se llevan a cabo.

5.1. Cargar datos

Este apartado podrás encontrarlo en el punto 1 del notebook.

En este parte cargamos el conjunto de datos para poder procesarlo en el notebook. Comprobamos el formato de los datos cargados y creamos un pandas.DataFrame que utilizaremos para el procesamiento de los datos en los siguientes pasos.

5.2. Exploración inicial de los datos

Este apartado podrás encontrarlo en el punto 2 del notebook.

En esta parte realizamos un análisis exploratorio de los datos para entender el formato del conjunto de datos que hemos cargado y para tener una idea más clara de la información que contiene. Mediante esta exploración inicial, podemos definir los pasos de limpieza que tenemos que llevar a cabo para poder crear las visualizaciones interactivas.

Si quieres aprender más sobre cómo abordar esta tarea, tienes a tu disposición esta guía introductoria sobre análisis exploratorio de datos.

5.3. Análisis del formato de los datos

Este apartado podrás encontrarlo en el punto 3 del notebook.

En esta parte resumimos las observaciones que hemos podido hacer durante la exploración inicial de los datos. Recapitulamos aquí las observaciones más importantes:

| Provincia de origen | Provincia de origen | CCAA y provincia de destino | CCAA y provincia de destino | CCAA y provincia de destino | Concepto turístico | Periodo | Total |

|---|---|---|---|---|---|---|---|

| Total Nacional | Total Nacional | Turistas | 2024M03 | 13.731.096 | |||

| Total Nacional | Ourense | Total Nacional | Andalucía | Almería | Turistas | 2024M03 | 373 |

Figura 3. Fragmento del conjunto de datos original.

Podemos observar en las columnas uno a cuatro que los orígenes de los flujos de turistas están desagregados por provincia mientras que, para los destinos, las provincias están agregadas por CCAA. Aprovecharemos el mapeado de las CCAA y de sus provincias que podemos extraer de la cuarta y quinta columna para agregar las provincias de origen por CCAA.

También podemos ver que la información contenida en la primera columna a veces es superflua, por lo cual, la combinaremos con la segunda columna. Además, hemos constatado que la quinta y sexta columna no aportan valor para nuestro análisis, por lo cual, las eliminaremos. Renombraremos algunas columnas para tener un pandas. DataFrame más comprensible.

5.4. Limpieza de los datos

Este apartado podrás encontrarlo en el punto 4 del notebook.

En esta parte llevamos a cabo los pasos necesarios para darle mejor formato a nuestros datos. Para ello aprovechamos varias funcionalidades que nos ofrece pandas, por ejemplo, para renombrar las columnas. También definimos una función reutilizable que necesitamos para concatenar los valores de la primera y segunda columna con el objetivo de no tener una columna que exclusivamente indique “Total Nacional” en todas las filas del pandas.DataFrame. Además, extraeremos de las columnas de destino un mapeado de CCAA a provincias que aplicaremos a las columnas de origen.

Queremos obtener una versión del conjunto de datos más comprimida con mayor transparencia de los nombres de las columnas y que no contenga información que no vamos a procesar. El resultado final del proceso de limpieza de datos es el siguiente:

| Origen | Provincia de origen | Destino | Provincia de destino | Periodo | Total |

|---|---|---|---|---|---|

| Total Nacional | Total Nacional | 2024M03 | 13731096.0 | ||

| Galicia | Ourense | Andalucía | Almería | 2024M03 | 373.0 |

Figura 4. Fragmento del conjunto de datos limpio.

5.5. Crear visualizaciones

Este apartado podrás encontrarlo en el punto 5 del notebook

En esta parte creamos nuestras visualizaciones interactivas utilizando la librería Holoviews. Para poder dibujar gráficos de cuerdas o de Sankey que visualicen el flujo de personas entre CCAA y CCAA y/o provincias, tenemos que estructurar la información de nuestros datos de tal forma que dispongamos de nodos y aristas. En nuestro caso, los nodos son los nombres de CCAA o provincia y las aristas, es decir, la relación entre los nodos, son el número de turistas. En el notebook definimos una función para obtener los nodos y aristas que podemos reutilizar para los diferentes diagramas que queramos realizar, cambiando el período de tiempo según la estación del año que nos interese analizar.

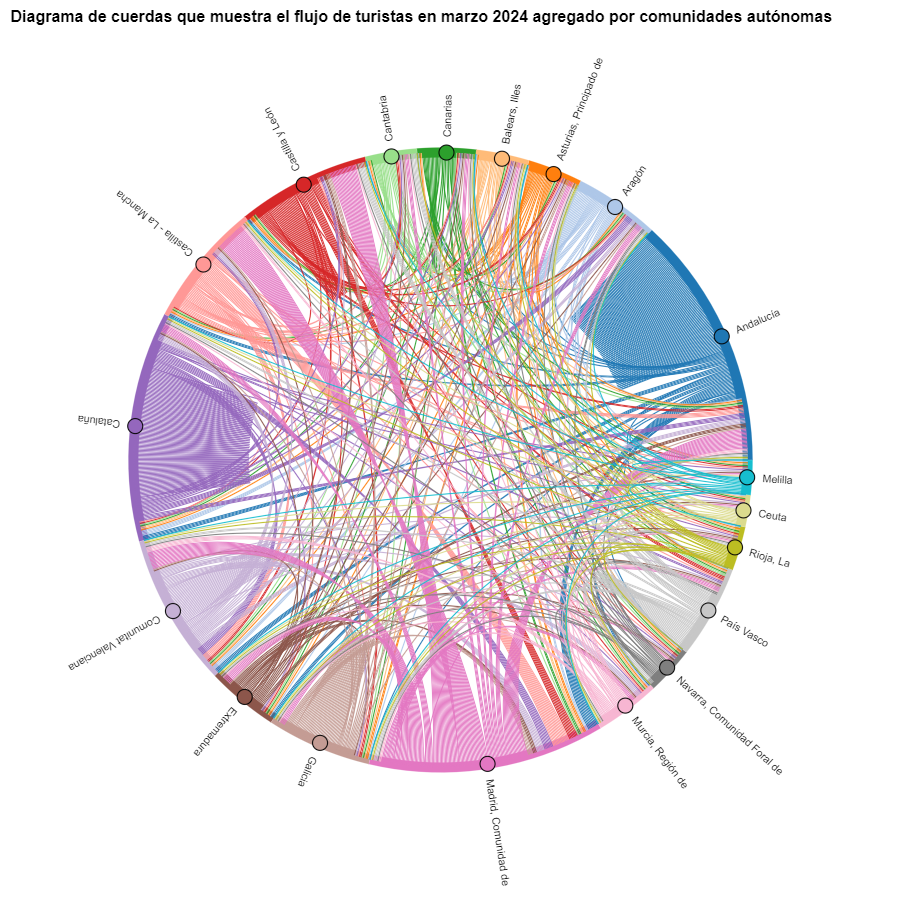

Vamos a crear primero un diagrama de cuerdas usando exclusivamente los datos sobre flujos de turistas de marzo de 2024. En el notebook, este diagrama de cuerdas es dinámico. Te animamos a probar su interactividad.

Figura 5. Diagrama de cuerdas que muestra el flujo de turistas en marzo 2024 agregado por comunidades autónomas.

En el diagrama de cuerdas se visualizan los flujos de turistas entre todas las CCAA. Cada CA tiene un color y los movimientos que hacen los turistas provenientes de esta CA se simbolizan con el mismo color. Podemos observar que los turistas de Andalucía y Cataluña viajan mucho dentro de sus propias CCAA. En cambio, los turistas de Madrid salen mucho de su propia CA.

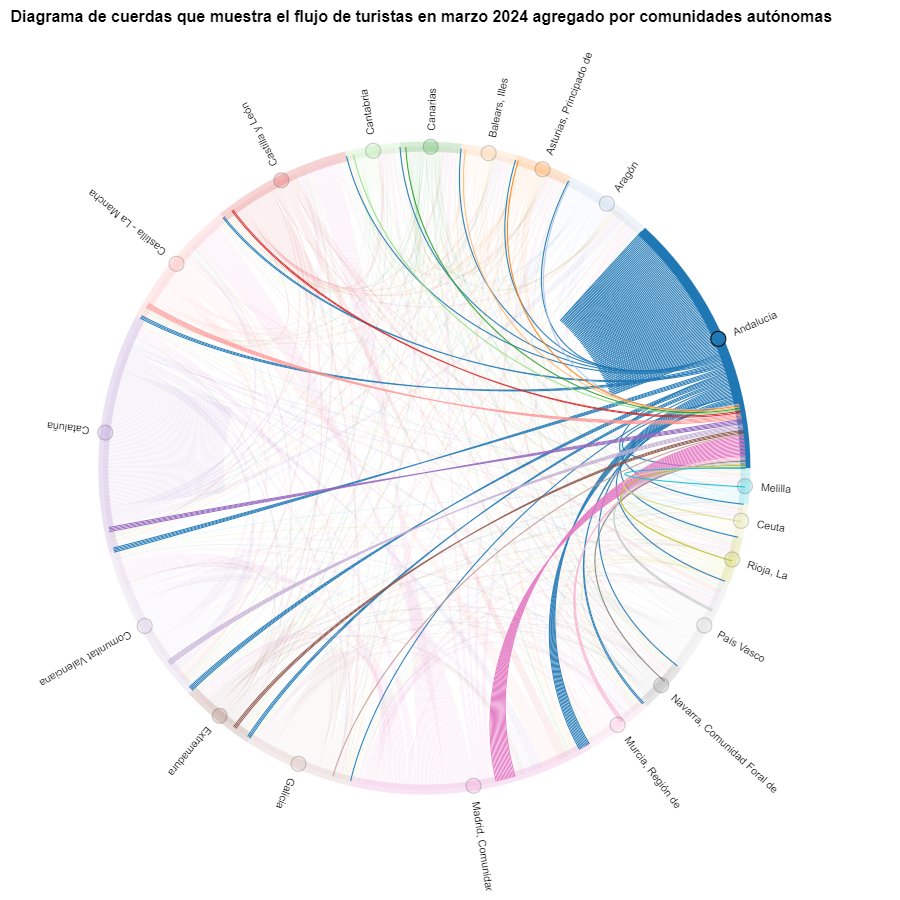

Figura 6. Diagrama de cuerdas que muestra el flujo de turistas entrando y saliendo de Andalucía en marzo 2024 agregado por comunidades autónomas.

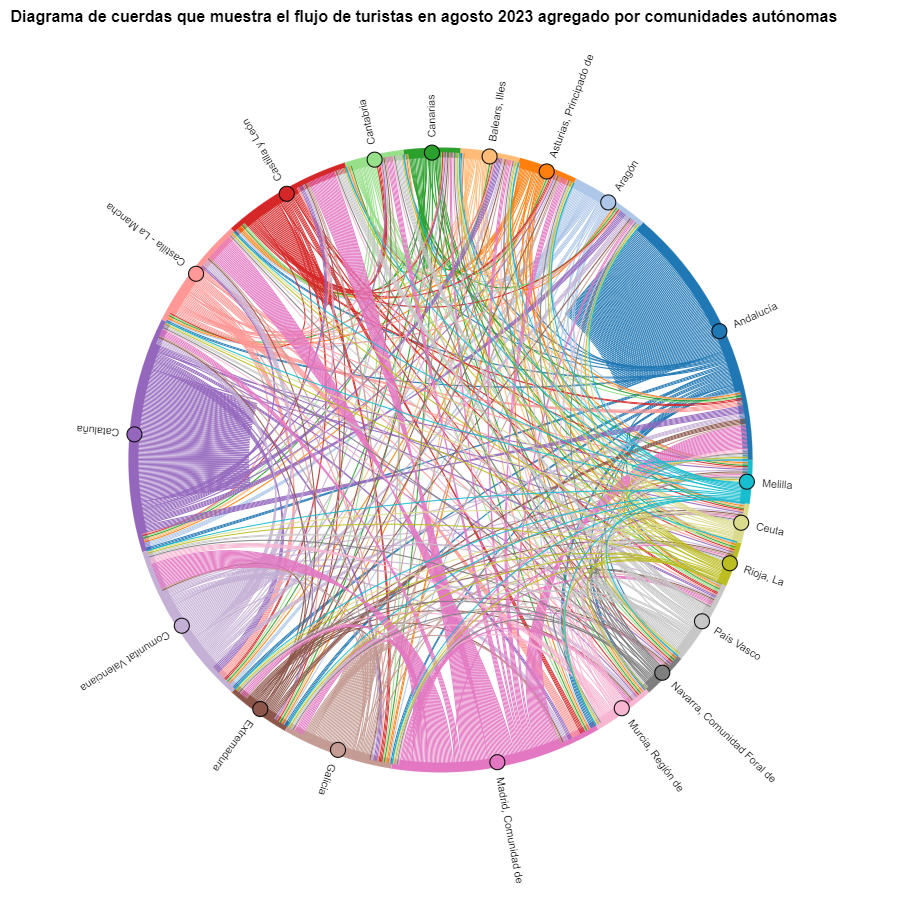

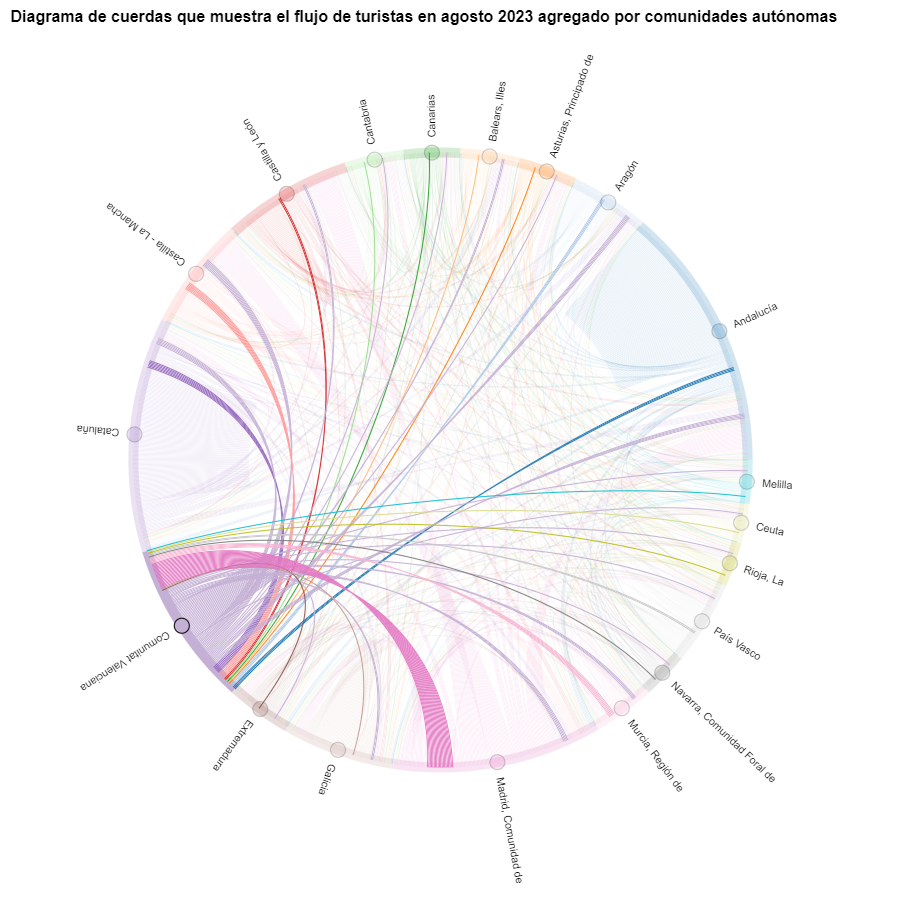

Creamos otro diagrama de cuerdas utilizando la función que hemos creado y visualizamos los flujos de turistas en agosto de 2023.

Figura 7. Diagrama de cuerdas que muestra el flujo de turistas en agosto 2023 agregado por comunidades autónomas.

Podremos observar que, a grandes rasgos, no cambian los movimientos de los turistas, solo que se intensifican los movimientos que ya hemos podido observar para marzo 2024.

Figura 8. Diagrama de cuerdas que muestra el flujo de turistas entrando y saliendo de la Comunitat Valenciana en agosto 2023 agregado por comunidades autónomas.

El lector puede crear el mismo diagrama para otros períodos de tiempo, por ejemplo, para el verano del año 2020, con el fin de visualizar el impacto de la pandemia en el turismo veraniego, reutilizando la función que hemos creado.

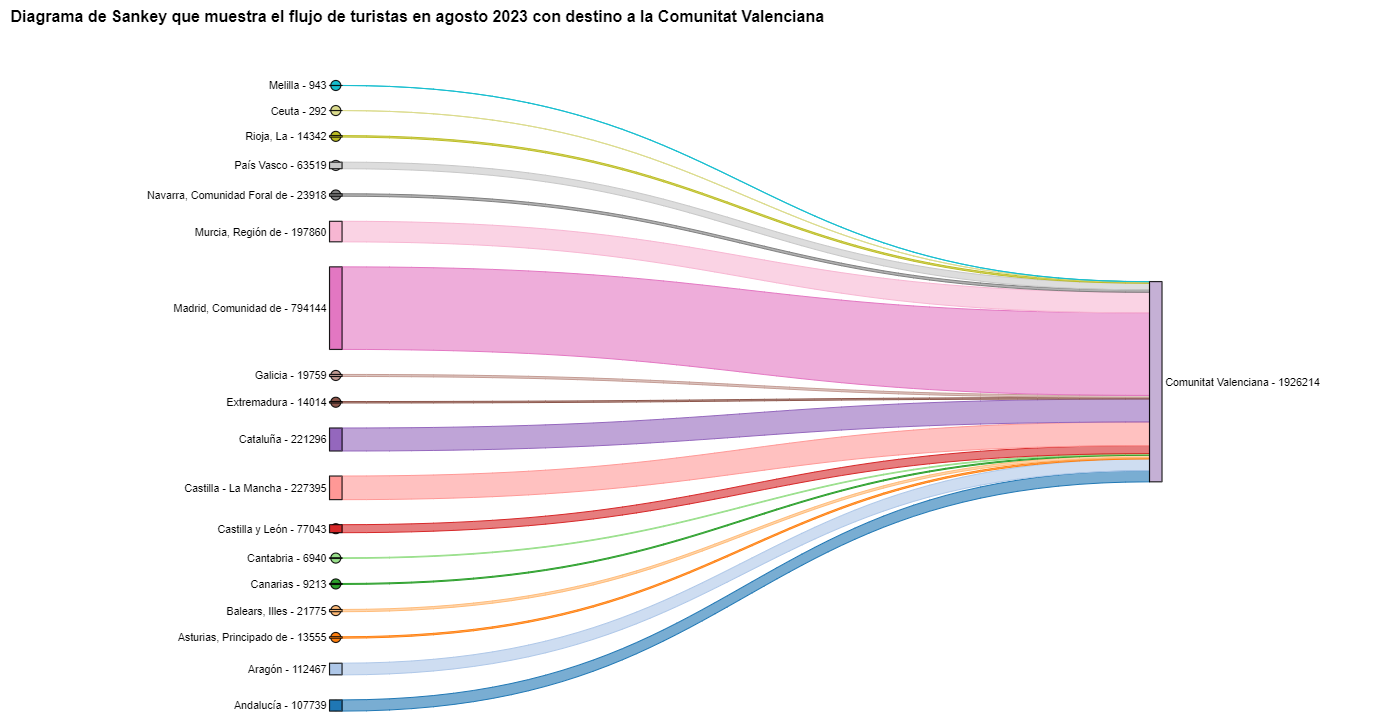

Para los diagramas de Sankey nos vamos a centrar en la Comunitat Valenciana, ya que es un destino vacacional popular. Filtramos las aristas que hemos creado para el diagrama de cuerdas anterior de manera que solo contengan flujos que terminen en la Comunitat Valenciana. El mismo procedimiento se podría aplicar para estudiar cualquier otra CA o se podría invertir para analizar dónde van a veranear los valencianos. Visualizamos el diagrama de Sankey que, igual que los diagramas de cuerdas, es interactivo dentro del notebook. El aspecto visual quedaría así:

Figura 9. Diagrama de Sankey que muestra el flujo de turistas en agosto 2023 con destino a la Comunitat Valenciana.

Como ya hemos podido intuir por el diagrama de cuerdas de arriba, véase la figura 8 el mayor grupo de turistas que llegan a la Comunitat Valenciana proviene de Madrid. Vemos que también hay un elevado número de turistas que visitan la Comunitat Valenciana desde las CCAA vecinas como Murcia, Andalucía y Cataluña.

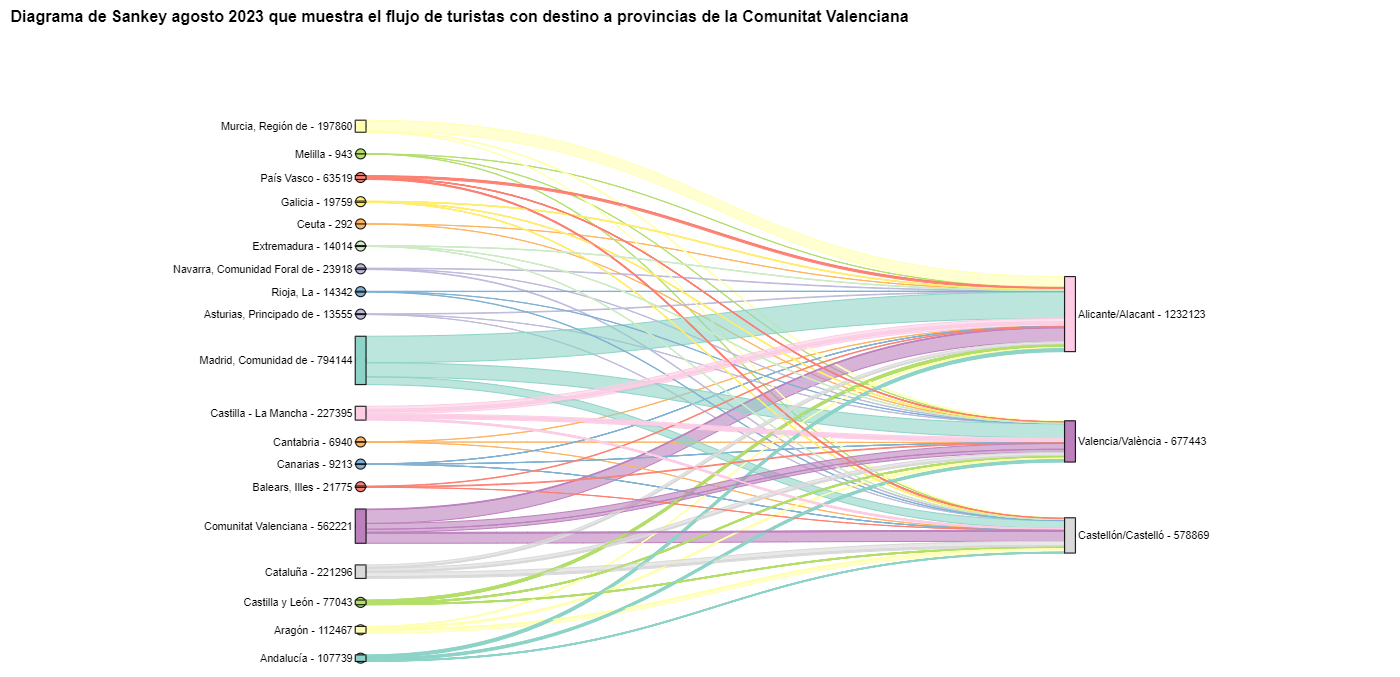

Para comprobar que estas tendencias se dan en las tres provincias de la Comunitat Valenciana, vamos a crear un diagrama de Sankey que muestre en el margen izquierdo todas las CCAA y en el margen derecho las tres provincias de la Comunitat Valenciana.

Para crear este diagrama de Sankey a nivel de provincias tenemos que filtrar nuestro pandas. DataFrame inicial para extraer de él las filas que contienen la información relevante. Los pasos en el notebook se pueden adaptar para realizar este análisis a nivel de provincias para cualquier otra CA. Aunque no estamos reutilizando la función que hemos usado anteriormente, también podemos cambiar el período de análisis.

El diagrama de Sankey que visualiza los flujos de turistas que llegaron en agosto de 2023 a las tres provincias valencianas quedaría así:

Figura 10. Diagrama de Sankey agosto 2023 que muestra el flujo de turistas con destino a provincias de la Comunitat Valenciana.

Podemos observar que, como ya suponíamos, el mayor número de turistas que llega a la Comunitat Valenciana en agosto proviene de la Comunidad de Madrid. Sin embargo, podemos comprobar que esto no es cierto para la provincia de Castellón, donde en agosto de 2023 la mayoría de los turistas fueron valencianos que se desplazaron dentro de su propia CA.

6. Conclusiones del ejercicio

Gracias a las técnicas de visualización empleadas en este ejercicio, hemos podido observar los flujos de turistas que se desplazan dentro del territorio nacional, enfocándonos en hacer comparaciones entre diversas épocas del año y tratando de identificar patrones. Tanto en los diagramas de cuerdas como en los diagramas de Sankey que hemos creado, hemos podido observar la afluencia de los turistas madrileños en las costas valencianas en verano. También hemos podido identificar las comunidades autónomas donde los turistas salen menos de su propia comunidad autónoma, como Cataluña y Andalucía.

7. ¿Quieres realizar el ejercicio?

Invitamos al lector a ejecutar el código contenido en el notebook de Google Colab que acompaña a este ejercicio para seguir con el análisis de los flujos de turistas. Dejamos aquí algunas ideas de posibles preguntas y de cómo se podrían contestar:

- El impacto de la pandemia: ya lo hemos mencionado brevemente arriba, pero una pregunta interesante sería medir el impacto que ha tenido la pandemia del coronavirus sobre el turismo. Podemos comparar los datos de los años anteriores con el 2020 y también analizar los años siguientes para detectar tendencias de estabilización. Visto que la función que hemos creado permite cambiar fácilmente el período de tiempo bajo análisis, te proponemos hacer este análisis por tu cuenta.

- Intervalos de tiempo: también es posible modificar la función que hemos estado usando de tal manera que no solo permita seleccionar un periodo de tiempo concreto, sino que también permita intervalos de tiempos.

- Análisis a nivel de provincias: igualmente, un lector avanzado con Pandas puede imponerse el reto de crear un diagrama de Sankey que visualice a qué provincias viajan los habitantes de una determinada región, por ejemplo, Ourense. Para no tener demasiadas provincias de destino que podrían hacer ilegible el diagrama de Sankey, se podrían visualizar solo las 10 más visitadas. Para obtener los datos para crear esta visualización, el lector tendría que jugar con los filtros que pone sobre el dataset y con el método de groupby de pandas, dejándose inspirar por el código ya ejecutado.

Esperamos que este ejercicio práctico te haya aportado conocimiento suficiente para desarrollar tus propias visualizaciones. Si tienes algún tema sobre ciencia de datos que quieras que tratemos próximamente, no dudes en proponer tu interés a través de nuestros canales de contacto.

Además, recuerda que tienes a tu disposición más ejercicios en el apartado sección de “Ejercicios de ciencia de datos”.

La revolución digital está transformando los servicios municipales, impulsada por la creciente adopción de tecnologías de inteligencia artificial (IA) que también se benefician de los datos abiertos. Estos avances tienen potencial para redefinir la manera en que los municipios ofrecen servicios a sus ciudadanos, proporcionando herramientas para mejorar la eficiencia, accesibilidad y sostenibilidad. El presente informe analiza casos de éxito en el despliegue de aplicaciones y plataformas que buscan mejorar diversos aspectos de la vida en los municipios, destacando su potencial para liberar algo más del vasto potencial aún por explotar de los datos abiertos y las tecnologías asociadas a la inteligencia artificial.

Las aplicaciones y plataformas descritas en este informe tienen un alto potencial de replicabilidad en diferentes contextos municipales, ya que abordan problemas que son comunes. La replicación de estas soluciones puede llevarse a cabo mediante la colaboración entre municipios, empresas y desarrolladores, así como a través de la liberación y estandarización de datos abiertos.

A pesar de los beneficios, la adopción de datos abiertos para la innovación municipal también presenta importantes desafíos. Debe garantizarse la calidad, actualización y estandarización de los datos publicados por las entidades locales, así como la interoperabilidad entre diferentes plataformas y sistemas. Además, es necesario reforzar la cultura de datos abiertos entre todos los actores implicados, incluidos los ciudadanos, los desarrolladores, las empresas y las propias administraciones públicas.

Los casos de uso analizados se dividen en cuatro secciones. A continuación, se describen cada una de estas secciones y se muestran algunos ejemplos de las soluciones incluidas en el informe.

Transporte y Movilidad

Uno de los desafíos más significativos en las áreas urbanas es la gestión del transporte y la movilidad. Las aplicaciones que utilizan datos abiertos han demostrado ser efectivas en la mejora de estos servicios. Por ejemplo, aplicaciones como Park4Dis facilitan la localización de plazas de aparcamiento para persona con movilidad reducida, utilizando datos de múltiples municipios y contribuciones de voluntarios. CityMapper, que ha alanzado escala global, por otro lado, ofrece rutas de transporte público optimizadas en tiempo real, integrando datos de diversos modos de transporte para proporcionar la ruta más eficiente. Estas aplicaciones no solo mejoran la movilidad, sino que también contribuyen a la sostenibilidad al reducir la congestión y las emisiones de carbono.

Medio Ambiente y Sostenibilidad

La creciente conciencia sobre la sostenibilidad ha impulsado el desarrollo de aplicaciones que promueven prácticas ecológicas. CleanSpot, por ejemplo, facilita la localización de puntos de reciclaje y la gestión de residuos urbanos. La aplicación incentiva la participación ciudadana en la limpieza y el reciclaje, contribuyendo a la reducción de la huella ecológica. Liight, por su parte, gamifica comportamientos sostenibles, recompensando a los usuarios por acciones como reciclar o usar el transporte público. Estas aplicaciones no solo mejoran la gestión ambiental, sino que también educan y motivan a los ciudadanos a adoptar hábitos más sostenibles.

Optimización de Servicios Públicos Básicos

Las plataformas de gestión de servicios urbanos, como Gestdropper, utilizan datos abiertos para monitorizar y controlar infraestructuras urbanas en tiempo real. Estas herramientas permiten una gestión más eficiente de recursos como el alumbrado público, redes de agua y mobiliario urbano, optimizando el mantenimiento, la respuesta ante incidencias y reduciendo costes operativos. Por otra parte, el despliegue de sistemas de gestión de citas previas, como CitaME, ayuda a reducir los tiempos de espera y mejorar la eficiencia en la atención al ciudadano.

Agregadores de Servicios a los Ciudadanos

Las aplicaciones que centralizan información y servicios públicos, como Badajoz Es Más y AppValencia, mejoran la accesibilidad y la comunicación entre las administraciones y los ciudadanos. Estas plataformas proporcionan datos en tiempo real sobre transporte público, eventos culturales, turismo y trámites administrativos, facilitando la vida en el municipio tanto a los residentes como a los turistas. Por ejemplo, al integrar múltiples servicios en una sola aplicación, se mejora la eficiencia y se reduce la necesidad de desplazamientos innecesarios. Estas herramientas también apoyan a las economías locales al promover eventos culturales y servicios comerciales.

Conclusiones

La utilización de datos abiertos y tecnologías de inteligencia artificial está transformando la gestión municipal, mejorando la eficiencia, accesibilidad y sostenibilidad de los servicios públicos. Los casos de éxito presentados en este informe describen cómo estas herramientas pueden beneficiar tanto a los ciudadanos como a las administraciones públicas convirtiendo las ciudades en entornos más inteligentes, inclusivos y sostenibles, y respondiendo mejor a las necesidades y bienestar de sus habitantes y visitantes.

Parece que fue ayer cuando terminábamos de comernos las uvas y dábamos la bienvenida al nuevo año. Sin embargo, ya han pasado seis meses, durante los cuales hemos presenciado numerosas novedades en el mundo, en España y también en el ecosistema de los datos abiertos.

Acompáñanos en este repaso que recoge algunos hechos noticiables sobre open data que han ocurrido en nuestro país en lo que llevamos de año.

Nuevas normativas para impulsar la apertura de datos y su uso

Durante las primeras semanas de 2024 se lograron algunos avances legislativos europeos y, como tal, de aplicación en nuestro país. El 11 de enero entró en vigor la Ley de Datos (Data Act), que busca democratizar el acceso a los datos, estimular la innovación y garantizar un uso justo en todo el panorama digital de Europa. Puedes conocer más sobre ella en esta infografía que repasa los aspectos más importantes.

Por su parte, a nivel estatal, hemos visto cómo los datos abiertos van ganando protagonismo y su impulso se tiene cada vez más en cuenta en normativas sectoriales. Es el caso del Proyecto de Ley (PL) de Movilidad Sostenible, que, entre otras cuestiones, incluye el fomento de los datos abiertos tanto de administraciones, como de gestores de infraestructura y de operadores públicos y privados.

Esta es una tendencia que ya habíamos visto en los últimos días de 2023 con la convalidación del Real Decreto-ley 6/2023, de 19 de diciembre, por el que se aprueban medidas urgentes para la ejecución del Plan de Recuperación, Transformación y Resiliencia en materia de servicio público de justicia, función pública, régimen local y mecenazgo. En este Real Decreto-ley se incluye el principio general de orientación al dato y se incide en la publicación de datos automáticamente procesables en portales de datos abiertos accesibles a la ciudadanía. También la Estrategia de Inteligencia Artificial 2024, impulsada por el Gobierno, incluye referencias a los datos en poder de los organismos públicos. En concreto establece que se creará un modelo de gobernanza común de los datos y corpus documentales de la Administración General del Estado (AGE) de tal forma que se garanticen los estándares de seguridad, calidad, interoperabilidad y reutilización de todos los datos, disponibles para el entrenamiento de modelos.

En relación con la gobernanza, a finales de 2023 vivimos otro avance que ha tenido su reflejo en 2024: la adopción de la Ordenanza Tipo del Gobierno del Dato en la Entidad Local, aprobada por la Federación Española de Municipios y Provincias (FEMP). A lo largo de estos meses, distintos ayuntamientos han incorporado y adaptado esta ordenanza a su territorio. Es el caso de Zaragoza o Fuenlabrada.

Novedades en plataformas de datos

En este tiempo también se han materializado nuevas plataformas o herramientas que ponen los datos a disposición de ciudadanos y empresas:

- El Gobierno de España ha creado el Punto de Acceso Nacional de Tráfico y Movilidad, que incluye datos sobre las instalaciones con puntos de recarga de vehículos eléctricos, detallando el tipo de conector, formato, modo de carga, etc.

- El Instituto Nacional de Estadística (INE) ha puesto en marcha un Panel de Indicadores Ambientales. Con él, será posible cuantificar el cumplimiento de objetivos medioambientales, como el Pacto Verde. También ha creado una sección específica para los datos de alto valor.

- El Instituto de Estadística de las Illes Balears (IBESTAT) ha renovado su portal web, que cuenta con un apartado específico sobre datos abiertos.

- Open Data Euskadi ha publicado una nueva API que facilita la reutilización de los datos de contratación pública de la administración vasca.

- MUFACE (Mutualidad General de Funcionarios Civiles del Estado) ha lanzado un espacio con datos históricos y actuales de elección de entidad, asistencia sanitaria, etc.

- Algunas entidades locales que han puesto en marcha nuevos portales de datos son la Diputación de Málaga o el Ayuntamiento de Lucena (Córdoba).

- El Museo del Prado ha puesto en marcha una visita virtual que permite recorrer las principales colecciones en 360º. Además, ofrece una selección de 89 obras digitalizadas en gigapixel.

- Investigadores de la Universidad de Sevilla han colaborado en la puesta en marcha de PEPAdb (Prehistoric Europe’s Personal Adornment database), una herramienta online y accesible con datos referidos a elementos de adorno personal en la prehistoria reciente.

Además, se han firmado acuerdos para seguir avanzando en la apertura de datos e impulso a la reutilización, que ponen de manifiesto el compromiso con los datos abiertos e interoperables.

- El INE, la Agencia Estatal de Administración Tributaria (AEAT), la Seguridad Social, el Banco de España y el Servicio Público de Empleo Estatal (SEPE) han firmado un acuerdo para facilitar el acceso conjunto a bases de datos para investigaciones de interés público.

- Los ayuntamientos de Castelldefels, el Prat de Llobregat y Esparreguera se han unido al Sistema de Información Territorial Municipal (SITMUN) para compartir información geográfica y tener acceso a un sistema de información transversal.

- La Universidad Rey Juan Carlos y ASEDIE, la Asociación Multisectorial de la Información, han unido fuerzas para crear el Observatorio en Open Data Reuse que nace con la visión de catalizar el progreso y la transparencia en el ámbito infomediario, destacando la importancia de la economía basada en datos.

Impulso de la reutilización de los datos

Tanto los datos publicados previamente como los que se han publicado a raíz de estos trabajos permiten desarrollar productos y servicios que acercan información de valor a la ciudadanía. Algunos ejemplos creados recientemente son:

- El Gobierno ha lanzado una herramienta que permite conocer la ejecución e impacto de las inversiones del Plan de Recuperación, Transformación y Resiliencia.

- Los datos de la red de puertos, aeropuertos, terminales ferroviarias, carreteras y líneas ferroviarias se pueden consultar fácilmente con este visualizador del Ministerio de Transporte y Movilidad Sostenible.

- La Iniciativa Barcelona Open Data ha presentado una nueva versión del portal DadesXViolènciaXDones, una herramienta para analizar el impacto de las políticas contra la violencia machista.

- El ayuntamiento de Madrid ha mostrado cómo mide el uso del Parque Cuña Verde de O´Donnell a través del análisis de datos y su programa GovTech.

- Además, si entramos en el terreno del periodismo de datos, encontramos múltiples ejemplos, como este artículo de elDiario.es donde se puede visualizar, barrio a barrio, el precio del alquiler y el acceso a la vivienda según ingresos.

Estos datos combinados con inteligencia artificial permiten resolver y avanzar en retos sociales, como muestran los siguientes ejemplos:

- El proyecto WildINTEL, de la Universidad de Huelva, en colaboración con la Agencia Estatal Consejo Superior de Investigaciones Científicas (CSIC), busca monitorizar la vida silvestre en Europa. Combina ciencia ciudadana e IA para la recopilación y gestión eficaz de datos de biodiversidad.

- Expertos en la Universidad Internacional de La Rioja han desarrollado AymurAI, un proyecto que promueve la transparencia judicial y la igualdad de género mediante inteligencia artificial, basada en metodologías con perspectiva de género y datos abiertos.

- Dos investigadores cántabros han creado un modelo que permite predecir variables climáticas en tiempo real y en alta resolución mediante inteligencia artificial.

Por otro lado, para impulsar la reutilización de los datos abiertos, los organismos públicos han puesto en marcha concursos e iniciativas que han facilitado la creación de nuevos productos y servicios. Algunos ejemplos de estos últimos meses son:

- El VII concurso de datos abiertos de Castilla y León.

- Los premios Pedro R. Muro-Medrano de la Universidad de Zaragoza.

- Los premios para proyectos de datos abiertos y periodismo de datos del Ayuntamiento de València.

Nuevos informes y recursos ligados a los datos abiertos

Algunos de los informes relativos a datos abiertos y su reutilización publicados en el primer semestre del año son:

- El “Informe ASEDIE : Economía del Dato en el ámbito infomediario”, que ya va por su edición número doce.

- El informe también de ASEDIE "Los datos geoespaciales en el Ministerio de Transportes y Movilidad Sostenible. Impacto de la información coproducida por IGN y CNIG".

- El informe "La reutilización de datos abiertos en España" de la Fundación COTEC.

- La "Guía de Buenas Prácticas para Periodistas de Datos" elaborada en el Observatori de Dades Obertes i Transparència de la Universitat Politècnica de València (UPV).

También se han celebrado gran cantidad de eventos, algunos se pueden ver en diferido y de otros se han elaborado crónicas-resumen:

- El "III Encuentro Nacional de Datos Abiertos (ENDA): Datos para el impulso del sector turístico", organizado por la Diputación de Castellón, la Diputación de Barcelona y el Gobierno de Aragón.

- La mesa redonda “Construyendo Inteligencia Turística: Compartición de datos para decisiones estratégicas del sector turístico” organizada por SEGITTUR (Sociedad Mercantil Estatal para la Gestión de la Innovación y las Tecnologías Turísticas) como parte del Fitur Know-how & Export.

- La sesión "La gestión del agua con datos abiertos" organizada en el marco de la iniciativa CafèAmbDades de la Generalitat de Catalunya.

- El taller del Portal Europeo de Datos "How to use open data for your research", con participación de la Universidad Politécnica de Madrid.

Estos son algunos ejemplos que ponen de manifiesto la gran actividad producida en el entorno de los datos abiertos durante los últimos seis meses. ¿Conoces algún ejemplo más? ¡Déjanoslo en comentarios o escribe a dinamizacion@datos.gob.es!

1. Introducción

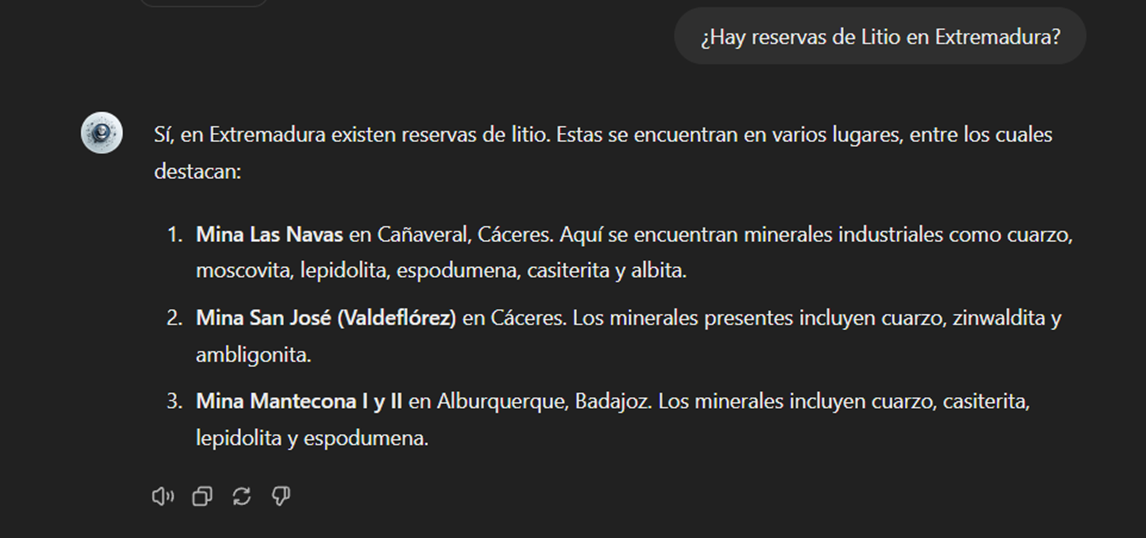

En la era de la información, la inteligencia artificial ha demostrado ser una herramienta invaluable para una variedad de aplicaciones. Una de las manifestaciones más increíbles de esta tecnología es GPT (Generative Pre-trained Transformer), desarrollado por OpenAI. GPT es un modelo de lenguaje natural que puede entender y generar texto, ofreciendo respuestas coherentes y contextualmente relevantes. Con la reciente introducción de Chat GPT-4, las capacidades de este modelo se han ampliado aún más, permitiendo una mayor personalización y adaptabilidad a diferentes temáticas.

En este post, te mostraremos cómo configurar y personalizar un asistente especializado en minerales críticos utilizando GPT-4 y fuentes de datos abiertas. Como ya mostramos en previas publicaciones, los minerales críticos son fundamentales para numerosas industrias, incluyendo la tecnología, la energía y la defensa, debido a sus propiedades únicas y su importancia estratégica. Sin embargo, la información sobre estos materiales puede ser compleja y dispersa, lo que hace que un asistente especializado sea particularmente útil.

El objetivo de este post es guiarte paso a paso desde la configuración inicial hasta la implementación de un asistente GPT que pueda ayudarte a resolver dudas y proporcionar información valiosa sobre minerales críticos en tu día a día. Además, exploraremos cómo personalizar aspectos del asistente, como el tono y el estilo de las respuestas, para que se adapte perfectamente a tus necesidades. Al final de este recorrido, tendrás una herramienta potente y personalizada que transformará la manera en que accedes y utilizas la información en abierto sobre minerales críticos.

Accede al repositorio del laboratorio de datos en Github.

En este vídeo, el autor te explica que vas a encontrar tanto en el Github como en Google Colab.

2. Contexto

La transición hacia un futuro sostenible no solo implica cambios en las fuentes de energía, sino también en los recursos materiales que utilizamos. El éxito de sectores como baterías de almacenamiento de energía, aerogeneradores, paneles solares, electrolizadores, drones, robots, redes de transmisión de datos, dispositivos electrónicos o satélites espaciales, depende enormemente del acceso a las materias primas críticas para su desarrollo. Entendemos que un mineral es crítico cuando se cumplen los siguientes factores:

- Sus reservas mundiales son escasas

- No existen materiales alternativos que puedan ejercer su función (sus propiedades son únicas o muy singulares)

- Son materiales indispensables para sectores económicos clave de futuro, y/o su cadena de suministro es de elevado riesgo

Puedes aprender más sobre los minerales críticos en el post mencionado anteriormente.

3. Objetivo

Este ejercicio se centra en mostrar al lector cómo personalizar un modelo GPT especializado para un caso de uso concreto. Adoptaremos para ello el enfoque “aprender haciendo”, de tal forma que el lector pueda comprender cómo configurar y ajustar el modelo para resolver un problema real y relevante, como el asesoramiento experto en minerales críticos. Este enfoque práctico no solo mejora la comprensión de las técnicas de personalización de modelos de lenguaje, sino que también prepara a los lectores para aplicar estos conocimientos en la resolución de problemas reales, ofreciendo una experiencia de aprendizaje rica y directamente aplicable a sus propios proyectos.

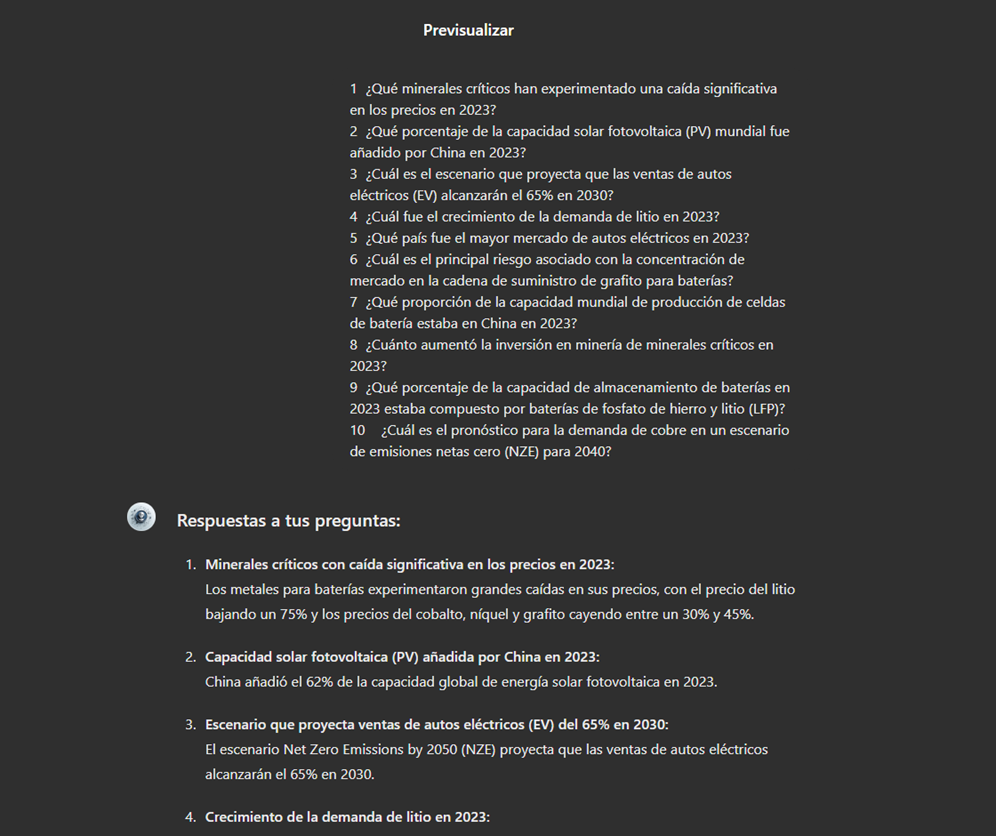

El asistente GPT especializado en minerales críticos estará diseñado para convertirse en una herramienta esencial para profesionales, investigadores y estudiantes. Su objetivo principal será facilitar el acceso a información precisa y actualizada sobre estos materiales, apoyar la toma de decisiones estratégicas y promover la educación en este campo. A continuación, se detallan los objetivos específicos que buscamos alcanzar con este asistente:

- Proporcionar información precisa y actualizada:

- El asistente debe ofrecer información detallada y precisa sobre diversos minerales críticos, incluyendo su composición, propiedades, usos industriales y disponibilidad.

- Mantenerse actualizado con las últimas investigaciones y tendencias del mercado en el ámbito de los minerales críticos.

- Asistir en la toma de decisiones:

- Proporcionar datos y análisis que puedan ayudar en la toma de decisiones estratégicas en la industria y la investigación sobre minerales críticos.

- Ofrecer comparativas y evaluaciones de diferentes minerales en función de su rendimiento, coste y disponibilidad.

- Promover la educación y la concienciación en torno a esta temática:

- Actuar como una herramienta educativa para estudiantes, investigadores y profesionales, ayudando a mejorar su conocimiento sobre los minerales críticos.

- Aumentar la conciencia sobre la importancia de estos materiales y los desafíos relacionados con su suministro y sostenibilidad.

4. Recursos

Para configurar y personalizar nuestro asistente GPT especializado en minerales críticos, es esencial disponer de una serie de recursos que faciliten la implementación y aseguren la precisión y relevancia de las respuestas del modelo. En este apartado, detallaremos los recursos necesarios que incluyen tanto las herramientas tecnológicas como las fuentes de información que serán integradas en la base de conocimiento del asistente.

Herramientas y Tecnologías

Las herramientas y tecnologías clave para desarrollar este ejercicio son:

- Cuenta de OpenAI: necesaria para acceder a la plataforma y utilizar el modelo GPT-4. En este post, utilizaremos la suscripción Plus de ChatGPT para mostrarte cómo crear y publicar un GPT personalizado. No obstante, puedes desarrollar este ejercicio de forma similar utilizando una cuenta gratuita de OpenAI y realizando el mismo conjunto de instrucciones a través de una conversación de ChatGPT estándar.

- Microsoft Excel: hemos diseñado este ejercicio de forma que cualquier persona sin conocimientos técnicos pueda desarrollarlo de principio a fin. Únicamente nos apoyaremos en herramientas ofimáticas como Microsoft Excel para realizar algunas adecuaciones de los datos descargados.

De forma complementaria, utilizaremos otro conjunto de herramientas que nos permitirán automatizar algunas acciones sin ser estrictamente necesaria su utilización:

- Google Colab: es un entorno de Python Notebooks que se ejecuta en la nube, permitiendo a los usuarios escribir y ejecutar código Python directamente en el navegador. Google Colab es especialmente útil para el aprendizaje automático, el análisis de datos y la experimentación con modelos de lenguaje, ofreciendo acceso gratuito a potentes recursos de computación y facilitando la colaboración y el intercambio de proyectos.

- Markmap: es una herramienta que visualiza mapas mentales de Markdown en tiempo real. Los usuarios escriben ideas en Markdown y la herramienta las renderiza como un mapa mental interactivo en el navegador. Markmap es útil para la planificación de proyectos, la toma de notas y la organización de información compleja visualmente. Facilita la comprensión y el intercambio de ideas en equipos y presentaciones.

Fuentes de Información

- Raw Materials Information System (RMIS): sistema de información sobre materias primas mantenido por el Joint Research Center de la Unión Europea. Proporciona datos detallados y actualizados sobre la disponibilidad, producción y consumo de materias primas en Europa.

- Catálogo de informes y datos de la Agencia Internacional de la Energía (IEA en sus siglas en inglés): ofrece un amplio catálogo de informes y datos relacionados con la energía, incluyendo estadísticas sobre producción, consumo y reservas de minerales energéticos y críticos.

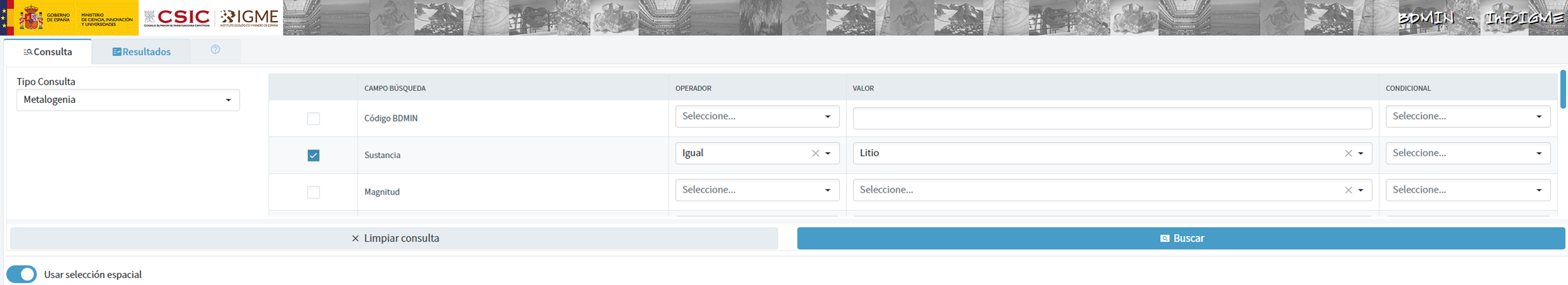

- Base de datos de minerales del Instituto Geológico y Minero Español (BDMIN): contiene información detallada sobre los minerales y depósitos minerales en España, útil para obtener datos específicos sobre la producción y reservas de minerales críticos en el país.

Con estos recursos, estarás bien equipado para desarrollar un asistente GPT especializado que pueda proporcionar respuestas precisas y relevantes sobre minerales críticos, facilitando la toma de decisiones informadas en este campo.

5. Desarrollo del ejercicio

5.1. Construcción de la base de conocimiento

Para que nuestro asistente GPT especializado en minerales críticos sea verdaderamente útil y preciso, es esencial construir una base de conocimiento sólida y estructurada. Esta base de conocimiento será el conjunto de datos e información que el asistente utilizará para responder a las consultas. La calidad y relevancia de esta información determinarán la eficacia del asistente en proporcionar respuestas precisas y útiles.

Búsqueda de Fuentes de Datos

Comenzamos con la recopilación de fuentes de información que nutrirán nuestra base de conocimiento. No todas las fuentes de información son igualmente fiables. Es fundamental evaluar la calidad de las fuentes identificadas, asegurando que:

- La información esté actualizada: la relevancia de los datos puede cambiar con rapidez, especialmente en campos dinámicos como el de los minerales críticos.

- La fuente sea confiable y reconocida: es necesario utilizar fuentes de instituciones reconocidas y respetadas en el ámbito académico y profesional.

- Los datos sean completos y accesibles: es crucial que los datos sean detallados y que estén accesibles para su integración en nuestro asistente.

En nuestro caso, desarrollamos una búsqueda online en diferentes plataformas y repositorios de información tratando de seleccionar información perteneciente a diversas entidades reconocidas:

- Centros de investigación y universidades:

- Publican estudios y reportes detallados sobre la investigación y desarrollo de minerales críticos.

- Ejemplo: RMIS del Joint Research Center de la Unión Europea.

- Instituciones gubernamentales y organismos internacionales:

- Estas entidades suelen proporcionar datos exhaustivos y actualizados sobre la disponibilidad y el uso de minerales críticos.

- Ejemplo: Agencia Internacional de la Energía (IEA).

- Bases de datos especializadas:

- Contienen datos técnicos y específicos sobre depósitos y producción de minerales críticos.

- Ejemplo: Base de datos de Minerales del Instituto Geológico y Minero español (BDMIN).

Selección y preparación de la información

Nos centraremos ahora en la selección y preparación de la información existente en estas fuentes para asegurar que nuestro asistente GPT pueda acceder a datos precisos y útiles.

RMIS del Joint Research Center de la Unión Europea:

- Información seleccionada:

Seleccionamos el informe “Supply chain analysis and material demand forecast in strategic technologies and sectors in the EU – A foresight study”. Se trata de un análisis de la cadena de suministro y la demanda de minerales en tecnologías y sectores estratégicos de la UE. Presenta un estudio detallado de las cadenas de suministro de materias primas críticas y pronostica la demanda de minerales hasta 2050.

- Preparación necesaria:

El formato del documento, PDF, permite la ingesta directa de la información por parte de nuestro asistente. No obstante, como se observa en la Figura 1, existe una tabla especialmente relevante en sus páginas 238-240 donde se analiza, para cada mineral, su riesgo de suministro, tipología (estratégico, crítico o no crítico) y las tecnologías clave que lo emplean. Decidimos, por ello, extraer esta tabla a un formato estructurado (CSV), de tal forma que dispongamos de dos piezas de información que pasarán a formar parte de nuestra base de conocimiento.

Figura 1: Tabla de minerales contenida en el PDF de JRC

Para extraer de forma programática los datos contenidos en esta tabla y transformarlos en un formato más fácilmente procesable, como CSV (comma separated values o valores separados por comas), utilizaremos un script de Python que podemos utilizar a través de la plataforma Google Colab (Figura 2).

Figura 2: Script Python para la extracción de datos del PDF de JRC desarrollado en plataforma Google Colab.

A modo de resumen, este script:

- Se apoya en la librería de código abierto PyPDF2, capaz de interpretar información contenida en ficheros PDF.

- Primero, extrae en formato texto (cadena de caracteres) el contenido de las páginas del PDF donde se encuentra la tabla de minerales eliminando todo el contenido que no se corresponde con la propia tabla.

- Posteriormente, recorre, línea a línea, la cadena de caracteres convirtiendo los valores en columnas de una tabla de datos. Sabremos que un mineral es utilizado en una tecnología clave si en la columna correspondiente de dicho mineral encontramos un número 1 (en caso contrario contendrá un 0).

- Por último, exporta dicha tabla a un fichero CSV para su posterior utilización.

Agencia Internacional de la Energía (IEA):

- Información seleccionada:

Seleccionamos el informe “Global Critical Minerals Outlook 2024”. Este proporciona una visión general de los desarrollos industriales en 2023 y principios de 2024, y ofrece perspectivas a medio y largo plazo para la demanda y oferta de minerales clave para la transición energética. También evalúa los riesgos para la fiabilidad, sostenibilidad y diversidad de las cadenas de suministro de minerales críticos.

- Preparación necesaria: