1. Introducción

Las visualizaciones son representaciones gráficas de datos que permiten comunicar de manera sencilla y efectiva la información ligada a los mismos. Las posibilidades de visualización son muy amplias, desde representaciones básicas, como puede ser un gráfico de líneas, barras o sectores, hasta visualizaciones configuradas sobre cuadros de mando o dashboards interactivos.

En esta sección de “Visualizaciones paso a paso” estamos presentando periódicamente ejercicios prácticos de visualizaciones de datos abiertos disponibles en datos.gob.es u otros catálogos similares. En ellos se abordan y describen de manera sencilla las etapas necesarias para obtener los datos, realizar las transformaciones y análisis que resulten pertinentes para, finalmente, la creación de visualizaciones interactivas, de las que podemos extraer información resumida en unas conclusiones finales. En cada uno de estos ejercicios prácticos, se utilizan sencillos desarrollos de código convenientemente documentados, así como herramientas de uso gratuito. Todo el material generado está disponible para su reutilización en el repositorio de GitHub.

En este ejercicio práctico, hemos realizado un sencillo desarrollo de código que está convenientemente documentado apoyandonos en herramientas de uso gratuito.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

2. Objetivo

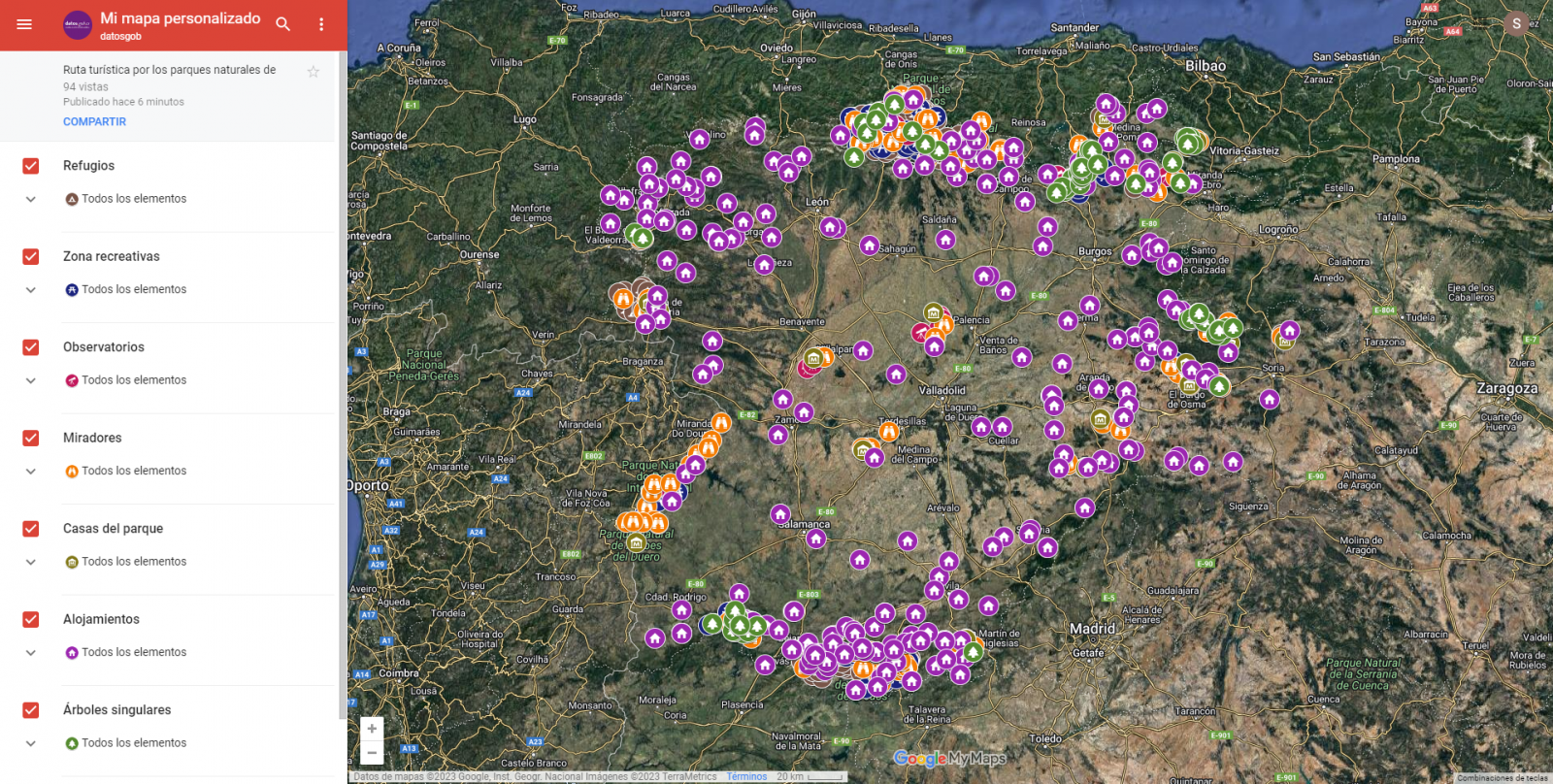

El objetivo principal de este post es mostrar cómo generar un mapa personalizado de Google Maps mediante la herramienta "My Maps" partiendo de datos abiertos. Este tipo de mapas son altamente populares en páginas, blogs y aplicaciones del sector turístico, no obstante, la información útil proporcionada al usuario suele ser escasa.

En este ejercicio, utilizaremos el potencial de los datos abiertos para ampliar la información a mostrar en nuestro mapa y hacerlo de una forma automática. También mostraremos como realizar un enriquecimiento de los datos abiertos para añadir información de contexto que mejore significativamente la experiencia de usuario.

Desde un punto de vista funcional, el objetivo del ejercicio es la creación de un mapa personalizado para planificar rutas turísticas por los espacios naturales de la Comunidad Autónoma de Castilla y León. Para ello se han utilizado conjuntos de datos abiertos publicados por la Junta de Castilla y León, que hemos preprocesado y adaptado a nuestras necesidades de cara a generar el mapa personalizado.

3. Recursos

3.1. Conjuntos de datos

Los conjuntos de datos contienen distinta información turística de interés geolocalizada. Dentro del catálogo de datos abiertos de la Junta de Castilla y León, encontramos el “diccionario de entidades” (sección información adicional), documento de vital importancia, ya que nos define la terminología utilizada en los distintos conjuntos de datos.

Estos conjuntos de datos también se encuentran disponibles en el repositorio de Github

3.2. Herramientas

Para la realización de las tareas de preprocesado de los datos se ha utilizado el lenguaje de programación Python escrito sobre un Notebook de Jupyter alojado en el servicio en la nube de Google Colab.

"Google Colab" o también llamado "Google Colaboratory", es un servicio gratuito en la nube de Google Research que permite programar, ejecutar y compartir código escrito en Python o R desde tu navegador, por lo que no requiere la instalación de ninguna herramienta o configuración.

Para la creación de la visualización interactiva se ha usado la herramienta Google My Maps.

"Google My Maps" es una herramienta online que permite crear mapas interactivos que pueden ser incrustados en sitios web o exportarse como archivos. Esta herramienta es gratuita, sencilla de usar y permite múltiples opciones de personalización.

Si quieres conocer más sobre herramientas que puedan ayudarte en el tratamiento y la visualización de datos, puedes recurrir al informe "Herramientas de procesado y visualización de datos".

4. Tratamiento o preparación de los datos

Los procesos que te describimos a continuación los encontrarás comentados en el Notebook que podrás ejecutar desde Google Colab.

Antes de lanzarnos a construir una visualización efectiva, debemos realizar un tratamiento previo de los datos, prestando especial atención a la obtención de los mismos y validando su contenido, asegurando que se encuentran en el formato adecuado y consistente para su procesamiento y que no contienen errores.

Como primer paso del proceso es necesario realizar un análisis exploratorio de los datos (EDA) con el fin de interpretar adecuadamente los datos de partida, detectar anomalías, datos ausentes o errores que pudieran afectar a la calidad de los procesos posteriores y resultados. Si quieres conocer más sobre este proceso puedes recurrir a la Guía Práctica de Introducción al Análisis Exploratorio de Datos.

El siguiente paso a dar es generar las tablas de datos preprocesados que usaremos para alimentar el mapa. Para ello, transformaremos los sistemas de coordenadas, modificaremos y filtraremos la información según nuestras necesidades.

Los pasos que se siguen en este preprocesamiento de los datos, explicados en el Notebook, son los siguientes:

- Instalación y carga de librerías

- Carga de los conjuntos de datos

- Análisis exploratorio de datos (EDA)

- Preprocesamiento de los conjuntos de datos

- Transformación de coordenadas

- Filtrado de la información

- Representación gráfica de los conjuntos de datos

- Almacenamiento de las nuevas tablas de datos transformadas

Durante el preprocesado de las tablas de datos, hay que hacer un cambio de sistema de coordenadas ya que en los conjuntos de datos de origen el sistema en el que se encuentran es ESTR89 (sistema estándar que se usa en la Unión Europea), mientras que las necesitaremos en el sistema WGS84 (sistema usado por Google My Maps entre otras aplicaciones geográficas). La forma de realizar este cambio de coordenadas se encuentra explicado en el Notebook. Si quieres saber más sobre tipos y sistemas de coordenadas, puedes recurrir a la “Guía de datos espaciales”

Una vez terminado el preprocesamiento, obtendremos las tablas de datos "recreativas_parques_naturales.csv", "alojamientos_rurales_2estrellas.csv", "refugios_parques_naturales.csv", "observatorios_parques_naturales.csv", "miradores_parques_naturales.csv", "casas_del_parque.csv", "arboles_parques_naturales.csv" las cuales incluyen campos de información genéricos y comunes como: nombre, observaciones, geoposición, … junto a campos de información específicos, los cuales se definen en detalle en el apartado 6.2 Personalización de la información a mostrar en el mapa.

Podrás reproducir este análisis, ya que el código fuente está disponible en nuestra cuenta de GitHub. La forma de proporcionar el código es a través de un documento realizado sobre un Jupyter Notebook que una vez cargado en el entorno de desarrollo podrás ejecutar o modificar de manera sencilla. Debido al carácter divulgativo de este post y para favorecer el entendimiento de los lectores no especializados, el código no pretende ser el más eficiente, sino facilitar su comprensión por lo que posiblemente se te ocurrirán muchas formas de optimizar el código propuesto para lograr fines similares. ¡Te animamos a que lo hagas!

5. Enriquecimiento de los datos

Con la finalidad de aportar mayor información relacionada, se realiza un proceso de enriquecimiento de datos sobre el conjunto de datos “registro de alojamientos hoteleros” explicado a continuación. Con este paso vamos a lograr añadir de forma automática información complementaria que no está inicialmente incluida. Con ello, conseguiremos mejorar la experiencia del usuario durante su uso del mapa al proporcionar información de contexto relacionada con cada punto de interés.

Para ello vamos a utilizar una herramienta útil para este tipo de tarea, OpenRefine. Esta herramienta de código abierto permite realizar múltiples acciones de preprocesamiento de datos, aunque en esta ocasión la usaremos para llevar a cabo un enriquecimiento de nuestros datos mediante la incorporación de contexto enlazando automáticamente información que reside en el popular repositorio de conocimiento Wikidata.

Una vez instalada la herramienta en nuestro ordenador, al ejecutarse se abrirá una aplicación web en el navegador.

A continuación, se detallan los pasos a seguir.

Paso 1

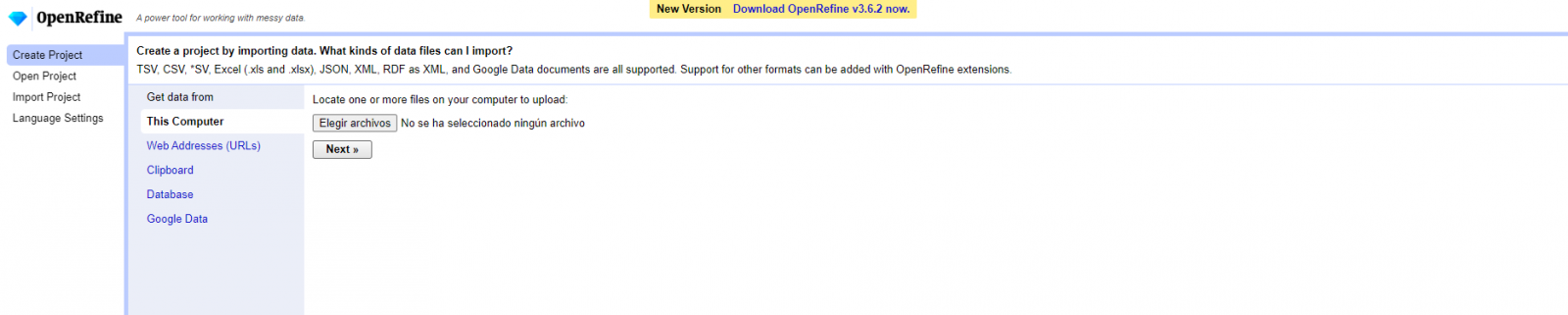

Carga del CSV en el sistema (Figura 1). En esta caso, el conjunto de datos “Registro de alojamientos hoteleros”.

Figura 1. Carga de archivo CSV en OpenRefine

Paso 2

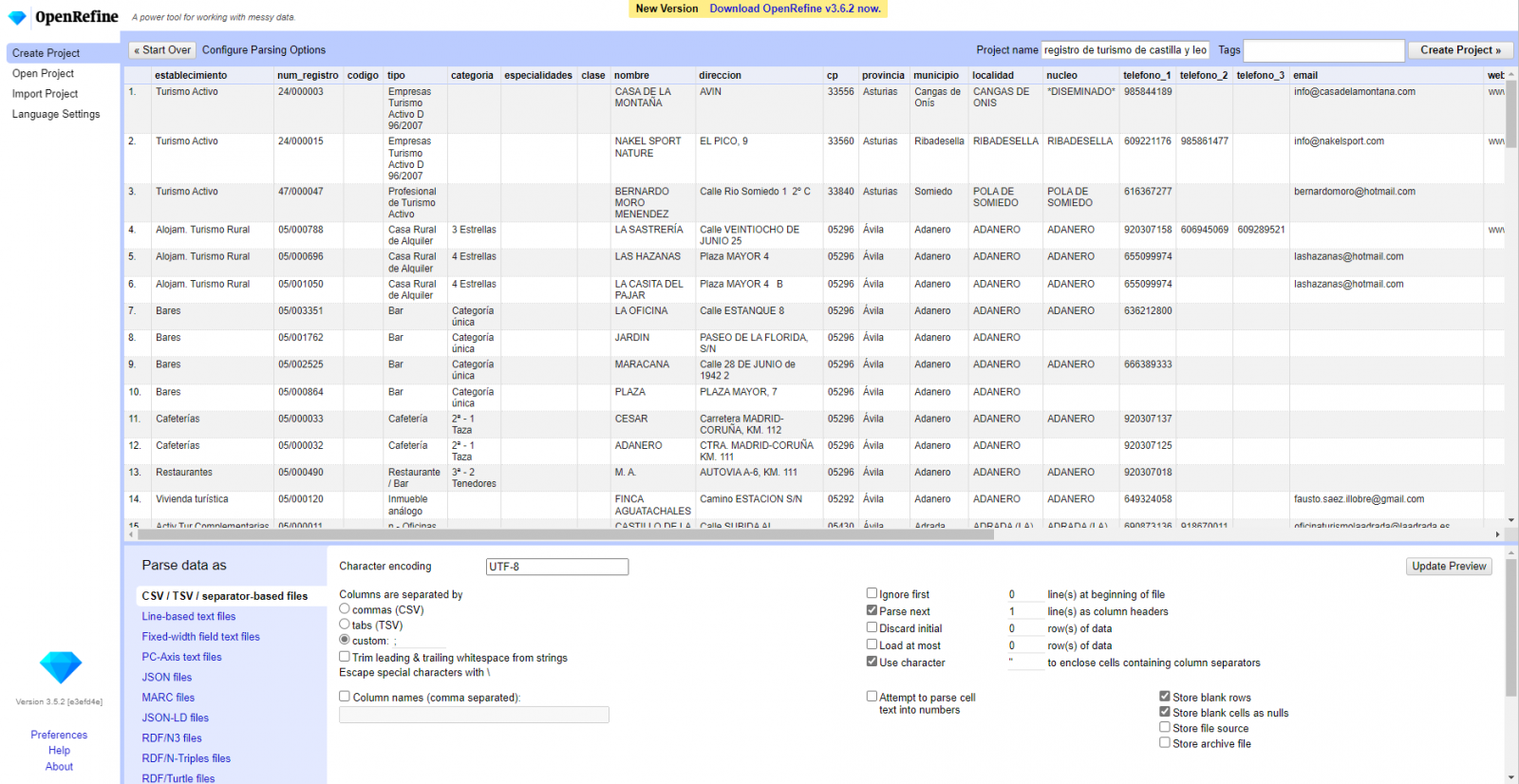

Creación del proyecto a partir del CSV cargado (Figura 2). OpenRefine se gestiona mediante proyectos (cada CSV subido será un proyecto), que se guardan en el ordenador dónde se esté ejecutando OpenRefine para un posible uso posterior. En este paso debemos dar un nombre al proyecto y algunos otros datos, como el separador de columnas, aunque lo más habitual es que estos últimos ajustes se rellenen automáticamente.

Figura 2. Creación de un proyecto en OpenRefine

Paso 3

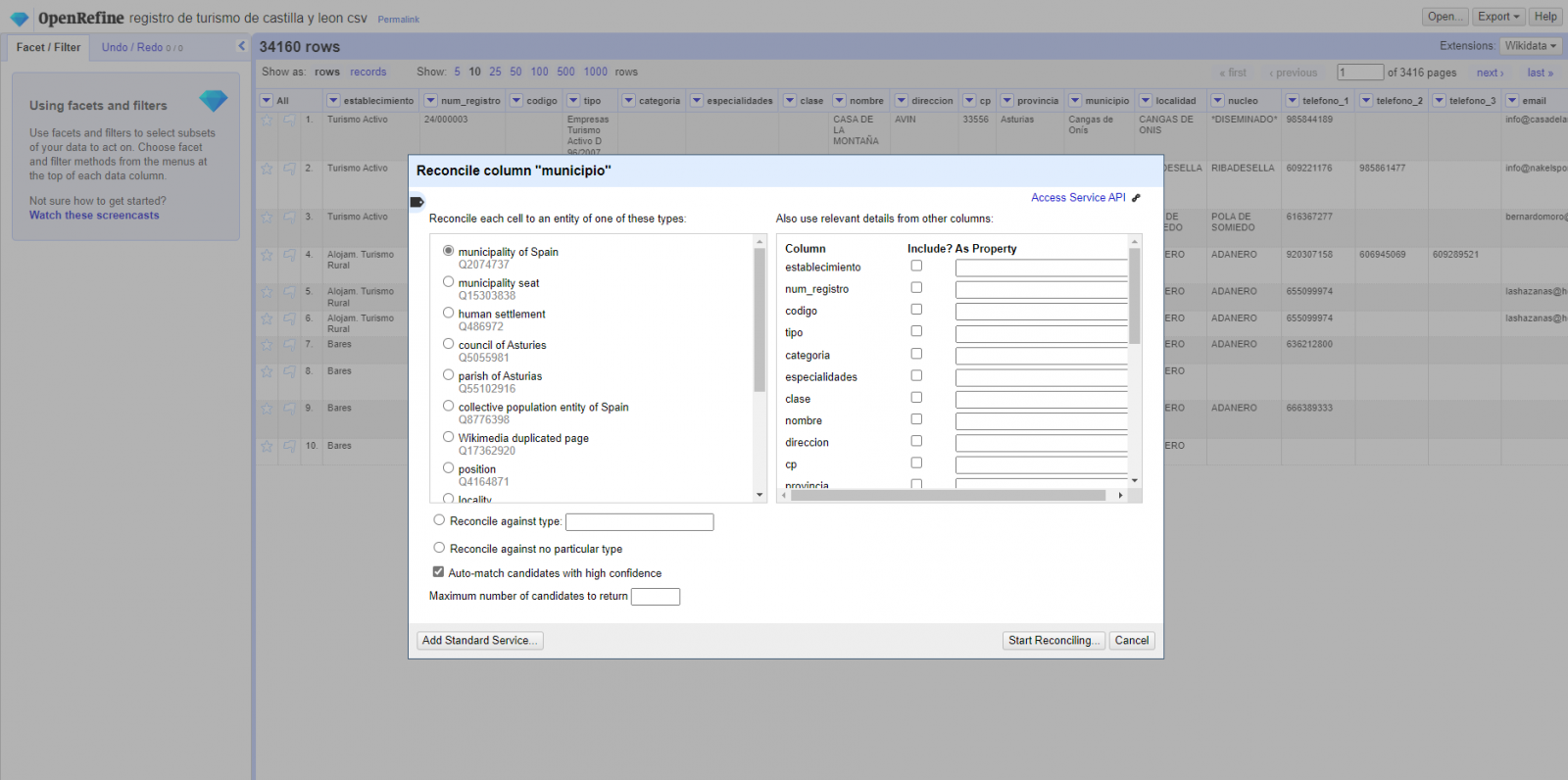

Enlazado (o reconciliación, usando la nomenclatura de OpenRefine) con fuentes externas. OpenRefine nos permite enlazar recursos que tengamos en nuestro CSV con fuentes externas como Wikidata. Para ello se deben realizar las siguientes acciones:

- Identificación de las columnas a enlazar. Habitualmente este paso suele estar basado en la experiencia del analista y su conocimiento de los datos que se representan en Wikidata. Como consejo, de forma genérica se podrán reconciliar o enlazar aquellas columnas que contengan información de carácter más global o general como nombres de países, calles, distritos, etc., y no se podrán enlazar aquellas columnas como coordenadas geográficas, valores numéricos o taxonomías cerradas (tipos de calles, por ejemplo). En este ejemplo, disponemos de la columna “municipios” que contiene el nombre de los municipios españoles.

- Comienzo de la reconciliación. (Figura 3) Comenzamos la reconciliación y seleccionamos la fuente por defecto que estará disponible: Wikidata(en). Después de hacer clic en Start Reconciling, automáticamente comenzará a buscar la clase del vocabulario de Wikidata que más se adecue basado en los valores de nuestra columna.

Figura 3. Selección de la clase que mejor representa los valores de la columna "municipio"

- Obtención de los valores de la reconciliación. OpenRefine nos ofrece la posibilidad de mejorar el proceso de reconciliación agregando algunas características que permitan orientar el enriquecimiento de la información con mayor precisión.

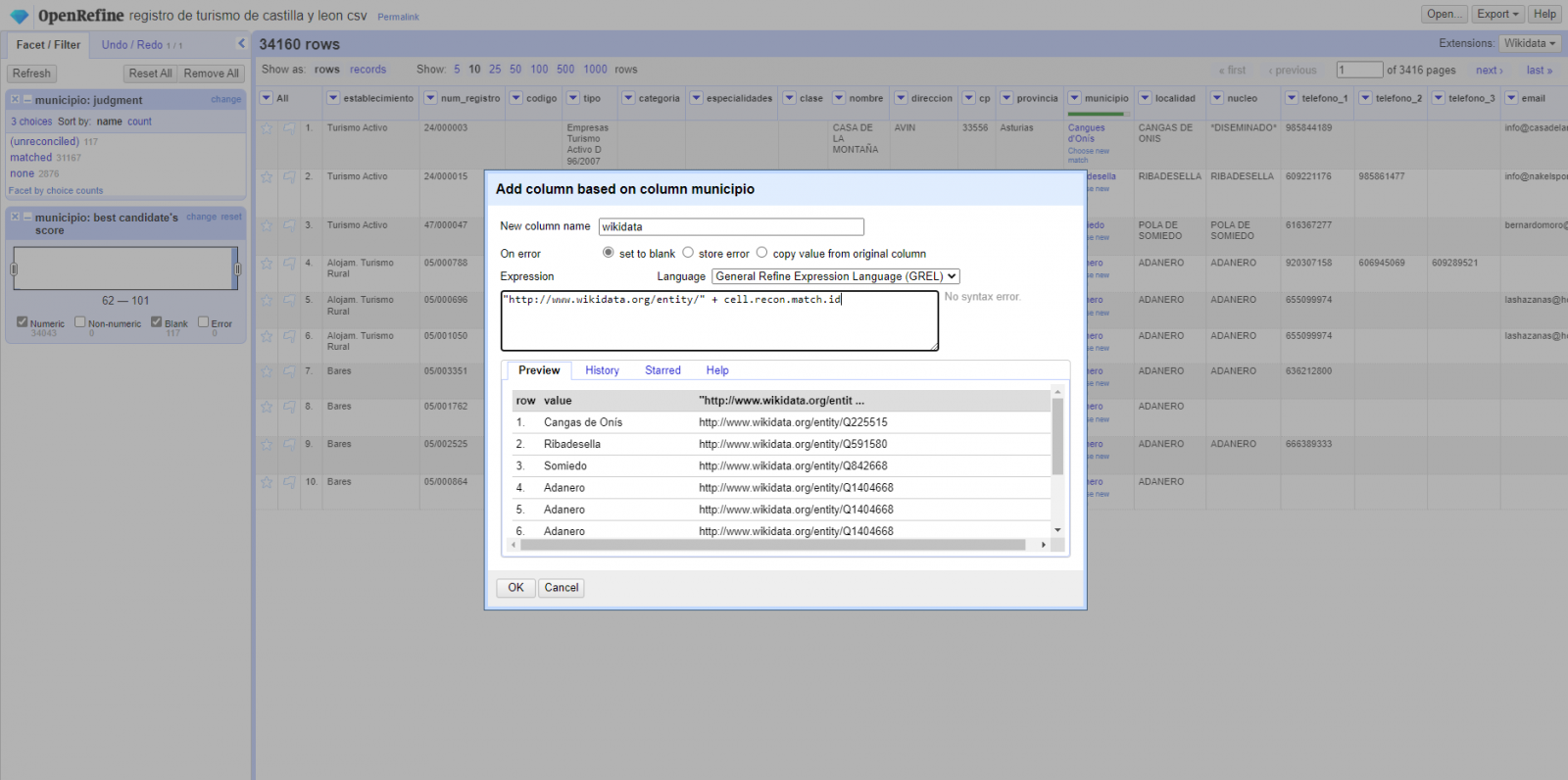

Paso 4

Generar una nueva columna con los valores reconciliados o enlazados. (Figura 4) Para ello debemos pulsar en la columna “municipio” e ir a “Edit Column → Add column based in this column”, dónde se mostrará un texto en la que tendremos que indicar el nombre de la nueva columna (en este ejemplo podría ser “wikidata”). En la caja de expresión deberemos indicar: “http://www.wikidata.org/entity/”+cell.recon.match.id y los valores aparecen como se previsualiza en la Figura. “http://www.wikidata.org/entity/” se trata de una cadena de texto fija para representar las entidades de Wikidata, mientras el valor reconciliado de cada uno de los valores lo obtenemos a través de la instrucción cell.recon.match.id, es decir, cell.recon.match.id(“Adanero”) = Q1404668

Mediante la operación anterior, se generará una nueva columna con dichos valores. Con el fin de comprobar que se ha realizado correctamente, haciendo clic en una de las celdas de la nueva columna, está debería conducir a una página web de Wikidata con información del valor reconciliado.

Figura 4. Generación de nueva columna con valores reconciliados

Paso 5

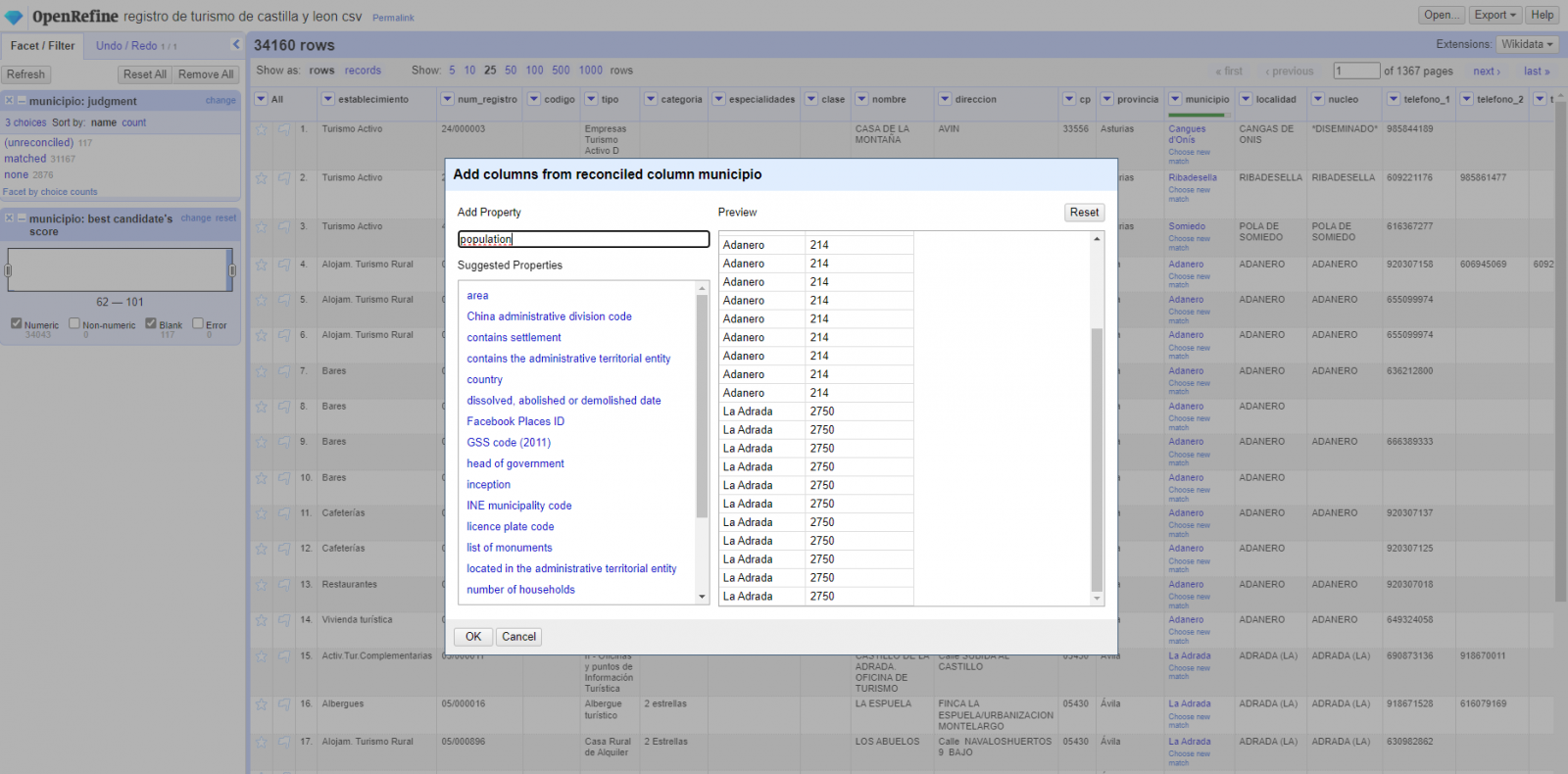

El proceso lo repetimos modificando en el paso 4 el “Edit Column → Add column based in this column” por “Add columns from reconciled values” (Figura 5). De esta forma, podremos elegir la propiedad de la columna reconciliada.

En este ejercicio hemos elegido la propiedad “image” con identificador P18 y la propiedad “population” con identificador P1082. No obstante, podríamos añadir todas las propiedades que consideremos útiles, como el número de habitantes, el listado de monumentos de interés, etc. Cabe destacar que al igual que enriquecemos los datos con Wikidata, podemos hacerlo con otros servicios de reconciliación.

Figura 5. Elección propiedad para reconciliación

En el caso de la propiedad “image”, debido a la visualización, queremos que el valor de las celdas tenga forma de link, por lo que hemos realizado varios ajustes. Estos ajustes han sido la generación de varias columnas según los valores reconciliados, adecuación de las columnas mediante comandos en lenguaje GREL (lenguaje propio de OpenRefine) y unión de los diferentes valores de ambas columnas. Puedes consultar estos ajustes y más técnicas para mejorar tu manejo de OpenRefine y adaptarlo a tus necesidades en el siguiente User Manual.

6. Visualización del mapa

6.1 Generación del mapa con "Google My Maps"

Para generar el mapa personalizado mediante la herramienta My Maps, hemos seguidos los siguientes pasos:

- Iniciamos sesión con una cuenta Google y vamos a "Google My Maps", teniendo acceso de forma gratuita sin tener que descargar ningún tipo de software.

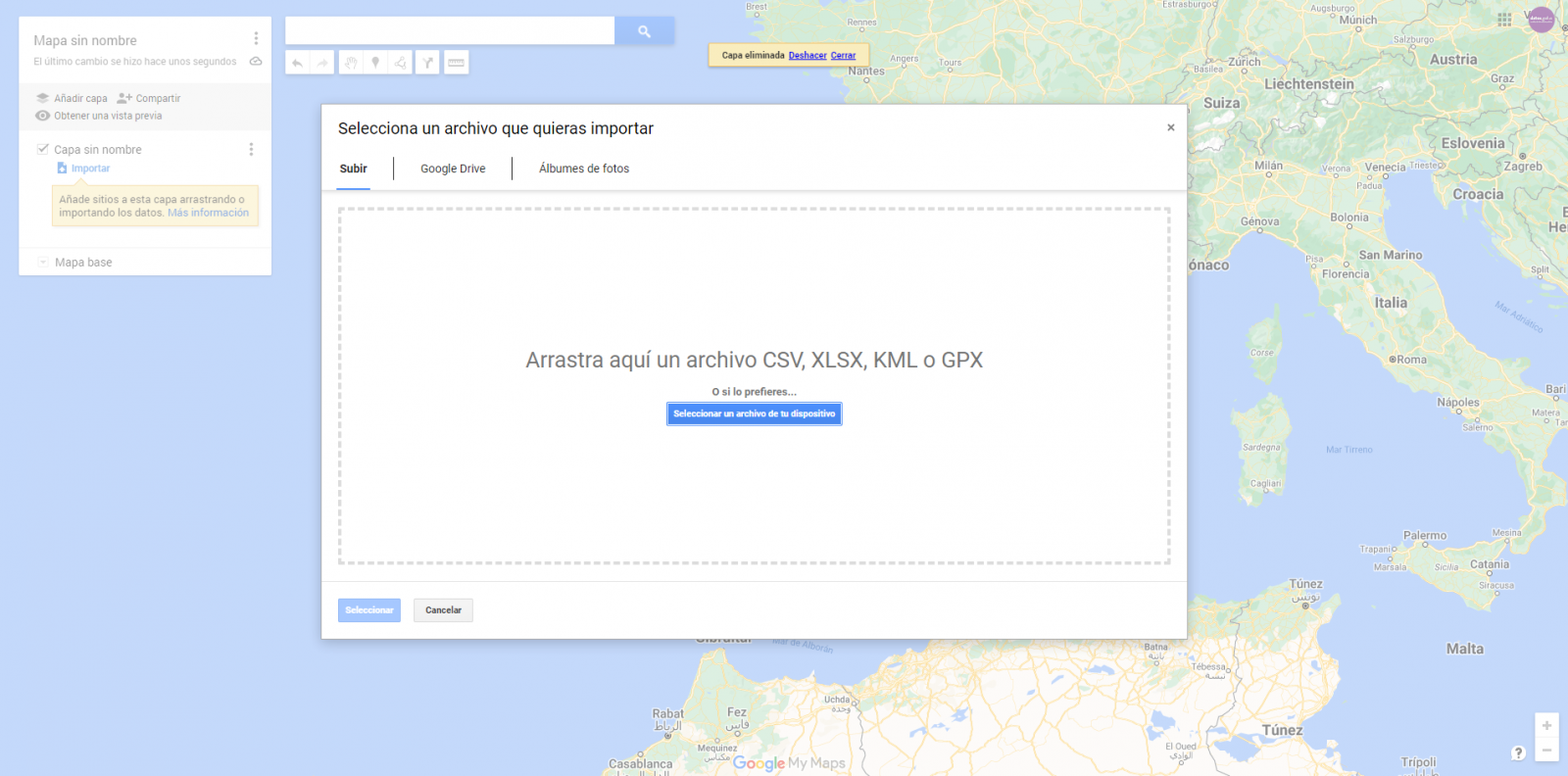

- Importamos las tablas de datos preprocesados, uno por cada nueva capa que añadimos al mapa. Google My Maps permite importar archivos CSV, XLSX, KML y GPX (Figura 6), los cuales deberán tener asociada información geográfica. Para realizar este paso, primero se debe crear una capa nueva desde el menú de opciones lateral.

Figura 6. Importación de archivos en "Google My Maps"

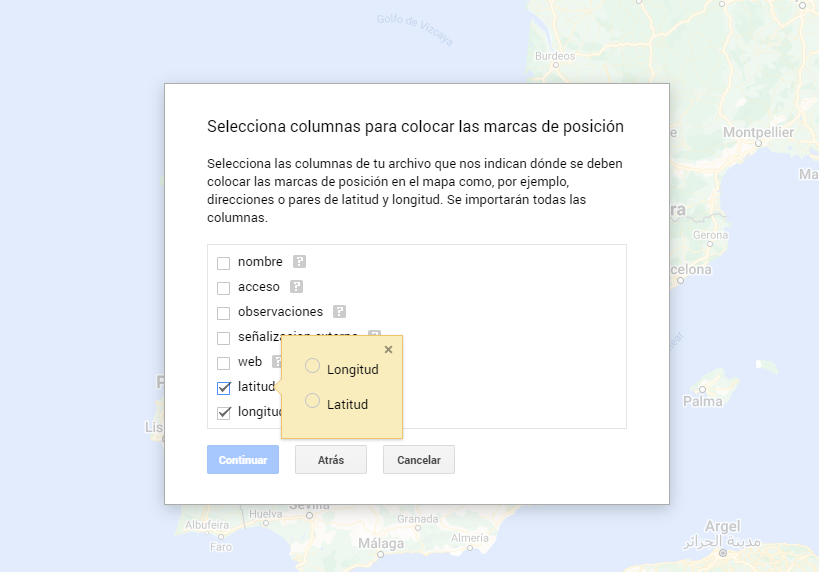

- En este caso práctico, importaremos tablas de datos preprocesados que contienen una variable con la latitud y otra con la longitud. Esta información geográfica se reconocerá automáticamente. My Maps también reconoce direcciones, códigos postales, países, ...

Figura 7. Selección columnas con valores de posición

- Mediante la opción de editar estilo que aparece en el menú lateral izquierdo, en cada una de las capas, podemos personalizar los pines, editando el color y su forma.

Figura 8. Edicción de pines de posición

- Por último, podemos elegir el mapa base que queremos visualizar en la parte inferior de la barra lateral de opciones.

Figura 9. Selección de mapa base

Si quieres conocer más sobre los pasos para la generación de mapas con “Google My Maps”, consulta el siguiente tutorial paso a paso.

6.2 Personalización de la información a mostrar en el mapa

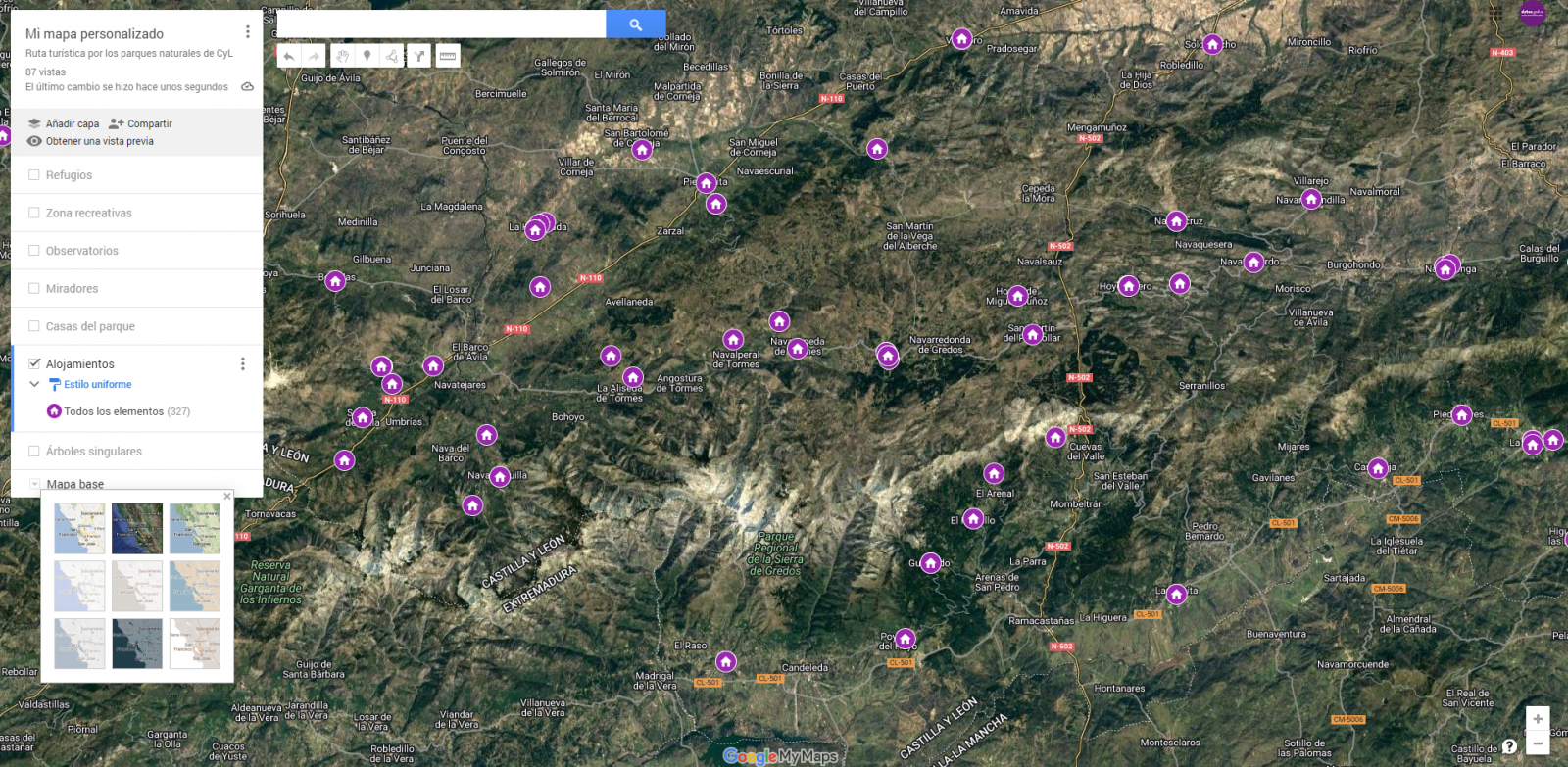

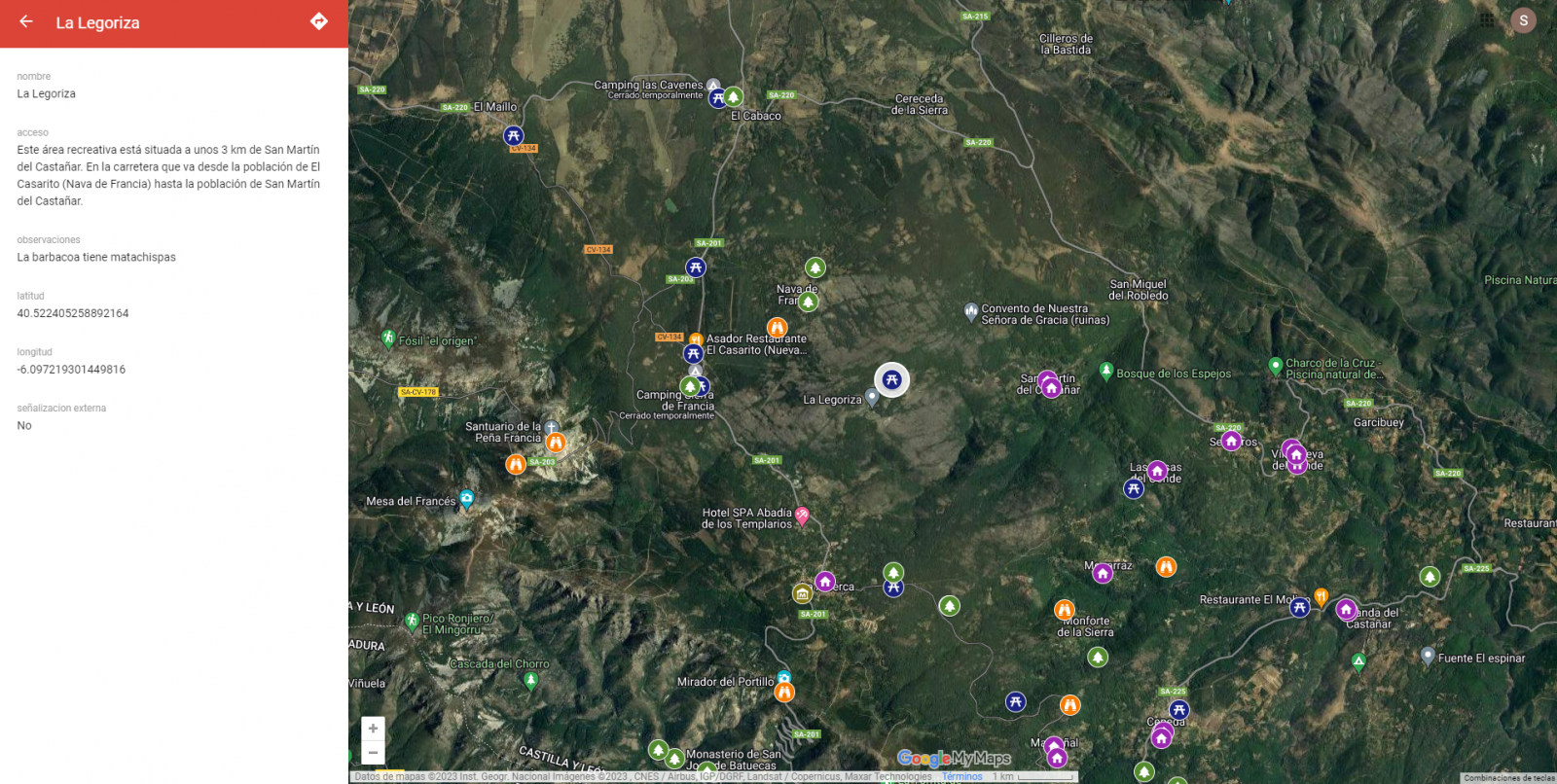

Durante el preprocesamiento de las tablas de datos, hemos realizado un filtrado de la información según el enfoque del ejercicio, que es la generación de un mapa para realizar rutas tusísticas por los espacios naturales de Castilla y León. A continuación, se describe la personalización de la información que hemos llevado a cabo para cada uno de los conjuntos de datos.

- En el conjunto de datos perteneciente a los árboles singulares de los espacios naturales, la información a mostrar para cada registro es el nombre, las observaciones, la señalización y la posición (latitud/longitud)

- En el conjunto de datos perteneciente a las casas del parque de los espacios naturales, la información a mostrar para cada registro es el nombre, las observaciones, la señalización, el acceso, la web y la posición (latitud/longitud)

- En el conjunto de datos perteneciente a los miradores de los espacios naturales, la información a mostrar para cada registro es el nombre, las observaciones, la señalización, el acceso y la posición (latitud/longitud)

- En el conjunto de datos perteneciente a los observatorios de los espacios naturales, la información a mostrar para cada registro es el nombre, las observaciones, la señalización y la posición (latitud/longitud)

- En el conjunto de datos perteneciente a los refugios de los espacios naturales, la información a mostrar para cada registro es el nombre, las observaciones, la señalización, el acceso y la posición (latitud/longitud). Dado que los refugios pueden encontrarse en estados muy diferentes y que algunos registros no ofrecen información en el campo “observaciones”, hemos decidido filtrar para que nos muestre solamente aquellos que tengan información en dicho campo.

- En el conjunto de datos perteneciente a las áreas recreativas de los espacios naturales, la información a mostrar para cada registro es el nombre, las observaciones, la señalización, el acceso y la posición (latitud/longitud). Hemos decidido filtrar para que nos muestre solamente aquellos que tengan información en los campos de “observaciones” y “acceso”.

- En el conjunto de datos perteneciente a los alojamientos, la información a mostrar para cada registro es el nombre, tipo de establecimiento, categoría, municipio, web, teléfono y la posición (latitud/longitud). Hemos filtrado el “tipo” de establecimiento para que nos muestre solamente los que están categorizados como alojamientos de turismo rural y hemos filtrado para que nos muestre los que son de 2 estrellas.

A continuación, tenemos la visualización del mapa personalizado que hemos creado. Seleccionando el icono para agrandar el mapa que aparece en la esquina superior derecha, podrás acceder su visualización en pantalla completa.

6.3 Funcionalidades sobre el mapa (capas, pines, rutas y vista inmersiva 3D)

En este punto, una vez creado el mapa personalizado, explicaremos diversas funcionalidades que nos ofrece "Google My Maps" durante la visualización de los datos.

-

Capas

Mediante el menú desplegable de la izquierda, podemos activar y desactivar las capas a mostrar según nuestras necesidades.

Figura 10. Capas en "My Maps"

-

Pines

Pinchando en cada uno de los pines del mapa podemos acceder a la información asociada a esa posición geográfica.

Figura 11. Pines en "My Maps"

-

Rutas

Podemos crear una copia del mapa sobre la que añadir nuestros recorridos personalizados.

En las opciones del menú lateral izquierdo, seleccionamos “copiar mapa”. Una vez copiado el mapa, mediante el símbolo de añadir indicaciones, situado debajo de la barra buscador, generaremos una nueva capa. A esta capa podremos indicarle dos o más puntos, junto al medio de transporte y nos creará el trazado junto a las indicaciones de trayecto.

Figura 12. Rutas en "My Maps"

-

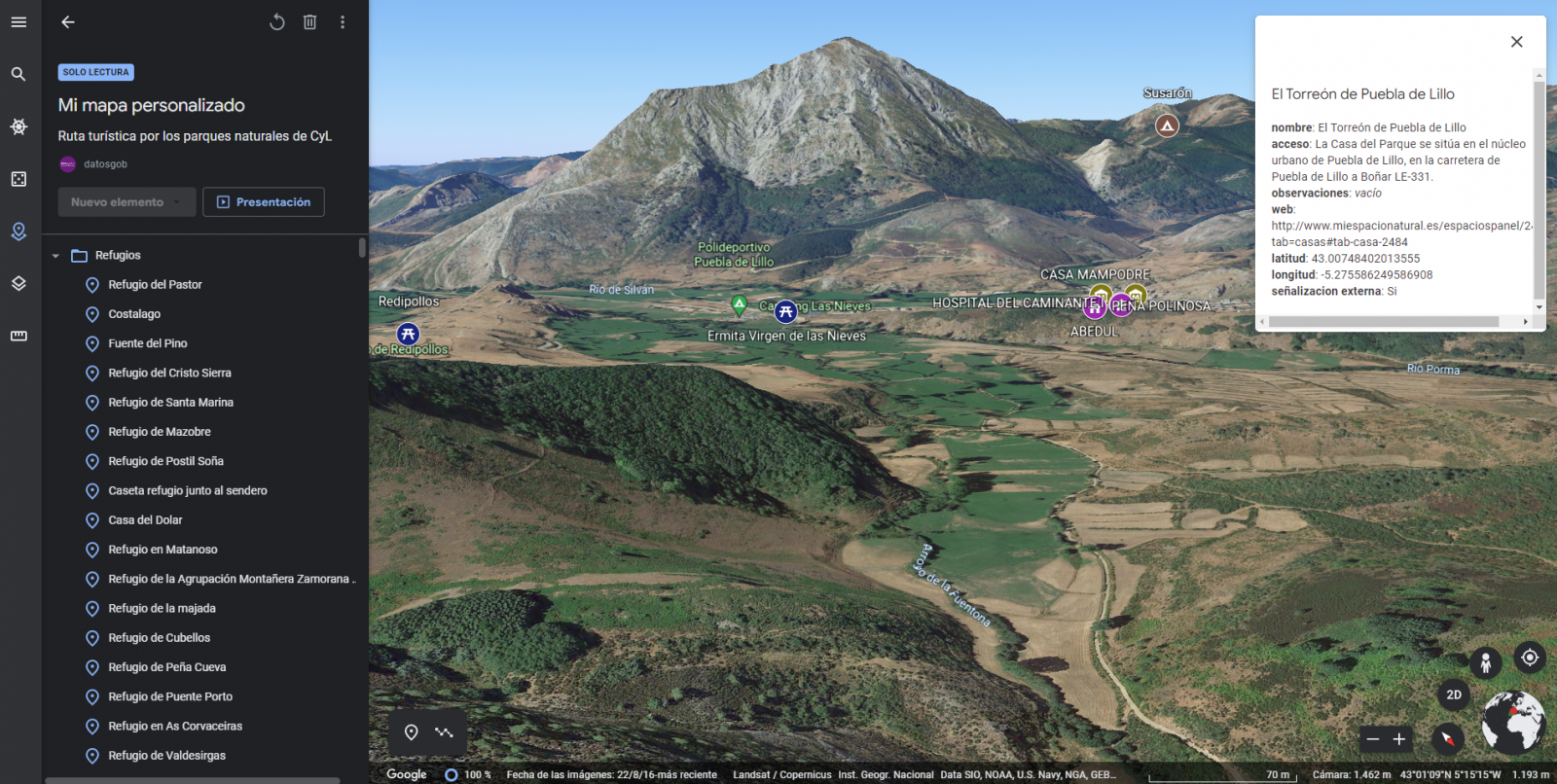

Mapa inmersivo en 3D

Mediante el símbolo de opciones que aparece en el menú lateral, podemos acceder a Google Earth, desde donde podemos realizar una exploración del mapa inmersiva en 3D, destacando el poder observar la altitud de los distintos puntos de interés. También puedes acceder mediante el siguiente enlace.

Figura 13. Vista inmersiva en 3D

7. Conclusiones del ejercicio

La visualización de datos es uno de los mecanismos más potentes para explotar y analizar el significado implícito de los datos. Cabe destacar la vital importancia que los datos geográficos tienen en el sector del turismo, lo cual hemos podido comprobar en este ejercicio.

Como resultado, hemos desarrollado un mapa interactivo con información aportada por los datos abiertos enriquecidos (Linked Data), la cual hemos personalizado según nuestros intereses.

Esperemos que esta visualización paso a paso te haya resultado útil para el aprendizaje de algunas técnicas muy habituales en el tratamiento y representación de datos abiertos. Volveremos para mostraros nuevas reutilizaciones. ¡Hasta pronto!

1. Introducción

Las visualizaciones son representaciones gráficas de datos que permiten comunicar de manera sencilla y efectiva la información ligada a los mismos. Las posibilidades de visualización son muy amplias, desde representaciones básicas, como puede ser un gráfico de líneas, barras o sectores, hasta visualizaciones configuradas sobre cuadros de mando o dashboards interactivos. Las visualizaciones juegan un papel fundamental en la extracción de conclusiones utilizando el lenguaje visual, permitiendo además detectar patrones, tendencias, datos anómalos o proyectar predicciones, entre otras muchas funciones.

En esta sección de “Visualizaciones paso a paso” estamos presentando periódicamente ejercicios prácticos de visualizaciones de datos abiertos disponibles en datos.gob.es u otros catálogos similares. En ellos se abordan y describen de manera sencilla las etapas necesarias para obtener los datos, realizar las transformaciones y análisis que resulten pertinentes para, finalmente, la creación de visualizaciones interactivas de las que podemos extraer información resumida en unas conclusiones finales. En cada uno de estos ejercicios prácticos se utilizan sencillos desarrollos de código convenientemente documentados, así como herramientas de uso gratuito. Todo el material generado está disponible para su reutilización en el repositorio del laboratorio de datos de Github perteneciente a datos.gob.es.

En este ejercicio práctico, hemos realizado un sencillo desarrollo de código que está convenientemente documentado apoyandonos en herramientas de uso gratuito.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

2. Objetivo

El objetivo principal de este post es mostrar cómo realizar una visualización interactiva partiendo de datos abiertos. Para este ejercicio práctico hemos utilizado un dataset proporcionado por el Ministerio de Justicia que contiene información sobre los resultados toxicológicos realizados en accidentes de tráfico, que cruzaremos con los datos que publica la Jefatura Central de Tráfico que contienen el detalle sobre el parque de vehículos matriculados en España.

A partir de este cruce de datos analizaremos y podremos observar las ratios de resultados toxicológicos positivos en relación con el parque de vehículos matriculados.

Cabe destacar que el Ministerio de Justicia pone a disposición de los ciudadanos diversos cuadros de mando donde visualizar los datos sobre los resultados toxicológicos realizados en accidentes de tráfico. La diferencia radica en que este ejercicio práctico hace hincapié en la parte didáctica, mostraremos cómo procesar los datos y cómo diseñar y construir las visualizaciones.

3. Recursos

3.1. Conjuntos de datos

Para este caso práctico se ha utilizado un conjunto de datos proporcionado por el Ministerio de Justicia, el cual contiene información sobre los resultados toxicológicos realizados en accidentes de tráfico. Este conjunto de datos se encuentra en el siguiente repositorio de Github:

También se han utilizado los conjuntos de datos del parque de vehículos matriculados en España. Estos conjuntos de datos son publicados por parte de la Jefatura Central de Tráfico, organismo dependiente del Ministerio del Interior. Se encuentran disponibles en la siguiente página del catálogo de datos de datos.gob.es:

3.2. Herramientas

Para la realización de las tareas de preprocesado de los datos se ha utilizado el lenguaje de programación Python escrito sobre un Notebook de Jupyter alojado en el servicio en la nube de Google Colab.

Google Colab o también llamado Google Colaboratory, es un servicio gratuito en la nube de Google Research que permite programar, ejecutar y compartir código escrito en Python o R desde tu navegador, por lo que no requiere la instalación de ninguna herramienta o configuración.

Para la creación de la visualización interactiva se ha usado la herramienta Google Data Studio.

Google Data Studio es una herramienta online que permite realizar gráficos, mapas o tablas que pueden incrustarse en sitios web o exportarse como archivos. Esta herramienta es sencilla de usar y permite múltiples opciones de personalización.

Si quieres conocer más sobre herramientas que puedan ayudarte en el tratamiento y la visualización de datos, puedes recurrir al informe \"Herramientas de procesado y visualización de datos\".

4. Tratamiento o preparación de los datos

Antes de lanzarnos a construir una visualización efectiva, debemos realizar un tratamiento previo de los datos, prestando especial atención a la obtención de los mismos y validando su contenido, asegurando que se encuentran en el formato adecuado y consistente para su procesamiento y que no contienen errores.

Los procesos que te describimos a continuación los encontrarás comentados en el Notebook que también podrás ejecutar desde Google Colab. Link al notebook de Google Colab

Como primer paso del proceso es necesario realizar un análisis exploratorio de los datos (EDA) con el fin de interpretar adecuadamente los datos de partida, detectar anomalías, datos ausentes o errores que pudieran afectar a la calidad de los procesos posteriores y resultados. Un tratamiento previo de los datos es esencial para garantizar que los análisis o visualizaciones creados posteriormente a partir de ellos son confiables y consistentes. Si quieres conocer más sobre este proceso puedes recurrir a la Guía Práctica de Introducción al Análisis Exploratorio de Datos.

El siguiente paso es la generación de las tablas de datos preprocesados que usaremos para generar las visualizaciones. Para ello ajustaremos las variables, realizaremos el cruce de datos entre ambos conjuntos y filtraremos o agruparemos según sea conveniente.

Los pasos que se siguen en este preprocesamiento de los datos son los siguientes:

- Importación de librerías

- Carga de archivos de datos a utilizar

- Detención y tratamiento de datos ausentes (NAs)

- Modificación y ajuste de las variables

- Generación de tablas con datos preprocesados para las visualizaciones

- Almacenamiento de las tablas con los datos preprocesados

Podrás reproducir este análisis, ya que el código fuente está disponible en nuestra cuenta de GitHub. La forma de proporcionar el código es a través de un documento realizado sobre un Jupyter Notebook que una vez cargado en el entorno de desarrollo podrás ejecutar o modificar de manera sencilla. Debido al carácter divulgativo de este post y para favorecer el entendimiento de los lectores no especializados, el código no pretende ser el más eficiente, sino facilitar su comprensión por lo que posiblemente se te ocurrirán muchas formas de optimizar el código propuesto para lograr fines similares. ¡Te animamos a que lo hagas!

5. Generación de las visualizaciones

Una vez hemos realizado el preprocesamiento de los datos, vamos con las visualizaciones. Para la realización de estas visualizaciones interactivas se ha usado la herramienta Google Data Studio. Al ser una herramienta online, no es necesario tener instalado un software para interactuar o generar cualquier visualización, pero sí es necesario que las tablas de datos que le proporcionemos estén estructuradas adecuadamente, para ello hemos realizado los pasos anteriores para la preparación de los datos.

El punto de partida es el planteamiento de una serie de preguntas que la visualización nos ayudará a resolver. Proponemos las siguientes:

-

¿Cómo está distribuido el parque de vehículos en España por comunidades autónomas?

-

¿Qué tipo de vehículo está implicado en mayor y en menor medida en accidentes de tráfico con resultados toxicológicos positivos?

-

¿Dónde se producen más hallazgos toxicológicos en víctimas mortales de accidentes de tráfico?

¡Vamos a buscar las respuestas viendo los datos!

5.1. Parque de vehículos matriculados por CCAA y por típo de vehículo

Esta representación visual se ha realizado teniendo en cuenta el número de vehículos matriculados en las distintas comunidades autónomas, desglosando el total por tipo de vehículo. Los datos, correspondientes a la media de los registros mes a mes de los años 2020 y 2021, están almacenados en la tabla “parque_vehiculos.csv” generada en el preprocesamiento de los datos de partida.

Mediante un mapa coroplético podemos visualizar qué CCAAs son las que poseen un mayor parque de vehículos. El mapa se complementa con un gráfico de anillo que aporta información de los porcentajes sobre el total por cada CCAA.

Según se definen en la “Guía de visualización de datos de la Generalitat Catalana” los mapas coropléticos o de coropletas muestran los valores de una variable sobre un mapa pintando las áreas de cada región afectada de un color determinado. Son utilizados cuando se quieren encontrar patrones geográficos en los datos que están categorizados por zonas o regiones.

Los gráficos de anillo, englobados en los gráficos de sectores, utilizan una representación circular que muestra cómo se distribuyen proporcionalmente los datos.

Una vez obtenida la visualización, mediante la pestaña desplegable, aparece la opción de filtrar por tipo de vehículo.

Ver la visualización en pantalla completa

5.2. Ratio resultados toxicológicos positivos para los distintos tipos de vehículos

Esta representación visual se ha realizado teniendo en cuanta las ratios de los resultados toxicológicos positivos por número de vehículos a nivel nacional. Contabilizamos como resultado positivo cada vez que un sujeto da positivo en el análisis de cada una de las sustancias, es decir, un mismo sujeto puede contabilizar varias veces en el caso de que sus resultados sean positivos para varias sustancias. Para ello se ha generado durante el preprocesamiento de datos la tabla “resultados_vehiculos.csv”

Mediante un gráfico de barras apiladas, podemos evaluar los ratios de los resultados toxicológicos positivos por número de vehículos para las distintas sustancias y los distintos tipos de vehículos.

Según se definen en la “Guía de visualización de datos de la Generalitat Catalana” los gráficos de barras se utilizan cuando se quiere comparar el valor total de la suma de los segmentos que forman cada una de las barras. Al mismo tiempo, ofrecen información sobre cómo son de grandes estos segmentos.

Cuando las barras apiladas suman un 100%, es decir, que cada barra segmenteada ocupa la altura de la representación, el gráfico se puede considerar un gráfico que permite representar partes de un total.

La tabla aportan la misma información de una forma complementaria.

Una vez obtenida la visualización, mediante la pestaña desplegable, aparece la opción de filtrar por tipo de sustancia.

Ver la visualización en pantalla completa

5.3. Ratio resultados toxicológicos positivos para las CCAAs

Esta representación visual se ha realizado teniendo en cuenta las ratios de los resultados toxicológicos positivos por el parque de vehículos de cada CCAA. Contabilizamos como resultado positivo cada vez que un sujeto da positivo en el análisis de cada una de las sustancias, es decir, un mismo sujeto puede contabilizar varias veces en el caso de que sus resultados sean positivos para varias sustancias. Para ello se ha generado durante el preprocesamiento de datos la tabla “resultados_ccaa.csv”.

Hay que remarcar que no tiene por qué coincidir la CCAA de matriculación del vehículo con la CCAA donde se ha registrado el accidente, no obstante, ya que este es un ejercicio didáctico y se presupone que en la mayoría de los casos coinciden, se ha decido partir de la base de que ambos coinciden.

Mediante un mapa coroplético podemos visualizar que CCAAs son las que poseen las mayores ratios. A la información aportada en la primera visualización sobre este tipo de gráficos, hay que añadir lo siguiente.

Según se define en la “Guía de visualización de datos para Entidades Locales” uno de los requisitos de los mapas coropléticos o de coropletas es utilizar una medida o dato numérico, un dato categórico para el territorio y un dato geográfico de polígono.

La tabla y el gráfico de barras aportan la misma información de una forma complementaria.

Una vez obtenida la visualización, mediante la pestaña despegable, aparece la opción de filtrar por tipo de sustancia.

Ver la visualización en pantalla completa

6. Conclusiones del estudio

La visualización de datos es uno de los mecanismos más potentes para explotar y analizar el significado implícito de los datos, independientemente del tipo de dato y el grado de conocimiento tecnológico del usuario. Las visualizaciones nos permiten construir significado sobre los datos y la creación de narrativas basadas en la representación gráfica. En el conjunto de representaciones gráficas de datos que acabamos de implementar se puede observar lo siguiente:

-

El parque de vehículos de las Comunidades Autónomas de Andalucía, Cataluña y Madrid corresponde a cerca del 50% del total del país.

-

Las ratios de resultados toxicológicos positivos más altas se presentan en las motocicletas, siendo del orden de tres veces superior a la siguiente ratio, los turismos, para la mayoría de las sustancias.

-

Las ratios de resultados toxicológicos positivos más bajas se presentan en los camiones.

-

Los vehículos de dos ruedas (motocicletas y ciclomotores) presentan ratios en \"cannabis\" superiores a los obtenidos en \"cocaina\", mientras que los vehículos de cuatro ruedas (turismos, furgonetas y camiones) presentan ratios en \"cocaina\" superiores a los obtenidos en \"cannabis\".

-

La comunidad autónoma donde mayor es la ratio para el total de sustancias es La Rioja.

Cabe destacar que en las visualizaciones tienes la opción de filtrar por tipo de vehículo y tipo de sustancia. Te animamos a lo que lo hagas para sacar conclusiones más específicas sobre la información concreta en la que estés más interesado.

Esperemos que esta visualización paso a paso te haya resultado útil para el aprendizaje de algunas técnicas muy habituales en el tratamiento y representación de datos abiertos. Volveremos para mostraros nuevas reutilizaciones. ¡Hasta pronto!

Los últimos meses del año siempre traen consigo numerosas novedades en el ecosistema de datos abiertos. Es la época elegida por muchos organismos para poner en marcha conferencias y eventos donde mostrar las últimas tendencias en la materia y exponer sus avances.

Nuevas funcionalidades y alianzas

Los organismos públicos han continuado avanzando en sus estrategias de datos abiertos, incorporando nuevas funcionalidades y conjuntos de datos a sus plataformas open data. Algunos ejemplos son:

- El 11 de noviembre, el Ministerio para la Transición Ecológica y el Reto Demográfico y The Information Lab Spain presentaron la plataforma SIDAMUN (Sistema Integrado de Datos Municipales). Se trata de una herramienta de visualización de datos con cuadros de mando interactivos que muestran información detallada sobre el estado de situación del territorio.

- El Ministerio de Agricultura, Pesca y Alimentación ha publicado cuatro informes interactivos para explotar más de 500 millones de datos y así dar a conocer de forma sencilla el estado y la evolución del sector primario español.

- El Portal de Datos Abiertos de la Junta de Andalucía se ha actualizado con el fin de impulsar la reutilización de la información, ampliando las posibilidades de acceso mediante APIs, de forma más eficiente y automatizada.

- El Instituto Geográfico Nacional ha actualizado la información sobre vías verdes, que ya están disponibles para descargar en KML, GPX y SHP.

- El Instituto de Estadística y Cartografía de Andalucía ha publicado los datos del Movimiento Natural de la Población del año 2021, que ofrece información sobre nacimientos, matrimonios y defunciones.

También hemos visto avances desde el punto de vista estratégico y de alianzas. La Conselleria de Participación y Transparencia de la Generalitat Valenciana lanzó un proceso participativo para diseñar el primer plan de acción del programa ‘OGP Local’ de la Alianza de Gobierno Abierto. Por su parte, el Gobierno de Canarias ha solicitado su entrada en la Alianza Internacional de Gobierno Abierto y fortalecerá la colaboración con las entidades locales de las islas para así transversalizar las políticas del Gobierno Abierto.

Además, diversos organismos han anunciado novedades para los próximos meses. Es el caso del Ayuntamiento de Córdoba, que lanzará próximamente un nuevo portal con datos abiertos, o del Ayuntamiento de Torrejón, que ha incluido en su plan de acción local la creación de un portal Open data, así como el impulso del uso del big data en las instituciones.

Los concursos de datos abiertos, un escaparate para conocer talento y nuevos casos de uso

Durante el otoño se han anunciado los ganadores de diversos certámenes que buscaban impulsar la reutilización de datos abiertos. Gracias a estos concursos hemos conocido también numerosos casos de reutilización que ponen de manifiesto el poder de los datos abiertos para generar beneficios sociales y económicos.

- A finales de octubre conocimos a los ganadores de nuestro Desafío Aporta. El primer premio fue para HelpVoice!, un servicio que busca ayudar a las personas mayores utilizando técnicas de reconocimiento de voz basadas en aprendizaje automático. Un entorno web para facilitar el análisis y la visualización interactiva de los microdatos de la Encuesta de Morbilidad Hospitalaria y una app para fomentar los hábitos saludables se hicieron con el segundo y el tercer premio, respectivamente.

- También se hicieron públicos los ganadores del concurso de ideas y aplicaciones de Open Data Euskadi. Entre los premiados encontramos un asistente inteligente para el ahorro energético y una app para localizar plazas libres de aparcamiento.

- Aragón Open Data, el portal de datos abiertos del Gobierno de Aragón, celebró su décimo aniversario con un datathon presencial para prototipar servicios que ayuden a las personas a través de los datos del portal. El premio a la solución más novedosa y con mayor impacto fue para Certifica-Tec, una web que permite visualizar geográficamente el estado de los certificados de eficiencia energética.

- El Datathon Open Data Bizkaia se presentó con el objetivo de transformar Bizkaia a partir de sus datos abiertos. A finales de noviembre, se celebró el evento final del Datathon. El ganador fue Argilum, seguido de Datoston.

- UniversiData ha puesto en marcha su primer datathon, cuyos proyectos ganadores se acaban de anunciar.

Además, en estos meses se han dado a conocer otras incitativas relacionadas con la reutilización de los datos, como por ejemplo:

- Investigadores de Universidad Politécnica de Madrid han llevado a cabo un estudio donde utilizan algoritmos de inteligencia artificial para analizar datos clínicos sobre pacientes de cáncer de pulmón, publicaciones científicas y datos abiertos. El objetivo es obtener patrones estadísticos que permitan mejorar los tratamientos.

- La Memoria de Investigación 2021 que la Universidad de Extremadura acaba de publicar ha sido generada automáticamente desde el portal open data. Se trata de un documento de más de 1.200 páginas que recoge las investigaciones de todos los departamentos del centro.

- F4map es un mapa 3D que ha sido elaborado gracias a los datos abiertos de la comunidad colaborativa OpenStreetMap. Así y alternando la visualización en 2D y 3D, ofrece una vista detallada de las distintas ciudades, edificios y monumentos de todo el mundo.

Divulgación de los datos abiertos y sus casos de uso a través de eventos

Si por algo ha resaltado el otoño, ha sido por la celebración de eventos centrados en el mundo del dato, muchos de los cuales fueron grabados y se pueden volver a ver online. Algunos ejemplos son:

- El Ministerio de Justicia y la Universidad de Salamanca organizaron el simposio “Justicia y Derecho en Datos: El papel del Dato como habilitador y motor del cambio para la transformación de la Justicia y el Derecho”. Durante el evento se reflexionó sobre el dato como bien público. Todas las ponencias están disponibles a través del canal de Youtube de la universidad.

- El pasado octubre, Madrid acogió una nueva edición del Data Management Summit Spain. El día anterior se celebró una sesión previa, organizada en colaboración con DAMA España y la Oficina del Dato, dirigida exclusivamente a representantes de la administración pública y centrado en los datos abiertos y el intercambio de información entre administraciones.

- La Diputación de Barcelona, la Diputación de Castellón y el Gobierno de Aragón organizaron el Encuentro Nacional de datos abiertos, con el objetivo de visibilizar la importancia de estos en la cohesión territorial.

- Las Jornadas Ibéricas de Infraestructura de Datos Espaciales ese celebraron en Sevilla, donde se debatió sobre las tendencias de información geográfica, y cuyo vídeo está disponible aquí.

- También están disponibles, para ver en diferido, las Jornadas Asociacionismo 2030, organizadas por el Gobierno de Canarias. Entre las ponencias destacamos la relativa al 'Mapa del asociacionismo canario' que visibiliza este tipo de datos de forma interactiva.

- ASEDIE organizó la 14º edición de su Conferencia internacional sobre reutilización de la información del sector público, que contó con diversas mesas redondas, incluyendo la relativa a ‘La Economía del Datos: derechos, obligaciones, oportunidades y barreras’. Puedes ver el evento completo aquí.

Guías y cursos

Durante estos meses también se han publicado guías que buscan ayudar a publicadores y reutilizadores en su trabajo con datos abiertos. Desde datos.gob.es hemos publicado documentos sobre Cómo elaborar un Plan de medidas de impulso de la apertura y reutilización de datos abiertos, la guía de Introducción a la anonimización de datos: Técnicas y casos prácticos y la Guía práctica para la mejora de la calidad de datos abiertos. Además, otros organismos también han publicado documentos de ayuda como por ejemplo:

- La Generalitat Valenciana ha publicado una guía que recopila las obligaciones de transparencia establecidas por la ley valenciana para las entidades del sector público.

- Desde la Agencia Española de Protección de Datos han traducido la Guía básica de Anonimización de la Autoridad de Protección de Datos de Singapur, dado su valor didáctico y de especial interés para responsables de protección de datos. La guía se complementa con herramienta gratuita de anonimización de datos, que la AEPD pone a disposición de las organizaciones

- La RED de Entidades Locales por la Transparencia y Participación Ciudadana de la FEMP acaba de presentar la Guía de visualización de datos para Entidades Locales, un documento con buenas prácticas y recomendaciones. El documento toma como referencia la un trabajo previo del Ayuntamiento de L’Hospitalet.

Novedades a nivel internacional

En este periodo, también hemos visto novedades a nivel europeo. Algunas de las que destacamos son:

- En octubre se celebró la final del EUdatathon 2022. Los equipos finalistas fueron seleccionados previamente entre un total de 156 propuestas iniciales.

- El Portal Europeo de Datos ha lanzado la iniciativa Use Case Observatory para medir el impacto del open data través del seguimiento de 30 casos de uso durante 3 años.

- Un grupo de científicos del Instituto Holandés para la Investigación de la Energía Fundamental ha creado una base de datos de 31.618 moléculas gracias a algoritmos entrenados con inteligencia artificial.

- El Banco Mundial ha desarrollado un nuevo dashboard de seguridad alimentaria y nutricional que ofrece los últimos datos mundiales y nacionales.

Estos son solo algunos ejemplos de lo que ha dado de sí el ecosistema de datos abiertos en los últimos meses. Si quieres compartir con nosotros alguna otra novedad, déjanos un comentario o mándanos un email a dinamizacion@datos.gob.es

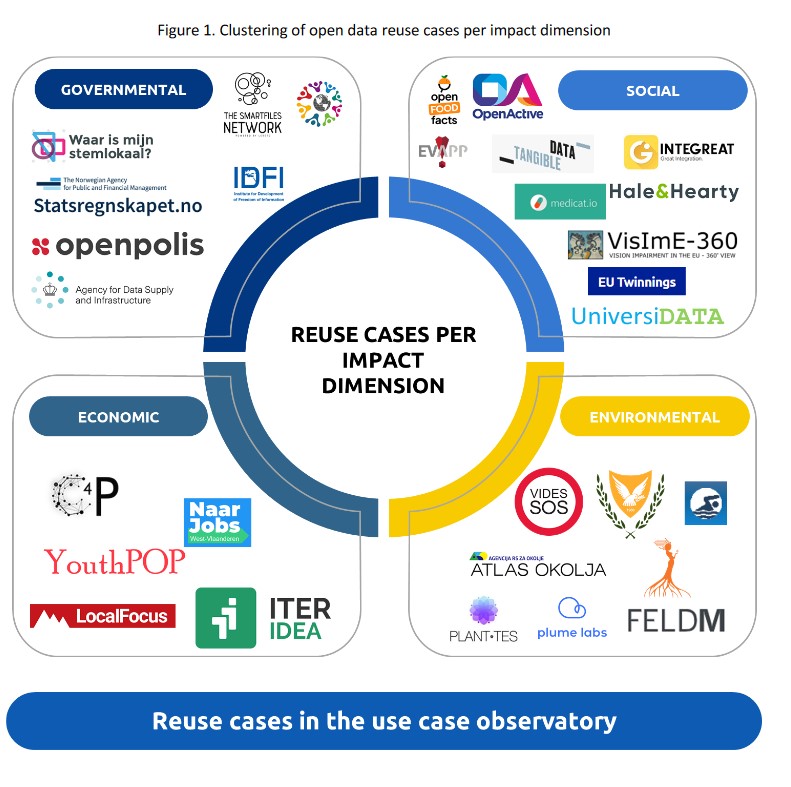

Medir el impacto de los datos abiertos es uno de los retos que tienen por delante las iniciativas de datos abiertos. En este contexto, el Portal de Datos Europeo ha puesto en marcha un observatorio de casos de uso que constará de diversos informes.

En el primer informe se presenta la metodología y 30 casos de reutilización seleccionados, incluyendo información sobre los servicios que ofrecen, los datos (abiertos) que utilizan y el impacto que tienen. Por último se presentan las conclusiones generales y las lecciones aprendidas en esta primera parte del proyecto. Para seleccionar los casos de uso, se realizó un inventario basado en tres fuentes: los ejemplos recogidos en los estudios de madurez que realiza cada año el portal europeo, las soluciones participantes en el EU Datathon y los ejemplos de reutilización disponibles en el repositorio de casos de uso de data.europa.eu.

Este informe se encuentra disponible en el siguiente enlace: "Observatorio de casos de uso: seguimiento de 3 años de 30 casos de reutilización para comprender el impacto económico, gubernamental, social y medioambiental de los datos abiertos (Volumen I) "

Medir el impacto de los datos abiertos es uno de los retos que tienen por delante las iniciativas open data. Existen diversos métodos, la mayoría de los cuales combinan el análisis cuantitativo con el cualitativo, con el fin de conocer cuál es el valor de determinados conjuntos de datos.

En este contexto, data.europa.eu, el Portal Europeo de Datos Abiertos, ha puesto en marcha un Observatorio de casos de uso (Use Case Observatory). Se trata de un proyecto de investigación sobre el impacto económico, gubernamental, social y medioambiental de los datos abiertos.

¿En qué consiste el Observatorio de casos de uso?

Durante tres años, desde 2022 hasta 2025, el Portal Europeo de Datos realizará el seguimiento de 30 casos de reutilización de datos abiertos. Con ello se busca:

- Evaluar cómo se crea el impacto de los datos abiertos

- Compartir los retos y logros de los casos de reutilización analizados

- Contribuir al debate sobre la metodología a utilizar para medir dicho impacto

Los casos de uso analizados hacen referencia a cuatro áreas de impacto:

- Impacto económico: Incluye casos de reutilización relacionados con la creación de empresas y la (re)capacitación de los trabajadores, entre otros. Por ejemplo, se incluyen soluciones que ayudan a identificar licitaciones públicas o solicitar puestos de trabajo.

- Impacto gubernamental: Se refiere a casos de reutilización que impulsan el gobierno electrónico, la transparencia y la rendición de cuentas.

- Impacto social: Engloba casos de reutilización en los ámbitos de la asistencia sanitaria, el bienestar y la lucha contra la desigualdad.

- Impacto medioambiental: Se circunscribe a casos de reutilización que promueven la sostenibilidad y la reducción de energía, incluyendo soluciones relacionadas con el control de la calidad del aire o la preservación de los bosques.

Para seleccionar los casos de uso, se realizó un inventario basado en tres fuentes: los ejemplos recogidos en los estudios de madurez que realiza cada año el portal europeo, las soluciones participantes en el EU Datathon y los ejemplos de reutilización disponibles en el repositorio de casos de uso de data.europa.eu. Solo se tuvieron en cuenta aquellos proyectos desarrollados en Europa, intentando mantener un equilibrio entre los distintos países. Además, se destacaron aquellos proyectos que hubiesen obtenido algún premio o que estuviesen alineados con las prioridades de la Comisión Europea para 2019 a 2024. Para finalizar la selección, desde data.europa.eu se realizaron entrevistas con representantes de los casos de uso que cumplían los requisitos y que estaban interesados en participar en el proyecto.

Tres proyectos españoles entre los casos de uso analizados

Los casos de uso seleccionados se recogen en la siguiente imagen:

Entre ellos, encontramos tres españoles:

- En la categoría de Impacto social se sitúa UniversiDATA-Lab, un portal público para el análisis avanzado y automático de los conjuntos de datos publicados por las universidades. Este proyecto, que se hizo con el primer premio del III Desafío Aporta, fue concebido por el equipo creador de UniversiData, una iniciativa colaborativa orientada e impulsada por universidades públicas con el fin de fomentar los datos abiertos en el sector de la educación superior en España de una forma armonizada. Puedes conocer más sobre estos proyectos en esta entrevista.

- En la misma categoría también encontramos a Tangible data, un proyecto centrado en la creación de esculturas basadas en datos, para acercarlos a personas sin conocimientos técnicos. Entre otras fuentes de datos, utiliza datasets provenientes de la NASA o de Our World in Data.

- En la categoría de medio ambiente está Planttes. Se trata de un proyecto de ciencia ciudadana diseñado para informar sobre la presencia de plantas alergénicas en nuestro entorno y el nivel de riesgo de alergia en función de su estado. Este proyecto está promovido por el Punto de Información Aerobiológica (PIA) del Instituto de Ciencia y Tecnología Ambientales (ICTA-UAB) y el Departamento de Biología Animal, Biología Vegetal y Ecología (BABVE), en colaboración con el Centro de Visión por Computador (CVC) y el Library Living Lab, todos ellos de la Universidad Autónoma de Barcelona (UAB).

Primer informe ya disponible

Fruto del trabajo de análisis realizado se desarrollarán tres informes. El primero de ellos, que se acaba de publicar, presenta la metodología y los 30 casos de reutilización seleccionados. Incluye información sobre los servicios que ofrecen, los datos (abiertos) que utilizan y el impacto que tienen en el momento de la redacción. El informe finaliza con un resume de las conclusiones generales y las lecciones aprendidas de esta primera parte del proyecto de investigación, ofreciendo una visión general de los próximos pasos del observatorio.

El segundo y el tercer informe, que verán la luz en 2024 y 2025, evaluarán el progreso de los mismos casos de uso y permitirá ampliar las conclusiones de este primer volumen. Los informes se focalizarán en determinar los logros alcanzados y los retos presentes en un espacio de tres años, lo cual permitirá extrapolar ideas concretas para mejorar las metodologías de evaluación del impacto de los datos abiertos.

El proyecto fue presentado en un webinar el pasado 7 de octubre, cuya grabación está disponible, junto con la presentación utilizada. En el webinar se invitó a participar a representantes de 4 de los casos de uso: Openpolis, Integreat, ANP y OpenFoodFacts.

La ciencia de los datos tiene un papel clave en la construcción de un mundo más equitativo, justo e inclusivo. Los datos abiertos relacionados con la justicia y la sociedad pueden servir de base para el desarrollo de soluciones tecnológicas que impulsen un sistema jurídico no solo más transparente, sino también más eficiente, ayudando a los juristas a realizar su trabajo de una manera más ágil y acertada. Es lo que se conoce como LegalTech, e incluye herramientas que permiten localizar información en grandes volúmenes de textos legales, realizar análisis predictivos o resolver disputas legales de forma sencilla, entre otros.

Además, este tipo de datos permite poner en marcha soluciones dirigidas a dar respuesta a los grandes desafíos sociales de la humanidad, ayudando a impulsar el bien común, como por ejemplo la inclusión de determinados colectivos, la ayuda a los refugiados y la población en zonas de conflicto o la lucha contra la violencia de género.

Cuando hablamos de datos abiertos relacionados con la justicia y la sociedad hacemos referencia tanto a datos jurídicos, como a otros que pueden tener repercusión a la hora de universalizar el acceso a servicios básicos, alcanzas la equidad, conseguir que todas las personas tengan las mismas oportunidades de desarrollo y promover la colaboración entre los diferentes agentes sociales.

¿Qué tipos de datos sobre justicia y sociedad puedo encontrar en datos.gob.es?

En nuestro portal puedes acceder a un amplio catálogo de datos que se encuentra clasificado por diferentes sectores. La categoría de Legislación y Justicia cuenta actualmente con más de 5.000 conjuntos de datos de diferente naturaleza, incluyendo información relacionadas con infracciones penales, recursos o víctimas de determinados delitos, entre otros. Por su parte, la categoría de sociedad y bienestar suma más de 8.000 datasets entre los que encontramos, por ejemplo, listados de ayudas, asociaciones o información sobre el desempleo.

De todos estos conjuntos de datos, recogemos a continuación algunos ejemplos de los más destacados junto al formato en el que puedes consultarlos:

A nivel estatal

- Instituto Nacional de Estadística (INE). Delitos según sexo por comunidades y ciudades autónomas. CSV, XLSX, XLS, JSON, PC-Axis, HTML (landing page de descarga de datos)

- Instituto Nacional de Estadística (INE). Agenda 2030 ODS - Población en riesgo de pobreza o exclusión social: indicador AROPE. CSV, XLS, XLSX, HTML (landing page de descarga de datos)

- Instituto Nacional de Estadística (INE). Uso de Internet por características demográficas y frecuencia de uso. CSV, XLSX, XLS, JSON, PC-Axis, HTML (landing page de descarga de datos)

- Instituto Nacional de Estadística (INE). Gasto según tamaño del municipio de residencia. CSV, XLSX, XLS, JSON, PC-Axis, HTML (landing page de descarga de datos)

- Instituto Nacional de Estadística (INE). Edad de jubilación en el acceso a la prestación. CSV, XLSX

- Ministerio de Justicia. Censo Judicial. XLSX, PDF, HTML (landing page de descarga de datos)

A nivel CC.AA.

- Instituto Cántabro de Estadística. Estadística de nulidades, separaciones y divorcios. RDF-XML, XLS, JSON, ZIP, PC-Axis, HTML (landing page de descarga de datos).

- Comunidad Autónoma del País Vasco. Normas y leyes en vigor aplicables en Euskadi. JSON, JSON-P, XML, XLSX.

- Comunidad Autónoma del País Vasco. Localización de las fosas comunes de la Guerra Civil y del Franquismo. CSV, XLS, XML.

- Generalitat de Cataluña. Estadísticas de los recursos del Departamento de Justicia. XLSX, HTML (landing page de descarga de datos).

- Generalitat de Cataluña. Estadísticas de la justicia juvenil en Cataluña. XLSX, HTML (landing page de descarga de datos).

- Comunidad Foral de Navarra. Estadística de transmisiones de derechos de la propiedad. XLSX, HTML (landing page de descarga de datos).

- Principado de Asturias. Indicadores de los Objetivos de Desarrollo Sostenible en Asturias. HTML, XLSX, ZIP.

- Principado de Asturias. Justicia en Asturias: plantillas de los órganos judiciales del Principado de Asturias según tipo. HTML (landing page de descarga de datos).

- Instituto Canario de Estadística. Jueces y magistrados en activo en Canarias. HTML, JSON, PC-Axis.

A nivel local

- Ayuntamiento de Santa Cruz de Tenerife. Aparcamientos para personas con movilidad reducida. SHP, KML, KMZ, RDF-XML, CSV, JSON, XLS

- Ayuntamiento de Madrid. Sedes de la Administración de Justicia en la ciudad de Madrid. CSV, XML, RSS, RDF-XML, JSON, HTML (landing page de descarga de datos)

- Ayuntamiento de Gijón. Cuerpos de seguridad. JSON, CSV, XLS, PDF, HTML, TSV, texto, XML, HTML (landing page de descarga de datos)

- Ayuntamiento de Madrid. Centros de atención para menores y familia. CSV, JSON, RDF-XML, XML, RSS, HTML (landing page de descarga de datos).

- Ayuntamiento de Zaragoza. Relación de comisarías de policía. CSV, JSON.

Algunos ejemplos de reutilización de datos relacionados con la justicia y el bien social

En la sección de empresas y aplicaciones de datos.gob.es puedes encontrar algunos ejemplos de soluciones elaboradas con datos abiertos relacionados con la justicia y el bien social. Un ejemplo es Papelea, una empresa que da respuesta a cuestiones legales y administrativas de los usuarios. Para ello se nutre de información pública como trámites administrativos de las principales administraciones, normas jurídicas, jurisprudencia, etc. Otro ejemplo es la Fundación ISEAK, especializada en la evaluación de políticas públicas en materia de empleo, desigualdad, inclusión o género, para lo cual utiliza fuentes de datos públicas como el Instituto Nacional de Estadística, la Seguridad Social o Eurostat u Opendata Euskadi.

A nivel internacional también encontramos ejemplos de iniciativas creadas para realizar el seguimiento de los casos procesales o mejorar la transparencia de los servicios policiales. En Europa está en auge la creación de empresas centradas en tecnología jurídica que buscan mejorar la vida cotidiana de la ciudadanía, así como de iniciativas que buscan usar los datos en pro de la equidad. Ejemplos concretos de soluciones en este ámbito son miHub, destinado a los solicitantes de asilo y a los refugiados, en Chipre, o Surviving in Brussels un sitio web para los sin techo y las personas que necesitan acceder a servicios como ayuda médica, alojamiento, ofertas de empleo, ayuda legal o asesoramiento financiero.

¿Conoces alguna empresa que utilice este tipo de datos o aplicación que se base en ellos para contribuir avance de la sociedad? Entonces no dudes en dejarnos un comentario con toda la información o enviarnos un correo a dinamizacion@datos.gob.es.

La demanda de profesionales con habilidades relacionadas con la analítica de datos no deja de crecer y ya se estima que la industria solo en España necesitaría más de 90.000 profesionales en datos e inteligencia artificial para impulsar la economía. Formar profesionales que puedan llenar este hueco es un gran reto que está haciendo incluso grandes compañías tecnológicas como Google, Amazon o Microsoft estén proponiendo programas de formación especializado que en paralelo a los que propone el sistema educativo reglado. Y en este contexto los datos abiertos tienen un papel muy relevante en la formación práctica de estos profesionales, ya que con frecuencia, los datos abiertos son la única posibilidad para realizar ejercicios reales y no solo simulados.

Además, aunque aún no existe un corpus de investigación sólido al respecto, algunos trabajos ya sugieren efectos positivos derivados del uso de datos abiertos como herramienta en el proceso de enseñanza-aprendizaje de cualquier materia y no solo de las relacionadas con la analítica de datos. Algunos países europeos han reconocido ya este potencial y han desarrollado proyectos piloto para determinar la mejor forma de introducir datos abiertos en el currículo escolar.

En este sentido, los datos abiertos se pueden utilizar como una herramienta para la educación y la formación de varias maneras. Por ejemplo, los datos abiertos se pueden utilizar para desarrollar nuevos materiales de enseñanza y aprendizaje, para crear proyectos basados en datos del mundo real para estudiantes o para apoyar la investigación sobre enfoques pedagógicos efectivos. Además, los datos abiertos se pueden utilizar para crear oportunidades de colaboración entre educadores, estudiantes e investigadores con el fin de compartir mejores prácticas y colaborar en soluciones a desafíos comunes.

Proyectos basados en datos del mundo real

Una aportación clave de los datos abiertos es su autenticidad, ya que son una representación de la enorme complejidad e incluso de los defectos del mundo real a diferencia de las construcciones artificiales o los ejemplos de libros de texto que se basan en supuestos muchos más simples.

Un ejemplo interesante en este sentido es el que documentó la Universidad Simon Fraser de Canadá en su Máster en Edición donde la mayor parte de sus alumnos proceden de programas universitarios no STEM y que por tanto tenían unas capacidades limitadas en el manejo de datos. El proyecto está disponible como recurso educativo abierto en la plataforma OER Commons y su objetivo es que los estudiantes comprendan que las métricas y la medición son herramientas estratégicas importantes para comprender el mundo que nos rodea.

Al trabajar con datos del mundo real, los estudiantes pueden desarrollar habilidades de construcción de relatos e investigación, y pueden aplicar habilidades analíticas y colaborativas en el uso de datos para resolver problemas del mundo real. El caso de estudio realizado con la primera edición en la que se utilizó este OER basado en datos abiertos está documentado en el libro “Open Data as Open Educational Resources - Case studies of emerging practice”. En él se muestra que la oportunidad de trabajar con datos pertenecientes a su campo de estudio resultó esencial para mantener a los estudiantes comprometidos con el proyecto. Sin embargo, lidiar con el desorden de los datos del "mundo real" fue lo que les permitió obtener un aprendizaje valioso y nuevas habilidades prácticas.

Desarrollo de nuevos materiales de aprendizaje

Los conjuntos de datos abiertos tienen un gran potencial para ser utilizados en el desarrollo de recursos educativos abiertos (REA) que son materiales de enseñanza, aprendizaje e investigación en soporte digital de carácter gratuito, pues son publicados con una licencia abierta (Creative Commons) que permite su uso, adaptación y redistribución para usos no comerciales de acuerdo con la definición de la UNESCO.

En este contexto, si bien los datos abiertos no siempre son REA, podemos decir que se convierten en REA cuando se usan en contextos pedagógicos. Los datos abiertos cuando se utilizan como recurso educativo facilitan que los estudiantes aprendan y experimenten trabajando con los mismos conjuntos de datos que utilizan investigadores, gobiernos y sociedad civil. Son un componente clave para que los estudiantes desarrollen habilidades de análisis, estadísticas, científicas y de pensamiento crítico.

Es difícil estimar la presencia actual de los datos abiertos como parte de los REA pero no resulta difícil encontrar ejemplos interesantes dentro de las principales plataformas de recursos educativos abiertos. En la plataforma Procomún podemos encontrar interesantes ejemplos como Aprender Geografía a través de la evolución de los paisajes agrarios de España que construye sobre la plataforma ArcGIS Online de la Universidad Complutense de Madrid un Webmap para el aprendizaje de los paisajes agrarios en España. El recurso educativo emplea ejemplos concretos de distintas comunidades autónomas empleando fotografías o imágenes fijas geolocalizadas y datos propios integrados con datos abiertos. De este modo los estudiantes trabajan los conceptos no a través de una mera descripción en texto sino con recursos interactivos que favorecen además la mejora de sus competencias digitales y espaciales

En la plataforma OER Commons encontramos por ejemplo el recurso “De los datos abiertos al compromiso cívico” que está dirigido a públicos a partir de enseñanza secundaria con el objetivo de enseñar a interpretar cómo se gasta el dinero público en un área regional, local, o barrio determinado. Para ello se apoya en los conocidos proyectos para analizar presupuestos públicos “¿Dónde van mis impuestos?”, disponibles en muchas zonas del mundo como fruto de las políticas de transparencia de los poderes públicos. Este recurso que podría ser portado a España con facilidad ya que contamos con numerosos proyectos ¿Donde van mis impuestos?, como el mantenido por Fundación Civio.

Habilidades relacionadas con datos

Cuando nos referimos a la formación y educación en habilidades relacionadas con los datos, en realidad nos estamos refiriendo a un área de gran amplitud que además es muy difícil dominar en todas sus facetas. De hecho, lo habitual es que los proyectos relacionados con datos se aborden en equipos donde cada miembro desempeña un rol especializado en alguna de estas áreas. Por ejemplo, es habitual diferenciar al menos la limpieza y preparación de datos, el modelado de datos y la visualización de datos como las principales actividades que se realizan en un proyecto de ciencia datos e inteligencia artificial.

En todos los casos el uso de datos abiertos está ampliamente adoptado como recurso central de los proyectos que se proponen para la adquisición de cualquiera de estas habilidades. La muy conocida comunidad de ciencia de datos Kaggle organiza competiciones basadas en conjuntos de datos abiertos aportados a la comunidad y que constituyen un recurso esencial para el aprendizaje basado en proyectos reales de quienes quieren adquirir habilidades relacionadas con los datos. Existen otras propuestas basadas en suscripciones como Dataquest o ProjectPro pero en todos los casos utilizan para los proyectos que proponen conjuntos de datos reales obtenidos de los múltiples repositorios de datos abiertos de carácter general o repositorios específicos de un área de conocimiento.

Los datos abiertos, al igual que en otras áreas, aún no han desarrollado todo su potencial como herramienta para la educación y la formación. Sin embargo como puede verse en el programa de la última edición de la OER Conference 2022, cada vez son más los ejemplos en los que los datos abiertos tienen un papel central en la enseñanza, las nuevas prácticas educativas y la creación de nuevos recursos educativos para todo tipo de materias, conceptos y habilidades.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El pasado 20 de octubre el concurso de datos abiertos organizado por la UE llegó a su fin tras varios meses de competición. La final de esta sexta edición del EU Datathon se celebró en Bruselas en el marco del Año Europeo de la Juventud y fue transmitido por streaming a nivel mundial.

Se trata de un certamen que brinda a los entusiastas de los datos abiertos y a los desarrolladores de aplicaciones de todo el mundo la oportunidad de demostrar el potencial de los datos abiertos, a la vez que sus ideas innovadoras obtienen visibilidad internacional y entran a competir por una parte del premio total, que asciende a 200.000 euros.

Los equipos finalistas fueron seleccionados previamente entre un total de 156 propuestas iniciales. Estas llegaron desde 38 países distintos, la mayor participación de la historia del concurso, para competir en cuatro categorías diferentes relacionadas con los retos a los que se enfrenta Europa hoy en día.

Antes de la final, los participantes seleccionados tuvieron la oportunidad de presentar en formato vídeo cada una de las propuestas que han ido desarrollando a partir de los datos abiertos procedentes de los catálogos europeos.

A continuación, desgranamos quiénes han sido los equipos ganadores de cada reto, en qué consiste la propuesta presentada y a cuánto asciende el premio.

Ganadores Reto "Pacto Verde Europeo"

El Pacto Verde Europeo (European Green Deal, en inglés) es el plan para impulsar una economía europea moderna, sostenible y competitiva. Los participantes que se decantaron por este reto tuvieron que desarrollar aplicaciones o servicios dirigidos a crear una Europa verde, capaz de impulsar el uso eficiente de los recursos.

1º premio: CROZ RenEUwable (Croacia)

La aplicación desarrollada por este equipo croata, "renEUwable", combina el análisis de datos medioambientales, sociales y económicos para ofrecer recomendaciones específicas y personales sobre el uso sostenible de la energía.

- Galardón: 25.000 €

2º premio: MyBioEUBuddy (Francia, Montenegro)

Este proyecto nace para ayudar a trabajadores del campo y gobiernos locales a encontrar regiones que cultiven productos orgánicos y puedan servir de ejemplo para construir una red de agricultura más sostenible.

- Galardón: 15.000 €

3º premio: Green Land Dashboard for Cities (Italia)

El bronce en esta categoría ha ido a parar a un proyecto italiano que pretende analizar y visualizar la evolución de las zonas verdes para ayudar a las ciudades, los gobiernos regionales y las organizaciones no gubernamentales a hacerlas más habitables y sostenibles.

- Galardón: 7.000 €

Ganadores Reto "Transparencia en la contratación pública"

La transparencia en la contratación pública ayuda a rastrear cómo se gasta el dinero, a combatir el fraude y a analizar las tendencias económicas y de mercado. Los participantes que eligieron este reto tuvieron que explorar la información disponible para desarrollar una aplicación que mejorase la transparencia.

1º premio: Free Software Foundation Europe e.V (Alemania)

Este equipo de desarrolladores tiene como objetivo poner al alcance de los usuarios los vínculos existentes entre el sector privado, las administraciones públicas, los usuarios y las licitaciones.

- Galardón: 25.000 €

2º premio: The AI-Team (Alemania)

Se trata de un proyecto que propone visualizar los datos del TED, el diario europeo de la contratación pública, en una base de datos gráfica y combinarlos con información sobre la propiedad y una lista de entidades sancionadas. Esto permitirá a los funcionarios públicos y a los competidores rastrear los importes y valores de los contratos adjudicados hasta llegar a los propietarios de las empresas.

- Galardón: 15.000 €

3º premio: EMMA (Francia)

Esta herramienta de prevención y detección temprana del fraude permite a las instituciones públicas, periodistas y a sociedad civil controlar automáticamente cómo se establece la relación entre empresas y administración a la hora de iniciarse un proceso de contratación pública.

- Galardón: 7.000 €

Ganadores Reto "Oportunidades de contratación pública en la UE para los jóvenes"

La contratación pública a menudo se percibe como un campo complejo, donde solo los especialistas se sienten cómodos para encontrar la información que necesitan. Así, los desarrolladores que participaron en este desafío tuvieron que diseñar, por ejemplo, aplicaciones destinadas a ayudar a los jóvenes a encontrar la información necesaria para aplicar a puestos de contratación pública.

1º premio: Hermix (Bélgica, Rumanía)

Se trata de una herramienta que desarrolla una metodología de marketing estratégico dirigido al sector B2G (bussines to goverment) para que, así, sea posible automatizar la creación y la monitorización de las estrategias de este sector.

- Galardón: 25.000 €

2º premio: YouthPOP (Grecia)

YouthPOP es una herramienta diseñada para democratizar las oportunidades de empleo y contratación pública para acercarlas a jóvenes trabajadores y empresarios. Para ello combinan datos históricos con tecnología de aprendizaje automático.

- Galardón: 15.000 €

3º premio: HasPopEU (Rumanía)

Esta propuesta aprovecha los datos abiertos de la contratación pública de la Unión Europea y las técnicas de machine learning para mejorar la comunicación de las competencias requeridas para acceder a este tipo de convocatorias laborales. La aplicación pone el foco en los jóvenes, los inmigrantes y las pymes.

- Galardón: 7.000 €

Ganadores Reto "Una Europa Adaptada a la Era Digital"

La UE aspira a una transformación digital que funcione para las personas y las empresas. Por ello, los participantes de este reto desarrollaron aplicaciones y servicios destinados a mejorar las competencias en materia de datos, conectividad o divulgación de los mismos, siempre tomando como base la Estrategia Europea de Datos.

1º premio: Lobium/Gavagai (Países Bajos, Suecia, Reino Unido)

Esta aplicación desarrollada a partir de técnicas de procesamiento del lenguaje natural nace con el objetivo de facilitar el trabajo de los periodistas de investigación, fomentando la transparencia y el rápido acceso a determinada información.

- Galardón: 25.000 €

2º premio: 100 Europeans (Grecia)

Se trata de una app interactiva que utiliza los datos abiertos para sensibilizar sobre los grandes retos de nuestro tiempo. De este modo y conscientes de lo difícil que es comunicar el impacto que estos retos tienen en la sociedad, ‘100 Europeans’ cambia la forma de trasladar el mensaje y personaliza los efectos del cambio climático, la contaminación o el sobrepeso en un total de cien personas. El objetivo de este proyecto es conseguir que la sociedad sea más consciente de estos retos al contarlos a través de historias de personas cercanas.

- Galardón: 15.000 €

3º premio: UNIOR NLP (Italia)

Aprovechando las técnicas de procesamiento del lenguaje natural y la recopilación de datos europeos, el grupo de investigación de lingüística computacional y procesamiento automático del lenguaje natural de la Universidad de Nápoles L'Orientale ha desarrollado un asistente personal llamado Maggie que guía a los usuarios para que exploren los contenidos culturales de toda Europa, respondiendo a sus preguntas y ofreciendo sugerencias personalizadas.

- Galardón: 7.000 €

Por último, el Premio del Público de esta edición de 2022 ha recaído también en CROZ RenEUwable, el mismo equipo que se llevó el primer premio del reto dedicado a fomentar el compromiso por el Pacto Verde europeo.

Al igual que sucedió con las ediciones anteriores, el EU Datathon es una competición organizada por la Oficina de Publicaciones de la Unión Europea en colaboración con la Estrategia de Datos Europea. Así, la edición recién clausurada de 2022 ha logrado activar el apoyo de una veintena de colaboradores y que representan a las partes interesadas en datos abiertos, dentro y fuera de las instituciones europeas.

La IV edición del Desafío Aporta, cuyo lema ha girado en torno a ‘El valor del dato para la salud y el bienestar de los ciudadanos’, ya tiene a sus tres ganadores. La competición, impulsada por Red.es en colaboración con la Secretaría de Estado de Digitalización e Inteligencia Artificial, arrancó en noviembre de 2021 con un concurso de ideas y continuó a principios de este verano con una selección de diez propuestas finalistas.

Al igual que sucedió en las tres ediciones anteriores, los candidatos elegidos dispusieron de un plazo de tres meses para transformar sus ideas en un prototipo que, posteriormente, debían presentar de forma presencial en la gala final.

En un contexto postpandémico, donde la salud juega un papel cada vez más importante, la temática de la competición buscaba identificar, reconocer y premiar las ideas destinadas a mejorar la eficiencia de este sector con soluciones basadas en el uso de los datos abiertos.

El pasado 18 de octubre, los diez finalistas acudieron a la sede de Red.es para presentar sus propuestas frente a un jurado formado por representantes de las Administraciones Públicas, organismos ligados a la economía digital y el ámbito de la universidad y las comunidades de datos. En tan solo doce minutos, tuvieron que resumir la finalidad del proyecto o servicio propuesto, explicar cómo había sido el proceso de desarrollo, qué datos habían utilizado y detenerse en aspectos como la viabilidad económica o la trazabilidad del mismo.

Una decena de proyectos innovadores para mejorar el sector salud

Las diez propuestas presentadas frente al jurado hicieron gala de una alto nivel de innovación, creatividad, rigor y vocación pública. Así mismo, fueron capaces de evidenciar que es posible mejorar la calidad de vida de los ciudadanos creando iniciativas que monitoricen la calidad del aire, construyan soluciones frente al cambio climático o den una respuesta más ágil a un problema de salud repentino, entre otros ejemplos expuestos.

Por todo ello, no es de extrañar que el jurado lo haya tenido complicado a la hora de elegir a los tres vencedores de esta cuarta edición. Finalmente, ha sido la iniciativa HelpVoice la que se ha alzado con el primer premio de 5.000€, la Encuesta de Morbilidad Hospitalaria se ha llevado los 4.000€ vinculados a la segunda posición y RIAN, Recomendador Inteligente de Actividades y Nutrición, ha cerrado el ranking con el tercer puesto y 3.000 euros en calidad de galardón.

Primer premio: HelpVoice!

- Equipo: Data Express, integrado por Sandra García, Antonio Ríos y Alberto Berenguer.

HelpVoice! es un servicio cuyo objetivo es ayudar a las personas mayores utilizando técnicas de reconocimiento de voz basadas en aprendizaje automático. Así, ante una situación de emergencia, el usuario solo tendrá que hacer clic en un dispositivo que puede ser un botón de emergencia, un teléfono móvil o herramientas de domótica y comentar sus síntomas. El sistema enviará un informe con la transcripción realizada y predicciones al hospital más cercano, agilizando la respuesta de los sanitarios.

En paralelo, HelpVoice! también recomendará al paciente qué hacer mientras espera a los servicios de emergencia. Respecto al uso de los datos, el equipo Data Express ha utilizado información geográfica abierta como el mapa de hospitales de España y emplea datos de reconocimiento del habla y sentimientos en el texto.

Segundo premio: Encuesta de Morbilidad Hospitalaria

- Equipo: Marc Coca Moreno

Se trata de un entorno web basado en las herramientas MERN, Python y Pentaho para el análisis y la visualización interactiva de los microdatos de la Encuesta de Morbilidad Hospitalaria. Todo el proyecto se ha desarrollado con herramientas open source y gratuitas y, tanto el código como el producto final, serán accesibles de forma abierta.

Para ser exactos, ofrece 3 grandes análisis con el fin de mejorar la planificación sanitaria:

- Descriptivos: recuento de las altas hospitalarias y serie temporal.

- KPI: tasas e indicadores estandarizados para la comparación y el benchmarking de las provincias y comunidades.

- Flujos: recuento y análisis de las altas de una región hospitalaria y procedencia del paciente.

Todos los datos pueden filtrarse según las variables del juego de datos (edad, sexo, diagnósticos, circunstancia de ingreso y alta, etc.)

En este caso, además de los microdatos de la Encuesta de Morbilidad Hospitalaria del INE, también se han integrado estadísticas del Padrón Continuo (también del INE), datos de los catálogos de diagnósticos CIE10 del Ministerio de Sanidad y de los catálogos e indicadores de Agency for Healthcare Research and Quality (AHRQ) y de las Comunidades Autónomas, como Cataluña: catálogos y herramientas de estratificación.

Puedes ver el resultado de este trabajo aquí.

Tercer premio: RIAN, Recomendador Inteligente de Actividades y Nutrición

- Equipo: RIAN Open Data Team, integrado por Jesús Noguera y Raúl Micharet.

Este proyecto surge para fomentar los hábitos saludables y combatir el sobrepeso, la obesidad, el sedentarismo y la mala nutrición entre niños y adolescentes. Se trata de una aplicación diseñada para dispositivos móviles y que utiliza técnicas de gamificación, así como realidad aumentada y algoritmos de inteligencia artificial para realizar recomendaciones.