En el último año, hemos visto como las decisiones en materia de salud marcaban la agenda política, social y económica de nuestro país, debido a la situación de pandemia mundial fruto de la COVID-19. Decisiones tomadas en base a datos públicos sobre incidencia acumulada, ocupación de camas en hospitales o tasa de vacunación han marcado nuestro día a día.

Este hecho pone de manifiesto la importancia de los datos de salud abiertos para la gestión y toma de decisiones por parte de nuestros gobernantes, pero también son fundamentales como base de soluciones que ayuden tanto a pacientes como a médicos.

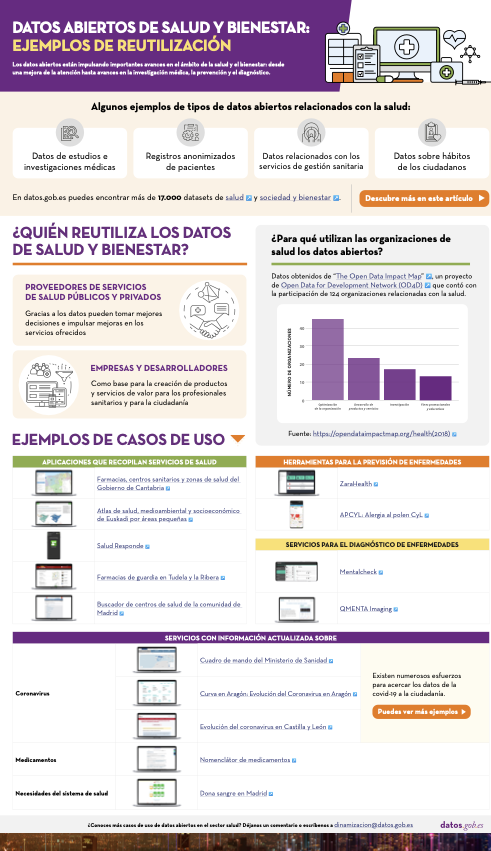

Los tipos de datos utilizados en el ámbito de la salud y bienestar son numerosos: resultados de estudios e investigaciones médicas, registros anonimizados de pacientes, datos sobre sus hábitos (como el ejercicio que realizamos o las horas que dormimos) o datos vinculados a los servicios y la gestión sanitaria. Todos estos datos esconden un gran valor que puede ser aprovechado tanto por los profesionales y proveedores de servicios de salud como por los ciudadanos.

¿Cómo han venido utilizando los datos abiertos los servicios de salud?

Según el estudio “The Open Data Impact Map”, un proyecto de Open Data for Development Network (OD4D), las organizaciones relacionadas con la salud utilizan los datos abiertos principalmente con el objetivo de optimizar su gestión y la organización de recursos. De las 124 organizaciones entrevistadas en 2018, solo 19 indicaron que aprovechan los datos abiertos para el desarrollo de productos y servicios sanitarios, y únicamente 13 para investigación. El mismo estudio indica que los datos abiertos más utilizados son aquellos relacionados directamente con la salud, y que son muy pocas las organizaciones que los combinan con conjuntos de datos de otras temáticas - principalmente geoespaciales o indicadores demográficos o sociales- para generar un conocimiento más profundo y detallado.

Sin embargo, las oportunidades en este campo son muy amplias, como se muestra a continuación.

Haz clic aquí para ver la infografía en tamaño completo y en su versión accesible

Ejemplos de servicios basados en datos abiertos de salud y bienestar

La situación parece que está cambiando y cada vez hay un mayor impulso para la puesta en marcha de aplicaciones, servicios o proyectos basados en datos en este campo. En Europa se apuesta por la creación de espacios de datos centrados en el ámbito de la salud, dentro de su estrategia de construcción de una nube europea, mientras que el gobierno de España ha incluido el impulso de soluciones de Salud Digital dentro de su estrategia de España Digital 2025. Entre las acciones contempladas por nuestro país está la agilización de los sistemas de información para permitir una mejor compartición de datos e interoperabilidad.

Aplicaciones que recopilan servicios de salud

Cuando hablamos de aplicaciones de salud, las más habituales son aquellas que ayudan a la ciudadanía a encontrar proveedores de atención sanitaria locales que satisfagan sus necesidades. Un ejemplo Farmacias de guardia en Tudela y la Ribera o el buscador de centros de salud de la comunidad de Madrid. Gracias a ellas los pacientes pueden saber dónde se ubican los centros y conocer información de interés, como el horario. Algunas aplicaciones, incluyen servicios adicionales, como Salud Responde, de la Junta de Andalucía, que permite la solicitud y modificación de citas médicas, mejorando la eficiencia del sistema.

Pero este tipo de servicios también pueden proporcionar una información importante a la hora de gestionar de una manera más eficiente los recursos, sobre todo cuando se cruza con otros conjuntos de datos. Por ejemplo, Farmacias, Centros Sanitarios y Zonas de Salud del Gobierno de Cantabria, desarrollada por Esri, incluye información sobre la ordenación territorial de los recursos sanitarios en función de factores geográficos, demográficos, epidemiológicos, socio-económicos, laborales, culturales, climatológicos y de transporte. Su objetivo principal no es solo facilitar el acceso de la ciudadanía a esta información, si no que “la prestación de servicios sanitarios se realice en las mejores condiciones de accesibilidad, eficiencia y calidad”.

Por su parte, el Atlas de salud, medioambiental y socioeconómico de Euskadi por áreas pequeñas muestra una serie de mapas con el objetivo de “monitorizar las desigualdades geográficas en indicadores de salud, socioeconómicos y medioambientales en Euskadi, teniendo en cuenta la perspectiva de género”. Información de gran utilidad de cara a los gestores de servicios para tratar de impulsar una mayor equidad en el acceso a la sanidad.

Herramientas para la prevención de enfermedades

En el mercado también encontramos aplicaciones destinadas a la prevención de enfermedades, como ZaraHealth, una aplicación web que muestra en tiempo real los datos de la calidad del agua, el estado del aire, y los niveles de polen de la ciudad de Zaragoza. El usuario puede establecer una serie de umbrales para los niveles de polen y de contaminación, de tal forma que se emita un aviso cuando se alcancen. De esta forma podrá evitar salir al aire libre o realizar ejercicio en las zonas que no se ajusten a sus necesidades. En la misma línea se mueve APCYL: Alergia al polen CyL.

Otro aspecto importante en nuestra salud es la dieta, clave en la prevención de diversas patologías como las enfermedades cardiovasculares o la diabetes. Webs como Mils, que ofrece información nutricional detallada sobre los alimentos pueden ayudarnos a llevar una dieta más saludable.

Servicios para el diagnóstico y tratamiento de enfermedades

Los datos abiertos pueden ayudar a evaluar los resultados sanitarios, desarrollar tratamientos más eficaces y predecir brotes de enfermedades.

En el campo de la salud mental, por ejemplo, encontramos Mentalcheck, una aplicación que permite realizar evaluaciones psicológicas y auto-registros mediante dispositivos móviles. Su objetivo es mejorar la Evaluación e Intervención Ecológica Momentánea (EMA y EMI en sus siglas en inglés). La aplicación incorpora datos abiertos sobre medicamentos y servicios de salud mental de la Administración de Alimentos y Medicamentos de EEUU (FDA, Food and Drug Administration). También permite integrar datos psicológicos y fisiológicos, para generar correlaciones.

Otro ejemplo es Qmenta, empresa centrada en el análisis de datos cerebrales, utilizando resonancias magnéticas y los datos clínicos relacionados. En los últimos meses también han incorporado datos abiertos relacionados con la COVID-19 en algunos de sus trabajos. A través de algoritmos de procesamiento de imágenes médicas, buscan acelerar el desarrollo de nuevas terapias para enfermedades neurológicas.

Información actualizada sobre enfermedades o necesidades del sistema

Otro campo donde los datos abiertos pueden impulsar mejoras es a la hora de informar de determinadas situaciones. Esto ha cobrado especial importancia en el contexto de pandemia mundial en el que nos encontramos y donde la ciudadanía demanda información constante y actualizada. En este sentido, encontramos el cuadro de mando del Ministerio de Sanidad a nivel estatal y distintas iniciativas regionales, como Curva en Aragón: Evolución del Coronavirus en Aragón o Evolución del coronavirus en Castilla y León. Se trata solo de un par de ejemplos, pero cabe resaltar que existen numerosos esfuerzos en este ámbito, como recoge el Ministerio de Sanidad en su web.

También es importante hacer transparente la información sobre medicamentos, tanto para médicos como para pacientes, facilitando las comparativas. En este sentido, el Nomenclátor de medicamentos muestra más de 20.000 medicamentos comercializados en España con cobertura de la Seguridad Social, ofreciendo información sobre su precio, presentación, enlace al prospecto, notas de seguridad o principios activos, entre otros.

Por último, también es importante informar sobre las necesidades de recursos, por ejemplos, las plazas de médicos o el estado de las reservas de sangre.

Los datos en general han impulsado importantes avances para mejorar los resultados sanitarios, desde un mayor acceso a la atención hasta la investigación médica y el diagnóstico. Los datos abiertos son un ingrediente fundamental que puede ayudar a enriquecer aún más esas soluciones con nuevas variables. Por ello es fundamental que se vayan abriendo cada vez más datos de salud y bienestar, siguiendo una serie de pautas y normas que garanticen la privacidad y seguridad de los pacientes. En este sentido, el informe “Datos abiertos y sanidad: contexto tecnológico, actores implicados y marco jurídico” incluye información sobre qué tipos de datos se pueden abrir y qué dice el marco jurídico al respecto.

¿Conoces más casos de uso de datos abiertos aplicados al sector de la sanidad y bienestar? Déjanos un comentario o escríbenos a dinamizacion@datos.gob.es.

Contenido elaborado por el equipo de datos.gob.es.

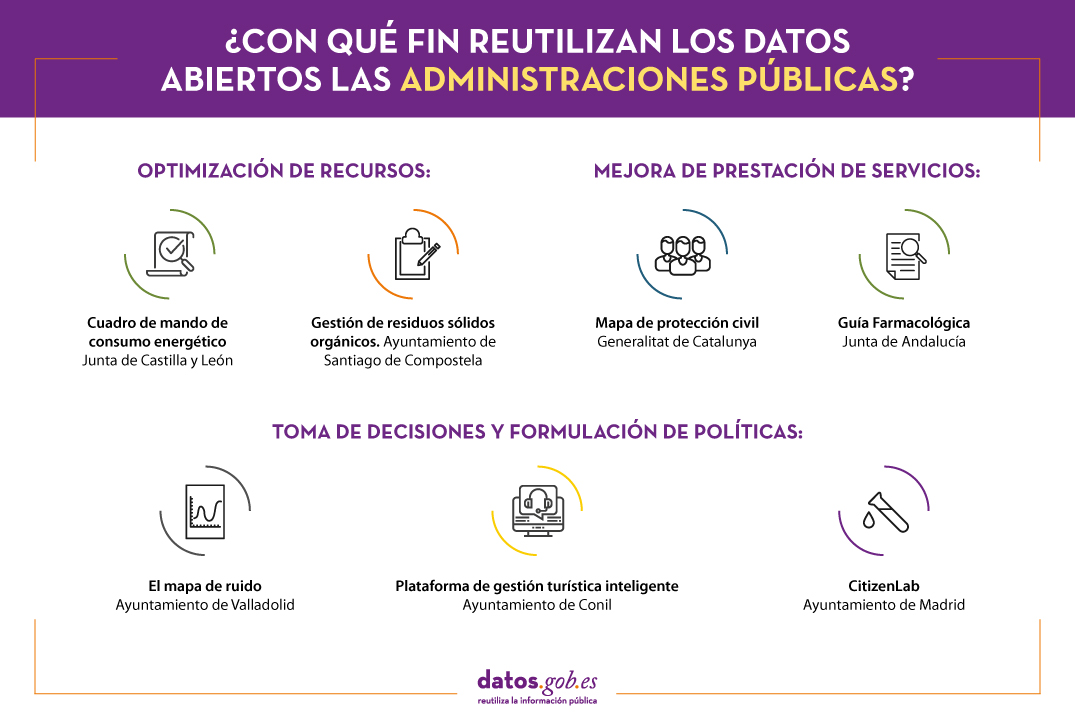

Los datos abiertos suponen una fuente de información para el desarrollo de servicios inteligentes, así como para la toma de decisiones y la formulación de políticas. Por ello, no es de extrañar que cada vez más organismos públicos, además de abrir datos - para que otros los reutilicen y por motivos de rendición de cuentas y transparencia-, también sean reutilizadores de sus propios datos con distintos fines.

En este sentido, el auge de las plataformas de gestión en smart cities está fomentando que muchos ayuntamientos y comunidades autónomas desarrollen aplicaciones y herramientas inteligentes que aprovechan el uso de los datos y las técnicas de analítica para innovar y mejorar los servicios públicos que ofrecen a los ciudadanos. A continuación, te mostramos varios ejemplos.

Optimización de recursos

Los datos abiertos pueden ser utilizados por organismos públicos para conocer cómo se están gestionando los recursos públicos, además de fomentar acciones que permitan realizar una gestión más eficiente y conseguir un ahorro económico, por ejemplo, en materia de consumo energético o impulsando una gestión de recursos más eficiente.

Cuadro de mando de consumo energético. Junta de Castilla y León.

Este datahub energético desarrollado por la iniciativa de datos abiertos de la Junta de Castilla y León, ofrece información detallada y visual sobre el consumo de energía en los centros gestionados por la Junta, como centros educativos, centros de salud, oficinas administrativas u hospitales, entre otros.

Se trata de un cuadro de mando que recoge información de más de 1.500 centros de consumo, ofreciendo diferentes tipos de representaciones gráficas que facilitan al lector la comprensión de los datos. A través de este enlace se puede consultar la fuente de datos utilizada para el desarrollo de esta plataforma.

La herramienta facilita el análisis desagregado por tipo de energía y por localización geográfica. Una información que pueden ser de interés para los ciudadanos, pero también para los propios gestores de la junta. Gracias a esta plataforma, la Junta ahorró entre 2015 e inicios de 2020 más de 12 millones de euros en electricidad.

Además, la Junta cuenta con un cuadro eléctrico centrado exclusivamente en el consumo eléctrico de los hospitales de Castilla y León por horas. Los datos se relacionan con la información meteorológica, de tal forma que se pueden estimar los costes futuros y optimizar el uso de la calefacción. Los datos utilizados para desarrollar este cuadro se pueden consultar aquí.

Gestión de residuos sólidos orgánicos. Ayuntamiento de Santiago de Compostela.

El Ayuntamiento de Santiago de Compostela ha puesto en marcha, dentro de la iniciativa Smartiago, un proyecto que persigue realizar una gestión sostenible e inteligente de residuos sólidos urbanos (RSU). El objetivo principal de esta herramienta es diseñar, desarrollar y construir contenedores inteligentes de superficie para la caracterización de residuos sólidos orgánicos, basados en el uso de tecnologías abiertas de IoT, la aplicación de algoritmos de aprendizaje automático y el uso de datos abiertos como fuentes para el enriquecimiento de modelos de predicción de compostaje comunitario. Con ello se busca alcanzar el objetivo del 50% de preparación para la reutilización y el reciclaje, partiendo del 13% actual. El proyecto, en base de desarrollo, también contará con una app de gamificación para incentivar buenas prácticas en materia de sostenibilidad.

Mejora de la prestación de servicios

Gracias a los datos abiertos también es posible crear herramientas para que los profesionales de servicios sociales puedan ofrecer una mejor respuesta y atención a las necesidades de la ciudadanía. Veamos un par de ejemplos:

Mapa de protección civil. Generalitat de Catalunya.

Este mapa interactivo muestra los principales recursos del sistema de protección civil de Cataluña. El mapa de protección civil permite ver donde se encuentran los distintos riesgos (tecnológicos, ambientales…) y la situación de los equipos para planificar mejor las respuestas. Aquí se puede consultar la principal fuente de datos que utiliza esta herramienta.

Guía Farmacológica. Junta de Andalucía.

Esta aplicación ha sido diseñada por la Junta de Andalucía para ofrecer a los profesionales sanitarios una consulta más rápida y eficiente de los principales fármacos que se utilizan en la atención a las urgencias y emergencias en Andalucía. Se trata de un instrumento de trabajo útil para aquellos sanitarios que prestan asistencia en situaciones críticas ya que incluye información en permanente actualización y contrastada acerca de las principales indicaciones, dosis, contraindicaciones e interacciones de los fármacos que más se utilizan.

Toma de decisiones y formulación de políticas

Los datos abiertos proporcionan un mayor conocimiento sobre lo que está sucediendo a nuestro alrededor, lo cual nos permite poder tomar mejores decisiones. Se trata de un instrumento muy útil para que los organismos públicos puedan elaborar políticas que respondan a las necesidades reales de la ciudadanía. Durante el último año, hemos visto como las medidas para evitar la propagación de la COVID-19 se tomaban en base a los datos relativos a la evolución de la enfermedad. Otros ejemplos son:

El Mapa de ruido. Ayuntamiento de Valladolid.

El Ayuntamiento de Valladolid cuenta con un Mapa de Ruido que organiza la información relativa a la contaminación acústica. Este mapa ha sido desarrollado para utilizarse de forma obligatoria en la ejecución de los cálculos previstos en las diferentes normas reguladoras, así como en el código técnico de la edificación y que aplicarán tanto a edificios residenciales, o dotacionales, institucionales e industriales, así como en el código técnico de la edificación y que aplicarán tanto a edificios residenciales, o dotacionales, institucionales e industriales.

Plataforma de gestión turística inteligente. Ayuntamiento de Conil.

En el marco de las convocatorias de Ciudades, Territorios e Islas Inteligentes de Red.es cada vez encontramos más propuestas que incluyen el desarrollo de plataformas de gestión de datos que impulsan una toma de decisiones eficiente. Un ejemplo es el Ayuntamiento de Conil de la Frontera, que trabaja con una plataforma de gestión turística inteligente para ampliar el conocimiento de los turistas, a través de la agregación y centralización de datos relativas a la procedencia del turista, movilidad y zonas más visitadas, lugares preferidos para visitar y pernoctar o encuestas de satisfacción, entre otros parámetros. De esta forma, desde la administración local pueden identificar patrones y llevar a cabo actuaciones que permitan adaptar y mejorar la gestión, detectar irregularidades, fomentar el desarrollo económico y empresarial o favorecer la generación de empleo en las áreas prioritarias identificadas. Estos datos también se han utilizado para estimar la población real durante la pandemia y hacer una mejor estimación de los ratios de incidencia. Aunque de momento estos datos no parecen ser públicos, el objetivo es que también se abran a través de una plataforma open data a empresas.

CitizenLab. Ayuntamiento de Madrid.

El gobierno autonómico de Madrid ha impulsado, junto a Grant Thornton, un laboratorio de datos para entender mejor el comportamiento ciudadano. El proyecto busca analizar modelos predictivos de comportamiento ciudadano mediante Big Data e Inteligencia Artificial (IA), con el objetivo de mejorar los servicios públicos en la Comunidad de Madrid en áreas como la movilidad, la atención sanitaria, el turismo y las infraestructuras. En el último año, por ejemplo, se ha utilizado para predecir la demanda de vacunas.

Sin duda, existen numerosas aplicaciones y herramientas digitales utilizadas por las administraciones públicas -y cada vez parece que serán más - que basan su funcionamiento en los datos abiertos para ofrecer más y mejores servicios a la ciudadanía. En este artículo hemos recopilado algunos ejemplos, pero si conoces alguna relacionada que pueda ser de interés, no dudes en dejar un comentario o escribirnos a nuestra dirección de correo electrónico dinamizacion@datos.gob.es.

Contenido elaborado por el equipo de datos.gob.es.

Los próximos días 23, 24 y 25 de noviembre tendrá lugar la primera edición de EU Open Data Days, las Jornadas de Datos Abiertos de la Unión Europea, que se podrán seguir de manera online. Organizadas por la Oficina de Publicaciones y la Presidencia del Consejo de la Unión Europea, nacen con la vocación de fomentar los datos abiertos, mostrando el valor de los diferentes modelos de negocio basados en ellos.

El evento se distribuirá en 3 jornadas: los dos primeros días tendrá lugar la conferencia EU DataViz 2021, centrada en el open data y las visualizaciones de datos, mientras que el último día se dedicará a la final del EU Datathon 2021.

EU Dataviz 2021

La conferencia EU Dataviz 2021 contarán con la participación de expertos que abordarán técnicas y buenas prácticas relativas a los datos abiertos y su reutilización tanto en el sector privado como en el público.

El contenido del evento se ha construido de manera colaborativa. Entre los meses de marzo y mayo de este año, los ciudadanos de todo el mundo tuvieron la oportunidad de enviar sus propuestas temáticas, para participar como ponentes. De entre las más de 150 propuestas recibidas, el Comité del Programa EU DataViz 2021 seleccionó las elegidas para conformar la agenda final, que ocupará dos jornadas.

23 de noviembre de 2021: Open data

La primera jornada arrojará luz sobre los datos abiertos como base de soluciones que den forma al futuro digital de Europa.

La apertura correrá a cargo de la Dirección General de la Oficina de Publicaciones de la Unión Europea. Seguirá Xavier Bettel, Primer Ministro de Luxemburgo, con una ponencia sobre los datos y la digitalización como centro de la innovación de Luxemburgo. A continuación, tendrá lugar una sesión plenaria- con charlas de 30 a 45 minutos en las que se expondrán buenas prácticas, nuevos casos de uso y tendencias emergentes- y tres sesiones temáticas – de 45 a 60 minutos, con un enfoque más práctico-:

-

Sesión plenaria. Se abordará la estrategia de datos de la UE y su camino hacia un mercado único europeo, así como la situación de los datos abiertos en Europa. También contará con una mesa redonda dedicada a la inteligencia de los datos y su conversión en decisiones informadas. La nota española la pondrá Nuria Oliver, Cofundadora y Vicepresidenta de ELLIS - Laboratorio Europeo de Aprendizaje y Sistemas Inteligentes (España)-, quien hablará sobre la experiencia de Valencia a la hora de utilizar la ciencia de los datos en la lucha contra el COVID-19.

-

Sesión temática 1: Creación de ecosistemas de datos abiertos. Se mostrarán ejemplos de proyectos que contribuyen a impulsar políticas de datos abiertos, como el proyecto europeo de conocimiento abierto sobre la salud del agua (WHOW).

-

Sesión temática 2: Datos para las personas. Se destacará la importancia de la participación ciudadana y de los proyectos orientados al usuario en el campo de los datos abiertos. Entre los proyectos que se mostrarán, destacamos la ponencia Antonio Ibáñez, Jefe de transparencia y reutilización de la información de Castilla y León, quien hablará sobre la transparencia y los datos abiertos en el servicio de salud de la región.

-

Sesión temática 3: Facilitar la reutilización de los datos. Centrada en los factores facilitadores de los datos abiertos, como los principios FAIR, la alfabetización digital o los mecanismos que garantizan la interoperabilidad.

24 de noviembre de 2021: Visualización de datos

Esta jornada abordará la importancia de comunicar los datos de forma eficiente. Aportará buenas prácticas y técnicas para construir narrativas de datos y asegurar un mejor servicio a los ciudadanos.

Tras la apertura de Boštjan Koritnik, Ministro de Administración Pública de Eslovenia, en representación de la Presidencia del Consejo de la Unión Europea, tendrán lugar también sesiones plenarias y temáticas.

-

Sesión plenaria. Constará de tres ponencias “La visualización de datos como vector de innovación: el caso de los abogados”, “Aplicación de una conciencia diversa, equitativa e inclusiva en la visualización de datos” y “Abrir los datos climáticos de la UE mediante la narración de datos”.

-

Sesión temática 1: De los datos abiertos a la visualización de datos. Esta sesión servirá de puente entre los datos abiertos y la visualización de datos. Se hablará de storytelling y de capacitar a los ciudadanos para que conviertan los datos abiertos en ideas, entre otras cuestiones.

-

Sesión temática 2: Servir a los ciudadanos con dataviz. Se centrará en cómo involucrar las necesidades de los ciudadanos en el proceso de creación de visualizaciones y se ofrecerán consejos concretos, por ejemplo, para las visualizaciones de datos en teléfonos móviles.

-

Sesión temática 3: Utilización de dataviz para la elaboración de políticas. Mostrará cómo la visualización de datos puede apoyar el ciclo de toma de decisiones, con especial atención al sector público de la UE.

EU datathon 2021

El 25 de noviembre tendrá lugar la final de EU Datathon 2021. Los nueve equipos finalistas presentarán sus soluciones al jurado, que evaluará cada propuesta y determinará la clasificación final en las distintas categorías. Entre los finalistas se encuentra la española CleanSpot, una app que busca incentivar el reciclaje a través de la gamificación.

Los retos temáticos serán presentados por un panel de expertos y el evento se cerrará con una ceremonia de entrega de premios.

¿Cómo puedo asistir?

La inscripción es gratuita. Las distintas ponencias podrán seguirse de manera online, pero es necesario acceder bajo registro. ¡Inscríbete y descubre las últimas tendencias y casos de uso de los datos abiertos!

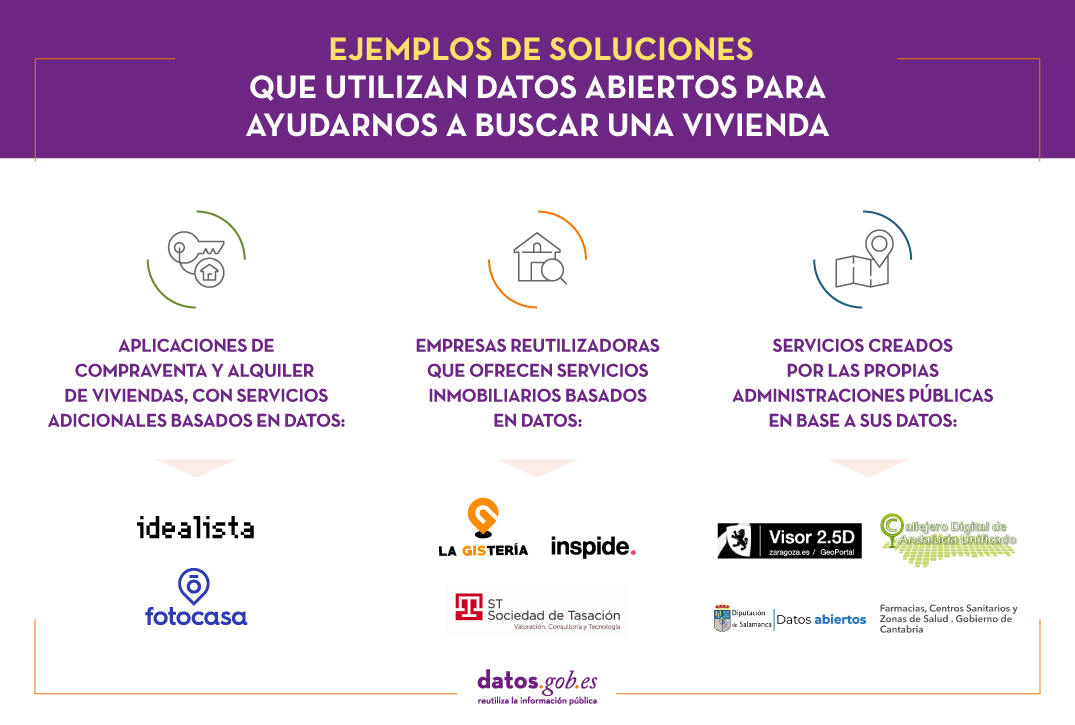

¿Sabías que la apertura de la información en sectores como el de la vivienda puede ayudarte a encontrar tu nuevo hogar? Cambiar de casa no suele ser una decisión fácil y pueden surgir algunas dudas, como saber si es más rentable comprar o alquilar, con qué servicios cuenta cada barrio de la ciudad o cuál es el precio aproximado de la vivienda en el mercado.

Los datos que ofrecen los organismos públicos pueden ayudarnos a encontrar respuestas a estas y otras muchas cuestiones. Estos datos se pueden utilizar para crear herramientas y aplicaciones que de una forma sencilla y amigable nos permitan comparar parámetros y tomar mejores decisiones, algunos de los cuales ya recogimos en un artículo anterior. En esta ocasión actualizamos la información incluyendo 10 nuevos casos de uso, ofrecidos por organismos públicos y privados, que pueden ofrecerte información de interés para encontrar tu nuevo hogar.

Aplicaciones de compraventa y alquiler de viviendas, que ofrecen servicios adicionales basados en datos

Actualmente existen numerosas herramientas digitales y aplicaciones que ofrecen a los usuarios información acerca de anuncios de venta o alquiler de inmuebles. Algunas de estas empresas, además, ofrecen servicios adicionales basados en datos que permiten conocer mejor el mercado. Veamos dos ejemplos.

- Idealista. En Idealista los usuarios pueden encontrar un análisis basado en datos del mercado inmobiliario en España, Portugal e Italia. Para ello utilizan tanto datos de fuentes públicas (por ejemplo, del Catastro, el Instituto Geográfico Nacional o el INE) como de fuentes privadas del propio portal idealista.com. Además, cuenta con un conjunto de herramientas tecnológicas - entre ellas la posibilidad de acceso a los datos de la plataforma a través de una API- y de análisis de información para procesar, homogeneizar y estructurar fuentes de datos útiles y transformarlas en información de fácil acceso. Un ejemplo es el mapa de precio medio de venta por metro cuadrado o su predicción de cuánta energía solar podrían generar todos los municipios de España.

- Fotocasa. Esta plataforma pone a disposición de los usuarios mapas interactivos con datos de su Índice Inmobiliario para saber, en tiempo real, el precio de venta y alquiler por m2 según la oferta de viviendas que están anunciadas en el portal inmobiliario. Fotocasa fomenta el uso de datos abiertos, posibilitando la utilización de estos datos de valor para medir el mercado.

Empresas reutilizadoras

En el mercado también encontramos empresas especializadas en la reutilización de datos, que aprovechan su potencial para crear servicios de interés en el campo inmobiliario. Algunos ejemplos son:

- La Gistería. Esta empresa de consultoría está especializada en visualizaciones de datos realizadas a través de tecnologías GIS. Junto a Geomarketing inmobiliario de Madrid, han creado 27 mapas delimitados por zonas, posicionando los puntos de interés de diversas áreas como salud, ocio, o educación. Estos mapas han sido creados utilizando los datos abiertos del Ayuntamiento de Madrid y la identidad de marca de la inmobiliaria Engel & Volkers para poder integrarlo en su web y facilitar la búsqueda de piso por parte de los usuarios.

- Inspide. A través de una aplicación web permite conocer si una ciudad como Madrid se adapta a los requerimientos de distanciamiento social derivados de la situación de pandemia actual y qué actuaciones urbanas podrían solucionar este problema. Inspide muestra, por ejemplo, el ancho de las aceras representado con colores, y especifica si su amplitud es adecuada para mantener la distancia requerida entre peatones. Se trata de una aplicación de gran interés si queremos encontrar un barrio amplio y de calles anchas en el que adquirir nuestra próxima vivienda.

- Sociedad de Tasación. Se trata de una empresa independiente de tasación que ofrecen valoraciones de todo tipo de bienes, en especial de activos inmobiliarios. Ofrece servicios de valoración, consultoría y tecnológicos, como el uso de Big Data e Inteligencia Artificial aplicada al Sector Inmobiliario. Para poner en marcha sus servicios utiliza tanto datos propios como públicos del Catastro, el portal estadístico de los Registradores, o del Consejo General del Notariado.

Servicios creados por las propias administraciones públicas en base a sus datos

No solo las empresas privadas crean soluciones basadas en datos abiertos. También ayuntamientos y organismos públicos ponen a disposición de sus ciudadanos aplicaciones y herramientas digitales que muestran información abierta de interés a la hora de decantarnos, por ejemplo, por la ubicación en la que compraremos nuestra nueva vivienda.

- Visor Interactivo de Zaragoza. El Ayuntamiento de Zaragoza, a través de su geoportal, ha incluido un visor interactivo que permite conocer los edificios de la ciudad y la sombra que proyectan en las calles. Este nuevo mapa virtual está accesible a todos los ciudadanos. El visor interactivo ofrece una visión innovadora de la ciudad que puede servir de ayuda si queremos información relevante acerca de la orientación y la exposición al sol que tiene una determinada zona de Zaragoza.

- Callejero Digital de Andalucía. Permite la búsqueda de direcciones postales en todos los municipios de Andalucía utilizando la información de vías y portales del proyecto CDAU (Callejero Digital de Andalucía Unificado). También es posible localizar otros puntos de interés, además de direcciones postales, a partir de los datos procedentes del producto DERA (Datos Espaciales de Referencia de Andalucía). Si estás pensando en buscar una zona que reúna las características que necesitas para comprar o alquilar una vivienda en Andalucía, esta aplicación puede servir de ayuda.

- Red de centros Crecemos de la provincia de Salamanca. El portal de datos abiertos de la Diputación de Salamanca ofrece a través de su página web información pública sobre la Red de centros Crecemos de la provincia de Salamanca. Esta red pertenece al programa ‘Crecemos’ de la Junta de Castilla y León, que facilita la conciliación en el medio rural, además de contribuir a generar empleo y fijar población en la zona. Entre otra información, se analizan los sitios donde es más fácil conciliar vida personal y laboral, información de gran utilidad para que los usuarios puedan saber dónde comprar una casa. El portal ofrece la posibilidad de descargar estos datos en varios formatos, como XSLX, CSV o XML.

- Farmacias, Centros Sanitarios y Zonas de Salud. Gobierno de Cantabria. ¿Cuántas farmacias y centros de salud existen en la zona en la que deseas comprar tu nueva vivienda? ¿A qué distancia se encuentran de tu ubicación? Este servicio muestra el mapa sanitario de Cantabria para ofrecer a sus usuarios datos acerca de la ubicación de las farmacias y hospitales en cada zona de la comunidad autónoma.

Sin duda, existen numerosas herramientas digitales y aplicaciones que basan sus servicios en datos abiertos para ofrecer información sobre el mercado inmobiliario a sus usuarios. Si conoces alguna otra herramienta basada en información abierta que crees que puede ser de nuestro interés, no dudes en dejarnos un comentario o enviarnos un correo a dinamizacion@datos.gob.es

Contenido elaborado por el equipo de datos.gob.es.

La movilidad es un motor económico clave. Aumentar la eficiencia y la calidad del sistema de movilidad de un país contribuye tanto a la fortaleza de su economía como a mejorar la calidad de vida de sus ciudadanos. Esto es particularmente importante en los sistemas de movilidad de las ciudades y sus áreas metropolitanas, donde se concentra la mayor parte de la población y, por tanto, de la actividad económica.

Conscientes de ello - y porque así lo exigimos los ciudadanos- las autoridades locales destinan desde hace décadas una parte importante de sus recursos anuales a ampliar, mejorar y hacer más eficientes sus redes de transporte y movilidad.

En la última década los datos abiertos han sido unos de los vectores de innovación más importantes que se han introducido en las estrategias de movilidad que desarrollan las ciudades, dando lugar a iniciativas difícilmente imaginables en periodos anteriores. Y es que, a pesar de todas las complejidades que conlleva, la apertura de conjuntos de datos de movilidad, tanto estáticos como en tiempo real, para su reutilización es en realidad económica y sencilla, si lo comparamos con el coste de construir una nueva infraestructura de transporte o con el coste de adquisición y mantenimiento de los sistemas de ayuda a la explotación (SAE) asociados a los servicios de movilidad. Además, la existencia de un despliegue cada vez mayor de redes de sensores, accesibles a través de sistemas de control desplegados en el contexto de estrategias de "ciudad inteligente", hacen que la tarea sea cada vez un poco más sencilla.

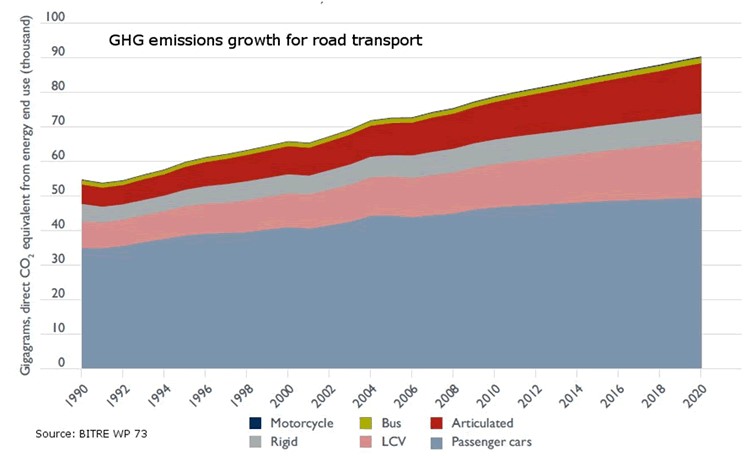

No debemos olvidar, además, que el transporte público es clave para hacer frente al cambio climático ya que se trata de una de las fuentes de emisiones de gases de efecto invernadero de más rápido crecimiento, y el transporte público ofrece la mejor solución de movilidad para trasladar a las personas de manera rápida y eficiente en las ciudades de todo el mundo. Como vemos en la figura, con el simple trasvase de pasajeros que utilizan sus vehículos privados al transporte público se consigue un gran impacto en la reducción de emisiones de gases de efecto invernadero. La Bus Industry Confederation estima que el transvase de viajeros desde los automóviles al transporte público puede generar una reducción de emisiones del 65% durante las horas pico. Esta reducción podría llegar hasta el 95% en las emisiones durante las horas valle para los viajeros que dejan de utilizar su vehículo privado para comenzar a utilizar el transporte público.

Por todo ello, contamos ya con numerosos ejemplos en los que liberar datos de transporte y movilidad para ponerlos en manos de los viajeros se está mostrando como una política con importantes beneficios para muchas ciudades: permite un mejor uso de los recursos y contribuye a una movilidad más eficiente por el espacio urbano.

Veamos algunos ejemplos quizá no tan conocidos como los que suelen alcanzar los medios de comunicación, pero que demuestran cómo la liberación de datos permite innovaciones beneficiosas tanto para los usuarios como, en algunos casos, para las propias autoridades.

Rediseño de las rutas de autobús en la ciudad de Nueva York

Todas las ciudades están constantemente pensando en formas de mejorar sus rutas de autobús con el fin de prestar el mejor servicio posible a los ciudadanos. Sin embargo, en la ciudad de Nueva York, la política de datos abiertos, aportó como consecuencia no planificada una importante ayuda para las autoridades, la aportación basada en el análisis de los datos de los propios usuarios de la red de autobuses.

La campaña Bus Turnaround Coalition promovida por los propios usuarios con el apoyo de TransitCenter, una fundación que trabaja para mejorar el transporte público en ciudades de Estados Unidos y la Riders Alliance, está utilizando datos abiertos para crear conciencia sobre el estado de la red de autobuses de la ciudad de Nueva York, proponiendo soluciones de mejora a los responsables de su gestión, la Autoridad Metropolitana de Transporte (MTA).

Para formular sus recomendaciones estas organizaciones analizaron los tiempos de llegada de los autobuses utilizando los mapas de ubicación de la propia MTA, incorporaron datos en tiempo real a través de la especificación GTFS, revisaron los datos de pasajeros y mapearon (y optimizaron) las rutas de los autobuses.

Entre las propuestas más novedosas está el cambio de enfoque en los criterios de diseño de las rutas. En vez de intentar satisfacer a todo tipo de viajeros, la Bus Turnaround Coalition, después de analizar cómo las personas se mueven realmente por la ciudad y qué tipo de transporte necesitarían para lograr sus objetivos de manera eficiente, propusieron las siguientes recomendaciones:

- Agregar líneas para llevar a los pasajeros de las afueras de la ciudad directamente a las líneas de metro, facilitando un viaje rápido.

- Mejorar las líneas para ofrecer rutas cortas y rápidas dentro de un vecindario, para las personas que quieren hacer un recado rápido o visitar a un amigo cercano.

- Dividir rutas demasiado largas para minimizar el riesgo de retrasos.

- Reajustar la distancia entre las paradas, que a menudo están demasiado cerca, complementando los huecos en la cobertura del metro.

Los datos abiertos han convertido frecuentes protestas y quejas de los usuarios por el mal funcionamiento de la red en un conjunto de aportaciones razonadas y basadas en datos, que han sido recogidas en una serie de compromisos de la MTA para mejorar la red de autobuses de Nueva York tales como el rediseño de la red de para 2021, el aumento del 25% en la velocidad de los trayectos o la gestión proactiva del mantenimiento de los autobuses.

Datos de uso de bicicletas en San Francisco

Como muchas otras ciudades, San Francisco, a través de su Agencia de Transporte Municipal (SFMTA), registra los datos de viajes de los usuarios de su sistema público de bicicletas compartidas y los ofrece como datos abiertos. En este caso la propia autoridad de transporte publica informes regulares, tanto sobre el uso en general del sistema, como de las conclusiones que obtiene para la propia mejora de la movilidad de la ciudad.

Documentando y analizando los volúmenes y las tendencias del uso de las bicicletas en San Francisco consiguen apoyar los objetivos del Plan Estratégico de la SFMTA, que pretende priorizar otras formas de viajar en la ciudad que no sean el automóvil particular.

Por ejemplo, el análisis continuo de los volúmenes de pasajeros en bicicleta en las intersecciones clave de la ciudad y las ideas aportadas por los ciudadanos ha permitido reducir la congestión del tráfico y los accidentes por la vía de la reorganización de las prioridades en el tránsito de los vehículos, de acuerdo con el uso real de las calzadas en cada momento del día.

Aparcamiento eficiente en Sacramento

Muchas ciudades tratan de abordar los problemas de congestión del tráfico desde diferentes puntos de vista incluido la gestión eficiente de los aparcamientos. Por ello uno de los conjuntos de datos que se publican con frecuencia en las ciudades con iniciativas de datos abiertos es el de ocupación de los aparcamientos públicos.

En la ciudad de Sacramento, California, la iniciativa de datos abiertos publica conjuntos de datos de la red de sensores que en toda la ciudad monitoriza la disponibilidad de estacionamiento en los parquímetros y no sólo en los aparcamientos públicos de la ciudad. De este modo han conseguido reducir las emisiones ya que los vehículos pasan menos tiempo buscando aparcamiento, al tiempo que han mejorado notablemente la fluidez del tráfico y la satisfacción de los ciudadanos que usan la app Sacpark.

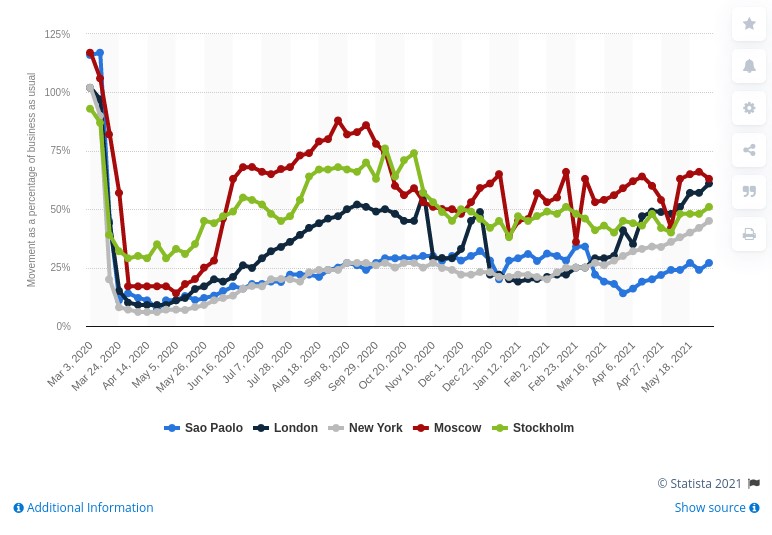

En el año 2020, debido a la pandemia, el transporte de pasajeros en todo el mundo se vio drásticamente reducido debido a las políticas de restricción de la movilidad que tuvieron que desplegar los gobiernos de todo el mundo para frenar la propagación del virus, como se ve en la siguiente imagen.

En junio de 2021 las ciudades aún están lejos de recuperar los niveles de movilidad que tenían en marzo de 2020, pero seguimos avanzado en que los datos sean la base sobre la cual construir información útil, y esenciales en las nuevas innovaciones que llegan a través de la inteligencia artificial.

Por ello, a medida que la pandemia remite, y muchas iniciativas se retoman, seguimos viendo cómo los datos abiertos están en el corazón de las estrategias de movilidad inteligente, conectada y respetuosa con el medio ambiente.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

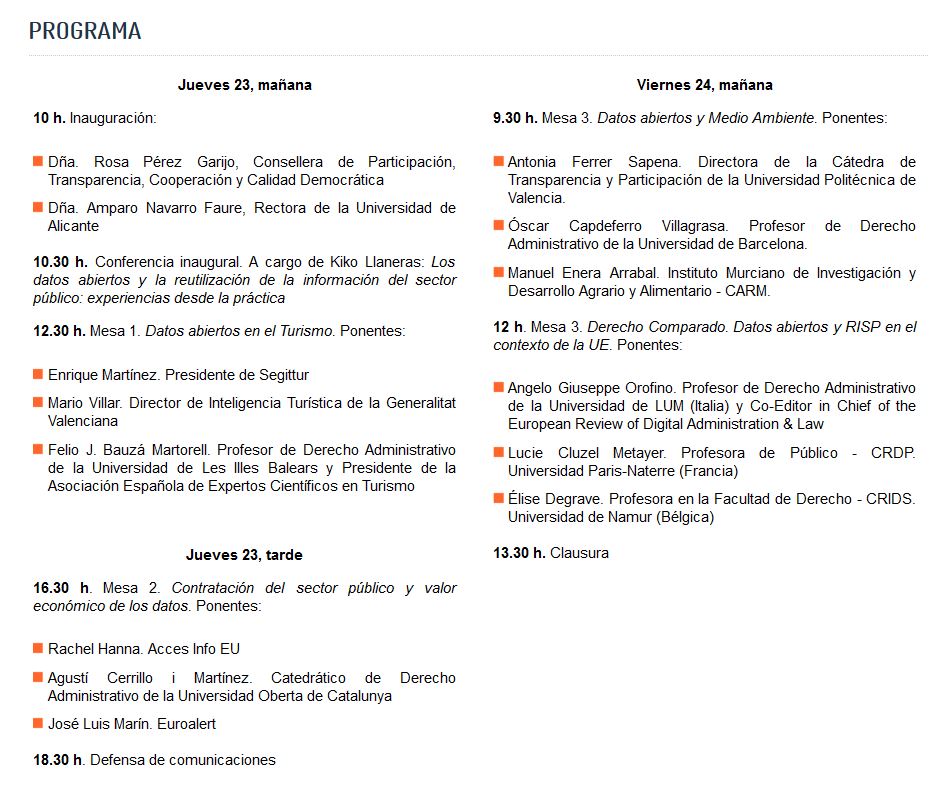

La Universidad de Alicante será la sede del Congreso Internacional de Datos Abiertos y Reutilización de la Información del Sector Público. El evento estará centrado en el papel de los datos abiertos y su potencial de reutilización para alcanzar mejoras en diversas áreas claves para nuestro país, como el turismo y la economía. También se abordará el análisis y las consecuencias jurídicas de la Directiva (UE) 2019/1024 del Parlamento Europeo y del Consejo, de 20 de junio de 2019, relativa a los datos abiertos y la reutilización de la información del sector público.

Este congreso se enmarca en el Proyecto “Retos del Ministerio PID2019-105736GB-I00DER: Datos abiertos y reutilización de la información del sector público en el contexto de su transformación digital: la adaptación al nuevo marco normativo de la Unión Europea”, cuyos investigadores principales son Julián Valero Torrijos y Rubén Martínez Gutiérrez, y del Convenio de Transparencia entre la Universidad de Alicante y la Conselleria de Participación, Transparencia, Cooperación y Calidad Democrática 2021.

Horario y agenda

El Congreso tendrá lugar los días 23 y 24 de septiembre de 2021 en modalidad online y presencial.

La inauguración correrá a cargo de Rosa Pérez Garijo, Consellera de Participación, Transparencia, Cooperación y Calidad Democrática de la Generalitat Valenciana, y Amparo Navarro Faure, Rectora de la Universidad de Alicante.

A continuación, Kiko Llaneras será el encargado de la conferencia inaugural con su ponencia “Los datos abiertos y la reutilización de la información del sector público: experiencias desde la práctica”. Kiko Llaneras es conocido por sus artículos de periodismo de datos en El país, donde analiza determinados aspectos de la actualidad política, social y económica en base a indicadores, estadísticas y encuestas, entre otras fuentes de datos.

A continuación, el Congreso se desarrollará en base a 4 mesas redondas, que llevarán por títulos:

- Datos abiertos en el Turismo

- Contratación y valor económico de los datos

- Datos abiertos y Medio Ambiente

- Derecho Comparado. Datos abiertos y RISP en el contexto de la UE

Cada uno de estas mesas contará con la participación de expertos y profesionales del ámbito público, privado y académico. Puedes ver el programa completo aquí.

¿Quieres participar en el Congreso? Aún estás a tiempo de enviar tus comunicaciones

El Congreso está abierto a la participación de ciudadanos y empresas que quieran compartir su conocimiento y experiencia. Se pueden presentar propuestas vinculadas a las cuatro mesas redondas, aunque también se admitirán temáticas libres siempre que estén alineadas con los objetivos del congreso.

Las comunicaciones deben presentarse antes del 15 de julio a través de este formulario. La solicitud consiste en un resumen de un máximo de 400 palabras donde se detalle la propuesta. El día 21 de este mismo mes la organización remitirá notificación de aceptación a las comunicaciones que deberán defenderse públicamente.

¿Cómo asistir?

El evento es gratuito, pero las plazas son limitadas. Para poder asistir, se debe completar este formulario antes del 20 de Septiembre de 2021 a las 23:59 horas. Las personas admitidas recibirán por correo electrónico confirmación de su inscripción.

A la hora de realizar la preinscripción, se debe indicar si se quiere asistir presencialmente o de manera virtual. Aquellos que marquen la opción online, recibirán un correo con el enlace a la plataforma de videollamada.

Si tienes cualquier duda, puedes escribir a cursos.deje@ua.es para temas administrativos y a ruben.martinez@ua.es para cuestiones académicas.

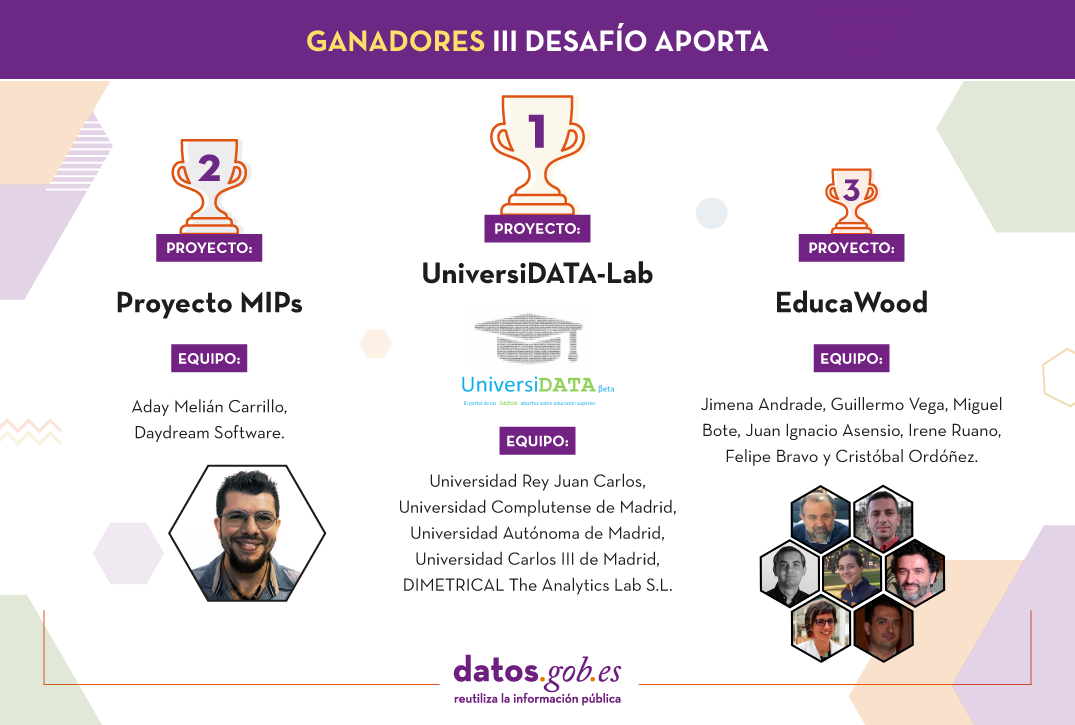

Tras meses de trabajo, el III Desafío Aporta llega a su fin. Bajo el lema “el valor del dato en la educación digital”, este año se buscaban soluciones que utilizasen datos abiertos para impulsar mejoras en el sector educativo.

La competición, organizada por la Iniciativa Aporta, lanzada por Red.es junto con la Secretaría de Estado de Digitalización e Inteligencia Artificial, comenzó en octubre de 2020, con una primera fase que consistía en un concurso de ideas. Tras la valoración del jurado, se eligieron 10 finalistas que han contado con tres meses para transformar sus ideas en un prototipo. Estos prototipos fueron presentados el pasado 22 de junio en una sesión online.

10 propuestas que destacan por su calidad

Los 10 trabajos presentados son una gran muestra del poder de los datos abiertos para transformar el sector educativo, mejorando su eficacia y eficiencia. La necesidad de un acceso universal al conocimiento a través de una educación inclusiva y de calidad ha quedado aún más patente en el contexto actual de pandemia que vivimos. Los datos abiertos pueden ayudar a superar este reto. Pueden ser analizados y utilizados para dar forma a soluciones que ayuden a mejorar la experiencia del alumnado en el proceso de aprendizaje, por ejemplo, a través de la personalización de la educación, la identificación de problemas de comportamiento o la toma de decisiones informada, entre otros aspectos.

Todos los trabajos presentados mostraban una gran calidad, reflejo del esfuerzo demostrado por todos los equipos finalistas. El jurado, integrado por expertos representantes de empresas, administraciones públicas y organismos ligados a la economía digital y el mundo académico, lo ha tenido complicado a la hora de elegir a los tres ganadores. Finalmente, los tres ganadores son UniversiDATA-Lab, Proyecto MIP y EducaWood, que se llevan un premio de 4.000€, 3.000€ y 2.000€ respectivamente.

Primer premio: UniversiDATA-Lab

-

Equipo: Universidad Rey Juan Carlos, Universidad Complutense de Madrid, Universidad Autónoma de Madrid, Universidad Carlos III de Madrid y DIMETRICAL The Analytics Lab S.L.

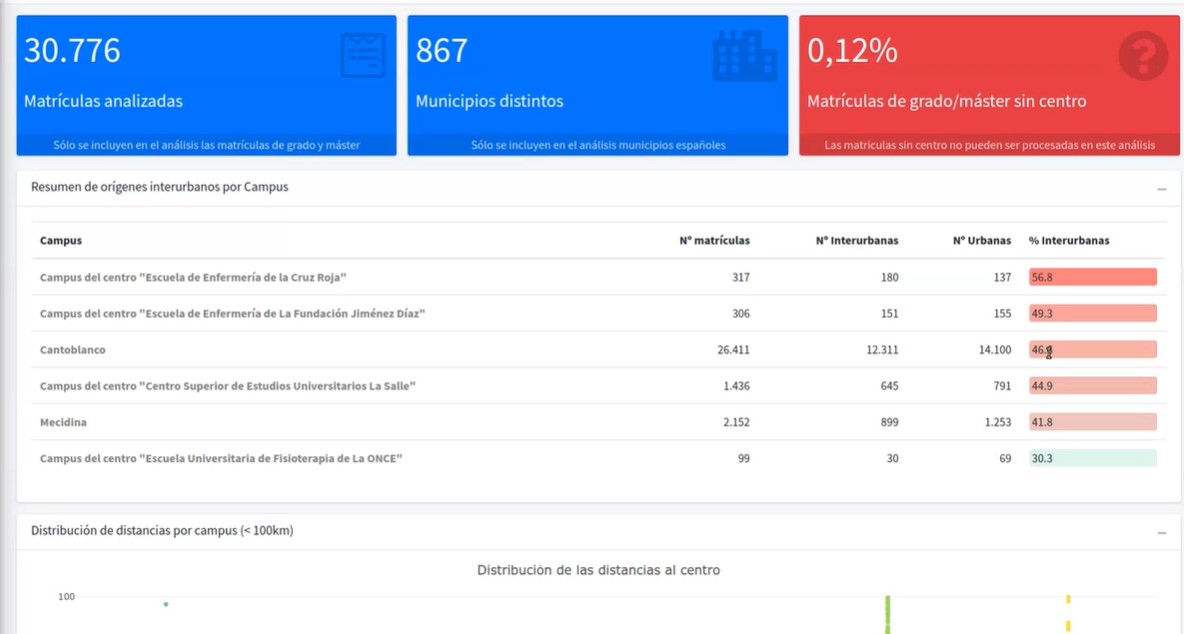

El primer premio ha sido para UniversiDATA-Lab, un portal público para el análisis avanzado y automático de los datasets publicados por las universidades. Se trata de un proyecto complementario a UniversiDATA: mientras que el objetivo de UniversiDATA es facilitar el acceso a conjuntos de datos universitarios de alta calidad y con formatos y criterios estándar, el objetivo de UniversiDATA-Lab es poner en valor esos datasets, llevando a cabo análisis avanzados y automáticos de los mismos, aprovechando la homogeneidad del contenido.

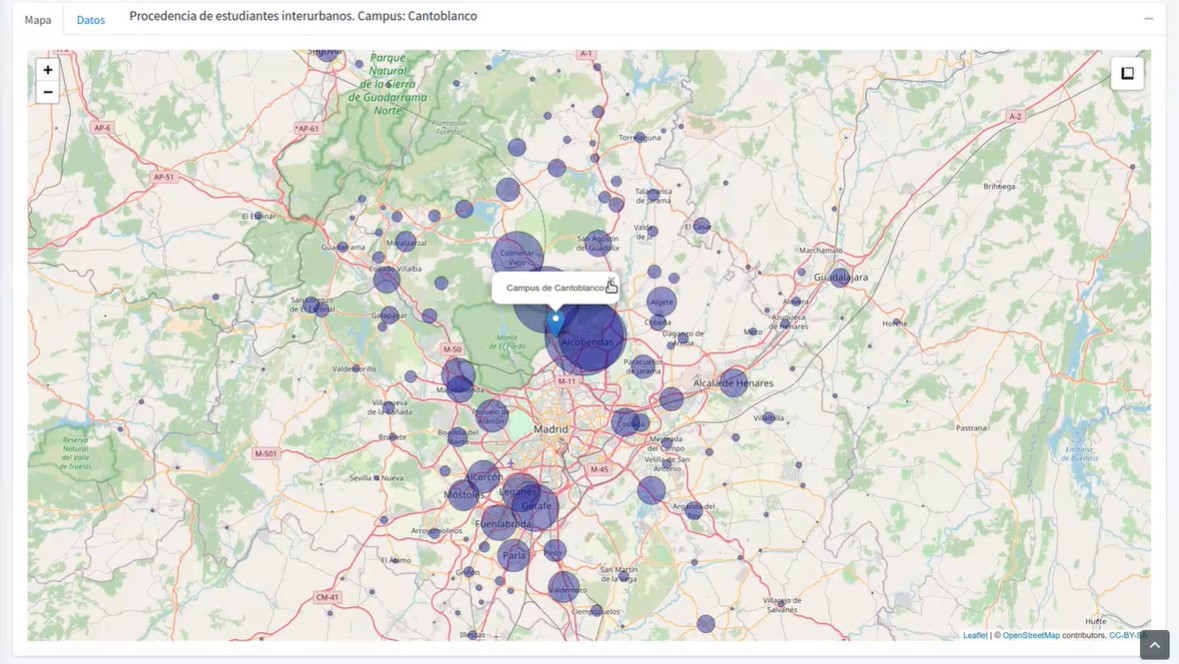

UniversiDATA-Lab ofrece un catálogo de aplicaciones creadas gracias a la aplicación de técnicas avanzadas de análisis y visualización, llevadas a cabo en lenguaje R. En la sesión online mostraron el análisis de desplazamientos interurbanos, el análisis del CO2 que generan los desplazamientos de los alumnos y el análisis de las diferencias de género en las distintas ramas universitarias.

Estos análisis pueden ser fundamentales a la hora de ayudar a las universidades a tomar decisiones relacionadas con la administración y la gestión, con grandes beneficios en el medio ambiente, la economía y la sociedad.

Capturas de UniversiDATA-Lab

Segundo premio: Proyecto MIP

- Equipo: Aday Melián Carrillo, Daydream Software.

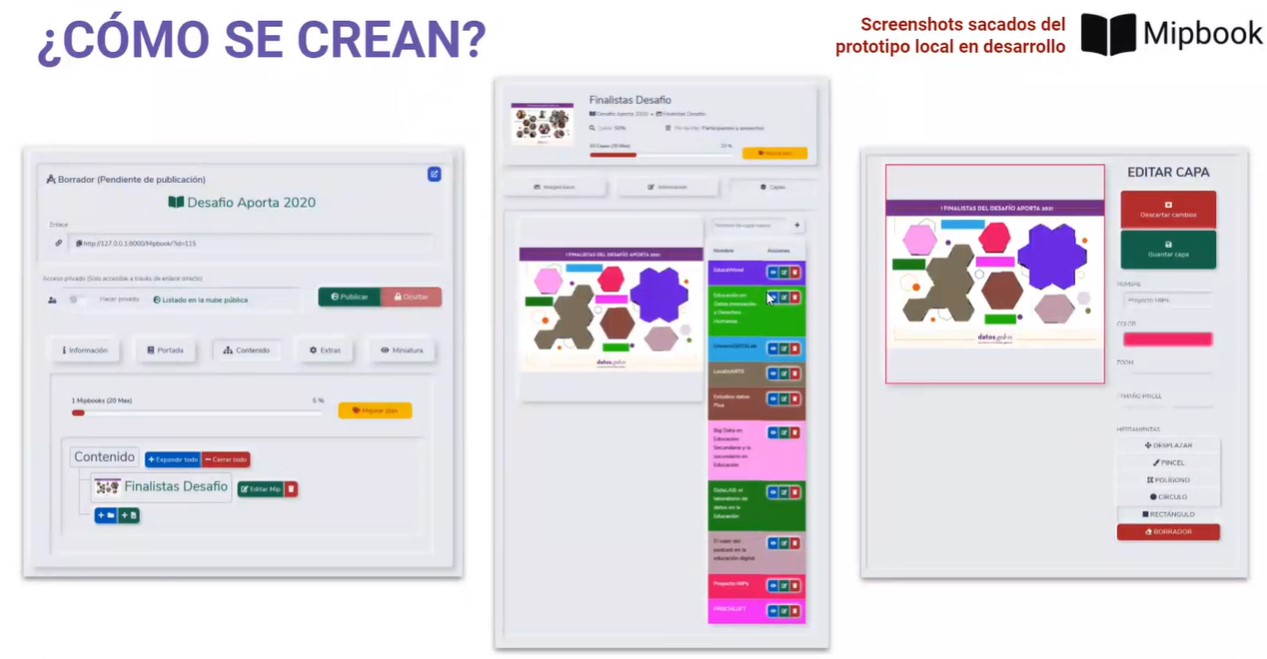

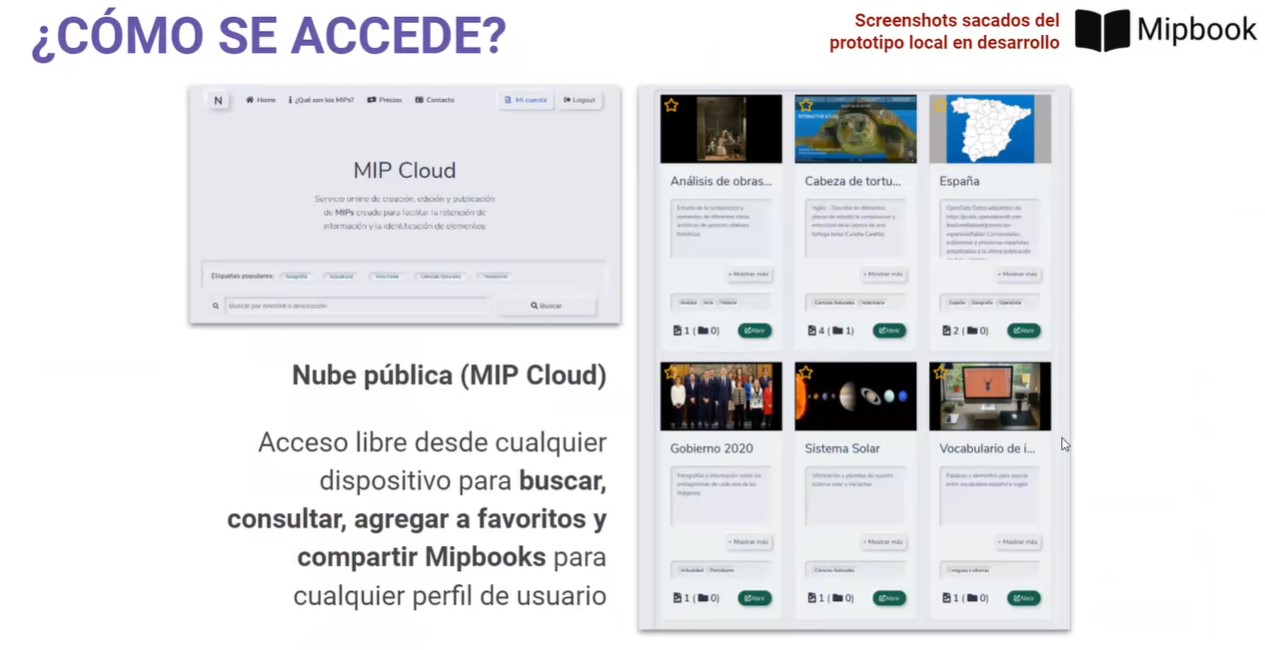

Proyecto MIP, el ganador del segundo premio, es un servicio online donde cualquier usuario puede registrarse y empezar a crear MIPs (Marked Information Picture). Un MIP es un soporte de información que consiste en una serie de capas interactivas sobre imágenes estáticas que facilitan la retención de información y la identificación de elementos.

El prototipo incluye un conversor en Python de datos abiertos GeoJSON al formato necesario para desarrollar atlas interactivos. A su vez, también ofrece una nube pública de MIPs accesibles libremente para consultas, estudios o aprendizaje independiente.

Gracias a esta herramienta los profesores pueden crear MIPs de forma rápida y sencilla, dibujando manualmente regiones de interés sobre cualquier imagen importada a través de la web. Una forma más amena de educar y con la que atraer más fácilmente la atención del alumnado.

Capturas de Proyecto MIP

Tercer premio EducaWood

-

Equipo: Jimena Andrade, Guillermo Vega, Miguel Bote, Juan Ignacio Asensio, Irene Ruano, Felipe Bravo y Cristóbal Ordóñez.

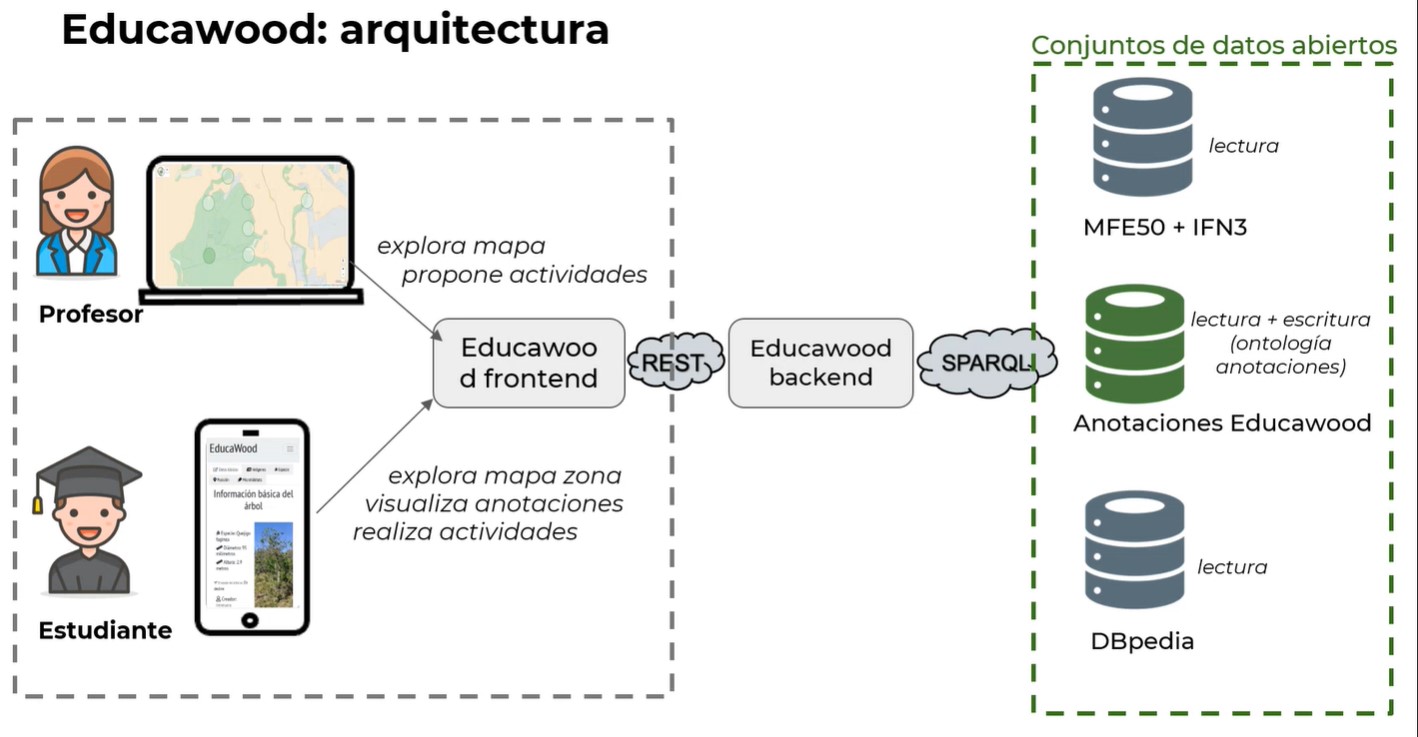

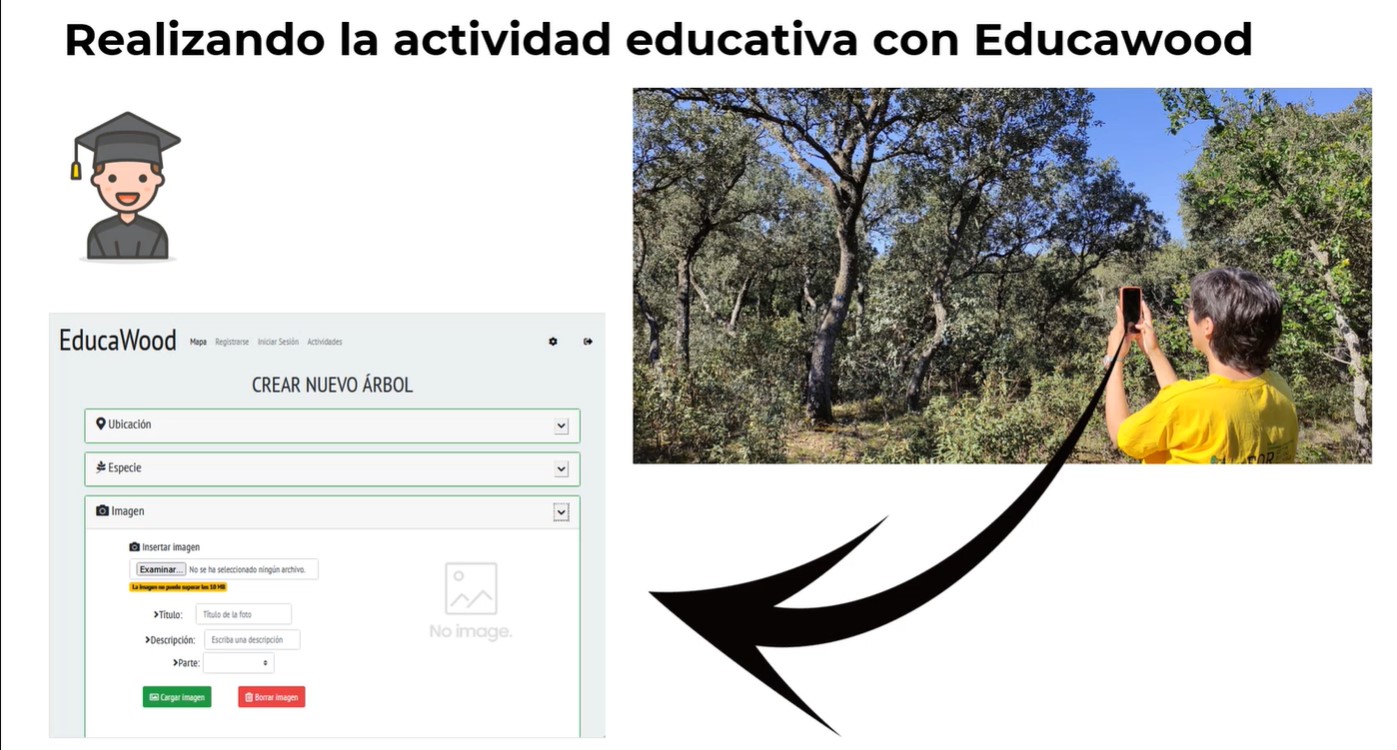

EducaWood es un portal web socio-semántico que permite explorar la información forestal de una zona del territorio español y enriquecerla con anotaciones de árboles. Su objetivo es impulsar las actividades de aprendizaje medioambiental, uno de los aspectos principales de la “Educación para los Objetivos de Desarrollo Sostenible” de la UNESCO, y que forma parte de la Agenda 2030 del Gobierno español.

Gracias al uso de EducaWood, el profesorado puede proponer actividades que los estudiantes realizan de manera presencial u online (a través de visitas virtuales al campo). En la modalidad presencial, los estudiantes visitan zonas naturales y realizan anotaciones de árboles, como la localización e identificación de especies, medidas, microhábitats, fotos, etc. Estas anotaciones pasan a estar disponibles para toda la comunidad como datos abiertos, posibilitando así el uso de la aplicación en remoto. Estos datos son enriquecidos, además con otras fuentes como el Mapa Forestal Español, el Inventario Forestal Nacional, GeoNames o DBPedia.

Educawood ayuda al alumnado a conocer mejor su entorno, a la vez que se promociona la toma de conciencia ecológica.

Capturas de Educawood

Alberto Martínez Lacambra, Director General de Red.es, hace entrega de los galardones

Los premios a los tres ganadores se han dado a conocer el 8 de julio en un acto organizado en la sede de Red.es.

Los 3 galardones han sido anunciados por Alberto Martínez Lacambra, Director General de Red.es, quien ha destacado la educación como elemento clave en la evolución de una sociedad marcada por la pandemia, así como la necesidad de trabajar para reducir la brecha digital y social que todavía existe. Ha agradecido la participación de todos los participantes, destacando la calidad de su trabajo.

El acto ha contado con la participación de varios miembros del jurado, que han podido conversar con los tres equipos ganadores.

En el siguiente video puedes ver cómo transcurrió el acto. También están disponibles las fotos en nuestra cuenta de Flickr.

En datos.gob.es ya estamos trabajando para dar forma al IV Desafío Aporta, que esperamos poder anunciar en los próximos meses.

La primavera está llegando a su fin para dar lugar al verano, a las vacaciones y al calor. Como cada cambio de estación, para la Iniciativa Aporta es el momento de repasar qué ha pasado en el ecosistema de datos abiertos durante los últimos tres meses.

Impulso a las estrategias de datos

Durante esta estación hemos visto como varias iniciativas, tanto locales como estatales, lanzaban procesos para actualizar sus estrategias relacionadas con los datos:

- En abril, el Ayuntamiento de Málaga presentó un Plan Municipal de Gobierno Abierto que incluye iniciativas de impulso a los datos abiertos. En concreto, el desarrollo de campañas informativas, la homogeneización de los formatos de los conjuntos de datos y la incorporación progresiva de nuevos datasets, incluyendo también datos externos a la gestión municipal.

- La Comunidad de Murcia puso en marcha una encuesta dirigida a las empresas de la región para conocer qué conjuntos de datos son de su interés, con el objetivo de valorar su incorporación al catálogo de datos abiertos de la región.

- El Gobierno de Asturias realizó un proceso participativo para elaborar una Estrategia de Gobernanza Pública. Entre otros aspectos, pretende implementar mecanismos que faciliten la participación y el acceso a los datos abiertos.

- El Ministerio de Asuntos Económicos y Transformación Digital ha lanzado una consulta para identificar propuestas para la integración de la Inteligencia Artificial en las cadenas de valor de los diferentes sectores de la economía. Todo ello en el marco de la Estrategia Nacional de Inteligencia Artificial.

La apuesta por los datos abiertos de los organismos públicos españoles también queda patente en el creciente apoyo a la Carta Internacional de Datos Abiertos. La representación española en el Open Data Charter ha crecido durante esta primavera: dos comunidades autónomas, Asturias y Valencia, y una entidad local, el Ayuntamiento de Pinto, acordaron adherirse.

Nuevos portales y conjuntos de datos abiertos

Además de la floración, la primavera también nos ha traído nuevas plataformas de compartición de datos abiertos:

- El Ayuntamiento de Alcalá de Henares ha desarrollado un nuevo Portal de Transparencia y Datos Abiertos para facilitar el acceso a la información y fomentar la transparencia de sus gestiones.

- También se ha estrenado una nueva versión de Euskalmet, el servicio meteorológico del País Vasco. El portal incluye un API Rest para reutilizadores.

- La Oficina Española de Patentes y Marcas ha presentado una nueva versión de su portal Open Data en un nuevo formato. A través de él, los usuarios pueden acceder a datos reutilizables de todas las modalidades de Propiedad Industrial, disponibles en formatos PDF, XML o SGML, entre otros.

Otros portales ya existentes han apostado por incorporar nuevas herramientas:

- El Servicio de Información Territorial de Baleares (Sitibsa) ha puesto en marcha una herramienta para incorporar de manera automática los datos abiertos de su portal al servicio de mapas de la Infraestructura de Datos Espaciales de Baleares (Ideib).

- El Centro Nacional de Información Geográfica (CNIG) ha publicado la aplicación web ‘Mapa a la Carta’, que permite personalizar sus mapas topográficos.

- GeoPamplona, el sistema de información geográfica desarrollado por el Ayuntamiento de la ciudad, ha incorporado novedades para mejorar la experiencia del usuario y hacer el servicio más accesible para la ciudadanía. Un ejemplo es su nuevo catálogo de mapas con información ya seleccionada, para que el usuario no tenga que buscarla.

- El Ayuntamiento de Zaragoza ha creado 'Mis mapas, mis datos', una herramienta para elaborar mapas sencillos y complejos, combinando varias fuentes de datos.

Además, como viene siendo habitual, la gran mayoría de las iniciativas de datos abiertos han ido actualizando sus datos de manera periódica. Algunas de las novedades que se han presentado estos meses son los mapas de patrimonio cultural de cada municipio en el portal de la diputación de Barcelona o los datos sobre el estado del Mar Menor en el portal de Murcia.

Crecen los eventos y los materiales formativos

Durante estos meses hemos asistido a multitud de eventos y webinars ligados a los datos abiertos. Algunos de ellos se han grabado y están disponibles para ver en cualquier momento:

- Unos días antes de la llegada de la primavera, en marzo, tuvo lugar jornada “El Dato en las Administraciones Locales 20/30. Experiencias y Retos”, que organizó el Ayuntamiento de Alcobendas, el Instituto de Transferencia de Conocimiento en Innovación Pública (ITCIP) y el Club de Innovación, con el apoyo de la FEMP (Red de Entidades Locales por la Transparencia y la Participación), la Red Española de Ciudades Inteligentes – RECI y Oracle. Las diferentes sesiones se pueden ver aquí.

- El 23 de abril se celebró una mesa redonda, en el marco del Máster en Tecnología e Innovación Digital en Ingeniería de la UNED, sobre "Big Data y datos abiertos aplicados a la movilidad". Si te lo perdiste, puedes verlo en Youtube.

Además, se han lanzado algunos cursos, guías y libros para aquellos que quieran ampliar sus conocimientos en materia de nuevas tecnologías y datos:

- El Gobierno central ha puesto en marcha el proyecto Elementos de IA en España. Se trata de un curso online gratuito dirigido a toda la ciudadanía que ofrece formación en fundamentos básicos de la Inteligencia Artificial.

- Castilla y León ha presentado la 'Guía de transformación digital para el empleado público', que cuenta con una sección dedicada a los datos abiertos. En ella se explica qué son, se habla del catálogo Nacional de Datos Abiertos (datos.gob.es) y se resalta la importancia de la reutilización de la información en el sector público.

- El Foro de Ingeniería en Geomática y Topografía del Grupo de Trabajo de la IDEE publica una nueva versión del libro 'Infraestructuras de Datos Espaciales', que enfatiza la publicación y descripción de los conjuntos de datos espaciales por medio de servicios. Entre otras cuestiones, incluye cómo se deben presentar a través de visualizadores y catálogos para su gestión y explotación.

Reutilización de datos por parte de Administraciones públicas y ciudadanos

El impacto de los datos abiertos también ha quedado patente en estos meses gracias a múltiples ejemplos. Por un lado, tenemos una serie de administraciones públicas que han aprovechado el valor de los datos para poner en marcha proyectos que mejoren su eficiencia y el servicio que proporcionan a la ciudadanía:

- La Agencia Tributaria de Madrid ha lanzado un proyecto para utilizar Big Data e Inteligencia Artificial para luchar contra el fraude en los impuestos municipales. Un Laboratorio Tributario liderará esta estrategia incorporando información del Portal de Datos Abiertos del Ayuntamiento.

- La Diputación de Valencia inicia el proyecto 'Connecta València: territorio turístico, inteligente y sostenible', que analiza datos turísticos para adaptar y mejorar la experiencia en todos sus municipios.

- El Ayuntamiento de Barcelona ha impulsado el proyecto piloto 'Dades x Comerç', desarrollado por BCNOpenData para ayudar al pequeño comercio a tomar decisiones y conocer mejor el comportamiento de la clientela en base a datos abiertos.

Por otro, empresas y emprendedores han utilizado los datos para crear productos, como por ejemplo:

- Las elecciones a la Comunidad de Madrid nos dejaron múltiples ejemplos de piezas periodísticas desarrolladas en base a datos abiertos, como por ejemplo estas de El Pais o eldiario.es.

- Dos bilbaínos han creado CityAr, una app donde los usuarios pueden organizar rutas, participar en eventos o jugar a través de realidad aumentada. CityAr utiliza los datos abiertos de Bilbao para mostrar la oferta cultural y de ocio de la ciudad.

En este periodo también se ha anunciado la convocatoria a dos premios dirigidos a reutilizadores:

- Los Premios Asedie 2021, para empresas, instituciones y proyectos de datos abiertos que puedan aportar valor social y/o económico. El plazo de presentación de candidaturas finaliza el 15 de septiembre de 2021.

- La nueva edición del concurso de datos abiertos que cada año convoca Castilla y León, dirigido a periodistas, docentes, estudiantes o reutilizadores de datos. Los interesados en participar deben mandar su propuesta antes del 13 de julio.

Un par de novedades a nivel mundial

A nivel internacional, una de las principales novedades ha sido el lanzamiento del nuevo portal europeo de datos, data.europa.eu, que se posiciona como punto de acceso único para los datos de toda Europa. Su desarrollo y gestión para los próximos 6 años ha sido adjudicado a un consorcio integrado, entre otros, por el Grupo de Ingeniería Ontológica de la Universidad Politécnica de Madrid.

Por su parte, Asia ha lanzado su primer portal oficial que reunirá datos abiertos publicados por instituciones, agencias y organizaciones de los distintos países que forman parte del continente.

Con estos ejemplos, queda patente que el ecosistema de datos abiertos no para y continúa evolucionando mes a mes. Si quieres compartir cualquier otra novedad que consideres de interés, te invitamos a contarnos tu opinión en la sección de comentarios.

Recientemente reflexionamos acerca del auge del periodismo de datos dentro de los medios de comunicación, una disciplina que cada vez está cobrando una mayor relevancia. A través de las tecnologías y herramientas ligadas a los datos, esta modalidad periodística permite ofrecer a los lectores una información más documentada, atractiva y comprensible. Para ello, realizan acciones como interpretar presupuestos municipales, combinar estadísticas e informes financieros o explorar información geoespacial para contar historias basada en grandes cantidades de datos.

En esta ocasión, queremos resaltar el papel que el periodismo de datos juega a la hora de servir como impulso para la creación de nuevas empresas, asociaciones y grupos de usuarios que reutilizan datos para impulsar la economía o impulsar la rendición de cuentas.

A continuación, analizaremos cómo la reutilización de los datos, dentro del campo del periodismo, ha favorecido la aparición de nuevos modelos de negocio, organizaciones sin ánimo de lucro y actividades de transparencia, investigación o fact-checking político en las que el periodismo de datos es el punto central de su negocio o actividad diaria.

Organizaciones ligadas al periodismo de datos

Agencias de noticias: EPDATA

EpData es la plataforma creada por Europa Press que tiene como principal objetivo facilitar el uso de datos públicos por parte de los periodistas para enriquecer las noticias mediante gráficos, además de analizar el contexto y contrastar las cifras ofrecidas por las diferentes fuentes.

Esta plataforma nace con el propósito de trasladar el espíritu de una agencia de noticias al mundo del periodismo de datos. Para conseguirlo, han creado un amplio repositorio de datos con todas las estadísticas sobre las que se informa a menudo en Europa Press, con más de 60 millones de datos de fuentes públicas y privadas. Cualquier usuario puede consultarlas a través de este enlace.

Actividades de EpData ligadas al periodismo de datos

Este repositorio permite a EpData ofrecer gráficos, estadísticas y visualizaciones de datos relacionadas con la actualidad cada día. Por ejemplo, durante el último año han ido mostrando datos actualizados sobre la pandemia actual que han utilizado para sus noticias otros medios y publicaciones científicas.

No obstante, el abanico de temas que compaginan en su plataforma es muy amplio, ya que ofrecen estadísticas y gráficas basadas en datos de temas tan diversos como empleo, evolución de la economía, sociedad, política, etc.

Fact-checking: Maldito Dato

Según sus coordinadores, “Maldito Dato es el proyecto dentro del medio de verificación Maldita.es en el que se llevan a cabo las informaciones de periodismo de datos, transparencia, investigación y el fact-checking político, es decir, la verificación del discurso político”.

En otras palabras, Maldito Dato es la sección de Maldita.es que realiza periodismo de datos, formada por especialistas en esta materia. Entre sus principales funciones, está la realización de piezas periodísticas basadas en los datos, fact-checking político y temas realizados a partir del uso de la Ley de Transparencia.

Actividades de Maldito Dato ligadas al periodismo de datos

Los datos abiertos forman una parte importante de la naturaleza de Maldito Dato, tanto a la hora de publicarlos como de reutilizarlos en sus noticias. Algunos ejemplos son:

- Mapa de casos de coronavirus a nivel municipal de toda España, desarrollado en base a los datos que publica cada comunidad autónoma.

- Datos del Ministerio de Sanidad sobre la vacunación, usando los datos que publica el Ministerio de Sanidad, bien sea en forma de datos abiertos o de informes diarios.

- En este otro ejemplo se puede ver cómo utilizan los datos del Portal Estadístico de la Delegación del Gobierno contra la Violencia de Género para realizar diversas gráficas comparativas sobre el incremento del número de llamadas al 016. También han realizado gráficas comparativas basadas en los datos del INE o incluso los del CIS.

Además de utilizar datos abiertos de las administraciones públicas, en otras ocasiones son ellos mismos quienes publican datos abiertos. Por ejemplo, cuando liberan bases de datos que obtienen por solicitudes de información a través de la Ley de Transparencia. Algunos ejemplos son la base de datos de solicitudes de información pública que realizan los ciudadanos en el Portal de la Transparencia, la base de datos con las inspecciones sanitarias a las piscinas de Madrid o la de las subvenciones del Ministerio del Interior por 'situaciones catastróficas'.

Organización sin ánimo de lucro: CIVIO

CIVIO es una organización sin ánimo de lucro que promueve la transparencia de las instituciones y que las personas puedan acceder a la información pública a través de la tecnología unida al periodismo. Para conseguir este objetivo cuentan con tres grandes líneas de actuación:

- Periodismo

- Incidencia pública

- Servicios de transparencia de las AA.PP.

Actividades de CIVIO ligadas al periodismo de datos

Esta organización ha publicado recientemente una investigación acerca del uso de la contratación de emergencia durante 2020. Para elaborarla han utilizado los contratos de emergencia adjudicados durante el pasado año que han sido publicados en el Portal de Contratación del Sector Público y desde las plataformas vinculadas a las diferentes comunidades autónomas. En este enlace se puede consultar un buscador de contratos de emergencia y aquí las principales conclusiones de la investigación.

Al final de este artículo, desde CIVIO nos explican la metodología que siguen para llevar a cabo el análisis de estos datos, así como las dificultades que han ido encontrando en el proceso. Los datos utilizados en esta investigación se han puesto a disposición de todos los usuarios en Datos Civio en formatos que facilitan su reutilización. Gracias a ello, diversos medios de comunicación han utilizado la base de datos de CIVIO para elaborar sus propias informaciones.

Análisis, visualización y comunicación de datos: STORYDATA

Storydata es una organización de mujeres expertas en investigación, análisis, visualización y comunicación de datos. Se caracterizan por ofrecer un servicio de comunicación global dirigido a entidades públicas y privadas que quieran transformar un conjunto de datos, propios o externos, en un relato comunicativo. Para ello utilizan diversos soportes y formatos, desde la elaboración de reportajes hasta la creación de campañas y la difusión de contenidos en redes sociales.

Actividades de Storydata ligadas con el periodismo de datos

Los datos abiertos forman parte del ADN de Storydata. Algunos de sus proyectos más relevantes son:

- El proyecto Datos contra el ruido que persigue combatir a través de datos abiertos las opiniones sobre la violencia machista.

- Colaboración en la sección de datos de la revista Barcelona Metròpolis del Ayuntamiento de Barcelona.

- Redacción sobre artículos de divulgación acerca de datos en el dossier de Associació de dones periodistes de Catalunya.

- Convenio de colaboración con el Máster de Periodismo de datos y Fact Checking de Blanquerna.

- Formación a múltiples medios, instituciones y universidades sobre periodismo de datos y visualización, como la Escola de dades de Sentit Crític, el Máster de Diseño de la Información y Visualización de Datos de Elisava, Instituto de la Euromediterránea (Euromesco), Jurados y píldora formativa en el Big Data Challenger de Fundación la Caixa.

Actualmente, Storydata colabora con medios de comunicación como Crític, por ejemplo, creando una visualización de datos que muestra la desigualdad en tiempos de confinamiento o esta otra sobre cómo afecta el coronavirus a los diferentes municipios de Catalunya.

Grupos de usuarios y lista de periodistas de datos

Si eres un periodista de datos, o estás interesado en la materia, quizás te interese saber que existen diferentes plataformas en las que puedes encontrar grupos de usuarios relacionados con la reutilización de datos en el ámbito del periodismo.

- En LinkedIn destaca el grupo ‘Periodismo de datos’, creado para que interesados y profesionales del periodismo de datos puedan aportar y compartir conocimiento relacionado con esta disciplina.

- En MeetUp encontramos el grupo de usuarios ‘Periodismo y visualización de datos’. Organizado por Adolfo Antón, cuenta con más de 1.200 participantes que interactúan en relación con el uso de los datos para su reutilización en materia periodística.

- También en MeetUp destaca el grupo Madrid Abriendo Datos.

- Grupos de Telegram o Slack: muchos usuarios de organizan a través de Telegram (en grupos como postdata, periodismodatos y visualizar) o Slack (periodismodatos.slack.com).

En la red también podemos encontrar una lista de comunicadores especializados en datos en España y Latinoamérica, formada por más de 300 periodistas. Este proyecto reúne a una serie de profesionales que ven en los datos la verdadera materia prima del periodismo. Si quieres consultar la lista completa, puedes hacerlo a través del siguiente enlace.

Esta es tan solo una muestra de organizaciones, empresas y grupos de usuarios ligados al periodismo de datos. Si conoces alguna otra que pueda ser de interés, no dudes en escribirnos un comentario o enviarnos un correo a dinamizacion@datos.gob.es.

Contenido elaborado por el equipo de datos.gob.es.

El periodismo de datos es una de las disciplinas que más ha crecido en los medios de comunicación en los últimos años, tanto dentro como fuera de nuestras fronteras. Esta modalidad del periodismo consiste en recabar datos veraces, analizarlos y ponerlos a disposición de la ciudanía a través de artículos y/o recursos gráficos e interactivos, facilitando la comprensión de asuntos complejos.

En datos.gob.es hemos entrevistado a Adolfo Antón, diseñador, periodista, formador y apasionado del Software Libre y el conocimiento abierto. Adolfo ha sido presidente de Open Knowledge Foundation España, coordinador de School of Data España, responsable del Datalab de Medialab Prado, coordinador del grupo de trabajo de Periodismo de Datos, de las Jornadas de Periodismo de Datos y comisario de los talleres de Periodismo de Datos (2014-2019) y Visualizar (2015-2018). Actualmente es coordinador del Máster Universitario de Periodismo y Visualización de Datos de la Universidad de Alcalá y Profesor del Máster de Periodismo Digital y de Datos en Universidad Nebrija.

Entrevista completa:

1. ¿A qué se dedica un periodista de datos?

Gracias, en primer lugar, por interesaros en el periodismo y la visualización de datos y por lo que puedo aportar a estos ámbitos. Agradezco y celebro la existencia de datos.gob.es, un proyecto imprescindible que cumple diez años dentro de poco y que, paradójicamente, creo que no es lo suficientemente conocido, utilizado y reconocido en estos campos.

Para responder a vuestra primera pregunta me voy a centrar en lo que habéis definido como periodismo de datos y que comienza por la recolección de datos veraces. Actualmente hay muchos proyectos que se encuentran en el campo de la verificación de noticias y esto, a mi modo de ver, lo entiendo como reacción a una proliferación exagerada de noticias falsas, manipuladas, bulos, mentiras y otras faunas y floras de las malas prácticas no solo periodísticas, sino también comunicativas. Es necesario verificar, certificar, acreditar y/o curar los datos con los que trabajamos, aportando un contexto, fuente y metodología. Si no, desarrollaremos análisis erróneos e historias falseadas.

Hay un dicho periodístico que dice "que un mal dato no te estropee un buen titular", y en esta tentación es muy importante que la ética periodística sea fuerte en periodistas, editorxs y en el propio medio.

Es necesario verificar, certificar, acreditar y/o curar los datos con los que trabajamos, aportando un contexto, fuente y metodología. Si no, desarrollaremos análisis erróneos e historias falseadas.

El periodismo de datos es, fundamentalmente, el uso de aplicaciones informáticas para trabajar con datos, ya sean pocos, muchos o muchísimos. En el periodismo de datos también son importantes la estadística, la infografía o la visualización de datos.

Con esas herramientas informáticas, se realiza lo que Paul Bradshaw denominó la pirámide invertida del periodismo de datos:

- Compilar (recopilar, recoger, recabar)

- Limpiar (fregar, escarbar, investigar, interrogar)

- Contextualizar (contexto de los datos y de la historia, metodología) y

- Combinar (datos, visualizaciones, infografías, mapas, textos, interactivos…)

Para ello es necesario, por tanto, utilizar herramientas informáticas y lenguajes informáticos que cubran una, varias o todas las tareas del proceso de trabajo. No es mandatorio, pero sí que es conveniente no enclaustrarnos en software que sea privativo y/o propietario pues determinará el uso que hagamos del mismo. Asimismo, los servicios de terceros pueden ser de gran ayuda, pero se prefieren servicios propios que podamos controlar al cien por cien.

2. ¿Por qué es importante el periodismo de datos? ¿Podría indicarnos algún caso de éxito o investigación donde haya sido clave?

El periodismo de datos es el periodismo que investiga con datos y, por tanto, es tan importante, necesario y primordial como el periodismo, si por ello entendemos un periodismo crítico e independiente, un cuarto poder de la sociedad actual. No saber trabajar con datos utilizando herramientas informáticas nos limita hacer buen periodismo, sea este económico, político o deportivo. Cada vez más el periodismo de datos deja de ser el caso de éxito excepcional de un periodismo generalista para ser la metodología del periodismo en general.

Los primeros casos de éxito en España pueden circunscribirse en torno a Civio, una organización que realiza periodismo de datos en proyectos como España en llamas, entre otros. Luego, son relevantes los proyectos que surgieron en torno a la conjunción de tres elementos que hicieron crecer el periodismo de datos en España:

- El grupo de Periodismo de Datos de Medialab-Prado, que despierta el interés público por esta disciplina y permiten la creación de una comunidad incipiente;

- El Máster de Periodismo de Investigación, Datos y Visualización de Unidad Editorial/URJC, que forma a una primera generación de periodistas de datos;

- Los medios que apuestan por ello en mayor o menor medida, como El Español, El Mundo, El Confidencial, RTVE, El Diario de Navarra, eldiario.es o Ara.cat.

Un punto álgido del periodismo de datos internacional y también de España fue, sin duda, la investigación sobre los Papeles de Panamá (Panama Papers) del Consorcio Internacional de Periodistas de Investigación (ICIJ, International Consortium of Investigative Journalists) de 2016 en la que participaron 109 medios de 76 países. En España fueron LaSexta y El Confidencial los medios participantes y lograron una amplia repercusión y la dimisión de entonces ministro de Industria, Energía y Turismo.

Lamentablemente, ni el Laboratorio de Datos de Medialab-Prado (continuador del grupo de periodismo de datos entre 2016 y 2019) existe ya, ni todos esos medios han mantenido o fortalecido los equipos. Pero, en general, sí que la disciplina se ha extendido en cuanto a comunidad, universidades y prácticas. Este proceso se ha acelerado tanto con la crisis del COVID19 que ya se considera al periodo actual como la segunda edad de oro de la visualización de datos.

3. ¿A qué retos se enfrenta hoy en día el periodismo de datos?

Es una pregunta difícil de contestar pues creo que a los retos tradicionales del periodismo se suman los que producen, como decía al principio, la abundancia de noticias falsas, manipuladas, sesgadas y difundidas por redes sociales donde cuestiones como la ética, la intimidad, la privacidad, la autoría, el anonimato o la producción automática y replicada en masa de contenidos genera un ruido ensordecedor. Además, se apuesta por una polarización intensiva que sirve para coleccionar datos de personas para crear perfiles de consumidores. Esto bombardea el proceso racional, reflexivo, discursivo y con escala de grises que un buen periodismo puede favorecer.

Si me centro en el periodismo de datos como metodología, el principal reto que observo es el de formar a periodistas en el uso de aplicaciones informáticas para trabajar con datos y con ello, poco a poco, mejorar la producción periodística para que el público en general valore los buenos productos periodísticos de datos.

El principal reto que observo es el de formar a periodistas en el uso de aplicaciones informáticas para trabajar con datos y con ello, poco a poco, mejorar la producción periodística para que el público en general valore los buenos productos periodísticos de datos.

4. ¿Hay una apuesta decidida de los medios tradicionales por el periodismo de datos?

Los Papeles de Panamá supusieron un momento esperanzador para el periodismo de datos y también por el hecho de que una televisión generalista apostara por esta disciplina. No ha ocurrido en términos generales, pero sí que la crisis del coronavirus ha producido un aumento de trabajos donde se produce cierto análisis y visualización de datos que son apreciables en las portadas de las webs de los medios, por ejemplo. Sin un análisis en profundidad diría que la mayoría son más escaparates con productos fáciles que completos trabajos de periodismo de datos en el sentido de que no se realizan todas las etapas del proyecto periodístico, sino fragmentos que cubren la demanda.

Cabe destacar el trabajo en análisis y visualización de datos que están haciendo en El País, RTVE.es y eldiario.es. A su vez, los medios especializados en verificación de noticias como Newtral y Maldita realizan una constante producción de noticias con formatos innovadores que también cuentan con análisis y visualización de datos.

Por otro lado, hay personas que no trabajan en medios pero que se han agrupado para trabajar desde el inicio de la pandemia sobre los datos del COVID19 en un esfuerzo encomiable que aúna recolección, análisis y visualización de datos y que deja el trabajo prácticamente preparado para que los medios lo tomen y rematen, pero todavía no se ha producido esa conexión mágica.

Por la experiencia de los talleres de periodismo de datos de Medialab-Prado diría que trabajar con datos lleva tiempo, requiere profesionales, equipo, ideas, etc., pero no son inversiones que puedan estar alejadas de cualquier redacción periodística, sea cual sea el tamaño del medio. El hecho de que esa apuesta decidida no se haya producido también deja el campo abierto a que otras propuestas se posicionen mejor, como ha ocurrido con las de verificación de noticias.

5. Los datos abiertos son fundamentales para que los periodistas de datos cuenten con información veraz de fuentes oficiales. ¿Qué tipos de datos son los más demandados por estos profesionales para sus investigaciones?

Mi impresión es que normalmente no se aprovechan los datos abiertos que hay, ya sea porque son muy complejos, porque se requiere amplios conocimientos en el tratamiento de datos, porque hay que trabajar mucho con ellos, porque se desconocen o, finalmente, porque no son "atractivos", no están de moda.

Es decir, tener un portal de datos abiertos y una política de publicación de datos abierta no asegura que se haga un uso de los datos, lo cual no quita para que esto, la publicación de datos abiertos de calidad, deba ser la política por defecto de toda administración pública y fuente de información que se precie.