¿Aceptas el reto de transformar Bizkaia a partir de sus datos abiertos? Así se presenta el “Datathon Open Data Bizkaia”, una competición de desarrollo colaborativo organizada por Lantik y la Diputación Foral de Bizkaia.

Los participantes tendrán que crear el mockup de una aplicación que ayude a resolver problemas que afecten la ciudadanía de Bizkaia. Para ello, deberán utilizar al menos un conjunto de datos entre todos aquellos disponibles en el portal Open Data Bizkaia. Estos datasets podrán ser combinados con datos procedentes de otras fuentes.

¿Cómo se desarrolla la competición?

La competición de desarrollará en dos fases:

- Primera fase. Los equipos participantes deberán entregar un documento con la propuesta en formato PDF. Entre otra información, dicha propuesta incluirá una breve descripción de la solución, sus funcionalidades y los conjuntos de datos utilizados.

- Segunda fase. Un jurado evaluará todas las solicitudes recibidas y que sean válidas en tiempo y forma. A continuación, se seleccionarán siete propuestas finalistas. Los equipos preseleccionados tendrán que realizar un mockup y un video promocional de máximo 2 minutos de duración, donde se presenten los integrantes del equipo y se describan las características más destacadas de la solución.

Estas fases se desarrollarán en base al siguiente calendario:

- Del 19 de septiembre al 19 de octubre. Abierto el plazo de inscripción para presentar las propuestas en pdf.

- 26 de octubre. Anuncio de los equipos preseleccionados.

- 14 de noviembre. Finaliza el plazo para entregar el mockup y el vídeo.

- 18 de noviembre. Celebración de la final en Bilbao, aunque también se podrá acudir, opcionalmente, de forma online. Se presentarán los videos y se seleccionarán los equipos ganadores.

¿Quiénes pueden participar?

La competición está dirigida a cualquier persona mayor de 16 años, independientemente de su nacionalidad, siempre y cuando disponga de DNI/NIF/NIE, pasaporte u otro documento público en vigor que acredite la identidad y edad del participante.

Se puede participar de manera individual o a través equipos de máximo seis personas.

¿En qué consisten los premios?

Entre los 7 finalistas se elegirán dos ganadores, que recibirán la siguiente cuantía económica:

- Primer premio: 2.500 euros.

- Segundo premio: 1.500 euros

Además, el resto de equipos finalistas recibirá 500 euros.

Para llevar a cabo la valoración, el jurado tomará como referencia una serie de criterios detallados en las bases de la competición: relevancia, reutilización de datos abiertos y aptitud para el propósito.

¿Cómo puedo participar?

Es necesario inscribirse a través del formulario que aparece en la web. Tras la inscripción, el equipo recibirá un correo electrónico con las indicaciones para presentar la propuesta.

Los participantes deberán subir su propuesta a un sharepoint habilitado para ello. En la web pueden encontrar un documento modelo que puede servir como referencia.

La propuesta deberá presentarse antes del 19 de octubre de 2022 a las 12h.

Descubre más sobre Open Data Bizkaia

Open Data Bizkaia facilita a la ciudadanía y los agentes reutilizadores el acceso a la información pública que gestiona la Diputación Foral de Bizkaia. Actualmente hay disponibles más de 900 conjuntos de datos.

En su web, además, ofrecen recursos para reutilizadores, una API, buenas prácticas y ejemplos de aplicaciones elaboradas con datasets del portal que pueden servir para inspirar a los participantes de esta competición.

Puedes conocer más sobre la estrategia Open Data de Bizkaia en este artículo.

Tras varios meses de pruebas y entrenamientos de distinto tipo, el primer sistema masivo de Inteligencia Artificial de la lengua española es capaz de generar sus propios textos y resumir otros ya existentes. MarIA es un proyecto que ha sido impulsado por la Secretaría de Estado de Digitalización e Inteligencia Artificial y desarrollado por el Centro Nacional de Supercomputación, a partir de los archivos web de la Biblioteca Nacional de España (BNE).

Hablamos de un avance muy importante en este ámbito, ya que se trata del primer sistema de inteligencia artificial experto en comprender y escribir en lengua española. Enmarcada dentro del Plan de Tecnologías del Lenguaje, esta herramienta pretende contribuir al desarrollo de una economía digital en español, gracias al potencial que los desarrolladores pueden encontrar en ella.

El reto de crear los asistentes del lenguaje del futuro

Los modelos de lenguaje al estilo de MarIA son la piedra angular sobre la que se sustenta el desarrollo del procesamiento del lenguaje natural, la traducción automática o los sistemas conversacionales, tan necesarios para comprender y replicar de forma automática una lengua. MarIA es un sistema de inteligencia artificial formado por redes neuronales profundas que han sido entrenadas para adquirir una comprensión de la lengua, de su léxico y de sus mecanismos para expresar el significado y escribir a nivel experto.

Gracias a este trabajo previo, los desarrolladores pueden crear herramientas relacionadas con el lenguaje y capaces de clasificar documentos, realizar correcciones o elaborar herramientas de traducción.

La primera versión de MarIA fue elaborada con RoBERTa, una tecnología que crea modelos del lenguaje del tipo “codificadores”, capaces de generar una interpretación que puede servir para categorizar documentos, encontrar similitudes semánticas en diferentes textos o detectar los sentimientos que se expresan en ellos.

Así, la última versión de MarIA ha sido desarrollada con GPT-2, una tecnología más avanzada que crea modelos generativos decodificadores y añade prestaciones al sistema. Gracias a estos modelos decodificadores, la última versión de MarIA es capaz de generar textos nuevos a partir de un ejemplo previo, lo que resulta muy útil a la hora de elaborar resúmenes, simplificar grandes cantidades de información, generar preguntas y respuestas e, incluso, mantener un diálogo.

Avances como los anteriores convierten a MarIA en una herramienta que, con entrenamientos adaptados a tareas específicas, puede ser de gran utilidad para desarrolladores, empresas y administraciones públicas. En esta línea, modelos similares que se han desarrollado en inglés son utilizados para generar sugerencias de texto en aplicaciones de escritura, resumir contratos o buscar informaciones concretas dentro de grandes bases de datos de texto para relacionarlas posteriormente con otras informaciones relevantes.

En otras palabras, además de redactar textos a partir de titulares o palabras, MarIA puede comprender no solo conceptos abstractos, sino también el contexto de los mismos.

Más de 135 mil millones de palabras al servicio de la inteligencia artificial

Para ser exactos, MarIA se ha entrenado con 135.733.450.668 de palabras procedentes de millones de páginas web que recolecta la Biblioteca Nacional y que ocupan un total de 570 Gigabytes de información. Para estos mismos entrenamientos, se ha utilizado el superordenador MareNostrum del Centro Nacional de Supercomputación de Barcelona y ha sido necesaria una potencia de cálculo de 9,7 trillones de operaciones (969 exaflops).

Teniendo en cuenta que uno de los primeros pasos para diseñar un modelo del lenguaje pasa por construir un corpus de palabras y frases que sirva como base de datos para entrenar al propio sistema, en el caso de MarIA, fue necesario realizar un cribado para eliminar todos los fragmentos de texto que no fuesen “lenguaje bien formado” (elementos numéricos, gráficos, oraciones que no terminan, codificaciones erróneas, etc.) y así entrenar correctamente a la IA.

Debido al volumen de información que maneja, MarIA se sitúa ya como el tercer sistema de inteligencia artificial experto en comprender y escribir con mayor número de modelos masivos de acceso abierto. Por delante solo están los modelos del lenguaje elaborados para el inglés y el mandarín. Esto ha sido posible principalmente por dos razones. Por un lado, debido al elevado nivel de digitalización en el que se encuentra el patrimonio de la Biblioteca Nacional y, por el otro, gracias a la existencia de un Centro de Supercomputación Nacional que cuenta con superordenadores como el MareNostrum 4.

El papel de los conjuntos de datos de la BNE

Desde que en 2014 lanzase su propio portal de datos abiertos (datos.bne.es), la BNE ha apostado por acercar los datos que están a su disposición y bajo su custodia: datos de las obras que conserva, pero también de autores, vocabularios controlados de materias y términos geográficos, entre otros.

En los últimos años, se ha desarrollado también la plataforma educativa BNEscolar, que busca ofrecer contenidos digitales del fondo documental de la Biblioteca Digital Hispánica y que pueden resultar de interés para la comunidad educativa.

Así mismo y para cumplir con los estándares internacionales de descripción e interoperabilidad, los datos de la BNE están identificados mediante URIs y modelos conceptuales enlazados, a través de tecnologías semánticas y ofrecidos en formatos abiertos y reutilizables. Además, cuentan con un alto nivel de normalización.

Próximos pasos

Así y con el objetivo de perfeccionar y ampliar las posibilidades de uso de MarIA, se pretende que la versión actual dé lugar a otras especializadas en áreas de conocimiento más concretas. Teniendo en cuenta que se trata de un sistema de inteligencia artificial dedicado a comprender y generar texto, se torna fundamental que este sea capaz de desenvolverse con soltura ante léxicos y conjuntos de información especializada.

Para ello, el PlanTL continuará expandiendo MarIA para adaptarse a los nuevos desarrollos tecnológicos en procesamiento del lenguaje natural (modelos más complejos que el GPT-2 ahora implementado, entrenados con mayor cantidad de datos) y se buscará la forma de crear espacios de trabajo para facilitar el uso de MarIA por compañías y grupos de investigación.

Contenido elaborado por el equipo de datos.gob.es.

Los portales de datos abiertos están experimentando un importante crecimiento en el número de conjuntos de datos que están siendo publicados en la categoría de transporte y movilidad. Sirva como ejemplo el portal de datos abiertos de la UE que ya cuenta con casi 48.000 conjuntos de datos en la categoría de transporte o el propio portal español datos.gob.es, que registra en torno a 2.000, si incluimos los que están dentro de la categoría de sector público. Una de las razones principales del crecimiento en la publicación de los datos relacionados con el transporte es la existencia de tres directivas que tienen entre sus objetivos maximizar la reutilización de conjuntos de datos en el área. La directiva PSI de reutilización de información del sector público en combinación con las directivas INSPIRE sobre infraestructura de información espacial e ITS sobre implantación de los sistemas de transporte inteligentes, junto con otros desarrollos legislativos, hacen que cada vez resulte más complicado justificar que los datos de transporte y movilidad permanezcan cerrados.

En este sentido, en España, la ley 37/2007 en su redacción de noviembre de 2021, añade la obligación de publicar datos abiertos a las sociedades mercantiles pertenecientes al sector público institucional que actúen como compañías aéreas. Con ello se consigue dar un paso más allá respecto a las más frecuentes obligaciones con los datos de los servicios públicos de transporte de viajeros por ferrocarril y carretera.

Además, los datos abiertos están en el corazón de las estrategias de movilidad inteligente, conectada y respetuosa con el medio ambiente, tanto en el caso de la estrategia española “es.movilidad”, como en el caso de la estrategia de movilidad sostenible propuesta por la comisión europea. En ambos casos los datos abiertos se han introducido como uno de los vectores de innovación clave en la transformación digital del sector para contribuir a la consecución de los objetivos de mejora en la calidad de vida de los ciudadanos y de protección al medio ambiente.

Sin embargo, se suele hablar mucho menos de la importancia y necesidad de los datos abiertos durante la fase de investigación, que después conduce a las innovaciones que todos disfrutamos. Y sin esta etapa en la que los investigadores trabajan para adquirir un mejor conocimiento del funcionamiento de las dinámicas de transporte y movilidad de las que todos somos parte, y en la que los datos abiertos tienen un papel fundamental, no sería posible obtener innovaciones relevantes o políticas públicas bien informadas. En este sentido vamos a revisar dos iniciativas muy relevantes en las que se están realizando esfuerzos coordinados plurinacionales en el ámbito de la investigación en movilidad y transporte.

El sistema de información y seguimiento de la investigación y la innovación en el transporte

A nivel europeo, la UE también apoya con firmeza la investigación e innovación en transporte, consciente de que necesita adaptarse a realidades globales como el cambio climático y la digitalización. La agenda estratégica de investigación e innovación en el transporte (STRIA) describe lo que está haciendo la UE para acelerar la investigación y la innovación necesarias para cambiar radicalmente el transporte apoyando prioridades como la electrificación, el transporte conectado y automatizado o la movilidad inteligente.

En este sentido, el sistema de información y seguimiento de la investigación y la innovación en el transporte (TRIMIS) es la herramienta que la Comisión Europea mantiene para proporcionar información de acceso abierto sobre la investigación y la innovación (I+i) en el transporte y que se lanzó con la misión de apoyar la formulación de las políticas públicas en el ámbito del transporte y la movilidad.

TRIMIS mantiene actualizado un cuadro de mando con el que visualizar los datos sobre investigación e innovación en transporte y ofrece una descripción general y datos detallados sobre la financiación y las organizaciones involucradas en estas investigaciones. La información puede filtrarse por las siete prioridades de STRIA y también incluye datos sobre la capacidad de innovación del sector del transporte.

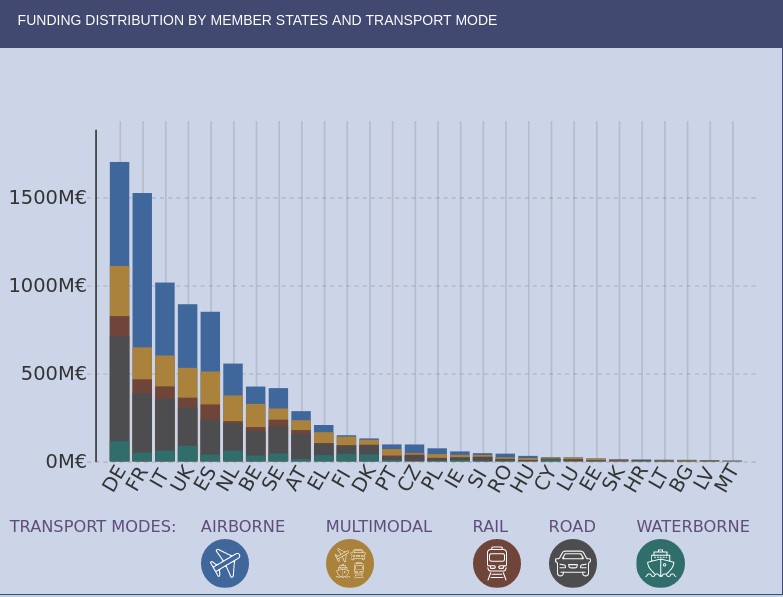

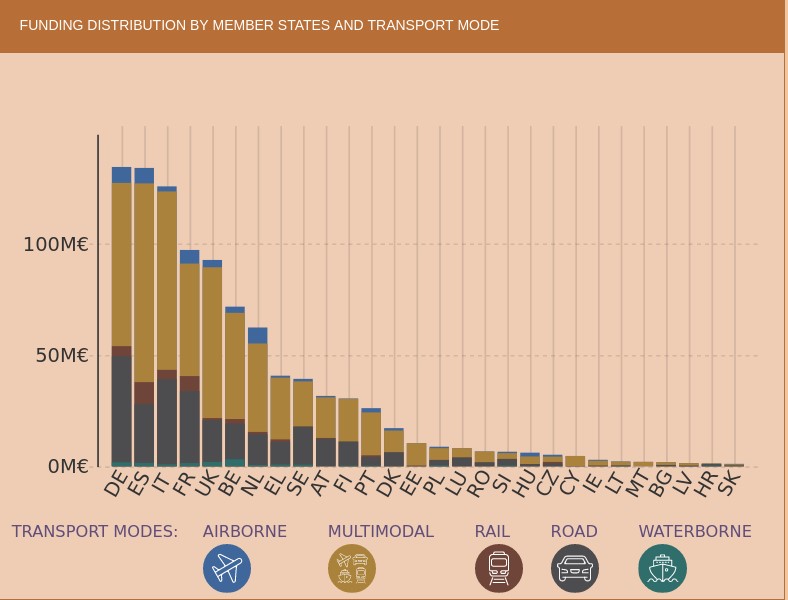

Si nos fijamos en la distribución geográfica de los fondos de investigación que proporciona TRIMIS, vemos que España aparece en quinto lugar, muy lejos de Alemania y Francia. Los sistemas de transporte en los que se está haciendo un mayor esfuerzo son el transporte por carretera y aéreo, beneficiarios de más de la mitad del esfuerzo total.

Sin embargo, encontramos que en el área estratégica de Servicios y movilidad inteligente (SMO), que se evalúan en términos de su contribución a la sostenibilidad general del sistema de energía y transporte, en España se está liderando el esfuerzo investigador al mismo nivel que Alemania. Cabe destacar además que el esfuerzo que se está realizando en España en lo que se refiere al transporte multimodal es superior al de otros países.

Como ejemplo del esfuerzo investigador que se está realizando en España tenemos el conjunto de datos piloto para implementar capacidades semánticas sobre la información de incidencias de tráfico relacionadas con la seguridad en la red estatal de carreteras españolas, excepto País Vasco y Cataluña, que publica la Dirección General de Tráfico y que utiliza una ontología para representar incidentes de tráfico que ha desarrollado a Universidad de Valencia.

El área de los sistemas y servicios de movilidad inteligente pretende contribuir a la descarbonización del sector del transporte europeo y entre sus principales prioridades están el desarrollo de sistemas que conecten los servicios de movilidad urbana y rural y promuevan el cambio modal, el uso sostenible del suelo, la suficiencia en la demanda de viajes y los modos de viaje activos y ligeros; el desarrollo de soluciones de gestión de datos de movilidad e infraestructura digital pública de acceso justo o la implantación de la intermodalidad, la interoperabilidad y el acoplamiento sectorial.

La iniciativa 100 preguntas en el ámbito de la movilidad

La Iniciativa de 100 Preguntas, lanzada por The Govlab en colaboración con Schmidt Futures, pretende identificar las 100 preguntas más importantes del mundo en una serie de dominios críticos para el futuro de la humanidad, como son el género, la migración o la calidad del aire.

Uno de estos dominios está dedicado precisamente al transporte y la movilidad urbana y tiene como objetivo identificar preguntas en las cuales los datos y la ciencia de datos tienen un gran potencial para obtener respuestas que contribuyan a impulsar importantes avances en conocimiento e innovación sobre los dilemas públicos más importantes y los problemas más graves que tienen que resolverse.

De acuerdo con la metodología utilizada, la iniciativa finalizó el 28 de julio la cuarta etapa en la que el público en general realizó la votación con la que se decidieron cuáles serían las 10 preguntas finales que deben ser abordadas. Las 48 preguntas iniciales fueron propuestas por un grupo de expertos en movilidad y científicos de datos por lo que están concebidas para que puedan ser respondidas con datos y pensadas para que, si se consiguen resolver, puedan tener un impacto transformador para las políticas de movilidad urbana.

En la próxima etapa, el grupo de trabajo de GovLab identificará cuáles son los conjuntos de datos que podrían proporcionar respuestas a las preguntas seleccionadas, algunas tan complejas como saber “¿dónde quieren ir los viajeros pero realmente no pueden y cuáles son las razones por las que no pueden alcanzar su destino con facilidad?” o “¿cómo podemos incentivar a las personas a realizar viajes en modos sostenibles, como caminar, andar en bicicleta y/o transporte público, en lugar de vehículos de motor personales?”

Otras preguntas están relacionadas con las dificultades encontradas por los reutilizadores y que han sido puestas de manifiesto con frecuencia en artículos de investigación como “Open Transport Data for maximising reuse in multimodal route”: “¿Cómo se pueden compartir los datos de transporte/movilidad recopilados con dispositivos como teléfonos inteligentes, y ponerlos a disposición de los investigadores, planificadores urbanos y legisladores?"

En algunos casos es previsible que los conjuntos de datos necesarios para responder las preguntas no estén disponibles o pertenezcan a compañías privadas por lo que también se intentará definir cuáles son los nuevos conjuntos de datos que deben generarse para ayudar a llenar los vacíos identificados. El objetivo final es proporcionar una definición clara de los requisitos de datos para responder a las preguntas y facilitar la formación de colaboraciones de datos que contribuyan a avanzar en la obtención de estas respuestas[2].

En definitiva, los cambios en el modo en que utilizamos el transporte y los estilos de vida, como el uso de teléfonos inteligentes, aplicaciones web móviles y redes sociales, junto con la tendencia a alquilar, en lugar de poseer un medio de transporte en particular, han abierto nuevos caminos hacia la movilidad sostenible y unas enormes posibilidades en el análisis e investigación de los datos capturados por estas aplicaciones.

Por ello las iniciativas globales para coordinar los esfuerzos de investigación son esenciales ya que las ciudades necesitan bases de conocimiento sólidas a las que recurrir para que las decisiones políticas sobre desarrollo urbano, transporte limpio, igualdad de acceso a oportunidades económicas y calidad de vida en los centros urbanos sean efectivas. No debemos olvidar que todo este conocimiento es además clave para que puedan establecerse adecuadamente prioridades y, de este modo, podamos aprovechar al máximo los escasos recursos públicos de los que habitualmente disponemos para afrontar los desafíos.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Quedan pocos días para que acabe el verano y, como en cada cambio de estación, es el momento de repasar lo que han dado de sí estos tres meses en el ecosistema de datos abiertos español.

En julio conocimos la última edición del informe DESI (Digital Economy and Society Index) de la Comisión Europea, que coloca a España por delante de la media de la UE en materia digital. Nuestro país se sitúa en la séptima posición, mejorando dos puestos con respecto a 2021. Una de las áreas donde se obtiene un mejor rendimiento es en los datos abiertos, donde ocupa el tercer lugar. Estos buenos datos son fruto de que cada vez más organismos apuestan por la apertura de la información que atesoran y más reutilizadores aprovechan esos datos para crear productos y servicios de valor, como veremos a continuación.

Avances en estrategia y acuerdos para impulsar el open data

Los datos abiertos ganan terreno en las estrategias políticas tanto a nivel nacional, como regional o local.

En este sentido, el Consejo de Ministros aprobó en julio el proyecto de Ley de Eficiencia Digital del Servicio Público de Justicia, una iniciativa que busca construir una Administración de Justicia más accesible, impulsando la orientación al dato de sus sistemas. Entre otras cuestiones, con esta ley se incorpora el concepto de “dato abierto” en la Administración de Justicia.

Otro ejemplo, este a nivel autonómico, proviene de la Generalitat de Valencia, que lanzó a comienzos de verano una nueva Estrategia de datos abiertos con el fin de ofrecer una información pública de calidad, por diseño y por defecto.

También hemos asistido al cierre de convenios de colaboración para impulsar el ecosistema open data, como por ejemplo:

- El Ajuntament de L'Hospitalet y la Universitat Politècnica de Catalunya han firmado un acuerdo para ofrecer formación a los estudiantes de grado o master sobre Big Data e inteligencia Artificial, partiendo del trabajo de datos abiertos.

- La Universidad de Castilla la Mancha ha acordado junto al Gobierno regional poner en marcha la cátedra ‘Gobierno Abierto’ con el fin de impulsar la formación superior y la investigación en materias como la transparencia, los datos abiertos o el acceso a la información pública.

- El Centro Nacional de Información Geográfica (CNIG) y Asedie han firmado un nuevo protocolo para mejorar el acceso a la información geográfica, con el fin de promover la apertura, el acceso y la reutilización de la información del Sector Público.

Ejemplos de reutilización de datos

El verano de 2022 lo recordaremos por las olas de calor y los incendios que han asolado los distintos rincones del país. Un contexto donde los datos abiertos han puesto de manifiesto su poder para dar a conocer el estado de la situación y ayudar en la extinción de fuegos. Los datos de Copernicus o de la Agencia Estatal de Meteorología (AEMET) han sido utilizados para monitorizar la situación y tomar decisiones. Estas fuentes de datos, junto a otras, también están sirviendo para conocer las consecuencias que la escasez de lluvias y las elevadas temperaturas están dejando en los embalses europeos. Además, estos datos han sido utilizados por medios de comunicación para contar a la ciudadanía la última hora de la evolución de los incendios.

La lucha contra el fuego basada en datos abiertos también se ha desarrollado a nivel autonómico. Por ejemplo, el Gobierno de Navarra ha lanzado Agronic, una herramienta que trabaja con Infraestructuras de Datos Espaciales de Navarra para prevenir los incendios producidos por máquinas cosechadoras. Por su parte, el portal de datos abiertos de la Diputación de Barcelona ha publicado conjuntos de datos con "información esencial" para la prevención de incendios forestales. Entre ellos se encuentran la red de puntos de agua, las franjas de baja combustibilidad y las actuaciones de gestión forestal, utilizados por los organismos públicos para la elaboración de planes para hacer frente al fuego.

Otros ejemplos de uso de datos abiertos que hemos conocido en este periodo son:

- La Red de Vigilancia Radiológica Ambiental de la Generalitat de Catalunya ha desarrollado, a partir de datos abiertos, un sistema para monitorizar la radiación presente en el ambiente de las centrales nucleares (Vandellòs y Ascó) y del resto del territorio catalán.

- Gracias a los datos abiertos compartidos por Aragón Open Data se ha redactado un nuevo artículo científico sobre la Covid-19 cuya finalidad es conocer e identificar patrones espaciotemporales en relación a la incidencia del virus y la organización de recursos sanitarios.

- La iniciativa Barcelona Open Data ha lanzado #DataBretxaWomen un proyecto que busca sensibilizar a la ciudadanía sobre la desigualdad existente entre hombres y mujeres en distintos sectores.

- Maldito dato ha utilizado los datos abiertos de la estadística desarrollada por Instituto Nacional de Estadística (INE) a partir de los datos de posicionamiento móvil, para mostrar cómo cambia la densidad de población de los distintos municipios españoles durante julio y agosto.

- Dentro de su Programa de Analítica de Datos para la Investigación y la Innovación en Salud, Cataluña ha priorizado 8 propuestas para hacer investigación basada en análisis de datos. Entre ellos encontramos estudios sobre migrañas, psicosis o cardiopatías.

Novedades en las plataformas de datos abiertos

El verano también ha sido la época elegida por distintos organismos para lanzar o actualizar sus plataformas open data. Algunos ejemplos son:

- El Instituto de Estadística de Navarra lanzó un nuevo portal web, con visualizaciones más dinámicas y atractivas. En el proceso de creación han logrado automatizar la producción estadística e integrar todos los datos en un único entorno.

- El Ayuntamiento de Zaragoza también acaba de publicar un nuevo portal de datos abiertos que ofrece toda la información municipal de una manera más clara y concisa. Este nuevo portal ha sido consensuado con otros ayuntamientos dentro del proyecto ‘Ciudades abiertas’.

- Otra ciudad que ya cuenta con portal de datos abiertos es Cádiz. Su Ayuntamiento ha puesto en marcha una plataforma que permitirá a los gaditanos conocer, acceder, reutilizar y redistribuir los datos abiertos presentes en la ciudad.

- El Instituto Valenciano de Competitividad Empresarial (IVACE) presentó un portal de datos abiertos con todos los registros de certificación energética de edificios de la Comunidad Valenciana desde 2011. Esto permitirá, entre otras acciones, realizar análisis del consumo y establecer estrategias de rehabilitación.

- Aragón Open Data ha incluido una nueva funcionalidad en su API que permite a los usuarios obtener datos geográficos en formato GeoJSON.

- El Instituto Geográfico Nacional comunicó una nueva versión de la app de terremotos, con novedades, contenido didáctico e información.

- El Ministerio para la Transición Ecológica y el Reto Demográfico presentó SIDAMUN, una plataforma que facilita el acceso a información estadística territorial a partir de datos municipales.

- El portal de datos abiertos del Gobierno de Canarias lanzó un nuevo buscador que permite localizar las páginas del portal utilizando metadatos, y que permite exportar en CVS, ODS o PDF.

Algunos organismos han aprovechado el verano para anunciar novedades que verán la luz en los próximos meses como la Xunta de Galicia, que avanza en el desarrollo de un Observatorio de Salud Pública mediante una plataforma de datos abiertos, el Ayuntamiento de Burgos, que estrenará portal de datos abiertos, o la Diputación de Pontevedra que lanzará próximamente un visor presupuestario en tiempo real.

Acciones para promover los datos abiertos

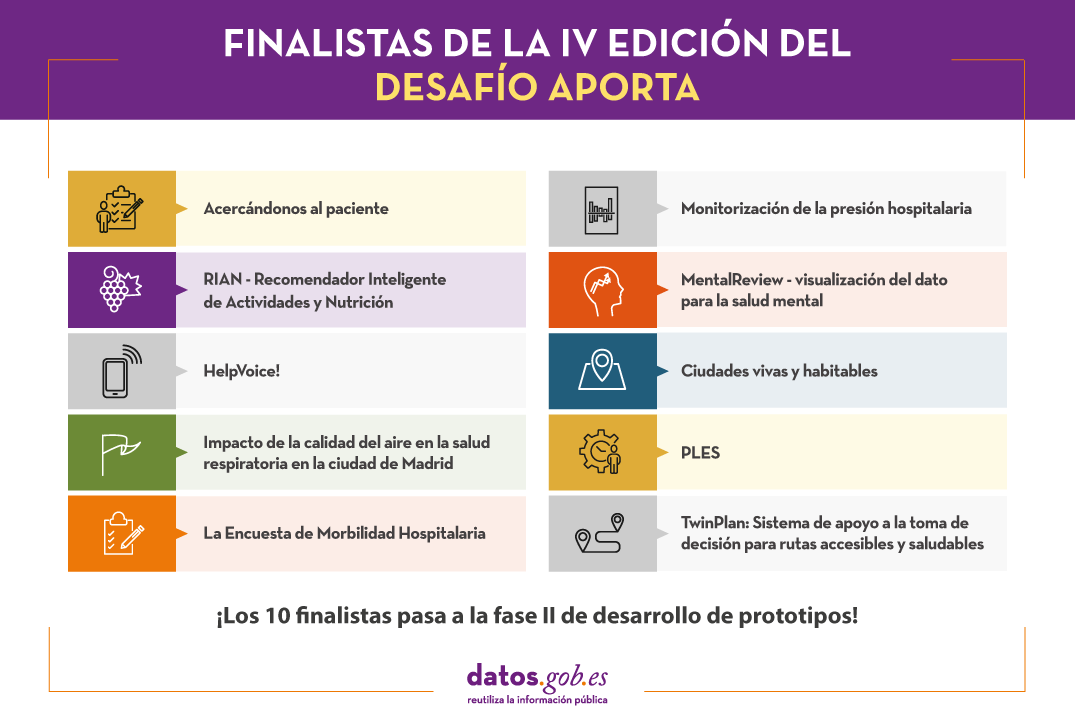

En junio conocimos a los finalistas del IV Desafío Aporta: “El valor del dato para la salud y el bienestar de los ciudadanos”, cuya final se celebrará en octubre. Además, en estos meses se han lanzado algunas competiciones para promover la reutilización de datos abiertos cuyo plazo de inscripción todavía está abierto, como el concurso de Castilla y León o el primer Datathon de UniversiData. También se puso en marcha el concurso de datos abiertos de Euskadi, que actualmente se encuentra en fase de evaluación.

Con respecto a los eventos, el verano comenzó con la celebración de la Semana de la Administración abierta, que reunió diversas actividades, algunas de ellas enfocadas en los datos. Si te lo perdiste, algunas organizaciones han puesto a disposición de los ciudadanos diversos materiales. Por ejemplo, puedes ver en vídeo el coloquio “Los datos abiertos con perspectiva de género: sí o sí” impulsado por el Gobierno de Canarias o acceder a las presentaciones del webinar para conocer a la Oficina del Dato y la Iniciativa Aporta.

Otros eventos que se han celebrado, con la participación de la Oficina del Dato, y cuyos vídeos son públicos son: el Congreso Nacional de Archivo y Documento Electrónico y los Espacios de Datos como ecosistemas para que las entidades puedan llegar más lejos.

Por último, en el campo de la formación, algunos ejemplos de cursos que se han lanzado estos meses son:

- El Instituto Geográfico Nacional ha lanzado un Plan de Formación Interadministrativo, con el fin de generar una cultura común entre todos los expertos en Información Geográfica de los organismos públicos.

- Andalucía Vuela ha lanzado una serie de formaciones gratuitas y dirigidas a la ciudadanía interesada en datos o inteligencia artificial.

Novedades a nivel internacional

El verano también ha dado lugar a muchas novedades en el ámbito internacional. Algunos ejemplos son:

- A comienzos del verano meteorológico se publicaron los resultados de la primera edición del Global Data Barometer, que mide el estado de los datos con respecto a cuestiones sociales como la Covid19 o el clima.

- También se dieron a conocer los 12 finalistas del Eu Datathon 2022.

- Se publico una edición interactiva del anuario regional 2021 de Eurostat.

- Inglaterra ha elaborado una estrategia para aprovechar el potencial de los datos en la sanidad y la atención sanitaria de forma segura, fiable y transparente.

Esta es solo una selección de noticias entre todas las novedades del ecosistema de datos abiertos de los últimos tres meses. Si quieres hacer alguna contribución, puedes dejarnos un mensaje en los comentarios o escribir a dinamizacion@datos.gob.es.

Un año más desde el 2016, la Junta de Castilla y León abre el plazo para recibir las propuestas más innovadoras en materia de datos abiertos. La sexta edición del concurso que lleva el mismo nombre tiene como finalidad “reconocer la realización de proyectos que suministren cualquier tipo de idea, estudio, servicio, sitio web o aplicaciones para dispositivos móviles, y que para ello utilicen conjuntos de datos del Portal de Datos Abiertos de la Junta de Castilla y León”.

Con este tipo de iniciativas, Castilla y León busca visibilizar el talento digital presente en la comunidad autónoma, a la vez que impulsa el uso de los datos abiertos y el papel de las empresas reutilizadoras castellanoleonesas.

El plazo para la presentación de las candidaturas está abierto desde el pasado 5 de agosto y concluirá el próximo 4 de octubre. A la hora de presentar los proyectos, los participantes podrán elegir entre la opción presencial o digital. Esta última se llevará a cabo a través de la Sede Electrónica de Castilla y León y podrán tramitarla tanto personas físicas como jurídicas.

4 categías distintas

Al igual que en ediciones anteriores, los proyectos y premios asociados a los mismos se dividen en cuatro categorías diferenciadas:

- Categoría “Ideas”: Aquí se incluyen aquellos proyectos que describan una idea que pueda utilizarse para crear estudios, servicios, sitios web o aplicaciones para dispositivos móviles. El requisito principal que deben cumplir es utilizar conjuntos de datos del portal de Datos Abiertos de la Junta de Castilla y León .

- Categoría “Productos y Servicios”: Engloba aquellos que proporcionen estudios, servicios, sitios web o aplicaciones para dispositivos móviles y que empleen conjuntos de datos del portal de Datos Abiertos de la Junta de Castilla y León, que estén accesibles para toda la ciudadanía vía web mediante una URL.

- Categoría “Recurso Didáctico”: En este apartado se recoge la creación de recursos didácticos abiertos (publicados con licencias Creative Commons) nuevos e innovadores que usen conjuntos de datos del portal de Datos Abiertos de la Junta de Castilla y León, y sirvan de apoyo a la enseñanza en el aula.

- Categoría “Periodismo de Datos”: Por último, esta categoría incluye piezas periodísticas publicadas o actualizadas (de forma relevante) en cualquier soporte (escrito o audiovisual) que utilice conjuntos de datos del portal de Datos Abiertos de la Junta de Castilla y León.

Respecto a los galardones de esta sexta edición, los premios ascienden a una dotación económica 12.000€ que se distribuye en función de la categoría premiada y el puesto alcanzado.

Categoría Ideas

- Primer premio 1.500€

- Segundo premio 500€

Categoría Productos y servicios

- Primer premio 2.500€

- Segundo premio 1.500€

- Tercer premio 500€

- Premio estudiantes: 1.500€

Categoría Recurso didáctico

- Primer premio 1.500€

Categoría Periodismo de datos

- Primer premio 1.500€

- Segundo premio 1.000€

Al igual que en ediciones anteriores, el veredicto final será emitido por un jurado formado por integrantes que cuentan con acreditada experiencia en el ámbito de los datos abiertos, el análisis de información o la economía digital. Igualmente, las decisiones del jurado se adoptarán por mayoría de votos y, en caso de empate, decidirá quién ostente la presidencia.

Por último y respecto a los ganadores, estos tendrán un plazo de 5 días hábiles para aceptar el galardón. De no producirse la aceptación del premio se entenderá que se renuncia al mismo. Si quieres consultar en detalle las condiciones y las bases legales del concurso puedes acceder a ellas a través de este enlace.

Ganadores de la edición 2021

La V edición del Concurso de Datos de Castilla y León contó con un total de 37 propuestas de las cuales tan solo ocho de ellas se alzaron con algún tipo de galardón. Así y de cara a participar en la edición vigente, puede resultar de interés conocer cuáles fueron los proyectos que se ganaron la atención del jurado en 2021.

Categoría Ideas

El primer premio, de 1.500€, fue para APP SOLAR-CYL, una herramienta web de dimensionamiento óptimo de instalaciones de autoconsumo solar fotovoltaico. Dirigida tanto a ciudadanos como a gestores energéticos de la Administración Pública, la solución busca ser un apoyo para el análisis de la viabilidad técnica y económica de este tipo de sistemas.

Categoría Productos y Servicios

Repuéblame es en una web destinada a redescubrir los mejores lugares en los que vivir o teletrabajar. De esta forma, la app cataloga los municipios castellanoleoneses en base a una serie de indicadores numéricos, de elaboración propia, relacionados con la calidad de vida. Al llevarse el primer premio de esta categoría, consiguió una dotación económica de 2.500 euros.

Categoría Periodismo de datos

La Asociación Maldita contra la desinformación obtuvo el primer premio de 1.500€ gracias al proyecto MAPA COVID-19: consulta cuántos casos de coronavirus hay y cómo está la ocupación de tu hospital.

Por último y después de que el jurado dictaminase que las candidaturas presentadas no cumplían con los criterios recogidos en las bases, la categoría “Recurso Didáctico” fue declarada desierta y, por ende, ninguno de los participantes fue premiado.

Si tienes alguna duda o consulta acerca del concurso, puedes escribir un correo a: datosabiertos@jcyl.es.

1. Introducción

Las visualizaciones son representaciones gráficas de datos que permiten comunicar de manera sencilla y efectiva la información ligada a los mismos. Las posibilidades de visualización son muy amplias, desde representaciones básicas, como puede ser un gráfico de líneas, barras o sectores, hasta visualizaciones configuradas sobre cuadros de mando o dashboards interactivos. Las visualizaciones juegan un papel fundamental en la extracción de conclusiones a partir de información visual, permitiendo además detectar patrones, tendencias, datos anómalos o proyectar predicciones, entre otras muchas funciones.

Antes de lanzarnos a construir una visualización efectiva, debemos realizar un tratamiento previo de los datos, prestando especial atención a la obtención de los mismos y validando su contenido, asegurando que se encuentran en el formato adecuado y consistente para su procesamiento y no contienen errores. Un tratamiento previo de los datos es primordial para realizar cualquier tarea relacionada con el análisis de datos y la realización de visualizaciones efectivas.

En la sección “Visualizaciones paso a paso” estamos presentando periódicamente ejercicios prácticos de visualizaciones de datos abiertos que están disponibles en el catálogo datos.gob.es u otros catálogos similares. En ellos abordamos y describimos de manera sencilla las etapas necesarias para obtener los datos, realizar las transformaciones y análisis que resulten pertinentes para, finalmente, crear visualizaciones interactivas, de las que podemos extraer información en forma de conclusiones finales.

En este ejercicio práctico, hemos realizado un sencillo desarrollo de código que está convenientemente documentado apoyandonos en herramientas de uso gratuito.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

2. Objetivo

El objetivo principal de este post es aprender a realizar una visualización interactiva partiendo de datos abiertos. Para este ejercicio práctico hemos escogido conjuntos de datos que contienen información relevante sobre los embalses nacionales. A partir de estos datos realizaremos el análisis de su estado y de su evolución temporal en los últimos años.

3. Recursos

3.1. Conjuntos de datos

Para este caso práctico se han seleccionado conjuntos de datos publicados por el Ministerio para la Transición Ecológica y el Reto Demográfico, que dentro del boletín hidrológico recoge series temporales de datos sobre él volumen de agua embalsada de los últimos años para todos los embalses nacionales con una capacidad superior a 5hm3. Datos históricos del volumen de agua embalsada disponibles en:

También se ha seleccionado un conjunto de datos geoespaciales. Durante su búsqueda, se han encontrado dos posibles archivos con datos de entrada, el que contiene las áreas geográficas correspondientes a los embalses de España y el que contiene las presas que incluye su geoposicionamiento como un punto geográfico. Aunque evidentemente no son lo mismo, embalses y presas guardan relación y para simplificar este ejercicio práctico optamos por utilizar el archivo que contiene la relación de presas de España. Inventario de presas disponible en: https://www.mapama.gob.es/ide/metadatos/index.html?srv=metadata.show&uuid=4f218701-1004-4b15-93b1-298551ae9446 , concretamente:

Este conjunto de datos contiene geolocalizadas (Latitud, Longitud) las presas de toda España con independencia de su titularidad. Se entiende por presa, aquellas estructuras artificiales que, limitando en todo o en parte el contorno de un recinto enclavado en el terreno, esté destinada al almacenamiento de agua dentro del mismo.

Para generar los puntos geográficos de interés se realiza un procesamiento mediante la herramienta QGIS, cuyos pasos son los siguientes: descargar el archivo ZIP, cargarlo en QGIS y guardarlo como CSV incluyendo la geometría de cada elemento como dos campos que especifican su posición como un punto geográfico (Latitud y Longitud).

También se he realizado un filtrado para quedarnos con los datos correspondientes a las presas de los embalses que tengan una capacidad mayor a 5hm3

3.2. Herramientas

Para la realización del preprocesamiento de los datos se ha utilizado el lenguaje de programación Python desde el servicio cloud de Google Colab, que permite la ejecución de Notebooks de Jupyter.

Google Colab o también llamado Google Colaboratory, es un servicio gratuito en la nube de Google Research que permite programar, ejecutar y compartir código escrito en Python o R desde tu navegador, por lo que no requiere la instalación de ninguna herramienta o configuración.

Para la creación de la visualización interactiva se ha usado la herramienta Google Data Studio.

Google Data Studio es una herramienta online que permite realizar gráficos, mapas o tablas que pueden incrustarse en sitios web o exportarse como archivos. Esta herramienta es sencilla de usar y permite múltiples opciones de personalización.

Si quieres conocer más sobre herramientas que puedan ayudarte en el tratamiento y la visualización de datos, puedes recurrir al informe \"Herramientas de procesado y visualización de datos\".

4. Enriquecimiento de los datos

Con la finalidad de aportar mayor información relacionada a cada una de las presas en el dataset con datos geoespaciales, se realiza un proceso de enriquecimiento de datos explicado a continuación.

Para ello vamos a utilizar una herramienta útil para este tipo de tarea, OpenRefine. Esta herramienta de código abierto permite realizar múltiples acciones de preprocesamiento de datos, aunque en esta ocasión la usaremos para llevar a cabo un enriquecimiento de nuestros datos mediante la incorporación de contexto enlazando automáticamente información que reside en el popular repositorio de conocimiento Wikidata.

Una vez instalada la herramienta en nuestro ordenador, al ejecutarse se abrirá una aplicación web en el navegador, en caso de que eso no ocurriese, se accedería a dicha aplicación tecleando en la barra de búsqueda del navegador \"localhost:3333\".

Pasos a seguir:

- Paso 1: Carga del CSV en el sistema (Figura 1).

Figura 1 - Carga de un archivo CSV en OpenRefine

- Paso 2: Creación del proyecto a partir del CSV cargado (Figura 2). OpenRefine se gestiona mediante proyectos (cada CSV subido será un proyecto), que se guardan en el ordenador dónde se esté ejecutando OpenRefine para un posible uso posterior. En este paso debemos dar un nombre al proyecto y algunos otros datos, como el separador de columnas, aunque lo más habitual es que estos últimos ajustes se rellenen automáticamente.

Figura 2 - Creación de un proyecto en OpenRefine

- Paso 3: Enlazado (o reconciliación, usando la nomenclatura de OpenRefine) con fuentes externas. OpenRefine nos permite enlazar recursos que tengamos en nuestro CSV con fuentes externas como Wikidata. Para ello se deben realizar las siguientes acciones (pasos 3.1 a 3.3):

- Paso 3.1: Identificación de las columnas a enlazar. Habitualmente este paso suele estar basado en la experiencia del analista y su conocimiento de los datos que se representan en Wikidata. Como consejo, habitualmente se podrán reconciliar o enlazar aquellas columnas que contengan información de carácter más global o general como nombres de países, calles, distritos, etc., y no se podrán enlazar aquellas columnas como coordenadas geográficas, valores numéricos o taxonomías cerradas (tipos de calles, por ejemplo). En este ejemplo, hemos encontrado la columna NOMBRE que contiene el nombre de cada embalse que puede servir como identificador único de cada ítem y puede ser un buen candidato para enlazar.

- Paso 3.2: Comienzo de la reconciliación. Comenzamos la reconciliación como se indica en la figura 3 y seleccionamos la única fuente que estará disponible: Wikidata(en). Después de hacer clic en Start Reconciling, automáticamente comenzará a buscar la clase del vocabulario de Wikidata que más se adecue basado en los valores de nuestra columna.

Figura 3 – Inicio del proceso de reconciliación de la columna NOMBRE en OpenRefine

- Paso 3.3: Selección de la clase de Wikidata. En este paso obtendremos los valores de la reconciliación. En este caso como valor más probable, seleccionamos el valor de la propiedad “reservoir” cuya descripción se puede ver en https://www.wikidata.org/wiki/Q131681, que corresponde a la descripción de un “lago artificial para acumular agua”. Únicamente habrá que pulsar otra vez en Start Reconciling.

OpenRefine nos ofrece la posibilidad de mejorar el proceso de reconciliación agregando algunas características que permitan orientar el enriquecimiento de la información con mayor precisión. Para ello ajustamos la propiedad P4568 cuya descripción se corresponde con el identificador de un embalse en España, en el SNCZI-Inventario de Presas y Embalses, como se observa en la figura 4.

Figura 4 - Selección de la clase de Wikidata que mejor representa los valores de la columna NOMBRE

- Paso 4: Generar una nueva columna con los valores reconciliados o enlazados. Para ello debemos pulsar en la columna NOMBRE e ir a “Edit Column → Add column based in this column”, dónde se mostrará un texto en la que tendremos que indicar el nombre de la nueva columna (en este ejemplo podría ser WIKIDATA_EMBALSE). En la caja de expresión deberemos indicar: “http://www.wikidata.org/entity/”+cell.recon.match.id y los valores aparecen como se previsualiza en la Figura 6. “http://www.wikidata.org/entity/” se trata de una cadena de texto fija para representar las entidades de Wikidata, mientras el valor reconciliado de cada uno de los valores lo obtenemos a través de la instrucción cell.recon.match.id, es decir, cell.recon.match.id(“ALMODOVAR”) = Q5369429.

Mediante la operación anterior, se generará una nueva columna con dichos valores. Con el fin de comprobar que se ha realizado correctamente, haciendo clic en una de las celdas de la nueva columna, está debería conducir a una página web de Wikidata con información del valor reconciliado.

El proceso lo repetimos para añadir otro tipo de información enriquecida como la referencia en Google u OpenStreetMap.

Figura 5 - Generación de las entidades de Wikidata gracias a la reconciliación a partir de una nueva columna

- Paso 5: Descargar el CSV enriquecido. Utilizamos la función Export → Custom tabular exporter situada en la parte superior derecha de la pantalla y seleccionamos las características como se indica en la Figura 6.

Figura 6 - Opciones de descarga del fichero CSV a través de OpenRefine

5. Preprocesamiento de datos

Durante el preprocesamiento es necesario realizar un análisis exploratorio de los datos (EDA) con el fin de interpretar adecuadamente los datos de partida, detectar anomalías, datos ausentes o errores que pudieran afectar a la calidad de los procesos posteriores y resultados, además de realizar las tareas de transformación y preparación de las variables necesarias. Un tratamiento previo de los datos es esencial para garantizar que los análisis o visualizaciones creadas posteriormente a partir de ellos son confiables y consistentes. Si quieres conocer más sobre este proceso puedes recurrir a la Guía Práctica de Introducción al Análisis Exploratorio de Datos.

Los pasos que se siguen en esta fase de preprocesamiento son los siguientes:

- Instalación y carga de librerías

- Carga de archivos de datos de origen

- Modificación y ajuste de las variables

- Detención y tratamiento de datos ausentes (NAs)

- Generación de nuevas variables

- Creación de tabla para visualización \"Evolución histórica de la reserva hídrica entre los años 2012 y 2022\"

- Creación de tabla para visualización \"Reserva hídrica (hm3) entre los años 2012 y 2022\"

- Creación de tabla para visualización \"Reserva hídrica (%) entre los años 2012 y 2022\"

- Creación de tabla para visualización \"Evolución mensual de la reserva hídrica (hm3) para distintas series temporales\"

- Guardado de las tablas con los datos preprocesados

Podrás reproducir este análisis, ya que el código fuente está disponible en este repositorio de GitHub. La forma de proporcionar el código es a través de un documento realizado sobre un Jupyter Notebook que una vez cargado en el entorno de desarrollo podrás ejecutar o modificar de manera sencilla. Debido al carácter divulgativo de este post y con el fin de favorecer el aprendizaje de lectores no especializados, el código no pretende ser el más eficiente, sino facilitar su comprensión por lo que posiblemente se te ocurrirán muchas formas de optimizar el código propuesto para lograr fines similares. ¡Te animamos a que lo hagas!

Puedes seguir los pasos y ejecutar el código fuente sobre este notebook en Google Colab.

6. Visualización de datos

Una vez hemos realizado un preprocesamiento de los datos, vamos con las visualizaciones. Para la realización de estas visualizaciones interactivas se ha usado la herramienta Google Data Studio. Al ser una herramienta online, no es necesario tener instalado un software para interactuar o generar cualquier visualización, pero sí es necesario que las tablas de datos que le proporcionemos estén estructuradas adecuadamente.

Para abordar el proceso de diseño del conjunto de representaciones visuales de los datos, el primer paso es plantearnos las preguntas que queremos resolver. Proponemos las siguientes:

- ¿Cuál es la localización de los embalses dentro del territorio nacional?

-

¿Qué embalses son los de mayor y menor aporte de volumen de agua embalsada (reserva hídrica en hm3) al conjunto del país?

-

¿Qué embalses poseen el mayor y menor porcentaje de llenado (reserva hídrica en %)?

-

¿Cuál es la tendencia en la evolución de la reserva hídrica en los últimos años?

¡Vamos a buscar las respuestas viendo los datos!

6.1. Localización geográfica y principal información de cada embalse

Esta representación visual se ha realizado teniendo en cuenta las coordenadas geográficas de los embalses y distinta información asociada a cada uno de ellos. Para ello se ha generado durante el preprocesamiento de datos la tabla “geo.csv”

Mediante un mapa de puntos geográficos se visualiza la localización de los embalses en el territorio nacional.

Una vez obtenido el mapa, pinchando en cada uno de los embalses podemos acceder a información complementaria sobre dicho embalse en la tabla inferior. También, mediante las pestañas despegables, aparece la opción de filtrar el mapa por demarcación hidrográfica y por embalse.

Ver la visualización en pantalla completa

6.2. Reserva hídrica (hm3) entre los años 2012 y 2022

Esta representación visual se ha realizado teniendo en cuenta la reserva hídrica (hm3) por embalse entre los años los años 2012 (inclusive) y 2022. Para ello se ha generado durante el preprocesamiento de datos la tabla “volumen.csv”

Mediante un gráfico de jerarquía rectangular se visualiza de forma intuitiva la importancia de cada embalse en cuanto a volumen embalsado dentro del conjunto nacional para el periodo temporal anteriormente indicado.

Una vez obtenido el gráfico, mediante las pestañas despegables, aparece la opción de filtrar la visualización por demarcación hidrográfica y por embalse.

Ver la visualización en pantalla completa

6.3. Reserva hídrica (%) entre los años 2012 y 2022

Esta representación visual se ha realizado teniendo en cuenta la reserva hídrica (%) por embalse entre los años 2012 (inclusive) y 2022. Para ello se ha generado durante el preprocesamiento de datos la tabla “porcentaje.csv”

Mediante un gráfico de barras se visualiza de forma intuitiva el porcentaje de llenado de cada embalse para el periodo temporal anteriormente indicado.

Una vez obtenido el gráfico, mediante las pestañas despegables, aparece la opción de filtrar la visualización por demarcación hidrográfica y por embalse.

Ver la visualización en pantalla completa

6.4. Evolución histórica de la reserva hídrica entre los años 2012 y 2022

Esta representación visual se ha realizado teniendo en cuenta los datos históricos de la reserva hídrica (hm3 y %) para todas las mediciones semanales registradas entre los años 2012(inclusive) y 2022. Para ello se ha generado durante el preprocesamiento de datos la tabla “lineas.csv”

Mediante gráficos de líneas y sus líneas de tendencia se visualiza la evolución temporal de la reserva hídrica (hm3 y %).

Una vez obtenido el gráfico, mediante las pestañas desplegables, podemos modificar la serie temporal, filtrar por demarcación hidrográfica y por embalse.

Ver la visualización en pantalla completa

6.5. Evolución mensual de la reserva hídrica (hm3) para distintas series temporales

Esta representación visual se ha realizado teniendo en cuenta la reserva hídrica (hm3) de los distintos embalses desglosada por meses para distintas series temporales (cada uno de los años desde el 2012 hasta el 2022). Para ello se ha generado durante el preprocesamiento de datos la tabla “lineas_mensual.csv”

Mediante un gráfico de líneas se visualízala la reserva hídrica mes a mes para cada una de las series temporales.

Una vez obtenido el gráfico, mediante las pestañas desplegables, podemos filtrar por demarcación hidrográfica y por embalse. También tenemos la opción de elegir la serie o series temporales (cada uno de los años desde el 2012 hasta el 2022) que queremos visualizar mediante el icono que aparece en la parte superior derecha del gráfico.

Ver la visualización en pantalla completa

7. Conclusiones

La visualización de datos es uno de los mecanismos más potentes para explotar y analizar el significado implícito de los datos, independientemente del tipo de dato y el grado de conocimiento tecnológico del usuario. Las visualizaciones nos permiten construir significado sobre los datos y la creación de narrativas basadas en la representación gráfica. En el conjunto de representaciones gráficas de datos que acabamos de implementar se puede observar lo siguiente:

-

Se observa una tendencia significativa en la disminución del volumen de agua embalsada por el conjunto de embalses nacionales entre los años 2012 y 2022.

-

El año 2017 es el que presenta valores más bajos de porcentaje de llenado total de los embalses, llegando a ser este inferior al 45% en ciertos momentos del año.

-

El año 2013 es el que presenta valores más altos de porcentaje de llenado total de los embalses, llegando a ser este superior al 80% en ciertos momentos del año.

Cabe destacar que en las visualizaciones tienes la opción de filtrar por demarcación hidrográfica y por embalse. Te animamos a lo que lo hagas para sacar conclusiones más específicas de las demarcaciones hidrográficas y embalses que estés interesado.

Esperemos que esta visualización paso a paso te haya resultado útil para el aprendizaje de algunas técnicas muy habituales en el tratamiento y representación de datos abiertos. Volveremos para mostraros nuevas reutilizaciones. ¡Hasta pronto!

El pasado mes de noviembre se lanzó la 4ª edición del Desafío Aporta, organizado por Red.es, en colaboración con la Secretaría de Estado de Digitalización e Inteligencia Artificial. Bajo el lema “El valor del dato para la salud y el bienestar de los ciudadanos”, la competición busca identificar nuevos servicios y soluciones, basadas en datos abiertos, que impulsen mejoras en dicho ámbito.

El reto se divide en dos fases: un concurso de ideas, seguido de una segunda fase donde los finalistas tienen que desarrollar y presentar un prototipo. Ahora nos encontramos en el ecuador de la competición. La fase I ha llegado a su fin y es el momento de conocer quiénes son los 10 finalistas que pasarán a la fase II.

Tras el análisis de las propuestas presentadas, muy diversas y de gran calidad, el jurado ha determinado una serie de finalistas, como ha quedado reflejado en la resolución publicada en la sede electrónica de Red.es.

Veamos cada candidatura en detalle:

Acercándonos al paciente

- Equipo:

SialSIG aporta, integrado por Laura García y María del Mar Gimeno.

- ¿En qué consiste?

Se construirá una plataforma que permitirá reducir el tiempo del rescate y optimizar la atención médica ante una emergencia. Se analizarán parámetros para categorizar las zonas definiendo el riesgo de mortalidad y se identificarán los lugares más óptimos para el aterrizaje de los medios aéreos de rescate. Esta información permitirá, además, conocer cuáles son las zonas más aisladas y vulnerables ante emergencias médicas, una información de gran valor para definir estrategias de actuación que conlleven una mejora de las gestiones y los medios a emplear.

- Datos

La plataforma busca integrar la información de todas las comunidades autónomas, incluyendo datos de población (censo, edad, sexo, etc.), datos de hospitales y helipuertos, datos de usos del suelo y cultivos, etc. En concreto, se obtendrán datos del padrón municipal del Instituto Nacional de Estadística (INE), los límites de provincias y municipios, la calificación de uso de los terrenos del Instituto Geográfico Nacional (IGN) y datos del SIGPAC (MAPA), entre otros.

Monitorización de la presión hospitalaria

- Equipo:

DSLAB, grupo de investigación en ciencia de datos de la Universidad Rey Juan Carlos, integrado por Isaac Martín, Alberto Fernández, Marina Cuesta y María del Carmen Lancho.

- ¿En qué consiste?

Con el objetivo de mejorar la gestión hospitalaria, el DSLAB propone un cuadro de mando interactivo y fácil de usar que permita:

- Monitorizar la presión hospitalaria

- Evaluar la carga y saturación real de los centros sanitarios

- Predecir la evolución de dicha presión

De esta forma se podrá ejecutar una mejor planificación de recursos, anticipar la toma de decisiones y evitar posibles colapsos.

- Datos

Para plasmar el potencial de la herramienta, el prototipo se realizará con datos abiertos relativos al COVID en la Comunidad Autónoma de Castilla y León, como la ocupación de camas o la situación epidemiológica por hospitales y provincias. No obstante, la solución es escalable y extrapolable a cualquier otro territorio con datos similares.

RIAN - Recomendador Inteligente de Actividades y Nutrición

- Equipo:

RIAN Open Data Team, integrado por Jesús Noguera y Raúl Micharet.

- ¿En qué consiste?

RIAN surge para fomentar hábitos saludables y combatir el sobrepeso, la obesidad, el sedentarismo y la mala nutrición entre niños y adolescentes. Se trata de una aplicación para dispositivos móviles que utiliza técnicas de gamificación, así como realidad aumentada y algoritmos de inteligencia artificial para realizar recomendaciones. Los usuarios tienen que resolver retos personalizados, de forma individual o colectiva, ligados con aspectos nutricionales y actividades físicas, como yincanas o juegos en espacios verdes públicos.

- Datos

El piloto utiliza datos relativos a zonas verdes, puntos de interés, vías verdes, actividades y eventos pertenecientes a las ciudades de Málaga, Madrid, Zaragoza y Barcelona. Estos datos se combinan con recomendaciones nutricionales (datos de alimentos y valores nutricionales y productos alimentarios con marca) y datos destinados al reconocimiento de alimentos por imágenes de Tensorflow o Kaggle, entre otros.

MentalReview - visualización del dato para la salud mental

- Equipo:

Kairos Digital Analytics and Big Data Solutions S.L.

- ¿En qué consiste?

MentalReview es una herramienta de monitorización de la salud mental para apoyar la gestión y planificación sociosanitaria, permitiendo a las instituciones mejorar los servicios de atención al ciudadano. La herramienta permitirá analizar la información extraída de bases de datos abiertas, calcular indicadores y, finalmente, visualizar la información a través de gráficas y un mapa interactivo. Esto permitirá conocer el estado actual de la salud mental en la población española, identificar tendencias o hacer un estudio de su evolución.

- Datos

Para su desarrollo se utilizarán datos del INE, el Centro de Investigaciones Sociológicas, los Servicios de Salud Mental de las distintas autonomías, la Agencia Española de Medicamentos y Productos Sanitarios o EUROSTAT, entre otros. Algunos ejemplos concretos de conjuntos de datos a utilizar son: los problemas de ansiedad en la juventud, la tasa de mortalidad por suicidio por comunidad autónoma, edad, sexo y periodo o el consumo de ansiolíticos.

HelpVoice!

- Equipo:

Data Express, integrado por Sandra García, Antonio Ríos y Alberto Berenguer.

- ¿En qué consiste?

HelpVoice! es un servicio que ayuda a nuestros mayores a través de técnicas de reconocimiento de voz basadas en aprendizaje automático. Ante una situación de emergencia, el usuario solo tendrá que hacer clic en un dispositivo que puede ser un botón de emergencia, un teléfono móvil o herramientas de domótica y comentar sus síntomas. El sistema enviará un informe con la transcripción realizada y predicciones al hospital más cercano, agilizando la respuesta de los sanitarios. En paralelo, HelpVoice! también recomendará al paciente qué hacer mientras espera a los servicios de emergencia.

- Datos

Entre otros datos abiertos, se utilizarán el mapa de hospitales de España. También se utilizarán datos de reconocimiento del habla y sentimientos en el texto.

Ciudades vivas y habitables: creando mapas de sombras de alta resolución para favorecer la adaptación de las ciudades al cambio climático

- Equipo:

Ciudades Vivas, integrado por Francisco Rodríguez-Sánchez y Jesús Sánchez-Dávila.

- ¿En qué consiste?

En el contexto actual de aumento de temperaturas, el equipo de Ciudades Vivas propone desarrollar un software abierto para promover la adaptación de las ciudades al cambio climático, facilitando la planificación del sombreado urbano. Utilizando técnicas de análisis espacial, teledetección y modelización, dicho software permitirá conocer el nivel de insolación (o sombreado) con alta resolución espaciotemporal (cada hora del día y sobre cada metro cuadrado de suelo) para cualquier municipio de España. El equipo analizará particularmente la situación del sombreado en la ciudad de Sevilla, ofreciendo sus resultados públicamente mediante una aplicación web que permitirá consultar los mapas de insolación y obtener rutas de sombra entre distintos puntos de la ciudad.

- Datos

Ciudades Vivas se basa en el uso de datos abiertos de teledetección (LiDAR) del Programa Nacional de Ortofotografía Aérea (PNOA), el arbolado de la ciudad de Sevilla y los datos espaciales de OpenStreetMap.

Impacto de la calidad del aire en la salud respiratoria en la ciudad de Madrid

- Equipo:

So Good Data, integrado por Ana Belén Laguna, Manuel López, Vicente Lorenzo, Javier Maestre e Iván Robles.

- ¿En qué consiste?

So Good Data propone un estudio para analizar el impacto de la contaminación atmosférica en el número de ingresos hospitalarios por causa de enfermedades respiratorias. También determinará cuáles son las partículas contaminantes que podrían resultar más perjudiciales. Con esta información, se podría predecir el número de ingresos a los que se va a enfrentar un hospital en función de la contaminación atmosférica en una fecha concreta, para tomar las medidas necesarias con antelación y reducir la mortalidad.

- Datos

Entre otros conjuntos de datos, se utilizarán para el estudio las hospitalizaciones por enfermedades respiratorias, la calidad del aire, las ventas de tabaco o el polen atmosférico en la Comunidad de Madrid.

PLES

- Equipo:

BOLT, integrado por Víctor José Montiel, Núria Foguet, Borja Macías, Alejandro Pelegero y José Luis Álvarez.

- ¿En qué consiste?

El equipo BOLT creará una aplicación web que permita al usuario obtener una estimación del tiempo medio de espera para consultas, pruebas o intervenciones en el sistema sanitario público de Cataluña. Los modelos de predicción de series temporales se desarrollarán mediante Python con técnicas estadísticas y de machine mearning. El usuario solo tendrá que indicar el hospital y el tipo de consulta, operación o prueba por la cual están esperando. Además de mejorar la transparencia con el paciente, la web también podrá ser utilizada por los profesionales sanitarios para gestionar mejor sus recursos.

- Datos

Se utilizarán los datos de las listas de espera públicas de Cataluña publicadas por CatSalut mensualmente. En concreto, se emplearán los datos mensuales de las listas de espera de intervenciones quirúrgicas, de consultas externas especializadas y de pruebas diagnósticas desde, por lo menos, 2019 a la actualidad. En el futuro la idea podría ser adaptada a otras Comunidades Autónomas.

La Encuesta de Morbilidad Hospitalaria: Propuesta de desarrollo de un entorno web MERN+Python para su análisis y la visualización gráfica

- Equipo:

Marc Coca Moreno

- ¿En qué consiste?

Se trata de un entorno web basado en las herramientas MERN, Python y Pentaho para el análisis y la visualización interactiva de los microdatos de la Encuesta de Morbilidad Hospitalaria. Todo el proyecto se desarrollará con herramientas open source y gratuitas. Tanto el código como el producto final serán accesibles de forma abierta.

En concreto, ofrece 3 grandes análisis con el fin de mejorar la planificación sanitaria:

o Descriptivos: recuento de las altas hospitalarias y serie temporal

o KPI: tasas e indicadores estandarizados para la comparación y el benchmarking de las provincias y comunidades.

o Flujos: recuento y análisis de las altas de una región hospitalaria y procedencia del paciente.

Todos los datos serán filtrables según las variables del juego de datos (edad, sexo, diagnósticos, circunstancia de ingreso y alta, etc.)

- Datos

Además de los microdatos de la Encuesta de Morbilidad Hospitalaria del INE, también integrará Estadísticas del Padrón Continuo (también del INE), datos de los catálogos de diagnósticos CIE10 del Ministerio de Sanidad y de los catálogos e indicadores de Agency for Healthcare Research and Quality (AHRQ) y de las Comunidades Autónomas, como Cataluña: catálogos y herramientas de estratificación.

TWINPLAN: Sistema de apoyo a la toma de decisión para rutas accesibles y saludables

- Equipo:

TWINPLAN, integrado por Ivan Araquistain, Josu Ansola e Iñaki Prieto.

- ¿En qué consiste?

Se trata de una web App para facilitar la accesibilidad de las personas con problemas de movilidad y promover el ejercicio saludable de toda la ciudadanía. La herramienta evalúa si su ruta está afectada por alguna incidencia en los ascensores públicos y, en caso afirmativo, propone una ruta accesible alternativa, indicando también el nivel de tráfico (ruido) en la zona, la calidad del aire y los puntos de cardioprotección. Así mismo, facilita el contacto de medios de transporte próximos.

Esta web App también podrá ser utilizada por las administraciones públicas para la monitorización del uso y planificación de nuevas infraestructuras accesibles.

- Datos

El prototipo se desarrollará utilizando datos del Gemelo Digital de los ascensores públicos de Ermua, aunque el modelo es escalable a otros territorios. Estos datos se complementan con otros datos públicos de Ermua como la red de sensores ambientales, tráfico y LurData, entre otras fuentes.

Ahora estas 10 propuestas cuentan con varios meses para desarrollar sus propuestas, que tendrán que presentar el 18 de octubre. Los tres prototipos mejor valorados por el jurado recibirán 5.000€, 4.000€ y 3.000€, respectivamente.

¡Mucha suerte a todos los finalistas!

(Puedes descargar la versión accesible en word aquí)

La vida digital ha llegado para incorporarse a nuestro día a día y con ella también nuevos hábitos de comunicación y consumo de información. Conceptos como realidad aumentada participan de forma activa en este proceso de cambio en el que cada vez más empresas y organismos están involucrados.

Diferencias entre realidad aumentada y virtual

A pesar de que la nomenclatura de estos conceptos guarda cierta similitud, en la práctica, hablamos de escenarios diferentes entre sí:

- Realidad virtual: Se trata de una experiencia digital que permite al usuario sumergirse en un mundo artificial donde puede experimentar matices sensoriales aislados de lo que sucede en su exterior.

- Realidad aumentada: Es una alternativa de visualización de datos que mejora la experiencia de usuario al incorporar elementos digitales a la realidad tangible. Es decir, permite añadir aspectos visuales sobre el entorno que nos rodea. Esto la hace especialmente interesante en el mundo de la visualización de datos, ya que permite superponer elementos gráficos a nuestra realidad. Para conseguirlo, lo más habitual es utilizar unas gafas especializadas. De forma paralela, la realidad aumentada también puede desarrollarse sin necesidad de recurrir a gadgets externos. Haciendo uso de la cámara de nuestro teléfono móvil, algunas aplicaciones son capaces de combinar la visualización de elementos reales presentes a nuestro alrededor con otros procesados digitalmente y que nos permiten interactuar con la realidad tangible.

En este artículo nos vamos a centrar en la realidad aumentada que se presenta como una fórmula eficaz para compartir, presentar y divulgar la información que contienen los conjuntos de datos.

Retos y oportunidades

El uso de herramientas de realidad aumentada es especialmente útil a la hora de distribuir y divulgar conocimiento de forma online. De esta forma, en lugar de compartir un conjunto de datos a través de texto y representaciones gráficas, la realidad aumentada permite explorar fórmulas divulgativas que facilitan la compresión desde el punto de vista de la experiencia de usuario.

Estas son algunas de las oportunidades asociadas a su empleo:

- A través de visualizaciones 3D, la realidad aumentada permite al usuario tener una experiencia inmersiva que facilita la toma de contacto y la interiorización de este tipo de información.

- Permite consultar información en tiempo real e interactuar con el entorno. La realidad aumentada permite que el usuario pueda interactuar con los datos en lugares remotos. Los datos pueden adaptarse, incluso en términos espaciales, a las necesidades y características del entorno. Esto es de especial utilidad en trabajos de campo, permitiendo que operarios que reparan averías o agricultores en medio de sus cultivos puedan acceder a la información actualizada que necesitan, de forma muy visual, combinada con el entorno.

- Es posible mostrar una mayor densidad de datos a la vez, algo que facilita el procesamiento cognitivo de la información. De este modo, la realidad aumentada ayuda a agilizar los procesos de comprensión y, por ende, nuestra capacidad para concebir nuevas realidades.

Ejemplo de visualización de datos de agricultura sobre el entorno

A pesar de estas ventajas, nos encontramos ante un mercado aun en desarrollo, que tiene que hacer frente a retos como los costes de implementación, la falta de estándares comunes o la preocupación de los usuarios por la seguridad.

Casos de Uso

Más allá de los retos, oportunidades y fortalezas, la realidad aumentada cobra aún más relevancia cuando las organizaciones la incorporan a su área de innovación para mejorar la experiencia de usuario o la eficiencia de procesos. Así, a través de los casos de uso, podemos comprender mejor el universo de utilidad que se esconde detrás de la realidad aumentada.

Un campo donde suponen una gran oportunidad es el turismo. Un ejemplo es Gijón en un clic, una aplicación móvil gratuita que pone al alcance de los visitantes 3 rutas. Durante los recorridos, se han instalado unas placas en el suelo desde donde los turistas pueden lanzar recreaciones de realidad aumentada con su propio teléfono móvil.

Desde el punto de vista de las empresas de hardware, podemos resaltar el ejemplo, entre un amplio listado, del prototipo de casco inteligente diseñado por la empresa Aegis Rider, que permite obtener información sin apartar la vista de la carretera. Este casco utiliza la realidad aumentada para proyectar a la altura de la mirada del motorista una serie de indicadores que le ayudarán a minimizar el riesgo de accidente.

Entre los datos proyectados destacan algunos que proceden de fuentes de datos abiertos como la información sobre el estado de las carreteras, el trazado de las mismas o la velocidad máxima de circulación. Además, utilizando un sistema basado en el reconocimiento de objetos y el deep learning, el casco de Aegis Rider también detecta objetos, animales, peatones u otros vehículos presentes en la calzada y que podrían suponer un riesgo de accidente al estar en la misma trayectoria.

Al margen de la seguridad vial, pero siguiendo con las posibilidades que ofrece la realidad aumentada, Accuvein utiliza la realidad aumentada para evitar que los pacientes crónicos, como los oncológicos, tengan que sufrir pinchazos fallidos a la hora de recibir su medicación. Para ello, Accuvein ha diseñado un escáner manual que proyecta la ubicación exacta de las distintas venas sobre la piel del paciente. Tal y como recogen sus propios desarrolladores, el nivel de acierto es 3,5 veces mayor respecto a un pinchazo tradicional.

Por otro lado, los ciudadanos de a pie pueden encontrarse también la realidad aumentada como material de apoyo informativo de noticias y reportajes. Medios de comunicación como The New York Times ofrecen, cada vez con más frecuencia, informaciones que utilizan la realidad aumentada para visualizar conjuntos de datos y facilitar su comprensión.

Herramientas para generar visualizaciones con realidad aumentada

Como hemos visto, la realidad aumentada también sirve para crear visualizaciones de datos que faciliten la comprensión de conjuntos de información que, a priori, pudiesen resultar abstractos. Para crear estas visualizaciones existen distintas herramientas, como por ejemplo Flow, cuya función es facilitar el trabajo de programadores y desarrolladores. Esta plataforma que muestra conjuntos de datos a través de la API del dispositivo WebXR permite a este tipo de profesionales cargar datos, crear visualizaciones y agregar pasos para la transición entre ellos. Otras herramientas son 3Data o Virtualitics. También compañías como IBM están entrando en el sector.

Por todo ello y al hilo de las evidencias que dejan casos como los anteriores, la realidad aumentada se posiciona como una de las tecnologías de visualización y transmisión de datos que han llegado para expandir aún más los límites de la sociedad del conocimiento en la que estamos inmersos.

Contenido elaborado por el equipo de datos.gob.es.

La primavera, además de la llegada del buen tiempo, nos ha traído gran cantidad de novedades relacionadas con el ecosistema open data y la compartición de datos. Durante los tres últimos meses han continuado los avances impulsados desde Europa, destacando dos iniciativas que actualmente se encuentran en fase de consulta pública:

- Avances en los espacios de datos. Se ha iniciado la tramitación de la primera iniciativa regulatoria de un espacio de datos. Esta primera propuesta se centra en los datos del sector salud y busca establecer un marco jurídico uniforme, facilitar el acceso electrónico de los pacientes a sus propios datos e impulsar su reutilización para otros fines secundarios. Actualmente se encuentra en fase de consulta pública hasta el 28 de julio.

- Impulso de los datos de alto valor. El concepto de datos de alto valor, recogido en la Directiva 2019/1024, hace referencia a aquellos datos cuya reutilización conlleva considerables beneficios para la sociedad, el medio ambiente y la economía. Aunque en dicha directiva se incluía una propuesta de categorías temáticas iniciales a considerar, actualmente se está trabajando en la creación de un listado más concreto. Este listado ya se ha hecho público y cualquier ciudadano que lo desee puede hacer comentarios sobre el mismo hasta el 24 de junio. En la misma línea, la Comisión Europea también ha sacado una serie de ayudas que buscan apoyar a las administraciones públicas a nivel local, regional y nacional con el fin de impulsar la disponibilidad, calidad y facilidad de uso de datos de alto valor.

Estas dos iniciativas ayudan a impulsar un ecosistema que en nuestro país no deja de crecer, como recogen estos ejemplos de noticias que hemos recopilado a lo largo de los últimos meses.

Ejemplos de reutilización de datos abiertos

En esta estación también hemos conocido distintos proyectos que ponen de manifiesto las ventajas del uso de los datos:

- Gracias al uso de Datos Abiertos Enlazados (Linked Open Data) un profesor de la Universidad de Valladolid ha creado la aplicación web LOD4Culture. Esta app permite explorar el patrimonio cultural mundial a partir de las bases de datos semánticas de dbpedia y wikidata.

- La Universidad de Zaragoza ha lanzado sensoriZAR para controlar la calidad del aire y reducir el consumo energético de sus espacios. Construida sobre IoT, datos abiertos y ciencia abierta, la solución está enfocada a la toma de decisiones basadas en datos.

- El Hospital de Villalba ha creado un mapa de riesgo cardiovascular en la Sierra de Madrid gracias al Big Data. El mapa recoge datos clínicos y demográficos de los pacientes para informar sobre la probabilidad de desarrollar una enfermedad de este tipo en el futuro.

- El Laboratorio de Gobierno Abierto de Aragón ha presentado recientemente "RADAR", una aplicación que ofrece información georeferenciada sobre las iniciativas en el ámbito rural.

Acuerdos para impulsar los datos abiertos

El compromiso de los organismos públicos con los datos abiertos queda patente en diversos acuerdos y planes que se han puesto en marcha en los últimos meses:

- El 13 de abril, los alcaldes de Madrid y Málaga sellaron dos acuerdos de colaboración para potenciar en conjunto la transformación digital y el crecimiento turístico en ambas ciudades. Gracias a ellos, se podrán adoptar políticas de seguridad y protección de datos, datos abiertos y Big Data, entre otros.

- El Govern de les Illes Balears y Asedie colaborarán para implementar medidas de datos abiertos, transparencia y reutilización de datos públicos. Así se recoge en un acuerdo que busca impulsar la colaboración público-privada y el desarrollo de soluciones comerciales, entre otros.