Menosdeluz.com es una web que permite a los usuarios encontrar información sobre el mercado eléctrico. Ofrece información sobre el precio de la luz de cada día y cada hora, evolución del precio del tope de gas y sobre energía solara. En la web, se alojan también tres comparadores de tarifas de luz que leyendo una factura busca en segundos la mejor tarifa de luz comercial para el usuario. La aplicación permite también realizar un análisis de potencia para ayudar al usuario a identificar la posibilidad de ahorrar ajustando la potencia a su uso diario. El uso de las aplicaciones de menosdeluz.com es gratuito.

La crisis humanitaria que se originó tras el terremoto de Haití en 2010 fue el punto de partida de una iniciativa voluntaria para crear mapas que identificaran el nivel de daño y vulnerabilidad por zonas, y así, poder coordinar los equipos de emergencia. Desde entonces, el proyecto de mapeo colaborativo conocido como Hot OSM (OpenStreetMap) realiza una labor clave en situaciones de crisis y desastres naturales.

Ahora, la organización ha evolucionado hasta convertirse en una red global de voluntarios que aportan sus habilidades de creación de mapas en línea para ayudar en situaciones de crisis por todo el mundo. La iniciativa es un ejemplo de colaboración en torno a los datos para resolver problemas de la sociedad, tema que desarrollamos en este informe de datos.gob.es.

Hot OSM trabaja para acelerar la colaboración con organizaciones humanitarias y gubernamentales en torno a los datos, así como con comunidades locales y voluntarios de todo el mundo, para proporcionar mapas precisos y detallados de áreas afectadas por desastres naturales o crisis humanitarias. Estos mapas se utilizan para ayudar a coordinar la respuesta de emergencia, identificar necesidades y planificar la recuperación.

En su trabajo, Hot OSM prioriza la colaboración y el empoderamiento de las comunidades locales. La organización trabaja para garantizar que las personas que viven en las áreas afectadas tengan voz y poder en el proceso de mapeo. Esto significa que Hot OSM trabaja en estrecha colaboración con las comunidades locales para asegurarse de que se mapeen áreas importantes para ellos. De esta manera, se tienen en cuenta las necesidades de las comunidades a la hora de planificar respuesta de emergencia y la recuperación.

Labor didáctica de Hot OSM

Además de su trabajo en situaciones de crisis, Hot OSM dedica esfuerzos a la promoción del acceso a datos geoespaciales abiertos y libres, y trabaja en colaboración con otras organizaciones para construir herramientas y tecnologías que permitan a las comunidades de todo el mundo aprovechar el poder del mapeo colaborativo.

A través de su plataforma en línea, Hot OSM proporciona acceso gratuito a una amplia gama de herramientas y recursos para ayudar a los voluntarios a aprender y participar en la creación de mapas colaborativos. La organización también ofrece capacitación para aquellos interesados en contribuir a su trabajo.

Un ejemplo de proyecto de HOT es el trabajo que la organización realizó en el contexto del ébola en África Occidental. En 2014, un brote de ébola afectó a varios países de África Occidental, incluidos Sierra Leona, Liberia y Guinea. La falta de mapas precisos y detallados en estas áreas dificultó la coordinación de la respuesta de emergencia.

En respuesta a esta necesidad, HOT inició un proyecto de mapeo colaborativo que involucró a más de 3.000 voluntarios en todo el mundo. Los voluntarios utilizaron herramientas en línea para mapear áreas afectadas por el ébola, incluidas carreteras, pueblos y centros de tratamiento.

Este mapeo permitió a los trabajadores humanitarios coordinar mejor la respuesta de emergencia, identificar áreas de alto riesgo y priorizar la asignación de recursos. Además, el proyecto también ayudó a las comunidades locales a comprender mejor la situación y a participar en la respuesta de emergencia.

Este caso en África Occidental es solo un ejemplo del trabajo que HOT realiza en todo el mundo para ayudar en situaciones de crisis humanitarias. La organización ha trabajado en una variedad de contextos, incluidos terremotos, inundaciones y conflictos armados, y ha ayudado a proporcionar mapas precisos y detallados para la respuesta de emergencia en cada uno de estos contextos.

Por otro lado, la plataforma también está involucrada en zonas en las que no hay cobertura de mapas, como en muchos países africanos. En estas zonas los proyectos de ayuda humanitaria muchas veces tienen un gran reto en las primeras fases, ya que es muy difícil cuantificar qué población vive en una zona y donde está emplazada. Poder tener la ubicación esas personas y que muestre vías de acceso las “pone en el mapa” y permite que puedan llegar a acceder a los recursos.

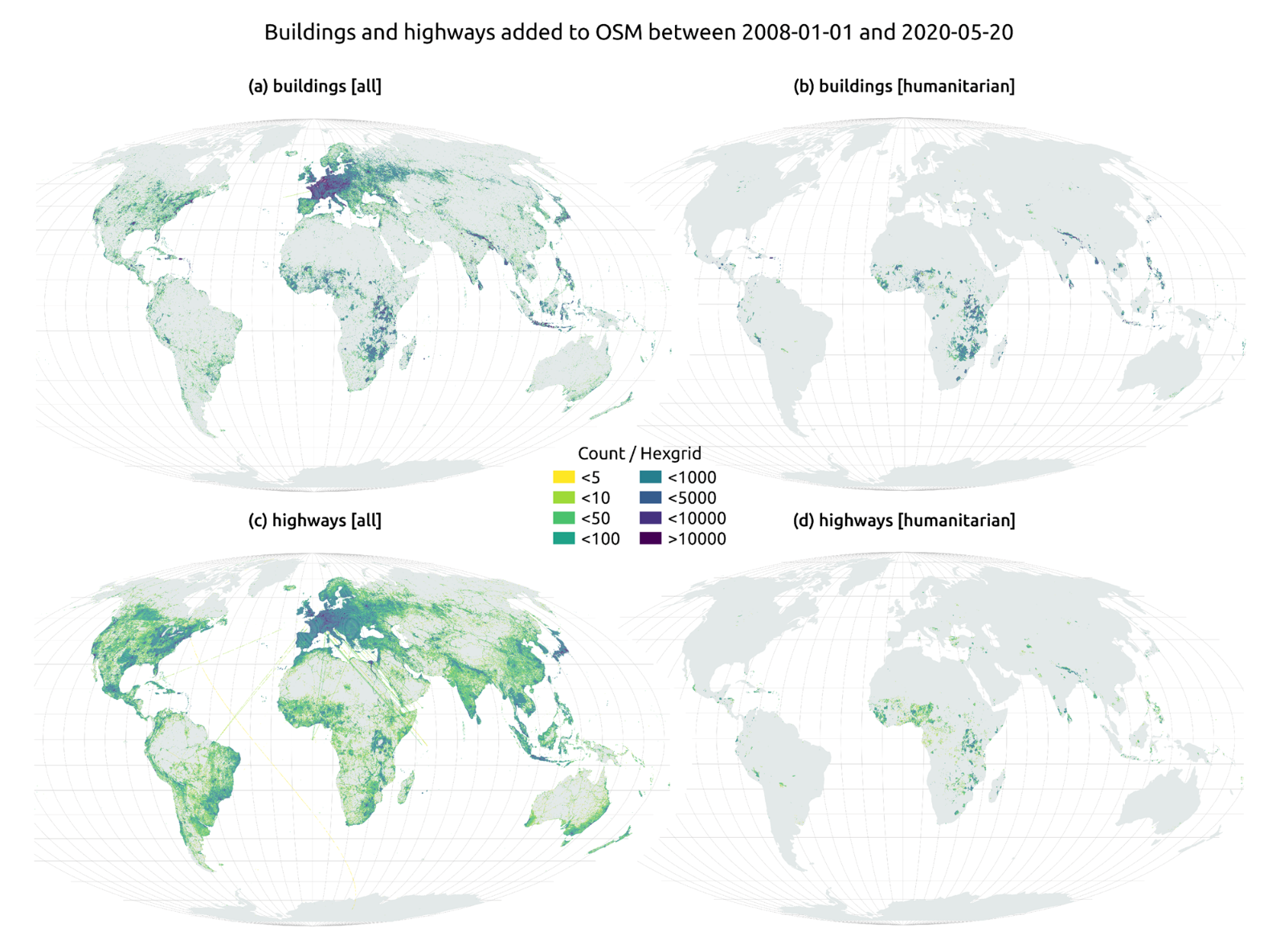

En el artículo The evolution of humanitarian mapping within the OpenStreetMap community de Nature, podemos ver gráficamente algunos de los logros de la plataforma.

Como colaborar

Empezar a colaborar con Hot OSM es fácil, basta con ir a la página https://tasks.hotosm.org/explore y ver los proyectos abiertos que necesitan colaboración.

Esta pantalla nos permite una gran cantidad de opciones a la hora de buscar los proyectos, seleccionado por nivel de dificultad, organización, ubicación o intereses entre otros.

Para participar, basta con pulsar el botón Registrese.

Dar un nombre y un e-mail y en la siguiente pantalla:

Nos preguntará si tenemos creada una cuenta en Open Street Maps o queremos crear una.

Si queremos ver más en detalle el proceso, esta página nos lo pone muy fácil.

Una vez creado el usuario, en la página aprender encontramos ayuda de cómo participar en el proyecto.

Es importante destacar que las contribuciones de los voluntarios se revisan y validan y existe un segundo nivel de voluntarios, los validadores, que dan por bueno el trabajo de los principiantes. Durante el desarrollo de la herramienta, el equipo de HOT ha cuidado mucho que sea una aplicación sencilla de utilizar para no limitar su uso a personas con conocimientos informáticos.

Además, organizaciones como Cruz Roja o Naciones unidas organizan regularmente mapatones con el objetivo de reunir grupos de personas para proyectos específicos o enseñar a nuevos voluntarios el uso de la herramienta. Estas reuniones sirven, sobre todo, para quitar el miedo de los nuevos usuarios a “romper algo” y para que puedan ver cómo su labor de voluntariado sirve para cosas concretas y ayuda a otras personas.

Otra de las grandes fortalezas del proyecto es que está basado en software libre y permite la reutilización del mismo. En el repositorio Github del proyecto MissingMaps podemos encontrar el código y si queremos crear una comunidad basada en el software, la organización Missing Maps nos facilita el proceso y dará visibilidad a nuestro grupo.

En definitiva, Hot OSM es un proyecto de ciencia ciudadana y altruismo de datos que contribuye a aportar beneficios a la sociedad mediante la elaboración de mapas colaborativos muy útiles en situaciones de emergencia. Este tipo de iniciativas están alineadas con el concepto europeo de gobernanza de datos que busca impulsar el altruismo para facilitar voluntariamente el uso de los datos para el bien común.

Contenido elaborado por Santiago Mota, senior data scientist.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Portal web con diversos cuadros de mandos interactivos de acceso libre dedicado a la gobernanza climática.

La aplicación agrupa ocho conjuntos de datos del portal de datos del Gobierno de Canarias, MITECO, ITC, ISTAC y GRAFCAN:

1. Inventario de emisiones

2. Huella de carbono

3. Contaminantes emitidos a la atmósfera

4. Incendios forestales

5. Proyecciones climáticas

6. PIMA

7. Producción de energía en Canarias

8. Producción neta de electricidad

1. Introducción

Las visualizaciones son representaciones gráficas de datos que permiten comunicar de manera sencilla y efectiva la información ligada a los mismos. Las posibilidades de visualización son muy amplias, desde representaciones básicas, como puede ser un gráfico de líneas, barras o sectores, hasta visualizaciones configuradas sobre cuadros de mando o dashboards interactivos.

En esta sección de “Visualizaciones paso a paso” estamos presentando periódicamente ejercicios prácticos de visualizaciones de datos abiertos disponibles en datos.gob.es u otros catálogos similares. En ellos se abordan y describen de manera sencilla las etapas necesarias para obtener los datos, realizar las transformaciones y análisis que resulten pertinentes para, finalmente, la creación de visualizaciones interactivas, de las que podemos extraer información resumida en unas conclusiones finales. En cada uno de estos ejercicios prácticos, se utilizan sencillos desarrollos de código convenientemente documentados, así como herramientas de uso gratuito. Todo el material generado está disponible para su reutilización en el repositorio Laboratorio de datos de GitHub.

A continuación, puedes acceder al material que utilizaremos en el ejercicio y que iremos explicando y desarrollando en los siguientes apartados de este post.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

2. Objetivo

El objetivo principal de este ejercicio es hacer un análisis de los datos meteorológicos recogidos en varias estaciones durante los últimos años. Para realizar este análisis utilizaremos distintas visualizaciones generadas mediante la librería “ggplot2” del lenguaje de programación “R”

De todas las estaciones meteorológicas españolas, hemos decidido analizar dos de ellas, una en la provincia más fría del país (Burgos) y otra en la provincia más cálida del país (Córdoba), según los datos de la AEMET. Se buscarán patrones y tendencias en los distintos registros entre los años 1990 y 2020 con el objetivo de entender la evolución meteorológica sufrida en este periodo de tiempo.

Una vez analizados los datos, podremos contestar a preguntas como las que se muestran a continuación:

-

¿Cuál es la tendencia en la evolución de las temperaturas en los últimos años?

-

¿Cuál es la tendencia en la evolución de las precipitaciones en los últimos años?

-

¿Qué estación meteorológica (Burgos o Córdoba) presenta una mayor variación de los datos climatológicos en estos últimos años?

-

¿Qué grado de correlación hay entre las distintas variables climatológicas registradas?

Estas, y muchas otras preguntas pueden ser resueltas mediante el uso de herramientas como ggplot2 que facilitan la interpretación de los datos mediante visualizaciones interactivas.

3. Recursos

3.1. Conjuntos de datos

Los conjuntos de datos contienen distinta información meteorológica de interés para las dos estaciones en cuestión desglosada por año. Dentro del centro de descargas de la AEMET, podremos descárgalos, previa solicitud de la clave API, en el apartado “climatologías mensuales/anuales”. De las estaciones meteorológicas existentes, hemos seleccionado dos de las que obtendremos los datos: Burgos aeropuerto (2331) y Córdoba aeropuerto (5402)

Cabe destacar, que, junto a los conjuntos de datos, también podremos descargar sus metadatos, los cuales son de especial importancia a la hora de identificar las distintas variables registradas en los conjuntos de datos.

Estos conjuntos de datos también se encuentran disponibles en el repositorio de Github

3.2. Herramientas

Para la realización de las tareas de preprocesado de los datos se ha utilizado el lenguaje de programación R escrito sobre un Notebook de Jupyter alojado en el servicio en la nube de Google Colab.

"Google Colab" o, también llamado Google Colaboratory, es un servicio en la nube de Google Research que permite programar, ejecutar y compartir código escrito en Python o R sobre un Jupyter Notebook desde tu navegador, por lo que no requiere configuración. Este servicio es gratuito.

Para la creación de las visualizaciones se ha usado la librería ggplot2.

"ggplot2" es un paquete de visualización de datos para el lenguaje de programación R. Se centra en la construcción de gráficos a partir de capas de elementos estéticos, geométricos y estadísticos. ggplot2 ofrece una amplia gama de gráficos estadísticos de alta calidad, incluyendo gráficos de barras, gráficos de líneas, diagramas de dispersión, gráficos de caja y bigotes, y muchos otros

Si quieres conocer más sobre herramientas que puedan ayudarte en el tratamiento y la visualización de datos, puedes recurrir al informe "Herramientas de procesado y visualización de datos".

4. Tratamiento o preparación de los datos

Los procesos que te describimos a continuación los encontrarás comentados en el Notebook que también podrás ejecutar desde Google Colab.

Antes de lanzarnos a construir una visualización efectiva, debemos realizar un tratamiento previo de los datos, prestando especial atención a la obtención de los mismos y validando su contenido, asegurando que se encuentran en el formato adecuado y consistente para su procesamiento y que no contienen errores.

Como primer paso del proceso, una vez importadas las librerías necesarias y cargados los conjuntos de datos, es necesario realizar un análisis exploratorio de los datos (EDA) con el fin de interpretar adecuadamente los datos de partida, detectar anomalías, datos ausentes o errores que pudieran afectar a la calidad de los procesos posteriores y resultados. Si quieres conocer más sobre este proceso puedes recurrir a la Guía Práctica de Introducción al Análisis Exploratorio de Datos.

El siguiente paso a dar es generar las tablas de datos preprocesadas que usaremos en las visualizaciones. Para ello, filtraremos los conjuntos de datos iniciales y calcularemos los valores que sean necesarios y de interés para el análisis realizado en este ejercicio.

Una vez terminado el preprocesamiento, obtendremos las tablas de datos “datos_graficas_C” y “datos_graficas_B” las cuales utilizaremos en el siguiente apartado del Notebook para generar las visualizaciones.

La estructura del Notebook en la que se realizan los pasos previamente descritos junto a comentarios explicativos de cada uno de ellos, es la siguiente:

- Instalación y carga de librerías

- Carga de los conjuntos de datos

- Análisis exploratorio de datos (EDA)

- Preparación de las tablas de datos

- Visualizaciones

- Guardado de gráficos

Podrás reproducir este análisis, ya que el código fuente está disponible en nuestra cuenta de GitHub. La forma de proporcionar el código es a través de un documento realizado sobre un Jupyter Notebook que una vez cargado en el entorno de desarrollo podrás ejecutar o modificar de manera sencilla. Debido al carácter divulgativo de este post y de cara a favorecer el entendimiento de los lectores no especializados, el código no pretende ser el más eficiente, sino facilitar su comprensión por lo que posiblemente se te ocurrirán muchas formas de optimizar el código propuesto para lograr fines similares. ¡Te animamos a que lo hagas!

5. Visualizaciones

Diversos tipos de visualizaciones y gráficos se han realizado con la finalidad de extraer información sobre las tablas de datos preprocesadas y responder a las preguntas iniciales planteadas en este ejercicio. Como se ha mencionado previamente, se ha utilizado el paquete “ggplot2” de R para realizar las visualizaciones.

El paquete "ggplot2" es una biblioteca de visualización de datos en el lenguaje de programación R. Fue desarrollado por Hadley Wickham y es parte del conjunto de herramientas del paquete "tidyverse". El paquete "ggplot2" está construido en torno al concepto de "gramática de gráficos", que es un marco teórico para construir gráficos mediante la combinación de elementos básicos de la visualización de datos como capas, escalas, leyendas, anotaciones y temas. Esto permite crear visualizaciones de datos complejas y personalizadas, con un código más limpio y estructurado.

Si quieres tener una visión a modo resumen de las posibilidades de visualizaciones con ggplot2, consulta la siguiente “cheatsheet”. También puedes obtener información más en detalle en el siguiente "manual de uso".

5.1. Gráficos de líneas

Los gráficos de líneas son una representación gráfica de datos que utiliza puntos conectados por líneas para mostrar la evolución de una variable en una dimensión continua, como el tiempo. Los valores de la variable se representan en el eje vertical y la dimensión continua en el eje horizontal. Los gráficos de líneas son útiles para visualizar tendencias, comparar evoluciones y detectar patrones.

A continuación, podemos visualizar varios gráficos de líneas con la evolución temporal de los valores de temperaturas medias, mínimas y máximas de las dos estaciones meteorológicas analizadas (Córdoba y Burgos). Sobre estos gráficos, hemos introducido líneas de tendencia para poder observar de forma visual y sencilla su evolución.

Para poder comparar las evoluciones, no solamente de manera visual mediante las líneas de tendencia graficadas, sino también de manera numérica, obtenemos los coeficientes de pendiente de la recta de tendencia, es decir, el cambio en la variable respuesta (tm_ mes, tm_min, tm_max) por cada unidad de cambio en la variable predictora (año).

-

Coeficiente de pendiente temperatura media Córdoba: 0.036

-

Coeficiente de pendiente temperatura media Burgos: 0.025

-

Coeficiente de pendiente temperatura mínima Córdoba: 0.020

-

Coeficiente de pendiente temperatura mínima Burgos: 0.020

-

Coeficiente de pendiente temperatura máxima Córdoba: 0.051

-

Coeficiente de pendiente temperatura máxima Burgos: 0.030

Podemos interpretar que cuanto mayor es este valor, más abrupta es la subida de temperatura media en cada periodo observado.

Por últimos, hemos creado un gráfico de líneas para cada estación meteorológica, en el que visualizamos de forma conjunta la evolución de las temperaturas medias, mínimas y máximas a lo largo de los años.

Las principales conclusiones obtenidas de las visualizaciones de este apartado son:

-

Las temperaturas medias, mínimas y máximas anuales registradas en Córdoba y Burgos tienen una tendencia en aumento.

-

El aumento más significativo se observa en la evolución de las temperaturas máximas de Córdoba (coeficiente de pendiente = 0.051)

-

El aumento más tenue se observa en la evolución de las temperaturas mínimas, tanto de Córdoba cómo de Burgos (coeficiente de pendiente = 0.020)

5.2. Gráficos de barras

Los gráficos de barras son una representación gráfica de datos que utiliza barras rectangulares para mostrar la magnitud de una variable en diferentes categorías o grupos. La altura o longitud de las barras representa la cantidad o frecuencia de la variable y las categorías se representan en el eje horizontal. Los gráficos de barras son útiles para comparar la magnitud de diferentes categorías y para visualizar diferencias entre ellas.

Hemos generado dos gráficos de barras con los datos correspondientes a la precipitación total acumulada por año para las distintas estaciones meteorológicas.

Al igual que en el apartado anterior, graficamos la línea de tendencia y calculamos el coeficiente de pendiente.

-

Coeficiente de pendiente precipitaciones acumuladas Córdoba: -2.97

-

Coeficiente de pendiente precipitaciones acumuladas Burgos: -0.36

Las principales conclusiones obtenidas de las visualizaciones de este apartado son:

-

Las precipitaciones acumuladas anuales tienen una tendencia en descenso tanto para Córdoba como para Burgos.

-

La tendencia de descenso es mayor para Córdoba (coeficiente = -2.97), siendo más moderada para Burgos (coeficiente = -0.36)

5.3. Histogramas

Los histogramas son una representación gráfica de una distribución de frecuencia de datos numéricos en un intervalo de valores. El eje horizontal representa los valores de los datos divididos en intervalos, llamados "bin", y el eje vertical representa la frecuencia o la cantidad de datos que se encuentran en cada "bin". Los histogramas son útiles para identificar patrones en los datos, como su distribución, dispersión, simetría o sesgo.

Hemos generado dos histogramas con las distribuciones de los datos correspondientes a la precipitación total acumulada por año para las distintas estaciones meteorológicas, siendo los intervalos elegidos de 50 mm3.

Las principales conclusiones obtenidas de las visualizaciones de este apartado son:

-

Los registros de precipitación acumulada anual en Burgos presentan una distribución cercana a una distribución normal y simétrica.

-

Los registros de precipitación acumulada anual en Córdoba no presentan una distribución simétrica.

5.4. Diagramas de cajas y bigotes

Los diagramas de cajas y bigotes, son una representación gráfica de la distribución de un conjunto de datos numéricos. Estos gráficos representan la mediana, el rango intercuartílico y los valores mínimo y máximo de los datos. La caja del gráfico representa el rango intercuartílico, es decir, el rango entre el primer y tercer cuartil de los datos. Los puntos fuera de la caja, llamados valores atípicos, pueden indicar valores extremos o datos anómalos. Los diagramas de cajas son útiles para comparar distribuciones y detectar valores extremos en los datos.

Hemos generado un gráfico con los diagramas de cajas correspondientes a los datos de precipitaciones acumuladas de las estaciones meteorológicas.

De cara a entender el gráfico, hay que destacar los siguientes puntos:

-

Los límites de la caja indican el primer y el tercer cuartil (Q1 y Q3), que dejan por debajo de cada uno, el 25% y el 75% de los datos respectivamente.

-

La línea horizontal dentro de la caja es la mediana (equivalente al segundo cuartil Q2), que deja por debajo la mitad de los datos.

-

Los límites de los bigotes son los valores extremos, es decir, el valor mínimo y el valor máximo de la serie de datos.

-

Los puntos fuera de los bigotes son los valores atípicos (outliers)

Las principales conclusiones obtenidas de la visualización de este apartado son:

-

Ambas distribuciones presentan 3 valores extremos, siendo significativos los de Córdoba con valores superiores a 1000 mm3.

-

Los registros de Córdoba tienen una mayor variabilidad que los de Burgos, los cuales se presentan más estables.

5.5. Gráficos de sectores

Un gráfico de sectores es un tipo de gráfico circular que representa proporciones o porcentajes de un todo. Se compone de varias secciones o sectores, donde cada sector representa una proporción de la totalidad del conjunto. El tamaño del sector se determina en función de la proporción que representa, y se expresa en forma de ángulo o porcentaje. Es una herramienta útil para visualizar la distribución relativa de las diferentes partes de un conjunto y facilita la comparación visual de las proporciones entre los distintos grupos.

Hemos generamos dos gráficos de sectores (polares). El primero de ellos con el número de días que los valores superan los 30º en Córdoba y el segundo de ellos con el número de días que los valores bajan de los 0º en Burgos.

Para la realización de estos gráficos, hemos agrupado la suma del número de días anteriormente descrito en seis grupos, correspondientes a periodos de 5 años desde 1990 hasta el 2020.

Las principales conclusiones obtenidas de las visualizaciones de este apartado son:

-

Se da un aumento del 31,9% en el total de días anuales con temperaturas superiores a 30º en Córdoba para el periodo comprendido entre el 2015-2020 respecto al periodo 1990-1995.

-

Se da un aumento del 33,5% en el total de días anuales con temperaturas superiores a 30º en Burgos para el periodo comprendido entre el 2015-2020 respecto al periodo 1990-1995.

5.6. Gráficos de dispersión

Los gráficos de dispersión son una herramienta de visualización de datos que representan la relación entre dos variables numéricas mediante la ubicación de puntos en un plano cartesiano. Cada punto representa un par de valores de las dos variables y su posición en el gráfico indica cómo se relacionan entre sí. Los gráficos de dispersión se utilizan comúnmente para identificar patrones y tendencias en los datos, así como para detectar cualquier posible correlación entre las variables. Estos gráficos también pueden ayudar a identificar valores atípicos o datos que no encajan con la tendencia general.

Hemos generado dos gráficas de dispersión en las que se comparan los valores de temperaturas medias máximas y medias mínimas buscando tendencias de correlación entre ambas para los valores cada estación meteorológica.

Para poder analizar las correlaciones, no solamente de manera visual mediante las gráficas, sino también de manera numérica, obtenemos los coeficientes de correlación de Pearson. Este coeficiente es una medida estadística que indica el grado de asociación lineal entre dos variables cuantitativas. Se utiliza para evaluar si existe una relación lineal positiva (ambas variables aumentan o disminuyen simultáneamente a un ritmo constante), negativa (los valores de ambas variables varían de forma contraria) o nula (sin relación) entre dos variables y la fortaleza de dicha relación, cuanto más cerca de +1, más alta es su asociación.

-

Coeficiente de Pearson (Temperatura media max VS min) Córdoba: 0.15

-

Coeficiente de Pearson (Temperatura media max VS min) Burgos: 0.61

En la imagen observamos que mientras en Córdoba se aprecia una mayor dispersión, en Burgos se observa una mayor correlación.

A continuación, modificaremos las gráficas de dispersión anteriores para que nos aporten más información de forma visual. Para ello dividimos el espacio por sectores de colores (rojo con valores de temperatura más altos/ azul valores de temperatura más bajos) y mostramos en las distintas burbujas la etiqueta con el año correspondiente. Cabe destacar que los límites de cambio de color de los cuadrantes corresponden con los valores medios de cada una de las variables.

Las principales conclusiones obtenidas de las visualizaciones de este apartado son:

-

Existe una relación lineal positiva entre la temperatura media máxima y mínima tanto en Córdoba como en Burgos, siendo mayor esta correlación en los datos de Burgos.

-

Los años que presentan valores más elevados de temperaturas máximas y mínimas en Burgos son (2003, 2006 y 2020)

-

Los años que presentan valores más elevados de temperaturas máximas y mínimas en Córdoba son (1995, 2006 y 2020)

5.7. Matriz de correlación

La matriz de correlación es una tabla que muestra las correlaciones entre todas las variables en un conjunto de datos. Es una matriz cuadrada que muestra la correlación entre cada par de variables en una escala que va de -1 a 1. Un valor de -1 indica una correlación negativa perfecta, un valor de 0 indica que no hay correlación y un valor de 1 indica una correlación positiva perfecta. La matriz de correlación se utiliza comúnmente para identificar patrones y relaciones entre variables en un conjunto de datos, lo que puede ayudar a comprender mejor los factores que influyen en un fenómeno o resultado.

Hemos generado dos mapas de calor con los datos de las matrices de correlación para ambas estaciones meteorológicas.

Las principales conclusiones obtenidas de las visualizaciones de este apartado son:

-

Existe una fuerte correlación negativa (- 0.42) para Córdoba y (-0.45) para Burgos entre el número de días anuales con temperaturas superiores a 30º y las precipitaciones acumuladas. Esto quiere decir que conforme aumenta el número de días con temperaturas superiores a 30º disminuyen notablemente las precipitaciones.

6. Conclusiones del ejercicio

La visualización de datos es uno de los mecanismos más potentes para explotar y analizar el significado implícito de los datos. Como hemos observado en este ejercicio, "ggplot2" se trata de una potente librería capaz de representar una grán variedad de gráficos con un alto grado de personalización que permite ajustar numerosas caracteristicas propias de cada gráfico.

Una vez analizadas las visualizaciones anteriores, podemos concluir que tanto para la estación meteorológica de Burgos, como la de Córdoba, las temperaturas (mínimas, medias, máximas) han sufrido un aumento considerable, los días con calor extremo ( Tº > 30º) también lo han sufrido y las precipitaciones han disminuido en el periodo de tiempo analizado, desde 1990 hasta el 2020.

Esperemos que esta visualización paso a paso te haya resultado útil para el aprendizaje de algunas técnicas muy habituales en el tratamiento, representación e interpretación de datos abiertos. Volveremos para mostraros nuevas reutilizaciones. ¡Hasta pronto!

Urban3r es una aplicación que permite visualizar diferentes indicadores sobre el estado actual de la edificación, los datos de demanda energética de los edificios residenciales en su estado actual y tras someterlos a una rehabilitación energética, así como los costes estimados de estas intervenciones.

Para facilitar la toma de decisiones a escala urbana, la herramienta permite filtrar por temáticas de estudio específicas y consultar los datos individualmente a escala de edificio. A este nivel hay que tener en cuenta que se trata de una primera aproximación orientativa.

Para las personas registradas, la herramienta dispone de un sistema de descarga de datos en formato CSV y GeoPackage de aquellos municipios de España de los que dispone de información. Los municipios de los que no tiene información, pueden ser procesados automáticamente mediante la subida del fichero urbano en formato CAT disponible en la Sede Electrónica del Catastro.

La información relacionada con la rehabilitación energética de los edificios procede de una aplicación a escala de referencia catastral de los datos elaborados en el marco de la ERESEE 2020 (Estrategia a largo plazo para la rehabilitación energética en el sector de la edificación en España).

En definitiva, es una plataforma de datos abiertos para impulsar la regeneración urbana en España que utiliza los conjuntos de datos de la Sede Electrónica del Catastro y permite la descarga de los datos por municipio en formato CSV.

El Sistema de Observación Meteorológica del Gobierno de Canarias es una infraestructura promovida por la Consejería de Transición Ecológica, Lucha contra el Cambio Climático y Planificación Territorial, que integra una red de estaciones equipadas con sensores meteorológicos y servidores encargados de la administración de la red y el almacenamiento, control de calidad y difusión de los datos registrados.

Se trata de una red que se concibe como una infraestructura complementaria a las ya existentes y esencial para el ejercicio de competencias como las relacionadas con el Cambio Climático o el seguimiento de Fenómenos Meteorológicas Adversos (FMA).

Conforme a la Directiva (UE) 2019/1024, este sistema gestiona un conjunto de datos de alto valor que está disponible para su reutilización. Por ello, desde su web es posible realizar los siguientes servicios:

- Consultar la ubicación de las estaciones y los últimos datos registrados.

- Descargar las series históricas de observaciones registradas por las estaciones en datos abiertos.

- Visualizar en tiempo real las observaciones registradas por las estaciones meteorológicas.

- Integrar, mediante una API, los datos registrados en cualquier sistema.

Actualizado: 21/03/2024

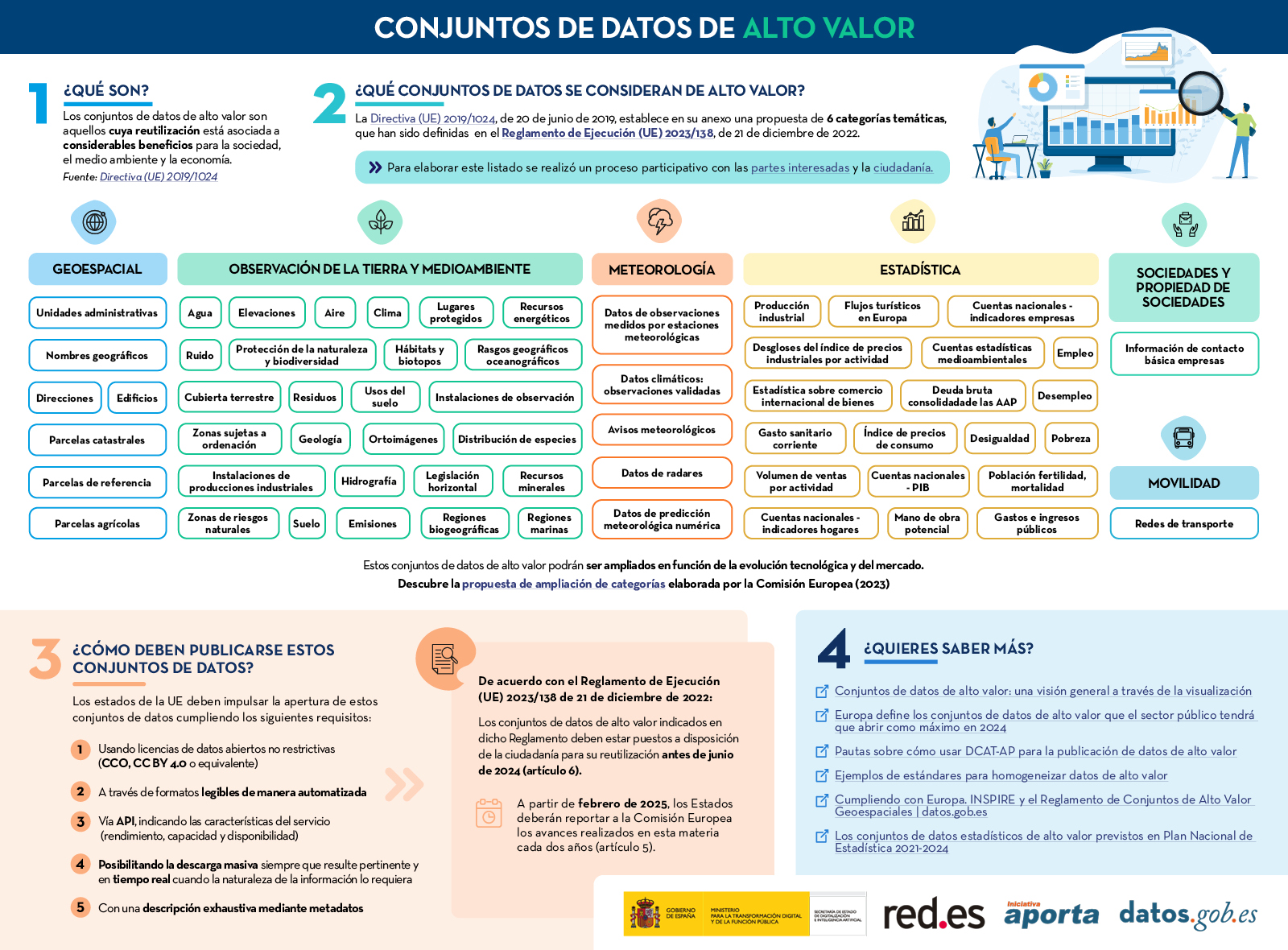

En enero de 2023, la Comisión Europea publicó un listado de conjuntos de datos de alto valor que los organismos del sector público deberían poner a disposición de la ciudadanía en un plazo máximo de 16 meses. El principal objetivo de establecer la lista de conjuntos de datos de alto valor es garantizar que los datos públicos de mayor potencial socioeconómico se pongan a disposición para su reutilización con una restricción jurídica y técnica mínima, y sin coste alguno. Dentro de estos conjuntos de datos del sector público, algunos como los meteorológicos o los relativos a la calidad del aire, resultan especialmente interesantes para desarrolladores y creadores de servicios como aplicaciones o páginas webs, que reportan valor añadido e importantes beneficios para la sociedad, el medioambiente o la economía.

La publicación del Reglamento se acompañó de unas preguntas frecuentes para ayudar a los organismos públicos a entender el beneficio de los HVDS (High Value Datasets) en la sociedad y la economía, así como para explicar algunos aspectos sobre la obligatoriedad y las ayudas para la publicación.

En línea con esta propuesta, la Vicepresidenta Ejecutiva para una Europa adaptada a la era digital, Margrethe Vestager, declaró lo siguiente en la nota de prensa lanzada por la Comisión Europea:

“Poner a disposición del público conjuntos de datos de gran valor beneficiará tanto a la economía como a la sociedad, por ejemplo, ayudando a combatir el cambio climático, reduciendo la contaminación atmosférica urbana y mejorando las infraestructuras de transporte. Se trata de un paso práctico hacia el éxito de la Década Digital y la construcción de un futuro digital más próspero”.

De forma paralela, Thierry Breton, Comisario de Mercado Interior, quiso añadir también las siguientes palabras a colación del anuncio del listado de los datos de alto valor: “Los datos son una piedra angular de nuestra competitividad industrial en la UE. Con la nueva lista de conjuntos de datos de alto valor estamos desbloqueando una gran cantidad de datos públicos en beneficio de todos. Las nuevas empresas y las pymes podrán utilizar estos para desarrollar nuevos productos y soluciones innovadoras que mejoren la vida de los ciudadanos de la UE y de todo el mundo”.

Seis categorías para aglutinar los nuevos conjuntos de datos de alto valor

De este modo, el reglamento se crea al amparo de la Directiva Europea de Datos Abiertos, que define seis categorías para diferenciar los nuevos conjuntos de datos de alto valor solicitados:

- Geoespaciales

- De observación de la Tierra y medioambiente

- Meteorológicos

- Estadísticos

- De empresas

- De movilidad

No obstante, tal y como recoge la nota de prensa de la Comisión Europea, esta gama temática podría ampliarse posteriormente en función de la evolución de la tecnología y el mercado. Así, los conjuntos de datos estarán disponibles en formato legible por máquina, a través de una interfaz de programación de aplicaciones (API) y, si fuera relevante, también con opción de descarga masiva.

Además, la reutilización de conjuntos de datos como los de movilidad o geolocalización de edificios puede ampliar las oportunidades de negocio disponibles para sectores como la logística o el transporte. De forma paralela, los datos de observación meteorológica, de radar, de calidad del aire o de contaminación del suelo también pueden apoyar la investigación y la innovación digital, así como la elaboración de políticas en la lucha contra el cambio climático.

En definitiva, una mayor disponibilidad de datos y, en especial de alto valor, tiene la capacidad de impulsar el espíritu empresarial ya que estos conjuntos de datos pueden ser un recurso importante para que las pymes desarrollen nuevos productos y servicios digitales, lo que a su vez también puede atraer nuevos inversores.

Descubre más en esta infografía:

Digital Earth Solutions es una empresa tecnológica cuyo objetivo es contribuir a la conservación de los ecosistemas marinos mediante soluciones innovadoras de modelización oceánica.

Basados en más de 20 años de estudio del CSIC en dinámica oceánica, Digital Solutions ha desarrollado un software único capaz de predecir en pocos minutos y con alta precisión la evolución geográfica de cualquier vertido o cuerpo flotante (plásticos, personas, algas...), pronosticando su trayectoria en el mar para los siguientes días o su origen analizando su movimiento atrás en el tiempo.

Gracias a esta tecnología es posible minimizar el impacto que generan los vertidos de petróleo y otros residuos en costas, mares y océanos.

EnEKO es un asistente virtual que ayuda a los usuarios a ahorrar energía. Se trata de un bot inteligente en Telegram, que ofrece información sobre el precio de la electricidad y los combustibles (gasolina y gasoil), para que los usuarios puedan hace un uso más racional de los recursos energéticos.

La aplicación combina datos de:

- Open Data Euskadi: Indicadores municipales de sostenibilidad, Consumo eléctrico anual del municipio.

- Red Eléctrica Española: Precio de la energía eléctrica

- Ministerio para la Transición Ecológica y el Reto Demográfico: Precio de carburantes en las gasolineras españolas.

- Servicios de geolocalización de Google: para cruzar los datos de precios energéticos y su ubicación.

La interacción con el usuario es muy sencilla: a través de un enlace de invitación se accede al grupo de Telegram enEKO TEAM, a partir del cual es posible acceder a un chat privado con el bot para interactuar con él a través del comando /ENEK.

enEKO se hizo con el primer premio del Concurso de aplicaciones de Open Data Euskadi.

Medir el impacto de los datos abiertos es uno de los retos que tienen por delante las iniciativas de datos abiertos. En este contexto, el Portal de Datos Europeo ha puesto en marcha un observatorio de casos de uso que constará de diversos informes.

En el primer informe se presenta la metodología y 30 casos de reutilización seleccionados, incluyendo información sobre los servicios que ofrecen, los datos (abiertos) que utilizan y el impacto que tienen. Por último se presentan las conclusiones generales y las lecciones aprendidas en esta primera parte del proyecto. Para seleccionar los casos de uso, se realizó un inventario basado en tres fuentes: los ejemplos recogidos en los estudios de madurez que realiza cada año el portal europeo, las soluciones participantes en el EU Datathon y los ejemplos de reutilización disponibles en el repositorio de casos de uso de data.europa.eu.

Este informe se encuentra disponible en el siguiente enlace: "Observatorio de casos de uso: seguimiento de 3 años de 30 casos de reutilización para comprender el impacto económico, gubernamental, social y medioambiental de los datos abiertos (Volumen I) "