El Centre de documentació i biblioteca del Institut Català d'Arqueologia Clàssica (ICAC) cuenta con el repositorio Open Science ICAC. Esta página web se configura como un espacio donde la ciencia se comparte de forma accesible e inclusiva. El espacio introduce recomendaciones y asesora sobre el proceso de la publicación de contenidos. También, sobre cómo poner a disposición los datos generados durante el proceso de investigación, de forma que sirvan a futuros trabajos de investigación.

La página web, además de ser un repositorio de textos de investigación científica, también es un lugar en el que encontrar herramientas y trucos a la hora de abordar el proceso de gestión de datos de investigación en cada una de sus fases: antes, durante y en el momento de la publicación.

- Antes de comenzar: recomienda crear un plan de gestión de datos para garantizar que la propuesta de investigación sea lo más sólida posible. El Plan de Gestión de Datos (PGD) es un documento metodológico que describe el ciclo de vida de los datos recogidos, generados y procesados durante un proyecto de investigación, una tesis doctoral, etc.

- Durante el proceso de investigación: en este punto señala la necesidad de unificar la nomenclatura de los documentos a generar antes de empezar a recopilar archivos o datos, para evitar una acumulación de contenido desorganizado que conducirá a datos extraviados o perdidos. Además, en este apartado se ofrece información sobre la estructura de directorios, nombres de carpetas y nombres de archivos, la creación de un archivo txt (README) que describa las nomenclaturas o el uso de nombres cortos y descriptivos como nombre del proyecto/acrónimo, fecha de creación del archivo, número de muestra o número de la versión. En la página web se pueden encontrar también recomendaciones sobre cómo estructurar cada uno de estos campos para que sean reutilizables y fácilmente buscables.

- Publicación de los datos de investigación: además de los propios resultados de la investigación en forma de tesis, tesina, paper... recomienda la publicación de los datos que se hayan ido generando con el propio proceso investigador. El propio ICAC señala que los datos de investigación siguen siendo valiosos una vez finalizado el proyecto de investigación para el que se generaron, y que compartir los datos puede abrir nuevas vías de investigación sin que los futuros investigadores tengan que recrear y recopilar datos idénticos. Por último, señala cómo, cuándo y qué tener en cuenta a la hora de publicar los datos de investigación.

Los contenidos gráficos para la mejora de la calidad de datos abiertos

Recientemente, el ICAC ha dado un paso más para incentivar unas buenas prácticas en el uso de datos abiertos. Para ello ha elaborado una serie de contenidos gráficos basándose en la “Guía práctica para la mejora de la calidad de datos abiertos”, elaborada por datos.gob.es. En concreto, el ente cultural ha elaborado cuatro infografías, en catalán e inglés, de fácil comprensión sobre buenas prácticas con datos abiertos en el trabajo con bases de datos y hojas de cálculo, textos y docs y formato CSV.

Todas las infografías surgidas de la adaptación de la guía están a disposición del público general y también del personal investigador del centro en Recercat, el repositorio de investigación de Cataluña. Próximamente también estará dentro de la web de Ciencia Abierta del Institut Català d'Arqueologia Clàssica (ICAC), Open Science ICAC.

Las infografías elaboradas por el ICAC repasan diversos aspectos. Las primeras, recogen las recomendaciones generales para garantizar la calidad de los datos abiertos, como el uso de codificación de caracteres estandarizados, tales como el UTF-8, o nombrar las columnas de forma correcta, utilizando solo letras en minúscula y evitando los espacios, siendo estos sustituidos por guiones. Entre las recomendaciones para generar datos de calidad, también recogen cómo mostrar la presencia de datos nulos o la carencia de datos o cómo gestionar la duplicidad de datos, de manera que se centralice la recogida de datos y su procesamiento en un único sistema de forma que, en caso de haber duplicidad, se puedan detectar de forma sencilla y puedan ser eliminados.

Las segundas abordan cómo establecer el formato de las cifras numéricas y de otros datos como las fechas, de manera que sigan el sistema estandarizado ISO, así como utilizar los puntos como decimales. En el caso de la información geográfica, tal y como recomienda la Guía, sus materiales también recogen la necesidad de reservar dos columnas para insertar la longitud y la latitud de los puntos geográficos utilizados.

La tercera temática de estas infografías se centra en la elaboración de buenas bases de datos u hojas de cálculo, de forma que sean fácilmente reutilizables y no generen problemas a la hora de trabajar con ellas. Entre las recomendaciones que destacan se encuentra la consistencia a la hora de generar nombres o códigos para cada ítem incluido en la recogida de datos, así como elaborar una guía de ayuda para las celdas que se encuentran codificadas, de manera que sean inteligibles para quienes necesiten reutilizarlas.

En el apartado de textos y documentos dentro de estas bases de datos, las infografías que ha elaborado el Institut Català d'Arqueologia Clàssica recogen algunas de las recomendaciones más importantes para crear textos y asegurarse de su conservación de la mejor forma posible. Entre ellas, señala la necesidad de guardar materiales adjuntos en los documentos de texto como pueden ser imágenes u hojas de cálculo de forma separada al documento de texto. De esta manera, se asegura que el documento conserva su calidad original, como la resolución de una imagen, por ejemplo.

Por último, la cuarta infografía que se ha puesto a disposición recoge las recomendaciones más importantes a la hora de trabajar con formato CSV (comma separated value) como crear un documento CSV para cada tabla y, en caso de trabajar con un documento con varias hojas de cálculo, ponerlas a disposición de forma independiente. También señala en este caso que cada fila en el documento CSV tiene el mismo número de columnas para que sean fácilmente trabajables y reutilizables, sin necesidad de realizar una limpieza posterior.

Como se mencionaba anteriormente, todas las infografías siguen las recomendaciones ya recogidas en la Guía práctica para la mejora de la calidad de datos abiertos.

La guía para la mejora de la calidad de datos abiertos

La “Guía práctica para la mejora de la calidad de datos abiertos” es un documento elaborado por datos.gob.es dentro de la Iniciativa Aporta y publicado en septiembre de 2022. El documento proporciona un compendio de directrices para actuar sobre cada una de las características que definen la calidad, impulsando su mejora. A su vez, esta guía toma como referente la guía para la calidad de datos de data.europe.eu, publicada en 2021 por la Oficina de Publicaciones de la Unión Europea y la completa para que tanto publicadores como reutilizadores de datos puedan seguir pautas que garanticen la calidad de los datos abiertos.

En resumen, la guía pretende ser un marco de referencia para todas las personas involucradas tanto en la generación como en la utilización de datos abiertos para que tengan un punto de partida que garantice la idoneidad de los datos tanto en su puesta a disposición como a la hora de evaluar si un conjunto de datos posee calidad suficiente para su reutilización en estudios, aplicaciones, servicios u otros.

A finales de 2023, como recogió datos.gob.es, el ISTAC hizo públicos más de 500 activos semánticos, entre los que se incluían 404 clasificaciones o 100 esquemas de conceptos.

Todos estos recursos están disponibles en el Catálogo de Datos Abiertos de Canarias, un entorno en el que hay cabida tanto para recursos semánticos como estadísticos y que, por tanto, puede entrañar una dificultad extra para un usuario que busque únicamente activos semánticos.

Para facilitar la reutilización de estos conjuntos de datos con información tan relevante para la sociedad, el Instituto Canario de Estadística, con la colaboración de la Dirección General de Transformación Digital de los Servicios Públicos del Gobierno de Canarias, publicó el Banco de activos semánticos.

En este portal, el usuario puede realizar búsquedas de manera más sencilla proporcionando una palabra clave, identificador, nombre del conjunto de datos o institución que lo elabora y mantiene.

El Banco de activos semánticos del Instituto Canario de Estadística es una aplicación que sirve para explorar los recursos estructurales utilizados por el ISTAC. De esta forma es posible reutilizar los activos semánticos con los que trabaja el ISTAC, ya que hace uso directo de las API de eDatos, la infraestructura que vertebra el instituto de estadística canario.

El número de recursos a consultar crece enormemente respecto a los datos disponibles en el Catálogo, ya que, por un lado, incluye los DSD (Definiciones de las Estructuras de Datos), con los que se construyen las tablas de datos finales; y, por otro, porque incluye no solo los esquemas y clasificaciones, sino cada uno de los códigos, conceptos y elementos que los componen.

Esta herramienta es el equivalente de los mencionados Fusion Metadata Registry usados por SDMX, Eurostat o las Naciones Unidas; pero con un enfoque mucho más práctico y accesible sin perder funcionalidades avanzadas. El SDMX es el estándar de compartición de datos y metadatos en el que se basan las organizaciones ya mencionadas. El uso de este estándar en aplicaciones como la del ISTAC permite homogeneizar de manera sencilla todos los recursos asociados a los datos estadísticos que se van a publicar.

La publicación de datos bajo el estándar SDMX es un proceso más laborioso, ya que obliga a generar no solo los datos, sino también las claves de publicación, pero a la larga permite que se creen plantillas u operaciones estadísticas que permite compararlas con los datos de otro país o región.

La aplicación recién lanzada por el ISTAC permite navegar por todos los recursos estructurales del ISTAC, incluyendo las familias de clasificaciones o conceptos, de manera interconectada, por lo que opera como una red.

Funcionalidades del Banco de activos semánticos

La principal ventaja de esta nueva herramienta frente a los registros mencionados es la facilidad de uso. La cual, en este caso, se mide directamente por lo poco que cuesta encontrar un recurso específico.

Gracias a la búsqueda avanzada, se pueden filtrar recursos específicos por ID, nombre, descripción y mantenedor; a los que se agrega la opción de incluir solo los resultados que interesen, discriminando tanto por versión como por si son recomendados por el ISTAC o no.

Además, está pensado para que sea un gran banco interconectado, de tal manera que, entrando en un concepto, se recomienden clasificaciones, o que en un DSD estén enlazadas todas las representaciones de las dimensiones y atributos.

Estas características no solo diferencian al Banco de activos semánticos de otras herramientas similares, sino que suponen un paso adelante en materia de interoperabilidad y transparencia al no simplemente ofrecer los recursos semánticos sino también sus relaciones entre ellos.

El nuevo recurso del ISTAC cumple con lo dispuesto tanto a escala nacional con el Esquema Nacional de Interoperabilidad (artículo 10, activos semánticos), como a escala europea con el Marco Europeo de Interoperabilidad (artículo 3.4, interoperabilidad semántica). Ambos documentos defienden la necesidad y el valor de utilizar recursos comunes para el intercambio de información, máxima que se está implantando de manera transversal en el Gobierno de Canarias.

Píldora formativa

Para difundir este nuevo buscador de activos semánticos, el ISTAC ha publicado un breve vídeo explicativo del Banco y sus características, además de aportar pinceladas necesarias sobre SDMX. En este vídeo es posible conocer, de forma sencilla y en apenas unos minutos cómo utilizar y sacar el máximo provecho al nuevo Banco de Activos Semánticos del ISTAC a través de las búsquedas sencillas, complejas y cómo organizar los datos para que respondan a un análisis previo deseado.

En resumen, con el Banco de activos semánticos, el Instituto Canario de Estadística ha dado un paso significativo para facilitar la reutilización de sus activos semánticos. Esta herramienta que agrupa decenas de miles de recursos estructurales permite acceder de manera sencilla a una red interconectada que cumple con los estándares de interoperabilidad a nivel nacional y europeo.

El Instituto Canario de Estadística (ISTAC) ha añadido a su catálogo más de 500 activos semánticos y más de 2100 cubos estadísticos. Esta inmensa cantidad de información representa lustros de trabajo del ISTAC en materia de normalización y adaptación a estándares internacionales punteros, que habilitan una mejor compartición de datos y metadatos entre productores y consumidores de información nacionales e internacionales.

El incremento de conjuntos de datos mejora no solo cuantitativamente el directorio de datos.canarias.es y datos.gob.es, sino que amplía los usos que éste ofrece gracias al tipo de información añadida.

Nuevos activos semánticos

Los recursos semánticos, a diferencia de los estadísticos, no presentan datos numéricos cuantificables, como pueden ser datos de desempleo o el PIB, sino que proporcionan homogeneidad y reproducibilidad.

Estos activos suponen un paso adelante en materia de interoperabilidad, según lo dispuesto tanto a escala nacional con el Esquema Nacional de Interoperabilidad (artículo 10, activos semánticos), como a escala europea con el Marco Europeo de Interoperabilidad (artículo 3.4, interoperabilidad semántica). En ambos documentos se expone la necesidad y el valor de utilizar recursos comunes para el intercambio de información, máxima que se está implantando de manera transversal en el Gobierno de Canarias. Estos activos semánticos ya se están usando en los formularios de la sede electrónica y se espera que en el futuro sean los activos semánticos que use todo el Gobierno de Canarias.

Concretamente en esta carga de datos hay 4 tipos de activos semánticos:

- Clasificaciones (404 cargadas): Listados de códigos que se utilizan para representar los conceptos asociados a las variables o categorías que forman parte de los conjuntos de datos normalizados, como por ejemplo la Clasificación Nacional de Actividades Económicas (CNAE), clasificaciones de países como la M49, o clasificaciones de sexo y edad.

- Esquemas de conceptos (100 cargados): Los conceptos son las definiciones de las variables en las que se desagregan los datos y que finalmente se representan con una o varias clasificaciones. Pueden ser transversales como “Edad”, “Lugar de nacimiento” y “Actividad de la empresa” o específicos para cada operación estadística como “Tipo de tareas del hogar” o “Índice de confianza del consumidor”.

- Esquemas de temas (2 cargados): Incorporan listas de temas que pueden corresponder a la clasificación temática de las operaciones estadísticas o al registro de temas INSPIRE.

- Esquemas de organizaciones (4 cargados): Se incluyen esquemas de entidades como unidades organizativas, universidades, agencias mantenedoras o proveedores de datos.

Todos estos tipos de recursos forman parte del estándar internacional SDMX (Statistical Data and Metadata Exchange), que se utiliza para el intercambio de datos y metadatos estadísticos. El estándar SDMX proporciona un formato y estructura común para facilitar la interoperabilidad entre diferentes organizaciones que producen, publican y utilizan datos estadísticos.

Este estándar es promovido por organizaciones como el Banco Central Europeo (BCE), Naciones Unidas, la Oficina Estadística de la Unión Europea (Eurostat), el Fondo Monetario Internacional (FMI) o la Organización para la Cooperación y el Desarrollo Económico (OCDE).

Con la inclusión de estos conjuntos de datos, datos.canarias.es y datos.gob.es entrarían a formar parte de un selecto grupo de organizaciones que también ponen a disposición de la sociedad diversos recursos estructurales para fines estadísticos en los siguientes registros públicos:

- SDMX Global Registry

- Euro SDMX Registry

- United Nations Statistical Division

- UNICEF Indicator Data Warehouse

- IMF SDMX Central

Nuevos recursos estadísticos

Dada la creciente necesidad de compartir, procesar y comparar datos, se hace indispensable la aplicación de estándares internacionales para la publicación e intercambio de datos y metadatos. El ISTAC se encuentra inmerso en un proceso de revisión y actualización de sus publicaciones para adaptarlas al estándar internacional SDMX, empezando por el análisis de la información publicada, pasando por la definición de activos semánticos y recursos estructurales en general, hasta llegar a la publicación de recursos estadísticos como los cubos o tablas de datos.

Como parte de este objetivo y tras años de trabajo armonizando y estandarizando datos, el ISTAC ha cargado en su catálogo 2196 cubos estadísticos que hacen uso de los activos semánticos antes descritos y que se basan en el estándar SDMX.

Esto permite mejorar el uso y compartición de datos tanto para el usuario de a pie como de manera programática gracias al uso estandarizado de recursos semánticos. En definitiva, la incorporación al catálogo de esta relevante información, supone un paso muy importante en la interoperabilidad de los datos y, por tanto, en su reutilización.

Madrid acoge del 25 al 27 de septiembre la cuarta edición del Open Science Fair, un evento internacional sobre la ciencia abierta que reunirá a expertos de todo el mundo con el objetivo de identificar prácticas comunes, acercar posturas y, en definitiva, mejorar las sinergias entre las diferentes comunidades y servicios que trabajan en este ámbito.

Este evento es una iniciativa de OpenAIRE, una organización que pretende crear una comunicación académica más abierta y transparente. Esta edición del Open Science Fair está co-organizada por la Fundación Española para la Ciencia y Tecnología (FECYT), dependiente del Ministerio de Ciencia e Innovación, y es uno de los eventos auspiciados por la presidencia española del Consejo de la Unión Europea.

La situación actual de la ciencia abierta

La ciencia ha dejado de ser algo exclusivo de los científicos. Investigadores, instituciones, agencias de financiación y editores científicos forman parte de un ecosistema que lleva a cabo un trabajo con un eco creciente en la ciudadanía y un mayor impacto en la sociedad. Además, cada vez es más habitual que los grupos de investigación se abran a colaborar con instituciones de todo el mundo. Para hacer posible esta colaboración es clave poder contar con datos abiertos y disponibles para su reutilización en investigaciones.

Sin embargo, para permitir que la investigación internacional e interdisciplinaria avance, es necesario garantizar la interoperabilidad entre comunidades y servicios, manteniendo al mismo tiempo la capacidad de apoyar los diferentes flujos de trabajo y sistemas de conocimiento.

Los objetivos y el programa de Open Science Fair

En este contexto se celebra el Open Science Fair 2023, que tiene como objetivo reunir y empoderar a las comunidades y servicios de ciencia abierta; identificar prácticas comunes relacionadas con la ciencia abierta para analizar las sinergias más adecuadas y, en definitiva, compartir experiencias que se desarrollan en diferentes partes del mundo.

El evento cuenta con un interesante programa que incluye conferencias magistrales de relevantes ponentes, mesas redondas, talleres y sesiones de capacitación, así como una sesión de demostración. Los asistentes podrán compartir experiencias e intercambiar opiniones, lo que permitirá definir las maneras más eficientes para que las comunidades puedan trabajar en conjunto y trazar hojas de ruta, adaptadas a cada circunstancia, para la implementación de la ciencia abierta.

Esta tercera edición del Open Science se centrará en ‘La ciencia abierta para futuras generaciones’ y los principales temas sobre los que tratará, tal y como se destaca en la web del evento, son:

- Avance y reforma de la evaluación de la investigación y la ciencia abierta. Conexiones, barreras y camino a seguir.

- Impacto de la inteligencia artificial en la ciencia abierta e impacto de la ciencia abierta en la inteligencia artificial.

- Innovación y disrupción en la publicación académica.

- Fair data, software y hardware.

- Apertura en investigación y educación.

- Compromiso público y ciencia ciudadana.

Ciencia abierta e inteligencia artificial

La inteligencia artificial está teniendo una gran importancia en el mundo académico a través de análisis de datos. Gracias al análisis de grandes cantidades de datos, los investigadores pueden identificar patrones y correlaciones a los que sería difícil llegar a través de otros métodos. La utilización de datos abiertos en el ámbito de la ciencia abierta abre un interesante y prometedor futuro, aunque es importante garantizar que los beneficios de la inteligencia artificial estén disponibles para todos de forma justa y equitativa.

Dada su gran relevancia, en el Open Science Fair se celebrarán dos conferencias magistrales y una mesa redonda sobre ‘IA con y para la ciencia abierta’. La combinación de los beneficios de los datos abiertos y la inteligencia artificial es una de áreas con mayor potencial para lograr avances científicos significativos y, como tal, tendrá su espacio en el evento. Así, se analizará desde tres puntos de vista (ética, infraestructura y algoritmos), cómo la inteligencia artificial apoya a los investigadores y cuáles son los ingredientes clave para que las infraestructuras abiertas pueden lograr que esto suceda.

El programa del Open Science Fair 2023 incluye también la presentación de una demo de una herramienta para mapear las actividades de investigación de la Universidad Europea de Tecnología EUt+ aprovechando los datos abiertos y el procesamiento del lenguaje natural. Este proyecto incluye el desarrollo de un conjunto de herramientas basadas en datos. Los asistentes a la demo podrán ver la plataforma desarrollada que integra datos de repositorios públicos, como proyectos europeos de investigación e innovación de CORDIS, patentes de la base de datos de la Oficina Europea de Patentes y publicaciones científicas de OpenAIRE. También se han recopilado datos de proyectos nacionales y regionales de diferentes repositorios, que han sido procesados y puestos a disposición del público.

Estos son solo alguno de los eventos que se desarrollarán dentro del Open Science Fair, pero el programa completo incluye un amplio conjunto de actos para explorar el conocimiento multidisciplinar y la evaluación de las investigaciones.

Aunque la inscripción al encuentro ya está cerrada, es posible mantenerse al tanto de todo lo que se hable durante su celebración a través del hashtag #OSFAIR2023 en Twitter, LinkedIn y Facebook, así como en su página web.

Además, en la web de datos.gob.es y en nuestras redes sociales puedes mantenerte al día sobre los eventos más destacados en el ámbito de los datos abiertos, como los que tendrán lugar durante este otoño.

Esta aplicación de software libre ofrece un mapa con todos los árboles de la ciudad de Barcelona geolocalizados mediante GPS. El usuario puede acceder a información en profundidad sobre la materia. Por ejemplo, el programa identifica el número de árboles que hay en cada calle, su estado e incluso la especie.

El desarrollador de la aplicación, Pedro López Cabanillas, ha utilizado conjuntos de datos del portal de datos abiertos de Barcelona (Open Data Barcelona) y declara, en su blog, que puede ser útil para estudiantes de botánica o “usuarios curiosos”. La aplicación Barcelona Trees ya cuenta con su tercera versión beta.

El programa utiliza el framework Qt, los lenguajes C++ y QML, y se puede construir (utilizando un compilador moderno adecuado) para los objetivos más comunes: sistemas operativos Windows, macOS, Linux y Android.

Gaia-X representa un innovador paradigma con el que vincular más estrechamente los datos con la infraestructura tecnológica que hay por debajo, de forma que se garantice la transparencia, el origen y el funcionamiento de estos recursos. Este modelo nos permite desplegar una Economía del Dato soberana y transparente, que respete los derechos fundamentales europeos, y que en España tomará forma en torno a los espacios de datos sectoriales (C12.I1 y C14.I2 del Plan de Recuperación, Transformación y Resiliencia). Estos se alinearán con el marco regulatorio europeo, así como con una gobernanza e instrumentos pensados para asegurar la interoperabilidad, y sobre la que articular el buscado mercado único de datos.

En este sentido, los nodos de interoperabilidad de Gaia-X, o Gaia-X Digital Clearing House (GXDCH), tienen por objeto ofrecer servicios de validación automática de las reglas de interoperabilidad a promotores y participantes de espacios de datos. La creación de este tipo de nodos fue anunciada en la Gaia-X Summit 2022, el pasado mes de noviembre en París. La arquitectura Gaia-X, promovida por la asociación Gaia-X European Association for Data & Cloud AISBL, se ha consolidado como una prometedora alternativa tecnológica para la creación de ecosistemas abiertos y transparentes de conjuntos y servicios de datos.

Estos ecosistemas, por naturaleza federados, servirán para el desarrollo a escala de la citada Economía del Dato. Pero para ello, deben cumplirse una serie de reglas mínimas que aseguren la interoperabilidad entre participantes. La conformidad con dichas reglas es precisamente la función de la GXDCH, sirviendo como "ancla" para desplegar servicios de mercado certificados. Por tanto, la creación en España de un nodo de estas características supone un elemento crucial para el despliegue de los espacios federados de datos a nivel nacional, lo que estimulará el desarrollo y la innovación en torno al dato bajo un entorno de respeto a la soberanía del dato, la privacidad, transparencia y la justa competencia.

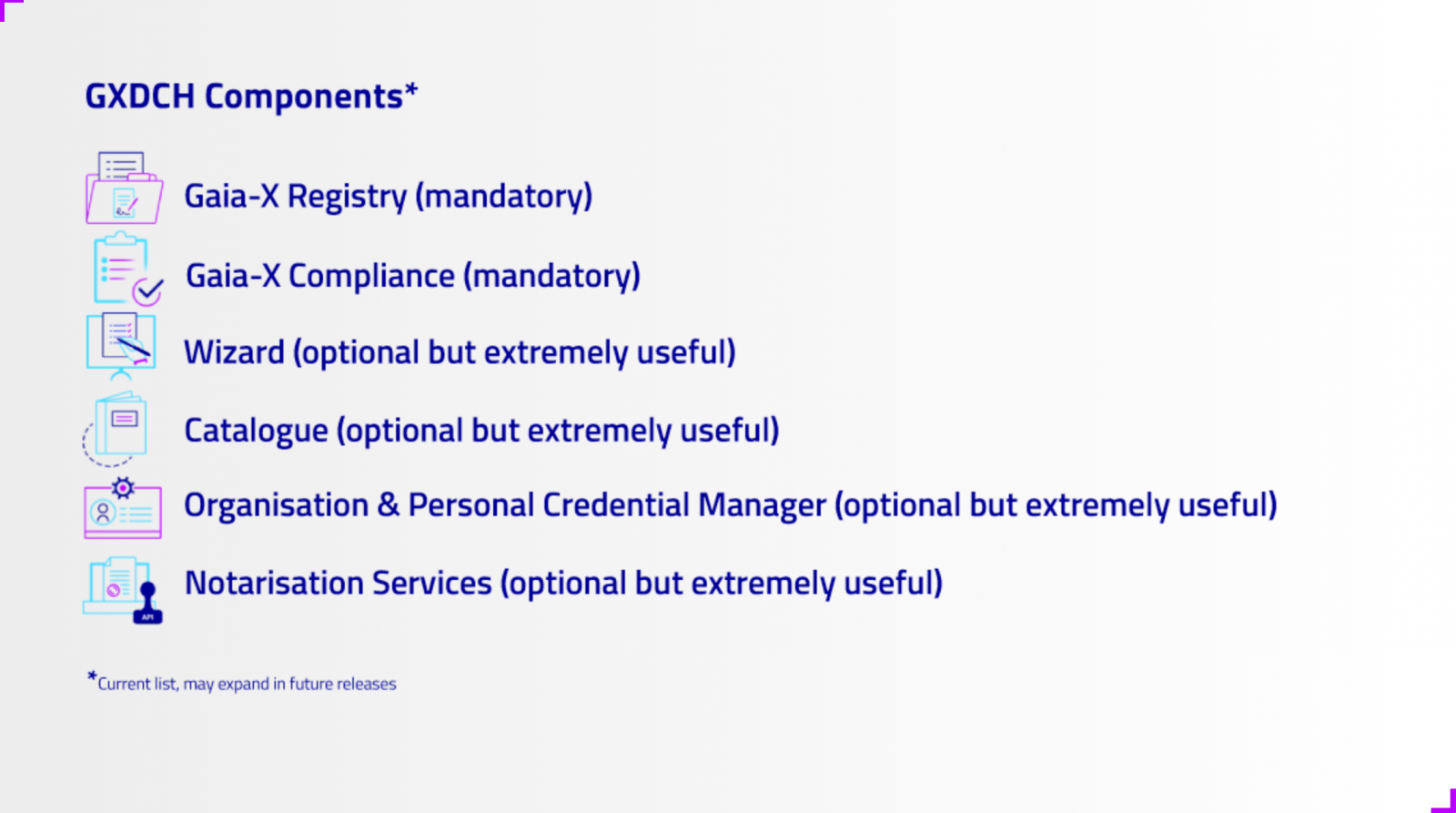

La GXDCH se define como un nodo en el que se prestan servicios operacionales de un ecosistema que cumpla con las reglas de interoperabilidad de Gaia-X. Como “servicios operacionales” se deben entender aquellos servicios que son necesarios para el funcionamiento de un espacio de datos, pero que no son en sí mismos servicios de compartición de datos, ni de aplicaciones de explotación de datos, ni de infraestructuras en la nube. Gaia-X define seis servicios operacionales, de los cuales al menos dos deben formar parte de los nodos obligatorios que alberguen las GXDCHs:

Servicios obligatorios

- Gaia-X Registry: Definida como una base de datos inmutable, no repudiable y distribuida con capacidad de ejecutar código. Típicamente sería una infraestructura blockchain que soporta un servicio de identidad descentralizada (‘Self Sovereign Identity’) en la que se almacenan, entre otras, la lista de autoridades emisoras de credenciales (Trust Anchors) u otros datos necesarios para el funcionamiento de la gestión de identidad en Gaia-X.

- Servicio de conformidad de Gaia-X o Gaia-X Compliance Service pertenece a los denominados Gaia-X Federation Services y su función es verificar el cumplimiento de las reglas mínimas de interoperabilidad definidas por la asociación Gaia-X (por ejemplo, el Trust Framework)

Servicios opcionales

- Servicio de edición de Self-Descriptions (SDs) o Wizard: Las SDs son credenciales verificables según el estándar definido por el W3C mediante las cuales se describen a sí mismos tanto los participantes de un ecosistema Gaia-X como los productos puestos a disposición por los proveedores. El servicio de conformidad antes mencionado consiste en validar que las SDs cumplen con las normas de interoperabilidad. El Wizard es un servicio de conveniencia para la creación de Self-Descriptions según esquemas predefinidos.

- Catálogo: Servicio de almacenamiento de la oferta de servicios disponible en el ecosistema para su consulta.

- e-Wallet: Para la gestión de credenciales verificables (SDs) por parte de los participantes en un sistema basado en identidades distribuidas.

- Servicio de Notaría: Servicio de emisión de credenciales verificables firmadas por autoridades de acreditación (Trust Anchors).

En qué consiste el servicio de conformidad de Gaia-X (p.e. Compliance Service)

El servicio de conformidad de Gaia-X pertenece a los denominados Gaia-X Federation Services, y su función es verificar el cumplimiento de las reglas mínimas de interoperabilidad definidas por la asociación Gaia-X. Gaia-X denomina a estas reglas mínimas de interoperabilidad (Trust Framework). Se debe tener en cuenta que el establecimiento del Trust Framework es una de las contribuciones diferenciadoras del marco tecnológico de Gaia-X frente a otras soluciones de mercado. Pero el objetivo no se limita a establecer normas de interoperabilidad, sino que pretende crear un servicio que sea operable y, en la medida de lo posible, automatizado, que valide el cumplimiento del Trust Framework. Este servicio es el Gaia-X Compliance Service.

El elemento clave de estas reglas son las denominadas “Self-Descriptions” (SDs). Las SDs son credenciales verificables según la norma definida por el W3C mediante las cuales se describen a sí mismos tanto los participantes de un espacio de datos como los productos puestos a disposición por los proveedores. El servicio Gaia-X Compliance valida el cumplimiento del Trust Framework mediante un chequeo de las SDs desde los siguientes puntos de vista:

- Formato y sintaxis de las SDs

- Validación de los esquemas de las SDs (vocabulario y ontología)

- Validación de la criptografía de las firmas de los emisores de las SDs

- Consistencia de los atributos

- Veracidad del valor de los atributos.

Una vez validadas las Self-Descriptions, el operador del servicio de conformidad emite una credencial verificable que da fe del cumplimiento de las normas de interoperabilidad, aportando confianza a los participantes del ecosistema. La Gaia-X AISBL proporciona el código necesario para implementar el Compliance Service y autoriza la prestación del servicio a entidades de confianza, pero no opera directamente el servicio por lo que requiere la existencia de socios que se encarguen de esta labor.

La anonimización de datos define la metodología y el conjunto de buenas prácticas y técnicas que reducen el riesgo de identificación de personas, la irreversibilidad del proceso de anonimización y la auditoría de la explotación de los datos anonimizados, monitorizando quién, cuándo y para qué se usan.

Este proceso es fundamental, tanto cuando hablamos de datos abiertos como de datos en general, para proteger la privacidad de las personas, garantizando el cumplimiento normativo y de los derechos fundamentales.

El informe “Introducción a la anonimización de datos: Técnicas y casos prácticos”, elaborado por Jose Barranquero, define los conceptos clave de un proceso de anonimización, incluyendo términos, principios metodológicos, tipos de riesgos y técnicas existentes.

El objetivo del informe es ofrecer una introducción suficiente y concisa, principalmente orientada a publicadores de datos que necesitan garantizar la privacidad de estos. No se trata de una guía exhaustiva, sino una primera toma de contacto para entender los riesgos y técnicas disponibles, así como la complejidad inherente a cualquier proceso de anonimización de datos.

¿Qué técnicas se incluyen en el informe?

Tras una introducción donde se definen los términos más relevantes y los principios básicos de anonimización, el informe se centra en comentar tres enfoques generales para la anonimización de datos, cada uno de los cuales está integrado a su vez por diversas técnicas:

- Aleatorización: tratamiento de datos, eliminando la correlación con el individuo, mediante la adición de ruido, la permutación, o la Privacidad Diferencial.

- Generalización: alteración de escalas u órdenes de magnitud a través de técnicas basadas en agregación como Anonimato-K, Diversidad-L, o Proximidad-T.

- Seudonimización: reemplazo de valores por versiones cifradas o tokens, habitualmente a través de algoritmos de HASH, que impiden la identificación directa del individuo, a menos que se combine con otros datos adicionales, que deben estar custodiados de forma adecuada.

El documento describe cada una de estas técnicas, así como los riesgos que suponen, aportando recomendaciones para evitarlos. Si bien, la decisión final sobre qué técnica o conjunto de técnicas es más adecuada depende de cada caso particular.

El informe finaliza con un conjunto de ejemplos prácticos sencillos que muestran la aplicación de las técnicas Anonimato-K y seudonimización mediante cifrado con borrado de clave. Para simplificar la ejecución del caso, se pone a disposición de los usuarios el código y los datos utilizados en el ejercicio, disponibles en Github. Para seguir el ejercicio, es recomendable tener unos conocimientos mínimos del lenguaje pyhton.

A continuación, puedes descargar el informe completo, así como el resumen ejecutivo y una presentación-resumen.

Tras varios meses de pruebas y entrenamientos de distinto tipo, el primer sistema masivo de Inteligencia Artificial de la lengua española es capaz de generar sus propios textos y resumir otros ya existentes. MarIA es un proyecto que ha sido impulsado por la Secretaría de Estado de Digitalización e Inteligencia Artificial y desarrollado por el Centro Nacional de Supercomputación, a partir de los archivos web de la Biblioteca Nacional de España (BNE).

Hablamos de un avance muy importante en este ámbito, ya que se trata del primer sistema de inteligencia artificial experto en comprender y escribir en lengua española. Enmarcada dentro del Plan de Tecnologías del Lenguaje, esta herramienta pretende contribuir al desarrollo de una economía digital en español, gracias al potencial que los desarrolladores pueden encontrar en ella.

El reto de crear los asistentes del lenguaje del futuro

Los modelos de lenguaje al estilo de MarIA son la piedra angular sobre la que se sustenta el desarrollo del procesamiento del lenguaje natural, la traducción automática o los sistemas conversacionales, tan necesarios para comprender y replicar de forma automática una lengua. MarIA es un sistema de inteligencia artificial formado por redes neuronales profundas que han sido entrenadas para adquirir una comprensión de la lengua, de su léxico y de sus mecanismos para expresar el significado y escribir a nivel experto.

Gracias a este trabajo previo, los desarrolladores pueden crear herramientas relacionadas con el lenguaje y capaces de clasificar documentos, realizar correcciones o elaborar herramientas de traducción.

La primera versión de MarIA fue elaborada con RoBERTa, una tecnología que crea modelos del lenguaje del tipo “codificadores”, capaces de generar una interpretación que puede servir para categorizar documentos, encontrar similitudes semánticas en diferentes textos o detectar los sentimientos que se expresan en ellos.

Así, la última versión de MarIA ha sido desarrollada con GPT-2, una tecnología más avanzada que crea modelos generativos decodificadores y añade prestaciones al sistema. Gracias a estos modelos decodificadores, la última versión de MarIA es capaz de generar textos nuevos a partir de un ejemplo previo, lo que resulta muy útil a la hora de elaborar resúmenes, simplificar grandes cantidades de información, generar preguntas y respuestas e, incluso, mantener un diálogo.

Avances como los anteriores convierten a MarIA en una herramienta que, con entrenamientos adaptados a tareas específicas, puede ser de gran utilidad para desarrolladores, empresas y administraciones públicas. En esta línea, modelos similares que se han desarrollado en inglés son utilizados para generar sugerencias de texto en aplicaciones de escritura, resumir contratos o buscar informaciones concretas dentro de grandes bases de datos de texto para relacionarlas posteriormente con otras informaciones relevantes.

En otras palabras, además de redactar textos a partir de titulares o palabras, MarIA puede comprender no solo conceptos abstractos, sino también el contexto de los mismos.

Más de 135 mil millones de palabras al servicio de la inteligencia artificial

Para ser exactos, MarIA se ha entrenado con 135.733.450.668 de palabras procedentes de millones de páginas web que recolecta la Biblioteca Nacional y que ocupan un total de 570 Gigabytes de información. Para estos mismos entrenamientos, se ha utilizado el superordenador MareNostrum del Centro Nacional de Supercomputación de Barcelona y ha sido necesaria una potencia de cálculo de 9,7 trillones de operaciones (969 exaflops).

Teniendo en cuenta que uno de los primeros pasos para diseñar un modelo del lenguaje pasa por construir un corpus de palabras y frases que sirva como base de datos para entrenar al propio sistema, en el caso de MarIA, fue necesario realizar un cribado para eliminar todos los fragmentos de texto que no fuesen “lenguaje bien formado” (elementos numéricos, gráficos, oraciones que no terminan, codificaciones erróneas, etc.) y así entrenar correctamente a la IA.

Debido al volumen de información que maneja, MarIA se sitúa ya como el tercer sistema de inteligencia artificial experto en comprender y escribir con mayor número de modelos masivos de acceso abierto. Por delante solo están los modelos del lenguaje elaborados para el inglés y el mandarín. Esto ha sido posible principalmente por dos razones. Por un lado, debido al elevado nivel de digitalización en el que se encuentra el patrimonio de la Biblioteca Nacional y, por el otro, gracias a la existencia de un Centro de Supercomputación Nacional que cuenta con superordenadores como el MareNostrum 4.

El papel de los conjuntos de datos de la BNE

Desde que en 2014 lanzase su propio portal de datos abiertos (datos.bne.es), la BNE ha apostado por acercar los datos que están a su disposición y bajo su custodia: datos de las obras que conserva, pero también de autores, vocabularios controlados de materias y términos geográficos, entre otros.

En los últimos años, se ha desarrollado también la plataforma educativa BNEscolar, que busca ofrecer contenidos digitales del fondo documental de la Biblioteca Digital Hispánica y que pueden resultar de interés para la comunidad educativa.

Así mismo y para cumplir con los estándares internacionales de descripción e interoperabilidad, los datos de la BNE están identificados mediante URIs y modelos conceptuales enlazados, a través de tecnologías semánticas y ofrecidos en formatos abiertos y reutilizables. Además, cuentan con un alto nivel de normalización.

Próximos pasos

Así y con el objetivo de perfeccionar y ampliar las posibilidades de uso de MarIA, se pretende que la versión actual dé lugar a otras especializadas en áreas de conocimiento más concretas. Teniendo en cuenta que se trata de un sistema de inteligencia artificial dedicado a comprender y generar texto, se torna fundamental que este sea capaz de desenvolverse con soltura ante léxicos y conjuntos de información especializada.

Para ello, el PlanTL continuará expandiendo MarIA para adaptarse a los nuevos desarrollos tecnológicos en procesamiento del lenguaje natural (modelos más complejos que el GPT-2 ahora implementado, entrenados con mayor cantidad de datos) y se buscará la forma de crear espacios de trabajo para facilitar el uso de MarIA por compañías y grupos de investigación.

Contenido elaborado por el equipo de datos.gob.es.

PCT Cartuja es una aplicación que busca dar servicio en tiempo real a los usuarios del Parque Tecnológico sevillano de la Cartuja. Entre las funciones disponibles puedes visualizar las plazas de aparcamiento disponibles en cada momento o acceder al directorio de entidades del Parque gracias a un buscador categorizado por sectores de actividad.

Además, dispondrás de toda la información relativa a horarios, disponibilidad de espacios para empresas o promociones vigentes para los trabajadores del PCT Cartuja.

Igualmente, la app informa sobre las notificaciones urgentes de última hora, la agenda de eventos empresariales y también sobre las últimas noticias relacionadas con las empresas y servicios que ofrece.

El auge de las ciudades inteligentes, la distribución de los recursos durante la pandemia o la lucha contra los desastres naturales ha despertado el interés por los datos geográficos. Y es que, de la misma forma que los datos abiertos del ámbito sanitario contribuyen a implementar mejoras sociales relacionadas con el diagnóstico de enfermedades o la reducción de listas de espera, los Sistemas de Información Geográfica ayudan a agilizar y simplificar algunos de los retos del futuro, con el objetivo de hacer de estos una realidad más sostenible desde el punto de vista ambiental, más eficiente en términos energéticos y más habitable para los ciudadanos.

Al igual que sucede en otros ámbitos, los profesionales que se dedican a optimizar al máximo los Sistemas de Información Geográfica (GIS en adelante) también construyen sus propios grupos de trabajo, asociaciones y comunidades formativas. Las comunidades GIS son grupos de voluntarios interesados en utilizar la información geográfica para maximizar los beneficios sociales que este tipo de datos pueden aportar en términos colectivos.

Así y a través de abordar los distintos enfoques que ofrece el campo de la información geográfica, las comunidades de datos trabajan en la elaboración de aplicaciones, el análisis de información geoespacial, la generación de cartografías y la creación de contenido divulgativo, entre otros.

En las siguientes líneas, analizaremos paso a paso cuál es el compromiso y el objetivo de tres ejemplos de comunidades GIS que actualmente están en activo.

GIS and Beers

¿Qué es y cuál es su objetivo?

Gis and Beers es una asociación centrada en la difusión, el análisis y el diseño de herramientas vinculadas a la información geográfica y los datos cartográficos. Especializados en sostenibilidad y medioambiente, utilizan los datos abiertos para proponer y difundir soluciones que buscan diseñar un entorno sostenible y respetuoso con la naturaleza.

¿Qué funciones lleva a cabo?

Además de difundir contenido especializado como informes y análisis de datos, los integrantes de Gis and Beers ofrecen recursos formativos dedicados a facilitar la comprensión de los sistemas de información geográfica desde la perspectiva medioambiental. Resulta habitual leer en su web artículos centrados en nuevos datos ambientales o ver tutoriales sobre cómo acceder a las plataformas de datos abiertos especializadas en medioambiente o a las herramientas disponibles para su gestión. Igualmente, cada vez que detectan la publicación de un nuevo catálogo de datos abiertos, comparten en su web las instrucciones necesarias para descargar los datos, gestionarlos y representarlos cartográficamente.

Próximos pasos

En línea con la conciencia medioambiental que marca el proyecto, desde Gis and Beers dedican cada vez más esfuerzos a fortalecer dos pilares clave para su contenido: concienciar sobre la importancia de la ciencia ciudadana (movimiento colaborativo que aporta datos observados por la ciudadanía) y promover el acceso a datos que faciliten el modelado sin adaptarlos previamente a necesidades cartográficas de análisis.

El papel de los datos abiertos

El origen de la mayor parte de los datos abiertos que utilizan proceden de fuentes estatales como el IGN, Aemet o el INE, aunque también se nutren de otras opciones como las que ofrecen organismos Google Earth Engine y Google Public Data.

¿Cómo contactar con ellos?

Si te interesa conocer más de cerca el trabajo de esta comunidad o necesitas ponerte en contacto con Gis and Beers, puedes visitar su página web o escribirles directamente a esta cuenta de correo electrónico.

Geovoluntarios

¿Qué es y cuál es su objetivo?

Se trata de una Organización sin ánimo de lucro formada por profesionales experimentados en el uso y la aplicación en remoto de tecnología geoespacial y cuyo objetivo es cooperar con otras organizaciones que prestan su apoyo en situaciones de emergencia y en proyectos alineados con los Objetivos de Desarrollo Sostenible.

La asociación tiene como objetivos principales:

- Proporcionar ayuda a organizaciones en cualquiera de las fases de una emergencia, priorizando la ayuda a organizaciones sin ánimo de lucro, de salvamento o que apoyen al tercer sector. Algunas de ellas son Cruz Roja, Protección Civil, organizaciones humanitarias, etc.

- Fomentar el voluntariado digital entre personas con conocimientos o interés en las tecnologías geoespaciales y el trabajo con datos geolocalizados.

- Buscar formas de apoyar a organizaciones trabajando en la consecución de los Objetivos de Desarrollo Sostenible (ODS).

- Proveer de herramientas geoespaciales y datos geolocalizados a proyectos sin ánimo de lucro que de otra forma no serían técnica o económicamente viables.

¿Qué funciones lleva a cabo?

La experiencia profesional acumulada por los integrantes de geovoluntarios permite ofrecer apoyo en tareas relacionadas con el análisis de datos geográficos, el diseño de modelos o la monitorización de situaciones de especial emergencia. De este modo, las funciones más habituales que llevan a cabo como ONG pueden resumirse en:

- Capacitar y ofrecer medios a voluntarios y organizaciones en todos los aspectos necesarios para proporcionar la ayuda con garantías: sistemas de información geográfica, análisis espacial, RGPD, seguridad, etc.

- Facilitar la creación de equipos temporales de trabajo para dar respuesta a las solicitudes de ayuda recibidas y que estén acorde con los fines de la organización.

- Crear grupos de trabajo que mantengan datos que sirvan de propósito general.

- Buscar acuerdos de colaboración con otras entidades, organizar y participar en eventos y realizar campañas de promoción del voluntariado digital.

Desde un punto de vista más concreto, entre todos los proyectos en los que ha participado Geovoluntarios, cabe destacar dos iniciativas en las que los integrantes se volcaron especialmente. Por un lado, el proyecto propio datos Covid, donde se logró crear una comunidad de voluntarios digitales comprometidos con la búsqueda y el análisis de datos fiables para, así, ofrecer información de calidad sobre la situación que se estaba viviendo en cada una de las diferentes comunidades autónomas de España.

Otra de las iniciativas a destacar fue Reactiva Madrid, un evento organizado por el Ayuntamiento de Madrid y Esri España que surgió para identificar y desarrollar trabajos que, a través de la participación ciudadana, ayudasen a prevenir y/o solucionar problemas relacionados con la pandemia provocada por la COVID-19 en los ámbitos de la economía, la movilidad y la sociedad.

Próximos pasos

Tras dos años volcados en resolver parte de los problemas generados por la crisis de la Covid-19, desde Geovoluntarios siguen centrados en colaborar con organizaciones que estén comprometidas con la asistencia a las personas más vulnerables en situaciones de emergencias, sin olvidar el compromiso que les vincula a cumplir los Objetivos de Desarrollo Sostenible.

Así, uno de los proyectos propios en los que los voluntarios están más activos es la aplicación y el perfeccionamiento de GeoObs, una app para geolocalizar diferentes proyectos de observación sobre: puntos sucios, peligro de incendios, zonas peligrosas para moteros, mejorar de una ciudad, ciclismo seguro, etc.

El papel de los datos abiertos

Para una ONG como Geovoluntarios los datos abiertos son esenciales tanto para desarrollar las tareas solidarias que llevan a cabo junto a otras asociaciones, como para diseñar servicios y aplicaciones propias. De ahí que estos recursos formen parte de las nuevas funcionalidades en las que la Asociación quiere centrarse.

Tanto es así que la recogida de datos marca un punto inicial para los proyectos piloto que se pueden encontrar actualmente bajo el ámbito de Geovoluntarios. Sin ir más lejos, la aplicación mencionada anteriormente es un ejemplo que demuestra cómo generar datos por observación puede contribuir a enriquecer los catálogos de datos abiertos disponibles.

¿Cómo contactar con ellos?

Si te interesa contactar con Geovoluntarios, puedes visitar su página web o rellenar el formulario de contacto.

Comunidad SIG

¿Qué es y cuál es su objetivo?

Comunidad SIG es un colectivo virtual que reúne a profesionales del ámbito de los datos geográficos y los sistemas de información vinculados al mismo sector. Fundados en el año 2009, difunden su trabajo a través de redes sociales como Facebook, Twitter o Instagram desde donde, además, comparten noticias e información relevante sobre geotecnología, geoprocesamiento u ordenamiento territorial entre otros temas.

Su objetivo no es otro que contribuir a ampliar el conocimiento divulgativo y de interés para la comunidad de datos geográficos, un espacio virtual con escasa presencia cuando este proyecto comenzó su labor en internet.

¿Qué funciones lleva a cabo?

En línea con los objetivos mencionados anteriormente, las tareas desarrolladas por SIG están centradas en la compartición y generación de contenido relacionado con los Sistemas de Información Geográfica. Dada la diversidad de campos y sectores de actuación dentro del mismo ámbito, tratan de equilibrar el contenido de sus publicaciones para conseguir congregar tanto a quien busca información como a quien provee oportunidades. Por esta razón es posible encontrar noticias sobre eventos, capacitaciones, proyectos de investigación, noticias sobre emprendedores o literatura entre muchos otros.

Próximos pasos

Conscientes del peso que tienen como comunidad dentro del ámbito de los datos geográficos, desde SIG tienen planificado reforzar cuatro ejes que afectan directamente al trabajo del proyecto: organizar charlas y webinars, contactar con organismos e instituciones capaces de aportar financiación a proyectos del área SIG, buscar entidades que proporcionen información geoespacial abierta y, por último, conseguir que una parte del sector privado participe económicamente en la formación y capacitación de los profesionales del ámbito SIG.

El papel de los datos abiertos

Se trata de una comunidad que está estrechamente vinculada al universo de los datos abiertos, debido a que comparte contenido que puede ser utilizado, complementado y redistribuido libremente por los usuarios. De hecho, según apuntan sus propios integrantes, cada vez se aprecia más la aceptación y la preferencia por esta tendencia, logrando que los colaboradores de la comunidad y sus propios proyectos, impulsen el debate y el interés a la utilizar datos abiertos en todas las fases activas de sus tareas o actividades.

¿Cómo contactar con ellos?

Al igual que en los casos anteriores, si te interesa ponerte en contacto con Comunidad SIG puedes hacerlo a través de su página de Facebook, Twitter o Instagram o enviando un correo electrónico al siguiente email.

Comunidades como Gis and Beers, SIG o Geovoluntarios son tan solo un pequeño ejemplo del trabajo que está desarrollando el colectivo GIS en la actualidad. Si formas parte de alguna comunidad de datos de este u otro ámbito o conoces de cerca la labor de comunidades que puedan resultar de interés en datos.gob.es, no dudes en enviarnos un correo electrónico a dinamizacion@datos.gob.es.

Geo Developers

¿Qué es y cuál es su objetivo?

Geodevelopers es una comunidad cuyo objetivo es reunir a desarrolladores y topógrafos del ámbito de los datos geográficos. La función principal de esta comunidad es compartir distintas experiencias profesionales relacionadas con los datos geográficos y, para ello, organizan charlas donde todo el mundo puede compartir su experiencia y conocimiento con el resto.

A través de su canal de YouTube es posible acceder a las formaciones y charlas realizadas hasta la fecha, así como estar al tanto de las siguientes que podrán llevar a cabo.

El papel de los datos abiertos

Aunque no se trata de una comunidad centrada en la reutilización de datos abiertos como tal, estos les sirven para desarrollar algunos proyectos y extraer nuevos aprendizajes que después incorporan a los flujos de trabajo.

Próximos pasos y contacto

El principal objetivo de futuro de Geodevelopers es hacer crecer la comunidad para, así, poder seguir compartiendo experiencias y conocimiento con el resto de interesados del ámbito GIS. Si quieres ponerte en contacto y seguir la evolución de este proyecto puedes hacerlo a través de su perfil de Twitter.