Sabemos que los datos abiertos que gestiona el sector público en el ejercicio de sus funciones constituyen un recurso de gran valor para fomentar la transparencia, impulsar la innovación y estimular el desarrollo económico. A nivel global, en los últimos 15 años esta idea ha llevado a la creación de portales de datos que sirven como punto de acceso único para la información pública tanto de un país, como de una región o ciudad.

Sin embargo, en ocasiones nos encontramos que el pleno aprovechamiento del potencial de los datos abiertos se ve limitado por problemas inherentes a su calidad. Inconsistencias, falta de estandarización o interoperabilidad y metadatos incompletos son solo algunos de los desafíos comunes que a veces merman la utilidad de los conjuntos de datos abiertos y que las agencias gubernamentales además señalan como el principal obstáculo para la adopción de la IA.

Cuando hablamos de la relación entre datos abiertos e inteligencia artificial, casi siempre partimos de la misma idea: los datos abiertos alimentan a la IA, esto es, son parte del combustible de los modelos. Ya sea para entrenar modelos fundacionales como ALIA, para especializar modelos de lenguaje pequeños (SLM) frente a LLM, o para evaluar y validar sus capacidades o explicar su comportamiento (XAI), el argumento gira en torno a la utilidad de los datos abiertos para la inteligencia artificial, olvidando que los datos abiertos ya estaban ahí y tienen muchas otras utilidades.

Por ello, vamos a invertir la perspectiva y a explorar cómo la propia IA puede convertirse en una herramienta poderosa para mejorar la calidad y, por tanto, el valor de los propios datos abiertos. Este enfoque, que ya esbozó la Comisión Económica para Europa de las Naciones Unidas (UNECE) en su pionero informe Machine Learning for Official Statistics de 2022, adquiere una mayor relevancia desde la explosión de la IA generativa. Actualmente podemos utilizar la inteligencia artificial disponible para incrementar la calidad de los conjuntos de datos que se publican a lo largo de todo su ciclo de vida: desde la captura y la normalización hasta la validación, la anonimización, la documentación y el seguimiento en producción.

Con ello, podemos aumentar el valor público del dato, contribuir a que crezca su reutilización y a amplificar su impacto social y económico. Y, al mismo tiempo, a mejorar la calidad de la siguiente generación de modelos de inteligencia artificial.

Desafíos comunes en la calidad de los datos abiertos

La calidad de los datos ha sido tradicionalmente un factor crítico para el éxito de cualquier iniciativa de datos abiertos, que aparece citado en numerosos informes como el de Comisión Europea “Improving data publishing by open data portal managers and owners”. Los desafíos más frecuentes que enfrentan los publicadores de datos incluyen:

-

Inconsistencias y errores: en los conjuntos de datos, es frecuente la presencia de datos duplicados, formatos heterogéneos o valores atípicos. La corrección de estos pequeños errores, idealmente en la propia fuente de los datos, tenía tradicionalmente un coste elevado y limitaba enormemente la utilidad de numerosos conjuntos de datos.

-

Falta de estandarización e interoperabilidad: dos conjuntos que hablan de lo mismo pueden nombrar las columnas de forma diferente, usar clasificaciones no comparables o carecer de identificadores persistentes para enlazar entidades. Sin un mínimo común, combinar fuentes se convierte en un trabajo artesanal que encarece la reutilización de los datos.

- Metadatos incompletos o inexactos: la carencia de información clara sobre el origen, la metodología de recolección, la frecuencia de actualización o el significado de los campos, complica la comprensión y el uso de los datos. Por ejemplo, saber con certeza si se puede integrar el recurso en un servicio, si está al día o si existe un punto de contacto para resolver dudas es muy importante para su reutilización.

- Datos obsoletos o desactualizados: en dominios muy dinámicos como la movilidad, los precios o los datos de medio ambiente, un conjunto desactualizado puede generar conclusiones erróneas. Y si no hay versiones, registro de cambios o indicadores de frescura, es difícil saber qué ha variado y por qué. La ausencia de un “historial” de los datos complica la auditoría y reduce la confianza.

- Sesgos inherentes: a veces la cobertura es incompleta, ciertas poblaciones quedan infrarrepresentadas o una práctica administrativa introduce una desviación sistemática. Si estos límites no se documentan y advierten, los análisis pueden reforzar desigualdades o llegar a conclusiones injustas sin que nadie lo perciba.

Dónde puede ayudar la Inteligencia Artificial

Por fortuna, en su estado actual, la inteligencia artificial ya está en disposición de proporcionar un conjunto de herramientas que pueden contribuir a abordar algunos de estos desafíos de calidad de los datos abiertos, transformando su gestión de un proceso manual y propenso a errores en uno más automatizado y eficiente:

- Detección y corrección de errores automatizada: los algoritmos de aprendizaje automático y los modelos de IA pueden identificar automáticamente y con una gran fiabilidad inconsistencias, duplicados, valores atípicos y errores tipográficos en grandes volúmenes de datos. Además, la IA puede ayudar a normalizar y estandarizar datos, transformándolos por ejemplo a formatos y esquemas comunes para facilitar la interoperabilidad (como DCAT-AP), y con una fracción del coste que suponía hasta el momento.

- Enriquecimiento de metadatos y catalogación: las tecnologías asociadas al procesamiento de lenguaje natural (PLN), incluyendo el uso de modelos de lenguaje grandes (LLM) y pequeños (SLM), puede ayudar en la tarea de analizar descripciones y generar metadatos más completos y precisos. Esto incluye tareas como sugerir etiquetas relevantes, categorías de clasificación o extraer entidades clave (nombres de lugares, organizaciones, etc.) de descripciones textuales para enriquecer los metadatos.

- Anonimización y privacidad: cuando los datos abiertos contienen información que podría afectar a la privacidad, la anonimización se convierte en una tarea crítica, pero, en ocasiones, costosa. La Inteligencia Artificial puede contribuir a que la anonimización sea mucho más robusta y a minimizar riesgos relacionados con la re-identificación al combinar diferentes conjuntos de datos.

Evaluación de sesgos: la IA puede analizar los propios conjuntos de datos abiertos para detectar sesgos de representación o históricos. Esto permite a los publicadores tomar medidas para corregirlos o, al menos, advertir a los usuarios sobre su presencia para que sean tenidos en cuenta cuando vayan a reutilizarse. En definitiva, la inteligencia artificial no debe verse solo como “consumidora” de datos abiertos, sino también como una aliada estratégica para mejorar su calidad. Cuando se integra con estándares, procesos y supervisión humana, la IA ayuda a detectar y explicar incidencias, a documentar mejor los conjuntos y a publicar evidencias de calidad que refuerzan la confianza. Tal y como se describe en la Estrategia de Inteligencia Artificial 2024, esa sinergia libera más valor público: facilita la innovación, permite decisiones mejor informadas y consolida un ecosistema de datos abiertos más robusto y fiable con unos datos abiertos más útiles, más confiables y con mayor impacto social.

Además, se activa un ciclo virtuoso: datos abiertos de mayor calidad entrenan modelos más útiles y seguros; y modelos más capaces facilitan seguir elevando la calidad de los datos. De este modo la gestión del dato deja de ser una tarea estática de publicación y se convierte en un proceso dinámico de mejora continua.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La inteligencia artificial (IA) se ha convertido en una tecnología central en la vida de las personas y en la estrategia de las empresas. En poco más de una década hemos pasado de interactuar con asistentes virtuales que entendían órdenes sencillas, a ver sistemas capaces de redactar informes completos, crear imágenes hiperrealistas o incluso escribir código.

Este salto tan visible ha hecho que muchos se pregunten: ¿es todo lo mismo?, ¿qué diferencia hay entre lo que ya conocíamos como IA y esta nueva “IA Generativa” de la que tanto se habla?

En este artículo vamos a ordenar esas ideas y explicar, con ejemplos claros, cómo encajan la IA “Tradicional” y la IA Generativa bajo el gran paraguas de la inteligencia artificial.

La IA tradicional: análisis y predicción

Durante muchos años, lo que entendíamos por IA estaba más cerca de lo que hoy llamamos “IA Tradicional”. Estos sistemas se caracterizan por resolver problemas concretos, bien definidos y dentro de un marco de reglas o datos disponibles.

Algunos ejemplos prácticos:

-

Motores de recomendación: Spotify sugiere canciones basadas en tu historial de escucha y Netflix ajusta su catálogo a tus gustos personales, generando hasta el 80% de las visualizaciones en la plataforma.

-

Sistemas de predicción: Walmart utiliza modelos predictivos para anticipar la demanda de productos en función de factores como el clima o eventos locales; Red Eléctrica de España aplica algoritmos similares para prever el consumo eléctrico y equilibrar la red.

- Reconocimiento automático: Google Photos clasifica imágenes reconociendo rostros y objetos; Visa y Mastercard usan modelos de detección de anomalías para identificar fraudes en tiempo real; herramientas como Otter.ai transcriben reuniones y llamadas automáticamente.

En todos estos casos, los modelos aprenden de datos pasados para ofrecer una clasificación, una predicción o una decisión. No inventan nada nuevo, sino que reconocen patrones y los aplican al futuro.

La IA Generativa: creación de contenido

La novedad de la IA generativa es que no solo analiza, sino que produce (genera) a partir de los datos que tiene.

En la práctica, esto significa que:

-

Puede generar texto estructurado a partir de un par de ideas iniciales.

-

Puede combinar elementos visuales existentes a partir de una descripción escrita.

-

Puede crear prototipos de productos, borradores de presentaciones o proponer fragmentos de código basados en patrones aprendidos.

La clave está en que los modelos generativos no se limitan a clasificar o predecir, sino que generan nuevas combinaciones basadas en lo que aprendieron durante su entrenamiento.

El impacto de este avance es enorme: en el mundo del desarrollo, GitHub Copilot ya incluye agentes que detectan y corrigen errores de programación por sí mismos; en diseño, la herramienta Nano Banana de Google promete revolucionar la edición de imágenes con una eficacia que podría dejar obsoletos programas como Photoshop; y en música, bandas enteramente creadas por IA como Velvet Velvet Sundown ya superan el millón de oyentes mensuales en Spotify, con canciones, imágenes y biografía totalmente generadas, sin músicos reales detrás.

¿Cuándo es mejor utilizar cada tipo de IA?

La elección entre IA Tradicional y Generativa no es cuestión de moda, sino de qué necesidad concreta se quiere resolver. Cada una brilla en situaciones distintas:

IA Tradicional: la mejor opción cuando…

-

Necesitas predecir comportamientos futuros basándote en datos históricos (ventas, consumo energético, mantenimiento predictivo).

-

Quieres detectar anomalías o clasificar información de forma precisa (fraude en transacciones, diagnóstico por imágenes, spam).

-

Buscas optimizar procesos para ganar eficiencia (logística, rutas de transporte, gestión de inventarios).

-

Trabajas en entornos críticos donde la fiabilidad y la precisión son imprescindibles (salud, energía, finanzas).

Utilízala cuando el objetivo es tomar decisiones basadas en datos reales con la máxima precisión posible.

IA Generativa: la mejor opción cuando…

-

Necesitas crear contenido (textos, imágenes, música, vídeos, código).

-

Quieres prototipar o experimentar con rapidez, explorando diferentes escenarios antes de decidir (diseño de productos, pruebas en I+D).

-

Buscas interacción más natural con usuarios (chatbots, asistentes virtuales, interfaces conversacionales).

-

Requieres personalización a gran escala, generando mensajes o materiales adaptados a cada individuo (marketing, formación, educación).

-

Te interesa simular escenarios que no puedes obtener fácilmente con datos reales (casos clínicos ficticios, datos sintéticos para entrenar otros modelos).

Utilízala cuando el objetivo es crear, personalizar o interactuar de una manera más humana y flexible.

Un ejemplo del ámbito sanitario lo ilustra bien:

-

La IA tradicional puede analizar miles de registros clínicos para anticipar la probabilidad de que un paciente desarrolle una enfermedad.

-

La IA generativa puede crear escenarios ficticios para entrenar a estudiantes de medicina, generando casos clínicos realistas sin exponer datos reales de pacientes.

¿Compiten o se complementan?

En 2019, Gartner introdujo el concepto de Composite AI para describir soluciones híbridas que combinaban distintos enfoques de inteligencia artificial con el fin de resolver un problema de manera más completa. Aunque entonces era un término poco extendido, hoy cobra más relevancia que nunca gracias a la irrupción de la IA Generativa.

La IA Generativa no sustituye a la IA Tradicional, sino que la complementa. Cuando se integran ambos enfoques dentro de un mismo flujo de trabajo, se logran resultados mucho más potentes que si se empleara cada tecnología por separado.

Aunque, según Gartner, Composite AI continúa en la fase de Innovation Trigger, donde una tecnología emergente comienza a generar interés, y aunque su uso práctico todavía es limitado, ya vemos muchas nuevas tendencias generándose en múltiples sectores:

-

En retail: un sistema tradicional predice cuántos pedidos recibirá una tienda la próxima semana, y una IA generativa genera automáticamente descripciones de producto personalizadas para los clientes de esos pedidos.

-

En educación: un modelo tradicional evalúa el progreso de los estudiantes y detecta áreas débiles, mientras que una IA generativa diseña ejercicios o materiales adaptados a esas necesidades.

-

En diseño industrial: un algoritmo tradicional optimiza la logística de fabricación, mientras que una IA generativa propone prototipos de nuevas piezas o productos.

En definitiva, en lugar de cuestionar qué tipo de IA es más avanzada, lo acertado es preguntarse: ¿qué problema quiero resolver y qué enfoque de IA es el adecuado para ello?

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Desde hoy, 15 de septiembre, están abiertas las inscripciones para uno de los eventos más importantes del sector geoespacial en la península ibérica. Las XVI Jornadas Ibéricas de Infraestructuras de Datos Espaciales (JIIDE 2025) se celebrarán en Oviedo del 12 al 14 de noviembre de 2025. Este encuentro anual representa una oportunidad única para explorar las últimas tendencias en reutilización de datos espaciales, especialmente en el contexto de la aplicación de inteligencia artificial al conocimiento territorial.

Desde su primera edición en 2011, las JIIDE han evolucionado como resultado de la colaboración entre la Direção-Geral do Território de Portugal, el Instituto Geográfico Nacional de España a través del Centro Nacional de Información Geográfica, y el Gobierno de Andorra. En esta decimosexta edición se suman también la Consejería de Ordenación del Territorio, Urbanismo, Vivienda y Derechos Ciudadanos del Principado de Asturias y la Universidad de Oviedo, consolidando así una iniciativa que reúne cada año a centenares de profesionales de la Administración pública, el sector privado y el ámbito académico.

Durante tres días, expertos con acreditada experiencia y conocimiento técnico en información geográfica compartirán sus desarrollos más innovadores, metodologías de trabajo y casos de éxito en la gestión y reutilización de datos espaciales.

Dos ejes: la inteligencia artificial y el marco normativo INSPIRE y HVDS

El tema central de esta edición, "IA y territorio: explorando las nuevas fronteras del conocimiento espacial", refleja la evolución natural del sector hacia la incorporación de tecnologías emergentes. La inteligencia artificial, el aprendizaje automático y los algoritmos de análisis avanzado están transformando radicalmente la manera en que procesamos, analizamos y extraemos valor de los datos geoespaciales.

Esta orientación hacia la IA no es casual. La publicación y de los datos geoespaciales permite aprovechar uno de los activos digitales más valiosos para el desarrollo económico, la vigilancia medioambiental, la competitividad, la innovación y la creación de empleo. Cuando estos datos se combinan con técnicas de inteligencia artificial, su potencial se multiplica exponencialmente.

Las jornadas se desarrollan en un momento especialmente relevante para el ecosistema de datos abiertos. La Directiva INSPIRE, junto con la Directiva (UE) 2019/1024 sobre datos abiertos y reutilización de la información del sector público, ha establecido un marco regulatorio que reconoce explícitamente el valor económico y social de los datos geoespaciales digitales.

La evolución en la publicación de los conjuntos de datos de alto valor marca un hito importante en este proceso. Estos conjuntos, caracterizados por su gran potencial para la reutilización, deben estar disponibles de forma gratuita, en formatos legibles por máquinas y a través de interfaces de programación de aplicaciones (API). Los datos geoespaciales ocupan una posición central en esta categorización, lo que subraya su importancia estratégica para el ecosistema de datos abiertos europeo.

Las JIIDE 2025 dedicarán especial atención a presentar ejemplos prácticos de reutilización de estos conjuntos de datos de alto valor, tanto mediante las nuevas OGC API como a través de los servicios de descarga tradicionales y los formatos interoperables establecidos. Esta aproximación práctica permitirá a los asistentes conocer casos reales de implementación y sus resultados tangibles.

Programa diverso: casos de uso, IA y reutilización de datos geoespaciales

También puedes consultar el programa aquí. Entre las actividades previstas, hay sesiones que abarcan desde aspectos técnicos fundamentales hasta aplicaciones innovadoras que demuestran el potencial transformador de estos datos. Las actividades se organizan en cinco temáticas principales:

Estructura de datos espaciales y metadatos.

Gestión y publicación de datos.

Desarrollo de software espacial.

Inteligencia artificial.

Cooperación entre agentes.

Algunos de los temas destacados son la gestión de proyectos y coordinación, donde se presentarán sistemas corporativos como el SIG de la Junta de Andalucía o el SITNA del Gobierno de Navarra. La observación de la Tierra ocupará también un lugar prominente, con presentaciones sobre la evolución del programa del Plan Nacional de Ortofotografía Aérea (APNOA) y técnicas avanzadas de procesamiento de imágenes mediante deep learning.

Por otro lado, los visualizadores temáticos también representan otro eje fundamental, mostrando cómo los datos espaciales pueden transformarse en herramientas accesibles para la ciudadanía. Desde visualizadores de eclipses hasta herramientas para calcular el potencial solar de los tejados, se presentarán desarrollos que demuestran cómo la reutilización creativa de datos puede generar servicios de alto valor social.

Siguiendo la temática anual, la aplicación de IA a los datos geoespaciales se abordará desde múltiples perspectivas. Se presentarán casos de uso en áreas tan diversas como la detección automática de instalaciones deportivas, la clasificación de nubes de puntos LiDAR, la identificación de materiales peligrosos como el amianto, o la optimización de la movilidad urbana.

Una de las sesiones más relevantes para la comunidad de datos abiertos se centrará específicamente en "Reutilización y gobierno abierto". Esta sesión abordará la integración de las infraestructuras de datos espaciales en los portales de datos abiertos, los metadatos de datos espaciales según el estándar GeoDCAT-AP, y la aplicación de normativas de calidad del dato.

Las administraciones locales desempeñan un papel fundamental en la generación y publicación de datos espaciales. Por este motivo, las JIIDE 2025 dedicarán una sesión específica a la publicación de datos locales, donde municipios como Barcelona, Madrid, Bilbao o Cáceres compartirán sus experiencias y desarrollos.

Además de las sesiones teóricas, las jornadas incluyen talleres prácticos sobre herramientas, metodologías y tecnologías específicas. Estos talleres, de 45 minutos a una hora de duración, permiten a los asistentes experimentar directamente con las soluciones presentadas. Algunos de ellos abordan la creación de geoportales web personalizados y otros, por ejemplo, la implementación de API OGC, pasando por técnicas de visualización avanzada y herramientas de gestión de metadatos.

Participa de manera presencial u online

Las JIIDE mantienen su compromiso con la participación abierta, invitando tanto a investigadores como a profesionales a presentar sus herramientas, soluciones técnicas, metodologías de trabajo y casos de éxito. Además, las JIIDE 2025 se celebrarán en modalidad híbrida, permitiendo tanto la participación presencial en Oviedo como el seguimiento virtual.

Esta flexibilidad, mantenida desde las experiencias de los últimos años, garantiza que los profesionales de todo el territorio ibérico y más allá puedan beneficiarse del conocimiento compartido. La participación continúa siendo gratuita, aunque requiere registro previo en cada sesión, mesa redonda o taller.

Desde hoy mismo, puedes inscribirte y aprovechar esta oportunidad de aprendizaje e intercambio de experiencias sobre datos geoespaciales. Las inscripciones están disponibles en la web oficial del evento: https://www.jiide.org/web/portal/inicio

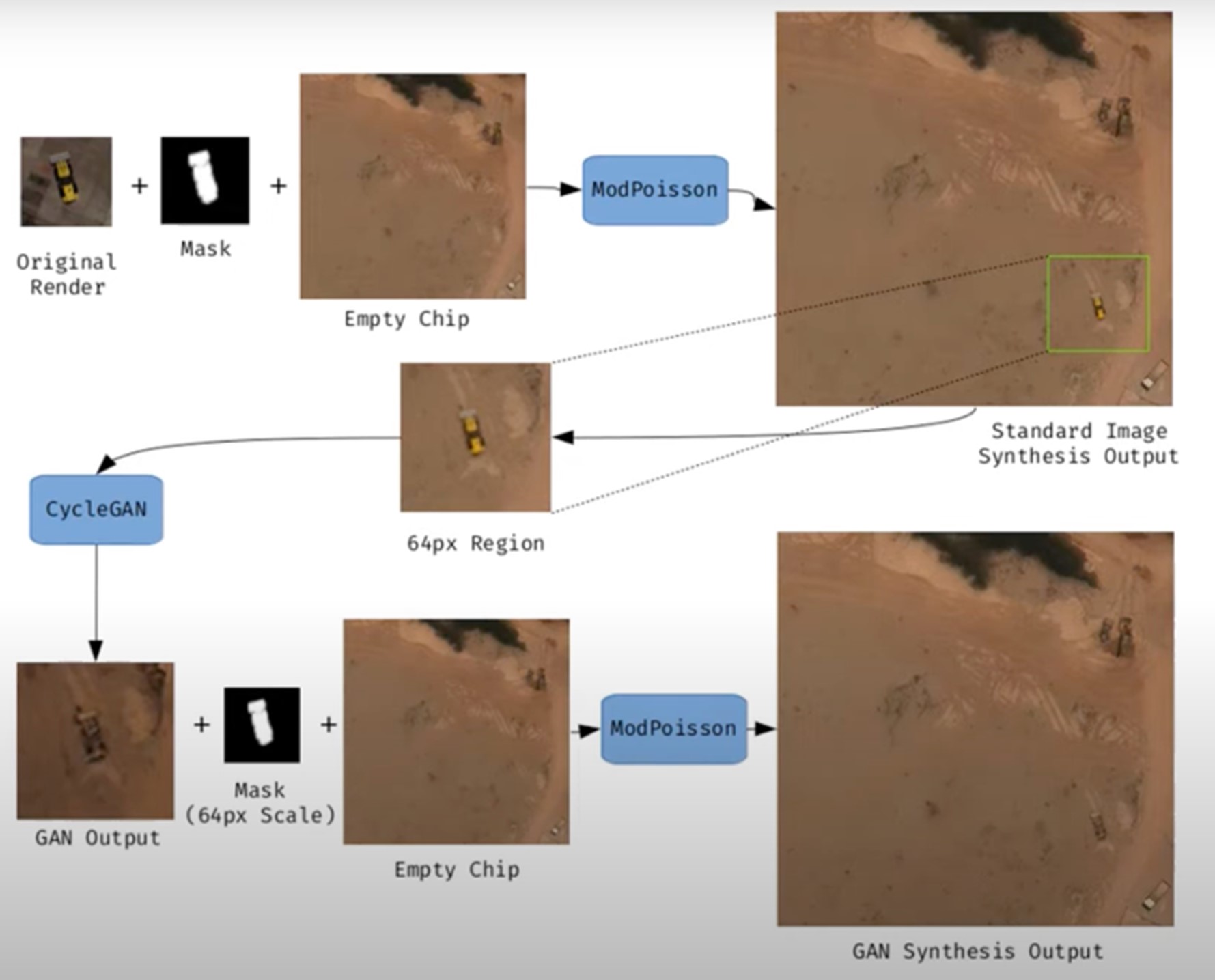

Las imágenes sintéticas son representaciones visuales generadas de forma artificial mediante algoritmos y técnicas computacionales, en lugar de capturarse directamente de la realidad con cámaras o sensores. Se producen a partir de distintos métodos, entre los que destacan las redes generativas antagónicas (Generative Adversarial Networks, GAN), los modelos de difusión, y las técnicas de renderizado 3D. Todas ellas permiten crear imágenes de apariencia realista que en muchos casos resultan indistinguibles de una fotografía auténtica.

Cuando se traslada este concepto al campo de la observación de la Tierra, hablamos de imágenes satelitales sintéticas. Estas no se obtienen a partir de un sensor espacial que capta radiación electromagnética real, sino que se generan digitalmente para simular lo que vería un satélite desde la órbita. En otras palabras, en vez de reflejar directamente el estado físico del terreno o la atmósfera en un momento concreto, son construcciones computacionales capaces de imitar el aspecto de una imagen satelital real.

El desarrollo de este tipo de imágenes responde a necesidades prácticas. Los sistemas de inteligencia artificial que procesan datos de teledetección requieren conjuntos muy amplios y variados de imágenes. Las imágenes sintéticas permiten, por ejemplo, recrear zonas de la Tierra poco observadas, simular desastres naturales -como incendios forestales, inundaciones o sequías- o generar condiciones específicas que son difíciles o costosas de capturar en la práctica. De este modo, constituyen un recurso valioso para entrenar algoritmos de detección y predicción en agricultura, gestión de emergencias, urbanismo o monitorización ambiental.

Figura 1. Ejemplo de generación de una imagen satelital sintética.

Su valor no se limita al entrenamiento de modelos. Allí donde no existen imágenes de alta resolución —por limitaciones técnicas, restricciones de acceso o motivos económicos—, la síntesis permite rellenar huecos de información y facilitar estudios preliminares. Por ejemplo, los investigadores pueden trabajar con imágenes sintéticas aproximadas para diseñar modelos de riesgo o simulaciones antes de disponer de datos reales.

Sin embargo, las imágenes satelitales sintéticas también plantean riesgos importantes. La posibilidad de generar escenas muy realistas abre la puerta a la manipulación y a la desinformación. En un contexto geopolítico, una imagen que muestre tropas inexistentes o infraestructuras destruidas podría influir en decisiones estratégicas o en la opinión pública internacional. En el terreno ambiental, se podrían difundir imágenes manipuladas para exagerar o minimizar impactos de fenómenos como la deforestación o el deshielo, con efectos directos en políticas y mercados.

Por ello, conviene diferenciar dos usos muy distintos. El primero es el uso como apoyo, cuando las imágenes sintéticas complementan a las reales para entrenar modelos o realizar simulaciones. El segundo es el uso como falsificación, cuando se presentan deliberadamente como imágenes auténticas con el fin de engañar. Mientras el primer uso impulsa la innovación, el segundo amenaza la confianza en los datos satelitales y plantea un reto urgente de autenticidad y gobernanza.

Riesgos de las imágenes satelitales aplicada a la observación de la Tierra

Las imágenes satelitales sintéticas plantean riesgos significativos cuando se utilizan en vez de imágenes captadas por sensores reales. A continuación, se detallan ejemplos que lo demuestran.

Un nuevo frente de desinformación: “deepfake geography”

El término deepfake geography ya se ha consolidado en la literatura académica y divulgativa para describir imágenes satelitales ficticias, manipuladas con IA, que parecen auténticas, pero no reflejan ninguna realidad existente. Una investigación de la Universidad de Washington, liderada por Bo Zhao, utilizó algoritmos como CycleGAN para modificar imágenes de ciudades reales -por ejemplo, alterando la apariencia de Seattle con edificios inexistentes o transformando Beijing en zonas verdes- lo que pone en evidencia el potencial para generar paisajes falsos convincentes.

Un artículo de la plataforma OnGeo Intelligence (OGC) subraya que estas imágenes no son puramente teóricas, sino amenazas reales que afectan a la seguridad nacional, el periodismo y el trabajo humanitario. Por su parte, el OGC advierte que ya se han observado imágenes satelitales fabricadas, modelos urbanos generados por IA y redes de carreteras sintéticas, y que representan desafíos reales a la confianza pública y operativa.

Implicaciones estratégicas y políticas

Las imágenes satelitales son consideradas "ojos imparciales" sobre el planeta, usadas por gobiernos, medios y organizaciones. Cuando estas imágenes se falsifican, sus consecuencias pueden ser graves:

- Seguridad nacional y defensa: si se presentan infraestructuras falsas o se ocultan otras reales, se pueden desviar análisis estratégicos o inducir decisiones militares equivocadas.

- Desinformación en conflictos o crisis humanitarias: una imagen alterada que muestre incendios, inundaciones o movimientos de tropas falsos puede alterar la respuesta internacional, los flujos de ayuda o la percepción de los ciudadanos, especialmente si se difunde por redes sociales o medios sin verificación.

- Manipulación de imágenes realistas de lugares: no solo las imágenes generales están en juego. Nguyen y colaboradores (2024) demostraron que es posible generar imágenes satelitales sintéticas altamente realistas de instalaciones muy específicas como plantas nucleares.

Crisis de confianza y erosión de la verdad

Durante décadas, las imágenes satelitales han sido percibidas como una de las fuentes más objetivas y fiables de información sobre nuestro planeta. Eran la prueba gráfica que permitía confirmar fenómenos ambientales, seguir conflictos armados o evaluar el impacto de desastres naturales. En muchos casos, estas imágenes se utilizaban como “evidencia imparcial”, difíciles de manipular y fáciles de validar. Sin embargo, la irrupción de las imágenes sintéticas generadas por inteligencia artificial ha empezado a poner en cuestión esa confianza casi inquebrantable.

Hoy en día, cuando una imagen satelital puede ser falsificada con gran realismo, surge un riesgo profundo: la erosión de la verdad y la aparición de una crisis de confianza en los datos espaciales.

La quiebra de la confianza pública

Cuando los ciudadanos ya no pueden distinguir entre una imagen real y una fabricada, se resquebraja la confianza en las fuentes de información. La consecuencia es doble:

- Desconfianza hacia las instituciones: si circulan imágenes falsas de un incendio, una catástrofe o un despliegue militar y luego resultan ser sintéticas, la ciudadanía puede empezar a dudar también de las imágenes auténticas publicadas por agencias espaciales o medios de comunicación. Este efecto “que viene el lobo” genera escepticismo incluso frente a pruebas legítimas.

- Efecto en el periodismo: los medios tradicionales, que han usado históricamente las imágenes satelitales como fuente visual incuestionable, corren el riesgo de perder credibilidad si publican imágenes adulteradas sin verificación. Al mismo tiempo, la abundancia de imágenes falsas en redes sociales erosiona la capacidad de distinguir qué es real y qué no.

- Confusión deliberada: en contextos de desinformación, la mera sospecha de que una imagen pueda ser falsa ya puede bastar para generar duda y sembrar confusión, aunque la imagen original sea completamente auténtica.

A continuación, se resumen los posibles casos de manipulación y riesgo en imágenes satelitales:

| Ámbito | Tipo de manipulación | Riesgo principal | Ejemplo documentado |

|---|---|---|---|

| Conflictos armados | Inserción o eliminación de infraestructuras militares. | Desinformación estratégica; decisiones militares erróneas; pérdida de credibilidad en observación internacional. | Alteraciones demostradas en estudios de deepfake geography donde se añadían carreteras, puentes o edificios ficticios en imágenes satelitales. |

| Cambio climático y medio ambiente | Alteración de glaciares, deforestación o emisiones. | Manipulación de políticas ambientales; retraso en medidas contra el cambio climático; negacionismo. | Estudios han mostrado la capacidad de generar paisajes modificados (bosques en zonas urbanas, cambios en el hielo) mediante GAN. |

| Gestión de emergencias | Creación de desastres inexistentes (incendios, inundaciones). | Mal uso de recursos en emergencias; caos en evacuaciones; pérdida de confianza en agencias. | Investigaciones han demostrado la facilidad de insertar humo, fuego o agua en imágenes satelitales. |

| Mercados y seguros | Falsificación de daños en infraestructuras o cultivos. | Impacto financiero; fraude masivo; litigios legales complejos. | Uso potencial de imágenes falsas para exagerar daños tras desastres y reclamar indemnizaciones o seguros. |

| Derechos humanos y justicia internacional | Alteración de pruebas visuales sobre crímenes de guerra. | Deslegitimación de tribunales internacionales; manipulación de la opinión pública. | Riesgo identificado en informes de inteligencia: imágenes adulteradas podrían usarse para acusar o exonerar a actores en conflictos. |

| Geopolítica y diplomacia | Creación de ciudades ficticias o cambios fronterizos. | Tensiones diplomáticas; cuestionamiento de tratados; propaganda estatal. | Ejemplos de deepfake maps que transforman rasgos geográficos de ciudades como Seattle o Tacoma. |

Figura 2. Tabla con los posibles casos de manipulación y riesgo en imágenes satelitales

Impacto en la toma de decisiones y políticas públicas

Las consecuencias de basarse en imágenes adulteradas van mucho más allá del terreno mediático:

- Urbanismo y planificación: decisiones sobre dónde construir infraestructuras o cómo planificar zonas urbanas podrían tomarse sobre imágenes manipuladas, generando errores costosos y de difícil reversión.

- Gestión de emergencias: si una inundación o un incendio se representan en imágenes falsas, los equipos de emergencia pueden destinar recursos a lugares equivocados, mientras descuidan zonas realmente afectadas.

- Cambio climático y medio ambiente: imágenes adulteradas de glaciares, deforestación o emisiones contaminantes podrían manipular debates políticos y retrasar la implementación de medidas urgentes.

- Mercados y seguros: aseguradoras y empresas financieras que confían en imágenes satelitales para evaluar daños podrían ser engañadas, con consecuencias económicas significativas.

En todos estos casos, lo que está en juego no es solo la calidad de la información, sino la eficacia y legitimidad de las políticas públicas basadas en esos datos.

El juego del gato y el ratón tecnológico

La dinámica de generación y detección de falsificaciones ya se conoce en otros ámbitos, como los deepfakes de vídeo o audio: cada vez que surge un método de generación más realista, se desarrolla un algoritmo de detección más avanzado, y viceversa. En el ámbito de las imágenes satelitales, esta carrera tecnológica tiene particularidades:

- Generadores cada vez más sofisticados: los modelos de difusión actuales pueden crear escenas de gran realismo, integrando texturas de suelo, sombras y geometrías urbanas que engañan incluso a expertos humanos.

- Limitaciones de la detección: aunque se desarrollan algoritmos para identificar falsificaciones (analizando patrones de píxeles, inconsistencias en sombras o metadatos), estos métodos no siempre son fiables cuando se enfrentan a generadores de última generación.

- Coste de la verificación: verificar de forma independiente una imagen satelital requiere acceso a fuentes alternativas o sensores distintos, algo que no siempre está al alcance de periodistas, ONG o ciudadanos.

- Armas de doble filo: las mismas técnicas usadas para detectar falsificaciones pueden ser aprovechadas por quienes las generan, perfeccionando aún más las imágenes sintéticas y haciendo más difícil diferenciarlas.

De la prueba visual a la prueba cuestionada

El impacto más profundo es cultural y epistemológico: lo que antes se asumía como una prueba objetiva ahora se convierte en un elemento sujeto a duda. Si las imágenes satelitales dejan de ser percibidas como evidencia fiable, se debilitan narrativas fundamentales en torno a la verdad científica, la justicia internacional y la rendición de cuentas política.

- En conflictos armados, una imagen de satélite que muestre posibles crímenes de guerra puede ser descartada bajo la acusación de ser un deepfake.

- En tribunales internacionales, pruebas basadas en observación satelital podrían perder peso frente a la sospecha de manipulación.

- En el debate público, el relativismo de “todo puede ser falso” puede usarse como arma retórica para deslegitimar incluso la evidencia más sólida.

Estrategias para garantizar autenticidad

La crisis de confianza en las imágenes satelitales no es un problema aislado del sector geoespacial, sino que forma parte de un fenómeno más amplio: la desinformación digital en la era de la inteligencia artificial. Así como los deepfakes de vídeo han puesto en cuestión la validez de pruebas audiovisuales, la proliferación de imágenes satelitales sintéticas amenaza con debilitar la última frontera de datos percibidos como objetivos: la mirada imparcial desde el espacio.

Garantizar la autenticidad de estas imágenes exige una combinación de soluciones técnicas y mecanismos de gobernanza, capaces de reforzar la trazabilidad, la transparencia y la responsabilidad en toda la cadena de valor de los datos espaciales. A continuación, se describen las principales estrategias en desarrollo.

Metadatos robustos: registrar el origen y la cadena de custodia

Los metadatos constituyen la primera línea de defensa frente a la manipulación. En imágenes satelitales, deben incluir información detallada sobre:

- El sensor utilizado (tipo, resolución, órbita).

- El momento exacto de la adquisición (fecha y hora, con precisión temporal).

- La localización geográfica precisa (sistemas de referencia oficiales).

- La cadena de procesado aplicada (correcciones atmosféricas, calibraciones, reproyecciones).

Registrar estos metadatos en repositorios seguros permite reconstruir la cadena de custodia, es decir, el historial de quién, cómo y cuándo ha manipulado una imagen. Sin esta trazabilidad, resulta imposible distinguir entre imágenes auténticas y falsificadas.

EJEMPLO: el programa Copernicus de la Unión Europea ya implementa metadatos estandarizados y abiertos para todas sus imágenes Sentinel, lo que facilita auditorías posteriores y confianza en el origen.

Firmas digitales y blockchain: garantizar la integridad

Las firmas digitales permiten verificar que una imagen no ha sido alterada desde su captura. Funcionan como un sello criptográfico que se aplica en el momento de adquisición y se valida en cada uso posterior.

La tecnología blockchain ofrece un nivel adicional de garantía: almacenar los registros de adquisición y modificación en una cadena inmutable de bloques. De esta manera, cualquier cambio en la imagen o en sus metadatos quedaría registrado y sería fácilmente detectable.

EJEMPLO: el proyecto ESA – Trusted Data Framework explora el uso de blockchain para proteger la integridad de datos de observación de la Tierra y reforzar la confianza en aplicaciones críticas como cambio climático y seguridad alimentaria.

Marcas de agua invisible: señales ocultas en la imagen

El marcado de agua digital consiste en incrustar señales imperceptibles en la propia imagen satelital, de modo que cualquier alteración posterior se pueda detectar automáticamente.

- Puede hacerse a nivel de píxel, modificando ligeramente patrones de color o luminancia.

- Se combina con técnicas criptográficas para reforzar su validez.

- Permite validar imágenes incluso si han sido recortadas, comprimidas o reprocesadas.

EJEMPLO: en el sector audiovisual, las marcas de agua se usa desde hace años en la protección de contenidos digitales. Su adaptación a imágenes satelitales está en fase experimental, pero podría convertirse en una herramienta estándar de verificación.

Estándares abiertos (OGC, ISO): confianza mediante interoperabilidad

La estandarización es clave para garantizar que las soluciones técnicas se apliquen de forma coordinada y global.

- OGC (Open Geospatial Consortium) trabaja en estándares para la gestión de metadatos, la trazabilidad de datos geoespaciales y la interoperabilidad entre sistemas. Su trabajo en API geoespaciales y metadatos FAIR (Findable, Accessible, Interoperable, Reusable) es esencial para establecer prácticas comunes de confianza.

- ISO desarrolla normas sobre gestión de la información y autenticidad de registros digitales que también pueden aplicarse a imágenes satelitales.

EJEMPLO: el OGC Testbed-19 incluyó experimentos específicos sobre autenticidad de datos geoespaciales, probando enfoques como firmas digitales y certificados de procedencia.

Verificación cruzada: combinar múltiples fuentes

Un principio básico para detectar falsificaciones es contrastar fuentes. En el caso de imágenes satelitales, esto implica:

- Comparar imágenes de diferentes satélites (ej. Sentinel-2 vs. Landsat-9).

- Usar distintos tipos de sensores (ópticos, radar SAR, hiperespectrales).

- Analizar series temporales para verificar la consistencia en el tiempo.

EJEMPLO: la verificación de daños en Ucrania tras el inicio de la invasión rusa en 2022 se realizó mediante la comparación de imágenes de varios proveedores (Maxar, Planet, Sentinel), asegurando que los hallazgos no se basaban en una sola fuente.

IA contra IA: detección automática de falsificaciones

La misma inteligencia artificial que permite crear imágenes sintéticas se puede utilizar para detectarlas. Las técnicas incluyen:

- Análisis forense de píxeles: identificar patrones generados por GAN o modelos de difusión.

- Redes neuronales entrenadas para distinguir entre imágenes reales y sintéticas en función de texturas o distribuciones espectrales.

- Modelos de inconsistencias geométricas: detectar sombras imposibles, incoherencias topográficas o patrones repetitivos.

EJEMPLO: investigadores de la Universidad de Washington y otros grupos han demostrado que algoritmos específicos pueden detectar falsificaciones satelitales con una precisión superior al 90% en condiciones controladas.

Experiencias actuales: iniciativas globales

Varios proyectos internacionales ya trabajan en mecanismos para reforzar la autenticidad:

- Coalition for Content Provenance and Authenticity (C2PA): una alianza entre Adobe, Microsoft, BBC, Intel y otras organizaciones para desarrollar un estándar abierto de procedencia y autenticidad de contenidos digitales, incluyendo imágenes. Su modelo se puede aplicar directamente al sector satelital.

- Trabajo del OGC: la organización impulsa el debate sobre confianza en datos geoespaciales y ha destacado la importancia de garantizar la trazabilidad de imágenes satelitales sintéticas y reales (OGC Blog).

- NGA (National Geospatial-Intelligence Agency) en EE. UU. ha reconocido públicamente la amenaza de imágenes sintéticas en defensa y está impulsando colaboraciones con academia e industria para desarrollar sistemas de detección.

Hacia un ecosistema de confianza

Las estrategias descritas no deben entenderse como alternativas, sino como capas complementarias en un ecosistema de confianza:

|

Id |

Capas |

¿Qué aportan? |

|---|---|---|

| 1 | Metadatos robustos (origen, sensor, cadena de custodia) |

Garantizan trazabilidad |

| 2 | Firmas digitales y blockchain (integridad de datos) |

Aseguran integridad |

| 3 | Marcas de agua invisible (señales ocultas) |

Añade un nivel oculto de protección |

| 4 | Verificación cruzada (múltiples satélites y sensores) |

Valida con independencia |

| 5 | IA contra IA (detector de falsificaciones) |

Responde a amenazas emergentes |

| 6 | Gobernanza internacional (responsabilidad, marcos legales) |

Articula reglas claras de responsabilidad |

Figura 3. Capas para garantizar la confianza en las imágenes sintéticas satelitales

El éxito dependerá de que estos mecanismos se integren de manera conjunta, bajo marcos abiertos y colaborativos, y con la implicación activa de agencias espaciales, gobiernos, sector privado y comunidad científica.

Conclusiones

Las imágenes sintéticas, lejos de ser únicamente una amenaza, representan una herramienta poderosa que, bien utilizada, puede aportar un valor significativo en ámbitos como la simulación, el entrenamiento de algoritmos o la innovación en servicios digitales. El problema surge cuando estas imágenes se presentan como reales sin la debida transparencia, alimentando la desinformación o manipulando la percepción pública.

El reto, por tanto, es doble: aprovechar las oportunidades que ofrece la síntesis de datos visuales para avanzar en ciencia, tecnología y gestión, y minimizar los riesgos asociados al mal uso de estas capacidades, especialmente en forma de deepfakes o falsificaciones deliberadas.

En el caso particular de las imágenes satelitales, la confianza adquiere una dimensión estratégica. De ellas dependen decisiones críticas en seguridad nacional, respuesta a desastres, políticas ambientales y justicia internacional. Si la autenticidad de estas imágenes se pone en duda, se compromete no solo la fiabilidad de los datos, sino también la legitimidad de las decisiones basadas en ellos.

El futuro de la observación de la Tierra estará condicionado por nuestra capacidad de garantizar la autenticidad, transparencia y trazabilidad en toda la cadena de valor: desde la adquisición de los datos hasta su difusión y uso final. Las soluciones técnicas (metadatos robustos, firmas digitales, blockchain, marcas de agua, verificación cruzada e IA para detección de falsificaciones), combinadas con marcos de gobernanza y cooperación internacional, serán la clave para construir un ecosistema de confianza.

En definitiva, debemos asumir un principio rector sencillo pero contundente:

“Si no podemos confiar en lo que vemos desde el espacio, ponemos en riesgo nuestras decisiones en la Tierra.”

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los asistentes de inteligencia artificial (IA) ya forman parte de nuestro día a día: les preguntamos la hora, cómo llegar a un determinado lugar o les pedimos que reproduzcan nuestra canción favorita. Y aunque la IA, en el futuro, pueda llegar a ofrecernos infinitas funcionalidades, no hay que olvidar que la diversidad lingüística es aún una asignatura pendiente.

En España, donde conviven el castellano junto con lenguas cooficiales como el euskera, catalán, valenciano y gallego, esta cuestión cobra especial relevancia. La supervivencia y vitalidad de estas lenguas en la era digital depende, en gran medida, de su capacidad para adaptarse y estar presentes en las tecnologías emergentes. Actualmente, la mayoría de asistentes virtuales, traductores automáticos o sistemas de reconocimiento de voz no entienden todos los idiomas cooficiales. Sin embargo, ¿sabías que existen proyectos colaborativos para garantizar la diversidad lingüística?

En este post te contamos el planteamiento y los mayores avances de algunas iniciativas que están construyendo los cimientos digitales necesarios para que las lenguas cooficiales en España también prosperen en la era de la inteligencia artificial.

ILENIA, el paraguas coordinador de iniciativas de recursos multilingües en España

Los modelos que vamos a ver en este post comparten enfoque porque forman parte de ILENIA, coordinador a nivel estatal que conecta los esfuerzos individuales de las comunidades autónomas. Esta iniciativa agrupa los proyectos BSC-CNS (AINA), CENID (VIVES), HiTZ (NEL-GAITU) y la Universidad de Santiago de Compostela (NÓS), con el objetivo de generar recursos digitales que permitan desarrollar aplicaciones multilingües en las diferentes lenguas de España.

El éxito de estas iniciativas depende fundamentalmente de la participación ciudadana. A través de plataformas como Common Voice de Mozilla, cualquier hablante puede contribuir a la construcción de estos recursos lingüísticos mediante diferentes modalidades de colaboración:

- Habla leída: recopilar diferentes maneras de hablar a través de las donaciones de voz de un texto específico.

- Habla espontánea: crea datasets reales y orgánicos fruto de conversaciones con los prompts.

- Texto en idioma: colaborar en la transcripción de audios o en la aportación de contenido textual, sugiriendo nuevas frases o preguntas para enriquecer los corpus.

Todos los recursos se publican bajo licencias libres como CC0, permitiendo su uso gratuito por parte de investigadores, desarrolladores y empresas.

El reto de la diversidad lingüística en la era digital

Los sistemas de inteligencia artificial aprenden de los datos que reciben durante su entrenamiento. Para desarrollar tecnologías que funcionen correctamente en una lengua específica, es imprescindible contar con grandes volúmenes de datos: grabaciones de audio, corpus de texto y ejemplos de uso real del idioma.

En otras publicaciones de datos.gob.es hemos abordado el funcionamiento de los modelos fundacionales y las iniciativas en castellano como ALIA, entrenadas con grandes corpus de texto como los de la Real Academia Española.

En ambos posts se explica por qué la recopilación de datos lingüísticos no es una tarea barata ni sencilla. Las empresas tecnológicas han invertido masivamente en recopilar estos recursos para lenguas con gran número de hablantes, pero las lenguas cooficiales españolas se enfrentan a una desventaja estructural. Esto ha llevado a que muchos modelos no funcionen correctamente o no estén disponibles en valenciano, catalán, euskera o gallego.

No obstante, existen iniciativas colaborativas y de datos abiertos que permiten crear recursos lingüísticos de calidad. Se trata de los proyectos que varias comunidades autónomas han puesto en marcha marcando el camino hacia un futuro digital multilingüe.

Por un lado, el Proyecto Nós en Galicia crea recursos orales y conversacionales en gallego con todos los acentos y variantes dialectales para facilitar la integración a través de herramientas como GPS, asistentes de voz o ChatGPT. Un propósito similar el de Aina en Catalunya que además ofrece una plataforma académica y un laboratorio para desarrolladores o Vives en la Comunidad Valenciana. En el País Vasco también existe el proyecto Euskorpus que tiene como objetivo la constitución de un corpus de texto de calidad en euskera. Veamos cada uno de ellos.

Proyecto Nós, un enfoque colaborativo para el gallego digital

El proyecto ha desarrollado ya tres herramientas operativas: un traductor neuronal multilingüe, un sistema de reconocimiento de voz que convierte habla en texto, y una aplicación de síntesis de voz. Estos recursos se publican bajo licencias abiertas, garantizando su acceso libre y gratuito para investigadores, desarrolladores y empresas. Estas son sus características principales:

- Impulsado por: la Xunta de Galicia y la Universidad de Santiago de Compostela.

- Objetivo principal: crear recursos orales y conversacionales en gallego que capturen la diversidad dialectal y de acentos de la lengua.

- Cómo participar: el proyecto acepta contribuciones voluntarias tanto leyendo textos como respondiendo a preguntas espontáneas.

- Dona tu voz en gallego: https://doagalego.nos.gal

Aina, hacia una IA que entienda y hable catalán

Con un planteamiento similar al proyecto Nós, Aina busca facilitar la integración del catalán en los modelos de lenguaje de inteligencia artificial.

Se estructura en dos vertientes complementarias que maximizan su impacto:

- Aina Tech se centra en facilitar la transferencia tecnológica al sector empresarial, proporcionando las herramientas necesarias para traducir automáticamente al catalán webs, servicios y negocios en línea.

- Aina Lab impulsa la creación de una comunidad de desarrolladores a través de iniciativas como Aina Challenge, fomentando la innovación colaborativa en tecnologías del lenguaje en catalán. A través de esta convocatoria se han premiado 22 propuestas ya seleccionadas con un importe total de 1 millón para que ejecuten sus proyectos.

Las características del proyecto son:

- Impulsado por: la Generalitat de Catalunya en colaboración con el Barcelona Supercomputing Center (BSC-CNS)

- Objetivo principal: va más allá de la creación de herramientas, busca construir una infraestructura de IA abierta, transparente y responsable con el catalán.

- Cómo participar: puedes añadir comentarios, mejoras y sugerencias a través del buzón de contacto: https://form.typeform.com/to/KcjhThot?typeform-source=langtech-bsc.gitbook.io.

Vives, el proyecto colaborativo para IA en valenciano

Por otro lado, Vives recopila voces hablando en valenciano para que sirvan de entrenamiento a los modelos de IA.

- Impulsado por: el Centro de Inteligencia Digital de Alicante (CENID).

- Objetivo: busca crear corpus masivos de texto y voz, fomentar la participación ciudadana en la recolección de datos, y desarrollar modelos lingüísticos especializados en sectores como el turismo y el audiovisual, garantizando la privacidad de los datos.

- Cómo participar: puedes donar tu voz a través de este enlace: https://vives.gplsi.es/instruccions/.

Gaitu: inversión estratégica en la digitalización del euskera

En Euskera, podemos destacar Gaitu que busca recopilar voces hablando en euskera para poder entrenar los modelos de IA. Sus características son:

- Impulsado por: HiTZ, el centro vasco de tecnología de la lengua.

- Objetivo: desarrollar un corpus en euskera para entrenar modelos de IA.

- Cómo participar: puedes donar tu voz en euskera aquí https://commonvoice.mozilla.org/eu/speak.

Ventajas de construir y preservar modelos de lenguaje multilingües

Los proyectos de digitalización de las lenguas cooficiales trascienden el ámbito puramente tecnológico para convertirse en herramientas de equidad digital y preservación cultural. Su impacto se manifiesta en múltiples dimensiones:

- Para la ciudadanía: estos recursos garantizan que hablantes de todas las edades y niveles de competencia digital puedan interactuar con la tecnología en su lengua materna, eliminando barreras que podrían excluir a determinados colectivos del ecosistema digital.

- Para el sector empresarial: la disponibilidad de recursos lingüísticos abiertos facilita que empresas y desarrolladores puedan crear productos y servicios en estas lenguas sin asumir los altos costes tradicionalmente asociados al desarrollo de tecnologías lingüísticas.

- Para el tejido investigador, estos corpus constituyen una base fundamental para el avance de la investigación en procesamiento de lenguaje natural y tecnologías del habla, especialmente relevante para lenguas con menor presencia en recursos digitales internacionales.

El éxito de estas iniciativas demuestra que es posible construir un futuro digital donde la diversidad lingüística no sea un obstáculo sino una fortaleza, y donde la innovación tecnológica se ponga al servicio de la preservación y promoción del patrimonio cultural lingüístico.

En el campo de la ciencia de datos, la capacidad de construir modelos predictivos robustos es fundamental. Sin embargo, un modelo no es solo un conjunto de algoritmos, es una herramienta que debe ser comprendida, validada y, en última instancia, útil para la toma de decisiones.

Gracias a la transparencia y accesibilidad de los datos abiertos, tenemos la oportunidad única de trabajar en este ejercicio con información real, actualizada y de calidad institucional que refleja problemáticas ambientales. Esta democratización del acceso permite no solo desarrollar análisis rigurosos con datos oficiales, sino también contribuir al debate público informado sobre políticas ambientales, creando un puente directo entre la investigación científica y las necesidades sociales.

En este ejercicio práctico, nos sumergiremos en el ciclo de vida completo de un proyecto de modelado, utilizando un caso de estudio real: el análisis de la calidad del aire en Castilla y León. A diferencia de los enfoques que se centran únicamente en la implementación de algoritmos, nuestra metodología se enfoca en:

- Carga y exploración inicial de los datos: identificar patrones, anomalías y relaciones subyacentes que guiarán nuestro modelado.

- Análisis exploratorio orientado al modelado: construir visualizaciones y realizar ingeniería de características para optimizar el modelado.

- Desarrollo y evaluación de modelos de regresión: construir y comparar múltiples modelos iterativos para entender cómo la complejidad afecta el rendimiento.

- Aplicación del modelo y conclusiones: utilizar el modelo final para simular escenarios y cuantificar el impacto de posibles políticas ambientales.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

Arquitectura del Análisis

El núcleo de este ejercicio sigue un flujo estructurado en cuatro fases clave, como se ilustra en la Figura 1. Cada fase se construye sobre la anterior, desde la exploración inicial de los datos hasta la aplicación final del modelo.

Figura 1. Fases del proyecto de modelado predictivo.

Proceso de Desarrollo

1. Carga y exploración inicial de los datos

El primer paso es entender la materia prima de nuestro análisis: los datos. Utilizando un conjunto de datos de calidad del aire de Castilla y León, que abarca 24 años de mediciones, nos enfrentamos a desafíos comunes en el mundo real:

- Valores Faltantes: variables como el CO y el PM2.5 tienen una cobertura de datos limitada.

- Datos Anómalos: se detectan valores negativos y extremos, probablemente debidos a errores de los sensores.

A través de un proceso de limpieza y transformación, convertimos los datos brutos en un conjunto de datos limpio y estructurado, listo para el modelado.

2. Análisis exploratorio orientado al modelado

Una vez limpios los datos, buscamos patrones. El análisis visual revela una fuerte estacionalidad en los niveles de NO₂, con picos en invierno y valles en verano. Esta observación es crucial y nos lleva a la creación de nuevas variables (ingeniería de características), como componentes cíclicos para los meses, que permiten al modelo "entender" la naturaleza circular de las estaciones.

Figura 2. Variación estacional de los niveles de NO₂ en Castilla y León.

3. Desarrollo y evaluación de modelos de regresión

Con un conocimiento sólido de los datos, procedemos a construir tres modelos de regresión lineal de complejidad creciente:

- Modelo Base: utiliza solo los contaminantes como predictores.

- Modelo Estacional: añade las variables de tiempo.

- Modelo Completo: incluye interacciones y efectos geográficos.

La comparación de estos modelos nos permite cuantificar la mejora en la capacidad predictiva. El Modelo Estacional emerge como la opción óptima, explicando casi el 63% de la variabilidad del NO₂, un resultado notable para datos ambientales.

4. Aplicación del modelo y conclusiones

Finalmente, sometemos el modelo a un riguroso diagnóstico y lo utilizamos para simular el impacto de políticas ambientales. Por ejemplo, nuestro análisis estima que una reducción del 20% en las emisiones de NO podría traducirse en una disminución del 4.8% en los niveles de NO₂.

Figura 3. Rendimiento del modelo estacional. Los valores predichos se alinean bien con los valores reales.

¿Qué puedes aprender?

Este ejercicio práctico te permite aprender:

- Ciclo de vida de un proyecto de datos: desde la limpieza hasta la aplicación.

- Técnicas de regresión lineal: construcción, interpretación y diagnóstico.

- Manejo de datos temporales: captura de estacionalidad y tendencias.

- Validación de modelos: técnicas como la validación cruzada y temporal.

- Comunicación de resultados: cómo traducir hallazgos en insights accionables.

Conclusiones y Futuro

Este ejercicio demuestra el poder de un enfoque estructurado y riguroso en la ciencia de datos. Hemos transformado un conjunto de datos complejo en un modelo predictivo que no solo es preciso, sino también interpretable y útil.

Para aquellos interesados en llevar este análisis al siguiente nivel, las posibilidades son numerosas:

- Incorporación de datos meteorológicos: variables como la temperatura y el viento podrían mejorar significativamente la precisión.

- Modelos más avanzados: explorar técnicas como los Modelos Aditivos Generalizados (GAM) u otros algoritmos de machine learning.

- Análisis espacial: investigar cómo varían los patrones de contaminación entre diferentes ubicaciones.

En resumen, este ejercicio no solo ilustra la aplicación de técnicas de regresión, sino que también subraya la importancia de un enfoque integral que combine el rigor estadístico con la relevancia práctica.

La participación ciudadana en la recopilación de datos científicos impulsa una ciencia más democrática, al involucrar a la sociedad en los procesos de I+D+i y reforzar la rendición de cuentas. En este sentido, existen diversidad de iniciativas de ciencia ciudadana puestas en marcha por entidades como CSIC, CENEAM o CREAF, entre otras. Además, actualmente, existen numerosas plataformas de plataformas de ciencia ciudadana que ayudan a cualquier persona a encontrar, unirse y contribuir a una gran diversidad de iniciativas alrededor del mundo, como por ejemplo SciStarter.

Algunas referencias en legislación nacional y europea

Diferentes normativas, tanto a nivel nacional como a nivel europeo, destacan la importancia de promover proyectos de ciencia ciudadana como componente fundamental de la ciencia abierta. Por ejemplo, la Ley Orgánica 2/2023, de 22 de marzo, del Sistema Universitario, establece que las universidades promoverán la ciencia ciudadana como un instrumento clave para generar conocimiento compartido y responder a retos sociales, buscando no solo fortalecer el vínculo entre ciencia y sociedad, sino también contribuir a un desarrollo territorial más equitativo, inclusivo y sostenible.

Por otro lado, la Ley 14/2011, de 1 de junio, de la Ciencia, la Tecnología y la Innovación, promueve “la participación de la ciudadanía en el proceso científico técnico a través, entre otros mecanismos, de la definición de agendas de investigación, la observación, recopilación y procesamiento de datos, la evaluación de impacto en la selección de proyectos y la monitorización de resultados, y otros procesos de participación ciudadana”.

A nivel europeo, el Reglamento (UE) 2021/695 que establece el Programa Marco de Investigación e Innovación “Horizonte Europa”, indica la oportunidad de desarrollar proyectos codiseñados con la ciudadanía, avalando la ciencia ciudadana como mecanismo de investigación y vía de difusión de resultados.

Iniciativas de ciencia ciudadana y planes de gestión de datos

El primer paso para definir una iniciativa de ciencia ciudadana suele ser establecer una pregunta de investigación que necesite de una recopilación de datos que pueda abordarse con la colaboración de la ciudadanía. Después, se diseña un protocolo accesible para que los participantes recojan o analicen datos de forma sencilla y fiable (incluso podría ser un proceso gamificado). Se deben preparar materiales formativos y desarrollar un medio de participación (aplicación, web o incluso papel). También se planifica cómo comunicar avances y resultados a la ciudadanía, incentivando su participación.

Al tratarse de una actividad intensiva en la recolección de datos, es interesante que los proyectos de ciencia ciudadana dispongan de un plan de gestión de datos que defina el ciclo de vida del dato en proyectos de investigación, es decir cómo se crean, organizan, comparten, reutilizan y preservan los datos en iniciativas de ciencia ciudadana. Sin embargo, la mayoría de las iniciativas de ciencia ciudadana no dispone de este plan: en este reciente artículo de investigación se encontró que sólo disponían de plan de gestión de datos el 38% de proyectos de ciencia ciudadana consultados.

Figura 1. Ciclo de vida del dato en proyectos de ciencia ciudadana Fuente: elaboración propia – datos.gob.es.

Por otra parte, los datos procedentes de la ciencia ciudadana solo alcanzan todo su potencial cuando cumplen los principios FAIR y se publican en abierto. Con el fin de ayudar a tener este plan de gestión de datos que hagan que los datos procedentes de iniciativas de ciencia ciudadana sean FAIR, es preciso contar con estándares específicos para ciencia ciudadana como PPSR Core.

Datos abiertos para ciencia ciudadana con el estándar PPSR Core

La publicación de datos abiertos debe considerarse desde etapas tempranas de un proyecto de ciencia ciudadana, incorporando el estándar PPSR Core como pieza clave. Como mencionábamos anteriormente, cuando se formulan las preguntas de investigación, en una iniciativa de ciencia ciudadana, se debe plantear un plan de gestión de datos que indique qué datos recopilar, en qué formato y con qué metadatos, así como las necesidades de limpieza y aseguramiento de calidad a partir de los datos que recolecte la ciudadanía, además de un calendario de publicación.

Luego, se debe estandarizar con PPSR (Public Participation in Scientific Research) Core. PPSR Core es un conjunto de estándares de datos y metadatos, especialmente diseñados para fomentar la participación ciudadana en procesos de investigación científica. Posee una arquitectura de tres capas a partir de un Common Data Model (CDM). Este CDM ayuda a organizar de forma coherente y conectada la información sobre proyectos de ciencia ciudadana, los conjuntos de datos relacionados y las observaciones que forman parte de ellos, de tal manera que el CDM facilita la interoperabilidad entre plataformas de ciencia ciudadana y disciplinas científicas. Este modelo común se estructura en tres capas principales que permiten describir de forma estructurada y reutilizable los elementos clave de un proyecto de ciencia ciudadana. La primera es el Project Metadata Model (PMM), que recoge la información general del proyecto, como su objetivo, público participante, ubicación, duración, personas responsables, fuentes de financiación o enlaces relevantes. En segundo lugar, el Dataset Metadata Model (DMM) documenta cada conjunto de datos generado, detallando qué tipo de información se recopila, mediante qué método, en qué periodo, bajo qué licencia y con qué condiciones de acceso. Por último, el Observation Data Model (ODM) se centra en cada observación individual realizada por los participantes de la iniciativa de ciencia ciudadana, incluyendo la fecha y el lugar de la observación y el resultado. Es interesante resaltar que este modelo de capas de PPSR-Core permite añadir extensiones específicas según el ámbito científico, apoyándose en vocabularios existentes como Darwin Core (biodiversidad) o ISO 19156 (mediciones de sensores). (ODM) se centra en cada observación individual realizada por los participantes de la iniciativa de ciencia ciudadana, incluyendo la fecha y el lugar de la observación y el resultado. Es interesante resaltar que este modelo de capas de PPSR-Core permite añadir extensiones específicas según el ámbito científico, apoyándose en vocabularios existentes como Darwin Core (biodiversidad) o ISO 19156 (mediciones de sensores).

Figura 2. Arquitectura de capas de PPSR CORE. Fuente: elaboración propia – datos.gob.es.

Esta separación permite que una iniciativa de ciencia ciudadana pueda federar automáticamente la ficha del proyecto (PMM) con plataformas como SciStarter, compartir un conjunto de datos (DMM) con un repositorio institucional de datos abiertos científicos, como aquellos agregados en RECOLECTA del FECYT y, al mismo tiempo, enviar observaciones verificadas (ODM) a una plataforma como GBIF sin redefinir cada campo.

Además, el uso de PPSR Core aporta una serie de ventajas para la gestión de los datos de una iniciativa de ciencia ciudadana:

- Mayor interoperabilidad: plataformas como SciStarter ya intercambian metadatos usando PMM, por lo que se evita duplicar información.

- Agregación multidisciplinar: los perfiles del ODM permiten unir conjuntos de datos de dominios distintos (por ejemplo, calidad del aire y salud) alrededor de atributos comunes, algo crucial para estudios multidisciplinares.

- Alineamiento con principios FAIR: los campos obligatorios del DMM son útiles para que los conjuntos de datos de ciencia ciudadana cumplan los principios FAIR.

Cabe destacar que PPSR Core permite añadir contexto a los conjuntos de datos obtenidos en iniciativas de ciencia ciudadana. Es una buena práctica trasladar el contenido del PMM a lenguaje entendible por la ciudadanía, así como obtener un diccionario de datos a partir del DMM (descripción de cada campo y unidad) y los mecanismos de transformación de cada registro a partir del ODM. Finalmente, se puede destacar iniciativas para mejorar PPSR Core, por ejemplo, a través de un perfil de DCAT para ciencia ciudadana.

Conclusiones

Planificar la publicación de datos abiertos desde el inicio de un proyecto de ciencia ciudadana es clave para garantizar la calidad y la interoperabilidad de los datos generados, facilitar su reutilización y maximizar el impacto científico y social del proyecto. Para ello, PPSR Core ofrece un estándar basado en niveles (PMM, DMM, ODM) que conecta los datos generados por la ciencia ciudadana con diversas plataformas, potenciando que estos datos cumplan los principios FAIR y considerando, de manera integrada, diversas disciplinas científicas. Con PPSR Core cada observación ciudadana se convierte fácilmente en datos abiertos sobre el que la comunidad científica pueda seguir construyendo conocimiento para el beneficio de la sociedad.

Jose Norberto Mazón, Catedrático de Lenguajes y Sistemas Informáticos de la Universidad de Alicante. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

En un mundo cada vez más complejo, las decisiones públicas necesitan más que intuición: requieren evidencia científica. Aquí es donde entran en juego las iniciativas de I+P (Innovación + Política Pública): una intersección entre creatividad, conocimiento basado en datos y acción política.

En este artículo vamos a explicar este concepto, incluyendo ejemplos e información sobre programas de financiación.

¿Qué es I+P?

I+P no es una fórmula matemática, sino una práctica estratégica que combina el conocimiento científico, la investigación y la participación ciudadana para mejorar la formulación, implementación y evaluación de políticas públicas. No se trata únicamente de aplicar tecnología a lo público, sino de repensar cómo se toman las decisiones, cómo se formulan soluciones y cómo se involucra a la sociedad en estos procesos a través de la aplicación de metodologías científicas.

Esta idea nace del concepto “ciencia para las políticas públicas”, también conocida como “ciencia para la política” o “Science for Policy” (S4P) e implica la colaboración activa entre las administraciones públicas y la comunidad científica.

Las iniciativas de I+P promueven la evidencia empírica y la experimentación. Para ello, impulsan el uso de datos, tecnologías emergentes, pruebas piloto, metodologías ágiles y ciclos de retroalimentación que ayudan a diseñar políticas más eficientes y eficaces, centradas en las necesidades reales de la ciudadanía. Gracias a ello se facilita la toma de decisiones en tiempo real y la posibilidad de realizar ajustes ágiles ante situaciones que requieren respuestas rápidas. En definitiva, se trata de dar respuestas más creativas y acertadas a los retos de hoy en día, como pueden ser el cambio climático o la desigualdad digital, áreas donde las políticas tradicionales se pueden quedar cortas.

El siguiente visual resume estos y otros beneficios.

Fuente: Convocatoria de innovación pública de FECYT- adaptado por datos.gob.es.

Ejemplos de iniciativas de I+P

El uso de datos para la toma de decisiones políticas quedó patente durante la pandemia de COVID-19, donde los responsables políticos iban adaptando las medidas a tomar en base a los reportes de instituciones como la Organización Mundial de la Salud (OMS). Pero más allá de este tipo de acontecimientos extraordinarios, hoy en día encontramos iniciativas consolidadas que buscan cada vez más promover la innovación y la toma de decisiones fundamentada en datos científicos en el ámbito público de forma continua. Veamos dos ejemplos.

-

Informes periódicos de instituciones científicas para acercar el conocimiento científico a la toma de decisiones públicas

Los informes científicos sobre temas como el cambio climático, la resistencia bacteriana o la producción alimentaria son ejemplos de cómo la ciencia puede orientar decisiones políticas informadas.

La iniciativa Science4Policy del Consejo Superior de Investigaciones Científicas (CSIC) es un ejemplo de ello. Se trata de una colección de informes temáticos que presentan evidencias sólidas, generadas en sus centros de investigación, sobre problemas sociales relevantes. Cada informe incluye:

- Una introducción al problema y su impacto social.

- Información sobre la investigación desarrollada por el CSIC sobre el tema.

- Conclusiones y recomendaciones para políticas públicas.

Su objetivo principal es transformar el conocimiento científico en aportaciones accesibles para públicos no especializados, facilitando así decisiones informadas por parte de los poderes públicos.

-

Los laboratorios de innovación pública, un espacio para la creatividad basada en la ciencia

Los laboratorios de innovación pública o GovLabs son espacios experimentales que permiten a empleados públicos, científicos, expertos en diversas materias y ciudadanos co-crear políticas, prototipar soluciones y aprender de forma iterativa.

Un ejemplo es el Laboratorio de Innovación Pública (LIP) impulsado por el Instituto Nacional de Administración Pública (INAP), donde se han realizado pilotos sobre el uso de tecnologías para impulsar el puesto de trabajo de nueva generación, la colaboración intermunicipal para compartir talento o la descentralización de pruebas selectivas. Además, cuentan con un Catálogo de Recursos de Innovación donde se recopilan herramientas con licencias abiertas puestas en marcha por diversos organismos y que pueden servir de apoyo a los emprendedores públicos.

También cabe la pena destacar a la Red Española de Innovación Pública y Transferencia Científica, impulsada por la Fundación NovaGob. Es un espacio colaborativo que reúne a profesionales, administraciones públicas, universidades y organizaciones del tercer sector con el objetivo de transformar la gestión pública en España. A través de grupos de trabajo y repositorios de buenas prácticas, impulsa el uso de la inteligencia artificial, la simplificación administrativa y la mejora de la atención ciudadana.

También encontramos laboratorios de innovación pública a nivel regional, como, por ejemplo Govtechlab Madrid, un proyecto liderado por la Fundación para el Conocimiento madri+d que conecta startups y pymes digitales con instituciones públicas para resolver retos reales. Durante el curso 2023/2024, lanzaron 9 pilotos, por ejemplo, para recopilar y analizar la opinión de la ciudadanía para tomar mejores decisiones en el Ayuntamiento de Alcobendas, unificar la toma y gestión de datos en las inscripciones de las actividades del Área de Juventud del Ayuntamiento de Boadilla del Monte o proporcionar información veraz y actualizada de manera digital sobre el tejido comercial mostoleño.

El papel de los gobiernos e instituciones públicas

La innovación en política pública puede estar impulsada por una diversidad de actores: administraciones públicas abiertas al cambio, universidades y centros de investigación, startups cívicas y empresas tecnológicas, organizaciones de la sociedad civil o ciudadanos comprometidos.

La Comisión Europea, por ejemplo, desempeña un papel clave en el fortalecimiento del ecosistema de ciencia para la política en Europa, promoviendo el uso efectivo del conocimiento científico en la toma de decisiones a todos los niveles: europeo, nacional, regional y local. A través de programas como Horizonte Europa y la Agenda de Política del Espacio Europeo de Investigación 2025-2027, se impulsan acciones para desarrollar capacidades, compartir buenas prácticas y alinear la investigación con las necesidades sociales.

En España también encontramos acciones como la reciente convocatoria de financiación de la Fundación Española para la Ciencia y la Tecnología (FECYT), el Ministerio de Ciencia, Innovación y Universidades, y la Oficina Nacional de Asesoramiento Científico, cuyo objetivo es impulsar:

- Proyectos de investigación que generen nuevas evidencias científicas aplicables al diseño de políticas públicas (Categoría A).

- Actividades de asesoramiento científico y transferencia de conocimiento entre investigadores y responsables públicos (Categoría B).

Los proyectos pueden recibir hasta 100.000 euros (Categoría A) o 25.000 euros (Categoría B), cubriendo hasta el 90% del coste total. Pueden participar organismos de investigación, universidades, entidades sanitarias, centros tecnológicos, centros de I+D y otros actores que promuevan la transferencia de la I+D. El plazo para solicitar la ayuda finaliza el próximo 17 de septiembre de 2025. Para más información, se deben visitar las bases de la convocatoria o asistir a algunas sesiones formativas que se están realizando.

Conclusión

En un mundo donde los desafíos sociales, económicos y medioambientales son cada vez más complejos, necesitamos nuevas formas de pensar y actuar desde las instituciones públicas. Por ello, I+P no es una moda, es una necesidad que nos permite pasar del “creemos que funciona” al “sabemos que funciona”, fomentando una política más adaptativa, ágil y eficaz.

Durante los últimos años hemos visto avances espectaculares en el uso de la inteligencia artificial (IA) y, detrás de todos estos logros, siempre encontraremos un mismo ingrediente común: los datos. Un ejemplo ilustrativo y conocido por todo el mundo es el de los modelos de lenguaje utilizados por OpenAI para su famoso ChatGPT, como por ejemplo GPT-3, uno de sus primeros modelos que fue entrenado con más de 45 terabytes de datos, convenientemente organizados y estructurados para que resultaran de utilidad.

Sin suficiente disponibilidad de datos de calidad y convenientemente preparados, incluso los algoritmos más avanzados no servirán de mucho, ni a nivel social ni económico. De hecho, Gartner estima que más del 40% de los proyectos emergentes de agentes de IA en la actualidad terminarán siendo abandonados a medio plazo debido a la falta de datos adecuados y otros problemas de calidad. Por tanto, el esfuerzo invertido en estandarizar, limpiar y documentar los datos puede marcar la diferencia entre una iniciativa de IA exitosa y un experimento fallido. En resumen, el clásico principio de “basura entra, basura sale” en la ingeniería informática aplicado esta vez a la inteligencia artificial: si alimentamos una IA con datos de baja calidad, sus resultados serán igualmente pobres y poco fiables.