Imagina una máquina que pueda saber si estás feliz, preocupado o a punto de tomar una decisión, incluso antes de que tú lo sepas con claridad. Aunque suena a ciencia ficción, ese futuro ya está empezando a tomar forma. Gracias a los avances en neurociencia y tecnología, hoy podemos registrar, analizar e incluso predecir ciertos patrones de actividad cerebral. A los datos que se generan a partir de estos registros se les conoce como neurodatos.

En este artículo vamos a explicar este concepto, así como potenciales casos de uso, tomando como base el informe “TechDispatch sobre Neurodatos”, de la Agencia Española de Protección de Datos (AEPD).

¿Qué son los neurodatos y cómo se recolectan?

El término neurodatos se refiere a los datos que se recopilan directamente del cerebro y el sistema nervioso, mediante tecnologías como la electroencefalografía (EEG), la resonancia magnética funcional (fMRI), los implantes neuronales o incluso interfaces cerebro-computadora. En este sentido, su captación se ve impulsada por las neurotecnologías.

De acuerdo con la OCDE, las neurotecnologías se identifican con “dispositivos y procedimientos que se utilizan para acceder, investigar, evaluar, manipular y emular la estructura y función de los sistemas neuronales”. Las neurotecnologías pueden ser invasivas (si requieren interfaces cerebro-ordenador que se implanten quirúrgicamente en el cerebro) o no invasivas, con interfaces que se colocan fuera del cuerpo (como gafas o diademas).

Asimismo, existen dos formas habituales de recopilar los datos:

- Recolección pasiva, donde los datos se captan de manera habitual sin que el sujeto tenga que realizar ninguna actividad específica.

- Recolección activa, donde se recogen datos mientras los usuarios realizan una actividad concreta. Por ejemplo, pensar explícitamente en algo, responder preguntas, realizar tareas físicas o recibir determinados estímulos.

Posibles casos de uso

Una vez se han recolectado los datos en bruto, se procede a su almacenamiento y tratamiento. El tratamiento variará según la finalidad y el uso que se quiera dar a los neurodatos.

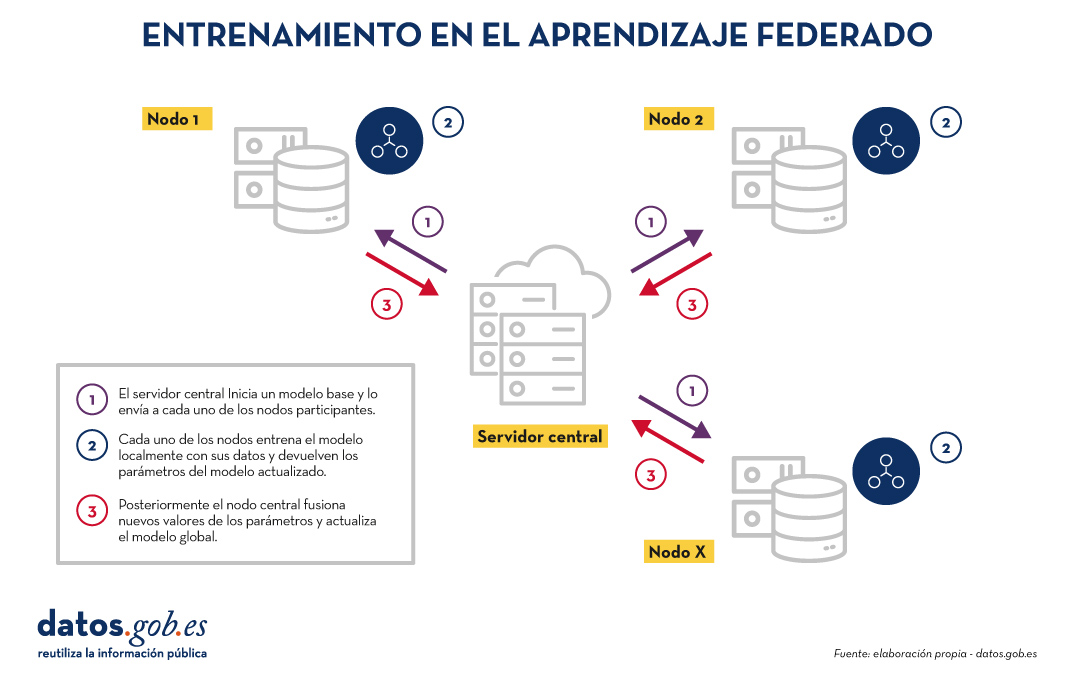

Figura 1. Estructura común para entender el tratamiento de neurodatos en diferentes casos de uso. Fuente: Informe “TechDispatch sobre Neurodatos”, de la Agencia Española de Protección de Datos (AEPD).

Como se puede ver en la imagen anterior, la Agencia Española de Protección de datos ha identificado 3 posibles finalidades:

-

Tratamiento de neurodatos para adquirir conocimiento directo y/o realizar predicciones.

Los neurodatos permiten descubrir patrones que decodifican la actividad cerebral en diversos sectores, como, por ejemplo:

- Salud: los neurodatos facilitan la investigación sobre el funcionamiento del cerebro y el sistema nervioso, lo que permite detectar signos de enfermedades neurológicas o mentales, realizar diagnósticos tempranos y predecir su comportamiento. Esto facilita el tratamiento personalizado desde etapas muy tempranas. Su impacto puede ser notable, por ejemplo, en la lucha contra el Alzheimer, la epilepsia o la depresión.

- Educación: a través de los estímulos cerebrales se puede analizar el rendimiento y los resultados del aprendizaje de los estudiantes. Por ejemplo, se puede medir la atención o el esfuerzo cognitivo del alumnado. Al cruzar estos datos con otros aspectos internos (como las preferencias del alumno) y externos (como las condiciones del aula o la metodología de enseñanza), se pueden tomar decisiones dirigidas a adaptar el ritmo de enseñanza.

- Marketing, economía y ocio: se puede analizar la respuesta cerebral ante ciertos estímulos para mejorar productos de ocio o campañas publicitarias. El objetivo es conocer las motivaciones y preferencias que impactan en la toma de decisiones. También se pueden utilizar en el ámbito laboral, para realizar un seguimiento de los empleados, conocer sus habilidades o determinar cómo funcionan ante la presión.

- Seguridad y vigilancia: los neurodatos se pueden usar para monitorizar factores que afectan a conductores o pilotos, como la somnolencia o la falta de atención, y así prevenir accidentes.

-

Tratamiento de neurodatos para controlar aplicaciones o dispositivos.

Al igual que en el estadio anterior, supone la recolección y análisis de información para la toma de decisiones, pero conlleva además una operación adicional: la generación de acciones a través de los impulsos mentales. Veamos varios ejemplos:

-

Ayudas ortopédicas o protésicas, implantes médicos o vida asistida por el entorno: gracias a tecnologías como las interfaces cerebro-computadora, es posible diseñar prótesis que respondan a la intención del usuario mediante la actividad cerebral. Además, los neurodatos pueden integrarse con sistemas inteligentes del hogar para anticipar necesidades, ajustar el entorno a los estados emocionales o cognitivos del usuario, e incluso emitir alertas ante signos tempranos de deterioro neurológico. Esto puede suponer una mejora de la autonomía de los pacientes y de su calidad de vida.

-

Robótica: se pueden interpretar las señales neuronales del usuario para controlar maquinaria, dispositivos de precisión o aplicaciones sin necesidad de utilizar las manos. Esto permite, por ejemplo, que una persona pueda manejar un brazo robótico o una herramienta quirúrgica simplemente con su pensamiento, lo cual es especialmente valioso en entornos donde se requiere precisión extrema o cuando el operador tiene movilidad reducida.

-

Videojuegos, realidad virtual y metaverso: dado que los neurodatos permiten controlar dispositivos de software, se pueden desarrollar interfaces cerebro-computadora que hagan posible manejar personajes o realizar acciones dentro de un juego, únicamente con la mente, sin necesidad de mandos físicos. Esto no solo incrementa la inmersión del jugador, sino que abre la puerta a experiencias más inclusivas y personalizadas.

- Defensa: los soldados pueden operar sistemas de armas, vehículos no tripulados, drones o robots de desactivación de explosivos en remoto, aumentando la seguridad personal y la eficiencia operativa en situaciones críticas.

-

Tratamiento de neurodatos para la estimulación o modulación del sujeto, logrando un neurofeedback.

En este caso, las señales del cerebro (salidas) se utilizan para generar nuevas señales que retroalimentan al cerebro (como entradas), lo que supone el control de las ondas cerebrales. Es el campo más complejo desde el punto de vista ético, ya que podrían generarse acciones de las que no es consciente el usuario. Algunos ejemplos son:

-

Psicología: los neurodatos tienen potencial para cambiar la forma en que el cerebro responde a ciertos estímulos. Se pueden utilizar, por tanto, como método de terapia para tratar el TDAH (Trastorno por Déficit de Atención e Hiperactividad), la ansiedad, la depresión, la epilepsia, el trastorno del espectro autista, el insomnio o la drogadicción, entre otros.

- Neuromejora: también se pueden utilizar para mejorar las capacidades cognitivas y afectivas en personas sanas. A través del análisis y estimulación personalizada de la actividad cerebral, es posible optimizar funciones como la memoria, la concentración, la toma de decisiones o la gestión emocional.

Retos éticos del uso de los neurodatos

Como hemos visto, aunque el potencial de los neurodatos es enorme, también plantea grandes retos éticos y legales. A diferencia de otros tipos de datos, los neurodatos pueden revelar aspectos profundamente íntimos de una persona, como sus deseos, emociones, miedos o intenciones. Esto abre la puerta a posibles usos indebidos, como la manipulación, la vigilancia encubierta o la discriminación basada en características neuronales. Además, se pueden recopilar en remoto y actuar sobre ellos sin que el sujeto sea consciente de la manipulación.

Esto ha generado un debate sobre la necesidad de nuevos derechos, como los neuroderechos, que buscan proteger la privacidad mental, la identidad personal y la libertad cognitiva. Desde diversas organizaciones internacionales, incluida la Unión Europea, se están tomando medidas para enfrentar estos desafíos y avanzar en la creación de marcos regulatorios y éticos que protejan los derechos fundamentales en el uso de tecnologías neurotecnológicas. Próximamente publicaremos un artículo que profundizará en estos aspectos.

En conclusión, los neurodatos suponen un avance muy prometedor, pero no exento de desafíos. Su capacidad para transformar sectores como la salud, la educación o la robótica es innegable, pero también lo son los desafíos éticos y legales que plantea su uso. A medida que avanzamos hacia un futuro donde mente y máquina están cada vez más conectadas, resulta crucial establecer marcos de regulación que garanticen la protección de los derechos humanos, en especial la privacidad mental y la autonomía individual. De esta forma podremos aprovechar todo el potencial de los neurodatos de manera justa, segura y responsable, en beneficio de toda la sociedad.

La compartición de datos o data sharing se ha convertido en un pilar imprescindible para el avance de la analítica y el intercambio de conocimiento, tanto en el ámbito privado como en el público. Las organizaciones de cualquier tamaño y sector –empresas, administraciones públicas, instituciones de investigación, comunidades de desarrolladores o individuos– encuentran un fuerte valor en la capacidad de compartir información de forma segura, fiable y eficiente. Este intercambio no se limita a datos en crudo o datasets estructurados; también se extiende a productos de datos más avanzados, tales como modelos de machine learning entrenados, dashboards analíticos, resultados de experimentos científicos y otros artefactos complejos que generan un gran impacto a través de su reutilización.

En este contexto, la importancia de la gobernanza de estos recursos cobra un papel crítico. No es suficiente con disponer de un método para mover ficheros de un sitio a otro; es necesario garantizar aspectos clave como el control de acceso (quién puede leer o modificar cierto recurso), la trazabilidad y la auditoría (saber quién ha accedido, cuándo y con qué finalidad) o el cumplimiento de regulaciones o estándares, especialmente en entornos empresariales y gubernamentales.

Con el fin de unificar estos requisitos, Unity Catalog surge como un almacén de metadatos (metastore) de próxima generación, pensado para centralizar y simplificar la gobernanza de datos y recursos de datos. Originalmente, Unity Catalog formaba parte de los servicios ofrecidos por la plataforma Databricks, pero el proyecto ha dado un salto a la comunidad de código abierto para convertirse en un estándar de referencia. Esto implica que ahora es posible utilizarlo, modificarlo y, en definitiva, contribuir a su evolución desde un entorno libre y colaborativo. Con ello, se espera que más organizaciones adopten sus modelos de catálogo y compartición, impulsando la reutilización de datos y la creación de flujos analíticos e innovaciones tecnológicas.

Fuente: https://docs.unitycatalog.io/

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

Objetivos

En este ejercicio, aprenderemos a configurar Unity Catalog, una herramienta que nos ayuda a organizar y compartir datos en la nube de manera segura. Aunque utilizaremos algo de código, explicaremos cada paso para que incluso personas con poca experiencia en programación puedan seguirlo a través de un laboratorio práctico.

Trabajaremos con un escenario realista donde gestionaremos datos sobre transporte público en diferentes ciudades. Crearemos catálogos de datos, configuraremos una base de datos y aprenderemos a interactuar con la información usando herramientas como Docker, Apache Spark y MLflow.

Nivel de dificultad: Intermedio.

Figura 1. Esquema Unity Catalog

Recursos Necesarios

En esta sección explicaremos los requisitos previos y recursos necesarios para poder desarrollar este laboratorio. El laboratorio está pensado para desarrollarse en un ordenador personal estándar (Windows, MacOS, Linux).

Adicionalmente utilizaremos las siguientes herramientas y entornos de trabajo:

- Docker Desktop: Docker es una herramienta que nos permite ejecutar aplicaciones en un entorno aislado llamado contenedor. Un contenedor es como una "caja" que contiene todo lo necesario para que una aplicación funcione correctamente, sin importar el sistema operativo que estés usando.

- Visual Studio Code: Nuestro entorno de trabajo será un Notebook Python que ejecutaremos y manipularemos a través del editor de código ampliamente utilizado Visual Studio Code (VS Code).

- Unity Catalog: Es una herramienta de gobernanza de datos que permite organizar y controlar el acceso a recursos como tablas, volúmenes de datos, funciones o modelos de machine learning. A lo largo del laboratorio, utilizaremos su versión open source, que puede desplegarse localmente, para aprender a gestionar catálogos de datos con control de permisos, trazabilidad y estructura jerárquica. Unity Catalog actúa como un metastore centralizado, facilitando la colaboración y la reutilización de datos de forma segura.

- Amazon Web Services: AWS será el proveedor cloud que utilizaremos para alojar ciertos datos del laboratorio, en concreto los datos en crudo (como archivos JSON) que gestionaremos mediante volúmenes de datos. Aprovecharemos su servicio Amazon S3 para almacenar estos archivos y configuraremos las credenciales y permisos necesarios para que Unity Catalog pueda interactuar con ellos de forma controlada.

Desarrollo del ejercicio

A lo largo del ejercicio, los participantes desplegarán la aplicación, comprenderán su arquitectura e irán construyendo un catálogo de datos paso a paso, aplicando buenas prácticas de organización, control de acceso y trazabilidad.

Despliegue y primeros pasos

- Clonamos el repositorio de Unity Catalog y lo levantamos con Docker.

- Exploramos su arquitectura: un backend accesible por API y CLI, y una interfaz gráfica intuitiva.

- Navegamos por los recursos que gestiona Unity Catalog: catálogos, esquemas, tablas, volúmenes, funciones y modelos.

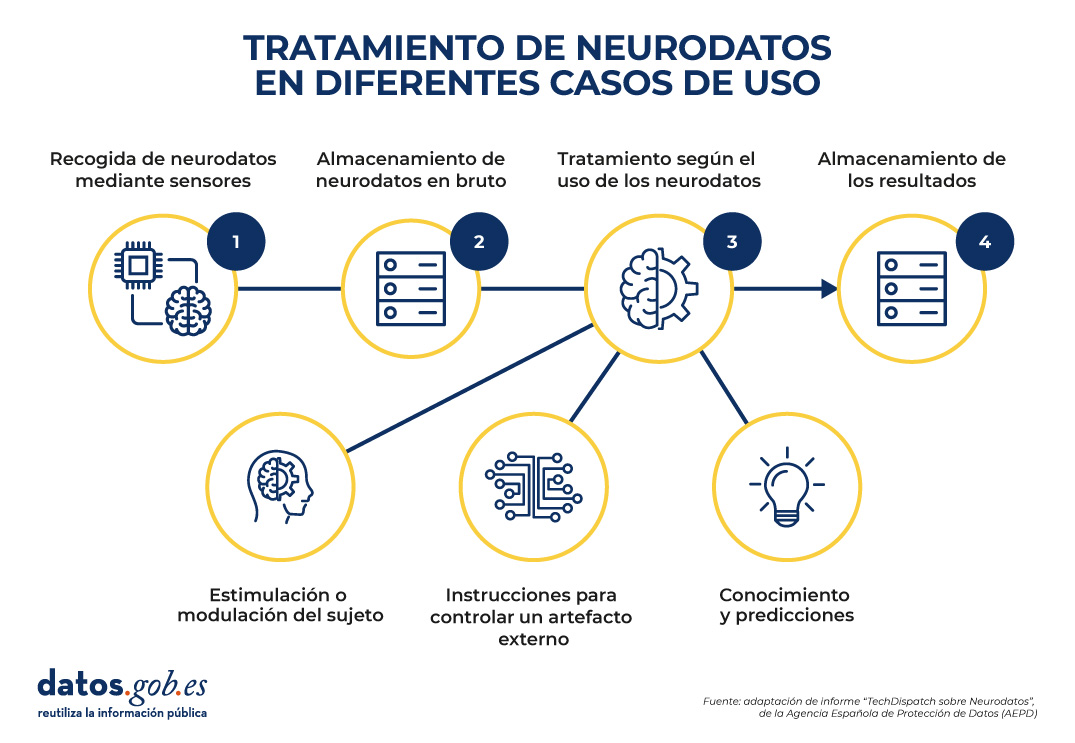

Figura 2. Captura de pantalla

¿Qué aprenderemos aquí?

Cómo levantar la aplicación, sus componentes principales, y cómo empezar a interactuar con ella desde distintos puntos: web, API y CLI.

Organización de recursos

- Configuramos una base de datos MySQL externa como repositorio de metadatos.

- Creamos catálogos para representar distintas ciudades y esquemas para distintos servicios públicos.

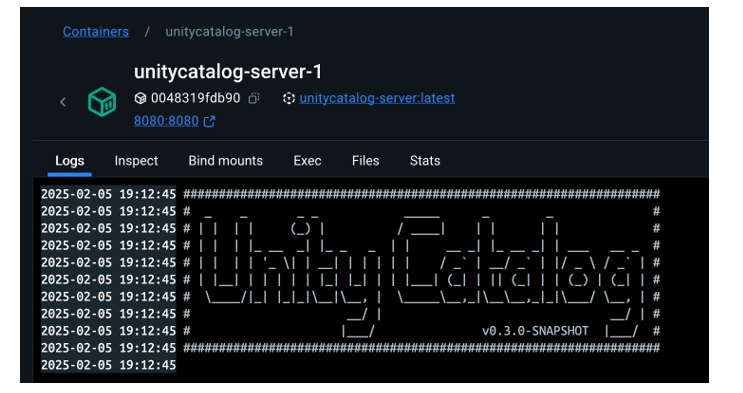

Figura 3. Captura de pantalla

¿Qué aprenderemos aquí?

Cómo estructurar el gobierno de datos a distintos niveles (ciudad, servicio, dataset) y cómo gestionar los metadatos de forma centralizada y persistente.

Construcción de datos y uso real

- Creamos tablas estructuradas para representar rutas, autobuses o paradas.

- Cargamos datos reales en estas tablas usando PySpark.Habilitamos un bucket en AWS S3 como almacenamiento de datos en crudo (volúmenes).

- Subimos ficheros JSON con eventos de telemetría y los gobernamos desde Unity Catalog.

Figura 4. Esquema

¿Qué aprenderemos aquí?

Cómo convivir con distintos tipos de datos (estructurados y no estructurados), y cómo integrarlos con fuentes externas (como AWS S3).

Funciones reutilizables y modelos de IA

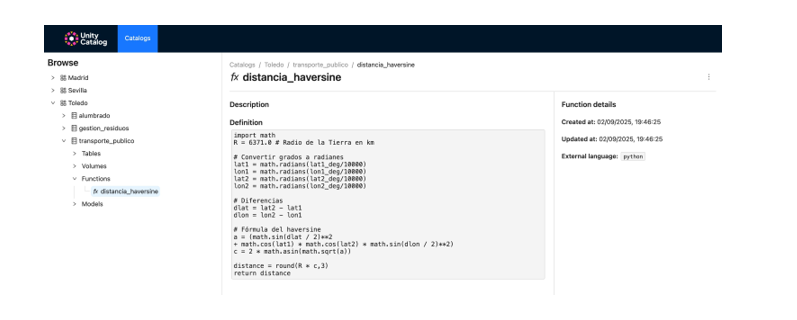

- Registramos funciones personalizadas (como el cálculo de distancias) reutilizables desde el catálogo.

- Creamos y registramos modelos de machine learning con MLflow.

- Ejecutamos predicciones desde Unity Catalog como si fueran cualquier otro recurso del ecosistema.

Figura 5. Captura de pantalla

¿Qué aprenderemos aquí?

Cómo ampliar el gobierno de datos a funciones y modelos, y cómo facilitar su reutilización y trazabilidad en entornos colaborativos.

Resultados y conclusiones

Como resultado de este laboratorio práctico, vamos a poner conocer la herramienta Unity Catalog como plataforma abierta para la gobernanza de datos y recursos de datos como modelos de machine learning. Exploraremos, además, el contexto de un caso de uso concreto y con un ecosistema de herramientas similar al que podemos encontrar en una organización real, sus capacidades, su modo de despliegue y su uso.

Mediante este ejercicio configuraremos y utilizaremos Unity Catalog para organizar datos de transporte público. En concreto, podrás:

- Aprender a instalar herramientas como Docker o Spark.

- Crear catálogos, esquemas y tablas en Unity Catalog.

- Cargar datos y almacenarlos en un bucket de Amazon S3.

- Implementar un modelo de machine learning con MLflow.

Veremos, en los próximos años, si este tipo de herramientas alcanzan el nivel de estandarización necesario para transformar la forma en que se administran y comparten los recursos de datos en múltiples sectores.

¡Te animamos a realizar más ejercicios de ciencia de datos! Accede al repositorio aquí

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La inteligencia artificial generativa comienza a estar presente en aplicaciones cotidianas que van desde agentes virtuales (o equipos de agentes virtuales) que nos resuelven dudas cuando llamamos a un centro de atención al cliente hasta asistentes inteligentes que redactan automáticamente resúmenes de reuniones o propuestas de informes en entornos de oficina.

Estas aplicaciones, gobernadas a menudo por modelos fundacionales de lenguaje (LLM), prometen revolucionar sectores enteros sobre la base de conseguir enormes ganancias en productividad. Sin embargo, su adopción conlleva nuevos retos ya que, a diferencia del software tradicional, un modelo de IA generativa no sigue reglas fijas escritas por humanos, sino que sus respuestas se basan en patrones estadísticos aprendidos tras procesar grandes volúmenes de datos. Esto hace que su comportamiento sea menos predecible y más difícil de explicar y que a veces ofrezca resultados inesperados, errores complicados de prever o respuestas que no siempre se alinean con las intenciones originales del creador del sistema.

Por ello, la validación de estas aplicaciones desde múltiples perspectivas como la ética, la seguridad o la consistencia es esencial para garantizar la confianza en los resultados de los sistemas que estamos creando en esta nueva etapa de transformación digital.

¿Qué hay que validar en los sistemas basados en IA generativa?

Validar los sistemas basados en IA generativa significa comprobar rigurosamente que cumplen ciertos criterios de calidad y responsabilidad antes de confiar en ellos para resolver tareas sensibles.

No se trata solo de verificar que “funcionan”, sino de asegurarse de que se comportan según lo esperado, evitando sesgos, protegiendo a los usuarios, manteniendo su estabilidad en el tiempo y cumpliendo las normas éticas y legales aplicables. La necesidad de una validación integral suscita un cada vez más amplio consenso entre expertos, investigadores, reguladores e industria: para desplegar IA de forma confiable se requieren estándares, evaluaciones y controles explícitos.

Resumimos cuatro dimensiones clave que deben verificarse en los sistemas basados en IA generativa para alinear sus resultados con las expectativas humanas:

- Ética y equidad: un modelo debe respetar principios éticos básicos y evitar perjudicar a personas o grupos. Esto implica detectar y mitigar sesgos en sus respuestas para no perpetuar estereotipos ni discriminación. También requiere filtrar contenido tóxico u ofensivo que pudiera dañar a los usuarios. La equidad se evalúa comprobando que el sistema ofrece un trato consistente a distintos colectivos demográficos, sin favorecer ni excluir indebidamente a nadie.

- Seguridad y robustez: aquí nos referimos tanto a la seguridad del usuario (que el sistema no genere recomendaciones peligrosas ni facilite actividades ilícitas) como a la robustez técnica frente a errores y manipulaciones. Un modelo seguro debe evitar instrucciones que lleven, por ejemplo, a conductas ilegales, rechazando esas solicitudes de manera fiable. Además, la robustez implica que el sistema resista ataques adversarios (como peticiones diseñadas para engañarlo) y que funcione de forma estable bajo distintas condiciones.

- Consistencia y fiabilidad: los resultados de la IA generativa deben ser consistentes, coherentes y correctos. En aplicaciones como las de diagnóstico médico o asistencia legal, no basta con que la respuesta suene convincente; debe ser cierta y precisa. Por ello se validan aspectos como la coherencia lógica de las respuestas, su relevancia respecto a la pregunta formulada y la exactitud factual de la información. También se comprueba su estabilidad en el tiempo (que ante dos peticiones similares se ofrezcan resultados equivalentes bajo las mismas condiciones) y su resiliencia (que pequeños cambios en la entrada no provoquen salidas sustancialmente diferentes).

- Transparencia y explicabilidad: para confiar en las decisiones de un sistema basado en IA, es deseable entender cómo y por qué las produce. La transparencia incluye proporcionar información sobre los datos de entrenamiento, las limitaciones conocidas y el rendimiento del modelo en distintas pruebas. Muchas empresas están adoptando la práctica de publicar “tarjetas del modelo” (model cards), que resumen cómo fue diseñado y evaluado un sistema, incluyendo métricas de sesgo, errores comunes y casos de uso recomendados. La explicabilidad va un paso más allá y busca que el modelo ofrezca, cuando sea posible, explicaciones comprensibles de sus resultados (por ejemplo, destacando qué datos influyeron en cierta recomendación). Una mayor transparencia y capacidad de explicación aumentan la rendición de cuentas, permitiendo que desarrolladores y terceros auditen el comportamiento del sistema.

Datos abiertos: transparencia y pruebas más diversas

Para validar adecuadamente los modelos y sistemas de IA, sobre todo en cuanto a equidad y robustez, se requieren conjuntos de datos representativos y diversos que reflejen la realidad de distintas poblaciones y escenarios.

Por otra parte, si solo las empresas dueñas de un sistema disponen datos para probarlo, tenemos que confiar en sus propias evaluaciones internas. Sin embargo, cuando existen conjuntos de datos abiertos y estándares públicos de prueba, la comunidad (universidades, reguladores, desarrolladores independientes, etc.) puede poner a prueba los sistemas de forma autónoma, funcionan así como un contrapeso independiente que sirve a los intereses de la sociedad.

Un ejemplo concreto lo dio Meta (Facebook) al liberar en 2023 su conjunto de datos Casual Conversations v2. Se trata de un conjunto de datos abiertos, obtenido con consentimiento informado, que recopila videos de personas de 7 países (Brasil, India, Indonesia, México, Vietnam, Filipinas y EE.UU.), con 5.567 participantes que proporcionaron atributos como edad, género, idioma y tono de piel.

El objetivo de Meta con la publicación fue precisamente facilitar que los investigadores pudiesen evaluar la imparcialidad y robustez de sistemas de IA en visión y reconocimiento de voz. Al expandir la procedencia geográfica de los datos más allá de EE.UU., este recurso permite comprobar si, por ejemplo, un modelo de reconocimiento facial funciona igual de bien con rostros de distintas etnias, o si un asistente de voz comprende acentos de diferentes regiones.

La diversidad que aportan los datos abiertos también ayuda a descubrir áreas descuidadas en la evaluación de IA. Investigadores del Human-Centered Artificial Intelligence (HAI) de Stanford pusieron de manifiesto en el proyecto HELM (Holistic Evaluation of Language Models) que muchos modelos de lenguaje no se evalúan en dialectos minoritarios del inglés o en idiomas poco representados, simplemente porque no existen datos de calidad en los benchmarks más conocidos.

La comunidad puede identificar estas carencias y crear nuevos conjuntos de prueba para llenarlos (por ejemplo, un conjunto de datos abierto de preguntas frecuentes en suajili para validar el comportamiento de un chatbot multilingüe). En este sentido, HELM ha incorporado evaluaciones más amplias precisamente gracias a la disponibilidad de datos abiertos, permitiendo medir no solo el rendimiento de los modelos en tareas comunes, sino también su comportamiento en otros contextos lingüísticos, culturales y sociales. Esto ha contribuido a visibilizar las limitaciones actuales de los modelos y a fomentar el desarrollo de sistemas más inclusivos y representativos del mundo real o modelos más adaptados a necesidades específicas de contextos locales como es el caso de modelo fundacional ALIA, desarrollado en España.

En definitiva, los datos abiertos contribuyen a democratizar la capacidad de auditar los sistemas de IA, evitando que el poder de validación resida solo en unos pocos. Permiten reducir los costes y barreras ya que un pequeño equipo de desarrollo puede probar su modelo con conjuntos abiertos sin tener que invertir grandes esfuerzos en recopilar datos propios. De este modo no solo se fomenta la innovación, sino que se consigue que soluciones de IA locales de pequeñas empresas estén sometidas también a estándares de validación rigurosos.

La validación de aplicaciones basadas en IA generativa es hoy una necesidad incuestionable para asegurar que estas herramientas operen en sintonía con nuestros valores y expectativas. No es un proceso trivial, requiere metodologías nuevas, métricas innovadoras y, sobre todo, una cultura de responsabilidad en torno a la IA. Pero los beneficios son claros, un sistema de IA rigurosamente validado será más confiable, tanto para el usuario individual que, por ejemplo, interactúa con un chatbot sin temor a recibir una respuesta tóxica, como para la sociedad en su conjunto que puede aceptar las decisiones basadas en estas tecnologías sabiendo que han sido correctamente auditadas. Y los datos abiertos contribuyen a cimentar esta confianza ya que fomentan la transparencia, enriquecen las pruebas con diversidad y hacen partícipe a toda la comunidad en la validación de los sistemas de IA..

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los datos son un recurso fundamental para mejorar nuestra calidad de vida porque permiten mejorar los procesos de toma de decisiones para crear productos y servicios personalizados, tanto en el sector público como en el privado. En contextos como la salud, la movilidad, la energía o la educación, el uso de datos facilita soluciones más eficientes y adaptadas a las necesidades reales de las personas. No obstante, en el trabajo con datos, la privacidad juega un papel clave. En este post, analizaremos cómo los espacios de datos, el paradigma de computación federada y el aprendizaje federado, una de sus aplicaciones más potentes, plantean una solución equilibrada para aprovechar el potencial de los datos sin poner en riesgo la privacidad. Además, resaltaremos cómo el aprendizaje federado también puede usarse con datos abiertos para mejorar su reutilización de forma colaborativa, incremental y eficiente.

La privacidad, clave en la gestión de datos

Como se ha mencionado anteriormente, el uso intensivo de datos exige una creciente atención a la privacidad. Por ejemplo, en salud digital, un mal uso secundario de datos de historias clínicas electrónicas podría vulnerar derechos fundamentales de pacientes. Una forma eficaz de preservar la privacidad es mediante ecosistemas de datos que prioricen la soberanía de los datos, como es el caso de los espacios de datos. Un espacio de datos es un sistema de gestión federada de datos que permite su intercambio de manera confiable entre proveedores y consumidores. Además, el espacio de datos garantiza la interoperabilidad de los datos para crear productos y servicios que generen valor. En un espacio de datos, cada proveedor mantiene sus propias normas de gobernanza, conservando el control sobre sus datos (es decir, la soberanía sobre sus datos), a la vez que se posibilita su reutilización por consumidores. Esto implica que cada proveedor debe poder decidir qué datos comparte, con quién y bajo qué condiciones, garantizando el cumplimiento de sus intereses y obligaciones legales.

Computación federada y espacios de datos

Los espacios de datos representan una evolución en la gestión de datos, relacionada con un paradigma denominado computación federada (federated computing), donde los datos se reutilizan sin necesidad de que haya un trasiego de datos desde los proveedores de datos hacia los consumidores. En la computación federada, los proveedores transforman sus datos en resultados intermedios que preservan la privacidad con el fin de poder ser enviados a los consumidores de datos. Además, esto posibilita que puedan aplicarse otras técnicas de mejora de la privacidad de datos (Privacy-Enhancing Technologies). La computación federada se alinea perfectamente con arquitecturas de referencia como Gaia-X y su Trust Framework, que establece los principios y requisitos para garantizar un intercambio de datos seguro, transparente y conforme a reglas comunes entre proveedores y consumidores de datos.

Aprendizaje federado

Una de las aplicaciones más potentes de la computación federada es el aprendizaje automático federado (federated learning), una técnica de inteligencia artificial que permite entrenar modelos sin necesidad de centralizar los datos. Es decir, en lugar de enviar los datos a un servidor central para procesarlos, lo que se envía son los modelos entrenados localmente por cada participante.

Estos modelos se combinan posteriormente de manera centralizada para crear un modelo global. A modo de ejemplo, imaginemos un consorcio de hospitales que quiere desarrollar un modelo predictivo para detectar una enfermedad rara. Cada hospital posee datos sensibles de sus pacientes, y compartirlos abiertamente no es viable por cuestiones de privacidad (incluso otras cuestiones legales o éticas). Con el aprendizaje federado, cada hospital entrena localmente el modelo con sus propios datos, y solo comparte los parámetros del modelo (resultados del entrenamiento) de manera centralizada. Así, el modelo final aprovecha la diversidad de datos de todos los hospitales sin comprometer la privacidad individual y las reglas de gobernanza de datos de cada hospital.

El entrenamiento en el aprendizaje federado suele seguir un ciclo iterativo:

- Un servidor central inicia un modelo base y lo envía a cada uno de los nodos distribuidos participantes.

- Cada nodo entrena el modelo localmente con sus datos.

- Los nodos devuelven solo los parámetros del modelo actualizado, no los datos (es decir, se evita el trasiego de datos).

- El servidor central agrega las actualizaciones en los parámetros, resultados del entrenamiento en cada nodo y actualiza el modelo global.

- El ciclo se repite hasta alcanzar un modelo suficientemente preciso.

Figura 1. Visual que representa el proceso de entrenamiento del aprendizaje federados. Elaboración propia

Este enfoque es compatible con diversos algoritmos de aprendizaje automático, incluyendo redes neuronales profundas, modelos de regresión, clasificadores, etc.

Beneficios y desafíos del aprendizaje federado

El aprendizaje federado ofrece múltiples beneficios al evitar el trasiego de datos. Destacamos los siguientes:

- Privacidad y cumplimiento normativo: al permanecer en su origen, se reducen significativamente los riesgos de exposición de los datos y se facilita el cumplimiento de regulaciones como el Reglamento General de Protección de Datos (RGPD).

- Soberanía de los datos: cada entidad mantiene el control total sobre sus datos, lo que evita conflictos de competitividad.

- Eficiencia: evita los costes y la complejidad de intercambiar grandes volúmenes de datos, lo que acelera los tiempos de procesamiento y desarrollo.

- Confianza: facilita la colaboración entre organizaciones sin fricciones.

Existen diversos casos de uso en los cuales el aprendizaje federado es necesario, por ejemplo:

- Salud: hospitales y centros de investigación pueden colaborar en modelos predictivos sin compartir datos de pacientes.

- Finanzas: bancos y aseguradoras pueden construir modelos de detección de fraude o análisis de riesgo compartido, respetando la confidencialidad de sus clientes.

- Turismo inteligente: los destinos turísticos pueden analizar flujos de visitantes o patrones de consumo sin necesidad de unificar las bases de datos de sus actores (tanto públicos como privados).

- Industria: empresas del mismo sector pueden entrenar modelos para mantenimiento predictivo o eficiencia operativa sin revelar datos competitivos.

Aunque sus beneficios son claros en diversidad de casos de uso, el aprendizaje federado también presenta retos técnicos y organizativos:

- Heterogeneidad de datos: los datos locales pueden tener diferentes formatos o estructuras, lo que dificulta el entrenamiento. Además, el esquema de estos datos puede cambiar con el tiempo, lo que representa una dificultad añadida.

- Datos desbalanceados: algunos nodos pueden tener más datos o de mayor calidad que otros, lo que puede sesgar el modelo global.

- Costes computacionales locales: cada nodo necesita recursos suficientes para entrenar el modelo localmente.

- Sincronización: el ciclo de entrenamiento requiere buena coordinación entre nodos para evitar latencias o errores.

Más allá del aprendizaje federado

Aunque la aplicación más destacada de la computación federada es el aprendizaje federado, están surgiendo muchas otras aplicaciones adicionales en la gestión de datos como, por ejemplo, el análisis de datos federado (federated analytics). El análisis de datos federado permite realizar análisis estadísticos y descriptivos sobre datos distribuidos sin necesidad de moverlos a los consumidores, sino que cada proveedor realiza localmente los cálculos estadísticos requeridos y solo comparte con el consumidor los resultados agregados según sus requisitos y permisos. En la siguiente tabla se muestran las diferencias entre aprendizaje federado y análisis de datos federado.

|

Criterio |

Aprendizaje federado |

Análisis de datos federado |

|

Objetivo |

Predicción y entrenamiento de modelos de aprendizaje automático. | Análisis descriptivo y cálculo de estadísticas. |

| Tipo de tarea | Tareas predictivas (por ejemplo, clasificación o regresión). | Tareas descriptivas (por ejemplo, medias o correlaciones). |

| Ejemplo | Entrenar modelos de diagnóstico de enfermedades a través de imágenes médicas procedentes de diversos hospitales. | Cálculo de indicadores sanitarios de un área de salud sin mover los datos entre hospitales. |

| Salida esperada | Modelo global entrenado. | Resultados estadísticos agregados. |

| Naturaleza | Iterativa. | Directa. |

| Complejidad computacional | Alta. | Media. |

| Algoritmos | Aprendizaje automático. | Algoritmos estadísticos. |

Figura 1. Tabla comparativa. Fuente: elaboración propia

Aprendizaje federado y datos abiertos: una simbiosis por explorar

En principio, los datos abiertos resuelven los problemas de privacidad antes de su publicación, por lo que se podría pensar que no es preciso hacer uso de técnicas de aprendizaje federado. Nada más lejos de la realidad. El uso de técnicas de aprendizaje federado puede aportar ventajas significativas en la gestión y explotación de los datos abiertos. De hecho, el primer aspecto a resaltar es que los portales de datos abiertos como datos.gob.es o data.europa.eu son entornos federados. Por ello, en estos portales, la aplicación de aprendizaje federado sobre conjuntos de datos de gran tamaño permitiría entrenar modelos directamente en origen, evitando costes de transferencia y procesamiento. Por otro lado, el aprendizaje federado facilitaría la combinación de datos abiertos con otros datos sensibles sin comprometer la privacidad de estos últimos. Finalmente, la naturaleza de una gran variedad de tipos de datos abiertos es muy dinámica (como los datos de tráfico), por lo que el aprendizaje federado habilitaría un entrenamiento incremental, considerando automáticamente nuevas actualizaciones de conjuntos de datos abiertos a medida que se publican, sin necesidad de reiniciar costosos procesos de entrenamiento.

Aprendizaje federado, base para una IA respetuosa con la privacidad

El aprendizaje automático federado representa una evolución necesaria en la forma en que desarrollamos servicios de inteligencia artificial, especialmente en contextos donde los datos son sensibles o están distribuidos entre varios proveedores. Su alineación natural con el concepto de espacio de datos lo convierte en una tecnología clave para impulsar la innovación basada en la compartición de datos, teniendo en cuenta la privacidad y manteniendo la soberanía de los datos.

A medida que la regulación (como el Reglamento relativo al Espacio Europeo de Datos de Salud) y las infraestructuras de espacios de datos evolucionen, el aprendizaje federado, y otros tipos de computación federada, jugarán un papel cada vez más importante en la compartición de datos, maximizando el valor de los datos, pero sin comprometer la privacidad. Finalmente, cabe destacar que, lejos de ser innecesario, el aprendizaje federado puede convertirse en un aliado estratégico para mejorar la eficiencia, gobernanza e impacto de los ecosistemas de datos abiertos.

Jose Norberto Mazón, Catedrático de Lenguajes y Sistemas Informáticos de la Universidad de Alicante. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

En el panorama actual del análisis de datos y la inteligencia artificial, la generación automática de informes completos y coherentes representa un desafío significativo. Mientras que las herramientas tradicionales permiten visualizar datos o generar estadísticas aisladas, existe la necesidad de sistemas que puedan investigar un tema a fondo, recopilar información de diversas fuentes, y sintetizar hallazgos en un informe estructurado y coherente.

En este ejercicio práctico, exploraremos el desarrollo de un agente de generación de reportes basado en LangGraph e inteligencia artificial. A diferencia de los enfoques tradicionales basados en plantillas o análisis estadísticos predefinidos, nuestra solución aprovecha los últimos avances en modelos de lenguaje para:

- Crear equipos virtuales de analistas especializados en diferentes aspectos de un tema.

- Realizar entrevistas simuladas para recopilar información detallada.

- Sintetizar los hallazgos en un informe coherente y bien estructurado.

Accede al repositorio del laboratorio de datos en Github.

Ejecuta el código de pre-procesamiento de datos sobre Google Colab.

Como se muestra en la Figura 1, el flujo completo del agente sigue una secuencia lógica que va desde la generación inicial de preguntas hasta la redacción final del informe.

Figura 1. Diagrama de flujo del agente.

Arquitectura de la aplicación

El núcleo de la aplicación se basa en un diseño modular implementado como un grafo de estados interconectados, donde cada módulo representa una funcionalidad específica en el proceso de generación de reportes. Esta estructura permite un flujo de trabajo flexible, recursivo cuando es necesario, y con capacidad de intervención humana en puntos estratégicos.

Componentes principales

El sistema se compone de tres módulos fundamentales que trabajan en conjunto:

1. Generador de Analistas Virtuales

Este componente crea un equipo diverso de analistas virtuales especializados en diferentes aspectos del tema a investigar. El flujo incluye:

- Creación inicial de perfiles basados en el tema de investigación.

- Punto de retroalimentación humana que permite revisar y refinar los perfiles generados.

- Regeneración opcional de analistas incorporando sugerencias.

Este enfoque garantiza que el informe final incluya perspectivas diversas y complementarias, enriqueciendo el análisis.

2. Sistema de Entrevistas

Una vez generados los analistas, cada uno participa en un proceso de entrevista simulada que incluye:

- Generación de preguntas relevantes basadas en el perfil del analista.

- Búsqueda de información en fuentes vía Tavily Search y Wikipedia.

- Generación de respuestas informativas combinando la información obtenida.

- Decisión automática sobre continuar o finalizar la entrevista en función de la información recopilada.

- Almacenamiento de la transcripción para su procesamiento posterior.

El sistema de entrevistas representa el corazón del agente, donde se obtiene la información que nutrirá el informe final. Tal y como se muestra en la Figura 2, este proceso puede monitorizarse en tiempo real mediante LangSmith, una herramienta abierta de observabilidad que permite seguir cada paso del flujo.

Figura 2. Monitorización del sistema vía LangGraph. Ejemplo concreto de una interacción analista-entrevistador.

3. Generador de Informes

Finalmente, el sistema procesa las entrevistas para crear un informe coherente mediante:

- Redacción de secciones individuales basadas en cada entrevista.

- Creación de una introducción que presente el tema y la estructura del informe.

- Organización del contenido principal que integra todas las secciones.

- Generación de una conclusión que sintetiza los hallazgos principales.

- Consolidación de todas las fuentes utilizadas.

La Figura 3 muestra un ejemplo del informe resultante del proceso completo, demostrando la calidad y estructura del documento final generado automáticamente.

Figura 3. Vista del informe resultante del proceso de generación automática al prompt de “Datos abiertos en España”.

¿Qué puedes aprender?

Este ejercicio práctico te permite aprender:

Integración de IA avanzada en sistemas de procesamiento de información:

- Cómo comunicarse efectivamente con modelos de lenguaje.

- Técnicas para estructurar prompts que generen respuestas coherentes y útiles.

- Estrategias para simular equipos virtuales de expertos.

Desarrollo con LangGraph:

- Creación de grafos de estados para modelar flujos complejos.

- Implementación de puntos de decisión condicionales.

- Diseño de sistemas con intervención humana en puntos estratégicos.

Procesamiento paralelo con LLMs:

- Técnicas de paralelización de tareas con modelos de lenguaje.

- Coordinación de múltiples subprocesos independientes.

- Métodos de consolidación de información dispersa.

Buenas prácticas de diseño:

- Estructuración modular de sistemas complejos.

- Manejo de errores y reintentos.

- Seguimiento y depuración de flujos de trabajo mediante LangSmith.

Conclusiones y futuro

Este ejercicio demuestra el extraordinario potencial de la inteligencia artificial como puente entre los datos y los usuarios finales. A través del caso práctico desarrollado, podemos observar cómo la combinación de modelos de lenguaje avanzados con arquitecturas flexibles basadas en grafos abre nuevas posibilidades para la generación automática de informes.

La capacidad de simular equipos de expertos virtuales, realizar investigaciones paralelas y sintetizar hallazgos en documentos coherentes, representa un paso significativo hacia la democratización del análisis de información compleja.

Para aquellas personas interesadas en expandir las capacidades del sistema, existen múltiples direcciones prometedoras para su evolución:

- Incorporación de mecanismos de verificación automática de datos para garantizar la precisión.

- Implementación de capacidades multimodales que permitan incorporar imágenes y visualizaciones.

- Integración con más fuentes de información y bases de conocimiento.

- Desarrollo de interfaces de usuario más intuitivas para la intervención humana.

- Expansión a dominios especializados como medicina, derecho o ciencias.

En resumen, este ejercicio no solo demuestra la viabilidad de automatizar la generación de informes complejos mediante inteligencia artificial, sino que también señala un camino prometedor hacia un futuro donde el análisis profundo de cualquier tema esté al alcance de todos, independientemente de su nivel de experiencia técnica. La combinación de modelos de lenguaje avanzados, arquitecturas de grafos y técnicas de paralelización abre un abanico de posibilidades para transformar la forma en que generamos y consumimos información.

La Agencia Española de Protección de Datos ha publicado recientemente la traducción al español de la Guía sobre generación de datos sintéticos, elaborada originalmente por la Autoridad de Protección de Datos de Singapur. Este documento ofrece orientación técnica y práctica para personas responsables, encargadas y delegadas de protección de datos sobre cómo implementar esta tecnología que permite simular datos reales manteniendo sus características estadísticas sin comprometer información personal.

La guía destaca cómo los datos sintéticos pueden impulsar la economía del dato, acelerar la innovación y mitigar riesgos en brechas de seguridad. Para ello, presenta casos prácticos, recomendaciones y buenas prácticas orientadas a reducir los riesgos de reidentificación. En este post, analizamos los aspectos clave de la Guía destacando casos de uso principales y ejemplos de aplicación práctica.

¿Qué son los datos sintéticos? Concepto y beneficios

Los datos sintéticos son datos artificiales generados mediante modelos matemáticos específicamente diseñados para sistemas de inteligencia artificial (IA) o aprendizaje automático (ML). Estos datos se crean entrenando un modelo con un conjunto de datos de origen para imitar sus características y estructura, pero sin replicar exactamente los registros originales.

Los datos sintéticos de alta calidad conservan las propiedades estadísticas y los patrones de los datos originales. Por lo tanto, permiten realizar análisis que produzcan resultados similares a los que se obtendrían con los datos reales. Sin embargo, al ser artificiales, reducen significativamente los riesgos asociados con la exposición de información sensible o personal.

Para profundizar en este tema, tienes disponible este Informe monográfico sobre datos sintéticos: ¿Qué son y para qué se usan? con información detallada sobre los fundamentos teóricos, metodologías y aplicaciones prácticas de esta tecnología.

La implementación de datos sintéticos ofrece múltiples ventajas para las organizaciones, por ejemplo:

- Protección de la privacidad: permiten realizar análisis de datos manteniendo la confidencialidad de la información personal o comercialmente sensible.

- Cumplimiento normativo: facilitan el seguimiento de regulaciones de protección de datos mientras se maximiza el valor de los activos de información.

- Reducción de riesgos: minimizan las posibilidades de brechas de datos y sus consecuencias.

- Impulso a la innovación: aceleran el desarrollo de soluciones basadas en datos sin comprometer la privacidad.

- Mejora en la colaboración: posibilitan compartir información valiosa entre organizaciones y departamentos de forma segura.

Pasos para generar datos sintéticos

Para implementar correctamente esta tecnología, la Guía sobre generación de datos sintéticos recomienda seguir un enfoque estructurado en cinco pasos:

- Conocer los datos: comprender claramente el propósito de los datos sintéticos y las características de los datos de origen que deben preservarse, estableciendo objetivos precisos respecto al umbral de riesgo aceptable y la utilidad esperada.

- Preparar los datos: identificar las ideas clave que deben conservarse, seleccionar los atributos relevantes, eliminar o seudonimizar identificadores directos, y estandarizar los formatos y estructuras en un diccionario de datos bien documentado.

- Generar datos sintéticos: seleccionar los métodos más adecuados según el caso de uso, evaluar la calidad mediante comprobaciones de integridad, fidelidad y utilidad, y ajustar iterativamente el proceso para lograr el equilibrio deseado.

- Evaluar riesgos de reidentificación: aplicar técnicas basadas en ataques para determinar la posibilidad de inferir información sobre individuos o su pertenencia al conjunto original, asegurando que los niveles de riesgo sean aceptables.

- Gestionar riesgos residuales: implementar controles técnicos, de gobernanza y contractuales para mitigar los riesgos identificados, documentando adecuadamente todo el proceso.

Aplicaciones prácticas y casos de éxito

Para obtener todas estas ventajas, los datos sintéticos pueden aplicarse en diversos escenarios que responden a necesidades específicas de las organizaciones. La Guía menciona, por ejemplo:

1. Generación de conjuntos de datos para entrenar modelos de IA/ML: los datos sintéticos resuelven el problema de la escasez de datos etiquetados (es decir, que se pueden utilizar) para entrenar modelos de IA. Cuando los datos reales son limitados, los datos sintéticos pueden ser una alternativa rentable. Además, permiten simular eventos extraordinarios o incrementar la representación de grupos minoritarios en los conjuntos de entrenamiento. Una aplicación interesante para mejorar el rendimiento y la representatividad de todos los grupos sociales en los modelos de IA.

2. Análisis de datos y colaboración: este tipo de datos facilitan el intercambio de información para análisis, especialmente en sectores como la salud, donde los datos originales son particularmente sensibles. Tanto en este sector como en otros, proporcionan a las partes interesadas una muestra representativa de los datos reales sin exponer información confidencial, permitiendo evaluar la calidad y potencial de los datos antes de establecer acuerdos formales.

3. Pruebas de software: son muy útiles para el desarrollo de sistemas y la realización de pruebas de software porque permiten utilizar datos realistas, pero no reales en entornos de desarrollo, evitando así posibles brechas de datos personales en caso de comprometerse el entorno de desarrollo.

La aplicación práctica de datos sintéticos ya está demostrando resultados positivos en diversos sectores:

I. Sector financiero: detección de fraudes. J.P. Morgan ha utilizado con éxito datos sintéticos para entrenar modelos de detección de fraude, creando conjuntos de datos con un mayor porcentaje de casos fraudulentos que permitieron mejorar significativamente la capacidad de los modelos para identificar comportamientos anómalos.

II. Sector tecnológico: investigación sobre sesgos en IA. Mastercard colaboró con investigadores para desarrollar métodos de prueba de sesgos en IA mediante datos sintéticos que mantenían las relaciones reales de los datos originales, pero eran lo suficientemente privados como para compartirse con investigadores externos, permitiendo avances que no habrían sido posibles sin esta tecnología.

III. Sector salud: salvaguarda de datos de pacientes. Johnson & Johnson implementó datos sintéticos generados por IA como alternativa a las técnicas tradicionales de anonimización para procesar datos sanitarios, logrando una mejora significativa en la calidad del análisis al representar eficazmente a la población objetivo mientras se protegía la privacidad de los pacientes.

El equilibrio entre utilidad y protección

Es importante destacar que los datos sintéticos no están inherentemente libres de riesgos. La semejanza con los datos originales podría, en determinadas circunstancias, permitir la filtración de información sobre individuos o datos confidenciales. Por ello, resulta crucial encontrar un equilibrio entre la utilidad de los datos y su protección.

Este equilibrio puede lograrse mediante la implementación de buenas prácticas durante el proceso de generación de datos sintéticos, incorporando medidas de protección como:

- Preparación adecuada de los datos: eliminación de valores atípicos, seudonimización de identificadores directos y generalización de datos granulares.

- Evaluación de riesgos de reidentificación: análisis de la posibilidad de que se puedan vincular los datos sintéticos con individuos reales.

- Implementación de controles técnicos: añadir ruido a los datos, reducir la granularidad o aplicar técnicas de privacidad diferencial.

Los datos sintéticos representan una oportunidad excepcional para impulsar la innovación basada en datos mientras se respeta la privacidad y se cumple con las normativas de protección de datos. Su capacidad para generar información estadísticamente representativa pero artificial los convierte en una herramienta versátil para múltiples aplicaciones, desde el entrenamiento de modelos de IA hasta la colaboración entre organizaciones y el desarrollo de software.

Al implementar adecuadamente las buenas prácticas y controles descritos en Guía sobre generación de datos sintéticos que ha traducido la AEPD, las organizaciones pueden aprovechar los beneficios de los datos sintéticos minimizando los riesgos asociados, posicionándose a la vanguardia de la transformación digital responsable. La adopción de tecnologías de mejora de la privacidad como los datos sintéticos no solo representa una medida defensiva, sino un paso proactivo hacia una cultura organizacional que valora tanto la innovación como la protección de datos, aspectos fundamentales para el éxito en la economía digital del futuro.

La evolución de la IA generativa está siendo vertiginosa: desde los primeros grandes modelos del lenguaje que nos impresionaron con su capacidad para reproducir la lecto-escritura de los humanos, pasando por las avanzadas técnicas de RAG (Retrieval-Augmented Generation) que mejoraron cuantitativamente la calidad de las respuestas proporcionadas y la aparición de agentes inteligentes, hasta llegar a una innovación que redefine nuestra relación con la tecnología: Computer use.

A finales del mes de abril del año 2020, tan solo un mes después de que comenzara un periodo inédito de confinamiento domiciliario de alcance mundial debido a la pandemia mundial del SAR-Covid19, difundíamos desde datos.gob.es los grandes modelos del lenguaje GPT-2 y GPT-3. OpenAI, fundada en 2015, había presentado prácticamente un año antes (febrero del 2019) un nuevo modelo del lenguaje que era capaz de generar texto escrito prácticamente indistinguible del creado por un humano. GPT-2 se había entrenado con un corpus (conjunto de textos preparados para entrenar modelos del lenguaje) de unos 40 GB (Gigabytes) de tamaño (unos 8 millones de páginas web), mientras que la última familia de modelos basados en GPT-4 se estima que han sido entrenados con corpus del tamaño de TB (Terabytes); mil veces más.

En este contexto, es importante hablar de dos conceptos:

- LLM (Large Language Models): son modelos de lenguaje de gran escala, entrenados con vastas cantidades de datos y capaces de realizar una amplia gama de tareas lingüísticas. Hoy, disponemos de incontables herramientas basadas en estos LLM que, por campos de especialidad, son capaces de generar código de programación, imágenes y videos ultra-realistas y resolver problemas matemáticos complejos. Todas las grandes empresas y organizaciones del sector tecnológico-digital se han lanzado a integrar estas herramientas en sus diferentes productos de software y hardware, desarrollando casos de uso que resuelven u optimizan tareas y actividades concretas que previamente tenían alta intervención humana.

- Agentes: la experiencia de uso con los modelos de inteligencia artificial cada vez es más completa, de forma que le podemos pedir a nuestra interfaz no sólo respuestas a nuestras preguntas, sino también que realice tareas complejas que requieren integración con otras herramientas informáticas. Por ejemplo, no solo le preguntamos a un chatbot información sobre los mejores restaurantes de la zona, sino que le pedimos que busque disponibilidad de mesa para unas fechas concretas y realice una reserva por nosotros. Esta experiencia de uso extendida es lo que nos proporcionan los agentes de inteligencia artificial. Basados en los grandes modelos del lenguaje, estos agentes son capaces de interaccionar con el mundo exterior (al modelo) y “hablar” con otros servicios mediante API e interfaces de programación preparadas para tal fin.

Computer use

Sin embargo, la capacidad de los agentes para realizar acciones de forma autónoma depende de dos elementos clave: por un lado, su programación concreta -la funcionalidad que se les haya programado o configurado-; por otro lado, la necesidad de que el resto de programas estén preparados para “hablar” con estos agentes. Es decir, sus interfaces de programación han de estar listas para recibir instrucciones de estos agentes. Por ejemplo, la aplicación de reservas del restaurante ha de estar preparada, no solo para recepcionar formularios rellenados por un humano, sino también, peticiones realizadas por un agente que previamente ha sido invocado por un humano mediante lenguaje natural. Este hecho impone una limitación sobre el conjunto de actividades y/o tareas que podemos automatizar desde un interfaz conversacional. Es decir, el interfaz conversacional puede proporcionarnos respuestas casi infinitas a las cuestiones que le planteemos, pero encuentra grandes limitaciones para interactuar con el mundo exterior debido a la falta de preparación del resto de aplicaciones informáticas.

Aquí es donde entra Computer use. Con la llegada del modelo Claude 3.5 Sonnet, la empresa Anthropic ha introducido Computer use, una capacidad en fase beta que permite a la IA interactuar directamente con interfaces gráficas de usuario.

¿Cómo funciona Computer use?

Claude puede mover el cursor de tu ordenador como si fueras tú, hacer clic en botones y escribir texto, emulando la forma en que los humanos operamos con un ordenador. La mejor forma de entender cómo funciona Computer use en la práctica es viéndolo en acción. Aquí os dejamos un link directo al canal de YouTube de la sección específica de Computer use.

Figura 1. Captura del canal de YouTube de Anthropic, sección específica de Computer use.

¿Te animas a probarlo?

Si has llegado hasta aquí, no te puedes quedar sin probarlo con tus propias manos.

A continuación, te proponemos una sencilla guía para poder probar Computer use en un entorno aislado. Es importante tener en cuenta las recomendaciones de seguridad que Antrophic propone en sus guías de Computer use. Esta característica del modelo Claude Sonet puede realizar acciones sobre un ordenador y esto puede ser potencialmente peligroso, por lo que se recomienda revisar cuidadosamente la advertencia de seguridad de Computer use.

Toda la documentación oficial para desarrolladores se encuentra en el repositorio oficial de Github de Antrophic. En este post, nosotros hemos optado por ejecutar Computer use en un entorno de un contenedor de Docker. Es la forma más sencilla y segura de probarlo. Si no lo tienes ya, puedes seguir las sencillas guías oficiales para pre-instalarlo en tu sistema.

Para reproducir esta prueba os proponemos seguir este guion paso a paso:

- Antropic API Key. Para interactuar con Claude Sonet necesitas una cuenta de Antropic que puedes crear gratuitamente aquí. Una vez dentro, puedes ir a la sección de API Keys y crear una nueva para tu prueba

- Una vez tengas tu API Key, deberás de ejecutar este comando en tu terminal, sustituyendo tu clave donde indica “%your_api_key%”:

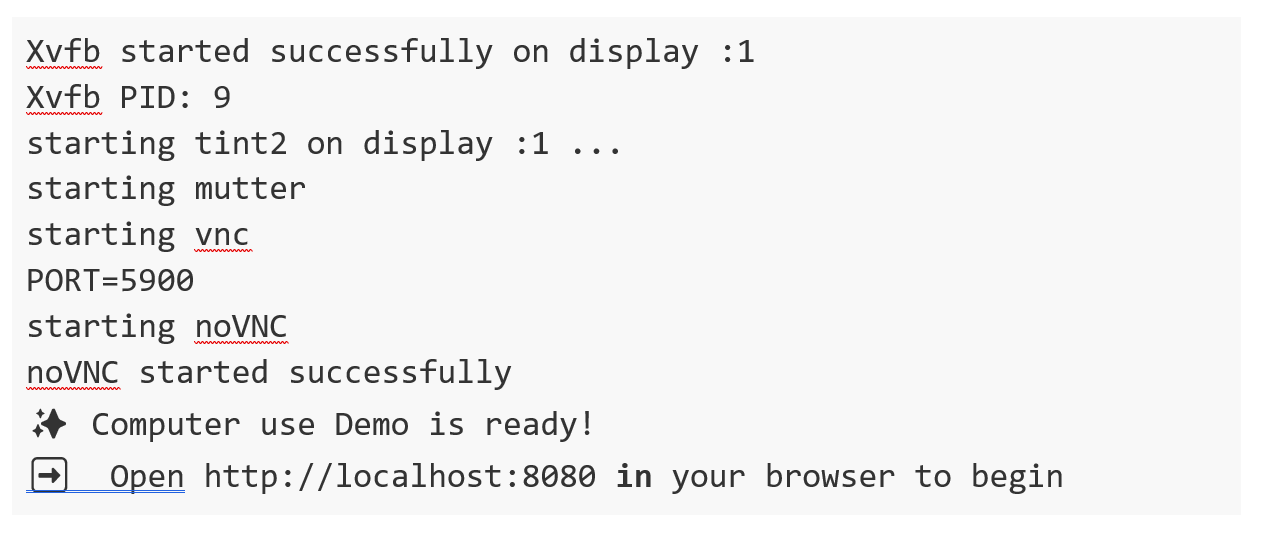

3. Si todo ha ido bien, verás estos mensajes en tu terminal y ya solo te queda abrir tu navegador y escribir esta url en la barra de navegación: http://localhost:8080/

Verás que se abre tu interfaz:

Figura 2. Interfaz de Computer use.

Ya puedes emplazar a explorar cómo funciona Computer use. Te sugerimos el siguiente prompt para empezar:

Te proponemos que empieces poco a poco. Por ejemplo, pídele que abra un navegador y busque algo. También puedes pedirle que te de información sobre tu ordenador o sistema operativo. Poco a poco, puedes ir pidiendo tareas más complejas. Nosotros hemos probado este prompt y tras varias pruebas hemos conseguido que Computer use realice la tarea completa.

Abre un navegador, navega hasta el catálogo de datos.gob.es, usa el buscador para localizar un conjunto de datos sobre: Seguridad ciudadana. Siniestralidad Tráfico. 2014; Localiza el fichero en formato csv; descárgalo y ábrelo con libre Office.

Potenciales usos en plataformas de datos como datos.gob.es

A la vista de esta primera versión experimental de Computer use parece que el potencial de la herramienta es muy alto. Podemos imaginar cuantas más cosas podemos hacer gracias a esta herramienta. Aquí os dejamos algunas ideas:

- Podríamos pedirle al sistema que realice una búsqueda completa de datasets relacionados con una temática concreta y que hiciera un resumen en un documento de los principales resultados. De esta manera, si por ejemplo escribimos un artículo sobre datos del tráfico en España, podríamos obtener de forma desatendida un listado con los principales datasets abiertos de datos de tráfico en España en el catálogo de datos.gob.es.

- De la misma forma, podríamos solicitar un resumen igual, pero en este caso, no de dataset, sino de artículos de la plataforma.

- Un ejemplo un poco más sofisticado sería pedirle a Claude, mediante el interfaz conversacional de Computer use que nos haga una serie de llamadas a la API de datos.gob.es para obtener información de ciertos datasets de forma programática. Para ello, abrimos un navegador y nos logueamos en una aplicación como Postman (recordemos en este punto que Computer use está en modo experimental y no nos permite introducir datos sensibles como credenciales de usuario en páginas web). A continuación le podemos pedimos que busque información sobre la API de datos.gob.es y ejecute una llamada http aprovechando que dicha API no requiere autenticación.

A través de estos sencillos ejemplos, esperamos haberte presentado una nueva aplicación de la IA generativa y que hayas entendido el cambio de paradigma que supone esta nueva capacidad. Si la máquina es capaz de emular el uso de un ordenador como lo hacemos los humanos, se abren nuevas oportunidades inimaginables para los próximos meses.

Contenido elaborado por Alejandro Alija, experto en Transformación Digital e Innovación. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su auto

La enorme aceleración de la innovación en torno a la inteligencia artificial (IA) en estos últimos años gira, en gran medida, en torno al desarrollo de los llamados “modelos fundacionales”. También conocidos como modelos grandes (Large [X] Models o LxM), Los modelos fundacionales, según la definición del Center for Research on Foundation Models (CRFM) del Institute for Human-Centered Artificial Intelligence's (HAI) de la Universidad de Stanford son modelos que han sido entrenados con conjuntos de datos de gran tamaño y gran diversidad y que pueden adaptarse a realizar una amplia gama de tareas mediante técnicas como el ajuste fino (fine-tuning).

Precisamente es esta versatilidad y capacidad de adaptación lo que ha convertido a los modelos fundacionales en la piedra angular de las numerosas aplicaciones de la inteligencia artificial que están desarrollándose, ya que una única arquitectura base puede utilizarse en multitud de casos de uso con un esfuerzo adicional limitado.

Tipos de modelos fundacionales

La "X" en LxM puede sustituirse por varias opciones según el tipo de datos o tareas para las que el modelo está especializado. Los más conocidos por el público son los LLM (Large Language Models), que están en la base de aplicaciones como ChatGPT o Gemini, y que se centran en la comprensión y generación de lenguaje natural. Por su parte, los LVM (Large Vision Models), como DINOv2 o CLIP, están diseñados para interpretar imágenes y vídeos, reconocer objetos o generar descripciones visuales. También existen modelos como como Operator o Rabbit R1 que se encuentran en la categoría de LAM (Large Action Models) y que están orientados a ejecutar acciones a partir de instrucciones complejas.

A medida que han ido surgiendo regulaciones en distintas partes del mundo, también han aparecido otras definiciones que buscan establecer criterios y responsabilidades sobre estos modelos para fomentar la confianza y la seguridad. La definición más relevante para nuestro contexto es la establecida en el Reglamento de IA de la Unión Europea (AI Act), el cual los denomina “modelos de IA de uso general” y los distingue por su “capacidad de realizar de manera competente una amplia variedad de tareas diferenciadas” y porque “suelen entrenarse usando grandes volúmenes de datos y a través de diversos métodos, como el aprendizaje autosupervisado, no supervisado o por refuerzo”.

Modelos fundacionales en español y otras lenguas cooficiales

Históricamente, el inglés ha sido el idioma dominante en el desarrollo de los grandes modelos de IA, hasta el punto de que en torno al 90% de los tokens de entrenamiento de los grandes modelos actuales se han extraído de textos en inglés. Por ello resulta lógico que los modelos más conocidos, por ejemplo la familia GPT de OpenAI, Gemini de Google o Llama de Meta, sean más competentes respondiendo en inglés y presenten menor desempeño al usarlos en otros idiomas como el español.

Por tanto, la creación de modelos fundacionales en español, como ALIA, no es un simple ejercicio técnico o de investigación, sino que se trata de un movimiento estratégico para garantizar que la inteligencia artificial no haga aún más profundas las asimetrías lingüísticas y culturales que ya existen en las tecnologías digitales en general. El desarrollo de ALIA, impulsado por la Estrategia de Inteligencia Artificial 2024 de España, “partiendo del amplio alcance de nuestras lenguas, habladas por 600 millones de personas, tiene como objetivo facilitar el desarrollo de servicios y productos avanzados en tecnologías del lenguaje, ofreciendo una infraestructura marcada por la máxima transparencia y apertura”.

Este tipo de iniciativas no son exclusivas de España. Otros proyectos similares incluyen BLOOM, un modelo multilingüe de 176 mil millones de parámetros desarrollado por más de 1.000 investigadores de todo el mundo y que soporta 46 lenguas naturales y 13 lenguajes de programación. En China, Baidu ha desarrollado ERNIE, un modelo con fuerte capacidad en mandarín, mientras que en Francia el modelo PAGNOL se ha centrado en mejorar las capacidades en francés. Estos esfuerzos paralelos muestran una tendencia global hacia la "democratización lingüística" de la IA.

Desde principios de 2025, están disponibles los primeros modelos de lenguaje en las cuatro lenguas cooficiales, dentro del proyecto ALIA. En la familia de modelos ALIA destaca ALIA-40B, un modelo con 40.000 millones de parámetros, que es por el momento el modelo fundacional multilingüe público más avanzado de Europa y que fue entrenado durante más de 8 meses en el supercomputador MareNostrum 5, procesando 6,9 billones de tokens que equivaldrían a unos 33 terabytes de texto (¡unos 17 millones de libros!). Aquí se incluyen todo tipo de documentos oficiales y repositorios científicos en español, desde los diarios de sesiones del Congreso hasta repositorios científicos o boletines oficiales para asegurar la riqueza y calidad de su conocimiento.

Aunque se trata de un modelo multilingüe, el español y lenguas cooficiales tienen un peso muy superior al habitual en estos modelos, en torno al 20%, ya que el entrenamiento del modelo se diseñó específicamente para estas lenguas, reduciendo la relevancia del inglés y adaptando los tokens a las necesidades del español, catalán, euskera y gallego. Gracias a ello, ALIA “entiende” mejor nuestras expresiones locales y matices culturales que un modelo genérico entrenado mayoritariamente en inglés.

Aplicaciones de los modelos fundacionales en español y lenguas cooficiales

Aún es muy pronto para juzgar el impacto en sectores y aplicaciones concretas que puedan tener ALIA y otros modelos que puedan desarrollarse a partir de esta experiencia. Sin embargo, se espera que sirvan de base para mejorar multitud de aplicaciones y soluciones de Inteligencia Artificial:

- Administración pública y gobierno: ALIA podría dar vida a asistentes virtuales que atiendan a la ciudadanía las 24 horas en trámites como pagar impuestos, renovar el DNI, solicitar becas, etc. ya que está entrenado específicamente con la normativa española. De hecho, ya se anunció un piloto para la Agencia Tributaria usando ALIA, que tendría como objetivo agilizar gestiones internas.

- Educación: un modelo como ALIA podría ser también la base de tutores virtuales personalizados que orienten a estudiantes en español y lenguas cooficiales. Por ejemplo, asistentes que expliquen conceptos de matemáticas o historia en lenguaje sencillo y respondan preguntas del alumnado, adaptándose a su nivel ya que, al conocer bien nuestra lengua, serían capaces de aportar matices importantes en las respuestas y entender las dudas típicas de hablantes nativos en estos idiomas. También podrían ayudar a profesores, generando ejercicios o resúmenes de lecturas o asistiéndoles en la corrección de los trabajos de los alumnos.

- Salud: ALIA podría servir para analizar textos médicos y ayudar a profesionales de la salud con informes clínicos, historiales, folletos informativos, etc. Por ejemplo, podría revisar expedientes de pacientes para extraer elementos clave, o asistir a los profesionales en el proceso de diagnóstico. De hecho, el Ministerio de Sanidad planea una aplicación piloto con ALIA para mejorar la detección temprana de insuficiencias cardíacas en atención primaria.

- Justicia: en el ámbito jurídico, ALIA entendería términos técnicos y contextos del derecho español mucho mejor que un modelo no especializado ya que ha sido entrenada con vocabulario legal de documentos oficiales. Un asistente legal virtual basado en ALIA podría ser capaz de contestar consultas básicas del ciudadano como, por ejemplo, cómo iniciar un determinado trámite legal, citando la normativa aplicable. La administración de justicia podría beneficiarse también con unas traducciones automáticas de documentos judiciales entre lenguas cooficiales mucho más precisas.

Líneas futuras

El desarrollo de modelos fundaciones en español, al igual que en otros idiomas, comienza a considerarse fuera de Estados Unidos como una cuestión estratégica que contribuye a garantizar la soberanía tecnológica de los países. Por supuesto, será necesario seguir entrenando versiones más avanzadas (se apunta a modelos de hasta 175 mil millones de parámetros, que serían equiparables a los más potentes del mundo), incorporando nuevos datos abiertos, y afinando las aplicaciones. Desde la Dirección del Dato y la SEDIA se pretende continuar apoyando el crecimiento de esta familia de modelos, para mantenerla en vanguardia y asegurar su adopción.

Por otra parte, estos primeros modelos fundacionales en español y lenguas cooficiales se han centrado inicialmente en el lenguaje escrito, así que la siguiente frontera natural podría estar en la multimodalidad. Integrar la capacidad de gestionar imágenes, audio o vídeo en español junto con el texto multiplicaría sus aplicaciones prácticas ya que en la interpretación de imágenes en español es uno de los ámbitos donde se detectan mayores deficiencias en los grandes modelos genéricos.

También habrá que vigilar los aspectos éticos para asegurarse que estos modelos no perpetúen sesgos y sean útiles para todos los colectivos, incluyendo aquellos que hablan en distintas lenguas o que tienen diferentes niveles educativos. En este aspecto la Inteligencia Artificial Explicable (XAI) no es algo opcional, sino un requisito fundamental para garantizar su adopción responsable. La Agencia Nacional de Supervisión de la IA, la comunidad investigadora y la propia sociedad civil tendrán aquí un rol importante.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

¿Sabías que las habilidades de ciencia de datos están entre las más demandadas por las empresas? En este pódcast, te vamos a contar cómo puedes formarte en este campo, de manera autodidacta. Para ello, contaremos con dos expertos en ciencia de datos:

- Juan Benavente, ingeniero industrial e informático con más de 12 años de experiencia en innovación tecnológica y transformación digital. Además, lleva años formando a nuevos profesionales en escuelas tecnológicas, escuelas de negocio y universidades.

- Alejandro Alija, doctor en física, científico de datos y experto en transformación digital. Además de su amplia experiencia profesional enfocada en el Internet of Things (internet de las cosas), Alejandro también trabaja como profesor en diferentes escuelas de negocio y universidades.

Resumen / Transcripción de la entrevista

1. ¿Qué es la ciencia de datos? ¿Por qué es importante y para qué nos puede servir?

Alejandro Alija: La ciencia de datos podría definirse como una disciplina cuyo principal objetivo es entender el mundo, los procesos propios de un negocio y de la vida, analizando y observando los datos. En los últimos 20 años ha cobrado una relevancia excepcional debido a la explosión en la generación de datos, principalmente por la irrupción de internet y del mundo conectado.

Juan Benavente: El término ciencia de datos ha ido evolucionando desde su creación. Hoy, un científico de datos es la persona que está trabajando en el nivel más alto en análisis de datos, frecuentemente asociado con la construcción de algoritmos de machine learning o inteligencia artificial para empresas o sectores específicos, como predecir u optimizar la fabricación en una planta.

La profesión está evolucionando rápidamente, y probablemente en los próximos años se vaya fragmentando. Hemos visto aparecer nuevos roles como ingenieros de datos o especialistas en MLOps. Lo importante es que hoy cualquier profesional, independientemente de su área, necesita trabajar con datos. No cabe duda de que cualquier posición o empresa requiere análisis de datos, cada vez más avanzados. Da igual si estás en marketing, ventas, operaciones o en la universidad. Cualquiera hoy en día está trabajando con datos, manipulándolos y analizándolos. Si además aspiramos a la ciencia de datos, que sería el mayor nivel de expertise, estaremos en una posición muy beneficiosa. Pero, sin duda, recomendaría a cualquier profesional que tenga esto en radar.

2. ¿Cómo os iniciasteis en la ciencia de datos y qué hacéis para manteneros actualizados? ¿Qué estrategias recomendaríais tanto para principiantes como para perfiles más experimentados?

Alejandro Alija: Mi formación básica es en física, e hice mi doctorado en ciencia básica. En realidad, podría decirse que cualquier científico, por definición, es un científico de datos, porque la ciencia se basa en formular hipótesis y demostrarlas con experimentos y teorías. Mi relación con los datos comenzó temprano en la academia. Un punto de inflexión en mi carrera fue cuando empecé a trabajar en el sector privado, específicamente en una compañía de gestión medioambiental que se dedica a medir y observar la contaminación atmosférica. El medio ambiente es un campo que tradicionalmente es gran generador de datos, especialmente por ser un sector regulado donde las administraciones y empresas privadas están obligadas, por ejemplo, a registrar los niveles de contaminación atmosférica en determinadas condiciones. Encontré series históricas de hasta 20 años de antigüedad que estaban a mi disposición para analizar. A partir de ahí empezó mi curiosidad y me especialicé en herramientas concretas para analizar y entender lo que está ocurriendo en el mundo.

Juan Benavente: Yo me identifico con lo que ha comentado Alejandro porque tampoco soy informático. Me formé en ingeniería industrial y aunque la informática es uno de mis intereses, no fue mi base. A diferencia, hoy en día, sí veo que se están formando más especialistas desde la universidad. Actualmente, un científico de datos tiene muchas skills a la espalda como cuestiones de estadística, matemáticas y la capacidad de entender todo lo que pasa en el sector. Yo he ido adquiriendo estos conocimientos en base a la práctica. Sobre cómo mantenerse actualizado, yo creo que, en muchos casos, puedes estar en contacto con empresas que están innovando en este campo. También en eventos sectoriales o tecnológicos se puede aprender mucho. Yo empecé en las smart cities y he ido pasando por el mundo industrial hasta aprender poco a poco.

Alejandro Alija: Por añadir otra fuente en la que mantenerse actualizado. A parte de las que ha comentado Juan, creo que es importante identificar lo que llamamos outsiders, los fabricantes de tecnologías, los actores del mercado. Son una fuente de información muy útil para estar actualizado: identificar sus estrategias de futuros y por qué apuestan.

3. Pongámonos en el caso hipotético de que alguien con pocos o nulos conocimientos técnicos, quiera aprender ciencia de datos, ¿por dónde empieza?