Se presenta a continuación una nueva guía de Análisis Exploratorio de Datos (AED) implementada en Python, que evoluciona y complementa la versión publicada en R en el año 2021. Esta actualización responde a las necesidades de una comunidad cada vez más diversa en el ámbito de la ciencia de datos.

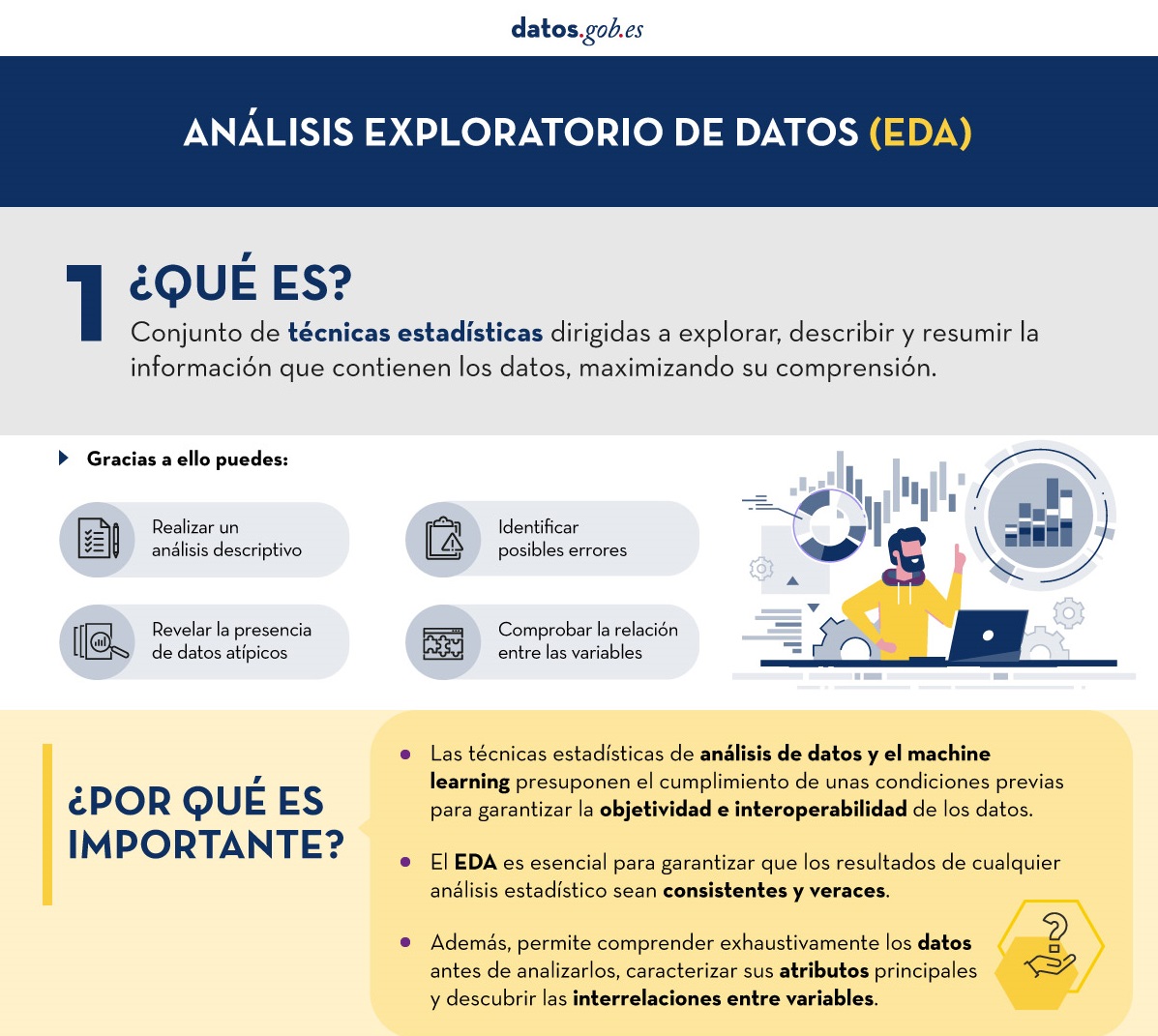

El Análisis Exploratorio de Datos (AED o EDA, por sus siglas en inglés) representa un paso crítico previo a cualquier análisis estadístico, ya que permite:

- Comprender exhaustivamente los datos antes de analizarlos.

- Verificar el cumplimiento de los requisitos estadísticos que garantizarán la validez de los análisis posteriores.

Para ejemplificar su importancia, tomemos el caso de la detección y tratamiento de valores atípicos, una de las tareas a realizar en un AED. Esta fase tiene un impacto significativo en estadísticos fundamentales como la media, la desviación estándar o el coeficiente de variación.

Además de explicar las distintas fases de un AED, la guía las ilustra con un caso práctico. En este sentido, se mantiene como caso práctico el análisis de datos de calidad del aire de Castilla y León. A través de explicaciones que el usuario podrá replicar, se transforman los datos públicos en información valiosa mediante el uso de bibliotecas Python fundamentales como pandas, matplotlib y seaborn, junto con herramientas modernas de análisis automatizado como ydata-profiling.

¿Por qué una nueva guía en Python?

La elección de Python como lenguaje para esta nueva guía refleja su creciente relevancia en el ecosistema de la ciencia de datos. Su sintaxis intuitiva y su extenso catálogo de bibliotecas especializadas lo han convertido en una herramienta fundamental para el análisis de datos. Al mantener el mismo conjunto de datos y estructura analítica que la versión en R, se facilita la comprensión de las diferencias entre ambos lenguajes. Esto resulta especialmente valioso en entornos donde coexisten múltiples tecnologías. Este enfoque es particularmente relevante en el contexto actual, donde numerosas organizaciones están migrando sus análisis desde lenguajes/herramientas tradicionales como R, SAS o SPSS hacia Python. La guía busca facilitar estas transiciones y garantizar la continuidad en la calidad de los análisis durante el proceso de migración.

Novedades y mejoras

Se ha enriquecido el contenido con la introducción al AED automatizado y las herramientas de perfilado de datos, respondiendo así a una de las últimas tendencias en el campo. El documento profundiza en aspectos esenciales como la interpretación de datos medioambientales, ofrece un tratamiento más riguroso de los valores atípicos y presenta un análisis más detallado de las correlaciones entre variables. Además, incorpora buenas prácticas en la escritura de código.

La aplicación práctica de estos conceptos se ilustra a través del análisis de datos de calidad del aire, donde cada técnica cobra sentido en un contexto real. Por ejemplo, al analizar las correlaciones entre contaminantes, no solo se muestra cómo calcularlas, sino que se explica cómo estos patrones reflejan procesos atmosféricos reales y qué implicaciones tienen para la gestión de la calidad del aire.

Estructura y contenidos

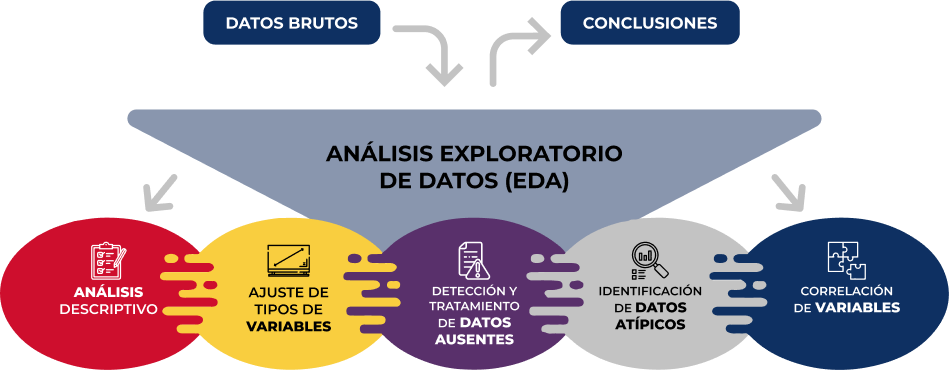

La guía sigue un enfoque práctico y sistemático, cubriendo las cinco etapas fundamentales del AED:

- Análisis descriptivo para obtener una visión representativa de los datos

- Ajuste de los tipos de variables para garantizar la consistencia

- Detección y tratamiento de datos ausentes

- Identificación y gestión de datos atípicos

- Análisis de correlación entre variables

Figura 1. Fases del análisis exploratorio de datos. Fuente: elaboración propia.

Como novedad en la estructura, se incluye una sección sobre análisis exploratorio automatizado, presentando herramientas modernas que facilitan la exploración sistemática de grandes conjuntos de datos.

¿A quién va dirigida?

Esta guía está diseñada para usuarios de datos abiertos que deseen realizar análisis exploratorios y reutilizar las valiosas fuentes de información pública que se encuentran en este y otros portales de datos a nivel mundial. Si bien es recomendable tener conocimientos básicos del lenguaje, la guía incluye recursos y referencias para mejorar las competencias en Python, así como ejemplos prácticos detallados que facilitan el aprendizaje autodidacta.

El material completo, que incluye tanto la documentación como el código fuente, se encuentra disponible en el repositorio de GitHub del portal. La implementación se ha realizado utilizando herramientas de código abierto como Jupyter Notebook en Google Colab, lo que permite reproducir los ejemplos y adaptar el código según las necesidades específicas de cada proyecto.

Se invita a la comunidad a explorar esta nueva guía, experimentar con los ejemplos proporcionados y aprovechar estos recursos para desarrollar sus propios análisis de datos abiertos.

Haz click para ver la infografía completa, en versión accesible

Figura 2. Captura de la infografía. Fuente: elaboración propia.

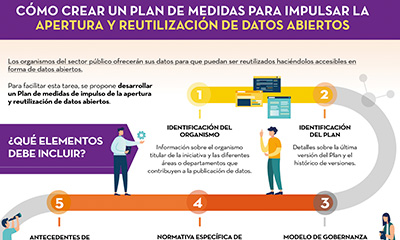

Los organismos del sector público deben ofrecer sus datos para que puedan ser reutilizados, haciéndolos accesibles en forma de datos abiertos, tal y como refiere el marco legislativo de España. El primer paso para ello es que cada entidad, tanto a nivel local, como autonómico y estatal, así como los organismos, entidades y sociedades mercantiles pertenecientes al sector público institucional, establezca una unidad responsable de garantizar la puesta a disposición de su información. Esta unidad estará encargada de promover que la información esté actualizada y sea provista en los formatos abiertos adecuados. También deberá coordinar las actividades de reutilización de la información, así como la promoción, concienciación y formación en materia de datos abiertos, entre otras funciones.

Una vez que se ha determinado quiénes son los responsables de garantizar la apertura de datos, es el momento de poner en marcha un plan de medidas de impulso de la apertura y reutilización de datos abiertos, de tal forma que todas las acciones a desarrollar se lleven a cabo de manera ordenada, coordinada y sujeta a una agenda viable de apertura.

Con el fin de ayudar a las unidades responsables en esta tarea, desde datos.gob.es se ha elaborado una plantilla para la formulación del Plan. El objetivo es orientar sobre los diferentes elementos que debe contener dicho plan con el fin de trazar una hoja de ruta factible de apertura de datos, así como permitir su seguimiento y evaluación.

La siguiente infografía recoge las categorías incluidas en la plantilla, junto con una breve definición (Haz clic en la imagen para acceder a la infografía).

A la hora de elaborar el plan, es importante que cada una de estas categorías se cumplimente con el máximo detalle posible. A continuación, puedes descargar el documento con la plantilla, donde se detallan todos estos elementos.

También se ha elaborado un documento con orientaciones sobre cuestiones importantes para el desarrollo de la iniciativa de datos abiertos y que es conveniente tener en cuenta en el momento de definir el plan de medidas de impulso de la apertura y reutilización de datos abiertos. Entre ellas se incluyen indicaciones sobre:

- La gobernanza de datos

- El marco normativo de los datos abiertos

- Las condiciones de reutilización más habituales

- Los datos de alto valor

- Los metadatos a considerar

- Los indicadores de medición para la evaluación y seguimiento de una iniciativa de datos abiertos

Haz clic en el botón que acompaña a cada documento para su descarga.

Antes de realizar un análisis de datos, con fines estadístico o predictivos por ejemplo a través de técnicas de machine learning, es necesario comprender la materia prima con la que vamos a trabajar. Hay que entender y evaluar la calidad de los datos para así, entre otros aspectos, detectar y tratar los datos atípicos o incorrectos, evitando posibles errores que pudieran repercutir en los resultados del análisis.

Una forma de llevar a cabo este pre-procesamiento es mediante un análisis exploratorio de datos (AED) o exploratory data analysis (EDA).

¿Qué es el análisis exploratorio de los datos?

El AED consiste en aplicar un conjunto de técnicas estadísticas dirigidas a explorar, describir y resumir la naturaleza de los datos, de tal forma que podamos garantizar su objetividad e interoperabilidad.

Gracias a ello se pueden identificar posibles errores, revelar la presencia de valores atípicos, comprobar la relación entre variables (correlaciones) y su posible redundancia, así como realizar un análisis descriptivo de los datos mediante representaciones gráficas y resúmenes de los aspectos más significativos.

En muchas ocasiones, esta exploración de los datos se descuida y no se lleva a cabo de manera correcta. Por este motivo, desde datos.gob.es hemos elaborado una guía introductoria que recoge una serie de tareas mínimas para realizar un correcto análisis exploratorios de datos, paso previo y necesario antes de llevar a cabo cualquier tipo de análisis estadístico o predictivo ligado a las técnicas de machine learning.

¿Qué incluye la guía?

La guía explica de forma sencilla cuáles son los pasos a seguir para garantizar unos datos consistentes y veraces. Para su elaboración se ha tomado como referencia el análisis exploratorio de datos descrito en el libro R for Data Science de Wickman y Grolemund (2017) disponible de forma gratuita. Estos pasos son:

Figura 1. Fases del análisis exploratorio de datos. Fuente: elaboración propia.

En la guía se explica cada uno de estos pasos y por qué son necesarios. Asimismo, se ilustran de manera práctica a través de un ejemplo. Para dicho caso práctico, se ha utilizado el dataset relativo al registro de la calidad del aire en la Comunidad Autónoma de Castilla y León incluido en nuestro catálogo de datos abiertos. El tratamiento se ha llevado a cabo con herramientas tecnológicas open source y gratuitas. En la guía se recoge el código para que los usuarios pueden replicarlo de forma autodidacta siguiendo los pasos indicados.

La guía finaliza con un apartado de recursos adicionales para aquellos que quieran seguir profundizando en la materia.

¿A quién va dirigida?

El público objetivo de la guía es el usuario reutilizador de datos abiertos. Es decir, desarrolladores, emprendedores o incluso periodistas de datos que quieran extraer todo el valor posible de la información con la que trabajan para obtener unos resultados fiables.

Es aconsejable que el usuario tenga nociones básicas del lenguaje de programación R, elegido para ilustrar los ejemplos. No obstante, en el apartado de bibliografía se incluyen recursos para adquirir mayores habilidades en este campo.

A continuación, en el apartado documentación, puedes descargarte la guía, así como una infografía-resumen que ilustra los principales pasos del análisis exploratorios de datos. También tienes disponible el código fuente del ejemplo práctico en nuestro Github.

Haz click para ver la infografía completa, en versión accesible

Figura 2. Captura de la infografía. Fuente: elaboración propia.

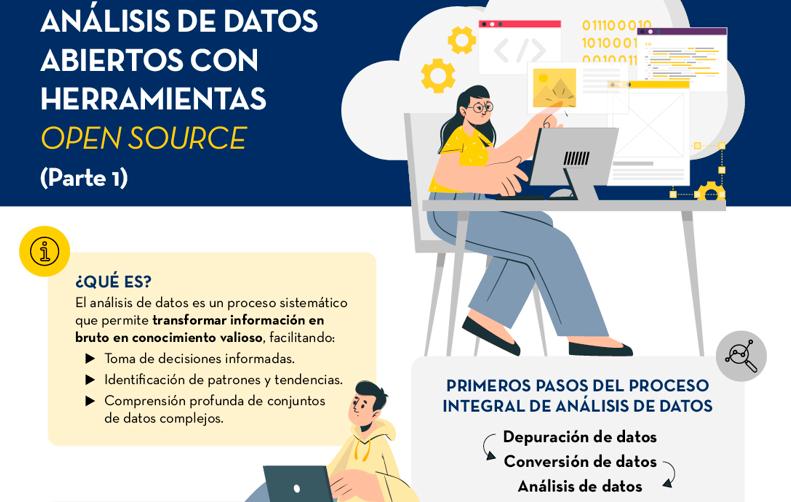

Infografía - Análisis de datos abiertos con herramientas open source PARTE I

Infografía - Visualización de datos abiertos con herramientas open source PARTE II

Ver infografía completa

Vivimos en un entorno en constante evolución en el que los datos crecen de manera exponencial y son, además, un componente fundamental de la economía digital. En este contexto, es necesario desbloquear su potencial para maximizar su valor mediante la creación de oportunidades para su reutilización. Sin embargo, es importante tener en cuenta que ese incremento en velocidad, escala y variedad de los datos supone que asegurar su calidad sea más complicado.

En este escenario surge la necesidad de establecer procesos comunes aplicables a los activos de datos de toda organización a lo largo de su ciclo de vida. Todo tipo de instituciones deben disponer de datos bien gobernados, gestionados y con niveles adecuados de calidad, siendo necesaria una metodología de evaluación común que pueda ayudar a una mejora continua de dichos procesos y permita evaluar la madurez de una organización de forma estandarizada.

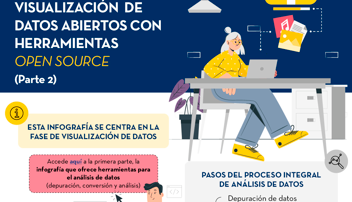

La Oficina del Dato ha patrocinado, promovido y participado en la generación de las especificaciones UNE, unos recursos normativos que permiten implantar procesos comunes en la gestión del dato y que además proporcionan un marco de referencia para establecer una cultura de datos organizacional.

Por una parte, encontramos las especificaciones UNE 0077:2023 Gobierno del dato, UNE 0078:2023 Gestión del dato y UNE 0079:2023 Gestión de la calidad del dato, que están concebidas para ser aplicadas de forma conjunta, habilitando un marco de referencia sólido que fomente la adopción de prácticas sostenibles y efectivas alrededor del dato.

Además, es necesaria una metodología de evaluación común que permita una mejora continua de los procesos de gobierno, gestión y gestión de la calidad del dato, así como la medición de la madurez de las organizaciones de forma estandarizada. Para el desarrollo de un marco homogéneo de evaluación del tratamiento que una organización hace de los datos se ha desarrollado la especificación UNE 0080.

Con el objetivo de ofrecer un proceso basado en estándares internacionales que ayude a las organizaciones a utilizar un modelo de calidad y a definir características y métricas de calidad adecuadas, se ha generado la especificación UNE 0081 Evaluación de la calidad del dato que complementa la UNE 0079 Gestión de la calidad del dato.

La siguiente infografía resumen cuáles son las claves de las Especificaciones UNE sobre el dato y las principales ventajas de su aplicación (haz clic en la imagen para acceder a la infografía).

También está disponible un vídeo explicativo sobre las Especificaciones UNE sobre datos

Los datos abiertos son una herramienta útil para tomar decisiones informadas que incentiven el éxito de un proceso y mejorar su eficacia. Desde una visión sectorial, los datos abiertos aportan información relevante sobre el sector legal, el educativo o el de la salud. Todos ellos, junto a otros muchos ámbitos, emplean fuentes abiertas para medir el cumplimiento de una mejora o desarrollar herramientas que faciliten el trabajo a los profesionales.

Los beneficios del uso de los datos abiertos son amplios y su variedad va de la mano de la innovación tecnológica: cada día surgen más oportunidades para emplear datos abiertos en el desarrollo de soluciones innovadoras. Ejemplo de ello puede ser el desarrollo urbanístico alineado con los valores de sostenibilidad que defiende la Organización de las Naciones Unidas (ONU).

Las ciudades ocupan el 3% de la superficie terrestre; sin embargo, emiten el 70% de las emisiones de carbono y consumen más del 60% de los recursos de todo el mundo, según la ONU. En 2023, más de la mitad de la población mundial vive en ciudades y se prevé que esta cifra siga creciendo. En 2030 se estima que más de 5.000 millones de personas vivirían en ciudades, es decir, más del 60% de la población de todo el mundo.

A pesar de la tendencia, las infraestructuras y los barrios no cumplen con las condiciones adecuadas de desarrollo sostenible y el objetivo es “Lograr que las ciudades y los asentamientos humanos sean inclusivos, seguros y sostenibles”, tal y como se reconoce en el ODS número 11. La planificación y gestión adecuada de los recursos urbanos son cuestiones de peso a la hora de crear y mantener comunidades basadas en la sostenibilidad. En este contexto, los datos abiertos juegan un importante papel para medir el cumplimiento de este ODS y así alcanzar la meta de ciudades sostenibles.

En definitiva, los datos abiertos se constituyen como una herramienta fundamental para el fortalecimiento y progreso del desarrollo sostenible de las ciudades.

En esta infografía, hemos recogido casos de uso que emplean conjuntos de datos abiertos para monitorizar y/o mejorar la eficiencia energética, el transporte y la movilidad urbana, la calidad del aire y el nivel de ruido. Cuestiones que contribuyen al buen funcionamiento de los centros urbanos.

Haz clic en la infografía para verla en tamaño real

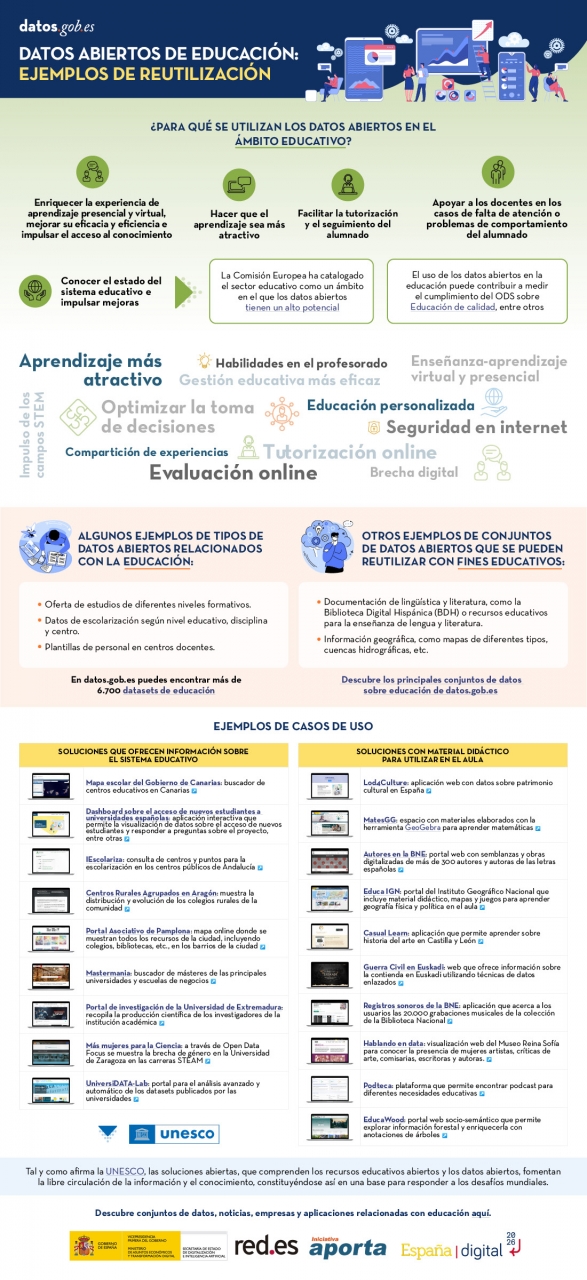

Las soluciones abiertas, que comprenden los recursos educativos abiertos (REA), el Acceso abierto a la información científica (OA, por sus siglas en inglés), el software libre y de código abierto (FOSS) y los datos abiertos, fomentan la libre circulación de la información y el conocimiento, constituyéndose así en una base para responder a los desafíos mundiales, tal y como recuerda la UNESCO.

El organismo de las Naciones Unidas para la Educación, la Ciencia y la Cultura reconoce así el valor de los datos abiertos en el ámbito educativo y considera que su uso puede contribuir a medir el cumplimiento de los Objetivos de Desarrollo Sostenible, especialmente el objetivo número 4 de Educación de calidad. Otros organismos internacionales reconocen también el potencial de la apertura de datos en la educación. Por ejemplo, la Comisión Europea ha catalogado el sector educativo como un ámbito en el que los datos abiertos tienen un alto potencial.

Los datos abiertos se pueden utilizar como una herramienta para la educación y la formación de diferentes formas. Así, se pueden utilizar para desarrollar nuevos materiales didácticos y para recopilar y analizar información sobre el estado del sistema educativo que sirvan para impulsar mejoras.

La pandemia mundial marcó un hito en el ámbito educativo, cuando se hizo imprescindible el uso de las nuevas tecnologías en el proceso de enseñanza-aprendizaje que pasó a ser íntegramente virtual durante meses. Aunque desde hacía años se venía hablando de los beneficios de incorporar las TIC y las soluciones abiertas a la educación, una tendencia que se conoce como Edtech, el COVID-19 aceleró este proceso.

Los beneficios del uso de los datos abiertos en el aula

En la siguiente infografía resumimos los beneficios que supone la aplicación de los datos abiertos en el ámbito de la educación y la formación, tanto desde el punto de vista del alumno y del docente, como el de los gestores del sistema educativo.

Existen multitud de conjuntos de datos que pueden utilizarse para el desarrollo de soluciones educativas. En datos.gob.es hay más de 6.700 datasets disponibles, a los que se pueden sumar otros que se utilizan con fines educativos en diferentes áreas, como literatura, geografía, historia, etc.

Son mucha las soluciones desarrolladas con datos abiertos que se utilizan con estos objetivos. Recopilamos algunas de ellas en función de su finalidad: en primer lugar, las soluciones que ofrecen información sobre el sistema educativo de cara a conocer su situación y planificar nuevas medidas y, en segundo lugar, las que ofrecen material didáctico para utilizar en el aula.

En definitiva, los datos abiertos se constituyen como una herramienta fundamental para el fortalecimiento y progreso de la educación y no podemos olvidar que la educación es un derecho universal y una de las principales herramientas para el progreso de la humanidad.

Haz clic en la infografía para verla a tamaño real:

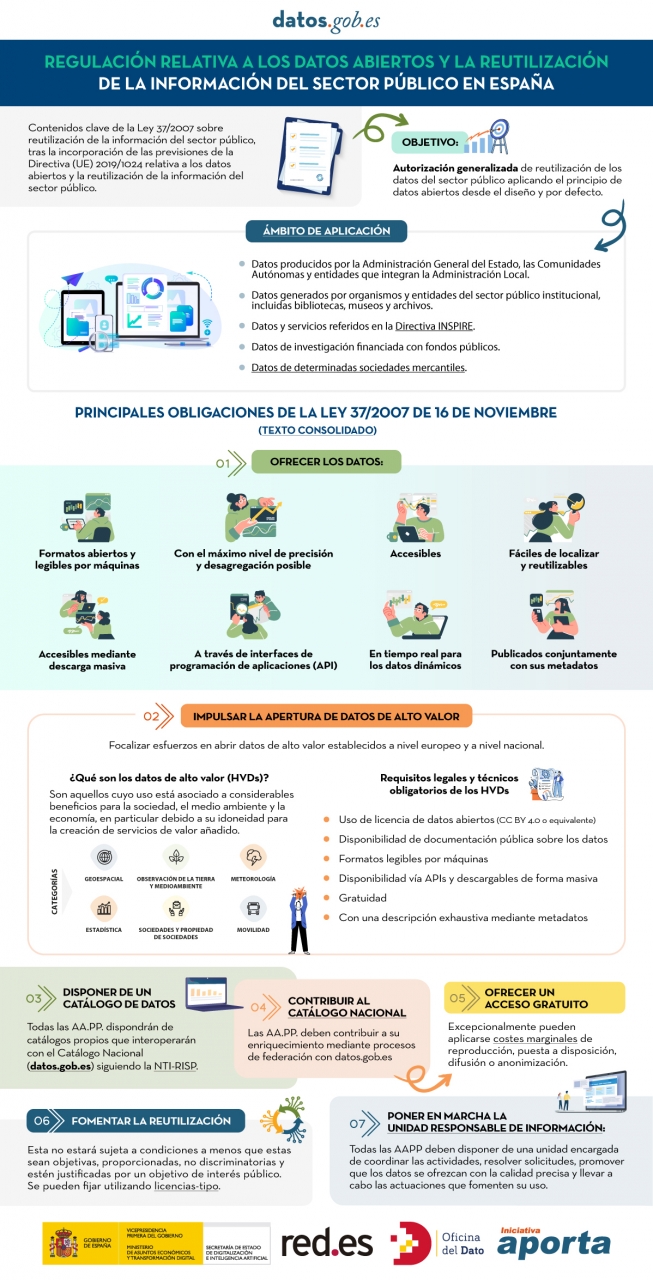

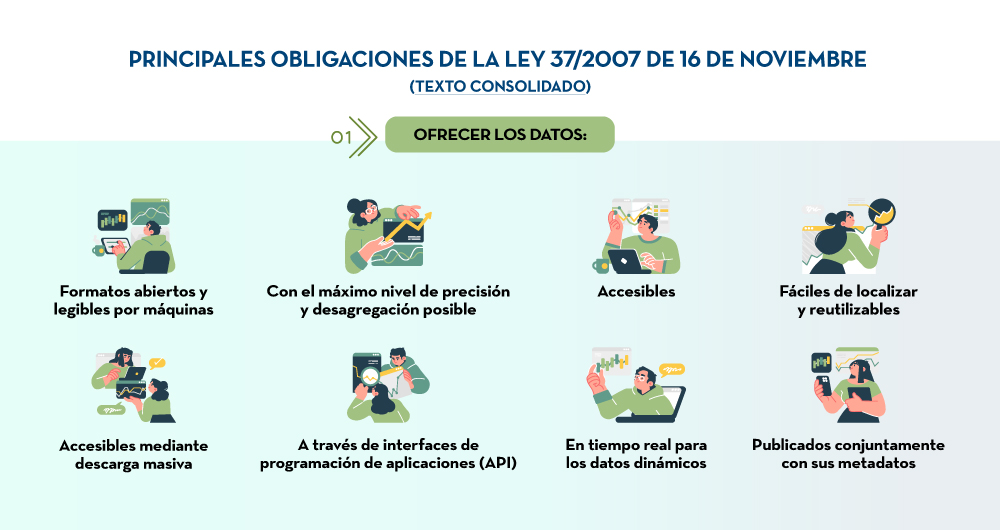

El sector público en España tendrá el deber de garantizar la apertura de sus datos desde el diseño y por defecto, así como su reutilización. Así lo recoge la modificación de la Ley 37/2007 sobre la reutilización de la información del sector público en aplicación de la Directiva Europea 2019/1024.

Esta nueva redacción de la norma busca ampliar el ámbito de aplicación de la Ley para acercar las garantías y obligaciones jurídicas al contexto tecnológico, social y económico actual. En este escenario, la normativa vigente tiene en cuenta que una mayor disponibilidad de los datos del sector público puede contribuir al desarrollo de tecnologías tan punteras como la inteligencia artificial y todas sus aplicaciones.

Además, esta iniciativa está alineada con la Estrategia de datos de la Unión Europea dirigida a la creación de un mercado único de datos en el que la información fluya libremente entre los estados y el sector privado en un intercambio que beneficie ambas partes.

De los datos de alto valor a la unidad responsable de información: obligaciones de la Ley 37/2007

En la siguiente infografía, destacamos las principales obligaciones que recoge el texto consolidado de la ley. Se enfatiza en deberes como impulsar la apertura de datos de alto valor (HVDS, por sus siglas en inglés, High Value Datasets), es decir, conjuntos de datos con un gran potencial para generar beneficios sociales, medioambientales y económicos. Tal y como dicta la Ley, los HVDS deberán publicarse con licencia de atribución de datos abiertos (CC BY 4.0 o equivalente), en formato legible por máquinas y acompañados de metadatos que describan las características de los conjuntos de datos. Todo ello será de acceso público y gratuito con el objetivo de incentivar el desarrollo tecnológico, económico y social, especialmente de las PYMEs.

Además de la publicación de los datos de alto valor, todas las administraciones públicas tendrán la obligación de disponer de catálogos propios de datos que interoperarán con el Catálogo Nacional siguiendo la NTI-RISP, con el objetivo de contribuir a su enriquecimiento. Como ocurre con los HVDS, el acceso a los conjuntos de datos de las AA. PP. deberá ser gratuito salvo excepciones en las que se podrían aplicar costes marginales resultado del tratamiento de los datos.

Para garantizar la gobernabilidad del dato, la ley establece la necesidad de designar una unidad responsable de información para cada entidad que coordine la apertura y reutilización de los datos, y que se encargue de responder a las solicitudes y demandas ciudadanas.

En definitiva, la Ley 37/2007, ha sido modificada con el objetivo de ofrecer garantías jurídicas a las exigencias de competitividad e innovación que suscitan tecnologías como la inteligencia artificial o el internet de las cosas, así como a realidades como los espacios de datos donde los datos abiertos se presentan como una pieza clave.

Haz clic en la infografía para verla a tamaño real:

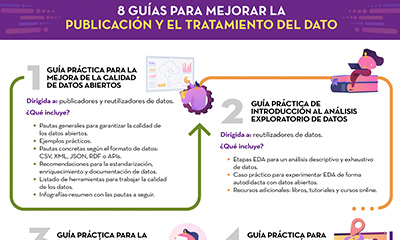

En este artículo recopilamos una serie de infografías dirigidas tanto a publicadores como reutilizadores que trabajen con datos abiertos. En ellas se muestras normas y buenas prácticas para facilitar tanto la publicación como el tratamiento de datos.

Guía técnica control de versiones de datos

|

Publicada: enero 2026 El Control de Versiones de Datos (CVD) permite registrar y documentar la evolución completa de un conjunto de datos, facilitando la colaboración, la auditoría y la recuperación de versiones anteriores. Sin un sistema claro para gestionar esos cambios es fácil perder trazabilidad. En esta infografía te contamos cómo llevar a cabo un CVD. |

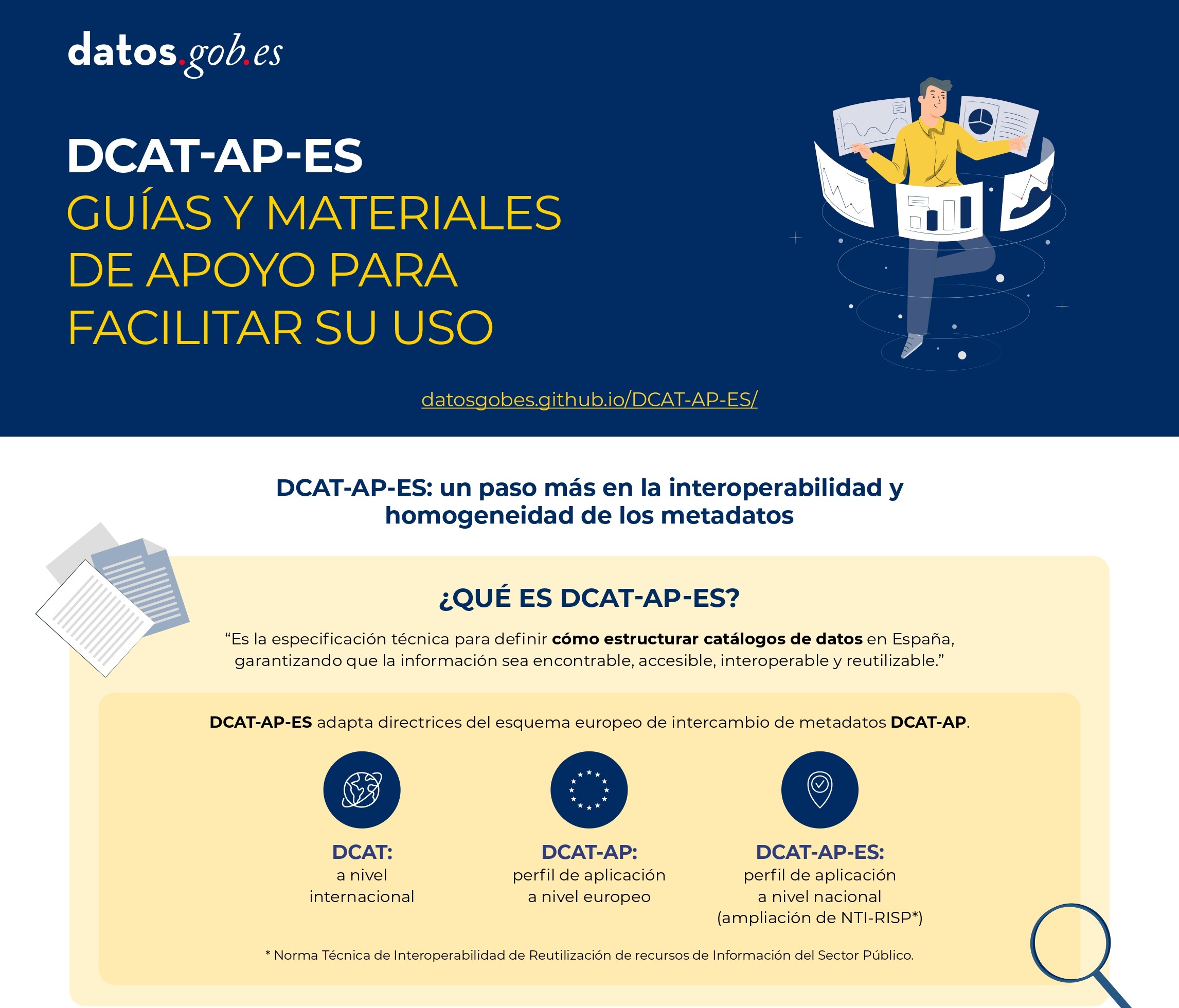

DCAT-AP-ES: Guías y materiales de apoyo para facilitar su uso

|

Publicada: agosto 2025 Este nuevo modelo de metadatos adopta las directrices del esquema europeo de intercambio de metadatos DCAT-AP (Data Catalog Vocabulary-Aplication Profile) con algunas restricciones y ajustes adicionales. |

Guía para el despliegue de portales de datos abiertos

|

Publicada: abril 2025 Esta infografía resume buenas prácticas y recomendaciones para diseñar, desarrollar y desplegar portales de datos abiertos en el ámbito municipal. En concreto recoge: marco estratégico, requisitos generales y pautas técnicas y funcionales. |

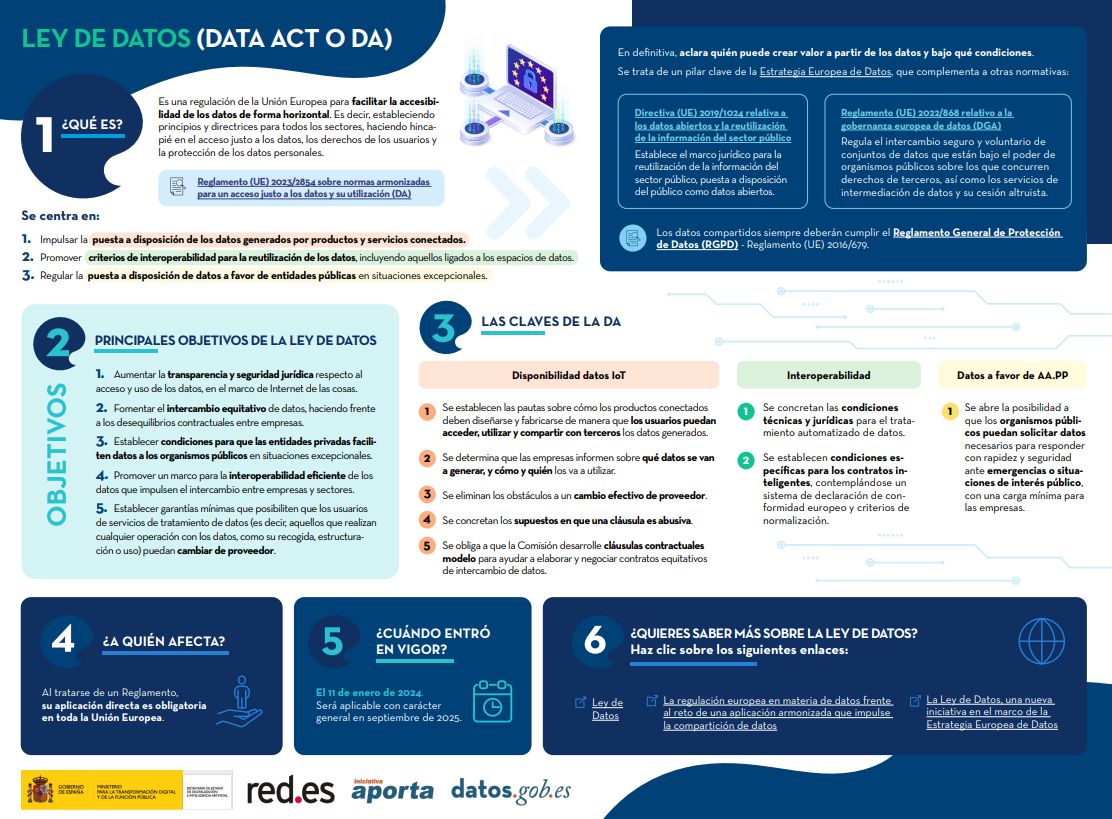

Ley de Datos (Data Act o DA)

|

Publicada: febrero 2024 La Ley de Datos (Data Act) es una regulación de la Unión Europea para facilitar la accesibilidad de los datos de forma horizontal. Es decir, estableciendo principios y directrices para todos los sectores, haciendo hincapié en el acceso justo a los datos, los derechos de los usuarios y la protección de los datos personales. Descubre cuáles son sus claves en esta infografía. También se ha creado una versión a una página para facilitar su impresión: accede aquí |

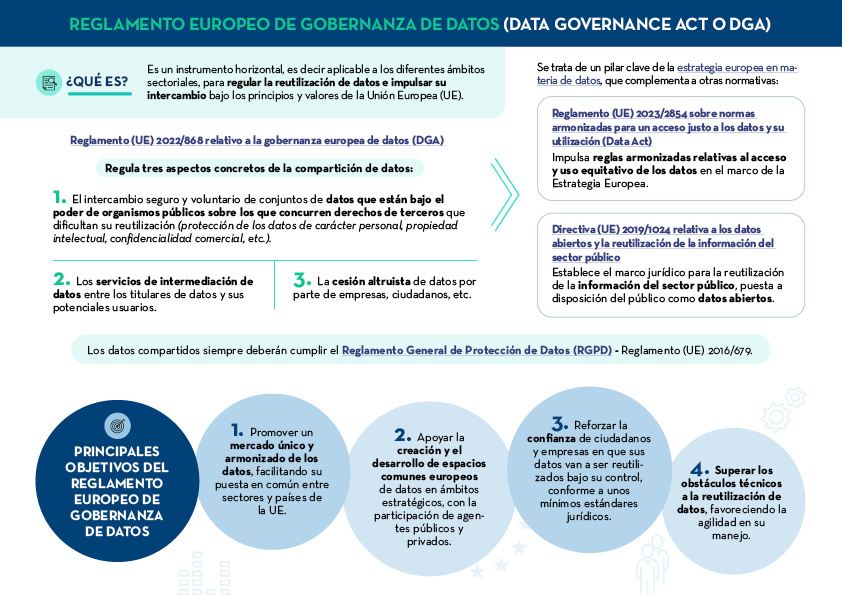

Reglamento europeo de gobernanza de datos (Data Governance Act o DGA)

|

Publicada: enero 2024 El Reglamento europeo de gobernanza de datos (Data Governance Act o DGA) es un instrumento horizontal para regular la reutilización de datos e impulsar su intercambio bajo los principios y valores de la Unión Europea (UE). Descubre cuáles son sus claves en esta infografía. También se ha creado una versión a una página para facilitar su impresión: accede aquí |

Las claves de las especificaciones UNE sobre el dato

|

Publicada: septiembre 2023 Todo tipo de instituciones deben disponer de datos bien gobernados, gestionados y con niveles adecuados de calidad, siendo necesaria una metodología de evaluación común. La siguiente infografía resumen cuáles son las claves de las Especificaciones UNE sobre el dato y sus principales ventajas. |

Principales obligaciones de la Ley 37/2007

|

Publicada: marzo 2023 En aplicación de la última Directiva europea de datos abiertos, se ha modificado la Ley 37/2007 para que incida en el concepto de los datos abiertos desde el diseño y por defecto. Esta infografía destaca los principales cambios de la normativa. |

Cómo crear un plan de medidas para impulsar la apertura y reutilización de datos abiertos

|

Publicada: noviembre 2022 Esta infografía recoge los diferentes elementos que debe contener un Plan de medidas de impulso de la apertura y reutilización de datos abiertos. El objetivo es que las unidades responsables de la apertura puedan trazar una hoja de ruta factible de apertura de datos, que además permita su seguimiento y evaluación. |

8 guías para mejorar la publicación y el tratamiento del dato

|

Publicada: octubre 2022 Desde datos.gob.es hemos elaborado diferentes guías para ayudar a publicadores y reutilizadores a la hora de preparar los datos datos para su publicación y/o análisis. En esta infografía te resumimos el contenido de ocho de ellas. |

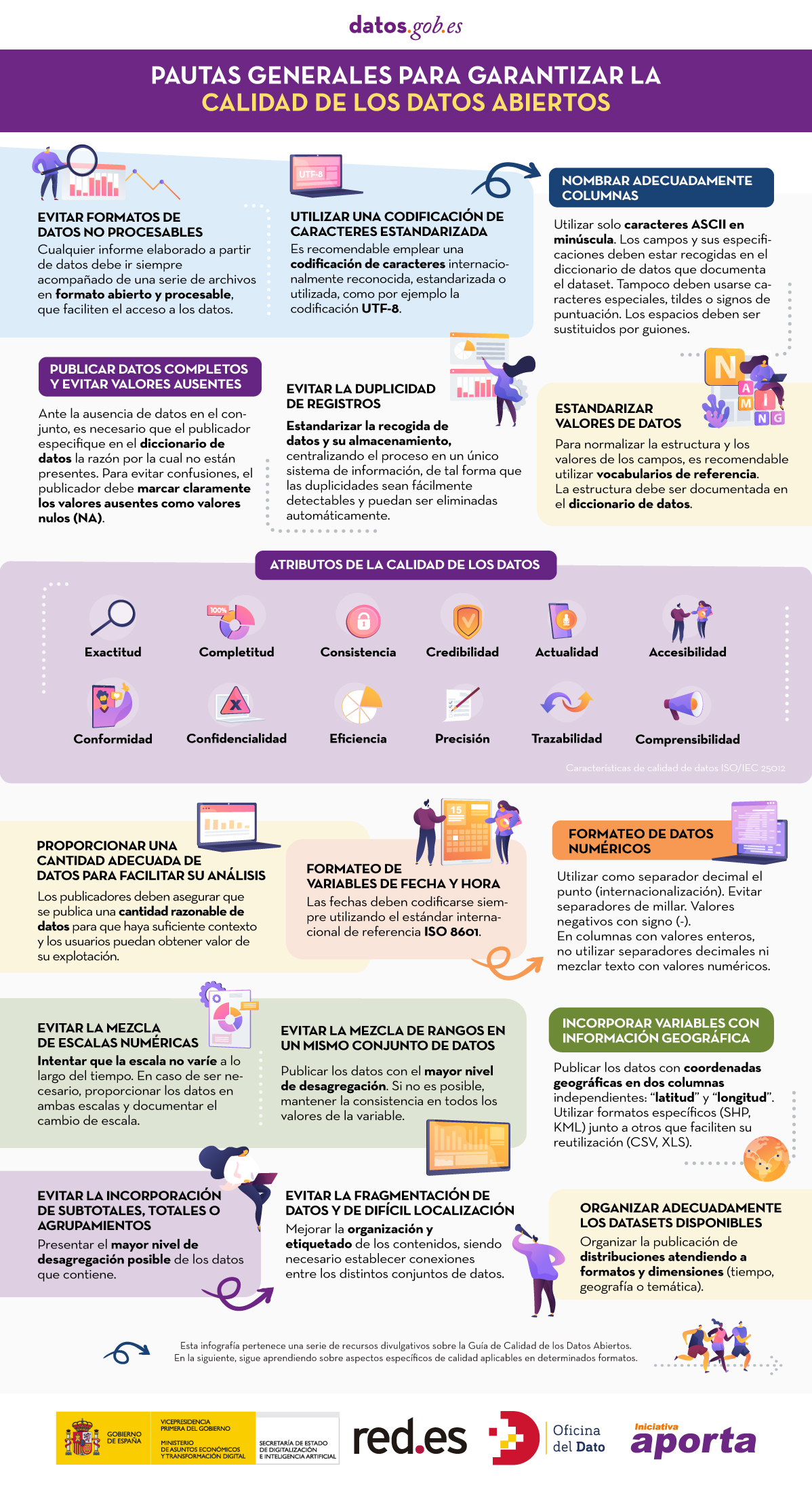

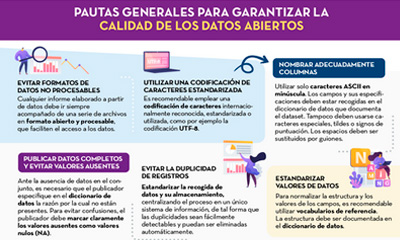

Pautas generales para garantizar la calidad de los datos abiertos

|

Publicada: septiembre 2022 Esta infografía detalla una serie pautas generales para garantizar la calidad de los datos abiertos, como, por ejemplo, utilizar una codificación de caracteres estandarizada, evitar la duplicidad de registros o incorporar variables con información geográfica. |

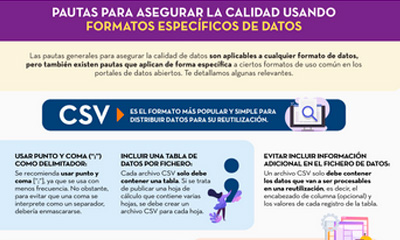

Pautas para asegurar la calidad usando formatos específicos de datos

|

Publicada: septiembre 2022 Esta infografía recoge pautas concretas para asegurar la calidad de los datos abiertos según el formato de datos utilizado. Se han incluido pautas específicas para los formatos CSV, XML, JSON, RDF y APIs. |

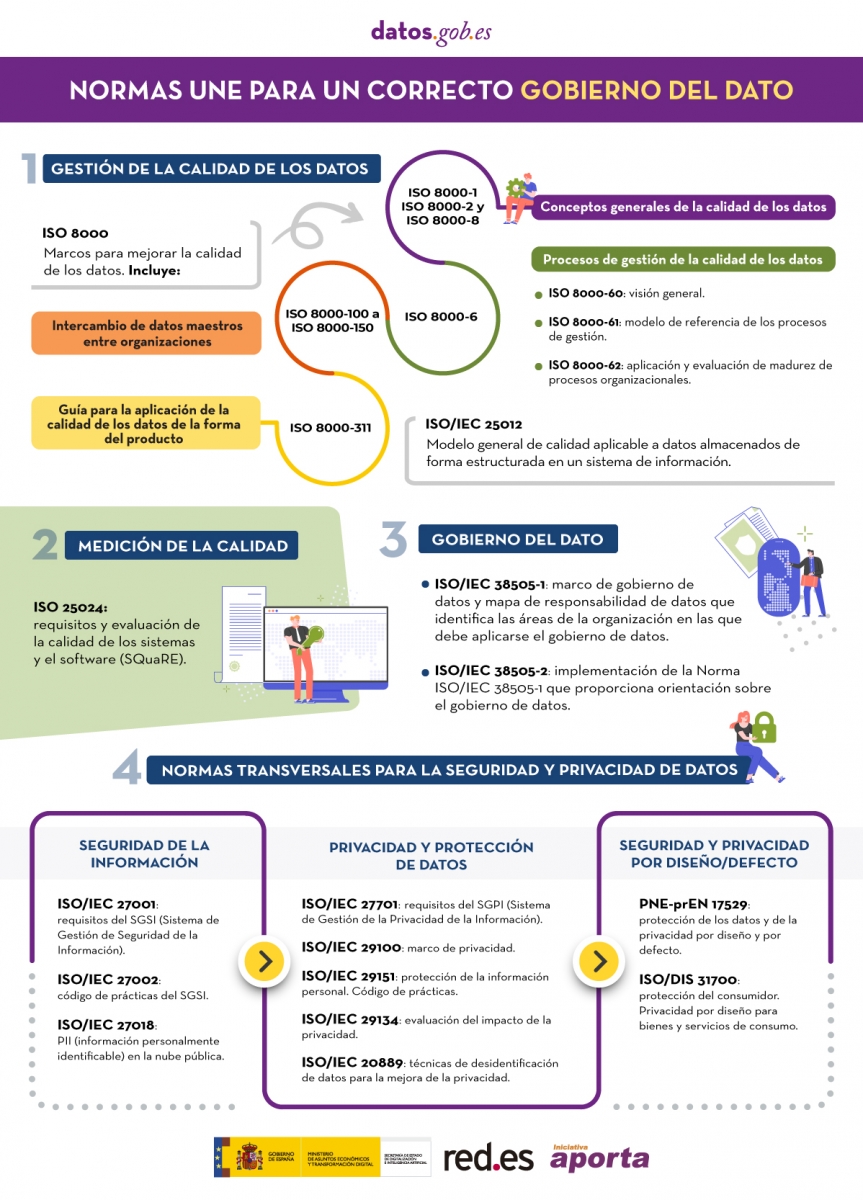

Normas para un correcto gobierno del dato

|

Publicada: mayo 2022 Esta infografía recoge la normas a tener en cuenta para un correcto gobierno del dato, según la Asociación Española de Normalización (UNE) . Estas normas se basan en 4 principios: Gobernanza, Gestión, Calidad y Seguridad y privacidad de datos. |

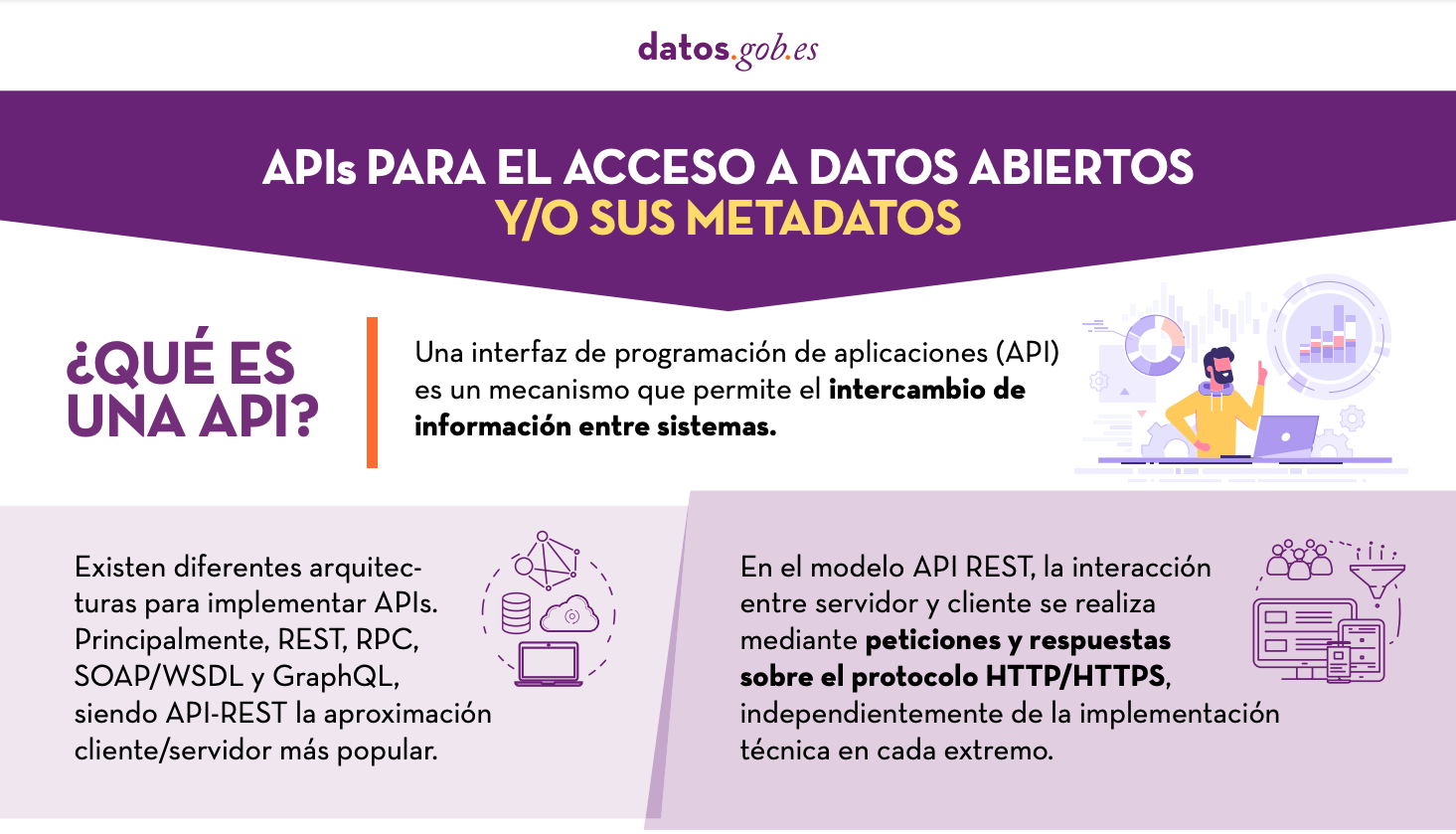

APIs para el acceso a datos abiertos

|

Publicada: enero 2022 Muchos portales de datos abiertos en España ya cuentan con sus propias APIs para facilitar el acceso a datos y metadatos. Esta infografía muestra algunos ejemplos a nivel nacional, autonómico y local, incluyendo información sobre la API de datos.gob.es. |

A la hora de publicar datos abiertos, es fundamental garantizar su calidad. Si los datos están bien documentados y cuentan con la calidad necesaria, será más fácil su reutilización, ya que serán menores los trabajos adicionales de depuración y procesamiento. Además, la baja calidad de los datos puede suponer un coste para los publicadores, que pueden llegar a gastar más dinero en solucionar los errores que en evitar con antelación los potenciales problemas.

Para ayudar en esta tarea, en el marco de la Iniciativa Aporta se ha elaborado la “Guía práctica para la mejora de la calidad de datos abiertos”, que proporciona un compendio de directrices para actuar sobre cada una de las características que definen la calidad, impulsando su mejora. El documento toma como referente la guía para la calidad de datos de data.europe.eu, publicada en 2021 por la Oficina de Publicaciones de la Unión Europea.

¿A quién está dirigida la guía?

La guía está dirigida a publicadores de datos abiertos, a quienes proporciona una serie de pautas claras para mejorar la calidad de sus datos.

No obstante, esta recopilación también puede orientar a los reutilizadores de datos sobre cómo afrontar las debilidades de calidad que pueden presentar los conjuntos de datos con los que trabajan.

¿Qué incluye la guía?

El documento comienza definiendo las características, según la norma ISO/IEC 25012, que deben cumplir los datos para considerarse de calidad, las cuales se recogen en la siguiente imagen.

A continuación, el grueso de la guía está enfocado en la descripción de recomendaciones y buenas prácticas para evitar los problemas más habituales que suelen surgir a la hora de publicar datos abiertos, estructuradas de la siguiente manera:

- Una primera parte donde se detallan una serie pautas generales para garantizar la calidad de los datos abiertos, como, por ejemplo, utilizar una codificación de caracteres estandarizada, evitar la duplicidad de registros o incorporar variables con información geográfica. Para cada pauta se proporciona una descripción detallada del problema, las características de calidad afectadas y las recomendaciones para su resolución, junto a ejemplos prácticos que facilitan su comprensión.

- Una segunda parte con pautas concretas para asegurar la calidad de los datos abiertos según el formato de datos utilizado. Se han incluido pautas específicas para los formatos CSV, XML, JSON, RDF y APIs.

- Por último, la guía también incluye recomendaciones para la estandarización y enriquecimiento de datos, así como para su documentación, y un listado de herramientas útiles para trabajar la calidad de los datos.

Puedes descargar la guía aquí o al final de la página.

Materiales adicionales

La guía va acompañada de una serie de infografías que recopilan las pautas antes indicadas:

El dato es un pilar clave de la transformación digital. Los datos confiables y de calidad son la base de todo, desde las principales decisiones estratégicas hasta el proceso operativo de rutina, son fundamentales en el desarrollo de los espacios de datos, así como la base de soluciones disruptivas ligadas a ámbitos tales como la inteligencia artificial o el Big Data.

En este sentido, la correcta gestión y gobierno de los datos se ha convertido en una actividad estratégica para todo tipo de organizaciones, públicas y privadas.

La normalización del gobierno del dato se basa en 4 principios:

- Gobernanza

- Gestión

- Calidad

- Seguridad y privacidad de datos

Aquellas organizaciones que quieran implementar un marco de gobierno sólido basado en estos pilares tienen a su disposición una serie de normas técnicas que proveen de principios guiadores para garantizar que los datos de una organización son correctamente gestionados y gobernados, tanto internamente como por contrataciones externas.

Con el objetivo de intentar aclarar las dudas en esta materia, la Asociación Española de Normalización (UNE), ha publicado varios materiales de apoyo.

El primero es un artículo sobre las distintas normas técnicas a considerar a la hora de desarrollar un gobierno del dato efectivo. Las normas recogidas en dicho artículo, junto a alguna adicional, se resumen en la siguiente infografía:

(Puedes descargar la versión accesible en word aquí)

Además, la UNE también ha publicado el informe “Estándares para la economía del dato”, que se puede descargar al final de este artículo. El informe comienza con una introducción donde se profundiza en el contexto legislativo europeo que está impulsando la Economía del dato y el reconocimiento que en él se hace de la normalización técnica como una herramienta clave a la hora de alcanzar los objetivos fijados. A continuación, se analizan de manera más detallada las normas técnicas incluidas en la infografía anterior.