La construcción del ecosistema de uso secundario de los datos de salud electrónica en el Espacio Europeo de Datos de Salud (EEDS) plantea un escenario significativo de oportunidades para la investigación española, para la innovación y el emprendimiento. Para ello, la Unión Europea está impulsando multitud de proyectos estratégicos en los que participan hospitales, fundaciones de investigación sanitaria, universidades, centros de investigación y empresas españolas. La lista de proyectos es extensa y atiende a satisfacer al menos dos objetivos: potenciar la generación de infraestructuras capaces de generar conjuntos de datos de calidad y promover condiciones para su reutilización.

El papel de España. Fortalezas en el despliegue del Espacio Europeo de Salud

España ofrece condiciones significativamente favorables no sólo para participar sino también para contribuir significativamente a las tareas de creación del EEDS:

- En primer lugar, nuestro sistema público de salud se caracteriza por un alto nivel de integración y estructuración. A diferencia de los sistemas basados en mecanismos de reembolso, en los que puede existir una atomización en el ámbito de la provisión de servicios, en nuestro sistema disponemos de un marco de referencia clara en atención primaria, especialidades médicas y servicios hospitalarios.

- Por otra parte, la experiencia desplegada por nuestros entornos de salud a partir del Reglamento General de Protección de Datos (RGPD) y, particularmente, las lecciones aprendidas a partir de la disposición adicional decimoséptima sobre tratamientos de datos de salud de la Ley Orgánica 3/2018, de 5 de diciembre, de Protección de Datos Personales y garantía de los derechos digitales (LOPDGDD) constituyen una experiencia valiosa.

- La apertura del Espacio Nacional de Datos de Salud promovido por el Gobierno de España e impulsado por el Ministerio para la Transformación Digital y de la Función Pública, el Ministerio de Sanidad y las Comunidades Autónomas permite el despliegue de una infraestructura esencial para el EEDS.

El Espacio Nacional de Datos de Salud se presentó el pasado 29 de enero. En el evento se resaltó cómo este proyecto representa un cambio de paradigma que revoluciona la gestión del dato sanitario, impulsando un modelo federado, seguro y ético que preserva la soberanía y privacidad de la información mientras facilita su uso para investigación, innovación y políticas públicas. Su funcionamiento se basa en un catálogo federado de metadatos y un riguroso proceso de acceso y análisis en entornos seguros, que busca potenciar la ciencia abierta y los avances científicos y tecnológicos, beneficiando a pacientes, investigadores, gestores e industria.

Lecciones aprendidas desde los Proyectos Europeos

El camino que arranca el Reglamento (UE) 2025/327 del Parlamento Europeo y del Consejo, de 11 de febrero de 2025, relativo al Espacio Europeo de Datos de Salud, y por el que se modifican la Directiva 2011/24/UE y el Reglamento (UE) 2024/2847 (EEDSR) plantea retos significativos que se abordan en los proyectos de investigación financiados con fondos europeos y nacionales. Las lecciones aprendidas en algunos de ellos pueden ser de extraordinaria utilidad para la comunidad investigadora y de emprendimiento en nuestro país. No podemos olvidar que partimos de fortalezas significativas.

1.-Cumplimiento desde el diseño

La existencia de una nueva normativa obliga a desplegar un análisis riguroso del estado del arte en nuestras organizaciones, no sólo para implementar su despliegue sino también para asegurar las condiciones previas de confiabilidad legal de los conjuntos de datos y de la investigación que se proponga.

2.-Accountability: responsabilidad proactiva y solidez documental

En nuestro país venimos de una larga tradición de “accountability”. El EEDSR va a imponer al solicitante de datos un conjunto de requisitos documentales relevantes, como, por ejemplo, haber previsto las garantías para prevenir cualquier uso indebido de los datos de salud electrónicos. Esta cuestión tampoco podrá descuidarse desde el punto de vista de los tenedores de datos, quienes también tendrán que cumplir algunos requisitos. Por ejemplo, demostrar que los datos son legítimos y reutilizables es una cuestión ética y jurídicamente documentable; y el procedimiento simplificado para el acceso a los datos de salud electrónicos a través de un tenedor fiable de datos de salud obliga a este a documentar la seguridad de su espacio de datos o las capacidades para evaluar las solicitudes de acceso a datos de salud.

Uno de los principales escollos a los que nos enfrentamos en este periodo intermedio de implantación del EEDS reside precisamente en la cultura organizativa para la generación de evidencias verificables. A medida que la estandarización y el conjunto de reglas comunes del EEDS escalen será necesario profundizar en la dinámica de la responsabilidad proactiva entendida como responsabilidad demostrada.

3. Entornos seguros de procesamiento

En nuestro país, los entornos de salud por su propia definición deben ser entornos seguros. El despliegue del Esquema Nacional de Seguridad (ENS) y el del RGPD, han permitido que la totalidad del sistema de salud, público o privado, haya adoptado modelos de madurez perfectamente coherentes con las condiciones de los entornos de procesamiento seguro que define el EEDSR.

Retos del sistema español

Junto a las fortalezas inherentes a nuestro sistema, es necesario considerar aquellos aspectos que se presentan como retos.

1. Anonimización y seudonimización

En el contexto nacional la citada disposición adicional decimoséptima de la Ley Orgánica 3/2018, de 5 de diciembre, de Protección de Datos Personales y garantía de los derechos digitales, define condiciones específicas para la seudonimización. Estas consisten en la separación funcional entre los equipos que seudonimizan y los que reutilizan los datos, y en la definición de un entorno seguro que prevenga cualquier intento de reidentificación. A ello se suman garantías jurídicas en términos de compromisos individuales de no reidentificación, despliegue de la herramienta de la evaluación de impacto relativa a la protección de datos y supervisión por comités de ética. El reto de la anonimización se muestra más exigente, ya que implica la imposibilidad de vincular bajo ninguna condición los datos de salud con los del paciente original.

2. Reeskilling de los equipos

El Espacio Europeo de Datos de Salud (EEDS) planteará un desafío formativo sin precedentes que atravesará todos los sectores implicados en el ecosistema de datos sanitarios. Los comités de ética de investigación deberán familiarizarse no solo con los usos secundarios admisibles de los datos de salud, sino también con la integración del Reglamento de Inteligencia Artificial y con los principios éticos del marco ALTAI (Assessment List for Trustworthy Artificial Intelligence). Esta necesidad de reeskilling se extenderá igualmente a los sistemas de salud y la administración sanitaria, donde los organismos de acceso a datos (Health Data Access Bodies) requerirán personal altamente cualificado en estos nuevos marcos éticos y regulatorios, al igual que los tenedores fiables de datos que custodiarán la información sensible. El personal de desarrollo y los equipos de tecnologías de la información también deberán adquirir nuevas competencias en ámbitos técnicos críticos, como la catalogación, validación y curación de datos, así como en los estándares de interoperabilidad que permitan la comunicación efectiva entre sistemas. Quizás el reto de capacitación más delicado recaerá sobre los nuevos operadores, que podrán aprovechar las oportunidades de acceso a conjuntos de datos para usos secundarios innovadores. Esto concierne especialmente a las startups tecnológicas del sector salud. Para enfrentar un marco normativo muy exigente, (RGPD, Regalmento de IA, EEDSR), los recursos y capacidades para el cumplimiento legal (compliance) en las pymes españolas es notablemente limitado. Por ello será necesario construir desde el inicio una cultura sólida de protección de datos y desarrollo ético de sistemas de inteligencia artificial confiables.

3. Catalogación de datos: el desafío de la calidad y la estandarización

En el contexto del Espacio Europeo de Datos de Salud, profundizar en la estandarización de los datos mediante las metodologías más funcionales —como OMOP CDM para datos clínicos observacionales, HL7 FHIR para el intercambio dinámico de información, DICOM para imágenes médicas, o terminologías de referencia como SNOMED CT, LOINC y RxNorm— se presenta como un elemento estratégico fundamental para la creación y reutilización de conjuntos de datos de alta calidad. Sin embargo, la adopción de estos estándares no es suficiente por sí sola: los procesos de validación, anotación semántica y enriquecimiento de datos requieren de recursos humanos altamente cualificados capaces de garantizar la coherencia, completitud y precisión de la información, convirtiéndose esta capacitación en una auténtica precondición para la participación efectiva en el ecosistema europeo de datos de salud. El alineamiento con la catalogación estandarizada de conjuntos de datos siguiendo el estándar HealthDCAT-AP (Health Data Catalog Application Profile), que permite describir de manera homogénea los metadatos descriptivos de los recursos de datos sanitarios, se presenta como uno de los retos inmediatos, junto con la implementación de los trabajos que se vienen desplegando en relación con el data utility quality label, una etiqueta de calidad que evalúa la utilidad real de los datos para usos secundarios y que se está convirtiendo en un sello de confianza para usuarios e investigadores.

Si anteriormente en este artículo se subrayaron las altísimas capacidades del sistema sanitario español para generar datos de salud de manera sistemática y en volúmenes significativos, estos aspectos de catalogación, estandarización y certificación de calidad ocuparán un lugar absolutamente central para diseñar condiciones óptimas de competitividad europea en su reutilización, transformando la abundancia de datos en una verdadera ventaja estratégica que permita a España posicionarse como un actor relevante en el panorama de la investigación y la innovación con datos de salud electrónicos.

La experiencia del proyecto EUCAIM (Cancer Image EU)

El Reglamento del Espacio Europeo de Datos de Salud tiene por objeto permitir el uso secundario de los datos sanitarios electrónicos en toda Europa mediante normas armonizadas en un ecosistema federado. En el ámbito del cáncer, el acceso fragmentado a conjuntos de datos de alta calidad ralentiza la investigación, limita la reproducibilidad y socava la capacidad de Europa para desarrollar y validar herramientas de IA fiables para la oncología.

EUCAIM demuestra la viabilidad de un ecosistema para el uso secundario del cáncer a través de un modelo federado que permite el acceso transfronterizo bajo normas armonizadas garantizando un control adecuado de los recursos a nivel local. Y ello se despliega mediante un conjunto de componentes habilitadores:

1) Un entorno de procesamiento seguro (SPE) federado a nivel europeo

EUCAIM está creando un SPE federado para hacer cumplir las condiciones de acceso a los datos, controlar el procesamiento y apoyar el análisis transfronterizo seguro bajo las restricciones del EEDS. Este SPE se ajusta plenamente a los requisitos y medidas que establece el artículo 73 EEDSR en materia de entornos seguros.

2) Superación de la «barrera de la anonimización»

EUCAIM promueve una estrategia de anonimización por capas que combina procesos de anonimización local autónoma por el tenedor de datos con controles de la plataforma para permitir que los conjuntos de datos sigan siendo útiles para la investigación y el desarrollo de la IA. La importancia de este enfoque radica en que pretende conciliar la protección de la privacidad con la necesidad práctica de disponer de conjuntos con grandes volúmenes de datos caracterizados por su diversidad.

3) Catalogación y estandarización de datos

EUCAIM alinea la catalogación con los principios HealthDCAT-AP cuyo objetivo principal es aplicar los principios FAIR, esto es asegurar que los datos sean encontrables, accesibles, interoperables y reutilizables.

4) Reducción de costes legales

EUCAIM ha desplegado un marco de cumplimiento propio orientado al Reglamento General de Protección de Datos y el Reglamento de Inteligencia Artificial. Para ello, se dispone de un marco sólido de cumplimiento a nivel de una plataforma que se despliega en ecosistemas complejos de datos. Este se basa en evaluaciones de impacto en la protección de datos (incluidas en el RGPD) con especial atención a los derechos fundamentales. También incorpora la formación y el reciclaje profesional de los usuarios como requisito funcional, de modo que la capacidad de cumplimiento se convierta en una característica esencial.

5) Apoyo a los usuarios de datos

EUCAIM ofrece ventajas significativas a los usuarios de datos, incluidos los investigadores y los desarrolladores de IA, al establecer un entorno transparente y bien gobernado para el acceso a los datos. La adopción de criterios de gobernanza transparentes, obligaciones claramente definidas y su aplicación técnica por la plataforma, proporcionan a los usuarios de datos la garantía de que su acceso es adecuado y lícito, totalmente auditable y se mantiene estable a lo largo del tiempo. El diseño de la plataforma garantiza que los usuarios puedan aprovechar datos de gran utilidad para análisis avanzados, incluido el procesamiento federado en un entorno seguro. A través de la formación obligatoria y la implementación de procedimientos estandarizados, los equipos se benefician de una menor incertidumbre y están mejor equipados para alinearse con los requisitos de cumplimiento establecidos por el EEDSR, el RGPD y los marcos de gobernanza de la IA.

6) Garantía de los derechos de los pacientes

El enfoque de EUCAIM se basa en la protección de datos desde el diseño y por defecto que une las salvaguardias organizativas con controles técnicos sólidos. Este marco se ha construido expresamente para minimizar el riesgo de uso indebido de los datos, al tiempo que apoya la investigación y la innovación transfronterizas seguras y eficaces en materia de cáncer. El resultado es un sistema en el que la protección de la privacidad no es un obstáculo sino un elemento fundamental que permite el uso responsable de los datos en beneficio de la sociedad y la ciencia. El modelo refuerza la responsabilidad por el uso secundario de los datos sanitarios mediante la combinación de una sólida supervisión de la gobernanza, un registro exhaustivo de las acciones y obligaciones estrictas y exigibles para todas las entidades participantes. Todas las acciones realizadas con los datos de los pacientes se registran y se someten a revisión, lo que garantiza que todos los usos sean totalmente auditables. Esta trazabilidad garantiza que el tratamiento de los datos se mantenga dentro de los límites del uso permitido y que cualquier desviación pueda identificarse y abordarse rápidamente.

Gobernanza multinivel: la clave del éxito sostenible

La lección aprendida más relevante en EUCAIM se refiere a la necesidad imperiosa de una gobernanza multinivel articulada, coherente y operativa. En sentido amplio, resulta indispensable proporcionar herramientas y marcos de gobierno efectivos sobre tres dimensiones fundamentales:

- En primer lugar, sobre los procesos de generación de conjuntos de datos y sus condiciones de compartición, estableciendo criterios claros sobre qué datos se generan, cómo se estandarizan, quién ostenta derechos sobre ellos y bajo qué licencias y restricciones pueden ser compartidos con terceros.

- En segundo lugar, sobre los procesos de solicitud de acceso a datos, definiendo procedimientos transparentes y eficientes para que investigadores, innovadores y responsables de políticas públicas puedan identificar, solicitar y obtener acceso a los datos necesarios para sus proyectos, minimizando las cargas administrativas sin comprometer las garantías éticas y legales.

- En tercer lugar, sobre los procesos de validación de la corrección de los conjuntos de datos y de adhesión al sistema, así como los procedimientos de autorización de acceso a datos, asegurando que solo datos de calidad certificada alimenten la infraestructura y que únicamente usuarios autorizados y con propósitos legítimos accedan a información sensible.

Esta gobernanza procedimental no puede funcionar sin decisiones estratégicas y operativas en relación con la definición de roles y funciones en materia de recursos humanos. Para ello, es necesario contar con perfiles profesionales necesarios como gestores de datos, expertos en ética de la investigación, especialistas en ciberseguridad, curadores de datos y responsables de calidad. En segundo lugar, será fundamental la definición de los entornos seguros de procesamiento donde se ejecutan análisis sobre datos sensibles, garantizando que estos espacios cumplan con los más altos estándares técnicos de seguridad, trazabilidad, auditoría y preservación de la privacidad, y que estén diseñados para operar bajo el principio de confianza cero (zero trust) adaptado al contexto sanitario. Solo mediante esta arquitectura de gobernanza multinivel, que integre dimensiones técnicas, organizativas, éticas y legales en todos los niveles de decisión —desde el diseño de políticas nacionales hasta la gestión operativa diaria de las plataformas—, será posible construir infraestructuras de datos de salud verdaderamente sostenibles, confiables y capaces de generar valor social, científico y económico a largo plazo, posicionando al sistema sanitario español como un actor estratégico en el ecosistema europeo de innovación en salud.

Contenido elaborado por Ricard Martínez Martínez, Director de la Cátedra de Privacidad y Transformación Digital, Departamento de Derecho Constitucional de la Universitat de València. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

¿Sabías que España creó en 2023 la primera agencia estatal dedicada específicamente a la supervisión de la inteligencia artificial (IA)? Anticipándose incluso al Reglamento Europeo en esta materia, la Agencia Española de Supervisión de Inteligencia Artificial (AESIA) nació con el objetivo de garantizar el uso ético y seguro de la IA, fomentando un desarrollo tecnológico responsable.

Entre sus principales funciones está asegurar que tanto entidades públicas como privadas cumplan con la normativa vigente. Para ello promueve buenas prácticas y asesora sobre el cumplimiento del marco regulatorio europeo, motivo por el cual recientemente ha publicado una serie de guías para asegurar la aplicación consistente de la regulación europea de IA.

En este post profundizaremos en qué es la AESIA y conoceremos detalles relevantes del contenido de las guías.

¿Qué es la AESIA y por qué es clave para el ecosistema de datos?

La AESIA nace en el marco del Eje 3 de la Estrategia Española de IA. Su creación responde a la necesidad de contar con una autoridad independiente que no solo supervise, sino que oriente el despliegue de sistemas algorítmicos en nuestra sociedad.

A diferencia de otros organismos puramente sancionadores, la AESIA está diseñada como un Think & Do Tank de inteligencia, es decir, una organización que investiga y propone soluciones. Su utilidad práctica se divide en tres vertientes:

- Seguridad jurídica: proporciona marcos claros para que las empresas, especialmente las pymes, sepan a qué atenerse al innovar.

- Referente internacional: actúa como el interlocutor español ante la Comisión Europea, asegurando que la voz de nuestro ecosistema tecnológico sea escuchada en la elaboración de estándares europeos.

- Confianza ciudadana: garantiza que los sistemas de IA utilizados en servicios públicos o áreas críticas respeten los derechos fundamentales, evitando sesgos y promoviendo la transparencia.

Desde datos.gob.es, siempre hemos defendido que el valor de los datos reside en su calidad y accesibilidad. La AESIA complementa esta visión asegurando que, una vez que los datos se transforman en modelos de IA, su uso sea responsable. Por ello, estas guías son una extensión natural de los recursos que publicamos habitualmente sobre gobernanza y apertura de datos.

Recursos para el uso de la IA: guías y checklist

La AESIA ha publicado recientemente unos materiales de apoyo a la implementación y el cumplimiento de la normativa europea de Inteligencia Artificial y sus obligaciones aplicables. Aunque no tienen carácter vinculante ni sustituyen ni desarrollan la normativa vigente, proporcionan recomendaciones prácticas alineadas con los requisitos regulatorios a la espera de que se aprueben las normas armonizadas de aplicación para todos los Estados miembros.

Son el resultado directo del piloto español de Sandbox Regulatorio de IA. Este entorno de pruebas permitió a desarrolladores y autoridades colaborar en un espacio controlado para entender cómo aplicar la normativa europea en casos de uso reales.

Es fundamental destacar que estos documentos se publican sin perjuicio de las guías técnicas que la Comisión Europea está elaborando. De hecho, España está sirviendo de "laboratorio" para Europa: las lecciones aprendidas aquí proporcionarán una base sólida al grupo de trabajo de la Comisión, asegurando una aplicación consistente de la regulación en todos los Estados miembros.

Las guías están diseñadas para ser una hoja de ruta completa, desde la concepción del sistema hasta su vigilancia una vez está en el mercado.

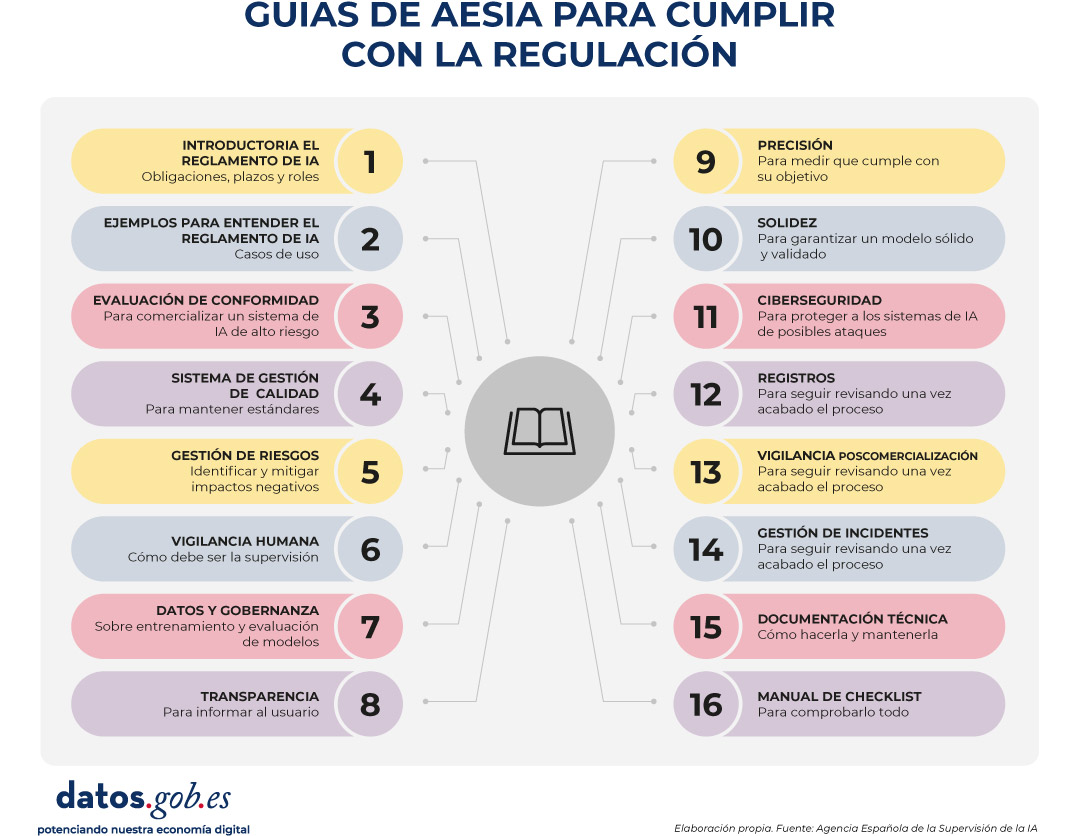

Figura 1. Guías de AESIA para cumplir con la regulación. Fuente: Agencia Española de la Supervisión de la IA

- 01. Introductoria al Reglamento de IA: ofrece una visión general sobre las obligaciones, los plazos de aplicación y los roles (proveedores, desplegadores, etc.). Es el punto de partida esencial para cualquier organización que desarrolle o despliegue sistemas de IA.

- 02. Práctica y ejemplos: aterriza los conceptos jurídicos en casos de uso cotidianos (por ejemplo, ¿es mi sistema de selección de personal una IA de alto riesgo?). Incluye árboles de decisión y un glosario de términos clave del artículo 3 del Reglamento, ayudando a determinar si un sistema específico está regulado, qué nivel de riesgo tiene y qué obligaciones son aplicables.

- 03. Evaluación de conformidad: explica los pasos técnicos necesarios para obtener el "sello" que permite comercializar un sistema de IA de alto riesgo, detallando los dos procedimientos posibles según los Anexos VI y VII del Reglamento como valuación basada en control interno o evaluación con intervención de organismo notificado.

- 04. Sistema de gestión de la calidad: define cómo las organizaciones deben estructurar sus procesos internos para mantener estándares constantes. Abarca la estrategia de cumplimiento regulatorio, técnicas y procedimientos de diseño, sistemas de examen y validación, entre otros.

- 05. Gestión de riesgos: es un manual sobre cómo identificar, evaluar y mitigar posibles impactos negativos del sistema durante todo su ciclo de vida.

- 06. Vigilancia humana: detalla los mecanismos para que las decisiones de la IA sean siempre supervisables por personas, evitando la "caja negra" tecnológica. Establece principios como comprensión de capacidades y limitaciones, interpretación de resultados, autoridad para no usar el sistema o anular decisiones.

- 07. Datos y gobernanza de datos: aborda las prácticas necesarias para entrenar, validar y testear modelos de IA asegurando que los conjuntos de datos sean relevantes, representativos, exactos y completos. Cubre procesos de gestión de datos (diseño, recogida, análisis, etiquetado, almacenamiento, etc.), detección y mitigación de sesgos, cumplimiento del Reglamento General de Protección de Datos, linaje de datos y documentación de hipótesis de diseño, siendo de especial interés para la comunidad de datos abiertos y científicos de datos.

- 08. Transparencia: establece cómo informar al usuario de que está interactuando con una IA y cómo explicar el razonamiento detrás de un resultado algorítmico.

- 09. Precisión: define métricas apropiadas según el tipo de sistema para garantizar que el modelo de IA cumple su objetivo.

- 10. Solidez: proporciona orientación técnica sobre cómo garantizar que los sistemas de IA funcionan de manera fiable y consistente en condiciones variables.

- 11. Ciberseguridad: instruye sobre protección contra amenazas específicas del ámbito de IA.

- 12. Registros: define las medidas para cumplir con las obligaciones de registro automático de eventos.

- 13. Vigilancia poscomercialización: documenta los procesos para ejecutar el plan de vigilancia, documentación y análisis de datos sobre el rendimiento del sistema durante toda su vida útil.

- 14. Gestión de incidentes: describe el procedimiento para notificar incidentes graves a las autoridades competentes.

- 15. Documentación técnica: establece la estructura completa que debe incluir la documentación técnica (proceso de desarrollo, datos de entrenamiento/validación/prueba, gestión de riesgos aplicada, rendimiento y métricas, supervisión humana, etc.).

- 16. Manual de checklist de Guías de requisitos: explica cómo utilizar las 13 checklists de autodiagnóstico que permiten realizar evaluación del cumplimiento, identificar brechas, diseñar planes de adaptación y priorizar acciones de mejora.

Todas las guías están disponibles aquí y tienen una estructura modular que se adapta a diferentes niveles de conocimiento y necesidades empresariales.

La herramienta de autodiagnóstico y sus ventajas

En paralelo, la AESIA publica un material que facilita la traducción de requisitos abstractos en preguntas concretas y verificables, proporcionando una herramienta práctica para la evaluación continua del grado de cumplimiento.

Se trata de listas de verificación que permiten a una entidad evaluar su nivel de cumplimiento de forma autónoma.

La utilización de estas checklists proporciona múltiples beneficios a las organizaciones. En primer lugar, facilitan la identificación temprana de brechas de cumplimiento, permitiendo a las organizaciones tomar medidas correctivas antes de la comercialización o puesta en servicio del sistema. También promueven un enfoque sistemático y estructurado del cumplimiento normativo. Al seguir la estructura de los artículos del Reglamento, garantizan que ningún requisito esencial quede sin evaluar.

Por otro lado, facilitan la comunicación entre equipos técnicos, jurídicos y de gestión, proporcionando un lenguaje común y una referencia compartida para discutir el cumplimiento normativo. Y, por último, las checklists sirven como base documental para demostrar la debida diligencia ante las autoridades supervisoras.

Debemos entender que estos documentos no son estáticos. Están sujetos a un proceso permanente de evaluación y revisión. En este sentido, la AESIA continúa desarrollando su capacidad operativa y ampliando sus herramientas de apoyo al cumplimiento.

Desde la plataforma de datos abiertos del Gobierno de España, te invitamos a explorar estos recursos. El desarrollo de la IA debe ir de la mano con datos bien gobernados y supervisión ética.

Hablar de dominio público es hablar de acceso libre al conocimiento, de cultura compartida y de innovación abierta. El concepto se ha convertido en una pieza clave para comprender cómo circula la información y cómo se construye el patrimonio común de la humanidad.

En este post exploraremos qué significa el dominio público y te mostraremos ejemplos de repositorios donde puedes descubrir y disfrutar de obras que ya forman parte de todos.

¿Qué es el dominio público?

Seguro que en algún momento de tu vida has visto la imagen de Mickey Mouse manejando el timón en un barco de vapor. Una imagen característica de la compañía Disney que ya puedes utilizar libremente en tus propias obras. Esto se debe a que esta primera versión de Mickey (Steamboat Willie, 1928) pasó a ser de dominio público en enero de 2024 -ojo, solo es “libre” la versión de esa fecha, adaptaciones posteriores sí continúan protegidas, como explicaremos después-.

Cuando hablamos de dominio público, hacemos referencia al conjunto de conocimiento, información, obras y creaciones (libros, música, películas, fotos, software, etc.) que no están protegidas por derechos de autor. Debido a ello, cualquier persona puede reproducirlas, copiarlas, adaptarlas y distribuirlas sin necesidad de pedir permiso ni pagar licencias. No obstante, sí se deben respetar siempre los derechos morales del autor, que son irrenunciables y no caducan. Estos derechos incluyen respetar siempre la autoría y la integridad de la obra*.

El dominio público, por tanto, da forma al espacio cultural donde las obras pasan a ser patrimonio común de la sociedad, lo cual supone múltiples beneficios:

- Acceso gratuito a la cultura y al conocimiento: cualquier ciudadano puede leer, ver, escuchar o descargar esas obras sin pagar licencias ni suscripciones. Esto favorece la educación, la investigación y el acceso universal a la cultura.

- Conservación de la memoria y el patrimonio: el dominio público garantiza que parte importante de nuestra historia, ciencia y arte se mantenga accesible para las generaciones presentes y futuras, sin quedar limitada por restricciones legales.

- Fomenta la creatividad y la innovación: artistas, desarrolladores, empresas, etc. pueden reutilizar y mezclar obras del dominio público para crear nuevos productos (como adaptaciones, nuevas ediciones, videojuegos, cómics, etc.) sin miedo a infringir derechos.

- Impulso tecnológico: archivos, museos y bibliotecas pueden digitalizar y difundir libremente sus fondos en dominio público, lo que genera oportunidades para proyectos digitales y desarrollo de nuevas herramientas. Por ejemplo, estas obras pueden utilizarse para entrenar modelos de inteligencia artificial y herramientas de procesamiento del lenguaje natural.

¿Qué obras y elementos pertenecen al dominio público, según la legislación española?

En el dominio público encontramos tanto contenidos cuyos derechos de autor han expirado como contenidos que nunca han estado protegidos. Veamos que dice la legislación española al respecto:

Obras cuya protección por derechos de autor ha expirado.

Para saber si una obra pertenece al dominio público, debemos fijarnos en la fecha de la muerte de su autor. En este sentido, en España, hay una fecha de inflexión: 1987. A partir de ese año, y según la ley de propiedad intelectual, las obras artísticas pasan a dominio público una vez transcurridos 70 años de la muerte de su autor. No obstante, los autores fallecidos antes de dicho año están sujetos a la Ley de 1879, donde el plazo en general era de 80 años – con excepciones-.

Solo las creaciones “originales literarias, artísticas o científicas” que impliquen un nivel suficiente de creatividad están protegidas, independientemente de su soporte (papel, digital, audiovisual, etc.). Esto incluye desde libros, composiciones musicales, obras teatrales, audiovisuales o pictóricas y esculturas hasta gráficos, mapas y diseños relativos a la topografía, la geografía y la ciencia o programas de ordenador, entre otros.

Cabe destacar que también son objeto de propiedad intelectual las traducciones y adaptaciones, las revisiones, actualizaciones y anotaciones; los compendios, resúmenes y extractos; los arreglos musicales, las colecciones de obras ajenas, como las antologías o cualesquiera transformaciones de una obra literaria, artística o científica. Por tanto, una adaptación reciente de El Quijote contará con su propia protección.

Obras que no pueden acogerse a la protección de los derechos de autor.

Como veíamos, no todo lo que se produce puede acogerse a derechos de autor, algunos ejemplos son:

- Documentos oficiales: las leyes, decretos, sentencias y otros textos oficiales no están sujetos a derechos de autor. Se consideran demasiado relevantes para la vida pública como para imponerles restricciones, y por ello forman parte del dominio público desde el momento de su publicación.

- Obras cedidas voluntariamente: los propios titulares de derechos pueden decidir liberar sus obras antes de que expire el plazo legal. Para ello existen herramientas como la licencia Creative Commons CC0 , que permite renunciar a la protección y poner la obra directamente a disposición de todos.

- Hechos e información: el derecho de autor no cubre hechos ni datos. La información y los acontecimientos son patrimonio común y pueden ser usados libremente por cualquiera.

Europeana y su defensa del dominio público

Europeana es la gran biblioteca digital de Europa, un proyecto impulsado por la Unión Europea que reúne millones de recursos culturales procedentes de archivos, museos y bibliotecas de todo el territorio. Su misión es facilitar el acceso libre y abierto al patrimonio cultural europeo, y en ese sentido el dominio público ocupa un lugar central. Europeana defiende que las obras que han perdido su protección por derechos de autor deben permanecer libres de restricciones, incluso cuando se digitalizan, porque forman parte del patrimonio común de la humanidad.

Fruto de su compromiso, recientemente ha actualizado su Carta del Dominio Público, donde recoge una serie de principios y guías esenciales para un dominio público robusto y vibrante en el entorno digital. Entre otras cuestiones, menciona cómo los avances tecnológicos y los cambios normativos han ampliado las posibilidades de acceso al patrimonio cultural, pero también han generado riesgos para la disponibilidad y reutilización de los materiales en dominio público. Por ello, propone ocho medidas para proteger y fortalecer el dominio público:

- Abogar contra la ampliación de los plazos o el alcance del copyright, que limita el acceso ciudadano a la cultura compartida.

- Oponerse a intentos de control indebido sobre materiales libres, evitando licencias, tarifas o restricciones contractuales que reconstituyan derechos.

- Garantizar que las reproducciones digitales no generen nuevas capas de protección, incluyendo fotos o modelos 3D, salvo que sean creaciones originales.

- Evitar contratos que restrinjan la reutilización: la financiación de la digitalización no debe traducirse en barreras legales.

- Etiquetar de forma clara y precisa las obras en dominio público, proporcionando datos como autor y fecha para facilitar su identificación.

- Equilibrar el acceso con otros intereses legítimos, respetando leyes, valores culturales y la protección de grupos vulnerables.

- Salvaguardar la disponibilidad del patrimonio, frente a amenazas como conflictos, cambio climático o la fragilidad de plataformas digitales, promoviendo una preservación sostenible.

- Ofrecer reproducciones y metadatos de alta calidad y reutilizables, en formatos abiertos y legibles por máquina, para potenciar su uso creativo y educativo.

Otras plataformas para acceder a obras de dominio público

Además de Europeana, en España contamos con un ecosistema de proyectos que ponen al alcance de todos el patrimonio cultural en dominio público:

- La Biblioteca Nacional de España (BNE) desempeña un papel clave: cada año publica la lista de autores españoles que entran en dominio público y ofrece acceso a sus obras digitalizadas a través de BNE Digital, un portal que permite consultar manuscritos, libros, grabados y otros materiales históricos. Así, podemos encontrar obras de autores de la talla de Antonio Machado o Federico García Lorca. Además, la BNE publica en abierto el conjunto de datos con información sobre los autores en dominio público.

- La Biblioteca Virtual del Patrimonio Bibliográfico (BVPB), impulsada por el Ministerio de Cultura, reúne miles de obras antiguas digitalizadas, garantizando que textos y materiales fundamentales de nuestra historia literaria y científica puedan ser preservados y reutilizados sin restricciones. Incluye reproducciones facsímiles digitales de manuscritos, libros impresos, fotografías históricas, materiales cartográficos, partituras, mapas, etc.

- Hispana actúa como un gran agregador nacional al conectar colecciones digitales de archivos, bibliotecas y museos españoles, ofreciendo un acceso unificado a materiales que forman parte del dominio público. Para ello, recolecta y hace accesibles los metadatos de los objetos digitales, permitiendo visualizar dichos objetos a través de enlaces que dirijan a las páginas de las instituciones propietarias.

En conjunto, todas estas iniciativas refuerzan la idea de que el dominio público no es un concepto abstracto, sino un recurso vivo y accesible que se expande cada año y que permite que nuestra cultura siga circulando, inspirando y generando nuevas formas de conocimiento.

Gracias a Europeana, BNE Digital, la BVPB, Hispana y otros muchos proyectos de este tipo, hoy tenemos la posibilidad de acceder a un patrimonio cultural inmenso que nos conecta con nuestro pasado y nos impulsa hacia el futuro. Cada obra que entra en el dominio público amplía las oportunidades de aprendizaje, innovación y disfrute colectivo, recordándonos que la cultura, cuando se comparte, se multiplica.

*De acuerdo con la Ley de Propiedad intelectual, la integridad de la obra hace referencia a impedir cualquier deformación, modificación, alteración o atentado contra ella que suponga perjuicio a sus legítimos intereses o menoscabo a su reputación.

El pasado 19 de noviembre, la Comisión Europea presentó la Estrategia Unión de Datos (Data Union Strategy), una hoja de ruta que busca consolidar un ecosistema europeo de datos robusto, seguro y competitivo. Esta estrategia se articula en torno a tres pilares fundamentales: ampliar el acceso a datos de calidad para la inteligencia artificial y la innovación, simplificar el marco normativo existente, y proteger la soberanía digital europea. En este post, explicaremos en detalle cada uno de estos pilares, así como el calendario de implementación del plan previsto para los próximos dos años.

Pilar 1: ampliar el acceso a datos de calidad para la IA y la innovación

El primer pilar de la estrategia se centra en garantizar que empresas, investigadores y administraciones públicas tengan acceso a datos de alta calidad que permitan desarrollar aplicaciones innovadoras, especialmente en el ámbito de la inteligencia artificial. Para ello, la Comisión propone una serie de iniciativas interconectadas que abarcan desde la creación de infraestructuras hasta el desarrollo de estándares y facilitadores técnicos. Como parte de este pilar se establecen una serie de acciones: la ampliación de espacios comunes europeos de datos, el desarrollo de los data labs, el impulso del Cloud and AI Development Act, la ampliación de activos de datos estratégicos y la elaboración de facilitadores para implementar estas medidas.

1.1 Ampliación de los Espacios Comunes Europeos de Datos (CEDS)

Los Espacios Comunes Europeos de Datos constituyen uno de los elementos centrales de esta estrategia:

-

Inversión prevista: 100 millones de euros para su despliegue.

-

Sectores prioritarios: salud, movilidad, energía, administración pública (legal) y medio ambiente.

-

Interoperabilidad: se apuesta por SIMPL para la interoperabilidad entre espacios de datos con el apoyo del Centro Europeo de Competencia en Datos (DSSC, por sus siglas en inglés Data Spaces Support Center).

-

Aplicaciones clave:

-

Espacio Europeo de Datos de Salud (EHDS): mención especial por su función como puente entre los sistemas de datos de salud y el desarrollo de la IA.

-

Nuevo Espacio de Datos de Defensa: para el desarrollo de sistemas de última generación, coordinado por la Agencia Europea de Defensa.

-

1.2 Laboratorios de datos (Data Labs): el nuevo ecosistema para conectar datos y desarrollo de IA

La estrategia plantea utiliza Data Labs como puntos de conexión entre el desarrollo de inteligencia artificial y los datos europeos.

Estos laboratorios emplean el data pooling, un proceso de combinación y compartición de datos públicos y restringidos provenientes de múltiples fuentes en un repositorio centralizado o entorno compartido. Todo esto facilita el acceso y uso de información. En concreto, los servicios que ofrecen los Data Labs son:

-

Facilita el acceso a los datos.

-

Infraestructura técnica y herramientas.

-

Data pooling.

-

Filtrado de datos y etiquetado

-

Guía regulatoria y formación.

-

Reducción de la brecha entre los espacios de datos y los ecosistemas de IA.

Plan de implementación:

-

Primera fase: los primeros Data Labs se establecerán en el marco de las AI Factories (gigafactorías de IA), ofreciendo servicios de datos para conectar el desarrollo de IA con los espacios de datos europeos.

-

Data Labs sectoriales: se establecerán de forma independiente en otros ámbitos para cubrir necesidades específicas, por ejemplo, en el sector energético.

-

Modelo autosostenible: se prevé que el modelo de Data Labs pueda desplegarse comercialmente, convirtiéndolo en un ecosistema autosostenible que conecta datos e IA.

1.3 Cloud and AI Development Act: impulso a la nube soberana

Para el impulso de la tecnología de nube, la Comisión propondrá en el primer trimestre de 2026 este nuevo reglamento. Actualmente hay una consulta pública abierta en la que se puede participar aquí.

1.4 Activos de datos estratégicos: sector público, recursos científicos, culturales y lingüísticos

Por un lado, en 2026 se propondrá ampliar la lista de los datos de alto valor High value datasets en inglés o HVDS para incluir datos legales, judiciales y administrativos, entre otros. Y, por otro lado, la Comisión mapeará bases existentes y financiará nuevas infraestructuras digitales.

1.5 Facilitadores horizontales: datos sintéticos, data pooling y estándares

La Comisión Europea elaborará guías y estándares sobre datos sintéticos y se financiará I+D avanzada en técnicas para su generación de a través de Horizon Europe.

Otro tema que la UE quiere impulsar es el data pooling, como explicamos anteriormente. Compartir datos de etapas tempranas del ciclo productivo puede generar beneficios colectivos, pero persisten barreras por incertidumbre legal y temor a infringir normas de competencia. ¿Su propósito? Convertir el data pooling en una opción confiable y legalmente segura para acelerar avances en sectores críticos.

Finalmente, en materia de estandarización, se solicitará a las organizaciones europeas de normalización (CEN/CENELEC) el desarrollo de nuevos estándares técnicos en dos ámbitos clave: la calidad del dato y el etiquetado. Estos estándares permitirán establecer criterios comunes sobre cómo deben ser los datos para garantizar su fiabilidad y cómo deben etiquetarse para facilitar su identificación y uso en diferentes contextos.

Pilar 2: Simplificación Normativa

El segundo pilar aborda uno de los desafíos más señalados por empresas y organizaciones: la complejidad del marco regulatorio europeo en materia de datos. La estrategia propone una serie de medidas destinadas a simplificar y consolidar la legislación existente.

2.1 Derogaciones y consolidación normativa: hacia un marco más coherente

Se quieren eliminar normativas cuyas funciones ya están cubiertas por legislación más reciente, evitando así duplicidades y contradicciones. En primer lugar, se derogará el Reglamento de Libre Flujo de Datos no Personales (FFoNPD), ya que sus funciones están ahora cubiertas por la Data Act (Ley de Datos). No obstante, se preservará explícitamente la prohibición de localización injustificada de datos, un principio fundamental para el mercado único digital.

Del mismo modo, la Data Governance Act (Reglamento europeo de gobernanza de datos o DGA) será eliminada como norma independiente, migrando sus provisiones esenciales a la Data Act. Este movimiento simplifica el marco regulatorio y, además, alivia la carga administrativa: las obligaciones para los intermediarios de datos pasarán a ser más ligeras y de carácter voluntario.

En cuanto al sector público, la estrategia plantea una consolidación importante. Las normas sobre intercambio de datos públicos, actualmente dispersas entre la DGA y la Directiva de Datos Abiertos (Open Data Directive), se fusionarán en un único capítulo dentro de la Data Act. Esta unificación facilitará tanto la aplicación como la comprensión del marco legal por parte de las administraciones públicas.

2.2 Reforma de cookies: equilibrio entre protección y usabilidad

Otro detalle relevante es la regulación de cookies que experimentará una modernización significativa, integrándose en el marco del Reglamento General de Protección de Datos (RGPD). La reforma busca un equilibrio: por un lado, se legalizarán usos de bajo riesgo que actualmente generan incertidumbre legal; por otro, se simplificarán los banners de consentimiento mediante sistemas de "un solo clic" (one-click). El objetivo es claro: reducir la denominada "fatiga del usuario" ante las solicitudes repetitivas de consentimiento que todos conocemos al navegar por Internet.

2.3 Ajustes al RGPD para facilitar el desarrollo de IA

El Reglamento General de Protección de Datos también será objeto de una reforma focalizada, diseñada específicamente para liberar datos de forma responsable en beneficio del desarrollo de la inteligencia artificial. Esta intervención quirúrgica aborda tres aspectos concretos:

-

Aclara cuándo puede aplicarse el interés legítimo para el entrenamiento de modelos de IA.

-

Define con mayor precisión la distinción entre datos anónimos y seudonimizados, especialmente en relación con el riesgo de reidentificación.

-

Armoniza las evaluaciones de impacto en protección de datos, facilitando su aplicación coherente en toda la Unión.

2. 4 Implementación y Apoyo a la Data Act

La Data Act, recientemente aprobada, será objeto de ajustes para mejorar su aplicación. Por un lado, se refina el alcance del intercambio de datos de empresas a gobiernos (B2G), limitándolo estrictamente a situaciones de emergencia. Por otro lado, se amplía el paraguas de protección: las condiciones favorables que actualmente disfrutan las pequeñas y medianas empresas (PYMES) se extenderán también a las empresas medianas o small mid-caps, aquellas que tienen entre 250 y 749 empleados.

Para facilitar la implementación práctica de la norma, ya se ha publicado un modelo de cláusulas contractuales tipo para el intercambio de datos, proporcionando así una plantilla que las organizaciones pueden utilizar directamente. Además, durante el primer trimestre de 2026 se publicarán dos guías adicionales: una sobre el concepto de "compensación razonable" en los intercambios de datos, y otra destinada a clarificar las definiciones clave de la Data Act que puedan generar dudas interpretativas.

Consciente de que las PYMES pueden tener dificultades para navegar este nuevo marco legal, se creará un Helpdesk Legal en el cuarto trimestre de 2025. Este servicio de asistencia ofrecerá asesoramiento directo sobre la aplicación de la Data Act, dando prioridad precisamente a las pequeñas y medianas empresas que carecen de departamentos jurídicos especializados.

2.5 Evolución de la gobernanza: hacia un ecosistema más coordinado

La arquitectura de gobernanza del ecosistema europeo de datos también experimenta cambios significativos. El European Data Innovation Board (EDIB) evoluciona desde un órgano principalmente consultivo hacia un foro de debates más técnicos y estratégicos, incorporando tanto a los Estados miembros como a representantes de la industria. Para ello, se modificará su articulado con dos objetivos: permitir la inclusión en los debates de las autoridades competentes en materia de Data Act, y dotar de mayor flexibilidad a la Comisión Europea en la composición y funcionamiento del organismo.

Complementariamente, se articulan dos mecanismos adicionales de retroalimentación y anticipación. La Apply AI Alliance canalizará el feedback sectorial, recogiendo las experiencias y necesidades específicas de cada industria. Por su parte, el AI Observatory actuará como radar de tendencias, identificando desarrollos emergentes en el ámbito de la inteligencia artificial y traduciéndolos en recomendaciones de políticas públicas. De este modo, se cierra un círculo virtuoso donde la política se nutre constantemente de la realidad del terreno.

Pilar 3: Protección de la soberanía del dato europeo

El tercer pilar se centra en garantizar que los datos europeos reciban un trato justo y seguro, tanto dentro como fuera de las fronteras de la Unión. La intención es que solo se compartan datos con países de la misma visión regulatoria.

3.1 Medidas específicas para proteger los datos europeos

-

Publicación de guías para evaluar el trato justo de datos de la UE en el extranjero (segundo trimestre 2026):

-

Publicación de toolbox contra prácticas injustas (segundo trimestre 2026):

-

La localización injustificada.

-

La exclusión.

-

Las salvaguardas débiles.

-

La fuga de datos.

-

-

Adopción de medidas para proteger los datos no personales sensibles.

Todas estas medidas se plantean implementar desde el último cuatrimestre de 2025 y durante todo 2026 en un despliegue progresivo que permitirá una adopción gradual y coordinada de las diferentes medidas, tal y como establece la Data Union Strategy.

En resumen, la Estrategia Unión de Datos representa un esfuerzo integral por consolidar el liderazgo europeo en la economía del dato. Para ello se impulsará el data pooling y los espacios de datos de los Estados miembro, se apostará por los Data Labs y las gigafactorías de IA y se incentivará la simplificación normativa.

La 17ª Conferencia Internacional sobre Reutilización de la Información del Sector Público se celebrará el próximo 3 de diciembre en Madrid. La Asociación Multisectorial de la Información (ASEDIE) organiza cada año esta cita, que en su nueva edición tendrá lugar en el Ministerio para la Transformación Digital y de la Función Pública en Madrid. Bajo el lema “Cuando la norma no basta: desigualdad en la aplicación de la normativa sobre datos”, se abordarán los retos actuales en torno a la reutilización de la información pública y la necesidad de marcos normativos ágiles y efectivos.

La complejidad normativa, un reto a abordar

Este evento reúne a expertos nacionales y europeos para abordar la reutilización de datos como motor de innovación. En concreto, la edición de este año pone el foco en la necesidad de avanzar en una regulación que fomente la cultura de apertura en todas las administraciones, evitando la fragmentación normativa y asegurando que el acceso a la información pública se traduzca en un verdadero valor económico y social.

A través de diversas ponencias y mesas redondas se abordarán algunos de los grandes desafíos actuales en esta materia: desde la simplificación normativa para facilitar la reutilización de información hasta el gobierno abierto como práctica real.

El programa de la Jornada

El evento ofrecerá una visión integral de cómo avanzar hacia un ecosistema de información más justo, abierto y competitivo.

La recepción de los asistentes tendrá lugar entra las 09:00 y las 09:30. A esa hora comenzará el evento con la bienvenida e inauguración, que correrá a cargo de Ruth del Campo, directora general del dato (Secretaría de Estado de Digitalización e Inteligencia Artificial). Le seguirán dos presentaciones de la Representación Permanente de España ante la Unión Europea, de la mano de Miguel Valle del Olmo, consejero de transformación digital, y Almudena Darias de las Heras, consejera de justicia.

A lo largo de la jornada tendrán lugar tres mesas redondas:

- 10:15 – 10:45. Mesa I: Simplificación normativa y seguridad jurídica: Pilares para un marco ágil y eficiente. Moderada por Ignacio Jiménez, presidente de ASEDIE, contará con la participación de Ruth del Campo y Meritxell Borràs i Solé, directora de la Autoritat Catalana de Protecció de Dades.

- 10:45 – 11:45. Mesa II: Transparencia y Gobierno Abierto: de la teoría a la práctica. Cuatro participantes nos trasladaran su visión y experiencia en la materia: Carmen Cabanillas, directora general de Gobernanza Publica (Secretaría de Estado de Función Pública), José Luis Rodríguez Álvarez, presidente del Consejo de Transparencia y Buen Gobierno, José Máximo López Vilaboa, director general de Transparencia y Buen Gobierno (Junta de Castilla y León) y Ángela Pérez Brunete, directora general de Transparencia y Calidad (Ayuntamiento de Madrid). La conversación estará moderada por Manuel Hurtado, vocal de la Junta Directiva de ASEDIE.

- 12:35 – 13:35. Mesa III: Registros abiertos y transparentes. Prevenir el blanqueo sin frenar la competitividad. Bajo la moderación de Valentín Arce, vicepresidente de ASEDIE, tendrá lugar una conversación protagonizada por Antonio Fuentes Paniagua, subdirector general del Notariado y de los Registros (Ministerio de la Presidencia, Justicia y Relaciones con las Cortes Antonio), Andrés Martínez Calvo, Consultor del Órgano Centralizado de Prevención (Consejo General del Notariado), Carlos Balmisa, secretario general técnico del Colegio de Registradores de la Propiedad y Mercantil, y José Luis Perea, secretario general de ATA Autónomos.

Durante la mañana también se entregarán:

- La certificación UNE 0080 (Guía de evaluación del Gobierno, Gestión y Gestión de la Calidad del Dato). Esta especificación desarrolla un marco homogéneo de evaluación de la madurez de una organización respecto al tratamiento de los datos. Descubre más sobre las especificaciones UNE relacionadas con el dato en este artículo.

- El Premio ASEDIE 2025. Este galardón internacional reconoce cada año a personas, empresas o instituciones que destacan por su contribución a la innovación y desarrollo del sector infomediario. Visibiliza proyectos que impulsan la reutilización de la información del sector público (RISP), destacando su papel en el desarrollo de la economía tanto española como global. Puedes conocer a los galardonados en las ediciones previas aquí.

El evento finalizará a las 13:45, con unas palabras de Ignacio Jiménez.

Puedes ver el programa detallado en la página web de ASEDIE.

Cómo asistir

La 17ª Conferencia de ASEDIE es una cita imprescindible para quienes trabajan en el ámbito de la reutilización de información, la transparencia y la innovación basada en datos.

Al evento de este año solo se podrá asistir de manera presencial en el Ministerio para la Transformación Digital y de la Función Pública (c/ Mármol, 2, Parque Empresarial Rio 55, 28005, Madrid). Es necesario inscribirse a través de su página web.

La convergencia entre datos abiertos, inteligencia artificial y sostenibilidad medioambiental plantea uno de los principales desafíos para el modelo de transformación digital que se está impulsando a nivel europeo. Esta interacción se concreta principalmente en tres manifestaciones destacadas:

-

La apertura de datos de alto valor directamente relacionados con la sostenibilidad, que pueden ayudar al desarrollo de soluciones de inteligencia artificial orientadas a la mitigación del cambio climático y la eficiencia de recursos.

-

El impulso de los denominados algoritmos verdes en la reducción del impacto ambiental de la IA, que se ha de concretar tanto en el uso eficiente de la infraestructura digital como en la toma de decisiones sostenibles.

-

La apuesta por espacios de datos medioambientales, generando ecosistemas digitales donde se comparten datos que provienen de fuentes diversas para facilitar el desarrollo de proyectos y soluciones interoperables con impacto relevante desde la perspectiva medioambiental.

A continuación, profundizaremos en cada uno de estos puntos.

Datos de alto valor para la sostenibilidad

La Directiva (UE) 2019/1024 sobre datos abiertos y reutilización de la información del sector público introdujo por primera vez el concepto de conjuntos de datos de alto valor, definidos como aquellos con un potencial excepcional para generar beneficios sociales, económicos y medioambientales. Estos conjuntos deben publicarse de forma gratuita, en formatos legibles por máquina, mediante interfaces de programación de aplicaciones (API) y, cuando proceda, se han de poder descargar de forma masiva. A tal efecto se han identificado una serie de categorías prioritarias, entre los que se encuentran los datos medioambientales y relativos a la observación de la Tierra.

Se trata de una categoría especialmente relevante, ya que abarca tanto datos sobre clima, ecosistemas o calidad ambiental, así como los vinculados a la Directiva INSPIRE, que hacen referencia a áreas ciertamente diversas como hidrografía, lugares protegidos, recursos energéticos, uso del suelo, recursos minerales o, entre otros, los relativos a zonas de riesgos naturales, incluyendo también ortoimágenes.

Estos datos tienen una singular relevancia a la hora de monitorizar las variables relacionadas con el cambio climático, como puede ser el uso del suelo, la gestión de la biodiversidad teniendo en cuenta la distribución de especies, hábitats y lugares protegidos, el seguimiento de las especies invasoras o la evaluación de los riesgos naturales. Los datos sobre calidad del aire y contaminación son cruciales para la salud pública y ambiental, de manera que el acceso a los mismos permite llevar a cabo análisis exhaustivos sin duda relevantes para la adopción de políticas públicas orientadas a su mejora. La gestión de recursos hídricos también se puede optimizar mediante datos de hidrografía y monitoreo ambiental, de manera que su tratamiento masivo y automatizado constituye una premisa inexcusable para hacer frente al reto de la digitalización de la gestión del ciclo del agua.

La combinación con otros datos medioambientales de calidad facilita el desarrollo de soluciones de IA orientadas a desafíos climáticos específicos. En concreto, permiten entrenar modelos predictivos para anticipar fenómenos extremos (olas de calor, sequías, inundaciones), optimizar la gestión de recursos naturales o monitorizar en tiempo real indicadores ambientales críticos. También permite impulsar proyectos económicos de gran impacto, como puede ser el caso de la utilización de algoritmos de IA para implementar soluciones tecnológicas en el ámbito de la agricultura de precisión, posibilitando el ajuste inteligente de los sistemas de riego, la detección temprana de plagas o la optimización del uso de fertilizantes.

Algoritmos verdes y responsabilidad digital: hacia una IA sostenible

El entrenamiento y despliegue de sistemas de inteligencia artificial, particularmente de modelos de propósito general y grandes modelos de lenguaje, conlleva un consumo energético significativo. Según estimaciones de la Agencia Internacional de la Energía, los centros de datos representaron alrededor del 1,5 % del consumo mundial de electricidad en 2024. Esta cifra supone un crecimiento de alrededor de un 12 % anual desde 2017, más de cuatro veces más rápido que la tasa de consumo eléctrico total. Está previsto que el consumo eléctrico de los centros de datos se duplique hasta alcanzar unos 945 TWh en 2030.

Ante este panorama, los algoritmos verdes constituyen una alternativa que necesariamente ha de tenerse en cuenta a la hora de minimizar el impacto ambiental que plantea la implantación de la tecnología digital y, en concreto, la IA. De hecho, tanto la Estrategia Europea de Datos como el Pacto Verde Europeo integran explícitamente la sostenibilidad digital como pilar estratégico. Por su parte, España ha puesto en marcha un Programa Nacional de Algoritmos Verdes, enmarcado en la Agenda Digital 2026 y con una medida específica en la Estrategia Nacional de Inteligencia Artificial.

Uno de los principales objetivos del Programa consiste en fomentar el desarrollo de algoritmos que minimicen su impacto ambiental desde la concepción —enfoque green by design—, por lo que la exigencia de una documentación exhaustiva de los conjuntos de datos utilizados para entrenar modelos de IA —incluyendo origen, procesamiento, condiciones de uso y huella ambiental— resulta fundamental para dar cumplimiento a esta aspiración. A este respecto, la Comisión ha publicado una plantilla para ayudar a los proveedores de inteligencia artificial de propósito general a resumir los datos utilizados para el entrenamiento de sus modelos, de manera que se pueda exigir mayor transparencia que, por lo que ahora interesa, también facilitaría la trazabilidad y gobernanza responsable desde la perspectiva ambiental, así como la realización de ecoauditorías.

El Espacio de Datos del Pacto Verde Europeo (Green Deal)

Se trata de uno de los espacios de datos comunes europeos contemplados en la Estrategia Europea de Datos que se encuentra en un estado más avanzado, tal y como demuestran las numerosas iniciativas y eventos de divulgación que se han impulsado en torno al mismo. Tradicionalmente el acceso a la información ambiental ha sido uno de los ámbitos con una regulación más favorable, de manera que con el impulso de los datos de alto valor y la decida apuesta que supone la creación de un espacio europeo en esta materia se ha producido un avance cualitativo muy destacable que refuerza una tendencia ya consolidada en este ámbito.

En concreto, el modelo de los espacios de datos facilita la interoperabilidad entre datos abiertos públicos y privados, reduciendo barreras de entrada para startups y pymes en sectores como la gestión forestal inteligente, la agricultura de precisión o, entre otros muchos ejemplos, la optimización energética. Al mismo tiempo, refuerza la calidad de los datos disponibles para que las Administraciones Públicas lleven a cabo sus políticas públicas, ya que sus propias fuentes pueden contrastarse y compararse con otros conjuntos de datos. Finalmente, el acceso compartido a datos y herramientas de IA puede fomentar iniciativas y proyectos de innovación colaborativa, acelerando el desarrollo de soluciones interoperables y escalables.

Ahora bien, el ecosistema jurídico propio de los espacios de datos conlleva una complejidad inherente a su propia configuración institucional, ya que en el mismo confluyen varios sujetos y, por tanto, diversos intereses y regímenes jurídicos aplicables:

-

Por una parte, las entidades públicas, a las que en este ámbito les corresponde un papel de liderazgo especialmente reforzado.

-

Por otra las entidades privadas y la ciudanía, que no sólo pueden aportar sus propios conjuntos de datos, sino asimismo ofrecer desarrollos y herramientas digitales que pongan en valor los datos a través de servicios innovadores.

-

Y, finalmente, los proveedores de la infraestructura necesaria para la interacción en el seno del espacio.

En consecuencia, son imprescindibles modelos de gobernanza avanzados que hagan frente a esta complejidad reforzada por la innovación tecnológica y de manera especial la IA, ya que los planteamientos tradicionales propios de la legislación que regula el acceso a la información ambiental son ciertamente limitados para esta finalidad.

Hacia una convergencia estratégica

La convergencia de datos abiertos de alto valor, algoritmos verdes responsables y espacios de datos medioambientales está configurando un nuevo paradigma digital imprescindible para afrontar los retos climáticos y ecológicos en Europa que requiere un enfoque jurídico robusto y, al mismo tiempo flexible. Este singular ecosistema no solo permite impulsar la innovación y eficiencia en sectores clave como la agricultura de precisión o la gestión energética, sino que también refuerza la transparencia y la calidad de la información ambiental disponible para la formulación de políticas públicas más efectivas.

Más allá del marco normativo vigente resulta imprescindible diseñar modelos de gobernanza que ayuden a interpretar y aplicar de manera coherente regímenes legales diversos, que protejan la soberanía de los datos y, en definitiva, garanticen la transparencia y la responsabilidad en el acceso y reutilización de la información medioambiental. Desde la perspectiva de la contratación pública sostenible, es esencial promover procesos de adquisición por parte de las entidades públicas que prioricen soluciones tecnológicas y servicios interoperables basados en datos abiertos y algoritmos verdes, fomentando la elección de proveedores comprometidos con la responsabilidad ambiental y la transparencia en las huellas de carbono de sus productos y servicios digitales.

Solo partiendo de este enfoque se puede aspirar a que la innovación digital sea tecnológicamente avanzada y ambientalmente sostenible, alineando así los objetivos del Pacto Verde, la Estrategia Europea de Datos y el enfoque europeo en materia de IA

Contenido elaborado por Julián Valero, catedrático de la Universidad de Murcia y Coordinador del Grupo de Investigación “Innovación, Derecho y Tecnología” (iDerTec). Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La Inteligencia Artificial (IA) está transformando la sociedad, la economía y los servicios públicos a una velocidad sin precedentes. Esta revolución trae enormes oportunidades, pero también desafíos relacionados con la ética, la seguridad y la protección de derechos fundamentales. Consciente de ello, la Unión Europea aprobó la Ley de Inteligencia Artificial (AI Act), en vigor desde el 1 de agosto de 2024, que establece un marco armonizado y pionero para el desarrollo, la comercialización y el uso de sistemas de IA en el mercado único, fomentando la innovación mientras protege a la ciudadanía.

Un ámbito especialmente relevante de esta normativa son los modelos de IA de propósito general (GPAI), como los grandes modelos de lenguaje (LLM) o los modelos multimodales, que se entrenan con enormes volúmenes de datos de muy diversa procedencia (texto, imágenes y vídeo, audio e incluso datos generados por usuarios). Esta realidad plantea retos críticos en propiedad intelectual, protección de datos y transparencia sobre el origen y el tratamiento de la información.

Para afrontarlos, la Comisión Europea, a través de la Oficina Europea de IA, ha publicado la Plantilla de Resumen Público de los Datos de Entrenamiento: un formato estandarizado que los proveedores deberán completar y publicar para resumir información clave sobre los datos usados en el entrenamiento. A partir del 2 de agosto de 2025, todo modelo de propósito general que se comercialice o distribuya en la UE deberá ir acompañado de este resumen; los modelos ya presentes en el mercado disponen hasta el 2 de agosto de 2027 para adaptarse. Esta medida materializa el principio de transparencia de la AI Act y pretende arrojar luz sobre las “cajas negras” de la IA.

En este artículo te contamos las claves de esta plantilla: desde sus objetivos y estructura, hasta información sobre plazos, sanciones y próximos pasos.

Objetivos y relevancia de la plantilla

Los modelos de IA de propósito general se entrenan con datos de muy diversa procedencia y modalidad, como:

-

Texto: libros, artículos científicos, prensa o redes sociales.

-

Imágenes y vídeos: contenidos digitales de Internet y colecciones visuales.

-

Audio: grabaciones, pódcast, programas de radio o conversaciones.

-

Datos de usuarios: información generada en la interacción con el propio modelo o con otros servicios del proveedor.

Este proceso de recopilación masiva de datos suele ser opaco, lo que genera preocupación entre titulares de derechos, usuarios, reguladores y la sociedad en su conjunto. Sin transparencia, resulta difícil evaluar si los datos se han obtenido de forma legal, si incluyen información personal no autorizada o si representan adecuadamente la diversidad cultural y lingüística de la Unión Europea.

El Considerando 107 de la AI Act establece que el objetivo principal de esta plantilla es incrementar la transparencia y facilitar el ejercicio y la protección de derechos. Entre los beneficios que aporta destacan:

-

Protección de la propiedad intelectual: permite que autores, editores y demás titulares de derechos identifiquen si sus obras han sido utilizadas durante el entrenamiento, facilitando la defensa de sus derechos y un uso justo de sus contenidos.

-

Salvaguarda de la privacidad: ayuda a detectar si se han empleado datos personales, aportando información útil para que las personas afectadas puedan ejercer sus derechos conforme al Reglamento General de Protección de Datos (RGPD) y otras normas del mismo ámbito.

-

Prevención de sesgos y discriminación: proporciona información sobre la diversidad lingüística y cultural de las fuentes utilizadas, clave para evaluar y mitigar sesgos que puedan generar discriminaciones.

-

Fomento de la competencia y la investigación: reduce los efectos de “caja negra” y facilita el escrutinio académico, al tiempo que ayuda a otras empresas a comprender mejor la procedencia de los datos, favoreciendo mercados más abiertos y competitivos.

En definitiva, esta plantilla no es solo un requisito legal, sino una herramienta para generar confianza en la inteligencia artificial, creando un ecosistema en el que la innovación tecnológica y la protección de derechos se refuercen mutuamente.

Estructura de la plantilla

La plantilla, publicada oficialmente el 24 de julio de 2025 tras una consulta pública con más de 430 organizaciones participantes, ha sido diseñada para que la información se presente de forma clara, homogénea y comprensible, tanto para especialistas como para la ciudadanía.

Se compone de tres secciones principales, que abarcan desde la identificación básica del modelo hasta los aspectos legales relacionados con el tratamiento de los datos.

1. Información general

Proporciona una visión global sobre el proveedor, el modelo y las características generales de los datos de entrenamiento:

-

Identificación del proveedor, como nombre y datos de contacto.

-

Identificación del modelo y sus versiones, incluyendo dependencias si se trata de una modificación (fine-tuning) de otro modelo.

-

Fecha de puesta en el mercado del modelo en la UE.

-

Modalidades de datos utilizadas (texto, imagen, audio, vídeo u otras).

-

Tamaño aproximado de los datos por modalidad, expresado en rangos amplios (por ejemplo, menos de 1.000 millones de tokens, entre 1.000 millones y 10 billones, más de 10 billones).

-

Cobertura lingüística, con especial atención a las lenguas oficiales de la Unión Europea.

Esta sección ofrece un nivel de detalle suficiente para comprender la magnitud y naturaleza del entrenamiento, sin revelar secretos comerciales.

2. Lista de fuentes de datos

Es el núcleo de la plantilla, donde se detalla la procedencia de los datos de entrenamiento. Está organizada en seis categorías principales, además de una categoría residual (Otros).

-

Conjuntos de datos públicos:

-

Datos disponibles gratuitamente y descargables como un todo o en bloques (p. ej., portales de datos abiertos, Common Crawl, repositorios académicos).

-

Se deben identificar los conjuntos “grandes”, definidos como aquellos que representan más del 3% del total de datos públicos utilizados en una modalidad específica.

-

-

Conjuntos privados licenciados:

-

Datos obtenidos mediante acuerdos comerciales con titulares de derechos o sus representantes, como licencias con editoriales para el uso de libros digitales.

-

Se proporciona únicamente una descripción general.

-

-

Otros datos privados no licenciados:

-

Bases de datos adquiridas a terceros que no gestionan directamente los derechos de autor.

-

Si son públicamente conocidas, deben listarse; si no, basta una descripción general (tipo de datos, naturaleza, idiomas).

-

-

Datos obtenidos mediante web crawling/scraping:

-

Información recopilada por el proveedor o en su nombre mediante herramientas automatizadas.

-

Se debe especificar:

-

Nombre/identificador de los rastreadores.

-

Finalidad y comportamiento (respeto a robots.txt, captchas, paywalls, etc.).

-

Periodo de recogida.

-

Tipos de sitios web (medios, redes sociales, blogs, portales públicos, etc.).

-

Lista de dominios más relevantes, que cubra al menos el 10% superior por volumen. Para PYMES, este requisito se ajusta al 5% o un máximo de 1.000 dominios, lo que sea menor.

-

-

-

Datos de usuarios:

-

Información generada a través de la interacción con el modelo o con otros servicios del proveedor.

-

Se debe indicar qué servicios contribuyen y la modalidad de los datos (texto, imagen, audio, etc.).

-

-

Datos sintéticos:

-

Datos creados por o para el proveedor mediante otros modelos de IA (por ejemplo, destilación de modelos o refuerzo con retroalimentación humana - RLHF).

-

Cuando corresponda, se debe identificar el modelo generador si está disponible en el mercado.

-

Categoría adicional – Otros: incluye datos que no encajan en las categorías anteriores, como fuentes offline, digitalización propia, etiquetado manual o generación humana.

3. Aspectos del procesamiento de datos

Se centra en cómo se han gestionado los datos antes y durante el entrenamiento, con especial atención al cumplimiento legal:

-

Respeto a las reservas de derechos (Text and Data Mining, TDM): medidas adoptadas para honrar el derecho de exclusión previsto en el artículo 4(3) de la Directiva 2019/790 sobre derechos de autor, que permite a los titulares impedir la minería de textos y datos. Este derecho se ejerce mediante protocolos de opt-out, como etiquetas en archivos o configuraciones en robots.txt, que indican que ciertos contenidos no pueden usarse para entrenar modelos. Los proveedores deben explicar cómo han identificado y respetado estos opt-outs en sus propios datasets y en los adquiridos a terceros.

-

Eliminación de contenido ilegal: procedimientos utilizados para evitar o depurar contenido ilícito bajo la legislación de la UE, como material de abuso sexual infantil, contenidos terroristas o infracciones graves de propiedad intelectual. Estos mecanismos pueden incluir listas negras, clasificadores automáticos o revisión humana, pero sin revelar secretos empresariales.

El siguiente visual resumen estos tres apartados:

Equilibrio entre transparencia y secretos comerciales

La Comisión Europea ha diseñado la plantilla buscando un equilibrio delicado: ofrecer información suficiente para proteger derechos y fomentar la transparencia, sin obligar a revelar información que pueda comprometer la competitividad de los proveedores.

-

Fuentes públicas: se exige el mayor nivel de detalle, incluyendo nombres y enlaces a los conjuntos de datos “grandes”.

-

Fuentes privadas: se permite un nivel de detalle más limitado, mediante descripciones generales cuando la información no sea pública.

-

Web scraping: se requiere un listado resumido de dominios, sin necesidad de detallar combinaciones exactas.

-

Datos de usuarios y sintéticos: la información se limita a confirmar su uso y describir la modalidad.

Gracias a este enfoque, el resumen es “generalmente completo” en alcance, pero no “técnicamente detallado”, protegiendo tanto la transparencia como la propiedad intelectual y comercial de las empresas.

Cumplimiento, plazos y sanciones

El artículo 53 de la AI Act detalla las obligaciones de los proveedores de modelos de propósito general, entre las que destaca la publicación de este resumen de datos de entrenamiento.

Esta obligación se complementa con otras medidas, como:

-

Disponer de una política pública de derechos de autor.

-

Implementar procesos de evaluación y mitigación de riesgos, especialmente para modelos que puedan generar riesgos sistémicos.

-

Establecer mecanismos de trazabilidad y supervisión de los datos y procesos de entrenamiento.

El incumplimiento puede acarrear multas significativas, de hasta 15 millones de euros o el 3% de la facturación global anual de la empresa, lo que suponga una mayor cantidad.

Próximos pasos para los proveedores

Para adaptarse a esta nueva obligación, los proveedores deberían:

-

Revisar procesos internos de recopilación y gestión de datos para garantizar que la información necesaria esté disponible y sea verificable.

-

Establecer políticas claras de transparencia y derechos de autor, incluyendo protocolos para respetar el derecho de exclusión en minería de textos y datos (TDM).

-

Publicar el resumen en canales oficiales antes de la fecha límite correspondiente.

-

Actualizar el resumen periódicamente, al menos cada seis meses o cuando se produzcan cambios materiales en el entrenamiento.

La Comisión Europea, a través de la Oficina Europea de IA, supervisará el cumplimiento y podrá solicitar correcciones o imponer sanciones.

Una herramienta clave para gobernar los datos

En nuestro artículo anterior, “Gobernar los datos para gobernar la Inteligencia Artificial”, destacábamos que una IA confiable solo es posible si existe un gobierno sólido de los datos.

Esta nueva plantilla refuerza ese principio, ofreciendo un mecanismo estandarizado para describir el ciclo de vida de los datos, desde su origen hasta su tratamiento, y fomentando la interoperabilidad y la reutilización responsable.

Se trata de un paso decisivo hacia una IA más transparente, justa y alineada con los valores europeos, donde la protección de derechos y la innovación tecnológica puedan avanzar juntas.

Conclusiones