Incendio Hoy es un visor web que muestra en tiempo casi real los incendios activos en España a partir de los datos abiertos de NASA FIRMS (sensores VIIRS y MODIS). La aplicación consulta y actualiza automáticamente las detecciones (hootspots) con una cadencia de minutos y las representa en un mapa interactivo de controles sencillos. El usuario puede filtrar por rango temporal (hasta cinco días), nivel de confiabilidad (baja/media/alta) y FRP (potencia radiactiva del fuego, en MW) para centrarse en los eventos más relevantes. Al hacer clic en un punto se despliega una ficha con coordenadas, fecha/hora, sensor, intensidad (FRP) y otros detalles. Además, incluye capas opcionales de temperatura y nubosidad, y un mapa de calor para identificar agrupaciones.

El sitio web incorpora una sección de “Preguntas frecuentes” que explica conceptos clave, como diferencias entre VIIRS y MODIS, qué es FRP, el nivel de confiabilidad, las por las que el incendio puedo no aparecer o los límites de detección satelital.

La sostenibilidad ambiental y la lucha contra el cambio climático constituyen uno de los mayores desafíos globales de nuestro tiempo. Afrontarlos requiere disponer de evidencias sólidas y de información confiable que permita comprender los riesgos, realizar un seguimiento del progreso, orientar la toma de decisiones y evaluar impactos en distintos sectores. A medida que los países diseñan e implementan políticas medioambientales, de mitigación y adaptación, el acceso a datos sobre el clima se convierte en un elemento esencial para una acción climática eficaz.

En este contexto, los datos abiertos desempeñan un papel estratégico. Facilitar el acceso a datos climáticos abiertos y de calidad permite a administraciones públicas, empresas, comunidades científicas y sociedad civil planificar y vigilar un desarrollo territorial sostenible, mejorar la formulación de políticas, fomentar la colaboración entre actores y transformar el conocimiento científico en acciones concretas. Diversas iniciativas están permitiendo avanzar en la mejora de la accesibilidad, interoperabilidad y reutilización de la información climática, contribuyendo a superar la dispersión de datos y a reforzar una respuesta coordinada frente al cambio climático. A continuación, recopilamos una selección de repositorios y portales de datos abiertos sobre el clima de referencia a nivel internacional.

Figura 1. 10 repositorios de datos públicos relacionado con el clima.

Climate Data Store

- Publicador: Programa Copernicus de la Unión Europea

El Climate Data Store es el portal de datos del Servicio de Cambio Climático de Copernicus (C3S). Ofrece acceso abierto a observaciones históricas, reanálisis, indicadores climáticos y proyecciones futuras basadas en modelos, con cobertura global y regional. Incluye variables como temperaturas, precipitación, viento, radiación, hielo y nivel del mar. Proporciona herramientas integradas de visualización, procesamiento y descarga que sirven para realizar análisis climáticos y planificar políticas de mitigación y adaptación.

Climate Change Knowledge Portal (CCKP)

- Publicador: Banco Mundial

El portal de conocimiento sobre el cambio climático del Banco Mundial proporciona datos climáticos históricos y proyecciones futuras a escala global, nacional y subnacional. Incluye variables de temperatura y precipitación, así como capas geoespaciales y datos geocodificados sobre infraestructuras y asentamientos. El CCKP facilita el análisis de vulnerabilidad y riesgos climáticos a través de mapas interactivos, perfiles de país y la descarga de datos en formatos estándar.

IPCC Data Distribution Centre

- Publicador: Intergovernmental Panel on Climate Change (IPCC) de Naciones Unidas

El Centro de Distribución de Datos del Panel Intergubernamental del Cambio Climático ofrece acceso a los conjuntos de datos utilizados en los informes de evaluación del IPCC, incluyendo observaciones históricas, proyecciones climáticas, escenarios socioeconómicos e indicadores clave. El portal reúne los datos empleados en el Sexto Informe de Evaluación (AR6), publicado entre 2021 y 2023, aunque continúa incorporando conjuntos de datos complementarios y actualizados que apoyan el análisis de impactos, vulnerabilidad y adaptación al cambio climático.

Climate Change Initiative Open Data Portal

- Publicador: Agencia Espacial Europea (ESA)

A través de su programa Climate Change Initiative (CCI), la Agencia Espacial Europea ofrece en este portal acceso libre y abierto a conjuntos de datos centrados en las Variables Climáticas Esenciales (ECV), como nivel del mar, temperatura, hielo marino o cobertura terrestre. Los datos, procedentes principalmente de observaciones satelitales, están disponibles mediante descargas, mapas interactivos y servicios web, y constituyen una referencia clave para el seguimiento del clima.

Global Climate Observing System (GCOS)

- Publicador: World Meteorological Organization (WMO)

GCOS es un sistema internacional que coordina y promueve redes de observación climática para garantizar la disponibilidad de datos de alta calidad sobre la atmósfera, los océanos y la superficie terrestre. Desarrollado en colaboración con el Programa de las Naciones Unidas para el Medio Ambiente (UNEP), la Comisión Oceanográfica Intergubernamental de la UNESCO (IOC-UNESCO) y el Consejo Internacional de Ciencias, GCOS facilita el acceso a observaciones climáticas a través de las redes y sistemas asociados.

GRID-Geneva

- Publicador: Programa de las Naciones Unidas para el Medio Ambiente (UNEP)

UNEP/GRID-Geneva es un centro especializado en el análisis y visualización de datos ambientales y climáticos mediante sistemas de información geográfica, teledetección y análisis estadístico. Gestiona diversas plataformas especializadas, como MapX, una solución de código abierto para gestionar y visualizar datos geoespaciales sobre recursos naturales, una plataforma específica de datos sobre el cambio climático, o sobre alerta temprana para el medio ambiente, entre otras.

UNFCCC Documents

- Publicador: United Nations Framework Convention on Climate Change (UNFCCC)

Este portal reúne la biblioteca documental de la Convención Marco de las Naciones Unidas sobre el Cambio Climático. Permite buscar, filtrar y descargar múltiples documentos relacionados con las negociaciones climáticas internacionales, incluidas las decisiones adoptadas en las Conferencias de las Partes (COP), informes de los órganos subsidiarios, comunicaciones nacionales y otros textos relevantes en el proceso climático internacional.

FAOSTAT

- Publicador: Food and Agriculture Organization of the United Nations (FAO)

FAOSTAT es la base de datos estadísticos de acceso abierto de la organización de las Naciones Unidas para la Alimentación y la Agricultura (FAO). Contiene series temporales desde 1961 hasta la actualidad con cobertura para más de 245 países. Incluye datos climáticos y agroclimáticos orientados a analizar la relación entre el clima y los sistemas alimentarios. En concreto, ofrece indicadores como temperaturas medias, precipitaciones, evapotranspiración, anomalías climáticas y variables relacionadas con sequías y estrés hídrico.

PREPdata

- Publicador: Partnership for Resilience and Preparedness (PREP)

PREPdata es una plataforma de datos abiertos basada en mapas que permite visualizar y combinar información climática, física y socioeconómica para el análisis de vulnerabilidad y la planificación de la adaptación frente al cambio climático. Es posible crear paneles personalizados integrando datos globales con información local aportada por los propios usuarios. La iniciativa está liderada por el World Resources Institute (WRI) y Future Earth, junto con socios colaboradores públicos y privados.

Climate Data Guide

- Publicador: National Center for Atmospheric Research (NCAR)

Climate Data Guide ofrece descripciones, comparativas y recomendaciones de expertos sobre conjuntos de datos climáticos ampliamente utilizados en investigación. Organiza los recursos en siete categorías: atmósfera, índices climáticos, criosfera, tierra, océano, paleoclima y reanálisis. Esta plataforma destaca por ofrecer orientación y ayudar a los usuarios a comprender qué datos existen, cómo se generan, qué limitaciones tienen y dónde acceder a ellos.

Esta es una recopilación de repositorios de datos abiertos relacionados con el clima, pero existen otros que pueden resultar de interés. ¿Cuáles añadirías a este listado? Déjanos un comentario.

La web Smart Agro–Recomendaciones de Riego es una plataforma gratuita desarrollada por el Cabildo de La Palma como parte del proyecto La Palma Smart Island. Su objetivo es mejorar la eficiencia del uso del agua en la agricultura local, especialmente para cultivos de plátano y aguacate.

Para obtener una recomendación personalizada, el usuario debe seleccionar un cultivo y una zona de la isla a través de un desplegable o sobre el mapa. En vez hecho esto, la aplicación:

- Proporciona gráficos detallados que muestran la evolución reciente de la precipitación y la evapotranspiración (ETo) en los últimos 7 días en la zona seleccionada.

- Genera recomendaciones de riego ajustadas al municipio y las condiciones climáticas locales.

Para realizar los cálculos, se utilizan los datos de la red insular de estaciones meteorológicas y de calidad del aire, junto a un motor de cálculo que procesa la información para generar las recomendaciones semanales. Asimismo, los datos generados por este motor se integran en el portal de datos abiertos, promoviendo un ecosistema de innovación abierto que se retroalimenta.

CLIMA TERRA es una aplicación web progresiva (PWA) que ofrece información ambiental en tiempo real de forma clara y accesible. Permite al usuario conocer parámetros clave como la temperatura, humedad relativa, velocidad del viento e índice UV, a partir de datos abiertos meteorológicos y geoespaciales.

La app ha sido diseñada con un enfoque minimalista y bilingüe (español/inglés), con el objetivo de acercar los datos abiertos a la ciudadanía y fomentar decisiones cotidianas más informadas y sostenibles.

embalses.info es una plataforma web que proporciona información actualizada sobre el estado de los embalses y pantanos de España. La aplicación ofrece datos hidrológicos en tiempo real con actualizaciones semanales, permitiendo a ciudadanos, investigadores y gestores públicos consultar niveles de agua, capacidades y evoluciones históricas de más de 400 embalses organizados en 16 cuencas hidrográficas.

La aplicación cuenta con un dashboard interactivo que muestra el estado general de los embalses españoles, un mapa interactivo (próximamente) de cuencas con niveles de llenado, y páginas detalladas para cada embalse con gráficos de evolución semanal, comparativas con años anteriores, e históricos desde los años 80. Incluye un potente buscador, análisis de datos con gráficos interactivos, y un formulario de contacto para sugerencias.

Desde el punto de vista técnico, la plataforma utiliza Next.js 14+ con TypeScript en el frontend, Prisma ORM para acceso a datos, y PostgreSQL/SQL Server como base de datos. Está optimizada para SEO con sitemap XML dinámico, meta tags optimizados, datos estructurados y URLs amigables. El sitio es completamente responsive, accesible y cuenta con tema claro/oscuro automático.

El valor público de la aplicación radica en proporcionar transparencia e información accesible sobre los recursos hídricos españoles, permitiendo a agricultores, administraciones, investigadores y medios de comunicación tomar decisiones informadas basadas en datos confiables y actualizados.

En este episodio hablamos de medio ambiente, centrándonos en el papel que juegan los datos en la transición ecológica ¿Pueden los datos abiertos ayudar a impulsar la sostenibilidad y proteger el planeta? Lo descubrimos con nuestros dos invitados:

- Francisco José Martínez García, director conservador de los parques naturales del sur de Alicante.

- José Norberto Mazón, catedrático de lenguajes y sistemas informáticos de la Universidad de Alicante.

Resumen / Transcripción de la entrevista

1. Los dos sois unos apasionados del uso de los datos en pro de la sociedad, ¿cómo descubristeis el potencial de los datos abiertos para la gestión del medio ambiente?

Francisco José Martínez: Yo, por mi parte, te puedo decir que cuando llegué a la administración pública, a la Generalitat Valenciana, la Generalitat puso en marcha un visor que se llama Visor Gva, que es abierto, que da mucha información de imágenes, de metadatos, de datos en diversos campos… y la verdad es que me facilitó muchísimo -y me sigue facilitando- el trabajo en la resolución de expedientes y el trabajo propio de un funcionario. Después también se incorporó otra base de datos que es el Banco de Datos de Biodiversidad, que ofrece datos en cuadrículas de un kilómetro por un kilómetro. Y finalmente, ya aplicado a los espacios naturales y humedales que yo dirijo, datos de calidad de aguas, todos ellos están en abierto y pueden ser objeto de generar investigación aplicada por parte de todos los investigadores.

Jose Norberto Mazón: En mi caso, fue precisamente con Francisco como director. Él dirige tres parques naturales que son humedales del sur de Alicante y sobre uno de ellos, en el que teníamos especial interés, que es el Parque Natural de la Laguna de la Mata y Torrevieja, Francisco nos comentó su experiencia -toda esta experiencia que acaba de comentar-. Nosotros en la Universidad de Alicante llevamos tiempo trabajando en gestión de datos, datos abiertos, interoperabilidad de datos, etcétera, y vimos la oportunidad de hacer una perspectiva de gestión del dato, de generación del dato y de reutilización del dato desde el territorio, desde el propio Parque Natural. Junto con otras entidades como Proyecto Mastral, Faunatura, AGAMED, y también compañeros y compañeras de la Universidad Politécnica de Valencia, vimos la posibilidad de estudiar esos datos de utilidad, poniendo el foco sobre todo en el concepto de datos de alto valor, que desde la Unión Europea se estaba apostando por ellos: esos datos que tienen potencial para generar beneficios socioeconómicos o medioambientales, beneficiar a todos los usuarios y contribuir a hacer una sociedad europea basada en la economía del dato. Y bueno, nos pusimos ahí a ver cómo podíamos colaborar, sobre todo para descubrir ese potencial de los datos a nivel de territorio.

2. A través de una estrategia llamada el Pacto verde, la Unión Europea aspira a convertirse en la primera economía del mundo competitiva y eficiente en el uso de los recursos, logrando emisiones netas de gases de efecto invernadero cero para 2050. ¿Qué medidas concretas son más urgentes para lograrlo y cómo pueden ayudar los datos a alcanzar estas metas? ¿Qué proyectos se están impulsando desde Europa para ello?

Francisco José Martínez: La Unión Europea tiene varias líneas, varios proyectos como el proyecto LIFE, enfocado a especies en peligro de extinción, los fondos FEDER para restaurar hábitats… Aquí en la Laguna de la Mata y Torrevieja, los hábitats terrestres los hemos mejorado con estos fondos FEDER y se trata precisamente de que esos hábitats sean mejores captadores de CO2 y se generen comunidades vegetales más autóctonas, eliminando las especies invasoras. Luego también tenemos el reglamento, a nivel normativo, de restauración de la naturaleza, que está en vigor desde 2024, y que nos obliga a restaurar hasta un 30 % de los ecosistemas terrestres y marinos degradados. He de decir también que la Fundación Biodiversidad, dependiente del Ministerio, genera bastantes proyectos relacionados, por ejemplo, con la generación de refugios climáticos en zonas urbanas. O sea, hay una serie de proyectos y bastante financiación en todo lo que tiene que ver con la renaturalización, la mejora de hábitats y la conservación de especies.

Jose Norberto Mazón: Yo me centraría también, por complementar lo que ha dicho Francisco, en toda la gestión del dato, la importancia que se le da a la gestión del dato a nivel de Pacto Verde Europeo, en concreto con proyectos de compartición de datos, de hacer los datos más interoperables. Es decir que, al final, todos aquellos actores que generen datos puedan ser de utilidad mediante su combinación y generar mucho más valor en lo que se denominan espacios de datos y sobre todo en el espacio de datos del Pacto Verde Europeo. Recientemente, además, acaban de terminar unos proyectos iniciales. Por ejemplo, por resaltar un par de ellos, el proyecto USAGE (Urban Data Spaces for Green dEal), que lo voy a comentar con dos pilotos concretos que han desarrollado muy interesantes. Uno sobre cómo se tiene que introducir todo lo que tiene que ver con datos para mitigar el cambio climático en la gestión urbanística en la ciudad de Ferrara, en Italia. Y otro piloto sobre la gobernanza del dato y cómo se tiene que hacer para que se cumplan los principios FAIR, en este caso en Zaragoza, con un concepto de islas climáticas también muy interesante. Y luego hay otro proyecto, el AD4GD (All Data for Green Deal) que ha hecho también pilotos en relación de esa interoperabilidad del dato. En este caso, en la Red de Lagos de Berlín. Berlín tiene como 300 lagos a los que tienen que monitorizar la calidad del agua, la cantidad de agua, etc. y se ha hecho a través de sensorización. La gestión de corredores biológicos en Cataluña, también, con datos de cómo se mueven las especies y cómo es necesario gestionar esos corredores biológicos. Y también han hecho alguna iniciativa de calidad del aire con ciencia ciudadana. Estos proyectos han finalizado ya, pero hay un proyecto súper interesante a nivel europeo que es el que va a poner en marcha ese gran espacio de datos del pacto europeo, que es el proyecto SAGE (Sustainable Green Europe Data Space), que está desarrollando diez casos de uso que engloban todo ese gran ámbito del Pacto Verde Europeo. En concreto, por resaltar uno que es muy pertinente, porque está alineado con lo que son los parques naturales, los humedales del sur de Alicante y que Francisco dirige, es el de los compromisos entre la naturaleza y los servicios ecosistémicos. Es decir, cómo hay que proteger la naturaleza, cómo tenemos que conservar, pero también tenemos que permitir esas actividades socioeconómicas de manera sostenible. Este espacio de datos va a integrar teledetección, modelos basados en inteligencia artificial, datos, etc.

3. ¿Querrías añadir algún otro proyecto a este nivel local o regional?

Francisco José Martínez: Sí, claro. Bueno, el que hemos realizado con Norberto, su equipo y varios equipos, varios departamentos de la Universidad Politécnica de Valencia y de la Universidad de Alicante, y es el gemelo digital. Se ha estado realizando una investigación para la generación de un gemelo digital en el Parque Natural de las Lagunas, aquí en Torrevieja. Y la verdad es que ha sido una investigación aplicada, se han generado muchos datos a partir de sensores, también de observaciones directas o de grabadoras de imágenes y de sonidos. Se ha hecho un buen registro de información a nivel de ruidos, de clima, de datos meteorológicos para poder realizar una buena gestión y que sea una ayuda inestimable para la gestión de los que tenemos que tomar decisiones día a día. Otros datos que también se han realizado en este proyecto aquí local, ha sido la recopilación de datos de carácter social, de uso turístico, de sentimiento de las personas (si están de acuerdo con lo que ven en el espacio natural o no). Es decir, hemos mejorado el conocimiento de este espacio natural gracias a este gemelo digital y esa es una información que no nos puede aportar ni nuestro visor ni el Banco de Datos de Biodiversidad.

Jose Norberto Mazón: Hablaba Francisco, por ejemplo, del conocimiento de las personas, de la afluencia de personas de determinadas zonas del parque natural. Y saber también lo que sienten, lo que piensan las personas que lo visitan, pues si no es a través de encuestas que son muy farragosas, etcétera es complicado. Nosotros hemos puesto al servicio de descubrir ese conocimiento, este gemelo digital con multitud de esa sensorización y con datos que al final también son interoperables y que permiten conocer muy bien el territorio. Evidentemente que sea territorial no significa que no sea escalable. Lo que estamos haciendo con el proyecto de gemelo digital, el proyecto ChanTwin, lo que hacemos es que se pueda volcar o que se pueda extrapolar a cualquier otra área natural, porque las problemáticas que hemos tenido al final las vamos a encontrar en cualquier área natural, como por ejemplo, problemas de conectividad, problemas de interoperabilidad de datos que vienen de sensores, etc. Sensores tenemos de muchos tipos, de afluencia de personas, de la calidad del agua, de temperaturas y variables climáticas, contaminación, etc. y al final además con todas las garantías de privacidad de datos. Esto lo tengo que decir, que es muy importante porque siempre intentamos que esa recolección de datos, por supuesto, garantice la privacidad de las personas. Podemos conocer las inquietudes de la gente que visita el parque y también, por ejemplo, la procedencia de esas personas. Y esto es una información muy interesante a nivel de dirección del parque, porque así, por ejemplo, Francisco puede tomar unas decisiones más informadas para gestionar mejor el parque. Pero, las personas que visitan el parque vienen de un municipio concreto, con un ayuntamiento que, por ejemplo, tiene una concejalía de Medio Ambiente o tiene una concejalía de Turismo. Y esa información puede ser muy interesante para poner en valor determinados aspectos, por ejemplo, medioambientales, de biodiversidad, o de actividad socioeconómica.

Francisco José Martínez: Los datos son fundamentales en la gestión del medio natural de un humedal, de una montaña, de un bosque, de un pastizal... en general de todos los espacios naturales. Fíjate que solo con el seguimiento y monitoreo de determinados parámetros ambientales nos sirven para dar explicación de eventos que pueden suceder, por ejemplo, una mortandad de peces. Sin haber tenido el histórico de los datos de oxígeno disuelto de temperatura, es muy difícil saber si es por eso o por un contaminante. Por ejemplo, la temperatura de las aguas, que está relacionada con el oxígeno disuelto: a más temperatura, menos oxígeno disuelto. Y sin oxígeno, resulta que aparecen en primavera verano -de acuerdo, como sean las temperaturas ambientales, se traslada al agua, a las lagunas, a los humedales-, aparece una enfermedad que es el botulismo y ya ha habido dos años que se nos han muerto cada año más de mil animales. La manera de controlarlo es previendo que esas temperaturas van a llegar a una concreta, que a partir de ahí el oxígeno casi desaparece de las aguas y nos da tiempo a planificar los equipos de trabajo que van retirando los cadáveres, que es la actuación fundamental para evitarla. Otro, por ejemplo, son los censos mensuales de aves acuáticas, que se observan de forma presencial, que se registran, que también tenemos grabadoras que registran sonidos. Podemos con eso conocer la dinámica cuando vienen las especies en migración y con eso también podemos hacer gestión de las aguas. Otro ejemplo puede ser el de la temperatura de la laguna de aquí de la Mata, que con el gemelo digital estamos haciendo un seguimiento, pues sabemos que cuando llega casi a treinta grados, el principal alimento de las aves desaparece, que es la artemia salina, porque no pueden vivir en esas temperaturas extremas con esa salinidad. pero sí podemos meter agua del mar, que a pesar de que ha estado muy caliente estas últimas primaveras y veranos, siempre está más fresca y podemos refrescar y alargar la vida de esta especie que precisamente se sincroniza con la reproducción de las aves. Entonces podemos hacer gestión de las aguas gracias al seguimiento y gracias a los datos que tenemos de las temperaturas de las aguas.

Jose Norberto Mazón: Fijaos la importancia de estos ejemplos que decía Francisco, que son paradigmáticos y de la importancia también del uso de los datos. Yo añadiría una cuestión simplemente que al final estos datos, el esfuerzo es ponerlos todos en abierto y que cumplan esos principios FAIR, es decir, que sean interoperables, porque como hemos oído que ha comentado Francisco, son datos de muchas fuentes, cada uno con características diferentes, recopilados de maneras diferentes, etc. Nos está hablando de datos de sensores, pero también otros datos que se recopilan de otra manera. Y luego también que nos permiten de alguna manera empezar a hacer procesos de cocreación de herramientas que utilicen estos datos a varios niveles. Por supuesto, a nivel de gestión del propio parque natural para tomar decisiones informadas, pero también a nivel de ciudadanía, incluso a nivel también de otro tipo de profesionales. Como bien decía Francisco, en los parques, en estos humedales se hacen actividades económicas y por lo tanto también el poder cocrear herramientas con esos actores o con el propio personal investigador de universidades es muy interesante. Y aquí siempre de lo que se trata es de fomentar que haya terceras personas, tanto físicas como jurídicas, por ejemplo, empresas o startups, personas emprendedoras, etc. que realicen diversas aplicaciones y servicios de valor añadido con esos datos: que diseñen herramientas fáciles de usar para la toma de decisiones, por ejemplo, o cualquier otro tipo de herramientas. Esto sería muy interesante, porque nos daría también un ecosistema de emprendimiento alrededor de esos datos. Y esto también lo que haría es que la propia sociedad se implicara más a partir de esos datos abiertos, a partir de la reutilización de datos abiertos, en un cuidado medioambiental y una concienciación medioambiental.

4. Un aspecto importante de esta transición es que debe ser “justa y no dejar a nadie atrás”. ¿Qué papel pueden jugar los datos para garantizar esa equidad?

Francisco José Martínez: En nuestro caso, nosotros venimos realizando con los técnicos de Educación y Divulgación Ambiental actuaciones de ciencia ciudadana. Vamos recopilando datos con personas que se apuntan a estas actividades. Hacemos dos actividades al mes y, por ejemplo, hemos realizado censos de murciélagos de distintas especias - porque uno ve los murciélagos y no distingue la especie, a veces ni los ve- en rutas nocturnas, para detectarlos y registrarlos. También hemos hecho actividades de grabación de fototrampeo para detectar mamíferos muy difíciles de ver. Con eso conseguimos que los niños, las niñas, las familias, la gente en general conozca una fauna que no sabe que existe cuando va caminando por la montaña. Y yo considero que llegamos a mucha gente y que estamos divulgando a la mayor cantidad de personas, de sectores posibles.

Jose Norberto Mazón: Y a partir de esos datos, de hecho, fijaos toda la cantidad de datos que está hablando Francisco. A partir de ahí, y fomentando esa línea que Francisco sigue como director de los Parques Naturales del sur de Alicante, lo que nos planteamos es: ¿podemos ir un paso más allá usando la tecnología? Y hemos hecho videojuegos que posibilitan tener más concienciación a esos grupos objetivo a los que a lo mejor de otra manera es muy difícil llegar. Por ejemplo, a adolescentes, a los que hay que inculcarles de alguna manera ese comportamiento, esa importancia también de los parques naturales. Y pensamos que los videojuegos pueden ser un canal muy interesante. ¿Y cómo lo hemos hecho? Basando esos videojuegos en datos, en datos que vienen de esto que ha comentado Francisco y también de los datos del propio gemelo digital. Es decir, datos que tenemos de la lámina de agua, de los niveles de ruido… Todos esos datos los incluimos en los videojuegos. Son videojuegos dinámicos que permiten de alguna manera tener una mejor concienciación de lo que es el parque natural y de los valores medioambientales y de conservación de la biodiversidad.

5. Nos lleváis un rato hablando de todos los datos que utilizáis, que al final provienen de diversas fuentes. ¿Nos resumirnos ese tipo de datos que utilizáis en vuestro día a día y cuáles son los retos que os encontráis a la hora de integrarlos en proyectos concretos?

Francisco José Martínez: Los datos vienen a ser espaciales, son imágenes con sus metadatos, censos de aves, de mamíferos, de los distintos grupos taxonómicos, de la fauna, de la flora… También realizamos inventarios de flora protegida en peligro de extinción. Datos meteorológicos fundamentales que, por cierto, también son muy importantes a la hora del tema de la protección civil. Fíjate todos los desastres que hay con las gotas frías o DANA. Datos muy importantes como son los de la calidad de aguas, datos físicos y químicos, altura de la lámina de agua que nos sirve para conocer la evaporación, las curvas de evaporación y con eso gestionar las entradas de agua y por supuesto, los datos de carácter social de carácter de uso público. Porque el uso público es muy importante en los espacios naturales. Es una manera de abrir a la ciudadanía, a las personas para que puedan conocer sus recursos naturales y conocerlos, valorarlos y de esa manera protegerlos. En cuanto a la dificultad, es verdad que hay una serie de datos, especialmente cuando se realizan investigaciones que a los que no podemos acceder. Están en repositorios para los técnicos que estamos en la administración o incluso para los consultores difíciles de acceder. Esto yo creo que Norberto lo puede explicar mejor: cómo se podría integrar esto si en plataformas, por sectores, por grupos…

Jose Norberto Mazón: De hecho, es un tema nuclear para nosotros. Al final hay muchos datos abiertos, como ha explicado Francisco durante todo este ratito que llevamos hablando, pero es verdad que están muy dispersos porque también se generan para cumplir diversos objetivos. Al final el objetivo principal de los datos abiertos es que se reutilicen, es decir, que se usen para fines diferentes de los que fueron concedidos inicialmente. Pero lo que nos encontramos es que al final hay muchas propuestas que son, como diríamos, de arriba hacia abajo (muy top down). Pero verdaderamente, donde está la problemática es en el territorio, desde abajo, en todos los actores implicados en el territorio, que aparte muchos datos se generan en el propio territorio. Es decir, es verdad que hay datos, por ejemplo, datos satelitales con teledetección, que los generan los propios satélites y luego nosotros los reutilizamos, pero luego los datos que vienen de sensores o los datos que vienen de ciencia ciudadana, etc. se generan en el propio territorio. Y nos encontramos que muchas veces, al final esos datos, por ejemplo, si hay personal investigador que hace un trabajo en un parque natural concreto, pues evidentemente ese equipo de investigación publica sus artículos y sus datos en abierto (porque por la ley de la ciencia tienen que publicarlos en abierto en repositorios). Pero claro, eso está muy orientado a la investigación. Entonces, los demás tipos de actores, por ejemplo, la dirección del parque, los gestores de una entidad local o incluso la propia ciudadanía, no tienen conciencia a lo mejor de que esos datos están disponibles y ni siquiera tienen mecanismos para consultarlos y obtener valor de ellos. La dificultad mayor, de hecho, está en esto, en que los datos que se generen desde el territorio se reutilicen desde el territorio. Es muy fácil reutilizarlos desde el territorio para solventar esos problemas también. Y esa dificultad es la que nosotros estamos intentando atajar con estos proyectos que tenemos en marcha, de momento con la creación de un data Lake, de una arquitectura de datos que nos permita gestionar toda esa heterogeneidad de los datos y hacerlo desde el territorio. Pero claro, aquí lo que tenemos que hacer verdaderamente es intentar hacerlo de manera federada, con esa filosofía de datos abiertos a nivel federado y además con un plus también, porque es verdad que la casuística dentro del territorio es muy grande. Hay multitud de actores, porque estamos hablando de datos abiertos, pero puede haber actores también que digan “yo quiero compartir ciertos datos, pero otros ciertos datos todavía no, porque puedo perder cierta competitividad, pero no me importaría dentro de tres meses poder compartirlos”. Es decir, hay que tener también un control sobre cierta tipología de datos y que convivan datos abiertos con otra tipología de datos que puedan ser compartidos. A lo mejor no de manera tan amplia, pero sí de manera, digamos, aportando gran valor. Estamos viendo esta posibilidad con un nuevo proyecto que estamos creando: un espacio de datos medioambientales, de biodiversidad en estos tres parques naturales del sur de la provinciade Alicante, y estamos con ese proyecto: Heleade.

Si quieres saber más sobre estos proyectos, te invitamos a visitar sus páginas web:

Clips de la entrevista

1. ¿Cómo se planteó el gemelo digital del Parque Natural de las Lagunas de Torrevieja?

2. ¿Qué proyectos se están impulsando en el marco del Espacio de Datos del Pacto Verde europeo?

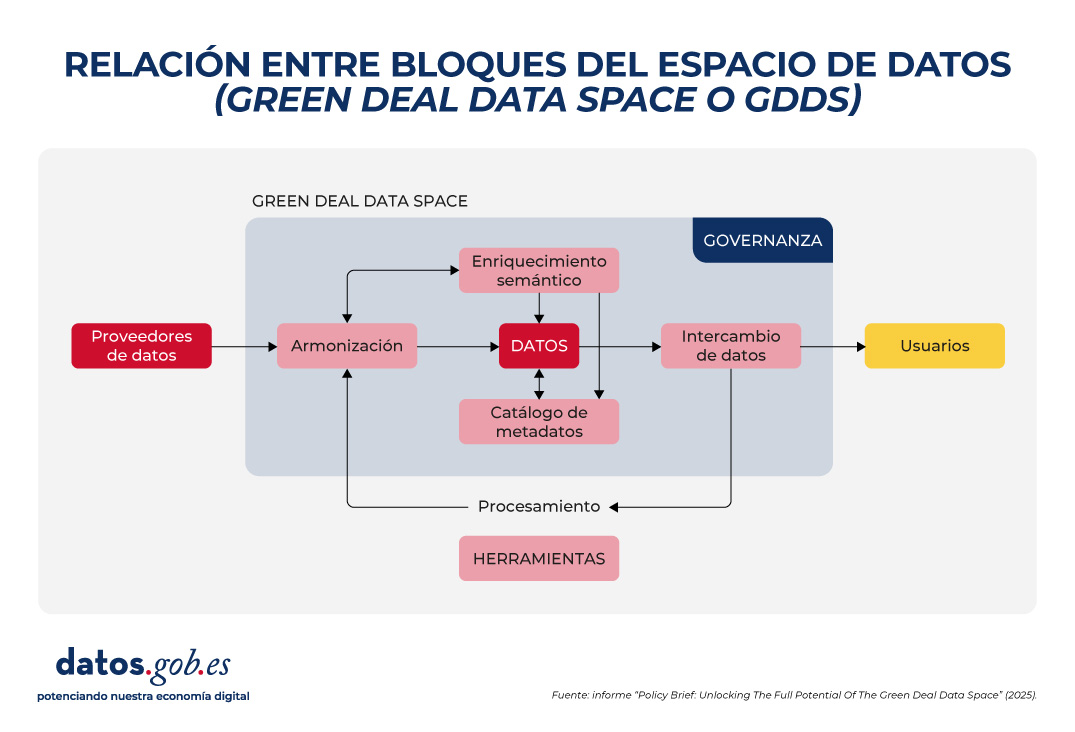

Para alcanzar sus objetivos de sostenibilidad medioambiental, Europa necesita información precisa, accesible y actualizada que permita tomar decisiones basadas en evidencias. El Espacio de Datos del Pacto Verde (Green Deal Data Space o GDDS) facilitará esta transformación al integrar diversas fuentes de datos en una infraestructura digital común, interoperable y abierta.

Desde Europa, se está trabajando en su desarrollo a través de diversos proyectos, que han permitido obtener recomendaciones y buenas prácticas para su implementación. ¡Descúbrelas en este artículo!

¿Qué es el Green Deal Data Space?

El Green Deal Data Space (GDDS) es una iniciativa de la Comisión Europea para crear un ecosistema digital que reúna datos de múltiples sectores. Su fin es apoyar y acelerar los objetivos del Pacto Verde: la hoja de ruta de la Unión Europea para lograr una economía sostenible, climáticamente neutra y justa. Los pilares del Pacto Verde incluyen:

- Una transición energética que reduzca las emisiones y mejore la eficiencia.

- El fomento de la economía circular, promoviendo el reciclaje, la reutilización y la reparación de productos para minimizar residuos.

- El impulso de prácticas agrícolas más sostenibles.

- La restauración de la naturaleza y la biodiversidad, protegiendo hábitats naturales y reduciendo la contaminación de aire, agua y suelo.

- La garantía de la justicia social, a través de una transición que facilite que ningún país o comunidad quede atrás.

A través de esta estrategia integral, la UE aspira a convertirse en la primera economía del mundo competitiva y eficiente en el uso de los recursos, logrando emisiones netas de gases de efecto invernadero cero para 2050. El Espacio de Datos del Pacto Verde se posiciona como una herramienta clave para alcanzar estos objetivos. Integrados en la Estrategia Europea del Dato, los espacios de datos son entornos digitales que permite el intercambio fiable de datos, al tiempo que se mantiene la soberanía y se garantiza la confianza y la seguridad en virtud de un conjunto de normas acordadas mutuamente.

En este caso concreto, el GDDS integrará datos de gran valor sobre biodiversidad, contaminación cero, economía circular, cambio climático, servicios forestales, movilidad inteligente y cumplimiento medioambiental. Estos datos serán fáciles de localizar, interoperables, accesibles y reutilizables bajo los principios FAIR (Findability, Accessibility, Interoperability, Reusability).

El GDDS se implementará a través del proyecto SAGE (Espacio de datos para una Europa verde y sostenible) y se basará en los resultados de la iniciativa GREAT (Gobernanza de la innovación responsable).

Un informe con recomendaciones para el GDDS

Como vimos en un artículo anterior, cuatro proyectos pioneros están sentando las bases de este ecosistema: AD4GD, B-Cubed, FAIRiCUBE y USAGE. Estos proyectos, financiados en el marco de la convocatoria HORIZON, han analizado y documentado durante varios años los requisitos necesarios para garantizar que el GDDS siga los principios FAIR. Fruto de ese trabajo, se ha elaborado el informe “Policy Brief: Unlocking The Full Potential Of The Green Deal Data Space”. Se trata de un conjunto de recomendaciones que buscan servir de guía para la implementación exitosa del Espacio de Datos del Pacto Verde.

El informe destaca cinco grandes áreas en las que se concentran los desafíos de la construcción del GDDS:

1. Armonización de datos

Los datos ambientales son heterogéneos, ya que provienen de distintas fuentes: satélites, sensores, estaciones meteorológicas, registros de biodiversidad, empresas privadas, institutos de investigación, etc. Cada proveedor utiliza sus propios formatos, escalas y metodologías. Esto provoca incompatibilidades que dificultan la comparación y la combinación de datos. Para solucionarlo, es esencial:

- Adoptar estándares y vocabularios internacionales ya existentes, como INSPIRE, que abracan múltiples ámbitos temáticos.

- Evitar formatos propietarios, primando aquellos abiertos y bien documentados.

- Invertir en herramientas que permitan transformar datos de un formato a otro de forma sencilla.

2. Interoperabilidad semántica

Garantizar la interoperabilidad semántica es crucial para que los datos puedan entenderse y reutilizarse en diferentes contextos y disciplinas, algo fundamental cuando se comparten datos entre comunidades tan diversas como las que participan en los objetivos del Pacto Verde. A ello hay que sumar que la Ley de Datos (Data Act) obliga a que los participantes en espacios de datos ofrezcan descripciones legibles por máquinas de los datasets, garantizando así su localización, acceso y reutilización. Además, exige que los vocabularios, taxonomías y listas de códigos empleados estén documentados de forma pública y coherente. Para lograrlo es necesario:

- Usar datos enlazados (linked data) y metadatos que ofrezcan conceptos claros y compartidos, a través de vocabularios, ontologías y estándares como los desarrollados por el OGC o las normas ISO.

- Usar los estándares que ya existen para organizar y describir los datos, y solo crear extensiones nuevas cuando sea realmente necesario.

- Mejorar los vocabularios internacionales ya aceptados, dándoles más precisión y aprovechando que las comunidades científicas ya los utilizan ampliamente.

3. Metadatos y curación de datos

Los datos solo alcanzan su máximo valor si están acompañados de metadatos claros que expliquen su origen, calidad, restricciones de uso y condiciones de acceso. Sin embargo, la gestión deficiente de metadatos sigue siendo una barrera importante. En muchos casos, los metadatos son inexistentes, están incompletos o mal estructurados, y a menudo se pierden al traducirse entre estándares no interoperables. Para mejorar esta situación se debe:

- Ampliar los estándares de metadatos existentes para incluir elementos críticos como observaciones, mediciones, trazabilidad de origen, etc.

- Fomentar la interoperabilidad entre estándares de metadatos en uso, mediante herramientas de mapeo y transformación que respondan tanto a las necesidades de datos comerciales como abiertos.

- Reconocer y financiar la creación y mantenimiento de metadatos en proyectos europeos, incorporando la obligación de generar un catálogo estandarizado desde el inicio en los planes de gestión de datos.

4. Intercambio de datos y provisión federada

El GDDS no busca solo centralizar toda la información en un solo repositorio, sino permitir que múltiples actores compartan datos de manera federada y segura. Por tanto, es necesario conseguir un equilibrio entre el acceso abierto y la protección de derechos y privacidad. Para ello se requiere:

- Adoptar y promover tecnologías abiertas y fáciles de usar, que permitan la integración entre datos abiertos y protegidos, cumpliendo con el Reglamento General de Protección de Datos (RGPD).

- Garantizar la integración de diversas API utilizadas por los proveedores de datos y las comunidades de usuarios, acompañadas de demostradores y directrices claras. No obstante, es necesario impulsar el uso de API estandarizadas para facilitar una implantación más fluida, como por ejemplo, las API de OGC (Open Geospatial Consortium) para activos geoespaciales.

- Ofrecer herramientas de conversión y especificaciones claras para permitir la interoperabilidad entre API y formatos de datos.

En paralelo al desarrollo del Eclipse Dataspace Connectors (una tecnología de código abierto para facilitar la creación de espacios de datos), se propone explorar alternativas como catálogos en blockchain o certificados digitales, siguiendo ejemplos como el sistema FACTS (Federated Agile Collaborative Trusted System).

5. Gobernanza inclusiva y sostenible

El éxito del GDDS dependerá de establecer un marco de gobernanza sólido que garantice transparencia, participación y sostenibilidad a largo plazo. No se trata solo de normas técnicas, sino también de reglas justas y representativas. Para avanzar en ello es clave:

- Usar exclusivamente nubes europeas para asegurar la soberanía de los datos, reforzar la seguridad y cumplir con la normativa de la UE, algo que cobra especial importancia ante los desafíos globales actuales.

- Integrar plataformas abiertas como Copernicus, el Portal Europeo de Datos e INSPIRE en el GDDS fortalece la interoperabilidad y facilita el acceso a datos públicos. En este sentido, es necesario diseñar estrategias eficaces para atraer proveedores de datos abiertos y evitar que el GDDS se convierta en un entorno comercial o restringido.

- Obligar a citar los datos en publicaciones académicas financiadas con fondos públicos aumenta su visibilidad y apoyar iniciativas de estandarización fortalece la visibilidad de los datos y asegura su mantenimiento a largo plazo.

- Ofrecer formación integral y promover el uso cruzado de herramientas de armonización evita la creación de nuevos silos de datos y mejora la colaboración entre dominios.

La siguiente imagen resume la relación entre estos bloques:

Conclusión

Todas estas recomendaciones inciden en una idea central: construir un Espacio de Datos del Pacto Verde que cumpla con los principios FAIR no solo es una cuestión técnica, sino también estratégica y ética. Requiere colaboración entre sectores, compromiso político, inversión en capacidades y una gobernanza inclusiva que garantice la equidad y la sostenibilidad. Si Europa logra consolidar este ecosistema digital, estará mejor preparada para afrontar los desafíos medioambientales con decisiones informadas, transparentes y orientadas al bien común.

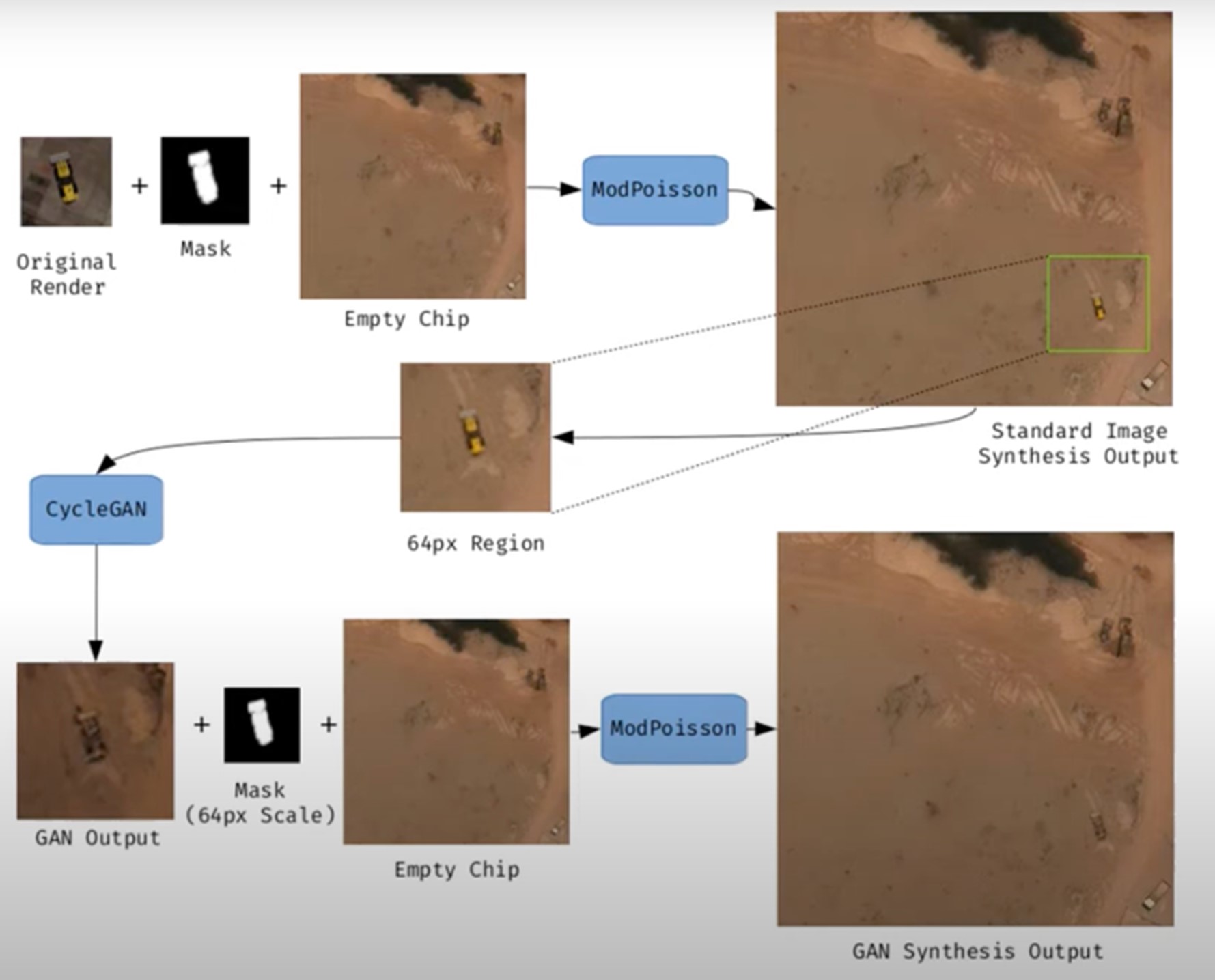

Las imágenes sintéticas son representaciones visuales generadas de forma artificial mediante algoritmos y técnicas computacionales, en lugar de capturarse directamente de la realidad con cámaras o sensores. Se producen a partir de distintos métodos, entre los que destacan las redes generativas antagónicas (Generative Adversarial Networks, GAN), los modelos de difusión, y las técnicas de renderizado 3D. Todas ellas permiten crear imágenes de apariencia realista que en muchos casos resultan indistinguibles de una fotografía auténtica.

Cuando se traslada este concepto al campo de la observación de la Tierra, hablamos de imágenes satelitales sintéticas. Estas no se obtienen a partir de un sensor espacial que capta radiación electromagnética real, sino que se generan digitalmente para simular lo que vería un satélite desde la órbita. En otras palabras, en vez de reflejar directamente el estado físico del terreno o la atmósfera en un momento concreto, son construcciones computacionales capaces de imitar el aspecto de una imagen satelital real.

El desarrollo de este tipo de imágenes responde a necesidades prácticas. Los sistemas de inteligencia artificial que procesan datos de teledetección requieren conjuntos muy amplios y variados de imágenes. Las imágenes sintéticas permiten, por ejemplo, recrear zonas de la Tierra poco observadas, simular desastres naturales -como incendios forestales, inundaciones o sequías- o generar condiciones específicas que son difíciles o costosas de capturar en la práctica. De este modo, constituyen un recurso valioso para entrenar algoritmos de detección y predicción en agricultura, gestión de emergencias, urbanismo o monitorización ambiental.

Figura 1. Ejemplo de generación de una imagen satelital sintética.

Su valor no se limita al entrenamiento de modelos. Allí donde no existen imágenes de alta resolución —por limitaciones técnicas, restricciones de acceso o motivos económicos—, la síntesis permite rellenar huecos de información y facilitar estudios preliminares. Por ejemplo, los investigadores pueden trabajar con imágenes sintéticas aproximadas para diseñar modelos de riesgo o simulaciones antes de disponer de datos reales.

Sin embargo, las imágenes satelitales sintéticas también plantean riesgos importantes. La posibilidad de generar escenas muy realistas abre la puerta a la manipulación y a la desinformación. En un contexto geopolítico, una imagen que muestre tropas inexistentes o infraestructuras destruidas podría influir en decisiones estratégicas o en la opinión pública internacional. En el terreno ambiental, se podrían difundir imágenes manipuladas para exagerar o minimizar impactos de fenómenos como la deforestación o el deshielo, con efectos directos en políticas y mercados.

Por ello, conviene diferenciar dos usos muy distintos. El primero es el uso como apoyo, cuando las imágenes sintéticas complementan a las reales para entrenar modelos o realizar simulaciones. El segundo es el uso como falsificación, cuando se presentan deliberadamente como imágenes auténticas con el fin de engañar. Mientras el primer uso impulsa la innovación, el segundo amenaza la confianza en los datos satelitales y plantea un reto urgente de autenticidad y gobernanza.

Riesgos de las imágenes satelitales aplicada a la observación de la Tierra

Las imágenes satelitales sintéticas plantean riesgos significativos cuando se utilizan en vez de imágenes captadas por sensores reales. A continuación, se detallan ejemplos que lo demuestran.

Un nuevo frente de desinformación: “deepfake geography”

El término deepfake geography ya se ha consolidado en la literatura académica y divulgativa para describir imágenes satelitales ficticias, manipuladas con IA, que parecen auténticas, pero no reflejan ninguna realidad existente. Una investigación de la Universidad de Washington, liderada por Bo Zhao, utilizó algoritmos como CycleGAN para modificar imágenes de ciudades reales -por ejemplo, alterando la apariencia de Seattle con edificios inexistentes o transformando Beijing en zonas verdes- lo que pone en evidencia el potencial para generar paisajes falsos convincentes.

Un artículo de la plataforma OnGeo Intelligence (OGC) subraya que estas imágenes no son puramente teóricas, sino amenazas reales que afectan a la seguridad nacional, el periodismo y el trabajo humanitario. Por su parte, el OGC advierte que ya se han observado imágenes satelitales fabricadas, modelos urbanos generados por IA y redes de carreteras sintéticas, y que representan desafíos reales a la confianza pública y operativa.

Implicaciones estratégicas y políticas

Las imágenes satelitales son consideradas "ojos imparciales" sobre el planeta, usadas por gobiernos, medios y organizaciones. Cuando estas imágenes se falsifican, sus consecuencias pueden ser graves:

- Seguridad nacional y defensa: si se presentan infraestructuras falsas o se ocultan otras reales, se pueden desviar análisis estratégicos o inducir decisiones militares equivocadas.

- Desinformación en conflictos o crisis humanitarias: una imagen alterada que muestre incendios, inundaciones o movimientos de tropas falsos puede alterar la respuesta internacional, los flujos de ayuda o la percepción de los ciudadanos, especialmente si se difunde por redes sociales o medios sin verificación.

- Manipulación de imágenes realistas de lugares: no solo las imágenes generales están en juego. Nguyen y colaboradores (2024) demostraron que es posible generar imágenes satelitales sintéticas altamente realistas de instalaciones muy específicas como plantas nucleares.

Crisis de confianza y erosión de la verdad

Durante décadas, las imágenes satelitales han sido percibidas como una de las fuentes más objetivas y fiables de información sobre nuestro planeta. Eran la prueba gráfica que permitía confirmar fenómenos ambientales, seguir conflictos armados o evaluar el impacto de desastres naturales. En muchos casos, estas imágenes se utilizaban como “evidencia imparcial”, difíciles de manipular y fáciles de validar. Sin embargo, la irrupción de las imágenes sintéticas generadas por inteligencia artificial ha empezado a poner en cuestión esa confianza casi inquebrantable.

Hoy en día, cuando una imagen satelital puede ser falsificada con gran realismo, surge un riesgo profundo: la erosión de la verdad y la aparición de una crisis de confianza en los datos espaciales.

La quiebra de la confianza pública

Cuando los ciudadanos ya no pueden distinguir entre una imagen real y una fabricada, se resquebraja la confianza en las fuentes de información. La consecuencia es doble:

- Desconfianza hacia las instituciones: si circulan imágenes falsas de un incendio, una catástrofe o un despliegue militar y luego resultan ser sintéticas, la ciudadanía puede empezar a dudar también de las imágenes auténticas publicadas por agencias espaciales o medios de comunicación. Este efecto “que viene el lobo” genera escepticismo incluso frente a pruebas legítimas.

- Efecto en el periodismo: los medios tradicionales, que han usado históricamente las imágenes satelitales como fuente visual incuestionable, corren el riesgo de perder credibilidad si publican imágenes adulteradas sin verificación. Al mismo tiempo, la abundancia de imágenes falsas en redes sociales erosiona la capacidad de distinguir qué es real y qué no.

- Confusión deliberada: en contextos de desinformación, la mera sospecha de que una imagen pueda ser falsa ya puede bastar para generar duda y sembrar confusión, aunque la imagen original sea completamente auténtica.

A continuación, se resumen los posibles casos de manipulación y riesgo en imágenes satelitales:

| Ámbito | Tipo de manipulación | Riesgo principal | Ejemplo documentado |

|---|---|---|---|

| Conflictos armados | Inserción o eliminación de infraestructuras militares. | Desinformación estratégica; decisiones militares erróneas; pérdida de credibilidad en observación internacional. | Alteraciones demostradas en estudios de deepfake geography donde se añadían carreteras, puentes o edificios ficticios en imágenes satelitales. |

| Cambio climático y medio ambiente | Alteración de glaciares, deforestación o emisiones. | Manipulación de políticas ambientales; retraso en medidas contra el cambio climático; negacionismo. | Estudios han mostrado la capacidad de generar paisajes modificados (bosques en zonas urbanas, cambios en el hielo) mediante GAN. |

| Gestión de emergencias | Creación de desastres inexistentes (incendios, inundaciones). | Mal uso de recursos en emergencias; caos en evacuaciones; pérdida de confianza en agencias. | Investigaciones han demostrado la facilidad de insertar humo, fuego o agua en imágenes satelitales. |

| Mercados y seguros | Falsificación de daños en infraestructuras o cultivos. | Impacto financiero; fraude masivo; litigios legales complejos. | Uso potencial de imágenes falsas para exagerar daños tras desastres y reclamar indemnizaciones o seguros. |

| Derechos humanos y justicia internacional | Alteración de pruebas visuales sobre crímenes de guerra. | Deslegitimación de tribunales internacionales; manipulación de la opinión pública. | Riesgo identificado en informes de inteligencia: imágenes adulteradas podrían usarse para acusar o exonerar a actores en conflictos. |

| Geopolítica y diplomacia | Creación de ciudades ficticias o cambios fronterizos. | Tensiones diplomáticas; cuestionamiento de tratados; propaganda estatal. | Ejemplos de deepfake maps que transforman rasgos geográficos de ciudades como Seattle o Tacoma. |

Figura 2. Tabla con los posibles casos de manipulación y riesgo en imágenes satelitales

Impacto en la toma de decisiones y políticas públicas

Las consecuencias de basarse en imágenes adulteradas van mucho más allá del terreno mediático:

- Urbanismo y planificación: decisiones sobre dónde construir infraestructuras o cómo planificar zonas urbanas podrían tomarse sobre imágenes manipuladas, generando errores costosos y de difícil reversión.

- Gestión de emergencias: si una inundación o un incendio se representan en imágenes falsas, los equipos de emergencia pueden destinar recursos a lugares equivocados, mientras descuidan zonas realmente afectadas.

- Cambio climático y medio ambiente: imágenes adulteradas de glaciares, deforestación o emisiones contaminantes podrían manipular debates políticos y retrasar la implementación de medidas urgentes.

- Mercados y seguros: aseguradoras y empresas financieras que confían en imágenes satelitales para evaluar daños podrían ser engañadas, con consecuencias económicas significativas.

En todos estos casos, lo que está en juego no es solo la calidad de la información, sino la eficacia y legitimidad de las políticas públicas basadas en esos datos.

El juego del gato y el ratón tecnológico

La dinámica de generación y detección de falsificaciones ya se conoce en otros ámbitos, como los deepfakes de vídeo o audio: cada vez que surge un método de generación más realista, se desarrolla un algoritmo de detección más avanzado, y viceversa. En el ámbito de las imágenes satelitales, esta carrera tecnológica tiene particularidades:

- Generadores cada vez más sofisticados: los modelos de difusión actuales pueden crear escenas de gran realismo, integrando texturas de suelo, sombras y geometrías urbanas que engañan incluso a expertos humanos.

- Limitaciones de la detección: aunque se desarrollan algoritmos para identificar falsificaciones (analizando patrones de píxeles, inconsistencias en sombras o metadatos), estos métodos no siempre son fiables cuando se enfrentan a generadores de última generación.

- Coste de la verificación: verificar de forma independiente una imagen satelital requiere acceso a fuentes alternativas o sensores distintos, algo que no siempre está al alcance de periodistas, ONG o ciudadanos.

- Armas de doble filo: las mismas técnicas usadas para detectar falsificaciones pueden ser aprovechadas por quienes las generan, perfeccionando aún más las imágenes sintéticas y haciendo más difícil diferenciarlas.

De la prueba visual a la prueba cuestionada

El impacto más profundo es cultural y epistemológico: lo que antes se asumía como una prueba objetiva ahora se convierte en un elemento sujeto a duda. Si las imágenes satelitales dejan de ser percibidas como evidencia fiable, se debilitan narrativas fundamentales en torno a la verdad científica, la justicia internacional y la rendición de cuentas política.

- En conflictos armados, una imagen de satélite que muestre posibles crímenes de guerra puede ser descartada bajo la acusación de ser un deepfake.

- En tribunales internacionales, pruebas basadas en observación satelital podrían perder peso frente a la sospecha de manipulación.

- En el debate público, el relativismo de “todo puede ser falso” puede usarse como arma retórica para deslegitimar incluso la evidencia más sólida.

Estrategias para garantizar autenticidad

La crisis de confianza en las imágenes satelitales no es un problema aislado del sector geoespacial, sino que forma parte de un fenómeno más amplio: la desinformación digital en la era de la inteligencia artificial. Así como los deepfakes de vídeo han puesto en cuestión la validez de pruebas audiovisuales, la proliferación de imágenes satelitales sintéticas amenaza con debilitar la última frontera de datos percibidos como objetivos: la mirada imparcial desde el espacio.

Garantizar la autenticidad de estas imágenes exige una combinación de soluciones técnicas y mecanismos de gobernanza, capaces de reforzar la trazabilidad, la transparencia y la responsabilidad en toda la cadena de valor de los datos espaciales. A continuación, se describen las principales estrategias en desarrollo.

Metadatos robustos: registrar el origen y la cadena de custodia

Los metadatos constituyen la primera línea de defensa frente a la manipulación. En imágenes satelitales, deben incluir información detallada sobre:

- El sensor utilizado (tipo, resolución, órbita).

- El momento exacto de la adquisición (fecha y hora, con precisión temporal).

- La localización geográfica precisa (sistemas de referencia oficiales).

- La cadena de procesado aplicada (correcciones atmosféricas, calibraciones, reproyecciones).

Registrar estos metadatos en repositorios seguros permite reconstruir la cadena de custodia, es decir, el historial de quién, cómo y cuándo ha manipulado una imagen. Sin esta trazabilidad, resulta imposible distinguir entre imágenes auténticas y falsificadas.

EJEMPLO: el programa Copernicus de la Unión Europea ya implementa metadatos estandarizados y abiertos para todas sus imágenes Sentinel, lo que facilita auditorías posteriores y confianza en el origen.

Firmas digitales y blockchain: garantizar la integridad

Las firmas digitales permiten verificar que una imagen no ha sido alterada desde su captura. Funcionan como un sello criptográfico que se aplica en el momento de adquisición y se valida en cada uso posterior.

La tecnología blockchain ofrece un nivel adicional de garantía: almacenar los registros de adquisición y modificación en una cadena inmutable de bloques. De esta manera, cualquier cambio en la imagen o en sus metadatos quedaría registrado y sería fácilmente detectable.

EJEMPLO: el proyecto ESA – Trusted Data Framework explora el uso de blockchain para proteger la integridad de datos de observación de la Tierra y reforzar la confianza en aplicaciones críticas como cambio climático y seguridad alimentaria.

Marcas de agua invisible: señales ocultas en la imagen

El marcado de agua digital consiste en incrustar señales imperceptibles en la propia imagen satelital, de modo que cualquier alteración posterior se pueda detectar automáticamente.

- Puede hacerse a nivel de píxel, modificando ligeramente patrones de color o luminancia.

- Se combina con técnicas criptográficas para reforzar su validez.

- Permite validar imágenes incluso si han sido recortadas, comprimidas o reprocesadas.

EJEMPLO: en el sector audiovisual, las marcas de agua se usa desde hace años en la protección de contenidos digitales. Su adaptación a imágenes satelitales está en fase experimental, pero podría convertirse en una herramienta estándar de verificación.

Estándares abiertos (OGC, ISO): confianza mediante interoperabilidad

La estandarización es clave para garantizar que las soluciones técnicas se apliquen de forma coordinada y global.

- OGC (Open Geospatial Consortium) trabaja en estándares para la gestión de metadatos, la trazabilidad de datos geoespaciales y la interoperabilidad entre sistemas. Su trabajo en API geoespaciales y metadatos FAIR (Findable, Accessible, Interoperable, Reusable) es esencial para establecer prácticas comunes de confianza.

- ISO desarrolla normas sobre gestión de la información y autenticidad de registros digitales que también pueden aplicarse a imágenes satelitales.

EJEMPLO: el OGC Testbed-19 incluyó experimentos específicos sobre autenticidad de datos geoespaciales, probando enfoques como firmas digitales y certificados de procedencia.

Verificación cruzada: combinar múltiples fuentes

Un principio básico para detectar falsificaciones es contrastar fuentes. En el caso de imágenes satelitales, esto implica:

- Comparar imágenes de diferentes satélites (ej. Sentinel-2 vs. Landsat-9).

- Usar distintos tipos de sensores (ópticos, radar SAR, hiperespectrales).

- Analizar series temporales para verificar la consistencia en el tiempo.

EJEMPLO: la verificación de daños en Ucrania tras el inicio de la invasión rusa en 2022 se realizó mediante la comparación de imágenes de varios proveedores (Maxar, Planet, Sentinel), asegurando que los hallazgos no se basaban en una sola fuente.

IA contra IA: detección automática de falsificaciones

La misma inteligencia artificial que permite crear imágenes sintéticas se puede utilizar para detectarlas. Las técnicas incluyen:

- Análisis forense de píxeles: identificar patrones generados por GAN o modelos de difusión.

- Redes neuronales entrenadas para distinguir entre imágenes reales y sintéticas en función de texturas o distribuciones espectrales.

- Modelos de inconsistencias geométricas: detectar sombras imposibles, incoherencias topográficas o patrones repetitivos.

EJEMPLO: investigadores de la Universidad de Washington y otros grupos han demostrado que algoritmos específicos pueden detectar falsificaciones satelitales con una precisión superior al 90% en condiciones controladas.

Experiencias actuales: iniciativas globales

Varios proyectos internacionales ya trabajan en mecanismos para reforzar la autenticidad:

- Coalition for Content Provenance and Authenticity (C2PA): una alianza entre Adobe, Microsoft, BBC, Intel y otras organizaciones para desarrollar un estándar abierto de procedencia y autenticidad de contenidos digitales, incluyendo imágenes. Su modelo se puede aplicar directamente al sector satelital.

- Trabajo del OGC: la organización impulsa el debate sobre confianza en datos geoespaciales y ha destacado la importancia de garantizar la trazabilidad de imágenes satelitales sintéticas y reales (OGC Blog).

- NGA (National Geospatial-Intelligence Agency) en EE. UU. ha reconocido públicamente la amenaza de imágenes sintéticas en defensa y está impulsando colaboraciones con academia e industria para desarrollar sistemas de detección.

Hacia un ecosistema de confianza

Las estrategias descritas no deben entenderse como alternativas, sino como capas complementarias en un ecosistema de confianza:

|

Id |

Capas |

¿Qué aportan? |

|---|---|---|

| 1 | Metadatos robustos (origen, sensor, cadena de custodia) |

Garantizan trazabilidad |

| 2 | Firmas digitales y blockchain (integridad de datos) |

Aseguran integridad |

| 3 | Marcas de agua invisible (señales ocultas) |

Añade un nivel oculto de protección |

| 4 | Verificación cruzada (múltiples satélites y sensores) |

Valida con independencia |

| 5 | IA contra IA (detector de falsificaciones) |

Responde a amenazas emergentes |

| 6 | Gobernanza internacional (responsabilidad, marcos legales) |

Articula reglas claras de responsabilidad |

Figura 3. Capas para garantizar la confianza en las imágenes sintéticas satelitales

El éxito dependerá de que estos mecanismos se integren de manera conjunta, bajo marcos abiertos y colaborativos, y con la implicación activa de agencias espaciales, gobiernos, sector privado y comunidad científica.

Conclusiones

Las imágenes sintéticas, lejos de ser únicamente una amenaza, representan una herramienta poderosa que, bien utilizada, puede aportar un valor significativo en ámbitos como la simulación, el entrenamiento de algoritmos o la innovación en servicios digitales. El problema surge cuando estas imágenes se presentan como reales sin la debida transparencia, alimentando la desinformación o manipulando la percepción pública.

El reto, por tanto, es doble: aprovechar las oportunidades que ofrece la síntesis de datos visuales para avanzar en ciencia, tecnología y gestión, y minimizar los riesgos asociados al mal uso de estas capacidades, especialmente en forma de deepfakes o falsificaciones deliberadas.

En el caso particular de las imágenes satelitales, la confianza adquiere una dimensión estratégica. De ellas dependen decisiones críticas en seguridad nacional, respuesta a desastres, políticas ambientales y justicia internacional. Si la autenticidad de estas imágenes se pone en duda, se compromete no solo la fiabilidad de los datos, sino también la legitimidad de las decisiones basadas en ellos.

El futuro de la observación de la Tierra estará condicionado por nuestra capacidad de garantizar la autenticidad, transparencia y trazabilidad en toda la cadena de valor: desde la adquisición de los datos hasta su difusión y uso final. Las soluciones técnicas (metadatos robustos, firmas digitales, blockchain, marcas de agua, verificación cruzada e IA para detección de falsificaciones), combinadas con marcos de gobernanza y cooperación internacional, serán la clave para construir un ecosistema de confianza.

En definitiva, debemos asumir un principio rector sencillo pero contundente:

“Si no podemos confiar en lo que vemos desde el espacio, ponemos en riesgo nuestras decisiones en la Tierra.”

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Sicma, sistema de información climática y medioambiental, es una plataforma que muestra los escenarios climáticos y diversas variables generadas tras ellos. Esta aplicación está desarrollada completamente con software libre y permite consultar las condiciones climáticas actuales, pasadas y futuras, con una resolución espacial variable según las necesidades de cada caso (100 por 100 metros en el caso de las Islas Canarias, y de 200 por 200 metros en el de Andalucía). Así se consigue obtener información local del punto de intervención.

La información se genera para los escenarios, modelos, horizontes y periodos anuales que se consideren necesarios en cada caso y con la resolución y las interpolaciones más adecuadas en cada territorio.

Sicma ofrece información de variables calculadas a partir de series diarias. Para cuantificar las incertidumbres, ofrece proyecciones generadas a partir de diez modelos climáticos del sexto informe del Grupo Intergubernamental de Expertos sobre el Cambio Climático (IPCC), cada uno bajo cuatro escenarios de emisiones futuras, las denominadas trayectorias socioeconómicas compartidas (SSP por sus siglas en inglés). Por tanto, se generan 40 proyecciones en total. Estas proyecciones climáticas, detalladas hasta el año 2100, son una herramienta muy útil para la planificación y gestión del agua, la agricultura y la conservación del medio natural.

El usuario puede acceder fácilmente a la información de los escenarios climáticos, proporcionando datos representativos en distintos ámbitos territoriales a través de un visor. Algunas de las variables que incluye este visor son: temperatura máxima, temperatura media, temperatura mínima, precipitación, evapotranspiración potencial, balance hídrico, días de calor (>40ºC) o noches tropicales (>22ºC).

Además de la visualización, también es posible la descarga en formatos alfanuméricos en hojas de cálculo, gráficos o mapas de valores.

Actualmente, existen dos entornos de sicma en abierto:

- Sicma Andalucía: https://andalucia.sicma.red/

- Sicma Canarias: https://canarias.sicma.red/

La inteligencia artificial (IA) se ha convertido en una tecnología clave en múltiples sectores, desde la salud y la educación hasta la industria y la gestión ambiental, sin olvidarnos de la cantidad de ciudadanos que crean textos, imágenes o vídeos con esta tecnología solo para su disfrute personal. Se estima que en España más de la mitad de la población adulta ha utilizado alguna vez alguna herramienta IA.

Sin embargo, este auge plantea desafíos en términos de sostenibilidad, tanto en consumo hídrico y energético como en impacto social y ético. Por ello, es necesario buscar soluciones que ayuden a mitigar los efectos negativos, promoviendo modelos eficientes, responsables y accesibles para todos. En este artículo vamos a abordar este reto, así como los posibles esfuerzos a llevar a cabo para darle solución.

¿Cuál es el impacto ambiental de la IA?

Ante un panorama donde la inteligencia artificial está de moda, cada vez son más los usuarios que se preguntan cuál es el precio que debemos pagar por poder crear memes en cuestión de segundos.

Para calcular bien el impacto total de la inteligencia artificial, es necesario considerar los ciclos del hardware y el software en su conjunto, como bien indica el Programa de las Naciones Unidas para el Medio Ambiente (PNUMA). Es decir, es necesario considerar desde la extracción de materias primas, la producción, el transporte y la construcción del centro de datos, la gestión, el mantenimiento y la eliminación de residuos electrónicos, hasta la recopilación y preparación de datos, la creación de modelos, el entrenamiento, la validación, la implementación, la inferencia, el mantenimiento y la retirada. Todo ello genera efectos directos, indirectos y de orden superior:

- Los impactos directos incluyen el consumo de energía, agua y recursos minerales, así como la producción de emisiones y residuos electrónicos, lo cual genera una huella de carbono considerable.

- Los efectos indirectos se derivan del uso de la IA, por ejemplo, los generados por el aumento en el uso de vehículos autónomos.

- Además, el uso generalizado de la inteligencia artificial también conlleva una dimensión ética, ya que puede exacerbar las desigualdades existentes, afectando especialmente a las minorías y las personas con bajos ingresos. En ocasiones, los datos de entrenamiento utilizados presentan sesgos o son de una baja calidad (por ejemplo, infrarrepresentando a determinados grupos poblacionales). Esta situación puede dar lugar a respuestas y decisiones que favorecen a grupos mayoritarios.

Algunas de las cifras que recopila el documento de la ONU y que pueden ayudarnos a hacernos una idea del impacto generado por la IA son:

- Una única petición de información a ChatGPT consume diez veces más electricidad que una consulta en un motor de búsqueda como Google, según datos de la Agencia Internacional de la Energía (AIE).

- Entrenar a un único modelo de lenguaje de gran escala (Large Language Models o LLM) genera aproximadamente 300.000 kg de emisiones de dióxido de carbono, lo que equivale a 125 vuelos de ida y vuelta entre Nueva York y Pekín, según el artículo científico “The carbon impact of artificial intelligence”.

- La demanda mundial de agua de la IA será de entre 4.200 y 6.600 millones de metros cúbicos para 2027, una cifra que supera el consumo total de un país como Dinamarca, de acuerdo con el estudio “Making AI Less “Thirsty”: Uncovering and Addressing the Secret Water Footprint of AI Models”.

Soluciones para conseguir una IA sostenible

Ante esta situación, la propia ONU propone diversos aspectos a los que es necesario prestar atención, por ejemplo:

- Búsqueda de métodos y parámetros normalizados para medir el impacto medioambiental de la IA, centrándose en los efectos directos, más fáciles de medir gracias a los datos de consumo de energía, agua y recursos. Al conocer esta información, resultará más sencillo tomar medidas que supongan un beneficio sustancial.

- Facilitar la concienciación de la sociedad, a través de mecanismos que obliguen a las empresas a hacer pública esta información de manera transparente y accesible. Esto podría acabar promoviendo cambios de comportamiento hacia un uso más sostenible de la IA.

- Dar prioridad a la investigación sobre la optimización de los algoritmos, en pro de la eficiencia energética. Por ejemplo, se puede minimizar la energía necesaria mediante la reducción de la complejidad computacional y el uso de datos. También se puede impulsar la computación descentralizada, ya que, al distribuir los procesos en redes menos exigentes, se evita sobrecargar los grandes servidores.

- Favorecer el uso de energías renovables en los centros de datos, como la solar o la eólica. Además, es necesario impulsar que las empresas lleven a cabo prácticas de compensación de emisiones de carbono.

Además de su impacto ambiental, y como veíamos anteriormente, la IA también debe ser sostenible desde una perspectiva social y ética. Para ello es necesario:

- Evitar sesgos algorítmicos: garantizar que los datos utilizados representen la diversidad de la población, evitando discriminaciones involuntarias.

- Transparencia en los modelos: hacer que los algoritmos sean comprensibles y accesibles, promoviendo la confianza y la supervisión humana.

- Accesibilidad y equidad: desarrollar sistemas de IA que sean inclusivos y beneficien a comunidades menos privilegiadas.

Si bien la inteligencia artificial plantea desafíos en términos de sostenibilidad, también puede ser una aliada clave en la construcción de un planeta más verde. Su capacidad para analizar grandes volúmenes de datos permite optimizar el uso de energía, mejorar la gestión de recursos naturales y desarrollar estrategias más eficientes en sectores como la agricultura, la movilidad y la industria. Desde la predicción del cambio climático hasta el diseño de modelos para reducir emisiones, la IA ofrece soluciones innovadoras que pueden acelerar la transición hacia un futuro más sostenible.

Programa Nacional de Algoritmos Verdes

En respuesta a esta realidad, España ha puesto en marcha el Programa Nacional de Algoritmos Verdes (PNAV). Esta una iniciativa que busca integrar la sostenibilidad en el diseño y aplicación de la IA, promoviendo modelos más eficientes y responsables con el medioambiente, a la vez que se impulsa su uso para dar respuesta a diferentes desafíos medioambientales.

El PNAV tiene como meta principal fomentar el desarrollo de algoritmos que minimicen el impacto ambiental desde su concepción. Este enfoque, conocido como "Verde por Diseño", implica que la sostenibilidad no sea un añadido posterior, sino un criterio fundamental en la creación de modelos de IA. Además, el programa busca potenciar la investigación en IA sostenible, mejorar la eficiencia energética de infraestructuras digitales y promover la integración de tecnologías como el blockchain verde en el tejido productivo.

Esta iniciativa se enmarca en el Plan de Recuperación, Transformación y Resiliencia, la Agenda España Digital 2026 y la Estrategia Nacional de Inteligencia Artificial. Entre los objetivos fijados se incluye la elaboración de una guía de buenas prácticas, un catálogo de algoritmos eficientes y otro de algoritmos para abordar problemas ambientales, la generación de una calculadora de impacto para autoevaluación, así como medidas de apoyo a la concienciación y formación de desarrolladores de IA.

Su página web funciona como un espacio de conocimiento sobre inteligencia artificial sostenible, donde se puede estar al tanto de las principales noticias, eventos, entrevistas, etc. relacionadas con este campo. Además, organizan competiciones, como hackathones, con el fin de impulsar soluciones que ayuden a resolver retos medioambientales.

El Futuro de la IA sostenible

El camino hacia una inteligencia artificial más responsable depende del esfuerzo conjunto de gobiernos, empresas y la comunidad científica. La inversión en investigación, el desarrollo de regulaciones adecuadas y la concienciación sobre IA ética serán clave para garantizar que esta tecnología impulse el progreso sin comprometer el planeta ni la sociedad.

La IA sostenible no solo es un desafío tecnológico, sino una oportunidad para transformar la innovación en un motor de bienestar global. De todos depende que podamos progresar como sociedad sin destruir el planeta.