Vivimos en una época en la que cada vez más fenómenos del mundo físico pueden observarse, medirse y analizarse en tiempo real. La temperatura de un cultivo, la calidad del aire de una ciudad, el estado de una presa, el flujo del tráfico o el consumo energético de un edificio ya no son datos que se revisan ocasionalmente: son flujos continuos de información que se generan segundo a segundo.

Esta revolución no sería posible sin los sistemas ciberfísicos (CPS), una tecnología que integra sensores, algoritmos y actuadores para conectar el mundo físico con el digital. Pero los CPS no sólo generan datos: también pueden alimentarse de datos abiertos, multiplicando su utilidad y permitiendo decisiones basadas en evidencia.

En este artículo exploraremos qué son los CPS, cómo generan datos masivos en tiempo real, qué retos plantea convertir esos datos en información pública útil, qué principios son esenciales para asegurar su calidad y trazabilidad, y qué ejemplos reales demuestran el potencial de su reutilización. Cerraremos con una reflexión sobre el impacto de esta combinación en la innovación, la ciencia ciudadana y el diseño de políticas públicas más inteligentes.

¿Qué son los sistemas ciberfísicos?

Un sistema ciberfísico es una integración estrecha entre componentes digitales —como software, algoritmos, comunicación y almacenamiento— y componentes físicos —sensores, actuadores, dispositivos IoT o máquinas industriales—. Su función principal es observar el entorno, procesar la información y actuar sobre él.

A diferencia de los sistemas tradicionales de monitorización, un CPS no se limita a medir: cierra un ciclo completo entre percepción, decisión y acción. Este ciclo se puede entender a través de tres elementos principales:

Figura 1. Ciclo de los sistemas ciberfísicos. Fuente: elaboración propia

Un ejemplo cotidiano que ilustra muy bien este ciclo completo de percepción, decisión y acción es el riego inteligente, cada vez más presente en la agricultura de precisión y en los sistemas domésticos de jardinería. En este caso, los sensores distribuidos por el terreno miden continuamente la humedad del suelo, la temperatura ambiente e incluso la radiación solar. Toda esa información fluye hacia la unidad de computación, que analiza los datos, los compara con umbrales previamente definidos o con modelos más complejos —por ejemplo, los que estiman la evaporación del agua o las necesidades hídricas de cada tipo de planta— y determina si realmente es necesario regar.

Cuando el sistema concluye que el suelo ha alcanzado un nivel de sequedad crítico, entra en juego el tercer elemento del CPS: los actuadores. Son ellos quienes abren las válvulas, activan la bomba de agua o regulan el caudal, y lo hacen durante el tiempo exacto necesario para devolver la humedad a niveles óptimos. Si las condiciones cambian —si empieza a llover, si la temperatura baja o si el suelo recupera humedad más rápido de lo esperado—, el propio sistema ajusta su comportamiento en consecuencia.

Todo este proceso ocurre sin intervención humana, de forma autónoma. El resultado es un uso más sostenible del agua, plantas mejor cuidadas y una capacidad de adaptación en tiempo real que solo es posible gracias a la integración de sensores, algoritmos y actuadores característica de los sistemas ciberfísicos.

Los CPS como fábricas de datos en tiempo real

Una de las características más relevantes de los sistemas ciberfísicos es su capacidad para generar datos de forma continua, masiva y con una resolución temporal muy alta. Esta producción constante puede apreciarse en múltiples situaciones del día a día:

- Una estación hidrológica puede registrar nivel y caudal cada minuto.

- Un sensor de movilidad urbana puede generar cientos de lecturas por segundo.

- Un contador inteligente registra el consumo eléctrico cada pocos minutos.

- Un sensor agrícola mide humedad, salinidad y radiación solar varias veces al día.

- Un dron cartográfico captura posiciones GPS decimétricas en tiempo real.

Más allá de estos ejemplos concretos, lo importante es comprender qué significa esta capacidad para el conjunto del sistema: los CPS se convierten en auténticas fábricas de datos, y en muchos casos llegan a funcionar como gemelos digitales del entorno físico que monitorizan. Esa equivalencia casi instantánea entre el estado real de un río, un cultivo, una carretera o una máquina industrial y su representación digital permite disponer de un retrato extremadamente preciso y actualizado del mundo físico, prácticamente al mismo tiempo que los fenómenos ocurren.

Esta riqueza de datos abre un enorme campo de oportunidades cuando se publica como información abierta. Los datos procedentes de CPS pueden impulsar servicios innovadores desarrollados por empresas, alimentar investigaciones científicas de alto impacto, potenciar iniciativas de ciencia ciudadana que complementen los datos institucionales, y reforzar la transparencia y la rendición de cuentas en la gestión de recursos públicos.

Sin embargo, para que todo ese valor llegue realmente a la ciudadanía y a la comunidad reutilizadora, es necesario superar una serie de retos técnicos, organizativos y de calidad que determinan la utilidad final del dato abierto. A continuación, analizamos cuáles son esos desafíos y por qué son tan importantes en un ecosistema cada vez más dependiente de información generada en tiempo real.

El reto: de datos en bruto a información pública útil

Que un CPS genere datos no significa que estos puedan publicarse directamente como datos abiertos. Antes de llegar a la ciudadanía y a las empresas reutilizadoras, la información necesita un trabajo previo de preparación, validación, filtrado y documentación. Las administraciones deben asegurarse de que esos datos son comprensibles, interoperables y fiables. Y en ese camino aparecen varios desafíos.

Uno de los primeros es la estandarización. Cada fabricante, cada sensor y cada sistema puede utilizar formatos distintos, diferentes frecuencias de muestreo o estructuras propias. Si no se armonizan esas diferencias, lo que obtenemos es un mosaico difícilmente integrable. Para que los datos sean interoperables se necesitan modelos comunes, unidades homogéneas, estructuras coherentes y estándares compartidos. Normativas como INSPIRE o los estándares de OGC (Open Geospatial Consortium) e IoT-TS son clave para que un dato generado en una ciudad pueda entenderse, sin transformación adicional, en otra administración o por cualquier reutilizador.

El siguiente gran reto es la calidad. Los sensores pueden fallar, quedarse congelados reportando siempre el mismo valor, generar lecturas físicamente imposibles, sufrir interferencias electromagnéticas o estar mal calibrados durante semanas sin que nadie lo note. Si esa información se publica tal cual, sin un proceso previo de revisión y limpieza, el dato abierto pierde valor e incluso puede inducir a errores. La validación —con controles automáticos y revisión periódica— es, por tanto, indispensable.

Otro punto crítico es la contextualización. Un dato aislado carece de significado. Un “12,5” no dice nada si no sabemos si son grados, litros o decibelios. Una medida de “125 ppm” no tiene utilidad si no conocemos qué sustancia se está midiendo. Incluso algo tan aparentemente objetivo como unas coordenadas necesita un sistema de referencia concreto. Y cualquier dato ambiental o físico solo puede interpretarse adecuadamente si se acompaña de la fecha, la hora, la ubicación exacta y las condiciones de captura. Todo esto forma parte de los metadatos, que son esenciales para que terceros puedan reutilizar la información sin ambigüedades.

También es fundamental abordar la privacidad y la seguridad. Algunos CPS pueden captar información que, directa o indirectamente, podría vincularse a personas, propiedades o infraestructuras sensibles. Antes de publicar los datos, es necesario aplicar procesos de anonimización, técnicas de agregación, controles de seguridad y evaluaciones de impacto que garanticen que el dato abierto no compromete derechos ni expone información crítica.

Por último, existen retos operativos como la frecuencia de actualización y la robustez del flujo de datos. Aunque los CPS generan información en tiempo real, no siempre es adecuado publicarla con la misma granularidad: en ocasiones es necesario agregarla, validar la coherencia temporal o corregir valores antes de compartirla. De igual modo, para que los datos sean útiles en análisis técnicos o en servicios públicos, deben llegar sin interrupciones prolongadas ni duplicados, lo que exige una infraestructura estable y mecanismos de supervisión.

Principios de calidad y trazabilidad necesarios para datos abiertos fiables

Superados estos retos, la publicación de datos procedentes de sistemas ciberfísicos debe apoyarse en una serie de principios de calidad y trazabilidad. Sin ellos, la información pierde valor y, sobre todo, pierde confianza.

El primero es la exactitud. El dato debe representar fielmente el fenómeno que mide. Esto requiere sensores correctamente calibrados, revisiones periódicas, eliminación de valores claramente erróneos y comprobación de que las lecturas se encuentran dentro de rangos físicamente posibles. Un sensor que marca 200 °C en una estación meteorológica o un contador que registra el mismo consumo durante 48 horas son señales de un problema que debe detectarse antes de la publicación.

El segundo principio es la completitud. Un conjunto de datos debe indicar cuándo hay valores perdidos, lagunas temporales o periodos en los que un sensor ha estado desconectado. Ocultar estos huecos puede llevar a conclusiones equivocadas, especialmente en análisis científicos o en modelos predictivos que dependen de la continuidad de la serie temporal.

El tercer elemento clave es la trazabilidad, es decir, la capacidad de reconstruir la historia del dato. Saber qué sensor lo generó, dónde está instalado, qué transformaciones ha sufrido, cuándo se capturó o si pasó por algún proceso de limpieza permite evaluar su calidad y fiabilidad. Sin trazabilidad, la confianza se erosiona y el dato pierde valor como evidencia.

La actualización adecuada es otro principio fundamental. La frecuencia con la que se publica la información debe adaptarse al fenómeno medido. Los niveles de contaminación atmosférica pueden necesitar actualizaciones cada pocos minutos; el tráfico urbano, cada segundo; la hidrología, cada minuto o cada hora según el tipo de estación; y los datos meteorológicos, con frecuencias variables. Publicar demasiado rápido puede generar ruido; demasiado lento, puede inutilizar el dato para ciertos usos.

El último principio es el de los metadatos enriquecidos. Los metadatos explican el dato: qué mide, cómo se mide, con qué unidad, qué precisión tiene el sensor, cuál es su rango operativo, dónde está ubicado, qué limitaciones tiene la medición y para qué se genera esa información. No son una nota al pie, sino la pieza que permite a cualquier reutilizador comprender el contexto y la fiabilidad del conjunto de datos. Con una buena documentación, la reutilización no solo es posible: se dispara.

Ejemplos: CPS que reutilizan datos públicos para ser más inteligentes

Además de generar datos, muchos sistemas ciberfísicos también consumen datos públicos para mejorar su desempeño. Esta retroalimentación convierte a los datos abiertos en un recurso central para el funcionamiento de los territorios inteligentes. Cuando un CPS integra información procedente de sensores propios con fuentes abiertas externas, su capacidad de anticipación, eficiencia y precisión aumenta de forma notable.

Agricultura de precisión: En el ámbito agrícola, los sensores instalados en el terreno permiten medir variables como la humedad del suelo, la temperatura o la radiación solar. Sin embargo, los sistemas de riego inteligente no dependen únicamente de esa información local: también incorporan predicciones meteorológicas de AEMET, mapas abiertos del IGN sobre pendiente o tipos de suelo y modelos climáticos publicados como datos públicos. Al combinar sus propias mediciones con estas fuentes externas, los CPS agrícolas pueden determinar con mucha mayor exactitud qué zonas del terreno necesitan agua, cuándo conviene sembrar y cuánta humedad debe mantenerse en cada cultivo. Esta gestión fina permite ahorros de agua y fertilizantes que, en algunos casos, superan el 30 %.

Gestión hídrica: Algo similar ocurre en la gestión del agua. Un sistema ciberfísico que controla una presa o un canal de riego necesita saber no solo qué está pasando en ese instante, sino qué puede ocurrir en las próximas horas o días. Por ello integra sus propios sensores de nivel con datos abiertos de aforos fluviales, predicciones de lluvia y nieve, e incluso información pública sobre caudales ecológicos. Con esta visión ampliada, el CPS puede anticipar inundaciones, optimizar el desembalse, responder mejor a fenómenos extremos o planificar el riego de forma sostenible. En la práctica, la combinación de datos propios y abiertos se traduce en una gestión más segura y eficiente del agua.

Impacto: innovación, ciencia ciudadana y decisiones basadas en datos

La unión entre sistemas ciberfísicos y datos abiertos genera un efecto multiplicador que se manifiesta en distintos ámbitos.

- Innovación empresarial: las empresas disponen de un terreno fértil para desarrollar soluciones basadas en información fiable y en tiempo real. A partir de datos abiertos y mediciones de CPS, pueden surgir aplicaciones de movilidad más inteligentes, plataformas de gestión hídrica, herramientas de análisis energético o sistemas predictivos para agricultura. El acceso a datos públicos reduce barreras de entrada y permite crear servicios sin necesidad de costosos datasets privados, acelerando la innovación y la aparición de nuevos modelos de negocio.

- Ciencia ciudadana: la combinación de CPS y datos abiertos también fortalece la participación social. Comunidades de vecinos, asociaciones o colectivos ambientales pueden desplegar sensores de bajo coste para complementar los datos públicos y entender mejor lo que ocurre en su entorno. Esto da lugar a iniciativas que miden el ruido en zonas escolares, monitorizan niveles de contaminación en barrios concretos, siguen la evolución de la biodiversidad o construyen mapas colaborativos que enriquecen la información oficial.

- Mejor toma de decisiones públicas: finalmente, los gestores públicos se benefician de este ecosistema de datos reforzado. La disponibilidad de mediciones fiables y actualizadas permite diseñar zonas de bajas emisiones, planificar de forma más efectiva el transporte urbano, optimizar redes de riego, gestionar situaciones de sequía o inundaciones o regular políticas energéticas basadas en indicadores reales. Sin datos abiertos que complementen y contextualicen la información generada por los CPS, estas decisiones serían menos transparentes y, sobre todo, menos defendibles ante la ciudadanía.

En resumen, los sistemas ciberfísicos se han convertido en una pieza esencial para entender y gestionar el mundo que nos rodea. Gracias a ellos podemos medir fenómenos en tiempo real, anticipar cambios y actuar de forma precisa y automatizada. Pero su verdadero potencial se despliega cuando sus datos se integran en un ecosistema de datos abiertos de calidad, capaz de aportar contexto, enriquecer decisiones y multiplicar usos.

La combinación de CPS y datos abiertos permite avanzar hacia territorios más inteligentes, servicios públicos más eficientes y una participación ciudadana más informada. Aporta valor económico, impulsa la innovación, facilita la investigación y mejora la toma de decisiones en ámbitos tan diversos como la movilidad, el agua, la energía o la agricultura.

Para que todo esto sea posible, es imprescindible garantizar la calidad, trazabilidad y estandarización de los datos publicados, así como proteger la privacidad y asegurar la robustez de los flujos de información. Cuando estas bases están bien asentadas, los CPS no solo miden el mundo: lo ayudan a mejorar, convirtiéndose en un puente sólido entre la realidad física y el conocimiento compartido.

Contenido elaborado por Dr. Fernando Gualo, Profesor en UCLM y Consultor de Gobierno y Calidad de datos. El contenido y el punto de vista reflejado en esta publicación es responsabilidad exclusiva de su autor.

La computación cuántica promete resolver en horas problemas que tomarían milenios a los superordenadores más potentes del mundo. Desde el diseño de nuevos fármacos hasta la optimización de redes de energía más sostenibles, esta tecnología transformará radicalmente nuestra capacidad para abordar los desafíos más complejos de la humanidad. Sin embargo, su verdadero potencial democratizador solo se materializará mediante la convergencia con los datos abiertos, permitiendo que investigadores, empresas y gobiernos de todo el mundo accedan tanto a la capacidad de cómputo cuántico en la nube como a los datasets públicos necesarios para entrenar y validar algoritmos cuánticos.

Tratar de explicar la teoría cuántica siempre ha supuesto un desafío, incluso para las mentes más brillantes que la humanidad ha dado en los últimos 2 siglos. El célebre físico Richard Feynman (1918-1988) lo expresó con su característico humor:

"Hubo un tiempo en que los periódicos decían que sólo doce hombres entendían la teoría de la relatividad. No creo que nunca fuera así [...] Por otro lado, creo que puedo decir con seguridad que nadie entiende la mecánica cuántica" Wikiquote.

Y eso lo dijo uno de los físicos más brillantes del siglo XX, premio Nobel y uno de los padres de la electrodinámica cuántica. Tan grande es la rareza del comportamiento cuántico a ojos de un humano que, hasta el mismísimo Albert Einstein en su ya mítica frase, le decía a Max Born, en una carta escrita al físico alemán en 1926 "Dios no juega a los dados con el universo" en referencia a su incredulidad sobre las propiedades probabilísticas y no deterministas que se le atribuyen al comportamiento cuántico. A lo que Niels Bohr - otro titán de la física del siglo XX - le respondió: "Einstein, deja de decirle a Dios qué hacer".

Computación clásica

Si queremos entender por qué la mecánica cuántica propone una revolución en la ciencia de la computación tenemos que entender sus diferencias fundamentales con la mecánica - y, por ende - computación clásica. Casi todos hemos oído hablar en algún momento de nuestra vida de los bits de información. Los humanos hemos desarrollado una forma de realizar cálculos matemáticos complejos reduciendo toda la información a bits - las unidades fundamentales de información con las que sabe trabajar una máquina -, que son los famosos ceros y unos (0 y 1). Con dos simples valores, hemos sido capaces de modelar todo nuestro mundo matemático. ¿Y esto por qué? se preguntará alguno. ¿Por qué en base 2 y no 5 o 7? Pues bien, en nuestro mundo físico clásico (en el que vivimos día a día) diferenciar entre 0 y 1 es relativamente sencillo; encendido y apagado, como en el caso de un interruptor eléctrico, o imanación norte o sur, en el caso de un disco duro magnético. Para un mundo binario, hemos desarrollado todo un lenguaje de codificación en base a dos estados: 0 y 1.

Computación cuántica

En computación cuántica en vez de bits, utilizamos los cúbits o qubits. Los qubits utilizan varias propiedades “extrañas” de la mecánica cuántica que les permite representar infinitos estados a la vez entre el cero y uno de los clásicos bits. Para entenderlo, es cómo si un bit solo pudiera representar un estado encendido o apagado en una bombilla, mientras que un qubit puede representar todas las intensidades de iluminación de la bombilla. Esta propiedad es conocida como “superposición cuántica” y permite que un ordenador cuántico explore millones de soluciones posibles al mismo tiempo. Pero esto no es todo en la computación cuántica. Si te parece extraña la superposición cuántica espera a ver el entrelazamiento cuántico (quantum entanglement). Gracias a esta propiedad, dos partículas (o dos qubits) “entrelazadas” están conectadas “a distancia” de forma que el estado de una determina el estado de la otra. Así que, con estas dos propiedades tenemos qubits de información, que pueden representar infinitos estados y están conectados entre ellos. Este sistema tiene potencialmente una capacidad de computación exponencialmente mayor que nuestros ordenadores basados en computación clásica.

Dos casos de aplicación de la computación cuántica

1. Descubrimiento de fármacos y medicina personalizada. Los ordenadores cuánticos pueden simular interacciones moleculares complejas que son imposibles de calcular con la computación clásica. Por ejemplo, el plegamiento de proteínas - fundamental para entender enfermedades como el Alzheimer - requiere analizar trillones de configuraciones posibles. Un ordenador cuántico podría reducir años de investigación a semanas, acelerando el desarrollo de nuevos medicamentos y tratamientos personalizados basados en el perfil genético de cada paciente.

2. Optimización logística y cambio climático. Empresas como Volkswagen ya utilizan computación cuántica para optimizar rutas de tráfico en tiempo real. A mayor escala, estos sistemas podrían revolucionar la gestión energética de ciudades enteras, optimizando redes eléctricas inteligentes que integren renovables de forma eficiente, o diseñar nuevos materiales para captura de CO2 que ayuden a combatir el cambio climático.

Una buena lectura recomendada para hacer un repaso completo por la computación cuántica aquí.

El papel de los datos (y los recursos de computación) abiertos

La democratización del acceso a la computación cuántica dependerá crucialmente de dos pilares: recursos de computación abiertos y datasets públicos de calidad. Esta combinación está creando un ecosistema donde la innovación cuántica ya no requiere millones de dólares en infraestructura. A continuación, vemos algunas opciones disponibles para cada uno de estos pilares.

- Acceso gratuito a hardware cuántico real:

- IBM Quantum Platform: ofrece acceso gratuito mensual a sistemas cuánticos de más de 100 qubits para cualquier persona en el mundo. Con más de 400.000 usuarios registrados que han generado más de 2.800 publicaciones científicas, demuestra cómo el acceso abierto acelera la investigación. Cualquier investigador puede registrarse en la plataforma y comenzar a experimentar en minutos.

- Open Quantum Institute (OQI): lanzado en CERN (la Organización Europea para la Investigación Nuclear) en 2024, va más allá, proporcionando no solo acceso a computación cuántica sino también mentorización y recursos educativos para regiones desatendidas. Su programa de hackathons en 2025 incluye eventos en Líbano, Emiratos Árabes Unidos y otros países, específicamente diseñados para mitigar la brecha digital cuántica.

- Datasets públicos para el desarrollo de algoritmos cuánticos:

- QDataSet: ofrece 52 conjuntos de datos públicos con simulaciones de sistemas cuánticos de uno y dos qubits, disponibles libremente para entrenar algoritmos de machine learning (ML) cuántico. Investigadores sin recursos para generar sus propios datos de simulación pueden acceder a su repositorio en GitHub y comenzar a desarrollar algoritmos inmediatamente.

- ClimSim: se trata de un dataset público de modelado relacionado con el clima que ya está siendo usado para demostrar los primeros algoritmos de ML cuántico aplicados al cambio climático. Permite a cualquier equipo, independientemente de su presupuesto, trabajar en problemas climáticos reales usando computación cuántica.

- PennyLane Datasets: es una colección abierta de moléculas, circuitos cuánticos y sistemas físicos que permite a las startups farmacéuticas sin recursos realizar simulaciones costosas y experimentar con el descubrimiento de fármacos asistido por computación cuántica.

Casos reales de innovación inclusiva

Las posibilidades que ofrece el uso de datos abiertos a la computación cuántica ha quedado patente en diversos casos de uso, fruto de investigaciones concretas y convocatorias de ayudas, como, por ejemplo:

- El Gobierno de Canadá lanzó en 2022 "Quantum Computing for Climate", una convocatoria específica para que PYMEs y startups desarrollen aplicaciones cuánticas usando datos climáticos públicos, demostrando cómo los gobiernos pueden catalizar innovación proporcionando tanto datos como financiación para su uso.

- UK Quantum Catalyst Fund (15 millones de libras) financia proyectos que combinan computación cuántica con datos públicos del sistema nacional de salud de Reino Unido (NHS) para problemas como la optimización de redes energéticas y diagnósticos médicos, creando soluciones de interés público verificables por la comunidad científica.

- El informe 2024 del Open Quantum Institute (OQI) detalla 10 casos de uso para los Objetivos de Desarrollo Sostenible de la ONU desarrollados colaborativamente por expertos de 22 países, donde los resultados y metodologías son públicamente accesibles, permitiendo que cualquier institución replique o mejore estos trabajos).

- Red.es ha abierto una manifestación de interés dirigida a agentes del ecosistema de tecnologías cuánticas para recopilar ideas, propuestas y necesidades que contribuyan al diseño de las futuras líneas de actuación de la Estrategia Nacional de Tecnologías Cuánticas 2025–2030, financiada con 40 millones de euros provenientes de los Fondos FEDER.

Estado actual de la computación cuántica

Estamos en la era NISQ (Noisy Intermediate-Scale Quantum), término acuñado por el físico John Preskill en 2018, que describe ordenadores cuánticos con 50-100 qubits físicos. Estos sistemas son suficientemente potentes para realizar ciertos cálculos más allá de las capacidades clásicas, pero sufren de decoherencia, errores frecuentes que los hacen poco viables en aplicaciones de mercado.

IBM, Google, y startups como IonQ ofrecen acceso cloud a sus sistemas cuánticos, con IBM proporcionando acceso público a través de IBM Quantum Platform desde 2016, siendo uno de los primeros procesadores cuánticos accesibles públicamente conectados a la nube.

En 2019, Google alcanzó la "supremacía cuántica" con su procesador Sycamore de 53 qubits, que realizó un cálculo en aproximadamente 200 segundos que tomaría aproximadamente 10.000 años a un superordenador clásico de última generación.

Los últimos análisis independientes sugieren que las aplicaciones cuánticas prácticas pueden emerger alrededor de 2035-2040, asumiendo un crecimiento exponencial continuo en las capacidades del hardware cuántico. IBM se ha comprometido a entregar un ordenador cuántico tolerante a fallos a gran escala, IBM Quantum Starling, para 2029, con el objetivo de ejecutar circuitos cuánticos que comprenden 100 millones de compuertas cuánticas en 200 qubits lógicos.

Para finalizar la sección, una fantástica entrevista corta a Ignacio Cirac, uno de los “padres españoles” de la computación cuántica.

La carrera global por el liderazgo cuántico

La competencia internacional por dominar las tecnologías cuánticas ha desencadenado una ola de inversiones sin precedentes. Según McKinsey, hasta 2022 el nivel reconocido oficialmente de inversión pública de China (15.300 millones de dólares) supera el de la Unión Europea (7.200 millones de dólares), Estados Unidos 1.900 millones de dólares) y Japón (1.800 millones de dólares) juntos.

A nivel doméstico, el Reino Unido ha comprometido 2.500 millones de libras durante diez años con su Estrategia Nacional Cuántica para hacer del país un hub global de innovación en esta tecnología, y Alemania ha realizado una de las inversiones estratégicas más grandes en computación cuántica, destinando 3.000 millones de euros bajo su plan de estímulo económico.

La inversión en el primer trimestre de 2025 muestra un crecimiento explosivo: las empresas de computación cuántica recaudaron más de 1.250 mil millones de dólares, más del doble que el año anterior, un aumento del 128%, reflejando una creciente confianza en que esta tecnología está acercándose a la relevancia comercial.

Iniciativa Quantum Spain

En el caso de España se han invertido 60 millones de euros en Quantum Spain, coordinado por el Barcelona Supercomputing Center. El proyecto incluye:

- Instalación del primer ordenador cuántico del sur de Europa.

- Red de 25 nodos de investigación distribuidos por todo el país.

- Formación de talento cuántico en universidades españolas.

- Colaboración con el sector empresarial para casos de uso reales.

Esta iniciativa posiciona a España como hub cuántico del sur de Europa, crucial para no depender tecnológicamente de otras potencias.

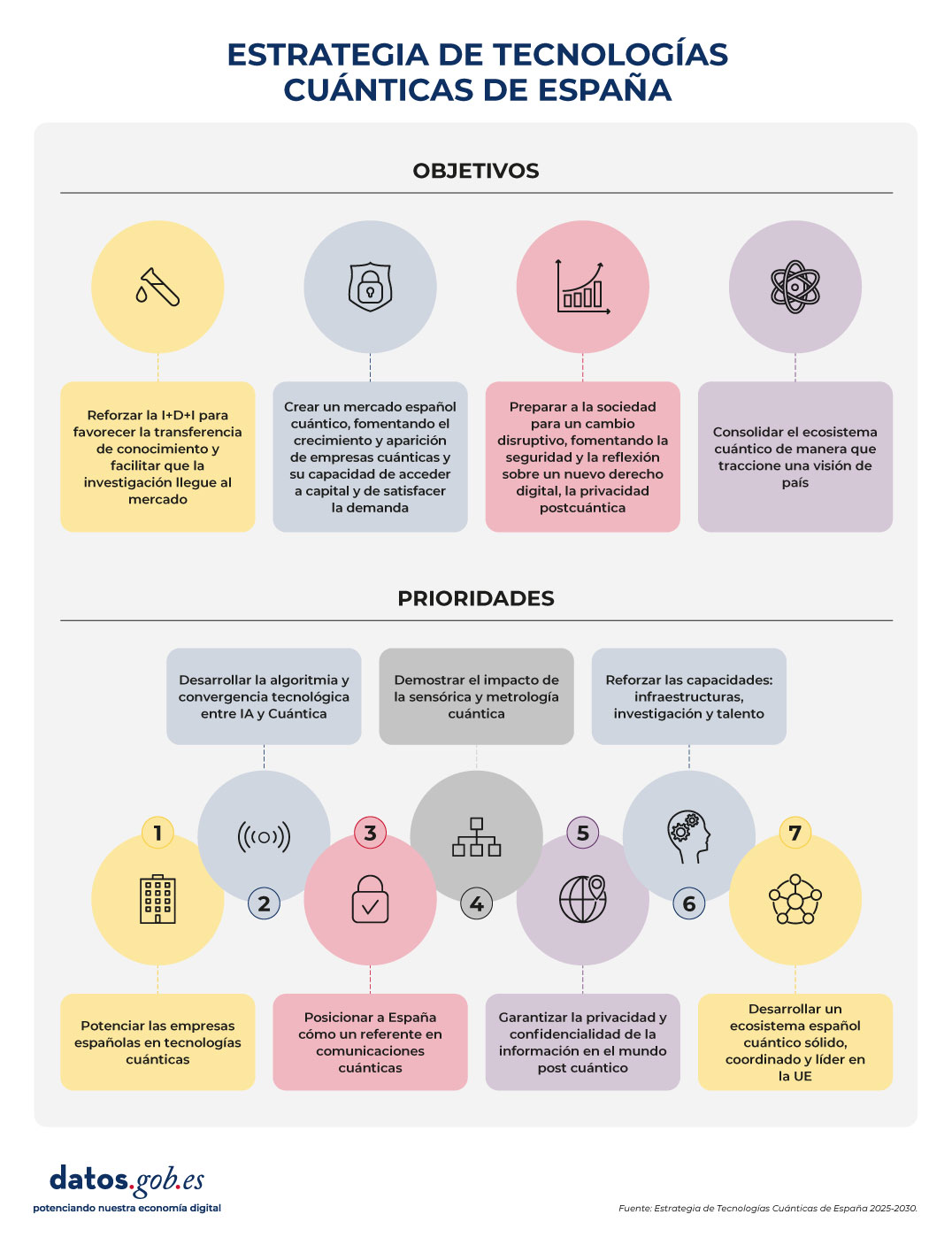

Además, muy recientemente se ha presentado la Estrategia de Tecnologías Cuánticas de España con una inversión de 800 millones de euros. Esta estrategia se estructura en 4 objetivos estratégicos y 7 acciones prioritarias.

Objetivos estratégicos:

- Reforzar la I+D+I para favorecer la transferencia de conocimiento y facilitar que la investigación llegue al mercado.

- Crear un mercado español cuántico, fomentando el crecimiento y aparición de empresas cuánticas y su capacidad de acceder a capital y de satisfacer la demanda.

- Preparar a la sociedad para un cambio disruptivo, fomentando la seguridad y la reflexión sobre un nuevo derecho digital, la privacidad postcuántica.

- Consolidar el ecosistema cuántico de manera que traccione una visión de país.

Acciones prioritarias:

- Prioridad 1: Potenciar las empresas españolas en tecnologías cuánticas.

- Prioridad 2: Desarrollar la algoritmia y convergencia tecnológica entre IA y Cuántica.

- Prioridad 3: Posicionar a España cómo un referente en comunicaciones cuánticas.

- Prioridad 4: Demostrar el impacto de la sensórica y metrología cuántica.

- Prioridad 5: Garantizar la privacidad y confidencialidad de la información en el mundo post cuántico.

- Prioridad 6: Reforzar las capacidades: infraestructuras, investigación y talento.

- Prioridad 7: Desarrollar un ecosistema español cuántico sólido, coordinado y líder en la UE.

Figura 1. Estrategia de tecnologías cuánticas de España. Fuente: elaboración propia

En definitiva, la computación cuántica y los datos abiertos representan una gran evolución tecnológica que afecta a la forma en que generamos y aplicamos el conocimiento. Si somos capaces de construir un ecosistema verdaderamente inclusivo —donde el acceso a hardware cuántico, datasets públicos y formación especializada esté al alcance de cualquiera— abriremos la puerta a una nueva era de innovación colaborativa con un gran impacto global.

Contenido elaborado por Alejandro Alija, experto en Transformación Digital e Innovación. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor

El portal europeo de datos abiertos ha publicado el tercer volumen de su Observatorio de Casos de Uso (Use Case Observatory, en inglés), un informe que recopila la evolución de proyectos de reutilización de datos en toda Europa. Esta iniciativa pone de relieve los avances logrados en cuatro áreas: impacto económico, gubernamental, social y medioambiental.

El cierre de una investigación de tres años

Entre 2022 y 2025, el portal europeo de datos abiertos ha llevado a cabo un seguimiento sistemático de la evolución de diversos proyectos europeos. La investigación comenzó con una selección inicial de 30 iniciativas representativas, que fueron analizadas en profundidad para identificar su potencial de impacto.

Tras dos años, 13 proyectos continuaron en el estudio, entre los que se encontraban tres españoles: Planttes, Tangible Data y UniversiDATA-Lab. Se estudió su desarrollo a lo largo del tiempo para comprender cómo la reutilización de datos abiertos puede generar beneficios reales y sostenibles.

La publicación del volumen III en octubre de 2025 marca el cierre de esta serie de informes, tras el volumen I (2022) y el volumen II (2024). Este último documento ofrece una visión longitudinal, mostrando cómo los proyectos han madurado en tres años de observación y qué impactos concretos han generado en sus respectivos contextos.

Conclusiones comunes

Este tercer y último informe recopila una serie de conclusiones clave:

Impacto económico

Los datos abiertos impulsan el crecimiento y la eficiencia en todos los sectores. Contribuyen a la creación de empleo, tanto de forma directa como indirecta, facilitan procesos de contratación más inteligentes y estimulan la innovación en ámbitos como la planificación urbana y los servicios digitales.

El informe muestra el ejemplo de:

- Naar Jobs (Bélgica): una aplicación para la búsqueda de empleo cerca del domicilio de los usuarios y focalizada en las opciones de transporte disponible.

Esta aplicación demuestra cómo los datos abiertos pueden convertirse en un motor para el empleo regional y el desarrollo empresarial.

Impacto gubernamental

La apertura de datos fortalece la transparencia, la rendición de cuentas y la participación ciudadana.

A este campo pertenecen dos casos de uso analizados:

- Waar is mijn stemlokaal? (Holanda): plataforma para la búsqueda de colegios electorales.

- Statsregnskapet.no (Noruega): web para visualizar los ingresos y gastos del gobierno.

Ambos ejemplos evidencian cómo el acceso a la información pública empodera a los ciudadanos, enriquece el trabajo de los medios de comunicación y respalda la elaboración de políticas basadas en evidencia. Todo ello ayuda a reforzar los procesos democráticos y la confianza en las instituciones.

Impacto social

Los datos abiertos promueven la inclusión, la colaboración y el bienestar.

A este campo pertenecen las siguientes iniciativas analizadas:

- UniversiDATA-Lab (España): repositorio de datos universitarios que facilita aplicaciones analíticas.

- VisImE-360 (Italia): herramienta para mapear la discapacidad visual y orientar recursos sanitarios.

- Tangible Data (España): empresa centrada en realizar esculturas físicas que convierten datos en experiencias accesibles.

- EU Twinnings (Países Bajos): plataforma que compara regiones europeas para encontrar “ciudades gemelas”

- Open Food Facts (Francia): base de datos colaborativa sobre productos alimenticios.

- Integreat (Alemania): aplicación que centraliza información pública para apoyar la integración de migrantes.

Todos ellos muestran cómo las soluciones basadas en datos pueden amplificar la voz de los colectivos vulnerables, mejorar los resultados en salud y abrir nuevas oportunidades educativas. Incluso los efectos más pequeños, como la mejora en la vida de una sola persona, pueden resultar significativos y duraderos.

Impacto medioambiental

Los datos abiertos actúan como un poderoso facilitador de la sostenibilidad.

Al igual que pasaba con el impacto ambiental, en esta área encontramos un gran número de casos de uso:

- Digital Forest Dryads (Estonia): proyecto que emplea datos para monitorizar los bosques y fomentar su conservación.

- Air Quality in Cyprus (Chipre): plataforma que informa sobre la calidad del aire y apoya políticas ambientales.

- Planttes (España): aplicación de ciencia ciudadana que ayuda a personas con alergias al polen mediante el seguimiento de la fenología de plantas.

- Environ-Mate (Irlanda): herramienta que promueve hábitos sostenibles y conciencia ecológica.

Estas iniciativas ponen de relieve cómo la reutilización de datos contribuye a sensibilizar, impulsar cambios de comportamiento y permitir intervenciones específicas para proteger los ecosistemas y fortalecer la resiliencia climática.

El volumen III también señala retos comunes: la necesidad de financiación sostenible, la importancia de combinar datos institucionales con datos generados por la ciudadanía y la conveniencia de involucrar a los usuarios finales en todo el ciclo de vida de los proyectos. Además, subraya la importancia de la colaboración europea y la interoperabilidad transnacional para escalar el impacto.

En conjunto, el informe refuerza la relevancia de seguir invirtiendo en ecosistemas de datos abiertos como herramienta clave para afrontar desafíos sociales y promover una transformación inclusiva.

El impacto de los proyectos españoles en la reutilización de datos abiertos

Como hemos mencionado, tres de los casos de uso analizados en el Use Case Observatory tienen sello español. Estas iniciativas destacan por su capacidad de combinar innovación tecnológica con impacto social y medioambiental, y ponen de manifiesto la relevancia de España dentro del ecosistema europeo de datos abiertos. Su trayectoria demuestra cómo nuestro país contribuye activamente a transformar los datos en soluciones que mejoran la vida de las personas y refuerzan la sostenibilidad y la inclusión. A continuación, hacemos un zoom en lo que el informe dice sobre ellas.

Esta iniciativa de ciencia ciudadana ayuda a personas con alergias al polen mediante información en tiempo real sobre plantas alergénicas en floración. Desde su aparición en el Volumen I del Use Case Observatory, ha evolucionado como plataforma participativa en la que los usuarios aportan fotos y datos fenológicos para crear un mapa de riesgo personalizado. Este modelo participativo ha permitido mantener un flujo constante de información validada por investigadores y ofrecer mapas cada vez más completos. Con más de 1.000 descargas iniciales y unos 65.000 visitantes anuales en su web, es una herramienta útil para personas con alergias, educadores e investigadores.

El proyecto ha reforzado su presencia digital, con una creciente visibilidad gracias al apoyo de instituciones como la Universidad Autónoma de Barcelona y la Universidad de Granada, además de la promoción realizada por la empresa Thigis.

Entre sus retos figuran ampliar la cobertura geográfica más allá de Cataluña y Granada y sostener la participación y validación de datos. Por ello, de cara al futuro, busca extender su alcance territorial, fortalecer la colaboración con escuelas y comunidades, integrar más datos en tiempo real y mejorar sus capacidades predictivas.

A lo largo de este tiempo, Planttes se ha consolidado como un ejemplo de cómo la ciencia impulsada por la ciudadanía puede mejorar la salud pública y la conciencia ambiental, demostrando el valor de la ciencia ciudadana en la educación ambiental, la gestión de alergias y el seguimiento del cambio climático.

El proyecto transforma conjuntos de datos en esculturas físicas que representan retos globales como el cambio climático o la pobreza, integrando códigos QR y NFC para contextualizar la información. Reconocido en los EU Open Data Days 2025, Tangible Data ha inaugurado su instalación Tangible climate en el Museo Nacional de Ciencias Naturales de Madrid.

Tangible Data ha evolucionado en tres años desde un proyecto prototipo basado en esculturas 3D para visualizar datos de sostenibilidad hasta convertirse en una plataforma educativa y cultural que conecta los datos abiertos con la sociedad. El Volumen III del Use Case Observatory refleja su expansión en escuelas y museos, la creación de un programa educativo para estudiantes de 15 años y el desarrollo de experiencias interactivas con inteligencia artificial, consolidando su compromiso con la accesibilidad y el impacto social.

Entre sus retos destacan la financiación y la ampliación del programa educativo, mientras que sus objetivos futuros incluyen escalar las actividades escolares, exhibir esculturas de gran formato en espacios públicos y reforzar la colaboración con artistas y museos. En conjunto, sigue fiel a su misión de hacer los datos tangibles, inclusivos y accionables.

UniversiDATA-Lab es un repositorio dinámico de aplicaciones analíticas basadas en datos abiertos de universidades españolas, creado en 2020 como colaboración público-privada y actualmente integrado por seis instituciones. Su infraestructura unificada facilita la publicación y reutilización de datos en formatos estandarizados, reduciendo barreras y permitiendo que estudiantes, investigadores, empresas y ciudadanos accedan a información útil para la educación, la investigación y la toma de decisiones.

En los últimos tres años, el proyecto ha pasado de ser un prototipo a una plataforma consolidada, con aplicaciones activas como el visor de presupuestos y de jubilaciones, y un visor de contratación en fase beta. Además, organiza un datathon periódico que impulsa la innovación y proyectos con impacto social.

Entre sus retos destacan la resistencia interna en algunas universidades y la compleja anonimización de datos sensibles, aunque ha respondido con protocolos sólidos y un enfoque en la transparencia. De cara al futuro, busca ampliar su catálogo, sumar nuevas universidades y lanzar aplicaciones sobre cuestiones emergentes como abandono escolar, diversidad del profesorado o sostenibilidad, aspirando a convertirse en referente europeo en reutilización de datos abiertos en educación superior.

Conclusión

Como conclusión, el tercer volumen del Use Case Observatory confirma que los datos abiertos se han consolidado como una herramienta clave para impulsar la innovación, la transparencia y la sostenibilidad en Europa. Los proyectos analizados —y en particular las iniciativas españolas Planttes, Tangible Data y UniversiDATA-Lab— demuestran que la reutilización de la información pública puede traducirse en beneficios concretos para la ciudadanía, la educación, la investigación y el medio ambiente.

En todo entorno de gestión de datos (empresas, Administración pública, consorcios, proyectos de investigación), disponer de datos no basta: si no sabes qué datos tienes, dónde están, qué significan, quién los mantiene, con qué calidad, cuándo cambiaron o cómo se relacionan con otros datos, entonces el valor es muy limitado. Los metadatos —datos sobre los datos— son esenciales para:

-

Visibilidad y acceso: permitir que usuarios encuentren qué datos existen y puedan acceder.

-

Contextualización: saber qué significan los datos (definiciones, unidades, semántica).

-

Trazabilidad / linaje: entender de dónde vienen los datos y cómo han sido transformados.

-

Gobierno y control: conocer quién es responsable, qué políticas aplican, permisos, versiones, obsolescencia.

-

Calidad, integridad y consistencia: asegurar la fiabilidad de los datos mediante reglas, métricas y monitoreo.

-

Interoperabilidad: garantizar que diferentes sistemas o dominios puedan compartir datos, utilizando un vocabulario común, definiciones compartidas y relaciones explícitas.

En resumen, los metadatos son la palanca que convierte los datos “aislados” en un ecosistema de información gobernada. A medida que los datos crecen en volumen, diversidad y velocidad, su función va más allá de la simple descripción: los metadatos añaden contexto, permiten interpretar los datos y facilitan que puedan ser encontrados, accesibles, interoperables y reutilizables (FAIR).

En el nuevo contexto impulsado por la inteligencia artificial, esta capa de metadatos adquiere una relevancia aún mayor, ya que proporciona la información de procedencia (provenance) necesaria para garantizar la trazabilidad, la fiabilidad y la reproducibilidad de los resultados. Por ello, algunos marcos recientes amplían estos principios hacia FAIR-R, donde la “R” adicional resalta la importancia de que los datos estén listos para la IA (AI-ready), es decir, que cumplen una serie de requisitos técnicos, estructurales y de calidad que optimizan su aprovechamiento por parte de los algoritmos de inteligencia artificial.

Así, hablamos de metadatos enriquecidos, capaces de conectar información técnica, semántica y contextual para potenciar el aprendizaje automático, la interoperabilidad entre dominios y la generación de conocimiento verificable.

De los metadatos tradicionales a los “metadatos enriquecidos”

Metadatos tradicionales

En el contexto de este artículo, cuando hablamos de metadatos con un uso tradicional, pensamos en catálogos, diccionarios, glosarios, modelos de datos de base de datos, y estructuras rígidas (tablas y columnas). Los tipos de metadatos más comunes son:

-

Metadatos técnicos: tipo de columna, longitud, formato, claves foráneas, índices, ubicaciones físicas.

-

Metadatos de negocio / semánticos: nombre de campo, descripción, dominio de valores, reglas de negocio, términos del glosario empresarial.

-

Metadatos operativos / de ejecución: frecuencia de actualización, última carga, tiempos de procesamiento, estadísticas de uso.

-

Metadatos de calidad: porcentaje de valores nulos, duplicados, validaciones.

-

Metadatos de seguridad / acceso: políticas de acceso, permisos, clasificación de sensibilidad.

-

Metadatos de linaje: rastreo de transformación en los pipelines de datos.

Estos metadatos se almacenan usualmente en repositorios o herramientas de catalogación, muchas veces con estructuras tabulares o en bases relacionales, con vínculos predefinidos.

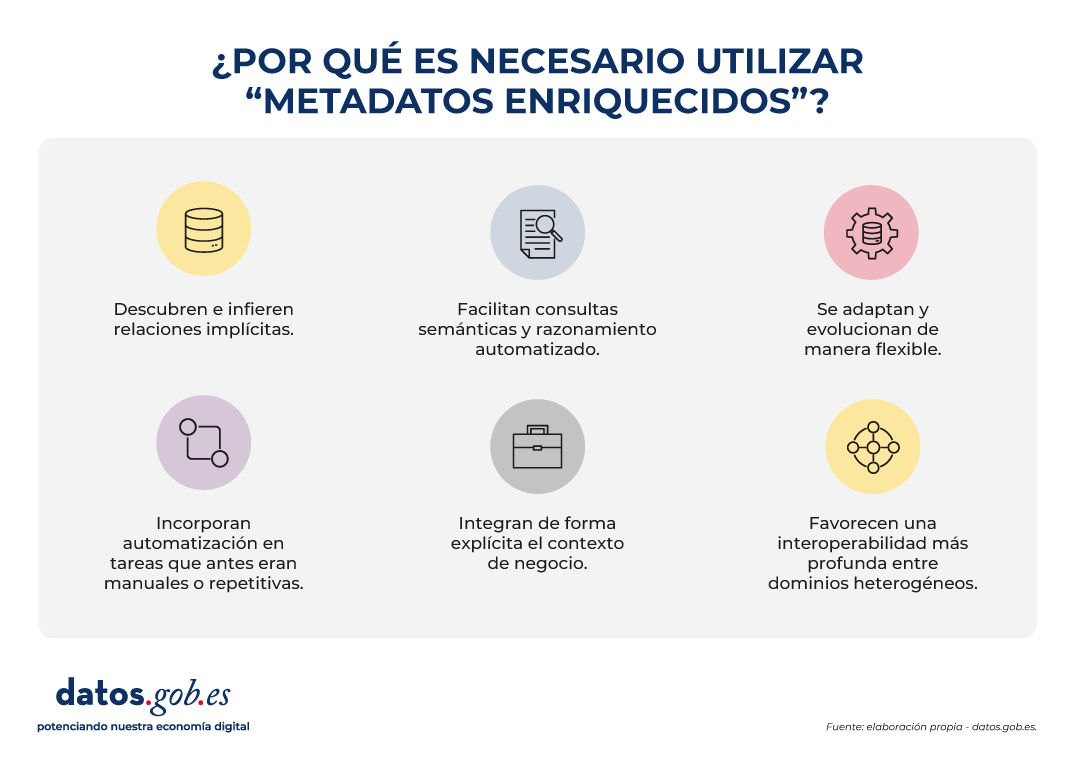

¿Por qué metadatos enriquecidos?

Los metadatos enriquecidos son aquella capa que no solo describe atributos, sino que:

- Descubren e infieren relaciones implícitas, identificando vínculos que no están expresamente definidos en los esquemas de datos. Esto permite, por ejemplo, reconocer que dos variables con nombres diferentes en sistemas distintos representan en realidad el mismo concepto (“altitud” y “elevación”), o que ciertos atributos mantienen una relación jerárquica (“municipio” pertenece a “provincia”).

- Facilitan consultas semánticas y razonamiento automatizado, permitiendo que los usuarios y las máquinas exploren relaciones y patrones que no están explícitamente definidos en las bases de datos. En lugar de limitarse a buscar coincidencias exactas de nombres o estructuras, los metadatos enriquecidos permiten formular preguntas basadas en significado y contexto. Por ejemplo, identificar automáticamente todos los conjuntos de datos relacionados con “ciudades costeras” aunque el término no aparezca literalmente en los metadatos.

- Se adaptan y evolucionan de manera flexible, ya que pueden ampliarse con nuevos tipos de entidades, relaciones o dominios sin necesidad de rediseñar toda la estructura del catálogo. Esto permite incorporar fácilmente nuevas fuentes de datos, modelos o estándares, garantizando la sostenibilidad del sistema a largo plazo.

- Incorporan automatización en tareas que antes eran manuales o repetitivas, como la detección de duplicidades, el emparejamiento automático de conceptos equivalentes o el enriquecimiento semántico mediante aprendizaje automático. También pueden identificar incoherencias o anomalías, mejorando la calidad y la coherencia de los metadatos.

- Integran de forma explícita el contexto de negocio, enlazando cada activo de datos con su significado operativo y su rol dentro de los procesos organizativos. Para ello utilizan vocabularios controlados, ontologías o taxonomías que facilitan un entendimiento común entre equipos técnicos, analistas y responsables de negocio.

- Favorecen una interoperabilidad más profunda entre dominios heterogéneos, que va más allá del intercambio sintáctico facilitado por los metadatos tradicionales. Los metadatos enriquecidos añaden una capa semántica que permite comprender y relacionar los datos en función de su significado, no solo de su formato. Así, datos procedentes de diferentes fuentes o sectores —por ejemplo, Sistemas de información Geográfica (GIS en inglés), Building Information Modeling (BIM) o Internet de las Cosas (IoT)— pueden vincularse de manera coherente dentro de un marco conceptual compartido. Esta interoperabilidad semántica es la que posibilita integrar conocimiento y reutilizar información entre contextos técnicos y organizativos diversos.

Esto convierte los metadatos en un activo vivo, enriquecido y conectado con el conocimiento del dominio, no solo un “registro” pasivo.

La evolución de los metadatos: ontologías y grafos de conocimiento

La incorporación de ontologías y grafos de conocimiento representa una evolución conceptual en la manera de describir, relacionar y aprovechar los metadatos, de ahí que hablemos de metadatos enriquecidos. Estas herramientas no solo documentan los datos, sino que los conectan dentro de una red de significado, permitiendo que las relaciones entre entidades, conceptos y contextos sean explícitas y computables.

En el contexto actual, marcado por el auge de la inteligencia artificial, esta estructura semántica adquiere un papel fundamental: proporciona a los algoritmos el conocimiento contextual necesario para interpretar, aprender y razonar sobre los datos de forma más precisa y transparente. Ontologías y grafos permiten que los sistemas de IA no solo procesen información, sino que entiendan las relaciones entre los elementos y puedan generar inferencias fundamentadas, abriendo el camino hacia modelos más explicativos y confiables.

Este cambio de paradigma transforma los metadatos en una estructura dinámica, capaz de reflejar la complejidad del conocimiento y de facilitar la interoperabilidad semántica entre distintos dominios y fuentes de información. Para comprender esta evolución conviene definir y relacionar algunos conceptos:

Ontologías

En el mundo de los datos, una ontología es un mapa conceptual muy organizado que define claramente:

- Qué entidades existen (ej. ciudad, río, carretera).

- Qué propiedades tienen (ej. una ciudad tiene nombre, población, código postal).

- Cómo se relacionan entre sí (ej. un río atraviesa una ciudad, una carretera conecta dos municipios).

El objetivo es que personas y máquinas compartan un mismo vocabulario y entiendan los datos de la misma manera. Las ontologías permiten:

- Definir conceptos y relaciones: por ejemplo, “una parcela pertenece a un municipio”, “un edificio tiene coordenadas geográficas”.

- Poner reglas y restricciones: como “cada edificio debe estar exactamente en una parcela catastral”.

- Unificar vocabularios: si en un sistema se dice “parcela” y en otro “unidad catastral”, la ontología ayuda a reconocer que son análogos.

- Hacer inferencias: a partir de datos simples, descubrir nuevo conocimiento (si un edificio está en una parcela y la parcela en Sevilla, se puede inferir que el edificio está en Sevilla).

- Establecer un lenguaje común: funcionan como un diccionario compartido entre distintos sistemas o dominios (GIS, BIM, IoT, catastro, urbanismo).

En resumen: una ontología es el diccionario y las reglas del juego que permiten que diferentes sistemas geoespaciales (mapas, catastro, sensores, BIM, etc.) se entiendan entre sí y puedan trabajar de manera integrada.

Grafos de conocimiento (Knowledge Graphs)

Un grafo de conocimiento es una forma de organizar información como si fuera una red de conceptos conectados entre sí.

-

Los nodos representan cosas o entidades, como una ciudad, un río o un edificio.

-

Las aristas (líneas) muestran las relaciones entre ellas, por ejemplo: “está en”, “atraviesa” o “pertenece a”.

-

A diferencia de un simple dibujo de conexiones, un grafo de conocimiento también explica el significado de esas relaciones: añade semántica.

Un grafo de conocimiento combina tres elementos principales:

-

Datos: los casos concretos o instancias, como “Sevilla”, “Río Guadalquivir” o “Edificio Ayuntamiento de Sevilla”.

-

Semántica (u ontología): las reglas y vocabularios que definen qué tipos de cosas existen (ciudades, ríos, edificios) y cómo pueden relacionarse entre sí.

-

Razonamiento: la capacidad de descubrir nuevas conexiones a partir de las existentes (por ejemplo, si un río atraviesa una ciudad y esa ciudad está en España, el sistema puede deducir que el río está en España).

Además, los grafos de conocimiento permiten conectar información de distintos ámbitos (por ejemplo, datos sobre personas, lugares y empresas) bajo un mismo lenguaje común, facilitando el análisis y la interoperabilidad entre disciplinas.

En otras palabras, un knowledge graph es el resultado de aplicar una ontología (el modelo de datos) a varios conjuntos de datos individuales (elementos espaciales, otros datos del territorio, registros de pacientes o productos de catálogo, etc.). Los grafos de conocimiento son ideales para integrar datos heterogéneos, porque no requieren un esquema rígido previamente completo: se pueden ir creciendo de forma flexible. Además, permiten consultas semánticas y navegación con relaciones complejas. A continuación, se pone un ejemplo para datos espaciales con los que entender las diferencias:

|

Ontología de datos espaciales (modelo conceptual) |

Grafo de conocimiento (ejemplos concretos con instancias) |

|---|---|

|

|

|

|

Casos de uso

Para entender mejor el valor de los metadatos inteligentes y los catálogos semánticos, nada mejor que mirar ejemplos donde ya se están aplicando. Estos casos muestran cómo la combinación de ontologías y grafos de conocimiento permite conectar información dispersa, mejorar la interoperabilidad y generar conocimiento accionable en distintos contextos.

Desde la gestión de emergencias hasta la planificación urbana o la protección del medio ambiente, diferentes proyectos internacionales han demostrado que la semántica no es solo teoría, sino una herramienta práctica que transforma datos en decisiones.

Algunos ejemplos relevantes incluyen:

- LinkedGeoData que convirtió datos de OpenStreetMap en Linked Data, enlazándolos con otras fuentes abiertas.

- Virtual Singapore un gemelo digital 3D que integra datos geoespaciales, urbanos y en tiempo real para simulación y planificación.

- JedAI-spatial una herramienta para interconectar datos espaciales en 3D mediante relaciones semánticas.

- SOSA Ontology, estándar ampliamente usado en proyectos de sensores e IoT para observaciones ambientales con componente geoespacial.

- Proyectos europeos de permisos digitales de construcción (ej. ACCORD), que combinan catálogos semánticos, modelos BIM y datos GIS para validar automáticamente normativas de construcción.

Conclusiones

La evolución hacia metadatos enriquecidos, apoyados en ontologías, grafos de conocimiento y principios FAIR-R, representa un cambio sustancial en la manera de gestionar, conectar y comprender los datos. Este nuevo enfoque convierte los metadatos en un componente activo de la infraestructura digital, capaz de aportar contexto, trazabilidad y significado, y no solo de describir información.

Los metadatos enriquecidos permiten aprender de los datos, mejorar la interoperabilidad semántica entre dominios y facilitar consultas más expresivas, donde las relaciones y dependencias pueden descubrirse de forma automatizada. De este modo, favorecen la integración de información dispersa y apoyan tanto la toma de decisiones informadas como el desarrollo de modelos de inteligencia artificial más explicativos y confiables.

En el ámbito de los datos abiertos, estos avances impulsan la transición desde repositorios descriptivos hacia ecosistemas de conocimiento interconectado, donde los datos pueden combinarse y reutilizarse de manera flexible y verificable. La incorporación de contexto semántico y procedencia (provenance) refuerza la transparencia, la calidad y la reutilización responsable.

Esta transformación requiere, sin embargo, un enfoque progresivo y bien gobernado: es fundamental planificar la migración de sistemas, garantizar la calidad semántica, y promover la participación de comunidades multidisciplinares.

En definitiva, los metadatos enriquecidos son la base para pasar de datos aislados a conocimiento conectado y trazable, elemento clave para la interoperabilidad, la sostenibilidad y la confianza en la economía de los datos.

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autora

La Diputación Foral de Bizkaia ha lanzado el Reto del Periodismo de Datos, un concurso dirigido a premiar la creatividad, el rigor y el talento en el uso de datos abiertos. Esta iniciativa busca impulsar proyectos periodísticos que utilicen los datos públicos disponibles en la plataforma Open Data Bizkaia para crear contenidos informativos con un fuerte componente visual. Ya sea a través de gráficos interactivos, mapas, vídeos animados o reportajes profundos, el objetivo es transformar los datos en narrativas que conecten con la ciudadanía.

¿Quién puede participar?

La convocatoria está abierta a personas físicas mayores de 18 años, tanto de forma individual como en equipos de hasta cuatro integrantes. Cada participante podrá presentar propuestas en una o varias de las categorías disponibles.

Es una oportunidad de especial relevancia para estudiantes, personas emprendedoras, desarrolladoras y desarrolladores, profesionales del diseño o periodistas con interés en los datos abiertos.

Tres categorías para impulsar el uso de los datos abiertos

El concurso se divide en tres categorías, cada una con su propio enfoque y criterios de evaluación:

-

Representación dinámica de datos: proyectos que presenten datos de forma interactiva, clara y visualmente atractiva.

-

Data storytelling a través del vídeo de animación: narrativas audiovisuales que expliquen fenómenos o tendencias usando datos públicos.

-

Reportaje + Datos: artículos periodísticos que integren análisis de datos con investigación y profundidad informativa.

Como hemos mencionado previamente, todos los proyectos deben basarse en los datos públicos disponibles en la plataforma Open Data Bizkaia, que ofrece información sobre múltiples áreas: economía, medio ambiente, movilidad, salud, cultura, etc. Es una fuente rica y accesible para construir historias relevantes y bien fundamentadas.

Hasta 4.500 euros en premios

Para cada categoría se otorgarán los siguientes premios:

-

Primer lugar: 1.500 euros

-

Segundo lugar: 750 euros

Los premios estarán sujetos a las retenciones fiscales correspondientes. Dado que una misma persona puede presentar propuestas a varias categorías, y que estas serán evaluadas de manera independiente, es posible que un único participante gane más de un premio. Por tanto, un único participante podrá llevarse hasta 4.500 euros, si gana en las tres categorías.

¿Cuáles son los criterios de evaluación?

La concesión de los premios se realizará mediante el procedimiento de concurrencia competitiva. Todos los proyectos recibidos en el periodo habilitado para ello serán evaluados por el jurado, conforme a una serie de criterios específicos para cada categoría:

-

Representación dinámica de datos:

-

Claridad comunicativa (30%)

-

Interactividad (25%)

-

Diseño y usabilidad (20%)

-

Originalidad en la representación (15%)

-

Rigor y fidelidad de los datos (10%)

-

Data storytelling en vídeo de animación

-

Narrativa y guion (30%)

-

Creatividad visual e innovación técnica (25%)

-

Claridad informativa (20%)

-

Impacto emocional y estético (15%)

-

Uso riguroso y honesto de los datos (10%)

-

Reportaje + Datos

-

Calidad periodística y profundidad analítica (30%)

-

Integración narrativa de los datos (25%)

-

Originalidad en el enfoque y el formato (20%)

-

Diseño y experiencia de usuario (15%)

-

Transparencia y trazabilidad de las fuentes (10%)

¿Cómo se presentan las solicitudes?

El plazo para presentar los proyectos comenzó el 3 de noviembre y estará abierto hasta el 3 de diciembre de 2025 a las 23:59. Las solicitudes podrán presentarse de diversas maneras:

-

Electrónicamente, a través de la sede electrónica de Bizkaia, utilizando el código de trámite 2899.

-

Presencialmente, en el Registro General de la Oficina Laguntza (c/ Diputación, 7, Bilbao), en cualquier otro registro público o en las oficinas de Correos.

En el caso de proyectos grupales, se deberá presentar una única solicitud firmada por una persona representante. Esta persona asumirá la interlocución con la Dirección General organizadora, encargándose de los trámites y del cumplimiento de las obligaciones correspondientes.

La documentación que se debe presentar es:

-

El proyecto a evaluar.

-

El certificado de estar al corriente en las obligaciones tributarias.

-

El certificado de estar al corriente en las obligaciones con la Seguridad Social.

-

La ficha de domiciliación bancaria, solo en caso de que la persona solicitante se oponga que esta Administración compruebe los datos bancarios por sus propios medios.

Información de contacto

Para consultas o información adicional, se puede contactar con la Diputación Foral de Bizkaia. En concreto, con el Departamento de Administración Pública y Relaciones Institucionales, Sección de Asesoramiento Técnico c/ Gran Vía, 2 (48009) en la ciudad de Bilbao. También se atenderán dudas en el teléfono 944 068 000 y en el correo electrónico SAT@bizkaia.eus.

Este concurso representa una oportunidad para explorar el potencial del periodismo de datos y contribuir a una comunicación más transparente y accesible. Los proyectos presentados podrán de manifiesto el potencial de los datos abiertos para facilitar la comprensión de temas de interés público, de forma clara y sencilla.

Para más detalles, se recomienda leer la información disponible en su página web.

El pasado 6 de octubre se aprobó el V Plan de Gobierno Abierto, una iniciativa que da continuidad al compromiso de las Administraciones públicas con la transparencia, la participación ciudadana y la rendición de cuentas. Este nuevo plan, que estará vigente hasta 2029, recoge 218 medidas agrupadas en 10 compromisos que afectan a los diversos niveles de la Administración.

En este artículo vamos a repasar las claves del Plan, centrándonos en aquellos compromisos relacionados con los datos y el acceso a la información pública.

Un documento fruto de la colaboración

El proceso de elaboración del V Plan de Gobierno Abierto se ha desarrollado de forma participativa y colaborativa, con el objetivo de recoger propuestas de distintos actores sociales. Para ello, se abrió una consulta pública en la que ciudadanos, organizaciones de la sociedad civil y representantes institucionales pudieron aportar ideas y sugerencias. También se desarrollaron una serie de talleres deliberativos. En total, se recibieron 620 aportaciones de la sociedad civil y más de 300 propuestas de ministerios, comunidades y ciudades autónomas, y representantes de las entidades locales.

Estas contribuciones se analizaron y se integraron en los compromisos del plan, que fueron posteriormente validados por el Foro de Gobierno Abierto. El resultado es un documento que refleja una visión compartida sobre cómo avanzar en transparencia, participación y rendición de cuentas en el conjunto de las Administraciones públicas.

10 líneas de acción principales con un papel destacado para los datos abiertos

Futo de ese trabajo colaborativo, se han fijado 10 líneas de acción. Los nueve primeros compromisos recogen iniciativas de la Administración General del Estado (AGE), mientras que el décimo agrupa las aportaciones de comunidades autónomas y entidades locales:

- Participación y espacio cívico.

- Transparencia y acceso a la información.

- Integridad y rendición de cuentas.

- Administración abierta.

- Gobernanza digital e inteligencia artificial.

- Apertura fiscal: cuentas claras y abiertas.

- Información veraz / ecosistema informativo.

- Difusión, formación y promoción del gobierno abierto.

- Observatorio de gobierno abierto.

- Estado abierto.

Figura 1. 10 líneas de acción del V Plan de Gobierno Abierto. Fuente: Ministerio de Inclusión, Seguridad Social y Migraciones.

Los datos y la información pública son un elemento clave en todos ellos. No obstante, la mayoría de medidas relacionadas con este campo las encontramos dentro de la línea de acción 2, donde se sitúa un apartado específico sobre apertura y reutilización de datos de la información pública. Entre las medidas previstas, se contempla:

- Modelo de gobernanza de datos: se propone crear un marco normativo que facilite el uso responsable y eficiente del dato público en la AGE. Incluye la regulación de órganos colegiados para el intercambio de datos, la aplicación de normativa europea y la creación de espacios institucionales para diseñar políticas públicas basadas en datos.

- Estrategia del dato para una administración centrada en el ciudadano: se busca establecer un marco estratégico para el uso ético y transparente de los datos en la Administración.

- Publicación de microdatos de encuestas electorales: se modificará la Ley Electoral para incluir la obligación de publicar los microdatos anonimizados de las encuestas electorales. Esto permite mejorar la fiabilidad de los estudios y facilitar el acceso abierto a datos individuales para su análisis.

- Apoyo a entidades locales en la apertura de datos: se ha lanzado un programa de ayudas para fomentar la apertura de datos homogéneos y de calidad en las entidades locales mediante convocatorias y/o convenios de colaboración. Además, se promoverá su reutilización mediante acciones de sensibilización, desarrollo de soluciones demostradoras y colaboración interadministrativa para impulsar la innovación pública.

- Apertura de datos en la Administración de Justicia: se continuarán publicando datos oficiales sobre justicia en portales públicos, con el objetivo de hacer la Administración de Justicia más transparente y accesible.

- Acceso e integración de información geoespacial de alto valor: se busca facilitar la reutilización de datos espaciales de alto valor en categorías como geoespacial, medio ambiente y movilidad. La medida incluye el desarrollo de mapas digitales, bases topográficas y una API para mejorar el acceso a esta información por parte de ciudadanos, administraciones y empresas.

- Datos abiertos del BORME: se trabajará para fomentar la publicación del contenido del Boletín Oficial del Registro Mercantil, especialmente la sección de empresarios, como datos abiertos en formatos legibles por máquina y accesibles mediante API.

- Bases de datos del Archivo Central de Hacienda: se impulsa la puesta a disposición pública de los registros del Archivo Central del Ministerio de Hacienda que no contengan datos personales ni estén sujetos a restricciones legales.

- Acceso seguro a datos públicos confidenciales para investigación e innovación: se quiere establecer un marco de gobernanza y entornos controlados que permitan a investigadores acceder de forma segura y ética a datos públicos sujetos a confidencialidad.

- Fomento del uso secundario del dato de salud: se continuará trabajando en el Espacio Nacional de Datos de Salud (ENDS), alineado con la normativa europea, para facilitar el uso de datos sanitarios con fines de investigación, innovación y políticas públicas. La medida incluye el fomento de infraestructuras técnicas, marcos normativos y garantías éticas para proteger la privacidad de los ciudadanos.

- Impulso de ecosistemas de datos para el progreso social: se busca promover espacios colaborativos de datos entre entidades públicas y privadas, bajo reglas claras de gobernanza. Estos ecosistemas ayudarán a desarrollar soluciones innovadoras que respondan a necesidades sociales, fomentando la confianza, la transparencia y el retorno justo de beneficios a la ciudadanía.

- Puesta en valor del dato público de calidad para ciudadanos y empresas: se continuará impulsando la generación de datos de calidad en los diferentes ministerios y organismos, para que se integren en el catálogo centralizado de información reutilizable de la AGE.

- Evolución de la plataforma datos.gob.es: se continúa trabajando en la optimización de datos.gob.es,. Esta medida forma parte de un continuo enriquecimiento para hacer frente a las cambiantes necesidades ciudadanas y tendencias emergentes.

Además de en este epígrafe específico, también se incluyen medidas relacionadas con los datos abiertos en otros apartados. Por ejemplo, la medida 3.5.5 propone transformar la Plataforma de Contratación del Sector Público en una herramienta avanzada que utilice Big Data e Inteligencia Artificial para reforzar la transparencia y prevenir la corrupción. Los datos abiertos juegan aquí un papel central, ya que permiten realizar auditorías masivas y análisis estadísticos para detectar patrones irregulares en los procesos de contratación. Además, al facilitar el acceso ciudadano a esta información, se promueve la fiscalización social y el control democrático sobre el uso de fondos públicos.

Otro ejemplo lo encontramos en la medida 4.1.1, donde se propone desarrollar una herramienta digital para la Administración General del Estado que incorpore desde su diseño los principios de transparencia y dato abierto. El sistema permitiría la trazabilidad, conservación, acceso y reutilización de documentos públicos, integrando criterios archivísticos, lenguaje claro y normalización documental. Además, se vincularía con el Catálogo Nacional de Datos Abiertos para asegurar que la información esté disponible en formatos abiertos y reutilizables.

El documento no solo resalta las posibilidades de los datos abiertos: también destaca las oportunidades que ofrece la Inteligencia Artificial tanto en la mejora del acceso a la información pública como en la generación de datos abiertos útiles para la toma de decisiones colectivas.

Impulso de datos abiertos en las Comunidades y Ciudades Autónomas

Como se mencionó anteriormente, el IV Plan de Gobierno Abierto también incluye compromisos adquiridos por los organismos autonómicos, los cuales se detallan en la línea de acción 10 sobre Estado abierto, muchos de ellos centrados en la disponibilidad de datos públicos.

Por ejemplo, la Generalitat de Catalunya informa de su interés en optimizar los recursos disponibles para la gestión de solicitudes de acceso a la información pública, así como en publicar los datos desagregados de los presupuestos públicos en ámbitos relacionados con la infancia o el cambio climático. Por su parte, la Junta de Andalucía quiere potenciar el acceso a la información sobre personal científico y producción científica, y desarrollar un Observatorio de datos de las universidades públicas andaluzas, entre otras medidas. Otro ejemplo lo encontramos en la Ciudad Autónoma de Melilla, que está trabajando en un Portal de Datos Abiertos.

Con respecto a la Administración local, los compromisos se han fijado a través de la Federación Española de Municipios y Provincias (FEMP). Desde la Red de Entidades Locales por la Transparencia y Participación Ciudadana de la FEMP se propone que las administraciones públicas locales publiquen, como mínimo, a elegir entre los siguientes campos: callejero; presupuestos y ejecución presupuestaria; subvenciones; contratación y licitación pública; padrón municipal; censo de vehículos; contenedores de residuos y reciclajes; registro de asociaciones; agenda cultural; alojamientos turísticos; áreas empresariales e industriales; censo de empresas o agentes económicos.

Todas estas medidas ponen de manifiesto el interés por la apertura de datos en las instituciones españolas como herramienta clave para fomentar el gobierno abierto, impulsar servicios y productos alineados con las necesidades ciudadanas y optimizar la toma de decisiones.

Un sistema de seguimiento

El seguimiento del V Plan de Gobierno Abierto se basa en un sistema reforzado de rendición de cuentas y en el uso estratégico de la plataforma digital HazLab, donde se alojan cinco grupos de trabajo, uno de ellos centrado en la transparencia y el acceso a la información.

Cada iniciativa del Plan dispone además de una ficha de seguimiento con información sobre su ejecución, cronograma y resultados, actualizada periódicamente por las unidades responsables y publicada en el Portal de la Transparencia.

Conclusiones

En conjunto, el V Plan de Gobierno Abierto busca una Administración más transparente, participativa y orientada al uso responsable de los datos públicos. Muchas de las medidas incluidas tienen como objetivo reforzar la apertura informativa, la mejora de la gestión documental y el impulso a la reutilización de datos en sectores clave como la salud, la justicia o la contratación pública. Este enfoque no solo facilita el acceso ciudadano a la información, sino que también promueve la innovación, la rendición de cuentas y una cultura de gobernanza más abierta y colaborativa.

La Inteligencia Artificial (IA) está convirtiéndose en uno de los principales motores del aumento de la productividad y la innovación tanto en el sector público como en el privado, siendo cada vez más relevante en tareas que van desde la creación de contenido en cualquier formato (texto, audio, video) hasta la optimización de procesos complejos a través de agentes de Inteligencia Artificial.

Sin embargo, los modelos avanzados de IA, y en particular los grandes modelos de lenguaje, exigen cantidades ingentes de datos para su entrenamiento, optimización y evaluación. Esta dependencia genera una paradoja: a la vez que la IA demanda más datos y de mayor calidad, la creciente preocupación por la privacidad y la confidencialidad (Reglamento General de Protección de Datos o RGPD), las nuevas reglas de acceso y uso de datos (Data Act), y los requisitos de calidad y gobernanza para sistemas de alto riesgo (Reglamento de IA), así como la inherente escasez de datos en dominios sensibles limitan el acceso a los datos reales.

En este contexto, los datos sintéticos pueden ser un mecanismo habilitador para conseguir nuevos avances, conciliando innovación y protección de la privacidad. Por una parte, permiten alimentar el progreso de la IA sin exponer información sensible, y cuando se combinan con datos abiertos de calidad amplían el acceso a dominios donde los datos reales son escasos o están fuertemente regulados.

¿Qué son los datos sintéticos y cómo se generan?

De forma sencilla, los datos sintéticos se pueden definir como información fabricada artificialmente que imita las características y distribuciones de los datos reales. La función principal de esta tecnología es reproducir las características estadísticas, la estructura y los patrones del dato real subyacente. En el dominio de las estadísticas oficiales existen casos como el del Censo de Estados Unidos que publica productos parcial o totalmente sintéticos como OnTheMap (movilidad de los trabajadores entre lugar de residencia y lugar trabajo) o el SIPP Synthetic Beta (microdatos socioeconómicos vinculados a impuestos y seguridad social).

La generación de datos sintéticos es actualmente un campo aún en desarrollo que se apoya en diversas metodologías. Los enfoques pueden ir desde métodos basados en reglas o modelado estadístico (simulaciones, bayesianos, redes causales), que imitan distribuciones y relaciones predefinidas, hasta técnicas avanzadas de aprendizaje profundo. Entre las arquitecturas más destacadas encontramos:

- Redes Generativas Adversarias (GAN): un modelo generativo, entrenado con datos reales, aprende a imitar sus características, mientras que un discriminador intenta distinguir entre datos reales y sintéticos. A través de este proceso iterativo, el generador mejora su capacidad para producir datos artificiales que son estadísticamente indistinguibles de los originales. Una vez entrenado, el algoritmo puede crear nuevos registros artificiales que son estadísticamente similares a la muestra original, pero completamente nuevos y seguros.

- Autoencoders Variacionales (VAE): Estos modelos se basan en redes neuronales que aprenden una distribución probabilística en un espacio latente de los datos de entrada. Una vez entrenado, el modelo utiliza esta distribución, para obtener nuevas observaciones sintéticas mediante el muestreo y decodificación de los vectores latentes. Los VAE son frecuentemente considerados una opción más estable y sencilla de entrenar en comparación con las GAN para la generación de datos tabulares.

- Modelos autorregresivos/jerárquicos y simuladores de dominio: utilizados, por ejemplo, en datos de historia clínica electrónica, que capturan dependencias temporales y jerárquicas. Los modelos jerárquicos estructuran el problema por niveles, primero muestrean variables de nivel superior y, después las de niveles inferiores condicionadas a las anteriores. Los simuladores de dominio codifican reglas del proceso y se calibran con datos reales, aportando control e interpretabilidad y garantizando el cumplimiento de reglas de negocio.

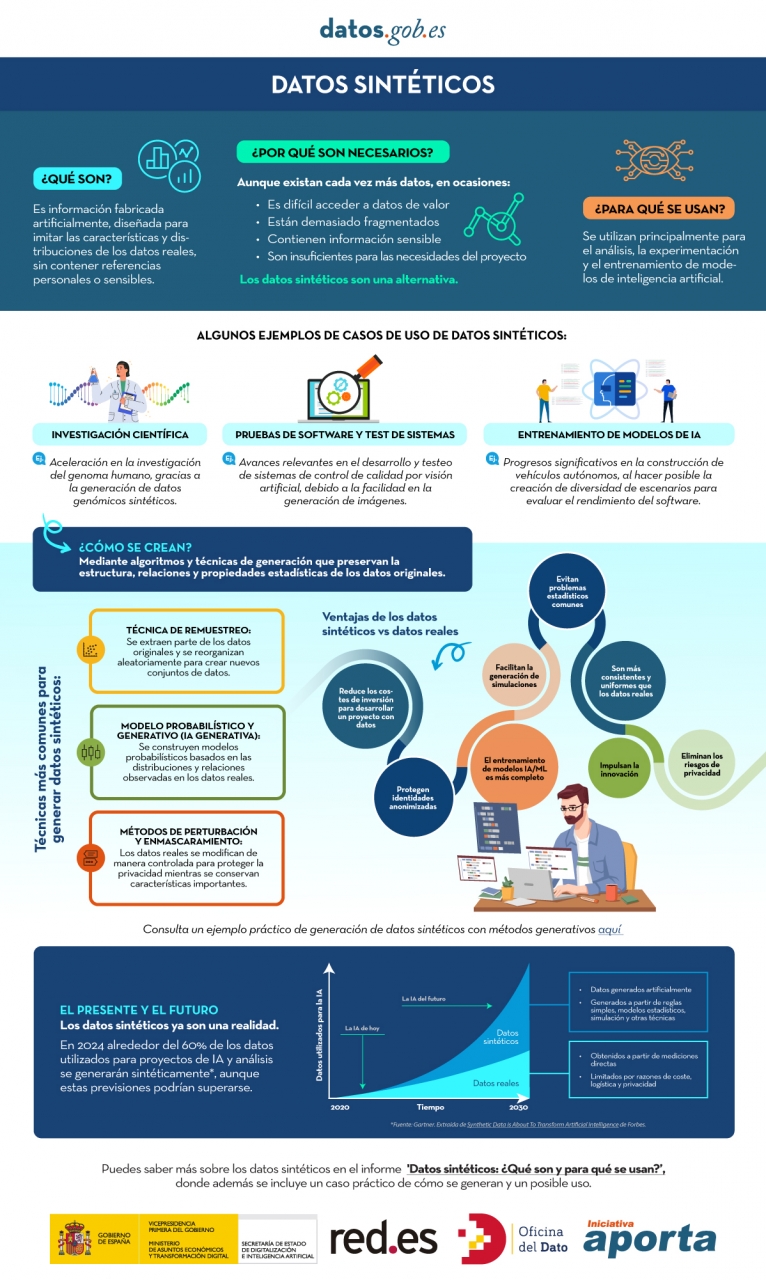

Puedes conocer más sobre los datos sintéticos y cómo se crean en esta infografía:

Figura 1. Infografía sobre datos sintéticos. Fuente: elaboración propia - datos.gob.es.

Si bien la generación sintética reduce inherentemente el riesgo de divulgación de datos personales, no lo elimina por completo. Sintético no significa automáticamente anónimo ya que, si los generadores se entrenan de forma inadecuada, pueden filtrarse trazas del conjunto real y ser vulnerables a ataques de inferencia de pertenencia (membership inference). De ahí que sea necesario utilizar Tecnologías de Mejora de la Privacidad (PET) como la privacidad diferencial y realizar evaluaciones de riesgo específicas. También el Supervisor Europeo de Protección de Datos (EDPS) ha subrayado la necesidad de realizar una evaluación de garantía de privacidad antes de que los datos sintéticos puedan ser compartidos, garantizando que el resultado no permita obtener datos personales reidentificables.

La Privacidad Diferencial (DP) es una de las tecnologías principales en este dominio. Su mecanismo consiste en añadir ruido controlado al proceso de entrenamiento o a los datos mismos, asegurando matemáticamente que la presencia o ausencia de cualquier individuo en el conjunto de datos original no altere significativamente el resultado final de la generación. El uso de métodos seguros, como el descenso de gradiente estocástico con privacidad diferencial (DP-SGD), garantiza que las muestras generadas no comprometan la privacidad de los usuarios que contribuyeron con sus datos al conjunto sensible.

¿Cuál es el papel de los datos abiertos?