Hace tan solo unos días, la Dirección General de Tráfico publicó el nuevo Programa Marco para Prueba de Vehículos Automatizados que, entre otras medidas, contempla “la entrega obligatoria de informes, tanto periódicos y finales como en caso de incidentes, que permitirán a la DGT evaluar la seguridad de las pruebas y publicar información básica […] garantizando la transparencia y la confianza pública”.

El avance de la tecnología digital está facilitando que el sector del transporte se enfrente a una revolución sin precedentes respecto a la conducción de vehículos autónomos, ofreciendo mejorar significativamente la seguridad vial, la eficiencia energética y la accesibilidad de la movilidad.

El despliegue definitivo de estos vehículos depende en gran medida de la disponibilidad, calidad y accesibilidad de grandes volúmenes de datos, así como de un marco jurídico adecuado que asegure la protección de los diversos bienes jurídicos implicados (datos personales, secreto empresarial, confidencialidad…), la seguridad del tráfico y la transparencia. En este contexto, los datos abiertos y la reutilización de la información del sector público se manifiestan como elementos esenciales para el desarrollo responsable de la movilidad autónoma, en particular a la hora de garantizar unos adecuados niveles de seguridad en el tráfico.

La dependencia de los datos en los vehículos autónomos

La tecnología que da soporte a los vehículos autónomos se sustenta en la integración de una compleja red de sensores avanzados, sistemas de inteligencia artificial y algoritmos de procesamiento en tiempo real, lo que les permite identificar obstáculos, interpretar las señales de tráfico, predecir el comportamiento de otros usuarios de la vía y, de una forma colaborativa, planificar rutas de forma completamente autónoma.

En el ecosistema de vehículos autónomos, la disponibilidad de datos abiertos de calidad resulta estratégica para:

- Mejorar la seguridad vial, de manera que puedan utilizarse datos de tráfico en tiempo real que permitan anticipar peligros, evitar accidentes y optimizar rutas seguras a partir del análisis masivo de datos.

- Optimizar la eficiencia operativa, ya que el acceso a información actualizada sobre el estado de las vías, obras, incidencias y condiciones de tráfico permite una planificación más eficiente de los desplazamientos.

- Impulsar la innovación sectorial, facilitando la creación de nuevas herramientas digitales que facilitan la movilidad.

En concreto, para garantizar un funcionamiento seguro y eficiente de este modelo de movilidad se requiere el acceso continuo a dos categorías fundamentales de datos:

- Datos variables o dinámicos, que ofrecen información en constante cambio como la posición, velocidad y comportamiento de otros vehículos, peatones, ciclistas o las condiciones meteorológicas en tiempo real.

- Datos estáticos, que comprenden información relativamente permanente como la localización exacta de señales de tráfico, semáforos, carriles, límites de velocidad o las principales características de la infraestructura viaria.

El protagonismo de los datos suministrados por las entidades públicas

Las fuentes de las que provienen tales datos son ciertamente diversas. Esto resulta de gran relevancia por lo que se refiere a las condiciones en que dichos datos estarán disponibles. En concreto, algunos de los datos son proporcionados por entidades públicas, mientras que en otros casos el origen proviene de empresas privadas (fabricantes de vehículos, proveedoras de servicios de telecomunicaciones, desarrolladoras de herramientas digitales…) con sus propios intereses o, incluso, de las personas que utilizan los espacios públicos, los dispositivos y las aplicaciones digitales.

Esta diversidad exige un diferente planteamiento a la hora de facilitar la disponibilidad de los datos en condiciones adecuadas, en concreto por las dificultades que pueden plantearse desde el punto de vista jurídico. Con relación a las Administraciones Públicas, la Directiva (UE) 2019/1024 relativa a datos abiertos y reutilización de información del sector público establece obligaciones claras que serían de aplicación, por ejemplo, a la Dirección General de Tráfico, las Administraciones titulares de las vías públicas o los municipios en el caso de los entornos urbanos. Asimismo, el Reglamento (UE) 2022/868 sobre gobernanza europea de datos refuerza este marco normativo, en particular por lo que se refiere a la garantía de los derechos de terceros y, en concreto, la protección de datos personales.

Más aún, algunos conjuntos de datos deberían proporcionarse en las condiciones establecidas para los datos dinámicos, esto es, aquellos “sujetos a actualizaciones frecuentes o en tiempo real, debido, en particular, a su volatilidad o rápida obsolescencia”, que habrán de estar disponibles “para su reutilización inmediatamente después de su recopilación, a través de las API adecuadas y, cuando proceda, en forma de descarga masiva”.

Incluso, cabría pensar que la categoría de datos de alto valor presenta un especial interés en el contexto de los vehículos autónomos dado su potencial para facilitar la movilidad, en concreto si tenemos en cuenta su potencial para:

- Impulsar la innovación tecnológica, ya que facilitarían a fabricantes, desarrolladores y operadores acceder a información fiable y actualizada, esencial para el desarrollo, validación y mejora continua de sistemas de conducción autónoma.

- Facilitar la supervisión y evaluación desde la perspectiva de la seguridad, ya que la transparencia y accesibilidad de estos datos son presupuestos esenciales desde esta perspectiva.

- Dinamizar el desarrollo de servicios avanzados, puesto que los datos sobre infraestructura vial, señalización, tráfico e, incluso, los resultados de pruebas realizadas en el contexto del citado Programa Marco constituyen la base para nuevas aplicaciones y servicios de movilidad que benefician al conjunto de la sociedad.

Sin embargo, esta condición no aparece expresamente recogida para los datos vinculados al tráfico en la definición realizada a nivel europeo, por lo que, al menos de momento, no cabría exigir a las entidades públicas la difusión de los datos que aplican a los vehículos autónomos en las singulares condiciones establecidas para los datos de alto valor. No obstante, en este momento de transición para el despliegue de los vehículos autónomos, resulta fundamental que las Administraciones públicas publiquen y mantengan actualizados en condiciones adecuadas para su tratamiento automatizado, algunos conjuntos de datos, como los relativos a:

- Señales viales y elementos de señalización vertical.

- Estados de semáforos y sistemas de control de tráfico.

- Configuración y características de carriles.

- Información sobre obras y alteraciones temporales de tráfico.

- Elementos de infraestructura vial críticos para la navegación autónoma.

La reciente actualización del catálogo oficial de señales de tráfico, que entra en vigor el 1 de julio de 2025 incorpora señalizaciones adaptadas a nuevas realidades, como es el caso de la movilidad personal. Sin embargo, requiere de una mayor concreción por lo que se refiere a la disponibilidad de los datos relativos a las señales en las referidas condiciones. Para ello será necesaria la intervención de las autoridades responsables de la señalización de las vías.

La disponibilidad de los datos en el contexto del espacio europeo de movilidad

Partiendo de estos condicionamientos y de la necesidad de disponer de los datos de movilidad generados por empresas privadas y particulares, los espacios de datos aparecen como el entorno jurídico y de gobernanza óptimo para facilitar su accesibilidad en condiciones adecuadas.

En este sentido, las iniciativas para el despliegue del espacio de datos europeo de movilidad, creado en 2023, constituyen una oportunidad para integrar en su diseño y configuración medidas que den soporte a la necesidad de acceso a los datos que exigen los vehículos autónomos. Así pues, en el marco de esta iniciativa sería posible liberar el potencial de los datos de movilidad y, en concreto:

- Facilitar la disponibilidad de los datos en condiciones específicas para las necesidades de los vehículos autónomos.

- Promover la interconexión de diversas fuentes de datos vinculadas a los medios de transporte ya existentes, pero también de los emergentes.

- Acelerar la transformación digital que suponen los vehículos autónomos.

- Reforzar la soberanía digital de la industria automovilística europea, reduciendo la dependencia de grandes corporaciones tecnológicas extranjeras.

En definitiva, los vehículos autónomos pueden suponer una transformación fundamental en la movilidad tal y como hasta ahora se ha concebido, pero su desarrollo depende entre otros factores de la disponibilidad, calidad y accesibilidad de datos suficientes y adecuados. El Proyecto de Ley de Movilidad Sostenible que actualmente se encuentra en tramitación en las Cortes Generales constituye una magnífica oportunidad para reforzar el papel de los datos a la hora de facilitar la innovación en este ámbito, lo que sin duda favorecería el desarrollo de los vehículos autónomos. Para ello será imprescindible, de una parte, contar con un entorno de compartición de datos que haga compatible el acceso a los datos con las adecuadas garantías para los derechos fundamentales y la seguridad de la información; y, de otra, diseñar un modelo de gobernanza que, como se enfatiza en el Programa impulsado por la Dirección General de Tráfico, facilite la participación colaborativa de “fabricantes, desarrolladores, importadores y operadores de flotas establecidos en España o en la Unión Europea”, lo que plantea importantes desafíos en la disponibilidad de los datos.

Contenido elaborado por Julián Valero, catedrático de la Universidad de Murcia y Coordinador del Grupo de Investigación “Innovación, Derecho y Tecnología” (iDerTec). Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El Ayuntamiento de València ha lanzado una convocatoria con el fin de premiar proyectos que fomenten la cultura de la apertura de información y los datos abiertos en la ciudad. En concreto, se busca fomentar la cultura de la transparencia gubernamental y el buen gobierno mediante la reutilización de datos abiertos.

Si estás pensando en participar, a continuación, te contamos algunas de las claves que debes tener en cuenta (aunque no olvides leer las bases completas de la convocatoria para más información).

¿En qué consisten los premios?

Los premios constan de una única categoría que engloba proyectos que demuestren el potencial de la reutilización de datos abiertos públicos, pudiéndose incluir también datos privados. En concreto, se podrán presentar aplicaciones, soluciones tecnológicas, servicios, trabajos, etc. que utilicen datos públicos de la ciudad de València para beneficiar a la comunidad.

Los requisitos que deben cumplir son los siguientes:

- Presentar un carácter innovador y poner de manifiesto su impacto en la mejora de la vida de las personas y su entorno.

- Ser de actualidad y estar implantados con carácter general, en el ámbito territorial del municipio de València. Los trabajos finales de grado, máster o tesis doctorales pueden haberse realizado en cualquier universidad, pero es obligatorio que hagan referencia y basen su investigación sobre ámbitos de transparencia en la ciudad de València.

- Usar un lenguaje inclusivo y no sexista.

- Estar redactados en castellano o valenciano.

- Tener un único autor, pudiendo tratarse de una entidad jurídica o asociación.

- Ser redactados conforme a lo indicado en las bases de la convocatoria, no pudiendo participar artículos previamente publicados en revistas.

- No haber recibido una subvención por parte del Ayuntamiento de València con el mismo objeto.

¿Quién puede participar?

El concurso está dirigido a público de amplios sectores: estudiantes, personas emprendedoras, desarrolladoras, profesionales del diseño, periodistas o cualquier ciudadano con interés en los datos abiertos.

Pueden participar tanto personas físicas como jurídicas del ámbito universitario, sector privado, entidades públicas y sociedad civil, siempre que hayan desarrollado el proyecto en el municipio de València.

¿Qué se valora y en qué consisten los premios?

Los proyectos recibidos serán valorados por un jurado que tendrá en cuenta los siguientes aspectos:

- Originalidad y grado de innovación.

- Valor público e impacto social y urbano.

- Viabilidad y sostenibilidad.

- Carácter colaborativo.

El jurado elegirá tres proyectos ganadores, que recibirán un diploma acreditativo y un premio económico consistente en:

- Primer premio: 5.000 euros.

- Segundo premio: 3.000 euros.

- Tercer premio: 2.000 euros.

Además, el Ayuntamiento hará difusión y publicidad de los proyectos que hayan sido reconocidos en esta convocatoria, lo que supondrá un altavoz para ganar visibilidad y reconocimiento.

Los premios se entregarán en un acto público presencial o virtual en la ciudad de València, al que estarán invitados todos los participantes. Una oportunidad para entablar conversación con otros ciudadanos y profesionales interesados en la materia.

¿Cómo puedo participar?

El plazo para presentar los proyectos finaliza el 7 de julio de 2025. La solicitud se podrá realizar de dos maneras:

- De manera presencial, presentando el modelo normalizado y el Anexo 1 de declaración responsable.

- De manera digital a través de la Sede Electrónica, donde se completará un formulario online de solicitud (que incluye la declaración responsable).

En ambos casos, además, habrá que presentar una memoria explicativa del proyecto. Este documento contendrá la descripción del proyecto, sus objetivos, las acciones desarrolladas y los resultados obtenidos, detallados en un máximo de 20 páginas. Es necesario revisar también la documentación adicional indicada en las bases, necesaria según la naturaleza del participante (persona física, jurídica, asociaciones, etc.).

Para aquellos participantes que tengan dudas, se ha habilitado la dirección de correo electrónico sctransparencia@valencia.es. También se puede plantear cualquier pregunta en los teléfonos 962081741 y 962085203.

Puedes ver las bases completas en este enlace.

La inteligencia artificial generativa comienza a estar presente en aplicaciones cotidianas que van desde agentes virtuales (o equipos de agentes virtuales) que nos resuelven dudas cuando llamamos a un centro de atención al cliente hasta asistentes inteligentes que redactan automáticamente resúmenes de reuniones o propuestas de informes en entornos de oficina.

Estas aplicaciones, gobernadas a menudo por modelos fundacionales de lenguaje (LLM), prometen revolucionar sectores enteros sobre la base de conseguir enormes ganancias en productividad. Sin embargo, su adopción conlleva nuevos retos ya que, a diferencia del software tradicional, un modelo de IA generativa no sigue reglas fijas escritas por humanos, sino que sus respuestas se basan en patrones estadísticos aprendidos tras procesar grandes volúmenes de datos. Esto hace que su comportamiento sea menos predecible y más difícil de explicar y que a veces ofrezca resultados inesperados, errores complicados de prever o respuestas que no siempre se alinean con las intenciones originales del creador del sistema.

Por ello, la validación de estas aplicaciones desde múltiples perspectivas como la ética, la seguridad o la consistencia es esencial para garantizar la confianza en los resultados de los sistemas que estamos creando en esta nueva etapa de transformación digital.

¿Qué hay que validar en los sistemas basados en IA generativa?

Validar los sistemas basados en IA generativa significa comprobar rigurosamente que cumplen ciertos criterios de calidad y responsabilidad antes de confiar en ellos para resolver tareas sensibles.

No se trata solo de verificar que “funcionan”, sino de asegurarse de que se comportan según lo esperado, evitando sesgos, protegiendo a los usuarios, manteniendo su estabilidad en el tiempo y cumpliendo las normas éticas y legales aplicables. La necesidad de una validación integral suscita un cada vez más amplio consenso entre expertos, investigadores, reguladores e industria: para desplegar IA de forma confiable se requieren estándares, evaluaciones y controles explícitos.

Resumimos cuatro dimensiones clave que deben verificarse en los sistemas basados en IA generativa para alinear sus resultados con las expectativas humanas:

- Ética y equidad: un modelo debe respetar principios éticos básicos y evitar perjudicar a personas o grupos. Esto implica detectar y mitigar sesgos en sus respuestas para no perpetuar estereotipos ni discriminación. También requiere filtrar contenido tóxico u ofensivo que pudiera dañar a los usuarios. La equidad se evalúa comprobando que el sistema ofrece un trato consistente a distintos colectivos demográficos, sin favorecer ni excluir indebidamente a nadie.

- Seguridad y robustez: aquí nos referimos tanto a la seguridad del usuario (que el sistema no genere recomendaciones peligrosas ni facilite actividades ilícitas) como a la robustez técnica frente a errores y manipulaciones. Un modelo seguro debe evitar instrucciones que lleven, por ejemplo, a conductas ilegales, rechazando esas solicitudes de manera fiable. Además, la robustez implica que el sistema resista ataques adversarios (como peticiones diseñadas para engañarlo) y que funcione de forma estable bajo distintas condiciones.

- Consistencia y fiabilidad: los resultados de la IA generativa deben ser consistentes, coherentes y correctos. En aplicaciones como las de diagnóstico médico o asistencia legal, no basta con que la respuesta suene convincente; debe ser cierta y precisa. Por ello se validan aspectos como la coherencia lógica de las respuestas, su relevancia respecto a la pregunta formulada y la exactitud factual de la información. También se comprueba su estabilidad en el tiempo (que ante dos peticiones similares se ofrezcan resultados equivalentes bajo las mismas condiciones) y su resiliencia (que pequeños cambios en la entrada no provoquen salidas sustancialmente diferentes).

- Transparencia y explicabilidad: para confiar en las decisiones de un sistema basado en IA, es deseable entender cómo y por qué las produce. La transparencia incluye proporcionar información sobre los datos de entrenamiento, las limitaciones conocidas y el rendimiento del modelo en distintas pruebas. Muchas empresas están adoptando la práctica de publicar “tarjetas del modelo” (model cards), que resumen cómo fue diseñado y evaluado un sistema, incluyendo métricas de sesgo, errores comunes y casos de uso recomendados. La explicabilidad va un paso más allá y busca que el modelo ofrezca, cuando sea posible, explicaciones comprensibles de sus resultados (por ejemplo, destacando qué datos influyeron en cierta recomendación). Una mayor transparencia y capacidad de explicación aumentan la rendición de cuentas, permitiendo que desarrolladores y terceros auditen el comportamiento del sistema.

Datos abiertos: transparencia y pruebas más diversas

Para validar adecuadamente los modelos y sistemas de IA, sobre todo en cuanto a equidad y robustez, se requieren conjuntos de datos representativos y diversos que reflejen la realidad de distintas poblaciones y escenarios.

Por otra parte, si solo las empresas dueñas de un sistema disponen datos para probarlo, tenemos que confiar en sus propias evaluaciones internas. Sin embargo, cuando existen conjuntos de datos abiertos y estándares públicos de prueba, la comunidad (universidades, reguladores, desarrolladores independientes, etc.) puede poner a prueba los sistemas de forma autónoma, funcionan así como un contrapeso independiente que sirve a los intereses de la sociedad.

Un ejemplo concreto lo dio Meta (Facebook) al liberar en 2023 su conjunto de datos Casual Conversations v2. Se trata de un conjunto de datos abiertos, obtenido con consentimiento informado, que recopila videos de personas de 7 países (Brasil, India, Indonesia, México, Vietnam, Filipinas y EE.UU.), con 5.567 participantes que proporcionaron atributos como edad, género, idioma y tono de piel.

El objetivo de Meta con la publicación fue precisamente facilitar que los investigadores pudiesen evaluar la imparcialidad y robustez de sistemas de IA en visión y reconocimiento de voz. Al expandir la procedencia geográfica de los datos más allá de EE.UU., este recurso permite comprobar si, por ejemplo, un modelo de reconocimiento facial funciona igual de bien con rostros de distintas etnias, o si un asistente de voz comprende acentos de diferentes regiones.

La diversidad que aportan los datos abiertos también ayuda a descubrir áreas descuidadas en la evaluación de IA. Investigadores del Human-Centered Artificial Intelligence (HAI) de Stanford pusieron de manifiesto en el proyecto HELM (Holistic Evaluation of Language Models) que muchos modelos de lenguaje no se evalúan en dialectos minoritarios del inglés o en idiomas poco representados, simplemente porque no existen datos de calidad en los benchmarks más conocidos.

La comunidad puede identificar estas carencias y crear nuevos conjuntos de prueba para llenarlos (por ejemplo, un conjunto de datos abierto de preguntas frecuentes en suajili para validar el comportamiento de un chatbot multilingüe). En este sentido, HELM ha incorporado evaluaciones más amplias precisamente gracias a la disponibilidad de datos abiertos, permitiendo medir no solo el rendimiento de los modelos en tareas comunes, sino también su comportamiento en otros contextos lingüísticos, culturales y sociales. Esto ha contribuido a visibilizar las limitaciones actuales de los modelos y a fomentar el desarrollo de sistemas más inclusivos y representativos del mundo real o modelos más adaptados a necesidades específicas de contextos locales como es el caso de modelo fundacional ALIA, desarrollado en España.

En definitiva, los datos abiertos contribuyen a democratizar la capacidad de auditar los sistemas de IA, evitando que el poder de validación resida solo en unos pocos. Permiten reducir los costes y barreras ya que un pequeño equipo de desarrollo puede probar su modelo con conjuntos abiertos sin tener que invertir grandes esfuerzos en recopilar datos propios. De este modo no solo se fomenta la innovación, sino que se consigue que soluciones de IA locales de pequeñas empresas estén sometidas también a estándares de validación rigurosos.

La validación de aplicaciones basadas en IA generativa es hoy una necesidad incuestionable para asegurar que estas herramientas operen en sintonía con nuestros valores y expectativas. No es un proceso trivial, requiere metodologías nuevas, métricas innovadoras y, sobre todo, una cultura de responsabilidad en torno a la IA. Pero los beneficios son claros, un sistema de IA rigurosamente validado será más confiable, tanto para el usuario individual que, por ejemplo, interactúa con un chatbot sin temor a recibir una respuesta tóxica, como para la sociedad en su conjunto que puede aceptar las decisiones basadas en estas tecnologías sabiendo que han sido correctamente auditadas. Y los datos abiertos contribuyen a cimentar esta confianza ya que fomentan la transparencia, enriquecen las pruebas con diversidad y hacen partícipe a toda la comunidad en la validación de los sistemas de IA..

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los datos abiertos son un combustible fundamental en la innovación digital contemporánea, creando ecosistemas de información que democratizan el acceso al conocimiento y potencian el desarrollo de soluciones tecnológicas avanzadas.

Sin embargo, la mera disponibilidad de datos no es suficiente. La construcción de ecosistemas robustos y sostenibles requiere marcos normativos claros, principios éticos sólidos y metodologías de gestión que garanticen tanto la innovación como la protección de derechos fundamentales. Por ello, la documentación especializada que orienta estos procesos se convierte en un recurso estratégico para gobiernos, organizaciones y empresas que buscan participar responsablemente en la economía digital.

En este post, recopilamos informes recientes, elaborados por organizaciones de referencia tanto del ámbito público como privado, que ofrecen estas orientaciones clave. Estos documentos no solo analizan los desafíos actuales de los ecosistemas de datos abiertos, sino que proporcionan herramientas prácticas y marcos de trabajo concretos para su implementación efectiva.

Estado y evolución del mercado del open data

Conocer cómo es y qué cambios ha habido en el ecosistema de los datos abiertos a nivel europeo y nacional es importante para tomar decisiones informadas y adaptarse a las necesidades de la industria. En este sentido, la Comisión Europea publica, periódicamente, un informe sobre los mercados de datos, que se actualiza regularmente. La última versión es de diciembre de 2024, aunque periódicamente se van publicando casos de uso que ejemplifican el potencial de los datos en Europa (el último de febrero de 2025).

Por otro lado, desde una perspectiva regulatoria europea, el último informe anual sobre la implementación de la Ley de Mercados Digitales (DMA) aborda una visión integral de las medidas adoptadas para garantizar la equidad y competitividad en el sector digital. Este documento es interesante para comprender cómo se está configurando el marco normativo que afecta directamente a los ecosistemas de datos abiertos.

A nivel nacional, el informe sectorial de ASEDIE sobre la "Economía del Dato en su ámbito infomediario" 2025 proporciona evidencia cuantitativa del valor económico generado por los ecosistemas de datos abiertos en España.

La importancia de los datos abiertos en la IA

Está claro que la intersección entre datos abiertos e inteligencia artificial es una realidad que plantea desafíos éticos y normativos complejos que requieren respuestas colaborativas y multisectoriales. En este contexto, el desarrollo de marcos que guíen el uso responsable de la IA se convierte en una prioridad estratégica, especialmente cuando estas tecnologías se nutren de ecosistemas de datos públicos y privados para generar valor social y económico. Estos son algunos informes que abordan este objetivo:

- IA generativa y datos abiertos: directrices y buenas prácticas: el Departamento de Comercio de EE. UU. ha publicado una guía con principios y buenas prácticas sobre cómo aplicar inteligencia artificial generativa de forma ética y efectiva en el contexto de los datos abiertos. El documento ofrece pautas para optimizar la calidad y la estructura de los datos abiertos con el fin de hacerlos útiles para estos sistemas, incluyendo la transparencia y gobernanza.

- Guía de buenas prácticas para el uso de la inteligencia artificial ética: esta guía muestra un enfoque integral que combina principios éticos sólidos con preceptos normativos claros y aplicables. Además del marco teórico, la guía sirve de herramienta práctica para implementar sistemas de IA de manera responsable, considerando tanto los beneficios potenciales como los riesgos asociados. La colaboración entre actores públicos y privados garantiza que las recomendaciones sean tanto técnicamente viables como socialmente responsables.

- Enhancing Access to and Sharing of Data in the Age of AI: este análisis de la Organización para la Cooperación y el Desarrollo Económicos (OCDE) aborda uno de los principales obstáculos para el desarrollo de la inteligencia artificial: el acceso limitado a datos de calidad y modelos efectivos. A través de ejemplos, se identifican estrategias específicas que los gobiernos pueden implementar para mejorar significativamente el acceso y la compartición de datos y ciertos modelos de IA.

- A Blueprint to Unlock New Data Commons for AI: Open Data Policy Lab ha elaborado una guía práctica que se centra en la creación y gestión de bienes comunes de dato (data commons) específicamente diseñados para habilitar casos de uso de inteligencia artificial de interés público. La guía ofrece metodologías concretas sobre cómo gestionar datos de manera que se facilite la creación de estos bienes comunes de dato, incluyendo aspectos de gobernanza, sostenibilidad técnica y alineación con objetivos de interés público.

- Guía práctica sobre colaboraciones basadas en datos: la iniciativa Data for Children Collaborative ha publicado una guía paso a paso para desarrollar colaboraciones de datos efectivas, con un enfoque en impacto social. Incluye ejemplos reales, modelos de gobernanza y herramientas prácticas para impulsar alianzas sostenibles.

En resumen, estos informes definen el camino hacia ecosistemas de datos más maduros, éticos y colaborativos. Desde las cifras de crecimiento del sector infomediario español hasta los marcos regulatorios europeos, pasando por las guías prácticas para la implementación de IA responsable, todos estos documentos comparten una visión común: el futuro de los datos abiertos depende de nuestra capacidad para construir puentes entre el sector público y privado, entre la innovación tecnológica y la responsabilidad social.

Los datos satelitales se han convertido en una herramienta fundamental para comprender y monitorear nuestro planeta desde una perspectiva única. Estos datos, recopilados por satélites en órbita alrededor de la Tierra, ofrecen una visión global y detallada de diversos fenómenos terrestres, marítimos y atmosféricos que tienen aplicaciones en múltiples sectores, como el cuidado del medio ambiento o impulso de la innovación en el sector energético.

En este artículo nos vamos a centrar en un nuevo sector: el ámbito de la pesca, donde los datos satelitales han revolucionado la forma en que se monitorean y gestionan las actividades pesqueras a nivel mundial. Repasaremos cuáles son los datos satelitales sobre pesca más utilizados para monitorizar la actividad pesquera y veremos posibles usos, destacando su relevancia en la detección de actividades ilegales.

Los datos satelitales más populares relacionados con la pesca: los datos de posicionamiento

Entre los datos satelitales, encontramos gran cantidad de datos públicos y abiertos, que son gratuitos y están disponibles en formatos reutilizables, como aquellos procedentes del programa europeo Copernicus. Estos datos se pueden complementar con otros que, aunque también son públicos, pueden tener coste y restricciones de uso o acceso. Esto se debe a que la obtención y procesamiento de estos datos implica costes significativos y se requiere la compra a proveedores especializados, como ORBCOMM, exactEarth, Spire Maritime o Inmarsat. A este segundo tipo pertenecen los datos procedentes de los dos sistemas más populares para obtener datos pesqueros, que son:

- Sistema de Identificación Automática (AIS, en sus siglas en inglés): transmite la ubicación, velocidad y dirección de los barcos. Se creó para mejorar la seguridad marítima y prevenir colisiones entre embarcaciones; es decir, su objetivo era evitar accidentes al permitir que los buques comuniquen su posición y obtengan la ubicación de otros barcos en tiempo real. Sin embargo, con la liberación de los datos satelitales en la década de 2010, la academia y las autoridades se dieron cuenta de que podían mejorar el conocimiento situacional al proporcionar información sobre los barcos, incluyendo su identidad, rumbo, velocidad y otros datos de navegación. Los datos AIS pasaron a facilitar la gestión del tráfico marítimo, permitiendo a las autoridades costeras y centros de tráfico monitorear y gestionar el movimiento de embarcaciones en sus aguas. Esta tecnología ha revolucionado la navegación marítima, proporcionando una capa adicional de seguridad y eficiencia en las operaciones marítimas. Los datos están disponibles a través de sitios webs como MarineTraffic o VesselFinder, que ofrecen servicios básicos de seguimiento de forma gratuita, pero requieren una suscripción para obtener funciones avanzadas.

- Sistema de Seguimiento de Buques (VMS): diseñado específicamente para el monitoreo pesquero, proporciona datos de posición y movimiento. Se creó específicamente para el monitoreo y la gestión de la industria pesquera moderna. Su desarrollo surgió hace aproximadamente dos décadas como una respuesta a la necesidad de mejorar el seguimiento, control y vigilancia de las actividades pesqueras. El acceso a los datos del VMS varía según la jurisdicción y los acuerdos internacionales. Los datos son utilizados principalmente por organismos gubernamentales, organizaciones regionales de gestión pesquera y autoridades encargadas de la vigilancia, quienes tienen acceso restringido y deben cumplir con estrictas normativas de seguridad y confidencialidad. Por otro lado, las empresas pesqueras también emplean sistemas VMS para gestionar sus flotas y cumplir con regulaciones locales e internacionales.

Análisis de datos satelitales pesqueros

Los datos satelitales han demostrado ser particularmente útiles para observar la pesca, ya que pueden ofrecer tanto un panorama general de un área marina o una flota pesquera, como la posibilidad de conocer la vida operativa de un solo buque. Para ello se suelen seguir los siguientes pasos:

- Recopilación de datos AIS y VMS.

- Integración con otras fuentes abiertas o privadas. Por ejemplo: registros de buques, datos oceanográficos, delimitaciones de zonas económicas especiales o aguas territoriales.

- Aplicación de algoritmos de aprendizaje automático para identificar patrones de comportamiento y maniobras de pesca.

- Visualización de datos en mapas interactivos.

- Generación de alertas sobre actividades sospechosas (para el monitorio en tiempo real).

Casos de uso de los datos satélites de pesca

Los datos satelitales de pesca ofrecen opciones rentables, especialmente para que aquellos con recursos limitados para patrullar sus aguas puedan monitorear de forma continua grandes extensiones oceánicas. Entre otras actividades, estos datos hacen posible el desarrollo de sistemas que permiten:

- La Supervisión del cumplimiento de regulaciones pesqueras, ya que los satélites pueden rastrear la posición y movimientos de los barcos pesqueros. Este monitoreo se puede hacer con datos históricos, con el objeto de realizar un análisis de patrones y tendencias de actividad pesquera. De esta forma se apoyan investigaciones a largo plazo y análisis estratégicos del sector pesquero.

- La detección de pesca ilegal, utilizando tanto datos históricos como en tiempo real. Al analizar patrones de movimiento inusuales o la presencia de embarcaciones en áreas restringidas, se pueden identificar posibles actividades de pesca ilegal, no declarada y no reglamentada (llamada pesca INDNR). La pesca INDNR representa un valor de hasta 23.500 millones de dólares anuales en productos marinos.

- La evaluación del volumen pesca, con los datos de la capacidad de carga de cada nave y los trasbordos de pescado que se realizan tanto en alta mar como en puerto.

- La identificación de áreas de alta actividad pesquera y la evaluación de su impacto en ecosistemas sensibles.

Un ejemplo concreto es el trabajo realizado por el Overseas Development Institute (ODI), titulado “Pesca en aguas turbias”, que revela cómo los datos satelitales permiten identificar embarcaciones, determinar su ubicación, rumbo y velocidad, así como entrenar algoritmoss, proporcionando una visión sin precedentes de las actividades pesqueras globales. El informe está basado en dos fuentes: entrevistas con los responsables de diversas plataformas privadas y públicas que se dedican a observar la pesca INDNR, así como en recursos abiertos y gratuitos como Global Fishing Watch (GFW) –una organización que es el fruto de la colaboración entre Oceana, SkyTruth y Google— y que proporciona datos abiertos.

Desafíos, consideraciones éticas y limitaciones a la hora de monitorizar la actividad pesquera

Aunque estos datos ofrecen grandes oportunidades, es importante notar que también tienen limitaciones. El estudio "Fishing for data: The role of private data platforms in addressing illegal, unreported and unregulated fishing and overfishing", menciona los problemas de trabajar con datos satelitales para combatir la pesca ilegal, unos retos que pueden aplicar al monitoreo de la pesca en general:

- La falta de un registro universal de buques de pesca unificada. Se carece de una base de datos única de embarcaciones pesqueras, lo que dificulta la identificación de las embarcaciones y sus empresas propietarias u operadoras. La información de las embarcaciones está dispersa en múltiples fuentes, como sociedades de clasificación, registros nacionales de buques y organizaciones regionales de gestión pesquera.

- Algoritmos deficientes. Los algoritmos utilizados para identificar comportamientos de pesca son a veces incapaces de identificar con precisión la actividad pesquera, dificultando la identificación de actividades ilegales. Por ejemplo, inferir el tipo de arte de pesca utilizado, las especies objetivo o la cantidad capturada a partir de los datos satelitales puede ser complejo.

- La mayoría de estos datos no son gratuitos y pueden resultar costosos. Los datos más utilizados en este campo, es decir, aquellos procedentes de sistemas AIS y VMS, conllevan un coste considerable.

- Datos satelitales incompletos. Los sistemas de identificación automática (AIS) son obligatorios solo para embarcaciones de más de 300 toneladas brutas, lo que deja fuera a muchas embarcaciones pesqueras. Además, las embarcaciones pueden apagar sus transmisores AIS para evitar la vigilancia.

- El uso de estas herramientas para la vigilancia, el control y la aplicación de la ley conlleva riesgos, como falsos positivos y correlaciones espurias. Además, la excesiva confianza en estas herramientas puede desviar los esfuerzos de aplicación de la ley en comportamientos que no se pueden detectar.

- La colaboración y la coordinación entre diversas iniciativas privadas, como Global Fishing Watch, no es todo lo fluida que podría ser. Si unieran sus esfuerzos, podrían crear una plataforma de datos más potente, pero es difícil incentivar dicha colaboración entre organizaciones que son competidoras.

El futuro de los datos satelitales en la pesca

El campo de los datos satelitales está en constante evolución, con nuevas técnicas de captura y análisis que mejoran la precisión y utilidad de la información obtenida. Las innovaciones en la captura de datos geoespaciales incluyen el uso de drones, LiDAR (light detection and ranging) y fotogrametría de alta resolución, que complementan los datos obtenidos por satélites tradicionales. En el ámbito del análisis, el machine learning y la inteligencia artificial están desempeñando un papel crucial. Por ejemplo, Global Fishing Watch utiliza algoritmos de aprendizaje automático para procesar millones de mensajes diarios de más de 200.000 embarcaciones pesqueras, permitiendo una visión global y en tiempo real de sus actividades.

El futuro de los datos satelitales es prometedor, con avances tecnológicos que ofrecen mejorar la resolución, frecuencia, volumen, calidad y tipos de datos que se pueden recopilar. La miniaturización de satélites y el desarrollo de constelaciones de microsatélites están mejorando el acceso al espacio y a los datos que se pueden obtener desde allí.

En el contexto de la pesca, se espera que los datos satelitales desempeñen un papel cada vez más importante en la gestión sostenible de los recursos marinos. La combinación de estos datos con otras fuentes de información, como sensores in situ y modelos oceanográficos, permitirá una comprensión más holística de los ecosistemas marinos y las actividades humanas que los afectan.

Contenido elaborado por Miren Gutiérrez, Doctora e investigadora en la Universidad de Deusto, experta en activismo de datos, justicia de datos, alfabetización de datos y desinformación de género. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor

El acceso a datos financieros y bancarios está revolucionando el sector, promoviendo la transparencia, la inclusión financiera y la innovación en servicios económicos. Sin embargo, la gestión de estos datos enfrenta desafíos normativos que buscan equilibrar apertura con seguridad y privacidad.

Por ese motivo, existen distintas formas de acceder a este tipo de datos, como veremos a continuación.

Open Banking y Open Finance versus Open Data

Estos términos, aunque relacionados, tienen diferencias importantes.

El termino Open Banking hace referencia a un sistema que permite a los bancos y otras instituciones financieras compartir de forma digital y segura los datos financieros de los clientes con terceros. Para ello es necesario que los clientes aprueben expresamente las condiciones de compartición de los datos. Este consentimiento puede ser cancelado en cualquier momento según los deseos del cliente.

Open Finance, por su parte, es una evolución de Open Banking que abarca un rango más amplio de productos y servicios financieros. Cuando hablamos de Open Finance, además de los datos bancarios, se incluyen datos sobre seguros, pensiones, inversiones y otros servicios financieros.

Tanto en el Open Banking como en el Open Finance, los datos no son abiertos (Open Data), sino que solo pueden acceder a ellos aquellos autorizados previamente por el cliente. El intercambio de datos se realiza a través de una interfaz de programación de aplicaciones o API (en sus siglas en inglés), que garantiza la agilidad y seguridad del proceso. Todo ello está regulado por la directiva europea sobre servicios de pago en el mercado interior (conocida como PSD2), aunque desde la Comisión Europea se está trabajando en la actualización del marco normativo.

-

Aplicaciones del Open Banking y el Open Finance:

El propósito de estas actividades es dar acceso a nuevos servicios basados en la información compartida. Por ejemplo, facilitan la creación de apps que unifiquen el acceso a todas las cuentas bancarias de un cliente, aunque sean de diferentes proveedores. Esto mejora la gestión y control de los ingresos y gastos al proporcionar una visión general en un único entorno.

Otro ejemplo de uso es que permiten a proveedores consultar información cruzada de forma más rápida. Por ejemplo, al permitir el acceso a los datos financieros de un cliente, un concesionario podría proporcionar información sobre las opciones de financiación más rápidamente.

Plataformas de datos abiertos sobre banca

Aunque los datos bancarios privados, como todos los tipos de datos personales, están estrictamente regulados y no pueden publicarse abiertamente debido a normativas de protección de la privacidad, sí existen conjuntos de datos financieros que pueden compartirse libremente. Por ejemplo, información agregada sobre tasas de interés, indicadores económicos, datos históricos de mercados bursátiles, tendencias de inversión y estadísticas macroeconómicas, que son accesibles a través de fuentes abiertas.

Estos datos, además de impulsar la transparencia y confianza en los mercados, pueden utilizarse para monitorear tendencias económicas, prevenir fraudes y mejorar la gestión de riesgos a nivel global. Además, empresas fintech, desarrolladores y emprendedores pueden aprovecharlos para crear soluciones como herramientas de análisis financiero, sistemas de pago digitales o de asesoramiento automatizado.

Veamos algunos ejemplos de espacios donde obtener datos abiertos sobre el sector bancario y financiero.

Fuentes internacionales

Algunas de las fuentes internacionales más populares son:

-

Banco Central Europeo: ofrece estadísticas y datos sobre mercados financieros de la zona euro, a través de diversas plataformas. Entre otra información, los usuarios pueden descargar conjuntos de datos sobre la inflación, los tipos de interés bancarios, la balanza de pagos, las finanzas públicas, etc.

-

Banco Mundial: facilita el acceso a datos económicos globales sobre desarrollo financiero, pobreza y crecimiento económico.

-

Fondo Monetario Internacional: proporciona un acceso simplificado a datos macroeconómicos y financieros, como las perspectivas de la economía mundial o regional. También ofrece en abierto los datos de informes como su Fiscal Monitor, donde se analiza la evolución más reciente de las finanzas públicas.

-

Federal Reserve Economic Data (FRED): se centra en información económica de los Estados Unidos, incluyendo indicadores de mercado y tasas de interés. Este repositorio está creado y mantenido por el Departamento de Investigación del Banco de la Reserva Federal de St.Louis.

Fuentes nacionales

A través del Catálogo Nacional de datos abiertos de datos.gob.es se puede acceder a una gran cantidad de conjuntos de datos relacionados con la economía. Uno de los publicadores más destacado es el Instituto Nacional de Estadística (INE), que ofrece datos sobre impagos por entidad financiera, hipotecas, etc.

Además, el Banco de España ofrece distintos productos para aquellos interesados en los datos económicos del país:

- Estadísticas: el Banco de España recopila, elabora y publica un amplio conjunto de estadísticas económicas y financieras. Incluye información sobre tipos de interés y de cambio, cuentas financieras de los sectores institucionales, balanzas de pago e incluso encuestas financieras a las familias, entre otros.

- Cuadro de mando: el Banco de España también ha puesto a disposición de la ciudadanía un visor interactivo que permite consumir datos trimestrales y anuales sobre estadísticas exteriores de una manera más sencilla.

Además, Banco de España ha habilitado una sala segura para que los investigadores puedan acceder a datos valiosos, pero que no pueden abrirse al gran público por su naturaleza. En este sentido encontramos:

- BELab: el laboratorio de datos protegidos gestionado por el Banco de España, que ofrece acceso in situ (Madrid) y en remoto. Estos datos han sido utilizados en diversos proyectos.

- ES_DataLab: laboratorio de microdatos restringido para investigadores que desarrollan proyectos con fines científicos y de interés público. En este caso, agrupa microdatos de diversos organismos, incluyendo el Banco de España.

Los espacios de datos: una oportunidad para el intercambio seguro y controlado de datos financieros

Como acabamos de ver, también existen opciones para facilitar el acceso a datos financieros y bancarios, de una forma controlada y segura. Es aquí donde entran en juego los espacios de datos, ecosistema donde diversos actores comparten datos de manera voluntaria y segura, siguiendo mecanismos comunes de gobernanza, normativos y técnicos.

En este sentido, Europa está impulsando un Espacio Europeo de Datos Financieros (EEDF), una iniciativa clave dentro de la Estrategia Europea de Datos. El EEDF se compone de tres pilares fundamentales:

- Datos de informes públicos (“divulgaciones públicas”): recoge datos de informes financieros (balances, ingresos, estado de resultados), que las empresas financieras están obligadas por ley a divulgar de forma periódica. En este ámbito está la iniciativa de Punto de acceso Único Europeo (ESAP), una plataforma centralizada para acceder a datos de más de 200 informes públicos de más de 150,000 empresas.

- Datos privados de los clientes de los proveedores de servicios financieros: abarca aquellos datos que tienen los proveedores de servicios financieros como los bancos. En este ámbito está el marco para el acceso a los datos financieros, que cubre datos como inversiones, seguros, pensiones, préstamos y ahorros.

- Datos de los informes de supervisión: para este tipo de datos se ha de tener en cuenta la estrategia de supervisión, que abarca datos desde diferentes sectores (bancos, seguros, fondos de pensiones…) con el fin de promover la transformación digital en el sector financiero.

En conclusión, el acceso a datos financieros y bancarios está evolucionando significativamente gracias a diversas iniciativas que han permitido una mayor transparencia y que fomentarán el desarrollo de nuevos servicios, al tiempo que garantizan la seguridad y privacidad de los datos compartidos. El futuro del sector financiero estará condicionado por la capacidad de las instituciones y reguladores para fomentar ecosistemas de datos que impulsen la innovación y la confianza en el mercado.

La reutilización de datos sigue creciendo en España, tal y como confirma el último informe de la Asociación Multisectorial de la Información (ASEDIE), que analiza y describe la situación del sector infomediario en el país. El documento, que va por su edición número 13, fue presentado el pasado viernes 4 de abril, en un evento donde se destacó el auge de la economía del dato en el panorama actual.

A continuación, recogemos las principales claves del informe.

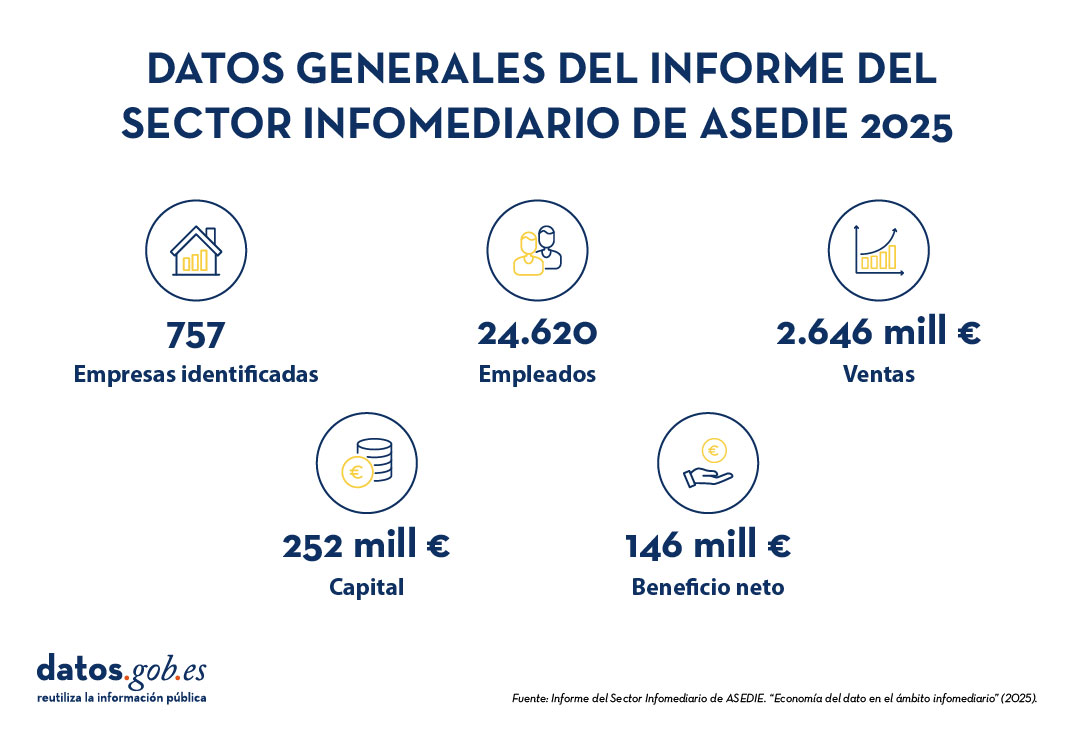

Un beneficio general de 146 millones de euros en 2023

Desde 2013, el informe del sector Infomediario de ASEDIE realiza un seguimiento continuo de este sector, compuesto por aquellas empresas y organizaciones que reutilizan datos -generalmente procedentes del sector público, pero también de fuentes privadas- para generar productos o servicios de valor añadido. Bajo el título "Economía del Dato en su ámbito infomediario", el informe de este año subraya la importancia de la colaboración público-privada en el impulso de la economía del dato y presenta datos relevantes sobre el estado actual del sector.

Cabe destacar que la información financiera utilizada para ventas y empleados corresponde al ejercicio 2023, ya que al cierre del informe no estaba disponible aún la información financiera del año 2024. Las principales conclusiones son:

- Desde la primera edición del informe, se ha pasado de 444 a 757 empresas infomediarias identificadas, lo que supone un crecimiento del 70%. Este crecimiento refleja su dinamismo, con altas y bajas anuales, mostrando una evolución positiva que consolida su recuperación tras la pandemia, aunque aún con margen de desarrollo.

- El sector está presente en todas las Comunidades Autónomas del país, incluida la Ciudad Autónoma de Melilla. La Comunidad de Madrid lidera el ranking con el 38% de las empresas infomediarias, seguida por Cataluña, Andalucía y la Comunidad Valenciana, que representan el 15%, 11% y 9%, respectivamente. El restante 27% se distribuye entre las demás comunidades autónomas.

- El 75% de las empresas infomediarias realizan su actividad en los subsectores de información geográfica, estudios de mercado, económico y financiero, e informática de infomediación (centrada en el desarrollo de soluciones tecnológicas para la gestión, análisis, procesamiento y visualización de datos).

- El sector infomediario muestra una tendencia de crecimiento y consolidación, con un 66% de empresas operando desde hace menos de 20 años. De este grupo, el 32% tiene entre 11 y 20 años, mientras que el 34% no supera la década de existencia. Además, el aumento en las compañías de entre 11 y 40 años indica que más empresas han logrado mantenerse en el tiempo.

- En cuanto a las ventas, el volumen estimado asciende a 2.646 millones de euros y la evolución de la venta media aumenta un 10,4%. La facturación media por empresa es superior a 4,4 millones, mientras que la mediana es 442.000 euros. En comparación con el año anterior, la media ha aumentado en 200.000 euros, mientras que la mediana ha descendido en 30.000 euros.

- Se estima que el sector infomediario emplea a unas 24.620 personas, el 64% de las cuales se concentra en tres subsectores. Estos datos suponen un crecimiento de un 6% con respecto al año anterior. Aunque la media general es de 39 empleados por empresa, la mediana por subsector no supera los 6, lo que indica que buena parte del empleo se concentra en un número reducido de grandes empresas. Por su parte, la facturación media por empleado ha sido de 108.000 euros en este año, aumentando un 8% respecto al año anterior.

- El capital suscrito del sector asciende a 252 millones de euros. Esto supone una subida del 6%, que rompe con la tendencia negativa de los últimos años.

- El 74% de las empresas ha presentado beneficios. El beneficio neto agregado de las 539 empresas de las que se dispone de datos superó los 145 millones de euros.

El siguiente visual resume algunos de estos datos

Figura 1. Fuente: Informe del Sector Infomediario de Asedie. "Economía del Dato en su ámbito infomediario" (2025).

Avances significativos en el Top 10 ASEDIE

El Top 10 de Asedie tiene como objetivo identificar y promover la apertura de determinados conjuntos de datos para su reutilización. Esta iniciativa busca fomentar la colaboración entre el sector público y privado, facilitando el acceso a información que puede generar beneficios económicos y sociales significativos. Su desarrollo ha tenido lugar en tres fases, cada una enfocada en diferentes conjuntos de datos, y cuya evolución se ha analizado en este informe:

-

Fase 1 (2019), donde se impulsaba la apertura de bases de datos de asociaciones, cooperativas y fundaciones. Actualmente, 16 comunidades autónomas permiten el acceso a las tres bases de datos e incluso 11 ya ofrecen los datos del NIF. Falta que se de acceso a las cooperativas en una comunidad.

- Fase 2 (2020), centrada en conjuntos de datos relativos a certificados de eficiencia energética, registros SAT (Sociedades Agrarias de Transformación) y polígonos Industriales. Todas las comunidades han puesto los datos de eficiencia energética a disposición de los ciudadanos, pero falta una en polígonos Industriales y tres en registros SAT.

- Fase 3 (2023), enfocada en datasets de agentes económicos, centros de enseñanza, centros de salud y ERES-ERTES (Expediente de Regulación de Empleo y Expediente de Regulación Temporal de Empleo). Se han producido avances con respecto al año pasado, pero se está trabajando en conseguir una mayor uniformidad en la información.

Nuevos casos de éxito y buenas prácticas

El informe finaliza con una sección donde se recopilan diversos casos de éxito de productos y servicios elaborados con información pública y que contribuyen al crecimiento de nuestra economía, como por ejemplo:

- Calculadora de mejoras de eficiencia energética: permite identificar las intervenciones necesarias y estimar los costes asociados y el impacto en la certificación de eficiencia energética (CEE).

- GEOPUBLIC: es una herramienta pensada para ayudar a las Administraciones Públicas a entender mejor su territorio. Permite analizar fortalezas, oportunidades y retos en comparación con otras regiones, provincias o municipios similares. Gracias a su capacidad de segmentar datos empresariales y sociodemográficos a diferentes escalas, facilita el seguimiento del ciclo de vida de las empresas y su influencia en la economía local.

- Nueva web del observatorio sectorial DBK: mejora la búsqueda de información sectorial, gracias al seguimiento continuado de unos 600 sectores españoles y portugués. Publica anualmente más de 300 informes en profundidad y 1.000 fichas de coyuntura de información sectorial.

- Servicio de asignación y reparación de datos: facilita la actualización de la información de los clientes de comercializadoras de energía eléctrica al permitir enriquecer dicha información con la referencia catastral asociada al punto de suministro. Con ello se da cumplimiento a un requerimiento de la Agencia Estatal de Administración Tributaria (AEAT).

El informe también incluye buenas prácticas de las administraciones públicas como:

- El Callejero Digital de Andalucía Unificado (CDAU), que centraliza, normaliza y mantiene actualizados los datos geográficos y postales de la región.

- El Geoportal del Ayuntamiento de Madrid, que integra metadatos, servicios de mapas OGC, un visor de mapas y un geolocalizador que respetan las directivas INSPIRE y LISIGE. Es fácil de usar tanto por profesionales como por la ciudadanía gracias a su interfaz intuitiva y accesible.

- El Instituto Canario de Estadística (ISTAC), que ha puesto a disposición de la sociedad un ecosistema tecnológico innovador. En él destaca eDatos, una infraestructura de código abierto para la gestión de datos estadísticos asegurando la transparencia y la interoperabilidad.

- El Inventario Forestal Nacional español (IFN) y su aplicación web Descarga IFN, un recurso básico para la gestión, investigación y educación forestal. Permite filtrar fácilmente las parcelas para su descarga.

- El Nodo de Interoperabilidad Estadística, que da cobertura legal, organizativa, semántica y técnica para la integración de los diferentes sistemas de información de los distintos niveles de gestión administrativa.

- El Open Cohesion School, un programa educativo innovador de la Generalitat de Catalunya dirigido a estudiantes de secundaria. Los estudiantes investigan proyectos financiados con fondos públicos para analizar su impacto, a la vez que desarrollan habilidades digitales, el pensamiento crítico y la participación cívica.

- El Sistema Nacional de Publicidad de Subvenciones y Ayudas Públicas, que ha presentado un sitio web completamente rediseñado. Ha mejorado su funcionalidad con consultas y descargas API-REST. Tienes más información aquí.

En conclusión, el sector infomediario en España se consolida como un motor clave para la economía, mostrando una evolución sólida y un crecimiento constante. Con un número récord de empresas y una facturación que superó los 2.600 millones de euros en 2023, el sector no solo genera empleo, sino que se posiciona como un referente de innovación. La información, convertida en un recurso estratégico, impulsa un futuro económico más eficiente y conectado. Su adecuado aprovechamiento, siempre desde una perspectiva ética, promete seguir siendo una fuente de progreso tanto en el ámbito nacional como internacional.

En un mundo cada vez más expuesto a riesgos naturales y crisis humanitarias, contar con datos geoespaciales precisos y actualizados puede marcar la diferencia entre una respuesta eficaz y una reacción tardía. Las huellas de edificios, es decir, los contornos de las construcciones tal como aparecen en el terreno, son uno de los recursos más valiosos en contextos de urgencia.

En este post profundizaremos en este concepto, incluyendo dónde obtener datos abiertos de huellas de edificios, y destacaremos su importancia en uno de sus múltiples casos de uso: la gestión de emergencias.

¿Qué son las huellas de edificios?

Las huellas de edificios (en inglés, building footprints) son representaciones geoespaciales, normalmente en formato vectorial, que muestran el contorno de las estructuras construidas sobre el terreno. Es decir, indican la proyección horizontal de un edificio sobre el suelo, vista desde arriba, como si se tratara de un plano en planta.

Estas huellas pueden incluir tanto edificaciones residenciales como industriales, comerciales, institucionales o incluso construcciones rurales. Dependiendo de la fuente de datos, pueden ir acompañadas de atributos adicionales como la altura, número de plantas, uso del edificio o fecha de construcción, lo que las convierte en una fuente de información muy rica para múltiples disciplinas.

A diferencia de un plano arquitectónico que muestra detalles internos, las huellas de edificios se limitan al perímetro de la construcción en contacto con el suelo. Esta simplicidad las hace ligeras, interoperables y fácilmente combinables con otras capas de información geográfica, como redes viales, zonas de riesgo, infraestructuras críticas o datos sociodemográficos.

Figura 1. Ejemplo de huellas de edificios: cada polígono representa el controno de una construcción vista desde arriba

¿Cómo se obtienen?

Existen varias formas de generar huellas de edificios:

- A partir de imágenes satelitales o aéreas: mediante técnicas de fotointerpretación o, más recientemente, mediante inteligencia artificial y algoritmos de machine learning.

- Con datos catastrales o registros oficiales: como en el caso del Catastro en España, que mantiene bases vectoriales precisas de todas las construcciones registradas.

- Mediante mapeo colaborativo: plataformas como OpenStreetMap (OSM) permiten a usuarios voluntarios digitalizar manualmente las huellas visibles en ortofotos.

¿Para qué sirven?

Las huellas de edificios son fundamentales para:

- Análisis urbano y territorial: permiten estudiar la densidad construida, la expansión urbana o el uso del suelo.

- Gestión catastral e inmobiliaria: son clave para calcular superficies, aplicar impuestos o regular edificaciones.

- Planificación de infraestructuras y servicios públicos: ayudan a ubicar equipamientos, diseñar redes de transporte o estimar demanda energética.

- Modelización 3D y ciudades inteligentes: sirven de base para generar modelos urbanos tridimensionales.

- Gestión de riesgos y emergencias: permiten identificar zonas vulnerables, estimar población afectada o planificar evacuaciones.

En definitiva, las huellas de edificios son una pieza básica de la infraestructura de datos espaciales y, cuando se ofrecen como datos abiertos, accesibles y actualizados, multiplican su valor y utilidad para el conjunto de la sociedad.

¿Por qué son clave en situaciones de emergencia?

De entre todos los posibles casos de uso, en este artículo nos vamos a centrar en la gestión de emergencias. Durante una situación de este tipo –como un terremoto, una inundación o un incendio forestal– los equipos de intervención necesitan saber qué zonas están edificadas, cuántas personas pueden habitar esas estructuras, cómo acceder a ellas y dónde concentrar los recursos. Las huellas de edificios permiten:

- Estimar rápidamente el número de personas potencialmente afectadas.

- Priorizar zonas de intervención y rescate.

- Planificar rutas de acceso y evacuación.

- Cruzar datos con otras capas (vulnerabilidad social, zonas de riesgo, etc.).

- Coordinar la acción entre servicios de emergencia, autoridades locales y cooperación internacional.

Datos abiertos disponibles

Ante una emergencia, es fundamental saber dónde localizar datos de huellas de edificios. Uno de los avances más relevantes en el ámbito del gobierno del dato es la disponibilidad creciente de huellas de edificios como datos abiertos. Este tipo de información, que antes estaba restringida a administraciones u organismos especializados, ahora puede ser utilizada libremente por gobiernos locales, ONG, investigadores y empresas.

A continuación, se resumen algunas de las principales fuentes disponibles para la gestión de emergencias y otros fines:

- JRC – Global Human Settlement Layer (GHSL): el Centro Común de Investigación de la Comisión Europea ofrece una serie de productos derivados del análisis de imágenes satelitales:

- GHS-BUILT-S: datos raster sobre áreas construidas a nivel global.

- GHS-BUILD-V: huellas vectoriales de edificios para Europa, generadas con IA.

- Descarga de datos: https://ghsl.jrc.ec.europa.eu/download.php

- IGN y Catastro de España: las huellas de edificios oficiales en España se pueden obtener a través del Catastro y el Instituto Geográfico Nacional (IGN). Son extremadamente detalladas y actualizadas.

- Centro de descargas del IGN: https://centrodedescargas.cnig.es

- Visor del Catastro: https://www.sedecatastro.gob.es

- Copernicus Emergency Management Service: ofrece productos cartográficos generados en tiempo récord cuando se activa una emergencia (terremotos, inundaciones, incendios, etc.). Incluyen mapas de daños y huellas de edificios afectados.

- Centro de descargas: https://emergency.copernicus.eu/mapping/list-of-components/EMSR

- Importante: para descargar los datos vectoriales detallados (como las huellas), es necesario registrarse en la plataforma DIAS/Copernicus EMS o solicitar acceso según el caso.

- OpenStreetMap (OSM): plataforma colaborativa donde usuarios de todo el mundo han digitalizado huellas de edificios, especialmente en zonas no cubiertas por fuentes oficiales. Es especialmente útil para proyectos humanitarios, zonas rurales y en desarrollo, y casos donde se necesita actualización rápida o participación local.

- Descarga de datos: https://download.geofabrik.de

- Google Open Buildings: este proyecto de Google ofrece más de 2.000 millones de huellas de edificios en África, Asia y otras regiones de datos escasos, generadas con modelos de inteligencia artificial. Es especialmente útil para fines humanitarios, desarrollo urbano en países del sur global, y evaluación de exposición al riesgo en lugares donde no hay catastros oficiales.

- Acceso directo a los datos: https://sites.research.google/open-buildings/

- Microsoft Building Footprints: Microsoft ha publicado conjuntos de huellas de edificios generadas con algoritmos de aprendizaje automático aplicados a imágenes aéreas y satelitales. Cobertura: Estados Unidos, Canadá, Uganda, Tanzania, Nigeria y recientemente India. Los datos están en acceso abierto bajo licencia ODbL.

- Meta (ex Facebook) AI Buildings Footprints: Meta AI ha publicado datasets generados mediante aprendizaje profundo en colaboración con Humanitarian OpenStreetMap Team (HOT). Se centraron en países africanos y del sudeste asiático.

- Acceso directo a los datos: https://dataforgood.facebook.com/dfg/tools/buildings

Tabla comparativa de fuentes de huellas de edificios abiertas

| Fuente/Proyecto | Cobertura geográfica | Tipo de datos | Formato | Requiere registro | Utilidad principal |

|---|---|---|---|---|---|

| JRC GHSL | Global (en raster) / Europa (vector) | Raster y vector | GeoTIFF / GeoPackage / Shapefile | No | Análisis urbano, planificación europea, estudios comparativos |

| IGN + Catastro España | España | Vector oficial | GML/Shapefile/WFS/WMS | No | Datos catastrales, planificación urbana, gestión municipal |

| Copernicus EMS | Europa y global (cuando hay activación) | Vector (post-emergencia) | PDF / GeoTIFF / Shapefile | Sí (para datos vectoriales detallados) | Cartografía rápida, gestión de emergencias |

| OpenStreetMap | Global (variable por zona) | Vector colaborativo | .osm / shapefile / GeoJSON | No | Mapas base, zonas rurales, apoyo humanitario |

| Google Open Buildings | África, Asia, LatAm (zonas seleccionadas) | Vector (generado con IA) | CSV / GeoJSON | No | Evaluación de riesgos, planificación en países en desarrollo |

| Microsoft Buildings Footprints | EE. UU., Canadá, India, África | Vector (IA) | GeoJSON | No | Datos masivos, planificación urbana, zonas rurales |

| Meta AI | África, Asia (zonas específicas) | Vector (IA) | GeoJSON / CSV | No | Apoyo humanitario, complementar OSM en zonas sin cobertura |

Figura 2. Tabla comparativa de fuentes de huella de edificios abiertas

Combinación y uso integrado de datos

Una de las grandes ventajas de que estas fuentes estén abiertas y documentadas es la posibilidad de combinarlas para mejorar la cobertura, la precisión y la utilidad operativa de las huellas de edificios. Os explicamos algunos enfoques recomendados:

1. Completar zonas sin cobertura oficial

- En regiones donde el catastro no está disponible o actualizado (como muchas zonas rurales o países en desarrollo), es útil usar Google Open Buildings o OpenStreetMap como base.

- GHSL también ofrece una visión armonizada a escala continental, útil para planificación y análisis comparativos.

2. Cruzar capas oficiales y colaborativas

- Las huellas del Catastro español se pueden enriquecer con datos de OSM cuando se detectan zonas nuevas o modificadas, especialmente tras un evento como una catástrofe.

- Esta combinación es ideal para municipios pequeños que no tienen capacidad técnica propia, pero quieren mantener sus datos al día.

3. Integración con datos sociodemográficos y de riesgo

- Las huellas ganan valor cuando se integran en sistemas de información geográfica (SIG) junto a capas como:

- Población por edificio (INE, WorldPop).

- Zonas inundables (MAPAMA, Copernicus).

- Centros de salud o escuelas.

- Infraestructuras críticas (red eléctrica, agua).

Esto permite modelar escenarios de riesgo, planificar evacuaciones o incluso simular impactos potenciales de una emergencia.

4. Uso combinado de activaciones reales

Algunos ejemplos reales de usos de estos datos son:

- En casos como la erupción en La Palma, se utilizaron simultáneamente datos del Catastro, OSM y productos de Copernicus EMS para cartografiar daños, calcular población afectada y planificar ayudas.

- Durante el terremoto en Turquía en 2023, organizaciones como UNOSAT y Copernicus combinaron imágenes satelitales con algoritmos automáticos para detectar colapsos estructurales y cruzarlos con huellas existentes. Esto permitió estimar rápidamente el número de personas potencialmente atrapadas.

En situaciones de emergencia, el tiempo es un recurso crítico. La inteligencia artificial aplicada a imágenes satelitales o aéreas permite generar huellas de edificios de forma mucho más rápida y automatizada que los métodos tradicionales.

En definitiva, las distintas fuentes no son excluyentes, sino complementarias. Su integración estratégica dentro de una infraestructura de datos bien gobernada es lo que permite pasar del dato al impacto, y poner el conocimiento geoespacial al servicio de la seguridad, la planificación y el bienestar colectivo.

Gobierno de datos y coordinación

Contar con huellas de edificios de calidad es un primer paso fundamental, pero su verdadero valor solo se activa cuando estos datos están bien gobernados, coordinados entre actores y preparados para ser utilizados de forma eficiente en situaciones reales. Aquí es donde entra en juego el gobierno del dato: el conjunto de políticas, procesos y estructuras organizativas que aseguran que los datos estén disponibles, sean fiables, actualizados y utilizados de forma responsable.

¿Por qué es clave la gobernanza de datos?

En contextos de emergencia o planificación territorial, la falta de coordinación entre instituciones o la existencia de datos duplicados, incompletos o desactualizados puede tener consecuencias graves: retrasos en la toma de decisiones, duplicación de esfuerzos o, en el peor de los casos, decisiones erróneas. Una buena gobernanza de datos garantiza que:

- Los datos sean conocidos y localizables: no basta con que existan; deben estar documentados, catalogados y accesibles en plataformas donde los usuarios los puedan encontrar fácilmente.

- Haya estándares e interoperabilidad: las huellas de edificios deben seguir formatos comunes (como GeoJSON, GML, shapefile), usar sistemas de referencia consistentes, y estar alineadas con otras capas geoespaciales (redes de servicios, límites administrativos, zonas de riesgo…).

- Se mantengan actualizados: especialmente en zonas urbanas o en desarrollo, donde nuevas construcciones surgen rápidamente. Un dato de hace cinco años puede ser inservible en una crisis actual.

- Se coordinen entre niveles de gobierno: municipal, regional, nacional y europeo. La compartición eficiente evita duplicidades y facilita respuestas conjuntas, especialmente en contextos transfronterizos o internacionales.

- Se definan roles y responsabilidades claras: ¿quién produce los datos?, ¿quién los valida?, ¿quién los distribuye?, ¿quién los activa en caso de emergencia?

El valor de la colaboración

Un ecosistema sólido de gobierno del dato también debe fomentar la colaboración multisectorial. Administraciones públicas, servicios de emergencia, universidades, sector privado, organizaciones humanitarias y ciudadanía pueden beneficiarse (y contribuir) al uso y mejora de estos datos.

Por ejemplo, en muchos países, los catastros locales trabajan en colaboración con organismos como los institutos geográficos nacionales, mientras que iniciativas de ciencia ciudadana y mapeo colaborativo (como OpenStreetMap) pueden complementar o actualizar datos oficiales en zonas menos cubiertas.

Preparación para emergencias

En situaciones de crisis, la coordinación debe estar anticipada. No se trata solo de tener los datos, sino de tener planes operativos claros sobre cómo acceder a ellos, quién los activa, en qué formatos, y cómo se integran con los sistemas de respuesta (como los Centros de Coordinación de Emergencias o los SIG de protección civil).

Por ello, muchas instituciones están desarrollando protocolos de activación de datos geoespaciales en emergencias, y plataformas como Copernicus Emergency Management Service ya trabajan bajo este principio, ofreciendo productos basados en datos bien gobernados y activables en tiempo récord.

Conclusión

Las huellas de edificios no son solo un recurso técnico para urbanistas o cartógrafos: son una herramienta crítica para la gestión del riesgo, la planificación urbana sostenible y la protección de la ciudadanía. En situaciones de emergencia, donde el tiempo y la información precisa son factores determinantes, disponer de estos datos puede marcar la diferencia entre una intervención eficaz y una tragedia evitable.

El avance en tecnologías de observación de la Tierra, el uso de inteligencia artificial y el compromiso con la apertura de datos por parte de instituciones como el JRC o el IGN han democratizado el acceso a información geoespacial de altísimo valor. Hoy es posible que una administración local, una ONG o un grupo de voluntarios accedan a huellas de edificios para planificar evacuaciones, estimar población afectada o diseñar rutas logísticas en tiempo real.

Sin embargo, el reto no es solo tecnológico, sino también organizativo y cultural. Es imprescindible fortalecer el gobierno del dato: asegurar que estos conjuntos estén bien documentados, actualizados, accesibles y que su uso esté integrado en los protocolos de emergencia y planificación. También es fundamental formar a los actores clave, promover la interoperabilidad y fomentar la colaboración entre instituciones públicas, sector privado y sociedad civil.

En definitiva, las huellas de edificios representan mucho más que geometrías en un mapa: son una base sobre la que construir resiliencia, salvar vidas y mejorar la toma de decisiones en momentos críticos. Apostar por su uso responsable y abierto es apostar por una gestión pública más inteligente, coordinada y centrada en las personas.

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los portales de datos abiertos contribuyen a que los municipios ofrezcan un acceso estructurado y transparente a los datos que generan en el ejercicio de sus funciones y en la prestación de los servicios de su competencia, fomentando además la creación de aplicaciones, servicios y soluciones que generan valor tanto para la ciudadanía y las empresas como para las propias administraciones públicas.

El informe tiene como propósito ofrecer una guía práctica para que las administraciones municipales puedan diseñar, desarrollar y mantener portales de datos abiertos eficaces, integrándolos en la estrategia global de ciudades inteligentes. El documento se estructura en varias secciones que abarcan desde la planificación estratégica hasta las recomendaciones técnicas y operativas necesarias para la creación y mantenimiento de portales de datos abiertos. Algunas de las claves principales son:

Principios fundamentales

El informe destaca la importancia de integrar los portales de datos abiertos en planes estratégicos municipales, alineando los objetivos del portal con las prioridades locales y las expectativas ciudadanas. También recomienda elaborar un Plan de medidas para el impulso de la apertura y reutilización de datos (Plan RISP), que incluya modelos de gobernanza, licencias claras, agenda de apertura de datos y acciones para estimular su reutilización. Finalmente, enfatiza la necesidad de contar con personal capacitado en ámbitos estratégicos, técnicos y funcionales, capaces de gestionar, mantener y promover la reutilización de datos abiertos.

Requisitos generales

En cuanto a los requisitos generales para garantizar el éxito del portal, se destaca la importancia de ofrecer datos de calidad, consistentes y actualizados en formatos abiertos como CSV y JSON, pero también en XLS, favoreciendo la interoperabilidad con plataformas nacionales e internacionales mediante estándares abiertos como DCAT-AP, y garantizando una accesibilidad efectiva del portal mediante un diseño intuitivo, inclusivo y adaptado a diferentes dispositivos. También se señala la obligación de cumplir estrictamente las normativas de privacidad y protección de datos, especialmente el Reglamento General de Protección de Datos (RGPD).

Para promover la reutilización, el informe aconseja fomentar ecosistemas dinámicos a través de eventos comunitarios como hackatones y talleres, destacando ejemplos exitosos de aplicación práctica de los datos abiertos. Además, insiste en la necesidad de proporcionar herramientas útiles como API para consultas dinámicas, visualizaciones de datos interactivas y documentación completa, así como en implementar mecanismos sostenibles de financiación y mantenimiento.

Pautas técnicas y funcionales

Con respecto a las pautas técnicas y funcionales, el documento detalla la importancia de construir una infraestructura técnica robusta y escalable basada en tecnologías en la nube, utilizando sistemas de almacenamiento diversos como bases de datos relacionales, NoSQL y soluciones específicas para series temporales o datos geoespaciales. Destaca además la relevancia de integrar herramientas avanzadas de automatización para garantizar la calidad constante de los datos y recomienda soluciones específicas para gestionar datos en tiempo real provenientes de Internet de las Cosas (IoT).