Aragón Open Data, portal de datos abiertos del Gobierno de Aragón, presentará el próximo 15 de marzo de 2023 sus trabajos más recientes para dar a conocer sus líneas de acción y avances en materia de apertura de datos y datos enlazados.

¿En qué consiste ‘Aragón Open Data: Abre y conecta datos’?

En este encuentro, que forma parte de los actos enmarcados en los Open Data Days 2023, Aragón Open Data aprovechará la ocasión para hablar de la evolución de su plataforma de datos abiertos y de la mejora de la calidad de los datos ofrecidos.

En esta línea, la jornada ‘Aragón Open Data: Abre y conecta datos’ pondrá además la sílaba tónica en detallar el funcionamiento de Aragopedia, su nueva estrategia de datos enlazados.

A través de una serie de explicaciones técnicas, apoyadas por una demo, los asistentes podrán conocer cómo funciona este servicio, basado en la nueva estructura de Información Interoperable de Aragón (EI2A) que permite compartir, conectar y relacionar determinados datos disponibles en el portal Aragón Open Data.

A continuación, y con el objetivo de detallar con la mayor precisión posible el planteamiento de la jornada, compartimos el programa de la misma:

- Bienvenida a la jornada. Julián Moyano, coordinador de Aragón Open Data.

- Introducción a Aragón Open Data (Marc Garriga, Desidedatum)

- Mejora de la calidad de los datos y de su semantización (Koldo Z. / Susana G.)

- Situación previa y situación actual

- Nueva navegación centrada en los datos de Aragón Open Data y Aragopedia (Pedro M. / Beni)

- Explicación y Demo

- Mi experiencia con la Aragopedia. (Sofía Arguís, Documentalista y usuaria de Aragón Open Data )

- Proceso de identificación, procesado y apertura de nuevos datos (Cristina C.)

- Punto de partida y Retos encontrados para lograr la apertura

- Conclusiones (Marc Garriga )

- Turno de preguntas/comentarios

¿Dónde y cuándo se celebra?

La jornada técnica ‘Aragón Open Data: Abre y conecta datos’ se celebrará el próximo 15 de marzo de 12:00 a 13:30 horas de forma online. Por ello, para poder asistir a la misma, los usuarios interesados deberán rellenar el formulario disponible en el siguiente punto.

¿Cómo puedo inscribirme?

Para asistir y acceder a la sesión online puedes completar el siguiente formulario y para cualquier cuestión no dudes en escribirnos opendata@aragon.es

Aragón Open Data está cofinanciado por la Unión Europea, Fondo Europeo de Desarrollo Regional (FEDER) "Construyendo Europa desde Aragón.

Urban3r es una aplicación que permite visualizar diferentes indicadores sobre el estado actual de la edificación, los datos de demanda energética de los edificios residenciales en su estado actual y tras someterlos a una rehabilitación energética, así como los costes estimados de estas intervenciones.

Para facilitar la toma de decisiones a escala urbana, la herramienta permite filtrar por temáticas de estudio específicas y consultar los datos individualmente a escala de edificio. A este nivel hay que tener en cuenta que se trata de una primera aproximación orientativa.

Para las personas registradas, la herramienta dispone de un sistema de descarga de datos en formato CSV y GeoPackage de aquellos municipios de España de los que dispone de información. Los municipios de los que no tiene información, pueden ser procesados automáticamente mediante la subida del fichero urbano en formato CAT disponible en la Sede Electrónica del Catastro.

La información relacionada con la rehabilitación energética de los edificios procede de una aplicación a escala de referencia catastral de los datos elaborados en el marco de la ERESEE 2020 (Estrategia a largo plazo para la rehabilitación energética en el sector de la edificación en España).

En definitiva, es una plataforma de datos abiertos para impulsar la regeneración urbana en España que utiliza los conjuntos de datos de la Sede Electrónica del Catastro y permite la descarga de los datos por municipio en formato CSV.

El Sistema de Observación Meteorológica del Gobierno de Canarias es una infraestructura promovida por la Consejería de Transición Ecológica, Lucha contra el Cambio Climático y Planificación Territorial, que integra una red de estaciones equipadas con sensores meteorológicos y servidores encargados de la administración de la red y el almacenamiento, control de calidad y difusión de los datos registrados.

Se trata de una red que se concibe como una infraestructura complementaria a las ya existentes y esencial para el ejercicio de competencias como las relacionadas con el Cambio Climático o el seguimiento de Fenómenos Meteorológicas Adversos (FMA).

Conforme a la Directiva (UE) 2019/1024, este sistema gestiona un conjunto de datos de alto valor que está disponible para su reutilización. Por ello, desde su web es posible realizar los siguientes servicios:

- Consultar la ubicación de las estaciones y los últimos datos registrados.

- Descargar las series históricas de observaciones registradas por las estaciones en datos abiertos.

- Visualizar en tiempo real las observaciones registradas por las estaciones meteorológicas.

- Integrar, mediante una API, los datos registrados en cualquier sistema.

El pasado 21 de febrero tuvo lugar la entrega de premios a los ganadores de la VI edición del Concurso de Datos Abiertos de Castilla y León. Esta competición, organizada por la Consejería de la Presidencia de la Junta de Castilla y León, reconoce la realización de proyectos que suministran ideas, estudios, servicios, sitios web o aplicaciones móviles, utilizando para ello conjuntos de datos de su Portal de Datos Abiertos.

El acto ha contado con la participación entre otros, de Jesús Julio Carnero García, Consejero de la Presidencia, y Rocío Lucas Navas, Consejera de Educación de la Junta de Castilla y León.

En su discurso, el consejero Jesús Julio Carnero García ha destacado que la Junta va a poner en marcha el proyecto de Gobierno del Dato, con el que pretenden sumar Transparencia y Datos Abiertos, para de este modo, mejorar los servicios que ofrecidos a los ciudadanos.

Así, el proyecto de Gobierno del Dato cuenta con una asignación aprobada de casi 2,5 millones de euros de los Fondos Next Generation, que incluye dos líneas de trabajo: tanto el diseño e implantación del modelo de Gobierno del Dato, como la capacitación de los empleados públicos.

Se trata de una acción de Gobierno abierto que, según ha añadido el propio Consejero, “tiene una estrecha relación con la transparencia, puesto que pretendemos que los Datos Abiertos estén disponibles de forma libre para todo el mundo, sin restricciones de copyright, patentes u otros mecanismos de control o registro”.

Nueve premiados en la VI edición del concurso de Datos Abiertos de Castilla y León

Es precisamente en este contexto donde destacan iniciativas como la VI edición del Concurso de Datos Abiertos de Castilla y León. En su sexta convocatoria, ha recibido un total de 26 propuestas procedentes de León, Palencia, Salamanca, Zamora, Madrid y Barcelona.

De esta forma, los 12.000 euros repartidos en las cuatro categorías definidas en las bases han quedado repartidos entre nueve de las propuestas mencionadas anteriormente. Así ha quedado el palmarés de galardones distribuido por categorías:

Categoría Productos y Servicios: destinada a reconocer proyectos que proporcionen estudios, servicios, sitios web o aplicaciones para dispositivos móviles y que estén accesibles para toda la ciudadanía vía web mediante una URL.

- Primer premio: 'Oferta de Formación profesional de Castilla y León. Una alternativa atractiva y accesible con herramientas no-cod'”. Autora: Laura Folgado Galache. (Zamora). 2.500 euros.

- Segundo premio: 'Enjoycyl: recogida y explotación de asistencia y valoración de actividades culturales'. Su autor es José María Tristán Martín. (Palencia) 1.500 euros.

- Tercer premio: 'Aplicación del problema de la p-mediana a la Atención Primaria en Castilla y León'. Autores: Carlos Montero y Ernesto Ramos (Salamanca) 500 euros.

- Premio estudiantes: 'Play4CyL'. Sus autores son Carlos Montero y Daniel Heras (Salamanca) 1.500 euros.

Categoría Ideas: busca premiar proyectos que describan una idea para desarrollar estudios, servicios, sitios web o aplicaciones para dispositivos móviles.

- Primer premio: 'Elige tu Universidad (Castilla y León)'. Autores: Maite Ugalde Enríquez y Miguel Balbi Klosinski (Barcelona) 1.500 euros.

- Segundo premio: 'Bots para interactuar con datos abiertos – Interfaces conversacionales para facilitar el acceso a los datos públicos (BODI)'. Autores: Marcos Gómez Vázquez y Jordi Cabot Sagrera (Barcelona) 500 euros.

Categoría Periodismo de Datos: premia piezas periodísticas publicadas o actualizadas (de forma relevante) en cualquier soporte (escrito o audiovisual).

- Primer premio: 'Elecciones 13-F en Castilla y León: habrá 186 colegios electorales menos que en las autonómicas de 2019'. Autores: Asociación Maldita contra la desinformación (Madrid) 1.500 euros.

- Segundo premio: 'Más de 2.500 alcaldes no cobraron nada de su ayuntamiento en 2020 y otros 1.000 no han informado de su sueldo'. Autores: Asociación Maldita contra la desinformación (Madrid). 1.000 euros.

Categoría Recurso Didáctico: reconoce la creación de recursos didácticos abiertos (publicados con licencias Creative Commons) nuevos e innovadores que sirvan de apoyo a la enseñanza en el aula.

En definitiva y tal y como apuntan desde la misma Consejería de la Presidencia, con este tipo de iniciativas y el Portal de Datos Abiertos se cumplen dos principios básicos: en primer lugar, el de transparencia, al poner a disposición de toda la sociedad datos generados por la Administración de la Comunidad en el desarrollo de sus funciones, en formatos abiertos y con una licencia libre para su uso; y en segundo lugar, el de colaboración, permitiendo el desarrollo de iniciativas compartidas que aporten mejoras sociales y económicas a través del trabajo conjunto entre la ciudadanía y las administraciones públicas.

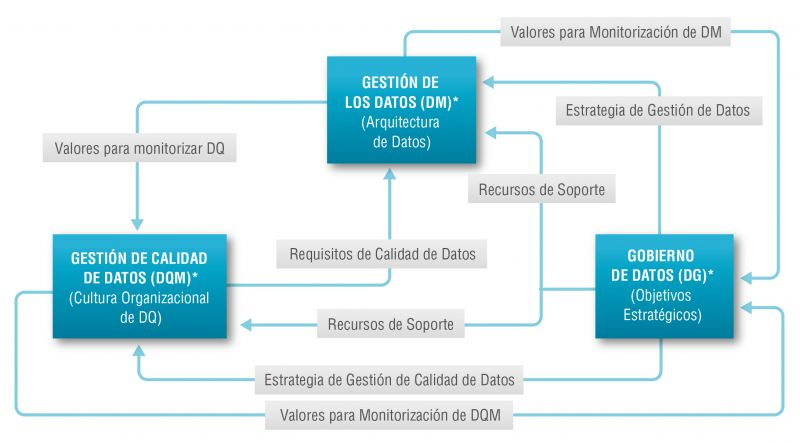

Existe una tan estrecha relación entre la gestión del dato, la gestión de calidad del dato y el gobierno del dato que en muchas ocasiones los términos se utilizan de forma indistinta o directamente se confunden. Sin embargo, existen importantes matices.

El objetivo general de la gestión de datos es asegurar que los datos satisfacen los requisitos de negocio que darán soporte a los procesos de la organización, tales como recopilar, almacenar, proteger, analizar y documentar los datos, con el objetivo de implementar los objetivos de la estrategia de gobierno del dato. Se trata de un conjunto de tareas tan amplio que existen diversas categorías de normas para certificar cada uno de los diferentes procesos: ISO/IEC 27000 para la seguridad y privacidad de la información, ISO/IEC 20000 para la gestión de servicios de TI, ISO/IEC 19944 para interoperabilidad, arquitectura o acuerdos de nivel de servicio en la nube, o ISO/IEC 8000-100 para el intercambio de datos y la gestión de datos maestros.

La gestión de calidad de datos, por su parte, se refiere a las técnicas y procesos utilizados para asegurar que los datos son adecuados para el uso que se pretende hacer de ellos. Para ello se requiere un Plan de calidad de los datos que debe ser acorde con la cultura de la organización y con la estrategia de negocio e incluye aspectos como la validación, verificación y limpieza de datos, entro otros. En este sentido también existe un conjunto de normas técnicas para conseguir que los datos tengan calidad] entre las que se incluyen la propia gestión de la calidad de los datos de transacción, los datos de producto y los datos maestros empresariales (ISO 8000) y las tareas de medición de la calidad de los datos (ISO 25024:2015).

Por su parte, el gobierno del dato, de acuerdo con la definición de Deloitte, está formado por conjunto de normas, políticas y procesos de una organización que permiten asegurar que los datos de la organización sean correctos, fiables, seguros y útiles. Es decir, es la parte estratégica y de planificación y control a alto nivel para conseguir crear valor para el negocio a partir de los datos. En este caso, el gobierno de los datos abiertos tiene sus propias especificidades debido al número de partes interesadas que intervienen y la propia naturaleza colaborativa de los datos abiertos.

El modelo Alarcos

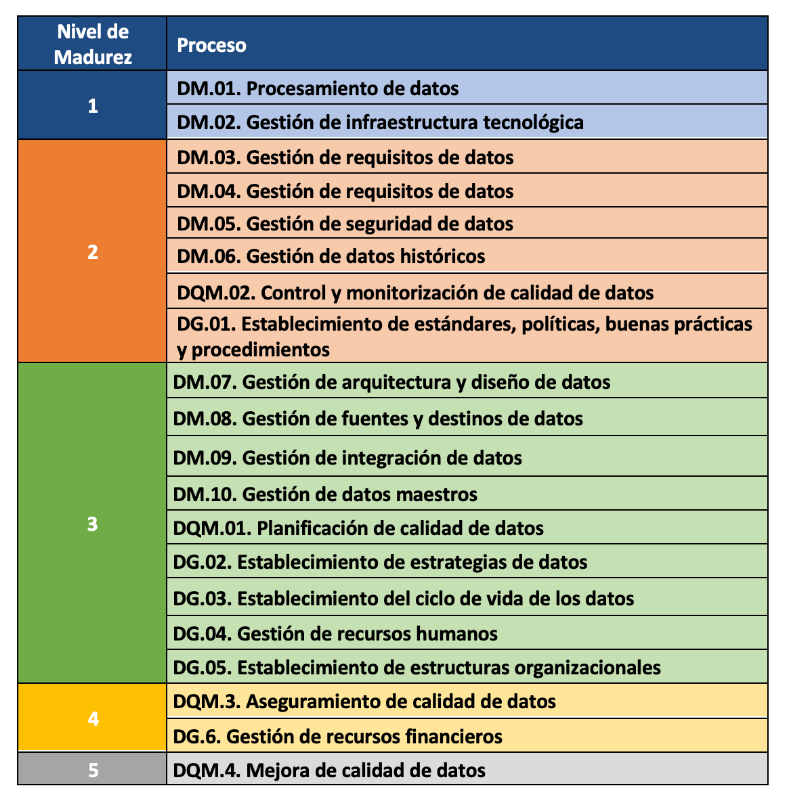

En este contexto el Modelo Alarcos de Mejora de Datos (MAMD), actualmente en su versión 3, tiene como objetivo recoger los procesos necesarios para alcanzar la calidad de las tres citadas dimensiones: la gestión de los datos, la gestión de la calidad de los datos y el gobierno de los datos. Este modelo ha sido desarrollado por un grupo de expertos coordinado por el grupo de investigación Alarcos de la Universidad de Castilla-La Mancha.

El Modelo MAMD está alineado con las mejores prácticas y estándares existentes tales como Data Management Community (DAMA), Data management maturity (DMM) o la propia familia de normas ISO 8000, cada una de las cuáles aborda diferentes aspectos relacionados con la calidad de los datos y la gestión de los datos maestros desde diferentes perspectivas. Además, el modelo Alarcos está basado en la familia de estándares para definir el modelo de madurez por lo que es posible conseguir la certificación de AENOR para el gobierno, gestión y calidad de datos ISO 8000-MAMD.

El modelo MAMD consiste de 21 procesos, 9 procesos corresponden a la gestión de los datos (DM), la gestión de la calidad de datos (DQM) incluye 4 procesos más y el gobierno del dato (DG), que añade otros 8 procesos.

La incorporación progresiva de los 21 procesos permite la definición de 5 niveles de madurez que contribuyen a que la organización mejore su gestión, calidad y gobierno de datos. Comenzando con el nivel 1 (Realizado) en el que el organismo puede demostrar que utiliza buenas prácticas en el uso de los datos y tiene el soporte tecnológico necesario, pero no presta atención al gobierno ni a la calidad de los datos, hasta el nivel 5 (Innovado) en el que el organismo es capaz de alcanzar sus objetivos y está continuamente mejorando.

El modelo puede certificarse con una auditoría equivalente a la de otras normas de AENOR por lo que existe la posibilidad de incluirlo en el ciclo de mejora continua y control interno de cumplimiento normativo de las organizaciones que ya cuentan con otros certificados.

Experiencias prácticas

La Biblioteca de la Universidad de Castilla-La Mancha (UCLM), que da soporte a más de 30.000 alumnos y 3.000 profesionales entre profesores y personal de administración y servicios, es una de las primeras organizaciones que pudo superar la auditoría de certificación y por tanto obtener el nivel 2 de madurez en ISO/IEC 33000 – ISO 8000 (MAMD).

Los puntos más fuertes que se identificaron en este proceso de certificación fueron el compromiso del equipo directivo y el nivel de coordinación con otras universidades. Como en toda auditoría, se propusieron mejoras como la necesidad de documentar las revisiones periódicas de seguridad de datos que contribuyeron a alimentar el ciclo de mejora.

El hecho de que las organizaciones de todo tipo otorguen un valor cada vez mayor a sus activos de datos hace que los modelos y normas técnicas de certificación tengan un papel fundamental en garantizar la calidad, la seguridad, la privacidad, la gestión o el adecuado gobierno de estos activos de datos. Además de los estándares ya existentes se sigue haciendo un importante esfuerzo para desarrollar nuevas normas que cubran aspectos que hasta ahora no se habían considerado centrales debido a la menor importancia de los datos en las cadenas de valor de las organizaciones. Sin embargo, aún es necesario continuar con la formalización de modelos que como el Modelo Alarcos de Mejora de Datos permitan abordar de forma holística, y no sólo desde sus diferentes dimensiones, la evaluación y el proceso de mejora de la organización en el tratamiento de sus activos de datos.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La administración pública trabaja para garantizar el acceso a los datos abiertos, y así, empoderar a la ciudadanía en su derecho a la información. En línea con este objetivo, el portal de datos abiertos europeo (data.europa.eu) referencia un gran volumen de datos de temáticas variadas.

Sin embargo, aunque los datos pertenecen a ámbitos de información diferentes o se encuentran en formatos diversos, resulta complejo explotarlos conjuntamente para maximizar su valor. Una forma de lograrlo es mediante el uso de RDF (Resource Description Framework), un modelo de datos que permite la interoperabilidad semántica de datos en la web, estándar del W3C, y destacado en los principios FAIR. RDF ocupa los niveles superiores del esquema de cinco estrellas en la publicación de datos abiertos, propuesto por Tim Berners-Lee, el padre de la web.

En RDF, se interconectan datos y metadatos de manera automática generando una red de datos abiertos enlazados (LOD, por sus siglas en inglés, Linked Open Data) aportando el contexto semántico necesario mediante relaciones explicitas entre datos procedentes de diferentes fuentes para facilitar su interconexión. Este modelo maximiza el potencial de explotación de los datos enlazados.

Se trata de un paradigma de compartición de datos que cobra especial relevancia dentro de la iniciativa de espacio de datos de la UE que explicamos en este post.

RDF ofrece grandes ventajas a la comunidad. Sin embargo, para poder maximizar la explotación de datos abiertos enlazados es necesario conocer el lenguaje de consulta SPARQL, un requerimiento técnico que puede dificultar el acceso público a los datos.

Un ejemplo del uso de RDF es el de los catálogos de datos abiertos disponibles en portales como datos.gob.es o data.europa.eu que están desarrollados siguiendo el estándar DCAT que es un modelo de datos en RDF para facilitar su interconexión. Estos portales disponen de interfaces para configurar consultas en lenguaje SPARQL, y recuperar los metadatos de los conjuntos de datos disponibles.

Una nueva aplicación para hacer accesibles los datos entrelazados: Vinalod

Ante esta situación y con el objetivo de facilitar el acceso a datos enlazados, Teresa Barrueco, científica de datos y especialista en visualización que participó en el EU Datathon de 2018, la competición de la UE para fomentar el diseño de soluciones y servicios digitales relacionadas con los datos abiertos, desarrolló junto a la Oficina de Publicaciones Europea una aplicación.

El resultado es una herramienta que permite explorar LOD sin necesidad de estar familiarizado con la sintaxis SPARQL bautizada con el nombre de Vinalod: Visualisation and navigation of linked open data. La aplicación, como indica su nombre, permite navegar y visualizar estructuras de datos en grafos de conocimiento que representan objetos de datos vinculados entre si mediante el uso de vocabularios que representan las relaciones existentes entre ellos. Así, mediante una interacción visual e intuitiva, el usuario puede acceder a diferentes fuentes de datos:

- Vocabularios de la UE. Datos de referencia de la UE que contiene, entre otros, información de Digital Europa Thesaurus, clasificación NUTS (sistema jerárquico para dividir el territorio económico de la UE) y vocabularios controlados del Named Authority Lists.

- Quién es quién en la UE. Directorio oficial de la UE para identificar a las instituciones que componen la estructura de la administración europea.

- Datos de la UE. Conjuntos y visualizaciones de datos publicados en el portal de datos abiertos de la UE que pueden explorarse según origen y temática.

- Publicaciones de la UE. Informes publicados por la Unión Europea clasificados según su temática.

- Legislación de la UE. Tratados de la UE y su clasificación.

La buena noticia es que la versión BETA de Vinalod ya está disponible para su utilización, un avance que permite filtrar temporalmente conjuntos de datos por país o idioma.

Para poner a prueba a la herramienta, probamos a buscar catálogos de datos publicados en español, que han sido modificados en los últimos tres meses. La respuesta de la herramienta es la siguiente:

que se puede interpretar de la siguiente forma:

Por lo tanto, el portal data.europa.eu alberga (“has catalog”) varios catálogos que cumplen con los criterios definidos: están en idioma español y han sido editados en los últimos tres meses. El usuario puede profundizar en cada nodo (“to”) y conocer cuáles son los conjuntos de datos publicados en cada uno de los portales.

En el ejemplo anterior, hemos explorado el apartado ‘Datos de la UE’. Sin embargo, podríamos hacer un ejercicio similar con cualquiera de los otros apartados. Estos son: Vocabularios de la UE; Quién es quién en la UE; Publicaciones de la UE y Legislación de la UE.

Todos estos los apartados están relacionados entre sí, es decir, un usuario puede empezar navegando por los ‘Datos de la UE’, como sucede en el ejemplo anteriormente explicado, y acabar en ‘Quién es quién de la UE’ con el directorio de cargos públicos europeos.

Como puede deducirse de las pruebas anteriores, la navegación por Vinalod es un ejercicio práctico en sí mismo que animamos a probar a todos los usuarios interesados en la gestión, explotación y reutilización de los datos abiertos.

Para ello, en este enlace vinculamos la versión BETA de la herramienta que contribuye a hacer más accesibles los datos abiertos sin la necesidad de conocer SPARQL, lo que significa que cualquier persona con un mínimo conocimiento técnico pueda trabajar con los datos abiertos enlazados.

Se trata de un aporte de valor para la comunidad de desarrolladores y reutilizadores de datos abiertos porque es un recurso al que puede acceder cualquier perfil de usuario, independientemente de su formación técnica. En definitiva, Vinalod es una herramienta que empodera a la ciudadanía, respeta su derecho a la información y contribuye a la apertura aún mayor de los datos abiertos.

El próximo 2 de marzo, tendrá lugar la presentación del proyecto ‘Datos abiertos y mujeres’, impulsado por el Observatorio Valenciano de Datos Abiertos y Transparencia, fruto de la colaboración entre la Conselleria de Participació, Transparencia, Cooperación y Calidad Democrática de la Generalitat y la Universidad Politécnica de València.

El evento que ha sido organizado por la profesora de la Universidad de Sevilla, Lorena R. Romero-Domínguez y la técnica audiovisual de la Universidad Politécnica de Valencia, Lucía García Robledo, con el apoyo de Antonia Ferrer Sapena, directora del Observatorio, y Eloína Coll Aliaga, directora de la Càtedra de Governança de la Ciutat de València, se llevará a cabo en el Salón de actos de Rectorado en la Universitat Politècnica de València.

Desde un inicio, el objetivo de este proyecto ha sido poner el foco en el rol que distintas mujeres del sector profesional desempeñan en el contexto de los datos y, en especial, de los datos abiertos. Así, mediante una serie de entrevistas, las profesionales seleccionadas comparten el transcurso de su trayectoria, explican cómo han crecido profesionalmente en el mundo de los datos y, también, cómo han abordado algunos de los proyectos más significativos de sus carreras a este respecto.

Las entrevistas, que fueron grabadas meses atrás, están disponibles para su visionado desde el canal de Youtube del Observatorio, donde podemos ver cómo cada una de las profesionales interpeladas reflexiona sobre los retos más importantes que afronta el sector, prestando especial atención a la inclusión de la perspectiva de género en los datos.

Presentación del proyecto y mesa redonda con algunas de las protagonistas

En la sesión de presentación del próximo 2 de marzo, se contará con Andrés Gomis, Director General de Transparencia, Atención a la Ciudadanía y Buen Gobierno de la Conselleria de Participación, Transparencia, Cooperación y Calidad Democrática de la Generalitat Valenciana y Elisa Valía, Tenienta Alcalde Participación, Derechos e Innovación de la Democracia. Concejala de Transparéncia y Gobierno Abierto del Ajuntament de València.

Además, también tendrá lugar una mesa de redonda sobre los datos con perspectiva de género que estará moderada por Carmen Montalbá, profesora de la Universitat de València, y en la que participarán las siguientes profesionales cuyas entrevistas forman parte del proyecto:

- Lorena R. Romero, profesora de la Universidad de Sevilla y autora del proyecto.

- Ana Tudela, Cofundadora de Datadista y miembro de la Oxford Climate Journalism Network.

- Silvia Rueda, Directora Territorial en la Conselleria de Innovación, Universidades, Ciencia y Sociedad Digital.

Junto a las ponentes anteriores que estarán presentes en la mesa redonda, el proyecto ‘Datos abiertos y mujeres’ recoge también las entrevistas de Lourdes Muñoz Santamaría, Fundadora y Directora de la Iniciativa Barcelona Open Data; Laura Castro, Diseñadora de visualización de datos en Affective Advisory; Zynnia del Villar, Directora de Investigación de Ciencias de Datos en Data-Pop Alliance; Thais Ruiz de Alda, Fundadora y CEO de Digital Fems. Tech Advisor&Consultant Digital Business; Sonia Castro-García Muñoz, Coordinadora de datos.gob.es (Red.es); Ana Tudela, Cofundadora de Datadista y Eva Méndez Rodríguez, Profesora Titular y Vicerrectora Adjunta de Política Científica de la Universidad Carlos III.

En definitiva, ‘Datos abiertos y mujeres’ es un proyecto que surge de la necesidad de incentivar un debate sobre la incorporación de la perspectiva de género a los datos, una práctica prioritaria para establecer políticas públicas que sean eficientes para combatir las desigualdades que se plantean entre hombres y mujeres.

Precisamente por esta razón, en las entrevistas, se ofrece una gran diversidad de visiones sobre el papel de los datos en los distintos campos profesionales, entre los que destacan, el periodismo de datos, el ámbito científico-tecnológico, el administrativo o las organizaciones internacionales, entre otros.

Por último, las personas interesadas en asistir presencialmente a la presentación del proyecto deberán inscribirse previamente en este formulario y, una vez confirmada su asistencia, acudir al Salón de actos de Rectorado UPV, en el edificio 3ª.

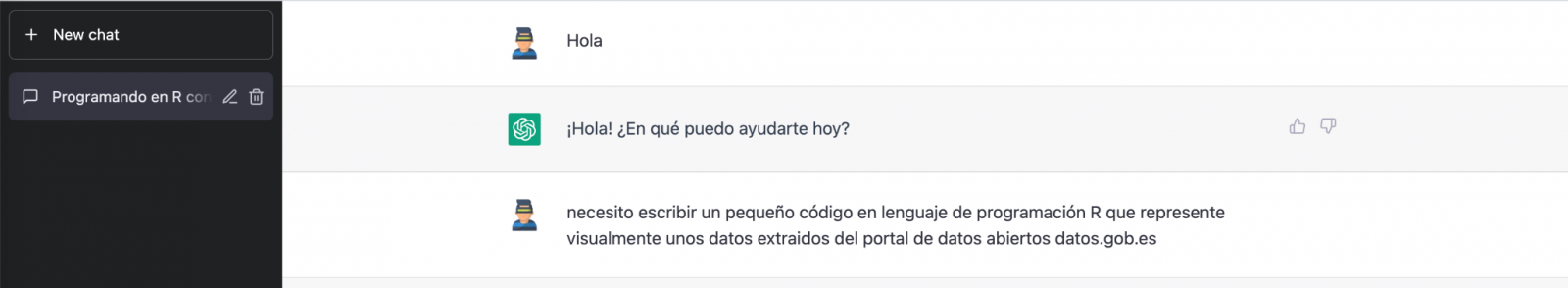

Hablar estos días de GPT-3 no es lo más original del mundo, lo sabemos. Toda la comunidad tecnológica está publicando ejemplos, realizando eventos y pronosticando el final del mundo del lenguaje y la generación de contenidos tal y cómo la conocemos actualmente. En este post, le pedimos a ChatGPT que nos eche una mano para programar un ejemplo de visualización de datos con R partiendo de un conjunto de datos abiertos disponible en datos.gob.es.

Introducción

Nuestro anterior post hablaba sobre Dall-e y la capacidad de GPT-3 para generar imágenes sintéticas partiendo de una descripción de lo que pretendemos generar en lenguaje natural. En este nuevo post, hemos realizado un ejercicio completamente práctico en el que le pedimos a la inteligencia artificial que nos ayude a realizar un sencillo programa en R que cargue un conjunto de datos abierto y genere algunas representaciones gráficas.

Hemos escogido un conjunto de datos abiertos de la plataforma datos.gob.es. En concreto, un conjunto de datos sencillos de uso de portales madrid.es. La descripción del repositorio explica que se incluye la información relativa a usuarios, sesiones y número de visitas a páginas de los siguientes portales del Ayuntamiento de Madrid: Portal Web municipal, Sede Electrónica, Portal de Transparencia, Portal de Datos Abiertos, Bibliotecas y Decide Madrid.

El fichero se puede descargar en formato .csv o .xslx y si lo pre-visualizamos tiene el siguiente aspecto:

Vale, comencemos a co-programar con ChatGPT!

Primero accedemos a la web y nos identificamos con nuestro usuario y contraseña. Es necesario estar registrado en el sitio web de openai.com para poder acceder a las capacidades de GPT-3, entre otras ChatGPT.

Iniciamos nuestra conversación:

Durante este ejercicio hemos intentado mantener una conversación de la misma forma que la tendríamos con un compañero de programación. Así que lo primero que hacemos es saludar y enunciar el problema que tenemos. Cuándo le pedimos a la IA que nos ayude a crear un pequeño programa en R que represente gráficamente unos datos, nos ofrece algunos ejemplos y ayuda con la explicación del programa:

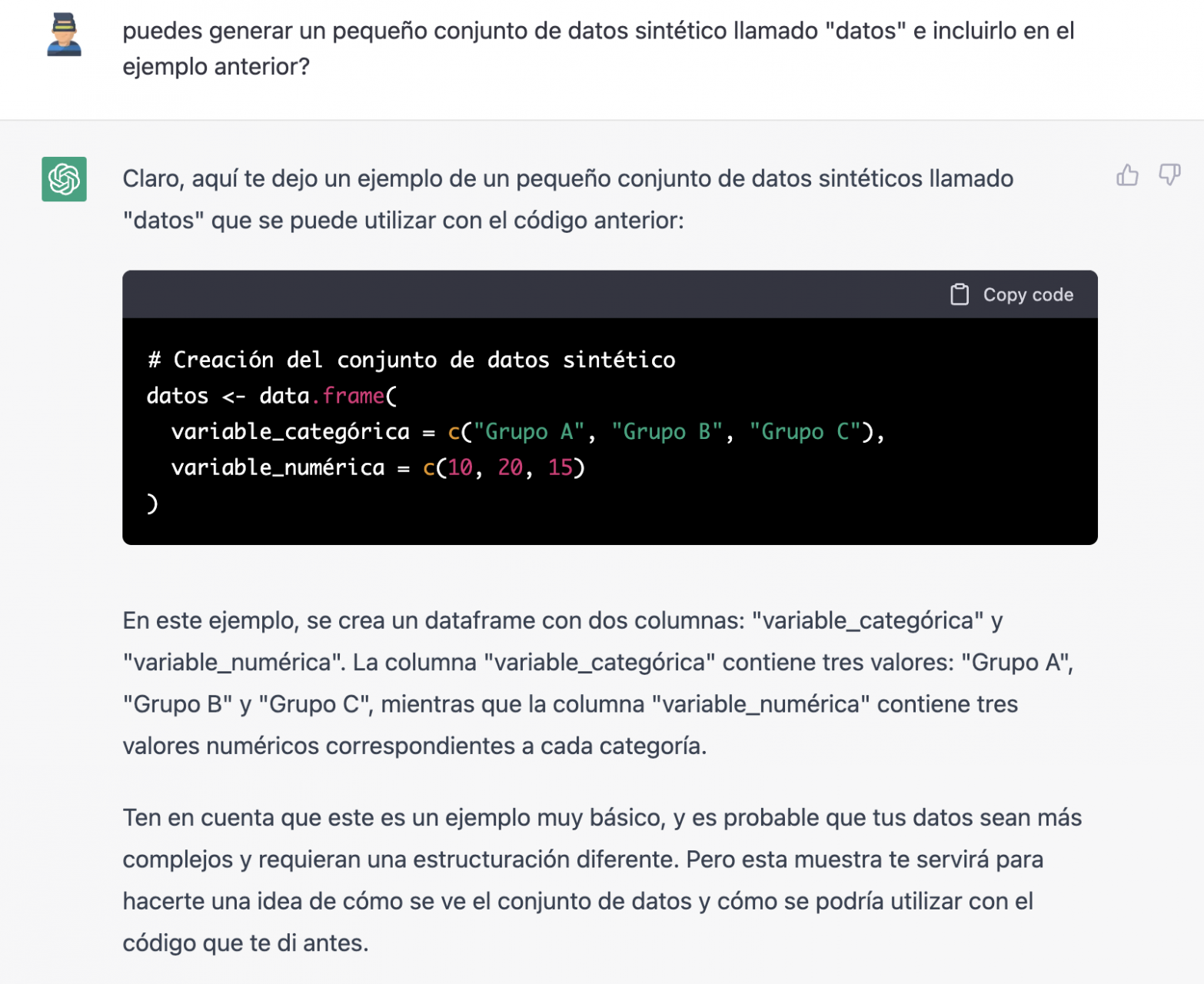

Puesto que no tenemos datos, no podemos hacer nada práctico por el momento, así que le pedimos si nos ayuda a generar unos datos sintéticos.

Como decimos, nos comportamos con la IA como lo haríamos con una persona (tiene buena pinta).

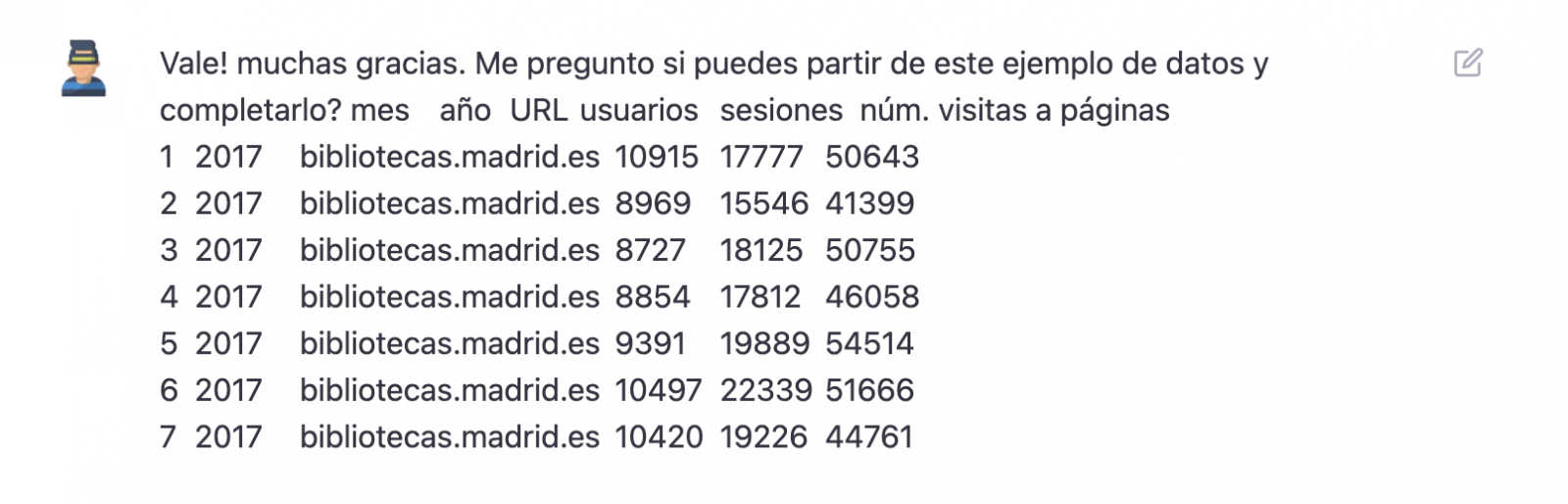

Una vez que parece que la IA responde con facilidad a nuestras preguntas, vamos con el siguiente paso, vamos a darle nosotros los datos. Y aquí empieza la magia… Hemos abierto el fichero de datos que nos hemos bajado de datos.gob.es y hemos copiado y pegado una muestra.

| Nota: ChatGPT no tiene conexión a Internet y por lo tanto no puede acceder a datos externos, así que lo único que podemos hacer es darle un ejemplo de los datos reales con los que queremos trabajar. |

Con los datos copiados y pegados tal cual se los hemos dado, nos escribe el código en R para cargarlos manualmente en un dataframe denominado “datos”. A continuación, nos proporciona el código de ggplot2 (la librería gráfica más conocida en R) para graficar los datos junto con una explicación del funcionamiento del código.

¡Genial! Es espectacular este resultado con un lenguaje totalmente natural y nada adaptado para hablar con una máquina. Veamos que pasa a continuación:

Pero resulta que al copiar y pegar el código en un entorno de RStudio comprobamos que este falla.

Así que le decimos lo que pasa y que nos ayude a solucionarlo.

Probamos de nuevo y ¡en este caso funciona!

Sin embargo, el resultado es un poco tosco. Así que se lo decimos.

A partir de aquí (y tras varios intentos de copiar y pegar más y más filas de datos) la IA cambia ligeramente el enfoque y me proporciona instrucciones y código para cargar mi propio fichero de datos desde mi ordenador en lugar de introducir manualmente los datos en el código.

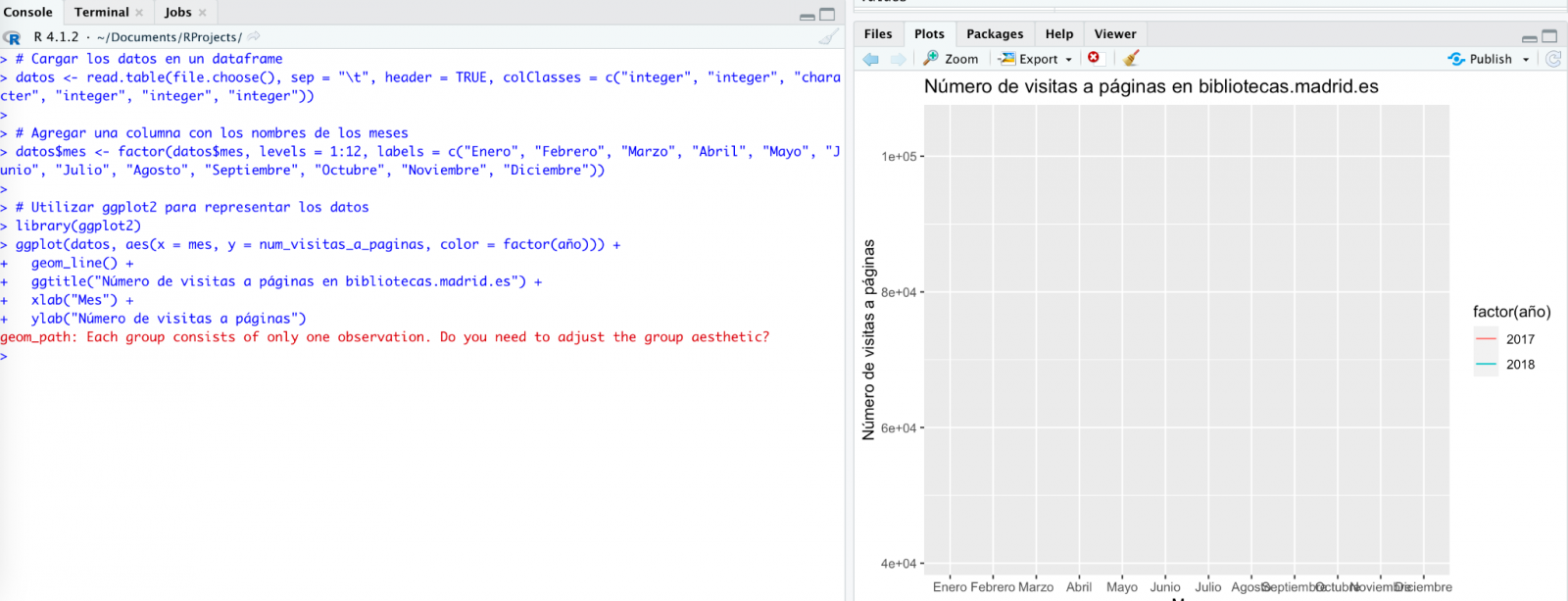

Le hacemos caso y copiamos un par de años de datos en un fichero de texto en nuestro ordenador. Fijaos, en lo que ocurre a continuación:

Probamos de nuevo:

Como veis, funciona, pero el resultado no es del todo acertado.

Y veamos lo que ocurre.

¡Por fin parece que ya nos ha entendido! Es decir, tenemos un gráfico de barras con las visitas a la web por mes, para los años 2017 (azul) y 2018 (rojo). Sin embargo, no me convencen ni el formato del título del eje ni tampoco se distingue bien la numeración del mismo eje.

Veamos el resultado ahora.

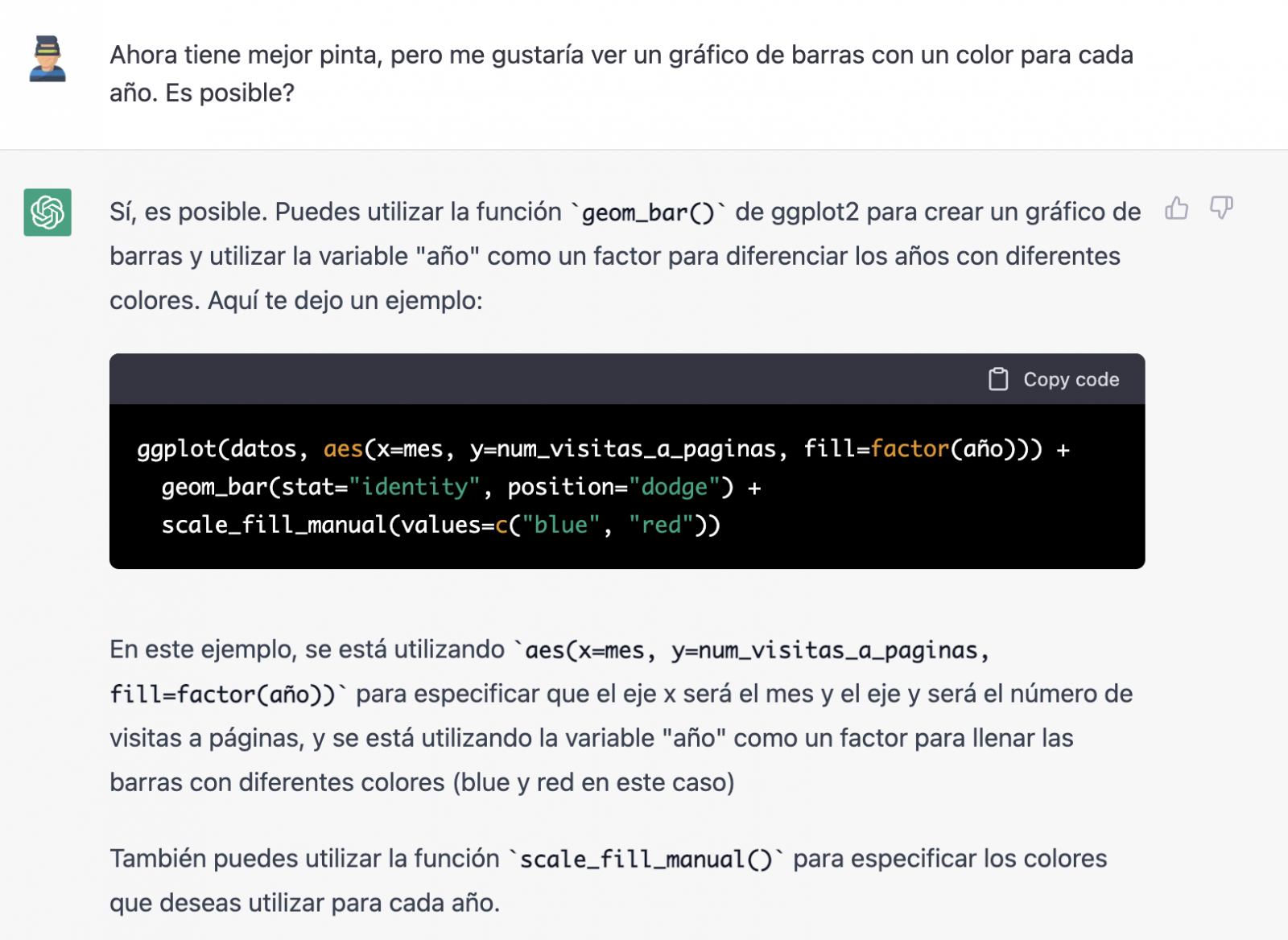

Tiene mucha mejor pinta, ¿verdad? Pero ¿qué tal si todavía le damos una vuelta de tuerca más?

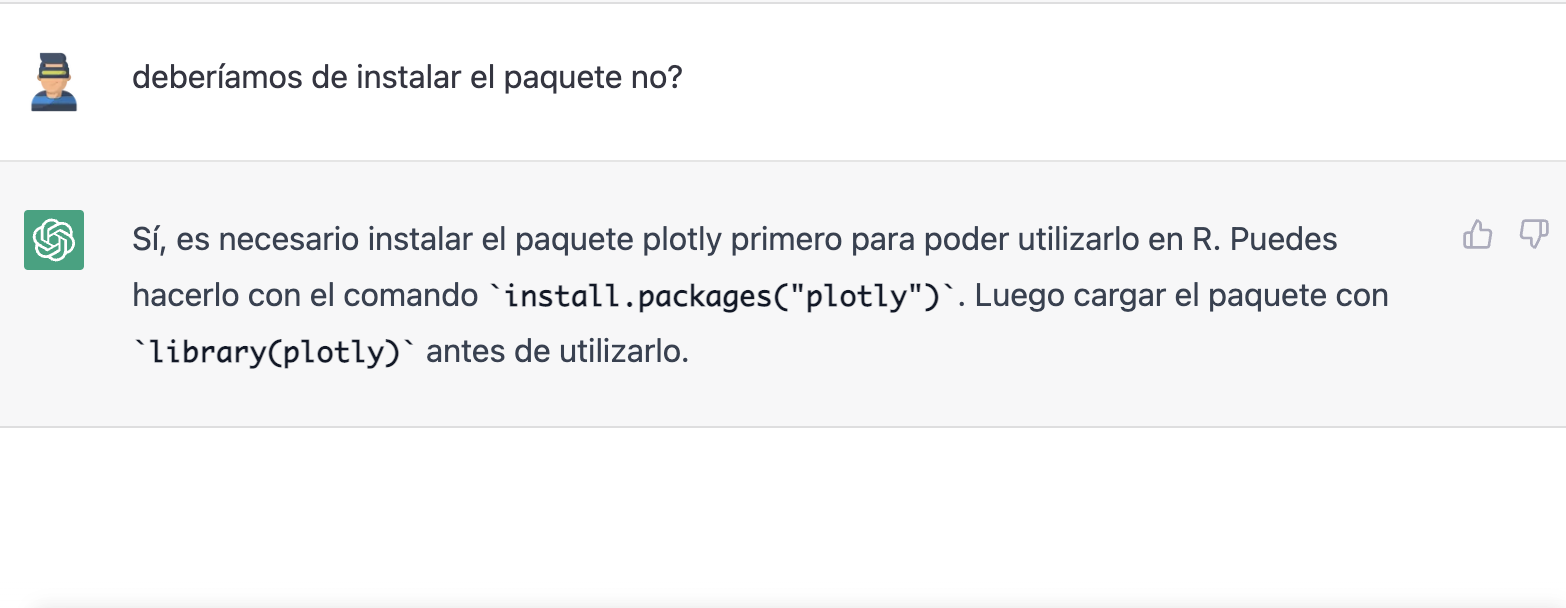

Sin embargo, se ha olvidado de decirnos que debemos instalar el paquete o librería plotly en R. Así que se lo recordamos.

Veamos el resultado:

Como podéis ver, ahora tenemos los controles del gráfico interactivo, de tal modo que podemos seleccionar un año concreto de la leyenda, hacer zoom, etc.

Conclusión

Puede que seas de esos escépticos, conservadores o prudentes que piensan que las capacidades demostradas por GPT-3 hasta el momento (ChatGPT, Dall-E2, etc) son todavía muy infantiles y poco prácticas en la vida real. Todas las consideraciones a este respecto son legítimas y, muchas, probablemente bien fundamentadas.

Sin embargo, algunos hemos pasado buena parte de la vida escribiendo programas, buscando documentación y ejemplos de código que pudiéramos adaptar o en los que inspirarnos; depurando errores, etc. Para todos nosotros (programadores, analistas, científicos, etc.) poder experimentar este nivel de interlocución con una inteligencia artificial en modo beta, puesta a disposición del público de forma gratuita y siendo capaz de demostrar esta capacidad de asistencia en la co-programación, es, sin duda, un salto cualitativo y cuantitativo en la disciplina de la programación.

No sabemos qué va a pasar, pero probablemente estemos a las puertas de un gran cambio de paradigma en la ciencia de la computación, hasta el punto que, quizás, haya cambiado para siempre la forma de programar y aún no nos hayamos dado cuenta.

Contenido elaborado por Alejandro Alija, experto en Transformación Digital.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La inteligencia artificial generativa se refiere a la capacidad de una máquina para generar contenido original y creativo, como imágenes, texto o música, a partir de un conjunto de datos de entrada. En lo que se refiere a la generación de texto, estos modelos son accesibles, en formato experimental, desde hace un tiempo, pero comenzaron a generar interés a mediados de 2020 cuando Open AI, una organización dedicada a la investigación en el campo de la inteligencia artificial general, publicó el acceso a su modelo de lenguaje GPT-3 a través de una API.

La arquitectura de GPT-3 está compuesta por 175 mil millones de parámetros, mientras que la de su antecesor GPT-2 era de 1.500 millones de parámetros, esto es, más de 100 veces más. GPT-3 representa por tanto un cambio de escala enorme ya que además fue entrenado con un corpus de datos mucho mayor y un tamaño de los tokens mucho más grande, lo que le permitió adquirir una comprensión más profunda y compleja del lenguaje humano.

A pesar de que fue de 2022 cuando OpenAI anunció la apertura de chatGPT, que permite dotar de una interfaz conversacional a un modelo de lenguaje basado en una versión mejorada de GPT-3, no ha sido hasta los últimos dos meses cuando la noticia ha llamado masivamente la atención del público, gracias a la amplia cobertura mediática que trata de dar respuesta al incipiente interés general.

Y es que, ChatGPT no sólo es capaz de generar texto a partir de un conjunto de caracteres (prompt) como GPT-3, sino que responde a preguntas en lenguaje natural en varios idiomas que incluyen inglés, español, francés, alemán, italiano o portugués. Es precisamente este cambio en la interfaz de acceso, pasando de ser una API a un chatbot, lo que lo ha convertido a la IA en accesible para cualquier tipo de usuario.

Tanto es así que más de un millón de personas se registraron para usarlo en tan solo cinco días, lo que ha motivado la multiplicación de ejemplos en los que chatGPT produce código de software, ensayos de nivel universitario, poemas e incluso chistes. Eso sin tener en cuenta que ha sido capaz de sacar adelante un examen de selectividad de Historia o de aprobar el examen final del MBA de la prestigiosa Wharton School.

Todo esto ha puesto a la IA generativa en el centro de una nueva ola de innovación tecnológica que promete revolucionar la forma en que nos relacionamos con internet y la web a través de búsquedas vitaminadas por IA o navegadores capaces de resumir el resultado de estas búsquedas.

Hace tan solo unos días, conocíamos la noticia de que Microsoft trabaja en la implementación de un sistema conversacional dentro de su propio buscador, el cual ha sido desarrollado a partir del conocido modelo de lenguaje de Open AI y cuya noticia ha puesto en jaque a Google.

Y es que, como consecuencia de esta nueva realidad en la que la IA ha llegado para quedarse, los gigantes tecnológicos han ido un paso más allá en la batalla por aprovechar al máximo los beneficios que esta reporta. En esta línea, Microsoft ha presentado una nueva estrategia dirigida a optimizar al máximo la manera en la que nos relacionamos con internet, introduciendo la IA para mejorar los resultados ofrecidos por los buscadores de navegadores, aplicaciones, redes sociales y, en definitiva, todo el ecosistema de la web.

Sin embargo, aunque el camino en el desarrollo de los nuevos y futuros servicios ofrecidos por la IA de Open AI aún están por ver, avances como los anteriores ofrecen una pequeña pista de la guerra de navegadores que se avecina y que, probablemente, cambie en el corto plazo la manera de crear y hallar contenido en la web.

Los datos abiertos

GPT-3, al igual que otros modelos que han sido generados con las técnicas descritas en la publicación científica original de GTP-3, es un modelo de lenguaje pre-entrenado, lo que significa que ha sido entrenado con un gran conjunto de datos, en total unos 45 terabytes de datos de texto. Según este paper, el conjunto de datos de entrenamiento estaba compuesto en un 60% por datos obtenidos directamente de internet en los que están contenidos millones de documentos de todo tipo, un 22% del corpus WebText2 construido a partir de Reddit, y el resto con una combinación de libros (16%) y Wikipedia (3%).

Sin embargo, no se sabe cuántos datos abiertos utiliza GPT-3 exactamente, ya que OpenAI no proporciona detalles más específicos sobre el conjunto de datos utilizado para entrenar el modelo. Lo que sí podemos hacer son algunas preguntas al propio chatGPT que nos ayuden a extraer interesantes conclusiones sobre el uso que hace de los datos abiertos.

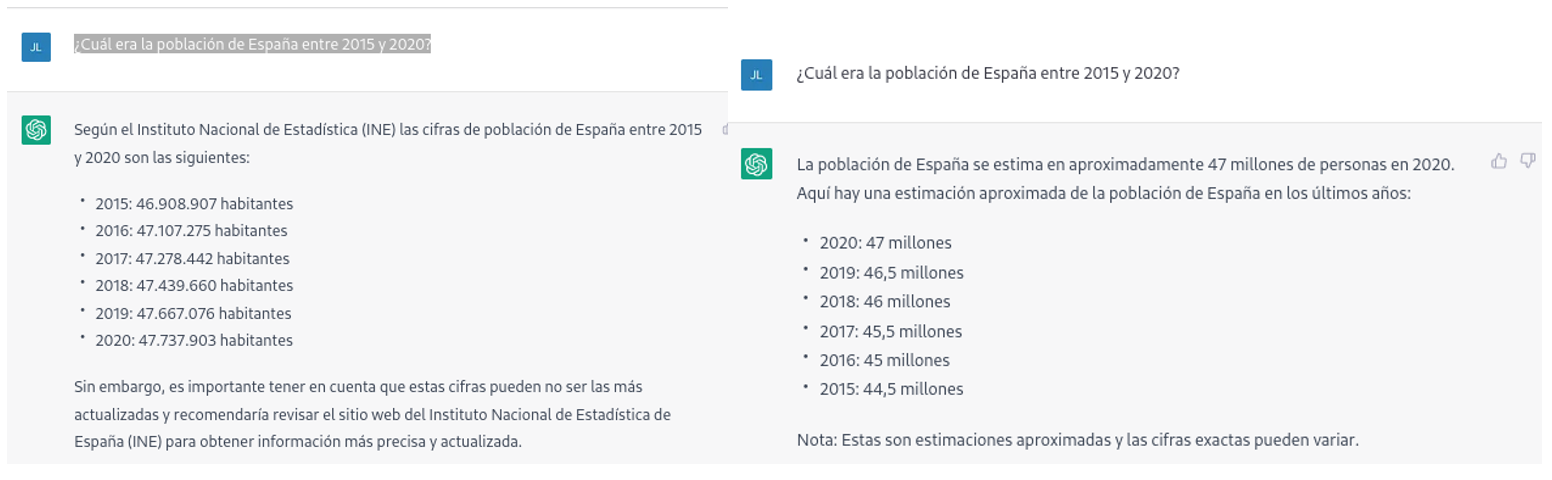

Por ejemplo, si le preguntamos a chatGPT cuál era la población de España entre 2015 y 2020 (no podemos pedirle datos más recientes), obtenemos una respuesta de este tipo:

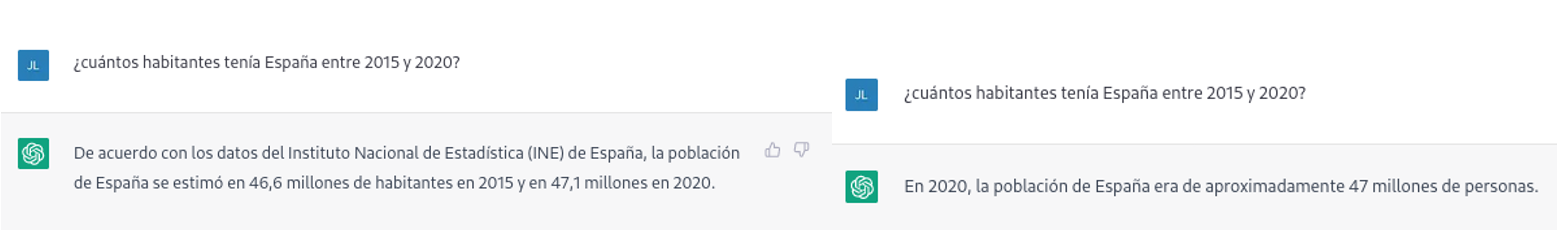

Tal como podemos ver en la imagen superior, aunque la pregunta sea la misma, la respuesta puede variar tanto en la redacción como en la información que contiene. Las variaciones pueden ser aún mayores si realizamos la pregunta en diferentes días o hilos de conversación:

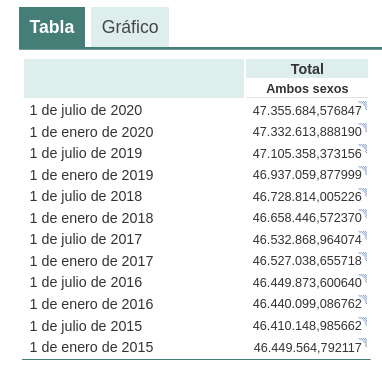

Pequeñas variaciones en la redacción del texto, generar la pregunta en diferentes momentos del hilo de conversación (recordemos que guarda el contexto) o en hilos o días diferentes puede conducir a resultados ligeramente diferentes. Además, la respuesta no es completamente precisa, tal y como nos advierte la propia herramienta si las comparamos con las series de población residente en España del propio INE, donde nos recomienda consultar. Los datos que idealmente habríamos esperado en la respuesta podrían obtenerse en un conjunto de datos abiertos del INE:

Este tipo de respuestas sugieren que los datos abiertos no se han empleado como una fuente autoritativa para responder preguntas de tipo factual, o al menos que aún no está completamente refinado el modelo en este sentido. Haciendo algunas pruebas básicas con preguntas sobre otros países hemos observado errores parecidos, por lo que no parece que se trate de un problema sólo con preguntas referentes a España.

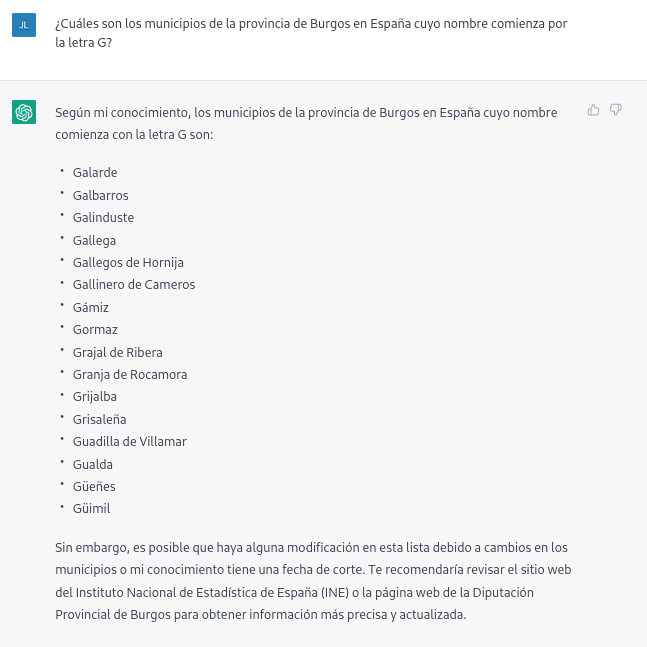

Si hacemos preguntas algo más específicas como pedir la lista de los municipios de la provincia de Burgos que comienzan por la letra “G” obtenemos respuestas que no son completamente correctas, como es propio de una tecnología que todavía está en fase incipiente.

La respuesta correcta debería contener seis municipios: Galbarros, La Gallega, Grijalba, Grisaleña, Gumiel de Hizán y Gumiel del Mercado. Sin embargo, la respuesta que hemos obtenido sólo contiene los cuatro primeros e incluye localidades de la provincia de Guadalajara (Gualda), municipios de la provincia de Valladolid (Gallegos de Hornija) o localidades de la provincia de Burgos que no son municipios (Galarde). En este caso, también podemos acudir a conjunto de datos abiertos para obtener la respuesta correcta.

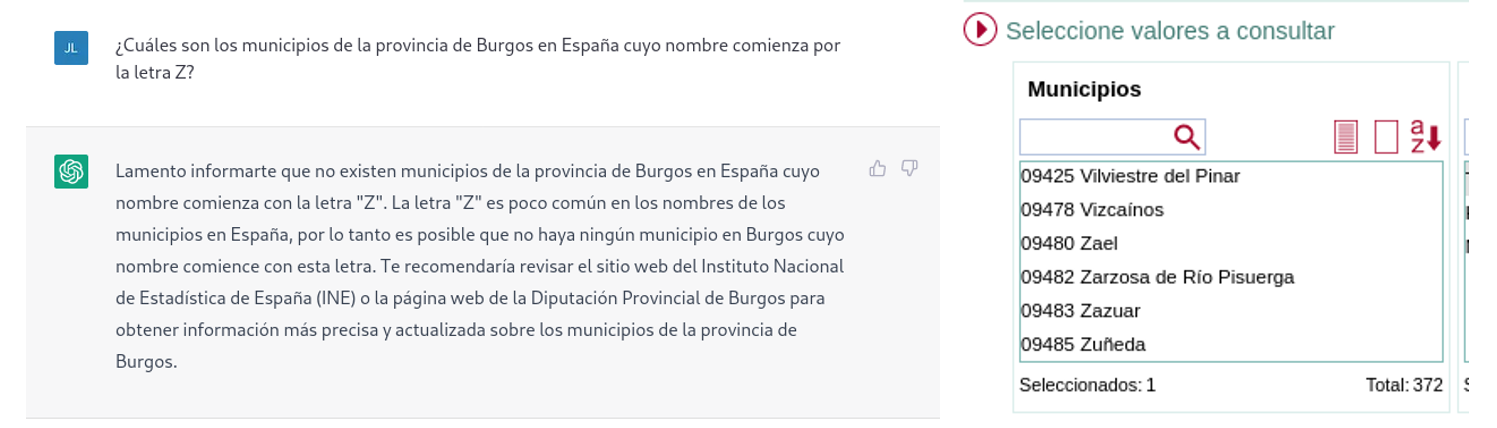

A continuación, le preguntamos a ChatGPT por la lista de municipios que comienzan por la letra Z en la misma provincia. ChatGPT nos dice que nos hay ninguno, razonando la respuesta, cuando en realidad hay cuatro:

Como se deduce de los ejemplos anteriores, vemos cómo los datos abiertos sí pueden contribuir a la evolución tecnológica y, por ende, a mejorar el funcionamiento de la inteligencia artificial de Open AI. Sin embargo, dado el estado de madurez actual de la misma, aún es pronto para ver un empleo óptimo de estos, a la hora de dar respuesta a preguntas más complejas.

Por lo tanto, para que un modelo de inteligencia artificial generativa sea eficaz, es necesario que cuente con una gran cantidad de datos de alta calidad y diversidad, y los datos abiertos son una fuente de conocimiento valiosa para este fin.

Probablemente, en futuras versiones del modelo, podamos ver cómo los datos abiertos ya adquieren un peso mucho más importante en la composición del corpus de entrenamiento, logrando conseguir una mejora importante en la calidad de las respuestas de tipo factual.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

HelpVoice! es un servicio diseñado para ayudar a las personas mayoresque hayan podido sufrir algún percance,utilizando técnicas de reconocimiento de voz basadas en aprendizaje automático. Este prototipo se hizo con el primer premio del IV Desafío Aporta, centrado en el valor del dato para la salud y el bienestar de los ciudadanos.Hemos hablado con sus creadores, Sandra García, Antonio Ríos y Alberto Berenguer, integrantes del equipo Data Express para que nos cuenten cómo fue su experiencia.

Entrevista completa

1. ¿Cómo funciona HelpVoice!?

HelpVoice! es una aplicación multisistema. Por lo general, todo gira alrededor de una emergencia (referida como alerta dentro de la terminología de nuestra aplicación). Según el rol que tenga un usuario dentro de una alerta, utilizará un sistema en concreto. En primer lugar, los pacientes dispondrán de una aplicación instalada en un dispositivo con recogida de voz, por ejemplo, un dispositivo móvil, uno de domótica o incluso uno IoT.Cuando el usuario graba una alerta, esta se envía a nuestros servidores que transcribirán el mensaje a texto y detectarán las palabras clave que contiene el mensaje para determinar tanto qué padece como qué grado de emergencia requiere la urgencia. Una vez obtenida esta información, el servidor busca a los hospitales más cercanos que estén capacitados para atender dicha alerta. Los hospitales, a su vez, dispondrán de una aplicación de escritorio que les permitirá gestionar las alertas, mediante una interfaz que les muestra toda la información recabada del mensaje enviado por el paciente.Los hospitales, mediante este programa, responderán a las alertas y determinarán el procedimiento de acción que se debe tomar. Todas las respuestas de los hospitales se notificarán tanto al paciente como a sus familiares, quienes también estarán registrados en la aplicación. Finalmente, los familiares disponen de una aplicación móvil que les permite realizar un seguimiento en tiempo real tanto de la alerta enviada por el paciente como de la respuesta que ha dado el hospital.

2. ¿Qué mejoras aporta su proyecto, basado en datos abiertos, al sector de la salud y el bienestar?

Una de las razones por las que surgió HelpVoice! fue el colapso telefónico que sufrió España durante la pandemia de la COVID-19, donde el contacto telefónico con los centros de salud era prácticamente imposible. Por otro lado, tuvimos tambiénen cuentalas denuncias del colectivo de personas mayores acerca de la brecha digital que hay hoy en día.Por lo tanto, HelpVoice! trata de ser una herramienta que mejora un servicio elemental, la atención de primer triaje hospitalario,y esto lo consiguemediante tecnologías potentes basadas en datos e inteligencia artificial la cual, a su vez, resulta accesible tanto para los usuarios como a los hospitales, los cuales necesitan tomar decisiones rápidas y precisas a la hora de atender emergencias.

3. ¿Cómo fue el proceso de desarrollo del prototipo? ¿Qué retos se encontraron y cómo los solucionaron?

El desarrollo de HelpVoice ha sido todo un desafío.En primer lugar, tuvimos dificultades para desarrollarnuestros sistemas de detección de palabras clave y predicción de enfermedades, ya que actualmente no existen bases de datos públicas en español que contemplen este tipo de problemas (finalmente, recurrimos a recursos en inglés).Por otro lado, la programación de la aplicación fue en sí un proceso complicado, ya que realizamos muchas iteraciones y tuvimos que aprender nuevas tecnologías que nos permitiesen llegar a ese prototipo que presentamos. Por ejemplo, realizamos tres versiones de la arquitectura de comunicación de las alertas y fue la primera vez que creamos softwareorientado a escritorio.A todo esto, se suma que uno de nuestros compañeros, Antonio, estaba viviendo en Canadá durante el desarrollo del prototipo, por lo que la diferencia horaria entre países supuso un obstáculo importante a la hora de establecer reuniones para coordinarse y evaluar los avances desarrollados.Sin embargo, aunque el camino fuese complicado, también ha sido una oportunidad única para aprender en todos los sentidos.

4. ¿Cómo ha sido su experiencia en el Desafío Aporta?¿Qué recomendaría a aquellas personas que estén pensando en participar en la próxima edición?

En general ha sido una experiencia muy enriquecedora; desde el principio, donde nos reunimos para idear una solución que se ajustase a los requisitos del desafío y aportase valor, hasta el final, donde tuvimos que desarrollar las ideas que habíamos planteado en la primera fase, haciendo frente a la cantidad de problemas que nos surgieron.A las personas que estén pensando en apuntarse, les recomendaríamos que no duden en apuntarse, porque es una oportunidad única para aprender.Dentro de los aspectos más técnicos del desafío recomendamos que el equipo sea lo más variado posible, con personal que aporte conocimiento experto, lo cual suma mucho valor a la propuesta.Finalmente, recomendamos también reflexionar y explorar sobre el tema propuesto para el desafío. Son propuestas muy abiertas donde muchas soluciones de gran utilidad pueden aparecer si se itera sobre ellas. No quedaros nunca con la primera idea que surja.

5. ¿Cuáles son sus próximos pasos? ¿Tienen pensado continuar trabajando en HelpVoice! u otros proyectos relacionados con los datos abiertos?

En primer lugar, estamos centrados en acabar nuestras tesis doctorales. Al fin y al cabo, HelpVoice! es una propuesta que hemos planteado como trabajo para explorar, aprender y salirnos de nuestra rutina académica. Hemos de admitir que este premio ha sido toda una sorpresa para nosotros. No nos habíamos planteado mucho el futuro del trabajo más allá de participar en el concurso. Sin embargo, con la aceptación que ha tenido, estamos planteándonos concretar el desarrollo del prototipo presentado y proponer una aplicación final que pueda brindar los servicios de HelpVoice! a la sociedad, al igual que también trataremos de buscar vías de financiación para que el desarrollo de ésta sea viable. Lo que sí tenemos claro, es que HelpVoice! no acaba aquí. ¡Veremos qué nos depara el futuro!