En los últimos quince años hemos visto cómo las administraciones públicas han pasado de publicar sus primeros conjuntos de datos abiertos a trabajar con conceptos mucho más complejos. Interoperabilidad, estándares, espacios de datos o soberanía digital son algunos de los conceptos de moda. Y, en paralelo, también ha cambiado la web. Aquel espacio abierto, descentralizado e interoperable que inspiró las primeras iniciativas de datos abiertos, ha evolucionado hacia un ecosistema mucho más complejo, donde conviven tecnologías, nuevos estándares y al mismo tiempo desafíos importantes como silos de información hasta ética digital y concentración tecnológica.

Para hablar de todo ello, hoy tenemos la suerte de contar con dos voces que no solo han observado esta evolución, sino que han sido protagonistas directos de ella a nivel internacional:

- Josema Alonso, con más de veinticinco años de experiencia trabajando en la web abierta, los datos y los derechos digitales, ha trabajado en la World Wide Web Foundation, en Open Government Partnership y el Foro Económico Mundial, entre otros.

- Carlos Iglesias, experto en estándares web, open data y gobierno abierto, ha asesorado a administraciones de todo el mundo en más de veinte proyectos. Ha participado activamente en comunidades como W3C, la Web Foundation o la Open Knowledge Foundation.

Resumen / Transcripción de la entrevista

1. ¿En qué momento creéis que estamos ahora y qué ha cambiado respecto a aquella primera etapa del open data?

Carlos Iglesias: Bueno, yo creo que lo que ha cambiado es que entendemos que hoy en día ese grito de guerra inicial de “queremos los datos ya” no es suficiente. Era una primera fase que en su día fue muy útil y necesaria porque había que romper con esa tendencia de tener los datos encerrados, no compartir los datos. Digamos que la urgencia en aquel momento era simplemente cambiar el paradigma y por eso el grito de guerra era el que era. He estado implicado, como Josema, en estudiar y analizar todos esos portales de datos abiertos e iniciativas que surgieron a partir de este movimiento. Y he visto que muchos de ellos empezaron a crecer sin ningún tipo de estrategia. De hecho, varios se quedaban por el camino o no tenían una visión clara de lo que querían hacer. La simple práctica yo creo que llegó a la conclusión de que la publicación de datos por sí misma no era suficiente. Y a partir de ahí yo creo que se han ido planteando, un poco con la madurez del movimiento, que hay que hacer más cosas, y hoy en día hablamos más de la gobernanza de los datos, de abrir datos con un propósito específico, de la importancia de los metadatos, los modelos. O sea, ya no es simplemente tener datos por tenerlos, sino que hay una visión más del dato como uno de los elementos más valiosos en la actualidad, probablemente, y también como una infraestructura necesaria para que funcionen muchas cosas hoy en día. Igual que en su día fueron claves infraestructuras como las redes de carreteras o de transporte público o la energía. Ahora mismo estamos en el momento de la gran eclosión de la inteligencia artificial. Convergen una serie de cuestiones que han hecho que esto haya eclosionado y el cambio es inmenso, a pesar de que estamos hablando solo de quizás poco más de diez o quince años desde ese primer movimiento de “queremos los datos ya”. Yo creo que ahora mismo el panorama es completamente distinto.

Josema Alonso: Sí que es cierto que teníamos aquella idea de “tú publica que alguien vendrá y hará algo con ello”. Y aquello lo que hizo es que se empezara a concienciar a la gente. Pero yo, personalmente, de aquella no me hubiera podido imaginar que muy pocos años después hubiéramos tenido incluso una directiva a nivel europeo de publicación de datos abiertos. Fue algo, la verdad, que recibimos con mucho agrado. Y que luego se empezara a implementar en todos los Estados miembros. Aquello movió un poco conciencias y movió prácticas, sobre todo dentro de la administración. Había mucho miedo de “a ver si pongo algo allí que sea problemático, que sea de mala calidad, que me critiquen por ello”, etc. Pero empezó a generar una cultura del dato y de la utilidad del dato muy importante. Y como también comentó Carlos en los últimos años, yo creo que ya nadie duda de esto. Las inversiones que se están realizando, por ejemplo, a nivel europeo y de Estados miembros, incluido en nuestro país, en España, en el fomento y desarrollo de los espacios de datos, son de cientos de millones de euros. Ya nadie tiene ese tipo de dudas y ahora está más el foco en cómo hacerlo bien, en cómo conseguir que todos interoperen. Esto es, que cuando se crea un espacio de datos europeos de un sector concreto, como puede ser agricultura o salud, todos los países y organizaciones puedan compartir datos de la mejor manera posible, de forma que se puedan intercambiar mediante modelos comunes y que se hagan dentro de entornos de confianza.

2. En este contexto, ¿por qué los estándares se han vuelto tan esenciales?

Josema Alonso: Yo creo que es por todo lo que hemos aprendido a lo largo de estos años. Hemos aprendido que es necesario que la gente pueda tener una cierta libertad a la hora de desarrollar sus propios sistemas. La propia arquitectura de la web, por ejemplo, así funciona, no tiene un control central ni nada, sino que cada participante dentro de la web gestiona las cosas a su manera. Pero existen unas reglas claras de cómo esas cosas luego tienen que interactuar unas con otras, Si no, no funcionaría, sino no seríamos capaces de cargar una página web en diferentes navegadores o en diferentes teléfonos móviles. Entonces, lo que estamos viendo últimamente es que se intenta cada vez más averiguar cómo llegar a ese tipo de consensos en un beneficio mutuo. Por ejemplo, parte de mi trabajo actual para la Comisión Europea es en la Comunidad de Interoperabilidad Semántica, donde gestionamos la creación de modelos uniformes que se utilizan en toda Europa, definiciones de vocabularios estándar básicos que se utilizan en todos los sistemas. En estos últimos años también se ha instrumentalizado de una manera que apoya, digamos, ese consenso mediante regulaciones que se han ido emitiendo, por ejemplo, a nivel europeo. Estos últimos años hemos visto la regulación de datos, la regulación de la gobernanza de datos y la de inteligencia artificial, cosas que intentan también poner un cierto orden y unas barreras. No es que todo el mundo vaya por medio del monte, porque si no, al final no llegamos a ningún lado, sino vamos a intentar todos hacerlo por consenso, pero vamos a intentar todos conducir dentro de la misma carretera para llegar al mismo destino de forma conjunta. Y creo que, desde la parte de las administraciones públicas, aparte de regular, es muy interesante que sean muy transparentes en la forma que se hace. Es la manera en la que todos podemos llegar a ver que lo que se construye está construido de una determinada manera, los modelos de datos que son transparentes, todo el mundo los puede ver participar en su desarrollo. Y aquí es donde estamos viendo algunas carencias de los sistemas de algoritmia y de inteligencia artificial, donde no sabemos muy bien los datos que utilizan ni donde se alojan. Y aquí es donde a lo mejor tendríamos que incidir un poquito más en el futuro. Pero creo que mientras se consiga esta dualidad, de generar el consenso y ofrecer un contexto en el que la gente se sienta segura desarrollándolo, seguiremos avanzando en la línea adecuada.

Carlos Iglesias: Si nos fijamos en los principios que hicieron que la web funcionara en su día, hay mucho enfoque también en la parte de comunidad y de dejar una plataforma abierta que se desarrolla en abierto, con unos estándares abiertos en el que todo el mundo podía unirse. Se buscaba un poco la participación de todo el mundo para enriquecer ese ecosistema. Y yo creo que con los datos deberíamos pensar que ese es el camino a recorrer. De hecho, más o menos es un poco también el concepto que creo que hay detrás de los espacios de datos. Al final no es fácil hacer algo así. Es muy ambicioso y no vemos un invento como la web todos los días.

3. Desde vuestra perspectiva, ¿qué riesgos existen realmente de que los datos queden atrapados en infraestructuras o modelos opacos? Y lo que es más importante, ¿qué podemos hacer para evitarlo?

Carlos Iglesias: Hace años veíamos que se intentaba cuantificar la cantidad de datos que se generaban diariamente. Yo creo que ahora ya nadie lo intenta siquiera, porque está a otra escala completamente, y ya en esa escala solo hay una forma de trabajar, que es automatizando las cosas. Y cuando hablamos de automatización, al final lo que necesitas son estándares, interoperabilidad, mecanismos de confianza, etc. Si miramos diez o quince años atrás, cuáles eran las compañías que tenían mayor cotización a nivel mundial, eran compañías como Ford o General Electric. Si te miras el top diez a nivel mundial hoy en día hay compañías que todos conocemos y usamos cada día como Meta, que es la matriz de Facebook, Instagram, WhatsApp y otros, o Alphabet que es la matriz de Google. O sea, de hecho, yo creo que ahora mismo dudo un poco, pero probablemente de las diez mayores cotizadas del mundo, todas se dedican a los datos. Estamos hablando de un ecosistema gigantesco y, para que esto funcione de verdad y siga siendo un ecosistema abierto del que todo el mundo se pueda beneficiar, la clave es la estandarización.

Josema Alonso: Yo estoy de acuerdo con todo lo que dijo Carlos y tenemos que poner el foco en que no quedemos atrapados. Y sobre todo desde las administraciones públicas hay un papel esencial que jugar. Yo comentaba antes la regulación, que a veces a la gente no le gusta mucho porque el mapa regulatorio empieza a ser extremadamente complicado. La Comisión Europea, a través de un decreto ómnibus, está intentando aliviar esa complejidad regulatoria y, como ejemplo, en la propia regulación de datos, que obliga a las empresas que tienen datos a facilitar la portabilidad de datos a sus usuarios. A mí me parece que es algo esencial. Vamos a ver muchos cambios en eso. Hay tres cosas que siempre me vienen a la cabeza; se necesita capacitación permanente. Esto cambia cada día a una velocidad sorprendente. Los volúmenes de datos que se gestionan ahora son descomunales. Como decía Carlos antes, hace unos días estuve hablando con una persona que dirige la infraestructura de una de las más grandes plataformas de streaming a nivel global y me decía que están recibiendo peticiones de datos generados por inteligencia artificial en un volumen tan grande en tan solo una semana como todo el catálogo que tienen disponible. Entonces la administración necesita tener una capacitación permanente en estos temas de todo tipo, tanto de la puntera tecnológica como acabamos de comentar, como de lo que hablábamos antes, de cómo mejorar la interoperabilidad, cómo crear mejores modelos de datos, etc. Otra es la infraestructura común en Europa, como la futura cartera digital europea, lo que sería el equivalente a la carpeta ciudadana nacional. Un ejemplo súper simple con el que tratamos es el certificado de nacimiento. Es muy complicado intentar integrar los sistemas de veintisiete países diferentes, que a su vez tienen gobiernos regionales y que a su vez tienen gobiernos locales. Entonces, cuanto más invirtamos en infraestructura común, tanto a nivel de semántico como a nivel de los de la propia infraestructura, de la nube, etcétera, yo creo que nos va a ir mejor. Y luego la última, que es la necesidad de gobernanza distribuida pero coordinada. Cada uno se rige por unas determinadas leyes a nivel local, nacional o europeo. Es bueno que empecemos a tener cada vez más coordinación en las capas más altas y que esas capas más altas vayan permeando hacia las capas más bajas y los sistemas sean cada vez más fáciles de integrar y que se entiendan unos con otros. Los espacios de datos es una de las grandes inversiones a nivel europeo, donde creo que esto se está empezando a lograr. Entonces, por resumir tres cosas así muy prácticas de hacer: capacitación permanente, invertir en infraestructura común y que la gobernanza siga siendo distribuida, pero cada vez más coordinada.

En la encrucijada del siglo XXI, las ciudades se enfrentan a desafíos de enorme magnitud. El crecimiento explosivo de la población, la urbanización acelerada y la presión sobre los recursos naturales están generando una demanda sin precedentes para encontrar soluciones innovadoras que permitan construir y gestionar entornos urbanos más eficientes, sostenibles y habitables.

A estos retos se suma el impacto del cambio climático en las ciudades. A medida que el mundo experimenta alteraciones en los patrones climáticos, las ciudades deben adaptarse y transformarse para garantizar la sostenibilidad y la resiliencia a largo plazo.

Una de las manifestaciones más directas del cambio climático en el entorno urbano es el aumento de las temperaturas. El efecto isla de calor urbana, agravado por la concentración de edificaciones y superficies asfaltadas que absorben y retienen el calor, se ve intensificado por el incremento global de la temperatura. Esto no solo afecta a la calidad de vida al aumentar los costes de refrigeración y la demanda energética, sino que también puede provocar graves problemas de salud pública, como golpes de calor y la agravación de enfermedades respiratorias y cardiovasculares.

El cambio en los patrones de precipitación es otro de los efectos críticos del cambio climático que afectan a las ciudades. Los episodios de lluvias intensas y las tormentas más frecuentes y severas pueden dar lugar a inundaciones urbanas, especialmente en zonas con infraestructuras de drenaje insuficientes u obsoletas. Esta situación ocasiona importantes daños estructurales, y también interrumpe la vida cotidiana, afecta a la economía local y aumenta los riesgos para la salud pública debido a la propagación de enfermedades transmitidas por el agua.

Ante estos desafíos, la planificación y el diseño urbano deben evolucionar. Las ciudades están adoptando estrategias de urbanismo sostenible que incluyen la creación de infraestructuras verdes, como parques y cubiertas vegetales, capaces de mitigar el efecto isla de calor y mejorar la absorción del agua durante episodios de lluvias intensas. Asimismo, la integración de sistemas de transporte público eficientes y la promoción de la movilidad no motorizada resultan esenciales para reducir las emisiones de carbono.

Los retos descritos también influyen en la normativa edificatoria y en los códigos de construcción. Los nuevos edificios deben cumplir estándares más exigentes de eficiencia energética, resistencia a condiciones meteorológicas extremas y reducción del impacto ambiental. Esto implica el uso de materiales sostenibles y técnicas constructivas que no solo disminuyan las emisiones de gases de efecto invernadero, sino que también ofrezcan seguridad y durabilidad frente a eventos climáticos extremos.

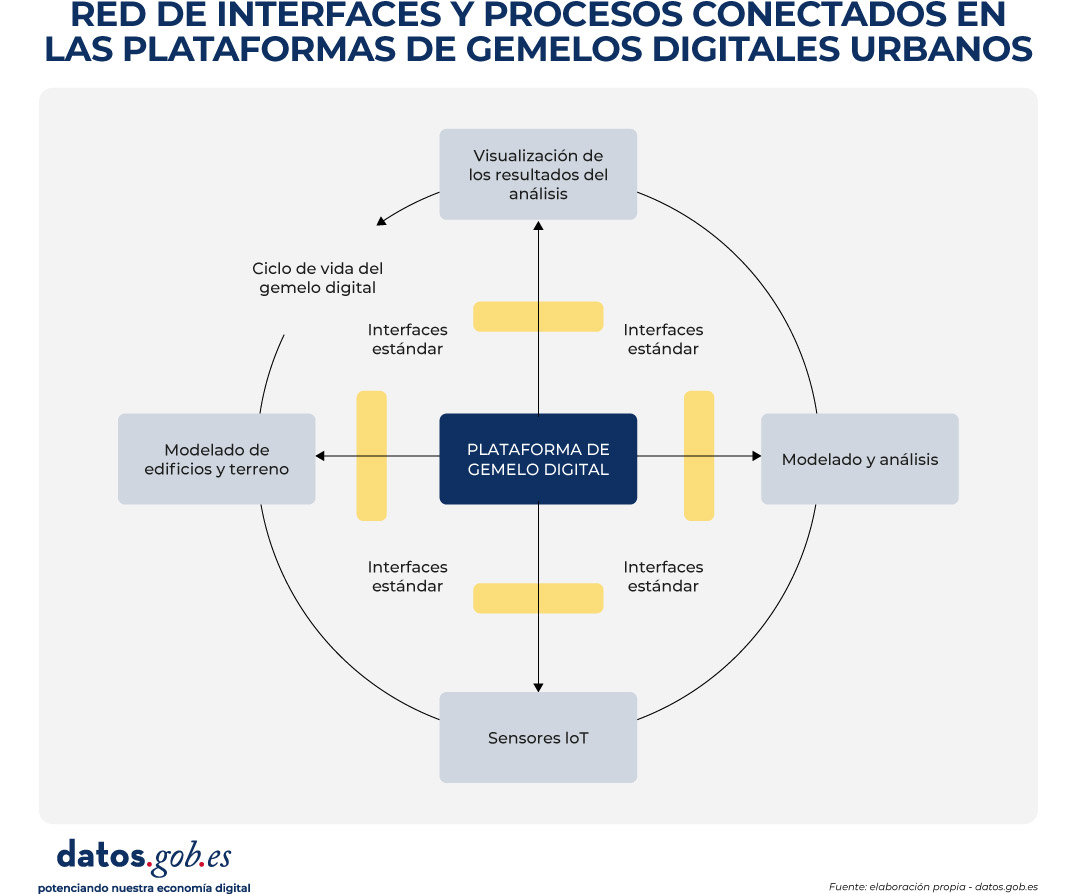

En este contexto, los gemelos digitales urbanos se han consolidado como una de las herramientas clave para apoyar la planificación, la gestión y la toma de decisiones en las ciudades. Su potencial es amplio y transversal: desde la simulación de escenarios de crecimiento urbano hasta el análisis de riesgos climáticos, la evaluación de impactos normativos o la optimización de servicios públicos. Sin embargo, más allá del discurso tecnológico y de las visualizaciones en 3D, la viabilidad real de un gemelo digital urbano depende de una cuestión fundamental de gobierno de datos: la disponibilidad, calidad y uso coherente de datos abiertos estandarizados.

¿Qué entendemos por gemelo digital urbano?

Un gemelo digital urbano no es simplemente un modelo tridimensional de la ciudad ni una plataforma de visualización avanzada. Se trata de una representación digital estructurada y dinámica del entorno urbano, que integra:

-

La geometría y semántica de la ciudad (edificios, infraestructuras, parcelas, espacios públicos).

-

Datos geoespaciales de referencia (catastro, planeamiento, redes, medio ambiente).

-

Información temporal y contextual, que permite analizar la evolución del territorio y simular escenarios.

-

En determinados casos, flujos de datos actualizables procedentes de sensores, sistemas de información municipales u otras fuentes operacionales.

Desde una perspectiva de estándares, un gemelo digital urbano puede entenderse como un ecosistema de datos y servicios interoperables, donde distintos modelos, escalas y dominios (urbanismo, edificación, movilidad, medio ambiente, energía) se conectan de forma coherente. Su valor no reside tanto en la tecnología concreta empleada como en su capacidad para alinear datos heterogéneos bajo modelos comunes, reutilizables y gobernables.

Además, la integración de datos en tiempo real en los gemelos digitales permite una gestión más eficiente de la ciudad en situaciones de emergencia. Desde la gestión de desastres naturales hasta la coordinación de eventos masivos, los gemelos digitales proporcionan a los responsables de la toma de decisiones una visión en tiempo real de la situación urbana, lo que facilita una respuesta rápida y coordinada.

Con el fin de contextualizar el papel de los estándares y facilitar la comprensión del funcionamiento interno de un gemelo digital urbano, la Figura 1 presenta un diagrama conceptual de la red de interfaces, modelos de datos y procesos que lo sustentan. El esquema ilustra cómo diferentes fuentes de información urbana —datos geoespaciales de referencia, modelos 3D de ciudad, información normativa y, en determinados casos, flujos dinámicos— se integran mediante estructuras de datos estandarizadas y servicios interoperables.

Figura 1. Diagrama conceptual de la red de interfaces y procesos conectados en las plataformas de gemelos digitales urbanos. Fuente: elaboración propia – datos.gob.es.

En estos entornos, CityGML y CityJSON actúan como modelos de información urbana que permiten describir digitalmente la ciudad de forma estructurada y comprensible. En la práctica, funcionan como “lenguajes comunes” para representar edificios, infraestructuras y espacios públicos, no solo desde el punto de vista de su forma (geometría), sino también de su significado (por ejemplo, si un objeto es un edificio residencial, una vía pública o una zona verde). Gracias a ello, estos modelos constituyen la base sobre la que se apoyan los análisis urbanos y la simulación de distintos escenarios.

Para que estos modelos tridimensionales puedan visualizarse de manera ágil en navegadores web y aplicaciones digitales, especialmente cuando se trata de grandes volúmenes de información, se puede incorporar 3D Tiles. Este estándar permite dividir los modelos urbanos en fragmentos manejables, facilitando su carga progresiva y su exploración interactiva, incluso en dispositivos con capacidades limitadas.

El acceso, intercambio y reutilización de toda esta información habitualmente se articula a través de OGC APIs, que pueden entenderse como interfaces normalizadas que permiten a distintas aplicaciones consultar y combinar datos urbanos de forma consistente. Estas interfaces hacen posible, por ejemplo, que una plataforma de planificación urbana, una herramienta de análisis climático o un visor ciudadano accedan a los mismos datos sin necesidad de duplicarlos ni transformarlos de manera específica.

De este modo, el diagrama refleja el flujo de datos desde las fuentes originales hasta las aplicaciones finales, mostrando cómo el uso de estándares abiertos permite separar claramente los datos, los servicios y los casos de uso. Esta separación resulta clave para garantizar la interoperabilidad entre sistemas, la escalabilidad de las soluciones digitales y la sostenibilidad del gemelo digital urbano a lo largo del tiempo, aspectos que se abordan de forma transversal en el resto del documento.

Figura 2. Vista General. Imagen de la UTE Fuses Viader + Perea + Mansilla + Desvigne.

Un ejemplo del impacto de los gemelos digitales urbanos en la construcción y gestión urbana puede encontrarse en el proyecto de regeneración urbana de la Plaza de las Glòries Catalanes, en Barcelona (España). Este proyecto tenía como objetivo transformar una de las zonas urbanas más emblemáticas de la ciudad en un espacio público más accesible, verde y sostenible.

Mediante el uso de gemelos digitales desde las fases iniciales del proyecto, los equipos de diseño y planificación pudieron crear modelos digitales detallados que representaban no solo la geometría de los edificios e infraestructuras existentes, sino también las complejas interacciones entre los distintos elementos urbanos, como el tráfico, el transporte público y las áreas peatonales.

Estos modelos no solo facilitaron la visualización y la comunicación del diseño propuesto entre todas las partes interesadas, sino que también permitieron simular distintos escenarios y evaluar su impacto en la movilidad, la calidad del aire y la accesibilidad peatonal. Como resultado, se pudieron tomar decisiones más informadas, contribuyendo de manera decisiva al éxito global de la iniciativa de regeneración urbana.

El papel crítico de los datos abiertos en los gemelos digitales urbanos

En el contexto de los gemelos digitales urbanos, los datos abiertos no deben entenderse como un complemento opcional ni como una acción puntual de transparencia, sino como la base estructural sobre la que se construyen sistemas urbanos digitales sostenibles, interoperables y reutilizables en el tiempo. Un gemelo digital urbano solo puede cumplir su función como herramienta de planificación, análisis y apoyo a la toma de decisiones si los datos que lo alimentan están disponibles, bien definidos y gobernados conforme a principios comunes.

Cuando un gemelo digital se desarrolla sin una estrategia clara de datos abiertos, tiende a convertirse en un sistema cerrado y dependiente de soluciones tecnológicas o proveedores concretos. En estos escenarios, la actualización de la información resulta costosa y compleja, la reutilización en nuevos contextos es limitada y el gemelo pierde rápidamente su valor estratégico, quedando obsoleto frente a la evolución real de la ciudad que pretende representar. Esta falta de apertura dificulta además la integración con otros sistemas y reduce la capacidad de adaptación a nuevas necesidades normativas, sociales o ambientales.

Uno de los principales aportes de los gemelos digitales urbanos es su capacidad para fundamentar las decisiones públicas en datos trazables y verificables. Cuando se apoyan en datos abiertos accesibles y comprensibles, estos sistemas permiten entender no solo el resultado de una decisión, sino también los datos, modelos y supuestos que la sustentan, integrando información geoespacial, modelos urbanos, normativa y, en determinados casos, datos dinámicos. Esta trazabilidad resulta clave para la rendición de cuentas, la evaluación de políticas públicas y la generación de confianza tanto a nivel institucional como ciudadano. Por el contrario, en ausencia de datos abiertos, los análisis y simulaciones que respaldan las decisiones urbanas se vuelven opacos, dificultando explicar cómo y por qué se ha llegado a una determinada conclusión y debilitando la confianza en el uso de tecnologías avanzadas para la gestión urbana.

Los gemelos digitales urbanos requieren, además, la colaboración de múltiples actores —administraciones, empresas, universidades y ciudadanía— y la integración de datos procedentes de distintos niveles administrativos y dominios sectoriales. Sin un enfoque basado en datos abiertos estandarizados, esta colaboración se ve obstaculizada por barreras técnicas y organizativas: cada actor tiende a utilizar formatos, modelos e interfaces diferentes, lo que incrementa los costes de integración y frena la creación de ecosistemas de reutilización en torno al gemelo digital.

Otro riesgo significativo asociado a la ausencia de datos abiertos es el incremento de la dependencia tecnológica y la consolidación de silos de información. Los gemelos digitales construidos sobre datos no estandarizados o de acceso restringido suelen quedar ligados a soluciones propietarias, dificultando su evolución, migración o integración con otros sistemas. Desde la perspectiva del gobierno del dato, esta situación compromete la soberanía de la información urbana y limita la capacidad de las administraciones para mantener el control sobre activos digitales estratégicos.

Por el contrario, cuando los datos urbanos se publican como datos abiertos estandarizados, el gemelo digital puede evolucionar como una infraestructura pública de datos, compartida, reutilizable y extensible en el tiempo. Esto implica no solo que los datos estén disponibles para su consulta o visualización, sino que sigan modelos de información comunes, con semántica explícita, geometría coherente y mecanismos de acceso bien definidos que faciliten su integración en distintos sistemas y aplicaciones.

Este enfoque permite que el gemelo digital urbano actúe como una base de datos común sobre la que puedan construirse múltiples casos de uso —planificación urbana, gestión de licencias, evaluación ambiental, análisis de riesgos climáticos, movilidad o participación ciudadana— sin duplicar esfuerzos ni generar inconsistencias. La reutilización sistemática de la información no solo optimiza recursos, sino que garantiza coherencia entre las distintas políticas públicas que inciden sobre el territorio.

Desde una perspectiva estratégica, los gemelos digitales urbanos basados en datos abiertos estandarizados permiten además alinear las políticas locales con los principios europeos de interoperabilidad, reutilización y soberanía del dato. El uso de estándares abiertos y modelos de información comunes facilita la integración de los gemelos digitales en iniciativas más amplias, como los espacios de datos sectoriales o las estrategias de digitalización y sostenibilidad promovidas a nivel europeo. De este modo, las ciudades no desarrollan soluciones aisladas, sino infraestructuras digitales coherentes con marcos normativos y estratégicos superiores, reforzando el papel del gemelo digital como herramienta transversal, transparente y sostenible para la gestión urbana.

Figura 3. Estrategias para implementar gemelos digitales urbanos. Fuente: elaboración propia– datos.gob.es.

Conclusión

Los gemelos digitales urbanos representan una oportunidad estratégica para transformar la forma en que las ciudades planifican, gestionan y toman decisiones sobre su territorio. Sin embargo, su verdadero valor no reside en la sofisticación tecnológica de las plataformas ni en la calidad de las visualizaciones, sino en la solidez del enfoque de datos sobre el que se construyen.

Los gemelos digitales urbanos solo pueden consolidarse como herramientas útiles y sostenibles cuando se apoyan en datos abiertos estandarizados, bien gobernados y concebidos desde su origen para la interoperabilidad y la reutilización. En ausencia de estos principios, los gemelos digitales corren el riesgo de convertirse en soluciones cerradas, difíciles de mantener, escasamente reutilizables y desconectadas de los procesos reales de gobernanza urbana.

El uso de modelos de información comunes, estándares abiertos y mecanismos de acceso interoperables permite que el gemelo digital evolucione como una infraestructura pública de datos, capaz de servir a múltiples políticas públicas y de adaptarse a los cambios sociales, ambientales y normativos que afectan a la ciudad. Esta aproximación refuerza la transparencia, mejora la coordinación institucional y facilita la toma de decisiones basadas en evidencias verificables.

En definitiva, apostar por gemelos digitales urbanos basados en datos abiertos estandarizados no es únicamente una decisión técnica, sino una decisión de política pública en materia de gobierno del dato. Es esta visión la que permitirá que los gemelos digitales contribuyan de forma efectiva a afrontar los grandes retos urbanos y a generar un valor público duradero para la ciudadanía.

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autora

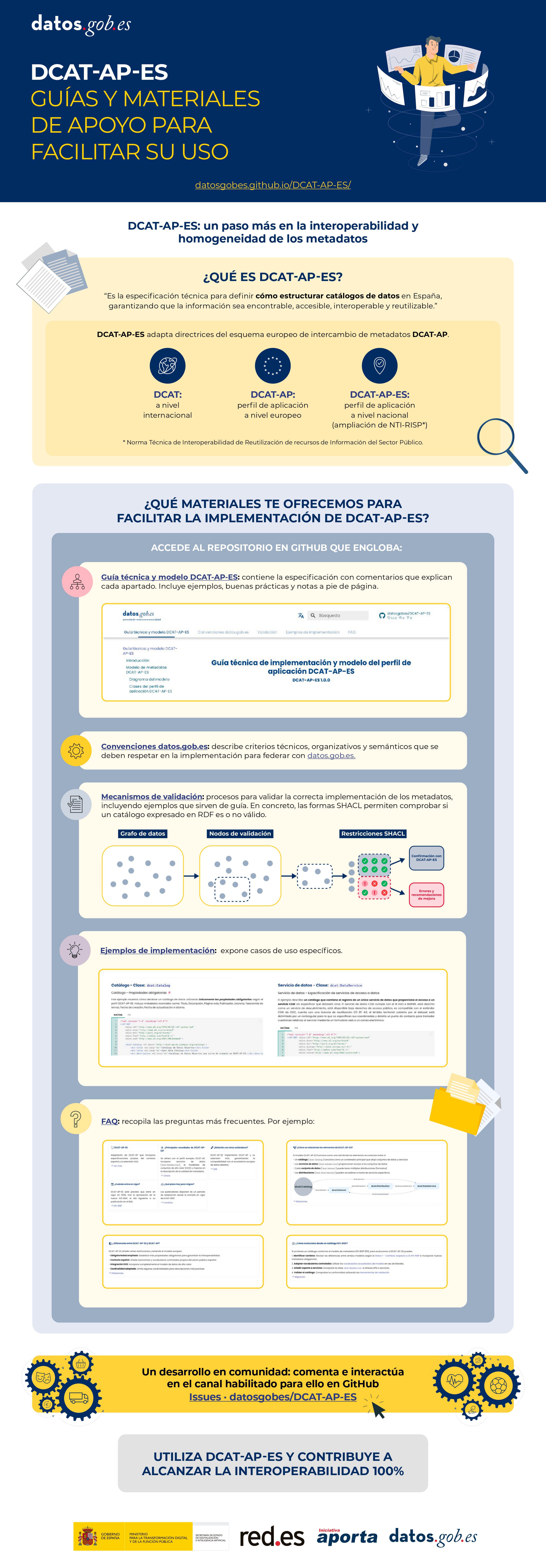

La futura nueva versión de la Norma Técnica de Interoperabilidad de Recursos de Información del Sector Público (NTI-RISP) incorpora DCAT-AP-ES como modelo de referencia para la descripción de conjuntos y servicios de datos. Esto supone un paso clave hacia una mayor interoperabilidad, calidad y alineación con los estándares europeos de datos.

Esta guía tiene como objetivo ayudar en su migración hacia este nuevo modelo. Está dirigida a responsables técnicos y gestores de catálogos de datos públicos que, sin disponer de experiencia avanzada en semántica o modelos de metadatos, necesitan actualizar su catálogo RDF para garantizar su conformidad con DCAT-AP-ES. Además, las pautas del documento también son aplicables para la migración desde otros modelos de metadatos basados en RDF, como perfiles locales, DCAT, DCAT-AP o adaptaciones sectoriales, ya que los principios y verificaciones fundamentales son comunes.

¿Por qué migrar a DCAT-AP-ES?

La Norma Técnica de Interoperabilidad de Recursos de Información del Sector Público constituye, desde 2013, el marco regulador en España para la gestión y apertura de los datos públicos. Alineada con el objetivo europeo y español de impulsar la economía del dato, la norma se ha actualizado con el fin de favorecer el intercambio de información a gran escala en entornos distribuidos y federados.

Esta actualización, que en el momento de publicación de la guía está en proceso de tramitación administrativa, incorpora un nuevo modelo de metadatos alineado con los estándares europeos más recientes: DCAT-AP-ES. Estos estándares facilitan la descripción homogénea de los conjuntos de datos y recursos de información reutilizables puestos a disposición pública. DCAT-AP-ES adopta las directrices del esquema europeo de intercambio de metadatos DCAT-AP (Data Catalog Vocabulary – Aplication Profile), promoviendo así la interoperabilidad entre catálogos nacionales y europeos.

Las ventajas de adoptar DCAT-AP-ES se resumen en:

- Interoperabilidad semántica y técnica: asegura que distintos catálogos puedan entenderse entre sí de forma automática.

- Alineación normativa: responde a los nuevos requisitos previstos en la NTI-RISP y alinea el catálogo con la Directiva (UE) 2019/1024 relativa a los datos abiertos y la reutilización de la información del sector público y el Reglamento de Ejecución (UE) 2023/138 por el que se establecen una lista de conjuntos de datos específicos de alto valor (High Value Dataset o HVD), facilitando la publicación de HVD y servicios de datos asociados.

- Mejora de la capacidad de encontrar los recursos: facilita la búsqueda, localización y reutilización de los conjuntos de datos mediante metadatos estandarizados y completos.

- Reducción de incidencias en la federación: minimiza errores y conflictos al integrar catálogos de distintas administraciones, garantizando la consistencia y la calidad en los procesos de interoperabilidad.

¿Qué ha cambiado en DCAT-AP-ES?

DCAT-AP-ES amplía y ordena el modelo anterior para hacerlo más interoperable, más preciso desde el punto de vista legal y más útil para el mantenimiento y la reutilización técnica de los catálogos de datos.

Los principales cambios son:

- En el catálogo: ahora es posible enlazar catálogos entre sí, registrar quién los creó, añadir una declaración de derechos complementaria a la licencia o describir cada entrada mediante registros.

- En los conjuntos de datos: se incorporan nuevas propiedades para cumplir la normativa sobre conjuntos de alto valor, dar soporte a la comunicación, documentar la procedencia y las relaciones entre recursos, gestionar versiones y describir la resolución espacial/temporal o el sitio web. Asimismo, se redefine la responsabilidad de la licencia, desplazando su declaración al nivel más adecuado.

- En las distribuciones: se amplían las opciones para indicar la disponibilidad planificada, la legislación, política de uso, la integridad, los formatos empaquetados, la URL directa de descarga, la licencia propia y el estado del ciclo de vida.

Un enfoque práctico y gradual

Muchos catálogos ya cumplen los requisitos establecidos en la versión de NTI-RISP de 2013. En estos casos, la migración a DCAT-AP-ES requiere un ajuste reducido, aunque la guía contempla también escenarios más complejos, siguiendo un enfoque progresivo y adaptable.

El documento distingue entre el cumplimiento mínimo indispensable y algunas ampliaciones que mejoran la calidad e interoperabilidad.

Se recomienda seguir una estrategia iterativa: partir del núcleo mínimo para asegurar continuidad operativa y, posteriormente, planificar la incorporación escalonada de elementos adicionales, como servicios de datos, contacto, legislación aplicable, categorización de HVD y metadatos contextuales. Este enfoque reduce riesgos, distribuye el esfuerzo de adaptación y favorece una transición ordenada.

Una vez realizados los primeros ajustes, el catálogo puede federarse tanto con el Catálogo Nacional, albergado en datos.gob.es, como con el Catálogo oficial de datos europeos, incrementado progresivamente la calidad y la interoperabilidad de los metadatos.

La guía constituye un material de apoyo técnico que facilita una transición básica, conforme a los requisitos mínimos de interoperabilidad. Además, complementa otros recursos de referencia, como la Guía técnica de implementación y modelo del perfil de aplicación DCAT-AP-ES, los ejemplos de implementación (Migración desde NIT-RISP a DCAT-AP-ES y Migración desde NTI-RISP a DCAT-AP-ES HVD) y las convenciones complementarias al modelo DCAT-AP-ES que definen reglas adicionales para abordar necesidades prácticas.

Contexto y necesidad de actualización

Los datos son un recurso clave en la transformación digital de las Administraciones Públicas. Asegurar su acceso, interoperabilidad y reutilización es fundamental para mejorar la transparencia, fomentar la innovación y facilitar el desarrollo de servicios públicos eficientes y centrados en la ciudadanía.

En este contexto, la Norma Técnica de Interoperabilidad de Reutilización de Recursos de Información (NTI-RISP) es el marco regulador en España para la gestión y apertura de datos públicos desde 2013. La norma establece condiciones comunes sobre selección, identificación, descripción, formato, condiciones de uso y puesta a disposición de los documentos y recursos de información elaborados o custodiados por el sector público, relativos a numerosos ámbitos de interés como la información social, económica, jurídica, turística, sobre empresas, educación, etc., cumpliendo plenamente con lo establecido en la Ley 37/2007, de 16 de noviembre, sobre reutilización de la información del sector público.

En los últimos meses se viene acometiendo una modernización del texto dentro del objetivo europeo y español de potenciar la economía del dato, impulsando su intercambio a gran escala dentro de entornos distribuidos y federados, garantizando las adecuadas condiciones de ciberseguridad y respetando los principios y valores europeos.

La nueva norma, en fase de tramitación, refiere un nuevo modelo de metadatos alineado con las últimas versiones de los estándares europeos, que facilitan la descripción de los conjuntos de datos y recursos de información reutilizables puestos a disposición pública.

Este nuevo modelo de metadatos, denominado DCAT-AP-ES, adopta las directrices del esquema europeo de intercambio de metadatos DCAT-AP (Data Catalog Vocabulary – Aplication Profile) con algunas restricciones y ajustes adicionales. DCAT-AP-ES está alineando con los estándares europeos DCAT-AP 2.1.1 y la extensión DCAT-AP-HVD 2.2.0, que incorpora los requisitos para los Conjuntos de Alto Valor (HVD, High-Value Datasets) definidos por la Comisión Europea.

¿Qué es DCAT-AP y cómo se aplica en España?

DCAT-AP es un perfil de aplicación basado en el vocabulario DCAT del W3C, diseñado para mejorar la interoperabilidad de los catálogos de datos abiertos del sector público en Europa. Su objetivo es proporcionar un modelo común de metadatos que facilite el intercambio, agregación y federación de catálogos de diferentes países y organizaciones (interoperabilidad).

DCAT-AP-ES, como perfil de aplicación de DCAT-AP en España, está diseñado para adaptarse a las particularidades del contexto nacional, garantizando una gestión eficiente de los datos abiertos a nivel estatal, autonómico y local.

DCAT-AP-ES, se establece como el estándar a considerar en la nueva versión de la NTI-RISP, que a su vez se enmarca en el Esquema Nacional de Interoperabilidad (ENI), regulado por el Real Decreto 4/2010, que establece las condiciones para la reutilización de la información del sector público en España.

Principales novedades de DCAT-AP-ES

La nueva versión de DCAT-AP-ES introduce mejoras significativas que facilitan la interoperabilidad y la gestión de datos en el ecosistema digital. Entre otras:

Alineación con DCAT-AP

- Mayor compatibilidad con los catálogos de datos abiertos europeos al alinear la NTI-RISP con el estándar comunitario DCAT-AP.

- Inclusión de propiedades avanzadas para mejorar la descripción de conjuntos de datos y servicios de datos, de cara a asegurar las posibilidades indicadas a continuación.

Incorporación de metadatos para la descripción de los Conjuntos de Alto Valor (HVD)

- Facilitación del cumplimiento de la regulación europea sobre datos de alto valor.

- Posibilidad de descripción detallada de los datos en sectores clave como geoespacial, meteorología, de observación de la tierra y medio ambiente, estadístico, movilidad y empresas.

Mejoras en la descripción de servicios de datos

- Inclusión de metadatos específicos para describir API y servicios de acceso a datos.

- Posibilidad de expresar un conjunto de datos en diferentes contextos (ej. geoespacial, con un servidor cartográfico, o estadístico, con una API de datos).

Soporte para procedencia y calidad de datos

- Incorporación de nuevas propiedades para gestionar ciclos de vida, versionado y origen.

- Implementación de mecanismos de validación y control de calidad mediante SHACL, asegurando la coherencia y estructura de los metadatos en los catálogos.

Uso de vocabularios controlados y mejores prácticas

- Adaptación de vocabularios estandarizados para licencias, formatos de datos, idiomas y temáticas.

- Mayor claridad en la clasificación de datos para facilitar su descubrimiento.

Gobernanza de datos y mejora en la gestión de agentes

- Especificación de roles de los agentes (creador, publicador) y puntos de contacto.

- Metadatos mejorados para representar la procedencia de los recursos.

Validación de conformidad y calidad de los metadatos

- Guías para ayudar en la validación de metadatos que cumplan con DCAT-AP-ES.

- Validación de grafos DCAT-AP-ES conforme a plantillas SHACL.

Beneficios clave de la actualización

La adopción de DCAT-AP-ES representa un salto cualitativo en la gestión y reutilización de los datos abiertos en España. Entre sus beneficios destacan:

✅ Facilita la federación de catálogos y el descubrimiento de datos.

✅ Mejora la interoperabilidad con el ecosistema europeo de datos abiertos.

✅ Cumple con las normativas europeas de datos abiertos.

✅ Aumenta la calidad de los metadatos mediante mecanismos de validación.

✅ Asegura que los datos sean FAIR (Findable, Accessible, Interoperable, Reusable).

Implementación y próximos pasos

¿Cuándo entrará en vigor?

El nuevo perfil de aplicación DCAT-AP-ES se implementará progresivamente en los catálogos de datos abiertos en España. Su aplicación será de carácter obligatorio una vez entre en vigor el texto de la modificación de la norma que, como se indicaba anteriormente, se encuentra en fase de tramitación administrativa pero ya es compatible con el federador de datos.gob.es

¿Existen materiales de apoyo y recursos para la implementación de DCAT-AP-ES?

El equipo gestor de la plataforma datos.gob.es ha desarrollado la Guía de implementación de DCAT-AP-ES, disponible en el repositorio de datos.gob.es.

Este repositorio se irá enriqueciendo a medida que se identifiquen nuevas necesidades de los usuarios que apliquen el estándar. Así mismo, se desarrollarán guías de ayuda y recursos didácticos que faciliten su adopción por parte de los organismos publicadores. Todas las novedades y recursos que vayan generándose en el contexto del perfil de aplicación se anunciarán y referirán puntualmente en datos.gob.es.

¿Dónde encontrar más información?

La documentación actualizada, guías y recursos estarán accesibles en datos.gob.es y en el repositorio de código asociado. En el momento actual se dispone de los siguientes:

- Guía de implementación de DCAT-AP-ES

- Manual de convenciones de DCAT-AP-ES

- Ejemplos de implementación de DCAT-AP-ES

- Preguntas frecuentes DCAT-AP-ES

- Validación de metadatos DCAT-AP-ES

- Vídeo explicativo DCAT-AP: español / inglés

- datos.gob.es

Descubre más en este vídeo:

Y en infografía (haz clic para acceder a la versión interactiva y accesible):

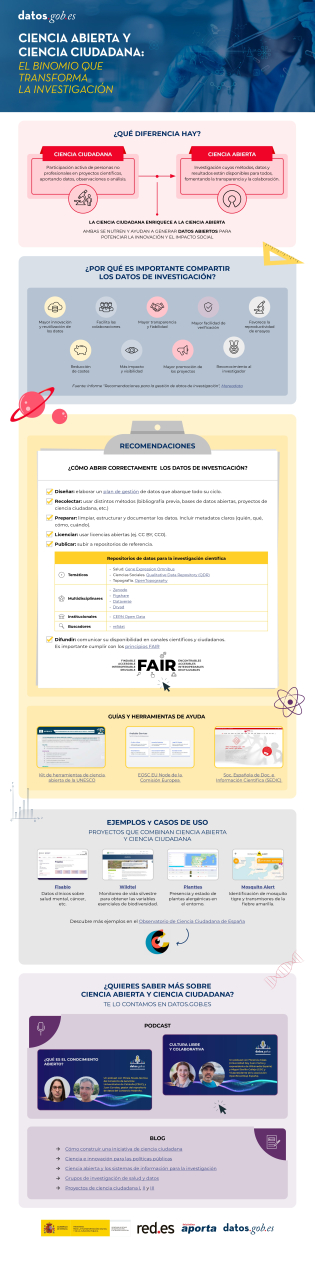

La participación ciudadana en la recopilación de datos científicos impulsa una ciencia más democrática, al involucrar a la sociedad en los procesos de I+D+i y reforzar la rendición de cuentas. En este sentido, existen diversidad de iniciativas de ciencia ciudadana puestas en marcha por entidades como CSIC, CENEAM o CREAF, entre otras. Además, actualmente, existen numerosas plataformas de plataformas de ciencia ciudadana que ayudan a cualquier persona a encontrar, unirse y contribuir a una gran diversidad de iniciativas alrededor del mundo, como por ejemplo SciStarter.

Algunas referencias en legislación nacional y europea

Diferentes normativas, tanto a nivel nacional como a nivel europeo, destacan la importancia de promover proyectos de ciencia ciudadana como componente fundamental de la ciencia abierta. Por ejemplo, la Ley Orgánica 2/2023, de 22 de marzo, del Sistema Universitario, establece que las universidades promoverán la ciencia ciudadana como un instrumento clave para generar conocimiento compartido y responder a retos sociales, buscando no solo fortalecer el vínculo entre ciencia y sociedad, sino también contribuir a un desarrollo territorial más equitativo, inclusivo y sostenible.

Por otro lado, la Ley 14/2011, de 1 de junio, de la Ciencia, la Tecnología y la Innovación, promueve “la participación de la ciudadanía en el proceso científico técnico a través, entre otros mecanismos, de la definición de agendas de investigación, la observación, recopilación y procesamiento de datos, la evaluación de impacto en la selección de proyectos y la monitorización de resultados, y otros procesos de participación ciudadana”.

A nivel europeo, el Reglamento (UE) 2021/695 que establece el Programa Marco de Investigación e Innovación “Horizonte Europa”, indica la oportunidad de desarrollar proyectos codiseñados con la ciudadanía, avalando la ciencia ciudadana como mecanismo de investigación y vía de difusión de resultados.

Iniciativas de ciencia ciudadana y planes de gestión de datos

El primer paso para definir una iniciativa de ciencia ciudadana suele ser establecer una pregunta de investigación que necesite de una recopilación de datos que pueda abordarse con la colaboración de la ciudadanía. Después, se diseña un protocolo accesible para que los participantes recojan o analicen datos de forma sencilla y fiable (incluso podría ser un proceso gamificado). Se deben preparar materiales formativos y desarrollar un medio de participación (aplicación, web o incluso papel). También se planifica cómo comunicar avances y resultados a la ciudadanía, incentivando su participación.

Al tratarse de una actividad intensiva en la recolección de datos, es interesante que los proyectos de ciencia ciudadana dispongan de un plan de gestión de datos que defina el ciclo de vida del dato en proyectos de investigación, es decir cómo se crean, organizan, comparten, reutilizan y preservan los datos en iniciativas de ciencia ciudadana. Sin embargo, la mayoría de las iniciativas de ciencia ciudadana no dispone de este plan: en este reciente artículo de investigación se encontró que sólo disponían de plan de gestión de datos el 38% de proyectos de ciencia ciudadana consultados.

Figura 1. Ciclo de vida del dato en proyectos de ciencia ciudadana Fuente: elaboración propia – datos.gob.es.

Por otra parte, los datos procedentes de la ciencia ciudadana solo alcanzan todo su potencial cuando cumplen los principios FAIR y se publican en abierto. Con el fin de ayudar a tener este plan de gestión de datos que hagan que los datos procedentes de iniciativas de ciencia ciudadana sean FAIR, es preciso contar con estándares específicos para ciencia ciudadana como PPSR Core.

Datos abiertos para ciencia ciudadana con el estándar PPSR Core

La publicación de datos abiertos debe considerarse desde etapas tempranas de un proyecto de ciencia ciudadana, incorporando el estándar PPSR Core como pieza clave. Como mencionábamos anteriormente, cuando se formulan las preguntas de investigación, en una iniciativa de ciencia ciudadana, se debe plantear un plan de gestión de datos que indique qué datos recopilar, en qué formato y con qué metadatos, así como las necesidades de limpieza y aseguramiento de calidad a partir de los datos que recolecte la ciudadanía, además de un calendario de publicación.

Luego, se debe estandarizar con PPSR (Public Participation in Scientific Research) Core. PPSR Core es un conjunto de estándares de datos y metadatos, especialmente diseñados para fomentar la participación ciudadana en procesos de investigación científica. Posee una arquitectura de tres capas a partir de un Common Data Model (CDM). Este CDM ayuda a organizar de forma coherente y conectada la información sobre proyectos de ciencia ciudadana, los conjuntos de datos relacionados y las observaciones que forman parte de ellos, de tal manera que el CDM facilita la interoperabilidad entre plataformas de ciencia ciudadana y disciplinas científicas. Este modelo común se estructura en tres capas principales que permiten describir de forma estructurada y reutilizable los elementos clave de un proyecto de ciencia ciudadana. La primera es el Project Metadata Model (PMM), que recoge la información general del proyecto, como su objetivo, público participante, ubicación, duración, personas responsables, fuentes de financiación o enlaces relevantes. En segundo lugar, el Dataset Metadata Model (DMM) documenta cada conjunto de datos generado, detallando qué tipo de información se recopila, mediante qué método, en qué periodo, bajo qué licencia y con qué condiciones de acceso. Por último, el Observation Data Model (ODM) se centra en cada observación individual realizada por los participantes de la iniciativa de ciencia ciudadana, incluyendo la fecha y el lugar de la observación y el resultado. Es interesante resaltar que este modelo de capas de PPSR-Core permite añadir extensiones específicas según el ámbito científico, apoyándose en vocabularios existentes como Darwin Core (biodiversidad) o ISO 19156 (mediciones de sensores). (ODM) se centra en cada observación individual realizada por los participantes de la iniciativa de ciencia ciudadana, incluyendo la fecha y el lugar de la observación y el resultado. Es interesante resaltar que este modelo de capas de PPSR-Core permite añadir extensiones específicas según el ámbito científico, apoyándose en vocabularios existentes como Darwin Core (biodiversidad) o ISO 19156 (mediciones de sensores).

Figura 2. Arquitectura de capas de PPSR CORE. Fuente: elaboración propia – datos.gob.es.

Esta separación permite que una iniciativa de ciencia ciudadana pueda federar automáticamente la ficha del proyecto (PMM) con plataformas como SciStarter, compartir un conjunto de datos (DMM) con un repositorio institucional de datos abiertos científicos, como aquellos agregados en RECOLECTA del FECYT y, al mismo tiempo, enviar observaciones verificadas (ODM) a una plataforma como GBIF sin redefinir cada campo.

Además, el uso de PPSR Core aporta una serie de ventajas para la gestión de los datos de una iniciativa de ciencia ciudadana:

- Mayor interoperabilidad: plataformas como SciStarter ya intercambian metadatos usando PMM, por lo que se evita duplicar información.

- Agregación multidisciplinar: los perfiles del ODM permiten unir conjuntos de datos de dominios distintos (por ejemplo, calidad del aire y salud) alrededor de atributos comunes, algo crucial para estudios multidisciplinares.

- Alineamiento con principios FAIR: los campos obligatorios del DMM son útiles para que los conjuntos de datos de ciencia ciudadana cumplan los principios FAIR.

Cabe destacar que PPSR Core permite añadir contexto a los conjuntos de datos obtenidos en iniciativas de ciencia ciudadana. Es una buena práctica trasladar el contenido del PMM a lenguaje entendible por la ciudadanía, así como obtener un diccionario de datos a partir del DMM (descripción de cada campo y unidad) y los mecanismos de transformación de cada registro a partir del ODM. Finalmente, se puede destacar iniciativas para mejorar PPSR Core, por ejemplo, a través de un perfil de DCAT para ciencia ciudadana.

Conclusiones

Planificar la publicación de datos abiertos desde el inicio de un proyecto de ciencia ciudadana es clave para garantizar la calidad y la interoperabilidad de los datos generados, facilitar su reutilización y maximizar el impacto científico y social del proyecto. Para ello, PPSR Core ofrece un estándar basado en niveles (PMM, DMM, ODM) que conecta los datos generados por la ciencia ciudadana con diversas plataformas, potenciando que estos datos cumplan los principios FAIR y considerando, de manera integrada, diversas disciplinas científicas. Con PPSR Core cada observación ciudadana se convierte fácilmente en datos abiertos sobre el que la comunidad científica pueda seguir construyendo conocimiento para el beneficio de la sociedad.

Jose Norberto Mazón, Catedrático de Lenguajes y Sistemas Informáticos de la Universidad de Alicante. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los datos son el motor de la innovación, y su potencial transformador se refleja en todos los ámbitos, destacando especialmente en el de la salud. Desde diagnósticos más rápidos hasta tratamientos personalizados y políticas públicas más eficaces, el uso inteligente de la información sanitaria tiene el poder de cambiar vidas de forma profunda y significativa.

Pero, para que estos datos desplieguen todo su valor y se conviertan en una fuerza real para el progreso, es fundamental que "hablen el mismo idioma". Es decir, que estén bien organizados, sean fáciles de encontrar y puedan compartirse de forma segura y coherente entre distintos sistemas, países y profesionales.

Aquí es donde entra en juego HealthDCAT-AP, una nueva especificación europea que, aunque suene técnico, tiene mucho que ver con nuestro bienestar como ciudadanos. HealthDCAT-AP está diseñado para describir los datos de salud —desde estadísticas agregadas hasta registros clínicos anonimizados— de manera homogénea, clara y reutilizable, a través de metadatos. En definitiva, no actúa sobre los datos clínicos en sí, sino que facilita que puedan localizarse y comprenderse mejor gracias a una descripción estandarizada.

HealthDCAT-AP se ocupa exclusivamente de los metadatos, es decir, de cómo se describen y organizan los conjuntos de datos en los catálogos, diferenciándose de HL7, FHIR y DICOM que estructuran el intercambio de información clínica e imágenes; CDA que describe la arquitectura de los documentos; y SNOMED CT, LOINC y CIE-10 que estandarizan la semántica de diagnósticos, procedimientos y observaciones para garantizar que los datos tengan el mismo significado en cualquier contexto

Este artículo explora cómo HealthDCAT-AP, en el contexto del Espacio Europeo de Datos Sanitarios (EHDS) y del Espacio Nacional de Datos Sanitarios (ENDS), aporta valor principalmente a quienes reutilizan los datos —como investigadores, innovadores o responsables de políticas públicas— y, en última instancia, beneficia también a la ciudadanía a través de los avances que estos generan.

¿Qué es HealthDCAT-AP y cuál es su relación con DCAT-AP?

Imagina una biblioteca enorme llena de libros sobre salud, pero sin ningún sistema para organizarlos. Buscar una información concreta sería una tarea caótica. Con los datos de salud ocurre algo similar: si no están bien descritos, localizarlos y reutilizarlos es prácticamente imposible.

HealthDCAT-AP nace para resolver este reto. Es una especificación técnica europea que permite describir de forma clara y uniforme los conjuntos de datos sanitarios dentro de catálogos de datos a, facilitando su búsqueda, acceso, comprensión y reutilización. En otras palabras, hace que la descripción de los datos sanitarios hable el mismo idioma en toda Europa, lo que resulta clave para mejorar la atención, la investigación y las políticas de salud.

Esta especificación técnica se basa en DCAT-AP, la especificación general utilizada para describir catálogos de conjuntos de datos del sector público en Europa. Mientras que DCAT-AP proporciona una estructura común para todo tipo de datos, HealthDCAT-AP es su extensión especializada en salud, que adapta y amplía ese modelo para cubrir las particularidades de los datos clínicos, epidemiológicos o biomédicos.

HealthDCAT-AP fue desarrollado en el marco del proyecto piloto europeo EHDS2 (European Health Data Space 2) y continúa evolucionando gracias al apoyo de proyectos como HealthData@EU Pilot, que trabajan en el despliegue de la futura infraestructura europea de datos sanitarios. La especificación está en desarrollo activo y su versión más reciente, junto con documentación y ejemplos, puede consultarse públicamente en su repositorio oficial de GitHub.

Así mismo, HealthDCAT-AP está diseñado para aplicar los principios FAIR que los datos sean Encontrables, Accesibles, Interoperables y Reutilizables. Esto significa que, aunque los datos sanitarios puedan ser complejos o sensibles, su descripción (metadatos) es clara, estandarizada y útil. Cualquier profesional o institución —ya sea en España o en otro país europeo— puede saber qué datos existen, cómo acceder a ellos y con qué condiciones. Esto fomenta la confianza, la transparencia y el uso responsable de los datos sanitarios. HealthDCAT-AP es además una piedra angular del EHDS y por ende del ENDS. Su adopción permitirá que hospitales, centros de investigación o administraciones compartan información de forma coherente y segura a lo largo de toda Europa. Así, se impulsa la colaboración entre países y se maximiza el valor de los datos para beneficio de toda la ciudadanía.

Para facilitar su uso y adopción, desde Europa, bajo las iniciativas mencionadas anteriormente, se han creado herramientas como el editor y el validador HealthDCAT-AP, que permiten a cualquier organización generar descripciones de conjuntos de datos a través de los metadatos que sean compatibles sin necesidad de conocimientos técnicos avanzados. Esto elimina barreras y anima a más entidades a participar en este ecosistema de datos de salud en red.

¿Cómo contribuye HealthDCAT-AP al valor público de los datos de salud?

Aunque HealthDCAT-AP es una especificación técnica centrada en la descripción de conjuntos de datos de salud, su adopción tiene implicaciones prácticas que van más allá del ámbito tecnológico. Al ofrecer una forma común y estructurada de documentar qué datos existen, cómo pueden utilizarse y en qué condiciones, contribuye a que distintos actores —desde hospitales y administraciones hasta centros de investigación o startups— puedan acceder, combinar y reutilizar mejor la información disponible, habilitando el denominado uso secundario de la misma, más allá del uso primario asistencial.

A continuación, se detallan algunos de los ámbitos donde su contribución técnica se traduce en beneficios concretos para el conjunto de la sociedad.

- Diagnósticos más rápidos y tratamientos personalizados: cuando los datos están bien organizados y son accesibles para quienes los necesitan, los avances en investigación médica se aceleran. Esto permite desarrollar herramientas de inteligencia artificial que detectan enfermedades antes, identificar patrones en grandes poblaciones y adaptar tratamientos al perfil de cada paciente. Es la base de la medicina personalizada, que mejora resultados y reduce riesgos.

- Mejor acceso al conocimiento sobre qué datos existen: HealthDCAT-AP permite a investigadores, gestores sanitarios o autoridades localizar más fácilmente conjuntos de datos útiles, gracias a su descripción estandarizada. Esto puede facilitar, por ejemplo, el análisis de desigualdades en salud o la planificación de recursos en situaciones de crisis.

- Mayor transparencia y trazabilidad: El uso de metadatos permite saber quién es responsable de cada conjunto de datos, con qué finalidad se puede usar y en qué condiciones. Esto fortalece la confianza en el ecosistema de reutilización de datos.

- Servicios sanitarios más eficientes: la estandarización de los metadatos mejora los flujos de información entre centros, regiones y sistemas. Esto reduce la burocracia, evita duplicidades, optimiza el uso de recursos y libera tiempo y dinero que pueden reinvertirse en mejorar la atención directa a los pacientes.

- Más innovación y nuevas soluciones para el ciudadano: al facilitar el acceso a mayores conjuntos de datos, HealthDCAT-AP impulsa el desarrollo de nuevas herramientas digitales centradas en el paciente: apps de autocuidado, sistemas de seguimiento remoto, comparadores de servicios, etc. Muchas de estas soluciones nacen fuera del sistema sanitario —en universidades, startups o asociaciones— pero benefician directamente a la ciudadanía.

- Una Europa conectada en torno a la salud: al compartir una forma común de describir los datos, HealthDCAT-AP hace posible que un conjunto de datos creado en España pueda ser comprendido y utilizado en Alemania o Finlandia, y viceversa. Esto favorece la colaboración internacional, refuerza la cohesión europea y garantiza que los ciudadanos se beneficien de avances científicos independientemente de su país.

¿Y qué papel juega España en todo esto?

España no solo está alineada con el futuro del dato sanitario en Europa: está participando activamente en su construcción. Gracias a una sólida base legal, un sistema sanitario ampliamente digitalizado, la experiencia acumulada en la compartición segura de información de salud dentro del SNS, y una larga trayectoria en datos abiertos —a través de iniciativas como datos.gob.es—, nuestro país se encuentra en una posición privilegiada para contribuir y beneficiarse del Espacio Europeo de Datos Sanitarios (EHDS).

Desde hace años, España ha desarrollado marcos legales y capacidades técnicas que anticipan muchos de los requisitos del Reglamento EHDS. La digitalización generalizada de la atención sanitaria y la experiencia en el uso de datos de forma segura y responsable permiten avanzar hacia un modelo interoperable, ético y orientado al bien común.

En este contexto, el proyecto del Espacio Nacional de Datos de Salud supone un paso decisivo. Esta iniciativa tiene como objetivo, convertirse en la plataforma nacional de referencia para el análisis y explotación de datos sanitarios para uso secundario., concibiéndose como catalizador de la investigación e innovación en salud, referente en la aplicación de soluciones disruptivas y puerta de acceso a diferentes orígenes de datos. Todo ello se realiza bajo condiciones estrictas de anonimización, seguridad, transparencia y protección de derechos, garantizando que los datos solo se utilicen con fines legítimos y con pleno respeto a la normativa vigente.

La familiaridad de España con estándares como DCAT-AP facilita el despliegue de HealthDCAT-AP. Plataformas como datos.gob.es, que ya actúan como punto de referencia en la publicación de datos abiertos, serán clave en su despliegue y difusión.

Conclusiones

HealthDCAT-AP puede sonar a algo técnico, pero en realidad es una especificación que puede llegar a repercutir en nuestra vida diaria. Al ayudar a describir mejor los datos de salud, facilita que esa información se utilice de forma útil, segura y responsable.

Esta especificación permite que la descripción de conjuntos de datos hable el mismo idioma en toda Europa. Así, se pueden encontrar más fácilmente, compartir con quien corresponde y reutilizar para fines que nos benefician a todos: diagnósticos más rápidos, tratamientos más personalizados, decisiones de salud pública más acertadas o nuevas herramientas digitales que mejoran nuestra calidad de vida.

España, gracias a su experiencia en datos abiertos y a su sistema sanitario digitalizado, está participando activamente en esta transformación realizando un esfuerzo conjunto entre profesionales, instituciones, empresas, investigadores, etc. y también ciudadanos. Porque cuando los datos se entienden y se gestionan bien, pueden marcar la diferencia. Pueden salvar tiempo, recursos, e incluso vidas.

HealthDCAT-AP no es solo una especificación técnica: es un paso adelante hacia una salud más conectada, transparente y centrada en las personas. Una especificación pensada para maximizar el uso secundario de la información de salud, y para que, con ello, todos como ciudadanos podamos salir beneficiados.

Contenido elaborado por Dr. Fernando Gualo, Profesor en UCLM y Consultor de Gobierno y Calidad de datos. El contenido y el punto de vista reflejado en esta publicación es responsabilidad exclusiva de su autor.

La normativa UNE 0087 define por primera vez en España los principios y requisitos clave para crear y operar en espacios de datos

El pasado día 17 de julio se publicó oficialmente la Especificación UNE 0087 “Definición y caracterización de los Espacios de Datos”, la primera norma española que establece un marco común para estos entornos digitales.

Este hito ha sido posible gracias a la colaboración del Centro de Referencia de Espacios de Datos (CRED), con la Asociación Española de Normalización (UNE). Dicha normativa, que fue aprobada el 20 de junio de 2025 define tres pilares claves en la adhesión a los espacios de datos: interoperabilidad, gobernanza y creación de valor, con el objetivo de ofrecer seguridad jurídica, confianza y un lenguaje técnico común en la economía del dato.

Para su creación, se han formado tres grupos de trabajo con más de 50 participantes de entidades tanto públicas como privadas que han aportado su conocimiento para definir los principios y características clave de estos sistemas colaborativos. Estos grupos de trabajo se han coordinado de la siguiente manera:

- GT1: Definición de Espacios de Datos y Modelo de Madurez.

- GT2: Interoperabilidad Técnica y Semántica.

- GT3: Interoperabilidad legal y organizativa.

La publicación de esta normativa supone, por tanto, un documento de referencia para la creación de espacios de datos seguros y confiables, aplicable en todos los sectores productivos y que sirve de base para futuros documentos guía.

De este modo, para ofrecer unas directrices que faciliten la implementación y desarrollo de los espacios de datos, nace la especificación UNE 0087:2025 para crear un marco inclusivo de referencia que oriente a las organizaciones y que estas se puedan aprovechar de toda la información en un entorno de cumplimiento normativo y soberanía digital. La publicación de esta normativa tiene una serie de beneficios:

- Acelerar el despliegue de los espacios de datos en todos los sectores de la economía.

- Favorecer la sostenibilidad y el escalado / crecimiento de los ecosistemas de compartición de datos.

- Fomentar la colaboración pública /privada, asegurando la convergencia con Europa.

- Avanzar hacia la autonomía tecnológica y la soberanía de los datos en los ecosistemas.

- Promover el descubrimiento de nuevas oportunidades de negocio innovadoras fomentando la colaboración y creación de alianzas estratégicas.

Dentro de la especificación se definen qué son los espacios de datos, de establecen sus características clave de interoperabilidad, gobernanza y generación de valor y se determinan cuáles con los beneficios de su adhesión. La especificación está publicada aquí y es importante añadir que, aunque aparezca un coste de descarga, tiene carácter gratuito, gracias al patrocinio de la Dirección General del Dato.

Con esta herramienta, España da un paso firme en la consolidación de espacios de datos cohesivos, seguros y alineados con el marco europeo, facilitando la implantación de proyectos transversales en diferentes sectores.

Como dicta la tradición, el fin de año es un buen momento para reflexionar sobre nuestras metas y objetivos de cara a la nueva etapa que comienza tras las campanadas. En materia de datos, el inicio de un nuevo año también brinda oportunidades para trazar un futuro interoperable y digital que habilite el desarrollo de una economía del dato robusta, un escenario que beneficie tanto a investigadores como administraciones públicas o empresas privadas, así como que repercuta positivamente en el ciudadano como cliente final de muchas operaciones realizadas con datos, optimizando y reduciendo los tiempos de tramitación. Para lograr este fin, existe la Estrategia europea de datos que persigue desbloquear el potencial de los datos a través de, entre otras, la Ley de Datos (Data Act, en inglés) que recoge un conjunto de medidas relacionadas con el acceso y uso equitativo de los datos asegurando así mismo que el dato manejado sea de calidad, esté debidamente securizado, etc.

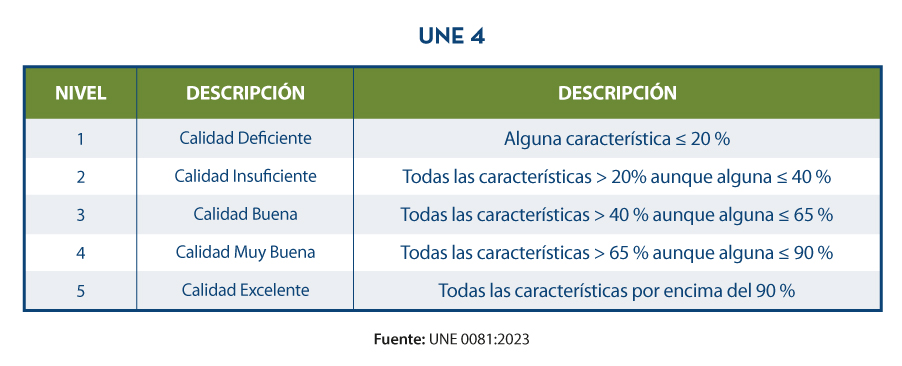

Como solución a esta necesidad, este último año se han publicado las especificaciones UNE de datos que son recursos normativos e informativos para implantar procesos comunes de gobierno, gestión y calidad del dato. Estas especificaciones, respaldadas por la Oficina del Dato, establecen estándares para disponer de datos bien gobernados (UNE 0077), gestionados (UNE 0078) y con niveles adecuados de calidad (UNE0079), permitiendo así mismo un crecimiento sostenible en la organización durante la implantación de los distintos procesos. Además de estas tres especificaciones, la especificación UNE 0080 define una guía y proceso de evaluación de madurez para medir el grado de implantación de los procesos de gobierno, gestión, y calidad del dato. Por su parte, la UNE 0081 también establece un proceso de evaluación del activo de datos en sí, es decir, de los conjuntos de datos, independientemente de su naturaleza o tipología; en resumen, su contenido está estrechamente relacionado con la UNE 0079 porque recoge unas características de calidad de los datos. La adopción de todas ellas puede proporcionar múltiples beneficios. En este post, analizamos cuáles son y cómo sería el proceso para cada especificación.

Así, con la mirada puesta en el futuro, planteamos un propósito de año nuevo: la aplicación de las especificaciones UNE del dato a una organización.

¿Qué ventajas tiene su aplicación y cómo puedo acceder a ellas?

En la era actual, donde el gobierno y la gestión eficiente de los datos se han convertido en un pilar fundamental para el éxito organizacional, la implementación de las especificaciones UNE sobre datos emerge como un faro guía hacia la excelencia marcando el camino a seguir. Estas especificaciones describen rigurosos procesos estandarizados que ofrecen a las organizaciones la posibilidad de construir una estructura robusta y confiable para el manejo de sus datos e información a lo largo de todo su ciclo de vida.

Al adoptar las especificaciones UNE, no solo se garantiza la calidad y seguridad de los datos, sino que también se constituye una base sólida y adecuada para la toma de decisiones informadas enriqueciendo los procesos organizacionales con buenas prácticas de datos. Por lo tanto, toda organización que decida abrazar estas normativas de cara al nuevo año estará acercándose a la innovación, la eficiencia y la confianza en el gobierno y la gestión de datos; así como preparándose para afrontar los desafíos y oportunidades que depara el futuro digital. La aplicación de especificaciones UNE no solo es un compromiso con la calidad, sino una inversión estratégica que pavimenta el camino hacia el éxito sostenible en un entorno empresarial cada vez más competitivo y dinámico porque:

- Maximiza la aportación de valor a la estrategia de negocio

- Minimiza riesgos en el tratamiento del dato

- Optimiza las tareas evitando trabajos innecesarios

- Establece marcos homogéneos de referencia y certificación

- Facilita la compartición de información con confianza y soberanía

El contenido de las guías puede visualizarse de forma libre y gratuita desde el portal de AENOR a través del enlace que figura a continuación accediendo al apartado de compra y marcando “lectura” en el desplegable en el que aparece preseleccionado “pdf”. El acceso a esta familia de especificaciones UNE del dato está patrocinado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, Dirección General del Dato. Aunque la visualización requiere registro previo, se aplica un descuento del 100% sobre el total del precio que se aplica en el momento de finalizar la compra. Tras finalizar la compra se podrá acceder a la norma o normas seleccionadas desde el área de cliente en el apartado mis productos.

- ESPECIFICACION UNE 0077:2023

- ESPECIFICACION UNE 0078:2023

- ESPECIFICACION UNE 0079:2023

- ESPECIFICACIÓN UNE 0080:2023

- ESPECIFICACIÓN UNE 0081:2023

Desde datos.gob.es nos hemos hecho eco del contenido de las mismas y hemos preparado diferentes recursos didácticos como esta infografía o este vídeo explicativo.

¿Cómo se aplican a una organización?

Una vez tomada la decisión de abordar la implantación de estas especificaciones, surge un interrogante crucial: ¿Cuál es la manera más efectiva de hacerlo? La respuesta a esta cuestión dependerá de la situación inicial (marcada por una evaluación inicial de madurez), el tipo de organización y los recursos disponibles en el momento de establecer el plan director o plan de implantación. No obstante, en datos.gob.es, hemos publicado una serie de contenidos elaborados por expertos en tecnologías ligadas a la economía del dato datos.gob.es, hemos publicado una serie de contenidos elaborados por expertos en tecnologías ligadas a la economía del dato que te acompañarán en el proceso.

Antes de empezar, es importante conocer los diferentes procesos que constituyen cada una de las especificaciones UNE sobre datos. En esta imagen se exponen cuáles son.

Una vez entendido lo básico, la serie de contenidos ‘Aplicación de las especificaciones UNE sobre datos’ abordan un ejercicio práctico, desglosado en tres posts, sobre un caso de uso especifico: la aplicación de estas especificaciones a los datos abiertos. Como ejemplo, se define una necesidad que tiene el Ayuntamiento ficticio de Vistabella: avanzar en la publicación en abierto de información de transporte público y eventos culturales.

- En el primer post de la serie, se destaca la importancia de utilizar la especificación UNE 0077 de gobierno del dato para establecer mecanismos aprobados que respalden la apertura y publicación de los datos abiertos. A través de este primer contenido, se realiza un repaso de los procesos necesarios para alinear la estrategia organizacional de tal manera que se logre conseguir la máxima transparencia y calidad de los servicios públicos mediante la reutilización de información.

- El segundo artículo de la serie se sumerge en la norma UNE 0079 de gestión de calidad de los datos y su aplicación en el contexto de los datos abiertos. Este contenido subraya que la calidad de los datos abiertos va más allá de los principios FAIR y destaca la importancia de evaluar la calidad mediante criterios objetivos. A través del ejercicio práctico, se explora cómo el Ayuntamiento de Vistabella aborda los procesos de la UNE para mejorar la calidad de los datos abiertos como parte de su estrategia para potenciar la publicación de datos sobre transporte público y eventos culturales.

- Por último, la norma UNE 0078 sobre gestión de datos se explica en un tercer artículo en el que se presenta el proceso de Compartición, Intermediación e Integración de Datos (CIIDat) para la publicación de datos abiertos, combinado con plantillas específicas.

En conjunto, estos tres artículos ofrecen una guía para que cualquier organización avance con éxito hacia la publicación en abierto de información clave, asegurando la coherencia y calidad de los datos. Al seguir estos pasos, las organizaciones estarán preparadas para cumplir con los estándares normativos con todas las ventajas que supone.

Para finalizar, abrazar el propósito de año nuevo de aplicar las especificaciones UNE sobre datos representa un compromiso estratégico y visionario para cualquier organización que, además, estará alineado con la Estrategia europea de datos y la hoja de ruta europea que persigue configurar un futuro digital líder a nivel mundial.

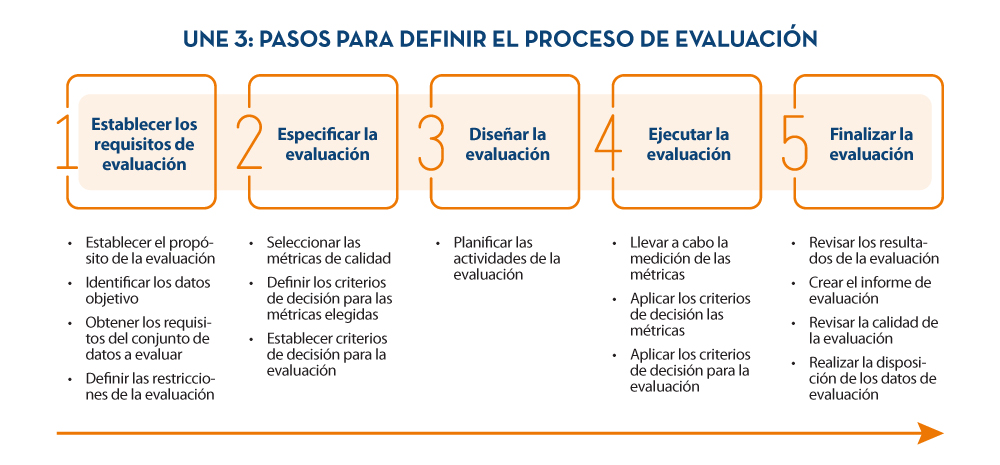

La nueva especificación UNE 0081 Evaluación de Calidad de Datos, centrada en los datos como producto (conjuntos de datos o bases de datos), complementa la especificación UNE 0079 Gestión de la calidad del dato, que analizamos en este artículo, se focaliza en los procesos de gestión de la calidad del dato. Ambas normas, la 0079 y la 0081 se complementan y abordan de forma holística la calidad de los datos:

- La norma UNE 0079 refiere los procesos, las actividades que deber realizar la organización para garantizar los niveles adecuados de calidad de sus datos para satisfacer la estrategia que la organización se han marcado.

- Por otra parte, la UNE 0081 define un modelo de calidad del dato, basado en las normas ISO/IEC 25012 e ISO/IEC 25024, en el que se detallan las características de calidad que pueden tener los datos, así como algunas métricas aplicables. También define el proceso que se debe seguir para evaluar la calidad de un conjunto de datos concreto, tomando como base la norma ISO/IEC 25040. Finalmente, la especificación acaba detallando cómo interpretar los resultados obtenidos de la evaluación, mostrando ejemplos concretos de aplicación.

¿Cómo puede una organización hacer uso de esta especificación para evaluar el nivel de calidad de sus datos?

Para dar respuesta a esta pregunta, vamos a contar el ejemplo del Ayuntamiento de Vistabella, previamente utilizado en artículos anteriores. El ayuntamiento tiene una serie de conjuntos de datos, cuya calidad quiere evaluar, para poder mejorarlos y dar un mejor servicio a la ciudadanía. La institución es consciente de que trabaja con muchos tipos de datos (transaccionales, maestros, de referencia, etc.), por lo tanto, lo primero que realiza es una primera identificación de los conjuntos de datos que aportan valor y para los cuales, no disponer de niveles adecuados de calidad, puede repercutir en el día a día. Algunos criterios a la seguir a la hora de seleccionar estos conjuntos pueden ser: datos que aportan un valor al ciudadano, datos resultantes de un proceso de integración o visión maestra del dato, datos críticos por ser utilizados en varios procesos/procedimientos, etc.

El siguiente paso será determinar en qué punto(s) del ciclo de vida de los procesos operativos del ayuntamiento se realizarán estos controles de calidad del dato.

Es en este punto donde la especificación UNE 0081 entra en juego. La evaluación se hace en función de las "reglas de negocio" que definen los requerimientos, requisitos de datos o validaciones que deben cumplir los datos para que aporten valor a la organización. A continuación, se muestran algunos ejemplos:

- Los DNI de los ciudadanos tendrán que cumplir con la sintaxis específica para ello (8 números y una letra).

- Toda fecha existente en el sistema tendrá que seguir la notación DD-MM-AAAA.

- No se admitirán registros de documentación con fecha posterior a la actual.

- Se deberá tener traza de quién y cuándo ha realizado un cambio en un conjunto de datos.

Para poder identificar de forma sistemática y exhaustiva las reglas de negocio que tengan que cumplir los datos en cada etapa de su ciclo de vida, el ayuntamiento hace uso de una metodología basada en BR4DQ.

A continuación, desde el ayuntamiento, se revisan todas las características de calidad de datos incluidas dentro de la especificación, se priorizan, y se determina un primer conjunto de ellas que se querrán tener en cuenta para la evaluación. Para ello, y en esta primera etapa, el ayuntamiento decide quedarse exclusivamente con las 5 características inherentes de ISO 25012 definidas dentro de la especificación. Estas son: exactitud, completitud, consistencia, credibilidad y actualidad.

Del mismo modo, para cada una de estas primeras características que se ha acordado abordar, se identifican posibles propiedades. Para ello, finalmente, desde el ayuntamiento se decide trabajar con el siguiente modelo de calidad que incluye las siguientes características y propiedades:

Hasta este punto, el ayuntamiento tiene identificado el conjunto de datos a evaluar, así como las reglas de negocio que le aplican, y en qué aspectos de la calidad se va a centrar (modelo de calidad de datos). A continuación, es necesario llevar a cabo la medición de calidad de datos a través de la validación de las reglas de negocio. Para ello se obtienen valores para las distintas métricas, los cuales se computan siguiendo una aproximación de abajo hacia arriba hasta determinar el nivel de calidad de datos del repositorio

Definición del proceso de evaluación

Para realizar la evaluación de una forma adecuada, se decide hacer uso del proceso de evaluación de calidad basado en ISO 25024, indicado dentro de la especificación UNE 0081 (véase a continuación).

Aplicación del proceso de evaluación

A continuación, se resumen los aspectos más destacables llevados a cabo por el Ayuntamiento durante la etapa 4 del proceso de evaluación:

- Validación del grado de cumplimiento de cada regla de negocio por propiedad: Disponiendo de todas las reglas de negocio clasificadas por propiedad, se valida el grado de cumplimiento de cada una de ellas, obteniendo así una serie de valores para cada una de las métricas. Esto se ejecuta sobre cada uno de los conjuntos de datos a evaluar.