Motivación

Hoy en día, en un entorno en constante cambio y en el que la generación de datos está creciendo de forma exponencial, es necesario establecer procesos comunes a lo largo del ciclo de vida de los activos de datos de toda organización. Disponer de datos bien gobernados, gestionados y con niveles adecuados de calidad se convierte en una necesidad para todo tipo de instituciones, siendo necesaria una metodología de evaluación común que pueda ayudar a una mejora continua de dichos procesos y permita evaluar la madurez de una organización de forma estandarizada.

El desarrollo de un marco homogéneo de evaluación de la madurez para una organización, con relación al tratamiento que hace de los datos, brinda la oportunidad de analizar detalladamente los procedimientos internos que realiza, identificando debilidades asociadas a esos procedimientos y permitiendo establecer planes de acción para su optimización y mejora. Al fortalecer estos procesos internos se garantiza una mayor confiabilidad y calidad de los datos, lo que también redunda en una mayor y más fácil participación en los nuevos mercados de datos, habilitando estos la comercialización y compartición de datos con soberanía, confianza y seguridad. Este innovador paradigma favorece la colaboración entre organizaciones, aprovechando sus sinergias, y generando además un desarrollo de entornos empresariales más eficientes y de mayor innovación.

El mencionado proceso de evaluación se podrá llevar a cabo de forma estandarizada gracias al desarrollo y publicación de la nueva especificación UNE 0080, y debe considerarse como un proceso de mejora continua. A lo largo de ese camino, entidades reconocidas e independientes podrán emitir certificaciones que validen que una organización cumple con ciertos estándares y requisitos establecidos, de tal forma que una organización pueda demostrar su compromiso y excelencia con los estándares, lo cual servirá para lograr un buen posicionamiento en el competitivo mercado de la economía del dato.

Especificaciones UNE – Guía de Evaluación del Gobierno, Gestión y Gestión de la Calidad del Dato

La Oficina del Dato ha patrocinado, promovido y participado en la generación de la especificación nacional UNE 0080:2023, con la que dar respuesta a la necesidad de contar con una guía de evaluación de procesos basada en estándares internacionales, con la que organizaciones tanto públicas como privadas, puedan evaluar de forma sistemática el estado actual o grado de consecución de sus procesos de trabajo en materia de gobierno, gestión y gestión de calidad del dato en base a la definición dada para esos procesos en las especificaciones UNE de Gobierno del dato UNE 0077:2023, Gestión del dato UNE 0078:2023, y Gestión de la calidad del dato UNE 0079:2023. Esta nueva especificación se encuentra dirigida a los responsables de implantar y supervisar los procesos de gobierno, gestión y calidad del dato en sus respectivas organizaciones, de tal forma que aseguren su buen funcionamiento o, en caso de que sea necesario, sean capaz de mejorarlos, así como a los consultores y auditores que necesiten llevar a cabo una evaluación de dichos procesos.

El modelo de evaluación de los procesos desarrollado en la guía está basado en la familia de normas internacionales ISO/IEC 33000, mientras que el modelo de madurez de la organización asociado a esa evaluación de los procesos está basado en el Modelo Alarcos de Madurez de Datos (MAMD) según las normas ISO 8000.

En la siguiente figura se pueden ver los 22 procesos definidos en las especificaciones UNE (0077, 0078 y 0079) distribuidos por los diferentes niveles de madurez organizacional con los que están relacionados. Es importante matizar que en esta figura no se muestran los niveles de capacidad de cada proceso, los cuales se desarrollan a continuación.

Modelo de Evaluación de procesos

El modelo de evaluación de procesos establece que cada uno de los 22 procesos definidos en las diferentes especificaciones (5 de Gobierno, 13 de gestión y 4 de gestión de la calidad) tienen distintos niveles de capacidad o grados de mejora, siendo el nivel 0 el más básico (no implementado) y el nivel 5 el más avanzado (innovado).

Cada nivel de capacidad de un proceso lleva asociados unos atributos de proceso (o requisitos) que es necesario cumplir para alcanzar dicho nivel de capacidad, siendo necesario no sólo cumplir los atributos de proceso del nivel a alcanzar, sino también los relativos a niveles inferiores. Los atributos de proceso por nivel de capacidad son los siguientes:

En la guía de evaluación se detallan exactamente qué requisitos son necesarios satisfacer para dar por cumplido cada atributo de proceso, así como sus métricas de evaluación para concluir si un atributo de proceso está No implementado (N), Parcialmente implementado (P), Ampliamente implementado (A) o Totalmente implementado (T). Por tanto, si por ejemplo queremos afirmar que un determinado proceso de nuestra organización está a un nivel de capacidad “Nivel 2 - Proceso Gestionado”, los atributos del proceso relativos al nivel 1 deben de estar Totalmente implementados (T) y los relativos al nivel 2 al menos Ampliamente implementados (A) o Totalmente implementados (T).

Modelo de Evaluación de madurez de la organización

La guía propone que para determinar el nivel de madurez de la organización en conjunto, será necesario no sólo que ésta realice los procesos propios de cada nivel, tal y como se muestra en la figura anterior, sino que estos también alcancen el nivel de capacidad acorde al nivel de madurez contra el que se evalúa.

Pongamos un ejemplo: si una organización quiere evaluar y acreditar que cumple con el nivel 2 de madurez organizacional “Gestionado”, necesita realizar al menos todos los procesos relativos al nivel de madurez 1 (2 procesos) y al nivel 2 (7 procesos), y que estos además estén desarrollados a un nivel de capacidad mínimo de grado 2 (proceso gestionado) mediante la certificación de sus respectivos atributos de proceso (‘totalmente implementado’ los atributos de procesos del nivel de capacidad 1 y ‘ampliamente implementados’ o ‘totalmente implementados’ los atributos de procesos relativos al nivel 2). Así, tal y como se muestra en la Figura 4 resumen de la evaluación de madurez organizacional, puede observarse como todos los procesos relativos al nivel gestionado han sido evaluados en cuanto a su capacidad como implementados al menos ampliamente.

En resumen, gracias al desarrollo de esta especificación o guía, las organizaciones van a disponer de una herramienta estandarizada para ser capaces de autoevaluar sus procesos en torno al gobierno del dato, gestión del dato, y gestión de la calidad del dato. Además, resulta también posible que puedan ser evaluadas por entidades externas certificadoras en última instancia, que acrediten no sólo la madurez organizacional, sino también una calidad del dato mínima, para escenarios en que éste vaya a ser compartido con otros participantes del ecosistema.

El contenido de esta guía, así como del resto de especificaciones UNE mencionadas, puede visualizarse de forma libre y gratuita desde el portal de AENOR a través del enlace que figura a continuación accediendo al apartado de compra y marcando “lectura” en el desplegable en el que aparece preseleccionado “pdf”. El acceso a esta familia de especificaciones UNE del dato está patrocinado por la Secretaría de Estado de Digitalización e Inteligencia Artificial, Dirección General del Dato. Aunque la visualización requiere registro previo, se aplica un descuento del 100% sobre el total del precio que se aplica en el momento de finalizar la compra. Tras finalizar la compra se podrá acceder a la norma o normas seleccionadas desde el área de cliente en el apartado mis productos.

- ESPECIFICACION UNE 0077:2023

- ESPECIFICACION UNE 0078:2023

- ESPECIFICACION UNE 0079:2023

- ESPECIFICACION UNE 0080:2023

En el siguiente vídeo se presenta un resumen de las mencionadas guías.

Con el avance que la tecnología y la conectividad han venido experimentando durante los últimos años hemos entrado de lleno en una nueva era en la que los datos nunca duermen y la cantidad de datos circulando es mayor que nunca. En la actualidad, podríamos decir que vivimos encerrados en una esfera rodeados de datos y eso nos ha ido haciendo cada vez más dependientes de ellos. Por otro lado, nos hemos ido también transformando poco a poco en seres tanto productores como recolectores de datos.

El término datasfera se ha venido utilizado históricamente para definir el conjunto de toda la información existente en los espacios digitales, incluyendo también otros conceptos relacionados como los flujos de datos y las plataformas implicadas. Pero este concepto ha ido desarrollándose y cobrando cada vez más relevancia de forma paralela al creciente peso de los datos en nuestra sociedad actual, convirtiéndose en un concepto importante a la hora de definir el futuro de las relaciones entre tecnología y sociedad.

En los inicios de la era digital podíamos considerar que vivíamos en nuestras propias burbujas de datos que íbamos alimentando poco a poco a lo largo de nuestras vidas hasta acabar totalmente inmersos en los datos del mundo online, donde la distinción entre lo real y lo virtual es cada vez más irrelevante. Hoy en día vivimos en una sociedad interconectada a través de los datos y también mediante algoritmos que nos unen y establecen relaciones entre nosotros. Todos aquellos datos que compartimos de forma más o menos consciente ya no nos afectan únicamente a nosotros mismos como individuos, sino que pueden tener también su efecto en el resto de la sociedad, incluso de forma a veces totalmente imprevisible – como en una versión digital del efecto mariposa.

Por tanto, los modelos de gobernanza que se basen en trabajar con los datos y su relación con las personas, como si se tratasen simplemente de instancias aisladas con las que podemos trabajar individualmente, ya no nos serán de utilidad en este nuevo entorno.

La necesidad de una aproximación a los datos basada en sistemas

En la actualidad, ese concepto relativamente simple de la dataesfera ha ido evolucionando hasta convertirse en un ecosistema digital completo, altamente interconectado y complejo – compuesto por una amplia gama de datos y tecnologías – que nosotros habitamos y que afecta a la forma en la que vivimos nuestras vidas. Es un sistema en el que los datos tienen valor solo en el contexto de su relación con otros datos, con las personas y con las normas que regulan esas relaciones.

Por lo tanto, para una gestión eficaz de este nuevo ecosistema, será necesaria una mejor comprensión de cómo los diferentes componentes de la dataesfera se relacionan entre sí, de cómo los datos fluyen a través de estos componentes y de cuáles serán las normas adecuadas necesarias para que este sistema interconectado funcione.

Los datos como componente activo del sistema

En una aproximación basada en sistemas, los datos se consideran un componente activo dentro del ecosistema. Esto significa que los datos ya no son sólo información estática, sino que también tienen la capacidad de influir en el funcionamiento del propio ecosistema y, por tanto, serán un componente más a tener en cuenta para la gestión eficaz del mismo.

Por ejemplo, los datos pueden utilizarse para ajustar el funcionamiento de los algoritmos, mejorando la precisión y la eficiencia de los sistemas de inteligencia artificial y de aprendizaje automático. De forma similar, también podrían utilizarse para ajustar la forma en que se toman decisiones y se aplican políticas en diferentes sectores, como la atención médica, la educación y la seguridad.

La dataesfera y la evolución del gobierno de los datos

Por lo tanto, será necesario explorar nuevos marcos colectivos de gobernanza de datos que tengan en consideración a todos los elementos del ecosistema en su diseño, controlando la forma en que se accede, se utiliza y se protege la información en el conjunto de la dataesfera.

Así se podría garantizar que los datos sean utilizados de manera segura, ética y responsable para el conjunto del ecosistema y no sólo en casos individuales o aislados. Por ejemplo, algunas de las nuevas herramientas de gobernanza de datos que hace ya tiempo que se están experimentando y nos pueden servir a la hora de gestionar la dataesfera de forma colectiva son los data commons o bienes digitales de datos, los data trusts o fideicomisos de datos, las cooperativas de datos, o los data collaboratives o colaboraciones de datos, entre otros.

El futuro de la dataesfera

La dataesfera seguirá creciendo y evolucionando en los próximos años, impulsada una vez más por los nuevos avances tecnológicos y el aumento de la conectividad y la ubicuidad de los sistemas. Será importante que los gobiernos y las organizaciones se mantengan al día de estos cambios y adapten sus estrategias de gobierno y gestión de datos en consecuencia mediante marcos regulatorios sólidos, acompañados de pautas éticas y prácticas responsables que aseguren que los beneficios que nos prometen la explotación de los datos se puedan finalmente materializar al mismo tiempo que se minimizan los riesgos.

Para poder atender adecuadamente estos desafíos, y aprovechar así todo el potencial de la dataesfera para un cambio positivo y por el bien común, será esencial dejar de pensar en los datos como algo que podamos tratar de forma aislada y adoptar un enfoque basado en sistemas que reconozca la naturaleza interconectada de los datos y su impacto en el conjunto de la sociedad.

Hoy en día, podríamos considerar que los espacios comunes de datos (data spaces), que la Comisión Europea lleva ya algún tiempo desarrollando como parte clave de su nueva estrategia de datos, son precisamente una evolución lógica del concepto de la dataesfera adaptada a las necesidades particulares de nuestro tiempo y actuando sobre todos los componentes del ecosistema simultáneamente: técnico, funcional, operacional, legal y de negocio.

Contenido elaborado por Carlos Iglesias, Open data Researcher y consultor, World Wide Web Foundation.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La ‘Estrategia europea de datos’ de la Comisión Europea establece que es clave la creación de un mercado único de datos compartidos. En dicha estrategia, la Comisión se ha marcado como uno de sus principales objetivos el impulso de una economía del dato acorde a los valores europeos de autodeterminación en la compartición de datos (soberanía), confidencialidad, transparencia, seguridad y competencia justa.

Los espacios de datos comunes a nivel europeo son un recurso fundamental en la estrategia de datos porque actúan como habilitadores del impulso de la economía del dato. De hecho, poner en común los datos europeos de sectores clave, fomentar la circulación de los datos y crear espacios de datos colectivos e interoperables son acciones que contribuyen al beneficio de la sociedad.

Aunque los entornos de compartición de datos existen desde hace tiempo, se plantea la creación de espacios de datos que garanticen los valores y principios de la UE. Desarrollar iniciativas legislativas que los habiliten no solo es un reto tecnológico, sino también de coordinación entre los participantes, de gobernanza, de adopción de estándares y de interoperabilidad.

Para abordar un desafío de tal magnitud, la Comisión tiene previsto invertir cerca de 8.000 millones de euros hasta 2027 en el despliegue de la transformación digital europea. Como parte del proyecto se incluye el fomento de infraestructuras, herramientas, arquitecturas y mecanismos para compartir datos. Para que triunfe esta estrategia es necesario que, desde el cumplimiento de los valores europeos, se plantee un paradigma de espacio de datos que tenga calado en la industria. Este paradigma de espacio de datos actuará como un estándar tecnológico de facto y permitirá que avance la concienciación social sobre las posibilidades del dato, algo que posibilitará el retorno económico de las inversiones requeridas para crearlo.

Con el fin de hacer realidad el paradigma de espacios de datos, desde la convergencia de las actuales iniciativas, la Comisión Europea ha apostado por el desarrollo del proyecto Simpl.

¿En qué consiste exactamente Simpl?

Simpl es un proyecto financiado por el programa Digital Europe de la Comisión Europea, dotado con 150 millones de euros y con un plazo de ejecución de tres años. Su objetivo es poner a disposición de la sociedad un software (middleware) para la construcción de ecosistemas de datos y servicios de infraestructuras en la nube que soporten los valores europeos de soberanía el dato, privacidad y mercado justo.

El proyecto Simpl consiste en la entrega de 3 productos:

- Simpl-Open: Middleware propiamente dicho. Se trata de una solución de software para crear ecosistemas de servicios de datos (compartición de datos y aplicaciones) y servicios de infraestructura en la nube (IaaS, PaaS, SaaS, etc). Este software debe incluir agentes que habiliten la conexión al espacio de datos, servicios operacionales y servicios de intermediación (catálogo, vocabulario, registro de actividad, etc). El resultado deberá entregarse bajo licencia de fuentes abiertas y se intentará construir una comunidad open source que garantice su evolución.

- Simpl-Labs: Infraestructura para crear entornos de trabajo de pruebas (test bed) para que los usuarios interesados pueden probar la última versión del software en la modalidad de autoservicio. Este entorno está pensado principalmente para promotores de espacios de datos que quieran hacer las oportunas pruebas técnicas antes de un despliegue.

- Simpl-Live: Despliegues de Simpl-open en entornos de producción que se corresponderán a espacios sectoriales contemplados en el programa Digital Europe. En concreto, se plantea el despliegue de espacios de datos gestionados por la propia Comisión Europea (Salud, Procurement, Lenguaje).

El proyecto tiene una orientación práctica y busca obtener resultados a la mayor brevedad. Por lo que se pretende que, además de suministrar el software, el contratista preste un servicio de laboratorio para que los usuarios puedan realizar pruebas. La empresa que desarrolle Simpl también deberá adaptar el software para el despliegue de espacios de datos comunes europeos previstos en el programa Digital Europe.

La asociación Gaia-X está considerada como la más próxima en sus objetivos al proyecto Simpl, así que el resultado del proyecto deberá esforzarse en la reutilización de los componentes que Gaia-X ponga a su disposición.

Por su parte, el centro Data Space Support Center, en el que participan las principales iniciativas europeas de creación de marcos tecnológicos y estándares para la construcción de espacios de datos, deberá definir los requisitos del middleware mediante especificaciones, modelos arquitectónicos y selección de estándares.

Los trabajos preparatorios de Simpl finalizaron en mayo de 2022, fijando el alcance y los requerimientos técnicos del proyecto que han sido objeto de detalle en el proceso contractual actualmente abierto. La licitación se puso en marcha el pasado 24 de febrero de 2023. Toda la información está disponible en TED eTendering, incluida la manera de formular preguntas sobre el proceso de licitación. El plazo para la presentación de solicitudes finaliza el 24 de abril de 2023 a las 17: 00 (hora de Bruselas).

Simpl espera disponer de una plataforma viable mínima publicada a principios de 2024. Paralelamente, y lo antes posible, el entorno abierto de pruebas (Simpl-Labs) se pondrá a disposición de las partes interesadas en experimentar. A continuación, se procederá a integrar progresivamente diferentes casos de uso, ayudándolos a ajustar Simpl a las necesidades específicas, considerando prioritarios los casos financiados de otro modo en el marco del programa de trabajo Europa DIGITAL.

Como conclusión, cabe remarcar que Simpl es la apuesta de la Comisión Europea para el despliegue e interoperabilidad de las diferentes iniciativas de espacios de datos sectoriales, garantizándose su concordancia con las especificaciones y requisitos emanados del Data Space Support Center y, por tanto, con el proceso de convergencia de las diferentes iniciativas europeas de construcción de espacios de datos (Gaia-X, IDSA, Fiware, BDVA).

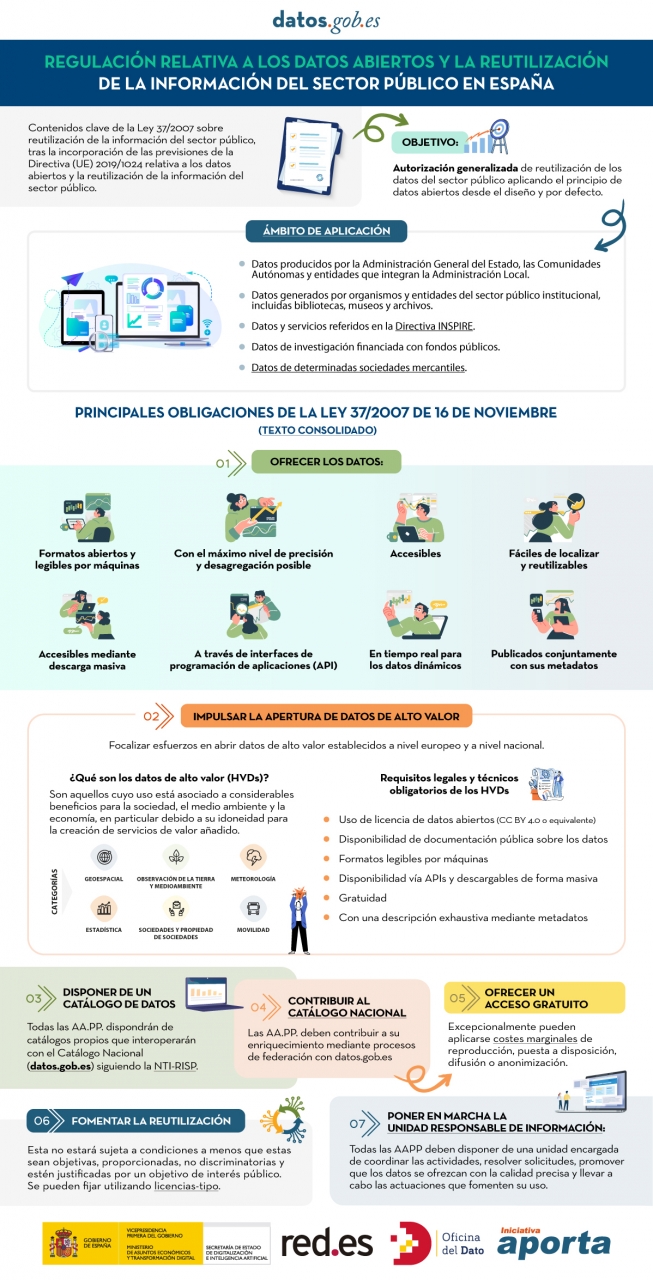

El sector público en España tendrá el deber de garantizar la apertura de sus datos desde el diseño y por defecto, así como su reutilización. Así lo recoge la modificación de la Ley 37/2007 sobre la reutilización de la información del sector público en aplicación de la Directiva Europea 2019/1024.

Esta nueva redacción de la norma busca ampliar el ámbito de aplicación de la Ley para acercar las garantías y obligaciones jurídicas al contexto tecnológico, social y económico actual. En este escenario, la normativa vigente tiene en cuenta que una mayor disponibilidad de los datos del sector público puede contribuir al desarrollo de tecnologías tan punteras como la inteligencia artificial y todas sus aplicaciones.

Además, esta iniciativa está alineada con la Estrategia de datos de la Unión Europea dirigida a la creación de un mercado único de datos en el que la información fluya libremente entre los estados y el sector privado en un intercambio que beneficie ambas partes.

De los datos de alto valor a la unidad responsable de información: obligaciones de la Ley 37/2007

En la siguiente infografía, destacamos las principales obligaciones que recoge el texto consolidado de la ley. Se enfatiza en deberes como impulsar la apertura de datos de alto valor (HVDS, por sus siglas en inglés, High Value Datasets), es decir, conjuntos de datos con un gran potencial para generar beneficios sociales, medioambientales y económicos. Tal y como dicta la Ley, los HVDS deberán publicarse con licencia de atribución de datos abiertos (CC BY 4.0 o equivalente), en formato legible por máquinas y acompañados de metadatos que describan las características de los conjuntos de datos. Todo ello será de acceso público y gratuito con el objetivo de incentivar el desarrollo tecnológico, económico y social, especialmente de las PYMEs.

Además de la publicación de los datos de alto valor, todas las administraciones públicas tendrán la obligación de disponer de catálogos propios de datos que interoperarán con el Catálogo Nacional siguiendo la NTI-RISP, con el objetivo de contribuir a su enriquecimiento. Como ocurre con los HVDS, el acceso a los conjuntos de datos de las AA. PP. deberá ser gratuito salvo excepciones en las que se podrían aplicar costes marginales resultado del tratamiento de los datos.

Para garantizar la gobernabilidad del dato, la ley establece la necesidad de designar una unidad responsable de información para cada entidad que coordine la apertura y reutilización de los datos, y que se encargue de responder a las solicitudes y demandas ciudadanas.

En definitiva, la Ley 37/2007, ha sido modificada con el objetivo de ofrecer garantías jurídicas a las exigencias de competitividad e innovación que suscitan tecnologías como la inteligencia artificial o el internet de las cosas, así como a realidades como los espacios de datos donde los datos abiertos se presentan como una pieza clave.

Haz clic en la infografía para verla a tamaño real:

El pasado 21 de febrero tuvo lugar la entrega de premios a los ganadores de la VI edición del Concurso de Datos Abiertos de Castilla y León. Esta competición, organizada por la Consejería de la Presidencia de la Junta de Castilla y León, reconoce la realización de proyectos que suministran ideas, estudios, servicios, sitios web o aplicaciones móviles, utilizando para ello conjuntos de datos de su Portal de Datos Abiertos.

El acto ha contado con la participación entre otros, de Jesús Julio Carnero García, Consejero de la Presidencia, y Rocío Lucas Navas, Consejera de Educación de la Junta de Castilla y León.

En su discurso, el consejero Jesús Julio Carnero García ha destacado que la Junta va a poner en marcha el proyecto de Gobierno del Dato, con el que pretenden sumar Transparencia y Datos Abiertos, para de este modo, mejorar los servicios que ofrecidos a los ciudadanos.

Así, el proyecto de Gobierno del Dato cuenta con una asignación aprobada de casi 2,5 millones de euros de los Fondos Next Generation, que incluye dos líneas de trabajo: tanto el diseño e implantación del modelo de Gobierno del Dato, como la capacitación de los empleados públicos.

Se trata de una acción de Gobierno abierto que, según ha añadido el propio Consejero, “tiene una estrecha relación con la transparencia, puesto que pretendemos que los Datos Abiertos estén disponibles de forma libre para todo el mundo, sin restricciones de copyright, patentes u otros mecanismos de control o registro”.

Nueve premiados en la VI edición del concurso de Datos Abiertos de Castilla y León

Es precisamente en este contexto donde destacan iniciativas como la VI edición del Concurso de Datos Abiertos de Castilla y León. En su sexta convocatoria, ha recibido un total de 26 propuestas procedentes de León, Palencia, Salamanca, Zamora, Madrid y Barcelona.

De esta forma, los 12.000 euros repartidos en las cuatro categorías definidas en las bases han quedado repartidos entre nueve de las propuestas mencionadas anteriormente. Así ha quedado el palmarés de galardones distribuido por categorías:

Categoría Productos y Servicios: destinada a reconocer proyectos que proporcionen estudios, servicios, sitios web o aplicaciones para dispositivos móviles y que estén accesibles para toda la ciudadanía vía web mediante una URL.

- Primer premio: 'Oferta de Formación profesional de Castilla y León. Una alternativa atractiva y accesible con herramientas no-cod'”. Autora: Laura Folgado Galache. (Zamora). 2.500 euros.

- Segundo premio: 'Enjoycyl: recogida y explotación de asistencia y valoración de actividades culturales'. Su autor es José María Tristán Martín. (Palencia) 1.500 euros.

- Tercer premio: 'Aplicación del problema de la p-mediana a la Atención Primaria en Castilla y León'. Autores: Carlos Montero y Ernesto Ramos (Salamanca) 500 euros.

- Premio estudiantes: 'Play4CyL'. Sus autores son Carlos Montero y Daniel Heras (Salamanca) 1.500 euros.

Categoría Ideas: busca premiar proyectos que describan una idea para desarrollar estudios, servicios, sitios web o aplicaciones para dispositivos móviles.

- Primer premio: 'Elige tu Universidad (Castilla y León)'. Autores: Maite Ugalde Enríquez y Miguel Balbi Klosinski (Barcelona) 1.500 euros.

- Segundo premio: 'Bots para interactuar con datos abiertos – Interfaces conversacionales para facilitar el acceso a los datos públicos (BODI)'. Autores: Marcos Gómez Vázquez y Jordi Cabot Sagrera (Barcelona) 500 euros.

Categoría Periodismo de Datos: premia piezas periodísticas publicadas o actualizadas (de forma relevante) en cualquier soporte (escrito o audiovisual).

- Primer premio: 'Elecciones 13-F en Castilla y León: habrá 186 colegios electorales menos que en las autonómicas de 2019'. Autores: Asociación Maldita contra la desinformación (Madrid) 1.500 euros.

- Segundo premio: 'Más de 2.500 alcaldes no cobraron nada de su ayuntamiento en 2020 y otros 1.000 no han informado de su sueldo'. Autores: Asociación Maldita contra la desinformación (Madrid). 1.000 euros.

Categoría Recurso Didáctico: reconoce la creación de recursos didácticos abiertos (publicados con licencias Creative Commons) nuevos e innovadores que sirvan de apoyo a la enseñanza en el aula.

En definitiva y tal y como apuntan desde la misma Consejería de la Presidencia, con este tipo de iniciativas y el Portal de Datos Abiertos se cumplen dos principios básicos: en primer lugar, el de transparencia, al poner a disposición de toda la sociedad datos generados por la Administración de la Comunidad en el desarrollo de sus funciones, en formatos abiertos y con una licencia libre para su uso; y en segundo lugar, el de colaboración, permitiendo el desarrollo de iniciativas compartidas que aporten mejoras sociales y económicas a través del trabajo conjunto entre la ciudadanía y las administraciones públicas.

16.500 millones de euros. Esos son los ingresos que se estima generarán la inteligencia artificial (IA) y los datos en la industria española para 2025, según se avanzó el pasado febrero en el foro de IndesIA, la asociación para la aplicación de la inteligencia artificial en la industria. La IA ya forma parte de nuestro día a día: ya sea haciendo más sencillo nuestro trabajo al realizar tareas rutinarias y repetitivas, o bien complementando las capacidades humanas en diversos ámbitos a través de modelos de aprendizaje automático que facilitan, por ejemplo, el reconocimiento de imágenes, la traducción automática o la predicción de diagnósticos médicos. Todas ellas, actividades que nos ayudan a mejorar la eficiencia de negocios y servicios, impulsando una toma de decisiones más certera.

Pero para que los modelos de aprendizaje automático (también conocidos por el término en inglés machine learning) funcionen correctamente, se necesitan datos de calidad y bien documentados. Todo modelo de aprendizaje automático se entrena y evalúa con datos. Las características de estos conjuntos de datos condicionan el comportamiento del modelo. Por ejemplo, si los datos de entrenamiento reflejan sesgos sociales no deseados es probable que estos también se incorporen en el modelo, lo cual puede tener graves consecuencias cuando se utiliza en ámbitos de gran importancia, como la justicia penal, la contratación de personas o el préstamo de créditos. Además, si no conocemos el contexto de los datos, puede que nuestro modelo no funcione correctamente, ya que en su proceso de construcción no se han tenido en cuenta las características intrínsecas de los datos sobre los cuales se sustenta.

Por estas y otras razones, el Foro Económico Mundial sugiere que todas las entidades deben documentar la procedencia, la creación y el uso de los conjuntos de datos de aprendizaje automático con el fin de evitar resultados erróneos o discriminatorios.

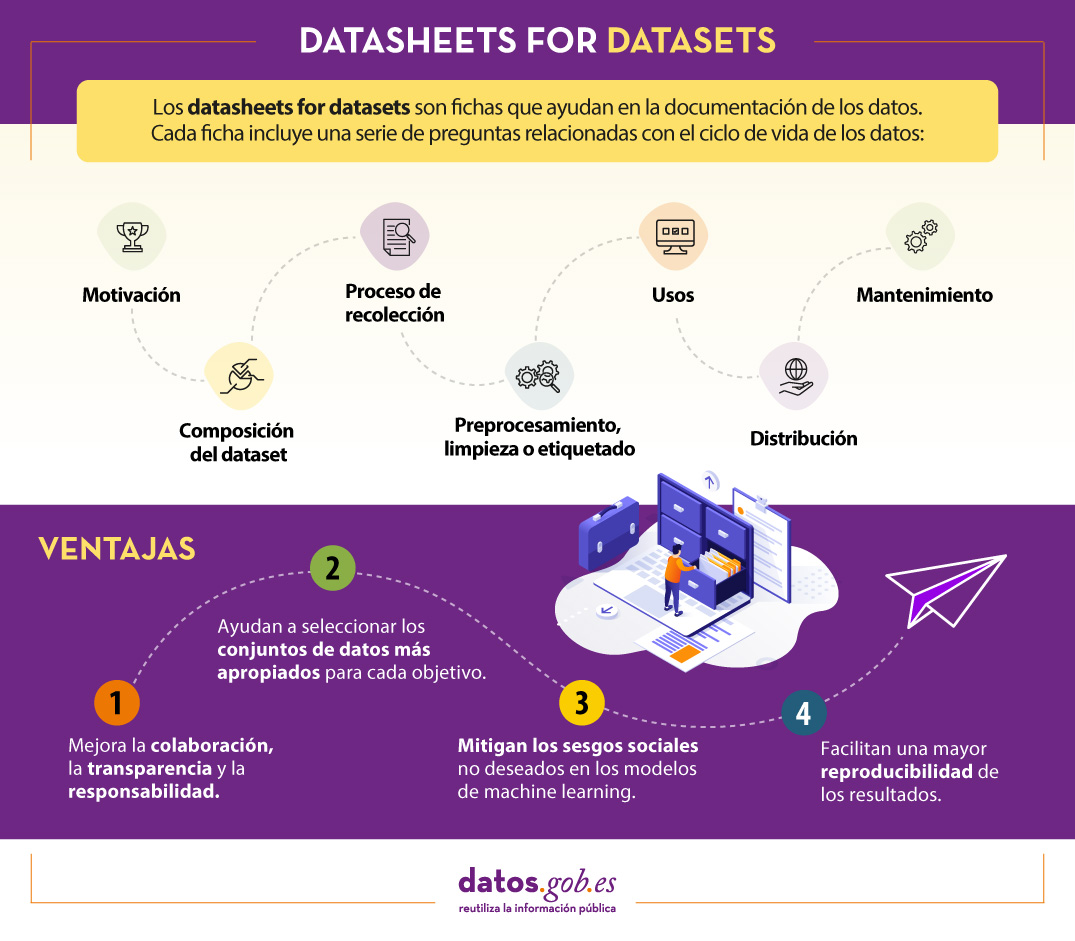

¿Qué son Datasheets for datasets?

Un mecanismo para documentar esta información son las conocidas como Datasheets for datasets. Este marco de trabajo propone que todo conjunto de datos debe ser acompañado de una “ficha de datos”, llamada datasheet, que consiste de un cuestionario que guía en la documentación de los datos y la reflexión a lo largo del ciclo de vida de los datos. Algunas de las ventajas que supone son:

- Mejora la colaboración, la transparencia y la responsabilidad dentro de la comunidad de aprendizaje automático.

- Mitiga los sesgos sociales no deseados en los modelos.

- Ayuda a los investigadores y desarrolladores a seleccionar los conjuntos de datos más apropiados para alcanzar sus objetivos específicos.

- Facilita una mayor reproducibilidad de los resultados.

Los datasheets variarán dependiendo de factores tales como el área de conocimiento, la infraestructura organizacional existente o los flujos de trabajo.

Para ayudar en la creación de las datasheet, se ha diseñado un cuestionario con una serie de preguntas, acordes a las etapas del ciclo de vida de los datos:

- Motivación. Recoge las razones que han llevado a la creación de los conjuntos de datos. También se pregunta sobre quién creó o financió dichos datasets.

- Composición. Ofrece a los usuarios la información necesaria sobre la adecuación del conjunto de datos a sus objetivos. Incluye, entre otras preguntas, qué unidades de observación representan el conjunto de datos (documentos, fotos, personas, países), qué tipo de información ofrece cada unidad o si hay errores, fuentes de ruido o redundancias en él. Reflexiona acerca de los datos que se refieren a personas para evitar posibles sesgos sociales o violaciones a la privacidad.

- Proceso de recolección. Su objetivo es ayudar a los investigadores y usuarios a pensar en cómo crear conjuntos de datos alternativos con similares características. Aquí se detalla, por ejemplo, cómo se adquirieron los datos, quién participó en el proceso de recopilación o cómo fue el proceso de revisión ética. Trata especialmente los aspectos éticos del procesamiento de datos protegidos por la RGPD.

- Preprocesamiento, limpieza o etiquetado. Gracias a estas preguntas, los usuarios de datos podrán determinar si estos han sido procesados de formas compatibles con los usos que les pretenden dar. Indaga sobre si se realizó algún preprocesamiento, limpieza o etiquetado de los datos, o si está disponible el software que se utilizó para preprocesarlos, limpiarlos y etiquetarlos.

- Usos. Esta sección proporciona información sobre aquellas tareas para las cuales los datos pueden o no pueden ser usados. Para ello, se debe responder a preguntas como: ¿El conjunto de datos ya ha sido usado para alguna tarea? ¿Para qué otras tareas pueden ser utilizados? ¿La composición del conjunto de datos o la forma en que se recopiló, preprocesó, limpió y etiquetó puede afectar a otros usos futuros?

- Distribución. Recoge cómo se difundirá el conjunto de datos. Las preguntas se centran en si los datos se distribuirán a terceros y, en caso afirmativo, cómo, cuándo, cuáles son las restricciones de uso y bajo qué licencias.

- Mantenimiento. El cuestionario finaliza con preguntas dirigidas a planificar el mantenimiento de los datos y comunicar el plan a los usuarios de los datos. Por ejemplo, se responde a si se actualizará el conjunto de datos o quién dará soporte.

Se recomienda que todas las preguntas sean tenidas en cuenta antes de la recolección de los datos, para que sus creadores puedan ser conscientes de los posibles problemas. Para ilustrar cómo se podría responder a cada una de ellas en la práctica, los creadores del modelo han elaborado un apéndice con un ejemplo para un conjunto de datos determinado.

¿Es efectivo Datasheets for datasets?

El marco para documentar los datos Datasheets for datasets ha recibido inicialmente buenas críticas, pero su implementación continúa acarreando diversos retos, sobre todo cuando se trabaja con datos dinámicos.

Para conocer si el marco resuelve de forma efectiva las necesidades de documentación de los creadores y los usuarios de los datos, en junio del 2022, Microsoft USA y la Universidad de Michigan llevaron a cabo un estudio sobre su implementación. Para ello realizaron una serie de entrevistas y un seguimiento de la aplicación del cuestionario por parte de varios profesionales del aprendizaje automático.

En resumen, los participantes expresaron la necesidad de que los marcos de documentación sean adaptables a los diferentes contextos, se integren en las herramientas existentes y en los flujos de trabajo, y que sean tan automatizados como sea posible, debido en parte a la extensión de las preguntas. No obstante, también resaltaron sus ventajas, como, por ejemplo, que reduce el riesgo de pérdida de información, promueve la colaboración entre todos los que participan en el ciclo de vida de los datos, facilita el descubrimiento de los datos o impulsa el pensamiento crítico, entre otras.

En definitiva, nos encontramos ante un buen punto de partida, pero que deberá evolucionar, sobre todo para adaptarse a las necesidades de los datos dinámicos y a los flujos de documentación aplicados en diferentes contextos.

Contenido elaborado por el equipo de datos.gob.es.

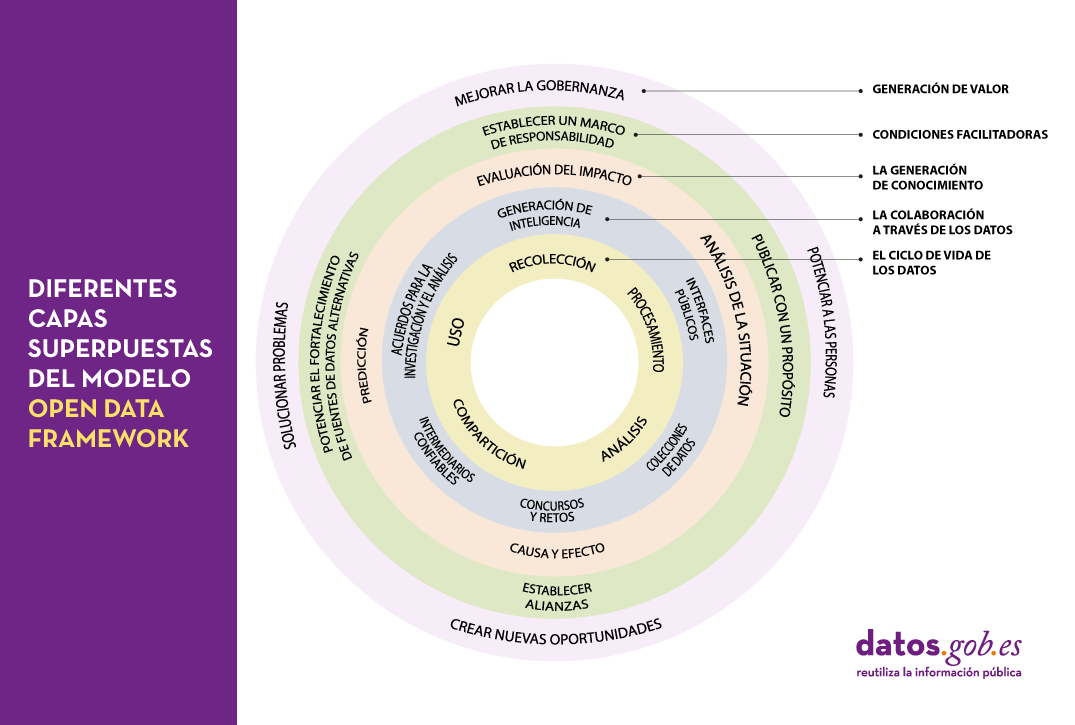

Una de las acciones clave que destacamos recientemente como necesarias para construir el futuro de los datos abiertos en nuestro país es la implantación de procesos para mejorar la gestión y gobernanza de los datos. No en vano, el llevar a cabo una gestión adecuada de los datos en nuestras organizaciones se está convirtiendo en una tarea cada vez más compleja y demandada. Buena muestra de ello es, por ejemplo, que los especialistas en data governance están cada vez más demandados – con más de 45.000 ofertas de empleo activas en Estados Unidos para un rol que hace no mucho era prácticamente inexistente – y docenas de plataformas de gestión de datos ahora se anuncian como data governance platforms.

¿Pero qué es lo que hay realmente detrás de esas palabras clave? ¿Qué es lo que debemos entender realmente por gobernanza de los datos? En realidad, de lo que estamos hablando es de una serie de procesos de transformación bastante complejos que afectan al conjunto de la organización.

Esa complejidad queda perfectamente reflejada en el framework que nos proponen desde el Open Data Policy Lab, donde podemos observar claramente las diferentes capas superpuestas del modelo y cuáles son sus principales características – dando lugar a un recorrido a través de la elaboración de los datos, la colaboración con los datos como herramienta principal, la generación de conocimiento, el establecimiento de las condiciones habilitadoras necesarias y la creación de valor añadido.

Pasemos entonces a continuación a pelar esa cebolla y observemos más en detalle qué es lo que encontraremos en cada una de esas capas:

El ciclo de vida de los datos

Nunca deberíamos considerar los datos como elementos aislados, sino como parte de un ecosistema mayor, que se encuentra inmerso en un ciclo continuo con las siguientes fases:

- Recolección o recopilación de los datos procedentes de distintas fuentes.

- Procesamiento y transformación de los datos para conseguir que sean utilizables.

- Compartición e intercambio de datos entre los distintos miembros de la organización.

- Análisis para extraer el conocimiento que se está buscando.

- Uso de los datos de acuerdo al conocimiento obtenido.

La colaboración a través de los datos

No es extraño que el ciclo de vida de los datos transcurra únicamente dentro de la organización donde se originan. Sin embargo, podremos aumentar el valor de esos datos exponencialmente, simplemente exponiéndolos a la colaboración con otras organizaciones a través de diversos mecanismos, añadiendo así una nueva capa de gestión:

- Interfaces públicos que ofrecen un acceso selectivo a los datos, habilitando nuevos usos y funciones.

- Intermediarios confiables que funcionan como agentes independientes de datos. Estos agentes coordinan el uso de los datos por parte de terceros, garantizando su seguridad e integridad en todo momento.

- Colecciones de datos que ofrecen una visión común, conjunta, completa y coherente de los datos a través de la agregación de porciones procedentes de distintas fuentes.

- Acuerdos para la investigación y el análisis, por los que se garantiza el acceso a ciertos datos con el objetivo de generar un conocimiento específico.

- Concursos y retos que dan acceso a datos específicos durante un periodo limitado de tiempo para promover nuevos usos innovadores de los mismos.

- Generación de inteligencia, mediante la cual se comparten también los conocimientos adquiridos por la organización a través de los datos y no solo la materia prima.

La generación de conocimiento

Gracias a las colaboraciones establecidas en la capa anterior será posible realizar nuevos estudios de los datos que nos permitirán tanto analizar el pasado como tratar de extrapolar el futuro mediante diversas técnicas como:

- Análisis de la situación, conociendo lo que está pasando en el entorno de los datos.

- Causa y efecto, buscando una explicación al origen de lo que está pasando.

- Predicción, intentando inferir que será lo siguiente que va a pasar.

- Evaluación del impacto, estableciendo lo que esperamos que debería suceder.

Condiciones facilitadoras

Existen una serie de procedimientos que cuando se aplican por encima de un ecosistema de datos colaborativo ya existente pueden dar lugar a un uso todavía más efectivo de los datos mediante técnicas como:

- Publicar con un propósito, con el objetivo de coordinar la oferta y la demanda de datos de la forma más eficiente posible.

- Establecer alianzas, incluyendo en nuestros análisis a aquellos grupos de personas y organizaciones que nos puedan ayudar a entender mejor las necesidades reales.

- Potenciar el fortalecimiento de fuentes de datos alternativas proporcionando los recursos necesarios para crear nuevas fuentes de datos en las áreas aún por explotar.

- Establecer un marco de responsabilidad en torno a los datos que tenga en cuenta los principios de equidad, compromiso y transparencia.

Generación de valor

La ampliación del ecosistema y el establecimiento de las condiciones adecuadas para que ese ecosistema florezca pueden dar lugar a economías de datos de escala de las que podremos obtener nuevos beneficios como:

- Mejorar la gobernanza y la operativa de la propia organización gracias a las mejoras generales en transparencia y eficiencia que acompañan a los procesos de apertura.

- Potenciar a las personas proporcionándoles las herramientas que necesitan para realizar sus tareas de la forma más adecuada y tomar las decisiones correctas.

- Crear nuevas oportunidades para la innovación, la creación de nuevos modelos de negocio y la elaboración de políticas públicas dirigidas por la evidencia.

- Solucionar problemas optimizando los procesos y servicios y las intervenciones dentro del sistema en el que operamos.

Como podemos observar, el concepto de gobernanza de los datos es en realidad mucho más amplio y complejo de lo que en principio uno podría esperar y abarca una serie de actuaciones clave y tareas que en la mayoría de organizaciones será prácticamente imposible tratar de centralizar en un único rol o a través de una única herramienta. Por tanto, a la hora de establecer un sistema de gobernanza de datos en una organización deberíamos afrontar el reto como un proceso de transformación integral o un cambio de paradigma en el que prácticamente todos los miembros de la misma deberán estar implicados en mayor o menor medida. Una buena forma de afrontar este reto con mayor facilidad y mejores garantías sería a través de la adopción e implementación de algunos de los marcos y estándares de referencia que se han ido creando al respecto y que se corresponderías con distintas partes de este modelo.

Contenido elaborado por Carlos Iglesias, Open data Researcher y consultor, World Wide Web Foundation.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Transformar los datos en conocimiento se ha convertido en uno de los objetivos principales a los que se enfrentan tanto las organizaciones públicas como privadas en la actualidad. Pero, para poder lograrlo, es necesario partir de la premisa de que los datos tratados están gobernados y son de calidad.

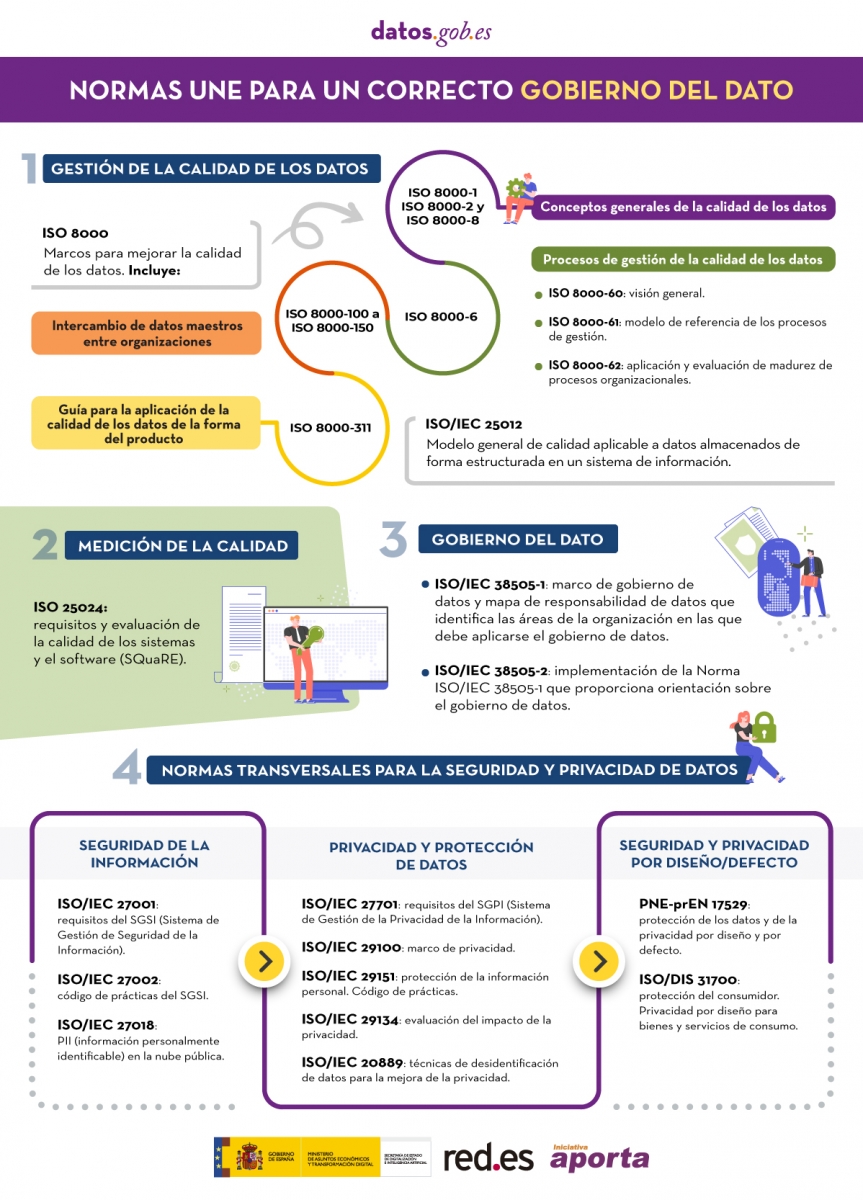

En este sentido, la Asociación Española de Normalización (UNE) ha publicado recientemente un artículo e informe donde se recogen distintas normas técnicas que buscan garantizar que la correcta gestión y gobernanza de los datos de una organización. En este post se recogen ambos materiales, incluyendo una infografía-resumen de las normas destacadas.

En los artículos de referencia señalados se mencionan norman técnicas relativas a gobernanza, gestión, calidad, seguridad y privacidad de datos. En esta ocasión queremos hacer un zoom sobre aquellas centradas en la calidad de los datos.

Estándares de referencia de gestión de la calidad

Tal y como dijo Lord Kelvin, físico y matemático británico del siglo XIX, “lo que no se mide, no se puede mejorar y lo que no se mejora, se degrada siempre”. Pero para medir la calidad del dato y poder mejorarla se necesitan estándares que nos ayuden a homogeneizar primero dicha calidad*. A ello nos pueden ayudar las normas técnicas detalladas a continuación:

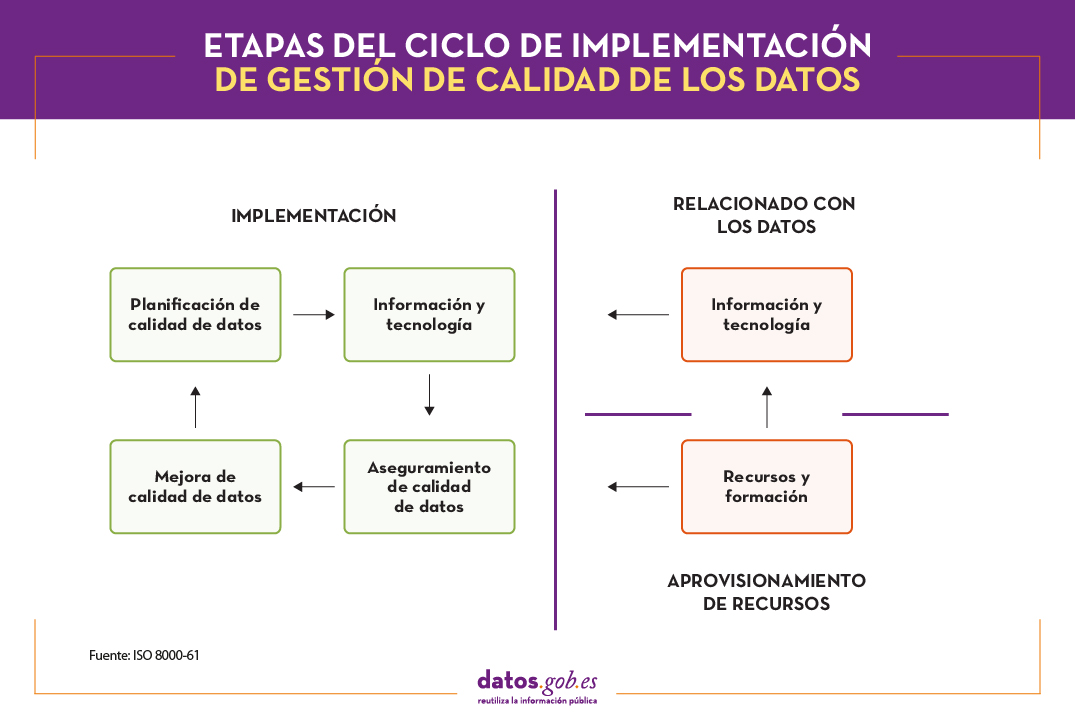

Norma ISO 8000

La normativa ISO (International Organization for Standardization), dispone de la norma ISO 8000 como el estándar internacional para la calidad de los datos de transacción, los datos de producto y los datos maestros empresariales. Esta norma se estructura en 4 partes: conceptos generales de la calidad de los datos (ISO 8000-1, ISO 8000-2 e ISO 8000-8), procesos de gestión de la calidad de los datos (ISO 8000-6x), aspectos relacionados con el intercambio de datos maestros entre organizaciones (partes 100 a 150) y aplicación de la calidad de los datos de producto (ISO 8000-311).

Dentro de la familia de las ISO 8000-6X, centrada en los procesos de gestión de la calidad de los datos para crear, almacenar y transferir los datos que dan soporte a los procesos de negocio de manera oportuna y rentable, encontramos:

- La ISO 8000-60 proporciona una visión general de los procesos de gestión de calidad de los datos sometidos a un ciclo de mejora continua.

- La ISO 8000-61 establece un modelo de referencia de procesos de gestión de calidad de los datos. La principal característica es que, para alcanzar la mejora continua, el proceso de implementación debe ser ejecutado continuamente siguiendo el ciclo Plan-Do-Check-Act. Además, se incluyen procesos de implementación relacionados con el aprovisionamiento de los recursos y el procesamiento de datos. Tal y como se muestra en la siguiente imagen, las cuatro etapas del ciclo de implementación deben disponer de datos de entrada, información de control y soporte para una mejora continua, así como contar con los recursos necesarios para el desempeño de las actividades.

- Por su parte, la ISO 8000-62, la última de la familia de las ISO 8000-6X, se enfoca en la evaluación de madurez de procesos organizacionales. En ella se especifica un marco de trabajo para evaluar la madurez de la gestión de la calidad de datos de la organización, basado en su capacidad de ejecutar las actividades relacionadas con los procesos de gestión de la calidad de datos identificados en la ISO 8000-61. En función de la capacidad del proceso evaluado, se asigna uno de los niveles definidos.

Norma ISO 25012

Otra de las normas ISO que trata sobre la calidad de los datos es la familia de las ISO 25000, que tiene por objetivo la creación de un marco de trabajo común para evaluar la cvalidad del producto de software. En concreto, la norma ISO 25012 define un un modelo general de calidad de datos aplicable a datos almacenados de forma estructurada en un sistema de información.

Además, en el contexto de datos abiertos se considera una referencia de acuerdo al conjunto de buenas prácticas para la evaluación de la calidad de los datos abiertos desarrollado por la red paneuropea Share-PSI, concebida para servir de orientación a todas las organizaciones públicas a la hora de compartir información.

En este caso, la calidad del producto de datos se entiende como el grado en que estos satisfacen los requisitos definidos previamente en el modelo de calidad de datos mediante las siguientes 15 características.

Estas características o dimensiones de calidad, se clasifican principalmente en dos categorías.

La calidad de datos inherente se relaciona con el potencial intrínseco de los datos de satisfacer las necesidades definidas cuando se utilizan en condiciones concretas. Se trata de:

- Exactitud: grado en el que los datos representan el verdadero valor del atributo deseado en un contexto específico, como pueda ser la cercanía de los datos a un conjunto de valores definidos en un determinado dominio.

- Completitud: grado en el que los datos asociados tienen valor para todos los atributos definidos.

- Consistencia: grado de coherencia con otros datos existentes, eliminando contradicciones.

- Credibilidad: grado en que los datos tienen atributos que se consideran ciertos y creíbles en su contexto, incluyendo la veracidad de los orígenes de datos.

- Actualidad: grado de vigencia de los datos para su contexto de uso.

Por otro lado, la calidad de datos dependiente del sistema se relaciona con el grado alcanzado a través de un sistema informático bajo condiciones concretas. Se trata de:

- Disponibilidad: grado en que los datos tienen atributos que permiten ser obtenidos por usuarios autorizados.

- Portabilidad: capacidad de los datos de ser instalados, reemplazados o eliminados de un sistema a otro, preservando el nivel de calidad.

- Recuperabilidad: grado en que los datos tienen atributos que permiten mantener y preservar la calidad incluso en caso de fallos.

Adicionalmente, hay características o dimensiones que pueden englobarse tanto dentro de calidad de datos inherente como dependiente del sistema. Estas son:

- Accesibilidad: posibilidad de acceso a los datos en un contexto concreto por unos roles determinados.

- Conformidad: grado en que los datos contienen atributos en base a estándares, normativas o referencias establecidas.

- Confidencialidad: mide el grado de aseguramiento de los datos en base a su naturaleza para poder acceder a ellos solo por los roles configurados.

- Eficiencia: posibilidades que ofrecen los datos para ser procesados con niveles de rendimiento esperados en situaciones concretas.

- Precisión: exactitud de los datos en base a un contexto de uso específico.

- Trazabilidad: capacidad de auditar el ciclo de vida completo del dato.

- Comprensibilidad: capacidad de los datos de ser interpretados por cualquier usuario, incluyendo la utilización de símbolos y lenguajes determinados para un contexto específico.

Además de las normas ISO, existen otros marcos de referencia que establecen pautas comunes para la medición de la calidad. DAMA Internacional, por ejemplo, tras analizar las similitudes de todos los modelos, establece 8 dimensiones de calidad básicas comunes a cualquier estándar: exactitud, completitud, consistencia, integridad, razonabilidad, oportunidad, unicidad, validez.

La necesidad de mejora continua

La homogeneización de la calidad de los datos de acuerdo a estándares de referencia como los descritos, permiten asentar las bases para una mejora continua de la información. A partir de la aplicación de estas normas, y teniendo en cuenta las dimensiones detalladas, es posible definir indicadores de calidad. Una vez se implementen y ejecuten, arrojarán unos resultados que tendrán que ser revisados por los diferentes propietarios de los datos, estableciendo umbrales de tolerancia e identificando así incidencias de calidad en todos aquellos indicadores que no superen el umbral definido.

Para ello, se tendrán en cuenta diferentes parámetros como la naturaleza del dato o su impacto en el negocio, ya que no se puede tratar de igual forma un campo descriptivo que una clave primaria, por ejemplo.

A partir de ahí, es frecuente poner en marcha un circuito de resolución de incidencias capaz de detectar la causa raíz que genera una deficiencia de calidad en un dato para extraerla y garantizar la mejora continua.

Gracias a ello, se obtienen innumerables beneficios, como minimizar riesgos, ahorro de tiempo y recursos, toma ágil de decisiones, adaptación a nuevos requerimientos o mejora reputacional.

Cabe destacar que las normas técnicas abordadas en este post permiten homogeneizar la calidad. Para tareas de medición de la calidad de los datos per se, deberíamos acudir a otras normas como la ISO 25024:2015.

Contenido elaborado por Juan Mañes, experto en Data Governance.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El dato es un pilar clave de la transformación digital. Los datos confiables y de calidad son la base de todo, desde las principales decisiones estratégicas hasta el proceso operativo de rutina, son fundamentales en el desarrollo de los espacios de datos, así como la base de soluciones disruptivas ligadas a ámbitos tales como la inteligencia artificial o el Big Data.

En este sentido, la correcta gestión y gobierno de los datos se ha convertido en una actividad estratégica para todo tipo de organizaciones, públicas y privadas.

La normalización del gobierno del dato se basa en 4 principios:

- Gobernanza

- Gestión

- Calidad

- Seguridad y privacidad de datos

Aquellas organizaciones que quieran implementar un marco de gobierno sólido basado en estos pilares tienen a su disposición una serie de normas técnicas que proveen de principios guiadores para garantizar que los datos de una organización son correctamente gestionados y gobernados, tanto internamente como por contrataciones externas.

Con el objetivo de intentar aclarar las dudas en esta materia, la Asociación Española de Normalización (UNE), ha publicado varios materiales de apoyo.

El primero es un artículo sobre las distintas normas técnicas a considerar a la hora de desarrollar un gobierno del dato efectivo. Las normas recogidas en dicho artículo, junto a alguna adicional, se resumen en la siguiente infografía:

(Puedes descargar la versión accesible en word aquí)

Además, la UNE también ha publicado el informe “Estándares para la economía del dato”, que se puede descargar al final de este artículo. El informe comienza con una introducción donde se profundiza en el contexto legislativo europeo que está impulsando la Economía del dato y el reconocimiento que en él se hace de la normalización técnica como una herramienta clave a la hora de alcanzar los objetivos fijados. A continuación, se analizan de manera más detallada las normas técnicas incluidas en la infografía anterior.

Los datos han ocupado un lugar fundamental en los últimos años en nuestra sociedad. Las nuevas tecnologías han permitido una globalización basada en el dato en la que todo lo que ocurre en el mundo está interconectado. Mediante sencillas técnicas es posible extraer de ellos un valor que resultaba inimaginable hace tan sólo algunos años. Sin embargo, para poder hacer un uso correcto de los datos, es necesario disponer de una buena documentación, a través de un diccionario de datos.

¿Qué es un diccionario de datos?

Es frecuente que cuando hablamos de diccionario de datos su significado se confunda con el de glosario de negocio o con el de vocabulario de datos, sin embargo, son conceptos distintos.

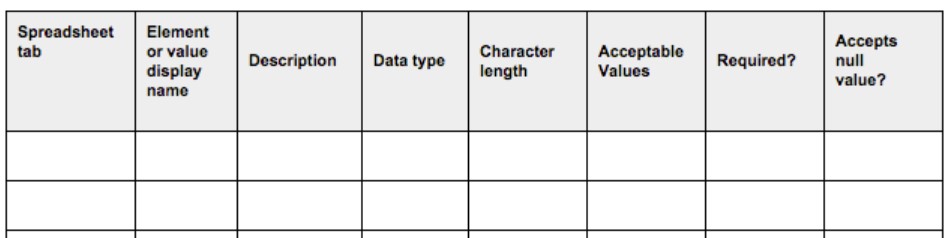

Mientras que un glosario de negocio, o vocabulario de datos, trata de dar significado funcional a los indicadores o conceptos que se manejan de forma que se garantice que se hable el mismo lenguaje, abstrayéndose del mundo técnico, tal y como se explica en este artículo, un diccionario de datos trata de documentar los metadatos más ligados a su almacenamiento en la base de datos. Es decir, incluye aspectos técnicos como el tipo de dato, formato, longitud, posibles valores que puede tomar e, incluso, transformaciones sufridas, sin olvidar la definición de cada campo. La documentación de estas transformaciones nos proporcionará automáticamente el linaje del dato, entendido como la trazabilidad a lo largo de su ciclo de vida. Estos metadatos ayudan a los usuarios a entender los datos desde el punto de vista técnico para poder explotarlos adecuadamente. Por este motivo, cada base de datos debería contar con su diccionario de datos asociado.

Para la cumplimentación de los metadatos solicitados en un diccionario de datos, existen guías y plantillas prediseñadas como el siguiente ejemplo proporcionado por el Departamento de Agricultura de los EEUU.

Además, para poder estandarizar su contenido, es frecuente el uso de taxonomías y vocabularios controlados para codificar los valores de acuerdo a listados de códigos.

Por último, un catálogo de datos, actúa como directorio para localizar la información y ponerla a disposición de los usuarios, proporcionando a todos los usuarios un único punto de referencia para el acceso a los mismos. Esto es posible gracias a los puentes trazados entre los términos funcionales y técnicos, a través del linaje.

Aplicabilidad en datos abiertos

Cuando hablamos de datos abiertos, los diccionarios de datos adquieren mayor importancia si cabe, ya que, al ponerse a disposición de terceros, su alcance de usabilidad es mucho mayor.

Cada conjunto de datos debería publicarse junto a su diccionario de datos que describa el contenido de cada columna. Por eso, cuando se publique un conjunto de datos abiertos, se debería publicar también una URL al documento que contenga su diccionario de datos, independientemente de su formato. En los casos que se requiera más de un Diccionario de Datos, debido a la variedad de las fuentes origen, deberá añadirse tantos como sean necesarios, generalmente uno por base de datos o tabla.

No obstante, desgraciadamente, es fácil encontrar conjuntos de datos extraídos directamente desde sistemas de información sin una adecuada preparación y sin un diccionario de datos asociado facilitado por los publicadores. Esto puede deberse a diversos factores, como el desconocimiento de este tipo de herramienta que facilita la documentación, el no saber con certeza cómo crear un diccionario, o simplemente, dar por hecho que el usuario conoce el contenido de los campos.

Sin embargo, las consecuencias de publicar datos sin documentarlos correctamente pueden provocar que el usuario vea datos referidos a siglas o nombres técnicos ilegibles, imposibilitando su tratamiento o, incluso, un uso inadecuado de los mismos debido a la ambigüedad y a la malinterpretación de los contenidos.

Para facilitar la creación de este tipo de documentación existen estándares y recomendaciones técnicas de algunos organismos. Por ejemplo, el World Wide Web Consortium (W3C), organismo que desarrolla los estándares que aseguren el crecimiento de la world wide web en el largo plazo, ha emitido un modelo en el que recomienda cómo publicar datos tabulares como CSV y metadatos en la web.

Interpretar los datos que se publican

Un ejemplo de una buena publicación de datos lo encontramos en este conjunto de datos publicado por el Instituto Nacional de Estadística (INE) y disponible en datos.gob.es, donde se indica “el número de personas entre 18 y 64 años de edad según idiomas maternos y no maternos más frecuentes que pueden usar, por características de los progenitores”. Para su interpretación, el INE aporta todos los detalles necesarios para su entendimiento en una URL, como las unidades de medida, las fuentes, periodo de validez, alcance y la metodología que sigue para la confección de estas encuestas. Además, proporciona nombres funcionales auto explicativos a cada columna para asegurar el entendimiento de su significado por parte de cualquier usuario ajeno al INE. Todo ello, permite al usuario conocer con certeza la información que descarga para su consumo, evitando malentendidos. Esta información se comparte en el apartado de “recursos relacionados”, pensado para este propósito. Se trata de un metadato que describe la propiedad dct:references.

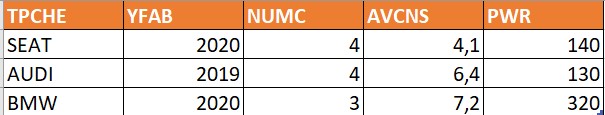

Aunque este ejemplo pueda parecernos lógico, no es raro encontrar casos en el lado opuesto. A modo ilustrativo, se muestra un ejemplo ficticio de conjunto de datos de la siguiente forma:

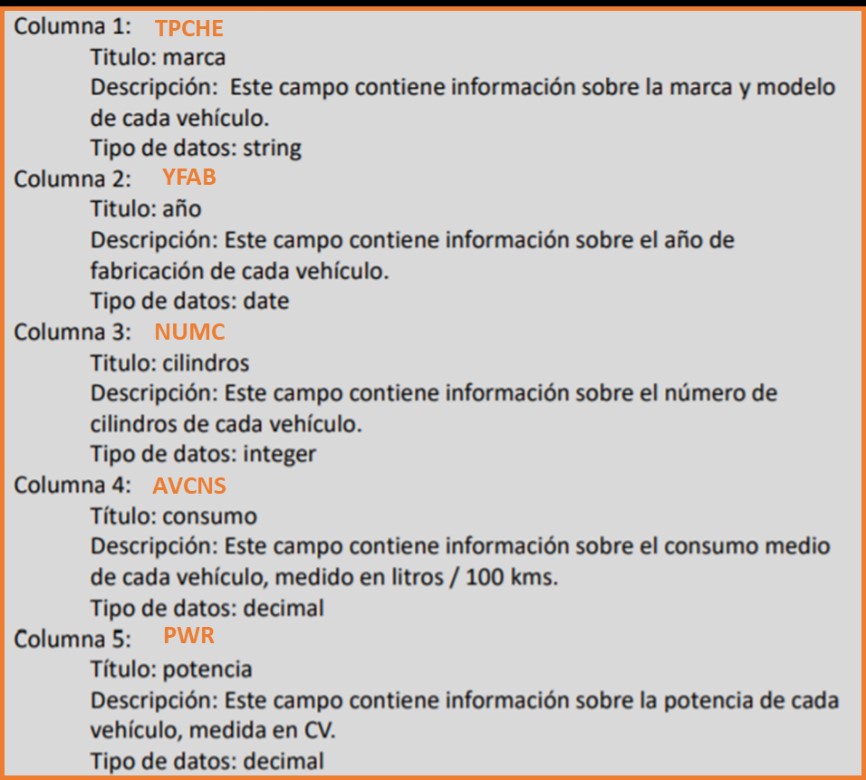

En este caso, un usuario que desconozca la base de datos, no sabrá interpretar correctamente el significado de los campos “TPCHE”, “YFAB”, “NUMC” … Sin embargo, si esta tabla viene asociada con un diccionario de datos, podremos relacionar el metadato con el conjunto, tal y como se muestra en la siguiente imagen:

En este caso, se ha optado por la publicación del diccionario de datos mediante un documento de texto que describe los campos, aunque existen multitud de formas de publicar los diccionarios. Puede realizarse siguiendo recomendaciones y estándares, como la antes mencionada por el W3C, mediante archivos de texto, como en este caso, o incluso, mediante plantillas de Excel customizadas por el propio publicador. No existe una forma mejor que otra por regla general, sino que debe adaptarse a la naturaleza y complejidad del conjunto de datos con el objetivo de asegurar su comprensión, planificando el nivel de detalle necesario en función del objetivo final, la audiencia receptora de los datos y las necesidades de los consumidores, tal y como se explica en este post.

Los datos abiertos nacen con el objetivo de facilitar la reutilización de la información para todo el mundo, pero para que dicho acceso sea realmente útil, no puede limitarse únicamente a la publicación de conjuntos de datos en bruto, sino que deben estar claramente documentados para un correcto tratamiento. La elaboración de diccionarios de datos que incluyan los detalles técnicos de los conjuntos de datos que se publican, es fundamental para la correcta reutilización de los mismos y la extracción de valor a partir de ellos.

Contenido elaborado por Juan Mañes, experto en Data Governance.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.