La visualización de datos es una práctica fundamental para democratizar el acceso a la información pública. Sin embargo, crear gráficos efectivos va mucho más allá de elegir colores atractivos o utilizar las últimas herramientas tecnológicas. Como señala Alberto Cairo, experto en visualización de datos y docente de la academia del portal europeo de datos abiertos (data.europa.eu), “cada decisión de diseño debe ser deliberada: inevitablemente subjetiva, pero nunca arbitraria”. A través de una serie de tres webinar que puedes volver a ver aquí, el experto ofreció consejos innovadores para estar a la vanguardia de la visualización de datos.

Cuando trabajamos con visualización de datos, especialmente en el contexto de la información pública, es crucial desmontar algunos mitos arraigados en nuestra cultura profesional. Frases como "los datos hablan por sí mismos", "una imagen vale más que mil palabras" o "muestra, no cuentes" suenan bien, pero esconden una verdad incómoda: los gráficos no siempre comunican automáticamente.

La realidad es más compleja. Un/a profesional del diseño puede querer comunicar algo específico, pero los lectores pueden interpretar algo completamente diferente. ¿Cómo se puede superar la brecha entre intención y percepción en visualización de datos? En este post, ofrecemos algunas claves de la serie formativa.

Un marco estructurado para diseñar con propósito

En lugar de seguir "reglas" rígidas o aplicar plantillas predefinidas, en el curso se propone un marco de pensamiento basado en cinco componentes interrelacionados:

- Contenido: la naturaleza, origen y limitaciones de los datos

- Personas: la audiencia a la que nos dirigimos

- Intención: los propósitos que definimos

- Restricciones: las limitaciones que enfrentamos

- Resultados: cómo es recibido el gráfico

Este enfoque holístico nos obliga a preguntarnos constantemente: ¿qué necesitan realmente saber nuestros lectores? Por ejemplo, cuando comunicamos información sobre riesgos de huracanes o emergencias sanitarias, ¿es más importante mostrar trayectorias exactas o comunicar impactos potenciales? La respuesta correcta depende del contexto y, sobre todo, de las necesidades informativas de la ciudadanía.

El peligro de la agregación excesiva

Aún sin perder de vista el propósito es importante no caer en añadir demasiada información o presentar solo promedios. Imaginemos, por ejemplo, un conjunto de datos sobre seguridad ciudadana a nivel nacional: un promedio puede esconder que la mayoría de las localidades son muy seguras, mientras unas pocas con tasas extremadamente altas distorsionan el indicador nacional.

Como explica Claus O. Wilke en su libro "Fundamentals of Data Visualization", esta práctica puede ocultar patrones cruciales, valores atípicos y paradojas que son precisamente los más relevantes para la toma de decisiones. Para evitar este riesgo, en la formación se propone visualizar una gráfica como un sistema de capas que debemos construir cuidadosamente desde la base:

1. Codificación (Encoding)

- Es la base de todo: cómo traducimos datos en atributos visuales. Las investigaciones en percepción visual nos muestran que no todos los "canales visuales" son igual de efectivos. La jerarquía sería:

- Más efectivos: posición, longitud y altura

- Medianamente efectivos: ángulo, área y pendiente

- Menos efectivos: color, saturación y forma

¿Cómo ponemos esto en práctica? Pues, por ejemplo, para realizar comparaciones precisas, un gráfico de barras será casi siempre mejor opción que un gráfico circular. Sin embargo, como se matiza en los materiales formativos, "efectivo" no siempre significa "apropiado". Un gráfico circular puede ser perfecto cuando queremos expresar la idea de un "todo y sus partes", aunque las comparaciones precisas sean más difíciles.

2. Disposición (Arrangement)

El posicionamiento, orden y agrupación de los elementos afecta profundamente a la percepción. ¿Queremos que el lector compare entre categorías dentro de un grupo, o entre grupos? La respuesta determinará si organizamos nuestra visualización con barras agrupadas o apiladas, con paneles múltiples o en una única vista integrada.

3. Andamiaje (Scaffolding)

Los títulos, introducciones, anotaciones, escalas y leyendas son fundamentales. En datos.gob.es hemos visto cómo las visualizaciones interactivas pueden condensar información compleja, pero sin un andamiaje adecuado, la interactividad puede confundir más que aclarar.

El valor de una correcta escala

Uno de los aspectos técnicos más delicados —y a menudo más manipulables— de una visualización es la elección de la escala. Una simple modificación en el eje Y puede cambiar por completo la interpretación del lector: una tendencia suave puede parecer una crisis repentina, o un crecimiento sostenido puede pasar desapercibido.

Como se menciona en el segundo webinar de la serie, las escalas no son un detalle menor: son un componente narrativo. Decidir dónde empieza un eje, qué intervalos se usan o cómo se representan los periodos de tiempo implica hacer elecciones que afectan directamente la percepción de la realidad. Por ejemplo, si una gráfica de empleo comienza el eje Y en 90 % en lugar de 0 %, el descenso puede parecer dramático, aunque, en realidad, sea mínimo.

Por eso, las escalas deben ser honestas con los datos. Ser “honesto” no significa renunciar a decisiones de diseño, sino mostrar claramente qué decisiones se tomaron y por qué. Si existe una razón válida para empezar el eje Y en un valor distinto de cero, debe explicarse explícitamente en la gráfica o en su pie de texto. La transparencia debe prevalecer sobre el dramatismo.

La integridad visual no solo protege al lector de interpretaciones engañosas, sino que refuerza la credibilidad de quien comunica. En el ámbito de los datos públicos, esa honestidad no es opcional: es un compromiso ético con la verdad y con la confianza ciudadana.

Accesibilidad: visualizar para todos

Por otro lado, uno de los aspectos frecuentemente olvidado es la accesibilidad. Aproximadamente el 8 % de los hombres y el 0,5 % de las mujeres tienen algún tipo de daltonismo. Herramientas como Color Oracle permiten simular cómo se ven nuestras visualizaciones para personas con diferentes tipos de deficiencias en la percepción del color.

Además, en el webinar se mencionó el proyecto Chartability, una metodología para evaluar la accesibilidad de las visualizaciones de datos. En el sector público español, donde la accesibilidad web es un requisito legal, esto no es opcional: es una obligación democrática. Bajo esta premisa publicó la Federación Española de Municipios y Provincias publicó una Guía de Visualización de Datos para Entidades Locales.

Narrativa visual: cuando los datos cuentan historias

Una vez resueltas las cuestiones técnicas, podemos abordar el aspecto narrativo que cada día es más importante para comunicar correctamente. En este sentido, el curso plantea un método sencillo pero poderoso:

- Escribe una frase larga que resuma los puntos que quieres comunicar.

- Divide esa frase en componentes, aprovechando las pausas naturales.

- Transforma esos componentes en secciones de tu infografía.

Este enfoque narrativo es especialmente efectivo para proyectos como los que encontramos en data.europa.eu, donde se combinan visualizaciones con explicaciones contextuales para comunicar el valor de los conjuntos de datos de alto valor o en los ejercicios de visualización y ciencia de datos de datos de datos.gob.es.

El futuro de la visualización de datos también incluye aproximaciones más creativas y centradas en el usuario. Proyectos que incorporan elementos personalizados, que permiten a los lectores situarse en el centro de la información, o que utilizan técnicas narrativas para generar empatía, están redefiniendo lo que entendemos por "comunicación de datos".

Incluso emergen formas alternativas de "sensificación de datos": la fisicalización (crear objetos tridimensionales con datos) y la sonificación (traducir datos a sonido) abren nuevas posibilidades para hacer la información más tangible y accesible. La empresa española Tangible Data, de la que nos hacemos eco en datos.gob.es porque reutiliza conjuntos de datos abiertos, es prueba de ello.

Figura 1. Ejemplos de sensificación de datos. Fuente: https://data.europa.eu/sites/default/files/course/webinar-data-visualisation-episode-3-slides.pdf

A modo de conclusión, podemos resaltar que la integridad en el diseño no es un lujo: es un requisito ético. Cada gráfico que publicamos en plataformas oficiales influye en cómo los ciudadanos perciben la realidad y toman decisiones. Por eso, dominar herramientas técnicas como las bibliotecas y API de visualización, que se analizan en otros artículos del portal, es tan relevante.

La próxima vez que crees una visualización con datos abiertos, no te preguntes solo "¿qué herramienta uso?" o "¿qué gráfico se ve mejor?". Pregúntate: ¿qué necesita realmente saber mi audiencia? ¿Esta visualización respeta la integridad de los datos? ¿Es accesible para todos? Las respuestas a estas preguntas son las que transforman un gráfico bonito en una herramienta de comunicación verdaderamente efectiva.

Crean aplicaciones intuitivas y atractivas que hacen que los datos sean accesibles y visualmente impactantes. Diseñan y desarrollan webs de visualizaciones de datos, dashboards y aplicaciones de analítica visual adaptadas a las necesidades de cada cliente.

Imagina que quieres saber cuántas terrazas hay en tu barrio, cómo evolucionan los niveles de polen del aire que respiras cada día o si el reciclaje en tu ciudad está funcionando bien. Toda esa información existe en las bases de datos de tu ayuntamiento, pero se encuentra entre hojas de cálculo y documentos técnicos que solo los expertos sabían interpretar.

Aquí es donde entran en juego las iniciativas de visualización de datos abiertos: transforman esos números aparentemente fríos en historias que cualquier persona puede entender de un vistazo. Un gráfico colorido que muestra la evolución del tráfico en tu calle, un mapa interactivo con las zonas verdes de tu ciudad, o una infografía que explica en qué se gasta el presupuesto municipal. Estas herramientas convierten la información pública en algo cercano, útil y, además, comprensible para toda la ciudadanía.

Además, las ventajas de este tipo de soluciones no son solo para la ciudadanía, sino que también benefician a la Administración que realiza el ejercicio, porque permite:

- Detectar y corregir errores en los datos.

- Incorporar nuevos conjuntos al portal.

- Disminuir el número de preguntas del ciudadano.

- Generar más confianza por parte de la sociedad.

Por tanto, visualizar datos abiertos permite acercar la Administración a la ciudadanía, facilita la toma de decisiones informadas, ayuda a las Administraciones Públicas a mejorar su oferta de datos abiertos y permite crear una sociedad más participativa donde todos podemos entender mejor cómo funciona el sector público. En este post, te presentamos algunos ejemplos de iniciativas de visualización de open data en portales de datos abiertos autonómicos y municipales.

Visualiza Madrid: acercando los datos a la ciudadanía

El portal de datos abiertos del Ayuntamiento de Madrid ha desarrollado la iniciativa "Visualiza Madrid", un proyecto que nace con el objetivo específico de hacer que los datos abiertos y su potencial lleguen a la ciudadanía en general, trascendiendo los perfiles técnicos especializados. Tal y como explicó Ascensión Hidalgo Bellota, Subdirectora general de Transparencia del Ayuntamiento de Madrid, durante el IV Encuentro Nacional de Datos Abiertos, “esta iniciativa responde a la necesidad de democratizar el acceso a la información pública”.

Actualmente, Visualiza Madrid cuenta con 29 visualizaciones que abarcan diferentes temáticas de interés ciudadano, desde información sobre terrazas de hostelería hasta gestión de residuos y análisis del tráfico urbano. Esta diversidad temática demuestra la versatilidad de las visualizaciones como herramienta para comunicar información de sectores muy diversos de la administración pública.

Además, la iniciativa ha recibido este año un reconocimiento externo a través de los premios Audaz 2025, una iniciativa del capítulo español de la Red Académica de Gobierno Abierto (RAGA España).

Castilla y León: análisis integral de datos regionales

La Junta de Castilla y León también ha desarrollado un portal especializado en análisis y visualizaciones que destaca por su enfoque integral hacia la presentación de datos autonómicos. Su plataforma de visualizaciones ofrece una aproximación sistemática al análisis de información regional, permitiendo a los usuarios explorar diferentes dimensiones de la realidad de Castilla y León a través de herramientas interactivas y dinámicas.

Esta iniciativa permite presentar información compleja de manera estructurada y comprensible, facilitando tanto el análisis académico como el uso ciudadano de los datos. La plataforma integra diferentes fuentes de información autonómica, creando un ecosistema coherente de visualizaciones que permite obtener una visión panorámica de diversos aspectos de la gestión regional. Entre las temáticas que ofrece podemos mencionar datos de turismo, del mercado laboral o de la ejecución de los presupuestos. Todas las visualizaciones están realizadas con conjuntos de datos abiertos del portal autonómico de Castilla y León.

El enfoque de Castilla y León demuestra cómo las visualizaciones pueden servir como herramienta de análisis territorial, proporcionando insights valiosos sobre dinámicas económicas, sociales y demográficas que resultan fundamentales para la planificación y evaluación de políticas públicas regionales.

Canarias: integración tecnológica con widgets interactivos

Por otro lado, el Gobierno de Canarias ha apostado por una estrategia innovadora mediante la implementación de widgets que permiten la integración de visualizaciones de datos abiertos del Instituto Canario de Estadística (ISTAC) en diferentes plataformas y contextos. Esta aproximación tecnológica representa un salto cualitativo en la distribución y reutilización de visualizaciones de datos públicos.

Los widgets desarrollados por Canarias facilitan que terceros puedan incorporar visualizaciones oficiales en sus propias aplicaciones, sitios web o análisis, ampliando exponencialmente el alcance y la utilidad de los datos abiertos canarios. Esta estrategia no solo multiplica los puntos de acceso a la información pública, sino que también fomenta la creación de un ecosistema colaborativo donde diferentes actores pueden beneficiarse y contribuir al valor de los datos abiertos.

La iniciativa canaria ilustra cómo la tecnología puede ser utilizada para crear soluciones escalables y flexibles que maximicen el impacto de las inversiones en visualización de datos abiertos, estableciendo un modelo replicable para otras administraciones que busquen amplificar el alcance de sus iniciativas de transparencia.

Lecciones aprendidas y mejores prácticas

A modo de ejemplo, los casos analizados revelan patrones comunes que pueden servir como guía para futuras iniciativas. La orientación hacia la ciudadanía general, más allá de usuarios técnicos especializados, emerge como un factor de oportunidad para el éxito de estas plataformas. Para mantener el interés y la relevancia de las visualizaciones es importante ofrecer diversidad temática y actualizar los datos regularmente.

La integración tecnológica y la interoperabilidad, como demuestra el caso de Canarias, abren nuevas posibilidades para maximizar el impacto de las inversiones públicas en visualización de datos. Asimismo, el reconocimiento externo y la participación en redes profesionales, como evidencia el caso de Madrid, contribuyen a la mejora continua y al intercambio de mejores prácticas entre administraciones.

En términos generales, las iniciativas de visualización de datos abiertos representan una oportunidad muy valiosa en la estrategia de transparencia y gobierno abierto de las administraciones públicas españolas. Los casos de Madrid, Castilla y León, así como de Canarias, son ejemplo de que existe un potencial enorme para transformar datos públicos en herramientas de empoderamiento ciudadano y mejora de la gestión pública.

El éxito de estas iniciativas radica en su capacidad para conectar la información gubernamental con las necesidades reales de la ciudadanía, creando puentes de comprensión que fortalecen la relación entre administración y sociedad. A medida que estas experiencias maduren y se consoliden, será fundamental mantener el foco en la usabilidad, la accesibilidad y la relevancia de las visualizaciones, asegurando que los datos abiertos cumplan verdaderamente su promesa de contribuir a una sociedad más informada, participativa y democrática.

La visualización de datos abiertos no es solo una cuestión técnica, sino una oportunidad estratégica para redefinir la comunicación pública y fortalecer los cimientos de una Administración verdaderamente abierta y transparente.

El Informe Europeo sobre Drogas proporciona una visión actual de la situación de las drogas en la región, analizando las principales tendencias y amenazas emergentes. Se trata de una publicación de gran valor, con un alto número de descargas, que se cita en múltiples medios de comunicación.

El informe se realiza de forma anual por la Agencia de la Unión Europea sobre Drogas (EUDA en sus siglas en inglés), nombre actual del antiguo Observatorio Europeo de las Drogas y las Toxicomanías. Este organismo recopila y analiza datos de los Estados miembros de la Unión Europea, junto con otros países asociados, como son Turquía y Noruega, para proporcionar una visión integral del consumo y oferta de drogas, los daños que producen y las intervenciones de reducción de daños. El informe contiene conjuntos completos de datos sobre estos temas desagregados a nivel nacional, e incluso, en algunos casos, a nivel de ciudad (como Barcelona o Palma de Mallorca).

Este estudio lleva realizándose desde 1993 y traduciéndose a más de 20 idiomas oficiales de la Unión Europea. No obstante, en los dos últimos años ha presentado una novedad: un cambio en los procesos internos para mejorar la visualización de los datos obtenidos. Un proceso que han explicado en el reciente webinar “El Informe Europeo sobre las Drogas: uso de un enfoque de datos abiertos para mejorar la visualización de datos”, organizado por el Portal de Datos Abiertos Europeo (data.europa.eu) el pasado 25 de junio. A continuación, se resume lo que contaron los representantes del Observatorio en esta cita.

La necesidad de un cambio

El Observatorio siempre ha trabajado con datos abiertos, pero el proceso presentaba ineficiencias. Hasta ahora el Informe Europeo sobre Drogas se había publicado siempre en formato PDF, poniendo el foco en conseguir un producto visualmente llamativo. El proceso interno previo a la publicación del informe consistía en varias etapas que involucraban a diversos equipos:

- Un equipo del Observatorio comprobaba el formato de los datos recibidos por parte del proveedor y, si era necesario, los adaptaba.

- Un equipo especializado en análisis de datos creaba visualizaciones a partir de los datos.

- Un equipo especializado en redacción redactaba el informe. El equipo que había creado las visualizaciones podía colaborar en esta fase.

- Un equipo interno validaba el contenido del reporte.

- El proveedor de los datos revisaba que el Observatorio había intepretado los datos correctamente.

A pesar del buen recibimiento del informe y su formato, en 2022 el Observatorio decidió cambiar completamente el formato de publicación por los siguientes motivos:

- Una vez iniciados los distintos pasos del proceso de publicación, los datos se formateban y dejaban de ser legibles por una máquina. Esto reducía la acessibilidad de los datos, por ejemplo, para lectores de pantalla, y limitaba su capacidad de reutilización.

- Si en los distintos pasos del proceso se detectaban errores, se corregían directamente sobre el formato que tenían los datos en este paso. Es decir, si en la fase de revisión se detectaba un error en un gráfico, se corregía directamente sobre dicho gráfico. Este procedimiento podía causar errores y opacar la trazabilidad de los datos, limitando la eficiencia: un mismo gráfico estático podía estar presente varias veces en el documento y cada mención se tenía que corregir individualmente.

- Al final del proceso se tenía que ajustar el formato de los datos de origen, por los cambios realizados en el procedimiento de publicación.

- Muchos de los usuarios que consultaban el informe lo hacían desde un dispositivo móvil, para el cual el formato del PDF no siempre era adecuado.

- Al no ser accesibles ni aptos para dispositivos moviles, los documentos en formato PDF no solían aparecer como primer resultado en los motores de búsqueda. Este punto es importante para el Observatorio, ya que muchos de los usuarios encuentran el informe a través de buscadores.

Era necesario un formato web responsive, que ajustara automáticamente el sitio web al tamaño y disposición de los dispositivos de sus usuarios. Con ello se buscaba:

- Una mejora de la accesibilidad.

- Un proceso de creación de visualizaciones más ágil.

- Un proceso de traducción más fácil.

- Un aumento de visitantes procedentes de motores de búsqueda.

- Un mayor modularidad.

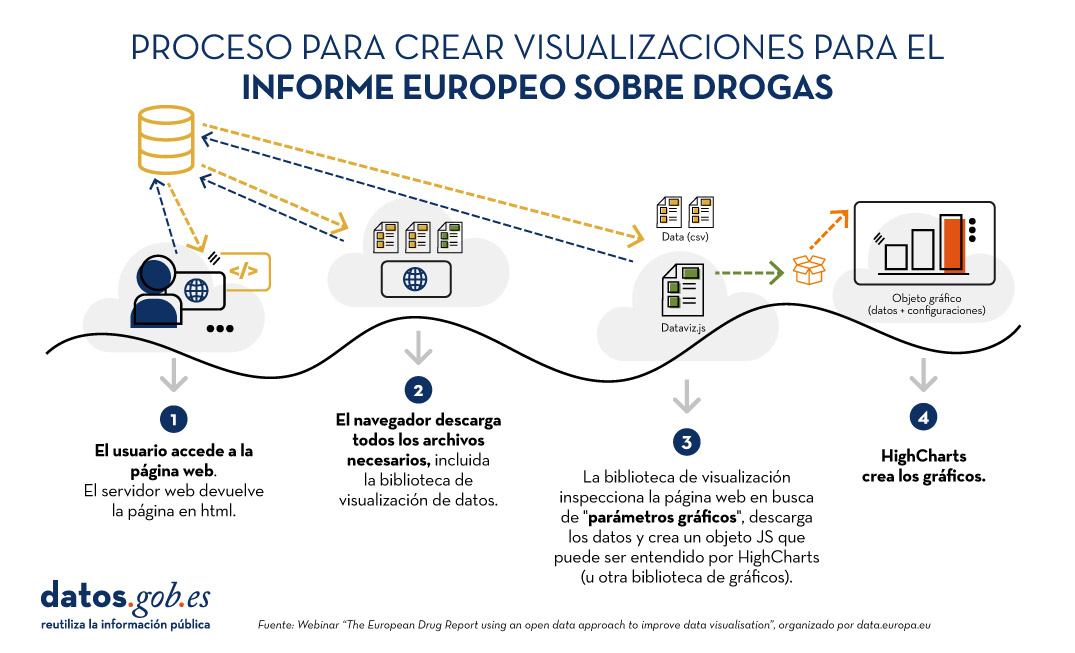

El proceso detrás del nuevo informe

Con el fin de transformar por completo el formato de publicación del informe, se ha llevado a cabo un proceso de visualización diseñado ad hoc, resumido en la siguiente imagen:

Figura 1. Proceso para crear visualizaciones para el Informe Europeo sobre Drogas. Fuente ES: Webinar “The European Drug Report using an open data approach to improve data visualisation”, organizado por data.europa.eu.

La principal novedad es que las visualizaciones se crean dinámicamente a partir de los datos fuente. De esta forma, si se modifica algo en dichos datos, automáticamente se cambia en todas las visualizaciones que se alimentan de ellos. Mediante el sistema de gestión de contenidos Drupal, en el que está basada gran parte de la web, los administradores pueden registrar cambios que automáticamente se reflejarán en el HTML y, por lo tanto, en las visualizaciones. Además, los administradores de la página disponen de un generador de visualizaciones que crea visualizaciones sin necesidad de tocar código, a partir de los datos e indicaciones -que equivalen a instrucciones sencillas como “ordenar de mayor a menor”, expresados mediante HTML-.

El mismo procedimiento dinámico de actualización se aplica al PDF que el usuario puede descargar. Si hay cambios en los datos, en las visualizaciones o se corrigen errores tipográficos, el PDF se genera nuevamente a través de un proceso de compilación que el Observatorio ha creado específicamente para esta tarea.

El informe después del cambio

Actualmente el informe se publica en versión HTML, con la posibilidad de descargar capítulos o el informe completo en formato PDF. Está estructurado por módulos temáticos y también permite la consulta de anexos.

Además, los datos siempre se publican en formato CSV y se indica en la misma página las condiciones de licencia de los datos (CC-BY-4.0). La referencia de la fuente de los datos siempre se pone a disposición del lector en la misma página en la que está una visualización.

Con este cambio de procedimiento y formato, se han conseguido beneficios para todos. Desde el punto de vista de los lectores, se ha mejorado la experiencia del usuario. Para la organización, se ha agilizado el proceso de publicación.

En cuanto a datos abiertos, este nuevo enfoque permite una mayor trazabilidad, ya que se puede consultar en cada momento los datos en su formato actual. Además, según los ponentes del Observatorio, este nuevo formato del informe, junto con el hecho de que los datos y visualizaciones siempre están actualizados, ha aumentado la accesibilidad de los datos para medios de comunicación.

Puedes acceder a los materiales del webinar aquí:

1. Introducción

En la era de la información, la inteligencia artificial ha demostrado ser una herramienta invaluable para una variedad de aplicaciones. Una de las manifestaciones más increíbles de esta tecnología es GPT (Generative Pre-trained Transformer), desarrollado por OpenAI. GPT es un modelo de lenguaje natural que puede entender y generar texto, ofreciendo respuestas coherentes y contextualmente relevantes. Con la reciente introducción de Chat GPT-4, las capacidades de este modelo se han ampliado aún más, permitiendo una mayor personalización y adaptabilidad a diferentes temáticas.

En este post, te mostraremos cómo configurar y personalizar un asistente especializado en minerales críticos utilizando GPT-4 y fuentes de datos abiertas. Como ya mostramos en previas publicaciones, los minerales críticos son fundamentales para numerosas industrias, incluyendo la tecnología, la energía y la defensa, debido a sus propiedades únicas y su importancia estratégica. Sin embargo, la información sobre estos materiales puede ser compleja y dispersa, lo que hace que un asistente especializado sea particularmente útil.

El objetivo de este post es guiarte paso a paso desde la configuración inicial hasta la implementación de un asistente GPT que pueda ayudarte a resolver dudas y proporcionar información valiosa sobre minerales críticos en tu día a día. Además, exploraremos cómo personalizar aspectos del asistente, como el tono y el estilo de las respuestas, para que se adapte perfectamente a tus necesidades. Al final de este recorrido, tendrás una herramienta potente y personalizada que transformará la manera en que accedes y utilizas la información en abierto sobre minerales críticos.

Accede al repositorio del laboratorio de datos en Github.

En este vídeo, el autor te explica que vas a encontrar tanto en el Github como en Google Colab.

2. Contexto

La transición hacia un futuro sostenible no solo implica cambios en las fuentes de energía, sino también en los recursos materiales que utilizamos. El éxito de sectores como baterías de almacenamiento de energía, aerogeneradores, paneles solares, electrolizadores, drones, robots, redes de transmisión de datos, dispositivos electrónicos o satélites espaciales, depende enormemente del acceso a las materias primas críticas para su desarrollo. Entendemos que un mineral es crítico cuando se cumplen los siguientes factores:

- Sus reservas mundiales son escasas

- No existen materiales alternativos que puedan ejercer su función (sus propiedades son únicas o muy singulares)

- Son materiales indispensables para sectores económicos clave de futuro, y/o su cadena de suministro es de elevado riesgo

Puedes aprender más sobre los minerales críticos en el post mencionado anteriormente.

3. Objetivo

Este ejercicio se centra en mostrar al lector cómo personalizar un modelo GPT especializado para un caso de uso concreto. Adoptaremos para ello el enfoque “aprender haciendo”, de tal forma que el lector pueda comprender cómo configurar y ajustar el modelo para resolver un problema real y relevante, como el asesoramiento experto en minerales críticos. Este enfoque práctico no solo mejora la comprensión de las técnicas de personalización de modelos de lenguaje, sino que también prepara a los lectores para aplicar estos conocimientos en la resolución de problemas reales, ofreciendo una experiencia de aprendizaje rica y directamente aplicable a sus propios proyectos.

El asistente GPT especializado en minerales críticos estará diseñado para convertirse en una herramienta esencial para profesionales, investigadores y estudiantes. Su objetivo principal será facilitar el acceso a información precisa y actualizada sobre estos materiales, apoyar la toma de decisiones estratégicas y promover la educación en este campo. A continuación, se detallan los objetivos específicos que buscamos alcanzar con este asistente:

- Proporcionar información precisa y actualizada:

- El asistente debe ofrecer información detallada y precisa sobre diversos minerales críticos, incluyendo su composición, propiedades, usos industriales y disponibilidad.

- Mantenerse actualizado con las últimas investigaciones y tendencias del mercado en el ámbito de los minerales críticos.

- Asistir en la toma de decisiones:

- Proporcionar datos y análisis que puedan ayudar en la toma de decisiones estratégicas en la industria y la investigación sobre minerales críticos.

- Ofrecer comparativas y evaluaciones de diferentes minerales en función de su rendimiento, coste y disponibilidad.

- Promover la educación y la concienciación en torno a esta temática:

- Actuar como una herramienta educativa para estudiantes, investigadores y profesionales, ayudando a mejorar su conocimiento sobre los minerales críticos.

- Aumentar la conciencia sobre la importancia de estos materiales y los desafíos relacionados con su suministro y sostenibilidad.

4. Recursos

Para configurar y personalizar nuestro asistente GPT especializado en minerales críticos, es esencial disponer de una serie de recursos que faciliten la implementación y aseguren la precisión y relevancia de las respuestas del modelo. En este apartado, detallaremos los recursos necesarios que incluyen tanto las herramientas tecnológicas como las fuentes de información que serán integradas en la base de conocimiento del asistente.

Herramientas y Tecnologías

Las herramientas y tecnologías clave para desarrollar este ejercicio son:

- Cuenta de OpenAI: necesaria para acceder a la plataforma y utilizar el modelo GPT-4. En este post, utilizaremos la suscripción Plus de ChatGPT para mostrarte cómo crear y publicar un GPT personalizado. No obstante, puedes desarrollar este ejercicio de forma similar utilizando una cuenta gratuita de OpenAI y realizando el mismo conjunto de instrucciones a través de una conversación de ChatGPT estándar.

- Microsoft Excel: hemos diseñado este ejercicio de forma que cualquier persona sin conocimientos técnicos pueda desarrollarlo de principio a fin. Únicamente nos apoyaremos en herramientas ofimáticas como Microsoft Excel para realizar algunas adecuaciones de los datos descargados.

De forma complementaria, utilizaremos otro conjunto de herramientas que nos permitirán automatizar algunas acciones sin ser estrictamente necesaria su utilización:

- Google Colab: es un entorno de Python Notebooks que se ejecuta en la nube, permitiendo a los usuarios escribir y ejecutar código Python directamente en el navegador. Google Colab es especialmente útil para el aprendizaje automático, el análisis de datos y la experimentación con modelos de lenguaje, ofreciendo acceso gratuito a potentes recursos de computación y facilitando la colaboración y el intercambio de proyectos.

- Markmap: es una herramienta que visualiza mapas mentales de Markdown en tiempo real. Los usuarios escriben ideas en Markdown y la herramienta las renderiza como un mapa mental interactivo en el navegador. Markmap es útil para la planificación de proyectos, la toma de notas y la organización de información compleja visualmente. Facilita la comprensión y el intercambio de ideas en equipos y presentaciones.

Fuentes de Información

- Raw Materials Information System (RMIS): sistema de información sobre materias primas mantenido por el Joint Research Center de la Unión Europea. Proporciona datos detallados y actualizados sobre la disponibilidad, producción y consumo de materias primas en Europa.

- Catálogo de informes y datos de la Agencia Internacional de la Energía (IEA en sus siglas en inglés): ofrece un amplio catálogo de informes y datos relacionados con la energía, incluyendo estadísticas sobre producción, consumo y reservas de minerales energéticos y críticos.

- Base de datos de minerales del Instituto Geológico y Minero Español (BDMIN): contiene información detallada sobre los minerales y depósitos minerales en España, útil para obtener datos específicos sobre la producción y reservas de minerales críticos en el país.

Con estos recursos, estarás bien equipado para desarrollar un asistente GPT especializado que pueda proporcionar respuestas precisas y relevantes sobre minerales críticos, facilitando la toma de decisiones informadas en este campo.

5. Desarrollo del ejercicio

5.1. Construcción de la base de conocimiento

Para que nuestro asistente GPT especializado en minerales críticos sea verdaderamente útil y preciso, es esencial construir una base de conocimiento sólida y estructurada. Esta base de conocimiento será el conjunto de datos e información que el asistente utilizará para responder a las consultas. La calidad y relevancia de esta información determinarán la eficacia del asistente en proporcionar respuestas precisas y útiles.

Búsqueda de Fuentes de Datos

Comenzamos con la recopilación de fuentes de información que nutrirán nuestra base de conocimiento. No todas las fuentes de información son igualmente fiables. Es fundamental evaluar la calidad de las fuentes identificadas, asegurando que:

- La información esté actualizada: la relevancia de los datos puede cambiar con rapidez, especialmente en campos dinámicos como el de los minerales críticos.

- La fuente sea confiable y reconocida: es necesario utilizar fuentes de instituciones reconocidas y respetadas en el ámbito académico y profesional.

- Los datos sean completos y accesibles: es crucial que los datos sean detallados y que estén accesibles para su integración en nuestro asistente.

En nuestro caso, desarrollamos una búsqueda online en diferentes plataformas y repositorios de información tratando de seleccionar información perteneciente a diversas entidades reconocidas:

- Centros de investigación y universidades:

- Publican estudios y reportes detallados sobre la investigación y desarrollo de minerales críticos.

- Ejemplo: RMIS del Joint Research Center de la Unión Europea.

- Instituciones gubernamentales y organismos internacionales:

- Estas entidades suelen proporcionar datos exhaustivos y actualizados sobre la disponibilidad y el uso de minerales críticos.

- Ejemplo: Agencia Internacional de la Energía (IEA).

- Bases de datos especializadas:

- Contienen datos técnicos y específicos sobre depósitos y producción de minerales críticos.

- Ejemplo: Base de datos de Minerales del Instituto Geológico y Minero español (BDMIN).

Selección y preparación de la información

Nos centraremos ahora en la selección y preparación de la información existente en estas fuentes para asegurar que nuestro asistente GPT pueda acceder a datos precisos y útiles.

RMIS del Joint Research Center de la Unión Europea:

- Información seleccionada:

Seleccionamos el informe “Supply chain analysis and material demand forecast in strategic technologies and sectors in the EU – A foresight study”. Se trata de un análisis de la cadena de suministro y la demanda de minerales en tecnologías y sectores estratégicos de la UE. Presenta un estudio detallado de las cadenas de suministro de materias primas críticas y pronostica la demanda de minerales hasta 2050.

- Preparación necesaria:

El formato del documento, PDF, permite la ingesta directa de la información por parte de nuestro asistente. No obstante, como se observa en la Figura 1, existe una tabla especialmente relevante en sus páginas 238-240 donde se analiza, para cada mineral, su riesgo de suministro, tipología (estratégico, crítico o no crítico) y las tecnologías clave que lo emplean. Decidimos, por ello, extraer esta tabla a un formato estructurado (CSV), de tal forma que dispongamos de dos piezas de información que pasarán a formar parte de nuestra base de conocimiento.

Figura 1: Tabla de minerales contenida en el PDF de JRC

Para extraer de forma programática los datos contenidos en esta tabla y transformarlos en un formato más fácilmente procesable, como CSV (comma separated values o valores separados por comas), utilizaremos un script de Python que podemos utilizar a través de la plataforma Google Colab (Figura 2).

Figura 2: Script Python para la extracción de datos del PDF de JRC desarrollado en plataforma Google Colab.

A modo de resumen, este script:

- Se apoya en la librería de código abierto PyPDF2, capaz de interpretar información contenida en ficheros PDF.

- Primero, extrae en formato texto (cadena de caracteres) el contenido de las páginas del PDF donde se encuentra la tabla de minerales eliminando todo el contenido que no se corresponde con la propia tabla.

- Posteriormente, recorre, línea a línea, la cadena de caracteres convirtiendo los valores en columnas de una tabla de datos. Sabremos que un mineral es utilizado en una tecnología clave si en la columna correspondiente de dicho mineral encontramos un número 1 (en caso contrario contendrá un 0).

- Por último, exporta dicha tabla a un fichero CSV para su posterior utilización.

Agencia Internacional de la Energía (IEA):

- Información seleccionada:

Seleccionamos el informe “Global Critical Minerals Outlook 2024”. Este proporciona una visión general de los desarrollos industriales en 2023 y principios de 2024, y ofrece perspectivas a medio y largo plazo para la demanda y oferta de minerales clave para la transición energética. También evalúa los riesgos para la fiabilidad, sostenibilidad y diversidad de las cadenas de suministro de minerales críticos.

- Preparación necesaria:

El formato del documento, PDF, nos permite la ingesta directa de la información por parte de nuestro asistente virtual. No realizaremos en este caso ninguna adecuación de la información seleccionada.

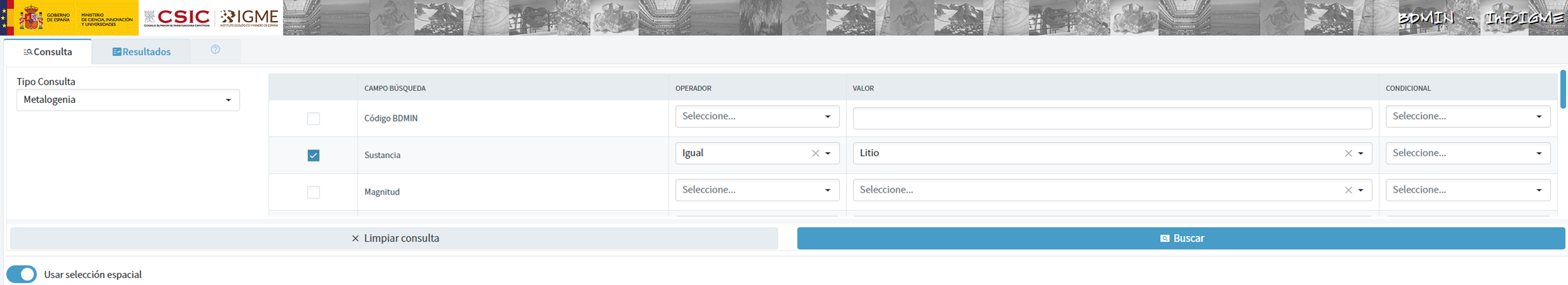

Base de Datos de Minerales del Instituto Geológico y Minero Español (BDMIN)

- Información seleccionada:

En este caso, utilizamos el formulario para seleccionar los datos existentes en esta base de datos en cuanto a indicios y yacimientos del ámbito de la metalogenia, en particular seleccionamos aquellos con contenido de Litio.

Figura 3: Selección de conjunto de datos en BDMIN.

- Preparación necesaria:

Observamos cómo la herramienta web nos permite la visualización online y también la exportación de estos datos en varios formatos. Seleccionamos, por tanto, todos los datos a exportar y haciendo clic en esta opción, descargamos un fichero Excel con la información deseada.

Figura 4: Herramienta de visualización y descarga en BDMIN

Figura 5: Datos descargados BDMIN.

Todos los archivos que componen nuestra base de conocimiento se encuentran GitHub del proyecto, de tal forma que aquel lector que lo desee pueda saltarse la fase de descarga y preparación de la información.

5.2. Configuración y personalización del GPT para minerales críticos

Cuando hablamos de "crear un GPT," en realidad nos estamos refiriendo a la configuración y personalización de un modelo de lenguaje basado en GPT (Generative Pre-trained Transformer) para adaptarlo a un caso de uso específico. En este contexto, no estamos creando el modelo desde cero, sino ajustando cómo el modelo preexistente (como GPT-4 de OpenAI) interactúa y responde dentro de un dominio específico, en este caso, sobre minerales críticos.

En primer lugar, accedemos a la aplicación a través de nuestro navegador y, en caso de no tener una cuenta, seguimos el proceso de registro y login en la plataforma ChatGPT. Como indicamos con anterioridad, para realizar la creación de un GPT paso a paso será necesario disponer de una cuenta Plus. No obstante, aquellos lectores que no dispongan de dicha cuenta, podrán trabajar con una cuenta gratuita interactuando con ChatGPT a través de una conversación estándar.

Figura 6: Página de inicio de sesión y registro de ChatGPT.

Una vez iniciada la sesión, seleccionamos la opción "Explorar GPT", y posteriormente hacemos clic en "Crear" para comenzar el proceso de creación de nuestro GPT.

Figura 7: Creación de nuevo GPT.

En pantalla se nos mostrará la pantalla dividida de creación de un nuevo GPT: a la izquierda podremos conversar con el sistema para indicarle las características que debe tener nuestro GPT, mientras que a la izquierda podremos interactuar con nuestro GPT para validar que su comportamiento es el adecuado según vayamos avanzando en el proceso de configuración.

Figura 8: Pantalla de creación de nuevo GPT.

En el GitHub de este proyecto, podemos encontrar todos los prompts o instrucciones que utilizaremos para configurar y personalizar nuestro GPT y que deberemos introducir de forma secuencial en la pestaña "Crear", situada en la pestaña izquierda de nuestras pantallas, para completar los pasos que se detallan a continuación.

Los pasos que vamos a seguir para la creación del GPT son:

- En primer lugar, le indicaremos el objetivo y las consideraciones básicas a nuestro GPT para que pueda entender su modo de empleo.

Figura 9: Instrucciones básicas de nuevo GPT.

2. Posteriormente crearemos un nombre y una imagen que representen a nuestro GPT y lo hagan fácilmente identificable. En nuestro caso, lo denominaremos MateriaGuru.

Figura 10: Selección de nombre para nuevo GPT.

Figura 11: Creación de imagen para GPT.

3. A continuación, construiremos la base de conocimiento a partir de la información anteriormente seleccionada y preparada para nutrir los conocimientos de nuestro GPT.

Figura 12: Carga de información a la base de conocimiento de nuevo GPT.

4. Ahora, podemos personalizar aspectos conversacionales como su tono, el nivel de complejidad técnica de sus repuesta o si esperamos respuestas escuetas o elaboradas.

5. Por último, desde la pestaña "Configurar", podemos indicar los iniciadores de conversación deseados para que los usuarios que interactúen con nuestro GPT tengan algunas ideas para empezar la conversación de forma predefinida.

Figura 13: Pestaña Configurar GPT.

En la Figura 13 podemos también observar el resultado definitivo de nuestro entrenamiento, donde aparecen elementos clave como su imagen, nombre, instrucciones, iniciadores de conversación o documentos que forma parte de su base de conocimiento.

5.3. Validación y publicación de GPT

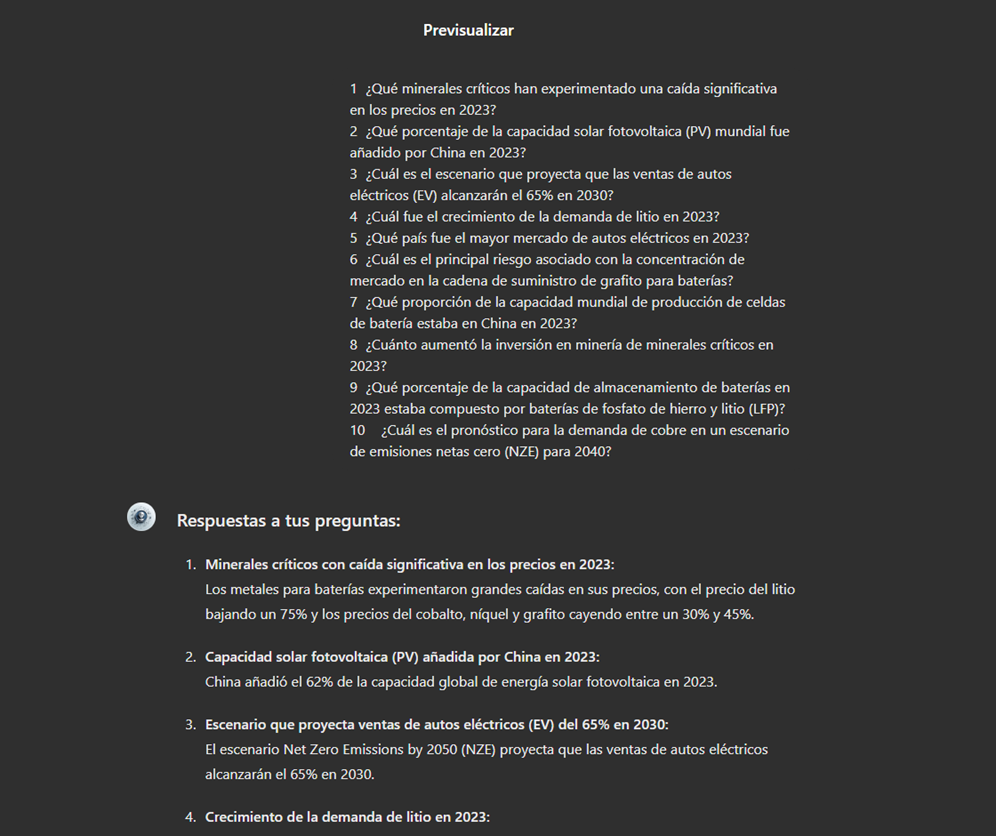

Antes de dar por bueno a nuestro nuevo asistente basado en GPT, procederemos a realizar una breve validación de su correcta configuración y aprendizaje respecto a la temática en torno a la que le hemos entrenado. Para ello, preparamos una batería de preguntas que le realizaremos para comprobar que responde de forma adecuada ante un escenario real de utilización.

| # | Pregunta | Respuesta |

|---|---|---|

| 1 | ¿Qué minerales críticos han experimentado una caída significativa en los precios en 2023? | Los precios de los minerales para baterías vieron particularmente grandes caídas con los precios del litio cayendo un 75% y los precios del cobalto níquel y grafito cayendo entre un 30% y un 45%. |

| 2 | ¿Qué porcentaje de la capacidad solar fotovoltaica (PV) mundial fue añadido por China en 2023? | China representó el 62% del aumento en la capacidad solar fotovoltaica global en 2023. |

| 3 | ¿Cuál es el escenario que proyecta que las ventas de autos eléctricos (EV) alcanzarán el 65% en 2030? | El escenario de emisiones netas cero (NZE) para 2050 proyecta que las ventas de autos eléctricos alcanzarán el 65% en 2030. |

| 4 | ¿Cuál fue el crecimiento de la demanda de litio en 2023? | La demanda de litio aumentó en un 30% en 2023. |

| 5 | ¿Qué país fue el mayor mercado de autos eléctricos en 2023? | China fue el mayor mercado de autos eléctricos en 2023 con 8.1 millones de ventas de autos eléctricos representando el 60% del total global. |

| 6 | ¿Cuál es el principal riesgo asociado con la concentración de mercado en la cadena de suministro de grafito para baterías? | Más del 90% del grafito de grado batería y el 77% de las tierras raras refinadas en 2030 se originan en China lo que representa un riesgo significativo para la concentración del mercado. |

| 7 | ¿Qué proporción de la capacidad mundial de producción de celdas de batería estaba en China en 2023? | China poseía el 85% de la capacidad de producción de celdas de batería en 2023. |

| 8 | ¿Cuánto aumentó la inversión en minería de minerales críticos en 2023? | La inversión en minería de minerales críticos creció un 10% en 2023. |

| 9 | ¿Qué porcentaje de la capacidad de almacenamiento de baterías en 2023 estaba compuesto por baterías de fosfato de hierro y litio (LFP)? | En 2023, las baterías LFP constituían aproximadamente el 80% del mercado total de almacenamiento de baterías. |

| 10 | ¿Cuál es el pronóstico para la demanda de cobre en un escenario de emisiones netas cero (NZE) para 2040? | En el escenario de emisiones netas cero (NZE) para 2040 se espera que la demanda de cobre tenga el mayor aumento en términos de volumen de producción. |

Figura 14: Tabla con batería de preguntas para la validación de nuestro GPT.

Valiéndonos de la parte de previsualización, situada a la derecha de nuestras pantallas, lanzamos la batería de preguntas y validamos que las respuestas se corresponden con aquellas esperadas.

Figura 15: Validación de respuestas GPT.

Por último, hacemos clic en el botón "Crear" para finalizar el proceso. Podremos seleccionar entre diferentes alternativas para restringir su utilización por parte de otros usuarios.

Figura 16: Publicación de nuestro GPT.

6. Escenarios de uso

En este apartado mostramos varios escenarios en los que podremos sacar partido a MateriaGuru en nuestro día a día. En el GitHub del proyecto podremos encontrar los prompts utilizados para replicar cada uno de ellos.

6.1. Consulta de información de minerales críticos

El escenario más típico de utilización de este tipo de GPTs es la asistencia para resolución de dudas relacionadas con la temática en cuestión, en este caso, los minerales críticos. A modo de ejemplo, hemos preparado una batería de cuestiones que el lector podrá plantear al GPT creado para comprender en mayor detalle la relevancia y situación actual de un material crítico como es el grafito a partir de los informes provistos a nuestro GPT.

Figura 17: Resolución de dudas de minerales críticos.

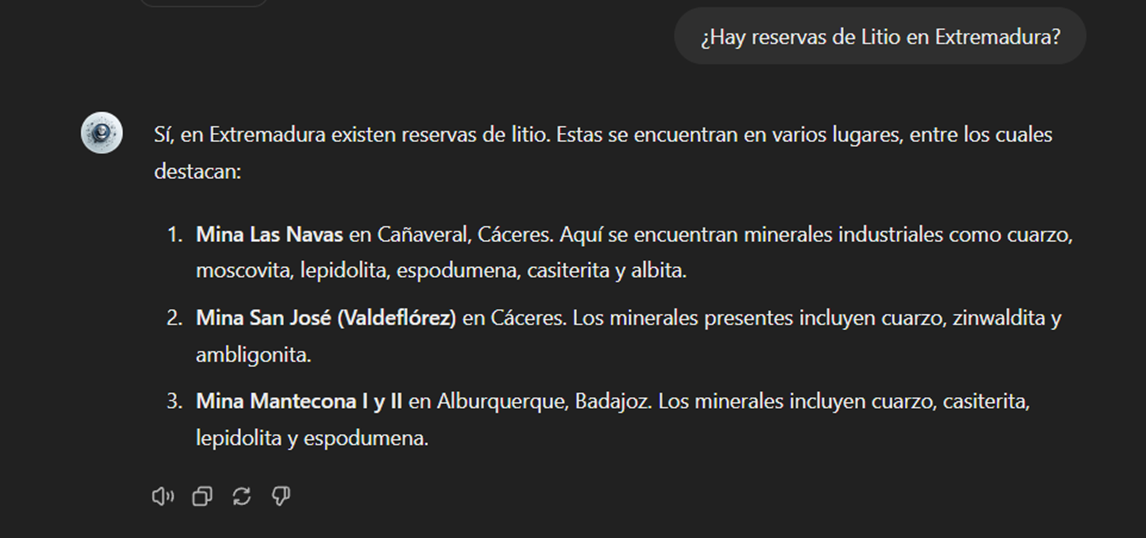

También podemos plantearle preguntas concretas sobre la información tabulada provista respecto a los yacimientos e indicios existentes en el territorio español.

Figura 18: Reservas de litio en Extremadura.

6.2. Representación de visualizaciones de datos cuantitativos

Otro escenario común, es la necesidad de consultar información cuantitativa y realizar representaciones visuales para su mejor entendimiento. En este escenario, podemos observar cómo MateriaGuru es capaz de generar una visualización interactiva de la producción de grafito en toneladas de los principales países productores.

Figura 19: Generación de visualización interactiva con nuestro GPT.

6.3. Generación de mapas mentales para facilitar la comprensión

Por último, en línea con la búsqueda de alternativas para un mejor acceso y comprensión del conocimiento existente en nuestro GPT, plantearemos a MateriaGuru la construcción de un mapa mental que nos permita entender de una forma visual conceptos clave de los minerales críticos. Para ello, utilizamos la notación abierta Markmap (Markdown Mindmap), que nos permite definir mapas mentales utilizando notación markdown.

Figura 20: Generación de mapas mentales desde nuetro GPT.

Deberemos copiar el código generado e introducirlo en un visualizador de markmap para poder generar el mapa mental deseado. Facilitamos aquí una versión de este código generada por MateriaGuru.

Figura 21: Visualización de mapas mentales.

7. Resultados y conclusiones

En el ejercicio de construcción de un asistente experto utilizando GPT-4, hemos logrado crear un modelo especializado en minerales críticos. Este asistente proporciona información detallada y actualizada sobre minerales críticos, apoyando la toma de decisiones estratégicas y promoviendo la educación en este campo. Primero recopilamos información de fuentes confiables como el RMIS, la Agencia Internacional de la Energía (IEA), y el Instituto Geológico y Minero Español (BDMIN). Posteriormente, procesamos y estructuramos los datos adecuadamente para su integración en el modelo. Las validaciones demostraron que el asistente responde de manera precisa a preguntas relevantes del dominio, facilitando el acceso a su información.

De esta forma, el desarrollo del asistente especializado en minerales críticos ha demostrado ser una solución efectiva para centralizar y facilitar el acceso a información compleja y dispersa.

La utilización de herramientas como Google Colab y Markmap ha permitido una mejor organización y visualización de los datos, aumentando la eficiencia en la gestión del conocimiento. Este enfoque no solo mejora la comprensión y el uso de la información sobre minerales críticos, sino que también prepara a los usuarios para aplicar estos conocimientos en contextos reales.

La experiencia práctica adquirida en este ejercicio es directamente aplicable a otros proyectos que requieran la personalización de modelos de lenguaje para casos de uso específicos.

8. ¿Quieres realizar el ejercicio?

Si quieres replicar este ejercicio, accede a este repositorio donde encontrarás más información (las prompt utilizadas, el código generado por MateriaGuru, etc.)

Además, recuerda que tienes a tu disposición más ejercicios en el apartado sección de “Visualizaciones paso a paso”.

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

En el vasto panorama tecnológico, pocas herramientas han marcado una huella tan profunda como Google Maps. Desde sus inicios, esta aplicación se convirtió en el estándar de búsqueda y navegación de puntos de interés en mapas. Pero, ¿qué sucede cuando buscamos opciones más allá de la omnipresente aplicación de mapas? En este post repasamos posibles alternativas a la conocida aplicación de Google.

Introducción

A principios de 2005, el blog oficial de Google publicó una breve nota de prensa en la que presentaron su última creación: Google Maps. Para hacernos a la idea que cómo era el año 2005, tecnológicamente hablando, basta con mirar los terminales móviles más rompedores aquel año:

Créditos de las imágenes: Cinco móviles que marcaron el año 2005

Algunos todavía recordamos cómo era la experiencia (o ausencia de experiencia) de ejecutar apps en estos terminales. Pues bien, en ese año se lanza la primera versión de Google Maps que nos permitía buscar restaurantes, hoteles y otros elementos cerca de nuestra ubicación, así como averiguar la ruta más óptima para ir del punto A al punto B sobre una versión digital de un mapa de nuestra ciudad. Además, ese mismo año, también se lanza Google Earth, que supuso un verdadero hito tecnológico al facilitar el acceso para casi todos los ciudadanos del mundo a imagen satelital.

Desde entonces, el ecosistema digital de mapas y navegación de Google, con su interfaz intuitiva y las innovadoras funciones de realidad aumentada, ha sido un faro que guía a millones de usuarios en sus viajes diarios.

Pero, ¿y si buscamos algo diferente? ¿Qué alternativas existen para aquellos que desean explorar nuevos horizontes? Acompáñanos en este viaje en el que nos aventuramos en el fascinante mundo de sus competidores. Desde opciones más especializadas hasta aquellas que priorizan la privacidad, descubriremos juntos las diversas rutas que podemos tomar en el vasto paisaje de la navegación digital.

Alternativas a Google Maps

Casi seguro que algunos de vosotros, lectores, habéis visto o utilizado alguna de las alternativas a Google Maps de código abierto, aunque a lo mejor no lo sabes. Por citar solo algunas de las alternativas más conocidas:

1. OpenStreetMap (OSM): OpenStreetMap es un proyecto colaborativo que crea un mapa del mundo editable por la comunidad. Ofrece datos geoespaciales abiertos y libres que pueden ser utilizados para diversas aplicaciones, desde navegación hasta análisis urbanos.

2. uMap: uMap es una herramienta online que permite a los usuarios crear mapas personalizados con capas de OpenStreetMap. Es fácil de usar y ofrece opciones de personalización, lo que la convierte en una opción popular para la creación rápida de mapas interactivos.

3. GraphHopper: GraphHopper es una solución para la creación de rutas de código abierto que utiliza datos de OpenStreetMap. Destaca por su capacidad para calcular rutas eficientes para vehículos, bicicletas y peatones, y puede ser utilizado como parte de aplicaciones personalizadas.

4. Leaflet: Leaflet es una librería de código abierto en JavaScript para mapas interactivos compatibles con dispositivos móviles. Es probablemente la librería más extendida por su bajo peso en KB y porque incluye todas las funciones de cartografía que la mayoría de los desarrolladores puedan necesitar.

5. Overture Maps: Mientras que las cuatro soluciones anteriores ya están ampliamente establecidas en el mercado, Overture Maps es un nuevo player. Se trata de un proyecto colaborativo para crear mapas abiertos interoperables.

De todas ellas, vamos a centrarnos en OpenStreetMap (OSM) y Overture Maps.

Open Street Maps: una herramienta colaborativa y abierta

De las citadas soluciones anteriores, probablemente, la más extendida y conocida sea Open Street Maps.

OpenStreetMap (OSM) destaca como una de las mejores alternativas a Google Maps de código abierto por varias razones:

-

En primer lugar, la característica fundamental de OpenStreetMap radica en su naturaleza colaborativa y abierta, donde una comunidad global contribuye a la creación y actualización constante de datos geoespaciales.

-

Además, OpenStreetMap proporciona datos libres y accesibles que pueden ser utilizados de manera flexible en una amplia gama de aplicaciones y proyectos. Citando literalmente su web, se puede leer: OpenStreetMap es datos abiertos: eres libre de usarlo para cualquier propósito siempre y cuando acredites a OpenStreetMap y a sus colaboradores. Si modificas o construyes sobre los datos de ciertas maneras, puedes distribuir el resultado solo bajo la misma licencia. Consulta la página de Derechos de Autor y Licencia para obtener más detalles.

-

La capacidad para personalizar mapas y la flexibilidad de integración de OpenStreetMap son también características muy destacadas. Los desarrolladores pueden adaptar fácilmente los mapas a las necesidades específicas de sus aplicaciones, aprovechando la API de OpenStreetMap. Esta es la clave del desarrollo de un ecosistema de aplicaciones alrededor de OSM cómo uMap, Leaflet o GraphHopper, entre otras muchas.

Overture Maps. Un competidor singular

Quizás, uno de los proyectos más prometedores que haya aparecido recientemente en la escena tecnológica mundial sea Overture Maps. Como indican (el pasado julio de este año) desde su fundación (OMF Overture Maps Foundation), se ha liberado el lanzamiento de su primer conjunto de datos abiertos, marcando un hito significativo en el esfuerzo colaborativo para crear productos de mapas abiertos interoperables. La primera versión Overture incluye cuatro capas de datos únicas:

-

Lugares de Interés (POIs)

-

Edificaciones

-

Red de Transporte

-

Límites Administrativos

Ejemplo de cobertura de lugares públicos en todo el mundo identificados en el dataset inicial del proyecto. La primera versión del paquete de datos de overture maps contiene, entre otros, 59 millones de registros de puntos de interés, 780 millones de edificios, redes de transporte y límites administrativos nacionales y regionales en todo el mundo.

Estas capas, que fusionan diversas fuentes de datos de mapas abiertos, se han validado y contrastado a través de controles de calidad y se lanzan bajo el esquema de datos de Overture Maps, hecho público en junio de 2023. En concreto, la capa de Lugares de Interés incluye datos sobre más de 59 millones de lugares en todo el mundo. Este conjunto de datos se presenta como un elemento fundamental para la navegación, la búsqueda local y para diversas aplicaciones basadas en la ubicación. Las otras tres capas incluyen información detallada sobre edificaciones (con más de 780 millones de huellas de edificaciones en todo el mundo), una red de transporte global derivada del proyecto OpenStreetMap y límites administrativos a nivel mundial con nombres regionales traducidos a más de 40 idiomas.

Uno de los datos más significativos de este anuncio quizás sea el de los colaboradores que se han unido para realizar este proyecto. La colaboración de Overture, fundada en diciembre de 2022 por Amazon Web Services (AWS), Meta, Microsoft y TomTom, ahora cuenta con más de una docena de empresas tecnológicas y del sector geoespacial, incluyendo nuevos miembros como Esri, Cyient, InfraMappa, Nomoko, Precisely, PTV Group, SafeGraph, Sanborn y Sparkgeo. La premisa central de esta colaboración es la necesidad de compartir datos de mapas como un activo común para respaldar futuras aplicaciones.

Como buen proyecto de código abierto, la fundación Overture ha puesto a disposición de la comunidad de desarrollo un repositorio de Github donde poder contribuir al proyecto.

En definitiva, los mapas digitales, sus correspondientes capas de datos geoespaciales, las capacidades de navegación y foto-geolocalización son activos vitales y estratégicos para las organizaciones sociales y tecnológicas alrededor del mundo. Ahora, cuando queda muy poco para el 20 aniversario del nacimiento de Google Maps, existen buenas alternativas de código abierto y los grandes actores del panorama tecnológico internacional se unen para generar aún activos espaciales de mayor valor. ¿Quién ganará esta nueva carrera? No lo sabemos, pero seguiremos muy de cerca las noticias de actualidad sobre este tema.

El Instituto Canario de Estadística (ISTAC) ha dado un paso significativo en volumen de datos geográficos gracias a la publicación de un total de 4.002 nuevos conjuntos de datos (3.859 mapas temáticos y 143 cubos estadísticos) en datos.gob.es , tras su federación en Canarias Datos Abiertos.

Este tipo de iniciativas están alineadas con la Estrategia de datos de la Unión Europea que establece las pautas para lograr un mercado único de datos que beneficie a las empresas, investigadores y administraciones públicas. La automatización de procesos de publicación mediante estándares comunes es clave para garantizar la interoperabilidad y el acceso adecuado a los conjuntos de datos abiertos de las AA.PP.

La generación de estos conjuntos de datos es la culminación de un trabajo de automatización que ha permitido la ampliación del número de cubos publicados, ya que ahora se presentan combinaciones de granularidad y año desde 2004. A principios de octubre, el ISTAC añadió a su catálogo más de 500 activos semánticos y más de 2100 cubos estadísticos, tal y como contamos en este post de datos.gob.es.

Además, los conjuntos publicados hasta la fecha se han sometido a un proceso de renovación para convertirse en los citados 143 cubos estadísticos. El incremento de estos conjuntos de datos mejora no solo cuantitivamente el directorio de datos.canarias.es y datos.gob.es, sino que amplía los usos que ofrece gracias al tipo de información añadida.

Los indicadores de estos cubos se representan sobre la cartografía a través de mapas de coropletas y en múltiples formatos. Esta automatización permitirá a su vez, no solo publicar otros conjuntos de datos de manera más sencilla en el futuro, sino que también se pueda hacer con más frecuencia.

Otro de los avances de este trabajo es que los servicios se generan al vuelo desde el servidor de mapas Geoserver, y no a través de una carga en CKAN, como se hacía hasta ahora, lo cual reduce su almacenamiento y agiliza su actualización.

Cómo acercar los indicadores demográficos a la población

Los indicadores demográficos son cubos densos en datos que ofrecen una gran cantidad de información geográfica detallada, incluyendo población total, desagregada por sexo, residencia, edad y otros índices hasta sumar 27 variables diferentes.

Al haber contenida tanta información en cada cubo, se puede dificultar la representación de los indicadores específicos sobre la cartografía, especialmente si el usuario no está habituado a trabajar con determinados softwares GIS (sistema de información geográfica, por sus siglas en inglés Geographical Information System ).

Para acercar este contenido a todo tipo de usuarios, el ISTAC ha generado 3.859 nuevos mapas, representando sobre un mapa de coropletas cada uno de los indicadores contenidos en los 143 cubos estadísticos. La publicación de estos nuevos datos cartográficos se presenta así como una forma más eficiente y simplificada de obtener la información ya representada, permitiendo a los usuarios acceder fácilmente a los datos específicos que necesitan.

Podríamos comparar esta transformación con las flores. Anteriormente solo se publicaban ramos enteros , con 27 flores por ramo, que había que saber gestionar y manejar para representar las flores que fueran de interés. Ahora, además de seguir publicando los ramos, se han generado nuevos procesos para poder publicar cada flor por separado, automatizando la generación de cada uno de estos conjuntos, que también se actualizarán con mayor frecuencia.

Esta nueva opción facilita la utilización de estos mapas de coropletas (como el que vemos en la imagen) por parte de personas sin conocimientos técnicos GIS, ya que se presentan en formatos fácilmente descargables como imagen (.jpg y .png) para un uso profesional, educativo o personal.

Mapa de población de 65 o más años (% sobre total) por municipios. Año 2022

Para los usuarios más avanzados, el ISTAC también ha ampliado la oferta de formatos en los que se sirven los cubos de indicadores originales. Los “ramos”, que anteriormente solo mostraban los datos en formato CSV, ahora cuentan con una amplia variedad de distribuciones: KML, GML, GeoPackage, GeoJSON, WFS, WMS. Aprovechando las ventajas que proporciona el uso de los estilos en el formato WMS, se han generado todos los estilos asociados a los indicadores, de manera que, haciendo uso de ellos, se consigue representar el mismo mapa que se descarga en formato imagen. Estos estilos están calculados para cada combinación de indicador-granularidad-año, según el método de cálculo de cuantiles para cinco intervalos.

Este nuevo enfoque con datos geográficos, tanto simples como complejos, enriquece el catálogo y permite que usuarios sin conocimientos específicos puedan acceder a ellos y reutilizarlos. Además, hay que tener en cuenta que esto abre las puertas a otras publicaciones masivas de datos basados en otras operaciones estadísticas.

En definitiva, se trata de un paso importante en el proceso de apertura de datos. Un proceso que permite mejorar el uso y la compartición de datos, tanto para el usuario de pie, como para profesionales del sector. Dada la creciente necesidad de compartir, procesar y comparar datos, se hace indispensable la aplicación de procesos que faciliten la interoperabilidad y el acceso adecuado a los datos abiertos . En este sentido, el Instituto Canario de Estadística está concentrando esfuerzos para garantizar que sus conjuntos de datos abiertos sean accesibles y estén en los formatos adecuados para su compartición. Todo ello para lograr obtener valor a partir de ellos.

Los datos son una fuente de conocimiento de gran valor para la sociedad. El compromiso público para lograr su apertura, la colaboración público-privada en materia de datos y el desarrollo de aplicaciones con datos abiertos son acciones que forman parte de la economía del dato, aquella que persigue el uso innovador, ético y práctico de los datos para mejorar el desarrollo social y económico.

Tan relevante es lograr un acceso y uso público de los datos como transmitir correctamente esa información tan valiosa. Para elegir cuál es el mejor gráfico para cada tipo de datos es necesario identificar el tipo de variables y la relación que existe entre ellas.

A la hora de comparar datos, debemos revisar que las variables sean de la misma naturaleza, es decir, variables cuantitativas o cualitativas, estar en la misma unidad de medida y que su contenido sea comparable.

Presentamos a continuación diferentes visualizaciones, sus normas de uso y las situaciones más adecuadas para emplear cada tipo. Abordamos una serie de ejemplos, desde los más sencillos como gráficos de barras hasta gráficos menos conocidos como las tablas de calor o las comparaciones acumuladas.

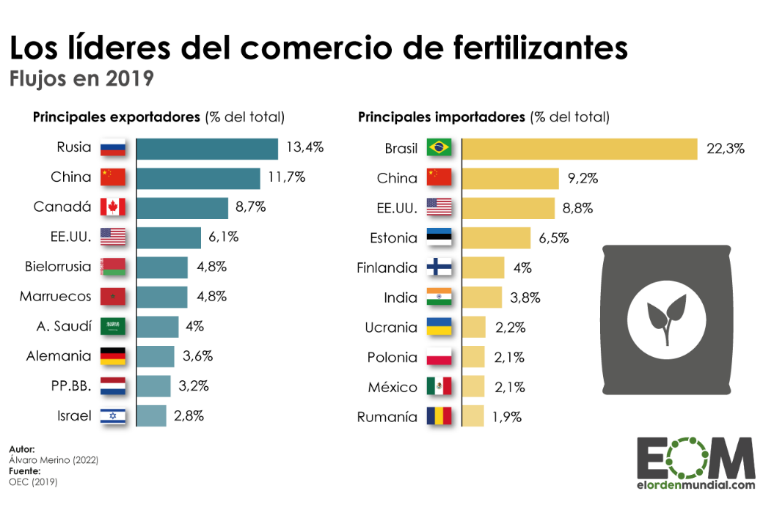

Gráficos de barras

Visualización que representa datos mediante dos ejes: uno que recoge datos cualitativos o de tiempo y otro que muestra los valores cuantitativos. También se utiliza para analizar tendencias porque uno de los ejes puede mostrar datos temporales. Si se le da la vuelta a los ejes se obtiene un gráfico de columnas.

Buenas prácticas:

- Mostrar las etiquetas de valor de los ejes y reservar las etiquetas como ventanas emergentes para los datos secundarios.

- Utilizarlo para representar menos de 10 puntos de valores. Cuando se quiera visualizar más puntos de valores será más adecuado emplear un gráfico de línea.

- Diferenciar claramente los datos reales de las estimaciones.

- Combinar con un gráfico de líneas para mostrar tendencias o la media.

- Colocar aquella con descripciones más largas en el eje vertical, cuando ninguna variable sea temporal.

Fuente: El Orden Mundial https://elordenmundial.com/mapas-y-graficos/comercio-fertilizantes-mundo/

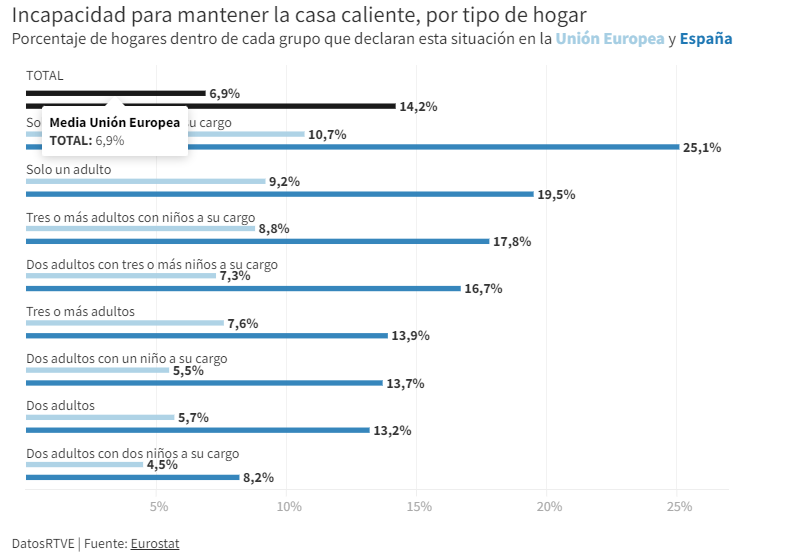

Gráficos de barras agrupadas

Tipo de gráfico de barras en el que cada categoría de datos se divide a su vez en dos o más subcategorías. Por lo tanto, el escenario comparativo abarca más factores.

Buenas prácticas

- Limitar el número de categorías para no mostrar demasiada información en el gráfico.

- Introducir un máximo de tres o cuatro subcategorías dentro de cada categoría. En el caso de que se necesite mostrar más agrupaciones, se puede valorar el uso de las barras apiladas o un conjunto de gráficas.

- Elegir colores que contrasten entre sí para diferenciar las barras de cada subcategoría.

Fuente: RTVE https://www.rtve.es/noticias/20230126/pobreza-energetica-espana/2417050.shtml

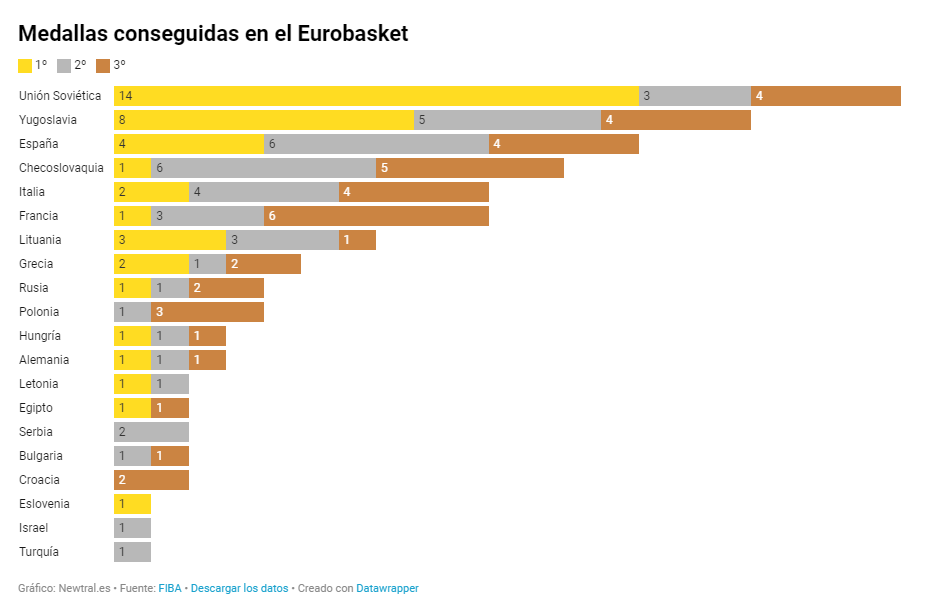

Gráficos de comparaciones acumuladas

Muestran la composición de una categoría de forma acumulada. Además de ofrecer una comparación entre variables, estos gráficos pueden evidenciar la segmentación de cada categoría. Pueden ser de barras apiladas o áreas acumuladas.

Buenas prácticas

- Evitar utilizar gráficos de barras apiladas a la hora de comparar segmentos de cada categoría entre sí. En ese caso, mejor utilizar gráficos múltiples.

- Limitar el número de subcategorías de las barras apiladas o segmentos de las áreas.

- Aplicar contraste de color entre las categorías y cumplir con los principios de accesibilidad.

Fuente: Newtral https://www.newtral.es/medallas-espana-eurobasket/20220917/

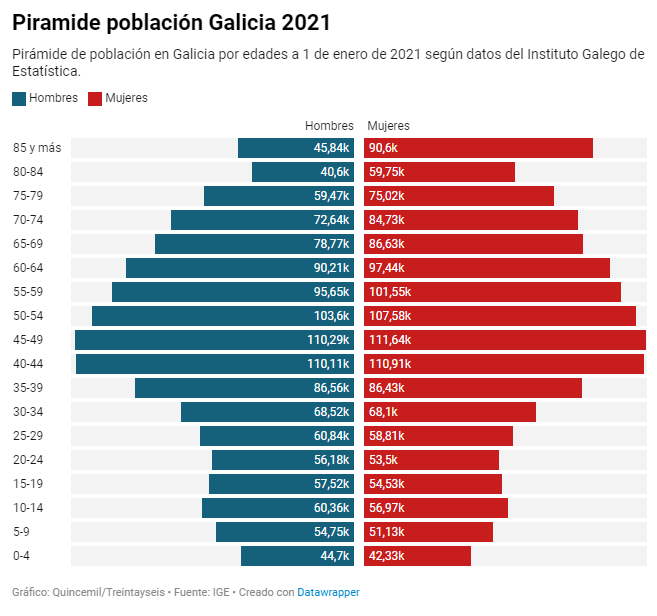

Pirámide de población

Combinación de dos gráficos de barras horizontales que comparten un eje vertical que representa el valor inicial y muestra dos valores que crecen a ambos lados de forma simétrica.

Buenas prácticas

- Definir un criterio de orden común como puede ser la edad.

- Representar los datos en números absolutos o porcentajes para tener en cuenta que la suma de los dos valores que se están comparando representa el total.

Fuente: El Español https://www.elespanol.com/quincemil/articulos/actualidad/asi-es-la-alarmante-piramide-de-poblacion-de-galicia-en-2021

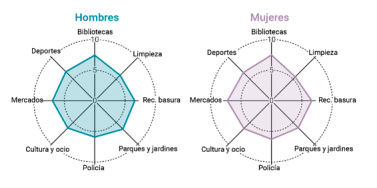

Gráfico de radar

Visualización circular formada por ejes polares que sirven para representar medidas con categorías que forman parte de un mismo tema. De cada categoría salen unos ejes radiales que confluyen en el punto central del gráfico.

Buenas prácticas:

- Mantener los datos numéricos dentro de un mismo rango de valores para evitar mostrar un gráfico deformado.

- Limitar el número de categorías con series de datos. Un número adecuado podría estar entre cuatro y siete categorías.

- Agrupar en un sector del círculo del radar las categorías que tengan relación entre sí o que compartan jerarquía común.

Fuente: Guía de visualización de datos para Entidades Locales https://redtransparenciayparticipacion.es/download/guia-de-visualizacion-de-datos-para-entidades-locales/

Tabla de calor

Representación gráfica en formato tabla que permite evaluar dos dimensiones distintas que aparecen diferenciadas con grados de tonalidad de color o códigos de semáforo.

Buenas prácticas

- Indicar el valor en cada celda porque el color solo es un atributo orientativo. En los gráficos interactivos, los valores se pueden identificar con una etiqueta emergente.

- Incluir en el gráfico un esquema o leyenda para explicar el significado de la escalera de color.

- Utilizar colores accesibles para todas las personas y con una semántica reconocible como degradados, frío-calor o semafóricos.

- Limitar o reducir la información representada en medida de lo posible.

Fuente: eldiario.es https://www.eldiario.es/sociedad/clave-saturacion-primaria-ratios-mitad-medicos-asignados-1-500-pacientes_1_9879407.html

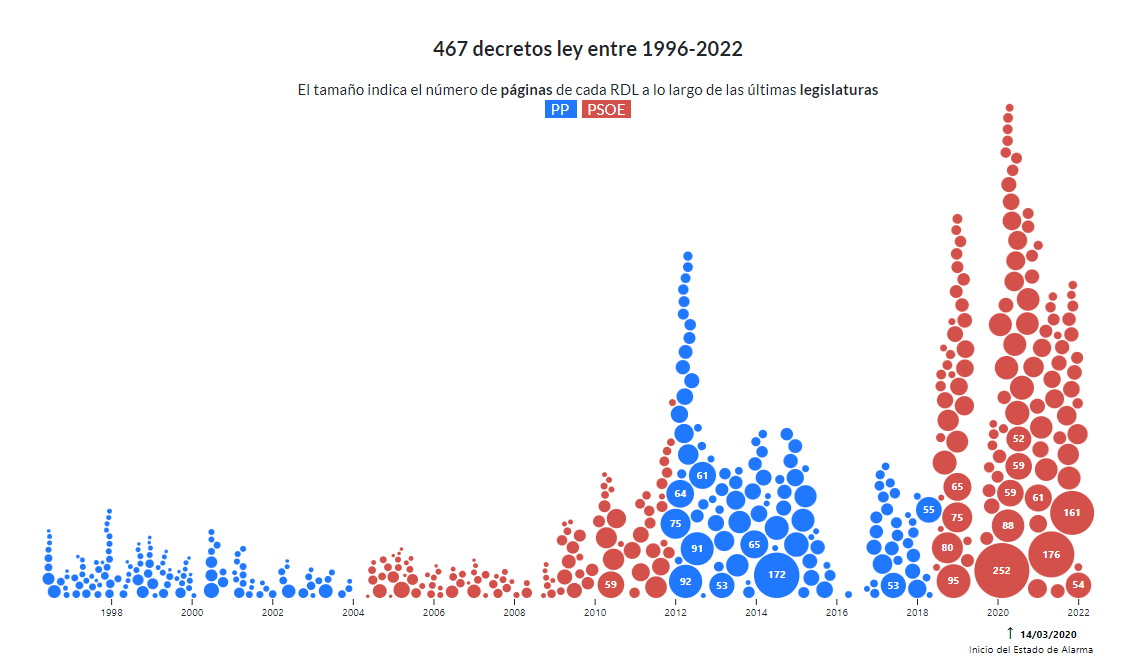

Gráfico de burbujas

Variedad del diagrama de dispersión que, a mayores, mediante el tamaño de la burbuja, representa una dimensión adicional. En este tipo de gráfico, es posible asignar diferentes colores para asociar grupos o separar categorías. Además de poder emplearlo para comparar variables, el gráfico de burbujas sirve para analizar distribuciones de frecuencias. Es habitual encontrar este tipo de visualizaciones en infografías, cuando no es tan relevante conocer el dato exacto como sí resaltar las diferencias de intensidad de valores.

Buenas prácticas

- Evitar la superposición de burbujas para que la información sea clara.

- Mostrar las etiquetas de valores siempre que sea posible y el número de burbujas lo permita.

Fuente: Civio https://civio.es/el-boe-nuestro-de-cada-dia/2022/07/07/decretos-ley-desde-1996/

Nube de palabras

Recurso gráfico que muestra palabras en mayor o menor tamaño en función de su frecuencia en un conjunto de datos. Para desarrollar este tipo de visualizaciones, se utiliza procesamiento de lenguaje natural (PLN) que es el campo de estudio de inteligencia artificial que utilizar el aprendizaje automático para interpretar textos y datos.

Buenas prácticas

- Se recomienda usar este recurso en infografías donde no sea relevante mostrar la cifra exacta sino una aproximación visual.

- Procurar que la longitud de las palabras sea similar para evitar que afecte a la percepción.

- Facilitar su lectura mostrando las palabras en horizontal.

- Presentar las palabras en un único color para mantener una representación neutra.

Esta visualización gráfica del que publicamos un artículo paso a paso, es una nube de palabras clave de varios textos de datos.gob.es.

Hasta aquí, hemos explicado los tipos de gráficos de comparaciones más comunes destacando ejemplos en medios de comunicación y fuentes de referencia. Sin embrago, podemos encontrar más modelos de visualizaciones para comparar datos en la Guía de Visualización de datos para entidades locales que ha servido de referencia para elaborar este post y otros que publicaremos próximamente. Este artículo forma parte de una serie de post sobre cómo elaborar diferentes tipos de visualizaciones según la relación de los datos y el objetivo de cada ejercicio.

Tal y como repite el mantra popular, “una imagen vale más que mil palabras” podría adaptarse a que “un gráfico vale más que mil números”. La visualización de datos sirve para hacer comprensible una información que, a priori, podría ser compleja.

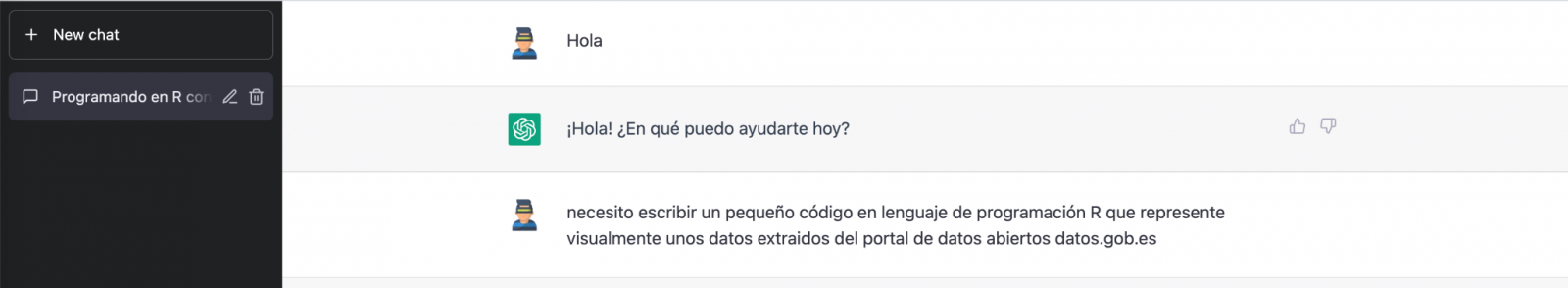

Hablar estos días de GPT-3 no es lo más original del mundo, lo sabemos. Toda la comunidad tecnológica está publicando ejemplos, realizando eventos y pronosticando el final del mundo del lenguaje y la generación de contenidos tal y cómo la conocemos actualmente. En este post, le pedimos a ChatGPT que nos eche una mano para programar un ejemplo de visualización de datos con R partiendo de un conjunto de datos abiertos disponible en datos.gob.es.

Introducción

Nuestro anterior post hablaba sobre Dall-e y la capacidad de GPT-3 para generar imágenes sintéticas partiendo de una descripción de lo que pretendemos generar en lenguaje natural. En este nuevo post, hemos realizado un ejercicio completamente práctico en el que le pedimos a la inteligencia artificial que nos ayude a realizar un sencillo programa en R que cargue un conjunto de datos abierto y genere algunas representaciones gráficas.

Hemos escogido un conjunto de datos abiertos de la plataforma datos.gob.es. En concreto, un conjunto de datos sencillos de uso de portales madrid.es. La descripción del repositorio explica que se incluye la información relativa a usuarios, sesiones y número de visitas a páginas de los siguientes portales del Ayuntamiento de Madrid: Portal Web municipal, Sede Electrónica, Portal de Transparencia, Portal de Datos Abiertos, Bibliotecas y Decide Madrid.

El fichero se puede descargar en formato .csv o .xslx y si lo pre-visualizamos tiene el siguiente aspecto:

Vale, comencemos a co-programar con ChatGPT!

Primero accedemos a la web y nos identificamos con nuestro usuario y contraseña. Es necesario estar registrado en el sitio web de openai.com para poder acceder a las capacidades de GPT-3, entre otras ChatGPT.

Iniciamos nuestra conversación:

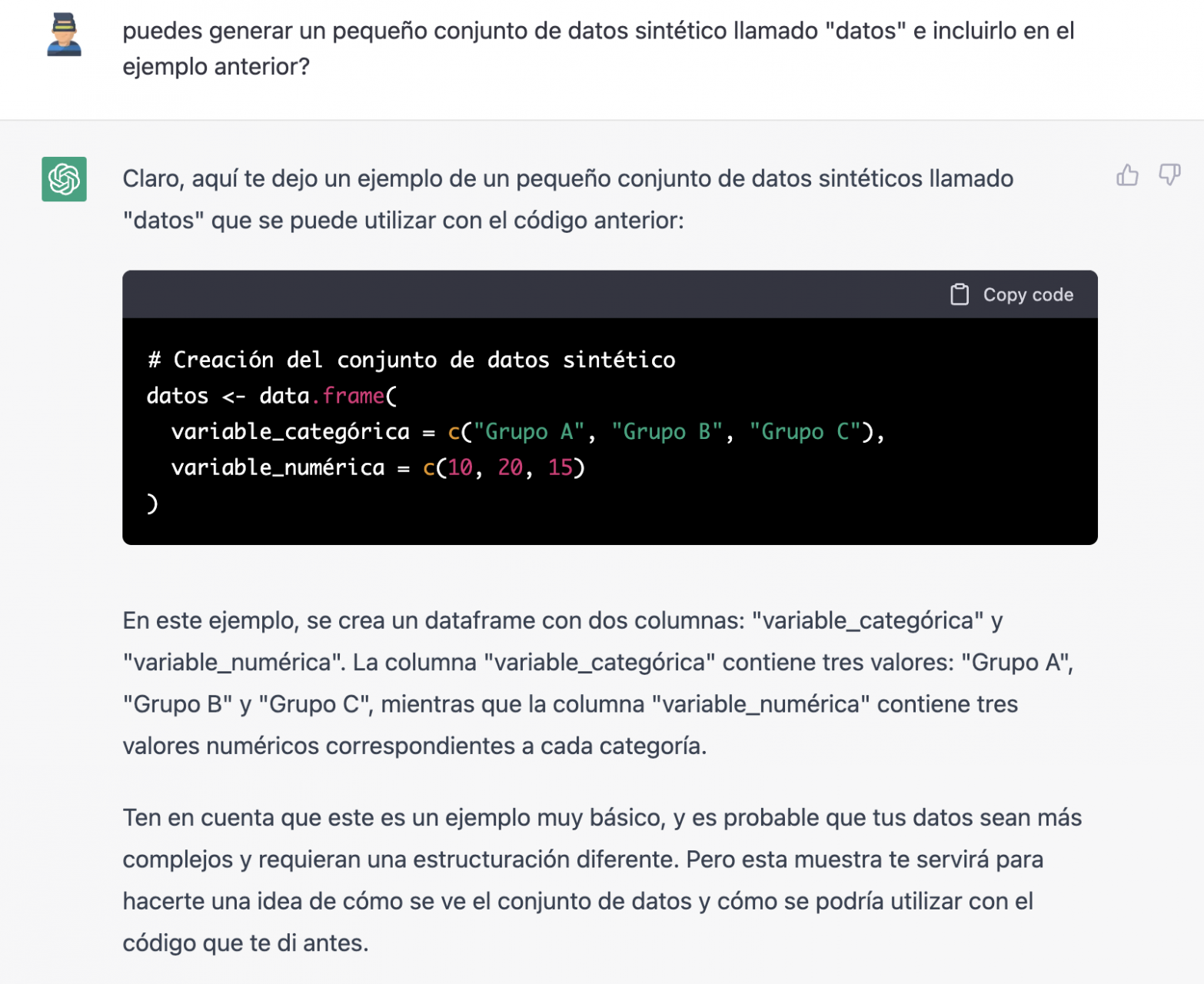

Durante este ejercicio hemos intentado mantener una conversación de la misma forma que la tendríamos con un compañero de programación. Así que lo primero que hacemos es saludar y enunciar el problema que tenemos. Cuándo le pedimos a la IA que nos ayude a crear un pequeño programa en R que represente gráficamente unos datos, nos ofrece algunos ejemplos y ayuda con la explicación del programa:

Puesto que no tenemos datos, no podemos hacer nada práctico por el momento, así que le pedimos si nos ayuda a generar unos datos sintéticos.

Como decimos, nos comportamos con la IA como lo haríamos con una persona (tiene buena pinta).

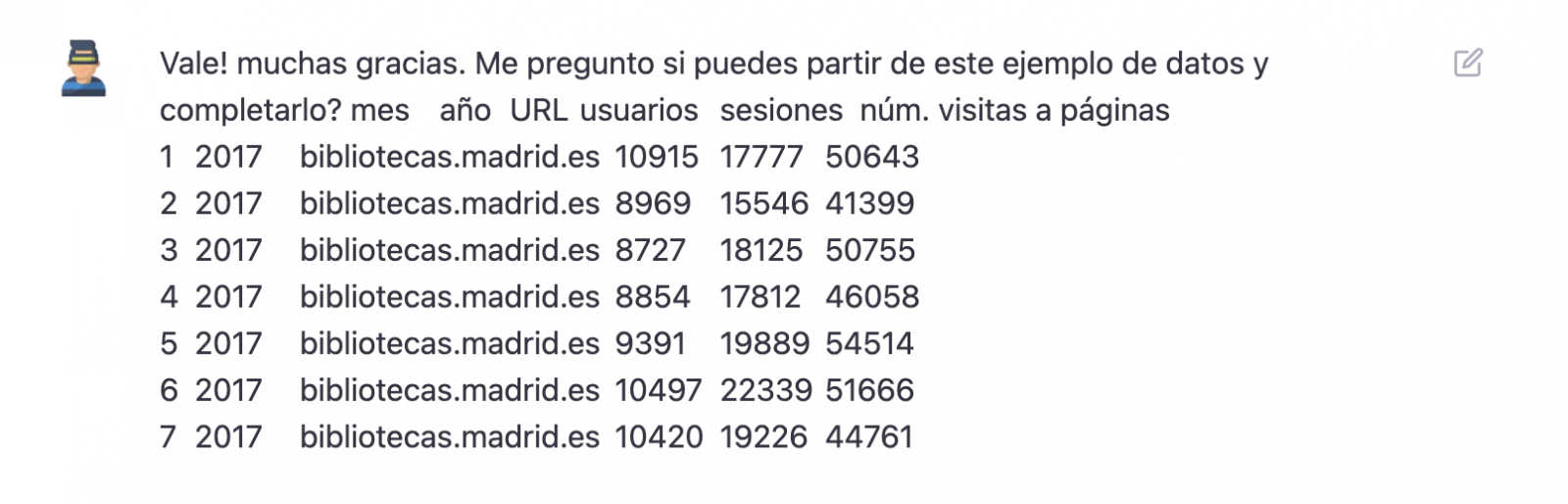

Una vez que parece que la IA responde con facilidad a nuestras preguntas, vamos con el siguiente paso, vamos a darle nosotros los datos. Y aquí empieza la magia… Hemos abierto el fichero de datos que nos hemos bajado de datos.gob.es y hemos copiado y pegado una muestra.

| Nota: ChatGPT no tiene conexión a Internet y por lo tanto no puede acceder a datos externos, así que lo único que podemos hacer es darle un ejemplo de los datos reales con los que queremos trabajar. |

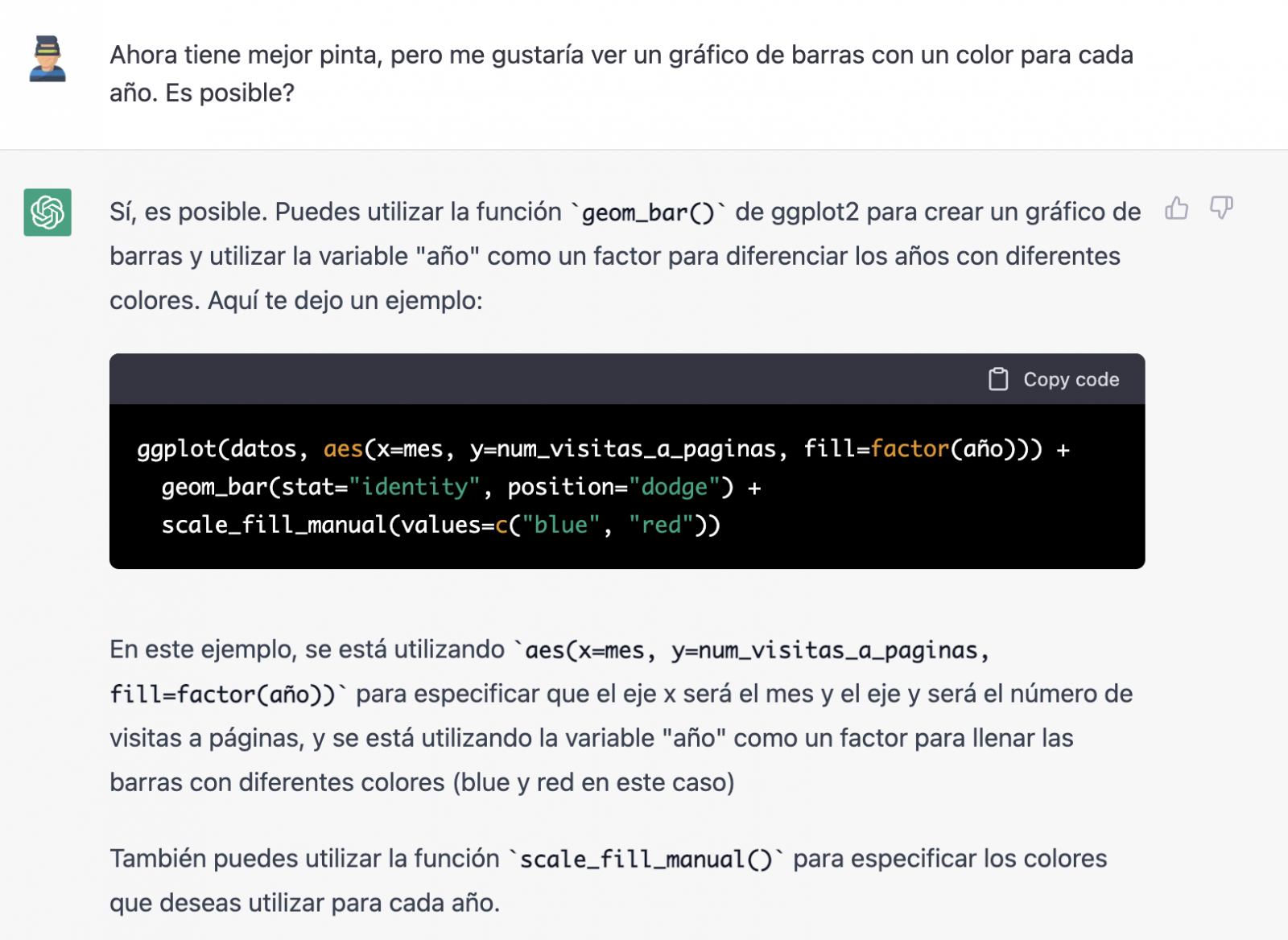

Con los datos copiados y pegados tal cual se los hemos dado, nos escribe el código en R para cargarlos manualmente en un dataframe denominado “datos”. A continuación, nos proporciona el código de ggplot2 (la librería gráfica más conocida en R) para graficar los datos junto con una explicación del funcionamiento del código.

¡Genial! Es espectacular este resultado con un lenguaje totalmente natural y nada adaptado para hablar con una máquina. Veamos que pasa a continuación:

Pero resulta que al copiar y pegar el código en un entorno de RStudio comprobamos que este falla.

Así que le decimos lo que pasa y que nos ayude a solucionarlo.

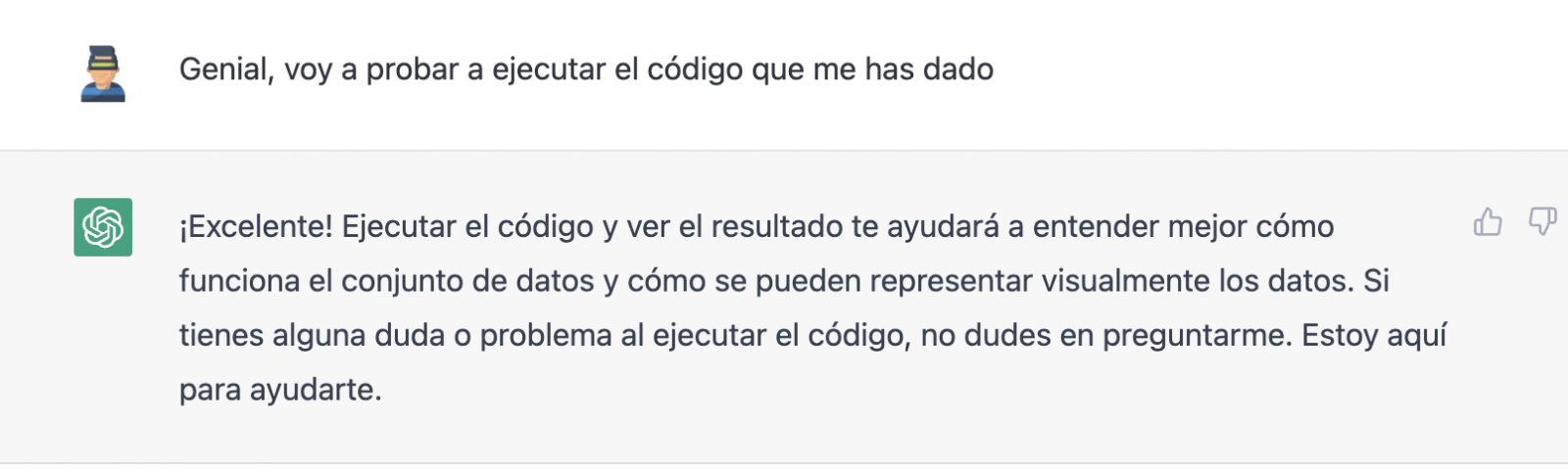

Probamos de nuevo y ¡en este caso funciona!

Sin embargo, el resultado es un poco tosco. Así que se lo decimos.

A partir de aquí (y tras varios intentos de copiar y pegar más y más filas de datos) la IA cambia ligeramente el enfoque y me proporciona instrucciones y código para cargar mi propio fichero de datos desde mi ordenador en lugar de introducir manualmente los datos en el código.

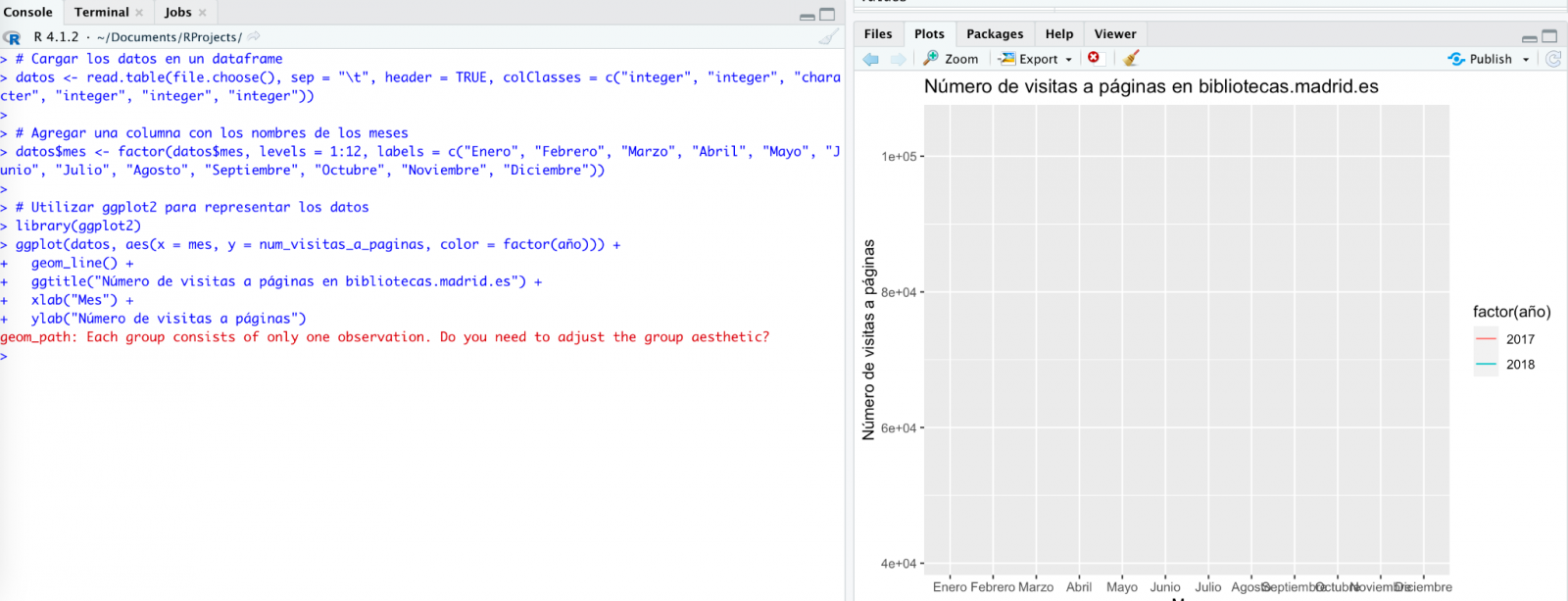

Le hacemos caso y copiamos un par de años de datos en un fichero de texto en nuestro ordenador. Fijaos, en lo que ocurre a continuación:

Probamos de nuevo:

Como veis, funciona, pero el resultado no es del todo acertado.

Y veamos lo que ocurre.

¡Por fin parece que ya nos ha entendido! Es decir, tenemos un gráfico de barras con las visitas a la web por mes, para los años 2017 (azul) y 2018 (rojo). Sin embargo, no me convencen ni el formato del título del eje ni tampoco se distingue bien la numeración del mismo eje.

Veamos el resultado ahora.

Tiene mucha mejor pinta, ¿verdad? Pero ¿qué tal si todavía le damos una vuelta de tuerca más?

Sin embargo, se ha olvidado de decirnos que debemos instalar el paquete o librería plotly en R. Así que se lo recordamos.

Veamos el resultado:

Como podéis ver, ahora tenemos los controles del gráfico interactivo, de tal modo que podemos seleccionar un año concreto de la leyenda, hacer zoom, etc.

Conclusión

Puede que seas de esos escépticos, conservadores o prudentes que piensan que las capacidades demostradas por GPT-3 hasta el momento (ChatGPT, Dall-E2, etc) son todavía muy infantiles y poco prácticas en la vida real. Todas las consideraciones a este respecto son legítimas y, muchas, probablemente bien fundamentadas.

Sin embargo, algunos hemos pasado buena parte de la vida escribiendo programas, buscando documentación y ejemplos de código que pudiéramos adaptar o en los que inspirarnos; depurando errores, etc. Para todos nosotros (programadores, analistas, científicos, etc.) poder experimentar este nivel de interlocución con una inteligencia artificial en modo beta, puesta a disposición del público de forma gratuita y siendo capaz de demostrar esta capacidad de asistencia en la co-programación, es, sin duda, un salto cualitativo y cuantitativo en la disciplina de la programación.

No sabemos qué va a pasar, pero probablemente estemos a las puertas de un gran cambio de paradigma en la ciencia de la computación, hasta el punto que, quizás, haya cambiado para siempre la forma de programar y aún no nos hayamos dado cuenta.

Contenido elaborado por Alejandro Alija, experto en Transformación Digital.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.