Vivimos rodeados de resúmenes generados por inteligencia artificial (IA). Tenemos la opción de generarlos desde hace meses, pero ahora se imponen en las plataformas digitales como el primer contenido que ven nuestros ojos al usar un buscador o abrir un hilo de emails. En plataformas como Microsoft Teams o Google Meet las reuniones por videollamada se transcriben y se resumen en actas automáticas para quien no ha podido estar presente, pero también para quien ha estado. Sin embargo, aquello que un modelo de lenguaje ha considerado importante, ¿es realmente lo importante para quien recibe el resumen?

En este nuevo contexto, la clave es aprender a recuperar el sentido detrás de tanta información resumida. Estas tres estrategias te ayudarán a transformar el contenido automático en una herramienta de comprensión y toma de decisiones.

1. Haz preguntas expansivas

Solemos resumir para reducir un contenido que no somos capaces de abarcar, pero corremos el riesgo de asociar breve con significativo, una equivalencia que no siempre se cumple. Por tanto, no deberíamos enfocarnos desde el inicio en resumir, sino en extraer información relevante para nosotros, nuestro contexto, nuestra visión de la situación y nuestra manera de pensar. Más allá del prompt básico “hazme un resumen”, esta nueva manera de enfocar un contenido que se nos escapa consiste en cruzar datos, conectar puntos y sugerir hipótesis, lo que llaman sensemaking o “construcción de sentido”. Y pasa, en primer lugar, por tener claro qué queremos saber.

Situación práctica:

Imaginemos una reunión larga a la que no hemos podido acudir. Esa tarde, recibimos en nuestro correo electrónico un resumen de los temas tratados. No siempre es posible, pero una buena práctica en este punto, si nuestra organización lo permite, es no quedarnos solo con el resumen: si está permitido, y siempre respetando las directrices de confidencialidad, sube la transcripción completa a un sistema conversacional como Copilot o Gemini y haz preguntas específicas:

-

¿Qué tema se repitió más o recibió más atención durante la reunión?

-

En una reunión anterior, la persona X usó este argumento. ¿Se usó de nuevo? ¿Lo discutió alguien? ¿Se dio por válido?

-

¿Qué premisas, suposiciones o creencias están detrás de esta decisión que se ha tomado?

-

Al final de la reunión, ¿qué elementos parecen más críticos para el éxito del proyecto?

-

¿Qué señales anticipan posibles retrasos o bloqueos? ¿Cuáles tienen que ver o podrían afectar a mi equipo?

Cuidado con:

Ante todo, revisa y confirma las atribuciones. Los modelos generativos son cada vez más precisos, pero tienen una gran capacidad para mezclar información real con información falsa o generada. Por ejemplo, pueden atribuir una frase a alguien que no la dijo, relacionar como causa-efecto ideas que en realidad no tenían conexión, y seguramente lo más importante: asignar tareas o responsabilidades de próximos pasos a alguien a quien no le corresponden.

2. Pide contenido estructurado

Los buenos resúmenes no son más cortos, sino más organizados, y el texto redactado no es el único formato al que podemos recurrir. Busca la eficacia y pide a los sistemas conversacionales que te devuelvan tablas, categorías, listas de decisiones o mapas de relaciones. La forma condiciona el pensamiento: si estructuras bien la información, la entenderás mejor y también la transmitirás mejor a otros, y por tanto irás más lejos con ella.

Situación práctica:

En este caso, imaginemos que recibimos un informe largo sobre el avance de varios proyectos internos de nuestra empresa. El documento tiene muchas páginas con párrafos descriptivos de estado, feedback, fechas, imprevistos, riesgos y presupuestos. Leerlo todo línea por línea sería imposible y no retendríamos la información. La buena práctica aquí es pedir una transformación del documento que nos sea útil de verdad. Si es posible, sube el informe al sistema conversacional y solicita contenido estructurado de manera exigente y sin escatimar en detalles:

-

Organiza el informe en una tabla con las siguientes columnas: proyecto, responsable, fecha de entrega, estado, y una columna final que indique si ha ocurrido algún imprevisto o se ha materializado algún riesgo. Si todo va bien, imprime en esa columna “CORRECTO”.

-

Genera un calendario visual con los entregables, sus fechas de entrega y los responsables, que empiece el 1 de octubre de 2025 y termine el 31 de enero de 2026, en forma de diagrama de Gantt.

-

Quiero una lista en la que aparezcan exclusivamente el nombre de los proyectos, su fecha de inicio y su fecha de entrega. Ordena por la fecha de entrega, las más cercanas primero.

-

Del apartado de feedback de los clientes que encontrarás en cada proyecto, crea una tabla con los comentarios más repetidos y a qué áreas o equipos suelen hacer referencia. Colócalos en orden, de los que más se repiten a los que menos.

-

Dame la facturación de los proyectos que están en riesgo de no cumplir plazos, indica el precio de cada uno y el total.

Cuidado con:

La ilusión de veracidad y exhaustividad que nos va a proporcionar un texto limpio, ordenado, automático y con fuentes es enorme. Un formato claro, como una tabla, una lista o un mapa, puede dar una falsa sensación de precisión. Si los datos de origen son incompletos o erróneos, la estructura solo maquilla el error y tendremos más dificultades para verlo. Las producciones de la IA suelen ser casi perfectas. Como mínimo, y si el documento es muy extenso, haz comprobaciones aleatorias ignorando la forma y centrándote en el contenido.

3. Conecta los puntos

El sentido estratégico rara vez está en un texto aislado, y mucho menos en un resumen. El nivel avanzado en este caso consiste en pedir al chat multimodal que cruce fuentes, compare versiones o detecte patrones entre varios materiales o formatos, como por ejemplo la transcripción de una reunión, un informe interno y un artículo científico. Lo que interesa realmente ver son claves comparativas como los cambios evolutivos, las ausencias o las inconsistencias.

Situación práctica:

Imaginemos que estamos preparando una propuesta para un nuevo proyecto. Tenemos varios materiales: la transcripción de una reunión del equipo directivo, el informe interno del año anterior y un artículo reciente sobre tendencias del sector. En lugar de resumirlos por separado, puedes subirlos al mismo hilo de conversación o a un chat que hayas personalizado sobre el tema, y pedirle acciones más ambiciosas.

-

Compara estos tres documentos y dime qué prioridades coinciden en todos, aunque se expresen de maneras distintas.

-

¿Qué temas del informe interno no se han mencionado en la reunión? Genera una hipótesis para cada uno sobre por qué no se han tratado.

-

¿Qué ideas del artículo podrían reforzar o cuestionar las nuestras? Dame ideas fuerza de la investigación que no estén reflejadas en nuestro informe interno.

-

Busca artículos en prensa de los últimos seis meses que avalen las ideas fuerza del informe interno.

-

Encuentra fuentes externas que complementen la información ausente en estos tres documentos sobre el tema X y genera un informe panorámico con referencias.

Cuidado con:

Es muy habitual que los sistemas de IA simplifiquen de forma engañosa debates complejos, no porque tengan un objetivo oculto sino porque en el entrenamiento se les ha premiado siempre la sencillez y la claridad. Además, la generación automática introduce un riesgo de autoridad: como el texto se presenta con apariencia de precisión y neutralidad, asumimos que es válido y útil. Y, por si fuera poco, los resúmenes estructurados se copian y comparten rápido. Antes de reenviar, asegúrate de que el contenido está validado, sobre todo si contiene decisiones, nombres o datos sensibles.

Conclusión

Los modelos basados en IA pueden ayudarte a visualizar convergencias, lagunas o contradicciones y, a partir de ahí, formular hipótesis o líneas de acción. Se trata de encontrar con mayor agilidad eso tan valioso que llamamos insights. Ese es el paso del resumen al análisis: lo más importante no es comprimir la información, sino seleccionarla bien, relacionarla y conectarla con el contexto. Intensificar la exigencia desde el prompt es la manera más adecuada de trabajar con los sistemas IA, pero también nos exige un esfuerzo personal previo de análisis y aterrizaje.

Contenido elaborado por Carmen Torrijos, experta en IA aplicada al lenguaje y la comunicación. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La Inteligencia Artificial (IA) está transformando la sociedad, la economía y los servicios públicos a una velocidad sin precedentes. Esta revolución trae enormes oportunidades, pero también desafíos relacionados con la ética, la seguridad y la protección de derechos fundamentales. Consciente de ello, la Unión Europea aprobó la Ley de Inteligencia Artificial (AI Act), en vigor desde el 1 de agosto de 2024, que establece un marco armonizado y pionero para el desarrollo, la comercialización y el uso de sistemas de IA en el mercado único, fomentando la innovación mientras protege a la ciudadanía.

Un ámbito especialmente relevante de esta normativa son los modelos de IA de propósito general (GPAI), como los grandes modelos de lenguaje (LLM) o los modelos multimodales, que se entrenan con enormes volúmenes de datos de muy diversa procedencia (texto, imágenes y vídeo, audio e incluso datos generados por usuarios). Esta realidad plantea retos críticos en propiedad intelectual, protección de datos y transparencia sobre el origen y el tratamiento de la información.

Para afrontarlos, la Comisión Europea, a través de la Oficina Europea de IA, ha publicado la Plantilla de Resumen Público de los Datos de Entrenamiento: un formato estandarizado que los proveedores deberán completar y publicar para resumir información clave sobre los datos usados en el entrenamiento. A partir del 2 de agosto de 2025, todo modelo de propósito general que se comercialice o distribuya en la UE deberá ir acompañado de este resumen; los modelos ya presentes en el mercado disponen hasta el 2 de agosto de 2027 para adaptarse. Esta medida materializa el principio de transparencia de la AI Act y pretende arrojar luz sobre las “cajas negras” de la IA.

En este artículo te contamos las claves de esta plantilla: desde sus objetivos y estructura, hasta información sobre plazos, sanciones y próximos pasos.

Objetivos y relevancia de la plantilla

Los modelos de IA de propósito general se entrenan con datos de muy diversa procedencia y modalidad, como:

-

Texto: libros, artículos científicos, prensa o redes sociales.

-

Imágenes y vídeos: contenidos digitales de Internet y colecciones visuales.

-

Audio: grabaciones, pódcast, programas de radio o conversaciones.

-

Datos de usuarios: información generada en la interacción con el propio modelo o con otros servicios del proveedor.

Este proceso de recopilación masiva de datos suele ser opaco, lo que genera preocupación entre titulares de derechos, usuarios, reguladores y la sociedad en su conjunto. Sin transparencia, resulta difícil evaluar si los datos se han obtenido de forma legal, si incluyen información personal no autorizada o si representan adecuadamente la diversidad cultural y lingüística de la Unión Europea.

El Considerando 107 de la AI Act establece que el objetivo principal de esta plantilla es incrementar la transparencia y facilitar el ejercicio y la protección de derechos. Entre los beneficios que aporta destacan:

-

Protección de la propiedad intelectual: permite que autores, editores y demás titulares de derechos identifiquen si sus obras han sido utilizadas durante el entrenamiento, facilitando la defensa de sus derechos y un uso justo de sus contenidos.

-

Salvaguarda de la privacidad: ayuda a detectar si se han empleado datos personales, aportando información útil para que las personas afectadas puedan ejercer sus derechos conforme al Reglamento General de Protección de Datos (RGPD) y otras normas del mismo ámbito.

-

Prevención de sesgos y discriminación: proporciona información sobre la diversidad lingüística y cultural de las fuentes utilizadas, clave para evaluar y mitigar sesgos que puedan generar discriminaciones.

-

Fomento de la competencia y la investigación: reduce los efectos de “caja negra” y facilita el escrutinio académico, al tiempo que ayuda a otras empresas a comprender mejor la procedencia de los datos, favoreciendo mercados más abiertos y competitivos.

En definitiva, esta plantilla no es solo un requisito legal, sino una herramienta para generar confianza en la inteligencia artificial, creando un ecosistema en el que la innovación tecnológica y la protección de derechos se refuercen mutuamente.

Estructura de la plantilla

La plantilla, publicada oficialmente el 24 de julio de 2025 tras una consulta pública con más de 430 organizaciones participantes, ha sido diseñada para que la información se presente de forma clara, homogénea y comprensible, tanto para especialistas como para la ciudadanía.

Se compone de tres secciones principales, que abarcan desde la identificación básica del modelo hasta los aspectos legales relacionados con el tratamiento de los datos.

1. Información general

Proporciona una visión global sobre el proveedor, el modelo y las características generales de los datos de entrenamiento:

-

Identificación del proveedor, como nombre y datos de contacto.

-

Identificación del modelo y sus versiones, incluyendo dependencias si se trata de una modificación (fine-tuning) de otro modelo.

-

Fecha de puesta en el mercado del modelo en la UE.

-

Modalidades de datos utilizadas (texto, imagen, audio, vídeo u otras).

-

Tamaño aproximado de los datos por modalidad, expresado en rangos amplios (por ejemplo, menos de 1.000 millones de tokens, entre 1.000 millones y 10 billones, más de 10 billones).

-

Cobertura lingüística, con especial atención a las lenguas oficiales de la Unión Europea.

Esta sección ofrece un nivel de detalle suficiente para comprender la magnitud y naturaleza del entrenamiento, sin revelar secretos comerciales.

2. Lista de fuentes de datos

Es el núcleo de la plantilla, donde se detalla la procedencia de los datos de entrenamiento. Está organizada en seis categorías principales, además de una categoría residual (Otros).

-

Conjuntos de datos públicos:

-

Datos disponibles gratuitamente y descargables como un todo o en bloques (p. ej., portales de datos abiertos, Common Crawl, repositorios académicos).

-

Se deben identificar los conjuntos “grandes”, definidos como aquellos que representan más del 3% del total de datos públicos utilizados en una modalidad específica.

-

-

Conjuntos privados licenciados:

-

Datos obtenidos mediante acuerdos comerciales con titulares de derechos o sus representantes, como licencias con editoriales para el uso de libros digitales.

-

Se proporciona únicamente una descripción general.

-

-

Otros datos privados no licenciados:

-

Bases de datos adquiridas a terceros que no gestionan directamente los derechos de autor.

-

Si son públicamente conocidas, deben listarse; si no, basta una descripción general (tipo de datos, naturaleza, idiomas).

-

-

Datos obtenidos mediante web crawling/scraping:

-

Información recopilada por el proveedor o en su nombre mediante herramientas automatizadas.

-

Se debe especificar:

-

Nombre/identificador de los rastreadores.

-

Finalidad y comportamiento (respeto a robots.txt, captchas, paywalls, etc.).

-

Periodo de recogida.

-

Tipos de sitios web (medios, redes sociales, blogs, portales públicos, etc.).

-

Lista de dominios más relevantes, que cubra al menos el 10% superior por volumen. Para PYMES, este requisito se ajusta al 5% o un máximo de 1.000 dominios, lo que sea menor.

-

-

-

Datos de usuarios:

-

Información generada a través de la interacción con el modelo o con otros servicios del proveedor.

-

Se debe indicar qué servicios contribuyen y la modalidad de los datos (texto, imagen, audio, etc.).

-

-

Datos sintéticos:

-

Datos creados por o para el proveedor mediante otros modelos de IA (por ejemplo, destilación de modelos o refuerzo con retroalimentación humana - RLHF).

-

Cuando corresponda, se debe identificar el modelo generador si está disponible en el mercado.

-

Categoría adicional – Otros: incluye datos que no encajan en las categorías anteriores, como fuentes offline, digitalización propia, etiquetado manual o generación humana.

3. Aspectos del procesamiento de datos

Se centra en cómo se han gestionado los datos antes y durante el entrenamiento, con especial atención al cumplimiento legal:

-

Respeto a las reservas de derechos (Text and Data Mining, TDM): medidas adoptadas para honrar el derecho de exclusión previsto en el artículo 4(3) de la Directiva 2019/790 sobre derechos de autor, que permite a los titulares impedir la minería de textos y datos. Este derecho se ejerce mediante protocolos de opt-out, como etiquetas en archivos o configuraciones en robots.txt, que indican que ciertos contenidos no pueden usarse para entrenar modelos. Los proveedores deben explicar cómo han identificado y respetado estos opt-outs en sus propios datasets y en los adquiridos a terceros.

-

Eliminación de contenido ilegal: procedimientos utilizados para evitar o depurar contenido ilícito bajo la legislación de la UE, como material de abuso sexual infantil, contenidos terroristas o infracciones graves de propiedad intelectual. Estos mecanismos pueden incluir listas negras, clasificadores automáticos o revisión humana, pero sin revelar secretos empresariales.

El siguiente visual resumen estos tres apartados:

Equilibrio entre transparencia y secretos comerciales

La Comisión Europea ha diseñado la plantilla buscando un equilibrio delicado: ofrecer información suficiente para proteger derechos y fomentar la transparencia, sin obligar a revelar información que pueda comprometer la competitividad de los proveedores.

-

Fuentes públicas: se exige el mayor nivel de detalle, incluyendo nombres y enlaces a los conjuntos de datos “grandes”.

-

Fuentes privadas: se permite un nivel de detalle más limitado, mediante descripciones generales cuando la información no sea pública.

-

Web scraping: se requiere un listado resumido de dominios, sin necesidad de detallar combinaciones exactas.

-

Datos de usuarios y sintéticos: la información se limita a confirmar su uso y describir la modalidad.

Gracias a este enfoque, el resumen es “generalmente completo” en alcance, pero no “técnicamente detallado”, protegiendo tanto la transparencia como la propiedad intelectual y comercial de las empresas.

Cumplimiento, plazos y sanciones

El artículo 53 de la AI Act detalla las obligaciones de los proveedores de modelos de propósito general, entre las que destaca la publicación de este resumen de datos de entrenamiento.

Esta obligación se complementa con otras medidas, como:

-

Disponer de una política pública de derechos de autor.

-

Implementar procesos de evaluación y mitigación de riesgos, especialmente para modelos que puedan generar riesgos sistémicos.

-

Establecer mecanismos de trazabilidad y supervisión de los datos y procesos de entrenamiento.

El incumplimiento puede acarrear multas significativas, de hasta 15 millones de euros o el 3% de la facturación global anual de la empresa, lo que suponga una mayor cantidad.

Próximos pasos para los proveedores

Para adaptarse a esta nueva obligación, los proveedores deberían:

-

Revisar procesos internos de recopilación y gestión de datos para garantizar que la información necesaria esté disponible y sea verificable.

-

Establecer políticas claras de transparencia y derechos de autor, incluyendo protocolos para respetar el derecho de exclusión en minería de textos y datos (TDM).

-

Publicar el resumen en canales oficiales antes de la fecha límite correspondiente.

-

Actualizar el resumen periódicamente, al menos cada seis meses o cuando se produzcan cambios materiales en el entrenamiento.

La Comisión Europea, a través de la Oficina Europea de IA, supervisará el cumplimiento y podrá solicitar correcciones o imponer sanciones.

Una herramienta clave para gobernar los datos

En nuestro artículo anterior, “Gobernar los datos para gobernar la Inteligencia Artificial”, destacábamos que una IA confiable solo es posible si existe un gobierno sólido de los datos.

Esta nueva plantilla refuerza ese principio, ofreciendo un mecanismo estandarizado para describir el ciclo de vida de los datos, desde su origen hasta su tratamiento, y fomentando la interoperabilidad y la reutilización responsable.

Se trata de un paso decisivo hacia una IA más transparente, justa y alineada con los valores europeos, donde la protección de derechos y la innovación tecnológica puedan avanzar juntas.

Conclusiones

La publicación de la Plantilla de Resumen Público marca un hito histórico en la regulación de la IA en Europa. Al exigir que los proveedores documenten y hagan públicos los datos utilizados en el entrenamiento, la Unión Europea da un paso decisivo hacia una inteligencia artificial más transparente y confiable, basada en la responsabilidad y el respeto a los derechos fundamentales. En un mundo donde los datos son el motor de la innovación, esta herramienta se convierte en la clave para gobernar los datos antes de gobernar la IA, asegurando que el desarrollo tecnológico se construya sobre la confianza y la ética.

Contenido elaborado por Dr. Fernando Gualo, Profesor en UCLM y Consultor de Gobierno y Calidad de datos. El contenido y el punto de vista reflejado en esta publicación es responsabilidad exclusiva de su autor.

A la hora de hacer frente a la responsabilidad derivada del uso de sistemas autónomos basados en el uso de la inteligencia artificial es habitual referirse a los dilemas éticos que puede plantear un accidente de circulación. Este ejemplo resulta de utilidad para ilustrar la problemática sobre la responsabilidad acerca de los daños generados por un accidente o, incluso, para determinar otro tipo de responsabilidades en el ámbito de la seguridad vial (por ejemplo, las multas ante infracciones de las normas de circulación).

Imaginemos que el vehículo autónomo ha circulado a una velocidad superior a la permitida o que, sencillamente, se ha saltado una señal y ha ocasionado un accidente que implica a otros vehículos. Desde el punto de vista de los riesgos jurídicos, de la responsabilidad que se generaría y, en concreto, de la incidencia de los datos en este escenario, podríamos plantear algunas preguntas que nos ayuden a comprender el alcance práctico de esta problemática:

-

¿Se han considerado en el diseño y entrenamiento todos los conjuntos de datos necesarios y de calidad suficiente para hacer frente a los riesgos del tráfico en distintos entornos (rurales, urbanos, ciudades densas…)?

-

¿Cuál es la responsabilidad si el accidente se debe a una mala integración de la herramienta de inteligencia artificial con el vehículo o a un fallo del fabricante que impide la correcta lectura de las señales?

-

¿Quién responde si el problema deriva de la información incorrecta o no actualizada de las señales de tráfico?

En este post vamos a explicar qué aspectos hay que tener en cuenta a la hora de valorar la responsabilidad que se puede generar en este tipo de casos.

La incidencia de los datos desde la perspectiva de los sujetos implicados

En el diseño, entrenamiento, despliegue y uso de los sistemas de inteligencia artificial, el efectivo control de los datos utilizados juega un papel esencial en la gestión de los riesgos jurídicos. Las condiciones de su tratamiento pueden tener importantes consecuencias desde la perspectiva de la responsabilidad en caso de que se produzcan daños o se incumpla la normativa aplicable.

Una aproximación rigurosa a esta problemática requiere distinguir en función de cada uno de los sujetos que intervienen en el proceso, desde su desarrollo inicial hasta su uso efectivo en unas circunstancias concretas, ya que las condiciones y las consecuencias pueden ser muy distintas. En este sentido, es necesario identificar el origen del daño o del incumplimiento con el fin de imputar las consecuencias jurídicas a quien efectivamente deba considerarse como responsable:

-

Así, puede que el daño o el incumplimiento vengan determinados por un problema de diseño en la aplicación utilizada o en su entrenamiento, de manera que se empleen indebidamente ciertos datos para esta finalidad. Siguiendo con el ejemplo del vehículo autónomo, este sería el caso de acceder sin consentimiento a los datos de las personas que viajan en el mismo.

-

Sin embargo, también es posible que el problema tenga su origen en quien lleva a cabo el despliegue de la herramienta en un entorno determinado para su uso real, posición que ocuparía el fabricante del vehículo. Es lo que podría suceder si, para su funcionamiento, se accediera a datos sin los permisos oportunos o si existiesen restricciones que impiden el acceso a la información necesaria para garantizar su buen funcionamiento.

-

El problema también podría estar generado por la propia persona o entidad que utiliza la herramienta. Volviendo al ejemplo del vehículo, cabría plantear que la titularidad del mismo corresponde a una empresa o a una persona física que no hubiera realizado las revisiones periódicas necesarias o actualizado el sistema cuando fuera preciso.

-

Finalmente, existe la posibilidad de que la problemática jurídica sobre la responsabilidad venga determinada por las condiciones en las que se proporcionan los datos en su fuente originaria. Por ejemplo, si los datos son inexactos: la información sobre la vía por donde circula el vehículo no está actualizada o los datos que emiten las señales de tráfico no son suficientemente precisos.

Retos relativos al entorno tecnológico: complejidad y opacidad

Además, la propia singularidad de la tecnología utilizada puede condicionar de manera relevante la imputación de la responsabilidad. En concreto, la opacidad tecnológica –es decir, la dificultad para entender por qué un sistema toma una decisión concreta– es uno de los principales desafíos a la hora de abordar los retos jurídicos que plantea la inteligencia artificial, ya que dificulta la determinación del sujeto responsable. Se trata de una problemática que adquiere una especial trascendencia por lo que se refiere al origen lícito de los datos y, asimismo, a las condiciones en que tiene lugar su tratamiento. De hecho, este fue precisamente el principal escollo que se encontró la inteligencia artificial generativa en los momentos iniciales de su aterrizaje en Europa: la falta de unas condiciones adecuadas de transparencia respecto al tratamiento de los datos personales justificó la paralización temporal de su comercialización hasta que se llevaron a cabo los ajustes necesarios.

En este sentido, la publicación de los datos utilizados para la fase de entrenamiento se convierte en una garantía adicional desde la perspectiva de la seguridad jurídica y, en concreto, para verificar las condiciones de cumplimiento normativo de la herramienta.

Por otra parte, la complejidad inherente a esta tecnología supone una dificultad adicional por lo que se refiere a la imputación de los daños que se puedan causar y, en consecuencia, a la determinación de quién debe hacer frente a los mismos. Siguiendo con el ejemplo del vehículo autónomo, podría darse el caso de que se solapen diversas causas, como la incorrección de los datos proporcionados por las señales de tráfico y, al mismo tiempo, un mal funcionamiento de la aplicación informática al no detectar potenciales incoherencias entre los datos utilizados y las efectivas necesidades de la misma.

¿Qué dice la regulación del Reglamento europeo sobre inteligencia artificial al respecto?

El Reglamento (UE) 2024/1689 establece un marco normativo armonizado en toda la Unión Europea con relación a la inteligencia artificial. Por lo que se refiere a los datos, contempla algunas obligaciones específicas para los sistemas clasificados como “alto riesgo”, que son los contemplados en el artículo 6 y en el listado del Anexo III (identificación biométrica, educación, gestión laboral, acceso a servicios esenciales…). En este sentido, incorpora un estricto régimen de requisitos técnicos, transparencia, supervisión y auditoría, combinado con procedimientos de evaluación de conformidad previos a su comercialización y mecanismos de control posteriores a la misma, fijando además responsabilidades precisas para proveedores, operadores y otros actores de la cadena de valor.

Por lo que se refiere a la gobernanza de los datos debe establecerse un sistema de gestión de riesgos que abarque todo el ciclo de vida de la herramienta y que evalúe, mitigue, supervise y documente los riesgos para la salud, la seguridad y los derechos fundamentales. En concreto, se exige que los conjuntos de datos de entrenamiento, validación y prueba sean:

-

Relevantes, representativos, completos y lo más libres de errores posible para la finalidad prevista.

-

Gestionados conforme a estrictas prácticas de gobernanza que mitiguen sesgos y discriminaciones, especialmente cuando puedan afectar derechos fundamentales de grupos vulnerables o minoritarios.

-

El Reglamento contempla, además, condiciones rigurosas para el uso excepcional de categorías especiales de datos personales por lo que se refiere a la detección y, en su caso, corrección de sesgos.

Con relación a la documentación técnica y conservación de registros se requiere:

-

La elaboración y mantenimiento de documentación técnica exhaustiva. En concreto, por lo que se refiere a la transparencia se deben proporcionar instrucciones de uso completas y claras que habrán de incluir información sobre datos y resultados de salida, entre otros extremos.

-

Los sistemas han de permitir el registro automático de eventos relevantes (logs) a lo largo de todo su ciclo de vida para asegurar la trazabilidad y facilitar la vigilancia posterior a la comercialización, lo que puede servir de gran utilidad a la hora de comprobar la incidencia de los datos utilizados.

Por lo que se refiere a la responsabilidad, el citado Reglamento se basa en un planteamiento ciertamente limitado desde dos puntos de vista:

-

En primer lugar, se limita a habilitar a los Estados miembros para que establezcan un régimen sancionador que contemple la imposición multas y otras vías de ejecución, tales como advertencias y medidas no pecuniarias, que deberán ser efectivas, proporcionadas y disuasorias del incumplimiento de la regulación. Se trata, por tanto, de instrumentos de carácter administrativo y naturaleza sancionadora, esto es, de castigo frente al incumplimiento de las obligaciones establecidas en dicha norma, entre las que se encuentran las relativas a la gobernanza de los datos y a la documentación y conservación de registros anteriormente referidas.

-

Sin embargo, en segundo lugar, el regulador europeo no ha considerado oportuno establecer disposiciones específicas por lo que se refiere a la responsabilidad civil con el objetivo de que se indemnice por los daños que se causen. Se trata de una cuestión de gran relevancia que, incluso, dio lugar a que la Comisión Europea formulase en 2022 una propuesta de Directiva específica. Aunque su tramitación no se ha culminado, ha dado lugar a un interesante debate cuyos principales argumentos se han sistematizado en un completo informe del Parlamento Europeo en el que se analiza el impacto que podría tener esta regulación.

Sin respuestas claras: debate abierto y evolución normativa

Así pues, a pesar del avance que ha supuesto la aprobación del Reglamento de 2024, lo cierto es que la regulación de la responsabilidad derivada del uso de instrumentos de inteligencia artificial sigue siendo una cuestión abierta sobre la que no existe un marco normativo completo y desarrollado. No obstante, una vez superado el planteamiento relativo a la personificación jurídica de los robots que se suscitó hace unos años, es indudable que la inteligencia artificial en sí misma no puede considerarse un sujeto jurídicamente responsable.

Como se ha enfatizado anteriormente, se trata de un debate complejo en el que no es posible ofrecer respuestas simples y generales, ya que resulta imprescindible concretarlas en cada caso concreto teniendo en cuenta los sujetos que han intervenido en cada una de las fases de diseño, implementación y uso de la correspondiente herramienta. Serán, por tanto, dichos sujetos quienes habrán de asumir la responsabilidad que corresponda, bien para el resarcimiento de los daños ocasionados o, en su caso, para hacer frente a las sanciones y otras medidas administrativas en los supuestos de incumplimiento de la regulación.

En definitiva, aunque la regulación europea sobre inteligencia artificial de 2024 puede resultar de utilidad para establecer estándares que ayuden a determinar cuándo un daño producido es contrario a Derecho y, por tanto, debe ser compensado, lo cierto es que se trata de un debate sin cerrar que habrá que reconducir aplicando las normas generales sobre protección del consumidor o productos defectuosos teniendo en cuenta las singularidades de esta tecnología. Y, por lo que se refiere a la responsabilidad administrativa, será necesario esperar a que se impulse definitivamente la iniciativa que se anunció hace unos meses y que se encuentra pendiente de aprobación formal por el Consejo de Ministros para su posterior tramitación parlamentaria en las Cortes Generales.

Contenido elaborado por Julián Valero, catedrático de la Universidad de Murcia y Coordinador del Grupo de Investigación “Innovación, Derecho y Tecnología” (iDerTec). Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los datos abiertos de fuentes públicas han evolucionado a lo largo de estos años, pasando de ser simples repositorios de información a constituir ecosistemas dinámicos que pueden transformar la gobernanza pública. En este contexto, la inteligencia artificial (IA) emerge como una tecnología catalizadora que se beneficia del valor de los datos abiertos y potencia exponencialmente su utilidad. En este post veremos cómo es la relación simbiótica de mutuo beneficio entre la IA y los datos abiertos.

Tradicionalmente, el debate sobre datos abiertos se ha centrado en los portales: las plataformas en las que gobiernos publican información para que la ciudadanía, las empresas y las organizaciones puedan acceder a ella. Pero la llamada “Tercera Ola de Datos Abiertos”, término acuñado por el GovLab de la Universidad de Nueva York, enfatiza que ya no basta con publicar datasets a demanda o por defecto. Lo importante es pensar en el ecosistema completo: el ciclo de vida de los datos, su explotación, mantenimiento y, sobre todo, el valor que generan en la sociedad.

¿Qué función pueden tener los datos abiertos aplicados a la IA?

En este contexto, la IA aparece como un catalizador capaz de automatizar tareas, enriquecer los datos abiertos gubernamentales (OGD), facilitar su comprensión y estimular la colaboración entre actores.

Una investigación reciente, desarrollada por universidades europeas, mapea cómo está sucediendo esta revolución silenciosa. El estudio propone una clasificación de los usos según en dos dimensiones:

- Perspectiva, que a su vez se divide en dos posibles vías:

- Inward-looking (portal): el foco está en las funciones internas de los portales de datos.

- Outward-looking (ecosistema): el foco se amplía a las interacciones con actores externos (ciudadanos, empresas, organizaciones).

- Fases del ciclo de vida del dato, las cuales podemos dividir en pre-procesamiento, exploración, transformación y mantenimiento.

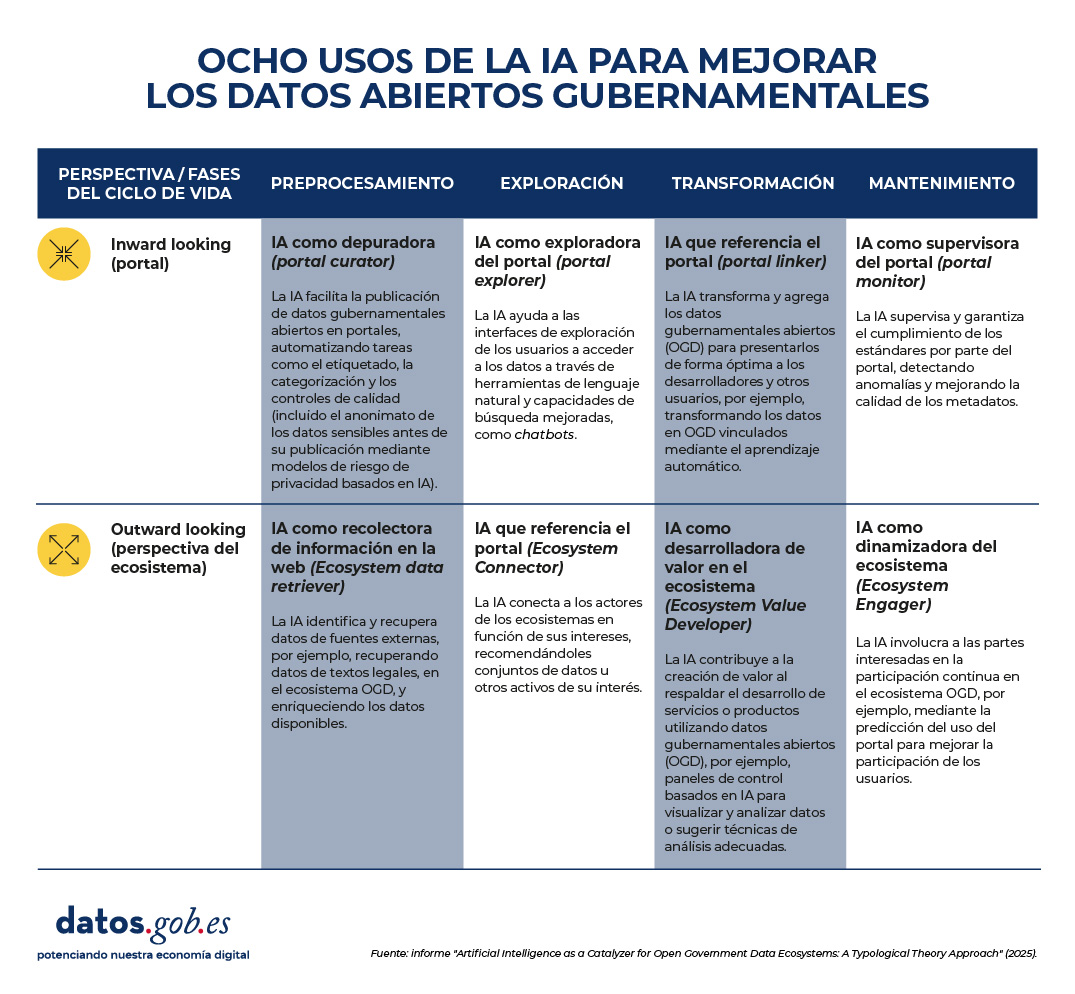

En resumen, el informe identifica estos ocho tipos de uso de la IA en los datos abiertos gubernamentales, que se producen al cruzar las perspectivas y las fases en el ciclo de vida del dato.

Figura 1. Ocho uso de la IA para mejorar los datos abiertos gubernamentales. Fuente: presentación "Data for AI or AI for data: artificial intelligence as a catalyser for open government ecosystems", basada en el informe del mismo nombre, de los EU Open Data Days 2025.

A continuación, se detalla cada uno de estos usos:

1. IA como depuradora (portal curator)

Esta aplicación se centra en el pre-procesamiento de datos dentro del portal. La IA ayuda a organizar, limpiar, anonimizar y etiquetar datasets antes de su publicación. Algunos ejemplos de tareas son:

- Automatización y mejora de las tareas de publicación de datos.

- Realización de funciones de etiquetado automático y categorización.

- Anonimización de datos para proteger la privacidad.

- Limpieza y filtrado automático de conjuntos de datos.

- Extracción de características y manejo de datos faltantes.

2. IA como recolectora de datos del ecosistema (ecosystem data retriever)

También en la fase de pre-procesamiento, pero con un enfoque externo, la IA amplía la cobertura de los portales al identificar y recopilar información de fuentes diversas. Algunas tareas son:

- Recuperar datos estructurados desde textos legales o normativos.

- Minería de noticias para enriquecer datasets con información contextual.

- Integración de datos urbanos procedentes de sensores o registros digitales.

- Descubrimiento y enlace de fuentes heterogéneas.

- Conversión de documentos complejos en información estructurada.

3. IA como exploradora del portal (portal explorer)

En la fase de exploración, los sistemas de IA también pueden facilitar la búsqueda e interacción con los datos publicados, con un enfoque más interno. Algunos casos de uso:

- Desarrollar buscadores semánticos para localizar conjuntos de datos.

- Implementar chatbots que guíen a los usuarios en la exploración de datos.

- Proporcionar interfaces de lenguaje natural para consultas directas.

- Optimizar los motores de búsqueda internos del portal.

- Utilizar modelos de lenguaje para mejorar la recuperación de información.

4. IA como recolectora de información en la web (ecosystem connector)

Operando también en la fase de exploración, la IA actúa como un puente entre actores y recursos del ecosistema. Algunos ejemplos son:

- Recomendar datasets relevantes a investigadores o empresas.

- Identificar socios potenciales a partir de intereses comunes.

- Extraer temas emergentes para apoyar la formulación de políticas.

- Visualizar datos de múltiples fuentes en paneles interactivos.

- Personalizar sugerencias de datos basadas en actividades en redes sociales.

5. IA que referencia el portal (portal linker)

Esta funcionalidad se enfoca en la transformación de datos dentro del portal. Su función es facilitar la combinación y presentación de información para distintos públicos. Algunas tareas son:

- Convertir datos en grafos de conocimiento (estructuras que conectan información relacionada, conocidas como Linked Open Data).

- Resumir y simplificar datos con técnicas de PLN (Procesamiento del Lenguaje Natural).

- Aplicar razonamiento automático para generar información derivada.

- Potenciar la visualización multivariante de datasets complejos.

- Integrar datos diversos en productos de información accesibles.

6. IA como desarrolladora de valor en el ecosistema (ecosystem value developer)

En la fase de transformación y con mirada externa, la IA genera productos y servicios basados en datos abiertos que aportan valor añadido. Algunas tareas son:

- Sugerir técnicas analíticas adecuadas según el tipo de conjunto de datos.

- Asistir en la codificación y procesamiento de información.

- Crear paneles de control basados en análisis predictivo.

- Garantizar la corrección y coherencia de los datos transformados.

- Apoyar el desarrollo de servicios digitales innovadores.

7. IA como supervisora del portal (portal monitor)

Se centra en el mantenimiento del portal, con un enfoque interno. Su papel es garantizar la calidad, consistencia y cumplimiento de estándares. Algunas tareas son:

- Detectar anomalías y valores atípicos en conjuntos de datos publicados.

- Evaluar la consistencia de metadatos y esquemas.

- Automatizar procesos de actualización y depuración de datos.

- Identificar incidencias en tiempo real para su corrección.

- Reducir costes de mantenimiento mediante monitorización inteligente.

8. IA como dinamizadora del ecosistema (ecosystem engager)

Y, por último, esta función opera en la fase de mantenimiento, pero hacia afuera. Busca promover la participación ciudadana y la interacción continua. Algunas tareas son:

- Predecir patrones de uso y anticipar necesidades de los usuarios.

- Proporcionar retroalimentación personalizada sobre datasets.

- Facilitar la auditoría ciudadana de la calidad de los datos.

- Incentivar la participación en comunidades de datos abiertos.

- Identificar perfiles de usuarios para diseñar experiencias más inclusivas.

¿Qué nos dice la evidencia?

El estudio se basa en una revisión de más de 70 artículos académicos que examinan la intersección entre IA y los datos abiertos gubernamentales (open government data u OGD). A partir de estos casos, los autores observan que:

- Algunos de los perfiles definidos, como portal curator, portal explorer y portal monitor, están relativamente maduros y cuentan con múltiples ejemplos en la literatura.

- Otros, como ecosystem value developer y ecosystem engager, están menos explorados, aunque son los que más potencial tienen para generar impacto social y económico.

- La mayoría de las aplicaciones actuales se centran en automatizar tareas concretas, pero hay un gran margen para diseñar arquitecturas más integrales, que combinen varios tipos de IA en un mismo portal o en todo el ciclo de vida del dato.

Desde un punto de vista académico, esta tipología aporta un lenguaje común y una estructura conceptual para estudiar la relación entre IA y datos abiertos. Permite identificar vacíos en la investigación y orientar futuros trabajos hacia un enfoque más sistémico.

En la práctica, el marco es útil para:

- Gestores de portales de datos: les ayuda a identificar qué tipos de IA pueden implementar según sus necesidades, desde mejorar la calidad de los datasets hasta facilitar la interacción con los usuarios.

- Responsables políticos: les orienta sobre cómo diseñar estrategias de adopción de IA en iniciativas de datos abiertos, equilibrando eficiencia, transparencia y participación.

- Investigadores y desarrolladores: les ofrece un mapa de oportunidades para crear herramientas innovadoras que atiendan necesidades específicas del ecosistema.

Limitaciones y próximos pasos de la sinergia entre IA y open data

Además de las ventajas, el estudio reconoce algunas asignaturas pendientes que, en cierta manera, sirven como hoja de ruta para el futuro. Para empezar, varias de las aplicaciones que se han identificado están todavía en fases tempranas o son conceptuales. Y, quizá lo más relevante, aún no se ha abordado en profundidad el debate sobre los riesgos y dilemas éticos del uso de IA en datos abiertos: sesgos, privacidad, sostenibilidad tecnológica.

En definitiva, la combinación de IA y datos abiertos es todavía un terreno en construcción, pero con un enorme potencial. La clave estará en pasar de experimentos aislados a estrategias integrales, capaces de generar valor social, económico y democrático. La IA, en este sentido, no funciona de manera independiente a los datos abiertos: los multiplica y los hace más relevantes para gobiernos, ciudadanía y sociedad en general.

Por primera vez en la historia de la organización, España acogerá la Cumbre Global de Open Government Partnership (OGP), institución internacional de referencia en gobierno abierto y participación ciudadana. Del 6 y el 10 de octubre de 2025, Vitoria-Gasteiz se transformará en la capital mundial del gobierno abierto, recibiendo a más de 2.000 representantes de gobiernos, organizaciones de la sociedad civil y expertos en políticas públicas procedentes de todo el mundo.

Aunque el registro para la Cumbre ya está cerrado debido a la gran demanda, la ciudadanía podrá seguir algunas de las sesiones plenarias a través de las retransmisiones en línea y participar en los debates a través de las redes sociales. Además, los resultados y compromisos surgidos de la Cumbre estarán disponibles en las plataformas digitales de OGP y del Gobierno de España.

En este post, repasamos el objetivo, programa de actividades y más información de interés.

Programa de actividades de un evento global

La Cumbre Global de OGP 2025 tendrá lugar en el Palacio de Congresos Europa de Vitoria-Gasteiz, donde se desarrollará una agenda ambiciosa alineada con el Programa de co-presidencia del Gobierno de España y la organización filipina Bankay Kita, Cielo Magno. Esta agenda se estructura en torno a tres ejes temáticos fundamentales:

-

Personas: actividades que abordan la protección del espacio cívico, el fortalecimiento de la democracia y el equilibrio entre las contribuciones del gobierno, la sociedad civil y el sector privado. Este eje busca garantizar que todos los actores sociales tengan voz en los procesos democráticos.

-

Instituciones: este bloque abordará la participación de todos los poderes del estado para mejorar la transparencia, la rendición de cuentas y la participación ciudadana en todos los niveles de gobierno.

-

Tecnología y datos: explorará los derechos digitales, la gobernanza de redes sociales y la libertad en Internet, así como la promoción del espacio cívico digital y la libertad de expresión en la era digital.

La programación de la Cumbre OGP incluye sesiones plenarias de alto nivel, talleres especializados, eventos paralelos y espacios para el networking que facilitarán el intercambio de conocimientos y la construcción de alianzas. Puedes consultar el programa completo aquí, entre los temas destacados se encuentran:

-

Inteligencia artificial y gobierno abierto: se analizará la gobernanza participativa de la IA y cómo garantizar que el desarrollo tecnológico respete los principios democráticos y los derechos humanos.

-

Transparencia algorítmica: se debatirá sobre la necesidad de hacer visibles y comprensibles los sistemas algorítmicos utilizados en la toma de decisiones públicas.

-

Justicia abierta: se explorará cómo fortalecer el estado de derecho a través de sistemas judiciales más transparentes y accesibles para la ciudadanía.

-

Participación inclusiva: se compartirán experiencias sobre cómo garantizar que poblaciones en situación de vulnerabilidad puedan participar efectivamente en los procesos democráticos.

-

Contratación pública abierta: se presentarán mejores prácticas para hacer más transparente y eficiente el gasto público a través de procesos de contratación abiertos.

Entre las sesiones más relevantes para el ecosistema de datos abiertos destaca la organizada por Red.es "Cuando la IA encuentra a los datos abiertos” que se celebrará el día 8 a las 9h. A través de una mesa redonda, se mostrará cómo la inteligencia artificial y los datos abiertos se potencian mutuamente. Por un lado, la IA ayuda a sacar más provecho de los datos abiertos, y por otro, estos datos son esenciales para entrenar y mejorar los sistemas de IA.

Además, a la misma hora, el jueves 9 se celebra la ponencia "Del dato al impacto mediante alianzas público-privadas y ecosistemas de compartición", organizado por la Dirección General del Dato del Ministerio para la Transformación Digital y de la Función Pública. Esta sesión, abordará cómo las colaboraciones entre el sector público y privado pueden maximizar el valor de los datos para generar un impacto real en la sociedad, explorando modelos innovadores de intercambio de datos que respeten la privacidad y fomenten la innovación.

Un legado de transformación democrática

La Cumbre de Vitoria-Gasteiz se suma a la tradición de las ocho cumbres anteriores celebradas en Canadá, Georgia, Estonia, Francia, Corea, México, Reino Unido y Brasil. Cada una de estas cumbres ha contribuido a fortalecer el movimiento global de gobierno abierto, generando compromisos concretos que han transformado la relación entre gobiernos y ciudadanía.

En esta edición, se reconocerán las reformas más prometedoras e impactantes a través de los Open Gov Awards, celebrando la innovación y el progreso en gobierno abierto a nivel mundial. Estos premios destacan iniciativas que han demostrado un impacto real en la vida de los ciudadanos y que pueden servir de inspiración para otros países y territorios.

Participación y colaboración de varios agentes

Una característica distintiva de OGP es su enfoque multiactor, que garantiza que tanto gobiernos como organizaciones de la sociedad civil tengan voz y voto en la definición de las agendas de gobierno abierto. Esta Cumbre no será la excepción, y contará con la participación de representantes de organizaciones ciudadanas, académicos, empresarios y activistas que trabajan por una democracia más participativa y transparente.

Paralelamente, se llevarán a cabo otros eventos que complementarán la agenda oficial. Estas actividades abordarán temas específicos como la protección de denunciantes, la participación juvenil o la integración de la perspectiva de género en las políticas públicas.

Este año, la Cumbre Global de OGP 2025 en Vitoria-Gasteiz aspira a generar compromisos concretos que fortalezcan la democracia en la era digital. Tal y como determina Open Government Partnership, los países participantes asumirían nuevos compromisos en sus planes de acción nacionales, especialmente en áreas como la gobernanza de la inteligencia artificial, la protección del espacio cívico digital y la lucha contra la desinformación.

En resumen, la Cumbre Global de OGP 2025 en Vitoria-Gasteiz marca un momento crucial para el futuro de la democracia. En un contexto de crecientes desafíos para las instituciones democráticas, este encuentro reafirma la importancia de mantener gobiernos abiertos, transparentes y participativos como pilares fundamentales de sociedades libres y prósperas.

Cada vez gana más terreno la idea de concebir la inteligencia artificial (IA) como un servicio de consumo inmediato o utility, bajo la premisa de que basta con “comprar una aplicación y empezar a utilizarla”. Sin embargo, subirse a la IA no es como comprar software convencional y ponerlo en marcha al instante. A diferencia de otras tecnologías de la información, la IA difícilmente se podrá utilizar con la filosofía del plug and play. Existe un conjunto de tareas imprescindibles que los usuarios de estos sistemas deberían emprender, no solo por razones de seguridad y cumplimiento legal, sino sobre todo para obtener resultados eficientes y confiables.

El Reglamento de inteligencia artificial (RIA)[1]

El RIA define marcos de referencia que deberían ser tenidos en cuenta por los proveedores[2] y responsables de desplegar[3] la IA. Esta es una norma muy compleja cuya orientación es doble. En primer lugar, en una aproximación que podríamos definir como de alto nivel, la norma establece un conjunto de líneas rojas que nunca podrán ser traspasadas. La Unión Europea aborda la IA desde un enfoque centrado en el ser humano y al servicio de las personas. Por ello, cualquier desarrollo deberá garantizar ante todo que no se vulneren derechos fundamentales ni se cause ningún daño a la seguridad e integridad de las personas. Adicionalmente, no se admitirá ninguna IA que pudiera generar riesgos sistémicos para la democracia y el estado de derecho. Para que estos objetivos se materialicen, el RIA despliega un conjunto de procesos mediante un enfoque orientado a producto. Esto permite clasificar los sistemas de IA en función de su nivel de riesgo, -bajo, medio, alto- así como los modelos de IA de uso general[4]. Y también, establecer, a partir de esta categorización, las obligaciones que cada sujeto participante deberá cumplir para garantizar los objetivos de la norma.

Habida cuenta de la extraordinaria complejidad del reglamento europeo, queremos compartir en este artículo algunos principios comunes que se deducen de su lectura y podrían inspirar buenas prácticas por parte de las organizaciones públicas y privadas. Nuestro enfoque no se centra tanto en definir una hoja de ruta para un determinado sistema de información como en destacar algunos elementos que, a nuestro juicio, pueden resultar de utilidad para garantizar que el despliegue y utilización de esta tecnología resulten seguros y eficientes, con independencia del nivel de riesgo de cada sistema de información basado en IA.

Definir un propósito claro

El despliegue de un sistema de IA es altamente dependiente de la finalidad que persigue la organización. No se trata de subirse al carro de una moda. Es cierto que la información pública disponible parece evidenciar que la integración de este tipo de tecnología forma parte importante de los procesos de transformación digital de las empresas y de la Administración, proporcionando mayor eficiencia y capacidades. Sin embargo, no puede convertirse en una moda instalar cualquiera de los Large Language Models (LLM). Se necesita una reflexión previa que tenga en cuenta cuáles son las necesidades de la organización y defina que tipo de IA va a contribuir a la mejora de nuestras capacidades. No adoptar esta estrategia podría poner en riesgo a nuestra entidad, no solo desde el punto de vista de su funcionamiento y resultados, sino incluso desde una perspectiva jurídica. Por ejemplo, introducir un LLM o un chatbot en un entorno de alto riesgo decisional podría suponer padecer impactos reputacionales o incurrir en responsabilidad civil. Insertar este LLM en un entorno médico, o utilizar un chatbot en un contexto sensible con población no preparada o en procesos de asistencia críticos, podría acabar generando situaciones de riesgo de consecuencias imprevisibles para las personas.

No hacer el mal

El principio de no maleficiencia es un elemento clave y debe inspirar de modo determinante nuestra práctica en el mundo de la IA. Por ello el RIA establece una serie de prácticas expresamente prohibidas para proteger los derechos fundamentales y la seguridad de las personas. Estas prohibiciones se centran en evitar manipulaciones, discriminaciones y usos indebidos de sistemas de IA que puedan causar daños significativos.

Categorías de prácticas prohibidas

1. Manipulación y control del comportamiento. Mediante el uso de técnicas subliminales o manipuladoras que alteren el comportamiento de personas o colectivos, impidiendo la toma de decisiones informadas y provocando daños considerables.

2. Explotación de vulnerabilidades. Derivadas de la edad, discapacidad o situación social/económica para modificar sustancialmente el comportamiento y causar perjuicio.

3. Puntuación social (Social Scoring). IA que evalúe a personas en función de su comportamiento social o características personales, generando calificaciones con efectos para los ciudadanos que resulten en tratos injustificados o desproporcionados.

4. Evaluación de riesgos penales basada en perfiles. IA utilizada para predecir la probabilidad de comisión de delitos únicamente mediante elaboración de perfiles o características personales. Aunque se admite su uso para la investigación penal cuando el delito se ha cometido efectivamente y existen hechos que analizar.

5. Reconocimiento facial y bases de datos biométricas. Sistemas para la ampliación de bases de datos de reconocimiento facial mediante la extracción no selectiva de imágenes faciales de Internet o de circuitos cerrados de televisión.

6. Inferencia de emociones en entornos sensibles. Diseñar o usar la IA para inferir emociones en el trabajo o en centros educativos, salvo por motivos médicos o de seguridad.

7. Categorización biométrica sensible. Desarrollar o utilizar una IA que clasifique a individuos según datos biométricos para deducir raza, opiniones políticas, religión, orientación sexual, etc.

8. Identificación biométrica remota en espacios públicos. Uso de sistemas de identificación biométrica remota «en tiempo real» en espacios públicos con fines policiales, salvo excepciones muy limitadas (búsqueda de víctimas, prevención de amenazas graves, localización de sospechosos de delitos graves).

Al margen de las conductas expresamente prohibidas es importante tener en cuenta que el principio de no maleficencia implica que no podemos utilizar un sistema de IA con la clara intención de causar un daño, con la conciencia de que esto podría ocurrir o, en cualquier caso, cuando la finalidad que perseguimos sea contraria a derecho.

Garantizar una adecuada gobernanza de datos

El concepto de gobernanza de datos se encuentra en el artículo 10 del RIA y aplica a los sistemas de alto riesgo. No obstante, contiene un conjunto de principios de alta rentabilidad a la hora de desplegar un sistema de cualquier nivel. Los sistemas de IA de alto riesgo que usan datos deben desarrollarse con conjuntos de entrenamiento, validación y prueba que cumplan criterios de calidad. Para ello se definen ciertas prácticas de gobernanza para asegurar:

- Diseño adecuado.

- Que la recogida y origen de los datos, y en el caso de los datos personales la finalidad perseguida, sean adecuadas y legítimas.

- Que se adopten procesos de preparación como la anotación, el etiquetado, la depuración, la actualización, el enriquecimiento y la agregación.

- Que el sistema se diseñe con casos de uso cuya información sea coherente con lo que se supone que miden y representan los datos.

- Asegurar la calidad de los datos garantizando la disponibilidad, la cantidad y la adecuación de los conjuntos de datos necesarios.

- Detectar y revisar de sesgos que puedan afectar a la salud y la seguridad de las personas, a los derechos o generar discriminación, especialmente cuando las salidas de datos influyan en las informaciones de entrada de futuras operaciones. Deben adoptarse medidas para prevenir y corregir estos sesgos.

- Identificar y resolver lagunas o deficiencias en los datos que impidan el cumplimiento del RIA, y añadiríamos que la legislación.

- Los conjuntos de datos empleados deben ser relevantes, representativos, completos y con propiedades estadísticas adecuadas para su uso previsto y deben considerar las características geográficas, contextuales o funcionales necesarias para el sistema, así como garantizar su diversidad. Además, carecerán de errores y estarán completos en vista de su finalidad prevista.

La IA es una tecnología altamente dependiente de los datos que la alimentan. Desde este punto de vista, no disponer de gobernanza de datos no solo puede afectar al funcionamiento de estas herramientas, sino que podría generar responsabilidad para el usuario.

En un futuro no lejano, la obligación de que los sistemas de alto riesgo obtengan un marcado CE emitido por un organismo notificado (es decir, designado por un Estado miembro de la Unión Europea) ofrecerá condiciones de confiabilidad al mercado. Sin embargo, para el resto de los sistemas de menor riesgo aplica la obligación de transparencia. Esto no implica en absoluto que el diseño de esta IA no deba tener en cuenta estos principios en la medida de lo posible. Por tanto, antes de realizar una contratación sería razonable verificar la información precontractual disponible tanto en relación con las características del sistema y su confiabilidad como respecto de las condiciones y recomendaciones de despliegue y uso.

Otra cuestión atañe a nuestra propia organización. Si no disponemos de las adecuadas medidas de cumplimiento normativo, organizativas, técnicas y de calidad que aseguren la confiabilidad de nuestros propios datos, difícilmente podremos utilizar herramientas de IA que se alimenten de ellos. En el contexto del RIA el usuario de un sistema también puede incurrir en responsabilidad. Es perfectamente posible que un producto de esta naturaleza haya sido desarrollado de modo adecuado por el proveedor y que en términos de reproducibilidad éste pueda garantizar que bajo las condiciones adecuadas el sistema funciona correctamente. Lo que desarrolladores y proveedores no pueden resolver son las inconsistencias en los conjuntos de datos que integre en la plataforma el usuario-cliente. No es su responsabilidad si el cliente no desplegó adecuadamente un marco de cumplimiento del Reglamento General de Protección de Datos o está utilizando el sistema para una finalidad ilícita. Tampoco será su responsabilidad que el cliente mantenga conjuntos de datos no actualizados o no confiables que al ser introducidos en la herramienta generen riesgos o contribuyan a la toma de decisiones inadecuadas o discriminatorias.

En consecuencia, la recomendación es clara: antes de implementar un sistema basado en inteligencia artificial debemos asegurarnos de que la gobernanza de datos y el cumplimiento de la legislación vigente se garanticen adecuadamente.

Garantizar la seguridad

La IA es una tecnología particularmente sensible que presenta riesgos de seguridad específicos, -los llamados efectos adversarios-, como por ejemplo la corrupción de los conjuntos de datos. No es necesario buscar ejemplos sofisticados. Como cualquier sistema de información la IA exige que las organizaciones los desplieguen y utilicen de modo seguro. En consecuencia, el despliegue de la IA en cualquier entorno exige el desarrollo previo de un análisis de riesgos que permita identificar cuáles son las medidas organizativas y técnicas que garantizan un uso seguro que la herramienta.

Formar a su personal

A diferencia del RGPD, en el que esta cuestión es implícita, el RIA expresamente establece como obligación el deber de formar. El artículo 4 del RIA es tan preciso que merece la pena su reproducción íntegra:

Los proveedores y responsables del despliegue de sistemas de IA adoptarán medidas para garantizar que, en la mayor medida posible, su personal y demás personas que se encarguen en su nombre del funcionamiento y la utilización de sistemas de IA tengan un nivel suficiente de alfabetización en materia de IA, teniendo en cuenta sus conocimientos técnicos, su experiencia, su educación y su formación, así como el contexto previsto de uso de los sistemas de IA y las personas o los colectivos de personas en que se van a utilizar dichos sistemas.

Este sin duda es un factor crítico. Las personas que utilizan la inteligencia artificial deben haber recibido una formación adecuada que les permita entender la naturaleza del sistema y ser capaces de tomar decisiones informadas. Uno de los principios nucleares de la legislación y del enfoque europeo es el de supervisión humana. Por tanto, con independencia de las garantías que ofrezca un determinado producto de mercado, la organización que lo utiliza siempre será responsable de las consecuencias. Y ello ocurrirá tanto en el caso en el que la última decisión se atribuya a una persona, como cuando en procesos altamente automatizados los responsables de su gestión no sean capaces de identificar una incidencia tomando decisiones adecuadas con supervisión humana.

La culpa in vigilando

La introducción masiva de los LLM plantea el riesgo de incurrir en la llamada culpa in vigilando: un principio jurídico que hace referencia a la responsabilidad que asume una persona por no haber ejercido la debida vigilancia sobre otra, cuando de esa falta de control se deriva un daño o un perjuicio. Si su organización ha introducido cualquiera de estos productos de mercado que integran funciones como realizar informes, evaluar información alfanumérica e incluso asistirle en la gestión del correo electrónico, será fundamental que asegure el cumplimiento de las recomendaciones que anteriormente hemos señalado. Resultará particularmente aconsejable que defina de modo muy preciso los fines para los que se implementa la herramienta, los roles y responsabilidades de cada usuario y proceda a documentar sus decisiones y a formar adecuadamente al personal.

Desgraciadamente el modelo de introducción en el mercado de los LLM ha generado por sí mismo un riesgo sistémico y grave para las organizaciones. La mayor parte de herramientas han optado por una estrategia de comercialización que no difiere en nada de la que en su día emplearon las redes sociales. Esto es, permiten el acceso en abierto y gratuito a cualquier persona. Es obvio que con ello consiguen dos resultados: reutilizar la información que se les facilita monetizando el producto y generar una cultura de uso que facilite la adopción y comercialización de la herramienta.

Imaginemos una hipótesis, por supuesto, descabellada. Un médico interno residente (MIR) ha descubierto que varias de estas herramientas han sido desarrolladas y, de hecho, se utilizan en otro país para el diagnóstico diferencial. Nuestro MIR está muy preocupado por tener que despertar al jefe de guardia médica en el hospital cada 15 minutos. Así que, diligentemente, contrata una herramienta, que no se ha previsto para ese uso en España, y toma decisiones basadas en la propuesta de diagnóstico diferencial de un LLM sin tener todavía las capacidades que lo habilitan para una supervisión humana. Evidentemente existe un riesgo significativo de acabar causando un daño a un paciente.

Situaciones como la descrita obligan a considerar cómo deben actuar las organizaciones que no utilizan IA pero que son conscientes del riesgo de que sus empleados las usen sin su conocimiento o consentimiento. En este sentido, se debería adoptar una estrategia preventiva basada en la emisión de circulares e instrucciones muy precisas respecto de la prohibición de su uso. Por otra parte, existe una situación de riesgo híbrida. El LLM se ha contratado por la organización y es utilizada por la persona empleada para fines distintos de los previstos. En tal caso la dupla seguridad-formación adquiere un valor estratégico.

Probablemente la formación y la adquisición de cultura sobre la inteligencia artificial sea un requisito esencial para el conjunto de la sociedad. De lo contrario, los problemas y riesgos sistémicos que en el pasado afectaron al despliegue de Internet volverán a suceder y quién sabe si con una intensidad difícil de gobernar.

Contenido elaborado por Ricard Martínez Martínez, Director de la Cátedra de Privacidad y Transformación Digital, Departamento de Derecho Constitucional de la Universitat de València. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

NOTAS

[1] Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo, de 13 de junio de 2024, por el que se establecen normas armonizadas en materia de inteligencia artificial y por el que se modifican los Reglamentos (CE) n.° 300/2008, (UE) n.° 167/2013, (UE) n.° 168/2013, (UE) 2018/858, (UE) 2018/1139 y (UE) 2019/2144 y las Directivas 2014/90/UE, (UE) 2016/797 y (UE) 2020/1828 disponible en https://eur-lex.europa.eu/legal-content/ES/TXT/?uri=OJ%3AL_202401689

[2] El RIA define como «proveedor»: una persona física o jurídica, autoridad pública, órgano u organismo que desarrolle un sistema de IA o un modelo de IA de uso general o para el que se desarrolle un sistema de IA o un modelo de IA de uso general y lo introduzca en el mercado o ponga en servicio el sistema de IA con su propio nombre o marca, previo pago o gratuitamente.

[3] EL RIA define como «responsable del despliegue»: una persona física o jurídica, o autoridad pública, órgano u organismo que utilice un sistema de IA bajo su propia autoridad, salvo cuando su uso se enmarque en una actividad personal de carácter no profesional.

[4] El RIA define como «modelo de IA de uso general»: un modelo de IA, también uno entrenado con un gran volumen de datos utilizando autosupervisión a gran escala, que presenta un grado considerable de generalidad y es capaz de realizar de manera competente una gran variedad de tareas distintas, independientemente de la manera en que el modelo se introduzca en el mercado, y que puede integrarse en diversos sistemas o aplicaciones posteriores, excepto los modelos de IA que se utilizan para actividades de investigación, desarrollo o creación de prototipos antes de su introducción en el mercado.

Sabemos que los datos abiertos que gestiona el sector público en el ejercicio de sus funciones constituyen un recurso de gran valor para fomentar la transparencia, impulsar la innovación y estimular el desarrollo económico. A nivel global, en los últimos 15 años esta idea ha llevado a la creación de portales de datos que sirven como punto de acceso único para la información pública tanto de un país, como de una región o ciudad.

Sin embargo, en ocasiones nos encontramos que el pleno aprovechamiento del potencial de los datos abiertos se ve limitado por problemas inherentes a su calidad. Inconsistencias, falta de estandarización o interoperabilidad y metadatos incompletos son solo algunos de los desafíos comunes que a veces merman la utilidad de los conjuntos de datos abiertos y que las agencias gubernamentales además señalan como el principal obstáculo para la adopción de la IA.

Cuando hablamos de la relación entre datos abiertos e inteligencia artificial, casi siempre partimos de la misma idea: los datos abiertos alimentan a la IA, esto es, son parte del combustible de los modelos. Ya sea para entrenar modelos fundacionales como ALIA, para especializar modelos de lenguaje pequeños (SLM) frente a LLM, o para evaluar y validar sus capacidades o explicar su comportamiento (XAI), el argumento gira en torno a la utilidad de los datos abiertos para la inteligencia artificial, olvidando que los datos abiertos ya estaban ahí y tienen muchas otras utilidades.

Por ello, vamos a invertir la perspectiva y a explorar cómo la propia IA puede convertirse en una herramienta poderosa para mejorar la calidad y, por tanto, el valor de los propios datos abiertos. Este enfoque, que ya esbozó la Comisión Económica para Europa de las Naciones Unidas (UNECE) en su pionero informe Machine Learning for Official Statistics de 2022, adquiere una mayor relevancia desde la explosión de la IA generativa. Actualmente podemos utilizar la inteligencia artificial disponible para incrementar la calidad de los conjuntos de datos que se publican a lo largo de todo su ciclo de vida: desde la captura y la normalización hasta la validación, la anonimización, la documentación y el seguimiento en producción.

Con ello, podemos aumentar el valor público del dato, contribuir a que crezca su reutilización y a amplificar su impacto social y económico. Y, al mismo tiempo, a mejorar la calidad de la siguiente generación de modelos de inteligencia artificial.

Desafíos comunes en la calidad de los datos abiertos

La calidad de los datos ha sido tradicionalmente un factor crítico para el éxito de cualquier iniciativa de datos abiertos, que aparece citado en numerosos informes como el de Comisión Europea “Improving data publishing by open data portal managers and owners”. Los desafíos más frecuentes que enfrentan los publicadores de datos incluyen:

-

Inconsistencias y errores: en los conjuntos de datos, es frecuente la presencia de datos duplicados, formatos heterogéneos o valores atípicos. La corrección de estos pequeños errores, idealmente en la propia fuente de los datos, tenía tradicionalmente un coste elevado y limitaba enormemente la utilidad de numerosos conjuntos de datos.

-

Falta de estandarización e interoperabilidad: dos conjuntos que hablan de lo mismo pueden nombrar las columnas de forma diferente, usar clasificaciones no comparables o carecer de identificadores persistentes para enlazar entidades. Sin un mínimo común, combinar fuentes se convierte en un trabajo artesanal que encarece la reutilización de los datos.

- Metadatos incompletos o inexactos: la carencia de información clara sobre el origen, la metodología de recolección, la frecuencia de actualización o el significado de los campos, complica la comprensión y el uso de los datos. Por ejemplo, saber con certeza si se puede integrar el recurso en un servicio, si está al día o si existe un punto de contacto para resolver dudas es muy importante para su reutilización.

- Datos obsoletos o desactualizados: en dominios muy dinámicos como la movilidad, los precios o los datos de medio ambiente, un conjunto desactualizado puede generar conclusiones erróneas. Y si no hay versiones, registro de cambios o indicadores de frescura, es difícil saber qué ha variado y por qué. La ausencia de un “historial” de los datos complica la auditoría y reduce la confianza.

- Sesgos inherentes: a veces la cobertura es incompleta, ciertas poblaciones quedan infrarrepresentadas o una práctica administrativa introduce una desviación sistemática. Si estos límites no se documentan y advierten, los análisis pueden reforzar desigualdades o llegar a conclusiones injustas sin que nadie lo perciba.

Dónde puede ayudar la Inteligencia Artificial

Por fortuna, en su estado actual, la inteligencia artificial ya está en disposición de proporcionar un conjunto de herramientas que pueden contribuir a abordar algunos de estos desafíos de calidad de los datos abiertos, transformando su gestión de un proceso manual y propenso a errores en uno más automatizado y eficiente:

- Detección y corrección de errores automatizada: los algoritmos de aprendizaje automático y los modelos de IA pueden identificar automáticamente y con una gran fiabilidad inconsistencias, duplicados, valores atípicos y errores tipográficos en grandes volúmenes de datos. Además, la IA puede ayudar a normalizar y estandarizar datos, transformándolos por ejemplo a formatos y esquemas comunes para facilitar la interoperabilidad (como DCAT-AP), y con una fracción del coste que suponía hasta el momento.

- Enriquecimiento de metadatos y catalogación: las tecnologías asociadas al procesamiento de lenguaje natural (PLN), incluyendo el uso de modelos de lenguaje grandes (LLM) y pequeños (SLM), puede ayudar en la tarea de analizar descripciones y generar metadatos más completos y precisos. Esto incluye tareas como sugerir etiquetas relevantes, categorías de clasificación o extraer entidades clave (nombres de lugares, organizaciones, etc.) de descripciones textuales para enriquecer los metadatos.

- Anonimización y privacidad: cuando los datos abiertos contienen información que podría afectar a la privacidad, la anonimización se convierte en una tarea crítica, pero, en ocasiones, costosa. La Inteligencia Artificial puede contribuir a que la anonimización sea mucho más robusta y a minimizar riesgos relacionados con la re-identificación al combinar diferentes conjuntos de datos.

Evaluación de sesgos: la IA puede analizar los propios conjuntos de datos abiertos para detectar sesgos de representación o históricos. Esto permite a los publicadores tomar medidas para corregirlos o, al menos, advertir a los usuarios sobre su presencia para que sean tenidos en cuenta cuando vayan a reutilizarse. En definitiva, la inteligencia artificial no debe verse solo como “consumidora” de datos abiertos, sino también como una aliada estratégica para mejorar su calidad. Cuando se integra con estándares, procesos y supervisión humana, la IA ayuda a detectar y explicar incidencias, a documentar mejor los conjuntos y a publicar evidencias de calidad que refuerzan la confianza. Tal y como se describe en la Estrategia de Inteligencia Artificial 2024, esa sinergia libera más valor público: facilita la innovación, permite decisiones mejor informadas y consolida un ecosistema de datos abiertos más robusto y fiable con unos datos abiertos más útiles, más confiables y con mayor impacto social.

Además, se activa un ciclo virtuoso: datos abiertos de mayor calidad entrenan modelos más útiles y seguros; y modelos más capaces facilitan seguir elevando la calidad de los datos. De este modo la gestión del dato deja de ser una tarea estática de publicación y se convierte en un proceso dinámico de mejora continua.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La inteligencia artificial (IA) se ha convertido en una tecnología central en la vida de las personas y en la estrategia de las empresas. En poco más de una década hemos pasado de interactuar con asistentes virtuales que entendían órdenes sencillas, a ver sistemas capaces de redactar informes completos, crear imágenes hiperrealistas o incluso escribir código.

Este salto tan visible ha hecho que muchos se pregunten: ¿es todo lo mismo?, ¿qué diferencia hay entre lo que ya conocíamos como IA y esta nueva “IA Generativa” de la que tanto se habla?

En este artículo vamos a ordenar esas ideas y explicar, con ejemplos claros, cómo encajan la IA “Tradicional” y la IA Generativa bajo el gran paraguas de la inteligencia artificial.

La IA tradicional: análisis y predicción

Durante muchos años, lo que entendíamos por IA estaba más cerca de lo que hoy llamamos “IA Tradicional”. Estos sistemas se caracterizan por resolver problemas concretos, bien definidos y dentro de un marco de reglas o datos disponibles.

Algunos ejemplos prácticos:

-

Motores de recomendación: Spotify sugiere canciones basadas en tu historial de escucha y Netflix ajusta su catálogo a tus gustos personales, generando hasta el 80% de las visualizaciones en la plataforma.

-

Sistemas de predicción: Walmart utiliza modelos predictivos para anticipar la demanda de productos en función de factores como el clima o eventos locales; Red Eléctrica de España aplica algoritmos similares para prever el consumo eléctrico y equilibrar la red.