Los modelos de lenguaje se encuentran en el epicentro del cambio de paradigma tecnológico que está protagonizando la inteligencia artificial (IA) generativa en los últimos dos años. Desde las herramientas con las que interaccionamos en lenguaje natural para generar texto, imágenes o vídeos y que utilizamos para crear contenido creativo, diseñar prototipos o producir material educativo, hasta aplicaciones más complejas en investigación y desarrollo que incluso han contribuido de forma decisiva a la consecución del Premio Nobel de Química de 2024, los modelos de lenguaje están demostrando su utilidad en una gran variedad de aplicaciones, que por otra parte, aún estamos explorando.

Desde que en 2017 Google publicó el influyente artículo "Attention is all you need", donde se describió la arquitectura de los Transformers, tecnología que sustenta las nuevas capacidades que OpenAI popularizó a finales de 2022 con el lanzamiento de ChatGPT, la evolución de los modelos de lenguaje ha sido más que vertiginosa. En apenas dos años, hemos pasado de modelos centrados únicamente en la generación de texto a versiones multimodales que integran la interacción y generación de texto, imágenes y audio.

Esta rápida evolución ha dado lugar a dos categorías de modelos de lenguaje: los SLM (Small Language Models), más ligeros y eficientes, y los LLM (Large Language Models), más pesados y potentes. Lejos de considerarlos competidores, debemos analizar los SLM y LLM como tecnologías complementarias. Mientras los LLM ofrecen capacidades generales de procesamiento y generación de contenido, los SLM pueden proporcionar soporte a soluciones más ágiles y especializadas para necesidades concretas. Sin embargo, ambos comparten un elemento esencial: dependen de grandes volúmenes de datos para su entrenamiento y en el corazón de sus capacidades están los datos abiertos, que son parte del combustible que se utiliza para entrenar estos modelos de lenguaje en los que se basan las aplicaciones de IA generativa.

LLM: potencia impulsada por datos masivos

Los LLM son modelos de lenguaje a gran escala que cuentan con miles de millones, e incluso billones, de parámetros. Estos parámetros son las unidades matemáticas que permiten al modelo identificar y aprender patrones en los datos de entrenamiento, lo que les proporciona una extraordinaria capacidad para generar texto (u otros formatos) coherente y adaptado al contexto de los usuarios. Estos modelos, como la familia GPT de OpenAI, Gemini de Google o Llama de Meta, se entrenan con inmensos volúmenes de datos y son capaces de realizar tareas complejas, algunas incluso para las que no fueron explícitamente entrenados.

De este modo, los LLM son capaces de realizar tareas como la generación de contenido original, la respuesta a preguntas con información relevante y bien estructurada o la generación de código de software, todas ellas con un nivel de competencia igual o superior al de los humanos especializados en dichas tareas y siempre manteniendo conversaciones complejas y fluidas.

Los LLM se basan en cantidades masivas de datos para alcanzar su nivel de desempeño actual: desde repositorios como Common Crawl, que recopila datos de millones de páginas web, hasta fuentes estructuradas como Wikipedia o conjuntos especializados como PubMed Open Access en el campo biomédico. Sin acceso a estos corpus masivos de datos abiertos, la capacidad de estos modelos para generalizar y adaptarse a múltiples tareas sería mucho más limitada.

Sin embargo, a medida que los LLM continúan evolucionando, la necesidad de datos abiertos aumenta para conseguir progresos específicos como:

- Mayor diversidad lingüística y cultural: aunque los LLM actuales manejan múltiples idiomas, en general están dominados por datos en inglés y otros idiomas mayoritarios. La falta de datos abiertos en otras lenguas limita la capacidad de estos modelos para ser verdaderamente inclusivos y diversos. Más datos abiertos en idiomas diversos garantizarían que los LLM puedan ser útiles para todas las comunidades, preservando al mismo tiempo la riqueza cultural y lingüística del mundo.

- Reducción de sesgos: los LLM, como cualquier modelo de IA, son propensos a reflejar los sesgos presentes en los datos con los que se entrenan. Esto, en ocasiones, genera respuestas que perpetúan estereotipos o desigualdades. Incorporar más datos abiertos cuidadosamente seleccionados, especialmente de fuentes que promuevan la diversidad y la igualdad, es fundamental para construir modelos que representen de manera justa y equitativa a diferentes grupos sociales.

- Actualización constante: los datos en la web y en otros recursos abiertos cambian constantemente. Sin acceso a datos actualizados, los LLM generan respuestas obsoletas muy rápidamente. Por ello, incrementar la disponibilidad de datos abiertos frescos y relevantes permitiría a los LLM mantenerse alineados con la actualidad.

- Entrenamiento más accesible: a medida que los LLM crecen en tamaño y capacidad, también lo hace el coste de entrenarlos y afinarlos. Los datos abiertos permiten que desarrolladores independientes, universidades y pequeñas empresas entrenen y afinen sus propios modelos sin necesidad de costosas adquisiciones de datos. De este modo se democratiza el acceso a la inteligencia artificial y se fomenta la innovación global.

Para solucionar algunos de estos retos, en la nueva Estrategia de Inteligencia Artificial 2024 se han incluido medidas destinadas a generar modelos y corpus en castellano y lenguas cooficiales, incluyendo también el desarrollo de conjuntos de datos de evaluación que consideran la evaluación ética.

SLM: eficiencia optimizada con datos específicos

Por otra parte, los SLM han emergido como una alternativa eficiente y especializada que utiliza un número más reducido de parámetros (generalmente en millones) y que están diseñados para ser ligeros y rápidos. Aunque no alcanzan la versatilidad y competencia de los LLM en tareas complejas, los SLM destacan por su eficiencia computacional, rapidez de implementación y capacidad para especializarse en dominios concretos.

Para ello, los SLM también dependen de datos abiertos, pero en este caso, la calidad y relevancia de los conjuntos de datos son más importantes que su volumen, por ello los retos que les afectan están más relacionados con la limpieza y especialización de los datos. Estos modelos requieren conjuntos que estén cuidadosamente seleccionados y adaptados al dominio específico para el que se van a utilizar, ya que cualquier error, sesgo o falta de representatividad en los datos puede tener un impacto mucho mayor en su desempeño. Además, debido a su enfoque en tareas especializadas, los SLM enfrentan desafíos adicionales relacionados con la accesibilidad de datos abiertos en campos específicos. Por ejemplo, en sectores como la medicina, la ingeniería o el derecho, los datos abiertos relevantes suelen estar protegidos por restricciones legales y/o éticas, lo que dificulta su uso para entrenar modelos de lenguaje.

Los SLM se entrenan con datos cuidadosamente seleccionados y alineados con el dominio en el que se utilizarán, lo que les permite superar a los LLM en precisión y especificidad en tareas concretas, como por ejemplo:

- Autocompletado de textos: un SLM para autocompletado en español puede entrenarse con una selección de libros, textos educativos o corpus como los que se impulsarán en la ya mencionada Estrategia de IA, siendo mucho más eficiente que un LLM de propósito general para esta tarea.

- Consultas jurídicas: un SLM entrenado con conjuntos de datos jurídicos abiertos pueden proporcionar respuestas precisas y contextualizadas a preguntas legales o procesar documentos contractuales de forma más eficaz que un LLM.

- Educación personalizada: en el sector educativo, SLM entrenados con datos abiertos de recursos didácticos pueden generar explicaciones específicas, ejercicios personalizados o incluso evaluaciones automáticas, adaptadas al nivel y las necesidades del estudiante.

- Diagnóstico médico: un SLM entrenado con conjuntos de datos médicos, como resúmenes clínicos o publicaciones abiertas, puede asistir a médicos en tareas como la identificación de diagnósticos preliminares, la interpretación de imágenes médicas mediante descripciones textuales o el análisis de estudios clínicos.

Desafíos y consideraciones éticas

No debemos olvidar que, a pesar de los beneficios, el uso de datos abiertos en modelos de lenguaje presenta desafíos significativos. Uno de los principales retos es, como ya hemos mencionado, garantizar la calidad y neutralidad de los datos para que estén libres de sesgos, ya que estos pueden amplificarse en los modelos, perpetuando desigualdades o prejuicios.

Aunque un conjunto de datos sea técnicamente abierto, su utilización en modelos de inteligencia artificial siempre plantea algunas implicaciones éticas. Por ejemplo, es necesario evitar que información personal o sensible se filtre o pueda deducirse de los resultados generados por los modelos, ya que esto podría causar daños a la privacidad de las personas.

También debe tenerse en cuenta la cuestión de la atribución y propiedad intelectual de los datos. El uso de datos abiertos en modelos comerciales debe abordar cómo se reconoce y compensa adecuadamente a los creadores originales de los datos para que sigan existiendo incentivos a los creadores.

Los datos abiertos son el motor que impulsa las asombrosas capacidades de los modelos de lenguaje, tanto en el caso de los SLM como de los LLM. Mientras que los SLM destacan por su eficiencia y accesibilidad, los LLM abren puertas a aplicaciones avanzadas que no hace mucho nos parecían imposibles. Sin embargo, el camino hacia el desarrollo de modelos más capaces, pero también más sostenibles y representativos, depende en gran medida de cómo gestionemos y aprovechemos los datos abiertos.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los premios 2024 Best Cases Award del observatorio Public Sector Tech Watch ya tienen finalistas. Estos premios buscan destacar soluciones que utilizan tecnologías emergentes, como inteligencia artificial o blockchain, en las administraciones públicas, a través de dos categorías:

- Soluciones para mejorar los servicios públicos que se ofrecen a los ciudadanos (Government-to-Citizen o G2C).

- Soluciones para mejorar los procesos internos de las propias administraciones (Government-to-Government o G2G).

Con estos premios se pretende generar un mecanismo para compartir las mejores experiencias sobre el uso de tecnologías emergentes en el sector público y así dar visibilidad a las administraciones más innovadoras de Europa.

Casi el 60% de las soluciones finalistas son españolas

En total, se han recibido 32 propuestas, 14 de las cuales han sido preseleccionadas en una evaluación previa. De ellas, más de la mitad son soluciones de organismos españoles. En concreto, se han preseleccionado nueve finalistas para la categoría G2G -cinco de ellas españolas- y cinco para G2C -tres de ellas ligadas a nuestro país-.

A continuación, se resumen en qué consisten estas soluciones españolas.

Soluciones para mejorar los procesos internos de las propias administraciones

- Innovación en el gobierno local: transformación digital y GeoAI para la gestión de datos (Diputación de Alicante).

Suma Gestión Tributaria, de la Diputación de Alicante, es el organismo encargado de gestionar y recaudar los tributos municipales de los ayuntamientos de su provincia. Para optimizar esta tarea, han desarrollado una solución que combina sistemas de información geográfica e inteligencia artificial (machine learning y deep learning) para mejorar la formación en detección de inmuebles que no tributan en los padrones. Esta solución recaba datos de múltiples administraciones y entidades con el objetivo de evitar retrasos en la recaudación de los ayuntamientos.

- Inspector autonómico de infraestructuras públicas: seguimiento de zonas de obras (Diputación Foral de Bizkaia e Interbiak).

El inspector autónomo de carreteras y el inspector autónomo urbano ayudan a las administraciones públicas a realizar un seguimiento automático de las carreteras. Estas soluciones, que se pueden instalar en cualquier vehículo, utilizan técnicas de visión artificial o por computadora junto a información procedente de sensores para comprobar de forma automática el estado de señales de tráfico, marcas viales, barreras de protección, etc. También realizan tareas de previsión temprana de la degradación del pavimento, monitorizan zonas de obras y generan alertas ante peligros, como posibles deslizamientos.

- Aplicación de drones para el transporte de muestras biológicas (Centro de Telecomunicaciones y Tecnologías de la Información -CTTI-, Generalitat de Catalunya).

Este proyecto piloto implementa y evalúa una ruta de transporte sanitario en la región sanitaria de Girona. Su objetivo es transportar muestras biológicas (sangre y orina) entre un centro de salud primaria y un hospital utilizando drones. Gracias a ello, el trayecto ha pasado de durar 20 minutos con el transporte terrestre a siete minutos con el uso de drones. Esto ha permitido mejorar la calidad de las muestras transportadas, aumentar la flexibilidad en la programación de los tiempos de transporte y reducir el impacto medioambiental.

- Automatización robótica de procesos en la administración de justicia (Ministerio de la Presidencia, Justicia y Relaciones con las Cortes).

Ministerio de la Presidencia, Justicia y Relaciones con las Cortes ha puesto en marcha una solución para la robotización de procesos administrativos con el fin de agilizar trabajos rutinarios, repetitivos y de bajo riesgo. Hasta la fecha, se han puesto en marcha más de 25 líneas de automatización de procesos, entre las que se encuentran la cancelación automática de antecedentes penales, las solicitudes de nacionalidad, la emisión automática de certificaciones de seguros de vida, etc. Gracias a ello se estima que se han ahorrado más de 500 mil horas de trabajo.

- Inteligencia artificial en el tratamiento de las publicaciones oficiales (Boletín Oficial de la Provincia de Barcelona y Servicio de Documentación y Publicaciones Oficiales, Diputación de Barcelona).

El CIDO (Buscador de Información y Documentación Oficial) ha implementado un sistema de IA que genera automáticamente resúmenes de publicaciones oficiales de las administraciones públicas de Barcelona. Utilizando técnicas de aprendizaje automático supervisado y redes neuronales, el sistema genera resúmenes de hasta 100 palabras para publicaciones en catalán o castellano. La herramienta permite el registro de modificaciones manuales para mejorar la precisión.

Soluciones para mejorar los servicios públicos que se ofrecen a los ciudadanos

- Escritorio Virtual de Inmediación Digital: acercar la Justicia a los ciudadanos a través de la digitalización (Ministerio de la Presidencia, Justicia y Relaciones con las Cortes).

El Escritorio Virtual de Inmediación Digital (EVID) permite realizar vistas a distancia con plenas garantías de seguridad jurídica utilizando tecnologías blockchain. La solución integra la convocatoria de la vista, la aportación de la documentación, la identificación de los participantes, la aceptación de consentimientos, la generación del documento justificativo de la actuación realizada, la firma de éste y la grabación de la sesión. De esta forma se pueden realizar actos jurídicos desde cualquier lugar, sin necesidad de desplazarse y de forma sencilla, haciendo que la justicia sea más inclusiva, accesible y ecológica. A finales de junio de 2024, se habían celebrado más de 370.000 sesiones virtuales a través de la EVID.

- Aplicación de la IA Generativa para facilitar a los ciudadanos la comprensión de los textos legales (Entitat Autònoma del Diari Oficial i Publicacions -EADOP-, Generalitat de Catalunya).

A menudo, el lenguaje jurídico es una barrera que impide a la ciudadanía entender fácilmente los textos legales. Para eliminar este obstáculo, el Govern pone a disposición de los usuarios del Portal Jurídico de Cataluña y de la población en general los resúmenes de normas de derecho catalán en lenguaje sencillo obtenidos a partir de la inteligencia artificial generativa. El objetivo es que, a finales de año, estén disponibles los resúmenes de las más de 14.000 disposiciones normativas vigentes adaptadas a la comunicación clara. Los resúmenes estarán editados en catalán y en castellano, con la perspectiva de ofrecer también en el futuro su versión en aranés.

- Emi - Empleo Inteligente (Consellería de Emprego, Comercio e Emigración de la Xunta de Galicia).

Emi, Empleo Inteligente es una herramienta de inteligencia artificial y big data que ayuda a las oficinas del Servicio Público de Empleo de Galicia a orientar a las personas desempleadas hacia las competencias que requiere el mercado laboral, en función de sus capacidades. Los modelos de IA realizan proyecciones a seis meses de los contratos de una ocupación concreta para una zona geográfica elegida. Además, permiten calcular la probabilidad de encontrar empleo de los individuos en los próximos meses.

Puedes ver todas las soluciones presentadas aquí. Los ganadores se anunciarán en el evento final que se celebrará el 28 de noviembre. La ceremonia se celebra en Bruselas, pero se podrá seguir también de manera online. Para ello es necesario registrarse aquí.

Public Sector Tech Watch: un observatorio para inspirar nuevos proyectos

Public Sector Tech Watch (PSTW), gestionado por la Comisión Europea, se posiciona como una “ventanilla única” para todos aquellos interesados -sector público, responsables políticos, empresas privadas, mundo académico, etc.- en los últimos avances tecnológicos para mejorar el funcionamiento del sector público y la prestación de servicios. Para ello cuenta con varias secciones donde se muestra la siguiente información de interés:

- Cases: contiene ejemplos de cómo utilizan tecnologías innovadores y sus datos asociados las organizaciones del sector público en Europa.

- Stories: presenta testimonios para mostrar los retos a los que se enfrentan las administraciones europeas en la aplicación de soluciones tecnológicas.

Si conoces algún caso de interés que actualmente no esté monitorizado por PSTW, puedes darlo de alta aquí. Los casos de éxito son revisados y evaluados antes de incluirse en la base de datos.

Desde el 28 de octubre y hasta el 24 de noviembre estará abierta la inscripción para presentar propuestas al reto de la Diputación de Bizkaia. El objetivo de la competición es identificar iniciativas que combinen la reutilización de datos disponibles en el portal Open Data Bizkaia con el uso de la inteligencia artificial. Las bases completas están disponibles en este enlace, pero, en este post, te contamos todo lo que tienes que saber sobre este concurso que ofrece premios en metálico para los cinco mejores proyectos.

Los participantes deberán utilizar al menos un dataset de la Diputación Foral de Bizkaia o de los ayuntamientos del territorio, que se pueden encontrar en el catálogo, para abordar uno de los cinco casos de uso propuestos:

- Contenido promocional sobre atractivos turísticos de Bizkaia: contenido promocional por escrito, como pueden ser imágenes generadas, flyers, etc. que utilicen datasets como:

- Playas de Bizkaia por municipio

- Agenda cultural – BizkaiKOA

- Agenda cultural de Bizkaia

- Bizkaibus

- Senderos

- Áreas de esparcimiento

- Hoteles de Euskadi – Open Data Euskadi

- Predicciones de la temperatura en Bizkaia – datos de Weather API

- Impulso del turismo a través del análisis de sentimientos: archivos de texto con recomendaciones para mejorar los recursos turísticos, como reportes en Excel y PowerPoint, etc. que utilicen datasets como:

- Playas de Bizkaia por municipio

- Agenda cultura – BizkaiKOA

- Agenda cultural de Bizkaia

- Bizkaibus

- Senderos

- Áreas de esparcimiento

- Hoteles de Euskadi – Open Data Euskadi

- Google reviews API – este recurso es de pago con posible capa gratuita

- Guías personalizadas para el turismo: Chatbot, documento con recomendaciones personalizadas que utilicen datasets como:

- Tabla de mareas 2024

- Playas de Bizkaia por municipio

- Agenda cultural – BizkaiKOA

- Agenda cultural de Bizkaia

- Bizkaibus

- Senderos

- Hoteles de Euskadi – Open Data Euskadi

- Predicciones de la temperatura en Bizkaia – datos de Weather API, recurso con capa gratuita

- Recomendación personalizada de eventos culturales: Chatbot, documento con recomendaciones personalizadas que utilicen datasets como:

- Agenda cultural - BizkaiKOA

- Agenda cultural de Bizkaia

- Optimización de la gestión de residuos: Reportes Excel, PowerPoint y Word que contengan recomendaciones y estrategias que utilicen datasets como:

- Residuos urbanos

- Contenedores por municipio

¿Cómo participar?

Los participantes podrán inscribirse de forma individual o en equipos a través de este formulario disponible en la web. El plazo de inscripción es del 28 de octubre al 24 de noviembre de 2024. Una vez cerrada la inscripción, los equipos deberán presentar sus soluciones en Sharepoint. Un jurado preseleccionará a cinco finalistas, quienes tendrán la oportunidad de presentar su proyecto en el evento final el 12 de diciembre, en el que se entregarán los premios. La organización recomienda asistir presencialmente, pero, si no es posible, también se permitirá la asistencia online.

La competición está abierta a cualquier persona mayor de 16 años con DNI o pasaporte en vigor, que no pertenezca a las entidades organizadoras. Además, se pueden presentar más de una propuesta.

¿Cuáles son los premios?

Los miembros del jurado elegirán cinco proyectos ganadores en base a los siguientes criterios de valoración:

- Adecuación de la solución propuesta al reto seleccionado.

- La creatividad y la innovación.

- Calidad y coherencia de la solución.

- Adecuación de datasets de Open Data Bizkaia utilizados.

Las candidaturas ganadoras recibirán un premio en metálico, así como el compromiso de abrir los datasets asociados al proyecto, en la medida en que sea posible.

- Primer premio: 2.000 €.

- Segundo premio: 1.000 €.

- Tres premios para el resto de finalistas de 500 € a cada uno.

Uno de los objetivos de este reto, tal y como explica la Diputación Foral de Bizkaia, es conocer si la oferta actual de datasets se ajusta a la demanda. Por este motivo, si alguna persona participante precisa de un conjunto de datos de Bizkaia o de sus ayuntamientos que no está disponible, puede proponer que la institución lo ponga a disposición del público. Siempre y cuando dicha información se ajuste a las competencias de la Diputación Foral de Bizkaia o de los ayuntamientos.

Este es un evento único que no solo te permitirá mostrar tus habilidades en inteligencia artificial y datos abiertos, sino que también contribuirás al desarrollo y mejora de Bizkaia. No dejes pasar la oportunidad de ser parte de este emocionante reto. ¡Inscríbete y empieza a crear soluciones innovadoras!

El procesamiento del lenguaje natural (NLP, por sus siglas en inglés) es una rama de la inteligencia artificial que permite a las máquinas comprender y manipular el lenguaje humano. En el núcleo de muchas aplicaciones modernas, como asistentes virtuales, sistemas de traducción automática y chatbots, se encuentran los word embeddings. Pero, ¿qué son exactamente y por qué son tan importantes?

¿Qué son los word embeddings?

Los word embeddings son una técnica que permite a las máquinas representar el significado de las palabras de manera que se puedan capturar relaciones complejas entre ellas. Para entenderlo, pensemos en cómo las palabras se usan en un contexto determinado: una palabra adquiere significado en función de las palabras que la rodean. Por ejemplo, la palabra banco podría referirse a una institución financiera o a un asiento, dependiendo del contexto en el que se encuentre.

La idea detrás de los word embeddings es que se asigna a cada palabra un vector en un espacio de varias dimensiones. La posición de estos vectores en el espacio refleja la cercanía semántica entre las palabras. Si dos palabras tienen significados similares, sus vectores estarán cercanos. Si sus significados son opuestos o no tienen relación, estarán distantes en el espacio vectorial.

Para visualizarlo, imaginemos que palabras como lago, río y océano estarían cerca entre sí en este espacio, mientras que palabras como lago y edificio estarían mucho más separadas. Esta estructura permite que los algoritmos de procesamiento de lenguaje puedan realizar tareas complejas, como encontrar sinónimos, hacer traducciones precisas o incluso responder preguntas basadas en contexto.

¿Cómo se crean los word embeddings?

El objetivo principal de los word embeddings es capturar relaciones semánticas y la información contextual de las palabras, transformándolas en representaciones numéricas que puedan ser comprendidas por los algoritmos de machine learning (aprendizaje automático). En lugar de trabajar con texto sin procesar, las máquinas requieren que las palabras se conviertan en números para poder identificar patrones y relaciones de manera efectiva.

El proceso de creación de word embeddings consiste en entrenar un modelo en un gran corpus de texto, como artículos de Wikipedia, para aprender la estructura del lenguaje. El primer paso implica realizar una serie de preprocesamientos en el corpus, que incluye tokenizar las palabras, eliminar puntuación y términos irrelevantes, y, en algunos casos, convertir todo el texto a minúsculas para mantener la consistencia.

El uso del contexto para capturar el significado

Una vez preprocesado el texto, se utiliza una técnica conocida como "ventana de contexto deslizante" para extraer información. Esto significa que, para cada palabra objetivo, se toman en cuenta las palabras que la rodean dentro de un cierto rango. Por ejemplo, si la ventana de contexto es de 3 palabras, para la palabra avión en la frase “El avión despega a las seis”, las palabras de contexto serán El, despega, a.

El modelo se entrena para aprender a predecir una palabra objetivo usando las palabras de su contexto (o a la inversa, predecir el contexto a partir de la palabra objetivo). Para ello, el algoritmo ajusta sus parámetros de manera que los vectores asignados a cada palabra se acerquen más en el espacio vectorial si esas palabras aparecen frecuentemente en contextos similares.

Cómo los modelos aprenden la estructura del lenguaje

La creación de los word embeddings se basa en la capacidad de estos modelos para identificar patrones y relaciones semánticas. Durante el entrenamiento, el modelo ajusta los valores de los vectores de manera que las palabras que suelen compartir contextos tengan representaciones similares. Por ejemplo, si avión y helicóptero se usan frecuentemente en frases similares (por ejemplo, en el contexto de transporte aéreo), los vectores de avión y helicóptero estarán cerca en el espacio vectorial.

A medida que el modelo procesa más y más ejemplos de frases, va afinando las posiciones de los vectores en el espacio continuo. De este modo, los vectores no solo reflejan la proximidad semántica, sino también otras relaciones como sinónimos, categorías (por ejemplo, frutas, animales) y relaciones jerárquicas (por ejemplo, perro y animal).

Un par de ejemplos simplificado

Imaginemos un pequeño corpus de solo seis palabras: guitarra, bajo, batería, piano, coche y bicicleta. Supongamos que cada palabra se representa en un espacio vectorial de tres dimensiones de la siguiente manera:

guitarra [0.3, 0.8, -0.1]

bajo [0.4, 0.7, -0.2]

batería [0.2, 0.9, -0.1]

piano [0.1, 0.6, -0.3]

coche [0.8, -0.1, 0.6]

bicicleta [0.7, -0.2, 0.5]

En este ejemplo simplificado, las palabras guitarra, bajo, batería y piano representan instrumentos musicales y están ubicadas cerca unas de otras en el espacio vectorial, ya que se utilizan en contextos similares. En cambio, coche y bicicleta, que pertenecen a la categoría de medios de transporte, se encuentran alejadas de los instrumentos musicales pero cercanas entre ellas. Esta otra imagen muestra cómo se verían distintos términos relacionados con cielo, alas e ingeniería en un espacio vectorial.

Figura1. Ejemplos de representación de un corpus en un espacio vectorial. Fuente: Adaptación de “Word embeddings: the (very) basics”, de Guillaume Desagulier.

Estos ejemplos solo utilizan tres dimensiones para ilustrar la idea, pero en la práctica, los word embeddings suelen tener entre 100 y 300 dimensiones para capturar relaciones semánticas más complejas y matices lingüísticos.

El resultado final es un conjunto de vectores que representan de manera eficiente cada palabra, permitiendo a los modelos de procesamiento de lenguaje identificar patrones y relaciones semánticas de forma más precisa. Con estos vectores, las máquinas pueden realizar tareas avanzadas como búsqueda semántica, clasificación de texto y respuesta a preguntas, mejorando significativamente la comprensión del lenguaje natural.

Estrategias para generar word embeddings

A lo largo de los años, se han desarrollado múltiples enfoques y técnicas para generar word embeddings. Cada estrategia tiene su forma de capturar el significado y las relaciones semánticas de las palabras, lo que resulta en diferentes características y usos. A continuación, se presentan algunas de las principales estrategias:

1. Word2Vec: captura de contexto local

Desarrollado por Google, Word2Vec es uno de los enfoques más conocidos y se basa en la idea de que el significado de una palabra se define por su contexto. Usa dos enfoques principales:

- CBOW (Continuous Bag of Words): en este enfoque, el modelo predice la palabra objetivo usando las palabras de su entorno inmediato. Por ejemplo, dado un contexto como "El perro está ___ en el jardín", el modelo intenta predecir la palabra jugando, basándose en las palabras El, perro, está y jardín.

- Skip-gram: A la inversa, Skip-gram usa una palabra objetivo para predecir las palabras circundantes. Usando el mismo ejemplo, si la palabra objetivo es jugando, el modelo intentaría predecir que las palabras en su entorno son El, perro, está y jardín.

La idea clave es que Word2Vec entrena el modelo para capturar la proximidad semántica a través de muchas iteraciones en un gran corpus de texto. Las palabras que tienden a aparecer juntas tienen vectores más cercanos, mientras que las que no están relacionadas aparecen más distantes.

2. GloVe: enfoque basado en estadísticas globales

GloVe, desarrollado en la Universidad de Stanford, se diferencia de Word2Vec al utilizar estadísticas globales de co-ocurrencia de palabras en un corpus. En lugar de considerar solo el contexto inmediato, GloVe se basa en la frecuencia con la que dos palabras aparecen juntas en todo el corpus.

Por ejemplo, si pan y mantequilla aparecen juntas con frecuencia, pero pan y planeta rara vez se encuentran en el mismo contexto, el modelo ajusta los vectores de manera que pan y mantequilla estén cerca en el espacio vectorial.

Esto permite que GloVe capture relaciones globales más amplias entre palabras y que las representaciones sean más robustas a nivel semántico. Los modelos entrenados con GloVe tienden a funcionar bien en tareas de analogía y similitud de palabras.

3. FastText: captura de sub-palabras

FastText, desarrollado por Facebook, mejora a Word2Vec al introducir la idea de descomponer las palabras en sub-palabras. En lugar de tratar cada palabra como una unidad indivisible, FastText representa cada palabra como una suma de n-gramas. Por ejemplo, la palabra jugando se podría descomponer en ju, uga, ando, etc.

Esto permite que FastText capture similitudes incluso entre palabras que no aparecieron explícitamente en el corpus de entrenamiento, como variaciones morfológicas (jugando, jugar, jugador). Esto es particularmente útil para lenguajes con muchas variaciones gramaticales.

4. Embeddings contextuales: captura de sentido dinámico

Modelos como BERT y ELMo representan un avance significativo en word embeddings. A diferencia de las estrategias anteriores, que generan un único vector para cada palabra independientemente del contexto, los embeddings contextuales generan diferentes vectores para una misma palabra según su uso en la frase.

Por ejemplo, la palabra banco tendrá un vector diferente en la frase "me senté en el banco del parque" que en "el banco aprobó mi solicitud de crédito". Esta variabilidad se logra entrenando el modelo en grandes corpus de texto de manera bidireccional, es decir, considerando no solo las palabras que preceden a la palabra objetivo, sino también las que la siguen.

Aplicaciones prácticas de los word embeddings

Los word embeddings se utilizan en una variedad de aplicaciones de procesamiento de lenguaje natural, como:

- Reconocimiento de Entidades Nombradas (NER, por sus siglas en inglés): permiten identificar y clasificar nombres de personas, organizaciones y lugares en un texto. Por ejemplo, en la frase "Apple anunció su nueva sede en Cupertino", los word embeddings permiten al modelo entender que Apple es una organización y Cupertino es un lugar.

- Traducción automática: ayudan a representar palabras de una manera independiente del idioma. Al entrenar un modelo con textos en diferentes lenguas, se pueden generar representaciones que capturan el significado subyacente de las palabras, facilitando la traducción de frases completas con un mayor nivel de precisión semántica.

- Sistemas de recuperación de información: en motores de búsqueda y sistemas de recomendación, los word embeddings mejoran la coincidencia entre las consultas de los usuarios y los documentos relevantes. Al capturar similitudes semánticas, permiten que incluso consultas no exactas se correspondan con resultados útiles. Por ejemplo, si un usuario busca "medicamento para el dolor de cabeza", el sistema puede sugerir resultados relacionados con analgésicos gracias a las similitudes capturadas en los vectores.

- Sistemas de preguntas y respuestas: los word embeddings son esenciales en sistemas como los chatbots y asistentes virtuales, donde ayudan a entender la intención detrás de las preguntas y a encontrar respuestas relevantes. Por ejemplo, ante la pregunta “¿Cuál es la capital de Italia?”, los word embeddings permiten que el sistema entienda las relaciones entre capital e Italia y encuentre Roma como respuesta.

- Análisis de sentimiento: los word embeddings se utilizan en modelos que determinan si el sentimiento expresado en un texto es positivo, negativo o neutral. Al analizar las relaciones entre palabras en diferentes contextos, el modelo puede identificar patrones de uso que indican ciertos sentimientos, como alegría, tristeza o enfado.

- Agrupación semántica y detección de similaridades: los word embeddings también permiten medir la similitud semántica entre documentos, frases o palabras. Esto se utiliza para tareas como agrupar artículos relacionados, recomendar productos basados en descripciones de texto o incluso detectar duplicados y contenido similar en grandes bases de datos.

Conclusión

Los word embeddings han transformado el campo del procesamiento de lenguaje natural al ofrecer representaciones densas y significativas de las palabras, capaces de capturar sus relaciones semánticas y contextuales. Con la aparición de embeddings contextuales, el potencial de estas representaciones sigue creciendo, permitiendo que las máquinas comprendan incluso las sutilezas y ambigüedades del lenguaje humano. Desde aplicaciones en sistemas de traducción y búsqueda, hasta chatbots y análisis de sentimiento, los word embeddings seguirán siendo una herramienta fundamental para el desarrollo de tecnologías cada vez más avanzadas y humanizadas en el campo del lenguaje natural.

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los próximos días 11, 12 y 13 de noviembre se celebra en Granada una nueva edición de DATAfórum Justicia. La cita reunirá a más de 100 ponentes para debatir sobre temas relacionados con los sistemas digitales de justicia, la inteligencia artificial (IA) y el uso del dato en el ecosistema judicial.

El evento está organizado por el Ministerio de Presidencia, Justicia y Relaciones con las Cortes, con la colaboración de la Universidad de Granada, la Junta de Andalucía, el Ayuntamiento de Granada y la entidad Formación y Gestión de Granada.

A continuación, se resumen algunos de los aspectos más importantes de estas jornadas.

Una cita dirigida a un público amplio

Este foro anual está dirigido tanto a profesionales del sector público, como del privado, sin dejar de lado al público general, que quiera saber más sobre la transformación digital de la justicia en nuestro país.

El DATAfórum Justicia 2024 cuenta, además, con un itinerario específico dirigido a estudiantes, cuyo objetivo es proporcionar a los jóvenes herramientas y conocimientos de valor en el ámbito de la justicia y la tecnología. Para ello, contarán con ponencias específicas y se pondrá en marcha un DATAthon. Estas actividades están especialmente dirigidas a estudiantes de derecho, ciencias sociales en general, ingenierías informáticas o materias relacionadas con la transformación digital. Los asistentes podrán obtener hasta 2 créditos ECTS (European Credit Transfer and Accumulation System o, en español, Sistema Europeo de Transferencia y Acumulación de Créditos): uno por asistir a las jornadas y otro por participar en el DATAthon.

Los datos, protagonistas de la agenda

El Paraninfo de la Universidad de Granada acogerá a expertos provenientes de la administración, instituciones y empresas privadas, que contarán su experiencia haciendo hincapié en las nuevas tendencias del sector, los retos que hay por delante y las oportunidades de mejora.

Las jornadas comenzarán el lunes 11 de noviembre a las 9:00 horas, con la bienvenida a los alumnos y la presentación del DATAthon. La inauguración oficial, dirigida a todas las audiencias, será a las 11:35 horas y correrá a cargo de Manuel Olmedo Palacios, Secretario de Estado de Justicia, y Pedro Mercado Pacheco, Rector de la Universidad de Granada.

A partir de entonces se sucederán diversas charlas, debates, entrevistas, mesas redondas y conferencias, entre las que encontramos un gran número de temáticas relacionadas con los datos. Entre otras cuestiones, se profundizará en la gestión del dato, tanto en administraciones como en empresas. También se abordará el uso de los datos abiertos para prevenir desde bulos hasta suicidios o la violencia sexual.

Otro tema con gran protagonismo será las posibilidades de la inteligencia artificial para optimizar el sector, tocando aspectos como la automatización de la justicia, la realización de predicciones. Se incluirán ponencias de casos de uso concretos, como la utilización de IA para la identificación de personas fallecidas, sin dejar de lado cuestiones como la gobernanza de algoritmos.

El evento finalizará el miércoles 13 a las 17:00 horas con la clausura oficial. En esta ocasión, Félix Bolaños, Ministro de la Presidencia, Justicia y Relaciones con las Cortes, acompañará al Rector de la Universidad de Granada.

Puedes ver la agenda completa aquí.

Un Datathon para resolver los retos del sector a través de los datos

En paralelo a esta agenda, se celebrará un DATAthon en el que los participantes presentarán ideas y proyectos innovadores para mejorar la justicia en nuestra sociedad. Se trata de un concurso destinado a estudiantes, profesionales del ámbito legal e informático, grupos de investigación y startups.

Los participantes se dividirán en equipos multidisciplinares para proponer soluciones a una serie de retos, planteados por la organización, utilizando tecnologías orientadas a la ciencia de datos. Durante las dos primeras jornadas los participantes dispondrán de tiempo para investigar y desarrollar su solución original. En la tercera jornada, deberán presentar una propuesta a un jurado cualificado. Los premios se entregarán el último día, antes de la clausura y del vino español y concierto que darán final a la edición 2024 del DATAfórum Justicia.

En la edición de 2023 participaron 35 personas, divididas en 6 equipos que resolvieron dos casos prácticos con datos de carácter público y se otorgaron dos premios de 1.000 euros.

Cómo inscribirse

El plazo de inscripción al DATAfórum Justicia 2024 ya está abierto. Debe realizarse a través de la web del evento, indicando si se trata de público general, personal de la administración pública, profesionales del sector privado o medios de comunicación.

Para participar en el DATAthon es necesario registrarse también en el site dedicado al concurso.

La edición del año pasado, centrada en propuestas para aumentar la eficiencia y transparencia en los sistemas judiciales, fue un gran éxito, con más de 800 inscritos. Este año se espera también una gran afluencia de público, así que te animamos a reservar tu plaza lo antes posible. Se trata de una gran oportunidad para conocer de primera mano experiencias exitosas y poder intercambiar opiniones con expertos en el sector.

Un gemelo digital es una representación virtual e interactiva de un objeto, sistema o proceso del mundo real. Hablamos, por ejemplo, de una réplica digital de una fábrica, una ciudad o incluso un cuerpo humano. Estos modelos virtuales permiten simular, analizar y predecir el comportamiento del elemento original, lo que es clave para la optimización y el mantenimiento en tiempo real.

Debido a sus funcionalidades, los gemelos digitales se están utilizando en diversos sectores como la salud, el transporte o la agricultura. En este artículo, repasamos las ventajas que aporta su uso y mostramos dos ejemplos relacionados con los datos abiertos.

Ventajas de los gemelos digitales

Los gemelos digitales utilizan fuentes de datos reales del entorno, obtenidos a través de sensores y plataformas abiertas, entre otros. Gracias a ello, los gemelos digitales se actualizan en tiempo real para reflejar la realidad, lo que aporta una serie de ventajas:

- Aumento del rendimiento: una de las principales diferencias con las simulaciones tradicionales es que los gemelos digitales utilizan datos en tiempo real para su modelización, lo que permite tomar decisiones más acertadas para optimizar el rendimiento de equipos y sistemas según las necesidades de cada momento.

- Mejora de la planificación: utilizando tecnologías basadas en inteligencia artificial (IA) y aprendizaje automático, el gemelo digital puede analizar problemas de rendimiento o realizar simulaciones virtuales de «qué pasaría si». De esta forma, se pueden predecir fallos y problemas antes de que ocurran, lo que permite un mantenimiento proactivo.

- Reducción de costes: la mejora en la gestión de datos gracias a un gemelo digital genera beneficios equivalentes al 25% del gasto total en infraestructuras. Además, al evitar fallos costosos y optimizar procesos, se pueden reducir significativamente los costes operativos. También permiten monitorear y controlar sistemas en remoto, desde cualquier lugar, mejorando la eficiencia al centralizar las operaciones.

- Personalización y flexibilidad: al crear modelos virtuales detallados de productos o procesos, las organizaciones pueden adaptar rápidamente sus operaciones para satisfacer las demandas cambiantes del entorno y las preferencias individuales de los clientes / ciudadanos. Por ejemplo, en la fabricación, los gemelos digitales permiten la producción personalizada en masa, ajustando las líneas de producción en tiempo real para crear productos únicos según las especificaciones del cliente. Por otro lado, en el ámbito de la salud, los gemelos digitales pueden modelar el cuerpo humano para personalizar tratamientos médicos, mejorando así la eficacia y reduciendo los efectos secundarios.

- Impulso de la experimentación e innovación: los gemelos digitales proporcionan un entorno seguro y controlado para probar nuevas ideas y soluciones, sin los riesgos y costes asociados a los experimentos físicos. Entre otras cuestiones, permiten experimentar con grandes objetos o proyectos que, por su tamaño, no suelen prestarse a la experimentación en la vida real.

- Mejora de la sostenibilidad: al permitir la simulación y el análisis detallado de procesos y sistemas, las organizaciones pueden identificar áreas de ineficiencia y desperdicio, optimizando así el uso de recursos. Por ejemplo, los gemelos digitales pueden modelar el consumo y la producción de energía en tiempo real, permitiendo ajustes precisos que reducen el consumo y las emisiones de carbono.

Ejemplos de gemelos digitales en España

A continuación, se muestran tres ejemplos que ponen de manifiesto estas ventajas.

Proyecto GeDIA: inteligencia artificial para predecir los cambios en los territorios

GeDIA es una herramienta para la planificación estratégica de ciudades inteligentes, que permite realiza simulaciones de escenarios. Para ellos utiliza modelos de inteligencia artificial basados en fuentes de datos y herramientas ya existentes en el territorio.

El alcance de la herramienta es muy amplio, pero sus creadores destacan dos casos de uso:

- Necesidades de infraestructuras futuras: la plataforma realiza análisis detallados considerando las tendencias, gracias a los modelos de inteligencia artificial. De esta forma, se pueden realizar proyecciones de crecimiento y planificar las necesidades de infraestructuras y servicios, como energía y agua, en áreas específicas de un territorio, garantizando su disponibilidad.

- Crecimiento y turismo: GeDIA también se utiliza para estudiar y analizar el crecimiento urbano y turístico en zonas concretas. La herramienta identifica patrones de gentrificación y evalúa su impacto en la población local, utilizando datos censales. De esta forma se pueden comprender mejor los cambios demográficos y su impacto, como las necesidades de vivienda, y tomar decisiones que faciliten el crecimiento equitativo y sostenible.

Esta iniciativa cuenta con la participación de diversas empresas y la Universidad de Málaga (UMA), así como el respaldo económico de Red.es y la Unión Europea.

Gemelo digital del Mar menor: datos para cuidar el medio ambiente

El Mar Menor, la laguna salada de la Región de Murcia, ha sufrido graves problemas ecológicos en los últimos años, influenciados por la presión agrícola, el turismo y la urbanización.

Para conocer mejor las causas y valorar posibles soluciones, TRAGSATEC, una entidad de protección ambiental de propiedad estatal, desarrolló un gemelo digital. Para ello mapeó un área circundante de más de 1.600 kilómetros cuadrados, conocida como la Región del Campo de Cartagena. En total se obtuvieron 51.000 imágenes nadirales, 200.000 imágenes oblicuas y más de cuatro terabytes de datos LiDAR.

Gracias a este gemelo digital, TRAGSATEC ha podido simular diversos escenarios de inundaciones y el impacto que tendría instalar elementos de contención u obstáculos, como un muro, que redirigieran el flujo del agua. También han podido estudiar la distancia entre el terreno y el agua subterránea, para determinar el impacto de la filtración de fertilizantes, entre otras cuestiones.

Retos y camino hacia el futuro

Estos son solo dos ejemplos, pero ponen de manifiesto el potencial de una tecnología cada vez más popular. No obstante, para que su implementación sea aun mayor es necesario hacer frente a algunos retos, como los costes iniciales, tanto en tecnología como en capacitación, o la seguridad, al aumentar la superficie de ataque. Otro de los retos a destacar son los problemas de interoperabilidad que surgen cuando las distintas administraciones públicas establecen gemelos digitales y espacios de datos locales. Para profundizar en esta problemática, la Comisión Europea ha publicado una guía que ayuda a identificar los principales retos organizativos y culturales de interoperabilidad, ofreciendo buenas prácticas para solventarlos.

En resumen, los gemelos digitales ofrecen numerosas ventajas, como la mejora del rendimiento o la reducción de costes. Estos beneficios están impulsando su adopción en diversas industrias y es probable que, a medida que se superen los retos actuales, los gemelos digitales se conviertan en una herramienta esencial para optimizar procesos y mejorar la eficiencia operativa en un mundo cada vez más digitalizado.

Casi la mitad de los adultos europeos carecen de competencias digitales básicas. De acuerdo con el último informe sobre el estado de la Década Digital, en 2023, solo el 55,6% de los ciudadanos declararon tener este tipo de capacidades. Este porcentaje crece al 66,2% en el caso de España, situado por delante de la media europea.

Tener capacidades digitales básicas es esencial en la sociedad actual, porque permite acceder a una mayor cantidad de información y servicios, así como comunicarse de manera efectiva en entornos online, facilitando una mayor participación en actividades cívicas y sociales. Y también supone una gran ventaja competitiva en el mundo laboral.

En Europa, más del 90% de las funciones profesionales requieren un nivel básico de conocimientos digitales. Hace mucho tiempo que el conocimiento tecnológico dejó de ser únicamente necesario para profesiones técnicas, sino que se está extendiendo a todos los sectores, desde las empresas hasta el transporte e incluso la agricultura. En este sentido, más del 70% de las empresas han afirmado que la falta de personal con las competencias digitales adecuadas es un obstáculo para la inversión.

Por ello, un objetivo clave de la Década Digital es garantizar que al menos el 80% de las personas de entre 16 y 74 años posean al menos competencias digitales básicas de aquí a 2030

Capacidades tecnológicas básicas que todos deberíamos tener

Cuando hablamos de capacidades tecnológicas básicas nos referimos, de acuerdo con el framework DigComp, a diversas áreas, entre las que se encuentran:

- Alfabetización informacional y de datos: incluye localizar, recuperar, gestionar y organizar datos, juzgando la pertinencia de la fuente y su contenido.

- Comunicación y colaboración: supone interactuar, comunicarse y colaborar a través de las tecnologías digitales teniendo en cuenta la diversidad cultural y generacional. También incluye la gestión de la propia presencia, identidad y reputación digitales.

- Creación de contenidos digitales: se definiría como la mejora e integración de información y contenidos para generar nuevos mensajes, respetando los derechos de autor y las licencias. También implica saber dar instrucciones comprensibles para un sistema informático.

- Seguridad: se circunscribe a la protección de dispositivos, contenidos, datos personales y la intimidad en los entornos digitales, para proteger la salud física y mental.

- Resolución de problemas: permite identificar y resolver necesidades y problemas en entornos digitales. También se enfoca en el uso de herramientas digitales para innovar procesos y productos, manteniéndose al día de la evolución digital.

¿Qué puestos de trabajo relacionados con datos son los más demandados?

Una vez que tenemos claro cuáles son las competencias básicas, cabe destacar que en un mundo donde cada vez cobra más importancia la digitalización no es de extrañar que también crezca la demanda de conocimientos tecnológicos avanzados y relacionados con los datos.

De acuerdo con los datos de la plataforma de empleo LinkedIn, entre las 25 profesiones que más crecen en España en 2024 encontramos analistas de seguridad (puesto 1), analistas de desarrollo de software (2), ingenieros de datos (11) e ingenieros de inteligencia artificial (25). Datos similares ofrece el Mapa del Empleo de Fundación Telefónica, que además destaca cuatro de los perfiles más demandados relacionados con los datos:

- Analista de datos: encargados de la gestión y aprovechamiento de la información, se dedican a la recopilación, análisis y explotación de los datos, para lo cual suelen recurrir a la creación de cuadros de mando e informes.

- Diseñador/a o administrador/a de bases de datos: enfocados en diseñar, implementar y gestionar bases de datos. Así como mantener su seguridad, ejecutando procedimientos de respaldo y recuperación de datos en caso de fallos.

- Ingeniero/a de datos: responsables del diseño e implementación de arquitecturas de datos e infraestructuras para captar, almacenar, procesar y acceder a los datos, optimizando su rendimiento y garantizando su seguridad.

- Científico/a de datos: centrado en el análisis de datos y modelado predictivo, la optimización de algoritmos y la comunicación de resultados.

Todos ellos son puestos con buenos salarios y expectativas de futuro, en los que sin embargo sigue existiendo una gran brecha entre hombres y mujeres. De acuerdo con datos europeos, sólo 1 de cada 6 especialistas en TIC y 1 de cada 3 licenciados en ciencias, tecnología, ingeniería y matemáticas (STEM) son mujeres.

Para desarrollar profesiones relacionadas con los datos, se necesitan, entre otros, conocimientos de lenguajes de programación populares como Python, R o SQL, y múltiples herramientas de procesado y visualización de datos, como las detalladas en estos artículos:

- Herramientas de depuración y conversión de datos

- Herramientas de análisis de datos

- Herramientas de visualización de datos

- Librerías y APIs de visualización de datos

- Herramientas de visualización geoespacial

- Herramientas de análisis de redes

Actualmente la oferta de formaciones sobre todas estas capacidades no deja de crecer.

Perspectivas de futuro

Casi una cuarta parte de todos los puestos de trabajo (23%) cambiarán en los próximos cinco años, de acuerdo con el Informe sobre el Futuro del Empleo 2023 del Foro Económico Mundial. Los avances tecnológicos crearán nuevos empleos, transformarán los existentes y destruirán aquellos que se queden anticuados. Los conocimientos técnicos, relacionados con áreas como la inteligencia artificial o el Big Data, y el desarrollo de habilidades cognitivas, como el pensamiento analítico, supondrán grandes ventajas competitivas en el mercado laboral del futuro. En este contexto, las iniciativas políticas para impulsar la recapacitación de la sociedad, como el Plan europeo de Acción de Educación Digital (2021-2027), ayudaran a generar marcos y certificados comunes en un mundo en constante evolución.

La revolución tecnológica ha venido para quedarse y continuará cambiando nuestro mundo. Por ello, quienes antes empiecen a adquirir nuevas capacidades, tendrán una posición más ventajosa en el panorama laboral futuro.

La alfabetización en datos se ha convertido en un asunto crucial en la era digital. Este concepto se refiere a la capacidad de las personas para comprender el uso que se hace de los datos, así como para acceder a ellos, crearlos, analizarlos, utilizarlos o reutilizarlos, y comunicarlos.

Vivimos en un mundo donde los datos y los algoritmos influyen en decisiones cotidianas y en las oportunidades que tiene la gente para vivir bien. Su efecto se puede sentir en áreas que incluyen desde la publicidad y la oferta de empleo, hasta la justicia penal y las ayudas sociales. Por ello es fundamental comprender cómo se generan y utilizan los datos.

La alfabetización en datos puede implicar muchas áreas, pero nos vamos a centrar en su relación con los derechos digitales por una parte y la Inteligencia artificial (IA) por otro. Este artículo propone explorar la importancia de la alfabetización en datos para la ciudadanía, abordando sus implicaciones en la protección de los derechos individuales y colectivos y la promoción de una sociedad más informada y crítica en un contexto tecnológico donde la inteligencia artificial cobra cada vez más importancia.

El contexto de los derechos digitales

Cada vez hay más estudios que indican que una participación efectiva en la sociedad actual –impulsada por los datos y presidida por algoritmos— requiere de una alfabetización en datos. Los derechos civiles se traducen cada vez más en derechos digitales a medida que nuestra sociedad se vuelve más dependiente de las tecnologías y entornos digitales. Esta transformación se manifiesta de varias maneras:

- Por un lado, los derechos reconocidos en constituciones y declaraciones de derechos humanos se están adaptando explícitamente al contexto digital. Por ejemplo, la libertad de expresión ahora incluye la libertad de expresión en línea, y el derecho a la privacidad se extiende a la protección de datos personales en entornos digitales. Además, algunos derechos civiles tradicionales se están reinterpretando en el contexto digital. Una muestra de ello es el derecho a la igualdad y no discriminación, que ahora incluye la protección contra la discriminación algorítmica y contra los sesgos en sistemas de inteligencia artificial. Otro ejemplo es el derecho a la educación, que se extiende ahora también al derecho a la educación digital. La importancia de las habilidades digitales en la sociedad se reconoce en varios marcos legales y documentos, tanto a nivel nacional como internacional, como por ejemplo la Ley Orgánica 3/2018 de Protección de Datos Personales y garantía de los derechos digitales (LOPDGDD), en España. Por último, el derecho de acceso a Internet se está considerando cada vez más como un derecho fundamental, similar al acceso a otros servicios básicos.

- Por otro lado, están surgiendo derechos que abordan desafíos únicos del mundo digital, como el derecho al olvido (vigente en la Unión Europea y algunos otros países que han adoptado legislaciones similares1), que permite a las personas solicitar la eliminación de la información personal disponible en línea, bajo ciertas condiciones. Otro ejemplo puede ser el derecho a la desconexión digital (en vigor en varios países, principalmente en Europa2), que garantiza que los y las trabajadoras puedan desconectarse de dispositivos y comunicaciones laborales fuera del horario de trabajo. De la misma forma, existe el derecho a la neutralidad de Internet para asegurar un acceso equitativo a los contenidos en línea sin discriminación por parte de los proveedores de servicios, un derecho que también este derecho está establecido en varios países y regiones, aunque su implementación y alcance pueden variar. La UE tiene regulaciones que protegen la neutralidad de la red, incluido el Reglamento 2015/2120, que establece normas para salvaguardar el acceso abierto a Internet. La Ley de Protección de Datos española contempla la obligación de los proveedores de Internet de proporcionar una oferta transparente de servicios sin discriminación por motivos técnicos o económicos. Además, el derecho de acceso a Internet –relacionado con la neutralidad de la red— está reconocido como un derecho humano por la Organización de las Naciones Unidas (ONU).

Esta transformación de los derechos refleja la creciente importancia de las tecnologías digitales en todos los aspectos de nuestras vidas.

El contexto de la inteligencia artificial

La relación entre el desarrollo de la IA y los datos es fundamental y simbiótica, ya que los datos sirven como base para el desarrollo de la IA de varias maneras:

- Se utilizan datos para entrenar algoritmos de IA, lo que les permite aprender, detectar patrones, hacer predicciones y mejorar su rendimiento con el tiempo.

- La calidad y la cantidad de datos afectan directamente la precisión y la confiabilidad de los sistemas de IA. En general, los conjuntos de datos más diversos y completos conducen a modelos de IA de mejor rendimiento.

- La disponibilidad de datos en varios dominios puede permitir el desarrollo de sistemas de IA para diferentes casos de uso.

Por ello, la alfabetización de datos se ha vuelto cada vez más crucial en la era de la IA, ya que forma la base para aprovechar y comprender de manera eficaz las tecnologías de IA.

Además, el auge de los macrodatos y de los algoritmos ha transformado los mecanismos de participación, presentando tanto desafíos como oportunidades. Los algoritmos, aunque puedan estar diseñados para ser justos, a menudo reflejan los prejuicios de sus creadores o de los datos con los que se entrenan. Esto puede llevar a decisiones que afectan negativamente a grupos vulnerables.

En este sentido, se están llevando a cabo esfuerzos desde el punto de vista legislativo y académico para evitar que esto ocurra. Por ejemplo, la Ley de Inteligencia Artificial (AI Act) europea incluye garantías para evitar sesgos perjudiciales en la toma de decisiones algorítmica. Por ejemplo, clasifica los sistemas de IA según su nivel de riesgo potencial e impone requisitos más estrictos a aquellos de alto riesgo. Además, se exige el uso de datos de alta calidad para entrenar los algoritmos, minimizando los sesgos, y establece mantener documentación detallada sobre el desarrollo y funcionamiento de los sistemas, permitiendo auditorías y evaluaciones con supervisión humana. Asimismo, esta ley refuerza los derechos de las personas afectadas por decisiones de la IA, incluido el derecho a impugnar las decisiones tomadas y su explicabilidad, permitiendo a las personas afectadas entender cómo se llegó a una decisión.

La importancia de la alfabetización digital en ambos contextos

La alfabetización de datos ayuda a la ciudadanía a tomar decisiones informadas y entender todas las implicaciones de sus derechos digitales, que también se consideran, en muchos aspectos, como se ha referido anteriormente, derechos civiles universales. En este contexto, la alfabetización de datos sirve como un filtro crítico para una plena participación cívica que permita a la ciudadanía influir en las decisiones políticas y sociales. Es decir, quienes tienen el acceso a los datos y las habilidades y herramientas para navegar por la infraestructura de datos de manera efectiva pueden intervenir e influir de manera significativa en los procesos políticos y sociales, algo que promueve la Open Government Partnership.

Por otro lado, la alfabetización en datos permite a la ciudadanía cuestionar y entender estos procesos, fomentando una cultura de responsabilidad y transparencia en el uso de la IA. Asimismo, existen barreras para participar en entornos impulsados por datos. Una de estas barreras es la brecha digital (es decir, la privación del acceso a infraestructuras, conectividad y formación, entre otras) y, de hecho, la falta de alfabetización en datos. Por tanto, esta última se presenta como un concepto crucial para superar los desafíos que plantea la datificación de las relaciones humanas y la plataformización de los contenidos y servicios.

Recomendaciones para implementar una sociedad preparada

Parte de la solución para abordar los desafíos que propone el desarrollo de la tecnología digital es incluir la alfabetización en datos en los currículos educativos desde una edad temprana.

Esto debería abarcar:

- Conceptos básicos de datos: comprensión de qué son los datos, cómo se recopilan y se utilizan.

- Análisis crítico: adquisición de las habilidades para evaluar la calidad y la fuente de los datos e identificar sesgos en la información presentada. Se busca reconocer los potenciales sesgos que los datos puedan contener y que se puedan producir en el procesamiento de dichos datos, además de impulsar la capacidad para actuar en favor de la apertura de datos y su uso para el bien común.

- Derechos y regulaciones: información sobre los derechos de protección de datos y cómo las leyes europeas afectan al uso de la IA. Este ámbito abarcaría toda regulación presente y futura que afecte al uso de los datos y su implicación en tecnología como la IA.

- Aplicaciones prácticas: la posibilidad de crear, usar y reusar datos abiertos disponibles en los portales habilitados por gobiernos y administraciones públicas, para generar así proyectos y oportunidades que permitan a las personas trabajar con datos reales, promoviendo un aprendizaje activo, contextualizado y continuo.

Al educar sobre el uso y la interpretación de los datos, se fomenta una sociedad más crítica y capaz de demandar responsabilidad en el uso de la IA. Las nuevas leyes de protección de datos en Europa ofrecen un marco que, junto con la educación, puede ayudar a mitigar los riesgos asociados con el abuso algorítmico y promover un uso ético de la tecnología. En una sociedad datificada, en la que los datos desempeñan un papel fundamental, existe la necesidad de fomentar la alfabetización de datos en la ciudadanía desde edad temprana.

1. El derecho al olvido se estableció por primera vez en mayo de 2014 a raíz de una resolución del Tribunal de Justicia de la Unión Europea. Posteriormente, en 2018, se reforzó con el Reglamento General de Protección de Datos (RGPD), que lo incluye explícitamente en su artículo 17 como "derecho de supresión". En julio de 2015, Rusia aprobó una ley que permite a los ciudadanos solicitar la eliminación de enlaces en los buscadores rusos si la información "infringe la legislación rusa o si es falsa o se ha quedado obsoleta". Turquía ha establecido su propia versión del derecho al olvido, siguiendo un modelo similar al de la UE. Serbia también ha implementado una versión del derecho al olvido en su legislación. En España, la Ley Orgánica de Protección de Datos Personales (LOPD) regula el derecho al olvido, especialmente en lo que respecta a ficheros de morosos. En Estados Unidos, el derecho al olvido se considera incompatible con la Constitución, principalmente debido a la fuerte protección de la libertad de expresión. Sin embargo, existen algunas regulaciones relacionadas, como la Fair Credit Reporting Act de 1970, que permite en ciertas situaciones la eliminación de información antigua o caduca en informes crediticios.

2. Algunos países en los que se ha establecido este derecho incluyen España, regulado por el artículo 88 de la Ley Orgánica 3/2018 de Protección de Datos Personales; Francia, que, en 2017, se convirtió en el primer país en aprobar una ley sobre el derecho a la desconexión digital; Alemania, incluido en la Ley de Horarios de Trabajo y de Descanso (Arbeitszeitgesetz); Italia, dentro de la Ley 81/201, y Bélgica. Fuera de Europa, está, por ejemplo, en Chile.

Contenido elaborado por Miren Gutiérrez, Doctora e investigadora en la Universidad de Deusto, experta en activismo de datos, justicia de datos, alfabetización de datos y desinformación de género. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor

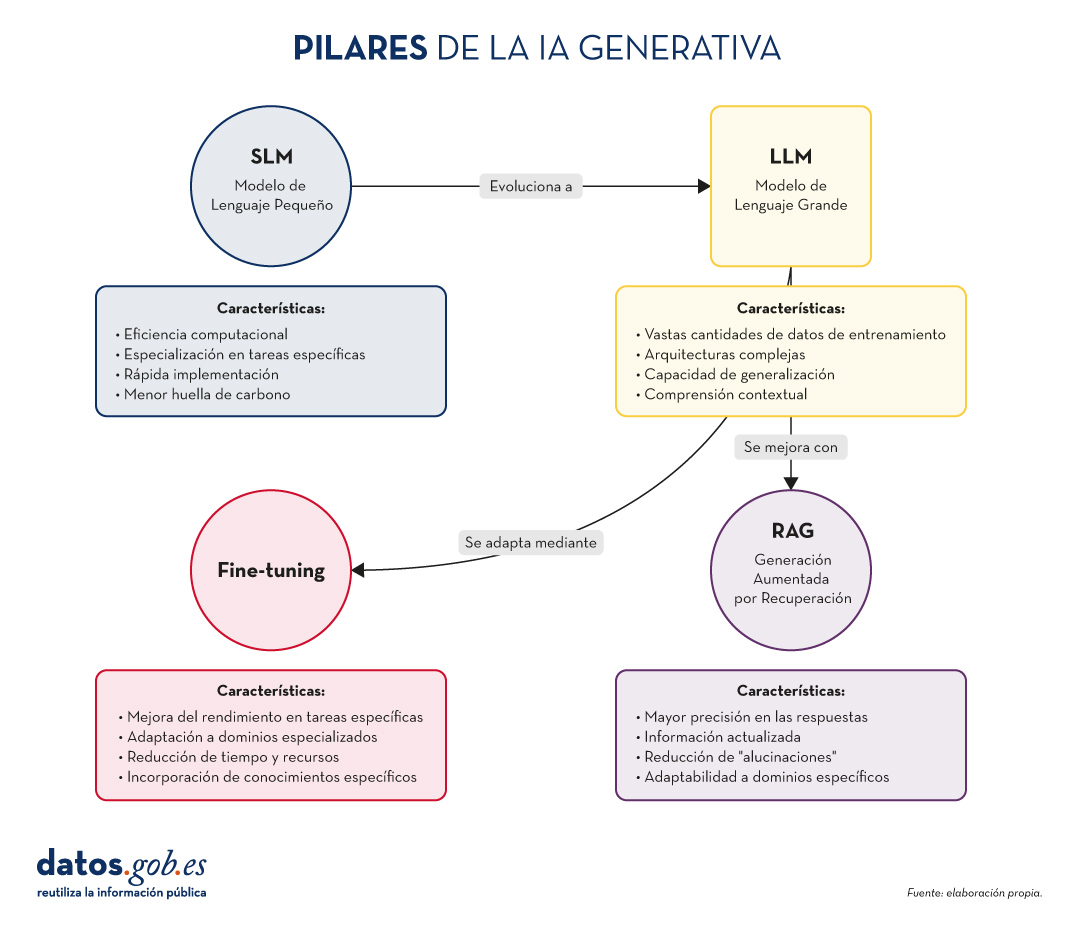

En el vertiginoso mundo de la Inteligencia Artificial (IA) Generativa, encontramos diversos conceptos que se han convertido en fundamentales para comprender y aprovechar el potencial de esta tecnología. Hoy nos centramos en cuatro: los Modelos de Lenguaje Pequeños (SLM, por sus siglas en inglés), los Modelos de Lenguaje Grandes (LLM), la Generación Aumentada por Recuperación (RAG) y el Fine-tuning. En este artículo, exploraremos cada uno de estos términos, sus interrelaciones y cómo están moldeando el futuro de la IA generativa.

Empecemos por el principio. Definiciones.

Antes de sumergirnos en los detalles, es importante entender brevemente qué representa cada uno de estos términos. Los dos primeros conceptos (SLM y LLM) que abordamos, son lo que se conoce cómo modelos del lenguaje. Un modelo de lenguaje es un sistema de inteligencia artificial que entiende y genera texto en lenguaje humano, como lo hacen los chatbots o los asistentes virtuales. Los siguientes dos conceptos (Fine Tuning y RAG), podríamos definirlos cómo técnicas de optimización de estos modelos del lenguaje previos. En definitiva, estás técnicas, con sus respectivos enfoques, que veremos más adelante, mejoran las respuestas y el contenido que devuelven al que pregunta. Vamos a por los detalles:

- SLM (Small Language Models): Modelos de lenguaje más compactos y especializados, diseñados para tareas específicas o dominios concretos.

- LLM (Large Language Models): Modelos de lenguaje de gran escala, entrenados con vastas cantidades de datos y capaces de realizar una amplia gama de tareas lingüísticas.

- RAG (Retrieval-Augmented Generation): Una técnica que combina la recuperación de información relevante con la generación de texto para producir respuestas más precisas y contextualizadas.

- Fine-tuning: El proceso de ajustar un modelo pre-entrenado para una tarea o dominio específico, mejorando su rendimiento en aplicaciones concretas.

Ahora, profundicemos en cada concepto y exploremos cómo se interrelacionan en el ecosistema de la IA Generativa.

Figura 1. Pilares de la IA genrativa. Elaboración propia.

SLM: La potencia en la especialización

Mayor eficiencia para tareas concretas

Los Modelos de Lenguaje Pequeños (SLM) son modelos de IA diseñados para ser más ligeros y eficientes que sus contrapartes más grandes. Aunque tienen menos parámetros, están optimizados para tareas específicas o dominios concretos.

Características clave de los SLM:

- Eficiencia computacional: requieren menos recursos para su entrenamiento y ejecución.

- Especialización: se centran en tareas o dominios específicos, logrando un alto rendimiento en áreas concretas.

- Rápida implementación: ideal para dispositivos con recursos limitados o aplicaciones que requieren respuestas en tiempo real.

- Menor huella de carbono: al ser más pequeños, su entrenamiento y uso consumen menos energía.

Aplicaciones de los SLM:

- Asistentes virtuales para tareas específicas (por ejemplo, reserva de citas).

- Sistemas de recomendación personalizados.

- Análisis de sentimientos en redes sociales.

- Traducción automática para pares de idiomas específicos.

LLM: El poder de la generalización

La revolución de los Modelos de Lenguaje Grandes

Los LLM han transformado el panorama de la IA Generativa, ofreciendo capacidades sorprendentes en una amplia gama de tareas lingüísticas.

Características clave de los LLM:

- Vastas cantidades de datos de entrenamiento: se entrenan con enormes corpus de texto, abarcando diversos temas y estilos.

- Arquitecturas complejas: utilizan arquitecturas avanzadas, como Transformers, con miles de millones de parámetros.

- Capacidad de generalización: pueden abordar una amplia variedad de tareas sin necesidad de entrenamiento específico para cada una.

- Comprensión contextual: son capaces de entender y generar texto considerando contextos complejos.

Aplicaciones de los LLM:

- Generación de texto creativo (historias, poesía, guiones).

- Respuesta a preguntas complejas y razonamientos.

- Análisis y resumen de documentos extensos.

- Traducción multilingüe avanzada.

RAG: Potenciando la precisión y relevancia

La sinergia entre recuperación y generación

Como ya exploramos en nuestro artículo anterior, RAG combina la potencia de los modelos de recuperación de información con la capacidad generativa de los LLM. Sus aspectos fundamentales son:

Características clave de RAG:

- Mayor precisión en las respuestas.

- Capacidad de proporcionar información actualizada.

- Reducción de "alucinaciones" o información incorrecta.

- Adaptabilidad a dominios específicos sin necesidad de reentrenar completamente el modelo.

Aplicaciones de RAG:

- Sistemas de atención al cliente avanzados.

- Asistentes de investigación académica.

- Herramientas de fact-checking para periodismo.

- Sistemas de diagnóstico médico asistido por IA.

Fine-tuning: Adaptación y especialización

Perfeccionando modelos para tareas específicas

El fine-tuning es el proceso de ajustar un modelo pre-entrenado (generalmente un LLM) para mejorar su rendimiento en una tarea o dominio específico. Sus elementos principales son los siguientes:

Características clave del fine-tuning:

- Mejora significativa del rendimiento en tareas específicas.

- Adaptación a dominios especializados o nichos.

- Reducción del tiempo y recursos necesarios en comparación con el entrenamiento desde cero.

- Posibilidad de incorporar conocimientos específicos de la organización o industria.

Aplicaciones del fine-tuning:

- Modelos de lenguaje específicos para industrias (legal, médica, financiera).

- Asistentes virtuales personalizados para empresas.

- Sistemas de generación de contenido adaptados a estilos o marcas particulares.

- Herramientas de análisis de datos especializadas.

Pongamos algunos ejemplos

A muchos de los que estéis familiarizados con las últimas noticias en IA generativa os sonarán estos ejemplos que citamos a continuación.

SLM: La potencia en la especialización

Ejemplo: BERT para análisis de sentimientos

BERT (Bidirectional Encoder Representations from Transformers) es un ejemplo de SLM cuando se utiliza para tareas específicas. Aunque BERT en sí es un modelo de lenguaje grande, versiones más pequeñas y especializadas de BERT se han desarrollado para análisis de sentimientos en redes sociales.

Por ejemplo, DistilBERT, una versión reducida de BERT, se ha utilizado para crear modelos de análisis de sentimientos en X (Twitter). Estos modelos pueden clasificar rápidamente tweets como positivos, negativos o neutros, siendo mucho más eficientes en términos de recursos computacionales que modelos más grandes.

LLM: El poder de la generalización

Ejemplo: GPT-3 de OpenAI

GPT-3 (Generative Pre-trained Transformer 3) es uno de los LLM más conocidos y utilizados. Con 175 mil millones de parámetros, GPT-3 es capaz de realizar una amplia variedad de tareas de procesamiento de lenguaje natural sin necesidad de un entrenamiento específico para cada tarea.

Una aplicación práctica y conocida de GPT-3 es ChatGPT, el chatbot conversacional de OpenAI. ChatGPT puede mantener conversaciones sobre una gran variedad de temas, responder preguntas, ayudar con tareas de escritura y programación, e incluso generar contenido creativo, todo ello utilizando el mismo modelo base.

Ya a finales de 2020 introducimos en este espacio el primer post sobre GPT-3 como gran modelo del lenguaje. Para los más nostálgicos, podéis consultar el post original aquí.

RAG: Potenciando la precisión y relevancia

Ejemplo: El asistente virtual de Anthropic, Claude

Claude, el asistente virtual desarrollado por Anthropic, es un ejemplo de aplicación que utiliza técnicas RAG. Aunque los detalles exactos de su implementación no son públicos, Claude es conocido por su capacidad para proporcionar respuestas precisas y actualizadas, incluso sobre eventos recientes.

De hecho, la mayoría de asistentes conversacionales basados en IA generativa incorporan técnicas RAG para mejorar la precisión y el contexto de sus respuestas. Así, ChatGPT, la citada Claude, MS Bing y otras similares usan RAG.

Fine-tuning: Adaptación y especialización

Ejemplo: GPT-3 fine-tuned para GitHub Copilot

GitHub Copilot, el asistente de programación de GitHub y OpenAI, es un excelente ejemplo de fine-tuning aplicado a un LLM. Copilot está basado en un modelo GPT (posiblemente una variante de GPT-3) que ha sido específicamente ajustado (fine-tuned) para tareas de programación.

El modelo base se entrenó adicionalmente con una gran cantidad de código fuente de repositorios públicos de GitHub, lo que le permite generar sugerencias de código relevantes y sintácticamente correctas en una variedad de lenguajes de programación. Este es un claro ejemplo de cómo el fine-tuning puede adaptar un modelo de propósito general a una tarea altamente especializada.

Otro ejemplo: en el blog de datos.gob.es, también escribimos un post sobre aplicaciones que utilizaban GPT-3 como LLM base para construir productos concretos ajustados específicamente.

Interrelaciones y sinergias

Estos cuatro conceptos no operan de forma aislada, sino que se entrelazan y complementan en el ecosistema de la IA Generativa:

- SLM y LLM: Mientras que los LLM ofrecen versatilidad y capacidad de generalización, los SLM proporcionan eficiencia y especialización. La elección entre uno u otro dependerá de las necesidades específicas del proyecto y los recursos disponibles.

- RAG y LLM: RAG potencia las capacidades de los LLM al proporcionarles acceso a información actualizada y relevante. Esto mejora la precisión y utilidad de las respuestas generadas.

- Fine-tuning y LLM: El fine-tuning permite adaptar LLM genéricos a tareas o dominios específicos, combinando la potencia de los modelos grandes con la especialización necesaria para ciertas aplicaciones.

- RAG y Fine-tuning: Estas técnicas pueden combinarse para crear sistemas altamente especializados y precisos. Por ejemplo, un LLM con fine-tuning para un dominio específico puede utilizarse como componente generativo en un sistema RAG.

- SLM y Fine-tuning: El fine-tuning también puede aplicarse a SLM para mejorar aún más su rendimiento en tareas específicas, creando modelos altamente eficientes y especializados.

Conclusiones y futuro de la IA

La combinación de estos cuatro pilares está abriendo nuevas posibilidades en el campo de la IA Generativa:

- Sistemas híbridos: combinación de SLM y LLM para diferentes aspectos de una misma aplicación, optimizando rendimiento y eficiencia.

- RAG avanzado: implementación de sistemas RAG más sofisticados que utilicen múltiples fuentes de información y técnicas de recuperación más avanzadas.

- Fine-tuning continuo: desarrollo de técnicas para el ajuste continuo de modelos en tiempo real, adaptándose a nuevos datos y necesidades.

- Personalización a escala: creación de modelos altamente personalizados para individuos o pequeños grupos, combinando fine-tuning y RAG.

- IA Generativa ética y responsable: implementación de estas técnicas con un enfoque en la transparencia, la verificabilidad y la reducción de sesgos.

SLM, LLM, RAG y Fine-tuning representan los pilares fundamentales sobre los que se está construyendo el futuro de la IA Generativa. Cada uno de estos conceptos aporta fortalezas únicas: