Los portales de datos abiertos contribuyen a que los municipios ofrezcan un acceso estructurado y transparente a los datos que generan en el ejercicio de sus funciones y en la prestación de los servicios de su competencia, fomentando además la creación de aplicaciones, servicios y soluciones que generan valor tanto para la ciudadanía y las empresas como para las propias administraciones públicas.

El informe tiene como propósito ofrecer una guía práctica para que las administraciones municipales puedan diseñar, desarrollar y mantener portales de datos abiertos eficaces, integrándolos en la estrategia global de ciudades inteligentes. El documento se estructura en varias secciones que abarcan desde la planificación estratégica hasta las recomendaciones técnicas y operativas necesarias para la creación y mantenimiento de portales de datos abiertos. Algunas de las claves principales son:

Principios fundamentales

El informe destaca la importancia de integrar los portales de datos abiertos en planes estratégicos municipales, alineando los objetivos del portal con las prioridades locales y las expectativas ciudadanas. También recomienda elaborar un Plan de medidas para el impulso de la apertura y reutilización de datos (Plan RISP), que incluya modelos de gobernanza, licencias claras, agenda de apertura de datos y acciones para estimular su reutilización. Finalmente, enfatiza la necesidad de contar con personal capacitado en ámbitos estratégicos, técnicos y funcionales, capaces de gestionar, mantener y promover la reutilización de datos abiertos.

Requisitos generales

En cuanto a los requisitos generales para garantizar el éxito del portal, se destaca la importancia de ofrecer datos de calidad, consistentes y actualizados en formatos abiertos como CSV y JSON, pero también en XLS, favoreciendo la interoperabilidad con plataformas nacionales e internacionales mediante estándares abiertos como DCAT-AP, y garantizando una accesibilidad efectiva del portal mediante un diseño intuitivo, inclusivo y adaptado a diferentes dispositivos. También se señala la obligación de cumplir estrictamente las normativas de privacidad y protección de datos, especialmente el Reglamento General de Protección de Datos (RGPD).

Para promover la reutilización, el informe aconseja fomentar ecosistemas dinámicos a través de eventos comunitarios como hackatones y talleres, destacando ejemplos exitosos de aplicación práctica de los datos abiertos. Además, insiste en la necesidad de proporcionar herramientas útiles como API para consultas dinámicas, visualizaciones de datos interactivas y documentación completa, así como en implementar mecanismos sostenibles de financiación y mantenimiento.

Pautas técnicas y funcionales

Con respecto a las pautas técnicas y funcionales, el documento detalla la importancia de construir una infraestructura técnica robusta y escalable basada en tecnologías en la nube, utilizando sistemas de almacenamiento diversos como bases de datos relacionales, NoSQL y soluciones específicas para series temporales o datos geoespaciales. Destaca además la relevancia de integrar herramientas avanzadas de automatización para garantizar la calidad constante de los datos y recomienda soluciones específicas para gestionar datos en tiempo real provenientes de Internet de las Cosas (IoT).

En relación con la usabilidad y estructura del portal, se enfatiza la importancia de un diseño centrado en el usuario, con navegación clara y un potente motor de búsqueda para facilitar el acceso rápido a los datos. Además, se insiste en la importancia de cumplir con los estándares internacionales de accesibilidad y ofrecer herramientas que simplifiquen la interacción con los datos, incluyendo visualizaciones gráficas claras y mecanismos de soporte técnico eficientes.

El informe también resalta el papel clave de las API como herramientas fundamentales para facilitar el acceso automatizado y dinámico a los datos del portal, ofreciendo consultas granulares, documentación clara, mecanismos robustos de seguridad y formatos estándar reutilizables. Además, sugiere una variedad de herramientas y frameworks técnicos para implementar estas API de forma eficiente.

Otro aspecto crítico destacado en el documento es la identificación y priorización de conjuntos de datos para publicación, ya que la planificación progresiva de la apertura de datos permite ajustar los procesos técnicos y organizativos de manera ágil, comenzando con los datos de mayor relevancia estratégica y demanda ciudadana.

Por último, la guía recomienda establecer un sistema de métricas e indicadores según la norma UNE 178301:2015 para evaluar el grado de madurez y el impacto real de los portales de datos abiertos. Estas métricas abarcan dominios estratégicos, legales, organizativos, técnicos, económicos y sociales, proporcionando un enfoque integral para medir tanto la eficacia en la publicación de los datos como su impacto tangible en la sociedad y la economía local.

Conclusiones

En conclusión, el informe proporciona un marco estratégico, técnico y práctico que sirve de referencia para el despliegue de portales de datos abiertos municipales, para que las ciudades maximicen su potencial como motores de desarrollo económico y social. Además, la integración de inteligencia artificial en diversos puntos de los proyectos de portales de datos abiertos representa una oportunidad estratégica para ampliar sus capacidades y generar un mayor impacto en la ciudadanía.

El concepto de data commons o bienes comunes de datos surge como un enfoque transformador para la gestión y el intercambio de datos que sirvan a fines colectivos y como alternativa al creciente número de macrosilos de datos de uso privado. Al tratar los datos como un recurso compartido, los data commons facilitan la colaboración, la innovación y el acceso equitativo a los mismos, enfatizando el valor comunal de los datos por encima de cualquier otra consideración. A medida que navegamos por las complejidades de la era digital —marcada en la actualidad por los rápidos avances en inteligencia artificial (IA) y el continuo debate sobre los retos en la gobernanza de datos— el papel que pueden jugar los data commons es ahora probablemente más importante que nunca.

¿Qué son los data commons?

Los data commons se refieren a un marco cooperativo donde los datos son recopilados, gobernados y compartidos entre todos los participantes de la comunidad mediante protocolos que promueven la apertura, la equidad, el uso ético y la sostenibilidad. Los data commons se diferencian de los modelos tradicionales de intercambio de datos, principalmente, por la prioridad que se da a la colaboración y la inclusión sobre el control unitario.

Otro objetivo común de los data commons es la creación de conocimiento colectivo que pueda ser utilizado por cualquiera para el bien de la sociedad. Esto los hace particularmente útiles a la hora de afrontar los grandes desafíos actuales, como los retos del medio ambiente, la interacción multilingüe, la movilidad, las catástrofes humanitarias, la preservación del conocimiento o los nuevos desafíos de la salud y la sanidad.

Además, también es cada vez más frecuente que estas iniciativas para compartir datos incorporen todo tipo de herramientas que faciliten su análisis e interpretación consiguiendo así democratizar no sólo la propiedad y el acceso a los datos, sino también su uso.

Por todo lo anterior, los data commons podrían considerarse hoy en día como una infraestructura digital pública crítica a la hora de aprovechar los datos y promover el bienestar social.

Principios de los data commons

Los data commons se construyen sobre una serie de principios simples que serán clave para su correcta gobernanza:

- Apertura y accesibilidad: los datos deben ser accesibles para todos los autorizados.

- Gobernanza ética: equilibrio entre la inclusión y la privacidad.

- Sostenibilidad: establecer mecanismos de financiación y recursos para mantener los datos como bienes comunes a lo largo del tiempo.

- Colaboración: fomentar que los participantes contribuyan con nuevos datos e ideas que habiliten su uso para el beneficio mutuo.

- Confianza: relaciones basadas en la transparencia y la credibilidad entre partícipes.

Además, si queremos asegurarnos también de que los data commons cumplan su papel como infraestructura digital de dominio público, deberemos garantizar otros requisitos mínimos adicionales como: existencia de identificadores únicos permanentes, metadatos documentados, acceso fácil a través de interfaces de programación de aplicaciones (API), portabilidad de los datos, acuerdos de intercambio de datos entre pares y capacidad de realizar operaciones sobre los mismos.

El importante papel de los data commons en la era de la Inteligencia Artificial

La innovación impulsada por la IA ha incrementado exponencialmente la demanda de conjuntos de datos diversos y de alta calidad, un bien relativamente escaso a gran escala que puede dar lugar a cuellos de botella en el desarrollo futuro de la tecnología y que, al mismo tiempo, hace de los data commons un facilitador muy relevante a la hora de conseguir una IA más equitativa. Al proporcionar conjuntos de datos compartidos gobernados por principios éticos, los data commons contribuyen a mitigar riesgos frecuentes como los sesgos, los monopolios de datos y el acceso desigual a los beneficios de la IA.

Además, la actual concentración de los desarrollos en el ámbito de la IA representa también un desafío para el interés público. En este contexto, los data commons cuentan con la llave necesaria para habilitar un conjunto de sistemas y aplicaciones de IA alternativos, públicos y orientados al interés general, que puedan contribuir a rebalancear esta concentración de poder actual. El objetivo de estos modelos sería demostrar cómo se pueden diseñar sistemas más democráticos, orientados al interés público y con propósitos bien definidos, basados en los principios y modelos de gobernanza de la IA pública.

Sin embargo, la era de la IA generativa también presenta nuevos desafíos para los data commons como, por ejemplo y quizás el más destacado, el riesgo potencial de una explotación descontrolada de los conjuntos de datos compartidos que podría dar lugar a nuevos desafíos éticos por el uso indebido de los datos y la vulneración de la privacidad.

Por otro lado, la falta de transparencia en cuanto al uso de los data commons por parte de la IA podría también acabar desmotivando a las comunidades que los gestionan poniendo en riesgo su continuidad. Esto se debe a la preocupación de que al final su contribución pueda estar beneficiando principalmente a las grandes plataformas tecnológicas, sin que haya ninguna garantía de un reparto más justo del valor y el impacto generados tal como se pretendía inicialmente."

Por todo lo anterior, organizaciones como Open Future abogan desde hace ya varios años por una Inteligencia Artificial que funcione como un bien común, gestionada y desarrollada como una infraestructura pública digital en beneficio de todos, evitando la concentración de poder y promoviendo la equidad y la transparencia tanto en su desarrollo como en su aplicación.

Para ello proponen una serie de principios que guíen la gobernanza de los bienes comunes de datos en su aplicación para el entrenamiento de la IA de forma que se maximice el valor generado para la sociedad y se minimicen las posibilidades de potenciales abusos por intereses comerciales:

- Compartir tantos datos como sea posible, pero manteniendo las restricciones que puedan resultar necesarias para preservar los derechos individuales y colectivos.

- Ser completamente transparente y proporcionar toda la documentación existente sobre los datos, así como sobre su uso, permitiendo además distinguir claramente entre datos reales y sintéticos.

- Respetar las decisiones tomadas sobre el uso de los datos por parte de las personas que han contribuido previamente a la creación de los datos, ya sea mediante la cesión de sus propios datos o a través de la elaboración de nuevos contenidos, incluyendo también el respeto hacia cualquier marco legal existente.

- Proteger el beneficio común en el uso de los datos y un uso sostenible de los mismos para poder asegurar una gobernanza adecuada a lo largo del tiempo, reconociendo siempre su naturaleza relacional y colectiva.

- Garantizar la calidad de los datos, lo que resulta crítico a la hora de conservar su valor como bien de interés común, especialmente teniendo en cuenta los potenciales riesgos de contaminación asociados a su uso por parte de la IA.

- Establecer instituciones fiables que se encarguen de la gobernanza de los datos y faciliten la participación por parte de toda la comunidad creada en torno a los datos, yendo así un paso más allá de los modelos existentes en la actualidad para los intermediarios de datos.

Casos de uso y aplicaciones

Existen en la actualidad múltiples ejemplos reales que nos ayudan a ilustrar el potencial transformador de los data commons:

-

Data commons sanitarios: proyectos como la iniciativa del National Institutes of Health en los Estados Unidos - NIH Common Fund para analizar y compartir grandes conjuntos de datos biomédicos, o el Cancer Research Data Commons del National Cancer Institute, demuestran cómo los data commons pueden contribuir a la aceleración de la investigación y la innovación en salud.

- Entrenamiento de la IA y machine learning: la evaluación de los sistemas de IA depende de conjuntos de datos de prueba rigurosos y estandarizados. Iniciativas como OpenML o MLCommons construyen conjuntos de datos abiertos, a gran escala y diversos, ayudando a la comunidad en general a ofrecer sistemas de IA más precisos y seguros.

- Data commons urbanos y de movilidad: las ciudades que aprovechan plataformas compartidas de datos urbanos mejoran la toma de decisiones y los servicios públicos mediante el análisis colectivo de datos, como es el caso de Barcelona Dades, que además de un amplio repositorio de datos abiertos integra y difunde datos y análisis sobre la evolución demográfica, económica, social y política de la ciudad. Otras iniciativas como el propio OpenStreetMaps pueden también contribuir a proporcionar datos geográficos de libre acceso.

- Preservación de la cultura y el conocimiento: con iniciativas tan relevantes en este campo como el proyecto de Common Voice de Mozilla para preservar y revitalizar los idiomas del mundo, o Wikidata, cuyo objetivo consiste en proporcionar un acceso estructurado a todos los datos provenientes de los proyectos de Wikimedia, incluyendo la popular Wikipedia.

Desafíos en los data commons

A pesar de su promesa y potencial como herramienta transformadora para los nuevos desafíos en la era digital, los data commons afrontan también sus propios desafíos:

- Complejidad en la gobernanza: llegar a conseguir un equilibrio correcto entre la inclusión, el control y la privacidad puede resultar una tarea delicada.

- Sostenibilidad: muchos de los data commons existentes libran una batalla continua para intentar asegurarse la financiación y los recursos que necesitan para mantenerse y garantizar su supervivencia a largo plazo.

- Problemas legales y éticos: abordar los retos relativos a los derechos de propiedad intelectual, la titularidad de datos y el uso ético siguen siendo aspectos críticos que todavía no se han resulto por completo.

- Interoperabilidad: asegurar la compatibilidad entre conjuntos de datos y plataformas es un obstáculo técnico persistente en casi cualquier iniciativa de compartición de datos, y los data commons no iban a ser la excepción.

El camino a seguir

Para desbloquear su pleno potencial, los data commons requieren de una acción colectiva y una apuesta decidida por la innovación. Las acciones clave incluyen:

- Desarrollar modelos de gobernanza estandarizados que consigan el equilibrio entre las consideraciones éticas y los requisitos técnicos.

- Aplicar el principio de reciprocidad en el uso de los datos, exigiendo a aquellos que se benefician de ellos compartir sus resultados de vuelta con la comunidad.

- Protección de datos sensibles mediante la anonimización, evitando que los datos puedan ser utilizados para vigilancia masiva o discriminación.

- Fomentar la inversión en infraestructura para apoyar el intercambio de datos escalable y sostenible.

- Promover la concienciación sobre los beneficios sociales de los data commons para impulsar la participación y la colaboración.

Los responsables políticos, investigadores y organizaciones civiles deberían trabajar juntos para crear un ecosistema en el que los data commons puedan prosperar, fomentando un crecimiento más equitativo en la economía digital y garantizando que los bienes comunes de datos puedan beneficiar a todos.

Conclusión

Los data commons pueden suponer una poderosa herramienta a la hora de democratizar el acceso a los datos y fomentar la innovación. En esta era definida por la IA y la transformación digital, nos ofrecen un camino alternativo hacia el progreso equitativo, sostenible e inclusivo. Al abordar sus desafíos y adoptar un enfoque de gobernanza colaborativa mediante la cooperación entre comunidades, investigadores y reguladores se podrá garantizar un uso equitativo y responsable de los datos.

De este modo se conseguirá que los data commons se conviertan en un pilar fundamental del futuro digital, incluyendo las nuevas aplicaciones de la Inteligencia Artificial, pudiendo servir además como herramienta habilitadora fundamental para algunas de las acciones clave que forman parte de la recién anunciada brújula Europea de competitividad, como la estrategia de la nueva Unión de Datos y la iniciativa de las Gigafábricas de IA.

Contenido elaborado por Carlos Iglesias, Open data Researcher y consultor, World Wide Web Foundation. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La Inteligencia Artificial (IA) ha dejado de ser un concepto futurista y se ha convertido en una herramienta clave en nuestra vida diaria. Desde las recomendaciones de películas o series en plataformas de streaming hasta los asistentes virtuales como Alexa o Google Assistant en nuestros dispositivos, la IA está en todas partes. Pero, ¿cómo se construye un modelo de IA? A pesar de lo que podría parecer, el proceso es menos intimidante si lo desglosamos en pasos claros y comprensibles.

Paso 1: definir el problema

Antes de empezar, necesitamos tener muy claro qué queremos resolver. La IA no es una varita mágica: diferentes modelos funcionarán mejor en diferentes aplicaciones y contextos por lo que es importante definir la tarea específica que deseamos ejecutar. Por ejemplo, ¿queremos predecir las ventas de un producto? ¿Clasificar correos como spam o no spam? Tener una definición clara del problema nos ayudará a estructurar el resto del proceso.

Además, debemos plantearnos qué tipo de datos tenemos y cuáles son las expectativas. Esto incluye determinar el nivel de precisión deseado y las limitaciones de tiempo o recursos disponibles.

Paso 2: recopilar los datos

La calidad de un modelo de IA depende directamente de la calidad de los datos utilizados para entrenarlo. Este paso consiste en recopilar y organizar los datos relevantes para nuestro problema. Por ejemplo, si queremos predecir ventas, necesitaremos datos históricos como precios, promociones o patrones de compra.

La recopilación de datos comienza identificando las fuentes relevantes, que pueden ser bases de datos internas, sensores, encuestas… Además de los datos propios de cada empresa, existe un amplio ecosistema de datos, tanto abiertos como propietarios, a los que podemos recurrir en busca de la construcción de modelos más potentes. Por ejemplo, el Gobierno de España habilita a través del portal datos.gob.es múltiples conjuntos de datos abiertos publicados por instituciones públicas. Por otro lado, la empresa Amazon Web Services (AWS) a través de su portal AWS Data Exchange permite el acceso y suscripción a miles de conjuntos de datos propietarios publicados y mantenidos por diferentes empresas y organizaciones.

En este punto también se debe considerar la cantidad de datos necesaria. Los modelos de IA suelen necesitar grandes volúmenes de información para aprender de manera efectiva. También es crucial que los datos sean representativos y no contengan sesgos que puedan afectar los resultados. Por ejemplo, si entrenamos un modelo para predecir patrones de consumo y solo usamos datos de un grupo limitado de personas, es probable que las predicciones no sean válidas para otros grupos con comportamientos diferentes.

Paso 3: preparar y explorar los datos

Una vez recopilados los datos, es hora de limpiarlos y normalizarlos. En muchas ocasiones, los datos en bruto pueden contener problemas como errores, duplicidades, valores faltantes, inconsistencias o formatos no estandarizados. Por ejemplo, podríamos encontrarnos con celdas vacías en un conjunto de datos de ventas o con fechas que no siguen un formato coherente. Antes de alimentar el modelo con estos datos, es fundamental adecuarlos para garantizar que el análisis sea preciso y confiable. Este paso no solo mejora la calidad de los resultados, sino que también asegura que el modelo pueda interpretar correctamente la información.

Una vez tenemos los datos limpios es fundamental realizar la ingeniería de características (feature engineering), un proceso creativo que puede marcar la diferencia entre un modelo básico y uno excelente. Esta fase consiste en crear nuevas variables que capturen mejor la naturaleza del problema que queremos resolver. Por ejemplo, si estamos analizando ventas online, además de usar el precio directo del producto, podríamos crear nuevas características como el ratio precio/media_categoría, los días desde la última promoción, o variables que capturen la estacionalidad de las ventas. La experiencia demuestra que contar con características bien diseñadas suele ser más determinante para el éxito del modelo que la elección del algoritmo en sí mismo.

En esta fase, también realizaremos un primer análisis exploratorio de los datos, buscando familiarizarnos con ellos y detectar posibles patrones, tendencias o irregularidades que puedan influir en el modelo. En esta guía podemos encontrar mayor detalle sobre cómo realizar un análisis exploratorio de datos.

Otra actividad típica de esta etapa es dividir los datos en conjuntos de entrenamiento, validación y prueba. Por ejemplo, si tenemos 10.000 registros, podríamos usar el 70% para entrenamiento, el 20% para validación y el 10% para pruebas. Esto permite que el modelo aprenda sin sobreajustarse a un conjunto de datos específico.

Para garantizar que nuestra evaluación sea robusta, especialmente cuando trabajamos con conjuntos de datos limitados, es recomendable implementar técnicas de validación cruzada (cross-validation). Esta metodología divide los datos en múltiples subconjuntos y realiza varias iteraciones de entrenamiento y validación. Por ejemplo, en una validación cruzada de 5 pliegues, dividimos los datos en 5 partes y entrenamos 5 veces, usando cada vez una parte diferente como conjunto de validación. Esto nos proporciona una estimación más fiable del rendimiento real del modelo y nos ayuda a detectar problemas de sobreajuste o variabilidad en los resultados.

Paso 4: seleccionar un modelo

Existen múltiples tipos de modelos de IA, y la elección depende del problema que deseemos resolver. Algunos ejemplos comunes son regresión, modelos de árboles de decisión, modelos de agrupamiento, modelos de series temporales o redes neuronales. En general, existen modelos supervisados, modelos no supervisados y modelos de aprendizaje por refuerzo. Podemos encontrar un mayor detalle en este post sobre cómo las maquinas aprenden.

A la hora de seleccionar un modelo, es importante tener en cuenta factores como la naturaleza de los datos, la complejidad del problema y el objetivo final. Por ejemplo, un modelo simple como la regresión lineal puede ser suficiente para problemas sencillos y bien estructurados, mientras que redes neuronales o modelos avanzados podrían ser necesarios para tareas como reconocimiento de imágenes o procesamiento del lenguaje natural. Además, también se debe considerar el balance entre precisión, tiempo de entrenamiento y recursos computacionales. Un modelo más preciso generalmente requiere configuraciones más complejas, como más datos, redes neuronales más profundas o parámetros optimizados. Aumentar la complejidad del modelo o trabajar con conjuntos de datos grandes puede alargar significativamente el tiempo necesario para entrenarlo. Esto puede ser un problema en entornos donde las decisiones deben tomarse rápidamente o los recursos son limitados y requerir hardware especializado, como GPUs o TPUs, y mayores cantidades de memoria y almacenamiento.

Hoy en día, muchas bibliotecas de código abiertas facilitan la implementación de estos modelos, como TensorFlow, PyTorch o scikit-learn.

Paso 5: entrenar el modelo

El entrenamiento es el corazón del proceso. Durante esta etapa, alimentamos el modelo con los datos de entrenamiento para que aprenda a realizar su tarea. Esto se logra ajustando los parámetros del modelo para minimizar el error entre sus predicciones y los resultados reales.

Aquí es clave evaluar constantemente el rendimiento del modelo con el conjunto de validación y realizar ajustes si es necesario. Por ejemplo, en un modelo de tipo red neuronal podríamos probar diferentes configuraciones de hiperparámetros como tasa de aprendizaje, número de capas ocultas y neuronas, tamaño del lote, número de épocas, o función de activación, entre otros.

Paso 6: evaluar el modelo

Una vez entrenado, es momento de poner a prueba el modelo utilizando el conjunto de datos de prueba que apartamos durante la fase de entrenamiento. Este paso es crucial para medir cómo se desempeña con datos que para el modelo son nuevos y garantiza que no esté “sobreentrenado”, es decir, que no solo funcione bien con los datos de entrenamiento, sino que sea capaz de aplicar el aprendizaje sobre nuevos datos que puedan generarse en el día a día.

Al evaluar un modelo, además de la precisión, también es común considerar:

- Confianza en las predicciones: evaluar cuán seguras son las predicciones realizadas.

- Velocidad de respuesta: tiempo que toma el modelo en procesar y generar una predicción.

- Eficiencia en recursos: medir cuánto uso de memoria y cómputo requiere el modelo.

- Adaptabilidad: cuán bien puede ajustarse el modelo a nuevos datos o condiciones sin necesidad de un reentrenamiento completo.

Paso 7: desplegar y mantener el modelo

Cuando el modelo cumple con nuestras expectativas, está listo para ser desplegado en un entorno real. Esto podría implicar integrar el modelo en una aplicación, automatizar tareas o generar informes.

Sin embargo, el trabajo no termina aquí. La IA necesita mantenimiento continuo para adaptarse a los cambios en los datos o en las condiciones del mundo real. Por ejemplo, si los patrones de compra cambian por una nueva tendencia, el modelo deberá ser actualizado.

Construir modelos de IA no es una ciencia exacta, es el resultado de un proceso estructurado que combina lógica, creatividad y perseverancia. Esto se debe a que intervienen múltiples factores, como la calidad de los datos, las elecciones en el diseño del modelo y las decisiones humanas durante la optimización. Aunque existen metodologías claras y herramientas avanzadas, la construcción de modelos requiere experimentación, ajustes y, a menudo, un enfoque iterativo para obtener resultados satisfactorios. Aunque cada paso requiere atención al detalle, las herramientas y tecnologías disponibles hoy en día hacen que este desafío sea accesible para cualquier persona interesada en explorar el mundo de la IA.

ANEXO I – Definiciones tipos de modelos

-

Regresión: técnicas supervisadas que modelan la relación entre una variable dependiente (resultado) y una o más variables independientes (predictores). La regresión se utiliza para predecir valores continuos, como ventas futuras o temperaturas, y puede incluir enfoques como la regresión lineal, logística o polinómica, dependiendo de la complejidad del problema y la relación entre las variables.

-

Modelos de árboles de decisión: métodos supervisados que representan decisiones y sus posibles consecuencias en forma de árbol. En cada nodo, se toma una decisión basada en una característica de los datos, dividiendo el conjunto en subconjuntos más pequeños. Estos modelos son intuitivos y útiles para clasificación y predicción, ya que generan reglas claras que explican el razonamiento detrás de cada decisión.

-

Modelos de agrupamiento: técnicas no supervisadas que agrupan datos en subconjuntos llamados clústeres, basándose en similitudes o proximidad entre los datos. Por ejemplo, se pueden agrupar clientes con hábitos de compra similares para personalizar estrategias de marketing. Modelos como k-means o DBSCAN permiten identificar patrones útiles sin necesidad de datos etiquetados.

-

Modelos de series temporales: diseñados para trabajar con datos ordenados cronológicamente, estos modelos analizan patrones temporales y realizan predicciones basadas en el historial. Se utilizan en casos como predicción de demanda, análisis financiero o meteorología. Incorporan tendencias, estacionalidad y relaciones entre los datos pasados y futuros.

-

Redes neuronales: modelos inspirados en el funcionamiento del cerebro humano, donde capas de neuronas artificiales procesan información y detectan patrones complejos. Son especialmente útiles en tareas como reconocimiento de imágenes, procesamiento de lenguaje natural y juegos. Las redes neuronales pueden ser simples o muy profundas (deep learning), dependiendo del problema y la cantidad de datos.

-

Modelos supervisados: estos modelos aprenden de datos etiquetados, es decir, conjuntos en los que cada entrada tiene un resultado conocido. El objetivo es que el modelo generalice para predecir resultados en datos nuevos. Ejemplos incluyen clasificación de correos en spam o no spam y predicciones de precios.

-

Modelos no supervisados: trabajan con datos sin etiquetas, buscando patrones ocultos, estructuras o relaciones dentro de los datos. Son ideales para tareas exploratorias donde no se conoce de antemano el resultado esperado, como segmentación de mercados o reducción de dimensionalidad.

- Modelo de aprendizaje por refuerzo: en este enfoque, un agente aprende interactuando con un entorno, tomando decisiones y recibiendo recompensas o penalizaciones según su desempeño. Este tipo de aprendizaje es útil en problemas donde las decisiones afectan un objetivo a largo plazo, como entrenar robots, jugar videojuegos o desarrollar estrategias de inversión.

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El diseño de API web es una disciplina fundamental para el desarrollo de aplicaciones y servicios, al facilitar el intercambio fluido de datos entre diferentes sistemas. En el contexto de las plataformas de datos abiertos, las API cobran especial importancia, ya que permiten a los usuarios acceder de manera automática y eficiente a la información necesaria, ahorrando costes y recursos.

Este artículo explora los principios esenciales que deben guiar la creación de API web eficaces, seguras y sostenibles, en base a los principios recopilados por el Grupo de Arquitectura Técnica ligado a World Wide Web Consortium (W3C), siguiendo estándares éticos y técnicos. Aunque estos principios hacen referencia al diseño de API, muchos son aplicables al desarrollo web en general.

Se busca que los desarrolladores puedan garantizar que sus API no solo cumplan con los requisitos técnicos, sino que también respeten la privacidad y seguridad de los usuarios, promoviendo una web más segura y eficiente para todos.

En este post, analizaremos algunos consejos para los desarrolladores de las API y cómo se pueden poner en práctica.

Prioriza las necesidades del usuario

Al diseñar una API, es crucial seguir la jerarquía de necesidades establecida por el W3C:

- Primero, las necesidades del usuario final.

- Segundo, las necesidades de los desarrolladores web.

- Tercero, las necesidades de los implementadores de navegadores.

- Por último, la pureza teórica.

Así podremos impulsar una experiencia de usuario que sea intuitiva, funcional y atractiva. Esta jerarquía debe guiar las decisiones de diseño, aunque reconociendo que en ocasiones estos niveles se interrelacionan: por ejemplo, una API más fácil de usar para los desarrolladores suele resultar en mejor experiencia para el usuario final.

Garantiza la seguridad

Garantizar la seguridad al desarrollar una API es crucial para proteger, tanto los datos de los usuarios, como la integridad del sistema. Una API insegura puede ser un punto de entrada para atacantes que buscan acceder a información sensible o comprometer la funcionalidad del sistema. Por ello, al añadir nuevas funcionalidades, debemos cumplir las expectativas del usuario y garantizar su seguridad.

En este sentido, es esencial considerar factores relacionados con la autenticación de usuarios, encriptación de datos, validación de entradas, gestión de tasas de solicitud (o Rate Limiting, para limitar la cantidad de solicitudes que un usuario puede hacer en un periodo determinado y evitar ataques de denegación de servicio), etc. También es necesario monitorear continuamente las actividades de la API y mantener registros detallados para detectar y responder rápidamente a cualquier actividad sospechosa.

Desarrolla una interfaz de usuario que transmita confianza

Es necesario considerar cómo las nuevas funcionalidades impactan en las interfaces de usuario. Las interfaces deben ser diseñadas para que los usuarios puedan confiar y verificar que la información proporcionada es genuina y no ha sido falsificada. Aspectos como la barra de direcciones, los indicadores de seguridad y las solicitudes de permisos deben dejar claro con quién se están interactuando y cómo.

Por ejemplo, la función alert de JavaScript, que permite mostrar un cuadro de diálogo modal que parece parte del navegador, es un caso histórico que ilustra esta necesidad. Esta función, creada en los primeros días de la web, ha sido frecuentemente utilizada para engañar a usuarios haciéndoles creer que están interactuando con el navegador, cuando en realidad lo hacen con la página web. Si esta funcionalidad se propusiera hoy, probablemente no sería aceptada por estos riesgos de seguridad.

Pide consentimiento explicito a los usuarios

En el contexto de satisfacer una necesidad de usuario, una página web puede utilizar una función que suponga una amenaza. Por ejemplo, el acceso a la geolocalización del usuario puede ser de ayuda en algunos contextos (como una aplicación de mapas), pero también afecta a la privacidad.

En estos casos es necesario que el usuario consienta su uso. Para ello:

- El usuario debe entender a qué está accediendo. Si no puedes explicar a un usuario tipo a qué está consintiendo de forma inteligible, deberás reconsiderar el diseño de la función.

- El usuario debe poder elegir entre otorgar o rechazar ese permiso de manera efectiva. Si se rechaza una solicitud de permiso, la página web no podrá hacer nada que el usuario crea que ha descartado.

Al pedir consentimiento, podemos informar al usuario de qué capacidades tiene o no tiene la página web, reforzando su confianza en la seguridad del sitio. Sin embargo, el beneficio de una nueva función debe justificar la carga adicional que supone para el usuario decidir si otorga o no permiso para una función.

Usa mecanismos de identificación adecuados al contexto

Es necesario ser transparente y permitir a las personas controlar sus identificadores y la información adjunta a ellos que proporcionan en diferentes contextos en la web.

Las funcionalidades que utilizan o dependen de identificadores vinculados a datos sobre una persona conllevan riesgos de privacidad que pueden ir más allá de una sola API o sistema. Esto incluye datos generados pasivamente (como su comportamiento en la web) y aquellos recopilados activamente (por ejemplo, a través de un formulario). En este sentido, es necesario entender el contexto en el que se usarán y cómo se integrarán con otras funcionalidades de la web, asegurando de que el usuario pueda dar un consentimiento adecuado.

Es recomendable diseñar API que recopilen la mínima cantidad de datos necesarios y usar identificadores temporales de corta duración, a menos que sea absolutamente necesario un identificador persistente.

Crea funcionalidades compatibles con toda la gama de dispositivos y plataformas

En la medida de lo posible, asegura que las funcionalidades de la web estén operativas en diferentes dispositivos de entrada y salida, tamaños de pantalla, modos de interacción, plataformas y medios, favoreciendo la flexibilidad del usuario.

Por ejemplo, los modelos de diseño 'display: block', 'display: flex' y 'display: grid' en CSS, por defecto, colocan el contenido dentro del espacio disponible y sin solapamientos. De este modo funcionan en diferentes tamaños de pantalla y permiten a los usuarios elegir su propia fuente y tamaño sin causar desbordamiento de texto.

Agrega nuevas capacidades con cuidado

Añadir nuevas capacidades a la web requiere tener en consideración las funcionalidades y el contenido ya existentes, para valorar cómo va a ser su integración. No hay que asumir que un cambio es posible o imposible sin verificarlo primero.

Existen muchos puntos de extensión que permiten agregar funcionalidades, pero hay cambios que no se pueden realizar simplemente añadiendo o eliminando elementos, porque podrían generar errores o afectar a la experiencia de usuario. Por ello es necesario verificar antes la situación actual, como veremos en el siguiente apartado.

Antes de eliminar o cambiar funcionalidades, comprende su uso actual

Es posible eliminar o cambiar funciones y capacidades, pero primero hay que conocer bien la naturaleza y el alcance de su impacto en el contenido existente. Para ello puede ser necesario investigar cómo se utilizan las funciones actuales.

La obligación de comprender el uso existente se aplica a cualquier función de la que dependan los contenidos. Las funciones web no se definen únicamente en las especificaciones, sino también en la forma en que los usuarios las utilizan.

La práctica recomendada es priorizar la compatibilidad de las nuevas funciones con el contenido existente y el comportamiento del usuario. En ocasiones, una cantidad significativa de contenido puede depender de un comportamiento concreto. En estas situaciones, se desaconseja eliminar o cambiar dicho comportamiento.

Deja la web mejor de lo que la encontraste

La forma de añadir nuevas capacidades a una plataforma web es mejorando la plataforma en su conjunto, por ejemplo, sus características de seguridad, privacidad o accesibilidad.

La existencia de un defecto en una parte concreta de la plataforma no debe servir de excusa para añadir o ampliar funcionalidades adicionales con el fin de solucionarlo, ya que con ello se pueden duplicar problemas y disminuir la calidad general de la plataforma. Siempre que sea posible, hay que crear nuevas capacidades web que mejoren la calidad general de la plataforma, mitigando los defectos existentes de forma global.

Minimiza los datos del usuario

Hay que diseñar las funcionalidades para que sean operativas con la mínima cantidad necesaria de datos aportados por el usuario para llevar a cabo sus objetivos . Con ello, limitamos los riesgos de que se divulguen o utilicen indebidamente.

Se recomienda diseñar las API de forma que a los sitios web les resulte más fácil solicitar, recopilar y/o transmitir una pequeña cantidad de datos (datos más granulares o específicos), que trabajar con datos más genéricos o masivos. Las API deben proporcionar granularidad y controles de usuario, en particular si trabajan sobre datos personales.

Otras recomendaciones

El documento también ofrece consejos para el diseño de API utilizando diversos lenguajes de programación. En este sentido, proporciona recomendaciones ligadas a HTML, CSS, JavaScript, etc. Puedes leer las recomendaciones aquí.

Además, si estás pensando en integrar una API en tu plataforma de datos abiertos, te recomendamos la lectura de la Guía práctica para la publicación de Datos Abiertos usando APIs.

Siguiendo estas indicaciones podrás desarrollar sitios web consistentes y útiles para los usuarios, que les permitan alcanzar sus objetivos de manera ágil y optimizando recursos.

Los EU Open Data Days 2025 son un evento esencial para todos los interesados en el mundo de los datos abiertos y la innovación en Europa y el mundo. Este encuentro, que se celebrará los días 19 y 20 de marzo de 2025, reunirá a expertos, profesionales, desarrolladores, investigadores y responsables de políticas públicas para compartir conocimientos, explorar nuevas oportunidades y abordar los retos a los que se enfrenta la comunidad de datos abiertos.

El evento, organizado por la Comisión Europea a través de data.europa.eu, tiene como objetivo principal promover la reutilización de datos abiertos. Los participantes tendrán la oportunidad de aprender sobre las últimas tendencias en el uso de los datos abiertos, descubrir nuevas herramientas y debatir sobre las políticas y normativas que están modelando el panorama digital en Europa.

¿Dónde y cuándo se celebra?

El evento se celebrará en el Centro Europeo de Convenciones de Luxemburgo, aunque también se podrá seguir online, con el siguiente horario:

- Miércoles 19 de marzo de 2025, de 13:30 a 18:30.

- Jueves 20 de marzo de 2025, de 9:00 a 15:30.

¿Qué temáticas se abordarán?

Ya está disponible la agenda del evento, donde encontramos distintas temáticas, como, por ejemplo:

- Historias de éxito y buenas prácticas: el evento contará con la presencia de profesionales que desarrollan su trabajo en la primera línea de la política de datos europea, para que cuenten su experiencia. Entre otras cuestiones, estos expertos proporcionarán una guía práctica para inventariar y abrir los datos del sector público de un país, abordarán el trabajo que implica la compilación de conjuntos de datos de alto valor o analizarán las perspectivas sobre la reutilización de datos en los modelos de negocio. También se explicarán buenas prácticas para contar con metadatos de calidad o mejorar la gobernanza de datos y su interoperabilidad.

- Foco en el uso de inteligencia artificial (IA): los datos abiertos ofrecen una fuente invaluable para el desarrollo y avance de la IA. Además, la IA puede optimizar la localización, gestión y uso de estos datos, ofreciendo herramientas que ayuden a agilizar procesos y extraer un mayor conocimiento. En este sentido, en el evento se abordará el potencial de la IA para transformar los ecosistemas de datos gubernamentales abiertos, fomentando la innovación, mejorando la gobernanza y potenciando la participación ciudadana. Los responsables del portal nacional de datos de Noruega contará cómo emplean un motor de búsqueda basado en IA para mejorar la localización de datos. Además, se explicarán los avances en espacios de datos lingüísticos y su uso en modelos de lenguaje, y se analizará cómo combinar de forma creativa los datos abiertos para lograr un impacto social.

- Aprendizaje sobre visualización de datos: los asistentes al evento podrán explorar cómo la visualización de datos está transformando la comunicación, la elaboración de políticas y la participación ciudadana. A través de diversos casos (como el árbol genealógico de 3.000 personas de la realeza europea o las relaciones del Patrimonio Cultural Inmaterial de la UNESCO) se mostrará cómo los procesos iterativos de diseño pueden descubrir patrones ocultos en redes complejas, aportando ideas sobre la narración y la comunicación de datos. También se abordará cómo influyen los elementos de diseño, como el color, la escala y el enfoque, en la percepción de los datos.

- Ejemplos y casos de uso: se mostrarán múltiples ejemplos de proyectos concretos basados en la reutilización de datos, en campos como la energía, el desarrollo urbano o el medio ambiente. Entre las experiencias que se compartirán, encontramos una empresa española, Tangible Data, que contará cómo las esculturas físicas de datos convierten conjuntos de datos complejos en experiencias accesibles y atractivas.

Estos son solo algunos de los temas a tratar, pero también se hablará de ciencia abierta, el papel de los datos abiertos en la transparencia y la rendición de cuentas, etc.

¿Por qué son tan importantes los EU Open Data Days?

El acceso a datos abiertos ha demostrado ser una herramienta poderosa para mejorar la toma de decisiones, impulsar la innovación y la investigación, y mejorar la eficiencia de las organizaciones. En un momento en el que la digitalización está avanzando rápidamente, la importancia de compartir y reutilizar datos se hace cada vez más crucial para enfrentar desafíos globales como el cambio climático, la salud pública o la justicia social.

Los EU Open Data Days 2025 son una oportunidad para explorar cómo los datos abiertos pueden aprovecharse para construir una Europa más conectada, innovadora y participativa.

Además, para aquellos que decidan asistir de forma presencial, el evento será también una oportunidad para establecer contactos con otros profesionales y organizaciones del sector, creando nuevas colaboraciones que pueden dar lugar a proyectos innovadores.

¿Cómo puedo asistir?

Para asistir presencialmente, es necesario inscribirse a través de este enlace. Sin embargo, no es necesario el registro para atender el evento de manera online.

Para cualquier consulta, se ha habilitado una dirección de correo donde se atenderán todas las dudas relativas al evento: EU-Open-Data-Days@ec.europa.eu.

Más información en la página web del evento.

En un mundo cada vez más impulsado por los datos, todas las organizaciones, tanto las empresas privadas, como los organismos públicos, buscan aprovechar su información para tomar decisiones más acertadas, mejorar la eficiencia de sus procesos y cumplir sus objetivos estratégicos. Sin embargo, crear una estrategia de datos efectiva es un desafío que no debe subestimarse.

Con frecuencia, organizaciones de todos los sectores caen en errores comunes que pueden comprometer el éxito de sus estrategias desde el principio. Desde ignorar la importancia del gobierno del dato hasta no alinear los objetivos estratégicos con las necesidades reales de la institución, estos fallos pueden traducirse en ineficiencias, incumplimientos normativos e, incluso, pérdida de confianza por parte de ciudadanos, empleados o usuarios.

En este artículo, exploraremos los errores más habituales en la creación de una estrategia de datos, con el propósito de ayudar tanto a entidades públicas como privadas a evitarlos. Nuestro objetivo es ofrecerles herramientas para construir una base sólida que les permita maximizar el valor de los datos en beneficio de su misión y sus objetivos.

Figura 1. Consejos para diseñar una estrategia de gobierno del dato. Fuente: elaboración propia

A continuación, se detallan algunos de los errores más comunes en la elaboración de una estrategia de datos, justificando su impacto y el grado de afectación que pueden tener en una organización:

Falta de vinculación con los objetivos de la organización y no identificación de las áreas clave

Para que la estrategia de datos sea efectiva en cualquier tipo de organización, es fundamental que esté alineada con sus objetivos estratégicos. Estos objetivos incluyen áreas clave como el incremento de los ingresos, la mejora del servicio, la optimización de costes o la experiencia del cliente/ciudadano. Además, priorizar las iniciativas es esencial para identificar las áreas de la organización que se beneficiarán más de la estrategia de datos. Este enfoque no solo permite maximizar el retorno de la inversión en datos, sino también asegurar que las iniciativas estén claramente conectadas con los resultados deseados, reduciendo posibles brechas entre los esfuerzos en datos y los objetivos estratégicos.

No definir objetivos claros a corto y medio plazo

Definir metas específicas y alcanzables en las etapas iniciales de una estrategia de datos es muy importante para establecer una dirección clara y demostrar su valor desde el principio. Esto impulsa la motivación de los equipos involucrados y genera confianza entre los líderes y las partes interesadas. Priorizar objetivos a corto plazo, como la implementación de un dashboard de indicadores clave o la mejora en la calidad de un conjunto específico de datos críticos, permite obtener resultados tangibles de manera rápida y justifica la inversión en la estrategia de datos. Estos logros iniciales no solo consolidan el respaldo de la dirección, sino que también fortalecen el compromiso de los equipos.

De igual forma, los objetivos a medio plazo son fundamentales para construir sobre los avances iniciales y preparar el terreno para proyectos más ambiciosos. Por ejemplo, la automatización de procesos de generación de informes o la implementación de modelos predictivos para áreas clave pueden ser metas intermedias que demuestren el impacto positivo de la estrategia en la organización. Estos logros permiten medir el progreso, evaluar el éxito de la estrategia y garantizar que esté alineada con las prioridades estratégicas de la organización.

Establecer una combinación de metas a corto y medio plazo asegura que la estrategia de datos mantenga su relevancia a lo largo del tiempo y continúe generando valor. Este enfoque ayuda a la organización a avanzar de manera estructurada, reforzando su posición tanto frente a sus competidores como en el cumplimiento de su misión en el caso de organismos públicos.

No realizar una evaluación de madurez previa para definir la estrategia lo más acotada posible

Antes de diseñar una estrategia de datos, es crucial realizar una evaluación previa que permita entender el estado actual de la organización en términos de datos y delimitar el alcance de manera realista y efectiva. Este paso no solo evita que los esfuerzos se dispersen, sino que también asegura que la estrategia esté alineada con las necesidades reales de la organización, maximizando así su impacto. Sin una evaluación previa, es fácil caer en el error de abordar iniciativas demasiado amplias o poco conectadas con las prioridades estratégicas.

Por lo tanto, realizar esta evaluación previa no es solo un ejercicio técnico, sino una herramienta estratégica que asegura que los recursos y esfuerzos estén bien dirigidos desde el principio. Con un diagnóstico claro, la estrategia de datos se convierte en una hoja de ruta sólida, capaz de generar resultados tangibles desde las primeras etapas. Cabe recordar que para realizar esta evaluación de madurez previa a la estrategia se podría utilizar la UNE 0080:2023, centrada en la evaluación de la madurez del gobierno y gestión del dato, proporciona un marco estructurado para esta evaluación inicial. Esta norma permite analizar de manera objetiva los procesos, tecnologías y capacidades de la organización en torno a los datos.

No llevar a cabo iniciativas de gobierno del dato

La definición de una estrategia sólida es fundamental para el éxito de las iniciativas de gobierno del dato. Es esencial contar con un área o unidad responsable del gobierno del dato, como una oficina del dato o un centro de excelencia, desde donde se establezcan las directrices claras y se coordinen las acciones necesarias para alcanzar los objetivos estratégicos comprometidos. Estas iniciativas deben estar alineadas con las prioridades de la organización, asegurando que los datos sean seguros, usables para los fines previstos y cumplan con la normativa y legislación vigente.

Un marco sólido de gobierno del dato es clave para garantizar la consistencia y la calidad de los datos, fortaleciendo la confianza en los informes y análisis que generan tanto valor interno como externo. Además, un enfoque adecuado reduce riesgos como el incumplimiento normativo, promoviendo un uso efectivo de los datos y protegiendo la reputación de la organización.

Por ello, es importante diseñar estas iniciativas con un enfoque integral, priorizando la colaboración entre las distintas áreas y alineándolas con la estrategia global de datos. Para profundizar en cómo estructurar un sistema de gobierno del dato efectivo, puedes consultar esta serie de artículos: De la estrategia del dato al sistema de gobierno de datos – Parte 1.

Enfocarse exclusivamente en la tecnología

Muchas organizaciones tienen la opinión errónea de que la adquisición de herramientas y plataformas sofisticadas será la solución definitiva a sus problemas de datos. Sin embargo, la tecnología constituye solo una parte del ecosistema. Sin los procesos adecuados, un marco de gobernanza y, por supuesto, personas, incluso la mejor tecnología fracasará. Esto es problemático porque puede dar lugar a enormes inversiones sin un retorno claro, así como a frustración entre los equipos cuando no obtienen los resultados esperados.

No involucrar a todas las partes interesadas ni definir los roles y responsabilidades

Una estrategia de datos sólida necesita sumar a todos los actores relevantes, ya sea en una administración pública o en una empresa privada. Cada área, departamento o unidad tiene una visión única de cómo los datos pueden ser útiles para alcanzar objetivos, mejorar servicios o tomar decisiones más informadas. Por eso, involucrar a todas las partes interesadas desde el principio no solo enriquece la estrategia, sino que también asegura que se alineen con las necesidades reales de la organización.

Asimismo, definir roles y responsabilidades claras es clave para evitar confusiones y duplicidades. Al saber quién es responsable de los datos, quién los gestiona y quién los usa, se garantiza un flujo de trabajo más eficiente y se fomenta la colaboración entre equipos. Tanto en el ámbito público como en el privado, este enfoque ayuda a maximizar el impacto de la estrategia de datos, asegurando que los esfuerzos estén coordinados y enfocados hacia un objetivo común.

No establecer métricas claras de éxito

Establecer indicadores clave de rendimiento (KPI) es fundamental para evaluar si las iniciativas están generando valor. Los KPI permiten demostrar los resultados de la estrategia de datos, reforzando el apoyo de los líderes y fomentando la disposición a seguir invirtiendo en el futuro. Al medir el impacto de las acciones, las organizaciones pueden garantizar la sostenibilidad y el desarrollo continuo de su estrategia, asegurando que esté alineada con los objetivos estratégicos y que aporte beneficios tangibles.

No posicionar la calidad de los datos en el centro

Una estrategia de datos sólida debe construirse sobre una base de datos confiables y de alta calidad. Ignorar este aspecto puede llevar a decisiones equivocadas, procesos ineficientes y pérdida de confianza en los datos por parte de los equipos. La calidad de datos no es solo un aspecto técnico, sino un habilitador estratégico: garantiza que la información utilizada sea completa, consistente, válida y oportuna.

Integrar la calidad de datos desde el principio implica definir métricas claras, establecer procesos de validación y limpieza, y asignar responsabilidades para su mantenimiento. Además, al colocar la calidad de datos en el centro de la estrategia, las organizaciones pueden desbloquear el verdadero potencial de los datos, asegurando que estos respalden con precisión los objetivos de negocio y refuercen la confianza de los usuarios. Sin calidad, la estrategia pierde fuerza y se convierte en una oportunidad desperdiciada.

No gestionar el cambio cultural ni la resistencia al cambio

La transición hacia una organización orientada a datos requiere no solo herramientas y procesos, sino también un enfoque claro en la gestión del cambio para involucrar a los empleados. Promover una mentalidad abierta hacia las nuevas prácticas es clave para garantizar la adopción y el éxito de la estrategia. Al priorizar la comunicación, la formación y el compromiso de los equipos, las organizaciones pueden facilitar este cambio cultural, asegurando que todos los niveles trabajen alineados con los objetivos estratégicos y maximizando el impacto de la estrategia de datos.

No planificar para la escalabilidad

Es fundamental que las organizaciones consideren cómo su estrategia de datos puede escalar a medida que crece el volumen de información. Diseñar una estrategia preparada para manejar este crecimiento asegura que los sistemas puedan soportar el aumento de datos sin necesidad de reestructuraciones futuras, lo que optimiza recursos y evita costos adicionales. Al planificar pensando en la escalabilidad, las organizaciones pueden garantizar una eficiencia operativa sostenible a largo plazo y aprovechar al máximo el valor de sus datos a medida que evolucionan sus necesidades.

Falta de actualización y revisión continua de la estrategia

Los datos y las necesidades de las organizaciones están en constante evolución, por lo que es importante revisar y adaptar regularmente la estrategia para mantenerla relevante y efectiva. Una estrategia de datos flexible y actualizada permite responder de manera ágil a nuevas oportunidades y desafíos, asegurando que siga generando valor a medida que cambian las prioridades del mercado o de la organización. Este enfoque proactivo garantiza que la estrategia continúe alineada con los objetivos estratégicos y refuerza su impacto positivo a largo plazo.

Como conclusión, es importante destacar que el éxito de una estrategia de datos radica en su capacidad para alinearse con los objetivos estratégicos de la organización, estableciendo metas claras y fomentando la participación de todas las áreas involucradas. Un buen sistema de gobierno del dato, acompañado de métricas que permitan medir su impacto, es la base para garantizar que la estrategia genere valor y sea sostenible a lo largo del tiempo.

Además, abordar aspectos como la calidad de los datos, el cambio cultural y la escalabilidad desde el inicio es esencial para maximizar su efectividad. Enfocarse exclusivamente en tecnología o descuidar estos elementos puede limitar los resultados y poner en riesgo la capacidad de la organización para adaptarse a nuevas oportunidades y desafíos. Finalmente, revisar y actualizar la estrategia de manera continua asegura su relevancia y refuerza su impacto positivo.

Para profundizar en cómo estructurar una estrategia de datos eficaz y su conexión con un sistema de gobierno del dato sólido, te recomendamos explorar los artículos publicados en datos.gob.es: De la estrategia del dato al sistema de gobierno de datos – Parte 1 y Parte 2. Estos recursos complementan los conceptos presentados en este artículo y ofrecen una visión práctica para su implementación en cualquier tipo de organización.

Contenido elaborado por Dr. Fernando Gualo, Profesor en UCLM y Consultor de Gobierno y Calidad de datos. El contenido y el punto de vista reflejado en esta publicación es responsabilidad exclusiva de su autor.

La capacidad de recopilar, analizar y compartir datos juega un papel crucial en el contexto de los desafíos globales a los que nos enfrentamos hoy en día como sociedad. Desde la contaminación y el cambio climático, pasando por la pobreza y las pandemias, hasta la movilidad sostenible y la falta de acceso a los servicios básicos. Los problemas globales exigen soluciones que puedan adaptarse a gran escala. Es ahí donde los datos abiertos pueden jugar un papel fundamental, ya que permiten que gobiernos, organizaciones y ciudadanos trabajen juntos de manera transparente, y facilitan el proceso hasta llegar a conseguir soluciones eficaces, innovadoras, adaptables y sostenibles.

El Banco Mundial como pionero en el uso integral de los datos abiertos

Uno de los ejemplos de buenas prácticas más relevantes que podemos encontrar a la hora de exprimir el potencial de los datos abiertos para afrontar los grandes desafíos globales es, sin duda, el caso del Banco Mundial, referente en el uso de los datos abiertos desde hace ya más de una década como herramienta fundamental para el desarrollo sostenible.

Desde el lanzamiento de su portal de datos abiertos en 2010, la institución ha llevado a cabo un completo proceso de transformación en cuanto al acceso y uso de los datos. Este portal, totalmente innovador en su día, se convirtió rápidamente en un modelo de referencia al ofrecer acceso libre y gratuito a una amplia gama de datos e indicadores que abarcan más de 250 economías. Además, su plataforma está en constante actualización y poco se parece en el presente a la versión inicial, ya que sigue mejorando continuamente y proporcionando nuevos conjuntos de datos y herramientas complementarias y especializadas con el objetivo de facilitar que los datos estén siempre accesibles y sean útiles para la toma de decisiones. Algunos ejemplos de esas herramientas serían:

- La Poverty and Inequality Platform (PIP): diseñada para monitorizar y analizar la pobreza y la desigualdad a nivel mundial. Con datos de más de 140 países, esta plataforma permite a los usuarios acceder a estadísticas actualizadas y comprender mejor las dinámicas del bienestar colectivo. También facilita la visualización de datos mediante gráficos interactivos y mapas, ayudando a los usuarios a obtener una comprensión clara y rápida de la situación en distintas regiones y a lo largo del tiempo.

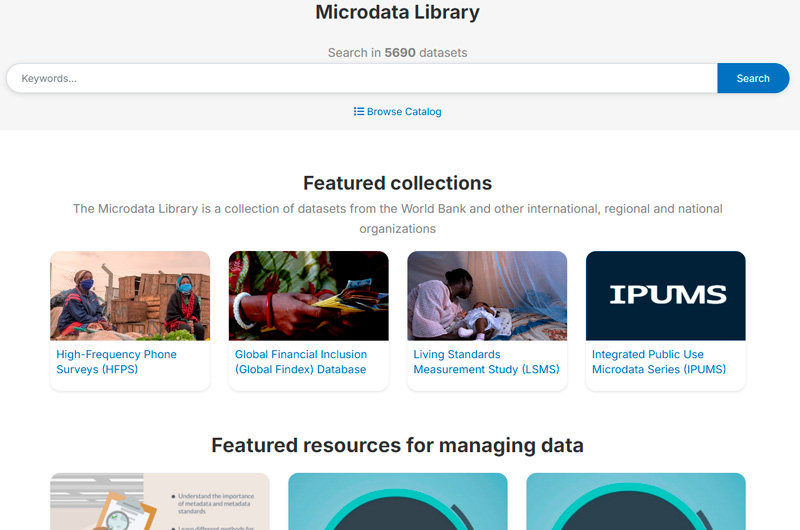

- La Microdata Library: proporciona acceso a datos de encuestas y censos a nivel de hogar y empresa en diversos países. La biblioteca cuenta con más de 3.000 conjuntos de datos provenientes de estudios y encuestas realizadas tanto por el propio Banco, así como de otras organizaciones internacionales y agencias nacionales de estadística. Los datos están disponibles de forma gratuita y son totalmente accesibles para poder ser descargados y analizados.

- Los World Development Indicators (WDI): son una herramienta fundamental para poder seguir el progreso de la agenda de desarrollo global. Esta base de datos contiene una vasta colección de indicadores de desarrollo económico, social y ambiental, abarcando más de 200 países y territorios. Cuenta con datos que cubren áreas como pobreza, educación, salud, sostenibilidad ambiental, infraestructura y comercio. Los WDIs nos proporcionan un marco de referencia de confianza a la hora de analizar tendencias de desarrollo globales y regionales.

Figura 1. Capturas de los portales web Poverty and Inequality Platform (PIP), Microdata Library y World Development Indicators (WDI).

Un hito relevante que ha marcado la forma en la que el Banco Mundial hace uso de los datos ha sido la publicación del informe sobre el Desarrollo Mundial 2021, titulado "datos para mejorar nuestras vidas". Este informe se ha convertido en una publicación emblemática que explora el potencial transformador de los datos para abordar los grandes retos de la humanidad, mejorar los resultados de los esfuerzos invertidos en desarrollo y promover un crecimiento inclusivo y equitativo. A través del informe, la institución aboga por una nueva agenda social para los datos, incluyendo una gobernanza robusta, ética y responsable de los mismos, maximizando su valor para poder generar un beneficio económico y social significativo.

En el informe se examina cómo los datos pueden ser integrados en las políticas públicas y los programas de desarrollo para abordar los desafíos globales en áreas como educación, salud, infraestructuras o el cambio climático. Pero, además, supuso un antes y un después a la hora de reforzar el compromiso del Banco Mundial con los datos como motor de cambio a la hora de afrontar los grandes desafíos, adoptando desde entonces una nueva hoja de ruta con un enfoque del uso de los datos más innovador, transformador y orientado a la acción. Desde ese momento han venido pasando de la teoría a la práctica a través de sus propios proyectos, donde los datos se convierten en una herramienta fundamental durante todo el ciclo estratégico, como en los siguientes ejemplos:

- Datos abiertos y reducción del riesgo de desastres: en el informe "Bienes públicos digitales para la reducción del riesgo de desastres en un clima cambiante" se subraya cómo el acceso abierto a datos geoespaciales y meteorológicos facilita la toma de decisiones y una planificación estratégica más eficaz. También se hace referencia a herramientas como OpenStreetMap que permiten a las comunidades mapear en tiempo real áreas vulnerables. Esta democratización de los datos refuerza la respuesta ante emergencias y fomenta la resiliencia de las comunidades expuestas a los riesgos de inundaciones, sequías y huracanes.

- Datos abiertos ante los retos agroalimentarios: el informe "¿Qué se está cocinando?" muestra cómo los datos abiertos están revolucionando los sistemas agroalimentarios globales, haciéndolos más inclusivos, eficientes y sostenibles. En la agricultura, el acceso a datos abiertos sobre patrones climáticos, calidad del suelo y precios de mercado habilita a los pequeños agricultores para tomar decisiones informadas. Además, las plataformas que ofrecen datos geoespaciales abiertos sirven para fomentar la agricultura de precisión, permitiendo optimizar recursos clave como el agua y los fertilizantes, a la vez que se reducen costes y se minimiza el impacto ambiental.

- Optimización de los sistemas de transporte urbano: en Tanzania, el Banco Mundial ha respaldado un proyecto que utiliza los datos abiertos para mejorar el sistema de transporte público. La rápida urbanización de Dar es Salaam ha provocado una congestión de tráfico considerable en varias zonas, afectando tanto la movilidad urbana como la calidad del aire. Esta iniciativa aborda la congestión del tráfico mediante un sistema de información en tiempo real que mejora la movilidad y reduce el impacto ambiental. Este enfoque, basado en datos abiertos, no solo aumenta la eficiencia del transporte, sino que también contribuye a una mejor calidad de vida para los habitantes de la ciudad.

Predicando con el ejemplo

Por último, y dentro de esta misma visión integral, cabe destacar cómo este organismo internacional cierra el círculo de los datos abiertos a través de su utilización también como herramienta de transparencia y comunicación de sus propias actividades. Es por ello que entre las herramientas de datos destacadas de su catálogo podremos encontrar algunas como:

- Su portal de proyectos y operaciones: una herramienta que ofrece acceso detallado a los proyectos de desarrollo que la institución financia y ejecuta en todo el mundo. Este portal actúa como una ventana a todas sus iniciativas globales, proporcionando información sobre objetivos, financiación, resultados esperados y avances para los miles de proyectos del Banco.

- La plataforma Finances One: en la que centralizan todos sus datos financieros de interés público y los correspondientes a la cartera de proyectos de todas las entidades del grupo. Su objetivo es simplificar la presentación de información financiera, facilitando su análisis y compartición por parte de clientes y socios.

El impacto futuro de los datos abiertos en los grandes desafíos globales

Como hemos visto también anteriormente, la apertura de datos ofrece un potencial inmenso para avanzar en la agenda de desarrollo sostenible y poder así enfrentar los desafíos globales con mayor eficacia. El Banco Mundial ha venido demostrando cómo esta práctica puede evolucionar y adaptarse a los desafíos actuales. Su liderazgo en este ámbito ha servido como modelo para otras instituciones, mostrando el impacto positivo que los datos abiertos pueden tener en el desarrollo sostenible y a la hora de afrontar los grandes desafíos que afectan a la vida de millones de personas en todo el mundo.

No obstante, hay todavía un largo camino por recorrer, ya que es necesario seguir mejorando las políticas de transparencia y acceso a la información para que los datos puedan llegar a beneficiar al conjunto de la sociedad de forma más equitativa. Además, otro desafío clave es fortalecer las capacidades necesarias para maximizar el uso e impacto de estos datos, particularmente en los países en vías de desarrollo. Esto implica no solo ir más allá de facilitar el acceso, sino también trabajar en la alfabetización de datos y en el apoyo a la creación de las herramientas adecuadas que permitan que la información sea utilizada de manera efectiva.

El uso de datos abiertos está consiguiendo que cada vez más actores puedan participar en la creación de soluciones innovadoras y conseguir un cambio real. Todo ello da lugar a una nueva área de trabajo en expansión que, en las manos correctas y con el apoyo adecuado, puede desempeñar un papel crucial en la creación de un futuro más seguro, justo y sostenible para todos. Esperamos que sean muchas las organizaciones que sigan el ejemplo del Banco Mundial y adopten también un enfoque integral en el uso de los datos para afrontar los grandes retos de la humanidad.

Contenido elaborado por Carlos Iglesias, Open data Researcher y consultor, World Wide Web Foundation. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

No hay duda de que los datos se han convertido en el activo estratégico para las organizaciones. Hoy en día, es esencial garantizar que las decisiones están fundamentadas en datos de calidad, independientemente del alineamiento que sigan: analítica de datos, inteligencia artificial o reporting. Sin embargo, asegurar repositorios de datos con altos niveles de calidad no es tarea fácil, dado que en muchos casos los datos provienen de fuentes heterogéneas donde los principios de calidad de datos no se han tenido en cuenta y no se dispone de contexto sobre el dominio.

Para paliar en la medida de lo posible esta casuística, en este artículo, exploraremos una de las bibliotecas más utilizadas en el análisis de datos: Pandas. Vamos a chequear cómo esta biblioteca de Python puede ser una herramienta eficaz para mejorar la calidad de los datos. También repasaremos la relación de alguna de sus funciones con las dimensiones y propiedades de calidad de datos incluidas en la especificación UNE 0081 de calidad de datos, y algunos ejemplos concretos de su aplicación en repositorios de datos con el objetivo de mejorar la calidad de los datos.

Utilizar de Pandas para Data Profiling

Si bien el data profiling y la evaluación de calidad de datos están estrechamente relacionados, sus enfoques son diferentes:

- Data Profiling: es el proceso de análisis exploratorio que se realiza para entender las características fundamentales de los datos, como su estructura, tipos de datos, distribución de valores, y la presencia de valores faltantes o duplicados. El objetivo es obtener una imagen clara de cómo son los datos, sin necesariamente hacer juicios sobre su calidad.

- Evaluación de calidad de datos: implica la aplicación de reglas y estándares predefinidos para determinar si los datos cumplen con ciertos requisitos de calidad, como exactitud, completitud, consistencia, credibilidad o actualidad. En este proceso, se identifican errores y se determinan acciones para corregirlos. Una guía útil para la evaluación de calidad de datos es la especificación UNE 0081.

Consiste en explorar y analizar un conjunto de datos para obtener una comprensión básica de su estructura, contenido y características, antes de realizar un análisis más profundo o una evaluación de la calidad de los datos. El objetivo principal es obtener una visión general de los datos mediante el análisis de la distribución, los tipos de datos, los valores faltantes, las relaciones entre columnas y la detección de posibles anomalías. Pandas dispone de varias funciones para realizar este perfilado de datos.

En resumen, el data profiling es un paso inicial exploratorio que ayuda a preparar el terreno para una evaluación más profunda de la calidad de los datos, proporcionando información esencial para identificar áreas problemáticas y definir las reglas de calidad adecuadas para la evaluación posterior.

¿Qué es Pandas y cómo ayuda a asegurar la calidad de los datos?

Pandas es una de las bibliotecas más populares de Python para la manipulación y análisis de datos. Su capacidad para gestionar grandes volúmenes de información estructurada hace que sea una herramienta poderosa en la detección y corrección de errores en repositorios de datos. Con Pandas, se pueden realizar operaciones complejas de forma eficiente, desde limpieza hasta validación de datos, todas ellas son esenciales para mantener los estándares de calidad. A continuación, se indican algunos ejemplos para mejorar la calidad de los datos en repositorios con Pandas:

-

Detección de valores nulos o inconsistentes: uno de los errores más comunes en los datos son los valores faltantes o inconsistentes. Pandas permite identificar estos valores fácilmente mediante funciones como isnull() o dropna(). Esto es clave para la propiedad de completitud de los registros y la dimensión de consistencia de datos, ya que los valores faltantes en campos críticos pueden distorsionar los resultados de los análisis.

# Identificar valores nulos en un dataframe

df.isnull().sum()

- Normalización y estandarización de datos: los errores en la consistencia de nombres o códigos son comunes en grandes repositorios. Por ejemplo, en un conjunto de datos que contiene códigos de productos, es posible que algunos estén mal escritos o no sigan una convención estándar. Pandas ofrece funciones como merge() para realizar una comparación con una base de datos de referencia y corregir estos valores. Esta opción es clave para mantener la dimensión y propiedad de consistencia semántica de los datos.

# Sustitución de valores incorrectos utilizando una tabla de referencia

df = df.merge(codigos_productos, left_on='codigo_producto', right_on='codigo_ref', how= ‘left’)

- Validación de requisitos de datos: Pandas permite crear reglas personalizadas para validar la conformidad de los datos con ciertas normas. Por ejemplo, si un campo de edad solo debería contener valores enteros positivos, podemos aplicar una función para identificar y corregir valores que no cumplan con esta regla. De esta forma, se puede validar cualquier regla de negocio de cualquiera de las dimensiones y propiedades de calidad de datos.

# Identificar registros con valores de edad no válidos (negativos o decimales)

errores_edad = df[(df['edad'] < 0) | (df['edad'] % 1 != 0)]

- Análisis exploratorio para identificar patrones anómalos: funciones como describe() o groupby() en Pandas permiten explorar el comportamiento general de los datos. Este tipo de análisis es fundamental para detectar patrones anómalos o fuera de rango en cualquier conjunto de datos, como, por ejemplo, valores inusualmente altos o bajos en columnas que deberían seguir ciertos rangos.

# Resumen estadístico de los datos

df.describe()

#Ordenar según categoría o propiedad

df.groupby()

- Eliminación de duplicados: los datos duplicados son un problema común en los repositorios de datos. Pandas ofrece métodos como drop_duplicates() para identificar y eliminar estos registros, asegurando que no haya redundancia en el conjunto de datos. Esta capacidad estaría relacionada con la dimensión de completitud y consistencia.

# Eliminar filas duplicadas

df = df.drop_duplicates()

Ejemplo práctico de aplicación de Pandas

Una vez presentadas las funciones anteriores que nos sirven para mejorar la calidad de los repositorios de datos, planteamos un caso para poner en práctica el proceso. Supongamos que estamos gestionando un repositorio de datos de ciudadanos y queremos asegurarnos de:

- Que los datos de edad no contengan valores no válidos (como negativos o decimales?

- Que los códigos de nacionalidad estén estandarizados.

- Que los identificadores únicos sigan un formato correcto.

- Que el lugar de residencia sea coherente.

Con Pandas, podríamos realizar las siguientes acciones:

1. Validación de edades sin valores incorrectos

# Identificar registros con edades fuera de los rangos permitidos (por ejemplo, menores de 0 o no enteros)

errores_edad = df[(df['edad'] < 0) | (df['edad'] % 1 != 0)]

# Uso de un dataset oficial de códigos de nacionalidad para corregir los registros incorrectos

df_corregida = df.merge(nacionalidades_ref, left_on='nacionalidad', right_on='codigo_ref', how='left')

3. Validación de indentificadores únicos

# Verificar si el formato del número de identificación sigue un patrón correcto

df['valid_id'] = df['identificacion'].str.match(r'^[A-Z0-9]{8}$')

errores_id = df[df['valid_id'] == False]

4. Verificación de coherencia en lugar de residencia

# Detectar posibles inconsistencias en la residencia (por ejemplo, un mismo ciudadano residiendo en dos lugares al mismo tiempo)

duplicados_residencia = df.groupby(['id_ciudadano', 'fecha_residencia'])['lugar_residencia'].nunique()

inconsistencias_residencia = duplicados_residencia[duplicados_residencia > 1]

Integración con diversidad de tecnologías

Pandas es una biblioteca extremadamente flexible y versátil que se integra fácilmente con muchas tecnologías y herramientas en el ecosistema de datos. Algunas de las principales tecnologías con las que Pandas tiene integración o se puede utilizar son:

-

Bases de datos SQL:

Pandas se integra muy bien con bases de datos relacionales como MySQL, PostgreSQL, SQLite, y otras que utilizan SQL. La biblioteca SQLAlchemy o directamente las bibliotecas específicas de cada base de datos (como psycopg2 para PostgreSQL o sqlite3) permiten conectar Pandas a estas bases de datos, realizar consultas y leer/escribir datos entre la base de datos y Pandas.

- Función común: pd.read_sql() para leer una consulta SQL en un DataFrame, y to_sql() para exportar los datos desde Pandas a una tabla SQL.

- APIs basadas en REST y HTTP: