El portal europeo de datos abiertos (data.europa.eu) organiza regularmente sesiones formativas virtuales sobre cuestiones de actualidad en el sector de los datos abiertos, regulaciones que afectan y tecnologías relacionadas. En este post, repasamos las claves del último webinar sobe los conjuntos de datos de alto valor (HVD, por sus siglas en inglés, High Value Datasets)

Entre otras cuestiones, este seminario se centró en transmitir buenas prácticas, así como explicar las experiencias de dos países, Finlandia y Chequia, que formaron parte del informe “High-value Datasets Best Practices in Europe”, publicado por data.europa.eu, junto con Dinamarca, Estonia, Italia, Países Bajos y Rumania. El estudio se realizó inmediatamente después de la publicación del reglamento de implementación de HVDS, en febrero de 2023.

Buenas prácticas ligadas a la puesta a disposición de datos de alto valor

Tras una introducción donde se explicó qué son y qué requisitos tienen que cumplir los datos de alto valor, durante el webinar, se detalló el alcance del informe. Concretamente, se identificaron retos, buenas prácticas y recomendaciones por parte de los estados miembros, como se detalla a continuación.

Marco político y legal

- Existe la necesidad de fomentar una cultura gubernamental prioritariamente práctica y enfocada a objetivos alcanzables, aprovechando valores culturales arraigados en los sistemas gubernamentales, como la transparencia.

- Se recomienda un enfoque estratégico basado en una perspectiva más amplia de la regulación, aprovechando esfuerzos realizados anteriormente para la implementación de directivas trascendentes como INSPIRE o DCAT como estándar para la publicación de datos. En este sentido, es oportuno priorizar acciones que se superponen con estas iniciativas existentes.

- Se recomienda utilizar licencias Creative Commons (CC).

- A nivel transversal, otro de los retos es combinar el cumplimiento de los requisitos de los conjuntos de datos de alto valor con las disposiciones del Reglamento General de Protección de Datos (RGPD), cuando hablamos de datos sensibles o personales.

Gobernanza y procesos

- Se anima a participar en asociaciones estratégicas y fomentar la colaboración a nivel nacional. Entre otras cuestiones se recomienda coordinar esfuerzos entre ministerios, agencias responsables de diferentes categorías de HVD y otros actores relacionados, especialmente en los Estados miembros con estructuras de gobernanza descentralizadas. Para ello, es relevante crear grupos de trabajo interdisciplinarios que faciliten la realización de un inventario de datos completo y aclaren qué agencia es responsable de cada conjunto de datos. Estos grupos permitirán compartir conocimiento y fomentar un sentido de comunidad y responsabilidad compartida, lo que contribuye al éxito general de los esfuerzos de gobernanza de datos.

- Se recomienda participar en intercambios periódicos con otros Estados miembros, para compartir ideas y soluciones a desafíos comunes.

- Es necesario promover la sostenibilidad a través de la responsabilidad individual de las agencias por sus respectivos conjuntos de datos. Garantizar la sostenibilidad de los portales nacionales de datos significa asegurarse de que los metadatos se mantengan con los recursos disponibles.

- Se aconseja desarrollar un marco integral de gobernanza de datos evaluando primero los recursos disponibles, incluida la experiencia técnica, las herramientas de gestión de datos y los aportes clave de las partes interesadas. Este proceso de evaluación permite una comprensión clara de las reglas, procesos y responsabilidades necesarias para una implementación efectiva de la gobernanza de datos.

Aspectos técnicos, calidad de los metadatos y nuevos requisitos

- Se propone desarrollar una comprensión integral de los requisitos específicos para los HVD. Esto implica identificar conjuntos de datos existentes para determinar su cumplimiento con los estándares descritos en el reglamento de implementación para los HVD. Es necesario constituir una base sistémica para identificar, mejorar la calidad y disponibilidad de los datos potenciando el valor general de los conjuntos de datos de alto valor.

- Se recomienda mejorar la calidad de los metadatos directamente en la fuente de datos antes de publicarlos en portales, siguiendo las pautas de publicación de conjuntos de datos de alto valor del DCAT-AP y los vocabularios controlados para las seis categorías de HVD. También es necesario mejorar la implementación de API y descargas masivas desde cada origen de datos. Su implementación presenta desafíos importantes debido a la escasez de recursos y experiencia, por lo que resulta imprescindible el fortalecimiento de capacidades y la dotación de recursos.

- Se sugiere fortalecer la disponibilidad de conjuntos de datos de alto valor a través de financiación externa o planificación estratégica. El reglamento exige que todos los HVD sean accesibles de forma gratuita por lo que algunos Estados miembros diversifican las fuentes de financiación buscando apoyo financiero por medio de vías externas, por ejemplo, aprovechando proyectos europeos. En este sentido, se recomienda adaptar los modelos de negocio progresivamente para ofrecer datos gratuitos.

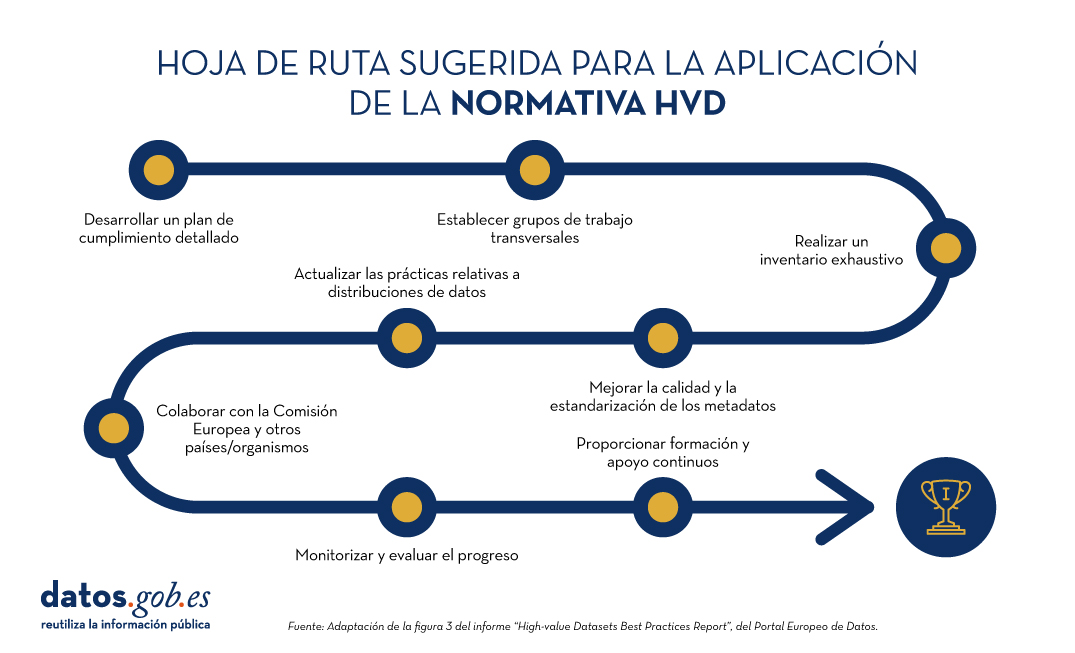

Por último, el informe destaca una hoja de ruta de cumplimiento del reglamento de implementación de HVD, sugerida en base a ocho pasos:

Figura 1: Hoja de ruta sugerida para la aplicación de la normativa HVD. Adaptación de la figura 3 del informe “High-value Datasets Best Practices Report”, del Portal Europeo de Datos.

El ejemplo de la República Checa

En una segunda parte del webinar, República Checa presentó su caso de implementación, que están abordando desde cuatro tareas principales: motivación, implementación regulatoria, responsabilidad de las agencias públicas proveedoras de datos y requerimientos técnicos.

- La motivación entre los diferentes agentes se está articulando a través de la constitución de grupos de trabajo.

- La implementación regulatoria se concentra en el análisis de datasets y la consistencia o inconsistencia con INSPIRE.

- Para impulsar la responsabilidad de las agencias públicas, se están llevando a cabo seminarios para compartir conocimiento en torno a la vinculación entre INSPIRE y HVD utilizando como vía de publicación el estándar DCAT-AP.

- Respecto a los requerimientos técnicos, se están integrando los requisitos de DCAT-AP e INSPIRE en las prácticas de metadatos adaptadas a su contexto nacional. Chequia ha desarrollado especificaciones para catálogos locales de datos abiertos, con el fin de garantizar la compatibilidad con el Catálogo Nacional de Datos Abiertos. No obstante, su mayor reto es una fuerte dependencia derivada de la falta de capacidades técnicas.

El ejemplo de Finlandia

A continuación, tomó la palabra Finlandia. Al contar con una legislación preexistente (INSPIRE y otras normas específicas sobre apertura de datos y gestión de información en administraciones públicas), Finlandia requirió solo ajustes menores para alinearse con la transposición nacional de la directiva de los HVD. El reto está en entender y hacer coexistir INSPIRE y los HVD.

Su estrategia principal se basa en el mapa sobre gestión de información en administraciones públicas, que asegura la armonización, interoperabilidad, gestión de alta calidad y seguridad para implementar los principios de apertura de datos. Además, han establecido dos grupos de trabajo para abordar la implementación de HVD:

- El primer grupo, que es un grupo coordinador de promotores de datos, se centró en cuestiones prácticas y técnicas. Como expertos legales, también brindaron orientación para comprender la regulación HVD desde una perspectiva legal.

- El segundo grupo, un grupo de coordinación interministerial, es un grupo de trabajo que garantiza que no haya conflictos ni superposiciones entre la regulación HVD y la legislación nacional. Este grupo administra el inventario, en formato hoja de cálculo, que contiene todos los elementos necesarios para un catálogo de HVD. Al identificar áreas donde los conjuntos de datos no cumplen con estos requisitos, las organizaciones pueden establecer una hoja de ruta para abordar las brechas y garantizar el cumplimiento total a lo largo del tiempo.

El secretariado de los grupos recae en un comité de datos geoespaciales. Ambos cuentan con una amplia red de partes interesadas para articular la discusión y el feedback de las medidas adoptadas.

De cara a futuro, destacan como reto la necesidad de ir alcanzando mayor experiencia técnica y a nivel ejecutivo.

Fin de la sesión

El webinar continuó con la participación de la empresa Compass Gruppe (Alemania) que comercializa, entre otros, datos procedentes del registro mercantil de Austria. Disponen de un portal que ofrece dichos datos vía API a través de un modelo de negocio freemium.

Además, se recordó la obligación que tienen los Estados miembros de reportar a Europa cada dos años los avances en HVD, una actividad con la que se espera impulsar la disponibilidad de metadatos armonizados federados sobre el portal europeo de datos. La idea es que los usuarios puedan encontrar todos los HVD de la Unión Europea, utilizando el filtrado disponible en el portal o a través de consultas SPARQL.

La combinación de las conclusiones del informe y las experiencias de los países ponentes, nos dan buenas pistas para orientar la implementación de los HVD, cumpliendo con la normativa europea. En resumen, la implementación de los HVD plantea los siguientes desafíos:

- Respaldar con la financiación necesaria el abordaje del proceso de apertura.

- Superar los retos técnicos para desarrollar accesos eficientes (API).

- Lograr una correcta convivencia entre INSPIRE y el reglamento de HVD.

- Consolidar grupos de trabajo que funcionen como un mecanismo robusto de avance y convergencia.

- Monitorizar los avances y realizar un seguimiento continuo del proceso.

- Invertir en la capacitación técnica del personal.

- Crear y mantener una fuerte coordinación ante la diversidad compleja de data holders.

- Potencial el aseguramiento de la calidad de los conjuntos de datos de alto valor.

- Acordar una estandarización necesaria desde el punto de vista empresarial.

Dando respuesta a estos retos, conseguiremos una apertura exitosa de los datos de alto valor, impulsando su reutilización en beneficio de toda la sociedad.

Puedes volver a ver la grabación de la sesión aquí

El activismo de datos es una práctica ciudadana cada vez más significativa en la era de las plataformas por su creciente contribución a la democracia, la justicia social y los derechos. Se trata de un activismo que utiliza los datos y su análisis para generar evidencias y visualizaciones con el objetivo de revelar injusticias, mejorar la vida de las personas y fomentar el cambio social.

Frente al uso masivo de datos de vigilancia por parte de determinadas corporaciones, el activismo de datos es ejercido por la ciudadanía y organizaciones no gubernamentales. Por ejemplo, la organización Forensic Architecture (FA), un centro de Goldsmiths dependiente de la Universidad de Londres, investiga violaciones de derechos humanos, incluidas las violencias de Estado, usando datos públicos, ciudadanos y satelitales, y metodologías como la inteligencia de fuentes abiertas (conocida como OSINT). El análisis de datos y metadatos, la sincronización de vídeos tomados por testigos o periodistas, así como de grabaciones y documentos oficiales, permiten reconstruir los hechos y generar un relato alternativo acerca de eventos y crisis.

El activismo de datos ha suscitado el interés de centros de investigación y organizaciones no gubernamentales, generando una línea de trabajo dentro de la disciplina de los estudios críticos. Esto ha permitido reflexionar sobre el efecto de los datos, las plataformas y sus algoritmos en nuestras vidas, así como acerca del empoderamiento que se genera cuando la ciudadanía ejerce su derecho a los datos y los usa para el bien común.

Imagen 1: Ecocidio en Indonesia (2015)

Fuente: Forensic Architecture (https://forensic-architecture.org/investigation/ecocide-in-indonesia)

Centros de investigación como Datactive o Data + Feminism Lab han creado teoría y debates sobre la práctica del activismo de datos. Asimismo, organizaciones como Algorights –una red colaborativa que fomenta la participación de la sociedad civil en el campo de las tecnologías de IA- y AlgorithmWatch -organización de derechos humanos- generan conocimiento, redes y argumentos para luchar por un mundo donde los algoritmos y la Inteligencia Artificial (IA)contribuyan a la justicia, la democracia y la sostenibilidad, en vez de debilitarlas.

Este artículo revisa cómo surgió el activismo de datos, qué interés ha suscitado en la ciencia social y su relevancia en la era de las plataformas.

Historia de una práctica

La producción de mapas usando datos ciudadanos podría ser de las primeras manifestaciones del activismo de datos tal y como se conoce ahora. Un mapa fundamental en la historia del activismo de datos fue el generado por víctimas y activistas con datos sobre el terremoto de Haití en 2010, sobre la plataforma keniata Ushahidi (“testimonio”, en Suajili). Una comunidad de humanitaristas digitales creó el mapa desde otros países y convocó a las víctimas y a sus familiares y conocidos para que compartieran datos de lo que estaba ocurriendo en tiempo real. En cuestión de pocas horas, los datos se verificaron y se visualizaron en un mapa interactivo que continuó actualizándose con más datos, y que fue decisivo a la hora de asistir a las víctimas en el terreno. Hoy en día se generan mapas de este tipo cada vez que surge una crisis, y se enriquecen con datos ciudadanos, satelitales y generados por drones dotados de cámaras para esclarecer hechos y generar evidencias.

Emergiendo de movimientos conocidos como cypherpunk y el tecnopositivismo o tecnoptimismo (basado en la confianza en que la tecnología es la respuesta a los retos de la humanidad), el activismo de datos ha ido evolucionando como práctica para adoptar posturas más críticas frente a la tecnología y a las asimetrías de poder que surgen entre quienes originan y ceden sus datos, y quienes los captan y analizan.

Hoy día, por ejemplo, la plataforma de producción de mapas comunitarios Ushahidi se ha empleado para crear datos sobre la violencia machista en Egipto y en Siria, y sobre ginecólogos confiables en India, por ejemplo. Actualmente, la invisibilización y el silenciamiento de las mujeres es la razón por la cual algunas organizaciones luchan por el reconocimiento y una política de visibilidad, algo que se hizo evidente con el movimiento #MeToo (#Cuéntalo en español). Las prácticas de datos feministas buscan visibilidad e interpretaciones críticas de la datificación (o la transformación de toda acción humana y no humana en datos mesurables y transformables en valor). Por ejemplo, Datos Contra el Feminicidio o Feminicidio.net ofrecen mapas y análisis de datos sobre el feminicidio en varios lugares del mundo.

El potencial para el empoderamiento algorítmico que ofrecen estos proyectos elimina las barreras a la igualdad, mejorando las condiciones que permiten a las mujeres resolver problemas, determinar cómo se recaban y se usan los datos y ejercer el poder.

Nacimiento y evolución de un concepto

En 2015 se publicó Los medios ciudadanos se encuentran con los grandes datos: el surgimiento del activismo de datos, en el que, por primera vez, se acuñaba y definía el activismo de datos como un concepto basado en prácticas observadas en activistas que se involucran políticamente con la infraestructura de datos. La infraestructura de datos incluye los datos, el software, el hardware y los procesos necesarios para convertir los datos en valor. Más adelante, Data activism and social change (London, Palgrave) y Activismo de datos y cambio social. Alianzas, mapas, plataformas y acción para un mundo mejor (Madrid: Dykinson) desarrollan marcos analíticos basados en casos reales que ofrecen formas de analizar otros casos.

Acompañando las variadas prácticas que existen dentro de activismo de datos, su estudio está creando espacios para la investigación feminista y postcolonialista sobre las consecuencias de la datificación. Mientras que los cronistas de la historia (principalmente fuentes masculinas) definieron la tecnología en relación con el valor sus productos, los estudios de datos feministas consideran a las mujeres como usuarias y diseñadoras de sistemas algorítmicos y buscan utilizar los datos para la igualdad, y alejarse de la explotación capitalista y sus estructuras de dominación.

El activismo de datos es hoy un concepto establecido en la ciencia social. Por ejemplo, Google Scholar ofrece más de 2.000 resultados sobre “data activism”. Varios investigadores e investigadoras lo emplean como perspectiva para analizar diversos asuntos. Por ejemplo, Rajão y Jarke exploran el activismo ambiental en Brasil; Gezgin estudia la ciudadanía crítica y el uso que hace esta de la infraestructura de datos; Lehtiniemi y Haapoja explora la agencia de datos y la participación ciudadana; y Scott examina la necesidad de los usuarios y usuarias de plataformas de desarrollar una vigilancia digital y cuidar de sus datos personales.

En el centro de estas preocupaciones se encuentra el concepto de agencia de datos, que se refiere a que las personas no sólo son conscientes del valor de sus datos, sino que también ejercen control sobre ellos, determinando cómo se usan y comparten. Se podría definir como acciones y prácticas relacionadas con la infraestructura de datos basadas en la reflexión y el interés individual y colectivo. Es decir, mientras darle un like a un post no se consideraría una acción con un alto grado de agencia de datos, participar en un hackaton –un evento colectivo en el que se mejora un programa informático o se crea— sí lo sería. La agencia de datos se basa en la alfabetización en datos, o el grado de conocimientos, acceso a los datos y a sus herramientas, y a las oportunidades para ejercerla que tienen las personas. El activismo de datos no es posible sin agencia de datos.

En el panorama en rápida evolución de la economía de plataformas, la convergencia del activismo de datos, los derechos digitales y la agencia de datos se ha vuelto crucial. El activismo de datos, impulsado por una creciente conciencia del posible uso indebido de los datos personales, alienta a individuos y colectivos a utilizar la tecnología digital para el cambio social, así como a abogar por una mayor transparencia y responsabilidad por parte de las gigantes tecnológicas. Dado que cada vez más la generación de datos y el uso de algoritmos determinan nuestras vidas en áreas como la educación, el empleo, los servicios sociales y la salud, el activismo de datos emerge como una necesidad y un derecho, más que como una opción.

____________________________________________________________________________

Contenido elaborado por Miren Gutiérrez, Doctora e investigadora en la Universidad de Deusto, experta en activismo de datos, justicia de datos, alfabetización de datos y desinformación de género.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor

El Estudio de Madurez de Datos Abiertos 2022 nos ofrece una visión del nivel de desarrollo de las políticas que promueven los datos abiertos en los países, así como una evaluación del impacto esperado de las mismas. Entre sus hallazgos destaca que la medición del impacto de los datos abiertos es una prioridad, pero también un gran desafío en toda Europa.

En esta edición se ha registrado una disminución del 7% en el nivel de madurez promedio en la dimensión de impacto para los países de UE27 que coincide con la reestructuración de los indicadores de la dimensión impacto. Sin embargo, no se puede considerar tanto una disminución en el nivel de madurez, sino una imagen más precisa de la dificultad en evaluar el impacto resultante de la reutilización de los datos abiertos.

Es por ello, que con el fin de comprender mejor cómo progresar en el desafío de medir el impacto de los datos abiertos, hemos analizado las mejores prácticas existentes para la medición del impacto de los datos abiertos en Europa. Para conseguir este objetivo se ha trabajado con los datos proporcionados por los países en las respuestas al cuestionario del estudio y en particular con las de los once países que han tenido una puntuación superior a los 500 puntos en la dimensión de Impacto, independientemente de su puntuación global y de su posición en el ranking: Francia, Irlanda, Chipre, Estonia y República Checa que obtienen la máxima puntuación de 600 puntos; y Polonia, España, Italia, Dinamarca y Suecia que puntuaron por encima de los 510 puntos.

En el informe proporcionamos un perfil de cada uno de los diez países en el que se analizan de forma general los resultados del país en todas las dimensiones del estudio y de forma detallada los diferentes componentes de la dimensión impacto en la que resumen las prácticas que han llevado a su alta puntuación a partir del análisis de las respuestas al cuestionario.

A través de esta estructura de fichas el documento permite una comparación directa entre los indicadores de los países y ofrece una visión detallada de las mejores prácticas y los desafíos en el uso de datos abiertos en lo que se refiere a la medición del impacto a través de los siguientes indicadores:

-

“Conciencia estratégica”: Cuantifica la conciencia y preparación de los países para entender el nivel de reutilización y el impacto de los datos abiertos dentro de su territorio.

-

“Midiendo la reutilización”: Se centra en cómo los países miden la reutilización de datos abiertos y en qué métodos utilizan.

-

“Impacto creado”: Recopila datos sobre el impacto creado dentro de cuatro áreas de impacto: impacto gubernamental (anteriormente impacto político), impacto social, impacto ambiental e impacto económico.

Para finalizar el informe proporciona un análisis comparativo de estos países y extrae una serie de recomendaciones y buenas prácticas que tienen como objetivo de proporcionar ideas sobre cómo mejorar el impacto de la apertura de datos en cada uno de los tres indicadores medidos en el estudio.

Si quieres saber más sobre el contenido de este informe, puedes ver la entrevista a su autor.

A continuación, puedes descargar el informe completo, el resumen ejecutivo y una presentación-resumen.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La Oficina del Dato elabora dos guías de ayuda para la concepción eficaz de espacios de datos

El concepto de espacio de datos, entendido como un ecosistema de compartición voluntaria de datos en un entorno de confianza, seguridad y soberanía, se va a desplegar con todo su potencial a lo largo de los próximos años, como apuesta clave de la Unión Europea para impulsar la economía del dato y preservar su soberanía digital. Dichos espacios se construyen alrededor de casos de uso concretos de compartición y explotación de datos donde satisfacer necesidades de negocio concretas, un proceso para el que no resulta sencillo descubrir dichas necesidades, ni su óptimo diseño, al estar presentes diversas consideraciones y áreas de conocimiento.

Para rebajar las barreras de entrada ligadas a su concepción, la Oficina del Dato, dependiente de la Secretaría de Estado de Digitalización e Inteligencia Artificial, ejerciendo su función de dinamizar el gobierno, gestión, compartición y el uso de datos, ha publicado sendas guías que facilitarán la puesta en marcha de casos de uso de compartición de datos: la Guía de evaluación de viabilidad de casos de uso y la Guía de diseño de casos de uso.

Ambos documentos tienen como objetivo ayudar a los potenciales creadores de espacios de datos a superar los desafíos propios de la puesta en marcha de un caso de uso de compartición de datos. En este sentido, las guías orientan paso a paso y en las sucesivas etapas del proceso, proporcionando plantillas con preguntas concretas a las diferentes situaciones que se irán presentando en su diseño. El uso de estas guías debe entenderse de forma iterativa, permitiendo un proceso de refinamiento; así, una vez establecida la viabilidad de un determinado escenario, se abordará su diseño detallado, en un proceso en el que la propia dinámica puede llevar a provocar un replanteamiento de la etapa original de viabilidad. De igual forma, las preguntas presentes en cada paso pueden provocar matizaciones en los pasos anteriores, permitiendo en todo momento una progresiva mejora.

Las guías tienen como origen el contenido de los trabajos realizados desde la iniciativa Data Sharing Coalition. Trabajos en los que, compartiendo experiencia y conocimiento, las organizaciones abordaron el desafío que supuso iniciar el camino de crear en la práctica casos de uso de compartición y explotación de datos. Tomando como base esta referencia, las guías que aquí presentamos han ido evolucionando y han sido particularizadas para el contexto español, siendo enriquecidas igualmente con las aportaciones de los participantes a los eventos de dinamización de espacios de datos organizados por la Oficina del Dato.

Guía de evaluación de viabilidad de casos de uso

La Guía de evaluación de viabilidad de casos de uso permite generar, describir y evaluar ideas de casos de uso escalables de compartición de datos. Con el objetivo final de tomar una decisión acerca de la viabilidad del escenario propuesto, la guía plantea una metodología estructurada a lo largo de cinco pasos: generación del caso de uso, definición de su alcance, evaluación del potencial, estudio de la complejidad de la interacción y toma de decisión final de viabilidad.

Guía de diseño de casos de uso

Una vez abordada la viabilidad del escenario planteado, y si ésta se estimase afirmativa, la Guía de diseño de casos de uso ofrece el soporte necesario para su puesta en marcha. En este punto, se incide tanto en su escalabilidad como en la reutilización de los datos más allá del ámbito inicial. A la hora de diseñar de forma óptima un caso de uso de intercambio y explotación de datos, creemos que las cuestiones de implementación técnica representan tan sólo uno de los factores a tomar en cuenta, resaltando también la criticidad de consideraciones tales como su gobernanza, el modelo de negocio, la experiencia de usuario y los diversos aspectos regulatorios sobre los que se articula y opera.

La Guía, a lo largo de diferentes etapas, aborda la definición detallada del caso de uso, fijando el objetivo y alcance, identificando las funcionalidades que permiten habilitar la compartición de datos, y detallando qué habilitadores permiten el desarrollo de dichas funcionalidades. Gracias al enfoque práctico de la guía, en ella se incluyen útiles plantillas de preguntas-clave que permiten descubrir fácilmente los diversos aspectos a considerar, abordando temas como los principios rectores del caso de uso, el modelo de iteración, los componentes funcionales, las reglas y regulaciones, los contratos, la privacidad, la gestión de la información y los riesgos, las herramientas de apoyo, o incluso los acuerdos de nivel de servicio o la planificación del proyecto.

Los documentos base de ambas guías, las plantillas de preguntas en formato de hoja de cálculo para facilitar su cumplimentación, así como un ejemplo relativo a la viabilidad del proyecto “Caminos de pasión” facilitado por la Fundación Santa María la Real, se encuentran disponibles a través de los siguientes enlaces.

La Asociación Multisectorial de la Información (ASEDIE), que reúne a las empresas infomediarias de nuestro país, vuelve a incluir entre sus objetivos anuales la promoción de la reutilización de información pública y privada.

Así y casi de forma paralela a la entrada del nuevo año, el pasado mes de diciembre, ASEDIE compartía los avances que ha experimentado el top 3 en la mayor parte de las comunidades autónomas, y las buenas expectativas que hay puestas en la segunda edición.

Desde que el pasado 2019 se lanzase esta iniciativa para promover la apertura de tres conjuntos de datos por parte de las comunidades autónomas, estas han ido poco a poco abriendo conjuntos de datos que han permitido mejorar el acceso a las fuentes informativas, a la par que están contribuyendo a impulsar el desarrollo de servicios y aplicaciones a partir de datos abiertos.

El objetivo de este proyecto, que en el año 2021 fue recogido como compromiso de Buenas Prácticas en el Observatorio del IV Plan de Gobierno Abierto y apoyado por las diecisiete Comunidades Autónomas, es armonizar la apertura de bases de datos del Sector Público con el ánimo de favorecer su reutilización, impulsando el desarrollo de la economía del dato.

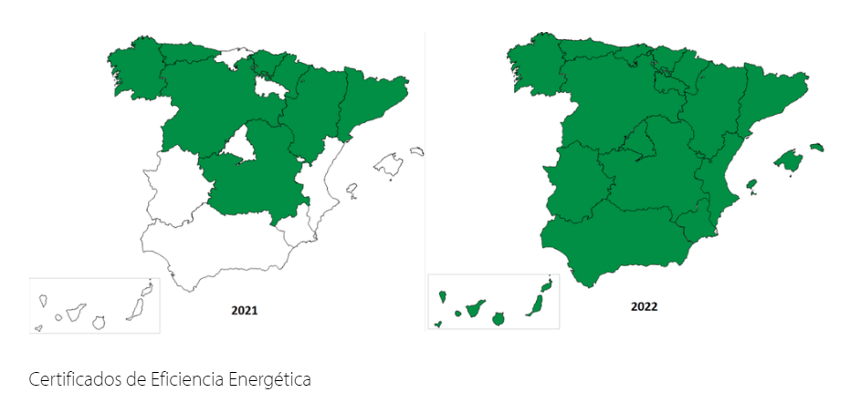

Primera edición: accesible en quince comunidades autónomas

La primera edición del Top 3 de Asedie fue todo un éxito no solo por los conjuntos de datos seleccionados, sino también por el ratio de apertura logrado cuatro años después. Actualmente, quince de las diecisiete comunidades autónomas de nuestro país han logrado abrir a todos los públicos las tres bases de datos: cooperativas, fundaciones y asociaciones.

2023: el año para completar la apertura de la segunda edición

Con la finalidad de continuar fomentando la apertura de información pública en las distintas autonomías, en 2020, ASEDIE lanzó una nueva edición del top 3 para que aquellas comunidades que ya habían superado el reto anterior pudiesen seguir avanzando. Así, para esta segunda edición las bases de datos seleccionadas fueron las siguientes:

- Certificados de Eficiencia Energética

- Polígonos Industriales

- Sociedades Agrarias de Transformación

Como resultado, la segunda edición del top 3 ya es accesible en siete comunidades autónomas. Es más, las bases de datos relativas a los certificados de eficiencia energética, una información cada vez más requerida a nivel europeo, ya están disponibles en abierto en todas las comunidades autónomas de la geografía española.

Próximos pasos: ampliar el compromiso por la apertura de datos

Como no podía ser de otra forma, uno de los principales objetivos anuales de ASEDIE es continuar impulsando la colaboración autonómica para poder completar la apertura de la segunda edición del top 3 en el resto de comunidades autónomas.

De forma paralela, la próxima edición del Informe ASEDIE, se hará pública el próximo 22 de marzo, aprovechando la Semana de la Administración Abierta. Al igual que en otras ocasiones, este documento servirá para hacer balance de los hitos conseguidos en el ejercicio anterior, así como para enumerar los nuevos retos.

De hecho, en relación a los datos abiertos, el informe ASEDIE es una herramienta muy útil a la hora de ampliar conocimientos en este área de expertise ya que incluye una relación de casos de éxito de empresas infomediarias y ejemplos de los productos y servicios que elaboran.

En resumen, gracias a iniciativas como las desarrolladas por ASEDIE, cada vez es más constante y tangible la colaboración público-privada, al facilitar que las empresas puedan reutilizar la información pública de una manera más sencilla.

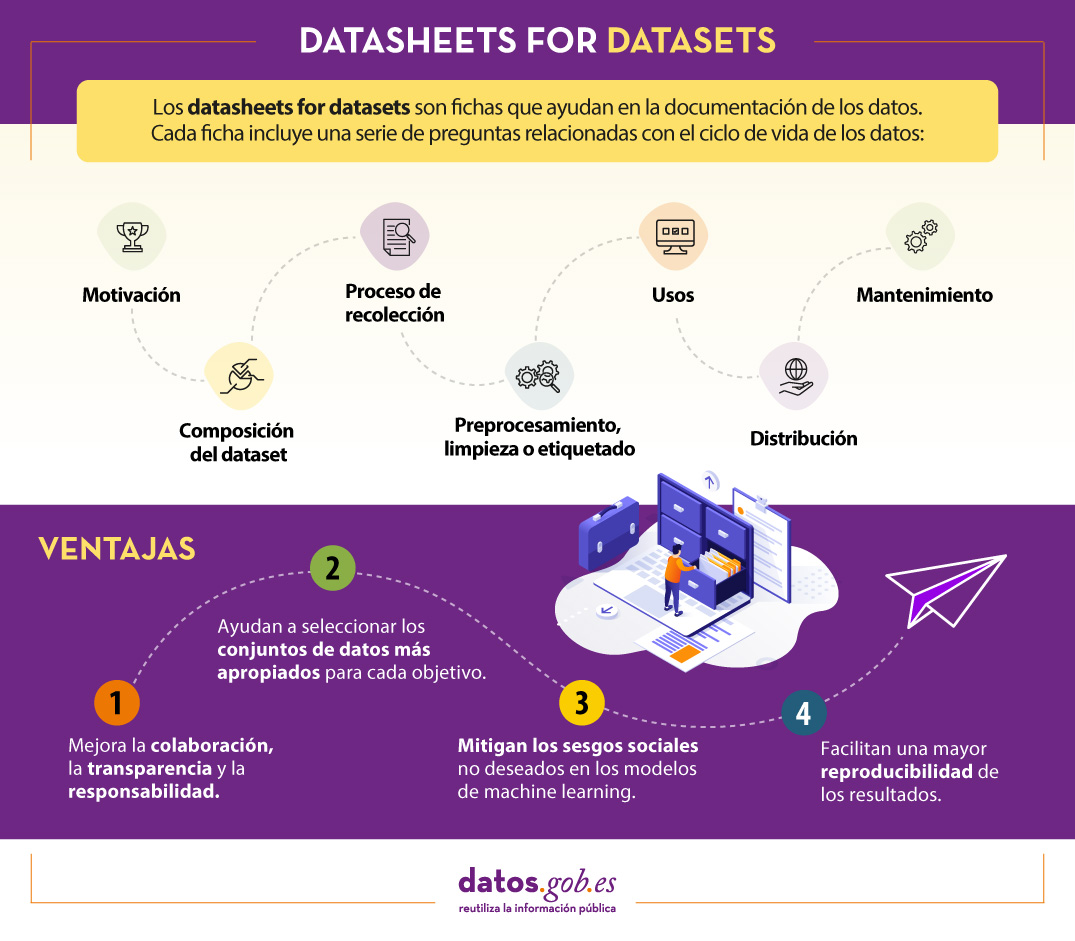

16.500 millones de euros. Esos son los ingresos que se estima generarán la inteligencia artificial (IA) y los datos en la industria española para 2025, según se avanzó el pasado febrero en el foro de IndesIA, la asociación para la aplicación de la inteligencia artificial en la industria. La IA ya forma parte de nuestro día a día: ya sea haciendo más sencillo nuestro trabajo al realizar tareas rutinarias y repetitivas, o bien complementando las capacidades humanas en diversos ámbitos a través de modelos de aprendizaje automático que facilitan, por ejemplo, el reconocimiento de imágenes, la traducción automática o la predicción de diagnósticos médicos. Todas ellas, actividades que nos ayudan a mejorar la eficiencia de negocios y servicios, impulsando una toma de decisiones más certera.

Pero para que los modelos de aprendizaje automático (también conocidos por el término en inglés machine learning) funcionen correctamente, se necesitan datos de calidad y bien documentados. Todo modelo de aprendizaje automático se entrena y evalúa con datos. Las características de estos conjuntos de datos condicionan el comportamiento del modelo. Por ejemplo, si los datos de entrenamiento reflejan sesgos sociales no deseados es probable que estos también se incorporen en el modelo, lo cual puede tener graves consecuencias cuando se utiliza en ámbitos de gran importancia, como la justicia penal, la contratación de personas o el préstamo de créditos. Además, si no conocemos el contexto de los datos, puede que nuestro modelo no funcione correctamente, ya que en su proceso de construcción no se han tenido en cuenta las características intrínsecas de los datos sobre los cuales se sustenta.

Por estas y otras razones, el Foro Económico Mundial sugiere que todas las entidades deben documentar la procedencia, la creación y el uso de los conjuntos de datos de aprendizaje automático con el fin de evitar resultados erróneos o discriminatorios.

¿Qué son Datasheets for datasets?

Un mecanismo para documentar esta información son las conocidas como Datasheets for datasets. Este marco de trabajo propone que todo conjunto de datos debe ser acompañado de una “ficha de datos”, llamada datasheet, que consiste de un cuestionario que guía en la documentación de los datos y la reflexión a lo largo del ciclo de vida de los datos. Algunas de las ventajas que supone son:

- Mejora la colaboración, la transparencia y la responsabilidad dentro de la comunidad de aprendizaje automático.

- Mitiga los sesgos sociales no deseados en los modelos.

- Ayuda a los investigadores y desarrolladores a seleccionar los conjuntos de datos más apropiados para alcanzar sus objetivos específicos.

- Facilita una mayor reproducibilidad de los resultados.

Los datasheets variarán dependiendo de factores tales como el área de conocimiento, la infraestructura organizacional existente o los flujos de trabajo.

Para ayudar en la creación de las datasheet, se ha diseñado un cuestionario con una serie de preguntas, acordes a las etapas del ciclo de vida de los datos:

- Motivación. Recoge las razones que han llevado a la creación de los conjuntos de datos. También se pregunta sobre quién creó o financió dichos datasets.

- Composición. Ofrece a los usuarios la información necesaria sobre la adecuación del conjunto de datos a sus objetivos. Incluye, entre otras preguntas, qué unidades de observación representan el conjunto de datos (documentos, fotos, personas, países), qué tipo de información ofrece cada unidad o si hay errores, fuentes de ruido o redundancias en él. Reflexiona acerca de los datos que se refieren a personas para evitar posibles sesgos sociales o violaciones a la privacidad.

- Proceso de recolección. Su objetivo es ayudar a los investigadores y usuarios a pensar en cómo crear conjuntos de datos alternativos con similares características. Aquí se detalla, por ejemplo, cómo se adquirieron los datos, quién participó en el proceso de recopilación o cómo fue el proceso de revisión ética. Trata especialmente los aspectos éticos del procesamiento de datos protegidos por la RGPD.

- Preprocesamiento, limpieza o etiquetado. Gracias a estas preguntas, los usuarios de datos podrán determinar si estos han sido procesados de formas compatibles con los usos que les pretenden dar. Indaga sobre si se realizó algún preprocesamiento, limpieza o etiquetado de los datos, o si está disponible el software que se utilizó para preprocesarlos, limpiarlos y etiquetarlos.

- Usos. Esta sección proporciona información sobre aquellas tareas para las cuales los datos pueden o no pueden ser usados. Para ello, se debe responder a preguntas como: ¿El conjunto de datos ya ha sido usado para alguna tarea? ¿Para qué otras tareas pueden ser utilizados? ¿La composición del conjunto de datos o la forma en que se recopiló, preprocesó, limpió y etiquetó puede afectar a otros usos futuros?

- Distribución. Recoge cómo se difundirá el conjunto de datos. Las preguntas se centran en si los datos se distribuirán a terceros y, en caso afirmativo, cómo, cuándo, cuáles son las restricciones de uso y bajo qué licencias.

- Mantenimiento. El cuestionario finaliza con preguntas dirigidas a planificar el mantenimiento de los datos y comunicar el plan a los usuarios de los datos. Por ejemplo, se responde a si se actualizará el conjunto de datos o quién dará soporte.

Se recomienda que todas las preguntas sean tenidas en cuenta antes de la recolección de los datos, para que sus creadores puedan ser conscientes de los posibles problemas. Para ilustrar cómo se podría responder a cada una de ellas en la práctica, los creadores del modelo han elaborado un apéndice con un ejemplo para un conjunto de datos determinado.

¿Es efectivo Datasheets for datasets?

El marco para documentar los datos Datasheets for datasets ha recibido inicialmente buenas críticas, pero su implementación continúa acarreando diversos retos, sobre todo cuando se trabaja con datos dinámicos.

Para conocer si el marco resuelve de forma efectiva las necesidades de documentación de los creadores y los usuarios de los datos, en junio del 2022, Microsoft USA y la Universidad de Michigan llevaron a cabo un estudio sobre su implementación. Para ello realizaron una serie de entrevistas y un seguimiento de la aplicación del cuestionario por parte de varios profesionales del aprendizaje automático.

En resumen, los participantes expresaron la necesidad de que los marcos de documentación sean adaptables a los diferentes contextos, se integren en las herramientas existentes y en los flujos de trabajo, y que sean tan automatizados como sea posible, debido en parte a la extensión de las preguntas. No obstante, también resaltaron sus ventajas, como, por ejemplo, que reduce el riesgo de pérdida de información, promueve la colaboración entre todos los que participan en el ciclo de vida de los datos, facilita el descubrimiento de los datos o impulsa el pensamiento crítico, entre otras.

En definitiva, nos encontramos ante un buen punto de partida, pero que deberá evolucionar, sobre todo para adaptarse a las necesidades de los datos dinámicos y a los flujos de documentación aplicados en diferentes contextos.

Contenido elaborado por el equipo de datos.gob.es.

A la hora de publicar datos abiertos, es fundamental garantizar su calidad. Si los datos están bien documentados y cuentan con la calidad necesaria, será más fácil su reutilización, ya que serán menores los trabajos adicionales de depuración y procesamiento. Además, la baja calidad de los datos puede suponer un coste para los publicadores, que pueden llegar a gastar más dinero en solucionar los errores que en evitar con antelación los potenciales problemas.

Para ayudar en esta tarea, en el marco de la Iniciativa Aporta se ha elaborado la “Guía práctica para la mejora de la calidad de datos abiertos”, que proporciona un compendio de directrices para actuar sobre cada una de las características que definen la calidad, impulsando su mejora. El documento toma como referente la guía para la calidad de datos de data.europe.eu, publicada en 2021 por la Oficina de Publicaciones de la Unión Europea.

¿A quién está dirigida la guía?

La guía está dirigida a publicadores de datos abiertos, a quienes proporciona una serie de pautas claras para mejorar la calidad de sus datos.

No obstante, esta recopilación también puede orientar a los reutilizadores de datos sobre cómo afrontar las debilidades de calidad que pueden presentar los conjuntos de datos con los que trabajan.

¿Qué incluye la guía?

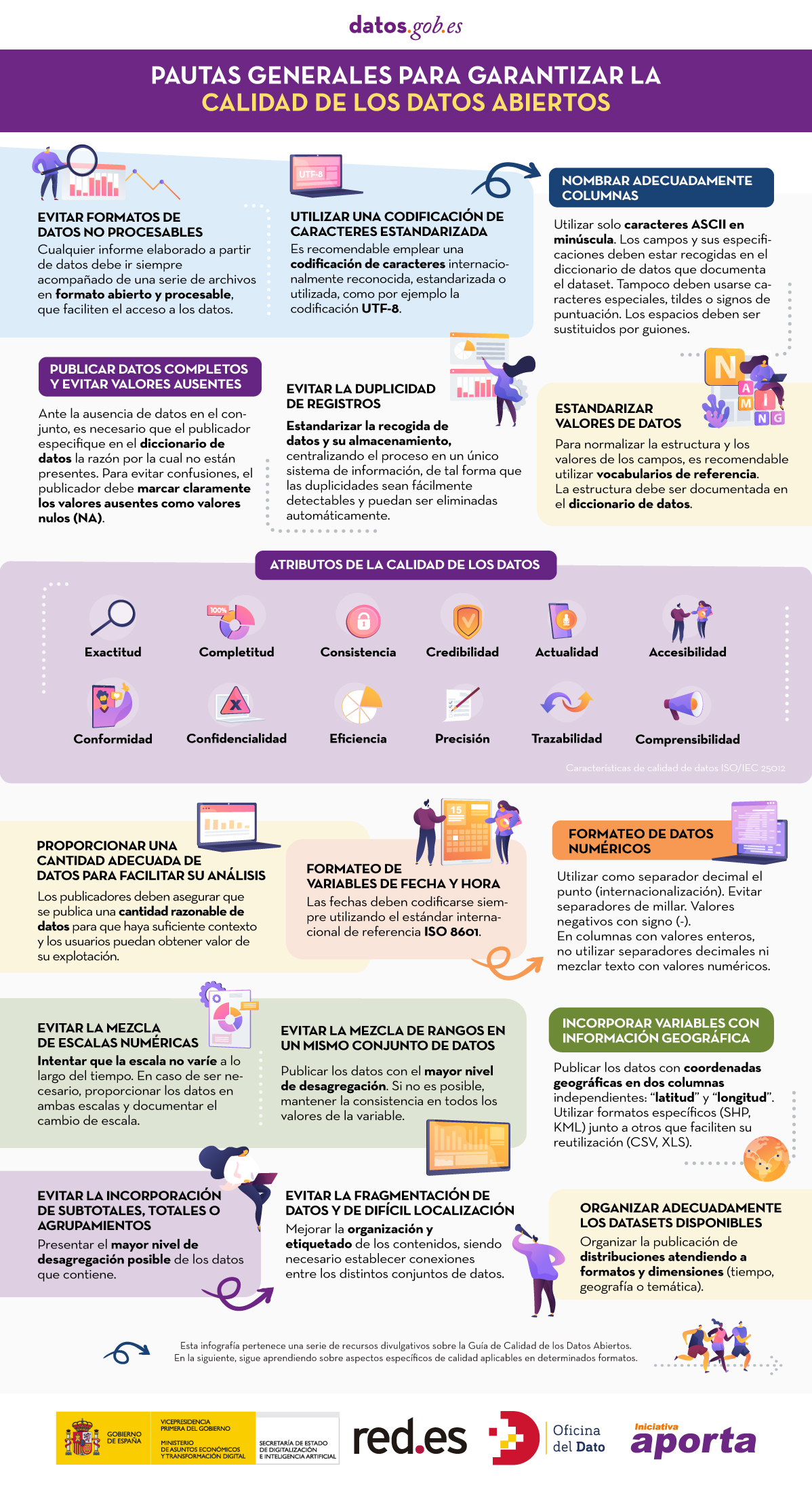

El documento comienza definiendo las características, según la norma ISO/IEC 25012, que deben cumplir los datos para considerarse de calidad, las cuales se recogen en la siguiente imagen.

A continuación, el grueso de la guía está enfocado en la descripción de recomendaciones y buenas prácticas para evitar los problemas más habituales que suelen surgir a la hora de publicar datos abiertos, estructuradas de la siguiente manera:

- Una primera parte donde se detallan una serie pautas generales para garantizar la calidad de los datos abiertos, como, por ejemplo, utilizar una codificación de caracteres estandarizada, evitar la duplicidad de registros o incorporar variables con información geográfica. Para cada pauta se proporciona una descripción detallada del problema, las características de calidad afectadas y las recomendaciones para su resolución, junto a ejemplos prácticos que facilitan su comprensión.

- Una segunda parte con pautas concretas para asegurar la calidad de los datos abiertos según el formato de datos utilizado. Se han incluido pautas específicas para los formatos CSV, XML, JSON, RDF y APIs.

- Por último, la guía también incluye recomendaciones para la estandarización y enriquecimiento de datos, así como para su documentación, y un listado de herramientas útiles para trabajar la calidad de los datos.

Puedes descargar la guía aquí o al final de la página.

Materiales adicionales

La guía va acompañada de una serie de infografías que recopilan las pautas antes indicadas:

Hoy en día podemos encontrar gran cantidad de información legislativa en la red. Países, regiones y municipios hacen públicos sus textos normativos y jurídicos a través de diversos espacios y boletines oficiales. El uso de esa información puede ser de gran utilidad para impulsar mejoras en el sector: desde facilitar la localización de información jurídica hasta el desarrollo de chatbots capaces de resolver dudas legales de los ciudadanos.

Sin embargo, localizar, acceder y reutilizar estos documentos suele resultar complejo, debido a las diferencias en los ordenamientos jurídicos, los diversos idiomas o los distintos sistemas técnicos utilizados para almacenar y gestionar los datos.

Para resolver este reto, la Unión Europea cuenta con un estándar de identificación y descripción de las normas denominado Identificador Europeo de Legislación, conocido como ELI por sus siglas en inglés (European Legislation Identifier).

¿Qué es el Identificador Europeo de Legislación?

El ELI surgió en 2012 a través de unas Conclusiones del Consejo (2012/C 325/02) en las que la Unión Europea invitaba a los Estados miembros a adoptar un estándar de identificación y descripción de las normas jurídicas. Esta iniciativa ha ido evolucionando y enriqueciéndose gracias a nuevas conclusiones publicadas en 2017 (2017/C 441/05) y 2019 (2019/C 360/01).

El ELI, que se basa en un acuerdo voluntario entre los países de la UE, busca facilitar el acceso, intercambio e interconexión de la información jurídica publicada en los sistemas nacionales, europeos y mundiales. De esta forma se facilita su disponibilidad como conjuntos de datos abiertos, impulsando su reutilización.

En concreto, el ELI permite:

- Identificar documentos legislativos, como normas o recursos legales, de forma univoca mediante un identificador único (URI), comprensible tanto por personas como por máquinas.

- Definir las características de cada documento a través de metadatos procesables automáticamente. Para ello utiliza vocabularios definidos mediante ontologías consensuadas y recomendadas para cada ámbito.

Gracias a ello, se consiguen una serie de ventajas:

- Aporta mayor calidad y fiabilidad.

- Aumenta la eficacia en los flujos de información, reduciendo tiempos y ahorrando costes.

- Optimiza y agiliza el acceso a la legislación de distintos sistemas jurídicos al proporcionar la información de manera uniforme.

- Mejora de la interoperabilidad de los sistemas jurídicos, facilitando la cooperación entre países.

- Facilita la reutilización de datos jurídicos como base de nuevos servicios y productos de valor añadido que mejoran la eficiencia del sector.

- Impulsa la transparencia y la rendición de cuentas de los Estados Miembros.

Aplicación del ELI en España

El ELI es un sistema flexible que debe ser adaptado a las peculiaridades de cada territorio. En el caso del ordenamiento español, existen diversos aspectos jurídicos y técnicos que condicionan su implementación.

Uno de los principales condicionantes es la pluralidad de emisores, con normas a nivel nacional, autonómico y local, cada una de las cuales cuenta con su propio medio de publicación oficial. Además, cada organismo publica los documentos en los formatos que considera adecuados (pdf, html, xml, etc.) y con distintos metadatos. A ello hay que sumar la pluralidad lingüística, por la cual cada boletín se publica en las lenguas oficiales correspondientes.

Por ello, se acordó que la implementación del ELI se realizaría de forma coordinada por todas las administraciones, en el marco de la Comisión Sectorial de Administración Electrónica (CSAE), a través de dos fases:

- Debido a la complejidad de la normativa local, en la primera fase, se decidió abordar únicamente la especificación técnica aplicable al Estado y las Comunidades Autónomas, mediante acuerdo de la CSAE de 13 de marzo de 2018.

- En febrero de 2022, se ha elaborado una nueva versión para incluir en su aplicación a la normativa local.

Con esta nueva especificación, quedan establecidas las directrices comunes para la implementación del ELI en el contexto español, pero respetando las particularidades de cada organismo. Es decir, recoge únicamente los elementos mínimos necesarios para garantizar la interoperabilidad de la información legal publicada en todos los niveles de administración, pero se sigue permitiendo que cada organismo mantenga sus propios diarios oficiales, bases de datos, procesos internos, etc.

Con respecto al ámbito temporal, los organismos tienen que aplicar estas especificaciones de la siguiente manera:

- Normativa estatal: aplica a aquella publicada a partir del 29/12/1978, así como la publicada antes si cuenta con versión consolidada.

- Normativa autonómica: aplica a aquella publicada a partir del 29/12/1978.

- Normativa local: cada entidad podrá aplicar su propio criterio.

¿Cómo implementar el ELI?

En la página web https://www.elidata.es/ se ofrecen recursos técnicos para la aplicación del identificador. En ella se explica el modelo contextual y se ofrecen distintas plantillas para facilitar su aplicación:

También ofrece la relación de metadatos mínimos comunes, entre otros recursos.

Además, para facilitar la coordinación nacional y la compartición de experiencias, en la web también se puede encontrar información sobre la implementación efectuada por las distintas administraciones.

El ELI ya se aplica, por ejemplo, en el Boletín Oficial del Estado (BOE). Desde su página web se puede acceder a todas las normas del BOE identificadas con ELI, distinguiendo entre las normas estatales y autonómicas. Si tomamos como referencia una norma como el Real Decreto-ley 24/2021, donde se procedía a la transposición de varias directivas europeas (incluida la de datos abiertos y reutilización de la información del sector público), vemos que se incluye un incluye un permalink ELI.

En definitiva, nos encontramos ante un mecanismo común de gran utilidad para facilitar la interoperabilidad de la información jurídica, lo cual puede impulsar su reutilización no solo a nivel nacional, sino también europeo, favoreciendo la creación del espacio de libertad, seguridad y justicia de la Unión Europea.

Contenido elaborado por el equipo de datos.gob.es.

Un espacio de datos es un ecosistema donde, de forma voluntaria, se ponen en común los datos de sus participantes (sector público, grandes y pequeñas empresas tecnológicas o de negocio, individuos, organismos de investigación, etc). Así y bajo un contexto de soberanía, confianza y seguridad, se pueden compartir, consumir y diseñar productos o servicios a partir de estos espacios de datos.

Esto es especialmente importante porque si el usuario siente que tiene el control sobre sus propios datos, gracias a una comunicación clara y concisa sobre los términos y condiciones que marcarán su uso, la compartición de los mismos se hará efectiva impulsando, así, el desarrollo económico y social del entorno.

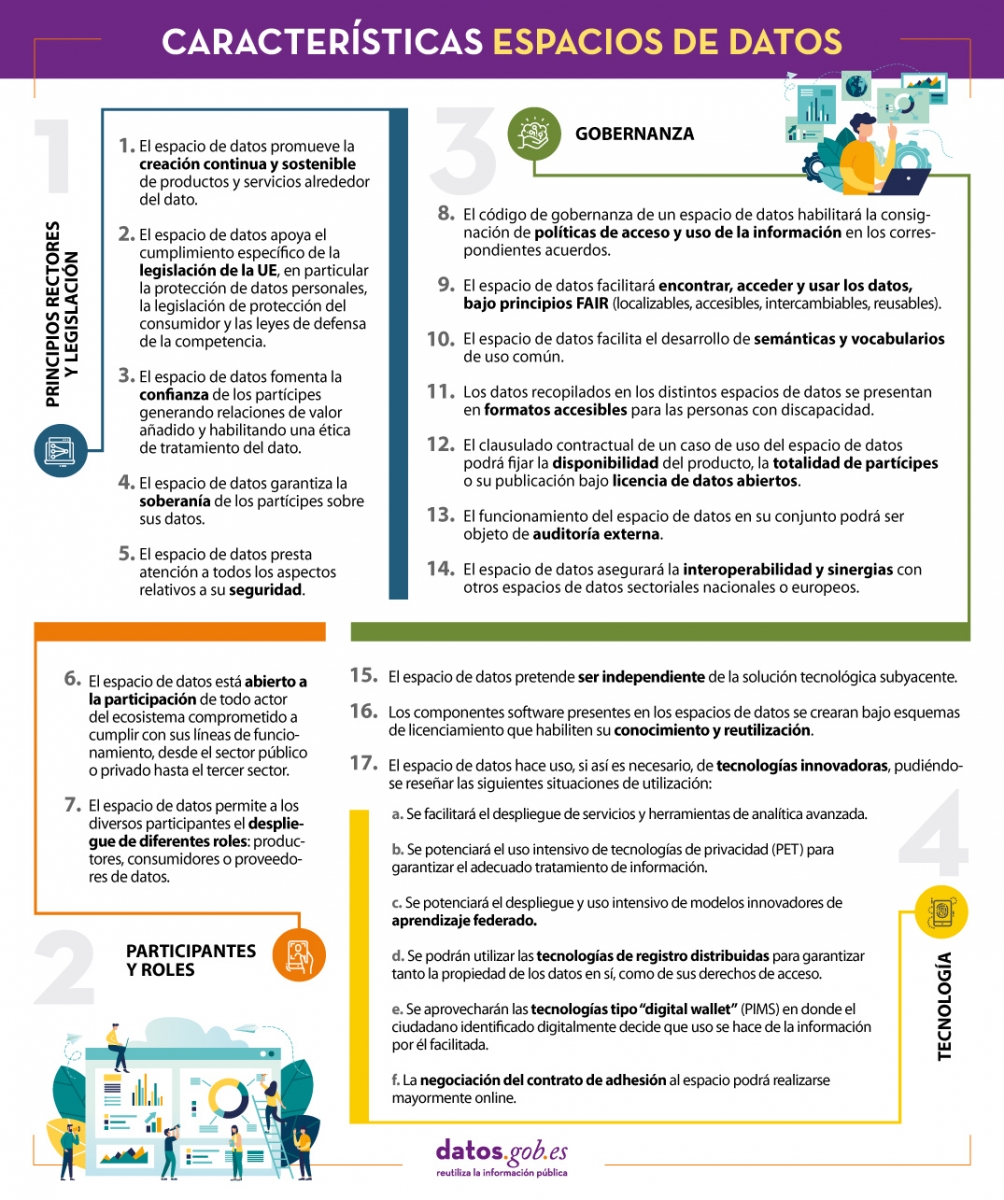

En línea con esta idea y con el objetivo de mejorar el diseño de los espacios de datos, desde la Oficina del Dato establecen una serie de características cuyo objetivo es dejar constancia de la normativa que deben seguir para diseñar, desde el punto de vista arquitectónico, espacios de datos eficaces y funcionales.

Resumimos en el siguiente visual algunas de las características más importantes para la creación de espacios de datos. Para consultar el documento original y la todas las normas propuestas por la Oficina del Dato es necesario descargar el documento adjunto que se encuentra al final de esta noticia.

(Puedes descargar la versión accesible en word aquí)

Este informe que publica el European Data Portal (EDP) tiene como objetivo avanzar en el debate sobre la sostenibilidad a medio y largo plazo de las infraestructuras de los portales de datos abiertos.

Ofrece recomendaciones a los publicadores de datos abiertos y a los intemediarios de datos sobre cómo hacer que los datos abiertos estén disponibles y como promover su reutilización. Está basado en el trabajo realizado anteriomente por el equipo de data.europa.eu, en la investigación sobre la gestión de datos abiertos, y en la interacción entre los humanos y los datos.

Teniendo en cuenta las conclusiones, se proponen 10 recomendaciones para el aumento en la reutilización de los datos.

El informe se encuentra disponible en este enlace: " Principles and recommendations to make data.europa.eu data more reusable: A strategy mapping report "