Los agentes de IA (como los de Google ADK, LangChain, etc.) son "cerebros". Pero un cerebro sin "manos" no puede actuar en el mundo real (consultar APIs, buscar en bases de datos, etc.). Esas "manos" son las herramientas.

El desafío es: ¿cómo conectas el cerebro con las manos de forma estándar, desacoplada y escalable? La respuesta es el Model Context Protocol (MCP).

Como ejercicio práctico, construiremos un sistema de agente conversacional que permite explorar el Catálogo Nacional de datos abiertos albergado en datos.gob.es mediante preguntas en lenguaje natural, facilitando así el acceso a datos públicos.

En este ejercicio práctico, el objetivo principal es ilustrar, paso a paso, cómo construir un servidor de herramientas independiente que hable el protocolo MCP.

Para hacer este ejercicio tangible y no solo teórico, usaremos, FastMCP para construir el servidor. Para probar que nuestro servidor funciona, crearemos un agente simple con Google ADK que lo consuma. El caso de uso (consultar la API de datos.gob.es) ilustra esta conexión entre herramientas y agentes. El verdadero aprendizaje es la arquitectura, que podrías reutilizar para cualquier API o base de datos.

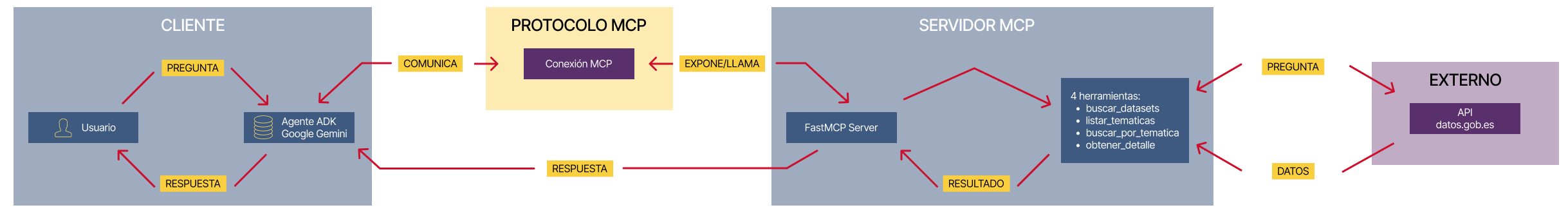

A continuación se muestran las tecnologías que usaremos y un esquema de cómo están realizados entre sí los diferentes componentes

- FastMCP (mcp.server.fastmcp): implementación ligera del protocolo MCP que permite crear servidores de herramientas con muy poco código mediante decoradores Python. Es el 'protagonista' del ejercicio.

- Google ADK (Agent Development Kit): framework para definir el agente de IA, su prompt y conectarlo a las herramientas. Es el 'cliente' que prueba nuestro servidor.

- FastAPI: para servir el agente como una API REST con interfaz web interactiva.

- httpx: para realizar llamadas asíncronas a la API externa de datos.gob.es.

- Docker y Docker Compose: para paquetizar y orquestar los dos microservicios, permitiendo que se ejecuten y comuniquen de forma aislada.

Figura 1. Arquitectura desacoplada con comunicación MCP.

El diagrama ilustra una arquitectura desacoplada dividida en cuatro componentes principales que se comunican mediante el protocolo MCP. Cuando el usuario realiza una consulta en lenguaje natural, el Agente ADK (basado en Google Gemini) procesa la intención y se comunica con el servidor MCP a través del Protocolo MCP, que actúa como intermediario estandarizado. El servidor MCP expone cuatro herramientas especializadas (buscar datasets, listar temáticas, buscar por temática y obtener detalles) que encapsulan toda la lógica de negocio para interactuar con la API externa de datos.gob.es. Una vez que las herramientas ejecutan las consultas necesarias y reciben los datos del catálogo nacional, el resultado se propaga de vuelta al agente, que finalmente genera una respuesta comprensible para el usuario, completando así el ciclo de comunicación entre el "cerebro" (agente) y las "manos" (herramientas).

Accede al repositorio del laboratorio de datos en GitHub

Ejecuta el código de pre-procesamiento de datos sobre Google Colab

La arquitectura: servidor MCP y agente consumidor

La clave de este ejercicio es entender la relación cliente-servidor:

- El Servidor (Backend): es el protagonista de este ejercicio. Su único trabajo es definir la lógica de negocio (las "herramientas") y exponerlas al mundo exterior usando el "contrato" estándar de MCP. Es el responsable de encapsular toda la lógica de comunicación con la API de datos.gob.es.

- El Agente (Frontend): es el "cliente" o "consumidor" de nuestro servidor. Su rol en este ejercicio es probar que nuestro servidor MCP funciona. Lo usamos para conectarnos, descubrir las herramientas que el servidor ofrece y llamarlas.

- El Protocolo MCP: es el "lenguaje" o "contrato" que permite que el agente y el servidor se entiendan sin necesidad de conocer los detalles internos del otro.

Proceso de desarrollo

El núcleo del ejercicio se divide en tres partes: crear el servidor, crear un cliente para probarlo y ejecutarlos.

1. El servidor de herramientas (el backend con MCP)

Aquí es donde reside la lógica de negocio y el foco de este tutorial. En el archivo principal (server.py), definimos funciones Python simples y usamos el decorador @mcp.tool de FastMCP para exponerlas como 'herramientas' consumibles.

La description que añadimos al decorador es crucial, ya que es la documentación que cualquier cliente MCP (incluyendo nuestro agente ADK) leerá para saber cuándo y cómo usar cada herramienta.

Las herramientas que definiremos en el ejercicio son:

- buscar_datasets(titulo: str): para buscar datasets por palabras clave en el título.

- listar_tematicas(): para descubrir qué categorías de datos existen.

- buscar_por_tematica(tematica_id: str): para encontrar datasets de un tema específico.

-

obtener_detalle_dataset(dataset_id: str): para obtener la información completa de un dataset.

2. El agente consumidor (el frontend con Google ADK)

Una vez construido nuestro servidor MCP, necesitamos una forma de probarlo. Aquí es donde entra Google ADK. Lo usamos para crear un "agente consumidor" simple.

La magia de la conexión ocurre en el argumento tools. En lugar de definir las herramientas localmente, simplemente le pasamos la URL de nuestro servidor MCP. El agente, al iniciarse, consultará esa URL, leerá el "contrato" MCP y sabrá automáticamente qué herramientas tiene disponibles y cómo usarlas.

# Ejemplo de configuración en agent.py

root_agent = LlmAgent(

...

instruction="Eres un asistente especializado en datos.gob.es...",

tools=[

MCPToolset(

connection_params=StreamableHTTPConnectionParams(

url="http://mcp-server:8000/mcp",

),

)

]

)3. Orquestación con Docker Compose

Finalmente, para ejecutar nuestro Servidor MCP y el agente consumidor juntos, usamos docker-compose.yml. Docker Compose se encarga de construir las imágenes de cada servicio, crear una red privada para que se comuniquen (por eso el agente puede llamar a http://mcp-server:8000) y exponer los puertos necesarios.

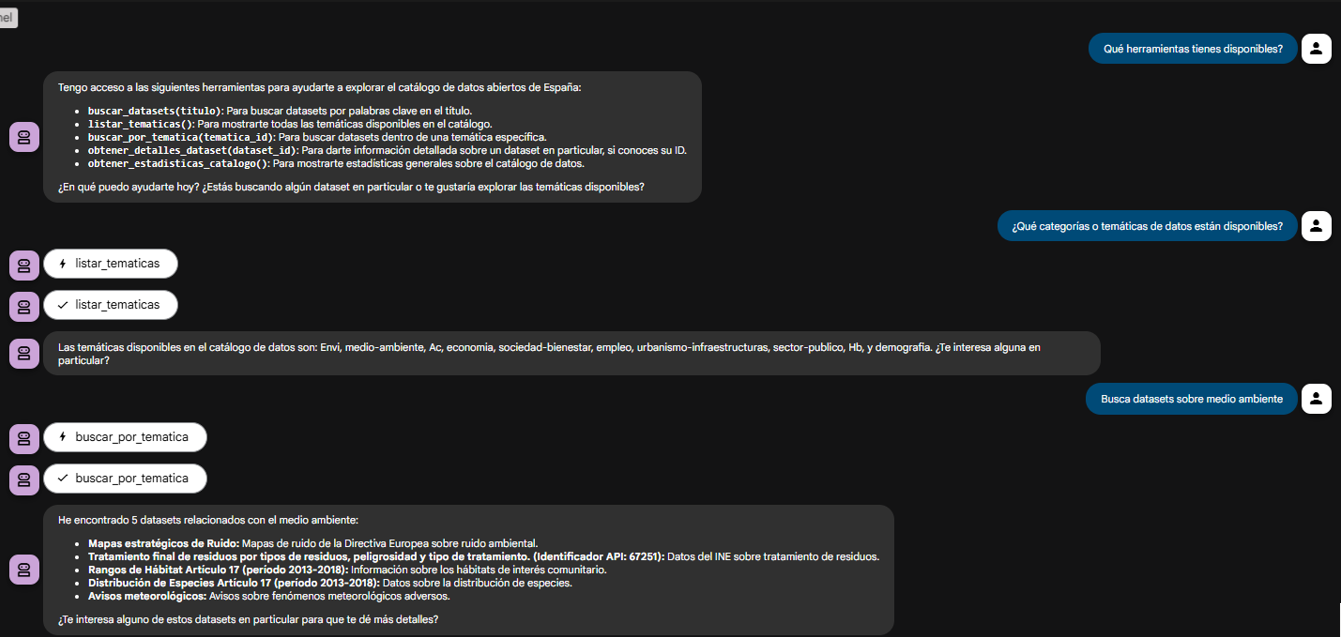

Probando el servidor MCP en acción

Una vez que ejecutamos docker-compose up --build, podemos acceder a la interfaz web del agente (http://localhost:8080).

El objetivo de esta prueba no es solo ver si el bot responde bien, sino verificar que nuestro servidor MCP funciona correctamente y que el agente ADK (nuestro cliente de prueba) puede descubrir y usar las herramientas que este expone.

Figura 2. Pantalla del agente demostrando sus herramientas.

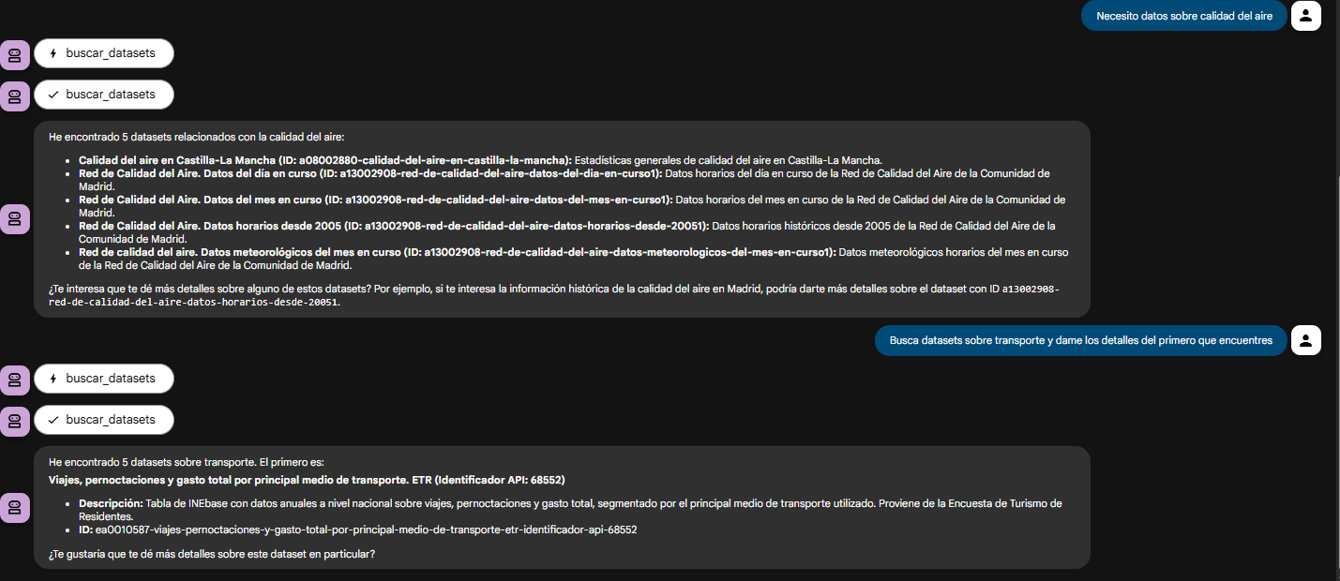

El verdadero poder del desacoplamiento se ve cuando el agente encadena lógicamente las herramientas que nuestro servidor le proveyó.

Figura 3. Pantalla del agente demostrando el uso conjunto de las herramientas.

¿Qué puedes aprender?

El objetivo de este ejercicio es aprender los fundamentos de una arquitectura de agentes moderna, centrándonos en el servidor de herramientas. En concreto:

- Cómo construir un servidor MCP: cómo crear un servidor de herramientas desde cero que hable MCP, usando decoradores como @mcp.tool.

- El patrón de una arquitectura desacoplada: el patrón fundamental de separar el 'cerebro' (LLM) de las 'herramientas' (lógica de negocio).

- Descubrimiento dinámico de herramientas: cómo un agente (en este caso, de ADK) puede conectarse dinámicamente a un servidor MCP para descubrir y consumir herramientas.

- Integración de API externas: el proceso de 'envolver' una API compleja (como la de datos.gob.es) en funciones simples dentro de un servidor de herramientas.

- Orquestación con Docker: cómo gestionar un proyecto de microservicios para desarrollo.

Conclusiones y futuro

Hemos construido un servidor de herramientas MCP robusto y funcional. El verdadero valor de este ejercicio es el cómo: una arquitectura escalable centrada en un servidor de herramientas que habla un protocolo estándar.

Esta arquitectura basada en MCP es increíblemente flexible. El caso de datos.gob.es es solo un ejemplo. Podríamos fácilmente:

- Cambiar el caso de uso: reemplazar el server.py por uno que conecte a una base de datos interna o a la API de Spotify, y cualquier agente que hable MCP (no solo ADK) podría consumirlo.

- Cambiar el "cerebro": cambiar el agente ADK por un agente de LangChain o cualquier otro cliente MCP, y nuestro servidor de herramientas seguiría funcionando sin cambios.

Para aquellos interesados en llevar este análisis al siguiente nivel, las posibilidades se centran en mejorar el servidor MCP:

- Implementar más herramientas: añadir filtros por formato, publicador o fecha al servidor MCP.

- Integrar caché: usar Redis en el servidor MCP para cachear las respuestas de la API y mejorar la velocidad.

- Añadir persistencia: guardar el historial de chat en una base de datos (esto sí sería en el lado del agente).

Más allá de estas mejoras técnicas, esta arquitectura abre la puerta a múltiples aplicaciones en contextos muy diversos.

- Periodistas y académicos pueden disponer de asistentes de investigación que les ayuden a descubrir conjuntos de datos relevantes en segundos.

- Organizaciones de transparencia pueden construir herramientas de monitorización que detecten automáticamente nuevas publicaciones de datos de contratación pública o presupuestos.

- Consultoras y equipos de inteligencia de negocio pueden desarrollar sistemas que crucen información de múltiples fuentes gubernamentales para elaborar informes sectoriales.

- Incluso en el ámbito educativo, esta arquitectura sirve como base didáctica para enseñar conceptos avanzados de programación asíncrona, integración de API y diseño de agentes de IA.

El patrón que hemos construido —un servidor de herramientas desacoplado que habla un protocolo estándar— es la base sobre la que puedes desarrollar soluciones adaptadas a tus necesidades específicas, independientemente del dominio o la fuente de datos con la que trabajes.

El Cabildo Insular de Tenerife ha convocado el II Concurso de Datos Abiertos: Desarrollo de APP, una iniciativa que premia la creación de aplicaciones web y móviles que aprovechen los conjuntos de datos disponibles en su portal datos.tenerife.es. Esta convocatoria representa una nueva oportunidad para desarrolladores, emprendedores y entidades innovadoras que quieran transformar información pública en soluciones digitales de valor para la sociedad. En este post, te contamos los detalles sobre la competición.

Un ecosistema en crecimiento: de las ideas a las aplicaciones

Esta iniciativa se enmarca en el proyecto de Datos Abiertos del Cabildo de Tenerife, que promueve la transparencia, la participación ciudadana y la generación de valor económico y social a través de la reutilización de información pública.

El Cabildo ha diseñado una estrategia en dos fases:

-

El I Concurso de Datos Abiertos: Ideas de Reutilización (ya celebrado) centrado en identificar propuestas creativas.

-

El II Concurso: Desarrollo de APP (convocatoria actual) que da continuidad al proceso y busca materializar ideas en aplicaciones funcionales.

Este enfoque progresivo permite construir un ecosistema de innovación que acompaña a los participantes desde la conceptualización hasta el desarrollo completo de soluciones digitales.

El objetivo es fomentar la creación de productos y servicios digitales que generen impacto social y económico, mientras se identifican nuevas oportunidades de innovación y emprendimiento en el ámbito de los datos abiertos.

Premios y dotación económica

Este concurso cuenta con una dotación total de 6.000 euros distribuidos en tres premios:

-

Primer premio: 3.000 euros

-

Segundo premio: 2.000 euros

-

Tercer premio: 1.000 euros

¿Quién puede participar?

La convocatoria está abierta a:

-

Personas físicas: desarrolladores individuales, diseñadores, estudiantes o cualquier persona interesada en la reutilización de datos abiertos.

-

Personas jurídicas: startups, empresas de tecnología, cooperativas, asociaciones u otras entidades.

Siempre y cuando presenten el desarrollo de una aplicación basada en datos abiertos del Cabildo de Tenerife. Una misma persona, física o jurídica, puede presentar tantas candidaturas como desee, tanto de forma individual como conjunta.

¿Qué tipo de aplicaciones se pueden presentar?

Las propuestas deben ser aplicaciones web o móviles que utilicen al menos un conjunto de datos del portal datos.tenerife.es. Algunas ideas que pueden servir de inspiración son:

-

Aplicaciones para optimizar el transporte y la movilidad en la isla.

-

Herramientas de visualización de datos turísticos o medioambientales.

-

Servicios de información ciudadana en tiempo real.

-

Soluciones para mejorar la accesibilidad y la participación social.

-

Plataformas de análisis de datos económicos o demográficos.

Criterios de evaluación: ¿qué valora el jurado?

El jurado evaluará las propuestas considerando los siguientes criterios:

-

Uso de datos abiertos: grado de aprovechamiento e integración de los conjuntos de datos disponibles en el portal.

-

Impacto y utilidad: valor que aporta la aplicación a la sociedad, capacidad para resolver problemas reales o mejorar servicios existentes.

-

Innovación y creatividad: originalidad de la propuesta y carácter innovador de la solución planteada.

-

Calidad técnica: solidez del código, buenas prácticas de programación, escalabilidad y mantenibilidad de la aplicación.

-

Diseño y usabilidad: experiencia de usuario (UX), diseño visual atractivo e intuitivo, garantía de accesibilidad digital en dispositivos Android e iOS.

¿Cómo participar?: plazos y forma de presentación:

Las solicitudes pueden presentarse hasta el 10 de marzo de 2026, tres meses desde la publicación de la convocatoria en el Boletín Oficial de la Provincia.

Sobre la documentación requerida, las propuestas deben presentarse en formato digital e incluir:

-

Descripción técnica detallada de la aplicación.

-

Memoria justificativa del uso de los datos abiertos.

-

Especificación de entornos tecnológicos utilizados.

-

Vídeo demostrativo del funcionamiento de la aplicación.

-

Código fuente completo.

-

Ficha técnica resumen.

Desde la institución organizadora recomiendan la presentación telemática a través de la Sede Electrónica del Cabildo de Tenerife, aunque también es posible la presentación presencial en los registros oficiales habilitados. Las bases completas y el modelo oficial de solicitud están disponibles en la Sede Electrónica del Cabildo.

Con esta segunda convocatoria, el Cabildo de Tenerife consolida su apuesta por la transparencia, la reutilización de información pública y la creación de un ecosistema de innovación digital. Iniciativas como esta demuestran cómo los datos abiertos pueden convertirse en catalizadores del emprendimiento, la participación ciudadana y el desarrollo económico local.

En los últimos seis meses, el ecosistema de datos abiertos en España ha vivido una intensa actividad marcada por los avances normativos y estratégicos, la puesta en marcha de nuevas plataformas y funcionalidades en los portales de datos, o el lanzamiento de soluciones innovadoras basadas en la información pública.

En este artículo, repasamos algunos de esos avances, para que puedas estar al día. Te invitamos también a revisar el artículo sobre las novedades del primer semestre de 2025 para que puedas tener una visión general de lo que ha sucedido este año en el ecosistema de datos nacional.

Avances estratégicos, normativos y políticos de carácter transversal

La calidad, interoperabilidad y gobernanza de los datos se han situado en el centro de la agenda tanto nacional como europea, con iniciativas que buscan fomentar un marco sólido para aprovechar el valor de los datos como activo estratégico.

Una de las principales novedades ha sido el lanzamiento de un nuevo paquete digital por parte de la Comisión Europea con el fin de consolidar un ecosistema europeo de datos robusto, seguro y competitivo. Este paquete incluye un ómnibus digital para simplificar la aplicación del Reglamento de inteligencia artificial (IA). Además, se complementa con la nueva Estrategia Unión de Datos (Data Union Strategy) que se articula en torno a tres pilares:

- Ampliar el acceso a datos de calidad para impulsar la inteligencia artificial y la innovación.

- Simplificar el marco normativo existente para reducir barreras y burocracia.

- Proteger la soberanía digital europea frente a dependencias externas.

Su implementación se producirá de forma gradual durante los próximos meses. Será entonces cuando podamos ir apreciando sus efectos sobre nuestro país y el resto de territorios comunitarios.

La actividad en España también se ha visto -y se verá- marcada por el V Plan de Gobierno Abierto 2025-2029, aprobado el pasado octubre. Este plan cuenta con más de 200 iniciativas y aportaciones tanto de la sociedad civil como de administraciones, muchas de ellas relacionadas con la apertura y reutilización de datos. El compromiso de España con los datos abiertos también ha quedado patente en la adhesión a la Carta Internacional de Datos Abiertos, una iniciativa global que promueve la apertura y reutilización de datos públicos como herramientas para mejorar la transparencia, la participación ciudadana, la innovación y la rendición de cuentas.

Junto al impulso de la apertura de datos, también se ha trabajado en el desarrollo de espacios de compartición de datos. En este sentido, se presentó la normativa UNE 0087, que se suma a especificaciones UNE sobre datos y define por primera vez en España los principios y requisitos clave para crear y operar en espacios de datos, mejorando su interoperabilidad y gobernanza.

Más soluciones innovadoras basadas en datos

Los organismos españoles continúan aprovechando el potencial de los datos como motor de soluciones y políticas que optimizan la prestación de servicios a la ciudadanía. Algunos ejemplos son:

- El Ministerio de Sanidad y la iniciativa de ciencia ciudadana, Mosquito Alert, están utilizando inteligencia artificial y análisis de imágenes automatizado para mejorar la detección y seguimiento en tiempo real de mosquitos tigres y especies invasoras.

- La Fundación Valenciaport, junto a otras organizaciones europeas, ha lanzado una herramienta gratuita que permite evaluar los beneficios de instalar sistemas de energía eólica y fotovoltaica en los puertos.

- El Cabildo de la Palma apostó por una agricultura inteligente con la nueva web Smart Agro: los agricultores reciben recomendaciones de riego personalizadas según clima y ubicación. El Cabildo también ha puesto en marcha un visor para hacer seguimiento de la movilidad en la isla.

- El Ayuntamiento de Segovia ha implementado un gemelo digital que centraliza aplicaciones y datos geográficos de alto valor, permitiendo visualizar y analizar la ciudad en un entorno tridimensional interactivo. Mejora la gestión municipal y promueve la transparencia y la participación ciudadana.

- El Ayuntamiento de Vila-real ha lanzado una aplicación digital que integra transporte público, aparcamientos y puntos turísticos en tiempo real. El proyecto busca optimizar la movilidad urbana y fomentar la sostenibilidad mediante tecnología inteligente.

- El Ayuntamiento de Sant Boi ha lanzado un mapa interactivo elaborado con datos abiertos que centraliza información sobre transporte urbano, aparcamiento y opciones sostenibles en una única plataforma, con el fin de mejorar la movilidad urbana.

- Se ha inaugurado la Red Internacional de Investigación DataActive, una iniciativa financiada por el Consejo Superior de Deportes que busca impulsar el diseño de entornos urbanos activos mediante el uso de datos abiertos.

No solo los organismos públicos reutilizan los datos abiertos, desde las universidades también se trabaja en proyectos ligados a la innovación digital basados en información pública:

- Estudiantes de la Universitat de València han diseñado proyectos que utilizan IA y datos abiertos para prevenir desastres naturales.

- Investigadores de la Universidad de Castilla-La Mancha han demostrado que es viable reutilizar modelos de predicción de calidad del aire en distintas zonas de Madrid usando transfer learning.

Además de soluciones, los datos abiertos también sirven para dar forma a otros tipos de productos, incluso esculturas. Es el caso de “El esqueleto del cambio climático”, una figura que presentó el Museo Nacional de Ciencias Naturales, basada en datos sobre los cambios en la temperatura global desde 1880 hasta 2024.

Nuevos portales y funcionalidades para extraer valor de los datos

Las soluciones e innovaciones comentadas anteriormente son posibles gracias a la existencia de múltiples plataformas de apertura o compartición de datos que no dejan de incorporar nuevos conjuntos de datos y funcionalidades para extraerles valor. Algunas de las novedades que hemos visto a este respecto en los últimos meses son:

- El Observatorio Nacional de Tecnología y Sociedad (ONTSI) ha lanzado una nueva web. Una de sus novedades es Ontsi Data, una herramienta para elaborar informes con indicadores tanto de su portal como de terceros.

- El Consejo General del Notariado ha lanzado un Portal Estadístico de la Vivienda, una herramienta abierta con datos fiables y actualizados sobre el mercado inmobiliario en España.

- La Agencia Española de Seguridad Alimentaria y Nutrición (AESAN) ha inaugurado en su web un espacio de datos abiertos con microdatos sobre la composición de alimentos y bebidas comercializados en España.

- El Centro de Investigaciones Sociológicas (CIS) estrenó una web renovada, adaptada a cualquier dispositivo y con un buscador más potente para facilitar el acceso a sus estudios y datos.

- El Instituto Geográfico Nacional (IGN) ha presentado una nueva web del SIOSE, el Sistema de Información sobre Ocupación del Suelo de España, con un diseño más moderno, intuitivo y dinámico. Además, ha puesto a disposición de la ciudadanía una nueva versión de la Información Geográfica de Referencia de Redes de Transporte (IGR-RT), segmentada por provincias y modos de transporte, y disponible en Shapefile y GeoPackage.

- La Plataforma de Asesores AKIS, impulsada por el Ministerio de Agricultura, Pesca y Alimentación, ha puesto en marcha una nueva API de datos abiertos que permite a los usuarios registrados descargar y reutilizar contenidos relacionados con el sector agroalimentario en España.

- La Generalitat de Catalunya estrenó nueva web corporativa que centraliza aspectos clave sobre fondos europeos, contratación pública, transparencia y datos abiertos en un único punto. También ha lanzado una web donde recoge información sobre los sistemas de IA que utiliza.

- PortCastelló ha publicado sus Memorias 2024 en formato open data. Toda la gestión, tráficos, infraestructuras y datos económicos del puerto ahora son accesibles y reutilizables por cualquier ciudadano.

- Investigadores de la Universitat Oberta de Catalunya y del Instituto de Ciencias Fotónicas han creado una biblioteca abierta con datos de 140 biomoléculas. Un recurso pionero que impulsa la ciencia abierta y el uso de datos abiertos en biomedicina.

- También se presentó CitriData, un espacio federado de datos, modelos y servicios en la cadena de valor de los cítricos andaluces. Su objetivo es transformar el sector mediante el uso inteligente y colaborativo de los datos.

Otros organismos están inmersos en el desarrollo de sus novedades. Por ejemplo, próximamente veremos el nuevo Portal de Datos Abiertos de Aguas de Alicante, que permitirá un acceso público a información clave sobre la gestión del agua, fomentando el desarrollo de soluciones basadas en Big Data e IA.

Estos meses también se han presentado avances estratégicos ligados a mejorar la calidad y el uso de los datos, como el Modelo de Gobierno del Dato de la Generalitat Valenciana o la Hoja de Ruta para la Estrategia Provincial de inteligencia artificial de la diputación de Castellón.

Datos.gob.es también presentó una nueva plataforma dirigida a para optimizar tanto la publicación como el acceso a los datos. Si quieres conocer esta y otras novedades de la Iniciativa Aporta en el año 2025, te invitamos a leer este post.

Fomentando el uso de los datos a través de eventos, recursos y acciones ciudadanas

La segunda mitad del año 2025 fue la época elegida por gran cantidad de organismos públicos para lanzar concursos dirigidos a impulsar la reutilización de los datos que publican. Fue el caso de la Junta de Castilla y León, el Ayuntamiento Madrid, el Ayuntamiento de Valencia o la Diputación Foral de Bizkaia. También se ha participado desde nuestro país en eventos internacionales como el Desafío NASA Space Apps.

Entre los eventos donde se ha aprovecho para difundir el poder de los datos abiertos, destacan la Cumbre Global de Open Government Partnership (OGP), las Jornadas Ibéricas de Infraestructuras de Datos Espaciales (JIIDE), el Congreso Internacional de Transparencia y Gobierno Abierto o la 17ª Conferencia Internacional sobre Reutilización de la Información del Sector Público de ASEDIE, aunque hubo muchos más.

También se ha trabajado en informes que ponen de manifiesto el impacto de los datos en sectores concretos, como el Informe Cátedra DATAGRI 2025 de la Universidad de Córdoba, centrado en el sector agroalimentario. Otros documentos publicados buscan ayudar a mejorar la gestión de los datos, como “Fundamentos del Gobierno del Dato en el contexto de los espacios de datos", liderado por DAMA España, en colaboración con Gaia-X España.

La participación ciudadana también es fundamental para el éxito de la innovación basada en datos. En este sentido, hemos visto tanto actividades dirigidas a impulsar la publicación de datos como a mejorar los ya publicados o su reutilización:

- Desde la Iniciativa Barcelona Open Data se solicitó la ayuda ciudadana para elaborar un ranking de soluciones digitales basadas en datos abiertos para promover el envejecimiento saludable. También organizaron una actividad participativa para mejorar la app iCuida, dirigida a trabajadores del hogar y cuidados. Esta app permite buscar lavabos públicos, refugios climáticos y otros puntos de interés para el día a día de las cuidadoras.

- La Agencia Espacial Española lanzó una encuesta para conocer necesidades y usos de imágenes y datos de Observación de la Tierra en el marco de proyectos estratégicos como la Constelación Atlántica.

En conclusión, las actividades realizadas en el segundo semestre de 2025 ponen de manifiesto la consolidación del ecosistema de datos abiertos en España como un motor de innovación, transparencia y participación ciudadana. Los avances normativos y estratégicos, junto con la creación de nuevas plataformas y soluciones basadas en datos, muestran un compromiso firme por parte de las instituciones y la sociedad en aprovechar la información pública como recurso clave para el desarrollo sostenible, la mejora de servicios y la generación de conocimiento.

Como siempre, este artículo es solo una pequeña muestra de las actividades realizadas. Te invitamos a compartir otras actividades que conozcas a través de los comentarios.

Cuando se acaban de cumplir tres años desde que comenzó la aceleración del despliegue masivo de la Inteligencia Artificial con el lanzamiento de ChatGPT, un término nuevo emerge con fuerza: la IA agéntica (Agentic AI). En los últimos tres años hemos pasado de hablar de modelos de lenguaje (como por ejemplo, los LLM) y chatbots (o asistentes conversacionales) a diseñar los primeros sistemas capaces no solo de responder a nuestras preguntas, sino de actuar de forma autónoma para conseguir objetivos, combinando datos, herramientas y colaboraciones con otros agentes de IA o con personas humanas. Esto es, la conversación global sobre IA se está moviendo desde la capacidad para "conversar" hacia la capacidad para "actuar" de estos sistemas.

En el sector privado, informes recientes de grandes consultoras describen agentes de IA que resuelven de principio a fin incidencias de clientes, orquestan cadenas de suministro, optimizan inventarios en el sector retail o automatizan la elaboración de informes de negocio. En el sector público, esta conversación también comienza a tomar forma y cada vez más administraciones exploran cómo estos sistemas pueden ayudar a simplificar trámites o a mejorar la atención a la ciudadanía. Sin embargo, el despliegue parece que está siendo algo más lento porque lógicamente en la administración no solo debe tenerse en cuenta la excelencia técnica sino también el estricto cumplimiento del marco normativo, que en Europa lo marca el Reglamento de IA, para que los agentes autónomos sean, ante todo, aliados de la ciudadanía.

¿Qué es la IA agéntica (Agentic AI)?

Aunque se trate de un concepto reciente que aún está en evolución, varias administraciones y organismos empiezan a converger en una definición. Por ejemplo, el Gobierno del Reino Unido describe la IA agéntica como sistemas formados por agentes de IA que “pueden comportarse e interactuar de forma autónoma para lograr sus objetivos”. En este contexto un agente de IA sería una pieza especializada de software que puede tomar decisiones y operar de forma cooperativa o independiente para lograr los objetivos del sistema.

Podríamos pensar, por ejemplo, en un agente de IA en una administración local que recibe la solicitud de una persona para abrir un pequeño negocio. El agente, diseñado de acuerdo con el procedimiento administrativo correspondiente, comprobaría la normativa aplicable, consultaría datos urbanísticos y de actividad económica, verificaría requisitos, rellenaría borradores de documentos, propondría citas o trámites complementarios y prepararía un resumen para que el personal funcionario pudiera revisar y validar la solicitud. Esto es, no sustituiría la decisión humana, sino que automatizaría buena parte del trabajo que hay entre la solicitud realizada por el ciudadano y la resolución dictada por la administración.

Frente a un chatbot conversacional -que responde a una pregunta y, en general, termina ahí la interacción-, un agente de IA puede encadenar múltiples acciones, revisar resultados, corregir errores, colaborar con otros agentes de IA y seguir iterando hasta alcanzar la meta que se le ha definido. Esto no significa que los agentes autónomos decidan por su cuenta sin supervisión, sino que pueden hacerse cargo de buena parte de la tarea siempre siguiendo reglas y salvaguardas bien definidas.

Las características clave de un agente autónomo incluyen:

- Percepción y razonamiento: es la capacidad de un agente para comprender una solicitud compleja, interpretar el contexto y desglosar el problema en pasos lógicos que conduzcan a resolverlo.

- Planificación y acción: es la habilidad para ordenar esos pasos, decidir la secuencia en que se van a ejecutar y adaptar el plan cuando cambian los datos o aparecen nuevas restricciones.

- Uso de herramientas: un agente puede, por ejemplo, conectarse a diversas API, consultar bases de datos, catálogos de datos abiertos, abrir y leer documentos o enviar correos electrónicos según lo requieran las tareas que está intentando resolver.

- Memoria y contexto: es la capacidad del agente para mantener la memoria de las interacciones en procesos largos, recordando las acciones y respuestas pasadas y el estado actual de la solicitud que está resolviendo.

- Autonomía supervisada: un agente puede tomar decisiones dentro de unos límites previamente establecidos para avanzar hacia la meta sin necesidad de intervención humana en cada paso, pero permitiendo siempre la revisión y trazabilidad de las decisiones.

Podríamos resumir el cambio que supone con la siguiente analogía: si los LLM son el motor de razonamiento, los agentes de IA son sistemas que además de esa capacidad de “pensar” en las acciones que habría que hacer, tienen "manos" para interactuar con el mundo digital e incluso con el mundo físico y ejecutar esas mismas acciones.

El potencial de los agentes de IA en los servicios públicos

Los servicios públicos se organizan, en buena medida, alrededor de procesos de una cierta complejidad como son la tramitación de ayudas y subvenciones, la gestión de expedientes y licencias o la propia atención ciudadana a través de múltiples canales. Son procesos con muchos pasos, reglas y actores diferentes, donde abundan las tareas repetitivas y el trabajo manual de revisión de documentación.

Como puede verse en el eGovernment Benchmark de la Unión Europea, las iniciativas de administración electrónica de las últimas décadas han permitido avanzar hacia una mayor digitalización de los servicios públicos. Sin embargo, la nueva ola de tecnologías de IA, especialmente cuando se combinan modelos fundacionales con agentes, abre la puerta a un nuevo salto para automatizar y orquestar de forma inteligente buena parte de los procesos administrativos.

En este contexto, los agentes autónomos permitirían:

- Orquestar procesos de extremo a extremo como, por ejemplo, recopilar datos de distintas fuentes, proponer formularios ya cumplimentados, detectar incoherencias en la documentación aportada o generar borradores de resoluciones para su validación por el personal responsable.

- Actuar como “copilotos” de los empleados públicos, preparando borradores, resúmenes o propuestas de decisiones que luego se revisan y validan, asistiendo en la búsqueda de información relevante o señalando posibles riesgos o incidencias que requieren atención humana.

- Optimizar los procesos de atención ciudadana apoyando en tareas como la gestión de citas médicas, respondiendo consultas sobre el estado de expedientes, facilitando el pago de tributos o guiando a las personas en la elección del trámite más adecuado a su situación.

Diversos análisis sobre IA en el sector público apuntan a que este tipo de automatización inteligente, al igual que en el sector privado, puede reducir tiempos de espera, mejorar la calidad de las decisiones y liberar tiempo del personal para tareas de mayor valor añadido. Un informe reciente de PWC y Microsoft que explora el potencial de la IA agéntica para el sector público resume bien la idea, señalando que al incorporar la IA agéntica en los servicios públicos, los gobiernos pueden mejorar la capacidad de respuesta y aumentar la satisfacción ciudadana, siempre que existan las salvaguardas adecuadas.

Además, la implementación de agentes autónomos permite soñar con una transición desde una administración reactiva (que espera a que el ciudadano solicite un servicio) a una administración proactiva que se ofrece a hacer por nosotros parte de esas mismas acciones: desde avisarnos de que se ha abierto una ayuda para la que probablemente cumplamos los requisitos, hasta proponernos la renovación de una licencia antes de que caduque o recordarnos una cita médica.

Un ejemplo ilustrativo de esto último podría ser un agente de IA que, apoyado en datos sobre servicios disponibles y en la información que el propio ciudadano haya autorizado utilizar, detecte que se ha publicado una nueva ayuda para actuaciones de mejora de la eficiencia energética a través de la rehabilitación de viviendas y envíe un aviso personalizado a quienes podrían cumplir los requisitos. Incluso ofreciéndoles un borrador de solicitud ya pre-cumplimentado para su revisión y aceptación. La decisión final sigue siendo humana, pero el esfuerzo de buscar la información, entender las condiciones y preparar la documentación se podría reducir mucho.

El rol de los datos abiertos

Para que un agente de IA pueda actuar de forma útil y responsable necesita apalancarse sobre un entorno rico en datos de calidad y un sistema de gobernanza de datos sólido. Entre esos activos necesarios para desarrollar una buena estrategia de agentes autónomos, los datos abiertos tienen importancia al menos en tres dimensiones:

- Combustible para la toma de decisiones: los agentes de IA necesitan información sobre normativa vigente, catálogos de servicios, procedimientos administrativos, indicadores socioeconómicos y demográficos, datos de transporte, medio ambiente, planificación urbana, etc. Para ello, la calidad y estructura de los datos es de gran importancia ya que datos desactualizados, incompletos o mal documentados pueden llevar a los agentes a cometer errores costosos. En el sector público, esos errores pueden traducirse en decisiones injustas que en última instancia podrían llevar a la pérdida de confianza de la ciudadanía.

- Banco de pruebas para evaluar y auditar agentes: al igual que los datos abiertos son importantes para evaluar modelos de IA generativa, también pueden serlo para probar y auditar agentes autónomos. Por ejemplo, simulando expedientes ficticios con datos sintéticos basados en distribuciones reales para comprobar cómo actúa un agente en distintos escenarios. De este modo, universidades, organizaciones de la sociedad civil y la propia administración puedan examinar el comportamiento de los agentes y detectar problemas antes de escalar su uso.

- Transparencia y explicabilidad: los datos abiertos podrían ayudar a documentar de dónde proceden los datos que utiliza un agente, cómo se han transformado o qué versiones de los conjuntos de datos estaban vigentes cuando se tomó una decisión. Esta trazabilidad contribuye a la explicabilidad y la rendición de cuentas, especialmente cuando un agente de IA interviene en decisiones que afectan a los derechos de las personas o a su acceso a servicios públicos. Si la ciudadanía puede consultar, por ejemplo, los criterios y datos que se aplican para otorgar una ayuda, se refuerza la confianza en el sistema.

El panorama de la IA agéntica en España y en el resto del mundo

Aunque el concepto de IA agéntica es reciente, ya existen iniciativas en marcha en el sector público a nivel internacional y comienzan a abrirse paso también en el contexto europeo y español:

- La Government Technology Agency (GovTech) de Singapur ha publicado una guía Agentic AI Primer para orientar a desarrolladores y responsables públicos sobre cómo aplicar esta tecnología, destacando tanto sus ventajas como sus riesgos. Además, el gobierno está pilotando el uso de agentes en varios ámbitos para reducir la carga administrativa de los trabajadores sociales y apoyar a las empresas en procesos complejos de obtención de licencias. Todo ello en un entorno controlado (sandbox) para probar estas soluciones antes de escalarlas.

- El Gobierno de Reino Unido ha publicado una nota específica dentro de su documentación “AI Insights” para explicar qué es la IA agéntica y por qué es relevante para servicios gubernamentales. Además, ha anunciado una licitación para desarrollar un “GOV.UK Agentic AI Companion” que sirva de asistente inteligente para la ciudadanía desde el portal del gobierno.

- La Comisión Europea, en el marco de la estrategia Apply AI y de la iniciativa GenAI4EU, ha lanzado convocatorias para financiar proyectos piloto que introduzcan soluciones de IA generativa escalables y replicables en las administraciones públicas, plenamente integradas en sus flujos de trabajo. Estas convocatorias buscan precisamente acelerar el paso en la digitalización a través de IA (incluidos agentes especializados) para mejorar la toma de decisiones, simplificar procedimientos y hacer la administración más accesible.

En España, aunque la etiqueta “IA agéntica” todavía no se utiliza aún de forma amplia, ya se pueden identificar algunas experiencias que van en esa dirección. Por ejemplo, distintas administraciones están incorporando copilotos basados en IA generativa para apoyar a los empleados públicos en tareas de búsqueda de información, redacción y resumen de documentos, o gestión de expedientes, como muestran iniciativas de gobiernos autonómicos como el de Aragón y o entidades locales como el Ayuntamiento de Barcelona que empiezan a documentarse de forma pública.

El salto hacia agentes más autónomos en el sector público parece, por tanto, una evolución natural sobre la base de la administración electrónica existente. Pero esa evolución debe, al mismo tiempo, reforzar el compromiso con la transparencia, la equidad, la rendición de cuentas, la supervisión humana y el cumplimiento normativo que exige el Reglamento de IA y el resto del marco normativo y que deben guiar las actuaciones de la administración pública.

Mirando hacia el futuro: agentes de IA, datos abiertos y confianza ciudadana

La llegada de la IA agéntica ofrece de nuevo a la Administración pública nuevas herramientas para reducir la burocracia, personalizar la atención y optimizar sus siempre escasos recursos. Sin embargo, la tecnología es solo un medio, el fin último sigue siendo generar valor público reforzando la confianza de la ciudadanía.

En principio, España parte de una buena posición: dispone de una Estrategia de Inteligencia Artificial 2024 que apuesta por una IA transparente, ética y centrada en las personas, con líneas específicas para impulsar su uso en el sector público; cuenta con una infraestructura consolidada de datos abiertos; y ha creado la Agencia Española de Supervisión de la Inteligencia Artificial (AESIA) como organismo encargado de garantizar un uso ético y seguro de la IA, de acuerdo con el Reglamento Europeo de IA.

Estamos, por tanto, ante una nueva oportunidad de modernización que puede construir unos servicios públicos más eficientes, cercanos e incluso proactivos. Si somos capaces de adoptar la IA agéntica adecuadamente, los agentes que se desplieguen no serán una “caja negra” que actúa sin supervisión, sino “agentes públicos” digitales, transparentes y auditables, diseñados para trabajar con datos abiertos, explicar sus decisiones y dejar rastro de las acciones que realizan. Herramientas, en definitiva, inclusivas, centradas en las personas y alineadas con los valores del servicio público.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Rampa es un servicio de rutas para personas con movilidad reducida. Este proyecto, desarrollado en el marco de los Premios a la reutilización de datos abiertos del Ayuntamiento de Madrid 2025, combina datos abiertos y tecnología geoespacial para facilitar la búsqueda de rutas y servicios accesibles para personas con movilidad reducida.

La aplicación web proporciona los siguientes datos:

- Accesibilidad: ofrece rutas optimizadas para sillas de ruedas, andadores y personas con movilidad reducida.

- Datos demográficos: permite visualizar índices de envejecimiento, dependencia y densidad poblacional para entender mejor las necesidades de cada área.

- Panel de control: permite visualizar las áreas con mayor y menor accesibilidad en Madrid y detecta los barrios y distritos más accesibles.

Plataforma web para filtrar y organizar las proposiciones del Congreso de los diputados según los votos de los partidos, con la capacidad que mostrar lo que han votado en conjunto o de forma distintas uno o varios partidos.

Como las proposiciones pueden tener varias votaciones se saca con un modelo de IA de ChatGPT la votación principal de cada proposición. También con IA se saca la información de los distintos puntos que tiene un proposición se genera una descripción explicativa y entendible para cualquier persona sobre la proposición.

El objetivo tener una plataforma donde se vea de forma clara y sencilla la actividad del Congreso de los Diputados.

La reutilización de los datos abiertos permite generar soluciones innovadoras que mejoran la vida de las personas, impulsan la participación ciudadana y refuerzan la transparencia pública. Prueba de ello son los concursos impulsados este año por la Junta de Castilla y León y el Ayuntamiento de Madrid.

Siendo la IX edición del Concurso de Castilla y León y la primera del de Madrid, ambas administraciones han hecho entrega de los premios a los proyectos seleccionados, reconociendo tanto a estudiantes y startups como a profesionales e investigadores que han sabido transformar datos públicos en herramientas y conocimientos útiles. En este post, repasamos los proyectos premiados en cada concurso y el contexto que los impulsa.

Castilla y León: novena edición de unos premios consolidados en una administración más abierta

En la entrega de los premios del IX Concurso de Datos Abiertos de la Junta de Castilla y León se puso en valor el refuerzo presupuestario (+65 %) en la Dirección General de Transparencia y Buen Gobierno, la ampliación de contenidos de publicidad activa y una mejora continua del derecho de acceso a la información pública, que ha reducido solicitudes y resoluciones desestimatorias. El Portal de Datos Abiertos de Castilla y León cuenta con 776 conjuntos de datos que permiten desarrollar servicios, aplicaciones y estudios cada año.

Los Premios Datos Abiertos reconocen iniciativas en cuatro categorías: Ideas, Productos y Servicios, Recursos Didácticos, Periodismo de Datos.

Ideas

-

Primer premio: CyL Rural Hub. Propuesta para desarrollar una plataforma integral del territorio rural que centralice servicios, infraestructuras, oportunidades laborales y oferta educativa. Su objetivo es facilitar a familias y profesionales información útil para planificar un proyecto de vida en los pueblos de la comunidad.

-

Segundo premio: App cultural de Castilla y León. Idea orientada a dinamizar la actividad cultural mediante una aplicación que centraliza eventos, actividades y localizaciones, ofreciendo además una experiencia intuitiva y cercana basada en datos abiertos.

Productos y Servicios

-

Primer premio: Puente CyL. Aplicación diseñada para apoyar la integración de personas migrantes mediante rutas personalizadas, un asistente de inteligencia artificial y un centro de recursos alimentado por datos públicos.

-

Segundo premio: MuniCyL. Herramienta que reúne información municipal dispersa y la presenta en una única plataforma clara, accesible y actualizada.

-

Tercer premio: Mapa interactivo de Espacios Naturales. Recurso que permite a los ciudadanos explorar los espacios protegidos del territorio de forma dinámica y en tiempo real.

-

Premios estudiantes: Info Salamanca. Plataforma que ofrece mapas interactivos, filtros temáticos y un asistente conversacional para acercar información provincial y facilitar la consulta de datos ciudadanos.

Recurso Didáctico

-

Primer premio: Uso de datos abiertos de la Junta de Castilla y León en desarrollo web. Un proyecto que introduce los datos abiertos en el aprendizaje del desarrollo web, con ejercicios prácticos y un buscador con IA para trabajar directamente con datos reales del portal.

Periodismo de Datos

-

Primer premio: Los infartos ya no son cosa de la edad, un reportaje sobre el aumento de infartos entre población joven.

-

Segundo premio: Burgos mantiene el liderazgo regional con 79 parques eólicos: un análisis del despliegue de energías renovables en la región.

Madrid: primera edición de unos premios que impulsan la reutilización en el ámbito urbano

Por otro lado, el Ayuntamiento de Madrid ha celebrado la primera edición de los Premios a la Reutilización de Datos Abiertos 2025. La ceremonia destacó la calidad y diversidad de las 65 candidaturas presentadas, muchas de ellas impulsadas por estudiantes universitarios y startups.

Los premios buscan impulsar el uso de los datos del Portal de Datos Abiertos del Ayuntamiento de Madrid, apoyar la creación de servicios y estudios que contribuyan al conocimiento de la ciudad y reforzar el papel del consistorio como administración referente en transparencia y rendición de cuentas.

En este caso, los galardones se estructuran en cuatro categorías: Servicios Web y Aplicaciones, Visualizaciones, Estudios e Ideas, y Mejora del Portal.

Servicios Web y Aplicaciones

-

Primer premio: Madriwa. Encuentra tu sitio en Madrid. Herramienta que facilita la búsqueda de vivienda mediante datos sobre barrios, servicios y precios, permitiendo una comparación informada y simplificada.

-

Segundo premio: Los guardianes del aire. Aplicación para consultar la calidad del aire de la ciudad, especialmente pensada para sensibilizar a población joven y centros educativos.

Visualizaciones

-

Primer premio: Rampa. Rutas para personas con movilidad reducida. Presenta itinerarios accesibles basados en datos geoespaciales y de orografía, ofreciendo rutas alternativas adaptadas a personas con movilidad reducida.

-

Segundo premio: AccesibiliMad. Muestra servicios públicos disponibles en cada entorno urbano, con especial atención a las necesidades específicas de distintos colectivos.

Estudios, Investigaciones e Ideas

-

Primer premio: Ciudades de quince minutos para la infancia. Análisis de la disponibilidad de servicios esenciales para menores en un radio máximo de 15 minutos, aportando una visión innovadora de planificación urbana.

-

Segundo premio: El impacto del turismo en las zonas urbanas. Estudio que profundiza en la relación entre viviendas turísticas, tejido comercial y dinámica laboral, utilizando datos urbanos y socioeconómicos.

Mejora de la Calidad del Portal

-

Primer premio: Your Open Data. Mejorando el harvesting en data.europa.eu. Propuesta que mejora la forma en que se facilitan los datos, elevando la calidad de los metadatos e impulsando la interoperabilidad europea.

-

Segundo premio: Descubrimiento, observabilidad y gobernanza inteligente de datos abiertos. Solución que introduce una capa automatizada de inteligencia y control sobre el catálogo municipal.

Tanto Castilla y León, con una trayectoria consolidada, como el Ayuntamiento de Madrid, que inaugura su propio reconocimiento, contribuyen de manera decisiva a fortalecer el ecosistema español de datos abiertos. Sus convocatorias son una muestra de cómo la colaboración entre administraciones, ciudadanía, ámbito académico y sector privado puede transformar los datos públicos en conocimiento, participación e innovación al servicio de toda la sociedad.

En el ecosistema del sector público, las subvenciones representan uno de los mecanismos más importantes para impulsar proyectos, empresas y actividades de interés general. Sin embargo, entender cómo se distribuyen estos fondos, qué organismos convocan ayudas más voluminosas o cómo varía el presupuesto según la región o los beneficiarios no es trivial cuando se trabaja con cientos de miles de registros.

En esta línea, presentamos un nuevo ejercicio práctico de la serie “Ejercicios de datos paso a paso”, en el que aprenderemos a explorar y modelar datos abiertos utilizando Apache Spark, una de las plataformas más extendidas para el procesamiento distribuido y el machine learning a gran escala.

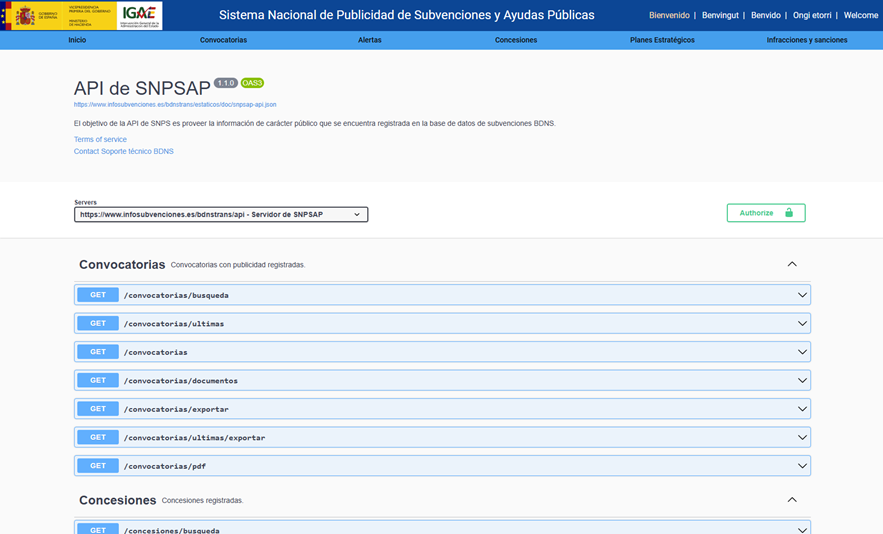

En este laboratorio trabajaremos con datos reales del Sistema Nacional de Publicidad de Subvenciones y Ayudas Públicas (BDNS) y construiremos un modelo capaz de predecir el rango de presupuesto de nuevas convocatorias en función de sus características principales.

Todo el código utilizado está disponible en el correspondiente repositorio de GitHub para que puedas ejecutarlo, entenderlo y adaptarlo a tus propios proyectos.

Accede al repositorio del laboratorio de datos en GitHub

Ejecuta el código de pre-procesamiento de datos sobre Google Colab

Contexto: ¿por qué analizar las subvenciones públicas?

La BDNS recoge información detallada sobre cientos de miles de convocatorias publicadas por distintas administraciones españolas: desde ministerios y consejerías autonómicas hasta diputaciones y ayuntamientos. Este conjunto de datos es una fuente extraordinariamente valiosa para:

-

analizar la evolución del gasto público,

-

entender qué organismos son más activos en ciertas áreas,

-

identificar patrones en los tipos de beneficiarios,

-

y estudiar la distribución presupuestaria según sector o territorio.

En nuestro caso, utilizaremos el dataset para abordar una pregunta muy concreta, pero de gran interés práctico:

¿Podemos predecir el rango de presupuesto de una convocatoria a partir de sus características administrativas?

Esta capacidad facilitaría tareas de clasificación inicial, apoyo a la toma de decisiones o análisis comparativos dentro de una administración pública.

Objetivo del ejercicio

El objetivo del laboratorio es doble:

- Aprender a manejar Spark de forma práctica:

- Cargar un dataset real de gran volumen

- Realizar transformaciones y limpieza

- Manipular columnas categóricas y numéricas

- Estructurar un pipeline de machine learning

2. Construir un modelo predictivo

Entrenaremos un clasificador capaz de estimar si una convocatoria pertenece a uno de estos rangos de presupuesto bajo (hasta 20 k€), medio (entre 20 y 150k€) o alto (superior a 150k€), basándonos para ello en variables como:

- Organismo concedente

- Comunidad Autónoma

- Tipo de beneficiario

- Año de publicación

- Descripciones administrativas

Recursos utilizados

Para completar este ejercicio empleamos:

Herramientas analíticas

- Python, lenguaje principal del proyecto

- Google Colab, para ejecutar Spark y crear Notebooks de forma sencilla

- PySpark, para el procesamiento de datos en las etapas de limpieza y modelado

- Pandas, para pequeñas operaciones auxiliares

- Plotly, para algunas visualizaciones interactivas

Datos

Dataset oficial del Sistema Nacional de Publicidad de Subvenciones (BDNS), descargado desde el portal de subvenciones del Ministerio de Hacienda.

Los datos utilizados en este ejercicio fueron descargados el 28 de agosto de 2025. La reutilización de los datos del Sistema Nacional de Publicidad de Subvenciones y Ayudas Públicas está sujeta a las condiciones legales recogidas en https://www.infosubvenciones.es/bdnstrans/GE/es/avisolegal.

Desarrollo del ejercicio

El proyecto se divide en varias fases, siguiendo el flujo natural de un caso real de data science.

5.1. Volcado y transformación de datos

En este primer apartado vamos a descargar automáticamente el dataset de subvenciones desde la API del portal del Sistema Nacional de Publicidad de Subvenciones (BDNS). Posteriormente transformaremos los datos a un formato optimizado como Parquet (formato de datos columnar) para facilitar su exploración y análisis.

En este proceso utilizaremos algunos conceptos complejos, como:

-

Funciones asíncronas: permite procesar en paralelo dos o más operaciones independientes, lo que facilita hacer más eficiente el proceso.

-

Escritor rotativo: cuando se supera un límite de cantidad de información el fichero que se está procesando se cierra y se abre uno nuevo con un índice autoincremental (a continuación del anterior). Esto evita procesar ficheros demasiado grandes y mejora la eficiencia.

Figura 1. Captura de la API del Sistema Nacional de Publicidad de Subvenciones y Ayudas Públicas

5.2. Análisis exploratorio

El objetivo de esta fase es obtener una primera idea de las características de los datos y de su calidad.

Analizaremos entre otros, aspectos como:

- Qué tipos de subvenciones tienen mayor número de convocatorias.

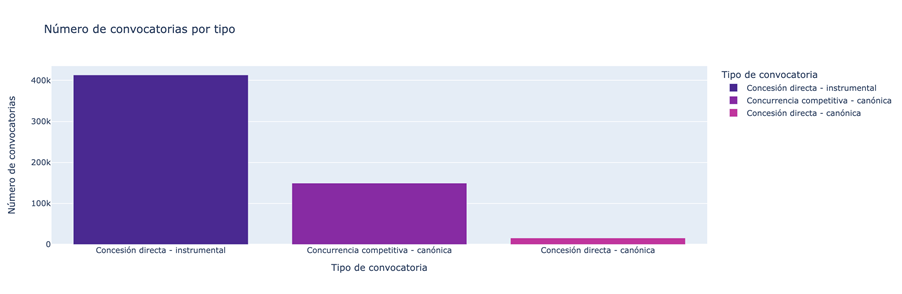

Figura 2. Tipos de subvenciones con mayor número de convocatorias.

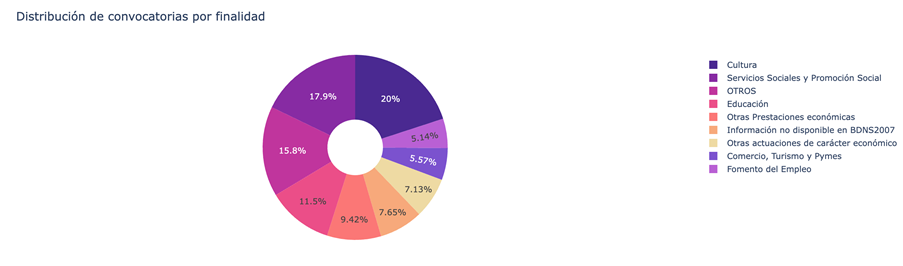

- Cuál es la distribución de las subvenciones en función de su finalidad (i.e. Cultura, Educación, Fomento del empleo…).

Figura 3. Distribución de las subvenciones en función de su finalidad.

- Qué finalidades agregan un mayor volumen presupuestario.

Figura 4. Finalidades con mayor volumen presupuestario.

5.3. Modelado: construcción del clasificador de presupuesto

Llegados a este punto, entramos en la parte más analítica del ejercicio: enseñar a una máquina a predecir si una nueva convocatoria tendrá un presupuesto bajo, medio o alto a partir de sus características administrativas. Para conseguirlo, diseñamos un pipeline completo de machine learning en Spark que nos permite transformar los datos, entrenar el modelo y evaluarlo de forma uniforme y reproducible.

Primero preparamos todas las variables —muchas de ellas categóricas, como el órgano convocante— para que el modelo pueda interpretarlas. Después combinamos toda esa información en un único vector que sirve como punto de partida para la fase de aprendizaje.

Con esa base construida, entrenamos un modelo de clasificación que aprende a distinguir patrones sutiles en los datos: qué organismos tienden a publicar convocatorias más voluminosas o cómo influyen elementos administrativos específicos en el tamaño de una ayuda.

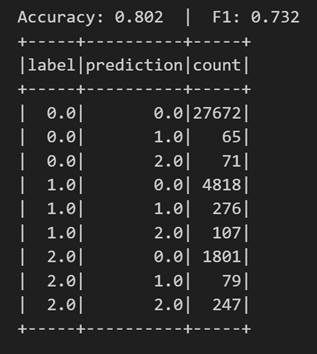

Una vez entrenado, analizamos su rendimiento desde distintos ángulos. Evaluamos su capacidad para clasificar correctamente los tres rangos de presupuesto y analizamos su comportamiento mediante métricas como la accuracy o la matriz de confusión.

Figura 5. Métricas accuracy.

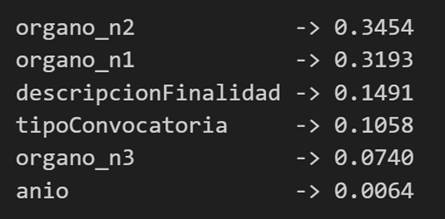

Pero no nos quedamos ahí: también estudiamos qué variables han tenido mayor peso en las decisiones del modelo, lo que nos permite entender qué factores parecen más determinantes a la hora de anticipar el presupuesto de una convocatoria.

Figura 6. Variables que han tenido mayor peso en las decisiones del modelo.

Conclusiones del ejercicio

Este laboratorio nos permitirá comprobar cómo Spark simplifica el procesamiento y modelado de datos de gran volumen, especialmente útiles en entornos donde las administraciones generan miles de registros al año, y conocer mejor el sistema de subvenciones tras analizar algunos aspectos clave de la organización de estas convocatorias.

¿Quieres realizar el ejercicio?

Si te interesa profundizar en el uso de Spark y en el análisis avanzado de datos públicos, puedes acceder al repositorio y ejecutar el Notebook completo paso a paso.

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Vivimos en una época en la que cada vez más fenómenos del mundo físico pueden observarse, medirse y analizarse en tiempo real. La temperatura de un cultivo, la calidad del aire de una ciudad, el estado de una presa, el flujo del tráfico o el consumo energético de un edificio ya no son datos que se revisan ocasionalmente: son flujos continuos de información que se generan segundo a segundo.

Esta revolución no sería posible sin los sistemas ciberfísicos (CPS), una tecnología que integra sensores, algoritmos y actuadores para conectar el mundo físico con el digital. Pero los CPS no sólo generan datos: también pueden alimentarse de datos abiertos, multiplicando su utilidad y permitiendo decisiones basadas en evidencia.

En este artículo exploraremos qué son los CPS, cómo generan datos masivos en tiempo real, qué retos plantea convertir esos datos en información pública útil, qué principios son esenciales para asegurar su calidad y trazabilidad, y qué ejemplos reales demuestran el potencial de su reutilización. Cerraremos con una reflexión sobre el impacto de esta combinación en la innovación, la ciencia ciudadana y el diseño de políticas públicas más inteligentes.

¿Qué son los sistemas ciberfísicos?

Un sistema ciberfísico es una integración estrecha entre componentes digitales —como software, algoritmos, comunicación y almacenamiento— y componentes físicos —sensores, actuadores, dispositivos IoT o máquinas industriales—. Su función principal es observar el entorno, procesar la información y actuar sobre él.

A diferencia de los sistemas tradicionales de monitorización, un CPS no se limita a medir: cierra un ciclo completo entre percepción, decisión y acción. Este ciclo se puede entender a través de tres elementos principales:

Figura 1. Ciclo de los sistemas ciberfísicos. Fuente: elaboración propia

Un ejemplo cotidiano que ilustra muy bien este ciclo completo de percepción, decisión y acción es el riego inteligente, cada vez más presente en la agricultura de precisión y en los sistemas domésticos de jardinería. En este caso, los sensores distribuidos por el terreno miden continuamente la humedad del suelo, la temperatura ambiente e incluso la radiación solar. Toda esa información fluye hacia la unidad de computación, que analiza los datos, los compara con umbrales previamente definidos o con modelos más complejos —por ejemplo, los que estiman la evaporación del agua o las necesidades hídricas de cada tipo de planta— y determina si realmente es necesario regar.

Cuando el sistema concluye que el suelo ha alcanzado un nivel de sequedad crítico, entra en juego el tercer elemento del CPS: los actuadores. Son ellos quienes abren las válvulas, activan la bomba de agua o regulan el caudal, y lo hacen durante el tiempo exacto necesario para devolver la humedad a niveles óptimos. Si las condiciones cambian —si empieza a llover, si la temperatura baja o si el suelo recupera humedad más rápido de lo esperado—, el propio sistema ajusta su comportamiento en consecuencia.

Todo este proceso ocurre sin intervención humana, de forma autónoma. El resultado es un uso más sostenible del agua, plantas mejor cuidadas y una capacidad de adaptación en tiempo real que solo es posible gracias a la integración de sensores, algoritmos y actuadores característica de los sistemas ciberfísicos.

Los CPS como fábricas de datos en tiempo real

Una de las características más relevantes de los sistemas ciberfísicos es su capacidad para generar datos de forma continua, masiva y con una resolución temporal muy alta. Esta producción constante puede apreciarse en múltiples situaciones del día a día:

- Una estación hidrológica puede registrar nivel y caudal cada minuto.

- Un sensor de movilidad urbana puede generar cientos de lecturas por segundo.

- Un contador inteligente registra el consumo eléctrico cada pocos minutos.

- Un sensor agrícola mide humedad, salinidad y radiación solar varias veces al día.

- Un dron cartográfico captura posiciones GPS decimétricas en tiempo real.

Más allá de estos ejemplos concretos, lo importante es comprender qué significa esta capacidad para el conjunto del sistema: los CPS se convierten en auténticas fábricas de datos, y en muchos casos llegan a funcionar como gemelos digitales del entorno físico que monitorizan. Esa equivalencia casi instantánea entre el estado real de un río, un cultivo, una carretera o una máquina industrial y su representación digital permite disponer de un retrato extremadamente preciso y actualizado del mundo físico, prácticamente al mismo tiempo que los fenómenos ocurren.

Esta riqueza de datos abre un enorme campo de oportunidades cuando se publica como información abierta. Los datos procedentes de CPS pueden impulsar servicios innovadores desarrollados por empresas, alimentar investigaciones científicas de alto impacto, potenciar iniciativas de ciencia ciudadana que complementen los datos institucionales, y reforzar la transparencia y la rendición de cuentas en la gestión de recursos públicos.

Sin embargo, para que todo ese valor llegue realmente a la ciudadanía y a la comunidad reutilizadora, es necesario superar una serie de retos técnicos, organizativos y de calidad que determinan la utilidad final del dato abierto. A continuación, analizamos cuáles son esos desafíos y por qué son tan importantes en un ecosistema cada vez más dependiente de información generada en tiempo real.

El reto: de datos en bruto a información pública útil

Que un CPS genere datos no significa que estos puedan publicarse directamente como datos abiertos. Antes de llegar a la ciudadanía y a las empresas reutilizadoras, la información necesita un trabajo previo de preparación, validación, filtrado y documentación. Las administraciones deben asegurarse de que esos datos son comprensibles, interoperables y fiables. Y en ese camino aparecen varios desafíos.

Uno de los primeros es la estandarización. Cada fabricante, cada sensor y cada sistema puede utilizar formatos distintos, diferentes frecuencias de muestreo o estructuras propias. Si no se armonizan esas diferencias, lo que obtenemos es un mosaico difícilmente integrable. Para que los datos sean interoperables se necesitan modelos comunes, unidades homogéneas, estructuras coherentes y estándares compartidos. Normativas como INSPIRE o los estándares de OGC (Open Geospatial Consortium) e IoT-TS son clave para que un dato generado en una ciudad pueda entenderse, sin transformación adicional, en otra administración o por cualquier reutilizador.

El siguiente gran reto es la calidad. Los sensores pueden fallar, quedarse congelados reportando siempre el mismo valor, generar lecturas físicamente imposibles, sufrir interferencias electromagnéticas o estar mal calibrados durante semanas sin que nadie lo note. Si esa información se publica tal cual, sin un proceso previo de revisión y limpieza, el dato abierto pierde valor e incluso puede inducir a errores. La validación —con controles automáticos y revisión periódica— es, por tanto, indispensable.

Otro punto crítico es la contextualización. Un dato aislado carece de significado. Un “12,5” no dice nada si no sabemos si son grados, litros o decibelios. Una medida de “125 ppm” no tiene utilidad si no conocemos qué sustancia se está midiendo. Incluso algo tan aparentemente objetivo como unas coordenadas necesita un sistema de referencia concreto. Y cualquier dato ambiental o físico solo puede interpretarse adecuadamente si se acompaña de la fecha, la hora, la ubicación exacta y las condiciones de captura. Todo esto forma parte de los metadatos, que son esenciales para que terceros puedan reutilizar la información sin ambigüedades.

También es fundamental abordar la privacidad y la seguridad. Algunos CPS pueden captar información que, directa o indirectamente, podría vincularse a personas, propiedades o infraestructuras sensibles. Antes de publicar los datos, es necesario aplicar procesos de anonimización, técnicas de agregación, controles de seguridad y evaluaciones de impacto que garanticen que el dato abierto no compromete derechos ni expone información crítica.

Por último, existen retos operativos como la frecuencia de actualización y la robustez del flujo de datos. Aunque los CPS generan información en tiempo real, no siempre es adecuado publicarla con la misma granularidad: en ocasiones es necesario agregarla, validar la coherencia temporal o corregir valores antes de compartirla. De igual modo, para que los datos sean útiles en análisis técnicos o en servicios públicos, deben llegar sin interrupciones prolongadas ni duplicados, lo que exige una infraestructura estable y mecanismos de supervisión.

Principios de calidad y trazabilidad necesarios para datos abiertos fiables

Superados estos retos, la publicación de datos procedentes de sistemas ciberfísicos debe apoyarse en una serie de principios de calidad y trazabilidad. Sin ellos, la información pierde valor y, sobre todo, pierde confianza.

El primero es la exactitud. El dato debe representar fielmente el fenómeno que mide. Esto requiere sensores correctamente calibrados, revisiones periódicas, eliminación de valores claramente erróneos y comprobación de que las lecturas se encuentran dentro de rangos físicamente posibles. Un sensor que marca 200 °C en una estación meteorológica o un contador que registra el mismo consumo durante 48 horas son señales de un problema que debe detectarse antes de la publicación.

El segundo principio es la completitud. Un conjunto de datos debe indicar cuándo hay valores perdidos, lagunas temporales o periodos en los que un sensor ha estado desconectado. Ocultar estos huecos puede llevar a conclusiones equivocadas, especialmente en análisis científicos o en modelos predictivos que dependen de la continuidad de la serie temporal.

El tercer elemento clave es la trazabilidad, es decir, la capacidad de reconstruir la historia del dato. Saber qué sensor lo generó, dónde está instalado, qué transformaciones ha sufrido, cuándo se capturó o si pasó por algún proceso de limpieza permite evaluar su calidad y fiabilidad. Sin trazabilidad, la confianza se erosiona y el dato pierde valor como evidencia.

La actualización adecuada es otro principio fundamental. La frecuencia con la que se publica la información debe adaptarse al fenómeno medido. Los niveles de contaminación atmosférica pueden necesitar actualizaciones cada pocos minutos; el tráfico urbano, cada segundo; la hidrología, cada minuto o cada hora según el tipo de estación; y los datos meteorológicos, con frecuencias variables. Publicar demasiado rápido puede generar ruido; demasiado lento, puede inutilizar el dato para ciertos usos.

El último principio es el de los metadatos enriquecidos. Los metadatos explican el dato: qué mide, cómo se mide, con qué unidad, qué precisión tiene el sensor, cuál es su rango operativo, dónde está ubicado, qué limitaciones tiene la medición y para qué se genera esa información. No son una nota al pie, sino la pieza que permite a cualquier reutilizador comprender el contexto y la fiabilidad del conjunto de datos. Con una buena documentación, la reutilización no solo es posible: se dispara.

Ejemplos: CPS que reutilizan datos públicos para ser más inteligentes

Además de generar datos, muchos sistemas ciberfísicos también consumen datos públicos para mejorar su desempeño. Esta retroalimentación convierte a los datos abiertos en un recurso central para el funcionamiento de los territorios inteligentes. Cuando un CPS integra información procedente de sensores propios con fuentes abiertas externas, su capacidad de anticipación, eficiencia y precisión aumenta de forma notable.

Agricultura de precisión: En el ámbito agrícola, los sensores instalados en el terreno permiten medir variables como la humedad del suelo, la temperatura o la radiación solar. Sin embargo, los sistemas de riego inteligente no dependen únicamente de esa información local: también incorporan predicciones meteorológicas de AEMET, mapas abiertos del IGN sobre pendiente o tipos de suelo y modelos climáticos publicados como datos públicos. Al combinar sus propias mediciones con estas fuentes externas, los CPS agrícolas pueden determinar con mucha mayor exactitud qué zonas del terreno necesitan agua, cuándo conviene sembrar y cuánta humedad debe mantenerse en cada cultivo. Esta gestión fina permite ahorros de agua y fertilizantes que, en algunos casos, superan el 30 %.

Gestión hídrica: Algo similar ocurre en la gestión del agua. Un sistema ciberfísico que controla una presa o un canal de riego necesita saber no solo qué está pasando en ese instante, sino qué puede ocurrir en las próximas horas o días. Por ello integra sus propios sensores de nivel con datos abiertos de aforos fluviales, predicciones de lluvia y nieve, e incluso información pública sobre caudales ecológicos. Con esta visión ampliada, el CPS puede anticipar inundaciones, optimizar el desembalse, responder mejor a fenómenos extremos o planificar el riego de forma sostenible. En la práctica, la combinación de datos propios y abiertos se traduce en una gestión más segura y eficiente del agua.

Impacto: innovación, ciencia ciudadana y decisiones basadas en datos

La unión entre sistemas ciberfísicos y datos abiertos genera un efecto multiplicador que se manifiesta en distintos ámbitos.

- Innovación empresarial: las empresas disponen de un terreno fértil para desarrollar soluciones basadas en información fiable y en tiempo real. A partir de datos abiertos y mediciones de CPS, pueden surgir aplicaciones de movilidad más inteligentes, plataformas de gestión hídrica, herramientas de análisis energético o sistemas predictivos para agricultura. El acceso a datos públicos reduce barreras de entrada y permite crear servicios sin necesidad de costosos datasets privados, acelerando la innovación y la aparición de nuevos modelos de negocio.

- Ciencia ciudadana: la combinación de CPS y datos abiertos también fortalece la participación social. Comunidades de vecinos, asociaciones o colectivos ambientales pueden desplegar sensores de bajo coste para complementar los datos públicos y entender mejor lo que ocurre en su entorno. Esto da lugar a iniciativas que miden el ruido en zonas escolares, monitorizan niveles de contaminación en barrios concretos, siguen la evolución de la biodiversidad o construyen mapas colaborativos que enriquecen la información oficial.

- Mejor toma de decisiones públicas: finalmente, los gestores públicos se benefician de este ecosistema de datos reforzado. La disponibilidad de mediciones fiables y actualizadas permite diseñar zonas de bajas emisiones, planificar de forma más efectiva el transporte urbano, optimizar redes de riego, gestionar situaciones de sequía o inundaciones o regular políticas energéticas basadas en indicadores reales. Sin datos abiertos que complementen y contextualicen la información generada por los CPS, estas decisiones serían menos transparentes y, sobre todo, menos defendibles ante la ciudadanía.

En resumen, los sistemas ciberfísicos se han convertido en una pieza esencial para entender y gestionar el mundo que nos rodea. Gracias a ellos podemos medir fenómenos en tiempo real, anticipar cambios y actuar de forma precisa y automatizada. Pero su verdadero potencial se despliega cuando sus datos se integran en un ecosistema de datos abiertos de calidad, capaz de aportar contexto, enriquecer decisiones y multiplicar usos.

La combinación de CPS y datos abiertos permite avanzar hacia territorios más inteligentes, servicios públicos más eficientes y una participación ciudadana más informada. Aporta valor económico, impulsa la innovación, facilita la investigación y mejora la toma de decisiones en ámbitos tan diversos como la movilidad, el agua, la energía o la agricultura.

Para que todo esto sea posible, es imprescindible garantizar la calidad, trazabilidad y estandarización de los datos publicados, así como proteger la privacidad y asegurar la robustez de los flujos de información. Cuando estas bases están bien asentadas, los CPS no solo miden el mundo: lo ayudan a mejorar, convirtiéndose en un puente sólido entre la realidad física y el conocimiento compartido.

Contenido elaborado por Dr. Fernando Gualo, Profesor en UCLM y Consultor de Gobierno y Calidad de datos. El contenido y el punto de vista reflejado en esta publicación es responsabilidad exclusiva de su autor.

El portal europeo de datos abiertos ha publicado el tercer volumen de su Observatorio de Casos de Uso (Use Case Observatory, en inglés), un informe que recopila la evolución de proyectos de reutilización de datos en toda Europa. Esta iniciativa pone de relieve los avances logrados en cuatro áreas: impacto económico, gubernamental, social y medioambiental.

El cierre de una investigación de tres años

Entre 2022 y 2025, el portal europeo de datos abiertos ha llevado a cabo un seguimiento sistemático de la evolución de diversos proyectos europeos. La investigación comenzó con una selección inicial de 30 iniciativas representativas, que fueron analizadas en profundidad para identificar su potencial de impacto.

Tras dos años, 13 proyectos continuaron en el estudio, entre los que se encontraban tres españoles: Planttes, Tangible Data y UniversiDATA-Lab. Se estudió su desarrollo a lo largo del tiempo para comprender cómo la reutilización de datos abiertos puede generar beneficios reales y sostenibles.

La publicación del volumen III en octubre de 2025 marca el cierre de esta serie de informes, tras el volumen I (2022) y el volumen II (2024). Este último documento ofrece una visión longitudinal, mostrando cómo los proyectos han madurado en tres años de observación y qué impactos concretos han generado en sus respectivos contextos.

Conclusiones comunes

Este tercer y último informe recopila una serie de conclusiones clave:

Impacto económico

Los datos abiertos impulsan el crecimiento y la eficiencia en todos los sectores. Contribuyen a la creación de empleo, tanto de forma directa como indirecta, facilitan procesos de contratación más inteligentes y estimulan la innovación en ámbitos como la planificación urbana y los servicios digitales.

El informe muestra el ejemplo de:

- Naar Jobs (Bélgica): una aplicación para la búsqueda de empleo cerca del domicilio de los usuarios y focalizada en las opciones de transporte disponible.

Esta aplicación demuestra cómo los datos abiertos pueden convertirse en un motor para el empleo regional y el desarrollo empresarial.

Impacto gubernamental

La apertura de datos fortalece la transparencia, la rendición de cuentas y la participación ciudadana.

A este campo pertenecen dos casos de uso analizados:

- Waar is mijn stemlokaal? (Holanda): plataforma para la búsqueda de colegios electorales.

- Statsregnskapet.no (Noruega): web para visualizar los ingresos y gastos del gobierno.

Ambos ejemplos evidencian cómo el acceso a la información pública empodera a los ciudadanos, enriquece el trabajo de los medios de comunicación y respalda la elaboración de políticas basadas en evidencia. Todo ello ayuda a reforzar los procesos democráticos y la confianza en las instituciones.

Impacto social

Los datos abiertos promueven la inclusión, la colaboración y el bienestar.

A este campo pertenecen las siguientes iniciativas analizadas:

- UniversiDATA-Lab (España): repositorio de datos universitarios que facilita aplicaciones analíticas.

- VisImE-360 (Italia): herramienta para mapear la discapacidad visual y orientar recursos sanitarios.

- Tangible Data (España): empresa centrada en realizar esculturas físicas que convierten datos en experiencias accesibles.

- EU Twinnings (Países Bajos): plataforma que compara regiones europeas para encontrar “ciudades gemelas”

- Open Food Facts (Francia): base de datos colaborativa sobre productos alimenticios.

- Integreat (Alemania): aplicación que centraliza información pública para apoyar la integración de migrantes.