¿Te imaginas una IA capaz de escribir canciones, novelas, comunicados de prensa, entrevistas, ensayos, manuales técnicos, código de programación, prescribir medicamentos y mucho más que aún no sabemos? Viendo a GPT-3 en acción no parece que estemos muy lejos.

En nuestro último informe sobre procesamiento del lenguaje natural (NLP) mencionamos el algoritmo GPT-2 desarrollado por OpenAI (la compañía fundada por nombres tan reconocidos cómo Elon Musk) como un exponente en cuanto a sus capacidades para la generación de texto sintético con una calidad indistinguible de cualquier otro texto creado por un humano. Los sorprendentes resultados de GPT-2 llevaron a la compañía a no publicar el código fuente del algoritmo por sus potenciales efectos negativos en la generación de deepfakes o noticias falsas.

Recientemente (mayo de 2020) se ha liberado una nueva versión del algoritmo, ahora denominado GPT-3 que incluye novedades funcionales y mejoras de rendimiento y capacidad de analizar y generar textos en lenguaje natural.

En este post tratamos de resumir de forma sencilla y asequible las principales novedades de GPT-3. ¿Te atreves a descubrirlas?

Comenzamos de forma directa, yendo al grano. ¿Qué trae consigo GPT-3? (adaptación de el post original de Mayor Mundada).

- Es mucho más grande (complejo) que todo lo que teníamos antes. Los modelos de deep learning basados en redes neuronales se suelen clasificar por su número de parámetros. A mayor número de parámetros, mayor es la profundidad de la red y por lo tanto su complejidad. El entrenamiento de la versión completa de GPT-2 daba cómo resultado 1.500 millones de parámetros. GPT-3 da cómo resultado 175.000 millones de parámetros. GPT-3 ha sido entrenado sobre una base de 570 GB de texto comparados con los 40 GB de GPT-2.

- Por primera vez puede ser utilizado cómo un producto o servicio. Es decir, OpenAI, ha anunciado la puesta a disposición de los usuarios de un API público para poder experimentar con el algoritmo. En el momento de escribir este post, el acceso al API está restringido (es lo que denominamos un private preview) y hay que solicitar acceso.

- Lo más importante: sus resultados. A pesar de que la API se encuentra restringida por invitación, son numerosos los usuarios en Internet (con acceso a la API) que han publicado artículos sobre sus resultados en diferentes ámbitos.

¿Qué papel juegan los datos abiertos?

En pocas ocasiones se tiene la posibilidad de ver la potencia y los beneficios de los datos abiertos cómo en este tipo de proyectos. Cómo hemos comentado más arriba GPT-3 ha sido entrenado con 570 GB de datos en formato de texto. Pues bien, resulta que el 60% de los datos de entrenamiento del algoritmo vienen de la fuente https://commoncrawl.org. Common Crawl es un proyecto abierto y colaborativo que proporciona un corpus para la investigación, el análisis, la educación, etc. Cómo se especifica en la web de Common Crawl los datos proporcionados son abiertos y se hospedan bajo la iniciativa de datos abiertos de AWS. Buena parte del resto de datos de entrenamiento también son abiertos incluyendo fuentes cómo Wikipedia.

Casos de uso

A continuación mostramos algunos de los ejemplos y casos de uso impactantes.

Generación de texto sintético

En esta entrada (no spoilers ;) ) del blog de Manuel Araoz se muestra la potencia del algoritmo para generar un artículo 100% sintético sobre Inteligencia Artificial. Manuel realiza el siguiente experimento: proporciona a GPT-3 una mínima descripción de su biografía incluida en su blog y un pequeño fragmento de la última entrada en su blog. 117 palabras en total. Tras 10 ejecuciones de GPT-3 para generar texto artificial relacionado, Manuel es capaz de copiar y pegar el texto generado, colocar una imagen de portada y ya tiene listo un nuevo post para su blog. Honestamente, el texto del post sintético es indistinguible de un post original salvo por los posibles errores en nombres, fechas, etc. que pueda incluir el texto.

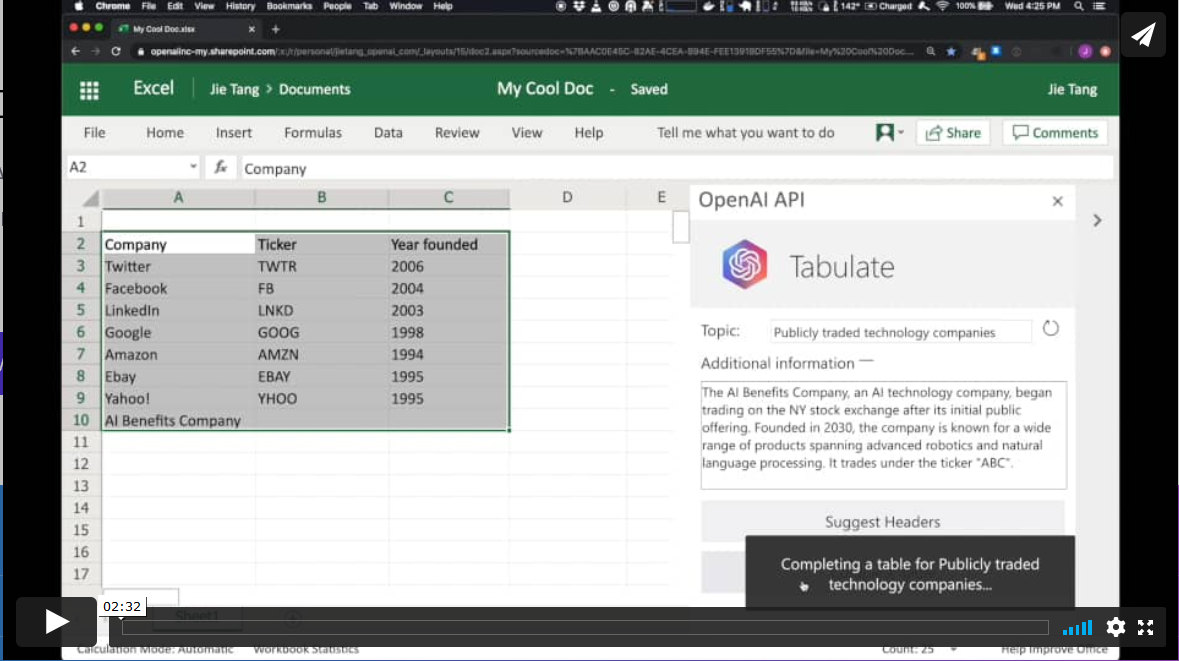

Productividad. Generación automática de tablas de datos.

En otro ámbito diferente, el algoritmo GPT-3 tiene aplicaciones en el ámbito de la productividad. En este ejemplo GPT-3 es capaz de crear una tabla de MS Excel sobre un determinado tema. Por ejemplo, si queremos obtener una tabla, a modo de lista, con las compañías tecnológicas más representativas y su año de fundación, simplemente proporcionamos a GPT-3 el patrón deseado y le pedimos que lo complete. El patrón de inicio puede ser algo similar a esta tabla de debajo (en un ejemplo real, los datos de entrada serán en inglés). GPT-3 completará la zona sombreada con datos reales. Sin embargo, si además del patrón de entrada, le proporcionamos al algoritmo una descripción verosímil de una compañía tecnológica ficticia y le volvemos a pedir que complete la tabla con la nueva información, el algoritmo incluirá los datos de esta nueva compañía ficticia.

Estos ejemplos son solo una muestra de lo que GPT-3 es capaz de hacer. Entre sus funcionalidades o aplicaciones se encuentran:

- la búsqueda semántica (diferente de la búsqueda por palabras clave)

- los chatbots

- la revolución de los servicios de atención al cliente (call-center)

- la generación de texto multipropósito (creación de poemas, novelas, música, noticias falsas, artículos de opinión, etc.)

- las herramientas de productividad. Hemos visto un ejemplo sobre cómo crear tablas de datos, pero se está hablando (y mucho), sobre la posibilidad de crear programas informáticos sencillos cómo páginas web y pequeñas aplicaciones sencillas sin necesidad de codificar, tan solo preguntándole a GPT-3 y sus hermanos que están por llegar.

- las herramientas de traducción on-line

- la comprensión y resúmenes de textos.

y tantas otras cosas que aún no hemos descubierto... Seguiremos informándoles sobre las próximas novedades en NLP y en particular de GPT-3, un game-changer que ha venido para revolucionar todo lo que conocemos por el momento.

Contenido elaborado por Alejandro Alija,experto en Transformación Digital e Innovación.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El impulso de la digitalización en la actividad industrial constituye uno de los ejes principales para abordar la transformación que pretende impulsar la Agenda España Digital 2025. A este respecto, son varias las iniciativas que ya se han puesto en marcha desde las instituciones públicas, entre las que destacan el programa Industria Conectada 4.0, a través del cual se pretende fomentar un marco de actuación conjunta y coordinada del sector público y privado en este ámbito.

Al margen de los debates acerca de lo que supone la Industria 4.0 y los desafíos que plantea, entre los principales requerimientos que se han identificado para evaluar la madurez y viabilidad de este tipo de proyectos se encuentra el relativo a la existencia de “una estrategia de recopilación, análisis y uso de datos relevantes, fomentando la implantación de tecnologías que lo faciliten, orientada a la toma de decisiones y a la satisfacción del cliente”, así como el uso de tecnologías que “permitan obtener modelos predictivos y prescriptivos, por ejemplo, Big Data e Inteligencia Artificial”. Precisamente, la Estrategia Española de I+D+I Artificial otorga una singular relevancia al uso masivo de datos que, en definitiva, precisa de su disponibilidad en condiciones adecuadas, tanto desde una perspectiva cuantitativa como cualitativa. En el caso de la Industria 4.0 esta exigencia se convierte en estratégica, en particular si se tiene en cuenta que casi la mitad del gasto tecnológico de las empresas está vinculado a la gestión de datos.

Aunque una parte relevante de los datos serán los que se generen en el desarrollo de su propia actividad por parte de las empresas, no puede obviarse que la reutilización de datos de terceros adquiere una singular importancia por el valor añadido que aporta, sobre todo por lo que se refiere a la información proporcionada por las entidades del sector público. En todo caso, los sectores concretos donde se desarrolle la actividad industrial determinarán qué tipo de datos resulten de especial utilidad. En este sentido, la industria alimentaria puede tener mayor interés en conocer con la mayor precisión posible no sólo la predicción meteorológica sino también datos históricos relacionados con el clima y, de este modo, planificar adecuadamente tanto su producción como, asimismo, la gestión de su personal, las actividades logísticas e, incluso, inversiones futuras. O, siguiendo con otro ejemplo, desde la industria farmacéutica y la vinculada al suministro de material sanitario se podrían adoptar decisiones más eficaces y eficientes si se pudiera acceder en condiciones adecuadas a información actualizada proveniente de los sistemas de salud autonómicos lo que, en última instancia redundaría no sólo en su propio beneficio sino, adicionalmente, en la mejor satisfacción de los propios intereses públicos.

Más allá de las particularidades de cada uno de los sectores sobre los que se proyecte la concreta actividad empresarial, con carácter general las entidades del sector público disponen de bancos de datos relevantes cuya efectiva apertura a fin de permitir su reutilización de manera automatizada sería de gran interés a la hora de facilitar la transformación digital de la actividad industrial. En concreto, la disponibilidad de información socio-económica puede aportar un indiscutible valor añadido, de manera que la adopción de las decisiones sobre la propia actividad de las empresas pueda estar basada en datos generados por los servicios de estadística pública, en parámetros que tengan relevancia desde la perspectiva de la actividad económica —caso, por ejemplo, de los tributos o los niveles de renta— o, incluso, en la planificación de la propia actividad de las entidades públicas con implicaciones patrimoniales, como sucede en el ámbito de las subvenciones o la contratación. Por otro lado, son numerosos los registros públicos con información estructurada cuya apertura aportaría un importante valor añadido desde la perspectiva industrial, tal y como sucede con aquellos que proporcionen información relevante sobre la población o la apertura de establecimientos que desarrollen actividades económicas que incidan directa o indirectamente sobre las condiciones en las que se desarrolla la actividad industrial, ya sea por lo que respecta a las condiciones de producción o sobre el mercado en el que se distribuyan sus productos. Adicionalmente, la accesibilidad de la información ambiental, urbanística y, en general, sobre la ordenación territorial supondría un indiscutible en el contexto de la transformación digital de la actividad industrial, ya que permitiría integrar variables esenciales para los tratamientos de datos que precisan este tipo de empresas.

Ahora bien, la disponibilidad de datos de terceros en los proyectos vinculados a la Industria 4.0 no puede limitarse únicamente al sector público, ya que resulta de especial trascendencia poder contar con datos proporcionados por sujetos privados. En concreto, existen ciertos sectores de actividad en los que su accesibilidad con fines de reutilización por parte de las empresas industriales presentaría una singular relevancia, tal y como sucede con el ámbito de las telecomunicaciones, la energía o, entre otros, las entidades financieras. Sin embargo, a diferencia de lo que sucede con los datos generados en el ámbito del sector público, no existe una regulación que obligue a que los sujetos privados ofrezcan información a terceros generada en el desarrollo de su propia actividad en formatos abiertos y reutilizables.

Es más, puede concurrir en ocasiones un interés legítimo por parte de tales entidades para evitar que otros sujetos accedan a los datos que tienen en su poder caso, por ejemplo, de que eventuales derechos de propiedad intelectual o industrial se vean afectados, existan obligaciones contractuales que cumplir o, simplemente, razones comerciales aconsejen evitar que información relevante esté disponible a empresas competidoras. Sin embargo, salvo la tímida regulación europea dirigida a facilitar la libre circulación de datos que no tengan carácter personal, no existe un marco normativo específico que resulte de aplicación para el sector privado por lo que, en última instancia, la posibilidad de reutilización de información relevante para proyectos relacionados con la Industria 4.0 estaría limitada a los acuerdos que puedan alcanzarse de manera voluntaria.

Así pues, el decidido impulso de la Industria 4.0 requiere la existencia de un adecuado ecosistema por lo que respecta a la accesibilidad de los datos generados por otras entidades que, en definitiva, no se pueden limitar única y exclusivamente al sector público. No se trata simplemente de adoptar una perspectiva de incrementar la eficiencia desde la perspectiva de los costes sino, más bien, de optimizar todos los procesos; lo que también afecta a ciertos aspectos sociales de creciente importancia como la eficiencia energética, el respeto al medio ambiente o la mejora en las condiciones laborales. Y es precisamente en relación a estos desafíos donde el papel que ha de jugar la Administración Pública resulta crucial, no sólo ofreciendo datos relevantes para su reutilización por parte de las empresas industriales sino, sobre todo, impulsando la consolidación de un modelo de producción tecnológica y socialmente avanzando a partir de los parámetros de la Industria 4.0, lo que requiere dinamizar igualmente unas condiciones jurídicas adecuadas que garanticen la accesibilidad de información generada por entidades privadas en ciertos sectores estratégicos.

Contenido elaborado por Julián Valero, catedrático de la Universidad de Murcia y Coordinador del Grupo de Investigación “Innovación, Derecho y Tecnología” (iDerTec).

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El machine learning es una rama dentro del campo de la Inteligencia Artificial que proporciona a los sistemas la capacidad de aprender y mejorar de manera automática, a partir de la experiencia. Estos sistemas transforman los datos en información, y con esta información pueden tomar decisiones. Para que un modelo realice predicciones de manera robusta, necesita alimentarse de datos. Cuantos más, mejor. Afortunadamente, hoy en día la red está repleta de fuentes de datos. En muchas ocasiones, los datos son recolectados por empresas privadas para su propio beneficio, pero también existen otras iniciativas, como, por ejemplo, portales de datos abiertos.

Una vez disponemos de los datos, estamos en disposición de comenzar el proceso de aprendizaje. Este proceso, llevado a cabo por un algoritmo, trata de analizar y explorar los datos en búsqueda de patrones ocultos. El resultado de este aprendizaje, a veces, no es más que una función que opera sobre los datos para calcular una determinada predicción.

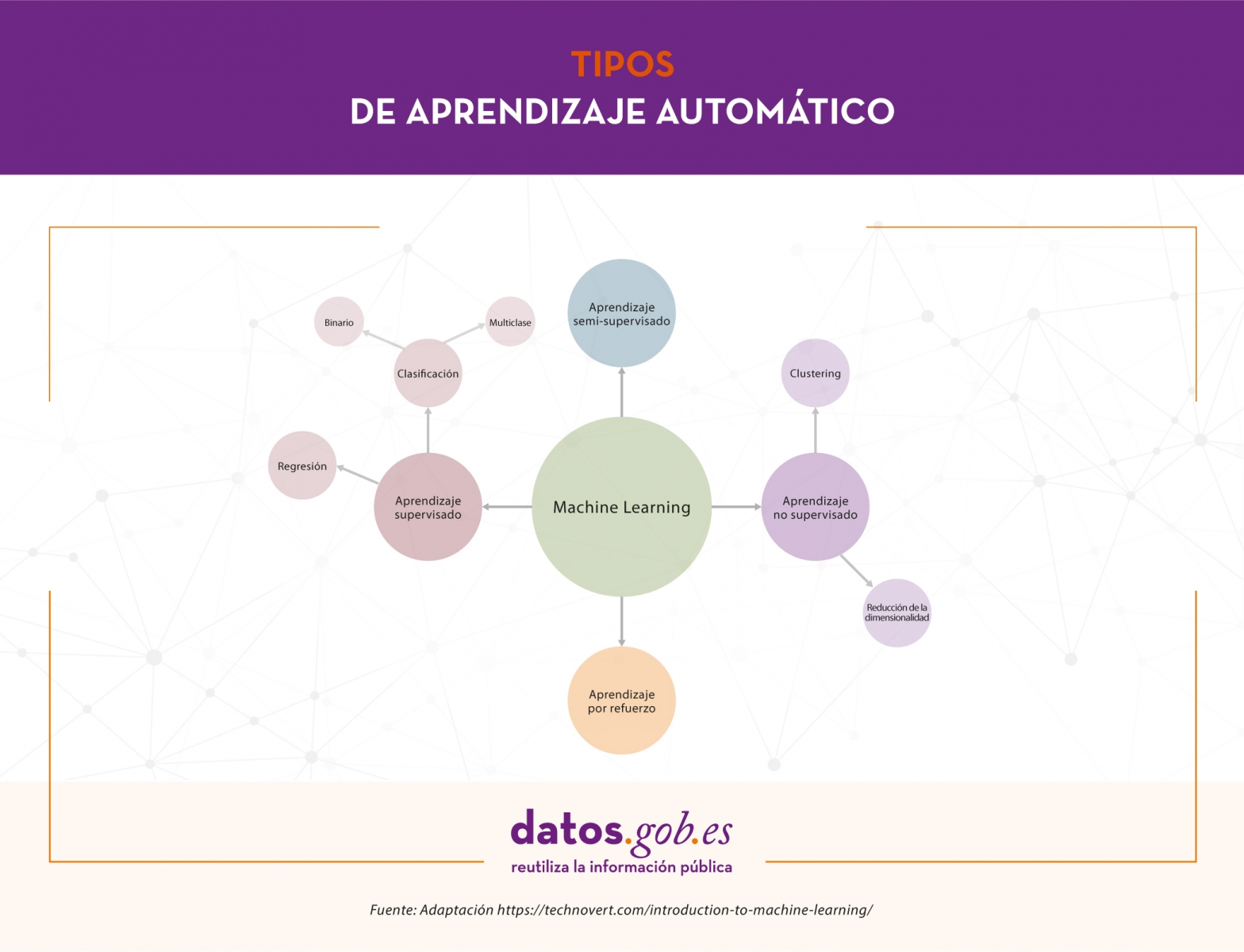

En este artículo vamos a ver los tipos de aprendizaje automático que existen incluyendo algunos ejemplos.

Tipos de aprendizaje automático

Dependiendo de los datos disponibles y la tarea que queramos abordar, podemos elegir entre distintos tipos de aprendizaje. Estos son: aprendizaje supervisado, aprendizaje no supervisado, aprendizaje semi-supervisado y aprendizaje por refuerzo.

Aprendizaje supervisado

El aprendizaje supervisado necesita conjuntos de datos etiquetados, es decir, le decimos al modelo qué es lo que queremos que aprenda. Supongamos que tenemos una heladería y durante los últimos años hemos estado registrando diariamente datos climatológicos, temperatura, mes, día de la semana, etc., y también hemos hecho lo propio con el número de helados vendidos cada día. En este caso, seguramente nos interesaría entrenar un modelo que, a partir de los datos climatológicos, temperatura, etc. (características del modelo) de un día concreto, nos diga cuántos helados se van a vender (la etiqueta a predecir).

Dependiendo del tipo de etiqueta, dentro del aprendizaje supervisado existen dos tipos de modelos:

- Los modelos de clasificación, que producen como salida una etiqueta discreta, es decir, una etiqueta dentro de un conjunto finito de etiquetas posibles. A su vez, los modelos de clasificación pueden ser binarios si tenemos que predecir entre dos clases o etiquetas (enfermedad o no enfermedad, clasificación de correos electrónicos como “spam” o no “spam”) o multiclase, cuando se tiene que clasificar más de dos clases (clasificación de imágenes de animales, análisis de sentimientos, etc.).

- Los modelos de regresión producen como salida un valor real, como el ejemplo que comentábamos de los helados.

Aprendizaje no supervisado

Por su parte, el aprendizaje no supervisado trabaja con datos que no han sido etiquetados. No tenemos una etiqueta que predecir. Estos algoritmos se usan principalmente en tareas donde es necesario analizar los datos para extraer nuevo conocimiento o agrupar entidades por afinidad.

Este tipo de aprendizaje también tiene aplicaciones para reducir dimensionalidad o simplificar conjuntos de datos. En el caso de agrupar datos por afinidad, el algoritmo debe definir una métrica de similitud o distancia que le sirva para comparar los datos entre sí. Como ejemplo de aprendizaje no supervisado tenemos los algoritmos de agrupamiento o clustering, que podrían aplicarse para encontrar clientes con características similares a los que ofrecer determinados productos o destinar una campaña de marketing, descubrimiento de tópicos o detección de anomalías, entre otros. Por otro lado, en ocasiones, algunos conjuntos de datos como los relacionados con información genómica tienen grandes cantidades de características y por varias razones, como, por ejemplo, reducir el tiempo de entrenamiento de los algoritmos, mejorar el rendimiento del modelo o facilitar la representación visual de los datos, necesitamos reducir la dimensionalidad o número de columnas del conjunto de datos. Los algoritmos de reducción de dimensionalidad utilizan técnicas matemáticas y estadísticas para convertir el conjunto de datos original en uno nuevo con menos dimensiones a cambio de perder un poco de información. Ejemplos de algoritmos de reducción de dimensionalidad son PCA, t-SNE o ICA.

Aprendizaje semi-supervisado

En ocasiones, es muy complicado disponer de un conjunto de datos completamente etiquetado. Imaginemos que somos los dueños de una empresa de fabricación de productos lácteos y queremos estudiar la imagen de marca de nuestra empresa a través de los comentarios que los usuarios han publicado en redes sociales. La idea es crear un modelo que clasifique cada comentario como positivo, negativo o neutro para, después, hacer el estudio. Lo primero que hacemos es bucear por las redes sociales y recolectar dieciséis mil mensajes donde se menciona a nuestra empresa. El problema ahora es que no tenemos etiqueta en los datos, es decir, no sabemos cuál es el sentimiento de cada comentario. Aquí entra en juego el aprendizaje semi-supervisado. Este tipo de aprendizaje tiene un poco de los dos anteriores. Usando este enfoque, se comienza etiquetando manualmente algunos de los comentarios. Una vez tenemos una pequeña porción de comentarios etiquetados, entrenamos uno o varios algoritmos de aprendizaje supervisado sobre esa pequeña parte de datos etiquetados y utilizamos los modelos resultantes del entrenamiento para etiquetar el resto de comentarios. Finalmente, entrenamos un algoritmo de aprendizaje supervisado utilizando como etiquetas las etiquetadas manualmente más las generadas por los modelos anteriores.

Aprendizaje por refuerzo

Por último, el aprendizaje por refuerzo es un método de aprendizaje automático que se basa en recompensar los comportamientos deseados y penalizar los no deseados. Aplicando este método, un agente es capaz de percibir e interpretar el entorno, ejecutar acciones y aprender a través de prueba y error. Es un aprendizaje que fija objetivos a largo plazo para obtener una recompensa general máxima y lograr una solución óptima. El juego es uno de los campos más utilizados para poner a prueba el aprendizaje por refuerzo. AlphaGo o Pacman son algunos juegos donde se aplica esta técnica. En estos casos, el agente recibe información sobre las reglas del juego y aprende a jugar por sí mismo. Al principio, evidentemente, se comporta de manera aleatoria, pero con el tiempo empieza a aprender movimientos más sofisticados. Este tipo de aprendizaje se aplica también en otras áreas como la robótica, la optimización de recursos o sistemas de control.

El aprendizaje automático es una herramienta muy poderosa que convierte los datos en información y facilita la toma de decisiones. La clave está en definir de manera clara y concisa el objetivo del aprendizaje para, dependiendo de las características del conjunto datos que disponemos, seleccionar el tipo de aprendizaje que mejor se ajusta para dar una solución que responda a las necesidades.

Contenido elaborado por Jose Antonio Sanchez, experto en Ciencia de datos y entusiasta de la Inteligencia Artificial .

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El Bosco, Tiziano, El Greco, Rubens, Velázquez, Goya... El Museo Nacional del Prado cuenta con más de 35.000 obras de un valor incuestionable, que lo convierten en una de las pinacotecas más importantes del mundo.

En el año de su bicentenario, nos acercamos al Prado de la mano de Javier Pantoja, Jefe de Área de Desarrollo Digital, para conocer qué proyectos innovadores están llevando a cabo para enriquecer la experiencia de sus visitantes.

-

En los últimos años, el Museo del Prado ha puesto en marcha una serie de proyectos tecnológicos encaminados a acercar sus colecciones a la ciudadanía. ¿Cómo surge esta idea? ¿En qué consiste la estrategia digital del Museo del Prado?

El Museo del Prado no busca solo desarrollar una estrategia digital, si no que quiere que “lo digital” sea parte de la estrategia del museo. Por ello, los 3 últimos planes estratégicos han contado con una línea de acción específica para el área digital.

Cuando hablamos de estrategia digital en el Prado, nos referimos a dos aspectos. Por un lado, hablamos de procesos, es decir, de la mejora de la gestión interna. Pero también buscamos que las herramientas digitales pueden hacer que el Prado llegue a un mayor número de público.

Nuestra intención es que la tecnología sea una herramienta, no un fin por sí misma. Hay una apuesta muy fuerte por tecnologías como los datos enlazados o la inteligencia artificial, pero siempre sin perder el objetivo de difundir la labor del Prado.

-

¿Qué tipo de tecnologías están implementando y cómo lo están haciendo? ¿Puede contarnos algunos proyectos concretos?

El punto más interesante del proyecto fue el lanzamiento de la web actual del Prado a finales de 2015. Buscábamos crear una web semántica, concebir las colecciones y la información sobre ellas de otra manera distinta, que permitiera ir más allá, y generar proyectos de lectura aumentada o la línea del tiempo que hemos presentado recientemente y que utiliza Inteligencia Artificial.

Ha sido un proceso de muchos años. Lo primero que había que hacer era digitalizar y documentar la colección, y para ello necesitábamos aplicativos internos que permitieran a todas las áreas del museo nutrir con su conocimiento, y de forma homogénea, las bases de datos.

Y después había que poner esa información a disposición del público aplicando modelos de web semántica. Es decir, necesitábamos definir semánticamente cada elemento: qué es una “técnica”, un “soporte”, un “pintor”, un “escultor”… Se trataba de crear relaciones entre todos los datos para dar como resultado grafos de conocimiento. Por ejemplo, relacionar a Goya con los libros que existen sobre él, los reyes que gobernaron en su tiempo, las técnicas que utilizaba, etc. La labor era tediosa, pero necesaria para obtener buenos resultados.

Esto permitió crear un buscador facetado, que ayudaba a acercar la colección a un grupo mucho más extenso de usuarios. Con un buscador booleano tienes que saber qué estás buscando, mientras que con el facetado es más sencillo buscar relaciones.

Toda esta labor informática de actualización, revisión y publicación de información, dio paso a una segunda parte del proyecto: era necesario hacer atractiva la información, que la web fuera estética, bonita y con un alta usabilidad. No hay que olvidar que nuestro objetivo era “poner el Prado en internet”. Había que crear una web de datos, pero que fuera fácil de utilizar. Al final el Prado es un museo de obras de arte y lo que busca es acercar ese arte a los ciudadanos.

El resultado fue una web que ha obtenido varios premios y reconocimientos.

-

¿Y cómo surgieron los proyectos de lectura aumentada y la línea del tiempo?

Surgen de una cuestión muy sencilla. Pongamos como ejemplo que un usuario entra en la ficha de la obra La Anunciación de Fra Angelico. En ella se mencionan términos como Fiésole o Taddeo Gaddi, que gran parte del público no sabe qué o quiénes son. Es decir, la información que se estaba dando, muy bien escrita y documentada, no llegaba a todo el público.

Aquí había dos soluciones. Por un lado, se podía realizar una ficha de obra con un nivel básico, pero es muy complejo crear un texto adaptado a cualquier persona, independientemente de su edad, nacionalidad, etc. Por eso se optó por otra solución: ¿Qué hace un usuario cuando no sabes algo? Lo busca en Google y pincha en Wikipedia.

Como el Museo del Prado no puede ser una enciclopedia, apostamos por aprovechar el conocimiento de Wikipedia y de DBpedia. Principalmente por 3 motivos:

- Disponía de la estructura de conocimiento precisa

- Permitía tener una enciclopedia de contexto

- Era una fuente abierta

- ¿Cuáles son los retos y barreras que se han encontrado a la hora reutilizar estos datos?

Antes de nada, teníamos que anotar una a una todas las entidades, ciudades, reyes… La labor era imposible, ya que actualmente hay 16.000 fichas de obra publicadas en la web. Además, el Prado está constantemente estudiando y revisando publicaciones.

Por ello recurrimos a un motor de reconocimiento del lenguaje natural: la maquina lee el texto y la Inteligencia Artificial lo entiende como un humano, extrae las entidades y las desambiguan. La máquina va procesando el lenguaje, que entiende en base al contexto, para lo cual utilizamos el grafo de conocimiento que ya teníamos y las relaciones entre las diferentes entidades a través de DBpedia.

El trabajo lo realizamos junto con Telefónica -empresa patrocinadora- y GNOSS -empresa desarrolladora-; y el grado de fiabilidad fue muy alto, entre el 80% y el 90%. Aun así, había cuestiones complejas. Por ejemplo, cuando se habla de “anunciación de la virgen”, no sabemos si nos referimos al concepto, a la iglesia que hay en Milán a algunos de los cuadros que existen sobre esta temática… Para garantizar que todo estaba correcto, el servicio de documentación del museo las revisó.

- ¿Cuál fue el siguiente paso?

Ya teníamos una lectura aumentada. Fue en este punto en el que nos preguntamos ¿por qué no hacer visible esas relaciones? Y así surgió la línea del Tiempo: un cúmulo de nuevos grafos de conocimiento que permitían al usuario ver de una manera más sencilla las relaciones entre conceptos, fruto de la explotación de la web de datos enlazados.

Las líneas del tiempo suelen ser unicapa, pero nosotros queríamos ir más allá y creamos una estructura multicapa, que permitiera entender y profundizar más en los conceptos: una capa de historia, otra de literatura, arquitectura, filosofía, artes escénicas… De esta forma podemos ver fácilmente, por ejemplo, qué obras se crearon durante la guerra de 100 años.

Para ello hubo que hacer una revisar de los conjuntos de datos y seleccionar los conceptos por el interés que generan y el contexto que aportaban a la colección del Prado.

- Este tipo de proyectos tienen un gran potencial para ser utilizados en el ámbito educativo…

Sí, nuestra herramienta tiene una intención divulgativa marcada y cuenta con un gran potencial para explotarse en ambientes educativos. Hemos intentado ponerlo fácil para que cualquier profesor o divulgador tenga a un golpe de vista todo el contexto de una obra.

Pero también se podría utilizar para aprender partes de historias. Por ejemplo, se puede contar la Guerra de la Independencia con las pinturas del 2 y 3 de mayo de Goya. De esta forma se podría conseguir un aprendizaje más activo, y basado en las relaciones entre conceptos.

La herramienta tiene un enfoque más apropiado para secundaria y bachillerato, pero también podría utilizarse en otras etapas.

- ¿Qué perfiles son necesarios para llevar a cabo un proyecto de este tipo?

Para llevar a cabo todo el proyecto creamos equipos multidisciplinares, integrados por diseñadores, informáticos, documentalistas…

Hay muy buenos especialistas haciendo semántica, trabajando en datos enlazados, inteligencia artificial, etc. Pero también es necesario contar con gente con las ideas para unir el rompecabezas en algo usable y útil para el usuario. Es decir, unir voluntades y conocimiento, en torno a una idea global y unos objetivos. Los avances tecnológicos están muy bien, y hay que conocerlos para poder aprovechar sus ventajas, pero siempre con un objetivo claro.

- ¿Podría comentarnos cuáles son los próximos pasos que van a seguir en materia de innovación tecnológica?

Nos gustaría llegar a acuerdos con otros museos y entidades para que todo el conocimiento esté integrado. Nos gustaría enriquecer la información y entrelazarla con datos de instituciones culturales y museísticas internacionales y nacionales.

Ya contamos con algunas alianzas, por ejemplo, se llegó a un acuerdo con de la Filmoteca Nacional y el archivo visual de RTVE, y nos gustaría seguir trabajando en esa línea.

Además, continuaremos trabajando con nuestros datos para acercar la colección del Prado a todos los ciudadanos. El Museo tiene que ser el primer reutilizador de sus fuentes pues es quien mejor las conoce y quién puede sacar de ellas un buen resultado.

La ciencia de datos es un campo interdisciplinar que busca extraer conocimiento actuable a partir de conjuntos de datos, estructurados en bases de datos o no estructurados como textos, audios o vídeos. Gracias a la aplicación de nuevas técnicas, la ciencia de datos nos está permitiendo responder preguntas que no son fáciles de resolver a través de otros métodos. El fin último es diseñar acciones de mejora o corrección a partir del nuevo conocimiento que obtenemos.

El concepto clave en ciencia de datos es CIENCIA, y no tanto datos, ya que incluso se ha comenzado a hablar de un cuarto paradigma de la ciencia, añadiendo el enfoque basado en datos a los tradicionales teórico, empírico y computacional.

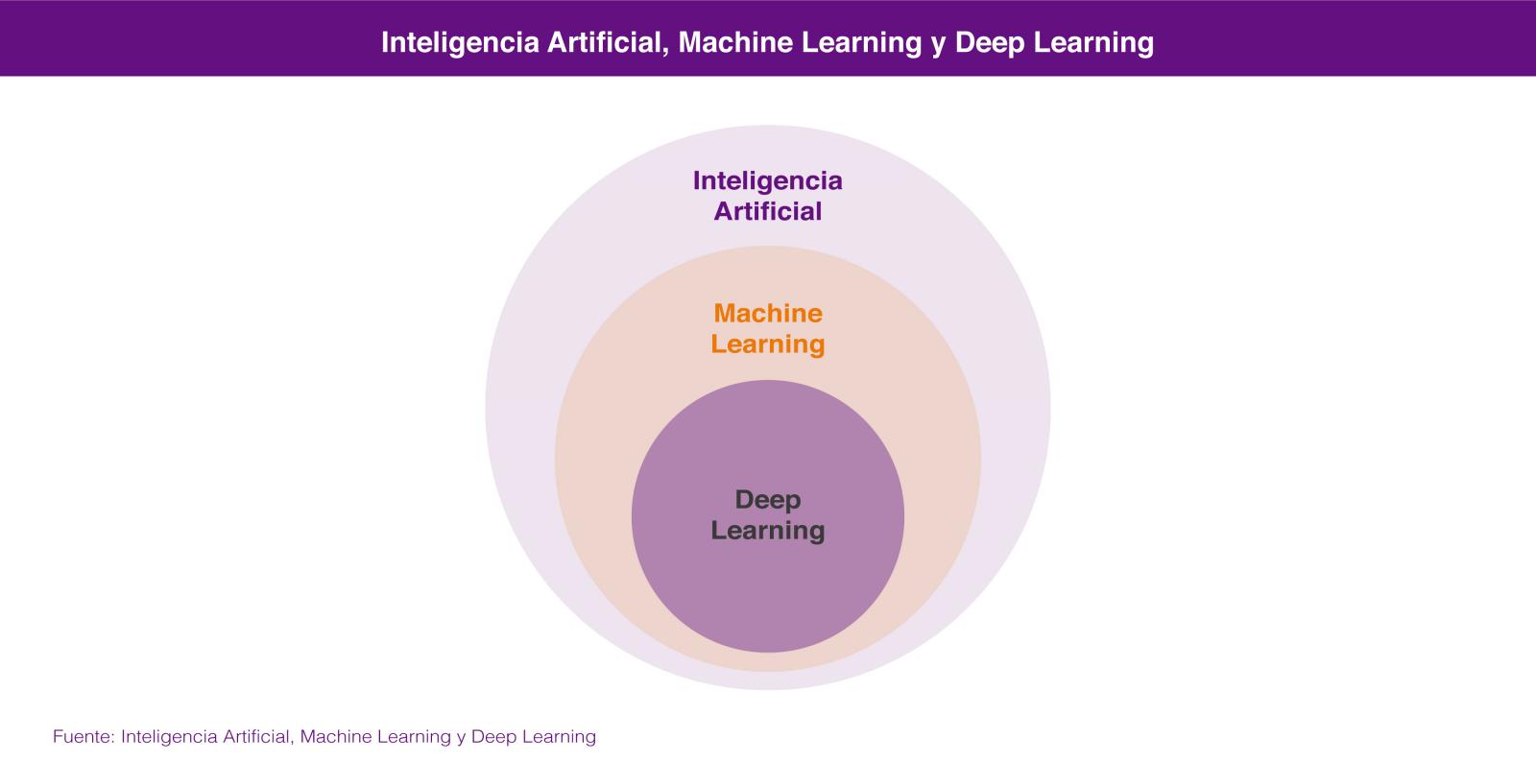

La ciencia de datos combina métodos y tecnologías que provienen de las matemáticas, la estadística y la informática, y entre las que encontramos el análisis exploratorio, el aprendizaje automático (machine learning), el aprendizaje profundo (deep learning), el procesamiento del lenguaje natural, la visualización de datos y el diseño experimental.

Dentro de la Ciencia de Datos, las dos tecnologías de las que más se está hablando son el Aprendizaje Automático (Machine Learning) y el Aprendizaje profundo (Deep Learning), ambas englobadas en el campo de la inteligencia artificial. En los dos casos se busca la construcción de sistemas que sean capaces de aprender a resolver problemas sin la intervención de un humano y que van desde los sistemas de predicción ortográfica o traducción automática hasta los coches autónomos o los sistemas de visión artificial aplicados a casos de uso tan espectaculares como las tiendas de Amazon Go.

En los dos casos los sistemas aprenden a resolver los problemas a partir de los conjuntos de datos que les enseñamos para entrenarlos en la resolución del problema, bien de forma supervisada cuando los conjuntos de datos de entrenamiento están previamente etiquetados por humanos, o bien de forma no supervisada cuando estos conjuntos de datos no están etiquetados.

En realidad lo correcto es considerar el aprendizaje profundo como una parte del aprendizaje automático por lo que, si tenemos que buscar un atributo que nos permita diferenciarlas, éste sería su forma de aprender, que es completamente diferente. El aprendizaje automático se basa en algoritmos (redes bayesianas, máquinas de vectores de soporte, análisis de clusters, etc) que son capaces de descubrir patrones a partir de las observaciones incluidas en un conjunto de datos. En el caso del aprendizaje profundo se emplea un enfoque que está inspirado, salvando las distancias, en el funcionamiento de las conexiones de las neuronas del cerebro humano y existen también numerosas aproximaciones para diferentes problemas, como por ejemplo las redes neuronales convolucionales para reconocimiento de imágenes o las redes neuronales recurrentes para procesamiento del lenguaje natural.

La idoneidad de un enfoque u otro la marcará la cantidad de datos que tengamos disponibles para entrenar nuestro sistema de inteligencia artificial. En general podemos decir que para pequeñas cantidades de datos de entrenamiento, el enfoque basado en redes neuronales no ofrece un rendimiento superior al enfoque basado en algoritmos. El enfoque basado en algoritmos se suele estancar a partir de una cierta cantidad de datos, no siendo capaz de ofrecer una mayor precisión aunque le enseñemos más casos de entrenamiento. Sin embargo, a través del aprendizaje profundo podemos extraer un mejor rendimiento a partir de esa mayor disponibilidad de datos, ya que el sistema suele ser capaz de resolver el problema con una mayor precisión, cuanto más casos de entrenamiento tenga a su disposición.

Ninguna de estas tecnologías es nuevas en absoluto, ya que llevan décadas de desarrollo teórico. Sin embargo en los últimos años se han producido avances que han rebajado enormemente la barrera para trabajar con ellas: liberación de herramientas de programación que permiten trabajar a alto nivel con conceptos muy complejos, paquetes de software open source para administrar infraestructuras de gestión de datos, herramientas en la nube que permiten acceder a una potencia de computación casi sin límites y sin necesidad de administrar la infraestructura, e incluso formación gratuita impartida por algunos de los mejores especialistas del mundo.

Todo ello está contribuyendo a que capturemos datos a una escala sin precedentes y los almacenemos y procesemos a unos costes aceptables que permiten resolver problemas antiguos con enfoques novedosos. La inteligencia artificial está además al alcance de muchas más personas, cuya colaboración en un mundo cada vez más conectado están dando lugar a innovaciones que avanzan a un ritmo cada vez más veloz en todos los ámbitos: el transporte, la medicina, los servicios, la industria, etc.

Por algo el trabajo de científico de datos ha sido denominado el trabajo más sexy del siglo 21.

Contenido elaborado por Jose Luis Marín, Head of corporate Technology Strategy en MADISON MK y CEO de Euroalert.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

No todos los titulares de prensa sobre Inteligencia Artificial son ciertos, pero tampoco cometas el error de subestimar los cambios que se avecinan en los próximos años gracias al desarrollo de la IA.

La inteligencia artificial no ha cambiado aún nuestras vidas y sin embargo estamos viviendo un ciclo de sobreexpectación sobre sus resultados y aplicaciones en el corto plazo. Los medios de comunicación no especializados y los departamentos de marketing de empresas y otras organizaciones potencian un clima de optimismo excesivo en cuanto a los logros actuales en el desarrollo de la IA.

Indudablemente, todos podemos hacerle a nuestro smartphone algunas preguntas sencillas y obtener respuestas bastante razonables. En nuestras compras on-line (por ejemplo en Amazon.com), experimentamos la recomendación de productos personalizados en base a nuestro perfil como compradores. Podemos buscar eventos en nuestra biblioteca de fotografías digitales alojada en algún servicio on-line como Google Photos. Con tan solo escribir, “cumpleaños de mama” en segundos obtendremos una lista de fotos de ese día con una precisión relativamente alta. Sin embargo, todavía no ha llegado el momento donde la IA modifique nuestra experiencia diaria al consumir productos y servicios digitales o físicos. A día de hoy, nuestro médico no usa la IA para apoyar su diagnóstico y nuestro abogado o asesor financiero no usa la IA para preparar un recurso o invertir mejor nuestro dinero.

La actualidad nos inunda con infografías fotorealistas de un mundo lleno de coches autónomos y asistentes virtuales con los que conversamos como si de una persona se tratara. El riesgo de la sobreexpectación en el corto plazo es que, en todo proceso de desarrollo de una tecnología disruptiva y exponencial, la tecnología, necesariamente, falla. Esto conduce a un estado de decepción que conlleva una reducción de las inversiones por parte de empresas y estados, lo que a su vez produce una ralentización en el desarrollo de dicha tecnología. El desarrollo de la IA no es ajena a este proceso y ya ha conocido dos etapas de ralentización. Estas etapas históricas se conocen como los “inviernos de la inteligencia artificial”. El primer invierno de la IA tuvo lugar tras los primeros años de la década de 1970. Tras el nacimiento de lo que hoy conocemos como IA - en la década de 1950 - a finales de los años 60, Marvin Minsky llegó a asegurar en 1967 que “... en el transcurso de una generación … el problema de crear una inteligencia artificial estará prácticamente solucionado...”. Tan solo tres años más tarde, el mismo Minsky precisaba: “... dentro de tres a ocho años habremos logrado una máquina con una inteligencia artificial superior a la del ser humano...”

En la actualidad ningún experto se atrevería a precisar cuándo (si es que) pudiera ocurrir esto. El conocido como segundo invierno de la IA llegaba en los primeros años de la década de los noventa del siglo pasado. Tras un periodo de sobreexpectación de los entonces conocidos como “sistemas expertos”. Los sistemas expertos son programas informáticos que contienen reglas lógicas que codifican y parametrizan el funcionamiento de sistemas sencillos. Por ejemplo, un programa informático que codifica las reglas del juego de ajedrez pertenece al tipo de programas que conocemos como sistemas experto. La codificación de reglas lógicas fijas para simular el comportamiento de un sistemas es lo que se conoce como inteligencia artificial simbólica y fue el primer tipo de inteligencia artificial que se desarrolló.

Entre 1980 y 1985 las empresas habían llegado a invertir más de mil millones de dólares estadounidenses cada año en el desarrollo de estos sistemas. Tras este periodo, se demostró que éstos resultaban ser extremadamente caros de mantener así como muy poco escalables y con escasos resultados para la inversión que suponían. El recorrido histórico del desarrollo de la IA desde sus inicios en 1950 hasta la actualidad es una lectura muy recomendada y apasionante.

¿Que ha conseguido la inteligencia artificial hasta el momento?

Si bien decimos que debemos de ser prudentes con las expectativas en cuanto a las aplicaciones de la inteligencia artificial que veremos en el corto plazo, debemos puntualizar aquí, cuáles han sido los principales logros de la inteligencia artificial desde un punto de vista estrictamente riguroso. Para ello nos basaremos en el libro de Francois Chollet con J.J. Allaire, Deep Learning with R. Manning Shelter Island (2018)

-

Clasificación de imágenes a nivel casi-humano.

-

Reconocimiento de lenguaje hablado a nivel casi-humano

-

Transcripción de lenguaje escrito a nivel casi-humano.

-

Mejora sustancial en la conversión de texto a lenguaje hablado.

-

Mejora sustancial en las traducciones.

-

Conducción autónoma a nivel casi humano.

-

Capacidad de responder a preguntas en lenguaje natural.

-

Jugadores (Ajedrez o Go) que superan con creces las capacidades humanas.

Tras esta breve introducción del momento histórico en el que nos encontramos con respecto a la IA, estamos en condiciones de definir de forma ligeramente más formal qué es la inteligencia artificial y a qué campos de la ciencia y la tecnología afecta directamente en su desarrollo.

La inteligencia Artificial podría definirse como: el campo de la ciencia que estudia la posibilidad de automatizar tareas intelectuales que normalmente son ejecutadas por humanos. La realidad es que el dominio científico de la IA se divide normalmente en dos sub-campos de las ciencias de la computación y la matemática denominadas Machine Learning y Deep Learning. La representación de esta afirmación se puede ver en la figura 1.

Figura 1. Inteligencia Artificial y sub-campos como el Machine Learning y el Deep Learning.

No vamos a entrar aquí en consideraciones técnicas sobre la diferencia entre machine learning y deep learning (puedes conocer más sobre estos conceptos en este post). Sin embargo, quizás lo más interesante es entender el cambio de paradigma que se produce desde los primeros desarrollo de la IA basados en reglas lógicas hasta la concepción moderna de nuestros días, donde las máquinas averiguan esas reglas que gobiernan un cierto proceso (por ejemplo, el riesgo de padecer un infarto de miocardio) en base a unos datos de entrada y a las experiencias previas que han sido registradas y analizadas por un cierto algoritmo. La figura 2 representa ese cambio de paradigma entre la programación clásica de reglas lógicas y la aproximación del machine learning o el aprendizaje autónomo de las máquinas.

Figura 2. El cambio de paradigma del Machine Learning con respecto a la programación clásica.

El rápido desarrollo que está viviendo la IA en nuestros días es fruto de múltiples factores. Sin embargo todos los expertos coinciden en que dos de ellos han sido y son claves para potenciar esta tercera ola de desarrollo de la inteligencia artificial: el abaratamiento del coste de computación por los ordenadores y la explosión de datos disponibles gracias a Internet y los dispositivos conectados.

Al igual que Internet ha impactado, y más que lo va a hacer, en todos los ámbitos de nuestras vidas - desde el consumidor final hasta los procesos y modelos operativos de las empresas y las industrias más tradicionales -, la IA va a cambiar radicalmente la forma en que los humanos utilizamos nuestras capacidades para el desarrollo de nuestra especie. No son pocas las noticias sobre la repercusión negativa que la IA va a tener sobre los puestos de trabajo en los próximos 10-20 años. Si bien es indudable que la automatización de ciertos procesos va a eliminar algunos puestos de trabajo que aún existen en la actualidad, no es menos cierto que, son precisamente, aquellos puestos de trabajo que nos hacen ser “menos humanos” los que primero van a desaparecer. Aquellos puestos de trabajo que emplean a las personas como máquinas para repetir las mismas acciones, una tras otra, serán sustituidos por agentes dotados con IA, bien sean en forma de software o en forma de robots equipados con IA.

Las tareas iterativas y predecibles caerán en el dominio exclusivo de las máquinas. Por el contrario, aquellas tareas que requieren de liderazgo, empatía, creatividad y juicios de valor seguirán perteneciendo únicamente a los humanos. ¿Entonces, ya está? ¿No tenemos nada más que hacer que esperar a que las máquinas hagan parte del trabajo y nosotros la otra parte? La respuesta es no. La realidad es que se crea un gran espacio en el medio de estos dos extremos. El espacio en que el humano es amplificado por la IA y a cambio la IA es entrenada por humanos para retroalimentar este ciclo intermedio. Paul R. Daugherty y H. James Wilson, definen en su libro Human + Machine este espacio como “The missing middle”, algo así como el espacio intermedio perdido. En este espacio intermedio, las máquinas dotadas con IA aumentan las capacidades humanas, nos hacen más fuertes con exoesqueletos capaces de levantar cargas pesadas o devolvernos la capacidad de andar tras una parálisis; nos hacen menos vulnerables al trabajar en ambientes potencialmente dañinos como el espacio, el fondo del mar o en una tubería con gases mortales; Nos aumentan nuestras capacidades sensoriales en tiempo real con gafas que portan cámaras y sensores que complementan nuestro campo de visión con información contextual superpuesta.

Con la ayuda de las máquinas dotadas con una IA mejorada, no es difícil imaginar cómo cambiarán los procesos y las tareas de mantenimiento en una fábrica, la forma tan diferente en la que se cultivarán nuestros campos, como trabajarán los almacenes del futuro y la eficiencia con la que se auto-gestionarán nuestros hogares.

En conclusión, dejemos de mirar a las máquinas y la IA como rivales por los que nos disputaremos nuestros puestos de trabajo y comencemos a pensar en la forma en la que vamos a fusionar nuestras habilidades más humanas con las capacidades superiores de las máquinas en cuanto a resistencia, velocidad y precisión.

Hagamos las cosas diferentes ahora para hacer cosas diferentes en el futuro.

Contenido elaborado por Alejandro Alija,experto en Transformación Digital e Innovación.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La adopción comercial de cualquier nueva tecnología por parte de la industria y por tanto su incorporación a la cadena de valor de los negocios, en forma de innovaciones, sigue un ciclo que puede ser modelado de diferentes formas. Uno de los modelos más conocidos es el hype cycle que utiliza Gartner en sus publicaciones. En lo que se refiere a la inteligencia artificial y la ciencia de datos, la discusión actual se centra en si se ha alcanzado ya el pico de expectativas sobredimensionadas o si, por el contrario, seguiremos viendo como aumentan las promesas de nuevas y revolucionarias innovaciones.

A medida que se avanza en este ciclo lo habitual es que se produzcan nuevos avances en la tecnología (la aparición de nuevos algoritmos en el caso de la Inteligencia Artificial) o en el conocimiento de las posibilidades de aplicación comercial de estos avances (nuevos productos o productos mejorados en precio o funcionalidad). Y por supuesto cuantas más industrias y sectores se ven afectados, mayores son las expectativas que se generan.

Sin embargo los nuevos descubrimientos no se quedan sólo en el plano de la tecnología sino que es habitual que también se profundice en el estudio y comprensión del impacto económico, social, legal o ético derivado de las innovaciones que van llegando al mercado. Para cualquier negocio es esencial detectar y comprender lo antes posible cuál es el impacto que una nueva tecnología va a tener en su cadena de valor ya que de este modo podrá incorporarla entre sus capacidades antes que sus competidores y generar ventajas competitivas.

Una de las tesis más interesantes que se han publicado recientemente para modelar y comprender el impacto económico de la Inteligencia Artificial es la que propone el profesor Ajay Agrawal junto con Joshua Gans y Avi Goldfarb en su libro “Prediction Machines: The Simple Economics of Artificial Intelligence”. La premisa es muy sencilla ya que parte de establecer que desde un punto de vista meramente económico el propósito de la inteligencia artificial es reducir el coste de las predicciones.

Cuando se reduce el coste de una materia prima o tecnología, lo habitual es que la industria comience a utilizarla cada vez más, primero para los productos o servicios para los que fue ideada y más tarde para otros que se resolvían o fabricaban de otro modo. En ocasiones incluso termina afectando al valor de productos sustitutivos (que baja) y complementarios (que sube) o a otros elementos de la cadena de valor.

A pesar de que se trata de tecnologías muy complejas los autores han conseguido establecer un marco económico para entender la IA sorprendentemente sencillo. Pero pensemos en un caso concreto, familiar para todos nosotros, en el que el aumento de la precisión de las predicciones llevado al extremo podría significar, no sólo a automatizar una serie de tareas, sino a cambiar por completo las reglas de un negocio.

Como todos sabemos, Amazon utiliza Inteligencia Artificial para el sistema de recomendaciones de compra que ofrece a sus usuarios sugerencias de nuevos productos que podría interesarles adquirir. Tal y como mencionan los autores en su libro, la precisión de este sistema ronda el 5%. Esto quiere decir que los usuarios adquieren 1 de cada 20 productos que Amazon les sugieren, lo cual no está nada mal.

Si Amazon consiguiese aumentar la precisión de estas predicciones, digamos al 20%, es decir, si consiguiese que los usuarios adquiriesen 1 de cada 5 productos sugeridos, Amazon aumentaría sus beneficios enormemente y el valor de la compañía se dispararía aún más. Pero si nos imaginamos un sistema capaz de tener un precisión del 90% en las predicciones de compra de los usuarios, Amazon podría plantearse cambiar radicalmente su modelo de negocio y enviarnos los productos antes de que decidamos comprarlos ya que sólo devolveríamos 1 de cada 10. La IA no se limitaría a automatizar tareas o a mejorar nuestra experiencia de compra sino que cambiaría radicalmente la forma en la que entendemos la industria del comercio minorista.

Dado que el principal sustituto de las predicciones que nos proporciona la inteligencia artificial son las predicciones que realizamos los humanos, parece claro que nuestro valor como herramienta predictiva seguirá bajando. El avance de la ola de automatizaciones basadas en inteligencia artificial y ciencia de datos ya nos permite ver el comienzo de esta tendencia.

Por el contrario los datos de las compañías se convertirían en un activo cada vez más valioso, ya que son el principal producto complementario necesario para generar predicciones correctas. Asimismo, los datos públicos, necesarios para enriquecer los datos de las compañías, y así hacer posibles nuevos casos de uso también aumentarían su valor.

Siguiendo esta línea de razonamiento podríamos atrevernos a establecer métricas para medir el valor de los datos públicos allí donde se utilizasen. Tan sólo tendríamos que responder la pregunta: ¿cuánto mejora la precisión de una determinada predicción si enriquecemos el entrenamiento con determinamos datos abiertos? Estas mejoras tendrían un valor concreto que nos podría dar una idea del valor económico de un conjunto de datos públicos en un escenario determinado.

El repetido mantra “los datos son el nuevo petróleo” está pasando de ser una afirmación política o de marketing a estar sustentada por la ciencia económica ya que los datos no dejan de ser la materia prima necesaria e indispensable para hacer buenas y valiosas predicciones. Y parece claro que para que el coste de las predicciones siga bajando, el valor de los datos deberá aumentar. Simple economía.

Contenido elaborado por Jose Luis Marín, Head of corporate Technology Strategy en MADISON MK y CEO de Euroalert.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Las nuevas tecnologías están cambiando el mundo en el que vivimos. Cambia la sociedad, cambia la economía, y con ello, los puestos de trabajo. La incorporación de tecnologías como la Inteligencia Artificial, el Big Data o el Internet de las Cosas están impulsando la demanda de nuevos perfiles profesionales que hace una década ni siquiera concebíamos. A ello hay que sumar las posibilidades de automatizar tareas actualmente desarrolladas por humanos, ejecutándolas de manera más rápida y eficiente, lo que lleva a algunos profesionales a pensar que su puesto de trabajo puede peligrar. Dar respuesta a esta situación es uno de los grandes retos que tenemos por delante.

De acuerdo con el informe It´s learning. Just not as we know. How to accelerate skills acquisition in the age of intelligent technologies, realizado por G20 Young Entrepreneurs’ Alliance y Accenture, si no se desarrollan las habilidades necesarias para este cambio, las economías de los países del G20 podrían perder hasta 11,5 billones de euros en el crecimiento acumulado del PIB en los próximos diez años.

Pero este cambio no es sencillo. No se trata solo de la aparición de nuevas profesiones y la desaparición de las viejas, sino de la evolución de los roles tradicionales. De acuerdo con el estudio, el 90% del tiempo de cada trabajador se verá afectado por las nuevas tecnologías. Tomando la media de todos los sectores, el 38% del tiempo laboral lo dedicamos actualmente a tareas que serán automatizadas, mientras que el 51% son actividades que podrán ser “mejoradas”, utilizando nuevas tecnologías que nos ayuden a aumentar nuestras habilidades. En definitiva, la solución no es solo formar a más ingenieros o analistas de datos, ya que incluso estos perfiles tendrán que evolucionar para adaptarse a un futuro que está más próximo de los que parece.

Para conocer cómo va a afectar este cambio a los distintos perfiles profesionales, el informe lleva a cabo un análisis de las tareas y habilidades necesarias para realizar los trabajos actuales, determinando cómo van a evolucionar en el futuro. Para facilitar el análisis, se han agrupado las profesiones en torno a 10 roles distintos. El siguiente cuadro muestra el resultado del estudio:

| Roles | Actividades representativas | Ejemplos de profesiones | Ejemplo de cómo evolucionaría su actividad |

|---|---|---|---|

| Dirección & Liderazgo | Supervisan y toman decisiones. | Directivos y educadores. | Los directivos de marketing manejan los datos ellos mismos y toman decisiones basadas en información procedente de las redes sociales y las métricas web. |

| Empatía & Soporte | Ofrecen apoyo experto y orientación. | Psiquiatras y enfermeras. | Las enfermeras pueden concentrarse en la atención al paciente en lugar de en tareas administrativas. |

| Ciencia & Ingeniería | Realizan análisis técnicos. | Ingenieros químicos y programadores informáticos. | Los investigadores se centran en compartir, explicar y aplicar su trabajo, reduciendo el tiempo que pasan en el laboratorio. |

| Procesos & Análisis | Procesan y analizan la información. | Auditores y empleados bancarios. | Los contables pueden garantizar el control de calidad en lugar de analizar datos. |

| Expertos en analítica | Examinan y aplican su experiencia ante sistemas complejos. | Controladores de tráfico aéreo y técnicos en ciencias forenses. | Los analistas especializados en seguridad pueden ampliar y profundizar sus búsquedas, con el apoyo de simulaciones basadas en AI. |

| Expertos en relaciones | Aplican su experiencia en entornos que exigen interacción humana. | Equipos médicos e intérpretes. | Los gestores de ambulancias pueden centrarse en la evaluación y el apoyo necesarios, en lugar de en los detalles logísticos. |

| Mantenimiento de equipos técnicos | Instalan y realizan el mantenimiento de equipos y maquinaria. | Mecánicos y trabajadores de mantenimiento. | Los mecánicos trabajan con datos para predecir fallos y realizar reparaciones preventivas. |

| Operaciones con maquinas & Maniobras | Opera maquinaria y conducen vehículos. | Conductores de camiones y operarios de grúas. | Los operarios de tractores pueden garantizar un tratamiento de los cultivos guiado, preciso y personalizado, mientras “conducen”. |

| Trabajos físicos / manuales | Realiza tareas físicas y agotadoras en ambientes concretos. | Trabajadores de la construcción y el paisajismo. | Los trabajadores de la construcción reducen la repetición del trabajo, ya que la tecnología predice la ubicación y la naturaleza de los obstáculos físicos. |

| Servicios físicos | Realizan servicios que exigen actividad física. | Peluqueros y cocineros. | Los asistentes de transporte pueden centrarse en las necesidades y el servicio del cliente en lugar de tareas técnicas. |

Los resultados muestran cómo algunas habilidades, como la gestión administrativas, disminuirán en importancia. Sin embargo, para casi todas las funciones descritas en la tabla anterior, será necesaria una combinación de habilidades de razonamiento complejo, creatividad, inteligencia socioemocional y percepción sensorial.

El problema es que este tipo de habilidades se adquieren con la experiencia. Los sistemas actuales de educación y aprendizaje, tanto reglado como corporativo, no están pensados para abordar esta revolución en la demanda de habilidades, por lo que va a ser necesario que ellos también evolucionen. Para facilitar esta transición, el informe proporciona una serie de recomendaciones:

-

Impulsar el aprendizaje experiencial: La enseñanza se ha basado tradicionalmente en un modelo pasivo, consistente en absorber el conocimiento escuchando o leyendo. Sin embargo, cada vez cobra más fuerza el aprendizaje experimental, es decir, a través de la aplicación práctica de los conocimientos. Sería el caso de los pilotos de avión, que aprenden a través de programas de simulación de vuelo. Las nuevas tecnologías, como la realidad aumentada o la inteligencia artificial, ayudan a que estas soluciones basadas en la experiencia sean más personalizadas y accesibles, abarcando un mayor número de sectores y puestos de trabajo.

-

Mover el foco de la organización a los individuos: En un equipo de trabajo es habitual que existan personas con distintas capacidades y habilidades, de tal forma que se complementen, pero, como hemos visto, también es necesario poner un mayor énfasis en ampliar la variedad de habilidades de cada trabajador individual, incluyendo nuevas habilidades como las capacidades de creatividad e inteligencia socioemocional. El sistema actual no potencia el aprendizaje de estas materias, por lo que es necesario diseñar métricas e incentivos que fomenten la mezcla de habilidades en cada persona.

-

Apoyar a los trabajadores más vulnerables: El aprendizaje debe ser accesible para todos, para así poder cerrar la brecha de habilidades que existe actualmente. De acuerdo con el estudio, y de manera general, los trabajadores más vulnerables al cambio tecnológico son los menos cualificados, debido a que sus puestos de trabajos suelen ser más fáciles de automatizar. Sin embargo, también suelen ser los que menos formación reciben por parte de la empresa, algo que debe cambiar. Otros colectivos a los que es importante prestar atención es a los trabajadores de mayor edad y a los de empresas pequeñas, con menos recursos. Cada vez más empresas recurren a cursos modulares y gratuitos, tipo MOOC, para facilitar la adquisición de habilidades de manera igualitaria entre toda la plantilla. Además, algunos gobiernos, como el de Francia o Singapur, están proporcionando ayudas a la formación.

En definitiva, estamos en un momento de cambio, en el que es necesario pararse a reflexionar sobre cómo va a cambiar nuestro entorno laboral para poder adaptarnos a ello, adquiriendo nuevas habilidades que nos aporten ventajas competitivas en nuestro futuro profesional.

En las políticas que está impulsando la Unión Europea se ha planteado la existencia de una íntima conexión entre la inteligencia artificial y los datos abiertos. A este respecto, como se ha destacado, los datos abiertos son esenciales para el correcto funcionamiento de la inteligencia artificial, ya que los algoritmos han de ser alimentados por datos cuya calidad y disponibilidad resulta imprescindible para su continua mejora y, asimismo, para auditar su correcto funcionamiento.

La inteligencia artificial conlleva un incremento de la sofisticación en los tratamientos de los datos, ya que requiere de una mayor precisión, actualización y calidad de los mismos que, por otro lado, han de ser obtenidos de fuentes muy diversas para incrementar la calidad del resultado final de los algoritmos. Asimismo, el hecho de que los tratamientos se realicen de forma automatizada y deban ofrecer respuestas precisas de manera inmediata ante circunstancias cambiantes supone una dificultad añadida. Se precisa, por tanto, una perspectiva dinámica que justifica la necesidad de que los datos no sólo se ofrezcan en formato abierto y legible por máquinas, sino también con los niveles más elevados de precisión y desagregación.

Esta exigencia adquiere una especial importancia por lo que se refiere a la accesibilidad de los datos generados por parte del sector público, sin duda una de las principales fuentes de donde se nutren los algoritmos debido tanto al elevado número de conjunto de datos disponibles como, asimismo, por el especial interés de las materias a las que se refiere su actividad, en especial los servicios públicos. En este sentido, al margen de la necesidad de superar las insuficiencias del marco legal vigente en cuanto al limitado alcance de las obligaciones que se imponen a las entidades públicas, resulta conveniente valorar en qué medida las condiciones jurídicas en que se ofrecen los datos sirven para dinamizar el desarrollo de aplicaciones basadas en la inteligencia artificial.

Así, en primer lugar, el artículo 5.3 de la Ley señala con rotundidad que “no podrá exigirse a las Administraciones y organismos del sector público que mantengan la producción y el almacenamiento de un determinado tipo de documento con vistas a su reutilización”. Teniendo en cuenta esta previsión legal, las referidas entidades pueden apoyarse en la inexistencia de una obligación de garantizar indefinidamente el suministro de los datos. También en la limitación de responsabilidad que contemplan algunas disposiciones al afirmar que el uso de los datos se realizará bajo la responsabilidad y riesgo de los usuarios o agentes de la reutilización o, incluso, la exoneración por cualquier error u omisión que venga determinado por la incorrección de los propios datos. Ahora bien, se trata de una interpretación cuyo efectivo alcance en cada caso concreto ha de contrastarse con la exigente regulación europea en la materia por lo que se refiere al alcance de las obligaciones y las vías de tutela, en particular tras la reforma que tuvo lugar en el año 2013.

Más allá de un planteamiento basado en el estricto cumplimiento normativo desde una interpretación restrictiva, lo cierto es que la necesidad de ofrecer políticas de apertura de datos del sector público para hacer frente a las singulares exigencias de la inteligencia artificial precisa de una aproximación proactiva que adopte una visión de mayor alcance. En este sentido, la interacción entre sujetos públicos y privados en contextos de mediciones y obtenciones sistemáticas de datos, continuamente actualizados a partir de conexiones generalizadas - como sucede en las iniciativas de ciudades inteligentes -, nos sitúa ante un escenario tecnológico donde las políticas activas de gestión contractual adquieren una especial importancia a fin de superar las barreras y dificultades jurídicas para su apertura. En efecto, en ocasiones los servicios públicos municipales son prestados con frecuencia por sujetos privados que se encuentran al margen de la normativa sobre reutilización y, además, los datos no siempre se obtienen de servicios u objetos gestionados por entidades públicas o con ocasión de actividades cuya gestión les corresponda; incluso a pesar del interés general subyacente en ámbitos como el suministro eléctrico, la prestación de servicios de telefonía y comunicaciones electrónicas o, incluso, los servicios financieros.

Por esta razón la iniciativa que puso en marcha la Unión Europea en 2017 adquiere una singular importancia desde la perspectiva de la inteligencia artificial, ya que pretende superar buena parte de las restricciones jurídicas actualmente existentes para la apertura de los datos. En el mismo sentido, la Estrategia española de I+D+I en Inteligencia Artificial, presentada recientemente por el Ministerio de Ciencia, Innovación y Universidades, sienta como una de sus prioridades el desarrollo de un ecosistema digital de datos entre cuyas medidas destacan la necesidad de garantizar un uso óptimo de los datos abiertos, así como la creación de un Instituto Nacional de Datos encargado de la gobernanza de los datos procedentes de los diferentes niveles de la Administración Pública. Asimismo, en la misma línea de la iniciativa europea antes referida, entre otras medidas se plantea la necesidad de ampliar las obligaciones de apertura a ciertas entidades privadas y a los datos científicos, lo que sin duda tendría un impacto relevante para el mejor funcionamiento de los algoritmos.

La singularidad tecnológica que plantea la Inteligencia Artificial requiere, sin duda, un marco ético y jurídico adecuado, que permita hacer frente a los desafíos que conlleva. La nueva Directiva sobre datos abiertos y reutilización de la información del sector público recientemente aprobada por el Parlamento Europeo supondrá un decidido impulso para la inteligencia artificial en la medida que dicha iniciativa ampliará tanto los sujetos obligados como el tipo de datos que habrán de estar disponibles. Sin duda una medida ciertamente relevante, a la que seguirán otras muchas en marco de la estrategia de la Unión Europea sobre Inteligencia Artificial, una de cuyas principales premisas es asegurar un marco normativo adecuado para facilitar la innovación tecnológica desde el respeto a los derechos fundamentales y los principios éticos.

Contenido elaborado por Julián Valero, catedrático de la Universidad de Murcia y Coordinador del Grupo de Investigación “Innovación, Derecho y Tecnología” (iDerTec).

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Los asistentes virtuales, los algoritmos de predicción de compra o los sistemas de detección de fraude. Todos interactuamos en el día a día con tecnologías de Inteligencia Artificial.

Aunque todavía queda mucho desarrollo por delante, no se puede negar el impacto que la Inteligencia Artificial tiene ya en nuestras vidas. Cuando hablamos de Inteligencia Artificial (o IA) no nos referimos a robots con aspecto humanoide que piensen como nosotros, sino a una sucesión de algoritmos que nos ayudan a extraer valor de grandes volúmenes de datos de forma ágil y eficiente, facilitando la toma de decisiones de manera automática. Estos algoritmos necesitan ser entrenados con datos de calidad para que su comportamiento se adecúe a las reglas de nuestro contexto social.

Actualmente, la Inteligencia Artificial tiene un gran impacto en la cadena de valor de los negocios, y condiciona muchas de las decisiones que toman no solo las empresas sino también los individuos. Por ello es fundamental que los datos que utilicen no estén sesgados y que respete los derechos humanos y los valores democráticos.

La Unión Europea y los gobiernos de los distintos países están impulsando políticas en este sentido. Para ayudarles en este proceso, la OCDE ha desarrollado una serie de principios mínimos que deberían cumplir los sistemas de IA. Se trata de una serie de estándares prácticos y flexibles que puedan resistir el paso del tiempo en un campo en constante evolución. Estos estándares no son legalmente vinculantes, pero buscan influir en las normas internacionales y funcionar como base de las distintas legislaciones.

Los principios de la OCDE para la Inteligencia Artificial se basan en las recomendaciones desarrolladas por un grupo de trabajo integrado por 50 miembros expertos en IA, entre los que hay representantes de gobiernos y líderes de las comunidades empresariales, así como de la sociedad civil, académica y científica. Estas recomendaciones fueron adoptadas el 22 de mayo de 2019 por los países miembros de la OCDE.

Dichas recomendaciones identifican cinco principios complementarios basados en valores para la administración responsable de la Inteligencia Artificial:

- La IA debe beneficiar a las personas y al planeta impulsando el crecimiento inclusivo, el desarrollo sostenible y el bienestar.

- Los sistemas de IA deben diseñarse respetando el estado de derecho, los derechos humanos, los valores democráticos y la diversidad, y deben incluir los mecanismos apropiados - como por ejemplo, permitir la intervención humana cuando sea necesario- para garantizar una sociedad justa y equitativa.

- Debe existir una transparencia y divulgación responsable en torno a los sistemas de IA, para garantizar que las personas entiendan sus resultados y puedan desafiarlos.

- Los sistemas de IA deben funcionar de manera sólida y segura a lo largo de su ciclo de vida y los riesgos potenciales deben evaluarse y gestionarse continuamente.

- Las organizaciones e individuos que desarrollan, despliegan u operan sistemas de IA deben ser responsables de su correcto funcionamiento, en base a los principios anteriormente descritos.

Tomando como referencia estos principios, la OCDE también proporciona cinco recomendaciones a los gobiernos:

- Facilitar la inversión pública y privada en investigación y desarrollo, con el objetivo de estimular la innovación en Inteligencia Artificial de manera segura y fiable.

- Fomentar los ecosistemas de IA accesibles con infraestructura y tecnologías digitales, y mecanismos para compartir datos y conocimientos.

- Asegurar un marco de políticas que abra el camino para el despliegue de sistemas de IA fiable.

- Capacitar a las personas con habilidades necesarias para la IA y apoyar a los trabajadores para una transición justa.

- Cooperar a través de las fronteras y los sectores para avanzar en la administración responsable de IA fiable.

Estas recomendaciones son un primer paso para la consecución de una Inteligencia Artificial responsable. Entre sus próximos pasos, la OCDE contempla el desarrollo del Observatorio de Políticas de IA, que se encargará de proporcionar orientación sobre las métricas, políticas y buenas prácticas con el objetivo de ayudar a implementar los principios anteriormente indicados, algo fundamental si queremos pasar del ámbito teórico a la práctica.

Los gobiernos pueden tomar como base estas recomendaciones y elaborar sus propias políticas, lo que facilitará la homogeneidad de los sistemas de Inteligencia Artificial y garantizará que su comportamiento respecte los principios básicos de convivencia.