Quizás, uno de los usos más cotidianos de la inteligencia artificial que podemos experimentar en nuestro día a día sea mediante la interacción con sistemas de visión artificial e identificación de objetos. Desde el desbloqueo de nuestro smartphone, hasta la búsqueda por imágenes en Internet. Todos estas funcionalidades son posibles gracias a modelos de inteligencia artificial en el campo de la detección y clasificación de imágenes. En este post recopilamos algunos de los repositorios abiertos de imágenes más importantes, gracias a los cuales, hemos podido entrenar los modelos actuales de reconocimiento de imágenes.

Introducción

Volvamos por un momento a finales de 2017, principios del 2018. La posibilidad de desbloquear nuestros smartphones con algún tipo de lector de huella dactilar se ha extendido. Con mayor o menor acierto, la mayor parte de los fabricantes habían conseguido incluir el lector biométrico en sus terminales. El tiempo de desbloqueo, la facilidad de uso y la seguridad extra aportada eran excepcionales frente a los clásicos sistemas de contraseñas, patrones, etc. Como viene ocurriendo desde el año 2008, el líder indiscutible en innovación digital en terminales móviles - Apple - volvía a revolucionar el mercado incorporando un novedoso sistema de desbloqueo en el iPhone X mediante la imágen de nuestra cara. El denominado sistema FaceID escanea nuestra cara para desbloquear el terminal en décimas de segundo sin tener que utilizar las manos. La probabilidad de suplantación de identidad con este sistema era de 1 a 1.000.000; 20 veces más seguro que su predecesor el TouchID.

Valga esta pequeña historia sobre una funcionalidad cotidiana, para introducir un tema importante en el campo de la inteligencia artificial, y en particular del campo del procesamiento de imágenes por ordenador: los repositorios de imágenes de entrenamiento de modelos de IA. Hemos hablado mucho en este espacio sobre este campo de la inteligencia artificial. Pocos meses después del lanzamiento del FaceID, publicamos un post sobre IA, en el que mencionamos la clasificación de imágenes a nivel casi-humano como uno de los logros más importantes de la IA en los últimos años. Esto no sería posible sin la disponibilidad de bancos abiertos de imágenes anotadas[1] con los que poder entrenar modelos de reconocimiento y clasificación de imágenes. En este post listamos algunos de los repositorios de imágenes (de libre acceso) más importantes para el entrenamiento de modelos.

Lógicamente, no es lo mismo reconocer la matrícula de un vehículo a la entrada de un parking que identificar una enfermedad pulmonar en una imagen de rayos-x. Los bancos de imágenes anotadas son tan variados como las potenciales aplicaciones de IA que éstas habilitan.

Probablemente los 2 repositorios más conocidos de imágenes son MNIST e ImageNET.

- MNIST, es un conjunto de 70.000 imágenes en blanco y negro de números manuscritos normalizados en tamaño, listas para entrenar algoritmos de reconocimiento de números. El artículo original del profesor LeCun es del año 1998.

- ImageNET es una base de datos enorme de conceptos (palabras o conjuntos de palabras). Cada concepto con significado propio se denomina synset. Cada synset está representado por cientos o miles de imágenes. En la propia web de ImageNET se cita el proyecto como una herramienta indispensable para el reciente avance del Deep Learning y la visión por ordenador.

The project has been instrumental in advancing computer vision and deep learning research. The data is available for free to researchers for non-commercial use

El subconjunto más utilizado de ImageNet es el conjunto de datos de clasificación y localización de imágenes ImageNet Large Scale Visual Recognition Challenge ILSVRC. Este subconjunto de imágenes se utilizó desde 2010 hasta 2017 para las competiciones de detección de objetos y clasificación de imágenes a nivel mundial. Este conjunto de datos abarca 1000 clases de objetos y contiene más de un millón de imágenes de entrenamiento, 50.000 imágenes de validación y 100.000 imágenes de prueba. Este subconjunto está disponible en Kaggle.

Además de estos dos clásicos repositorios que ya forman parte de la historia del procesado de imágenes por inteligencia artificial, disponemos de algunos repositorios temáticos más actuales y variados. Estos son algunos ejemplos:

- Los tan molestos CAPTCHAs y reCAPTCHAs que encontramos en multitud de sitios web para verificar quienes estamos intentando acceder somos humanos son un buen ejemplo de inteligencia artificial aplicado al campo de la seguridad. Por supuesto, los CAPTCHAs también necesitan su propio repositorio para comprobar cuán efectivos son para evitar accesos no deseados. Te recomendamos leer este interesante artículo sobre la historia de estos compañeros de navegación por la web.

- Como hemos visto varias veces en el pasado, una de las aplicaciones más prometedoras de la IA en el campo de la imágenes es la de asistir a los médicos en el diagnóstico de enfermedades a partir de una prueba de imágen médica (rayos-x, tomografía computerizada, etc.) Para convertir esto en una realidad, no son pocos los esfuerzos en recopilar, anotar y poner a disposición de la comunidad investigadora repositorios de imágenes médicas anonimizadas y de calidad para entrenar modelos de detección de objetos, formas y patrones que puedan revelar una posible enfermedad. El 30% de todos los cánceres que padecen las mujeres en el mundo corresponde con el cáncer de mama. De ahí la importancia de contar con bancos de imágenes que faciliten el entrenamiento de modelos específicos.

- El diagnóstico de enfermedades basadas en la sangre a menudo implica la identificación y caracterización de muestras de sangre de pacientes. Los métodos automatizados (mediante imagen médica) para detectar y clasificar los subtipos de células sanguíneas tienen importantes aplicaciones médicas.

- Hace 3 años el Covid19 irrumpió en nuestras vidas poniendo a las sociedades desarrolladas patas arriba con esta pandemia de alcance mundial y consecuencias terribles en términos de pérdidas humanas y económicas. La comunidad científica al completo se volcó en dar solución en tiempo record para atajar las consecuencias del nuevo coronavirus. Fueron muchos los esfuerzos en la mejora del diagnóstico de la enfermedad. Algunas técnicas apostaron por el análisis de imagen asistidas por IA. Al mismo tiempo, las autoridades sanitarias incorporaron un elemento nuevo en nuestra rutina diaria - las mascarillas-. Todavía hoy en algunas situaciones la mascarilla sigue siendo de obligado uso, y durante estos 3 años hemos tenido que vigilar su adecuado uso en casi todo tipo de lugares. Tanto es así que en estos meses han proliferado los bancos de imágenes específicos para entrenar modelos de IA y visión artificial que detecten el uso de mascarillas de forma autónoma.

- Para ampliar información sobre repositorios abiertos relacionados con la salud y el bienestar, te dejamos este post que publicamos hace unos meses.

Además de estos curiosos ejemplos que hemos citado en este post, te animamos a explorar la sección de conjuntos de datos de Kaggle que incluyen imágenes como datos. Tan solo tienes 10.000 conjuntos para recorrer ;)

[1] Los repositorios de imágenes anotadas contienen, además de los ficheros de imágen (jpeg, tiff, etc.), unos ficheros descriptivos con los metadatos que identifican a cada imágen. Normalmente, estos ficheros (csv, JSON o XML) incluyen un identificador único para cada imágen además de unos campos que proporcionan información sobre el contenido de la imágen. Por ejemplo, el nombre del objeto que aparece en la imágen.

Contenido elaborado por Alejandro Alija,experto en Transformación Digital e Innovación.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Tras varios meses de pruebas y entrenamientos de distinto tipo, el primer sistema masivo de Inteligencia Artificial de la lengua española es capaz de generar sus propios textos y resumir otros ya existentes. MarIA es un proyecto que ha sido impulsado por la Secretaría de Estado de Digitalización e Inteligencia Artificial y desarrollado por el Centro Nacional de Supercomputación, a partir de los archivos web de la Biblioteca Nacional de España (BNE).

Hablamos de un avance muy importante en este ámbito, ya que se trata del primer sistema de inteligencia artificial experto en comprender y escribir en lengua española. Enmarcada dentro del Plan de Tecnologías del Lenguaje, esta herramienta pretende contribuir al desarrollo de una economía digital en español, gracias al potencial que los desarrolladores pueden encontrar en ella.

El reto de crear los asistentes del lenguaje del futuro

Los modelos de lenguaje al estilo de MarIA son la piedra angular sobre la que se sustenta el desarrollo del procesamiento del lenguaje natural, la traducción automática o los sistemas conversacionales, tan necesarios para comprender y replicar de forma automática una lengua. MarIA es un sistema de inteligencia artificial formado por redes neuronales profundas que han sido entrenadas para adquirir una comprensión de la lengua, de su léxico y de sus mecanismos para expresar el significado y escribir a nivel experto.

Gracias a este trabajo previo, los desarrolladores pueden crear herramientas relacionadas con el lenguaje y capaces de clasificar documentos, realizar correcciones o elaborar herramientas de traducción.

La primera versión de MarIA fue elaborada con RoBERTa, una tecnología que crea modelos del lenguaje del tipo “codificadores”, capaces de generar una interpretación que puede servir para categorizar documentos, encontrar similitudes semánticas en diferentes textos o detectar los sentimientos que se expresan en ellos.

Así, la última versión de MarIA ha sido desarrollada con GPT-2, una tecnología más avanzada que crea modelos generativos decodificadores y añade prestaciones al sistema. Gracias a estos modelos decodificadores, la última versión de MarIA es capaz de generar textos nuevos a partir de un ejemplo previo, lo que resulta muy útil a la hora de elaborar resúmenes, simplificar grandes cantidades de información, generar preguntas y respuestas e, incluso, mantener un diálogo.

Avances como los anteriores convierten a MarIA en una herramienta que, con entrenamientos adaptados a tareas específicas, puede ser de gran utilidad para desarrolladores, empresas y administraciones públicas. En esta línea, modelos similares que se han desarrollado en inglés son utilizados para generar sugerencias de texto en aplicaciones de escritura, resumir contratos o buscar informaciones concretas dentro de grandes bases de datos de texto para relacionarlas posteriormente con otras informaciones relevantes.

En otras palabras, además de redactar textos a partir de titulares o palabras, MarIA puede comprender no solo conceptos abstractos, sino también el contexto de los mismos.

Más de 135 mil millones de palabras al servicio de la inteligencia artificial

Para ser exactos, MarIA se ha entrenado con 135.733.450.668 de palabras procedentes de millones de páginas web que recolecta la Biblioteca Nacional y que ocupan un total de 570 Gigabytes de información. Para estos mismos entrenamientos, se ha utilizado el superordenador MareNostrum del Centro Nacional de Supercomputación de Barcelona y ha sido necesaria una potencia de cálculo de 9,7 trillones de operaciones (969 exaflops).

Teniendo en cuenta que uno de los primeros pasos para diseñar un modelo del lenguaje pasa por construir un corpus de palabras y frases que sirva como base de datos para entrenar al propio sistema, en el caso de MarIA, fue necesario realizar un cribado para eliminar todos los fragmentos de texto que no fuesen “lenguaje bien formado” (elementos numéricos, gráficos, oraciones que no terminan, codificaciones erróneas, etc.) y así entrenar correctamente a la IA.

Debido al volumen de información que maneja, MarIA se sitúa ya como el tercer sistema de inteligencia artificial experto en comprender y escribir con mayor número de modelos masivos de acceso abierto. Por delante solo están los modelos del lenguaje elaborados para el inglés y el mandarín. Esto ha sido posible principalmente por dos razones. Por un lado, debido al elevado nivel de digitalización en el que se encuentra el patrimonio de la Biblioteca Nacional y, por el otro, gracias a la existencia de un Centro de Supercomputación Nacional que cuenta con superordenadores como el MareNostrum 4.

El papel de los conjuntos de datos de la BNE

Desde que en 2014 lanzase su propio portal de datos abiertos (datos.bne.es), la BNE ha apostado por acercar los datos que están a su disposición y bajo su custodia: datos de las obras que conserva, pero también de autores, vocabularios controlados de materias y términos geográficos, entre otros.

En los últimos años, se ha desarrollado también la plataforma educativa BNEscolar, que busca ofrecer contenidos digitales del fondo documental de la Biblioteca Digital Hispánica y que pueden resultar de interés para la comunidad educativa.

Así mismo y para cumplir con los estándares internacionales de descripción e interoperabilidad, los datos de la BNE están identificados mediante URIs y modelos conceptuales enlazados, a través de tecnologías semánticas y ofrecidos en formatos abiertos y reutilizables. Además, cuentan con un alto nivel de normalización.

Próximos pasos

Así y con el objetivo de perfeccionar y ampliar las posibilidades de uso de MarIA, se pretende que la versión actual dé lugar a otras especializadas en áreas de conocimiento más concretas. Teniendo en cuenta que se trata de un sistema de inteligencia artificial dedicado a comprender y generar texto, se torna fundamental que este sea capaz de desenvolverse con soltura ante léxicos y conjuntos de información especializada.

Para ello, el PlanTL continuará expandiendo MarIA para adaptarse a los nuevos desarrollos tecnológicos en procesamiento del lenguaje natural (modelos más complejos que el GPT-2 ahora implementado, entrenados con mayor cantidad de datos) y se buscará la forma de crear espacios de trabajo para facilitar el uso de MarIA por compañías y grupos de investigación.

Contenido elaborado por el equipo de datos.gob.es.

Los datos se han convertido en uno de los pilares del proceso de transformación digital de la sociedad, lo que interpela también a sectores como la justicia y la aplicación del derecho. Gracias a ellos, se ha conseguido mejorar el acceso a la información y la estadística, permitiendo que la toma de decisiones se base en cifras objetivas a las que poder aplicar nuevas técnicas como la automatización y la inteligencia artificial.

Así y con el objetivo de seguir ahondando en las ventajas derivadas del ecosistema de los datos, el próximo 17 y 18 de octubre, la Universidad de Salamanca organiza, en colaboración con el Ministerio de Justicia, un simposio sobre Justicia y Datos.

¿Cuáles serán las temáticas a abordar?

Durante las dos jornadas que durará el evento y a través de las distintas ponencias, se tratará de reflexionar sobre "el papel de los datos para el buen funcionamiento de los servicios públicos". Es decir, cómo pueden ayudar los datos abiertos a mejorar la eficiencia y la eficacia de estos de cara a la ciudadanía y los servicios ofrecidos a la misma.

En línea con esta idea, las cuestiones que formarán parte del simposio girarán en torno a los siguientes temas:

- Asistentes personalizados

- Analítica de Datos

- Diseño de Visualizaciones de Datos

- Gobernanza, Transparencia y Datos Abiertos

- IA – NLP

- IA – Otros

- Robotización

- Espacios compartidos de datos

- Capacitación en Datos, IA, RPA

Así, mientras la primera jornada estará formada por conferencias de personas relevantes del sector de la Justicia, el Derecho y el sector académico, en la segunda, se mostrarán las distintas iniciativas del sector tecnológico del ámbito internacional y del legal-tech relacionadas con los datos.

Igualmente, en salas simultáneas, se analizarán proyectos públicos y privados en los que se aplica la tecnología a los servicios de Justicia y del Derecho.

En conclusión, se trata de un evento que busca convertirse en un punto de encuentro para la innovación en el ámbito de la justicia. De forma que, a través del intercambio de experiencias y casos de éxito, entre la administración, instituciones y empresas privadas de cualquier ámbito sea posible orientar el uso de los datos a proveer y dar soluciones a problemas concretos.

¿Cómo puedo asistir?

La asistencia a las jornadas será gratuita y estas se desarrollarán en la Hospedería Arzobispo Fonseca de Salamanca. Para poder asistir, será necesario cumplimentar el siguiente formulario de inscripción. Asimismo, y al igual que sucede con otros eventos similares, este también será retransmitido online y en directo.

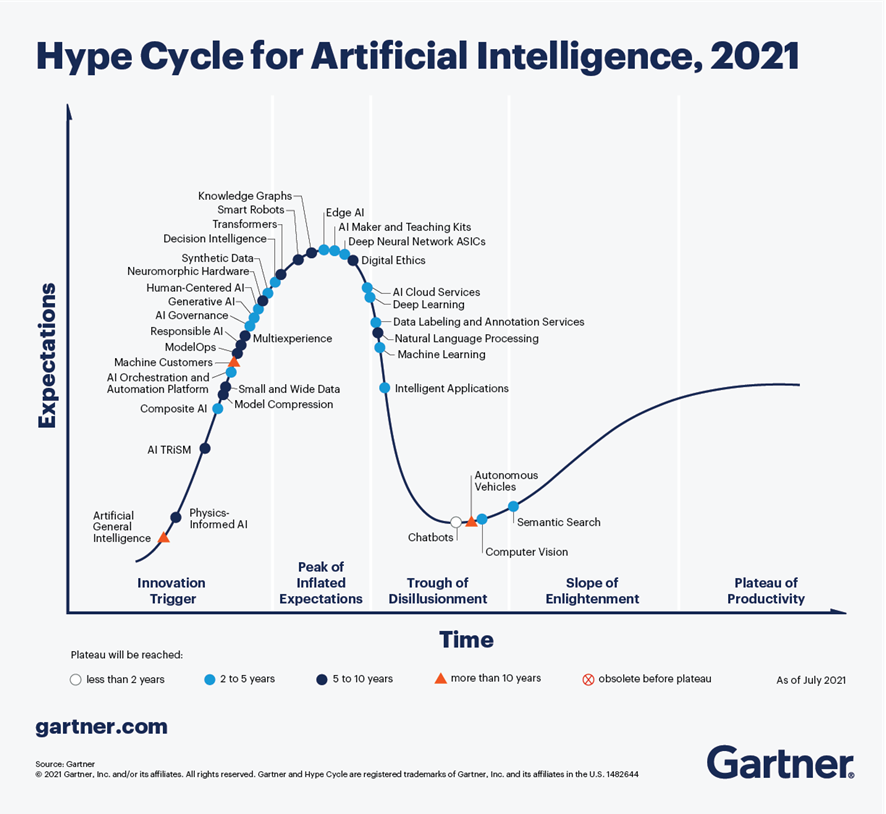

Según el último análisis realizado por Gartner en septiembre de 2021, sobre las tendencias en materia de Inteligencia Artificial, los Chatbots son una de las tecnologías más cercanas a ofrecer una productividad efectiva en menos de 2 años. En la Figura 1, extraída de dicho informe, se observa que existen 4 tecnologías que han superado ampliamente el estado de sobre-expectativa (peak of inflated expectations) y comienzan ya a salir del canal de desilusión (trough of disillisionment), hacia estados de mayor madurez y estabilidad, incluyendo chatbots, búsqueda semántica, visión artificial y vehículos autónomos.

Figura 1 - Tendencias en IA para los próximos años.

En el caso concreto de los chatbots, existen grandes expectativas de productividad en los próximos años gracias a la madurez de las diferentes plataformas disponibles, tanto en opciones de Cloud Computing, como en proyectos de código abierto, es especial RASA o Xatkit. En la actualidad es relativamente sencillo desarrollar un chatbot o asistente virtual sin conocimientos de IA, mediante el uso de estas plataformas.

¿Cómo funciona un chatbot?

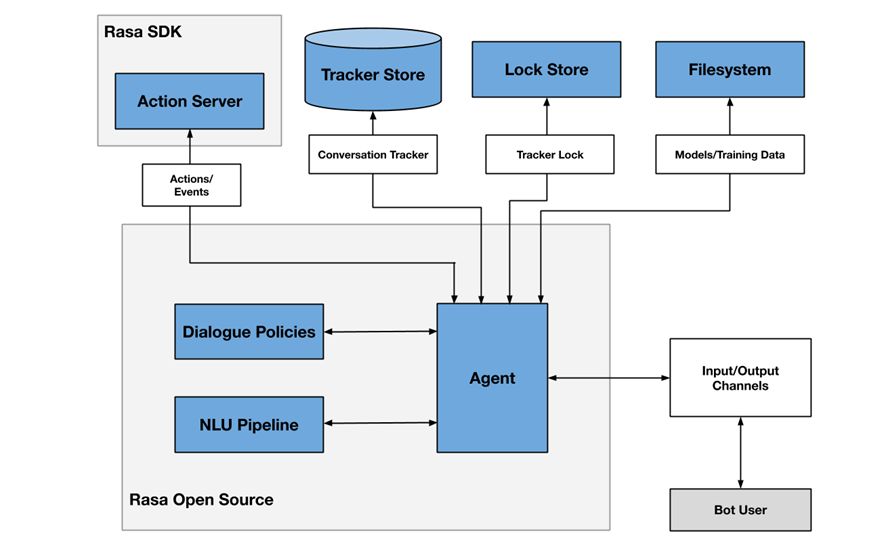

A modo de ejemplo, la Figura 2 muestra un diagrama de los diferentes componentes que habitualmente incluye un chatbot, en este caso enfocado en la arquitectura del proyecto RASA.

Figura 2 - Arquitectura del proyecto RASA

Uno de los componentes principales es el módulo agente (agent), que actúa a modo de controlador del flujo de datos y normalmente es la interfaz del sistema con los diferentes canales (input/output channels) ofrecidos a los usuarios, como aplicaciones de chat, redes sociales, aplicaciones web o móviles, etc.

El módulo de NLU (Natural Languge Understanding) se encarga de identificar la intención del usuario (qué quiere consultar o hacer), la extracción de entidades (de qué está hablando) y la generación de respuestas. Se considera un flujo (pipeline) porque intervienen varios procesos de diferente complejidad, en muchos casos incluso mediante el uso de modelos pre-entrenados de Inteligencia Artificial.

Finalmente, el módulo de gestión de conversaciones (dialogue policies) define cuál es el siguiente paso en una conversación, basándose en el contexto y el histórico de mensajes. Este módulo se integra con otros subsistemas como el almacén de conversaciones (tracker store) o el servidor que procesa las acciones necesarias para dar respuesta al usuario (action server).

Chatbots en portales de datos abiertos como mecanismo para localizar datos y acceder a información

Cada vez existen más iniciativas para empoderar a los ciudadanos en la consulta de datos abiertos mediante el uso de chatbots, empleando interfaces de lenguaje natural, aumentando así el valor neto que ofrecen dichos datos. El uso de chatbots permite automatizar la recopilación de datos a partir de la interacción con el usuario y responder de forma sencilla, natural y fluida, permitiendo la democratización de la puesta en valor de datos abiertos.

En el SOM Research Lab (Universitat Oberta de Catalunya) fueron pioneros en la aplicación de chatbots para mejorar el acceso de los ciudadanos a los datos abiertos a través de los proyectos Open Data for All y BODI (Bots para interactuar con datos abiertos – Interfaces conversacionales para facilitar el acceso a los datos públicos). Puedes encontrar más información sobre este último proyecto en este artículo.

También cabe destacar el chatbot de Aragón Open Data, del portal de datos abiertos del Gobierno de Aragón, cuyo objetivo es acercar la gran cantidad de datos disponibles a la ciudadanía, para que esta pueda aprovechar su información y valor, evitando cualquier barrera técnica o de conocimiento entre la consulta realizada y los datos abiertos existentes. Los dominios sobre los que ofrece información son:

- Información general sobre Aragón y su territorio

- Turismo y viajes en Aragón

- Transporte y agricultura

- Asistencia técnica o preguntas frecuentes en materia de sociedad de la información

Conclusiones

Estos son sólo algunos ejemplos del uso práctico de chatbots en la puesta en valor de datos abiertos y su potencial a corto plazo. En los próximos años veremos cada vez más ejemplos de asistentes virtuales en diferentes escenarios, tanto del ámbito de las administraciones públicas como en servicios privados, en especial enfocados a la mejora de la atención al usuario en aplicaciones de comercio electrónico y servicios surgidos de iniciativas de transformación digital.

Contenido elaborado por José Barranquero, experto en Ciencia de Datos y Computación Cuántica.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

La situación de pandemia que hemos vivido durante los últimos años ocasionó que una gran cantidad de eventos tuvieran que celebrarse de manera online. Fue el caso de las Jornadas Ibéricas de Infraestructuras de Datos Espaciales (JIIDE), cuyas ediciones de 2020 y 2021 tuvieron un formato virtual. Sin embargo, la situación ha cambiado y en este 2022 podremos volver a reunirnos para hablar de las últimas tendencias en información geográfica.

Sevilla será la sede de la JIIDE 2022

Sevilla ha sido la ciudad elegida para reunir a todos aquellos profesionales de la administración pública, el sector privado y el académico interesados en la información geográfica y que utilizan Infraestructuras de Datos Espaciales (IDE) en el ejercicio de sus actividades.

En concreto, la cita tendrá lugar del 25 al 27 de octubre en la Universidad de Sevilla. Puedes ver más información aquí.

Foco en la experiencia de usuario

El lema de este año es «Experiencia y evolución tecnológica: acercando la IDE a la ciudadanía». Con ello se quiere poner el énfasis en las nuevas tendencias tecnológicas y su uso para proporcionar al ciudadano soluciones que resuelvan problemas concretos, mediante la publicación y tratamiento de la información geográfica de forma normalizada, interoperable y abierta.

Durante tres días los asistentes podrán compartir experiencias y casos de uso sobre cómo utilizar técnicas de Big Data, Inteligencia Artificial o el Cloud Computing para mejorar la capacidad de análisis, el almacenamiento y la publicación web de grandes volúmenes de datos procedente de diversas fuentes, incluyendo sensores en tiempo real.

También se hablarán de las nuevas especificaciones y estándares que han surgido, así como de la evaluación que se está realizando de la Directiva INSPIRE.

Agenda ya disponible

Aunque aún quedan por confirmar algunas participaciones, el programa ya está disponible en la web de las Jornadas. Habrá unas 80 comunicaciones donde se mostrarán experiencias relativas a proyectos reales, 7 talleres técnicos donde compartir conocimientos concretos y una mesa redonda para promover el debate

Entre las ponencias encontramos algunas enfocadas en los datos abiertos. Es el caso del Ayuntamiento de Valencia que nos hablará de cómo utilizan datos abiertos para la obtención de la equidad ambiental en los barrios de la ciudad o la sesión dedicada a la “fototeca aérea Digital de Andalucía: un proyecto para la convergencia de las IDE y Open-Data”.

¿Cómo puedo asistir?

El evento es gratuito, pero para acudir es necesario registrarse a través de este formulario. En él es necesario indicar la jornada a la que se desea acudir.

De momento está abierto el registro para acudir presencialmente, pero en septiembre, se abrirá, en la web de las jornadas, la posibilidad de participar en las JIIDE de forma virtual.

Organizadores

Las Jornadas Ibéricas de Infraestructuras de Datos Espaciales (JIIDE) nacieron de la colaboración de la Direção-Geral do Território de Portugal, el Instituto Geográfico Nacional de España y el Govern d' Andorra. En esta ocasión se une como organizador el Instituto de Estadística y Cartografía de Andalucía y la Universidad de Sevilla.

La inteligencia artificial (IA) lleva ya varios años muy presente en nuestras vidas. Si bien no existe una definición exacta sobre ella, una descripción podría ser “la habilidad de una máquina de presentar las mismas capacidades que los seres humanos, como el razonamiento, el aprendizaje, la creatividad y la capacidad de planear”. Este proceso se realiza mediante la creación y la aplicación de algoritmos. Dicho de otra manera, la IA hace referencia a la capacidad que tienen los ordenadores, software y otras máquinas de pensar y actuar como lo harían los seres humanos.

La inteligencia artificial permite desarrollar diferentes casos de uso que facilitan la toma de decisiones o proporcionan soluciones a problemas complejos. Gracias a ello, esta inteligencia ha sido capaz, no solo de revolucionar el mundo empresarial sino también el ámbito social, con aplicaciones que van desde la rápida detección del cáncer hasta la lucha contra la deforestación del Amazonas, por nombrar algunos ejemplos.

Dadas todas estas ventajas, no es de extrañar que en los últimos años haya crecido la demanda de perfiles profesionales relacionados con este campo. Por ello, a continuación, te mostramos algunos ejemplos de cursos y formaciones de interés que podrían ayudarte a ampliar tu conocimiento sobre inteligencia artificial.

Cursos online

Elementos de IA

- Impartido por: Universidad de Helsinki y Reaktor

- Duración: 50 horas

- Idioma: Español

- Precio: Gratuito

Este proyecto educativo masivo y abierto (MOOC), al que ya se han inscrito más de 750.000 estudiantes, te ofrece la oportunidad de aprender qué es la inteligencia artificial, además de mostrarte cómo puede afectar a tu vida laboral y personal o cómo evolucionará en los próximos años.

Este curso, que ofrece a toda la ciudadanía la posibilidad de formarse y conocer de primera mano el funcionamiento y las oportunidades que ofrece la IA, ha sido promovido en nuestro país por la Secretaría de Estado de Digitalización e Inteligencia Artificial junto a la UNED.

Building AI

- Impartido por: Universidad de Helsinki y Reaktor

- Duración: 50 horas

- Idioma: Inglés

- Precio: Gratuito

Los creadores del curso anterior lanzaron tiempo más tarde esta otra formación con la pretensión de cerrar la brecha entre los cursos para principiantes como ‘Elementos de IA’ y la gran mayoría de oferta formativa sobre este campo que existe en el mercado, que suelen presentar un nivel más avanzado.

Este curso, que comienza donde termina el anterior, te ayudará a profundizar en elementos como el machine learning, las redes neuronales o algunas aplicaciones prácticas de la IA. Además, te ofrece la opción de plantear tu primer proyecto sobre inteligencia artificial e iniciarte en programación si lo deseas.

Programa especializado: Introducción a la inteligencia artificial

- Impartido por: Coursera (UNAM)

- Duración: 8 meses

- Idioma: Español

- Precio: Gratuito

Este curso está dirigido a personas que tienen interés en conocer más acerca de los diferentes desarrollos que se han ido generando durante los últimos años en el campo de la inteligencia artificial.

Si te decantas por esta formación aprenderás a implementar tecnología de IA con un propósito específico, a comparar la solución que has desarrollado con otras existentes o a reportar los resultados obtenidos en un ensayo estructurado.

Machine Learning Crash Course

- Impartido por: Google

- Duración: 15 horas

- Idioma: Inglés

- Precio: Gratuito

A través de este curso conocerás algunos conceptos clave como el estudio detallado del aprendizaje automático y darás tus primeros pasos con la API TensorFlow, entre otros.

Para poder cursarlo es recomendable contar con cierta experiencia en programación (preferiblemente en Python), conocimiento básico de aprendizaje automático, de estadística, álgebra lineal y cálculo.

Machine Learning

- Impartido por: Coursera (Stanford)

- Duración: 60 horas

- Idioma: Inglés (subtítulos en español)

- Precio: Gratuito (47€ si se desea solicitar certificado)

Se trata de un MOOC sobre machine learning creado por Andrew Ng, fundador del proyecto Google Brain en 2011 y de la plataforma de cursos online Coursera.

A través de este curso abordarás temas como el aprendizaje supervisado y no supervisado, el reconocimiento de patrones estadísticos o la aplicación de 'buenas prácticas' en este campo. Además, también aprenderás a aplicar algoritmos de aprendizaje a la construcción de robots inteligentes, entre otros muchos aspectos.

Másters

La oferta formativa que existe actualmente sobre inteligencia artificial no solo viene recogida a través de cursos. Cada vez son más las universidades y centros de estudio que ofrecen a sus alumnos programas especializados y másters universitarios relacionados con el campo de la IA. A continuación, te mostramos algunos ejemplos:

- Máster oficial en Seguridad Informática e IA, Universitat Rovira i Virgili (60 créditos ECTS, un año académico): su plan de estudios abarca temas de investigación relacionados con la protección de la información, la seguridad en las aplicaciones, el aprendizaje automático, o la modelización y resolución de problemas, entre otros.

- Máster universitario en Inteligencia Artificial, Universidad de Santiago de Compostela (USC) (90 créditos ECTS, 18 meses): ofrece a sus alumnos la posibilidad de ampliar sus conocimientos sobre aspectos como procesamiento del lenguaje natural, robótica, fundamentos de IA o ingeniería de datos.

- Máster Universitario en Sistemas Inteligentes y Aplicaciones Numéricas en Ingeniería, Universidad de Las Palmas de Gran Canaria (ULPGC) (60 créditos ECTS, 1 año académico): introduce al estudiante a las bases y fundamentos de algunas áreas punteras como el modelado computacional y la simulación numérica de problemas de ingeniería, el uso y desarrollo de sistemas inteligentes y autónomos, o los métodos de análisis e interpretación de datos.

- Máster en Inteligencia Artificial, Universitat Politécnica de catanlunya (90 créditos ECTS, 18 meses): ofrece una base sólida y conocimientos avanzados sobre inteligencia artificial. En este máster aprenderás conceptos clave sobre inteligencia computacional, visión artificial o los sistemas multiagente.

- Máster Universitario en Inteligencia Artificial Aplicada, Universidad Carlos III Madrid (60 créditos ECTS, 1 año académico): permite comprender los métodos y técnicas de IA más relevantes y aplicarlas para desarrollar soluciones apropiadas a diferentes tipos de problemas.

- Máster Universitario en Inteligencia Artificial, UNIR (60 créditos ECTS, 1 año académico): en este máster aprenderás técnicas de percepción computacional y visión artificial, razonamiento y planificación automática, machine learning y deep learning, Procesamiento del Lenguaje Natural, así como las tecnologías necesarias para implementarlas.

- Máster Universitario en Investigación en IA , Asociación Española para la Inteligencia Artificial (AEPIA) (60 créditos ECTS, un año académico): cuenta con tres especialidades: Aprendizaje y Ciencia de Datos, Inteligencia en la Web y Razonamiento y Planificación.

- Master en Inteligencia Artificial, Universidad Europea (30 créditos ECTS, 8 meses): dirigido a que los estudiantes adquieran una visión integradora de la Inteligencia Artificial y el dominio de técnicas avanzadas de Machine Learning y Optimización Computacional.

Esta ha sido tan solo una pequeña recopilación de formaciones relacionadas con el campo de la inteligencia artificial que esperamos pueda ser de tu interés. Si conoces algún otro curso o máster que quieras recomendar, no dudes en dejarnos un comentario o escribirnos un correo electrónico a dinamizacion@datos.gob.es.

La asociación AMETIC representa a empresas de todos los tamaños ligadas con la industria tecnológica digital española, un sector clave para el PIB nacional. Entre otras cuestiones, AMETIC busca impulsar un entorno favorable para el crecimiento de las empresas del sector, potenciando el talento digital y la creación y consolidación de nuevas empresas.

En datos.gob.es hemos hablado con Antonio Cimorra, Director de Transformación Digital y Tecnologías Habilitadoras de AMETIC, para reflexionar sobre el papel de los datos abiertos en la innovación y como base de nuevos productos, servicios e incluso modelos de negocio.

Entrevista completa:

1. ¿Cómo ayudan los datos abiertos a impulsar la transformación digital? ¿Qué tecnologías disruptivas son las más beneficiadas por la apertura de datos?

Los datos abiertos constituyen uno de los pilares de la economía del dato, que está llamada a ser la base de nuestro desarrollo presente y futuro y de la transformación digital de nuestra sociedad. Todas las industrias, administraciones publicas y la propia ciudadanía no hemos hecho más que comenzar a descubrir y utilizar el enorme potencial y utilidad que la utilización de los datos aporta a la mejora de la competitividad de las empresas, a la eficiencia y mejora de los servicios de las Administraciones Públicas y a las relaciones sociales y la calidad de vida de las personas.

2. Una de las áreas en las que trabajan desde AMETIC es la Inteligencia Artificial y el Big Data, entre cuyos objetivos está promover la creación de plataformas públicas de compartición de datos abiertos. ¿Podría explicarnos qué acciones llevan o han llevado a cabo para ello?

En AMETIC contamos con una Comisión de Inteligencia Artificial y Big Data en la que participan las principales empresas proveedoras de esta tecnología. Desde este ámbito, trabajamos en la definición de iniciativas y propuestas que contribuyen difundir su conocimiento entre los potenciales usuarios, con las consiguientes ventajas que supone su incorporación en los sectores público y privado. Son destacados ejemplos de las acciones en este ámbito la reciente presentación del Observatorio de Inteligencia Artificial de AMETIC, así como el AMETIC Artificial Intelligence Summit que en 2022 celebrará su quinta edición que pondrá foco en mostrar cómo la Inteligencia Artificial puede contribuir al cumplimiento de los Objetivos de Desarrollo Sostenible y a los Planes de Transformación a ejecutar con Fondos Europeos

3. Los datos abiertos pueden servir de base para desarrollar servicios y soluciones que den lugar a nuevas empresas. ¿Podría contarnos algún ejemplo de caso de uso llevado a cabo por sus asociados?

Los datos abiertos y muy particularmente la reutilización de la información del sector público son la base de desarrollo de un sinfín de aplicaciones e iniciativas emprendedoras tanto en empresas consolidadas de nuestro sector tecnológico como en otros muchos casos de pequeñas empresas o startups que encuentran en esta fuente de información el motor de desarrollo de nuevos negocios y acercamiento al mercado.

4. ¿Qué tipos de datos son los más demandados por las empresas a las que representan?

En la actualidad, todos los datos de actividad industrial y social cuentan con una importante demanda por las empresas, atendiendo a su gran valor en el desarrollo de proyectos y soluciones que vienen demostrando su interés y extensión en todos los ámbitos y tipología de organizaciones y usuarios en general.

5. También es fundamental contar con iniciativas de compartición de datos como GAIA-X, constituida sobre los valores de soberanía digital y disponibilidad de los datos. ¿Cómo han recibido las empresas la creación de un hub nacional?

El sector tecnológico ha recibido la creación del hub nacional de GAIA-X muy positivamente, entendiendo que nuestra aportación desde España a este proyecto europeo será de enorme valor para nuestras empresas de muy distintos ámbitos de actividad. Espacios de compartición de datos en sectores como el turismo, la sanidad, la movilidad, la industria, por poner algunos ejemplos, cuentan con empresas y experiencias españolas que son ejemplo y referencia a nivel europeo y mundial.

6. En este momento hay una gran demanda de profesionales relacionados con la captación, análisis y visualización de datos. Sin embargo, la oferta de profesionales, aunque va creciendo, continúa siendo limitada. ¿Qué habría que hacer para impulsar la capacitación en habilidades relacionadas con los datos y la digitalización?

La oferta de profesionales tecnológicos es uno de los mayores problemas para el desarrollo de nuestra industria local y para la transformación digital de la sociedad. Es una dificultad que podemos calificar como histórica, y que lejos de ir a menos, cada día es mayor en número de puestos y perfiles a cubrir. Es un problema a nivel mundial que evidencia que no existe una formula única o sencilla para solucionarlo, pero si podemos mencionar la importancia de que todos los agentes sociales y profesionales desarrollemos acciones conjuntas y en colaboración que permitan la capacitación digital de nuestra población desde edades tempranas y de ciclos y programas formativos y de grado especializados que se caractericen por su proximidad con lo que serán las carreras profesionales para lo que es necesario contar con la participación del sector empresarial

7. Durante los últimos años, has formado parte del jurado de las distintas ediciones del Desafío Aporta. ¿Cómo cree que contribuyen este tipo de acciones a impulsar negocios basados en datos?

El Desafío Aporta ha sido un ejemplo de apoyo y estímulo para la definición de muchos proyectos en torno a los datos abiertos y para el desarrollo de una industria propia que en estos últimos años ha venido creciendo de forma muy significativa con la puesta a disposición de datos de muy distintos colectivos, en muchos casos por parte de las Administraciones Públicas, y su posterior reutilización e incorporación a aplicaciones y soluciones de interés para muy distintos usuarios.

Los datos abiertos constituyen uno de los pilares de la economía del dato, que está llamada a ser la base de nuestro desarrollo presente y futuro y de la transformación digital de nuestra sociedad.

8. ¿Cuáles son las próximas acciones que van a llevar a cabo en AMETIC ligadas a la economía del dato?

Entre las acciones más destacadas de AMETIC en relación con la economía del dato cabría citar nuestra reciente incorporación al hub nacional de GAIA-X para el que hemos sido elegidos miembros de su junta directiva, y en donde representaremos e incorporaremos la visión y las aportaciones de la industria tecnológica digital en todos los espacios de datos que se constituyan, sirviendo de canal de participación de las empresas tecnológicas que desarrollan su actividad en nuestro país y que tienen que conformar la base de los proyectos y casos de uso que integrar en la red europea GAIA-X en colaboración con otros hubs nacionales.

¿Te has preguntado alguna vez cómo Alexa es capaz de reconocer nuestra voz y entender lo que le estamos diciendo (algunas veces mejor que otras)? ¿Te has parado a pensar cómo Google es capaz de buscar imágenes similares a la que le estamos proporcionando? Probablemente sepas que estas técnicas pertenecen al ámbito de la inteligencia artificial. Pero no te engañes, construir estos modelos sofisticados solo está al alcance de unos pocos. En este post te contamos por qué y qué podemos hacer el común de los mortales para entrenar modelos de inteligencia artificial.

Introducción

En los últimos años hemos sido testigos de avances increíbles y sorprendentes en el ámbito del entrenamiento de modelos de Deep Learning. En anteriores ocasiones hemos citado los ejemplos más relevantes cómo GPT-3 o Megatron-Turing NLG. Estos modelos, optimizados para el procesamiento de lenguaje natural (en inglés, NLP), son capaces de escribir artículos completos (prácticamente indistinguibles de los escritos por un humano) o realizar resúmenes coherentes de obras clásicas, de cientos de páginas, sintetizando el contenido en tan solo unos párrafos. Impresionante ¿verdad?

Sin embargo, estos logros no son ni mucho menos baratos. Es decir, la complejidad de estos modelos es tal que, se necesitan miles de gigabytes de información pre-procesada - lo que denominamos datasets anotados- que han sido previamente analizados (etiquetados) por un humano experto en la materia. Por ejemplo, el último entrenamiento del modelo Megatron-Turing NLG, creado en colaboración por Microsoft y NVIDIA, utilizó 270.000 millones de tokens (pequeños trozos de texto que pueden ser palabras o sub-palabras que constituyen la base para el entrenamiento de estos modelos de lenguaje natural). Además de la información necesaria para poder entrenar estos modelos, está el hecho de las necesidades especiales de computación que requieren estos entrenamientos. Para ejecutar tareas de entrenamiento de estos modelos, se necesitan las máquinas (los ordenadores) más avanzados del mundo y los tiempos de entrenamiento se cuentan por semanas. Aunque no existen datos oficiales, algunas fuentes citan que el coste de entrenamiento de los últimos modelos como GPT-3 o Megatron-Turing se cuentan por decenas de millones de dólares. Así, cabría preguntarnos, cómo podemos utilizar y entrenar modelos si no tenemos acceso a los clusters de cálculo más potentes del mundo.

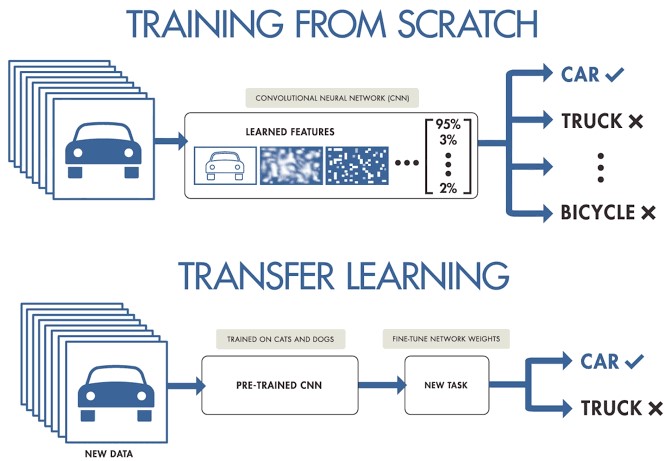

La respuesta: Transfer Learning

Cuando trabajamos en un proyecto de machine learning o deep learning y no disponemos de acceso a grandes conjuntos de datos preparados para entrenamiento, podemos partir de modelos pre-entrenados para crear un nuevo modelo ajustado o afinado a nuestro caso de uso concreto. Es decir, cargamos un modelo previamente entrenado con un conjunto muy grande de datos de entrenamiento y re-entrenamos sus últimas capas para ajustarlo a nuestro conjunto concreto de datos. Esto es lo que se conoce como Transfer Learning.

Fuente original: Transfer Learning en Deep Learning: Más allá de nuestros modelos. Post de Josu Alonso en Medium.

Simplificando mucho, se podría decir que el Machine Learning tradicional aplica en tareas de aprendizaje aisladas, donde no es necesario retener el conocimiento adquirido, mientras que en un proyecto de Transfer Learning el aprendizaje es fruto de tareas previas, logrando una buena precisión precisión en menos tiempo y con menos datos. Esto conlleva muchas oportunidades, aunque también algunos retos, como por ejemplo que el nuevo dominio herede sesgos del dominio anterior.

Veamos un ejemplo concreto. Supongamos que tenemos un nuevo desafío de Deep Learning y queremos hacer un clasificador automático de razas de perros. En este caso, podemos aplicar la técnica de transfer learning a partir de un modelo general de clasificación de imágenes, para posteriormente ajustarlo a un conjunto concreto de fotografías de razas de perro. La mayoría de los modelos pre-entrenados parten de un subconjunto de la base de datos de ImageNet, de la que ya hemos hablado en varias ocasiones. La red neuronal (de ImageNet), que es el tipo de algoritmo base que se utiliza en estos modelos de clasificación de imágenes, ha sido entrenada con 1.2 millones de imágenes de más de 1000 categorías de objetos diferentes como teclados, tazas de café, lápices y muchos animales. Al utilizar una red pre-entrenada para aplicar Transfer Learning, conseguimos resultados mucho más rápidos y sencillos que si tuviéramos que entrenar una red desde cero.

Por ejemplo, en este fragmento de código, se muestra el proceso de partir de un modelo pre-entrenado con ImageNet y re-entrenar o añadir nuevas capas para conseguir ajustes finos sobre el modelo original.

# creamos la base del modelo pre-entrenado partiendo de ImageNET

base_model <- application_inception_v3(weights = 'imagenet', include_top = FALSE)

# Añadimos capas adicionales a nuestra red neuronal

predictions <- base_model$output %>%

layer_global_average_pooling_2d() %>%

layer_dense(units = 1024, activation = 'relu') %>%

layer_dense(units = 200, activation = 'softmax')

# creamos un nuevo modelo para entrenar

model <- keras_model(inputs = base_model$input, outputs = predictions)

# Nos aseguramos de entrenar solo nuestras nuevas capas para no destruir el entrenamiento previo.

freeze_weights(base_model)

# compilamos el modelo

model %>% compile(optimizer = 'rmsprop', loss = 'categorical_crossentropy')

# entrenamos el modelo

model %>% fit_generator(...)

Conclusiones

Entrenar un modelo de deep learning para propósito general no está al alcance de todo el mundo. Las barreras son varias, desde la dificultad de acceso a los datos de entrenamiento de calidad y en suficiente volumen, cómo la capacidad de computación necesaria para procesar billones de imágenes o textos. Para casos de uso más acotados, donde solamente requerimos un refinamiento de los modelos generalistas, aplicar la técnica de Transfer Learning, nos posibilita conseguir resultados fantásticos en términos de precisión y tiempo de entrenamiento, con un coste asumible por la mayoría de científicos de datos. Las aplicaciones de Transfer Learning son muy numerosas y los sitios web especializados están llenos de ejemplos de aplicación. Alineado con esta tendencia, recientemente se ha popularizado mucho la técnica de Style Transfer Learning, que consiste en reconstruir imágenes basándose en el estilo de una imágen previa. Seguiremos hablando sobre este tema en próximos posts.

Ejemplo de Style Transfer Learning en Kaggle

No es el objetivo de este post explicar con detalle cada una de las secciones de este fragmento de código.

Contenido elaborado por Alejandro Alija,experto en Transformación Digital e Innovación.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Hoy en día las aplicaciones de Inteligencia Artificial (IA) están presentes en múltiples ámbitos de la vida cotidiana, desde televisores y altavoces inteligentes que son capaces de entender lo que les solicitamos, hasta sistemas de recomendación que nos ofrecen servicios y productos adaptados a nuestras preferencias.

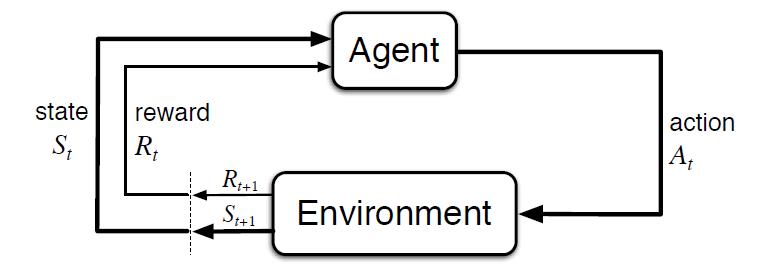

Estas IA “aprenden” gracias a las diversas técnicas que existen, entre las que destacan el aprendizaje supervisado, no supervisado y el aprendizaje por refuerzo. En este artículo nos centraremos en el aprendizaje por refuerzo, que se enfoca principalmente en el método de prueba y error, de forma similar a cómo aprendemos los humanos y los animales en general.

La clave de este tipo de sistemas está en fijar correctamente los objetivos a largo plazo para encontrar una solución global óptima, sin focalizarse en exceso en las recompensas inmediatas, que no permiten realizar una exploración adecuada del conjunto de soluciones posibles.

Entornos de simulación como complemento a los conjuntos de datos abiertos

Al contrario que en otros tipos de aprendizaje, donde normalmente se aprende a partir de conjuntos de datos históricos, este tipo de técnicas requieren de entornos de simulación que permitan entrenar a un agente virtual mediante su interacción con un entorno, donde recibe recompensas o penalizaciones en función del estado y las acciones que realiza. Este ciclo entre agente y entorno puede verse en el siguiente diagrama:

Figura 1 - Esquema de aprendizaje por refuerzo [Sutton & Barto, 2015]

Es decir, partiendo de un entorno simulado, con un estado inicial, el agente realiza una acción que genera un nuevo estado y una posible recompensa o penalización, que depende de los estados anteriores y la acción realizada. El agente aprende la mejor estrategia en este entorno simulado a partir de la experiencia, explorando el conjunto de estados, y siendo capaz de recomendar la mejor política de actuación si se configura de forma adecuada.

El ejemplo más conocido a nivel mundial fue el éxito conseguido por AlphaGo, al vencer al 18 veces campeón del mundo Lee Sedol en 2016. El Go es un juego ancestral, considerado una de las 4 artes básicas en la cultura China, junto con la música, la pintura y la caligrafía. Al contrario que con el ajedrez, el número de combinaciones de juego posibles es superior al número de átomos del Universo, siendo un problema imposible de resolver por algoritmos tradicionales.

Curiosamente, el avance tecnológico demostrado por AlphaGo al resolver un problema que se afirmaba fuera del alcance de una IA, quedó eclipsado un año después por su sucesor AlphaGo Zero. En esta versión sus creadores optaron por no emplear datos históricos, ni reglas heurísticas. AlphaGo Zero sólo emplea las posiciones del tablero y aprende por prueba y error jugando contra sí mismo.

Siguiendo esta innovadora estrategia de aprendizaje, en 3 días de ejecución consiguió superar a AlphaGo, y después de 40 días se convirtió en el mejor jugador de Go, acumulando miles de años de conocimiento en cuestión de días, y descubriendo incluso estrategias desconocidas hasta la fecha.

El impacto de este hito tecnológico abarca infinidad de ámbitos, pudiendo contar con soluciones de IA que aprendan a resolver problemas complejos desde la experiencia. Desde la gestión de recursos, la planificación de estrategias, o la calibración y optimización de sistemas dinámicos.

El desarrollo de soluciones en este ámbito está especialmente limitado por la necesidad de contar con entornos de simulación adecuados, siendo el componente más complejo de construir. Si bien existen múltiples repositorios donde se pueden obtener entornos de simulación abiertos que nos permitan probar este tipo de soluciones.

El referente más conocido es Open AI Gym, el cual incluye un extenso conjunto de librerías y entornos de simulación abiertos para el desarrollo y validación de algoritmos de aprendizaje por refuerzo. Entre otros incluye simuladores para el control básico de elementos mecánicos, aplicaciones de robótica y simuladores físicos, videojuegos ATARI en dos dimensiones, e incluso el aterrizaje de un módulo lunar. Además, permite integrar y publicar nuevos simuladores abiertos para el desarrollo de simuladores propios adaptados a nuestras necesidades que puedan ser compartidos con la comunidad:

Figura 2 - Ejemplos de entornos visuales de simulación ofrecidos por Open AI Gym

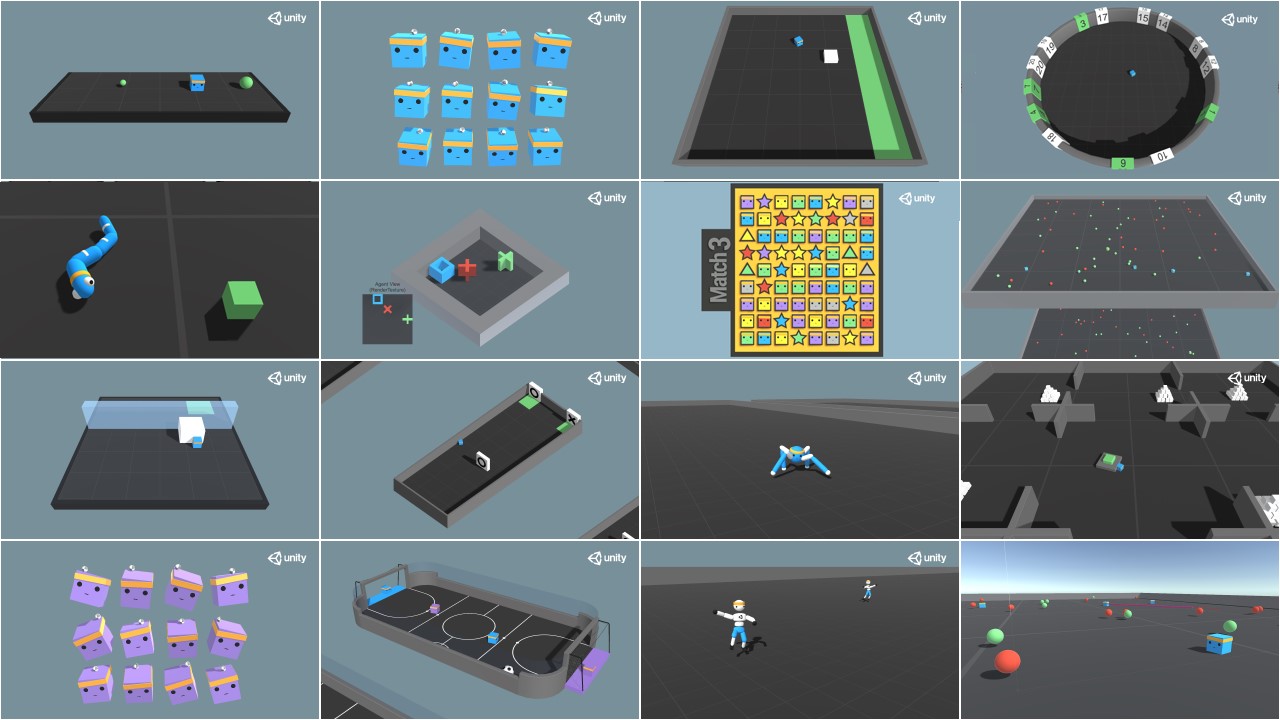

Otra referencia interesante es Unity ML Agents, donde también encontramos múltiples librerías y varios entornos de simulación, ofreciendo además la posibilidad de integrar nuestro propio simulador:

Figura 3 - Ejemplos de entornos visuales de simulación ofrecidos por Unity ML Agents

Posibles aplicaciones del aprendizaje por refuerzo en las administraciones públicas

Este tipo de aprendizaje se emplea especialmente en áreas como la robótica, la optimización de recursos o los sistemas de control, permitiendo definir políticas o estrategias óptimas de actuación en entornos concretos.

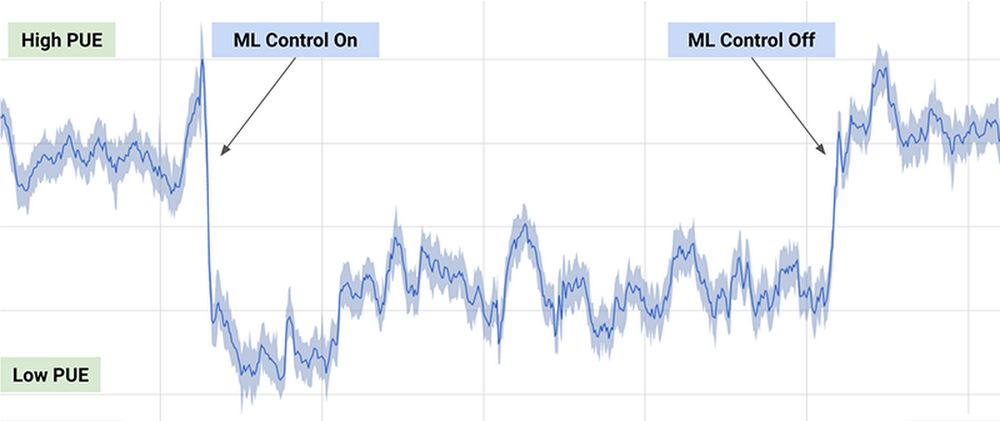

Uno de los ejemplos prácticos más conocidos, es el algoritmo de DeepMind empleado por Google para reducir un 40% el consumo de energía necesario para enfriar sus centros de datos en 2016, consiguiendo una reducción significativa en el consumo de energía durante su uso, como puede observarse en el siguiente gráfico (extraído del artículo anterior):

Figura 4 - Resultados del algoritmo de DeepMind sobre el consumo energético de los centros de datos de Google

El algoritmo empleado usa una combinación de técnicas de aprendizaje profundo y aprendizaje por refuerzo, junto con un simulador de propósito general para comprender sistemas dinámicos complejos que podría aplicarse en múltiples entornos como la transformación entre tipos de energía, el consumo de agua o la optimización de recursos en general.

Otras posibles aplicaciones en el ámbito público incluyen la búsqueda y recomendación de conjuntos de datos abiertos a través de chatbots, o la optimización de políticas públicas, como es el caso del proyecto europeo Policy Cloud, aplicado por ejemplo en el análisis de futuras estrategias de las diferentes denominaciones de origen de los vinos de Aragón.

En general, la aplicación de este tipo de técnicas podría optimizar el uso de recursos públicos mediante la planificación de políticas de actuación que reviertan en un consumo más sostenible, reduciendo la contaminación, los residuos y el gasto público.

Contenido elaborado por Jose Barranquero, experto en Ciencia de datos y computación cuántica.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

Durante la última década hemos visto como las instituciones nacionales e internacionales, así como los gobiernos de los países y las propias asociaciones empresariales alertaban sobre la escasez de perfiles tecnológicos y la amenaza que esto supone para la innovación y el crecimiento. No se trata de un problema exclusivamente europeo - y que por tanto afecta también a España-, sino que en mayor o menor medida se da en todo el mundo, y que ha sido agravado aún más por la reciente pandemia.

Cualquiera que lleve un tiempo de vida profesional, y no necesariamente en el mundo tecnológico, ha podido observar cómo la demanda de roles relacionados con la tecnología ha ido aumentando. No es más que la consecuencia de que las compañías de todo el mundo están haciendo grandes inversiones en digitalización para mejorar sus operaciones e innovar en sus productos, junto con la creciente presencia de la tecnología en todos los aspectos de nuestra vida.

Y dentro de los profesionales de la tecnología, durante los últimos años hay un grupo que se ha convertido en una especie de unicornio debido a su particular escasez, los científicos de datos y el resto de profesionales relacionados con los datos y la inteligencia artificial: ingenieros de datos, ingenieros de machine learning, especialistas en ingeniería artificial en todos los ámbitos, desde la gobernanza de datos hasta la propia configuración y despliegue de modelos de aprendizaje profundo, etc.

Este escenario es especialmente problemático para España donde los salarios son menos competitivos que en otros países de nuestro entorno y donde, de entrada, la proporción de trabajadores de IT está por debajo de la media de la UE. Por tanto, es previsible que las compañías españolas y las administraciones públicas, que también están implementando proyectos de este tipo, se enfrenten a crecientes dificultades para reclutar y retener el talento relacionado con la tecnología en general, y con los datos y la inteligencia artificial en particular.

Cuando existe un problema de oferta, la única solución sostenible a medio y largo plazo es aumentar la producción de aquello que escasea. En este caso la solución pasaría por incorporar al mercado laboral nuevos profesionales como único mecanismo para garantizar un mejor equilibrio entre oferta y demanda. Y así lo reconocen todas las estrategias y planes nacionales y europeos relacionadas con la digitalización, la inteligencia artificial y la propia reforma de los sistemas educativos, tanto superior como de formación profesional.

Las Estrategias españolas

La Estrategia Nacional de Inteligencia Artificial dedica uno de sus ejes a la promoción del desarrollo de capacidades digitales con el objetivo de poner todos los medios que garanticen que los trabajadores tengan un dominio adecuado de las habilidades digitales y capacidades para comprender y desarrollar tecnologías y aplicaciones de Inteligencia Artificial. El Gobierno español ha previsto una amplia gama de políticas de educación y formación cuya base es el Plan Nacional de competencias digitales, publicado en enero de 2021 y que está alineado con la Agenda Digital 2025.

Este plan incluye la analítica de datos y la inteligencia artificial como áreas de vanguardia tecnológica dentro de las competencias digitales especializadas, esto es, “necesarias para satisfacer la demanda laboral de especialistas en tecnologías digitales: personas que trabajan directamente en el diseño, implementación, operación y/o mantenimiento de sistemas digitales”.

En general, la estrategia nacional presenta acciones de política sobre educación y habilidades digitales para toda la población a lo largo de toda su vida. Aunque en muchos casos estas medidas están aún en fase de planificación y verán un impulso importante con el despliegue de los fondos de NextGenerationEU, ya tenemos algunos ejemplos pioneros como los programas de formación y orientación para el empleo para desempleados y jóvenes licitados el año pasado y recientemente adjudicados. En el caso de la formación para personas desempleadas ya se encuentran en ejecución actuaciones para como el programa Actualízate y el proyecto de formación para la adquisición de capacidades para la economía digital. Las acciones adjudicadas que están dirigidas a jóvenes está previsto que comiencen en el primer trimestre de 2022. En ambos casos el objetivo es la impartición de acciones formativas gratuitas dirigidas a la adquisición y mejora de competencias TIC, competencias personales y empleabilidad, en el ámbito de la transformación y la economía digital, así como la orientación y la inserción laboral. Entre estas competencias TIC, sin duda, las relacionadas con los datos y la inteligencia artificial tendrán un peso importante en los programas de formación.

El papel de las universidades

Por otra parte, las universidades de todo el mundo, y por supuesto las españolas, llevan ya un tiempo adaptando planes de estudio y creando nuevos programas formativos relacionados con los datos y la inteligencia artificial. La primera en adaptarse a la demanda fue la formación de posgrado, que, dentro del sistema de educación superior, es la más flexible y rápida de implementar. La primera hornada de profesionales con formación específica en datos e inteligencia artificial provenía de disciplinas diversas. Por ello, entre los veteranos de los equipos de datos de las empresas podemos encontrar diferentes disciplinas STEM, desde las matemáticas y la física hasta prácticamente cualquier ingeniería. En general, lo que tenían en común estos pioneros era haber cursado Másteres en Big Data, en ciencia de datos, en analítica de datos, etc. complementados con formaciones no regladas a través de MOOCs.

En la actualidad están comenzando a llegar ya al mercado laboral los primeros profesionales que han cursado los primeros grados en ciencia de datos o ingeniería de datos que reformaron las universidades pioneras - pero que en la actualidad están ya implantados en numerosas universidades españolas - . Estos profesionales tienen un grado de adaptación muy alto a las actuales necesidades del mercado laboral, por lo que están muy demandados entre las empresas.

Para las universidades, el principal reto pendiente es que los planes de estudios universitarios de cualquier disciplina incluyan conocimientos para trabajar con datos y para comprender cómo los datos apoyan la toma de decisiones. Esto será vital para apoyar el objetivo de la UE de que el 70% de los adultos tenga habilidades digitales básicas para 2025.

Grandes compañías tecnológicas desarrollando talento

Una idea del tamaño del problema que supone la escasez de estas competencias para la economía global es la implicación de gigantes tecnológicos como Google, Amazon o Microsoft en su solución. En los últimos años hemos observado como prácticamente todas ellas han lanzado materiales y programas gratuitos a gran escala para certificar personal en diferentes áreas de la tecnología, porque lo consideran una amenaza para su propio crecimiento, aunque no sean precisamente ellas las que tengan las mayores dificultades para reclutar el escaso talento existente. Su visión es que si el resto de compañías no son capaces de seguir el ritmo de la digitalización esto hará que su propio crecimiento se resienta y por eso hacen grandes inversiones en programas de certificación más allá de sus propias tecnologías, como por ejemplo el Certificado profesional de Soporte de TI de Google o el Programa especializado: Desarrollo de aplicaciones modernas con Python de AWS.

Otras compañías multinacionales están abordando la escasez de talento volviendo a capacitar a sus empleados en habilidades analíticas e inteligencia artificial. Para ello siguen diferentes estrategias, como incentivar que sus empleados cursen MOOC o crear planes de formación a medida con proveedores especializados del sector educativo. En algunos casos, también se incentiva a los empleados en roles no relacionados con los datos a participar en capacitaciones ligadas a la ciencia de datos, como la visualización o analítica de datos.

Aunque tardaremos aún en ver sus efectos debido a la elevada inercia que tienen todas estas medidas, sin duda se va en la dirección adecuada para mejorar la competitividad de unas empresas que necesitan seguir el elevado ritmo global de innovación que rodea la inteligencia artificial y todo lo referente con los datos. Por su parte los profesionales que sepan adaptarse a esta demanda vivirán un momento dulce los próximos años y podrán elegir con qué proyectos se comprometen sin preocuparse por las dificultades que, por desgracia, afectan al empleo en otras áreas de conocimiento y sectores de actividad.

Contenido elaborado por Jose Luis Marín, Senior Consultant in Data, Strategy, Innovation & Digitalization.

Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.