En los últimos quince años hemos visto cómo las administraciones públicas han pasado de publicar sus primeros conjuntos de datos abiertos a trabajar con conceptos mucho más complejos. Interoperabilidad, estándares, espacios de datos o soberanía digital son algunos de los conceptos de moda. Y, en paralelo, también ha cambiado la web. Aquel espacio abierto, descentralizado e interoperable que inspiró las primeras iniciativas de datos abiertos, ha evolucionado hacia un ecosistema mucho más complejo, donde conviven tecnologías, nuevos estándares y al mismo tiempo desafíos importantes como silos de información hasta ética digital y concentración tecnológica.

Para hablar de todo ello, hoy tenemos la suerte de contar con dos voces que no solo han observado esta evolución, sino que han sido protagonistas directos de ella a nivel internacional:

- Josema Alonso, con más de veinticinco años de experiencia trabajando en la web abierta, los datos y los derechos digitales, ha trabajado en la World Wide Web Foundation, en Open Government Partnership y el Foro Económico Mundial, entre otros.

- Carlos Iglesias, experto en estándares web, open data y gobierno abierto, ha asesorado a administraciones de todo el mundo en más de veinte proyectos. Ha participado activamente en comunidades como W3C, la Web Foundation o la Open Knowledge Foundation.

Resumen / Transcripción de la entrevista

1. ¿En qué momento creéis que estamos ahora y qué ha cambiado respecto a aquella primera etapa del open data?

Carlos Iglesias: Bueno, yo creo que lo que ha cambiado es que entendemos que hoy en día ese grito de guerra inicial de “queremos los datos ya” no es suficiente. Era una primera fase que en su día fue muy útil y necesaria porque había que romper con esa tendencia de tener los datos encerrados, no compartir los datos. Digamos que la urgencia en aquel momento era simplemente cambiar el paradigma y por eso el grito de guerra era el que era. He estado implicado, como Josema, en estudiar y analizar todos esos portales de datos abiertos e iniciativas que surgieron a partir de este movimiento. Y he visto que muchos de ellos empezaron a crecer sin ningún tipo de estrategia. De hecho, varios se quedaban por el camino o no tenían una visión clara de lo que querían hacer. La simple práctica yo creo que llegó a la conclusión de que la publicación de datos por sí misma no era suficiente. Y a partir de ahí yo creo que se han ido planteando, un poco con la madurez del movimiento, que hay que hacer más cosas, y hoy en día hablamos más de la gobernanza de los datos, de abrir datos con un propósito específico, de la importancia de los metadatos, los modelos. O sea, ya no es simplemente tener datos por tenerlos, sino que hay una visión más del dato como uno de los elementos más valiosos en la actualidad, probablemente, y también como una infraestructura necesaria para que funcionen muchas cosas hoy en día. Igual que en su día fueron claves infraestructuras como las redes de carreteras o de transporte público o la energía. Ahora mismo estamos en el momento de la gran eclosión de la inteligencia artificial. Convergen una serie de cuestiones que han hecho que esto haya eclosionado y el cambio es inmenso, a pesar de que estamos hablando solo de quizás poco más de diez o quince años desde ese primer movimiento de “queremos los datos ya”. Yo creo que ahora mismo el panorama es completamente distinto.

Josema Alonso: Sí que es cierto que teníamos aquella idea de “tú publica que alguien vendrá y hará algo con ello”. Y aquello lo que hizo es que se empezara a concienciar a la gente. Pero yo, personalmente, de aquella no me hubiera podido imaginar que muy pocos años después hubiéramos tenido incluso una directiva a nivel europeo de publicación de datos abiertos. Fue algo, la verdad, que recibimos con mucho agrado. Y que luego se empezara a implementar en todos los Estados miembros. Aquello movió un poco conciencias y movió prácticas, sobre todo dentro de la administración. Había mucho miedo de “a ver si pongo algo allí que sea problemático, que sea de mala calidad, que me critiquen por ello”, etc. Pero empezó a generar una cultura del dato y de la utilidad del dato muy importante. Y como también comentó Carlos en los últimos años, yo creo que ya nadie duda de esto. Las inversiones que se están realizando, por ejemplo, a nivel europeo y de Estados miembros, incluido en nuestro país, en España, en el fomento y desarrollo de los espacios de datos, son de cientos de millones de euros. Ya nadie tiene ese tipo de dudas y ahora está más el foco en cómo hacerlo bien, en cómo conseguir que todos interoperen. Esto es, que cuando se crea un espacio de datos europeos de un sector concreto, como puede ser agricultura o salud, todos los países y organizaciones puedan compartir datos de la mejor manera posible, de forma que se puedan intercambiar mediante modelos comunes y que se hagan dentro de entornos de confianza.

2. En este contexto, ¿por qué los estándares se han vuelto tan esenciales?

Josema Alonso: Yo creo que es por todo lo que hemos aprendido a lo largo de estos años. Hemos aprendido que es necesario que la gente pueda tener una cierta libertad a la hora de desarrollar sus propios sistemas. La propia arquitectura de la web, por ejemplo, así funciona, no tiene un control central ni nada, sino que cada participante dentro de la web gestiona las cosas a su manera. Pero existen unas reglas claras de cómo esas cosas luego tienen que interactuar unas con otras, Si no, no funcionaría, sino no seríamos capaces de cargar una página web en diferentes navegadores o en diferentes teléfonos móviles. Entonces, lo que estamos viendo últimamente es que se intenta cada vez más averiguar cómo llegar a ese tipo de consensos en un beneficio mutuo. Por ejemplo, parte de mi trabajo actual para la Comisión Europea es en la Comunidad de Interoperabilidad Semántica, donde gestionamos la creación de modelos uniformes que se utilizan en toda Europa, definiciones de vocabularios estándar básicos que se utilizan en todos los sistemas. En estos últimos años también se ha instrumentalizado de una manera que apoya, digamos, ese consenso mediante regulaciones que se han ido emitiendo, por ejemplo, a nivel europeo. Estos últimos años hemos visto la regulación de datos, la regulación de la gobernanza de datos y la de inteligencia artificial, cosas que intentan también poner un cierto orden y unas barreras. No es que todo el mundo vaya por medio del monte, porque si no, al final no llegamos a ningún lado, sino vamos a intentar todos hacerlo por consenso, pero vamos a intentar todos conducir dentro de la misma carretera para llegar al mismo destino de forma conjunta. Y creo que, desde la parte de las administraciones públicas, aparte de regular, es muy interesante que sean muy transparentes en la forma que se hace. Es la manera en la que todos podemos llegar a ver que lo que se construye está construido de una determinada manera, los modelos de datos que son transparentes, todo el mundo los puede ver participar en su desarrollo. Y aquí es donde estamos viendo algunas carencias de los sistemas de algoritmia y de inteligencia artificial, donde no sabemos muy bien los datos que utilizan ni donde se alojan. Y aquí es donde a lo mejor tendríamos que incidir un poquito más en el futuro. Pero creo que mientras se consiga esta dualidad, de generar el consenso y ofrecer un contexto en el que la gente se sienta segura desarrollándolo, seguiremos avanzando en la línea adecuada.

Carlos Iglesias: Si nos fijamos en los principios que hicieron que la web funcionara en su día, hay mucho enfoque también en la parte de comunidad y de dejar una plataforma abierta que se desarrolla en abierto, con unos estándares abiertos en el que todo el mundo podía unirse. Se buscaba un poco la participación de todo el mundo para enriquecer ese ecosistema. Y yo creo que con los datos deberíamos pensar que ese es el camino a recorrer. De hecho, más o menos es un poco también el concepto que creo que hay detrás de los espacios de datos. Al final no es fácil hacer algo así. Es muy ambicioso y no vemos un invento como la web todos los días.

3. Desde vuestra perspectiva, ¿qué riesgos existen realmente de que los datos queden atrapados en infraestructuras o modelos opacos? Y lo que es más importante, ¿qué podemos hacer para evitarlo?

Carlos Iglesias: Hace años veíamos que se intentaba cuantificar la cantidad de datos que se generaban diariamente. Yo creo que ahora ya nadie lo intenta siquiera, porque está a otra escala completamente, y ya en esa escala solo hay una forma de trabajar, que es automatizando las cosas. Y cuando hablamos de automatización, al final lo que necesitas son estándares, interoperabilidad, mecanismos de confianza, etc. Si miramos diez o quince años atrás, cuáles eran las compañías que tenían mayor cotización a nivel mundial, eran compañías como Ford o General Electric. Si te miras el top diez a nivel mundial hoy en día hay compañías que todos conocemos y usamos cada día como Meta, que es la matriz de Facebook, Instagram, WhatsApp y otros, o Alphabet que es la matriz de Google. O sea, de hecho, yo creo que ahora mismo dudo un poco, pero probablemente de las diez mayores cotizadas del mundo, todas se dedican a los datos. Estamos hablando de un ecosistema gigantesco y, para que esto funcione de verdad y siga siendo un ecosistema abierto del que todo el mundo se pueda beneficiar, la clave es la estandarización.

Josema Alonso: Yo estoy de acuerdo con todo lo que dijo Carlos y tenemos que poner el foco en que no quedemos atrapados. Y sobre todo desde las administraciones públicas hay un papel esencial que jugar. Yo comentaba antes la regulación, que a veces a la gente no le gusta mucho porque el mapa regulatorio empieza a ser extremadamente complicado. La Comisión Europea, a través de un decreto ómnibus, está intentando aliviar esa complejidad regulatoria y, como ejemplo, en la propia regulación de datos, que obliga a las empresas que tienen datos a facilitar la portabilidad de datos a sus usuarios. A mí me parece que es algo esencial. Vamos a ver muchos cambios en eso. Hay tres cosas que siempre me vienen a la cabeza; se necesita capacitación permanente. Esto cambia cada día a una velocidad sorprendente. Los volúmenes de datos que se gestionan ahora son descomunales. Como decía Carlos antes, hace unos días estuve hablando con una persona que dirige la infraestructura de una de las más grandes plataformas de streaming a nivel global y me decía que están recibiendo peticiones de datos generados por inteligencia artificial en un volumen tan grande en tan solo una semana como todo el catálogo que tienen disponible. Entonces la administración necesita tener una capacitación permanente en estos temas de todo tipo, tanto de la puntera tecnológica como acabamos de comentar, como de lo que hablábamos antes, de cómo mejorar la interoperabilidad, cómo crear mejores modelos de datos, etc. Otra es la infraestructura común en Europa, como la futura cartera digital europea, lo que sería el equivalente a la carpeta ciudadana nacional. Un ejemplo súper simple con el que tratamos es el certificado de nacimiento. Es muy complicado intentar integrar los sistemas de veintisiete países diferentes, que a su vez tienen gobiernos regionales y que a su vez tienen gobiernos locales. Entonces, cuanto más invirtamos en infraestructura común, tanto a nivel de semántico como a nivel de los de la propia infraestructura, de la nube, etcétera, yo creo que nos va a ir mejor. Y luego la última, que es la necesidad de gobernanza distribuida pero coordinada. Cada uno se rige por unas determinadas leyes a nivel local, nacional o europeo. Es bueno que empecemos a tener cada vez más coordinación en las capas más altas y que esas capas más altas vayan permeando hacia las capas más bajas y los sistemas sean cada vez más fáciles de integrar y que se entiendan unos con otros. Los espacios de datos es una de las grandes inversiones a nivel europeo, donde creo que esto se está empezando a lograr. Entonces, por resumir tres cosas así muy prácticas de hacer: capacitación permanente, invertir en infraestructura común y que la gobernanza siga siendo distribuida, pero cada vez más coordinada.

En la encrucijada del siglo XXI, las ciudades se enfrentan a desafíos de enorme magnitud. El crecimiento explosivo de la población, la urbanización acelerada y la presión sobre los recursos naturales están generando una demanda sin precedentes para encontrar soluciones innovadoras que permitan construir y gestionar entornos urbanos más eficientes, sostenibles y habitables.

A estos retos se suma el impacto del cambio climático en las ciudades. A medida que el mundo experimenta alteraciones en los patrones climáticos, las ciudades deben adaptarse y transformarse para garantizar la sostenibilidad y la resiliencia a largo plazo.

Una de las manifestaciones más directas del cambio climático en el entorno urbano es el aumento de las temperaturas. El efecto isla de calor urbana, agravado por la concentración de edificaciones y superficies asfaltadas que absorben y retienen el calor, se ve intensificado por el incremento global de la temperatura. Esto no solo afecta a la calidad de vida al aumentar los costes de refrigeración y la demanda energética, sino que también puede provocar graves problemas de salud pública, como golpes de calor y la agravación de enfermedades respiratorias y cardiovasculares.

El cambio en los patrones de precipitación es otro de los efectos críticos del cambio climático que afectan a las ciudades. Los episodios de lluvias intensas y las tormentas más frecuentes y severas pueden dar lugar a inundaciones urbanas, especialmente en zonas con infraestructuras de drenaje insuficientes u obsoletas. Esta situación ocasiona importantes daños estructurales, y también interrumpe la vida cotidiana, afecta a la economía local y aumenta los riesgos para la salud pública debido a la propagación de enfermedades transmitidas por el agua.

Ante estos desafíos, la planificación y el diseño urbano deben evolucionar. Las ciudades están adoptando estrategias de urbanismo sostenible que incluyen la creación de infraestructuras verdes, como parques y cubiertas vegetales, capaces de mitigar el efecto isla de calor y mejorar la absorción del agua durante episodios de lluvias intensas. Asimismo, la integración de sistemas de transporte público eficientes y la promoción de la movilidad no motorizada resultan esenciales para reducir las emisiones de carbono.

Los retos descritos también influyen en la normativa edificatoria y en los códigos de construcción. Los nuevos edificios deben cumplir estándares más exigentes de eficiencia energética, resistencia a condiciones meteorológicas extremas y reducción del impacto ambiental. Esto implica el uso de materiales sostenibles y técnicas constructivas que no solo disminuyan las emisiones de gases de efecto invernadero, sino que también ofrezcan seguridad y durabilidad frente a eventos climáticos extremos.

En este contexto, los gemelos digitales urbanos se han consolidado como una de las herramientas clave para apoyar la planificación, la gestión y la toma de decisiones en las ciudades. Su potencial es amplio y transversal: desde la simulación de escenarios de crecimiento urbano hasta el análisis de riesgos climáticos, la evaluación de impactos normativos o la optimización de servicios públicos. Sin embargo, más allá del discurso tecnológico y de las visualizaciones en 3D, la viabilidad real de un gemelo digital urbano depende de una cuestión fundamental de gobierno de datos: la disponibilidad, calidad y uso coherente de datos abiertos estandarizados.

¿Qué entendemos por gemelo digital urbano?

Un gemelo digital urbano no es simplemente un modelo tridimensional de la ciudad ni una plataforma de visualización avanzada. Se trata de una representación digital estructurada y dinámica del entorno urbano, que integra:

-

La geometría y semántica de la ciudad (edificios, infraestructuras, parcelas, espacios públicos).

-

Datos geoespaciales de referencia (catastro, planeamiento, redes, medio ambiente).

-

Información temporal y contextual, que permite analizar la evolución del territorio y simular escenarios.

-

En determinados casos, flujos de datos actualizables procedentes de sensores, sistemas de información municipales u otras fuentes operacionales.

Desde una perspectiva de estándares, un gemelo digital urbano puede entenderse como un ecosistema de datos y servicios interoperables, donde distintos modelos, escalas y dominios (urbanismo, edificación, movilidad, medio ambiente, energía) se conectan de forma coherente. Su valor no reside tanto en la tecnología concreta empleada como en su capacidad para alinear datos heterogéneos bajo modelos comunes, reutilizables y gobernables.

Además, la integración de datos en tiempo real en los gemelos digitales permite una gestión más eficiente de la ciudad en situaciones de emergencia. Desde la gestión de desastres naturales hasta la coordinación de eventos masivos, los gemelos digitales proporcionan a los responsables de la toma de decisiones una visión en tiempo real de la situación urbana, lo que facilita una respuesta rápida y coordinada.

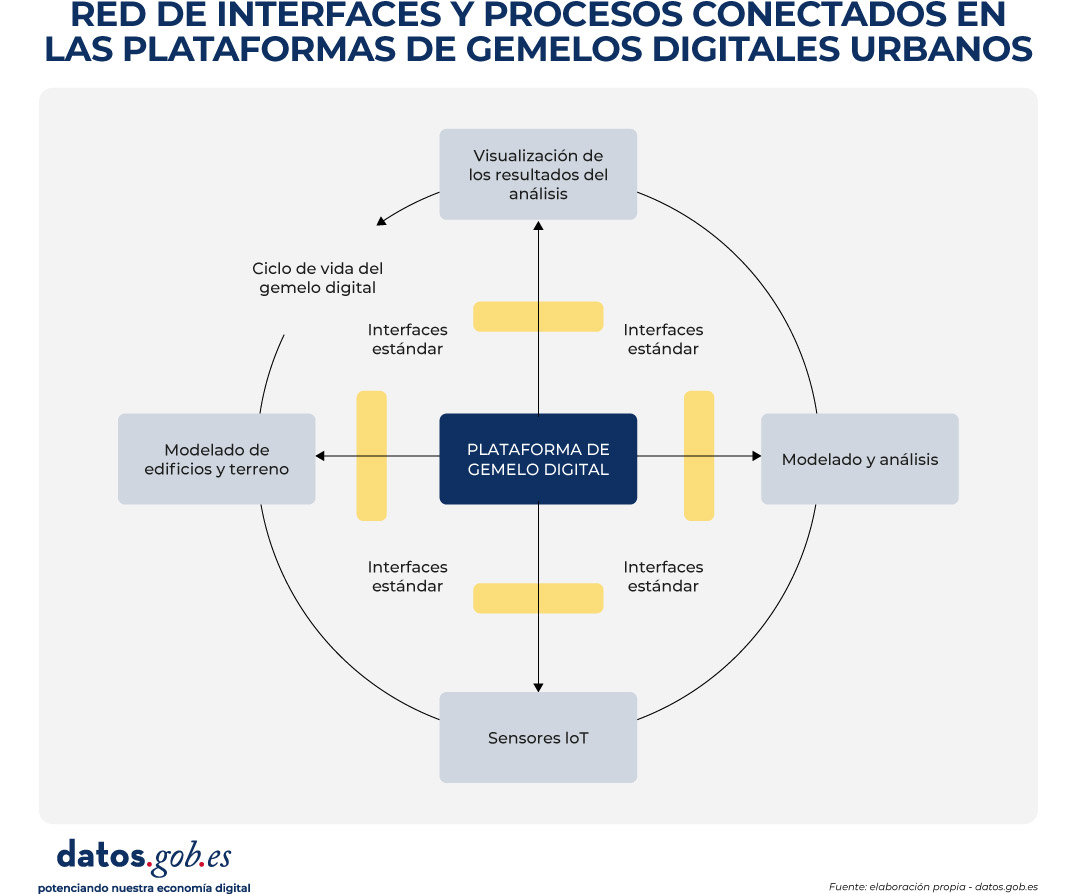

Con el fin de contextualizar el papel de los estándares y facilitar la comprensión del funcionamiento interno de un gemelo digital urbano, la Figura 1 presenta un diagrama conceptual de la red de interfaces, modelos de datos y procesos que lo sustentan. El esquema ilustra cómo diferentes fuentes de información urbana —datos geoespaciales de referencia, modelos 3D de ciudad, información normativa y, en determinados casos, flujos dinámicos— se integran mediante estructuras de datos estandarizadas y servicios interoperables.

Figura 1. Diagrama conceptual de la red de interfaces y procesos conectados en las plataformas de gemelos digitales urbanos. Fuente: elaboración propia – datos.gob.es.

En estos entornos, CityGML y CityJSON actúan como modelos de información urbana que permiten describir digitalmente la ciudad de forma estructurada y comprensible. En la práctica, funcionan como “lenguajes comunes” para representar edificios, infraestructuras y espacios públicos, no solo desde el punto de vista de su forma (geometría), sino también de su significado (por ejemplo, si un objeto es un edificio residencial, una vía pública o una zona verde). Gracias a ello, estos modelos constituyen la base sobre la que se apoyan los análisis urbanos y la simulación de distintos escenarios.

Para que estos modelos tridimensionales puedan visualizarse de manera ágil en navegadores web y aplicaciones digitales, especialmente cuando se trata de grandes volúmenes de información, se puede incorporar 3D Tiles. Este estándar permite dividir los modelos urbanos en fragmentos manejables, facilitando su carga progresiva y su exploración interactiva, incluso en dispositivos con capacidades limitadas.

El acceso, intercambio y reutilización de toda esta información habitualmente se articula a través de OGC APIs, que pueden entenderse como interfaces normalizadas que permiten a distintas aplicaciones consultar y combinar datos urbanos de forma consistente. Estas interfaces hacen posible, por ejemplo, que una plataforma de planificación urbana, una herramienta de análisis climático o un visor ciudadano accedan a los mismos datos sin necesidad de duplicarlos ni transformarlos de manera específica.

De este modo, el diagrama refleja el flujo de datos desde las fuentes originales hasta las aplicaciones finales, mostrando cómo el uso de estándares abiertos permite separar claramente los datos, los servicios y los casos de uso. Esta separación resulta clave para garantizar la interoperabilidad entre sistemas, la escalabilidad de las soluciones digitales y la sostenibilidad del gemelo digital urbano a lo largo del tiempo, aspectos que se abordan de forma transversal en el resto del documento.

Figura 2. Vista General. Imagen de la UTE Fuses Viader + Perea + Mansilla + Desvigne.

Un ejemplo del impacto de los gemelos digitales urbanos en la construcción y gestión urbana puede encontrarse en el proyecto de regeneración urbana de la Plaza de las Glòries Catalanes, en Barcelona (España). Este proyecto tenía como objetivo transformar una de las zonas urbanas más emblemáticas de la ciudad en un espacio público más accesible, verde y sostenible.

Mediante el uso de gemelos digitales desde las fases iniciales del proyecto, los equipos de diseño y planificación pudieron crear modelos digitales detallados que representaban no solo la geometría de los edificios e infraestructuras existentes, sino también las complejas interacciones entre los distintos elementos urbanos, como el tráfico, el transporte público y las áreas peatonales.

Estos modelos no solo facilitaron la visualización y la comunicación del diseño propuesto entre todas las partes interesadas, sino que también permitieron simular distintos escenarios y evaluar su impacto en la movilidad, la calidad del aire y la accesibilidad peatonal. Como resultado, se pudieron tomar decisiones más informadas, contribuyendo de manera decisiva al éxito global de la iniciativa de regeneración urbana.

El papel crítico de los datos abiertos en los gemelos digitales urbanos

En el contexto de los gemelos digitales urbanos, los datos abiertos no deben entenderse como un complemento opcional ni como una acción puntual de transparencia, sino como la base estructural sobre la que se construyen sistemas urbanos digitales sostenibles, interoperables y reutilizables en el tiempo. Un gemelo digital urbano solo puede cumplir su función como herramienta de planificación, análisis y apoyo a la toma de decisiones si los datos que lo alimentan están disponibles, bien definidos y gobernados conforme a principios comunes.

Cuando un gemelo digital se desarrolla sin una estrategia clara de datos abiertos, tiende a convertirse en un sistema cerrado y dependiente de soluciones tecnológicas o proveedores concretos. En estos escenarios, la actualización de la información resulta costosa y compleja, la reutilización en nuevos contextos es limitada y el gemelo pierde rápidamente su valor estratégico, quedando obsoleto frente a la evolución real de la ciudad que pretende representar. Esta falta de apertura dificulta además la integración con otros sistemas y reduce la capacidad de adaptación a nuevas necesidades normativas, sociales o ambientales.

Uno de los principales aportes de los gemelos digitales urbanos es su capacidad para fundamentar las decisiones públicas en datos trazables y verificables. Cuando se apoyan en datos abiertos accesibles y comprensibles, estos sistemas permiten entender no solo el resultado de una decisión, sino también los datos, modelos y supuestos que la sustentan, integrando información geoespacial, modelos urbanos, normativa y, en determinados casos, datos dinámicos. Esta trazabilidad resulta clave para la rendición de cuentas, la evaluación de políticas públicas y la generación de confianza tanto a nivel institucional como ciudadano. Por el contrario, en ausencia de datos abiertos, los análisis y simulaciones que respaldan las decisiones urbanas se vuelven opacos, dificultando explicar cómo y por qué se ha llegado a una determinada conclusión y debilitando la confianza en el uso de tecnologías avanzadas para la gestión urbana.

Los gemelos digitales urbanos requieren, además, la colaboración de múltiples actores —administraciones, empresas, universidades y ciudadanía— y la integración de datos procedentes de distintos niveles administrativos y dominios sectoriales. Sin un enfoque basado en datos abiertos estandarizados, esta colaboración se ve obstaculizada por barreras técnicas y organizativas: cada actor tiende a utilizar formatos, modelos e interfaces diferentes, lo que incrementa los costes de integración y frena la creación de ecosistemas de reutilización en torno al gemelo digital.

Otro riesgo significativo asociado a la ausencia de datos abiertos es el incremento de la dependencia tecnológica y la consolidación de silos de información. Los gemelos digitales construidos sobre datos no estandarizados o de acceso restringido suelen quedar ligados a soluciones propietarias, dificultando su evolución, migración o integración con otros sistemas. Desde la perspectiva del gobierno del dato, esta situación compromete la soberanía de la información urbana y limita la capacidad de las administraciones para mantener el control sobre activos digitales estratégicos.

Por el contrario, cuando los datos urbanos se publican como datos abiertos estandarizados, el gemelo digital puede evolucionar como una infraestructura pública de datos, compartida, reutilizable y extensible en el tiempo. Esto implica no solo que los datos estén disponibles para su consulta o visualización, sino que sigan modelos de información comunes, con semántica explícita, geometría coherente y mecanismos de acceso bien definidos que faciliten su integración en distintos sistemas y aplicaciones.

Este enfoque permite que el gemelo digital urbano actúe como una base de datos común sobre la que puedan construirse múltiples casos de uso —planificación urbana, gestión de licencias, evaluación ambiental, análisis de riesgos climáticos, movilidad o participación ciudadana— sin duplicar esfuerzos ni generar inconsistencias. La reutilización sistemática de la información no solo optimiza recursos, sino que garantiza coherencia entre las distintas políticas públicas que inciden sobre el territorio.

Desde una perspectiva estratégica, los gemelos digitales urbanos basados en datos abiertos estandarizados permiten además alinear las políticas locales con los principios europeos de interoperabilidad, reutilización y soberanía del dato. El uso de estándares abiertos y modelos de información comunes facilita la integración de los gemelos digitales en iniciativas más amplias, como los espacios de datos sectoriales o las estrategias de digitalización y sostenibilidad promovidas a nivel europeo. De este modo, las ciudades no desarrollan soluciones aisladas, sino infraestructuras digitales coherentes con marcos normativos y estratégicos superiores, reforzando el papel del gemelo digital como herramienta transversal, transparente y sostenible para la gestión urbana.

Figura 3. Estrategias para implementar gemelos digitales urbanos. Fuente: elaboración propia– datos.gob.es.

Conclusión

Los gemelos digitales urbanos representan una oportunidad estratégica para transformar la forma en que las ciudades planifican, gestionan y toman decisiones sobre su territorio. Sin embargo, su verdadero valor no reside en la sofisticación tecnológica de las plataformas ni en la calidad de las visualizaciones, sino en la solidez del enfoque de datos sobre el que se construyen.

Los gemelos digitales urbanos solo pueden consolidarse como herramientas útiles y sostenibles cuando se apoyan en datos abiertos estandarizados, bien gobernados y concebidos desde su origen para la interoperabilidad y la reutilización. En ausencia de estos principios, los gemelos digitales corren el riesgo de convertirse en soluciones cerradas, difíciles de mantener, escasamente reutilizables y desconectadas de los procesos reales de gobernanza urbana.

El uso de modelos de información comunes, estándares abiertos y mecanismos de acceso interoperables permite que el gemelo digital evolucione como una infraestructura pública de datos, capaz de servir a múltiples políticas públicas y de adaptarse a los cambios sociales, ambientales y normativos que afectan a la ciudad. Esta aproximación refuerza la transparencia, mejora la coordinación institucional y facilita la toma de decisiones basadas en evidencias verificables.

En definitiva, apostar por gemelos digitales urbanos basados en datos abiertos estandarizados no es únicamente una decisión técnica, sino una decisión de política pública en materia de gobierno del dato. Es esta visión la que permitirá que los gemelos digitales contribuyan de forma efectiva a afrontar los grandes retos urbanos y a generar un valor público duradero para la ciudadanía.

Contenido elaborado por Mayte Toscano, Senior Consultant en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autora

El acceso a datos a través de API se ha convertido en una de las piezas clave del ecosistema digital actual. Administraciones públicas, organismos internacionales y empresas privadas publican información para que terceros puedan reutilizarla en aplicaciones, análisis o proyectos de inteligencia artificial. En esta situación, hablar de datos abiertos es, casi inevitablemente, hablar también de API.

Sin embargo, el acceso a una API rara vez es completamente libre e ilimitado. Existen restricciones, controles y mecanismos de protección que buscan equilibrar dos objetivos que, a primera vista, pueden parecer opuestos: facilitar el acceso a los datos y garantizar la estabilidad, seguridad y sostenibilidad del servicio. Estas limitaciones generan dudas frecuentes: ¿son realmente necesarias?, ¿van contra el espíritu de los datos abiertos?, ¿hasta qué punto pueden aplicarse sin cerrar el acceso?

Este artículo aborda cómo se gestionan estas limitaciones, por qué son necesarias y cómo encajan —lejos de lo que a veces se piensa— dentro de una estrategia coherente de datos abiertos.

Por qué es necesario limitar el acceso a una API

Una API no es simplemente un “grifo” de datos. Detrás suele haber infraestructura tecnológica, servidores, procesos de actualización, costes operativos y equipos responsables de que el servicio funcione correctamente.

Cuando un servicio de datos se expone sin ningún tipo de control, aparecen problemas bien conocidos:

- Saturación del sistema, provocada por un número excesivo de consultas simultáneas.

- Uso abusivo, intencionado o no, que degrade el servicio para otros usuarios.

- Costes descontrolados, especialmente cuando la infraestructura está desplegada en la nube.

- Riesgos de seguridad, como ataques automatizados o scraping masivo.

En muchos casos, la ausencia de límites no conduce a más apertura, sino a un deterioro progresivo del propio servicio.

Por este motivo, limitar el acceso no suele ser una decisión ideológica, sino una necesidad práctica para asegurar que el servicio sea estable, predecible y justo para todos los usuarios.

La API Key: control básico, pero efectivo

El mecanismo más habitual para gestionar el acceso es la API Key. Mientras que en algunos casos como la API del catálogo nacional de datos abiertos de datos.gob.es no se requiere ningún tipo de clave para poder acceder a la información publicada, otros catálogos solicitan una clave única que identifica a cada usuario o aplicación y que se incluye en cada llamada a la API.

Aunque desde fuera pueda parecer una simple formalidad, la API Key cumple varias funciones importantes. Permite identificar quién consume los datos, medir el uso real del servicio, aplicar límites razonables y actuar ante comportamientos problemáticos sin afectar al resto de usuarios.

En el contexto español existen ejemplos claros de plataformas de datos abiertos que funcionan así. La Agencia Estatal de Meteorología (AEMET), por ejemplo, ofrece acceso abierto a datos meteorológicos de alto valor, pero exige solicitar una API Key gratuita para consultas automatizadas. El acceso es libre y gratuito, pero no anónimo ni descontrolado.

Hasta aquí, el enfoque es relativamente conocido: identificación del consumidor y límites básicos de uso. Sin embargo, en muchas situaciones nos esto ya no es suficiente.

Cuando la API se convierte en un activo estratégico

Las plataformas líderes de gestión de API, como MuleSoft o Kong entre otros, fueron pioneras en implantar mecanismos avanzados de control y protección del acceso a las API. Su foco inicial estaba ligado a entornos empresariales complejos, donde múltiples aplicaciones, organizaciones y países consumen servicios de datos de forma intensiva y continuada.

Con el tiempo, muchas de estas prácticas han ido extendiéndose también a plataformas de datos abiertos. A medida que ciertos servicios de datos abiertos ganan relevancia y se convierten en dependencias clave para aplicaciones, investigaciones o modelos de negocio, los retos asociados a su disponibilidad y estabilidad se vuelven similares. La caída o degradación de servicios de datos abiertos de gran escala —como los relacionados con observación de la Tierra, clima o ciencia— puede tener un impacto significativo en múltiples sistemas que dependen de ellos.

En este sentido, la gestión avanzada del acceso deja de ser una cuestión exclusivamente técnica y pasa a formar parte de la propia sostenibilidad de un servicio que se vuelve estratégico. No se trata tanto de quién publica los datos, sino del papel que esos datos juegan dentro de un ecosistema más amplio de reutilización. Por ello, muchas plataformas de open data están adoptando, de forma progresiva, mecanismos ya probados en otros ámbitos, adaptándolos a sus principios de apertura y acceso público. A continuación, se detallan algunos de ellos.

Limitar el caudal: regular el ritmo, no el derecho de acceso

Una de las primeras capas adicionales es la limitación del caudal de uso, lo que habitualmente se conoce como rate limiting. En lugar de permitir un número ilimitado de llamadas, se define cuántas peticiones pueden realizarse en un intervalo de tiempo determinado.

La clave aquí no es impedir el acceso, sino regular el ritmo. Un usuario puede seguir utilizando los datos, pero se evita que una única aplicación monopolice los recursos. Este enfoque es habitual en las API de datos meteorológicos, movilidad o estadísticas públicas, donde muchos usuarios acceden simultáneamente.

Las plataformas más avanzadas van un paso más allá y aplican límites dinámicos, que se ajustan según la carga del sistema, el momento del día o el comportamiento histórico del consumidor. El resultado es un control más justo y flexible.

Contexto, origen y comportamiento: más allá del volumen

Otra evolución importante es dejar de mirar solo cuántas llamadas se hacen y empezar a analizar desde dónde y cómo se realizan. Aquí entran medidas como la restricción por direcciones IP, el control geográfico (geofencing) o la diferenciación entre entornos de prueba y producción.

En algunos casos, estas limitaciones responden a marcos regulatorios o licencias de uso. En otros, simplemente permiten proteger partes más sensibles del servicio sin cerrar el acceso general. Por ejemplo, una API puede ser accesible globalmente en modo consulta, pero limitar determinadas operaciones a situaciones muy concretas.

Las plataformas también analizan patrones de comportamiento. Si una aplicación empieza a realizar consultas repetitivas, incoherentes o muy distintas a su uso habitual, el sistema puede reaccionar automáticamente: reducir temporalmente el caudal, lanzar alertas o exigir un nivel adicional de validación. No se bloquea “porque sí”, sino porque el comportamiento deja de encajar con un uso razonable del servicio.

Medir impacto, no solo llamadas

Una tendencia especialmente relevante es dejar de medir únicamente el número de peticiones y empezar a considerar el impacto real de cada una. No todas las consultas consumen los mismos recursos: algunas transfieren grandes volúmenes de datos o ejecutan operaciones más costosas.

Un ejemplo claro en datos abiertos sería una API de movilidad urbana. Consultar el estado de una parada o el tráfico en un punto concreto implica pocos datos y un impacto limitado. En cambio, descargar de una sola vez todo el histórico de posiciones de vehículos de una ciudad durante varios años supone una carga mucho mayor para el sistema, aunque se realice en una única llamada.

Por este motivo, muchas plataformas introducen cuotas basadas en volumen de datos transferidos, tipo de operación o peso de la consulta. Esto evita situaciones en las que un uso aparentemente moderado genera una carga desproporcionada sobre el sistema.

¿Cómo encaja todo esto con el open data?

Llegados a este punto, surge inevitablemente la pregunta: ¿siguen siendo abiertos los datos cuando existen todas estas capas de control?

La respuesta depende menos de la tecnología y más de las reglas del juego. Los datos abiertos no se definen por la ausencia total de control técnico, sino por principios como el acceso no discriminatorio, la ausencia de barreras económicas, la claridad en las licencias y la posibilidad real de reutilización.

Solicitar una API Key, limitar el caudal o aplicar controles contextuales no contradice estos principios si se hace de forma transparente y equitativa. De hecho, en muchos casos es la única manera de garantizar que el servicio siga existiendo y funcionando correctamente a medio y largo plazo.

La clave está en el equilibrio: reglas claras, acceso gratuito, límites razonables y mecanismos pensados para proteger el servicio, no para excluir. Cuando este equilibrio se consigue, el control deja de percibirse como una barrera y pasa a ser parte natural de un ecosistema de datos abiertos, útiles y sostenibles.

Contenido elaborado por Juan Benavente, ingeniero superior industrial y experto en Tecnologías ligadas a la economía del dato. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El Cabildo Insular de Tenerife ha convocado el II Concurso de Datos Abiertos: Desarrollo de APP, una iniciativa que premia la creación de aplicaciones web y móviles que aprovechen los conjuntos de datos disponibles en su portal datos.tenerife.es. Esta convocatoria representa una nueva oportunidad para desarrolladores, emprendedores y entidades innovadoras que quieran transformar información pública en soluciones digitales de valor para la sociedad. En este post, te contamos los detalles sobre la competición.

Un ecosistema en crecimiento: de las ideas a las aplicaciones

Esta iniciativa se enmarca en el proyecto de Datos Abiertos del Cabildo de Tenerife, que promueve la transparencia, la participación ciudadana y la generación de valor económico y social a través de la reutilización de información pública.

El Cabildo ha diseñado una estrategia en dos fases:

-

El I Concurso de Datos Abiertos: Ideas de Reutilización (ya celebrado) centrado en identificar propuestas creativas.

-

El II Concurso: Desarrollo de APP (convocatoria actual) que da continuidad al proceso y busca materializar ideas en aplicaciones funcionales.

Este enfoque progresivo permite construir un ecosistema de innovación que acompaña a los participantes desde la conceptualización hasta el desarrollo completo de soluciones digitales.

El objetivo es fomentar la creación de productos y servicios digitales que generen impacto social y económico, mientras se identifican nuevas oportunidades de innovación y emprendimiento en el ámbito de los datos abiertos.

Premios y dotación económica

Este concurso cuenta con una dotación total de 6.000 euros distribuidos en tres premios:

-

Primer premio: 3.000 euros

-

Segundo premio: 2.000 euros

-

Tercer premio: 1.000 euros

¿Quién puede participar?

La convocatoria está abierta a:

-

Personas físicas: desarrolladores individuales, diseñadores, estudiantes o cualquier persona interesada en la reutilización de datos abiertos.

-

Personas jurídicas: startups, empresas de tecnología, cooperativas, asociaciones u otras entidades.

Siempre y cuando presenten el desarrollo de una aplicación basada en datos abiertos del Cabildo de Tenerife. Una misma persona, física o jurídica, puede presentar tantas candidaturas como desee, tanto de forma individual como conjunta.

¿Qué tipo de aplicaciones se pueden presentar?

Las propuestas deben ser aplicaciones web o móviles que utilicen al menos un conjunto de datos del portal datos.tenerife.es. Algunas ideas que pueden servir de inspiración son:

-

Aplicaciones para optimizar el transporte y la movilidad en la isla.

-

Herramientas de visualización de datos turísticos o medioambientales.

-

Servicios de información ciudadana en tiempo real.

-

Soluciones para mejorar la accesibilidad y la participación social.

-

Plataformas de análisis de datos económicos o demográficos.

Criterios de evaluación: ¿qué valora el jurado?

El jurado evaluará las propuestas considerando los siguientes criterios:

-

Uso de datos abiertos: grado de aprovechamiento e integración de los conjuntos de datos disponibles en el portal.

-

Impacto y utilidad: valor que aporta la aplicación a la sociedad, capacidad para resolver problemas reales o mejorar servicios existentes.

-

Innovación y creatividad: originalidad de la propuesta y carácter innovador de la solución planteada.

-

Calidad técnica: solidez del código, buenas prácticas de programación, escalabilidad y mantenibilidad de la aplicación.

-

Diseño y usabilidad: experiencia de usuario (UX), diseño visual atractivo e intuitivo, garantía de accesibilidad digital en dispositivos Android e iOS.

¿Cómo participar?: plazos y forma de presentación:

Las solicitudes pueden presentarse hasta el 10 de marzo de 2026, tres meses desde la publicación de la convocatoria en el Boletín Oficial de la Provincia.

Sobre la documentación requerida, las propuestas deben presentarse en formato digital e incluir:

-

Descripción técnica detallada de la aplicación.

-

Memoria justificativa del uso de los datos abiertos.

-

Especificación de entornos tecnológicos utilizados.

-

Vídeo demostrativo del funcionamiento de la aplicación.

-

Código fuente completo.

-

Ficha técnica resumen.

Desde la institución organizadora recomiendan la presentación telemática a través de la Sede Electrónica del Cabildo de Tenerife, aunque también es posible la presentación presencial en los registros oficiales habilitados. Las bases completas y el modelo oficial de solicitud están disponibles en la Sede Electrónica del Cabildo.

Con esta segunda convocatoria, el Cabildo de Tenerife consolida su apuesta por la transparencia, la reutilización de información pública y la creación de un ecosistema de innovación digital. Iniciativas como esta demuestran cómo los datos abiertos pueden convertirse en catalizadores del emprendimiento, la participación ciudadana y el desarrollo económico local.

En los últimos seis meses, el ecosistema de datos abiertos en España ha vivido una intensa actividad marcada por los avances normativos y estratégicos, la puesta en marcha de nuevas plataformas y funcionalidades en los portales de datos, o el lanzamiento de soluciones innovadoras basadas en la información pública.

En este artículo, repasamos algunos de esos avances, para que puedas estar al día. Te invitamos también a revisar el artículo sobre las novedades del primer semestre de 2025 para que puedas tener una visión general de lo que ha sucedido este año en el ecosistema de datos nacional.

Avances estratégicos, normativos y políticos de carácter transversal

La calidad, interoperabilidad y gobernanza de los datos se han situado en el centro de la agenda tanto nacional como europea, con iniciativas que buscan fomentar un marco sólido para aprovechar el valor de los datos como activo estratégico.

Una de las principales novedades ha sido el lanzamiento de un nuevo paquete digital por parte de la Comisión Europea con el fin de consolidar un ecosistema europeo de datos robusto, seguro y competitivo. Este paquete incluye un ómnibus digital para simplificar la aplicación del Reglamento de inteligencia artificial (IA). Además, se complementa con la nueva Estrategia Unión de Datos (Data Union Strategy) que se articula en torno a tres pilares:

- Ampliar el acceso a datos de calidad para impulsar la inteligencia artificial y la innovación.

- Simplificar el marco normativo existente para reducir barreras y burocracia.

- Proteger la soberanía digital europea frente a dependencias externas.

Su implementación se producirá de forma gradual durante los próximos meses. Será entonces cuando podamos ir apreciando sus efectos sobre nuestro país y el resto de territorios comunitarios.

La actividad en España también se ha visto -y se verá- marcada por el V Plan de Gobierno Abierto 2025-2029, aprobado el pasado octubre. Este plan cuenta con más de 200 iniciativas y aportaciones tanto de la sociedad civil como de administraciones, muchas de ellas relacionadas con la apertura y reutilización de datos. El compromiso de España con los datos abiertos también ha quedado patente en la adhesión a la Carta Internacional de Datos Abiertos, una iniciativa global que promueve la apertura y reutilización de datos públicos como herramientas para mejorar la transparencia, la participación ciudadana, la innovación y la rendición de cuentas.

Junto al impulso de la apertura de datos, también se ha trabajado en el desarrollo de espacios de compartición de datos. En este sentido, se presentó la normativa UNE 0087, que se suma a especificaciones UNE sobre datos y define por primera vez en España los principios y requisitos clave para crear y operar en espacios de datos, mejorando su interoperabilidad y gobernanza.

Más soluciones innovadoras basadas en datos

Los organismos españoles continúan aprovechando el potencial de los datos como motor de soluciones y políticas que optimizan la prestación de servicios a la ciudadanía. Algunos ejemplos son:

- El Ministerio de Sanidad y la iniciativa de ciencia ciudadana, Mosquito Alert, están utilizando inteligencia artificial y análisis de imágenes automatizado para mejorar la detección y seguimiento en tiempo real de mosquitos tigres y especies invasoras.

- La Fundación Valenciaport, junto a otras organizaciones europeas, ha lanzado una herramienta gratuita que permite evaluar los beneficios de instalar sistemas de energía eólica y fotovoltaica en los puertos.

- El Cabildo de la Palma apostó por una agricultura inteligente con la nueva web Smart Agro: los agricultores reciben recomendaciones de riego personalizadas según clima y ubicación. El Cabildo también ha puesto en marcha un visor para hacer seguimiento de la movilidad en la isla.

- El Ayuntamiento de Segovia ha implementado un gemelo digital que centraliza aplicaciones y datos geográficos de alto valor, permitiendo visualizar y analizar la ciudad en un entorno tridimensional interactivo. Mejora la gestión municipal y promueve la transparencia y la participación ciudadana.

- El Ayuntamiento de Vila-real ha lanzado una aplicación digital que integra transporte público, aparcamientos y puntos turísticos en tiempo real. El proyecto busca optimizar la movilidad urbana y fomentar la sostenibilidad mediante tecnología inteligente.

- El Ayuntamiento de Sant Boi ha lanzado un mapa interactivo elaborado con datos abiertos que centraliza información sobre transporte urbano, aparcamiento y opciones sostenibles en una única plataforma, con el fin de mejorar la movilidad urbana.

- Se ha inaugurado la Red Internacional de Investigación DataActive, una iniciativa financiada por el Consejo Superior de Deportes que busca impulsar el diseño de entornos urbanos activos mediante el uso de datos abiertos.

No solo los organismos públicos reutilizan los datos abiertos, desde las universidades también se trabaja en proyectos ligados a la innovación digital basados en información pública:

- Estudiantes de la Universitat de València han diseñado proyectos que utilizan IA y datos abiertos para prevenir desastres naturales.

- Investigadores de la Universidad de Castilla-La Mancha han demostrado que es viable reutilizar modelos de predicción de calidad del aire en distintas zonas de Madrid usando transfer learning.

Además de soluciones, los datos abiertos también sirven para dar forma a otros tipos de productos, incluso esculturas. Es el caso de “El esqueleto del cambio climático”, una figura que presentó el Museo Nacional de Ciencias Naturales, basada en datos sobre los cambios en la temperatura global desde 1880 hasta 2024.

Nuevos portales y funcionalidades para extraer valor de los datos

Las soluciones e innovaciones comentadas anteriormente son posibles gracias a la existencia de múltiples plataformas de apertura o compartición de datos que no dejan de incorporar nuevos conjuntos de datos y funcionalidades para extraerles valor. Algunas de las novedades que hemos visto a este respecto en los últimos meses son:

- El Observatorio Nacional de Tecnología y Sociedad (ONTSI) ha lanzado una nueva web. Una de sus novedades es Ontsi Data, una herramienta para elaborar informes con indicadores tanto de su portal como de terceros.

- El Consejo General del Notariado ha lanzado un Portal Estadístico de la Vivienda, una herramienta abierta con datos fiables y actualizados sobre el mercado inmobiliario en España.

- La Agencia Española de Seguridad Alimentaria y Nutrición (AESAN) ha inaugurado en su web un espacio de datos abiertos con microdatos sobre la composición de alimentos y bebidas comercializados en España.

- El Centro de Investigaciones Sociológicas (CIS) estrenó una web renovada, adaptada a cualquier dispositivo y con un buscador más potente para facilitar el acceso a sus estudios y datos.

- El Instituto Geográfico Nacional (IGN) ha presentado una nueva web del SIOSE, el Sistema de Información sobre Ocupación del Suelo de España, con un diseño más moderno, intuitivo y dinámico. Además, ha puesto a disposición de la ciudadanía una nueva versión de la Información Geográfica de Referencia de Redes de Transporte (IGR-RT), segmentada por provincias y modos de transporte, y disponible en Shapefile y GeoPackage.

- La Plataforma de Asesores AKIS, impulsada por el Ministerio de Agricultura, Pesca y Alimentación, ha puesto en marcha una nueva API de datos abiertos que permite a los usuarios registrados descargar y reutilizar contenidos relacionados con el sector agroalimentario en España.

- La Generalitat de Catalunya estrenó nueva web corporativa que centraliza aspectos clave sobre fondos europeos, contratación pública, transparencia y datos abiertos en un único punto. También ha lanzado una web donde recoge información sobre los sistemas de IA que utiliza.

- PortCastelló ha publicado sus Memorias 2024 en formato open data. Toda la gestión, tráficos, infraestructuras y datos económicos del puerto ahora son accesibles y reutilizables por cualquier ciudadano.

- Investigadores de la Universitat Oberta de Catalunya y del Instituto de Ciencias Fotónicas han creado una biblioteca abierta con datos de 140 biomoléculas. Un recurso pionero que impulsa la ciencia abierta y el uso de datos abiertos en biomedicina.

- También se presentó CitriData, un espacio federado de datos, modelos y servicios en la cadena de valor de los cítricos andaluces. Su objetivo es transformar el sector mediante el uso inteligente y colaborativo de los datos.

Otros organismos están inmersos en el desarrollo de sus novedades. Por ejemplo, próximamente veremos el nuevo Portal de Datos Abiertos de Aguas de Alicante, que permitirá un acceso público a información clave sobre la gestión del agua, fomentando el desarrollo de soluciones basadas en Big Data e IA.

Estos meses también se han presentado avances estratégicos ligados a mejorar la calidad y el uso de los datos, como el Modelo de Gobierno del Dato de la Generalitat Valenciana o la Hoja de Ruta para la Estrategia Provincial de inteligencia artificial de la diputación de Castellón.

Datos.gob.es también presentó una nueva plataforma dirigida a para optimizar tanto la publicación como el acceso a los datos. Si quieres conocer esta y otras novedades de la Iniciativa Aporta en el año 2025, te invitamos a leer este post.

Fomentando el uso de los datos a través de eventos, recursos y acciones ciudadanas

La segunda mitad del año 2025 fue la época elegida por gran cantidad de organismos públicos para lanzar concursos dirigidos a impulsar la reutilización de los datos que publican. Fue el caso de la Junta de Castilla y León, el Ayuntamiento Madrid, el Ayuntamiento de Valencia o la Diputación Foral de Bizkaia. También se ha participado desde nuestro país en eventos internacionales como el Desafío NASA Space Apps.

Entre los eventos donde se ha aprovecho para difundir el poder de los datos abiertos, destacan la Cumbre Global de Open Government Partnership (OGP), las Jornadas Ibéricas de Infraestructuras de Datos Espaciales (JIIDE), el Congreso Internacional de Transparencia y Gobierno Abierto o la 17ª Conferencia Internacional sobre Reutilización de la Información del Sector Público de ASEDIE, aunque hubo muchos más.

También se ha trabajado en informes que ponen de manifiesto el impacto de los datos en sectores concretos, como el Informe Cátedra DATAGRI 2025 de la Universidad de Córdoba, centrado en el sector agroalimentario. Otros documentos publicados buscan ayudar a mejorar la gestión de los datos, como “Fundamentos del Gobierno del Dato en el contexto de los espacios de datos", liderado por DAMA España, en colaboración con Gaia-X España.

La participación ciudadana también es fundamental para el éxito de la innovación basada en datos. En este sentido, hemos visto tanto actividades dirigidas a impulsar la publicación de datos como a mejorar los ya publicados o su reutilización:

- Desde la Iniciativa Barcelona Open Data se solicitó la ayuda ciudadana para elaborar un ranking de soluciones digitales basadas en datos abiertos para promover el envejecimiento saludable. También organizaron una actividad participativa para mejorar la app iCuida, dirigida a trabajadores del hogar y cuidados. Esta app permite buscar lavabos públicos, refugios climáticos y otros puntos de interés para el día a día de las cuidadoras.

- La Agencia Espacial Española lanzó una encuesta para conocer necesidades y usos de imágenes y datos de Observación de la Tierra en el marco de proyectos estratégicos como la Constelación Atlántica.

En conclusión, las actividades realizadas en el segundo semestre de 2025 ponen de manifiesto la consolidación del ecosistema de datos abiertos en España como un motor de innovación, transparencia y participación ciudadana. Los avances normativos y estratégicos, junto con la creación de nuevas plataformas y soluciones basadas en datos, muestran un compromiso firme por parte de las instituciones y la sociedad en aprovechar la información pública como recurso clave para el desarrollo sostenible, la mejora de servicios y la generación de conocimiento.

Como siempre, este artículo es solo una pequeña muestra de las actividades realizadas. Te invitamos a compartir otras actividades que conozcas a través de los comentarios.

Los datos abiertos son una pieza central de la innovación digital en torno a la inteligencia artificial ya que permiten, entre otras cosas, entrenar modelos o evaluar algoritmos de aprendizaje automático. Pero entre “descargar un CSV de un portal” y acceder a un conjunto de datos listo para aplicar técnicas de aprendizaje automático hay, todavía, un abismo.

Buena parte de ese abismo tiene que ver con los metadatos, es decir cómo se describen los conjuntos de datos (a qué nivel de detalle y con qué estándares). Si los metadatos se limitan a título, descripción y licencia, el trabajo de comprensión y preparación de datos se hace más complejo y tedioso para la persona que diseña el modelo de aprendizaje automático. Si, en cambio, se usan estándares que faciliten la interoperabilidad, como DCAT, los datos se vuelven más FAIR (Findable, Accessible, Interoperable, Reusable) y, por tanto, más fáciles de reutilizar. No obstante, es necesario metadatos adicionales para que los datos sean más fáciles de integrar en flujos de aprendizaje automático.

Este artículo realiza un itinerario por las diversas iniciativas y estándares necesarios para dotar a los datos abiertos de metadatos útiles para la aplicación de técnicas de aprendizaje automático.

DCAT como columna vertebral de los portales de datos abiertos

El vocabulario DCAT (Data Catalog Vocabulary) fue diseñado por la W3C para facilitar la interoperabilidad entre catálogos de datos publicados en la Web. Describe catálogos, conjuntos de datos y distribuciones, siendo la base sobre la que se construyen muchos portales de datos abiertos.

En Europa, DCAT se concreta en el perfil de aplicación DCAT-AP, recomendado por la Comisión Europea y ampliamente adoptado para describir conjuntos de datos en el sector público, por ejemplo, en España con DCAT-AP-ES. Con DCAT-AP se responde a preguntas como:

- ¿Qué conjuntos de datos existen sobre un tema concreto?

- ¿Quién los publica, bajo qué licencia y en qué formatos?

- ¿Dónde están las URL de descarga o las API de acceso?

El uso de un estándar como DCAT es imprescindible para descubrir conjuntos de datos, pero es necesario ir un paso más allá con el fin de saber cómo se utilizan en modelos de aprendizaje automático o qué calidad tienen desde la perspectiva de estos modelos.

MLDCAT-AP: aprendizaje automático en el catálogo de un portal de datos abiertos

MLDCAT-AP (Machine Learning DCAT-AP) es un perfil de aplicación de DCAT desarrollado por SEMIC y la comunidad Interoperable Europe, en colaboración con OpenML, que extiende DCAT-AP al dominio del aprendizaje automático.

MLDCAT-AP incorpora clases y propiedades para describir:

- Modelos de aprendizaje automático y sus características.

- Conjuntos de datos utilizados en el entrenamiento y la evaluación.

- Métricas de calidad obtenidas sobre los conjuntos de datos.

- Publicaciones y documentación asociadas a los modelos de aprendizaje automático.

- Conceptos relacionados con riesgo, transparencia y cumplimiento del contexto regulatorio europeo del AI Act.

Con ello, un catálogo basado en MLDCAT-AP ya no solo responde a “qué datos hay”, sino también a:

- ¿Qué modelos se han entrenado con este conjunto de datos?

- ¿Cuál ha sido el rendimiento de ese modelo según determinadas métricas?

- ¿Dónde se describe este trabajo (artículos científicos, documentación, etc.)?

MLDCAT-AP representa un gran avance en trazabilidad y gobernanza, pero se mantiene la definición de metadatos a un nivel que todavía no considera la estructura interna de los conjuntos de datos ni qué significan exactamente sus campos. Para eso, se necesita bajar a nivel de la propia estructura de la distribución de conjunto de datos.

Metadatos a nivel de estructura interna del conjunto de datos

Cuando se quiere describir qué hay dentro de las distribuciones de los conjuntos de datos (campos, tipos, restricciones), una iniciativa interesante es Data Package, parte del ecosistema de Frictionless Data.

Un Data Package se define por un archivo JSON que describe un conjunto de datos. En este archivo se incluyen no sólo metadatos generales (como el nombre, título, descripción o licencia) y recursos (es decir, los ficheros de datos con su ruta o una URL de acceso a su correspondiente servicio), sino también se define un esquema con:

- Nombres de campos.

- Tipos de datos (integer, number, string, date, etc.).

- Restricciones, como rangos de valores válidos, claves primarias y ajenas, etc.

Desde la óptica del aprendizaje automático, esto se traduce en la posibilidad de realizar una validación estructural automática antes de usar los datos. Además, también permite una documentación precisa de la estructura interna de cada conjunto de datos y mayor facilidad para compartir y versionar conjuntos de datos.

En resumen, mientras que MLDCAT-AP indica qué conjuntos de datos existen y cómo encajan en el ámbito de modelos de aprendizaje automático, Data Package especifica exactamente “qué hay” dentro de los conjuntos de datos.

Croissant: metadatos que preparan datos abiertos para aprendizaje automático

Aun con el concurso de MLDCAT-AP y de Data Package, faltaría conectar los conceptos subyacentes en ambas iniciativas. Por una parte, el ámbito del aprendizaje automático (MLDCAT-AP) y por otro el de las estructuras internas de los propios datos (Data Package). Es decir, se puede estar usando los metadatos de MLDCAT-AP y de Data Package pero para solventar algunas limitaciones que adolecen ambos, es necesario complementarlo. Aquí entra en juego Croissant, un formato de metadatos para preparar los conjuntos de datos para la aplicación de aprendizaje automático. Croissant está desarrollado en el marco de MLCommons, con participación de industria y academia.

Específicamente, Croissant se implementa en JSON-LD y se construye sobre schema.org/Dataset, un vocabulario para describir conjuntos de datos en la Web. Croissant combina los siguientes metadatos:

- Metadatos generales del conjunto de datos.

- Descripción de recursos (archivos, tablas, etc.).

- Estructura de los datos.

- Capa semántica sobre aprendizaje automático (separación de datos de entrenamiento/validación/test, campos objetivo, etc.)

Cabe destacar que Croissant está diseñado para que distintos repositorios (como Kaggle, HuggingFace, etc.) puedan publicar conjuntos de datos en un formato que las librerías de aprendizaje automático (TensorFlow, PyTorch, etc.) puedan cargar de forma homogénea. También existe una extensión de CKAN para usar Croissant en portales de datos abiertos.

Otras iniciativas complementarias

Merece la pena mencionar brevemente otras iniciativas interesantes relacionadas con la posibilidad de disponer de metadatos que permitan preparar a los conjuntos de datos para la aplicación de aprendizaje automático (“ML-ready datasets”):

- schema.org/Dataset: usado en páginas web y repositorios para describir conjuntos de datos. Es la base sobre la que se apoya Croissant y está integrado, por ejemplo, en las directrices de datos estructurados de Google para mejorar la localización de conjuntos de datos en buscadores.

- CSV on the Web (CSVW): conjunto de recomendaciones del W3C para acompañar ficheros CSV con metadatos en JSON (incluyendo diccionarios de datos), muy alineado con las necesidades de documentación de datos tabulares que luego se usan en aprendizaje automático.

- Datasheets for Datasets y Dataset Cards: iniciativas que permiten desarrollar una documentación narrativa y estructurada para describir el contexto, la procedencia y las limitaciones de los conjuntos de datos. Estas iniciativas son ampliamente adoptadas en plataformas como Hugging Face.

Conclusiones

Existen diversas iniciativas que ayudan a realizar una definición de metadatos adecuada para el uso de aprendizaje automático con datos abiertos:

- DCAT-AP y MLDCAT-AP articulan el nivel de catálogo, modelos de aprendizaje automático y métricas.

- Data Package describe y valida la estructura y restricciones de los datos a nivel de recurso y campo.

- Croissant conecta estos metadatos con el flujo de aprendizaje automático, describiendo cómo los conjuntos de datos son ejemplos concretos para cada modelo.

- Iniciativas como CSVW o Dataset Cards complementan las anteriores y son ampliamente utilizadas en plataformas como HuggingFace.

Estas iniciativas pueden usarse de manera combinada. De hecho, si se adoptan de forma conjunta, se permite que los datos abiertos dejen de ser simplemente “ficheros descargables” y se conviertan en una materia prima preparada para el aprendizaje automático, reduciendo fricción, mejorando la calidad y aumentando la confianza en los sistemas de IA construidos sobre ellos.

Jose Norberto Mazón, Catedrático de Lenguajes y Sistemas Informáticos de la Universidad de Alicante. Los contenidos y los puntos de vista reflejados en esta publicación son responsabilidad exclusiva de su autor.

El año 2025 ha supuesto un nuevo impulso para la Iniciativa Aporta y datos.gob.es, consolidando su papel como motor de innovación y referencia en el ecosistema de los datos abiertos en España. A lo largo de estos meses hemos reforzado nuestro compromiso con la apertura de la información pública, ampliando recursos y mejorando la experiencia de quienes reutilizan los datos para generar conocimiento, soluciones y oportunidades.

A continuación, y como siempre que llega el fin de año, recogemos algunos de los avances realizados en estos últimos doce meses, junto con el impacto generado.

Continúa el impulso internacional

Durante este año hemos continuado fortaleciendo la posición internacional de España en materia de datos abiertos, participando en iniciativas y foros que promueven la transparencia y la reutilización de la información pública a nivel global. La colaboración con organismos internacionales y la alineación con estándares europeos han permitido que nuestro país siga siendo un referente en la materia, contribuyendo activamente a la construcción de un ecosistema de datos más sólido y compartido. Algunos puntos a destacar son:

- La adhesión de nuestro país a la Carta Internacional de Datos Abiertos durante la IX Cumbre Global de la Alianza para el Gobierno Abierto en Vitoria-Gasteiz. Con este compromiso, el Gobierno reconoció al dato como un activo estratégico para diseñar políticas públicas y mejorar los servicios, consolidando la transparencia y la innovación digital.

- El impulso de DCAT-AP-ES a través de la puesta en marcha de una comunidad en GitHub, con recursos que facilitan su implementación. Este nuevo modelo de metadatos adopta las directrices del esquema europeo de intercambio de metadatos DCAT-AP, mejorando la interoperabilidad.

- La presencia de España, un año más, entre los países prescriptores en materia de datos abiertos, de acuerdo con el informe Open Data Maturity 2025, elaborado por data.europa.eu. Nuestro país reforzó su liderazgo mediante el desarrollo de políticas estratégicas, la modernización técnica y la innovación impulsada por la reutilización.

Una nueva plataforma con más datos y recursos

Otro de los hitos más destacados ha sido el estreno de la nueva plataforma de datos.gob.es, diseñada para optimizar tanto la publicación como el acceso a los datos. Con un aspecto renovado y una arquitectura de la información más clara, hemos conseguido que la navegación sea más intuitiva y funcional, facilitando que cualquier usuario pueda encontrar y aprovechar la información que necesita de manera más sencilla y eficiente.

A ello hay que sumar el crecimiento en volumen y diversidad de datos publicados en la plataforma. En 2025 hemos alcanzado casi 100.000 conjuntos de datos disponibles para su reutilización, lo que supone un incremento del 9% respecto al año anterior. Entre ellos destacan más de 300 datasets de alto valor, es decir, pertenecientes a categorías “cuya reutilización está asociada a considerables beneficios para la sociedad, el medio ambiente y la economía” de acuerdo con la Unión Europea. Estos conjuntos de datos, fundamentales para proyectos estratégicos, multiplican las posibilidades de análisis y sirven de base para innovaciones tecnologías, por ejemplo, ligadas a la inteligencia artificial.

Pero la Iniciativa Aporta no se limita a ofrecer datos: también acompaña a la comunidad con contenidos que ayudan a comprender y sacar el máximo partido de esta información. Durante este año hemos publicado más de un centenar de artículos de actualidad y análisis, además de infografías, pódcasts y vídeos que acercan temáticas complejas de forma clara y accesible. Asimismo, hemos ampliado nuestras guías y ejercicios prácticos, incorporando nuevas temáticas como el uso de la inteligencia artificial en aplicaciones conversacionales.

La reutilización de datos se refleja también en el aumento de casos de uso y modelos de negocio. En 2025 se han identificado decenas de soluciones, aplicaciones y empresas innovadoras basados en datos abiertos. Estos ejemplos muestran cómo la apertura de la información pública se traduce en beneficios tangibles para la sociedad y la economía.

Una comunidad en constante crecimiento

La comunidad que nos acompaña continúa creciendo y consolidándose. En el caso de las redes sociales, destaca nuestra presencia en LinkedIn, donde llegamos a profesionales y expertos en datos que comparten e interactúan con nuestro contenido de forma constante. Actualmente superamos los 17.000 seguidores (un 23 % más que en 2024). También se ha consolidado la apuesta en Instagram, con un crecimiento del 95 % (400 seguidores). Nuestro perfil en esta red social se puso en marcha en 2024 y desde entonces no deja de crecer, atrayendo a seguidores interesados en las oportunidades que ofrece la reutilización de datos públicos y privados. Por su parte, la comunidad de X (antiguo Twitter) se ha mantenido estable, en 20.700 seguidores.

A ello se suma el boletín de datos.gob.es, que se ha rediseñado y ya cuenta con más de 4.000 suscriptores, un reflejo del interés creciente por mantenerse al día en el ámbito de los datos. También hemos reforzado nuestros canales de atención, respondiendo a numerosas consultas y peticiones de organismos y ciudadanos. En concreto, se han atendido cerca de 2.000 interacciones a través de los distintos canales de soporte a publicadores, consultas generales y dinamización.

Todo este esfuerzo se traduce en un crecimiento sostenido del portal: en 2025 datos.gob.es ha recibido cerca de dos millones de visitas, con más de tres millones y medio de páginas vistas y un aumento significativo en el tiempo de permanencia de los usuarios. Estas cifras confirman que cada vez más personas encuentran en los datos abiertos un recurso valioso para sus proyectos y actividades.

Gracias por acompañarnos

En resumen, el balance de 2025 refleja un año de avances, aprendizajes y logros compartidos. Nada de esto sería posible sin la colaboración de la comunidad de datos en España, que impulsa con su participación y creatividad el universo de los datos abiertos. En 2026 seguiremos trabajando juntos para que los datos continúen siendo una palanca de innovación, transparencia y progreso.

Puedes ver más sobre nuestra actividad en la siguiente infografía:

España vuelve a destacar en el panorama europeo de datos abiertos. El informe Open Data Maturity 2025 sitúa a nuestro país entre los líderes en la apertura y reutilización de información del sector público, consolidando una trayectoria ascendente en innovación digital.

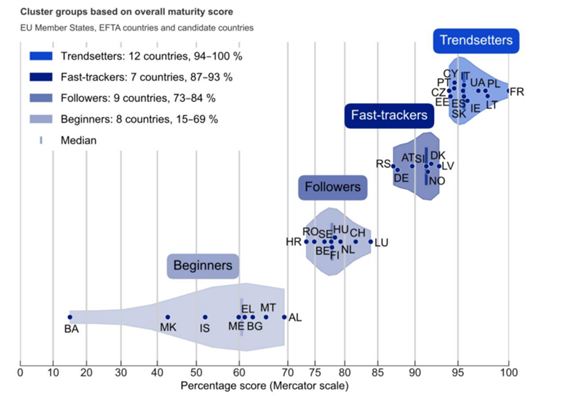

El informe, elaborado anualmente por el portal europeo de datos, data.europa.eu, evalúa el grado de madurez de los datos abiertos en Europa. Para ello analiza varios indicadores, agrupados en cuatro dimensiones: política, portal, calidad e impacto. En la edición de este año han participado 36 países, incluidos los 27 Estados miembros de la Unión Europea (EU), tres países de la Asociación Europea de Libre Comercio (Islandia, Noruega y Suiza) y seis países candidatos (Albania, Bosnia y Herzegovina, Montenegro, Macedonia del Norte, Serbia y Ucrania).

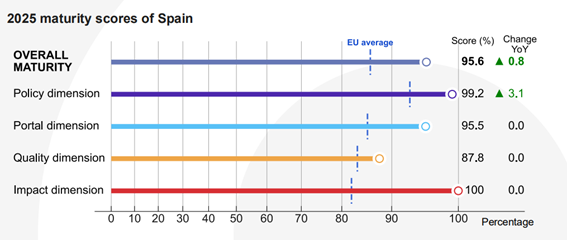

Este año, España se sitúa en quinta posición entre los países de la Unión Europea y sexta del total de países analizados, empatada con Italia. En concreto se ha obtenido una puntuación total de 95,6%, muy por encima de la media de los países analizados (81,1%). Con este dato, España mejora su puntuación con respecto a 2024, cuando obtuvo un 94,8%.

España, entre los líderes europeos

Con esta posición, España se sitúa un año más entre los países prescriptores en materia de datos abiertos (trendsetters), es decir, aquellos que marcan tendencia y sirven de ejemplo de buenas prácticas a otros Estados. España comparte grupo con Francia, Lituania, Polonia, Ucrania, Irlanda, la ya mencionada Italia, Eslovaquia, Chipre, Portugal, Estonia y República Checa.

Los países de este grupo cuentan con políticas avanzadas de datos abiertos, alineadas con los progresos técnicos y políticos de la Unión Europea, incluyendo la publicación de conjuntos de datos de alto valor. Además, existe una coordinación sólida de las iniciativas relacionadas con los datos abiertos en todos los niveles de la administración. Sus portales nacionales ofrecen funciones completas y metadatos de calidad, con escasas limitaciones en publicación o uso. Esto lleva a que los datos publicados se puedan reutilizar más fácilmente para múltiples fines, contribuyendo a generar un impacto positivo en distintos ámbitos.

Figura 1. Países integrantes de los distintos clusters.

Las claves del avance de España

De acuerdo con el informe, España reforzó su liderazgo en materia de datos abiertos mediante el desarrollo de políticas estratégicas, la modernización técnica y la innovación impulsada por la reutilización. En concreto, las mejoras en el ámbito político son las que han impulsado el crecimiento de España:

Figura 2. Puntuación de España en las distintas dimensiones junto con el crecimiento sobre el año anterior.

Tal y como se muestra en la imagen, la dimensión política ha alcanzado una puntuación de 99,2% frente al 96% del año pasado, destacando sobre la media europea que es del 93,1%. El motivo de este crecimiento es el avance en el marco normativo. En este sentido, el informe destaca la configuración del V Plan de Gobierno Abierto, desarrollado a través de un proceso de cocreación en el que participaron todos los grupos de interés. Este plan ha introducido nuevas iniciativas relacionadas con la gobernanza y la reutilización de datos abiertos. Otra cuestión destacada es que España impulsó la publicación de conjuntos de datos de alto valor, en consonancia con el Reglamento de Ejecución (UE) 2023/138.

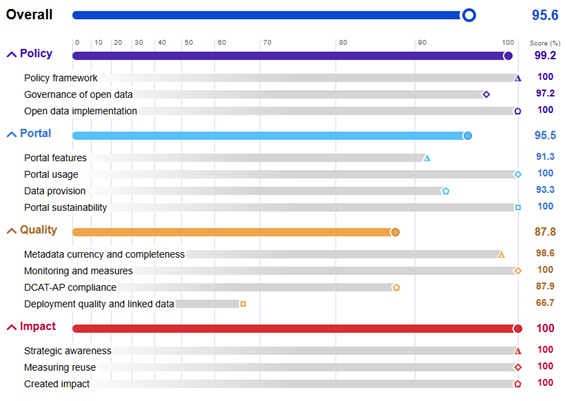

El resto de dimensiones se mantienen estables, todas ellas con puntuaciones por encima de la media europea: en la dimensión portal se ha obtenido un 95,5% en comparación con el 85,45% europeo, mientras que la de calidad ha sido valorada con un 87,8% versus el 83.4% del resto de países analizados. El bloque de Impacto continúa siendo nuestra gran baza, con un 100% frente al 82.1% europeo. En esta dimensión continuamos posicionándonos como grandes líderes, gracias a una definición clara de reutilización, la medición sistemática del uso de datos y la existencia de ejemplos de impacto en los ámbitos gubernamental, social, ambiental y económico.

Aunque no se hayan producido grandes movimientos en la puntuación de estas dimensiones, el informe sí destaca hitos de España en todos los ámbitos. Por ejemplo, la plataforma datos.gob.es se sometió a un importante rediseño, que incluyó ajustes al perfil de metadatos DCAT-AP-ES, con el fin de mejorar la calidad e interoperabilidad. En este sentido, se publicó una guía de implementación específica y se consolidó una comunidad de aprendizaje y desarrollo a través de GitHub. Además, se mejoraron el motor de búsqueda y las herramientas de supervisión del portal, incluyendo el seguimiento de la reutilización externa a través de referencias de GitHub y análisis enriquecidos a través de cuadros de mando interactivos.

La implicación del sector infomediario ha sido clave a la hora de reforzar el liderazgo de España en datos abiertos. El informe destaca la importancia de actividades como el Encuentro Nacional de Datos Abiertos, con retos que se trabajan conjuntamente por parte de un equipo multidisciplinar con representantes de instituciones públicas, privadas y académicas, edición tras edición. A ello hay que sumar que la Federación Española de Municipios y Provincias identificó 80 conjuntos de datos esenciales en los que los gobiernos locales deben poner el foco a la hora de avanzar en la apertura de información, fomentando la coherencia y reutilización a nivel municipal.

La siguiente imagen muestra la puntuación específica de cada una de las subdimensiones analizadas:

Figura 3. Puntuación de España en las distintas dimensiones y subcategorías.

Puedes ver el detalle del informe de España en la web del portal europeo.

Próximos pasos y retos comunes

El informe finaliza con una serie de recomendaciones concretas para cada grupo de países. Para el grupo de trendsetters, en el que se encuentra España, las recomendaciones no se centran tanto en alcanzar la madurez —ya lograda—, sino en profundizar y expandir su papel como referentes europeos. Algunas de las recomendaciones son:

- Consolidar ecosistemas temáticos (comunidades de proveedores y reutilizadores) y priorizar los datos de alto valor de forma sistemática.

- Alinear la acción local con la estrategia nacional, habilitando políticas “data-driven”.

- Cooperar con data.europa.eu y otros países para implementar y adaptar un marco de evaluación de impacto con métricas por dominios.

- Desarrollar perfiles de usuario y permitir sus contribuciones al portal nacional.

- Mejorar la calidad de datos y metadatos, y su localización, mediante herramientas de validación, inteligencia artificial y flujos centrados en el usuario.

- Aplicar estándares específicos de dominio para armonizar datasets y maximizar la interoperabilidad, calidad y reutilización.

- Ofrecer formación avanzada y certificada en normativa y alfabetización de datos.

- Colaborar internacionalmente en soluciones reutilizables, como software compartido u open source.

España ya trabaja en muchos de estos puntos para continuar mejorando su oferta de datos abiertos. El objetivo es que cada vez más reutilizadores puedan aprovechar de forma sencilla el potencial de la información pública para generar servicios y soluciones que generen un impacto positivo en toda la sociedad.

La posición alcanzada por España en este ranking europeo es fruto del trabajo de todas las iniciativas públicas, empresas, comunidades de usuarios y reutilizadores ligados a los datos abiertos, que impulsan un ecosistema que no deja de crecer. ¡Gracias por el esfuerzo!

En este pódcast hablamos de los datos de transporte y movilidad, un tema muy presente en nuestro día a día. Cada vez que consultamos una aplicación para saber cuánto tardará un autobús, estamos aprovechando los datos abiertos ligados al transporte. De la misma forma, cuando una administración realiza una planificación urbanística u optimiza flujos de tráfico, hace uso de datos de movilidad.

Para profundizar en los retos y oportunidades que hay detrás de la apertura de este tipo de datos por parte de las administraciones públicas españolas, contamos con dos invitadas de excepción:

- Tania Gullón Muñoz-Repiso, directora de la División de Estudios y Tecnología del Transporte del Ministerio de Transportes y Movilidad Sostenible. ¡Bienvenida, Tania!

- Alicia González Jiménez, subdirectora adjunta en la Subdirección General de Cartografía y Observación del Territorio del Instituto Geográfico Nacional. ¡Bienvenida, Alicia!