La Navidad vuelve cada año como una oportunidad para detenernos, respirar y reconectar con aquello que nos inspira. Desde datos.gob.es, aprovechamos estas fechas para compartir nuestra tradicional carta de recomendaciones: una selección de libros que invitan a comprender mejor el mundo digital, reflexionar sobre el impacto de la inteligencia artificial, mejorar nuestras competencias profesionales y asomarnos a los dilemas éticos que marcan nuestro tiempo.

En este post, recopilamos obras de ética tecnológica, sociedad digital, ingeniería de IA, computación cuántica, aprendizaje automático y gobierno del dato. Una lista variada, con títulos tanto en castellano como en inglés, que combina rigor académico, divulgación y visión crítica. Si buscas una lectura que te haga crecer, sorprender a algún ser querido o simplemente alimentar tu curiosidad, aquí encontrarás opciones para todos los gustos.

La ética de la inteligencia artificial de Sara Degli-Esposti

-

¿De qué va? Esta especialista en privacidad y análisis de datos ofrece una visión clara y rigurosa sobre los riesgos y oportunidades de la IA aplicada a ámbitos como la salud, la seguridad, las políticas públicas o la comunicación digital. Su propuesta destaca por integrar perspectivas jurídicas, sociotécnicas y de derechos fundamentales.

-

¿A quién va dirigido? Lectores que busquen una introducción sólida al debate internacional sobre ética y regulación de la IA.

Disponible gratuitamente aquí: https://ciec.edu.co/wp-content/uploads/2024/12/LA-ETICA-DE-LA-INTELIGENCIA-ARTIFICIAL.pdf

Entiende la tecnología de Nate Gentile

-

¿De qué va? En este libro, el divulgador y especialista en hardware y cultura digital Nate Gentile desmonta mitos, explica conceptos técnicos de forma accesible y ofrece una mirada crítica sobre cómo funciona realmente la tecnología que utilizamos cada día. Desde el rendimiento de los procesadores y las arquitecturas de los sistemas hasta los modelos de negocio de las grandes plataformas, la obra combina rigor técnico con un estilo cercano, acompañado de ejemplos prácticos y anécdotas de la comunidad tecnológica.

-

¿A quién va dirigido? Lectores curiosos que quieran comprender mejor el funcionamiento interno de los dispositivos, profesionales que busquen una aproximación divulgativa pero precisa, y cualquier persona que desee perder el miedo a la tecnología y entenderla de forma más consciente.

Clics contra la humanidad de James Williams

-

¿De qué va? Esta obra periodística analiza cómo las plataformas digitales moldean nuestra atención, nuestras creencias y nuestras decisiones. A través de historias reales, el libro muestra el impacto del diseño algorítmico en la política, la opinión pública y la vida diaria. Una lectura incisiva y oportuna, especialmente en un momento de creciente preocupación por la desinformación y la economía de la atención.

-

¿A quién va dirigido? Quienes quieran entender cómo funcionan las plataformas y qué efectos pueden tener en la sociedad.

La primavera de la inteligencia artificial de Carmen Torrijos y José Carlos Sánchez

- ¿De qué va? A partir de ejemplos cotidianos, los autores explican qué son realmente los modelos de lenguaje, cómo funcionan tecnologías como ChatGPT o la visión por computador, qué transformaciones están generando en sectores como la educación, la creatividad o la comunicación, y cuáles son sus límites actuales. Además, aportan una reflexión crítica sobre los retos éticos, sociales y laborales asociados a esta nueva ola de innovación.

- ¿A quién va dirigido? Lectores que quieran comprender el fenómeno actual de la IA sin necesidad de conocimientos técnicos, docentes y profesionales que buscan contextualizar su impacto en su sector, y cualquier persona interesada en entender qué hay detrás del boom de la IA generativa y cómo puede influir en nuestro futuro inmediato.

Diseño de sistemas de Machine Learning de Chip Huyen

-

¿De qué va? Es un manual práctico y moderno que explica, de principio a fin, cómo diseñar, desplegar y mantener sistemas de machine learning robustos. Chip Huyen combina experiencia técnica con claridad divulgativa, abordando desde ingeniería de datos hasta monitorización de modelos y MLOps. Una obra muy valorada en la industria.

-

¿A quién va dirigido? Profesionales técnicos, equipos que implantan productos basados en IA y estudiantes que quieran entender cómo se construyen sistemas reales en producción.

Ética en la Inteligencia Artificial y las Tecnologías de la Información de Gabriela Arriagada-Bruneau, Claudia López y Marcelo Mendoza

-

¿De qué va? Este libro aborda uno de los grandes desafíos de nuestro tiempo: cómo desarrollar sistemas de IA respetuosos con las personas y con la sociedad. Las autoras analizan principios de equidad, transparencia, responsabilidad y gobernanza, combinando fundamentos filosóficos con ejemplos prácticos. Su enfoque iberoamericano resulta especialmente valioso para comprender cómo estos retos afectan a esta región.

-

¿A quién va dirigido? Estudiantes, responsables públicos, profesionales de la tecnología y cualquier persona que quiera entender los dilemas éticos detrás de los algoritmos que utilizamos a diario.

Generative Deep Learning: Teaching Machines to Paint, Write, Compose, and Play de David Foster

-

¿De qué va? Esta obra, que ya es un clásico en su terreno, introduce las arquitecturas generativas más importantes (GANs, VAEs, modelos de difusión) con ejemplos y código reproducible. La segunda edición actualiza conceptos y aporta nuevos casos prácticos relacionados con texto, sonido e imagen.

-

¿A quién va dirigido? Quienes quieran aprender a crear modelos generativos desde cero o entender las tecnologías que están detrás de la creación automática de contenido.

Supremacía cuántica de Michio Kaku

-

¿De qué va? La computación cuántica ha dejado de ser ciencia ficción para convertirse en un campo estratégico global. Michio Kaku, divulgador reconocido, explica con claridad qué es un qubit, cómo funcionan los ordenadores cuánticos, qué límites presentan y qué transformaciones impulsarán en criptografía, simulación química o inteligencia artificial.

-

¿A quién va dirigido? Ideal para amantes de la ciencia, curiosos tecnológicos y lectores que quieran asomarse al futuro de la computación sin necesidad de conocimientos matemáticos avanzados.

Gobierno del Dato basado en especificaciones UNE de Ismael Caballero, Fernando Gualo y Mario G. Piattini

-

¿De qué va? Este libro es una guía completa para entender y aplicar las normas UNE relativas al gobierno del dato en las organizaciones. Explica de forma clara cómo estructurar roles, procesos, políticas y controles para gestionar los datos como un activo estratégico. Incluye casos prácticos, modelos de madurez, ejemplos de implantación y orientaciones para alinear la gobernanza con estándares internacionales y con las necesidades reales del sector público y privado. Un recurso especialmente útil en un momento en el que la calidad, la trazabilidad y la interoperabilidad de los datos son fundamentales para impulsar la transformación digital.

-

¿A quién va dirigido? Responsables de datos (CDO), equipos de analítica y arquitectura, profesionales de administraciones públicas, consultores y cualquier organización que quiera implantar un modelo formal de gobierno del dato basado en estándares reconocidos.

Aunque nos encantaría incluir muchos más títulos, esta selección ya es un excelente punto de partida para explorar los grandes temas que configurarán la transformación digital de los próximos años. Si en estas fiestas te apetece regalar conocimiento, estas obras serán un acierto seguro: combinan actualidad, reflexión crítica, aplicaciones prácticas y una mirada amplia al futuro tecnológico.

Recuerda que, aunque aquí mencionamos títulos que puedes encontrar en librerías online, siempre te animamos a consultar primero en tu librería de barrio. Es una forma magnífica de apoyar al pequeño comercio y contribuir a que el ecosistema cultural siga vivo y vibrante.

¿Nos recomiendas otro título?

En datos.gob.es nos encanta descubrir nuevas lecturas. Si conoces algún libro sobre datos, IA, tecnología o sociedad digital que merezca estar en próximas ediciones, puedes compartirlo en los comentarios o escribirnos a través de este formulario. ¡Felices fiestas y felices lecturas!

La visualización de datos es una práctica fundamental para democratizar el acceso a la información pública. Sin embargo, crear gráficos efectivos va mucho más allá de elegir colores atractivos o utilizar las últimas herramientas tecnológicas. Como señala Alberto Cairo, experto en visualización de datos y docente de la academia del portal europeo de datos abiertos (data.europa.eu), “cada decisión de diseño debe ser deliberada: inevitablemente subjetiva, pero nunca arbitraria”. A través de una serie de tres webinar que puedes volver a ver aquí, el experto ofreció consejos innovadores para estar a la vanguardia de la visualización de datos.

Cuando trabajamos con visualización de datos, especialmente en el contexto de la información pública, es crucial desmontar algunos mitos arraigados en nuestra cultura profesional. Frases como "los datos hablan por sí mismos", "una imagen vale más que mil palabras" o "muestra, no cuentes" suenan bien, pero esconden una verdad incómoda: los gráficos no siempre comunican automáticamente.

La realidad es más compleja. Un/a profesional del diseño puede querer comunicar algo específico, pero los lectores pueden interpretar algo completamente diferente. ¿Cómo se puede superar la brecha entre intención y percepción en visualización de datos? En este post, ofrecemos algunas claves de la serie formativa.

Un marco estructurado para diseñar con propósito

En lugar de seguir "reglas" rígidas o aplicar plantillas predefinidas, en el curso se propone un marco de pensamiento basado en cinco componentes interrelacionados:

- Contenido: la naturaleza, origen y limitaciones de los datos

- Personas: la audiencia a la que nos dirigimos

- Intención: los propósitos que definimos

- Restricciones: las limitaciones que enfrentamos

- Resultados: cómo es recibido el gráfico

Este enfoque holístico nos obliga a preguntarnos constantemente: ¿qué necesitan realmente saber nuestros lectores? Por ejemplo, cuando comunicamos información sobre riesgos de huracanes o emergencias sanitarias, ¿es más importante mostrar trayectorias exactas o comunicar impactos potenciales? La respuesta correcta depende del contexto y, sobre todo, de las necesidades informativas de la ciudadanía.

El peligro de la agregación excesiva

Aún sin perder de vista el propósito es importante no caer en añadir demasiada información o presentar solo promedios. Imaginemos, por ejemplo, un conjunto de datos sobre seguridad ciudadana a nivel nacional: un promedio puede esconder que la mayoría de las localidades son muy seguras, mientras unas pocas con tasas extremadamente altas distorsionan el indicador nacional.

Como explica Claus O. Wilke en su libro "Fundamentals of Data Visualization", esta práctica puede ocultar patrones cruciales, valores atípicos y paradojas que son precisamente los más relevantes para la toma de decisiones. Para evitar este riesgo, en la formación se propone visualizar una gráfica como un sistema de capas que debemos construir cuidadosamente desde la base:

1. Codificación (Encoding)

- Es la base de todo: cómo traducimos datos en atributos visuales. Las investigaciones en percepción visual nos muestran que no todos los "canales visuales" son igual de efectivos. La jerarquía sería:

- Más efectivos: posición, longitud y altura

- Medianamente efectivos: ángulo, área y pendiente

- Menos efectivos: color, saturación y forma

¿Cómo ponemos esto en práctica? Pues, por ejemplo, para realizar comparaciones precisas, un gráfico de barras será casi siempre mejor opción que un gráfico circular. Sin embargo, como se matiza en los materiales formativos, "efectivo" no siempre significa "apropiado". Un gráfico circular puede ser perfecto cuando queremos expresar la idea de un "todo y sus partes", aunque las comparaciones precisas sean más difíciles.

2. Disposición (Arrangement)

El posicionamiento, orden y agrupación de los elementos afecta profundamente a la percepción. ¿Queremos que el lector compare entre categorías dentro de un grupo, o entre grupos? La respuesta determinará si organizamos nuestra visualización con barras agrupadas o apiladas, con paneles múltiples o en una única vista integrada.

3. Andamiaje (Scaffolding)

Los títulos, introducciones, anotaciones, escalas y leyendas son fundamentales. En datos.gob.es hemos visto cómo las visualizaciones interactivas pueden condensar información compleja, pero sin un andamiaje adecuado, la interactividad puede confundir más que aclarar.

El valor de una correcta escala

Uno de los aspectos técnicos más delicados —y a menudo más manipulables— de una visualización es la elección de la escala. Una simple modificación en el eje Y puede cambiar por completo la interpretación del lector: una tendencia suave puede parecer una crisis repentina, o un crecimiento sostenido puede pasar desapercibido.

Como se menciona en el segundo webinar de la serie, las escalas no son un detalle menor: son un componente narrativo. Decidir dónde empieza un eje, qué intervalos se usan o cómo se representan los periodos de tiempo implica hacer elecciones que afectan directamente la percepción de la realidad. Por ejemplo, si una gráfica de empleo comienza el eje Y en 90 % en lugar de 0 %, el descenso puede parecer dramático, aunque, en realidad, sea mínimo.

Por eso, las escalas deben ser honestas con los datos. Ser “honesto” no significa renunciar a decisiones de diseño, sino mostrar claramente qué decisiones se tomaron y por qué. Si existe una razón válida para empezar el eje Y en un valor distinto de cero, debe explicarse explícitamente en la gráfica o en su pie de texto. La transparencia debe prevalecer sobre el dramatismo.

La integridad visual no solo protege al lector de interpretaciones engañosas, sino que refuerza la credibilidad de quien comunica. En el ámbito de los datos públicos, esa honestidad no es opcional: es un compromiso ético con la verdad y con la confianza ciudadana.

Accesibilidad: visualizar para todos

Por otro lado, uno de los aspectos frecuentemente olvidado es la accesibilidad. Aproximadamente el 8 % de los hombres y el 0,5 % de las mujeres tienen algún tipo de daltonismo. Herramientas como Color Oracle permiten simular cómo se ven nuestras visualizaciones para personas con diferentes tipos de deficiencias en la percepción del color.

Además, en el webinar se mencionó el proyecto Chartability, una metodología para evaluar la accesibilidad de las visualizaciones de datos. En el sector público español, donde la accesibilidad web es un requisito legal, esto no es opcional: es una obligación democrática. Bajo esta premisa publicó la Federación Española de Municipios y Provincias publicó una Guía de Visualización de Datos para Entidades Locales.

Narrativa visual: cuando los datos cuentan historias

Una vez resueltas las cuestiones técnicas, podemos abordar el aspecto narrativo que cada día es más importante para comunicar correctamente. En este sentido, el curso plantea un método sencillo pero poderoso:

- Escribe una frase larga que resuma los puntos que quieres comunicar.

- Divide esa frase en componentes, aprovechando las pausas naturales.

- Transforma esos componentes en secciones de tu infografía.

Este enfoque narrativo es especialmente efectivo para proyectos como los que encontramos en data.europa.eu, donde se combinan visualizaciones con explicaciones contextuales para comunicar el valor de los conjuntos de datos de alto valor o en los ejercicios de visualización y ciencia de datos de datos de datos.gob.es.

El futuro de la visualización de datos también incluye aproximaciones más creativas y centradas en el usuario. Proyectos que incorporan elementos personalizados, que permiten a los lectores situarse en el centro de la información, o que utilizan técnicas narrativas para generar empatía, están redefiniendo lo que entendemos por "comunicación de datos".

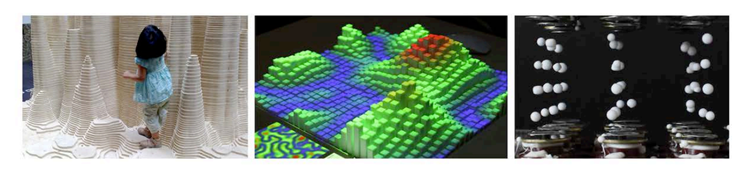

Incluso emergen formas alternativas de "sensificación de datos": la fisicalización (crear objetos tridimensionales con datos) y la sonificación (traducir datos a sonido) abren nuevas posibilidades para hacer la información más tangible y accesible. La empresa española Tangible Data, de la que nos hacemos eco en datos.gob.es porque reutiliza conjuntos de datos abiertos, es prueba de ello.

Figura 1. Ejemplos de sensificación de datos. Fuente: https://data.europa.eu/sites/default/files/course/webinar-data-visualisation-episode-3-slides.pdf

A modo de conclusión, podemos resaltar que la integridad en el diseño no es un lujo: es un requisito ético. Cada gráfico que publicamos en plataformas oficiales influye en cómo los ciudadanos perciben la realidad y toman decisiones. Por eso, dominar herramientas técnicas como las bibliotecas y API de visualización, que se analizan en otros artículos del portal, es tan relevante.

La próxima vez que crees una visualización con datos abiertos, no te preguntes solo "¿qué herramienta uso?" o "¿qué gráfico se ve mejor?". Pregúntate: ¿qué necesita realmente saber mi audiencia? ¿Esta visualización respeta la integridad de los datos? ¿Es accesible para todos? Las respuestas a estas preguntas son las que transforman un gráfico bonito en una herramienta de comunicación verdaderamente efectiva.

La educación tiene el poder de transformar vidas. Reconocida como un derecho fundamental por la comunidad internacional, constituye un pilar clave para el desarrollo humano y social. Sin embargo, según datos de la UNESCO, 272 millones de niños y jóvenes siguen sin acceso a la escuela, el 70% de los países destina menos del 4% de su PIB a la educación y aún son necesarios 69 millones de docentes más para lograr la educación primaria y secundaria universal en 2030. Ante este desafío global, los recursos educativos abiertos y las iniciativas de acceso libre se presentan como herramientas decisivas para fortalecer los sistemas de enseñanza, reducir desigualdades y avanzar hacia una educación inclusiva, equitativa y de calidad.

Los recursos educativos abiertos (REA) ofrecen tres beneficios principales: aprovechan las posibilidades de las tecnologías digitales para solucionar retos educativos comunes; actúan como catalizadores de innovación pedagógica y social al transformar la relación entre docentes, estudiantes y conocimiento; y contribuyen a mejorar el acceso equitativo a materiales educativos de alta calidad.

Qué son los recursos educativos abiertos (REA)

Según la UNESCO, los recursos educativos abiertos son "materiales de aprendizaje, enseñanza e investigación en cualquier formato y soporte que existen en el dominio público o están bajo derechos de autor y fueron liberados bajo una licencia abierta". El concepto, acuñado en el foro celebrado en París en el año 2002, tiene como característica fundamental que estos recursos permiten "su acceso sin coste, su reutilización, reorientación, adaptación y redistribución por parte de terceros".

Los REA abarcan una amplia variedad de formatos, desde cursos completos, libros de texto y programas curriculares hasta mapas, vídeos, pódcasts, aplicaciones multimedia, herramientas de evaluación, aplicaciones móviles, bases de datos e incluso simulaciones.

Los recursos educativos abiertos están constituidos por tres elementos que funcionan de manera inseparable:

- Contenidos educativos: incluyen todo tipo de material utilizable en el proceso de enseñanza-aprendizaje, desde objetos formales hasta recursos externos y sociales. Es aquí donde entrarían los datos abiertos, los cuales se pueden aprovechar para generar este tipo de recursos.

- Herramientas tecnológicas: software que permite desarrollar, utilizar, modificar y distribuir el contenido, incluyendo aplicaciones para la creación de contenidos y plataformas para comunidades de aprendizaje.

- Licencias abiertas: elemento diferenciador que respeta la propiedad intelectual mientras proporciona permisos para el uso, adaptación y redistribución de los materiales.

Por tanto, los REA se caracterizan principalmente por su accesibilidad universal, eliminando barreras económicas y geográficas que tradicionalmente limitan el acceso a la educación de calidad.

Innovación educativa y transformación pedagógica

La transformación pedagógica constituye uno de los principales impactos de los recursos educativos abiertos en el panorama educativo actual. Los REA no son simples contenidos digitales gratuitos, sino catalizadores de innovación que están redefiniendo los procesos de enseñanza-aprendizaje a nivel global.

Combinados con metodologías pedagógicas adecuadas y objetivos de aprendizaje bien diseñados, los REA ofrecen nuevas opciones de enseñanza innovadoras para lograr que tanto los docentes como los estudiantes asuman un papel más activo en el proceso educativo e incluso en la creación de contenidos. Fomentan competencias esenciales como el pensamiento crítico, la autonomía y la capacidad de “aprender a aprender”, superando los modelos tradicionales basados en la memorización.

La innovación educativa impulsada por los REA se materializa a través de herramientas tecnológicas abiertas que facilitan su creación, adaptación y distribución. Programas como eXeLearning permiten desarrollar contenidos educativos digitales de manera sencilla, mientras que LibreOffice e Inkscape ofrecen alternativas libres para la producción de materiales.

La interoperabilidad lograda mediante estándares abiertos, como IMS Global o SCORM, garantiza que estos recursos puedan integrarse en diferentes plataformas y, por tanto, la accesibilidad para todos los usuarios, incluidas personas con discapacidades.

Otra innovación prometedora para el futuro de los REA es la combinación de tecnologías descentralizadas como Nostr con herramientas de autoría como LiaScript. Este enfoque resuelve la dependencia de servidores centrales, permitiendo crear un curso completo y distribuirlo a través de una red abierta y resistente a la censura. El resultado es un único y permanente enlace (URI de Nostr) que encapsula todo el material, otorgando al creador la soberanía total sobre su contenido y garantizando su perdurabilidad. En la práctica, esto supone una revolución para el acceso universal al conocimiento. Los educadores comparten su trabajo con la seguridad de que el enlace será siempre válido, mientras que los estudiantes acceden al material de forma directa, sin necesidad de plataformas o intermediarios. Esta sinergia tecnológica es un paso fundamental para materializar la promesa de un ecosistema educativo verdaderamente abierto, resiliente y global, donde el conocimiento fluye sin barreras.

El potencial de los Recursos Educativos Abiertos se concreta gracias a las comunidades y proyectos que los desarrollan y difunden. Iniciativas institucionales, repositorios colaborativos y programas promovidos por organismos públicos y docentes aseguran que los REA sean accesibles, reutilizables y sostenibles.

Colaboración y comunidades de aprendizaje abiertas

La dimensión colaborativa representa uno de los pilares fundamentales que sostienen el movimiento de recursos educativos abiertos. Este enfoque trasciende fronteras y conecta a profesionales de la educación a nivel global.

Las comunidades educativas alrededor de los REA han generado espacios donde docentes comparten experiencias, acuerdan aspectos metodológicos y resuelven dudas sobre la aplicación práctica de estos recursos. La coordinación entre profesionales suele producirse en redes sociales o a través de canales digitales como Telegram, en los que participan tanto usuarios como creadores de contenidos. Este "claustro virtual" facilita la implementación efectiva de metodologías activas en el aula.

Más allá de los espacios surgidos por iniciativa de los propios docentes, distintos organismos e instituciones han promovido proyectos colaborativos y plataformas que facilitan la creación, el acceso y el intercambio de Recursos Educativos Abiertos, ampliando así su alcance e impacto en la comunidad educativa.

Proyectos y repositorios de REA en España

En el caso de España, los Recursos Educativos Abiertos cuentan con un ecosistema consolidado de iniciativas que reflejan la colaboración entre administraciones públicas, centros educativos, comunidades docentes y entidades culturales. Plataformas como Procomún, proyectos de creación de contenidos como EDIA (Educativo, Digital, Innovador y Abierto) o CREA (Creación de Recursos Educativos Abiertos), y repositorios digitales como Hispana muestran la diversidad de enfoques adoptados para poner a disposición de la ciudadanía recursos educativos y culturales en abierto. A continuación, te contamos un poco más sobre ellos:

- El Proyecto EDIA (Educativo, Digital, Innovador y Abierto), desarrollado por el Centro Nacional de Desarrollo Curricular en Sistemas no Propietarios (CEDEC), se centra en la creación de recursos educativos abiertos diseñados para integrarse en entornos que fomentan las competencias digitales y que se adaptan a metodologías activas. Los recursos se crean con eXeLearning, que facilita la edición, e incluyen plantillas, guías, rúbricas y todos los documentos necesarios para llevar al aula la propuesta didáctica.

- La red Procomún nació fruto del Plan de Cultura Digital en la Escuela puesto en marcha en 2012 por el Ministerio de Educación, Cultura y Deporte. Actualmente este repositorio cuenta con más de 74.000 recursos y 300 itinerarios de aprendizaje, junto a un banco multimedia de 100.000 activos digitales bajo la licencia Creative Commons y que, por tanto, se pueden reutilizar para crear nuevos materiales. Dispone, además, de una aplicación móvil. Procomún también utiliza eXeLearning y el estándar LOM-ES, lo que asegura una descripción homogénea de los recursos y facilita su búsqueda y clasificación. Además, es una web semántica, lo que supone que puede conectarse con comunidades existentes a través de la Linked Open Data Cloud.

Desde las comunidades autónomas también se ha promovido la creación de recursos educativos abiertos. Un ejemplo es CREA, un programa de la Junta de Extremadura orientado a la producción colaborativa de recursos educativos abiertos. Su plataforma permite al profesorado crear, adaptar y compartir materiales didácticos estructurados, integrando contenidos curriculares con metodologías activas. Los recursos se generan en formatos interoperables y se acompañan de metadatos que facilitan su búsqueda, reutilización e integración en distintas plataformas.

Existen iniciativas similares, como el proyecto REA-DUA en Andalucía, que aglutina más de 250 recursos educativos para primaria, secundaria y bachillerato, con atención a la diversidad. Por su parte, Galicia puso en marcha el curso 2022-23 cREAgal cuyo portal cuenta en la actualidad con más de 100 recursos de educación primaria y secundaria. Este proyecto incide en la inclusión y promueve la autonomía personal del alumnado. Además, desde algunas consejerías de educación se ponen a disposición recursos educativos abiertos, como es el caso de Canarias.

Hispana, el portal de acceso al patrimonio cultural español

Además de estas iniciativas orientadas a la creación de recursos educativos, han surgido otras que promueven la recopilación de contenidos que no fueron creados con un fin educativo pero que pueden ser utilizados en el aula. Es el caso de Hispana, un portal de agregación de fondos digitales de bibliotecas, archivos y museos españoles.

Para proporcionar acceso al patrimonio cultural y científico español, Hispana recolecta y hace accesibles los metadatos de los objetos digitales, permitiendo visualizar dichos objetos a través de enlaces que dirigen a las páginas de las instituciones propietarias. Además de actuar como recolector, Hispana también agrega el contenido de las instituciones que lo deseen a Europeana, la biblioteca digital europea, lo que permite aumentar la visibilidad y reutilización de los recursos.

Hispana es un repositorio OAI-PMH, lo que significa que utiliza el protocolo Open Archives Initiative – Protocol for Metadata Harvesting, un estándar internacional para la recolección e intercambio de metadatos entre repositorios digitales. Así, Hispana recolecta los metadatos de los archivos, museos y bibliotecas españoles que exponen sus fondos con este protocolo y los envía a Europeana.

Iniciativas internacionales y cooperación global

A nivel global es importante destacar el papel de la Unesco a través de la Coalición Dinámica sobre los REA, que busca coordinar esfuerzos para aumentar la disponibilidad, calidad y sostenibilidad de estos activos.

En Europa, ENCORE+ (European Network for Catalysing Open Resources in Education) busca fortalecer el ecosistema europeo de REA. Entre sus objetivos se encuentra crear una red que conecte universidades, empresas y organismos públicos para impulsar la adopción, reutilización y calidad de los REA en Europa. ENCORE+ promueve, además, la interoperabilidad entre plataformas, la estandarización de metadatos y la cooperación para garantizar la calidad de los recursos.

En Europa se han desarrollado otras iniciativas interesantes como EPALE (Electronic Platform for Adult Learning in Europe), una iniciativa de la Comisión Europea dirigida a los especialistas en educación para personas adultas. La plataforma contiene estudios, informes y materiales formativos, muchos de ellos bajo licencias abiertas, lo que contribuye a la difusión y uso de los REA.

Además, existen numerosos proyectos que generan y ponen a disposición recursos educativos abiertos en todo el mundo. En Estados Unidos, OER Commons funciona como un repositorio global de materiales educativos de diferentes niveles y materias. Este proyecto utiliza Open Author, un editor en línea que facilita que docentes sin conocimientos técnicos avanzados creen y personalicen recursos educativos digitales directamente en la plataforma.

Otro proyecto destacado es el Plan Ceibal, un programa público en Uruguay que representa un modelo de inclusión tecnológica para la igualdad de oportunidades. Además de proveer acceso a tecnología, genera y distribuye REA en formatos interoperables, compatibles con estándares como SCORM y metadatos estructurados que facilitan su búsqueda, integración en plataformas de aprendizaje y reutilización por parte del profesorado.

Junto a iniciativas como estas, existen otras que, aunque no producen recursos educativos abiertos de manera directa, sí fomentan su creación y uso mediante la colaboración entre docentes y estudiantes de diferentes países. Es el caso de proyectos como eTwinning y Global Classroom.

La fortaleza de los REA radica en su contribución a la democratización del conocimiento, su naturaleza colaborativa y su capacidad para impulsar metodologías innovadoras. Al derribar barreras geográficas, económicas y sociales, los recursos educativos abiertos hacen que el derecho a la educación esté un poco más cerca de convertirse en una realidad universal.

El sector de los datos abiertos es muy activo. Para estar al día de todo lo que ocurre, desde datos.gob.es publicamos una recopilación de novedades como el desarrollo de nuevas aplicaciones tecnológicas, avances legislativos u otras noticias relacionadas.

Hace seis meses, ya hicimos la última recopilación del año 2024. En esta ocasión, vamos a resumir algunas innovaciones, mejoras y logros del primer semestre de 2025.

Marco normativo: nuevas regulaciones que transforman el panorama

Una de las novedades más significativas es la publicación del Reglamento relativo al Espacio Europeo de Datos de Salud por parte del Parlamento Europeo y el Consejo. Esta normativa establece un marco común para el intercambio seguro de datos sanitarios entre los estados miembro, facilitando tanto la investigación médica como la prestación de servicios sanitarios transfronterizos. Además, este hito representa un cambio paradigmático en la gestión de datos sensibles, demostrando que es posible conciliar la privacidad y protección de datos con la necesidad de compartir información para el bien común. Las implicaciones para el sistema sanitario español son considerables, ya que permitirá una mayor interoperabilidad con otros países europeos y facilitará el desarrollo de proyectos de investigación colaborativos.

Por otro lado, la entrada en vigor de la Ley Europea de IA establece normas claras para el desarrollo de esta tecnología, garantizando la seguridad, transparencia y respeto de los derechos humanos. Este tipo de normativas son especialmente relevantes en el contexto de datos abiertos, donde la transparencia algorítmica y la explicabilidad de los modelos de IA se convierten en requisitos esenciales.

En España, el compromiso con la transparencia se materializa en iniciativas como el nuevo Observatorio de Derechos Digitales, que cuenta con la participación de más de 150 entidades y 360 personas expertas. Esta plataforma se configura como un espacio de diálogo y seguimiento de las políticas digitales, contribuyendo a garantizar que la transformación digital respete los derechos fundamentales.

Innovaciones tecnológicas en España y el extranjero

Uno de los hitos más destacados en el ámbito tecnológico es el lanzamiento de ALIA, la infraestructura pública de recursos de inteligencia artificial. Esta iniciativa busca desarrollar modelos de lenguaje abiertos y transparentes que fomenten el uso del castellano y las lenguas cooficiales españolas en el ámbito de la IA.

ALIA no es solo una respuesta a la hegemonía de los modelos anglosajones, sino una apuesta estratégica por la soberanía tecnológica y la diversidad lingüística. Los primeros modelos ya disponibles han sido entrenados en español, catalán, gallego, valenciano y euskera, marcando un precedente importante en el desarrollo de tecnologías inclusivas y culturalmente sensibles.

Con relación a esta innovación, las aplicaciones prácticas de la inteligencia artificial se están multiplicando en diversos sectores. Por ejemplo, en el ámbito financiero, la Agencia Tributaria ha adoptado un compromiso ético en el diseño y uso de la inteligencia artificial. En este marco, la comunidad ha desarrollado incluso un chatbot virtual entrenado con datos propios que ofrece orientación legal en temas fiscales y tributarios.

En el sector sanitario, un grupo de radiólogos españoles está trabajando en un proyecto para la detección precoz de lesiones oncológicas utilizando IA, demostrando cómo la combinación de datos abiertos y algoritmos avanzados puede tener un impacto directo en la salud pública.

También combinando IA con datos abiertos se han desarrollado proyectos relacionados con la sostenibilidad medioambiental. Este modelo desarrollado en España combina IA y datos meteorológicos abiertos para predecir la producción de energía solar en los próximos 30 años, proporcionando información crucial para la planificación energética nacional.

Otro sector relevante en lo que respecta a la innovación tecnológica es el de las smart cities. En estos últimos meses, Las Palmas de Gran Canaria ha digitalizado sus mercados municipales combinando redes WiFi, dispositivos IoT, un gemelo digital y plataformas de datos abiertos. Esta iniciativa integral busca mejorar la experiencia del usuario y optimizar la gestión comercial, demostrando cómo la convergencia tecnológica puede transformar espacios urbanos tradicionales.

Zaragoza, por su parte, ha desarrollado un mapa de vulnerabilidad utilizando inteligencia artificial aplicada a datos abiertos, proporcionando una herramienta valiosa para la planificación urbana y las políticas sociales.

Otro caso relevante es el proyecto de la Iniciativa Open Data Barcelona, #iCuida, que destaca como un ejemplo innovador de reutilización de datos abiertos para mejorar la vida de las cuidadoras y trabajadoras del hogar. Esta aplicación demuestra cómo los datos abiertos pueden dirigirse a colectivos específicos y generar impacto social directo.

Por último, pero no menos importante, a nivel global, este semestre DeepSeek ha lanzado DeepSeek-R1, una nueva familia de modelos generativos especializados en razonamiento, publicando tanto los modelos como su metodología de entrenamiento completa en código abierto, contribuyendo al avance democrático de la IA.

Nuevos portales de datos abiertos y herramientas de mejora

En toda esta vorágine de innovación y tecnología, el panorama de los portales de datos abiertos se ha enriquecido con nuevas iniciativas sectoriales. El Colegio de Registradores Mercantiles y de la Propiedad de España ha presentado su plataforma de datos abiertos, permitiendo acceso inmediato a datos registrales sin esperar informes periódicos. Esta iniciativa representa un cambio significativo en la transparencia del sector registral.

En el ámbito sanitario, el portal 'I+Salud' del sistema sanitario público de Andalucía recoge y difunde desde un sitio único los recursos y datos sobre actividades y resultados de investigación, facilitando el acceso a información científica relevante.

Además de la disponibilidad de datos, hay un tratamiento que los hace más accesibles al público general: la visualización de datos. La Universidad de Granada ha desarrollado 'UGR en cifras', un espacio de acceso libre con sección de datos abiertos que facilita la exploración de estadísticas oficiales y se erige como pieza fundamental en la transparencia universitaria.

Por otro lado, IDENA, la nueva herramienta del Geoportal de Navarra, incorpora funcionalidades avanzadas para buscar, navegar, incorporar mapas, compartir datos y descargar información geográfica, siendo operativa en cualquier dispositivo.

Formación para el futuro: eventos y jornadas

El ecosistema formativo en este ecosistema se fortalece cada año con eventos como la Cumbre de Gestión del Dato (Data Management Summit) en Tenerife, que aborda la interoperabilidad en administraciones públicas y la inteligencia artificial. Otro evento de referencia en los datos abiertos que también se celebró en Canarias fue el Encuentro Nacional de Datos Abiertos.

Más allá de estos eventos, la innovación colaborativa también ha fomentado a través de hackathones especializados, como el dedicado a soluciones de IA generativa para la biodiversidad o el Merkle Datathon en Gijón. Estos eventos no solo generan soluciones innovadoras, sino que también crean comunidades de práctica y fomentan el talento emergente.

Un año más, los concursos de datos abiertos de Castilla y León y Euskadi han premiado proyectos que demuestran el potencial transformador de la reutilización de datos abiertos, inspirando nuevas iniciativas y aplicaciones.

Perspectiva internacional y tendencias globales: la cuarta ola de datos abiertos

Open Data Policy Lab habló en los EU Open Data Days de lo que se conoce como la "cuarta ola" de datos abiertos, estrechamente vinculada a la IA generativa. Esta evolución representa un salto cualitativo en la forma de procesar, analizar y utilizar los datos públicos, donde los modelos de lenguaje natural permiten interacciones más intuitivas y análisis más sofisticados.

En general, el panorama de datos abiertos en 2025 revela una transformación profunda del ecosistema, donde la convergencia entre inteligencia artificial, marcos normativos avanzados y aplicaciones especializadas está redefiniendo las posibilidades de la transparencia y la innovación pública.

La inteligencia artificial ya no es cosa del futuro: está aquí y puede convertirse en una aliada en nuestro día a día. Desde facilitarnos tareas en el trabajo, como redactar correos o resumir documentos, hasta ayudarnos a organizar un viaje, aprender un nuevo idioma o planificar nuestros menús semanales, la IA se adapta a nuestras rutinas para hacernos la vida más fácil. No hace falta ser un experto en tecnología para sacarle partido; si bien las herramientas actuales son muy accesibles, comprender sus capacidades y saber cómo formular las preguntas adecuadas maximizará su utilidad.

Sujetos pasivos y activos de la IA

Las aplicaciones de la inteligencia artificial en el día a día están transformando nuestra vida cotidiana. La IA abarca ya múltiples campos de nuestras rutinas. Los asistentes virtuales, como Siri o Alexa, se encuentran entre las herramientas más conocidas que incorporan inteligencia artificial, y se utilizan para responder preguntas, programar citas o controlar dispositivos.

Muchas personas usan a diario herramientas o aplicaciones con inteligencia artificial, aunque esta opere de forma imperceptible para al usuario y no requiera su intervención. Google Maps, por ejemplo, utiliza IA para optimizar rutas en tiempo real, predecir el estado del tráfico, sugerir caminos alternativos o estimar la hora de llegada. Spotify la aplica para personalizar las listas de reproducción o sugerir canciones, y Netflix para realizar recomendaciones y adaptar el contenido que se muestra a cada usuario.

Pero también es posible ser un usuario activo de la inteligencia artificial utilizando herramientas que interactúan directamente con los modelos. Así, podemos hacer preguntas, generar textos, resumir documentos o planificar tareas. La IA deja de ser un mecanismo oculto para convertirse en una especie de copiloto digital que nos asiste en nuestro día a día. ChatGPT, Copilot o Gemini son herramientas que nos permiten usar la IA sin necesidad de ser expertos. Esto nos facilita la automatización de tareas cotidianas, liberando tiempo para dedicarlo a otras actividades.

IA en el hogar y la vida personal

Los asistentes virtuales responden a comandos de voz y nos informan de qué hora es, el tiempo que va a hacer o nos ponen la música que queremos escuchar. Pero sus posibilidades van mucho más allá, ya que son capaces de aprender de nuestros hábitos para anticiparse a nuestras necesidades. Pueden controlar diferentes dispositivos que tenemos en el hogar de manera centralizada, como la calefacción, el aire acondicionado, las luces o los dispositivos de seguridad. También es posible configurar acciones personalizadas que se activen a través de un comando de voz. Por ejemplo, una rutina “buenos días” que encienda las luces, nos informe del pronóstico del tiempo y del estado del tráfico.

Cuando hemos perdido el manual de alguno de los electrodomésticos o aparatos electrónicos que tenemos en casa, la inteligencia artificial es una buena aliada. Enviando una foto del dispositivo, nos ayudará a interpretar las instrucciones, configurarlo o solucionar problemas básicos.

Si quieres ir más allá, la IA puede hacer por ti algunas tareas de la vida cotidiana. A través de estas herramientas podemos planificar nuestros menús semanales, indicando necesidades o preferencias, como platos aptos para celiacos o vegetarianos, preparar la lista de la compra y obtener las recetas. También nos puede ayudar a elegir entre los platos de la carta de un restaurante teniendo en cuenta nuestras preferencias y restricciones alimentarias, como alergias o intolerancias. A través de una simple foto de la carta, la IA nos ofrecerá sugerencias personalizadas.

El ejercicio físico es otro ámbito de nuestra vida personal en el que estos copilotos digitales son muy valiosos. Podemos pedirle, por ejemplo, que cree rutinas de ejercicios adaptadas a diferentes condiciones físicas, objetivos y material disponible.

La planificación de unas vacaciones es otra de las funcionalidades más interesantes de estos asistentes digitales. Si les proporcionamos un destino, un número de días, intereses e incluso presupuesto, tendremos un plan completo para nuestro próximo viaje.

Aplicaciones de la IA en los estudios

La IA está transformando profundamente la forma de estudiar, ofreciendo herramientas que personalizan el aprendizaje. Ayudar a los más pequeños de la casa en sus tareas escolares, aprender un idioma o adquirir nuevas habilidades para nuestro desarrollo profesional son solo algunas de las posibilidades.

Existen plataformas que generan contenidos personalizados en apenas unos minutos y material didáctico realizado a partir de datos abiertos que se puede utilizar tanto en el aula como en casa para repasar. Entre los universitarios o los estudiantes de secundaria y bachillerato, algunas de las opciones más populares son las aplicaciones que resumen o hacen esquemas a partir de textos más largos. Incluso es posible generar un pódcast desde un fichero, lo que nos puede ayudar a entender y familiarizarnos con un tema mientras hacemos deporte o cocinamos.

Pero también podemos crear nuestras aplicaciones para estudiar o incluso simular exámenes. Sin tener conocimientos de programación, es posible generar una aplicación para aprender las tablas de multiplicar, los verbos irregulares en inglés o lo que se nos ocurra.

Cómo usar la IA en el trabajo y las finanzas personales

En el ámbito profesional la inteligencia artificial ofrece herramientas que aumentan la productividad. De hecho, se estima que en España un 78% de los trabajadores utilizan ya herramientas de IA en el ámbito laboral. Al automatizar procesos, ahorramos tiempo para centrarnos en tareas de más valor. Estos asistentes digitales resumen documentos largos, generan informes especializados en un campo, redactan correos electrónicos o toman notas en las reuniones.

Algunas plataformas incorporan ya la transcripción de las reuniones en tiempo real, algo que puede resultar muy útil si no dominamos el idioma. Microsoft Teams, por ejemplo, ofrece a través de Copilot opciones útiles desde la pestaña “Resumen” de la propia reunión, como la transcripción, un resumen o la posibilidad de agregar notas.

El manejo de las finanzas personales ha evolucionado igualmente gracias a aplicaciones que utilizan IA, permitiendo controlar gastos y gestionar un presupuesto. Pero también podemos crear nuestro propio asesor financiero personal utilizando alguna herramienta de IA, como ChatGPT. Al proporcionarle información sobre ingresos, gastos fijos, variables y objetivos de ahorro, analiza los datos y crea planes financieros personalizados.

Prompts y creación de aplicaciones útiles para el día a día

Hemos visto las grandes posibilidades que nos brinda la inteligencia artificial como copiloto en nuestro día a día. Pero para lograr que sea un buen asistente digital, debemos saber cómo preguntarle y darle las instrucciones precisas.

Un prompt es una instrucción básica o petición que se realiza a un modelo de IA para guiarlo, con el objetivo de que nos proporcione una respuesta coherente y de calidad. Un buen prompting es la clave para sacar el máximo rendimiento de la IA. Es fundamental preguntar bien y proporcionar la información necesaria.

Para escribir prompts efectivos tenemos que ser claros, específicos y evitar ambigüedades. Debemos indicar cuál es el objetivo, es decir, qué queremos que la IA haga: resumir, traducir, generar una imagen, etc. Igualmente es clave proporcionarle el contexto, explicando a quién se dirige o por qué lo necesitamos, además de cómo esperamos que sea la respuesta. Esto puede incluir el tono del mensaje, el formato, las fuentes que se utilicen para generarla, etc.

A continuación, te dejamos algunos consejos para crear prompts efectivos:

- Utiliza frases cortas, directas y concretas. Cuanto más clara sea la petición, más precisa será la respuesta. Evita expresiones como “por favor” o “gracias”, ya que lo único que hacen es añadir ruido innecesario y consumir más recursos. Por el contrario, utiliza palabras como “debes”, “haz”, “incluye” o “enumera”. Para reforzar la petición puedes usar mayúsculas en esas palabras. Estas expresiones son especialmente útiles para afinar una primera respuesta del modelo que no cumple con tus expectativas.

- Indica el público al que se dirige. Especifica si la respuesta va dirigida a un público experto, inexperto, niños, adolescentes, adultos, etc. Cuando queremos una respuesta sencilla podemos, por ejemplo, pedirle a la IA que nos lo explique como si tuviéramos diez años.

- Usa delimitadores. Separa las instrucciones mediante algún símbolo, como unas barras (//) o comillas para que el modelo comprenda mejor la instrucción. Por ejemplo, si quieres que haga una traducción, usa delimitadores para separar la orden (“Traduce al inglés”) de la frase que debe traducir.

- Indica la función que debe adoptar el modelo. Especifica el rol que debe asumir el modelo para generar la respuesta. Indicarle si debe actuar como un experto en finanzas o en nutrición, por ejemplo, ayudará a generar respuestas más especializadas ya que adaptará tanto el contenido como el tono.

- Divide las peticiones completas en solicitudes sencillas. Si vas a hacer una petición compleja que requiere un prompt excesivamente largo, es recomendable que la desgloses en pasos más sencillos. Si necesitas explicaciones detalladas utiliza expresiones como “Piensa a paso” para que te dé una respuesta más estructurada.

- Usa ejemplos. Incluye en el prompt ejemplos de lo que buscas para guiar al modelo hacia la respuesta.

- Proporciona instrucciones en positivo. En lugar de pedir que no haga o incluya algo, expresa la petición de forma afirmativa. Por ejemplo, en vez de “No uses frases largas”, dile: “Utiliza frases breves y concisas”. Las instrucciones en positivo evitan ambigüedades y facilitan que la IA entienda lo que debe hacer. Esto sucede porque los prompts negativos suponen un esfuerzo extra para el modelo, al tener que deducir cuál es la acción contraria.

- Ofrece propinas o penalizaciones. Esto sirve para reforzar comportamientos deseados y coartar respuesta inadecuadas. Por ejemplo, “Si usas frases vagas o ambiguas, perderás 100 euros”.

- Pide que te pregunte lo que necesite. Si le indicamos que nos pida información adicional, reducimos la posibilidad de las alucinaciones, ya que estamos mejorando el contexto de nuestra petición.

- Solicita que responda como un humano. Si los textos te parecen demasiado artificiales o mecánicos, especifica en el prompt que la respuesta sea más natural o que parezca elaborada por un humano.

- Proporciona el inicio de la respuesta. Este simple truco resulta muy útil para guiar al modelo hacia la respuesta que esperamos.

- Delimita las fuentes que debe utilizar. Si acotamos el tipo de información que debe utilizar para generar la respuesta, obtendremos respuestas más afinadas. Pide, por ejemplo, que utilice solo datos posteriores a un año concreto.

- Solicita que imite un estilo. Podemos proporcionarle un ejemplo para que su respuesta sea coherente con el estilo de la referencia o pedirle que siga el estilo de un autor famoso.

Si bien es posible generar código funcional para tareas y aplicaciones sencillas sin conocimientos de programación, es importante notar que el desarrollo de soluciones más complejas o robustas a nivel profesional sigue requiriendo experiencia en programación y desarrollo de software. Para crear, por ejemplo, una aplicación que nos ayude a gestionar nuestras tareas pendientes, le pedimos a las herramientas de IA que generen el código, explicando de manera detallada qué queremos que haga, cómo esperamos que se comporte y qué aspecto debe tener. A partir de estas instrucciones, la herramienta generará el código y nos irá guiando para probarlo, modificarlo y ponerlo en marcha. Podemos preguntarle cómo y dónde ejecutarlo de manera gratuita y pedirle ayuda para realizar mejoras.

Como hemos visto, el potencial de estos asistentes digitales es enorme, pero su verdadero poder reside en gran parte en cómo nos comunicamos con ellos. Los prompts claros y bien estructurados son la clave para obtener respuestas precisas sin necesidad de ser expertos en tecnología. La IA no solo nos ayuda a automatizar tareas rutinarias, sino que amplía nuestras capacidades, permitiéndonos hacer más en menos tiempo. Estas herramientas están redefiniendo nuestro día a día, haciéndolo más eficiente y dejándonos tiempo para otras cosas. Y lo mejor de todo: ya está a nuestro alcance.

La ciencia de datos está de moda. Las profesiones relacionadas con este ámbito se encuentran entre las más demandadas, de acuerdo con el último estudio “Posiciones y competencias más Demandadas 2024”, realizado por la Asociación Española de Directores de Recursos Humanos. En concreto, se observa una demanda significativa para roles relacionados con la gestión y análisis de datos, como Data Analyst, Data Engineer y Data Scientist. El auge de la inteligencia artificial (IA) y la necesidad de tomar decisiones basadas en datos están impulsando la integración de este tipo de profesionales en todos los sectores.

Las universidades son conscientes de esta situación y por ello oferta una gran cantidad de grados, posgrados y también cursos de verano, tanto para principiantes como para aquellos que quieren ampliar conocimientos y explorar nuevas tendencias tecnológicas. A continuación, recogemos algunos de ellos a modo de ejemplo. Se trata de cursos que combinan teoría y práctica, permitiendo descubrir el potencial de los datos.

1. Análisis y Visualización de Datos: Estadística Práctica con R e Inteligencia Artificial. Universidad Nacional de Educación a Distancia (UNED).

Este seminario ofrece formación integral en análisis de datos con un enfoque práctico. Se aprenderá a utilizar el lenguaje R y el entorno RStudio, con el foco puesto en la visualización, la inferencia estadística y su uso en sistemas de inteligencia artificial. Está dirigido a estudiantes de ramas afines y profesionales de diversos sectores (como educación, negocios, salud, ingeniería o ciencias sociales) que requieran aplicar técnicas estadísticas y de IA, así como a investigadores y académicos que necesiten procesar y visualizar datos.

- Fecha y lugar: del 25 al 27 de junio de 2025 en modalidad online y presencial (en Plasencia).

2. Big Data. Análisis de datos y aprendizaje automático con Python. Universidad Complutense.

Gracias a esta formación, los estudiantes podrán adquirir una comprensión profunda de cómo los datos se obtienen, gestionan y analizan para generar conocimiento de valor a la hora de tomar decisiones. Entre otras cuestiones, se mostrará el ciclo de vida de un proyecto Big Data, incluyendo un módulo específico sobre datos abiertos. En este caso, el lenguaje elegido para la formación será Python. Para asistir, no se requieren conocimientos previos: está abierto a estudiantes universitarios, docentes, investigadores y profesionales de cualquier sector con interés en la temática.

- Fecha y lugar: del 30 de junio al 18 de julio de 2025 en Madrid.

3. Challenges in Data Science: Big Data, Biostatistics, Artificial Intelligence and Communications. Universitat de València.

Este programa nace con la vocación de ayudar a los participantes a comprender el alcance de la revolución impulsada por los datos. Integrado dentro de los programas de movilidad Erasmus, combina clases magistrales, trabajo en grupo y una sesión de laboratorio experimental, todo en inglés. Entre otros temas, se hablará de datos abiertos, herramientas open source, bases de datos de Big Data, computación en la nube, privacidad y seguridad de los datos institucionales, minería y visualización de textos.

- Fecha y lugar: Del 30 de junio al 4 de julio en dos sedes de Valencia. Nota: Actualmente las plazas están cubiertas, pero está abierta la lista de espera.

4. Gemelos digitales: de la simulación a la realidad inteligente. Universidad de Castilla-La Mancha.

Los gemelos digitales son una herramienta fundamental para impulsar la toma de decisiones basada en datos. Con este curso, los estudiantes podrán comprender las aplicaciones y los retos de esta tecnología en diversos sectores industriales y tecnológicos. Se hablará de la inteligencia artificial aplicada a gemelos digitales, la computación de alto rendimiento (HPC) y la validación y verificación de modelos digitales, entre otros. Está dirigido a profesionales, investigadores, académicos y estudiantes interesados en la materia.

- Fecha y lugar: 3 y 4 de julio en Albacete.

5. Geografía de la salud y Sistemas de Información Geográfica: aplicaciones prácticas. Universidad de Zaragoza.

El aspecto diferencial de este curso es que está pensado para aquellos alumnos que busquen un enfoque práctico de la ciencia de datos en un sector concreto como es el de la salud. Su objetivo es proporcionar conocimientos teóricos y prácticos sobre la relación entre geografía y salud. Los alumnos aprenderán a utilizar Sistemas de Información Geográfica (SIG) para analizar y representar datos sobre prevalencia de enfermedades. Está abierto a distintos públicos (desde estudiantes o personas que trabajen en instituciones públicas y centros sanitarios, a asociaciones de vecinos u organizaciones sin ánimo de lucro vinculadas con temas de salud) y no requiere titulación universitaria previa.

- Fecha y lugar: del 7 al 9 de julio de 2025 en Zaragoza.

6. Deep into data science. Universidad de Cantabria.

Dirigido a científicos, estudiantes universitarios (desde segundo año) de ingeniería, matemáticas, física e informática, este curso intensivo busca proporcionar una visión completa y práctica de la revolución digital actual. Los estudiantes aprenderán sobre herramientas de programación Python, machine learning, inteligencia artificial, redes neuronales o cloud computing, entre otros temas. Todos los temas se introducen de forma teórica para a continuación experimentar en prácticas de laboratorio.

- Fecha y lugar: del 7 al 11 de julio de 2025 en Camargo.

7.Advanced Programming. Universitat Autònoma de Barcelona.

Impartido totalmente en inglés, el objetivo de este curso es mejorar las habilidades y conocimientos de programación de los alumnos a través de la práctica. Para ello se desarrollarán dos juegos en dos lenguajes distintos, Java y Python. Los alumnos serán capaces de estructurar una aplicación y programar algoritmos complejos. Está orientada a estudiantes de cualquier titulación (matemáticas, física, ingeniería, química, etc.) que ya se hayan iniciado en la programación y quieran mejorar sus conocimientos y habilidades.

- Fecha y lugar: 14 de julio al 1 de agosto de 2025, en una ubicación por definir.

8.Visualización y análisis de datos con R. Universidade de Santiago de Compostela.

Este curso está dirigido a principiantes en la materia. En él se abordarán las funcionalidades básicas de R con el objetivo de que los estudiantes adquieran las habilidades necesarias para desarrollar análisis estadísticos descriptivos e inferenciales (estimación, contrastes y predicciones). También se darán a conocer herramientas de búsqueda y ayuda para que los alumnos puedan profundizar en su uso de manera independiente.

- Fecha y lugar: del 14 al 24 de julio de 2025 en Santiago de Compostela.

9. Fundamentos de inteligencia artificial: modelos generativos y aplicaciones avanzadas. Universidad Internacional de Andalucía.

Este curso ofrece una introducción práctica a la inteligencia artificial y sus principales aplicaciones. En él se abordan conceptos relacionados con el aprendizaje automático, las redes neuronales, el procesamiento del lenguaje natural, la IA generativa y los agentes inteligentes. El lenguaje utilizado será Python, y aunque el curso es introductorio, se aprovechará mejor si el estudiante tiene conocimientos básicos en programación. Por ello, se dirige principalmente a estudiantes de grado o posgrado en áreas técnicas como ingeniería, informática o matemáticas, profesionales que buscan adquirir competencias en IA para aplicar en sus industrias y docentes e investigadores interesados en actualizarse sobre el estado del arte en IA.

- Fecha y lugar: del 19 al 22 de agosto de 2025, en Baeza.

10. IA Generativa para innovar en la empresa: casos reales y herramientas para su implementación. Universidad del País Vasco.

Este curso, abierto al público general, tiene como objetivo ayudar a comprender el impacto de la IA generativa en distintos sectores y su papel en la transformación digital a través de la exploración de casos reales de aplicación en empresas y centros tecnológicos de Euskadi. Para ello se combinan charlas, paneles de discusión y una sesión práctica enfocada en el uso de modelos generativos, y técnicas como Retrieval-Augmented Generation (RAG) y Fine-Tuning.

- Fecha y lugar: 10 de septiembre en San Sebastián.

Invertir en formación tecnológica durante el verano no solo es una excelente manera de fortalecer habilidades, sino también de conectar con expertos, compartir ideas y descubrir oportunidades de innovación. Esta selección es solo una pequeña muestra de la oferta disponible. Si conoces algún otro curso que quieras compartir con nosotros, deja un comentario o escríbenos a dinamizacion@datos.gob.es

El conocimiento abierto es aquel que puede ser reutilizado, compartido y mejorado por otros usuarios e investigadores sin restricciones notables. Esto incluye datos, publicaciones académicas, software y otros recursos disponibles. Para profundizar en esta temática contamos con representantes de dos instituciones cuyo objetivo es impulsar la producción científica y que esta sea dispuesta en abierto para su reutilización:

- Mireia Alcalá Ponce de León, técnica de recursos de información del área de aprendizaje, investigación y ciencia abierta del Consorcio de Servicios Universitarios de Cataluña (CSUC).

- Juan Corrales Corrillero, gestor del repositorio de datos del Consorcio Madroño.

Resumen / Transcripción de la entrevista

1. ¿Podéis explicar brevemente a qué se dedican las instituciones para las que trabajáis?

Mireia Alcalá: El CSUC es el Consorcio de Servicios Universitarios de Cataluña y es una organización que tiene como objetivo ayudar a universidades y centros de investigación que están en Cataluña a mejorar su eficiencia a través de proyectos colaborativos. Estamos hablando de unas 12 universidades y casi unos 50 centros de investigación.

Ofrecemos servicios en muchas áreas: cálculo científico, administración electrónica, repositorios, administración en la nube, etc. y también ofrecemos servicios bibliotecarios y de ciencia abierta, que es lo que nos toca más de cerca. En el área de aprendizaje, investigación y ciencia abierta, que es donde estoy trabajando, lo que hacemos es intentar facilitar la adopción de nuevas metodologías por parte del sistema universitario y de investigación, sobre todo, en la ciencia abierta, y damos apoyo a la gestión de datos de investigación.

Juan Corrales: El Consorcio Madroño es un consorcio de bibliotecas universitarias de la Comunidad de Madrid y de la de la UNED (Universidad Nacional de Educación a Distancia) para la cooperación bibliotecaria. Buscamos incrementar la producción científica de las universidades que forman parte del consorcio y también incrementar la colaboración entre las bibliotecas en otros ámbitos. Estamos también, al igual que el CSUC, muy involucrados con la ciencia abierta: en promocionar la ciencia abierta, en proporcionar infraestructuras que la faciliten, no solamente para los miembros del Consorcio Madroño, sino también de forma global. Aparte, también damos otros servicios bibliotecarios y creamos estructuras para ellos.

2. ¿Qué requisitos debe de cumplir una investigación para qué se considere abierta?

Juan Corrales: Para que una investigación se considere abierta hay muchas definiciones, pero quizás una de las más importantes es la que da la Estrategia Nacional de Ciencia Abierta que tiene seis pilares.

Uno de ellos es que hay que poner en acceso abierto tanto los datos de investigación como las publicaciones, los protocolos, las metodologías... Es decir, todo tiene que estar accesible y, en principio, sin barreras para todo el mundo, no solamente para los científicos, no solamente para las universidades que pueden pagar el acceso a estos datos de investigación o a estas publicaciones.

También es importante utilizar plataformas de código abierto que podamos personalizar. El código abierto es software que cualquiera, en principio con conocimientos, puede modificar, personalizar y redistribuir, como contrapunto al software privado de muchas empresas, que no permite hacer todas estas gestiones.

Otro punto importante, aunque este estemos todavía lejos de llegar en la mayoría de las instituciones, es permitir la revisión por pares abiertas, porque permite saber quién ha hecho una revisión, con qué comentarios, etc. Se puede decir que permite volver a hacer el ciclo de revisión por pares y mejorarlo.

Un último punto es la ciencia ciudadana: permitir a los ciudadanos de a pie formar parte de la ciencia, que no solamente se haga dentro de las universidades o institutos de investigación.

Y otro punto importante es añadir nuevas formas de medir la calidad de la ciencia.

Mireia Alcalá: Estoy de acuerdo con lo que dice Juan. A mí también me gustaría añadir que, para que un proceso de investigación se considere abierto, lo tenemos que mirar globalmente. Es decir, que incluya todo el ciclo de vida de los datos. No podemos hablar de que una ciencia es abierta si solo nos fijamos en que los datos al final estén en abierto. Ya desde el principio de todo el ciclo de vida del dato, es importante que se usen plataformas y se trabaje de una manera más abierta y colaborativa.

3. ¿Por qué es importante que universidades y centros de investigación pongan sus estudios y datos a disposición de la ciudadanía?

Mireia Alcalá: Yo creo que es clave que las universidades y los centros compartan sus estudios, porque gran parte de la investigación, tanto aquí en España como a nivel europeo o mundial, se financia con dinero público. Por lo tanto, si la sociedad es quien está pagando la investigación, lo lógico es que también se beneficie de sus resultados. Además, abrir el proceso de investigación puede ayudar a que sea más transparente, más responsable, etc.

Se ha visto que gran parte de la investigación hecha hasta hoy en día no es reutilizable, ni reproducible. ¿Esto qué quiere decir? Que los estudios que se han hecho, casi en el 80% de los casos otra persona no puede cogerlo y volver a utilizar esos datos. ¿Por qué? Porque no siguen los mismos estándares, las mismas maneras, etc. Por lo tanto, yo creo que tenemos que hacer que sea extensivo a todos los sitios y un ejemplo claro está en época de pandemia. Con la COVID-19, investigadores de todo el mundo trabajaron juntos, compartiendo datos y hallazgos en tiempo real, trabajando de la misma manera, y se vio que la ciencia fue mucho más rápida y eficiente.

Juan Corrales: Los puntos claves ya los ha tocado todos Mireia. Aparte, se podría añadir que acercar la ciencia a la sociedad puede hacer que todos los ciudadanos sintamos que la ciencia es algo nuestro, no solamente de científicos o universitarios. Es algo en lo que podemos participar y esto puede ayudar también a frenar quizás los bulos, las fake news, a tener una visión más exhaustiva de las noticias que nos llegan a través de redes sociales y a poder filtrar qué puede ser real y qué puede ser falso.

4. ¿Qué investigaciones deben publicarse en abierto?

Juan Corrales: Ahora mismo, según la ley que tenemos en España, la última Ley de ciencia, deben publicarse en abierto todas las publicaciones que están financiadas principalmente por fondos públicos o en las que participan instituciones públicas. Esto realmente no ha tenido mucha repercusión hasta el año pasado, porque, aunque la ley salió hace dos años, en la anterior también se decía, también hay una ley de la Comunidad de Madrid que dice lo mismo… pero desde el año pasado se está teniendo en cuenta en la evaluación que hace la ANECA (la Agencia de Evaluación de la Calidad) a los investigadores. Desde entonces casi todos los investigadores han tenido como algo prioritario publicar sus datos e investigaciones en abierto. Sobre todo, con los datos era algo que no se estaba haciendo prácticamente hasta ahora.

Mireia Alcalá: A nivel estatal es como dice Juan. Nosotros a nivel autonómico también tenemos una ley del 2022, la Ley de la ciencia, que básicamente dice exactamente lo mismo que la ley española. Pero a mí también me gusta que la gente conozca que no solo tenemos que tener en cuenta la legislación estatal, sino las convocatorias de donde se consigue el dinero para financiar los proyectos. Básicamente en Europa, en los programas marco como el Horizon Europe, se dice claramente que, si tú recibes una financiación de la Comisión Europea, tendrás que hacer un plan de gestión de datos al inicio de tu investigación y publicar los datos siguiendo los principios FAIR.

5.Entre otras cuestiones, tanto el CSUC como el Consorcio Madroño se encargan de dar soporte a entidades e investigadores que quieren poner sus datos a disposición de la ciudadanía, ¿cómo debe ser un proceso de apertura de datos de datos de investigación? ¿Qué retos son los más habituales y cómo los solucionan?

Mireia Alcalá: En nuestro repositorio que se llama RDR (de Repositori de Dades de Recerca), son básicamente las instituciones participantes las que se encargan de dar apoyo al personal investigador. El investigador llega al repositorio cuando ya está en la fase final de la investigación y necesita publicar para ayer los datos y entonces todo es mucho más complejo y lento. Se tarda más en verificar estos datos y hacer que sean encontrables, accesibles, interoperables y reutilizables.

En nuestro caso particular, tenemos una checklist que pedimos que todo dataset cumpla para garantizar este mínimo de calidad en los datos, para que se puedan reutilizar. Estamos hablando de que tenga identificadores persistentes como ORCID para el investigador o ROR para identificar las instituciones, que tenga documentación que explique cómo reutilizar esos datos, que tenga una licencia, etc. Como tenemos este checklist, los investigadores, a medida que van depositando, van mejorando sus procesos y empiezan a trabajar y a mejorar la calidad de los datos desde el principio. Es un proceso lento.

El principal reto, yo creo que es que el investigador asuma que eso que él tiene son datos, porque la mayoría lo desconoce. La mayoría de los investigadores creen que los datos son unos números que ha sacado una máquina que mide la calidad del aire, y desconoce que un dato puede ser una fotografía, una lámina de una excavación arqueológica, un sonido captado en una determinada atmósfera, etc. Por lo tanto, el principal reto es que todo el mundo entienda qué es un dato y que su dato puede ser valioso para otros.

¿Y cómo lo solucionamos? Intentando hacer mucha formación, mucha sensibilización. En los últimos años, desde el Consorcio, hemos trabajado para formar al personal de curación de datos, el que se dedica a ayudar a los investigadores directamente a fairificar estos datos. También estamos empezando a hacer sensibilización directamente con los investigadores para que usen las herramientas y entiendan un poco todo este nuevo paradigma que es la gestión de datos.

Juan Corrales: En el Consorcio Madroño, hasta noviembre, la única forma de abrir datos era que los investigadores pasaran un formulario con los datos y sus metadatos a los bibliotecarios, y eran los bibliotecarios los que los subían para asegurar que eran FAIR. Desde noviembre, también permitimos a los investigadores que suban los datos directamente al repositorio, pero no se publican hasta que han sido revisados por bibliotecarios expertos, que verifican que los datos y metadatos tienen calidad. Es muy importante que los datos estén bien descritos para que puedan ser fácilmente encontrables, reutilizables e identificables.

En cuanto a los retos, están todos los que ha dicho Mireia - que los investigadores muchas veces no saben que tienen datos- y también, aunque la ANECA ha ayudado mucho con las nuevas obligaciones a que se publiquen datos de investigación, muchos investigadores quieren poner sus datos corriendo en los repositorios, sin tener en cuenta que tienen que ser datos de calidad, que no basta con ponerlos, sino que es importante que esos datos después se puedan reutilizar.

6. ¿Qué actividades y herramientas proporcionáis desde vuestras instituciones u otras similares para ayudar a las organizaciones a alcanzar el éxito en esta tarea?

Juan Corrales: Desde Consorcio Madroño, el propio repositorio que utilizamos, la herramienta donde se suben los datos de investigación, facilita que los datos sean FAIR, porque ya proporciona identificadores únicos, plantillas para los metadatos bastante completas que se pueden personalizar, etc. También tenemos otra herramienta que ayuda a crear los planes de gestión de datos para que los investigadores, para que antes de crear sus datos de investigación, empiecen a planificar cómo van a trabajar con ellos. Eso es algo muy importante y que desde las instituciones europeas se está impulsando desde hace ya mucho, y también desde la Ley de la ciencia y la Estrategia Nacional de Ciencia Abierta.

Después, más que las herramientas, es muy importante también la revisión por parte de bibliotecarios expertos.

Hay otras herramientas que ayudan a evaluar la calidad de un dataset, de los datos de investigación, como son Fair EVA o de F-Uji, pero lo que hemos comprobado es que esas herramientas al final lo que están evaluando más es la calidad del repositorio, del software que se está utilizando, y de los requisitos que estás pidiendo a los investigadores para subir estos metadatos, porque todos nuestros datasets tienen una evaluación bastante alta y bastante similar. Entonces, para lo que sí nos sirven esas herramientas es para mejorar tanto los requisitos que estamos poniendo a nuestros datasets, a nuestros conjuntos de datos, como para poder mejorar las herramientas que tenemos, en este caso el software de Dataverse, que es el que estamos utilizando.

Mireia Alcalá: A nivel de herramientas y actividades vamos a la par, porque con el Consorcio Madroño tenemos relación desde hace años, e igual que ellos tenemos todas estas herramientas que ayudan y facilitan el poner los datos de la mejor manera posible ya desde el principio, por ejemplo, con la herramienta para hacer planes de gestión de datos.

Aquí en el CSUC se ha trabajado también en los últimos años de una manera muy intensa en poder cerrar este gap en el ciclo de vida de los datos, abarcando temas de infraestructuras, almacenaje, cloud, etc. para que, en el momento que se analicen y se gestionen los datos, los investigadores tengan también un sitio donde poder ir. Después del repositorio, ya pasamos a todos los canales y portales que permiten difundir y visibilizar toda esta ciencia, porque no tiene sentido que hagamos repositorios y estén allí a modo de silo, sino que tienen que estar interconectados. Desde hace ya muchos años se ha trabajado muy bien en hacer protocolos de interoperabilidad y en seguir los mismos estándares. Por lo tanto, los datos tienen que estar disponibles en otros sitios, y tanto el Consorcio Madroño como nosotros estamos en todos los sitios posibles y más.

7. ¿Nos podéis contar un poco más sobre estos repositorios que ofrecéis? Además de ayudar a los investigadores a poner sus datos a disposición de la ciudadanía, también ofrecéis un espacio, unos repositorios digitales donde albergar estos datos, para que puedan ser localizados por los usuarios.

Mireia Alcalá: Si hablamos específicamente de datos de investigación, como tenemos un mismo repositorio tanto el Consorcio Madroño como nosotros, vamos a dejar que Juan nos explique el software y las especificaciones, y yo me voy a centrar en otros repositorios de producción científica que también ofrece el CSUC. Aquí lo que hacemos es coordinar diferentes repositorios cooperativos según la tipología del recurso que contiene. Por lo tanto, tenemos TDX para tesis, RECERCAT para documentos de investigación, RACO para revista científicas o MACO, para monografías en acceso abierto. En función de tipo de producto, disponemos de un repositorio concreto, porque no todo puede estar en un mismo sitio ya que cada output de la investigación tiene unas particularidades diferentes. Aparte de los repositorios, que son cooperativos, también tenemos otros espacios que hacemos para instituciones concretas, ya sea con una solución más estándar o algunas funcionalidades más personalizadas. Pero básicamente es esto: tenemos para cada tipo de output que hay en la investigación, un repositorio específico que se adapta a cada una de las particularidades de estos formatos.

Juan Corrales: En el caso de Consorcio Madroño, nuestro repositorio se llama e-cienciaDatos, pero está basado en el mismo software que el repositorio del CSUC, que es el Dataverse. Es un software de código abierto, con lo cual puede ser mejorado y personalizado. Aunque en principio el desarrollo está gestionado desde la Universidad de Harvard, en Estados Unidos, estamos participando en su desarrollo instituciones de todo el mundo -no sé si treinta y tantos países hemos participado ya en su desarrollo-.

Entre otras cosas, por ejemplo, las traducciones al catalán la han hecho desde el CSUC, la traducción al español la hemos hecho desde el Consorcio Madroño y también hemos participado en otros pequeños desarrollos. La ventaja que tiene este software es que facilita mucho que los datos sean FAIR y compatible con otros puntos que tienen mucha más visibilidad, porque, por ejemplo, el CSUC es mucho más grande, pero en el Consorcio Madroño estamos seis universidades, y es raro que alguien vaya a buscar un dataset en el Consorcio Madroño, en e-cienciaDatos, directamente. Lo normal es que lo busquen desde Google o un portal europeo o internacional. Con estas facilidades que tiene Dataverse, lo pueden buscar desde cualquier sitio y pueden terminar encontrando los datos que tenemos en el Consorcio Madroño o en el CSUC.

8. ¿Qué otras plataformas con datos en abierto de investigaciones, a nivel español o europeo, recomiendan?

Juan Corrales: Por ejemplo, a nivel español está la FECYT, la Fundación Española de Ciencia y Tecnología, que tiene un recolector que recoge los datos de investigación de todas las instituciones españolas prácticamente. Ahí aparecen todas las publicaciones de todas las instituciones: de Consorcio Madroño, de CSUC y muchísimas más.